Mar

4

Dos verdades incompatibles

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (3)

Comments (3)

Trabajo presentado en la XIX Edición del Carnaval de la Física

El mundo de la Física tiene planteado un gran problema y los físicos son muy conscientes de ello, conocen su existencia desde hace décadas. El problema es el siguiente:

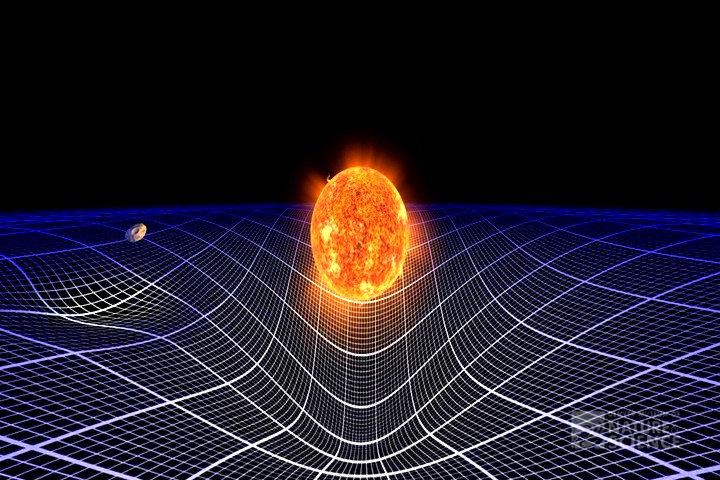

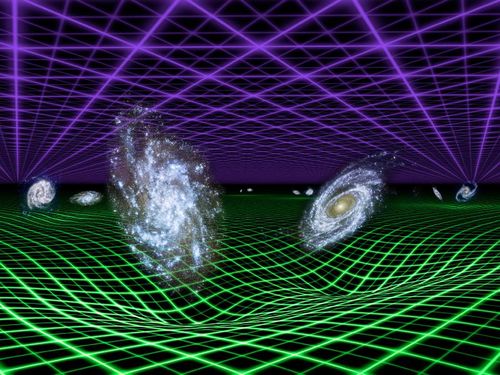

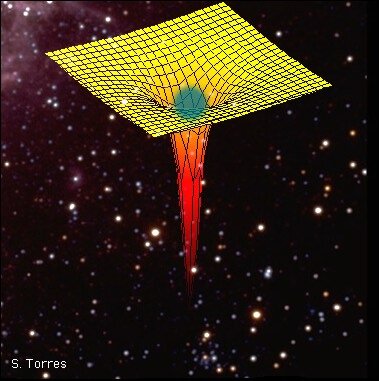

La realtividad general nos dice que en presencia de masa, se curva el espacio y se distorsiona el Tiempo

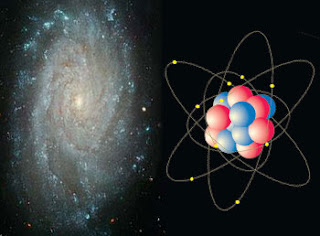

Existen dos pilares fundamentales en los cuales se apoya toda la física moderna. Uno es la relatividad general de Albert Einstein, que nos proporciona el marco teórico para la comprensión del universo a una escala máxima: estrellas, galaxias, cúmulos (o clusters) de galaxias, y aún más allá, hasta la inmensa expansión del propio universo.

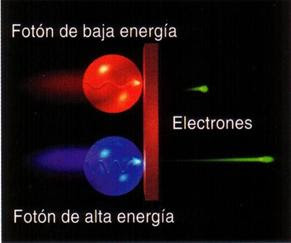

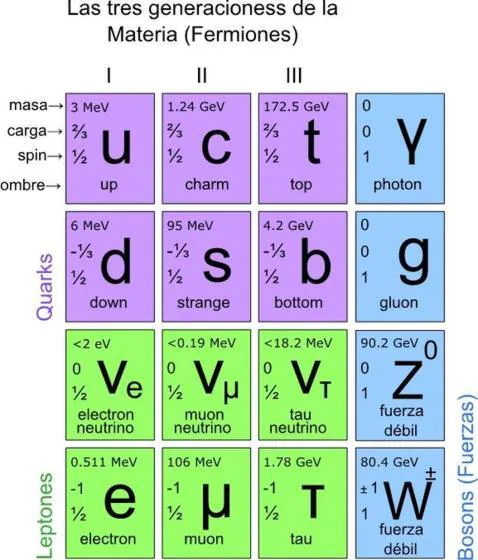

El otro pilar es la mecánica cuántica, que en un primer momento vislumbro Max Planck y posteriormente fue desarrollada por W. Heisemberg, Schrödinger, el mismo Einstein, Dirac, Niels Bohr y otros, que nos ofrece un marco teórico para comprender el universo en su escala mínima: moléculas, átomos, y así hasta las partículas subatómicas, como los electrones y quarks.

Durante años de investigación, los físicos han confirmado experimentalmente, con una exactitud casi inimaginable, la practica totalidad de las predicciones que hacen las dos teorías. Sin embargo, estos mismos instrumentos teóricos nos llevan a una conclusión inquietante: tal como se formulan actualmente, la relatividad general y la mecánica cuántica no pueden ser ambas ciertas a la vez.

Nos encontramos con que las dos teorías en las que se basan los enormes avances realizados por la física durante el último siglo (avances que han explicado la expansión de los cielos y la estructura fundamental de la materia) son mutuamente incompatibles. Cuando se juntan ambas teorías, aunque la formulación propuesta parezca lógica, aquello explota; la respuesta es un sinsentido que nos arroja un sin fin de infinitos a la cara.

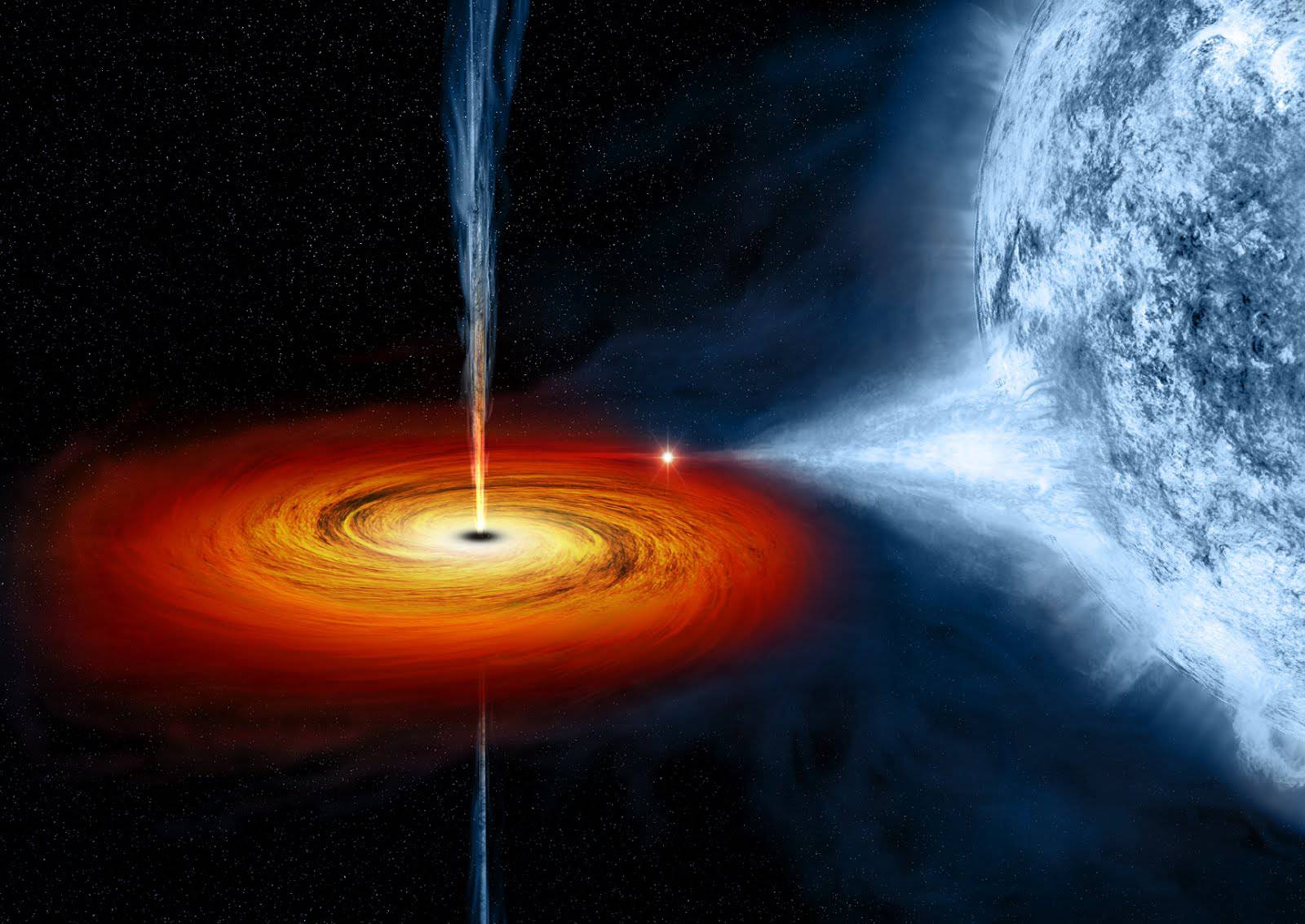

Así que si tú, lector, no has oído nunca previamente hablar de este feroz antagonismo, te puedes preguntar a que será debido. No es tan difícil encontrar la respuesta. Salvo en algunos casos muy especiales, los físicos estudian cosas que son o bien pequeñas y ligeras (como los átomos y sus partes constituyentes), o cosas que son enormes y pesadas (como estrellas de neutrones y agujeros negros), pero no ambas al mismo tiempo. Esto significa que sólo necesitan utilizar la mecánica cuántica, o la relatividad general, y pueden minimizar el problema que se crea cuando las acercan demasiado; las dos teorías no pueden estar juntas. Durante más de medio siglo, este planteamiento no ha sido tan feliz como la ignorancia, pero ha estado muy cerca de serlo.

“… de Estados Unidos (NASA, registraron las ráfagas de viento más rápidas nunca antes detectadas alrededor de un agujero negro.”

No obstante, el universo puede ser un caso extremo. En las profundidades centrales de un agujero negro se aplasta una descomunal masa hasta reducirse a un tamaño minúsculo. En el momento del Bing Bang, la totalidad del universo salió de la explosión de una bolita microscópica cuyo tamaño hace que un grano de arena parezca gigantesco. Estos contextos son diminutos y, sin embargo, tienen una masa increíblemente grande, por lo que necesitan basarse tanto en la mecánica cuántica como en la relatividad general.

Por ciertas razones, las fórmulas de la relatividad general y las de la mecánica cuántica, cuando se combinan, empiezan a agitarse, a traquetear y a tener escapes de vapor como el motor de un viejo automóvil. O dicho de manera menos figurativa, hay en la física preguntas muy bien planteadas que ocasionan esas respuestas sin sentido, a que me referí antes, a partir de la desafortunada amalgama de las ecuaciones de las dos teorías.

Aunque se desee mantener el profundo interior de un agujero negro y el surgimiento inicial del universo envueltos en el misterio, no se puede evitar sentir que la hostilidad entre la mecánica cuántica y la relatividad general está clamando por un nivel más profundo de comprensión.

¿Puede ser creíble que para conocer el universo en su conjunto tengamos que dividirlo en dos y conocer cada parte por separado? Las cosas grandes una ley, las cosas pequeñas otra.

Einstein que con sus trqabajos (algunos maravillosos), como el Efecto Fotoeléctrico que le valió el Nóbel, fue uno de los padres de la Mecánica cuántica y, sin embargo, pasó gran parte de su vida combatiéndola, a él no le entraba en la cabeza que aquella teoría de lo muy pequeño, fuese incompatible con la suya de la Relatividad General. Aquellos dons “mundos” de lo muy grande y lo muy pequeño aparecían incompatibles y, cuando los físicos trataban de unirlos, aunque el planteamiento fuese racional y muy bien conformado, el resultado era como una gran explosión de indinitos sin sentido… ¿Por qué sería?

No creo que eso pueda ser así. Mi opinión es que aún no hemos encontrado la llave que abre la puerta de una teoría cuántica de la gravedad, es decir, una teoría que unifique de una vez por todas las dos teorías más importantes de la física: mecánica cuántica + relatividad general.

Allí, en esa lejana región donde dicen que están las cuerdas vibrantes de la Teoría M, según nos dicen, subyace esa teoría cuántica de la Gravedad, toda vez que, ambas teorías, la de Einstein y la de Planck, la de lo muy grande y lo muy pequeño, conviven sin problemas y, no sólo no se rechazan sino que, se complementan en un todo armonioso.

Si es así, la teoría de supercuerdas ha venido a darme la razón. Los intensos trabajos de investigación llevada a cabo durante los últimos 20 años demuestran que puede ser posible la unificación de las dos teorías cuántica y relativista a través de nuevas y profundas matemáticas topológicas que han tomado la dirección de nuevos planteamientos más avanzados y modernos, que pueden explicar la materia en su nivel básico para resolver la tensión existente entre las dos teorías.

En esta nueva teoría de supercuerdas se trabaja en 10, 11 ó en 26 dimensiones, se amplía el espacio ahora muy reducido y se consigue con ello, no sólo el hecho de que la mecánica cuántica y la relatividad general no se rechacen, sino que por el contrario, se necesitan la una a la otra para que esta nueva teoría tenga sentido. Según la teoría de supercuerdas, el matrimonio de las leyes de lo muy grande y las leyes de lo muy pequeño no sólo es feliz, sino inevitable.

Esto es sólo una parte de las buenas noticias, porque además, la teoría de las supercuerdas (abreviando teoría de cuerdas) hace que esta unión avance dando un paso de gigante. Durante 30 años, Einstein se dedicó por entero a buscar esta teoría de unificación de las dos teorías, no lo consiguió y murió en el empeño; la explicación de su fracaso reside en que en aquel tiempo, las matemáticas de la teoría de supercuerdas eran aún desconocidas. Sin embargo, hay una curiosa coincidencia en todo esto, me explico:

Cuando los físicos trabajan con las matemáticas de la nueva teoría de supercuerdas, Einstein, sin que nadie le llame, allí aparece y se hace presente por medio de las ecuaciones de campo de la relatividad general que, como por arte de magia, surgen de la nada y se hacen presentes en la nueva teoría que todo lo unifica y también todo lo explica; posee el poder demostrar que todos los sorprendentes sucesos que se producen en nuestro universo (desde la frenética danza de una partícula subatómica que se llama quark hasta el majestuoso baile de las galaxias o de las estrellas binarias bailando un valls, la bola de fuego del Big Bang y los agujeros negros) todo está comprendido dentro de un gran principio físico en una ecuación magistral.

Esta nueva teoría requiere conceptos nuevos y matemáticas muy avanzados y nos exige cambiar nuestra manera actual de entender el espacio, el tiempo y la materia. Llevará cierto tiempo adaptarse a ella hasta instalarnos en un nivel en el que resulte cómodo su manejo y su entendimiento. No obstante, vista en su propio contexto, la teoría de cuerdas emerge como un producto impresionante pero natural, a partir de los descubrimientos revolucionarios que se han realizado en la física del último siglo. De hecho, gracias a esta nueva y magnifica teoría, veremos que el conflicto a que antes me refería existente entre la mecánica cuántica y la relatividad general no es realmente el primero, sino el tercero de una serie de conflictos decisivos con los que se tuvieron que enfrentar los científicos durante el siglo pasado, y que fueron resueltos como consecuencia de una revisión radical de nuestra manera de entender el universo.

El primero de estos conceptos conflictivos, que ya se había detectado nada menos que a finales del siglo XIX, está referido a las desconcertantes propiedades del movimiento de la luz.

Isaac Newton y sus leyes del movimiento nos decía que si alguien pudiera correr a una velocidad suficientemente rápida podría emparejarse con un rayo de luz que se esté emitiendo, y las leyes del electromagnetismo de Maxwell decían que esto era totalmente imposible. Einstein, en 1.905, vino a solucionar el problema con su teoría de la relatividad especial y a partir de ahí le dio un vuelco completo a nuestro modo de entender el espacio y el tiempo que, según esta teoría, no se pueden considerar separadamente y como conceptos fijos e inamovibles para todos, sino que por el contrario, el espacio-tiempo era una estructura maleable cuya forma y modo de presentarse dependían del estado de movimiento del observador que lo esté midiendo.

La velocidad de la luz es una constante universal y, cuado es emitida por un cuerpo celeste de forma isotrópica, corre en todas las direcciones a la misma velocidad de 299.792.458 metros por segundo. No importa si la fuente emisora está en movimiento o en reposo, la velocidad es invariante.

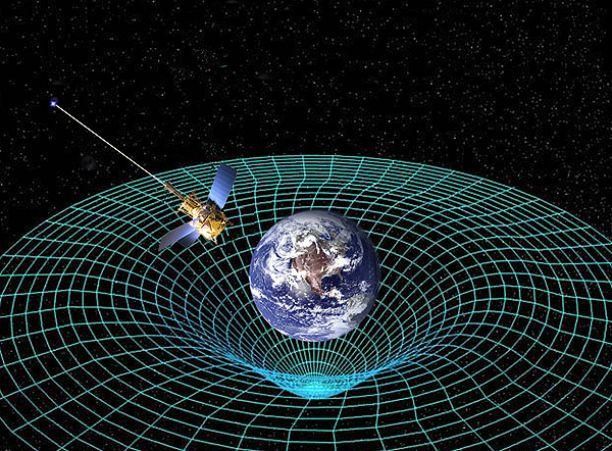

El escenario creado por el desarrollo de la relatividad especial construyó inmediatamente el escenario para el segundo conflicto. Una de las conclusiones de Einstein es que ningún objeto (de hecho, ninguna influencia o perturbación de ninguna clase) puede viajar a una velocidad superior a la de la luz. Einstein amplió su teoría en 1915 – relatividad general – y perfeccionó la teoría de la gravitación de Newton, ofreciendo un nuevo concepto de la gravedad que estaba producida por la presencia de grandes masas, tales como planetas o estrellas, que curvaban el espacio y distorsionaban el tiempo.

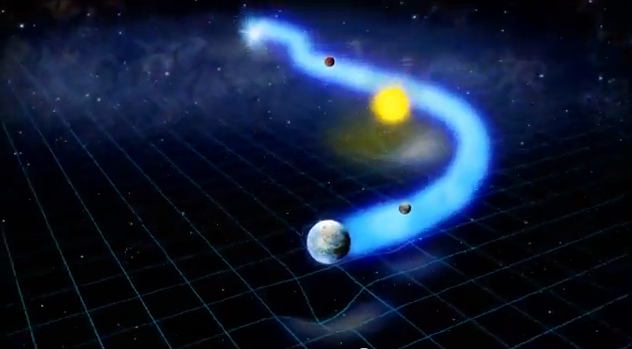

Tales distorsiones en la estructura del espacio y el tiempo transmiten la fuerza de la gravedad de un lugar a otro. La luna no se escapa y se mantiene ahí, a 400.000 Km de distancia de la Tierra, porque está influenciada por la fuerza de gravedad que ambos objetos crean y los mantiene unidos por esa cuerda invisible que tira de la una hacia la otra y viceversa. Igualmente ocurre con el Sol y la Tierra que, separados por 150 millones de kilómetros, están influidos por esa fuerza gravitatoria que hace girar a la Tierra (y a los demás planetas del Sistema Solar) alrededor del Sol.

Así las cosas, no podemos ya pensar que el espacio y el tiempo sean un telón de fondo inerte en el que se desarrollan los sucesos del universo, al contrario; según la relatividad especial y la relatividad general, son actores que desempeñan un papel íntimamente ligado al desarrollo de los sucesos.

El descubrimiento de la relatividad general, aunque resuelve un conflicto, nos lleva a otro. Durante tres décadas desde 1.900, en que Max Planck publicó su trabajo sobre la absorción o emisión de energía de manera discontinua y mediante paquetes discretos a los que él llamo cuantos, los físicos desarrollaron la mecánica cuántica en respuesta a varios problemas evidentes que se pusieron de manifiesto cuando los conceptos de la física del siglo XIX se aplicaron al mundo microscópico. Así que el tercer conflicto estaba servido, la incompatibilidad manifiesta entre relatividad general y mecánica cuántica.

La forma geométrica ligeramente curvada del espacio que aparece a partir de la relatividad general, es incompatible con el comportamiento microscópico irritante y frenético del universo que se deduce de la mecánica cuántica, lo cual era sin duda alguna el problema central de la física moderna.

Las dos grandes teorías de la física, la relatividad general y la mecánica cuántica, infalibles y perfectas por separado, no funcionaban cuando tratábamos de unirlas resulta algo incomprensible, y, de todo ello podemos deducir que, el problema radica en que debemos saber como desarrolar nuevas teorías que modernicen a las ya existentes que, siendo buenas herramientas, también nos resultan incompletas para lo que, en realidad, necesitamos.

emilio silvera

Mar

3

Ya tenemos el Higgs, ¿y ahora qué?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

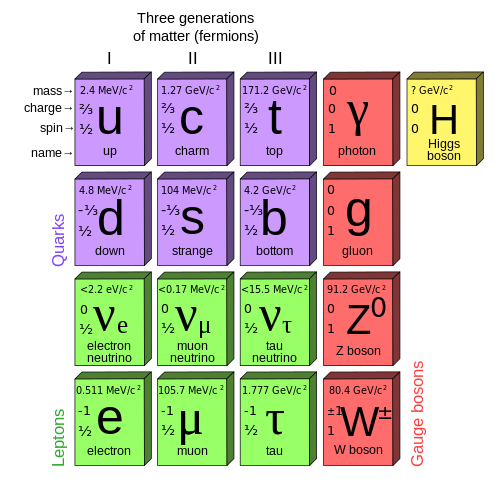

El descubrimiento de la última partícula del Modelo Estándar abre muchos nuevos caminos a la Física

Las lágrimas del padre del Bosón de Higgs, en imágenes

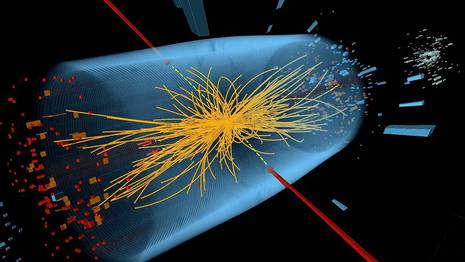

“Gracias, Naturaleza”. Con esas palabras, Fabiola Gianotti, portavoz del experimento ATLAS, del CERN, terminaba la histórica intervención durante la que confirmaba el hallazgo de una nueva partícula con todas las características predichas para el bosón de Higgs.

Antes que ella, Joe Incandela, portavoz del CMS, el segundo gran experimento europeo implicado en la búsqueda, hacía lo propio ante un auditorio que estalló en vítores y aplausos. Incandela consiguió emocionar al mismísimo Peter Higgs, el físico que en 1964 predijo la existencia de la partícula, que no logró contener las lágrimas. El anuncio de los resultados obtenidos por separado por ATLAS y CMS pone fin a casi cincuenta años de “cacería”, la más larga, intensa y costosa de toda la historia de la Física moderna.

¿Cuál o cuales serán, a partir de ahora, los pasos siguientes? Muchos están convencidos de que el hallazgo del bosón de Higgs abre las puertas a nuevos y apasionantes campos de investigación y a respuestas con las que hoy la Física apenas si se atreve a soñar. Materia oscura, supersimetría, unificación de las fuerzas de la Naturaleza… Hoy se ha cruzado un umbral que abre para la Ciencia infinitas posibilidades.

Aunque resulta difícil concretar, estas son algunas de las consecuencias más previsibles del hallazgo del Higgs.

Confirmación del Modelo Estandar

El Modelo Estandar es el la teoría que engloba todos nuestros conocimientos sobre el mundo subatómico. El modelo predice con exactitud todas las partículas que forman la materia, y también las fuerzas que actúan entre ellas, haciendo posible que el Universo sea tal y como lo conocemos.

Todas las partículas predichas por el Modelo Estandar han sido paulatinamente descubiertas en laboratorio. Sólo faltaba una: el bosón de Higgs. Su hallazgo supone la confirmación definitiva de que las ideas actuales son correctas, por lo menos en cuanto se refiere a la materia ordinaria, de la que todos estamos hechos. Si el Higgs no se hubiera descubierto, habríamos tenido que asumir que algo en el Modelo Estandar estaba equivocado. Y eso habría obligado a replantear todo desde el principio.

Sin embargo, y a pesar de su exactitud, el Modelo Estandar sigue sin poder “cuantificar” la gravedad, una de las cuatro fuerzas fundamentales de la Naturaleza, y tampoco explica lo que son la materia y la energía oscuras, responsables del 96% de la masa del Universo. Toda la materia ordinaria, la que forma las galaxias, las estrellas y los planetas, apenas si suma un 4% del total. Puede que el Higgs abra nuevas ventanas para la comprensión del Universo en que vivimos.

El origen de la masa

Si hay algo que hemos oído ya hasta la saciedad es que el bosón de Higgs puede resolver el misterio de por qué las cosas tienen masa. Algo que, si lo pensamos mínimamente, resulta de la máxima importancia, ya que si las partículas subatómicas no tuvieran masa la materia sólida no existiría.

El bosón de Higgs está asociado a un campo energético, llamado el Campo de Higgs, que inunda todo el Universo de la misma forma en que el agua inunda una piscina. Y es precisamente así, “nadando” en el campo de Higgs, como las diferentes partículas (protones, neutrones, electrones, etc.) adquieren su masa.

Las más pequeñas y ligeras encuentran menos resistencia a la hora de moverse. Las más grandes lo hacen con mayor dificultad. Sin este mecanismo, ninguna partícula tendría masa y ninguna de ellas habría podido juntarse con otras partículas para formar átomos y después, poco a poco, objetos más complejos y grandes como estrellas y planetas (o seres humanos).

Por eso, el hallazgo del bosón de Higgs también confirma que este mecanismo existe, y que funciona además tal y como lo predecían las teorías. Ahora, el siguiente paso será el de explicar la razón por la que cada tipo individual de partícula tiene exactamente la masa que tiene, y no cualquier otra. Lo que, a su vez, podría abrir las puertas a cuestiones que, hoy por hoy, siguen envueltas en el misterio.

La unificación de las fuerzas

Existen cuatro fuerzas fundamentales en la Naturaleza: electromagnetismo, fuerza nuclear fuerte, fuerza nuclear débil y gravedad. Cada una de ellas cuenta con una partícula “mensajera” que es la que transporta la unidad mínima de cada fuerza concreta (por ejemplo, el fotón para el electromagnetismo y los bosones W y Z para la fuerza nuclear débil). Y los físicos están convencidos de que es posible unificar las cuatro fuerzas en una única teoría que las englobe a todas.

A finales del siglo XIX, James Clerk Maxwell dio el primer paso hacia esta “gran unificación” al descubrir que la electricidad y el magnetismo son, en realidad, una única fuerza que se manifiesta de dos formas diferentes. La partícula mensajera para ambas, en efecto, es la misma: el fotón.

Ahora, el bosón de Higgs haría posible “unificar” con el electromagnetismo también la fuerza nuclear débil, que es la responsable de la desintegración radiactiva de las diferentes partículas. Basta pensar en los avances que permitió la comprensión de la fuerza electromagnética (unificada) para darse cuenta de la importancia, y las posibilidades, que tendrá la nueva “fuerza electrodébil”.

Mucho más adelante, quizá, será posible unificar también la fuerza nuclear fuerte (que es la responsable de la cohesión de los núcleos atómicos y cuya partícula mensajera es el gluón) y la gravedad, la auténtica “bestia negra” de la Física actual, ya que se resiste más que ninguna otra a ser “cuantificada” por los científicos.

Supersimetría

Otra teoría que seguramente se verá afectada (y mucho) por el descubrimiento del Higgs es la de la Supersimetría. Según esta idea, cada una de las partículas conocidas debe tener una “superpartícula” asociada, muy parecida a su “socia” pero con características sutilmente diferentes, entre ellas una masa mucho mayor.

Y a pesar de que hasta ahora no hay evidencias experimentales que la validen, la Supersimetría resulta enormemente atractiva porque podría contener las claves para la unificación de las dos fuerzas de la Naturaleza que aún se nos resisten, las ya citadas fuerza nuclear fuerte y la gravedad.

E incluso podría suministrar una partícula candidata a ser la unidad mínima de materia oscura, esa “otra clase” de materia de la que no sabemos prácticamente nada y cuya existencia conocemos sólo por los efectos (gravitatorios) que produce en la materia ordinaria, que sí podemos ver.

Por supuesto, todos estos nuevos conocimientos teóricos llevarán a un incontable (e imprevisible) número de aplicaciones prácticas que, hoy por hoy, ni siquiera podemos atisbar. Pensemos lo que sería el mundo sin electricidad, energía atómica, internet, electrónica… es decir, si nunca hubiéramos luchado por comprender cómo funciona el electromagnetismo o la energía atómica.

Dicen que, en pleno siglo XIX y durante una presentación pública, un político preguntó a Michael Faraday, descubridor de la inducción electromagnética, para qué demonios podría servir su descubrimiento. A lo cual Faraday respondió: “señor, no estoy muy seguro, pero es más que probable que dentro de veinte años usted cobre impuestos por ello”.

Fuente:

Feb

25

¡La Física! Esa gran disciplina científica

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Universidad Nacional Autónoma de México, Instituto de Astronomía

| Estrellas de Neutrones |

Las estrellas de neutrones son los objetos más densos observables en el Universo. Sólo son superadas por el interior de los hoyos negros, que no es observable. En colisiones relativistas de iones pesados, en RHIC o en el LHC, es posible alcanzar densidades superiores, pero con una enorme densidad de energía (cientos de GeV por nucleón), mientras que la materia en el interior de una estrella de neutrones es altamente degenerada.

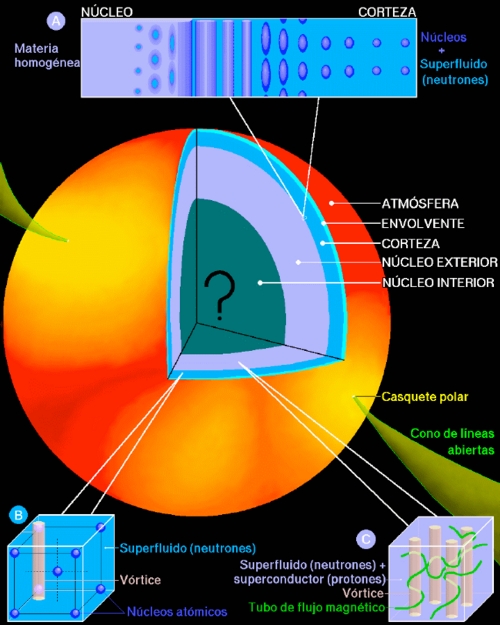

En la Fig. 1 se presenta lo que, teóricamente, consideramos es la estructura de una estrella de neutrones. Con un radio de unos 10 km, el 98% de la masa se encuentra a densidades supra-nucleares en el núcleo de la estrella, mientras que una capa de aproximadamente un kilómetro de espesor, la corteza, está formada de núcleos atómicos. En la superficie tenemos una atmósfera, de unos cuantos centímetros de espesor, donde se forma el espectro térmico que podemos observar. A una densidad ρ ~ 104g cm-3 la materia está totalmente ionizada y cuando ρ ~ 106g cm-3 los electrones forman un gas de Fermi relativista. Dada la enorme energía en este gas de electrones, resulta energéticamente favorable fusionar parte de los electrones con protones, lo que resulta en núcleos cada vez mas ricos en neutrones conforme aumenta la densidad. Cuando ρ ~ 5×1011g cm-3, el número de neutrones es tal que no caben mas en los núcleos. Hemos alcanzado el punto de “goteo” de neutrones, donde además de los núcleos y el gas de electrones, tenemos un gas “libre” de neutrones. Al acercarse a la densidad nuclear, ρ0 ~ 2.8×1014g cm-3 los núcleos se fusionan y entramos al “núcleo” de la estrella (“core” en ingles). En la zona de transición es muy probable que encontremos núcleos no esféricos, muy alargados (“espaguetis”) y bidimensionales (“lasañas”), lo que comúnmente se llama la fase “pasta” (ver recuadro “A” en la Fig. 1). Dadas las altas presiones en la corteza ésta debe ser sólida, muy probablemente en forma cristalina (recuadro “B” en la Fig. 1).

|

|

| Figura 1. Visión “artística” de una estrella de neutrones. (D. Page, en “Fronteras del Universo”, Ed. M. Peimbert, 2000, Fondo de Cultura Económica) | |

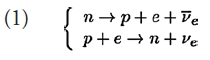

En el núcleo de la estrella, empezamos con un líquido cuántico de neutrones, protones y electrones. Las interacciones débiles, tipo β, como

permiten ajustar las densidades nn y np de nucleones. Debido a las diferencias de masas, la primera de estas reacciones ocurre espontáneamente en el vacío mientras que la segunda requiere de energía cinética en el estado inicial. En un medio denso las energías relevantes no son las masas, sino los potenciales químicos de las partículas, los cuales incluyen la masa, la energía cinética de Fermi y la energía potencial. Esta última requiere de un modelo de las interacciones fuertes a densidades supra-nucleares; el equilibrio energético y efecto de las reacciones β, determinan nn y np. El resultado es que a ρ = &rho0 los nucleones se distribuyen en una proporción de 5% de protones por 95% de neutrones, aunque la fracción de protones aumenta con la densidad. Nuevas partículas pueden aparecer a mayores densidades, como hiperones o condensados de mesones (π – o K -). El núcleo interior de la estrella, está marcada en oscuro en la Fig. 1, con un gran signo de interrogación, ya que existe la posibilidad de se alcance la densidad suficiente para inducir desconfinamento de los quarks. Refiero el lector a [1] para más detalles y referencias a los trabajos originales.

Neutrinos

Producidas en explosiones de supernovas, con temperaturas iniciales superiores a los 50 MeV ~ 50×1010 K, las estrellas de neutrones jóvenes se enfrían por emisión de neutrinos, hasta llegar a una edad de unos 100,000 años, a partir de lo cual la pérdida de energía por emisión de fotones térmicos en la superficie empieza a dominar. El proceso de emisión de neutrinos más eficiente es el descrito en la Eq. (1), llamado “Urca directo”, con una emisividad εDUrca ≈ 1027 (T/109 K)6 erg cm-3 s-1.Esto implica que un metro cúbico de materia podría producir una luminosidad (L = 3.8×1033 erg s-1) de neutrinos cuando T=109 K. Sin embargo, la reacción (1) tiene una fuerte limitante: la conservación del momento, la cual requiere un concentración de protones superior al 15%; por lo cual el proceso Urca directo está cinematicamente prohibido. Sin embargo, existen procesos como

que proporcionan el momento faltante, aquí el neutrón n’ es una partícula del medio. Nótese que el proceso (2), llamado “Urca modificado” por involucrar dos fermiones degenerados, comparado con el proceso (1) es mucho menos eficiente, εMUrca ≈ 1021 (T/109 K)8 erg cm-3 s-1, con una dependencia en la temperatura de la forma T8 en lugar de T6. El proceso (2) es el mecanismo estándar de enfriamiento y el proceso (1) soló actua a densidad altas, es decir en estrellas muy masivas.

Superfluidez y Superconductividad

La teoría BCS de superconductividad está basada en la formación de pares de Cooper y en la aparición de una brecha Δ(T) en elespectro de excitaciones, cuando la interacción entre fermiones es atractiva. La presencia de una brecha y consecuentemente la existencia de pares de Cooper en núcleos fue observada en 1958, poco tiempo después de la formulación de la teoría BCS y es un ingrediente esencial en los modelos de estructura nuclear. Para momentos p<1.5 fm-1 la interacción nuclear n-n o p-p es atractiva en el canal 1S0 (en notación espectroscópica: singlete de espín, momento angular orbital L=0 y J=L+S=0). Esto lleva a predecir que los neutrones deben de formar un superfluido en la corteza interna de una estrella de neutrones mientras que los protones, debido a su baja concentración, formarían un superconductor en el núcleo exterior. En el núcleo de la estrella el momento de Fermi de los neutrones es superior a 1.5 fm-1 y el canal 1S0 se vuelve repulsivo. Sin embargo la formación de pares de Cooper en triplete de espín, en el canal atractivo 3P2, es posible. A mas altas densidades es probable que los hiperones y/o los quarks formen superfluidos/superconductores. El interior de una estrella de neutrones es un paraíso para pares de Cooper, pero el calcular precisamente el tamaño de la brecha Δ(T), y el valor de Tc, es una pesadilla para el físico teórico. El caso del helio-3 es un ejemplo de ello y en el caso del apareamiento 3P2 de los neutrones a densidades supra-nucleares las predicciones para Δ van desde casi 0 hasta más de 5 MeV.

La presencia de una brecha Δ en el espectro de excitaciones implica que cuando T<<Tc estas son fuertemente suprimidas, aproximadamente por un factor de Boltzmann exp (-Δ(T)/T). En consecuencia, el calor específico Cv, así como todos los procesos de emisión de neutrinos en los cuales esta componente apareada participa, están exponencialmente suprimidos. Sin embargo, la transición de fase es de segundo orden, es decir continua. Cuando T ~ Tc, como es bien conocido en el caso de los superfluidos/superconductores terrestres, el calor específico Cv aumenta en un factor del orden 2.5. Otro aspecto del desarrollo progresivo del condensado es el constante rompimiento y formación de pares de Cooper, cuando T ~ Tc , y la posibilidad de que el condensado decaiga en un par neutrino – anti-neutrino:

donde <nn´> representa el condensado de pares de Cooper. Este “proceso de Cooper” puede ser mas eficiente que el Urca modificado (2) por mas de un orden de magnitud.

Enfriamiento y Superfluidez

Esta breve descripción permite esbozar el panorama de la evolución térmica de estrellas de neutrones: a partir de su nacimiento se enfrían por emisión de neutrinos y cuando alcanzan edades del orden de 105 años su evolución se determina por la emisión superficial de fotones.

La tasa de emisión de neutrinos es muy sensible a la composición de la materia a densidades supra-nucleares: cualquier cambio a la composición relativa de neutrones a protones resulta en emisividades de neutrinos altísimas y enfriamiento muy rápido. Tenemos un zoológico completo de modelos de materia ultra densa, casi todos prediciendo un enfriamiento rápido. Por otra parte, el enfriamiento rápido puede ser moderado por el apareamiento de las partículas, mientras la brecha, o la temperatura crítica, sea suficientemente grande. Nos encontramos con el problema de la casi imposibilidad de calcular con suficiente precisión el tamaños de las brechas relevantes y el hecho de que la emisión de neutrinos es controlada por estas brecha de manera exponencial. Las dos revisiones [2] y [3] presentan mas detalles sobre los mecanismos de enfriamiento.

Del lado observacional, tenemos una docena de estrellas de neutrones jóvenes con temperaturas estimadas. Sus altas temperaturas superficiales, entre 0.5 y 2×106 K, indican que ningún proceso Urca directo está actuando en ellas, al menos que esté fuertemente suprimido por apareamiento de las partículas que participen en el proceso. El “modelo mínimo” de enfriamiento [4] fue desarrollado con el fin de presentar un punto de referencia con el cual comparar estas observaciones e identificar posibles candidatas a estrellas conteniendo algún tipo de materia “exótica”. Este modelo excluye a priori cualquier forma de materia densa que resulte en enfriamiento rápido, es decir una alta concentración de protones, condensados de mesones, hiperones y quarks desconfinados. Sin embargo considera el efecto de la superconductividad / superfluidez de protones / neutrones, es decir el apareamiento, y el aumento en la emisión de neutrinos por el proceso de Cooper durante la transición de fase. Resulta que los procesos Urca modificados por si mismos no son suficientemente eficientes para explicar la evolución de las estrellas mas frías pero sí se pueden interpretar las observaciones tomando en cuenta el proceso de Cooper, bajo una condición: la temperatura crítica máxima, Tc, para el apareamiento 3P2 de los neutrones debe estar entre 1/2 y 2×109 K [5]. En este rango de valores de Tc el proceso de Cooper domina el enfriamiento a edades entre unos cientos hasta unas decenas de miles de años de edad.

En el caso contrario debemos suponer la presencia de algún tipo de materia extra para entender la evolución de estas estrellas de neutrones jóvenes. En conclusión, hasta hace poco tiempo nos encontrábamos en una situación que requería de alguna nueva pista para poder avanzar.

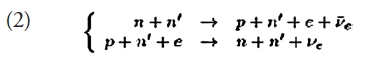

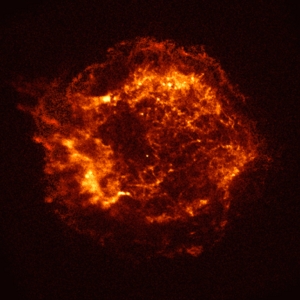

El Caso de Cas A

Casiopeia A es un remanente de supernova en la constelación de Casiopeia. Por su interés astronómico, la NASA decidió inaugurar el satélite de rayos X Chandra, su “primera luz”, con una imagen de este remanente en agosto del 1999 (ver Fig. 2). ¡En el centro de la imagen apareció la estrella de neutrones, “Cas A”, formada por la supernova! Con una edad de unos 330 años es la estrella de neutrones más joven conocida. Al analizar 10 años de observaciones del remanente, y de su estrella, Craig Heinke y Wynn Ho encontraron que Cas A se había enfriado en un 4% del año 2000 al 2009 [5] y que ¡su flujo se había reducido en un 20%! Esta evolución es inconmpatible con casi todas la predicciones teóricas.

|

|

| Figura 2. El remanente de supernova Casiopeia A en rayos X: primera luz de Chandra, en agosto del 1999. El punto brillante en su centro es la estrella de neutrones, descubierta en esta observación. (Crédito: NASA/CXC/SAO) | |

La luminosidad térmica de fotones de la estrella es LX ≈ 1034 erg s-1 mientras que la tasa de enfriamiento observada, junto con una estimación del calor específico, requiere que la estrella esté perdiendo energía térmica a una tasa de 1038 erg s-1. ¿Cuál puede ser el agente de enfriamiento que supere al de fotones por 4 órdenes de magnitud? Sólo puede ser la emisión de neutrinos.

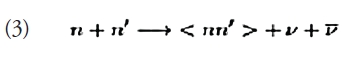

Aunque un comportamiento como el de Cas A es sorprendente, había sido descrito teóricamente con anterioridad (ver, e.g., la Fig. 6 en [5] o Fig. 8 en [2]). Después de afinar detalles, la interpretación resulto clara [7,8]: tras un lento enfriamiento previo, la temperatura interna T de Cas A alcanzó, en las últimas décadas, la temperatura crítica de superfluidez de los neutrones, Tc, lo cual disparó la fuerte emisión de neutrinos por el proceso Cooper. La figura 3 ilustra esto con tres modelos: a edades superiores a los 100 años, sin superfluidez (“Tc=0”), el enfriamiento es lento; al contrario, con una Tc demasiado alta (“Tc=109 K” ), el enfriamiento rápido ocurre demasiado temprano y posteriormente el enfriamiento es también lento; mientras que con Tc=5.5×108 K el enfriamiento rápido, pero transitorio, ajusta perfectamente las observaciones. Además de ser, posiblemente, la primera evidencia directa de la existencia de superfluidez a densidades supra-nucleares, esto nos proporciona una “medición” bastante robusta de la temperatura crítica Tc para los neutrones y los detalles del enfriamiento rápido implican también que los protones deben de ser superconductores con una temperatura crítica más alta. Si la interpretación resiste al tiempo, y el enfriamiento continua durante varias décadas como lo predice el modelo, estaríamos viendo en tiempo real una gran concentración de neutrones pasando por la transición de fase de superfluidez.

|

|

| Figura 3. Tres modelos de enfriamiento, temperatura efectiva “al infinito” Te ∞ vs edad: ver texto para descripción. La estrella marca el valor observado de Cas A y el recuadro detalla el ajuste del modelo con las cinco observaciones de Chandra. (Adaptado de la Ref. [8]) | |

El Futuro: ¿Exótico?

Lo bizarro de un superfluido estelar ha recibido mucha cobertura mediática (ver, e.g., [9]). Sin embargo, lo más importante de estos resultados es que podemos, por lo menos en el caso de Cas A, borrar la zona oscura y el signo “?” en el centro de la Fig. 1. Hace seis meses estábamos todavía caminando en medio de una jungla de modelos, pero sólo uno de ellos parece sobrevivir a la observación del enfriamiento de Cas A que podría ser la “Piedra de Rosetta” de la física de materia ultra-densa. Es ciertamente sólo media piedra: hay evidencias de estrellas que sufren emisión de neutrinos todavía mucho más intensa como son los casos de SAX J1808.4-3658 y 1H 1905+00. Estos dos objetos están en sistemas binarios con acreción transitoria: cuando termina una fase de acreción esperamos ver la superficie caliente de la estrella, estrellas de primera generación como Cas A. Al considerar densidades más altas, alcanzadas en estrellas más masivas, el signo “?” vuelve a aparecer. Sin embargo, el entender con un sorprendente lujo de detalle, la estructura y la evolución de una estrella “mínima” como Cas A, nos abre el camino para identificar más claramente objetos realmente “exóticos”.

Referencias:

[1] Page, D., & Reddy, S., “Dense Matter in Compact Stars: Theoretical Developments and Observational Constraints”, Annu. Rev. Nucl. Part. Sci. 56, 327, (2006)

[2] Yakovlev, D. G., & Pethick, C. J., “Neutron Star Cooling”, Annu. Rev. Astronom. & Astrophys. 42, 169, (2004)

[3] Page, D., Geppert, U., & Weber, F., “The Cooling of Compact Stars”, Nucl. Phys. A 777, 497, (2006), numero especial sobre Nuclear Astrophysics.

[4] Page, D., Lattimer, J. M., Prakash, M., & Steiner, A. W., “Minimal Cooling of Neutron Stars: A New Paradigm”, Astrophys. J. Suppl. 155, 623, (2004).

[5] Page, D., Lattimer, J. M., Prakash, M., & Steiner, A. W., “Neutrino Emission from Cooper Pairs and Minimal Cooling of Neutron Stars”, Astrophys. J. 707, 1131, (2009)

[6] Heinke, C. O., & Ho, W. C. G., “Direct Observation of the Cooling of the Cassiopeia A Neutron Star”, Astrophys. J. Lett. 719, 167, (2010)

[7] Shternin, P. S., Yakovlev, D. G., Heinke, C. O., Ho, W. C. G., & Patnaude, D. J., “Cooling Neutron Star in the Cassiopeia-A Supernova Remnant: Evidence for Superfluidity in the Core”, Mon. Not. Roy. Astron. Soc.: Lett. 412, 108, (2011)

[8] Page, D., Prakash, M., Lattimer, J. M., & Steiner, A. W., “Rapid Cooling of the Neutron Star in Cassiopeia A Triggered by Neutron Superfluidity in Dense Matter”, Phys. Rev. Lett. 106, 081101, (2011)

[9] “Cassiopeia A: NASA’s Chandra Finds Superfluid in Neutron Star’s Core”: http://chandra.harvard.edu/photo/2011/casa/

Feb

23

Revoluciones científicas ¡La Relatividad!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Relativista ~

Clasificado en Física Relativista ~

Comments (0)

Comments (0)

La Escuela Jónica Fundada por Tales de Mileto en el siglo VI a.C. TALES DE MILETO (625-546)

Hemos tenido que construir máquinas inmensas para poder comprobar los efectos que se producen en un cuerpo cuando éste quiere ir más rápido que la luz. Lo predijo la teoría de la relatividad especial de Einstein y se ha comprobado despuès en los aceleradores de partículas: Nada va más rápido que la luz en nuestro Universo.

Es preciso ampliar un poco más las explicaciones anteriores que no dejan sentadas todas las cuestiones que el asunto plantea, y quedan algunas dudas que incitan a formular nuevas preguntas, como por ejemplo: ¿por qué se convierte la energía en masa y no en velocidad?, o ¿por qué se propaga la luz a 299.793 Km/s y no a otra velocidad?

La única respuesta que podemos dar hoy es que así es el universo que nos acoge y las leyes naturales que lo rigen, donde estamos sometidos a unas fuerzas y unas constantes universales de las que la velocidad de la luz en el vacio es una muestra.

A velocidades grandes cercanas a la de la luz (velocidades relativistas) no sólo aumenta la masa del objeto que viaja, sino que disminuye también su longitud en la misma dirección del movimiento (contracción de Lorentz) y en dicho objeto y sus ocupantes –si es una nave– se retrasa al paso del tiempo, o dicho de otra manera, el tiempo allí transcurre más despacio. A menudo se oye decir que las partículas no pueden moverse “más deprisa que la luz” y que la “velocidad de la luz” es el límite último de velocidad.

Pero decir esto es decir las cosas a medias, porque la luz viaja a velocidades diferentes dependiendo del medio en el que se mueve. Donde más deprisa se mueve la luz es en el vacío: allí lo hace a 299.792’458 Km/s. Este sí es el límite último de velocidades que podemos encontrar en nuestro universo.

En el futuro, grandes estaciones sumergidas en el océano y ciudades en otros mundos rodeadas de campos de fuerza que impedirán la radiación nosiva mientras tanto se va consiguiendo terraformar el planeta. La tecnología habrá avanzado tanto que nada de lo que hoy podamos imaginar estará fuera de nuestro alcance y, viajar a mundos situados a decenas de años-luz de la Tierra será para entonces, lo cotidiano

Eso es lo que imaginamos pero… ¿Qué maravillas tendremos dentro de 150 años? ¿Qué adelantos científicos se habrán alcanzado? ¿Qué planetas habremos colonizado? ¿Habrá sucedido ya ese primer contacto del que tanto hablamos? ¿Cuántas “Tierras” habrán sido encontradas? ¿Qué ordenadores utilizaremos? ¿Será un hecho cotidiano el viaje espacial tripulado? ¿Estaremos explotando las reservas energéticas de Titán? ¿Qué habrá pasado con la Teoría de Cuerdas? Y, ¿Habrá, por fín aparecido la dichosa Gravedad cuántica y sabremos si realmente, existe esa materia oscura de la que tanto se habla? Haciendo todas estas preguntas de lo que será o podrá ser, nos viene a la memoria todo lo que fue y que nos posibilita hacer estas preguntas.

Una cosa nos debe quedar bien clara, nada dentro de 250 años será lo mismo que ahora. Todo habrá cambiado en los distintos ámbitos de nuestras vidas y, a excepción del Amor y los sentimientos que sentiremos de la misma manera (creo), todo lo demás, habrá dado lugar a nuevas situaciones, nuevas formas de vida, nuevas sociedades, nuevas maneras y, podríamos decir que una Humanidad nueva, con otra visión y otras perspectivas.

La Ciencia habrá avanzado tanto que, la media de vida de los seres de nuestra especie habrá alcanzado el siglo y más: Nuevos medicamentos y tratamientos, el “universo de lo nano” habrá entrado con fuerza en nuestras vidas y en nuestras tecnologías, la computación que tendremos dentro de un siglo sería irreconocible para los usuarios de hoy, y, los avances en el conocimiento de los materiales, de la Astrofísica y de la Mecánica cuántica nos dejarían más que asombrados. Sin embargo, aunque estamos contribuyendo a ello, ese será otro mundo que no podremos diusfrutar y, con imaginarlo, nos conformaremos.

Nuevas maneras de sondear la Naturaleza y desvelar los secretos

Todo eso ha podido y podrá ser posible gracias a los que antes que nosotros estuvieron aquí. Pero echemos una mirada al pasado. Dejando a un lado a los primeros pensadores y filósofos, como Tales, Demócrito, Empédocles, Ptolomeo, Copérnico, Galileo, Kepler y otros muchos de tiempos pasados, tenemos que atender a lo siguiente:

La cuántica nos habla del “universo” de las partículas subatómicas, de los cuantos de Planck, la Gravesad lo hace del macromundo, de como ésta fuerza de la Naturaleza dihuja la geometría del espacio, mantiene unidos los planetas alrededor de las estrellas en los sistemas planetarios, o, conforma estrellas supermasivas que dejan la secuencia principal en Agujeros negros.

Nuestra Física actual está regida y dominada por dos explosiones cegadoras ocurridas en el pasado: Una fue aquel artículo de 8 páginas que escribiera Max Planck, en ese corto trabajo dejó sentados los parámetros que rigen la Ley de la distribución de la energía radiada por un cuerpo negro. Introdujo en física el concepto novedoso de que la energía es una cantidad que es radiada por un cuerpo en pequeños paquetes discretos, en vez de en una emisión continua. Estos pequeños paquetes se conocieron como cuantos y la ley formulada es la base de la teoría cuántica.

Un amigo físico me decía: cuando escribo un libro, procuro no poner ecuaciones, cada una de ellas me quita diez lectores. Siguiendo el ejemplo, procuro hacer lo mismo (aunque no siempre es posible) pero, en esta ocasión dejaremos el desarrollo de la energía de Planck del que tantas veces se habló aquí, y, ponernos ahora a dilucidar ecuaciones no parece lo más entretenido, aunque el lenguaje de la ciencia, no pocas veces es el de los números.

Allá por el Año 1905, en desconocido Einstein, escribía unos artículos sobr ela Relatividad Especial que hablaba de que la masa y la energía eran la misma cosa, de que la velocidad de la luz nos decía qué límite tiene el universo para transmitir información o viajar, que los objetos se contraen el en sentido de la marcha si van a una velocidad relativista, o que el Tiempo, se puede ralentizar cuando marcha a velocidades cercanas a la de la lus.

En mayo de 1905, Einstein publicó, también en la revista gran alemán “Annalen der Physik”, un segundo artículo, más sutil, sobre el movimiento browniano, descrito por Robert Brown en 1827. El famoso botánico en la naturaleza, que las piedras contienen agua, en el que hay granos de polen. Estos granos de polen están en movimiento mientras están encerrados durante millones de años.

¿Cómo es que estos granos de polen se mueven?

De la misma manera las gotas de tinta en un líquido, se diluyen debido a la constante agitación de las partículas. Este es el movimiento browniano. Durante más de 70 años, no físico, no podría explicar este fenómeno como la existencia de las moléculas, estas pequeñas partículas no fueron encontrados. El movimiento browniano se explica en 1900 por Einstein, y Marian Smoluchowski por Louis Bachelier. El movimiento realizado por el polen suspendido en el aire, por ejemplo, en un rayo de Sol a través de un bosque sombrío, debido a la existencia de las moléculas. Einstein explica el movimiento browniano de la hipótesis atómica y molecular, y calcula el tamaño de las moléculas.

Para el astrónomo Christian Huygens, esta sustancia se llamaba “éter”, y lo permeaba todo en el universo. Por supuesto, el éter –aunque aceptado como una hipótesis muy probable– no podía ser como cualquier material. Para permitir el traslado de la onda electromagnética propuesta por Maxwell debía ser más denso que el acero, pero al mismo tiempo carecer de masa y viscosidad, para no obstruir el paso de los planetas. También debía ser perfectamente transparente, y mantenerse completamente estático y uniforme en todo el cosmos (para explicar que la velocidad de la luz fuera siempre constante, como revelaban las mediciones).

En septiembre de 1905, y todavía en la revista alemana “Annalen der Physik”, aparece el tercer artículo de Einstein. El tercer artículo titulado “la electrodinámica de cuerpos en movimiento”, es aún más revolucionario, porque la intuición de Einstein se rompe con la física newtoniana. Einstein ataca a la asunción de un espacio y tiempo absoluto, tal como se define por la mecánica newtoniana.

También se ocupa de la existencia del éter, medio interestelar inerte debe apoyar a la luz, como el agua o el aire las ondas de sonido de apoyo a medida que avanzan. Este artículo es el creador de la teoría de la relatividad. AE = Δmc2, Einstein redefinió ciertas leyes de la naturaleza, pero su teoría tiene límites, es por eso que se llama teoría de la relatividad. Sólo cuando los objetos se mueven a gran velocidad en línea recta cerca del observador, se encogen y los relojes de reducir la velocidad.

El último artículo, se deriva del artículo anterior, que contiene sólo dos páginas y se publica inmediatamente después de la tercera en septiembre de 1905. En este artículo se titula “La inercia de la energía”, y no de fines, con E = mc2, pero AE = Δmc2.

La variación del contenido energético de un sistema es igual a la variación de la masa multiplicada por c2, la velocidad de la luz. Esta idea explica que cuando un cuerpo masivo absorbe la energía, su masa ha cambiado. Esta energía se calcula multiplicando la masa por el cuadrado de la velocidad de la luz. Ahora sabemos que el poder de la energía contenida en la materia es enorme, incluso cuando un cuerpo es inerte. E es la energía expresada en julios, m la masa en kilogramos, y c es la velocidad de la luz en m/s. Los físicos entienden como la masa contiene una energía oculta, enorme. La energía oculta, lo que corresponde a 1 kg de la materia es importante, ya que es de 9 x 1016 julios (1 kW / h = 3.600.000 J). Esto corresponde a la energía producida por un reactor nuclear con una capacidad de 1400 MW durante dos años.

En cualquier evento de Ciencia, ahí aparecen esos galimatias de los números y letras que pocos pueden comprender, dicen que es el lenguaje que se debe utilizar cuando las palabras no pueden expresar lo que se quiere decir. Y, lo cierto es que, así resulta ser.

Después de lo de Planck y su radiación de cuerpo negro, cinco años más tarde, irrumpió en escena otra revolución de la Física se produjo en 1.905, cuando Albert Einstein publicó su trabajo sobre la relatividad Especial especial nos dio un golpecito en nuestras cabezas para despertar en ellas nuestra comprensión de las leyes que gobiernan el Universo.

Nos dijo que la velocidad de la luz es la máxima alcanzable en nuestro universo, que la masa y la energía son la misma cosa, que si se viaja a velocidades cercanas a la de la luz, el tiempo se ralentiza pero, el cuerpo aumentará su masa y se contraerá en el sentido de la misma…Y, todo eso, ha sido una y mil veces comprobado. Sin embargo, muchas son las pruebas que se realizan para descubrir los fallos de la teoría, veamos una:

Los científicos que estudian la radiación gamma de una explosión de rayos lejanos han encontrado que la velocidad de la luz no varía con la longitud de onda hasta escalas de distancia por debajo de la relatividad(longitud de Planck. Ellos dicen que esto desfavorece a algunas teorías de la gravedad cuántica que postulan la violación de la invariancia de Lorentz.

La invariancia de Lorentz se estipula que las leyes de la física son las mismas para todos los observadores, independientemente de dónde se encuentren en el universo. Teoría de la Relatividad de Einstein, utilizó este principio como un postulado de la relatividad especial especial, en el supuesto de que la velocidad de la luz en el vacío, no depende de que se esté midiendo, siempre y cuando la persona esté en un sistema inercial de referencia. En más de 100 años la invariancia de Lorentz nunca ha sido insuficiente.

La Teoría de cuerdas nos habla de las vibraciones que éstas emiten y que son partículas cuánticas. En esta teoría, de manera natural, se encuentran las dos teorías más importantes del momento: La Gravedad y la Mecánica cuántica, allí, subyacen las ecuaciones de campo de la teoría de la relatividad de Einstein que, cuando los físicas de las “cuerdas” desarrollan su teoría, aparecen las ecuciones relativista, sin que nadie las llame, como por arte de magia. Y, tal aparición, es para los físicos una buena seña.

Sin embargo, los físicos siguen sometiendo a pruebas cada vez más rigurosas, incluyendo versiones modernas del famoso experimento interferométrico de Michelson y Morley. Esta dedicación a la precisión se explica principalmente por el deseo de los físicos para unir la mecánica cuántica con la relaticidad general, dado que algunas teorías de la gravedad cuántica (incluyendo la teoría de cuerdas y la gravedad cuántica de bucles) implica que la invariancia Lorentz podría romperse.

Granot y sus colegas estudiaron la radiación de una explosión de la relatividad y los rayos gamma (asociada con una explosión de gran energía en una galaxia distante) que fue descubierto por la NASA relatividad/Fermi Gamma-Ray Space Telescope, el 10 de mayo de este año. Se analizó la radiación en diferentes longitudes de onda para ver si había indicios de que los sucesos relativistas producían fotones con energías diferentes llegaron a los detectores de relatividad/Fermi en diferentes momentos.

Tal difusión de los tiempos de llegada parece indicar que la invariancia Lorentz efectivamente había sido violada, es decir que la velocidad de la luz en el vacío depende de la energía de la luz y no es una constante universal. Cualquier dependencia de la energía sería mínima, pero aún podría resultar en una diferencia mensurable en los tiempos de llegada de relatividad/fotones debido a los miles de millones de años luz de a la que se encuentran las explosiones relativistas de rayos gamma.

Cuando nos acercamos a la vida privada del genio… ¡también, como todos, era humano!

De la calidad de Einstein como persona nos habla un detalle: Cuando el Presidente Chaim Weizmann de Israel murió en 1952, a Einstein, se le ofreció la presidencia, pero se negó, diciendo que no tenía “ni la habilidad natural ni la experiancia para tratar con seres humanos.” Luego escribió que se sentía muy honrado por el ofrecimiento del estado de Israel, pero a la vez triste y avergonzado de no poder aceptarla.

Pero sigamos con la segunda revolución de su teoría que se dio en dos pasos: 1905 la teoría de la relatividad especial y en 1.915, diez años después, la teoría de la relatividad general que varió por completo el concepto del Cosmos y nos llevó a conocer de manera más profunda y exacta la Gravedad de Newton que mejoró. En realidad, a partir de la relatividad General nació la verdadera Cosmología con objetos antes inexistentes como agujeros negros y de gusano entre otros muchos fenómenos que dicha teoría nos trajo.

La Relatividad de Einteins nos decía que el espacio se curva en presencia de grandes masas

En la Teoría Especial de la Relatividad, se refirió a sistemas de referencias inerciales (no acelerados). Asume que las leyes de la física son idénticas en todos los sitemas de referencia y que la velocidad de la luz en el vacío, c, es constante en el todo el Universo y es independiente de la velocidad del obervador.

La teoría desarrolla un sistema de matemáticas con el fin de reconciliar estas afirmaciones en aparente conflicto. Una de las conclusiones de la teoría es que la masa de un cuerpo, aumenta con la velocidad (hay una ecuación quer así lo demuestra), y, tal hecho, ha sido sobradamente comprobado en los aceleradores de partículas donde un muón, ha aumentado más de diez veces su masa al circular a velocidades cercanas a la de la luz. Y el muón que tiene una vida de dos millonésimas de segundo, además, al desplazarse a velocidades relativistas, también ven incrementado el tiempo de sus vidas.

El Acelerador de Partículas LHC es una Obra inmensa que ha construido el SER Humano para saber sobre la Naturaleza de la materia y…

Todos esos impulsos son llevados a procesadores electrónicos de datos a través de cientos de miles de cables. Por último, se hace una grabación en carrete de cinta magnética codificada con ceros y unos. La cinta graba las violentas colisiones de los protones y antiprotones, en las que generan unas setenta partículas que salen disparadas en diferentes direcciones dentro de las varias secciones del detector.

El LHC es un esfuerzo internacional, donde participan alrededor de siete mil físicos de 80 países. Consta de un túnel en forma de anillo, con dimensiones interiores parecidas a las del metro subterráneo de la Ciudad de México, y una circunferencia de 27 kilómetros. Está ubicado entre las fronteras de Francia y Suiza, cerca de la ciudad de Ginebra, a profundidades que van entre los 60 y los 120 metros debido a que una parte se encuentra bajo las montañas del Jura

La ciencia, en especial la física de partículas, gana confianza en sus conclusiones por duplicación; es decir, un experimento en California se confirma mediante un acelerador de un estilo diferente que funciona en Ginebra con otro equipo distinto que incluye, en cada experimento, los controles necesarios y todas las comprobaciones para que puedan confirmar con muchas garantías, el resultado finalmente obtenido. Es un proceso largo y muy complejo, la consecuencia de muchos años de investigación de muchos equipos diferentes.

Einstein también concluyó que si un cuerpo pierde una energía L, su masa disminuye en L/c2. Y generalizó esta conclusión al importante postulado de que la masa de un cuerpo es una medida de su contenido en energía, de acuerdo con la ecuación m=E/c2 ( o la más popular E=mc2).

Otras de las conclusiones de la teoría de Einstein en su modelo especial, está en el hecho de que para quien viaje a velocidades cercanas a c (la velocidad de la luz en el vacío), el tiempo transcurrirá más lento. Dicha afirmación también ha sido experimentalmente comprobada.

Todos estos conceptos, por nuevos y revolucionarios, no fueron aceptados por las buenas y en un primer momento, algunos físicos no estaban preparados para comprender cambios tan radicales que barrían de un plumazo, conceptos largamente arraigados.

Todo lo grande está hecho de cosas pequeñas

Fue Max Planck, el Editor de la Revista que publicó el artículo de Albert Einstein, quien al leerlo se dió cuenta de la enorme importancia de lo que allí se decía. A partir de aquel momento, se convirtió en su valedor, y, en verdad, Einstein reconoció publicamente tal ayuda.

En la segunda parte de su teoría, la Relatividad General, Einstein concluyó que el espacio y el tiempo están distorsionados por la materia y la energía, y que esta distorsión es la responsable de la gravedad que nos mantiene en la superficie de la Tierra, la misma que mantiene unidos los planetas del Sistema Solar girando alrededor del Sol y, también la que hace posible la existencia de las Galaxias.

¡La Gravedad! Siempre está presente e incide en los comportamientos de la materia. La gravedad presente en un agujero negro gigante hace que en ese lugar, el tiempo deje de existir, se paralice y el espacio, se curve en una distorsión infinita. Es decir, ni espacio ni tiempo tienen lugar en la llamada singulariudad.

Nos dio un conjunto de ecuaciones a partir de los cuales se puede deducir la distorsión del tiempo y del espacio alrededor de objetos cósmicos que pueblan el Universo y que crear esta distorsión en función de su masa. Se han cumplido 100 años desde entonces y miles de físicos han tratado de extraer las predicciones encerradas en las ecuaciones de Einstein (sin olvidar a Riemann ) sobre la distorsión del espaciotiempo.

Un Agujero Negro es lo definitivo en distorsión espaciotemporal, según las ecuaciones de Einstein: está hecho única y exclusivamente a partir de dicha distorsión. Su enorme distorsión está causada por una inmensa cantidad de energía compactada: energía que reside no en la materia, sino en la propia distorsión. La distorsión genera más distorsión sin la ayuda de la materia. Esta es la esencia del Agujero Negro.

Las ecuaciones de campo de la relatividad general de Einstein… ¡Nos dicen tántas cosas!

Si tuviéramos un agujero negro del tamaño de la calabaza más grande del mundo, de unos 10 metros de circunferencia, entonces conociendo las leyes de la geometría de Euclides se podría esperar que su diámetro fuera de 10 m.: л = 3,14159…, o aproximadamente 3 metros. Pero el diámetro del agujero es mucho mayor que 3 metros, quizá algo más próximo a 300 metros. ¿ Cómo puede ser esto ? Muy simple: las leyes de Euclides fallan en espacios muy distorsionados.

Con Einstein llegó la cosmología moderna, otra manera de mirar el Universo

Con esta teoría de la Relatividad General, entre otros pasos importantes, está el hecho de que dió lugar al nacimiento de la Cosmología que, de alguna manera, era como mirar con nueva visión a lo que l Universo podía significar, Después de Einstein, el Universo no fue el mismo.

El análisis de la Gravitación que aquí se miuestra interpreta el Universo como un continuo espacio-tiempo de cuatro dimensiones en el el que la presencia de una masa (como decía antes) curva el espacio para crear un campo gravitacional.

De la veracidad y comprobación de las predicciones de ésta segunda parte de la Teoría Relativista, tampoco, a estas alturas cabe duda alguna, y, lo más curioso del caso es que, después de casi un siglo (1.915), aún los físicos están sacando partido de las ecuaciones de campo de la teoría relativista en su versión general o de la Gravedad.

Tan importante es el trabajo de Einstein que, en las nuevas teorías, en las más avanzadas, como la Teoría M (que engloba las cinco versiones de la Teoría de Cuerdas), cuando la están desarrollando, como por arte de magía y sin que nadie las llame, surgen, emergen, las ecuaciones de Einstein de la Relatividad General.

La luz se propaga en cualquier medio pero en el vacío, mantiene la mayor velocidad posible en nuestro Universo, y, hasta el momento, que se sepa, nada ha corrido más que la luz en ese medio. Algunos han publicado ésta o aquella noticia queriendo romper la estabilidad de la relatividad especial y han publicado que los neutrinos o los taquiones van más rápidos que la luz. Sin embargo, todo se quedó en eso, en una noticia sin demostración para captar la atención del momento.

La luz se propaga en el vacío a una velocidad aproximada a los 30.000 millones (3×1010) de centímetros por segundo. La cantidad c2 representa el producto c×c, es decir:

3×1010 × 3×1010, ó 9×1020.

Por tanto, c2 es igual a 900.000.000.000.000.000.000. Así pues, una masa de un gramo puede convertirse, en teoría, en 9×1020 ergios de energía.

El ergio es una unida muy pequeña de energía que equivale a: “Unidad de trabajo o energía utilizado en el sistema c.g.s y actúa definida como trabajo realizado por una fuerza de 1 dina cuando actúa a lo largo de una distancia de 1 cm: 1 ergio = 10-7 julios”. La kilocaloría, de nombre quizá mucho más conocido, es igual a unos 42.000 millones de ergios. Un gramo de materia convertido en energía daría 2’2×1010 (22 millones) de kilocalorías. Una persona puede sobrevivir cómodamente con 2.500 kilocalorías al día, obtenidas de los alimentos ingeridos. Con la energía que representa un solo gramo de materia tendríamos reservas para unos 24.110 años, que no es poco para la vida de un hombre.

Emilio Silvera

Feb

17

Creando modelos científicos para saber

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

¿Cómo sabemos (si son ciertas) las cosas que pensamos que sabemos?

¿A qué se refieren los científicos cuando dicen que ellos “conocen” lo que hay dentro del un átomo, por ejemplo, o lo que pasó en los tres primeros minutos de vida del Universo?

Se refieren a que tienen lo que ellos denominan un modelo del átomo, o del universo temprano, o lo que sea en que ellos estén interesados, y que este modelo encaja con el resultado de sus experimentos, o sus observaciones del mundo. Este tipo de modelo científico no es una representación física de la cosa real, del mismo modo que un modelo de avión representa un avión de tamaño natural, sino que es una imagen mental que se describe mediante un grupo de ecuaciones matemáticas.

Los átomos y las moléculas que componen el aire que respiramos, por ejemplo, se pueden describir en términos de un modelo en el que imaginamos cada partícula como si fuera una pequeña esfera perfectamente elástica (una diminuta bola de billar), con todas las pequeñas esferas rebotando unas contra las otras y contra las paredes del recipiente.

Ésa es la imagen mental, pero es sólo la mitad del modelo; lo que lo hace un modelo científico es describir el modo como se mueven las esferas y rebotan unas contra otras mediante un grupo de leyes físicas, escritas en términos de ecuaciones matemáticas. En este caso, estas son esencialmente las leyes del movimiento descubiertas por Isaac Newton hacen más de 300 años.

Mirando dentro del átomo

Utilizando estas leyes matemáticas es posible predecir, por ejemplo, qué le pasará a la presión ejercida por un gas si se aplasta hasta la mitad de su volumen inicial. Si hacemos el experimento, el resultado que se obtiene encaja con la predicción del Modelo (en este caso la presión se doblará), lo que lo convierte en un buen modelo.

Naturalmente, no deberíamos sorprendernos de que el modelo estándar de un gas que lo describe en términos de pequeñas bolas que rebotan unas contra otras de acuerdo con las leyes de Newton haga esta predicción en concreto correcta, porque los experimentos fueron hechos primero, y el modelo fue diseñado o construido, para hacer encajar los resultados de esos experimentos.

Tenemos modelos para mtodo

El siguiente paso en el proceso científico es utilizar el modelo que se ha desarrollado desde las medidas efectuadas en un grupo de experimentos para hacer predicciones (predicciones precisas, matemáticas) sobre lo que le pasará al mismo sistema cuando se hacen experimentos diferentes. Si el modelo hacer predicciones “correctas” bajo nuevas circunstancias, demuestra que es un buen modelo; si fracasa al hacer las predicciones correctas, no se puede descartas completamente, porque todavía nos dice algo útil sobre los primeros experimentos; pero en el mejor de los casos tiene una aplicabilidad limitada.

De hecho, todos los modelos científicos tienen aplicabilidad limitada. Ninguno de ellos es “la verdad”. El modelo de un átomo como una pequeña esfera perfectamente elástica funciona bien en cálculos de cambio de presión de un gas bajo circunstancias diferentes, pero si queremos describir el modo en que el átomo emite o absorbe luz, necesitamos un modelo de átomo que al menos tenga dos componentes, un núcleo central diminuto (que se puede considerar él mismo como una pequeña esfera perfectamente elástica para determinados fines) rodeado por una nube de electrones.

Las cosas que creemos saber… ¡No siempre son ciertas!

Los modelos científicos son representaciones de la realidad, no la realidad en sí misma, y no importa lo bien que funcionen o lo precisas que sean sus predicciones bajo circunstancias apropiadas, siempre se considerarán aproximaciones y ayudas a la imaginación, más que la verdad absoluta. Cuando un científico afirma, por ejemplo, que el núcleo de un átomo está compuesto por partículas denominadas protones y neutrones (nucleones) lo que en realidad debería decir es que el núcleo de un átomo se comporta, bajo determinadas circunstancias, como si estuviera formado de protones y neutrones. Los mejores científicos toman el “como si” como se lee, pero entienden que sus modelos son, efectivamente, sólo modelos; científicos menores a menudo olvidan esta diferencia crucial.

Los científicos menos y muchos no-científicos, tienen otra idea equivocada. A menudo piensan que el papel de los científicos hoy en día es llevar a cabo experimentos que probarán la exactitud de un modelo con una precisión cada vez mayor -hacia posiciones con más y más decimales- ¡En absoluto! La razón para llevar a cabo experimentos que demuestren predicciones previas no comprobadas es descubrir (como decía Feynman) donde fallan los modelos.

Encontrar defectos en sus modelos es la esperanza abrigada por los mejores científicos, porque esos defectos -cosas que los modelos no pueden predecir o explicar en detalle- destacarán los lugares donde necesitamos una nueva comprensión, con modelos mejores, para progresar…

El arquetipo ejemplo de esto es la Gravedad. La ley de la gravedad de Newton se consideró la pieza clave de la física durante más de doscientos años, desde la década de 1680 hasta comienzos del siglo XX. Pero había unas pocas, aparentemente insignificantes, cosas que el modelo newtoniano no podía explicar (o predecir), referente a la órbita del planeta Mercurio y al modo como la luz se curva cuando pasa cerca del Sol.

El modelo de la Gravedad de Einstein, basado en su teoría general de la relatividad, explica lo mismo que el modelo de Newton, pero también explica los detalles sutiles de órbitas planetarias y curvatura de la luz. En ese sentido, es un modelo mejor y más completo que el anterior, y hace predicciones correctas (en particular, sobre el Universo en general) que el viejo modelo no hace. Pero el modelo de Newton todavía es todo lo que se necesita si se está calculando el vuelo de una sonda espacial desde la Tierra hasta la Luna. Se podrían hacer los mismos cálculos empleando la relatividad general, pero sería más tedioso por su complejidad y daría la misma respuesta, así que, en muchos casos donde no existe la complejidad, se utiliza el modelo más sencillo de Newton.

Así que, amigos, los modelos (todos los modelos) han sido y serán buenos en su momento y, también, como ocurrió con el de la Gravedad, vendrán otros nuevos que los superarán y servirán mejor y de manera más profunda en el conocimiento de las cosas que traten, llegando así un poco más lejos en nuestros conocimientos sobre la Naturaleza, ya que, a medida que observamos el Universo, nuestras mentes se abren al saber del mundo que nos rodea y cada vez, podemos comprender mejor lo que realmente ocurre en él.

Nuestras percepciones del Universo son, la mayoría de las veces, equivocadas, y nos formamos una idea de lo que allí está o de lo que allí ocurre que, en la realidad, es otra muy diferente. Y, eso, es así debido a que nuestros conocimientos son muy limitados sobre las cosas, y, está aconsejado por ideas preconcebidas que, muchas veces, entorpece la comprensión de esa realidad que incansables buscamos.

Cuando se consiguen describir de manera exitosa las cosas que ocurren en la Naturaleza, como es el caso de la Relatividad, tanto especial como General, a los físicos, les encanta definirlos como “modelo estándar”. El modelo de los gases de las bolas de billar (que también es conocido como teoría cinética, ya que trata de partículas en movimiento) es un modelo estándar. Pero cuando los físicos hablan de “el modelo estándar”, se están refiriendo a uno de los grandes triunfos de la ciencia del siglo XX.

Gravedad y Mecánica cuántica son los dos moldelos prevalentes hoy en la física del mundo, de la Naturaleza, del Universo. Ahí están las explicaciones que de la materia, del espacio tiempo y de las fuerzas universales y las constantes podemos dar y, estamos tratando de abrir camino a nuevas teorías y modelos que nos lleven más alla pero, necesitamos saber matemáticas que no se inventaron aún y también, disponer de energías imposibles, ya que, la energía de Planck de 1019 GeV necesaria para llegar hasta las cuerdas… ¡es sólo un suelo del futuro lejano!

Mirando dentro del átomos

Así ocurre con los modelos que describen la Mecánica Cuántica y la Relatividad, son Modelos Hitos en la Historia de la Ciencia de la Humanidad. Ambos modelos han sido explicado aquí, en mis comentarios muchas veces y, además, no es este el motivo del presente trabajo que, se circunscribe a explicar lo que es un modelo científico y como funciona, al mismo tiempo de cómo se valora su validez que, en realidad, nunca será definitiva, que es lo que ocurre con nuestros conocimientos.

Así que, dicho todo lo anterior, podemos llegar a una conclusión que estaría bien y nos acercaría a la realidad: Lo que sabemos es lo que creemos saber del mundo que nos rodea, y, no es, de ninguna manera, lo que deberíamos saber si nos estamos refiriendo a la realidad de lo que es el Universo y de lo que su Naturaleza finalmente significa y nos quiere decir, para llegar a ese final de comprensión, se necesitarán muchos modelos que se irán desechando por otros que vendrán, y, de esa manera, la Humanidad se acercará a esa realidad que tanto persigue.

emilio silvera

Totales: 83.764.090

Totales: 83.764.090 Conectados: 47

Conectados: 47

![[stephan_quinteto_2009_hubble.jpg]](http://3.bp.blogspot.com/_xBXZbW6ivIs/SqpvjP3SBJI/AAAAAAAAEqc/fh3ULAFurbs/s1600/stephan_quinteto_2009_hubble.jpg)