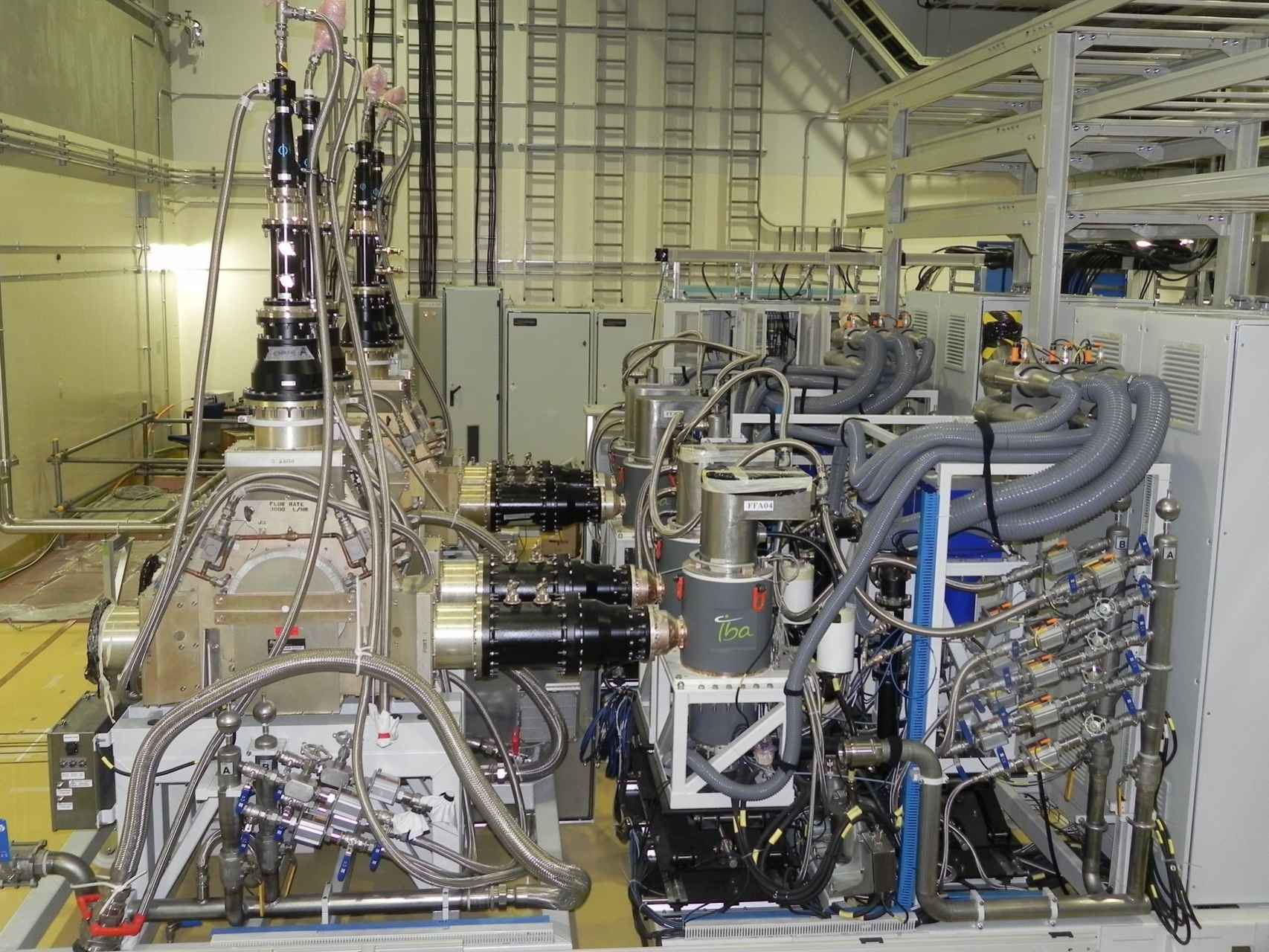

Fuentes de radiofrecuencia fabricadas en España e instaladas en el IFMIF. Atsushi Kasugai

Fuentes de radiofrecuencia fabricadas en España e instaladas en el IFMIF. Atsushi KasugaiFeb

10

La Vida de las Partículas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

La Mente: Ese misterio

La mente humana es tan compleja que no todos ante la misma cosa vemos lo mismo. Nos enseñan figuras y dibujos y nos piden que digamos (sin pensarlo) la primera cosa que nos sugiere. De entre diez personas, sólo coinciden tres, los otros siete divergen en la apreciación de lo que el dibujo o la figura les sugiere. Un paisaje puede ser descrito de muy distintas maneras según quién lo pueda contar.

Solo el 1% de las formas de vida que han vivido en la Tierra están ahora presentes, el 99%, por una u otra razón se han extinguido. Sin embargo, ese pequeño tanto por ciento de la vida actual, supone unos cinco millones de especies según algunas estimaciones. La Tierra acoge a todas esas especies u palpita de vida que prolifera por doquier. Hay seres vivos por todas partes y por todos los rincones del inmenso mosaico de ambientes que constituye nuestro planeta encontramos formas de vida, cuyos diseños parecen hechos a propósito para adaptarse a su hábitat, desde las profundidades abisales de los océanos hasta las más altas cumbres, desde las espesas selvas tropicales a las planicies de hielo de los casquetes polares. Se ha estimado la edad de 3.800 millones de años desde que aparecieron los primeros “seres vivos” sobre el planeta (dato de los primeros microfósiles). Desde entonces no han dejado de aparecer más y más especies, de las que la mayoría se han ido extinguiendo. Desde el siglo XVIII en que Carlos Linneo propuso su Systema Naturae no han cesado los intentos por conocer la Biodiversidad…, de la que por cierto nuestra especie, bautizada como Homo sapiens por el propio Linneo, es una recién llegada de apenas 200.000 años.

Ahora, hablaremos de la vida media de las partículas elementales (algunas no tanto). Cuando hablamos del tiempo de vida de una partícula nos estamos refiriendo al tiempo de vida media, una partícula que no sea absolutamente estable tiene, en cada momento de su vida, la misma probabilidad de desintegrarse. Algunas partículas viven más que otras, pero la vida media es una característica de cada familia de partículas.

También podríamos utilizar el concepto de “semivida”. Si tenemos un gran número de partículas idénticas, la semivida es el tiempo que tardan en desintegrarse la mitad de ese grupo de partículas. La semivida es 0,693 veces la vida media.

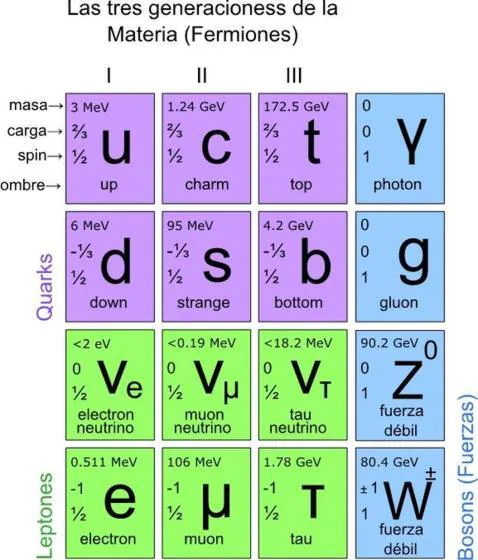

Si miramos una tabla de las partículas más conocidas y familiares (fotón, electrón muón tau, la serie de neutrinos, los mesones con sus piones, kaones, etc., y, los Hadrones bariones como el protón, neutrón, lambda, sigma, psi y omega, en la que nos expliquen sus propiedades de masa, carga, espín, vida media (en segundos) y sus principales maneras de desintegración, veríamos como difieren las unas de las otras.

Algunas partículas tienen una vida media mucho más larga que otras. De hecho, la vida media difiere enormemente. Un neutrón por ejemplo, vive 10¹³ veces más que una partícula Sigma⁺, y ésta tiene una vida 10⁹ veces más larga que la partícula sigma cero. Pero si uno se da cuenta de que la escala de tiempo “natural” para una partícula elemental (que es el tiempo que tarda su estado mecánico-cuántico, o función de ondas, en evolucionar u oscilar) es aproximadamente 10ˉ²⁴ segundos, se puede decir con seguridad que todas las partículas son bastantes estables. En la jerga profesional de los físicos dicen que son “partículas estables”.

¿Cómo se determina la vida media de una partícula? Las partículas de vida larga, tales como el neutrón y el muón, tienen que ser capturadas, preferiblemente en grandes cantidades, y después se mide electrónicamente su desintegración. Las partículas comprendidas entre 10ˉ¹⁰ y 10ˉ⁸ segundos solían registrarse con una cámara de burbujas, pero actualmente se utiliza con más frecuencia la cámara de chispas. Una partícula que se mueve a través de una cámara de burbujas deja un rastro de pequeñas burbujas que puede ser fotografiado. La Cámara de chispas contiene varios grupos de de un gran número de alambres finos entrecruzados entre los que se aplica un alto voltaje. Una partícula cargada que pasa cerca de los cables produce una serie de descargas (chispas) que son registradas electrónicamente. La ventaja de esta técnica respecto a la cámara de burbujas es que la señal se puede enviar directamente a una computadora que la registra de manera muy exacta.

Una partícula eléctricamente neutra nunca deja una traza directamente, pero si sufre algún tipo de interacción que involucre partículas cargadas (bien porque colisionen con un átomo en el detector o porque se desintegren en otras partículas), entonces desde luego que pueden ser registradas. Además, realmente se coloca el aparato entre los polos de un fuerte imán. Esto hace que la trayectoria de las partículas se curve y de aquí se puede medir la velocidad de las partículas. Sin embargo, como la curva también depende de la masa de la partícula, es conveniente a veces medir también la velocidad de una forma diferente.

Una colisión entre un protón y un anti-protón registrada mediante una cámara de chispas del experimento UA5 del CERN.

En un experimento de altas energías, la mayoría de las partículas no se mueven mucho más despacio que la velocidad de la luz. Durante su carta vida pueden llegar a viajar algunos centímetros y a partir de la longitud media de sus trazas se puede calcular su vida. Aunque las vidas comprendidas entre 10ˉ¹³ y 10ˉ²⁰ segundos son muy difíciles de medir directamente, se pueden determinar indirectamente midiendo las fuerzas por las que las partículas se pueden transformar en otras. Estas fuerzas son las responsables de la desintegración y, por lo tanto, conociéndolas se puede calcular la vida de las partículas, Así, con una pericia ilimitada los experimentadores han desarrollado todo un arsenal de técnicas para deducir hasta donde sea posible todas las propiedades de las partículas. En algunos de estos procedimientos ha sido extremadamente difícil alcanzar una precisión alta. Y, los datos y números que actualmente tenemos de cada una de las partículas conocidas, son los resultados acumulados durante muchísimos años de medidas experimentales y de esa manera, se puede presentar una información que, si se valorara en horas de trabajo y coste de los proyectos, alcanzaría un precio descomunal pero, esa era, la única manera de ir conociendo las propiedades de los pequeños componentes de la materia.

Que la mayoría de las partículas tenga una vida media de 10ˉ⁸ segundos significa que son ¡extremadamente estables! La función de onda interna oscila más de 10²² veces/segundo. Este es el “latido natural de su corazón” con el cual se compara su vida. Estas ondas cuánticas pueden oscilar 10ˉ⁸ x 10²², que es 1¹⁴ o 100.000.000.000.000 veces antes de desintegrarse de una u otra manera. Podemos decir con toda la seguridad que la interacción responsable de tal desintegración es extremadamente débil.

Se habla de ondas cuánticas y también, de ondas gravitacionales. Las primeras han sido localizadas y las segundas están siendo perseguidas.

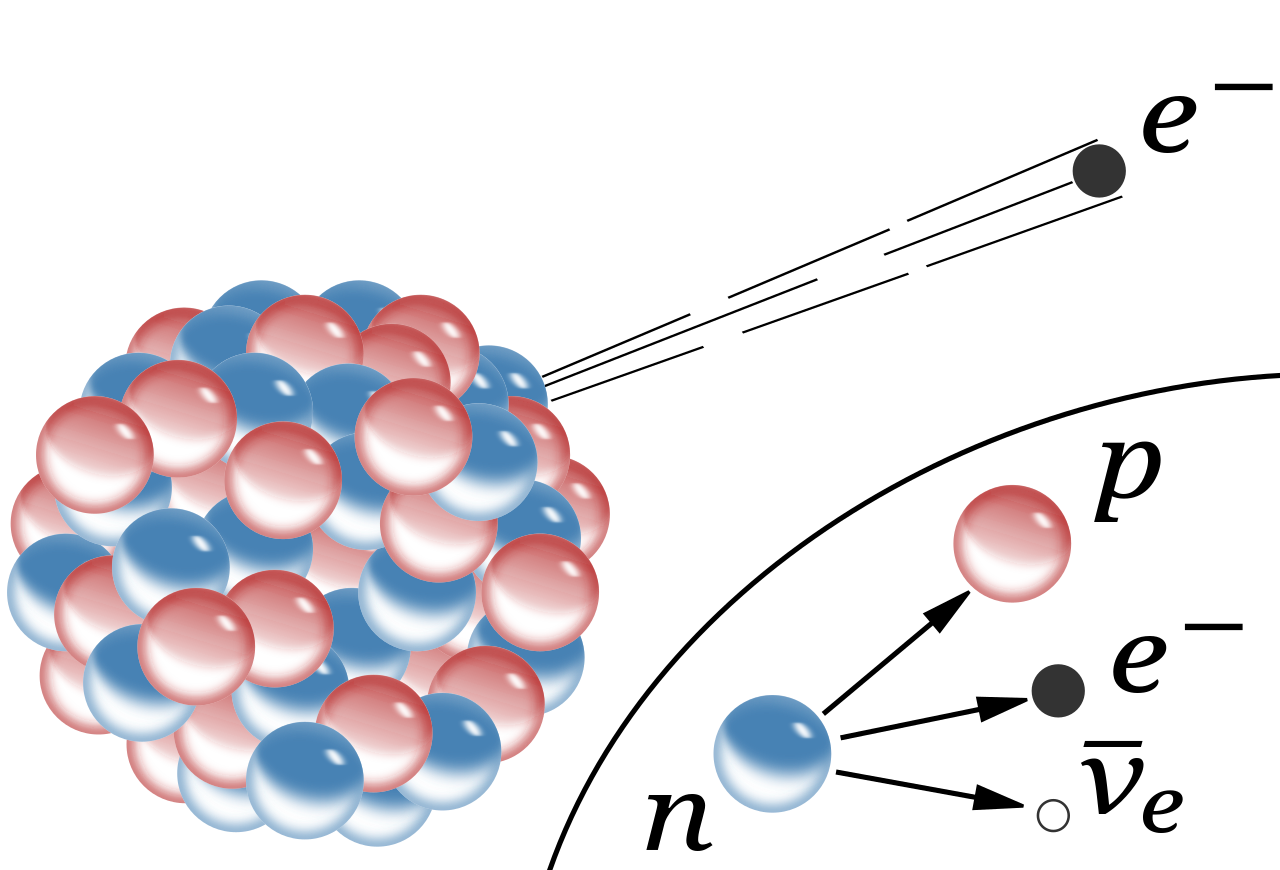

Aunque la vida de un neutrón sea mucho más larga (en promedio un cuarto de hora), su desintegración también se puede atribuir a la interacción débil. A propósito, algunos núcleos atómicos radiactivos también se desintegran por interacción débil, pero pueden necesitar millones e incluso miles de millones de años para ello. Esta amplia variación de vidas medias se puede explicar considerando la cantidad de energía que se libera en la desintegración. La energía se almacena en las masas de las partículas según la bien conocida fórmula de Einstein E = Mc². Una desintegración sólo puede tener lugar si la masa total de todos los productos resultantes es menor que la masa de la partícula original. La diferencia entre ambas masas se invierte en energía de movimiento. Si la diferencia es grande, el proceso puede producirse muy rápidamente, pero a menudo la diferencia es tan pequeña que la desintegración puede durar minutos o incluso millones de años. Así, lo que determina la velocidad con la que las partículas se desintegran no es sólo la intensidad de la fuerza, sino también la cantidad de energía disponible.

Si no existiera la interacción débil, la mayoría de las partículas serían perfectamente estables. Sin embargo, la interacción por la que se desintegran las partículas π°, η y Σ° es la electromagnética. Se observará que estas partículas tienen una vida media mucho más corta, aparentemente, la interacción electromagnética es mucho más fuerte que la interacción débil.

Durante la década de 1950 y 1960 aparecieron tal enjambre de partículas que dio lugar a esa famosa anécdota de Fermi cuando dijo: “Si llego a adivinar esto me hubiera dedicado a la botánica.”

Si la vida de una partícula es tan corta como 10ˉ²³ segundos, el proceso de desintegración tiene un efecto en la energía necesaria para producir las partículas ante de que se desintegre. Para explicar esto, comparemos la partícula con un diapasón que vibra en un determinado modo. Si la “fuerza de fricción” que tiende a eliminar este modo de vibración es fuerte, ésta puede afectar a la forma en la que el diapasón oscila, porque la altura, o la frecuencia de oscilación, está peor definida. Para una partícula elemental, esta frecuencia corresponde a su energía. El diapasón resonará con menor precisión; se ensancha su curva de resonancia. Dado que para esas partículas extremadamente inestable se miden curvas parecidas, a medida se las denomina resonancias. Sus vidas medias se pueden deducir directamente de la forma de sus curvas de resonancia.

Bariones Delta. Un ejemplo típico de una resonancia es la delta (∆), de la cual hay cuatro especies ∆ˉ, ∆⁰, ∆⁺ y ∆⁺⁺(esta última tiene doble carga eléctrica). Las masas de las deltas son casi iguales 1.230 MeV. Se desintegran por la interacción fuerte en un protón o un neutrón y un pión.

Existen tanto resonancias mesónicas como bariónicas . Las resonancias deltas son bariónicas. Las resonancias deltas son bariónicas. (También están las resonancias mesónicas rho, P).

Las resonancias parecen ser solamente una especie de versión excitada de los Hadrones estable. Son réplicas que rotan más rápidamente de lo normal o que vibran de diferente manera. Análogamente a lo que sucede cuando golpeamos un gong, que emite sonido mientras pierde energía hasta que finalmente cesa de vibrar, una resonancia termina su existencia emitiendo piones, según se transforma en una forma más estable de materia.

Por ejemplo, la desintegración de una resonancia ∆ (delta) que se desintegra por una interacción fuerte en un protón o neutrón y un pión, por ejemplo:

∆⁺⁺→р + π⁺; ∆⁰→р + πˉ; o п+π⁰

En la desintegración de un neutrón, el exceso de energía-masa es sólo 0,7 MeV, que se puede invertir en poner en movimiento un protón, un electrón y un neutrino. Un Núcleo radiactivo generalmente tiene mucha menos energía a su disposición.

El estudio de los componentes de la materia tiene una larga historia en su haber, y, muchos son los logros conseguidos y muchos más los que nos quedan por conseguir, ya que, nuestros conocimientos de la masa y de la energía (aunque nos parezca lo contrario), son aún bastante limitados, nos queda mucho por descubrir antes de que podamos decir que dominamos la materia y sabemos de todos sus componentes. Antes de que eso llegue, tendremos que conocer, en profundidad, el verdadero origen de la Luz que esconde muchos secretos que tendremos que desvelar.

Esperemos que con los futuros experimentos del LHC y de los grandes Aceleradores de partículas del futuro, se nos aclaren algo las cosas y podamos avanzar en el perfeccionamiento del Modelo Estándar de la Física de Partículas que, como todos sabemos es un Modelo incompleto que no contiene a todas las fuerzas de la Naturaleza y, cerca de una veintena de sus parámetros son aleatorios y no han sido explicados.(Bueno, ahora son 19 después del descubrimiento del Bosón de Higgs).

Sin embargo, a mí particularmente me quedan muchas dudas al respecto.

emilio silvera

Feb

6

reando Modelos Científicos para saber

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (3)

Comments (3)

¿Cómo sabemos (si son ciertas) las cosas que pensamos que sabemos?

¿A qué se refieren los científicos cuando dicen que ellos “conocen” lo que hay dentro del un átomo, por ejemplo, o lo que pasó en los tres primeros minutos de vida del Universo?

Se refieren a que tienen lo que ellos denominan un modelo del átomo, o del universo temprano, o lo que sea en que ellos estén interesados, y que este modelo encaja con el resultado de sus experimentos, o sus observaciones del mundo. Este tipo de modelo científico no es una representación física de la cosa real, del mismo modo que un modelo de avión representa un avión de tamaño natural, sino que es una imagen mental que se describe mediante un grupo de ecuaciones matemáticas.

Los átomos y las moléculas que componen el aire que respiramos, por ejemplo, se pueden describir en términos de un modelo en el que imaginamos cada partícula como si fuera una pequeña esfera perfectamente elástica (una diminuta bola de billar), con todas las pequeñas esferas rebotando unas contra las otras y contra las paredes del recipiente.

Ésa es la imagen mental, pero es sólo la mitad del modelo; lo que lo hace un modelo científico es describir el modo como se mueven las esferas y rebotan unas contra otras mediante un grupo de leyes físicas, escritas en términos de ecuaciones matemáticas. En este caso, estas son esencialmente las leyes del movimiento descubiertas por Isaac Newton hacen más de 300 años.

Mirando dentro del átomo

Utilizando estas leyes matemáticas es posible predecir, por ejemplo, qué le pasará a la presión ejercida por un gas si se aplasta hasta la mitad de su volumen inicial. Si hacemos el experimento, el resultado que se obtiene encaja con la predicción del Modelo (en este caso la presión se doblará), lo que lo convierte en un buen modelo.

Naturalmente, no deberíamos sorprendernos de que el modelo estándar de un gas que lo describe en términos de pequeñas bolas que rebotan unas contra otras de acuerdo con las leyes de Newton haga esta predicción en concreto correcta, porque los experimentos fueron hechos primero, y el modelo fue diseñado o construido, para hacer encajar los resultados de esos experimentos.

Tenemos modelos para mtodo

El siguiente paso en el proceso científico es utilizar el modelo que se ha desarrollado desde las medidas efectuadas en un grupo de experimentos para hacer predicciones (predicciones precisas, matemáticas) sobre lo que le pasará al mismo sistema cuando se hacen experimentos diferentes. Si el modelo hacer predicciones “correctas” bajo nuevas circunstancias, demuestra que es un buen modelo; si fracasa al hacer las predicciones correctas, no se puede descartas completamente, porque todavía nos dice algo útil sobre los primeros experimentos; pero en el mejor de los casos tiene una aplicabilidad limitada.

De hecho, todos los modelos científicos tienen aplicabilidad limitada. Ninguno de ellos es “la verdad”. El modelo de un átomo como una pequeña esfera perfectamente elástica funciona bien en cálculos de cambio de presión de un gas bajo circunstancias diferentes, pero si queremos describir el modo en que el átomo emite o absorbe luz, necesitamos un modelo de átomo que al menos tenga dos componentes, un núcleo central diminuto (que se puede considerar él mismo como una pequeña esfera perfectamente elástica para determinados fines) rodeado por una nube de electrones.

Las cosas que creemos saber… ¡No siempre son ciertas!

Los modelos científicos son representaciones de la realidad, no la realidad en sí misma, y no importa lo bien que funcionen o lo precisas que sean sus predicciones bajo circunstancias apropiadas, siempre se considerarán aproximaciones y ayudas a la imaginación, más que la verdad absoluta. Cuando un científico afirma, por ejemplo, que el núcleo de un átomo está compuesto por partículas denominadas protones y neutrones (nucleones) lo que en realidad debería decir es que el núcleo de un átomo se comporta, bajo determinadas circunstancias, como si estuviera formado de protones y neutrones. Los mejores científicos toman el “como si” como se lee, pero entienden que sus modelos son, efectivamente, sólo modelos; científicos menores a menudo olvidan esta diferencia crucial.

Los científicos menos y muchos no-científicos, tienen otra idea equivocada. A menudo piensan que el papel de los científicos hoy en día es llevar a cabo experimentos que probarán la exactitud de un modelo con una precisión cada vez mayor -hacia posiciones con más y más decimales- ¡En absoluto! La razón para llevar a cabo experimentos que demuestren predicciones previas no comprobadas es descubrir (como decía Feynman) donde fallan los modelos.

Encontrar defectos en sus modelos es la esperanza abrigada por los mejores científicos, porque esos defectos -cosas que los modelos no pueden predecir o explicar en detalle- destacarán los lugares donde necesitamos una nueva comprensión, con modelos mejores, para progresar…

El arquetipo ejemplo de esto es la Gravedad. La ley de la gravedad de Newton se consideró la pieza clave de la física durante más de doscientos años, desde la década de 1680 hasta comienzos del siglo XX. Pero había unas pocas, aparentemente insignificantes, cosas que el modelo newtoniano no podía explicar (o predecir), referente a la órbita del planeta Mercurio y al modo como la luz se curva cuando pasa cerca del Sol.

El modelo de la Gravedad de Einstein, basado en su teoría general de la relatividad, explica lo mismo que el modelo de Newton, pero también explica los detalles sutiles de órbitas planetarias y curvatura de la luz. En ese sentido, es un modelo mejor y más completo que el anterior, y hace predicciones correctas (en particular, sobre el Universo en general) que el viejo modelo no hace. Pero el modelo de Newton todavía es todo lo que se necesita si se está calculando el vuelo de una sonda espacial desde la Tierra hasta la Luna. Se podrían hacer los mismos cálculos empleando la relatividad general, pero sería más tedioso por su complejidad y daría la misma respuesta, así que, en muchos casos donde no existe la complejidad, se utiliza el modelo más sencillo de Newton.

Así que, amigos, los modelos (todos los modelos) han sido y serán buenos en su momento y, también, como ocurrió con el de la Gravedad, vendrán otros nuevos que los superarán y servirán mejor y de manera más profunda en el conocimiento de las cosas que traten, llegando así un poco más lejos en nuestros conocimientos sobre la Naturaleza, ya que, a medida que observamos el Universo, nuestras mentes se abren al saber del mundo que nos rodea y cada vez, podemos comprender mejor lo que realmente ocurre en él.

Nuestras percepciones del Universo son, la mayoría de las veces, equivocadas, y nos formamos una idea de lo que allí está o de lo que allí ocurre que, en la realidad, es otra muy diferente. Y, eso, es así debido a que nuestros conocimientos son muy limitados sobre las cosas, y, está aconsejado por ideas preconcebidas que, muchas veces, entorpece la comprensión de esa realidad que incansables buscamos.

Cuando se consiguen describir de manera exitosa las cosas que ocurren en la Naturaleza, como es el caso de la Relatividad, tanto especial como General, a los físicos, les encanta definirlos como “modelo estándar”. El modelo de los gases de las bolas de billar (que también es conocido como teoría cinética, ya que trata de partículas en movimiento) es un modelo estándar. Pero cuando los físicos hablan de “el modelo estándar”, se están refiriendo a uno de los grandes triunfos de la ciencia del siglo XX.

Gravedad y Mecánica cuántica son los dos moldelos prevalentes hoy en la física del mundo, de la Naturaleza, del Universo. Ahí están las explicaciones que de la materia, del espacio tiempo y de las fuerzas universales y las constantes podemos dar y, estamos tratando de abrir camino a nuevas teorías y modelos que nos lleven más alla pero, necesitamos saber matemáticas que no se inventaron aún y también, disponer de energías imposibles, ya que, la energía de Planck de 1019 GeV necesaria para llegar hasta las cuerdas… ¡es sólo un suelo del futuro lejano!

Mirando dentro del átomos

Así ocurre con los modelos que describen la Mecánica Cuántica y la Relatividad, son Modelos Hitos en la Historia de la Ciencia de la Humanidad. Ambos modelos han sido explicado aquí, en mis comentarios muchas veces y, además, no es este el motivo del presente trabajo que, se circunscribe a explicar lo que es un modelo científico y como funciona, al mismo tiempo de cómo se valora su validez que, en realidad, nunca será definitiva, que es lo que ocurre con nuestros conocimientos.

Así que, dicho todo lo anterior, podemos llegar a una conclusión que estaría bien y nos acercaría a la realidad: Lo que sabemos es lo que creemos saber del mundo que nos rodea, y, no es, de ninguna manera, lo que deberíamos saber si nos estamos refiriendo a la realidad de lo que es el Universo y de lo que su Naturaleza finalmente significa y nos quiere decir, para llegar a ese final de comprensión, se necesitarán muchos modelos que se irán desechando por otros que vendrán, y, de esa manera, la Humanidad se acercará a esa realidad que tanto persigue.

emilio silvera

Ene

27

La Ciencia no duerme

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

Ciencia ABC

Hallan, por vez primera, la forma de teletransportar un organismo vivo. Científicos proponen cómo pasar la memoria de un microorganismo a otro en un experimento que parece sacado de Star Trek

La investigación puede ser un espectacuar primer avance en el teletransporte de seres vivos completos – Archivo

Nunca hasta ahora habíamos estado tan cerca de Star Trek y el impresionante teletransportador que permitía a la tripulación de la nave Enterprise desmaterializarse en un punto y reaparecer instantaneamente en otro. Un equipo mixto de investigadores de las Universidades de Purdue, en Estados Unidos, y Tsinghua, en China, ha elaborado, en efecto, el primer esquema realizado hasta ahora para teletransportar el estado cuántico interno (la memoria) de un microorganismo vivo a otro. La investigación constituye un espectacular avance en el camino, hoy propio de la ciencia ficción, del teletransporte de seres vivientes completos.

El esquema propuesto por Tongcan Li y Zhang-qi Yin prevé el uso de osciladores electromecánicos y circuitos superconductores para lograr su ambicioso objetivo. En un artículo publicado en Science Bulletin, los investigadores proponen también un esquema para crear un estado de “Gato de Schrodinger” en el que un microorganismo puede estar en dos lugares al mismo tiempo.

En 1935, Erwin Schroedinger propuso un experimento imaginario que consistía en encerrar un gato vivo dentro de una caja en la que se había introducido también una probeta con gas venenoso y un dispositivo, de una sola partícula radiactiva y que tenía una probabilidad del 50% de desintegrarse en un tiempo dado. Al desintegrarse la partícula, el veneno quedaría liberado y el gato moriría sin remedio. Una vez pasado el tiempo establecido, tendríamos un 50% de probabilidades de que la partícula se haya desintegrado y encontrar que el gato está muerto, y otro 50% de que no haya sido así y el gato siga vivo. En el idioma de la Física Cuántica, estaríamos ante una superposición de dos estados posibles (vivo o muerto) que no se concretará hasta el instante en que se abra la caja. Hasta ese momento, en efecto, podríamos decir sin miedo a equivocarnos que el gato está vivo y muerto al mismo tiempo. Sólo abriendo la caja modificaremos el estado de Superposición y haremos que se concrete una de las dos posibilidades.

Realidades «imposibles»

La idea de Schroedinger sirvió para revelar por primera vez al gran público las profundas implicaciones de la Mecánica Cuántica, en cuyo reino la superposición de estados de las partículas está a la orden del día y es pura rutina para los investigadores, que han tenido que acostumbrarse a realidades “imposibles”, como electrones que están en varios lugares a la vez, partículas que se comunican de forma instantánea sin importar la distancia o que, incluso, son capaces de viajar en el tiempo. Desde el hipotético experimento de Schroedinger, los físicos han dedicado décadas de estudio y esfuerzo para tratar de averiguar si las extrañas leyes que rigen en el universo cuántico pueden trasladarse también al mundo macroscópico. Y es que, después de todo, tanto nosotros como todo lo que nos rodea está hecho de partículas.

Por supuesto, se han hecho ya importantes avances. Y en las últimas dos décadas diversos grupos de investigadores han conseguido cada vez mejores resultados a la hora de “teletransportar” estados cuánticos, primero de partículas individuales (un único fotón, en 1997), después de átomos completos, y últimamente de conjuntos cada vez más numerosos de átomos. Recientemente, por ejemplo, un equipo de la Universidad de Colorado logró llevar al estado cuántico toda una membrada de aluminio de 15 micrómetros de diámetro (un micrómetro es la milésima parte de un milímetro), y “teletransportar” sus características y su movimiento a una serie de fotones aislados.

Pero nadie ha conseguido hacer lo mismo con un organismo vivo. Y todos los experimentos llevados a cabo hasta ahora están aún muy lejos de conseguir teletransportar un organismo, o su estado cuántico.

Bacteria cuántica

En su estudio, Tongcang Li y Zhang-qi Yin proponen colocar una bacteria sobre un oscilador electromecánico integrado en un circuito superconductor para conseguir un estado cuántico de superposición en el organismo y teletransportar después ese estado. En principio, el microorganismo es mucho más pequeño que la membrana del oscilador y no debería, por lo tanto, afectar a su funcionamiento. La bacteria, junto a la membrana, serían llevados a un estado cuántico. Después de lo cual, ese estado se podría teletransportar hasta otro organismo distante por medio de circuitos superconductores de microondas. Dado que los estados internos del organismo contienen información, la propuesta de los investigadores supone, en realidad, un esquema para teletransportar esa información, o memoria, de un organismo vivo a otro.

La configuración propuesta por Tongcang Li y Zhang-qi Yin constituye también un poderoso microscopio, ya que no solo es capaz de detectar la existencia del spin de electrones individuales (que puede asociarse a determinados defectos genéticos), sino que puede también manipular y detectar sus estados cuánticos, permitiendo su uso como “memorias cuánticas”.

En palabras de Li, “proponemos un método sencillo para poner un microorganismo en dos lugares al mismo tiempo, y facilitamos un esquema para teletransportar el estado cuántico de un organismo completo. Espero que nuestro trabajo inspire a otros investigadores para que piensen seriamente sobre la posibilidad de la teleportación cuántica de microorganismos y en sus posibilidades futuras. Nuestro trabajo también proporciona pistas para futuros estudios sobre los efectos de las reacciones bioquímicas en los estados de superposición cuántica de los organismos vivientes”.

Ene

18

¿La Fusicón Nuclear? ¡Falta mucho Tiempo para eso!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (4)

Comments (4)

El español Juan Ramón Knaster dirige en Japón un proyecto internacional para desarrollar materiales para los futuros reactores de energía de fusión, el futuro esperado por los científicos durante muchos años.

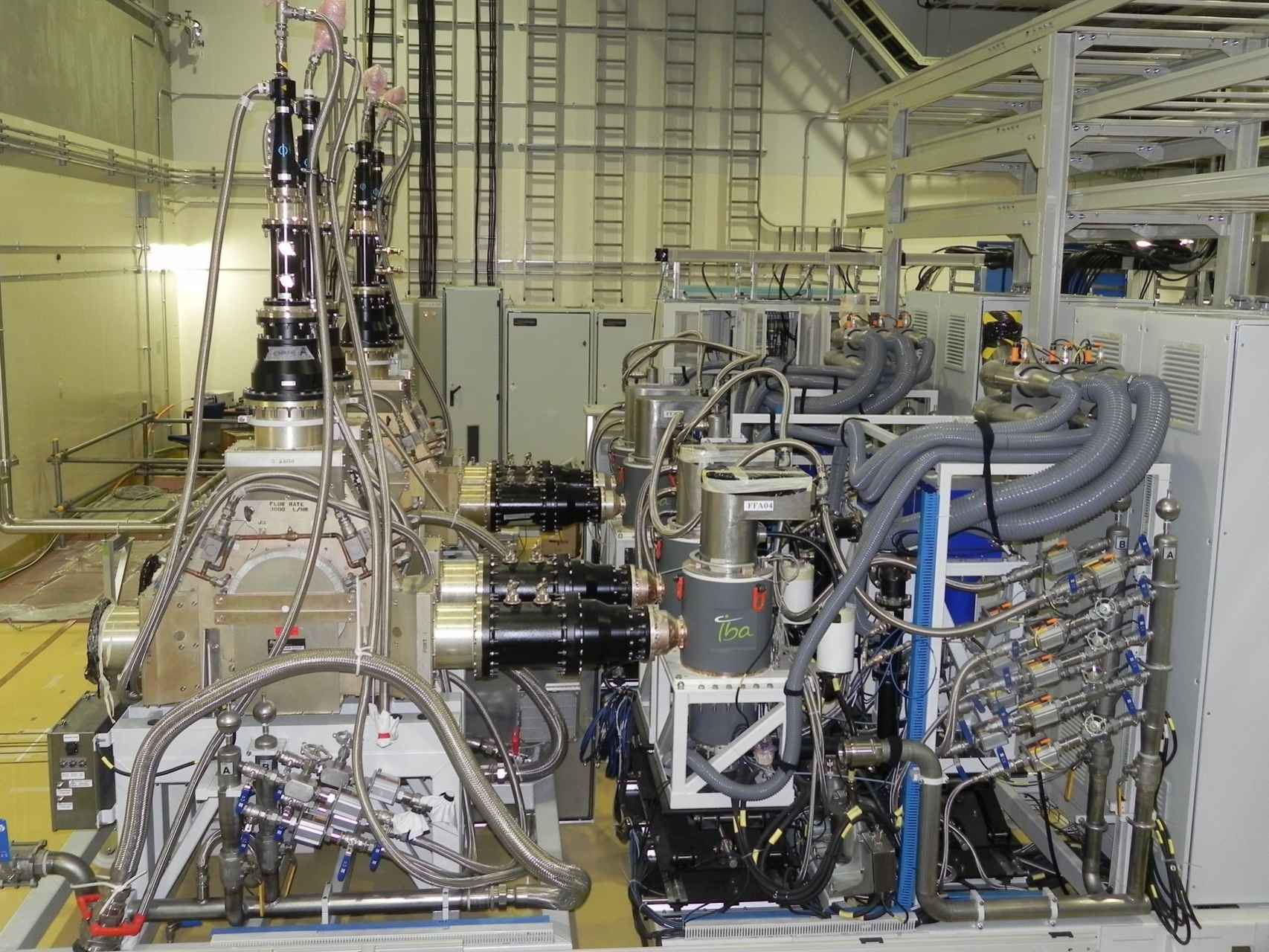

Fuentes de radiofrecuencia fabricadas en España e instaladas en el IFMIF. Atsushi Kasugai

Fuentes de radiofrecuencia fabricadas en España e instaladas en el IFMIF. Atsushi KasugaiAl famoso físico ruso Lev Artsimovich, que dirigió el programa soviético de fusión nuclear entre 1951 y 1973, le preguntaron en cierta ocasión cuándo estaría operativa la prometedora fuente de energía en la que trabajaba. “Cuando la humanidad la necesite, tal vez un poco antes”, fue su célebre respuesta.

Una broma recurrente entre los expertos es que siempre faltan 50 años. Sin embargo, hay razones para pensar que por fin los plazos se acortan y que en las próximas décadas se van a poner en marcha los primeros reactores comerciales de fusión, un reto científico y tecnológico formidable para disponer de una energía limpia, barata y potencialmente inagotable.

El proyecto internacional ITER, que se está construyendo en Francia, participado por China, Corea del Sur, Estados Unidos, Europa, India, Japón y Rusia, ha fijado un calendario para demostrar que es posible producir energía de forma comercial mediante fusión de núcleos de hidrógeno. El posterior proyecto DEMO suministrará por primera vez megavatios a la red eléctrica, previsiblemente en la década de 2040.

Sin embargo, hay otra pieza clave para llegar a ese histórico momento: se llama IFMIF (International Fusion Materials Irradiation Facility) en su fase EVEDA (Engineering Validation and Engineering Design Activity) y se coordina desde Rokkasho (Japón) bajo la dirección del físico e ingeniero español Juan Ramón Knaster.

El científico José Ramón Knaster. José Pichel

“ITER nos enseñará cómo confinar el plasma de las reacciones de fusión, así que sabremos hacer el contenido, pero a día de hoy aún no sabemos cómo hacer el continente”, explica a EL ESPAÑOL. Esa es la principal misión de IFMIF: caracterizar los materiales que podrían exponerse a las reacciones de fusión y contribuir a encontrar otros mejores para construir un reactor viable económicamente, al reducir las necesidades de mantenimiento.

Queremos hacer de manera artificial lo que el Sol hace desde hace 5.000 años. es la única manera que hemos podido vislumbrar para obtener energía barata y no contaminante. Copias a la Naturaleza sería el mejor resultado pero… ¿Lo podrémos conseguir?

La fusión

En una central nuclear actual, la energía se produce por la fisión del uranio, es decir, un neutrón rompe el núcleo del átomo de uranio en dos núcleos más ligeros, que son radiactivos y liberan nuevos neutrones que, a su vez, colisionan con otros núcleos de uranio en tiempos cortísimos, desencadenando lo que se conoce como reacción en cadena.

Claro que el problema de la fusión nuclear es que necesita temperaturas de 15.000.ooo ºC y, ¿qué material puede soportar ese calor inconmensurable?

En cambio, la fusión es el fenómeno contrario, dos núcleos de hidrógeno se unen para formar helio, un proceso que libera una enorme cantidad de energía. De hecho, la fusión de núcleos ligeros produce la energía de las estrellas, como el Sol. Ese es el proceso que los científicos quieren imitar en la Tierra fusionando deuterio y tritio, isótopos del hidrógeno que presentan, respectivamente, uno y dos neutrones en el núcleo del átomo junto al protón.

El deuterio es un átomo estable, está presente en la naturaleza, se puede extraer del agua, de manera que sería una fuente de combustible casi inagotable, mientras que el tritio se producirá artificialmente a partir de litio durante la operación del futuro reactor.

El resultado de la fusión entre los núcleos de deuterio y tritio es un núcleo de helio, un gas inocuo, y un neutrón muy caliente, cuya energía es la que se utilizará para la generación eléctrica con el mismo método de las centrales térmicas actuales: vapor que mueve una turbina conectada a un alternador. “Para poder captar la energía hay que absorber el neutrón que se libera y queremos desarrollar materiales que lo hagan sufriendo una mínima degradación, ya que los actuales durarían pocos años”, señala Knaster, empleado de Fusion for Energy (F4E), el organismo de la Unión Europea encargado de la contribución de Europa al ITER.

Acelerador de partículas

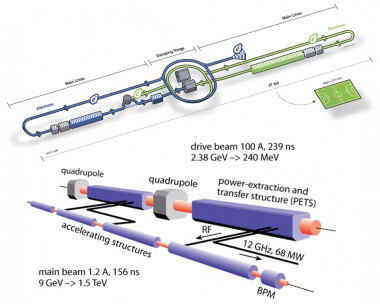

El problema es cómo obtener una fuente de neutrones de características similares a la que produciría un futuro reactor y así probar el comportamiento de distintos materiales. La idea surgió en los años 70 en Estados Unidos, pero la tecnología no estaba preparada hasta ahora. Se conseguirá con un acelerador de deuterones (iones de deuterio) que impacten en una pantalla de litio líquido. Tanto el acelerador como la pantalla de litio líquido tienen unas características que los hacen únicos en el mundo, al límite de lo que la tecnología actual puede conseguir.

No creo que con estos aceleradores lineales se consigue lo que estamos persiguiendo

No creo que con estos aceleradores lineales se consigue lo que estamos persiguiendo

Knaster, que también trabajó en el CERN en el diseño y construcción del LHC, explica que el acelerador de su proyecto es muy diferente. En lugar de circular, será lineal, pero sobre todo destacará por ser “el de mayor corriente con núcleos de hidrógeno que se haya construido nunca”.

Este gran proyecto internacional se enmarca dentro del Broader Approach Agreement, un acuerdo entre la Unión Europea y Japón en el que participan seis países europeos (Alemania, Bélgica, España, Francia, Italia y Suiza). En concreto, en el diseño de los componentes del acelerador están especialmente involucrados Italia, Francia y España.

Beneficios para la industria española

Laboratorio Nacional de Fusión

El Centro de Investigaciones Energéticas, Medioambientales y Tecnológicas (CIEMAT) coordina la aportación española, que tiene importantes repercusiones para la industria nacional. “Ha permitido a España meter la cabeza en terrenos tecnológicos que hasta ahora nos estaban vedados porque no teníamos experiencia en las licitaciones internacionales”, destaca Knaster.

En particular, el desarrollo del acelerador de alta corriente, rompiendo las fronteras tecnológicas actuales, tendrá múltiples aplicaciones más allá de este proyecto, ya que podría emplearse en medicina para tratamientos anticancerígenos o en el estudio de la transmutación de materiales para resolver el problema de los residuos radiactivos.

El científico español dirige en Japón a más de 50 investigadores, a los que hay que sumar unos 300 más que trabajan desde los países europeos que forman parte del proyecto. En la actualidad, se discute la posibilidad de construir una fuente de neutrones basada en los logros de IFMIF/EVEDA. Posiblemente, se llamará IFMIF-DONES y, si se ubica en Europa, España es uno de los candidatos para albergarla.

Llega el momento

Boro 11 e Hidrógeno, otra vía para la fusión nuclear.

En opinión de Knaster, el momento que vaticinó Artsimovich está muy próximo, la humanidad está empezando a necesitar la energía de fusión. “Ya hay un consenso sobre el impacto que tienen los combustibles fósiles en el cambio climático y las energías renovables llegan hasta donde llegan, ningún país basará jamás su modelo energético en ellas, por la noche no hay sol y los vientos no son constantes, es necesario un suministro estable”, comenta.

Ante este panorama, la actual energía nuclear de fisión es “un mal menor” que no deja de implicar riesgos, como bien saben en Japón tras los sucesos de Fukushima, y que depende de las reservas de uranio, no muy abundantes. Por el contrario, un reactor de fusión es “como un inmenso microondas”, no puede desencadenar la reacción en cadena descontrolada característica de los accidentes nucleares, no deja desechos radiactivos de larga duración y utiliza combustibles económicos y casi inagotables.

La Publicación es del Diario El Español. Sólo he añadido algunas imágenes para hacerlo más ameno, y, algún que otro comentario que redsondea la noticia.

Ene

15

Velocidades inimaginables

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (2)

Comments (2)

En el centro del átomo se encuentra un pequeño grano compacto aproximadamente 100.000 veces más pequeño que el propio átomo: el núcleo atómico. Su masa, e incluso más aún su carga eléctrica, determinan las propiedades del átomo del cual forma parte. Debido a la solidez del núcleo parece que los átomos, que dan forma a nuestro mundo cotidiano, son intercambiables entre sí, e incluso cuando interaccionan entre ellos para formar sustancias químicas (los elementos). Pero el núcleo, a pesar de ser tan sólido, puede partirse. Si dos átomos chocan uno contra el otro con gran velocidad podría suceder que los núcleos llegaran a chocar entre sí y entonces, o bien se rompen en trozos, o se funden liberando en el proceso partículas subnucleares. La nueva física de la primera mitad del siglo XX estuvo dominada por los nuevos acertijos que estas partículas planteaban.

Pero tenemos la mecánica cuántica; ¿es que no es aplicable siempre?, ¿cuál es la dificultad? Desde luego, la mecánica cuántica es válida para las partículas subatómicas, pero hay más que eso. Las fuerzas con que estas partículas interaccionan y que mantienen el núcleo atómico unido son tan fuertes que las velocidades a las que tienen que moverse dentro y fuera del núcleo están cerca de la velocidad de la luz, c, que es de 299.792’458 Km/s. Cuando tratamos con velocidades tan altas se necesita una segunda modificación a las leyes de la física del siglo XIX; tenemos que contar con la teoría de la relatividad especial de Einstein.

Esta teoría también fue el resultado de una publicación de Einstein de 1905. en esta teoría quedaron sentadas las bases de que el movimiento y el reposo son conceptos relativos, no son absolutos, como tampoco habrá un sistema de referencia absoluto con respecto al cual uno pueda medir la velocidad de la luz.

Pero había más cosas que tenían que ser relativas. En este teoría, la masa y la energía también dependen de la velocidad, como lo hacen la intensidad del campo eléctrico y del magnético. Einstein descubrió que la masa de una partícula es siempre proporcional a la energía que contienen, supuesto que se haya tenido en cuenta una gran cantidad de energía en reposo de una partícula cualquiera, como se denota a continuación:

E = mc2

Como la velocidad de la luz es muy grande, esta ecuación sugiere que cada partícula debe almacenar una cantidad enorme de energía, y en parte esta predicción fue la que hizo que la teoría de la relatividad tuviese tanta importancia para la física (¡y para todo el mundo!). Para que la teoría de la relatividad también sea autoconsistente tiene que ser holista, esto es, que todas las cosas y todo el mundo obedezcan a las leyes de la relatividad. No son sólo los relojes los que se atrasan a grandes velocidades, sino que todos los procesos animados se comportan de la forma tan inusual que describe esta teoría cuando nos acercamos a la velocidad de la luz. El corazón humano es simplemente un reloj biológico y latirá a una velocidad menor cuando viaje en un vehículo espacial a velocidades cercanas a la de la luz. Este extraño fenómeno conduce a lo que se conoce como la “paradoja de los gemelos”, sugerida por Einstein, en la que dos gemelos idénticos tienen diferente edad cuando se reencuentran después de que uno haya permanecido en la Tierra mientras que el otro ha viajado a velocidades relativistas.

Einstein comprendió rápidamente que las leyes de la gravedad también tendrían que ser modificadas para que cumplieran el principio relativista.

La formulación de newton es bien conocida, en la segunda imagen que se representan en este esquema dos partículas que se acercan entre sí siguiendo un movimiento acelerado. La interpretación newtoniana supone que el espacio-tiempo es llano y que lo que provoca la curvatura de las líneas de universo es la fuerza de interacción gravitatoria entre ambas partículas. Por el contrario, la interpretación einsteiniana supone que las líneas de universo de estas partículas son geodésicas (“rectas”), y que es la propia curvatura del espacio tiempo lo que provoca su aproximación progresiva.

Para poder aplicar el principio de la relatividad a la fuerza gravitatoria, el principio tuvo que ser extendido de la siguiente manera: no sólo debe ser imposible determinar la velocidad absoluta del laboratorio, sino que también es imposible distinguir los cambios de velocidad de los efectos de una fuerza gravitatoria.

Einstein comprendió que la consecuencia de esto era que la gravedad hace al espacio-tiempo lo que la humedad a una hoja de papel: deformar la superficie con desigualdades que no se pueden eliminar. Hoy en día se conocen muy bien las matemáticas de los espacios curvos, pero en el época de Einstein el uso de estas nociones matemáticas tan abstractas para formular leyes físicas era algo completamente nuevo, y le llevó varios años encontrar la herramienta matemática adecuada para formular su teoría general de la relatividad que describe cómo se curva el espacio en presencia de grandes masas como planetas y estrellas.

Einstein tenía la idea en su mente desde 1907 (la relatividad especial la formuló en 1905), y se pasó 8 años buscando las matemáticas adecuadas para su formulación.

Leyendo el material enviado por un amigo al que pidió ayuda, Einstein quedó paralizado. Ante él, en la primera página de una conferencia dada ante el Sindicato de Carpinteros, 60 años antes por un tal Riemann, tenía la solución a sus desvelos: el tensor métrico de Riemann, que le permitiría utilizar una geometría espacial de los espacios curvos que explicaba su relatividad general.

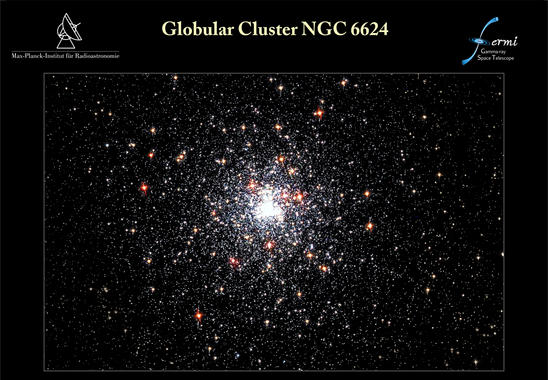

Desde que se puso en órbita el telescopio espacial de rayos gamma Fermi, el 11 de junio de 2008, ha detectado poblaciones enteras de objetos nunca antes vistos. El último hallazgo de Fermi afecta al púlsar J1823-3021A, avistado en 1994 con el radiotelescopio Lovell, en Inglaterra. Un equipo internacional de expertos se ha dado cuenta de que esta estrella pulsante emite rayos gamma y gracias a Fermi ha podido caracterizar sus inusuales propiedades. Los resultados de su investigación se publican en el último número de Science. Lo cierto es que han descubierto el púlsar de milisegundos más joven y con la fuerza magnética más potente

No está mal que en este punto recordemos la fuerza magnética y gravitatoria que nos puede ayudar a comprender mejor el comportamiento de las partículas subatómicas.

El electromagnetismo, decíamos al principio, es la fuerza con la cual dos partículas cargadas eléctricamente se repelen (si sus cargas son iguales) o se atraen (si tienen cargas de signo opuesto).

La interacción magnética es la fuerza que experimenta una partícula eléctricamente cargada que se mueve a través de un campo magnético. Las partículas cargadas en movimiento generan un campo magnético como, por ejemplo, los electrones que fluyen a través de las espiras de una bobina.

Las fuerzas magnéticas y eléctricas están entrelazadas. En 1873, James Clerk Maxwell consiguió formular las ecuaciones completas que rigen las fuerzas eléctricas y magnéticas, descubiertas experimentalmente por Michael Faraday. Se consiguió la teoría unificada del electromagnetismo que nos vino a decir que la electricidad y el magnetismo eran dos aspectos de una misma cosa.

La interacción es universal, de muy largo alcance (se extiende entre las estrellas), es bastante débil. Su intensidad depende del cociente entre el cuadrado de la carga del electrón y 2hc (dos veces la constante de Planck por la velocidad de la luz). Esta fracción es aproximadamente igual a 1/137’036…, o lo que llamamos α y se conoce como constante de estructura fina.

En general, el alcance de una interacción electromagnética es inversamente proporcional a la masa de la partícula mediadora, en este caso, el fotón, sin masa.

También antes hemos comentado sobre la interacción gravitatoria de la que Einstein descubrió su compleja estructura y la expuso al mundo en 1915 con el nombre de teoría general de la relatividad, y la relacionó con la curvatura del espacio y el tiempo. Sin embargo, aún no sabemos cómo se podrían reconciliar las leyes de la gravedad y las leyes de la mecánica cuántica (excepto cuando la acción gravitatoria es suficientemente débil).

La teoría de Einstein nos habla de los planetas y las estrellas del cosmos. La teoría de Planck, Heisemberg, Schrödinger, Dirac, Feynman y tantos otros, nos habla del comportamiento del átomo, del núcleo, de las partículas elementales en relación a estas interacciones fundamentales. La primera se ocupa de los cuerpos muy grandes y de los efectos que causan en el espacio y en el tiempo; la segunda de los cuerpos muy pequeños y de su importancia en el universo atómico. Cuando hemos tratado de unir ambos mundos se produce una gran explosión de rechazo. Ambas teorías son (al menos de momento) irreconciliables.

- La interacción gravitatoria actúa exclusivamente sobre la masa de una partícula.

- La gravedad es de largo alcance y llega a los más lejanos confines del universo conocido.

- Es tan débil que, probablemente, nunca podremos detectar esta fuerza de atracción gravitatoria entre dos partículas elementales. La única razón por la que podemos medirla es debido a que es colectiva: todas las partículas (de la Tierra) atraen a todas las partículas (de nuestro cuerpo) en la misma dirección.

La partícula mediadora es el hipotético gravitón. Aunque aún no se ha descubierto experimentalmente, sabemos lo que predice la mecánica cuántica: que tiene masa nula y espín 2.

La ley general para las interacciones es que, si la partícula mediadora tiene el espín par, la fuerza entre cargas iguales es atractiva y entre cargas opuestas repulsiva. Si el espín es impar (como en el electromagnetismo) se cumple a la inversa.

Pero antes de seguir profundizando en estas cuestiones hablemos de las propias partículas subatómicas, para lo cual la teoría de la relatividad especial, que es la teoría de la relatividad sin fuerza gravitatoria, es suficiente.

Si viajamos hacia lo muy pequeño tendremos que ir más allá de los átomos, que son objetos voluminosos y frágiles comparados con lo que nos ocupará a continuación: el núcleo atómico y lo que allí se encuentra. Los electrones, que ahora vemos “a gran distancia” dando vueltas alrededor del núcleo, son muy pequeños y extremadamente robustos. El núcleo está constituido por dos especies de bloques: protones y neutrones. El protón (del griego πρώτος, primero) debe su nombre al hecho de que el núcleo atómico más sencillo, que es el hidrógeno, está formado por un solo protón. Tiene una unidad de carga positiva. El neutrón recuerda al protón como si fuera su hermano gemelo: su masa es prácticamente la misma, su espín es el mismo, pero en el neutrón, como su propio nombre da a entender, no hay carga eléctrica; es neutro.

La masa de estas partículas se expresa en una unidad llamada mega-electrón-voltio o MeV, para abreviar. Un MeV, que equivale a 106 electrón-voltios, es la cantidad de energía de movimiento que adquiere una partícula con una unidad de carga (tal como un electrón o un protón) cuando atraviesa una diferencia de potencial de 106 (1.000.000) voltios. Como esta energía se transforma en masa, el MeV es una unidad útil de masa para las partículas elementales.

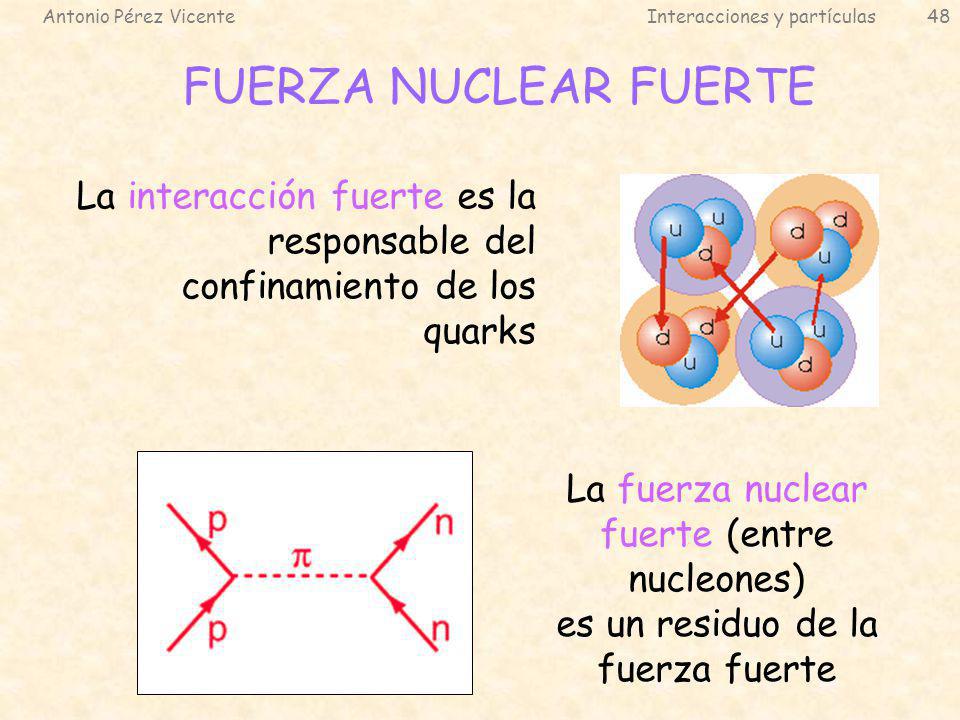

La mayoría de los núcleos atómicos contienen más neutrones que protones. Los protones se encuentran tan juntos en el interior de un núcleo tan pequeño que se deberían repeles entre sí fuertemente, debido a que tienen cargas eléctricas del mismo signo. Sin embargo, hay una fuerza que los mantiene unidos estrechamente y que es mucho más potente e intensa que la fuerza electromagnética: la fuerza o interacción nuclear fuerte, unas 102 veces mayor que la electromagnética, y aparece sólo entre hadrones para mantener a los nucleones confinados dentro del núcleo. Actúa a una distancia tan corta como 10-15 metros, o lo que es lo mismo, 0’000000000000001 metros.

La interacción fuerte está mediada por el intercambio de mesones virtuales, 8 gluones que, como su mismo nombre indica (glue en inglés es pegamento), mantiene a los protones y neutrones bien sujetos en el núcleo, y cuanto más se tratan de separar, más aumenta la fuerza que los retiene, que crece con la distancia, al contrario que ocurre con las otras fuerzas.

La luz es una manifestación del fenómeno electromagnético y está cuantizada en “fotones”, que se comportan generalmente como los mensajeros de todas las interacciones electromagnéticas. Así mismo, como hemos dejado reseñado en el párrafo anterior, la interacción fuerte también tiene sus cuantos (los gluones). El físico japonés Hideki Yukawa (1907 – 1981) predijo la propiedad de las partículas cuánticas asociadas a la interacción fuerte, que más tarde se llamarían piones. Hay una diferencia muy importante entre los piones y los fotones: un pión es un trozo de materia con una cierta cantidad de “masa”. Si esta partícula está en reposo, su masa es siempre la misma, aproximadamente 140 MeV, y si se mueve muy rápidamente, su masa parece aumentar en función E = mc2. Por el contrario, se dice que la masa del fotón en reposo es nula. Con esto no decimos que el fotón tenga masa nula, sino que el fotón no puede estar en reposo. Como todas las partículas de masa nula, el fotón se mueve exclusivamente con la velocidad de la luz, 299.792’458 Km/s, una velocidad que el pión nunca puede alcanzar porque requeriría una cantidad infinita de energía cinética. Para el fotón, toda su masa se debe a su energía cinética.

Los físicos experimentales buscaban partículas elementales en las trazas de los rayos cósmicos que pasaban por aparatos llamados cámaras de niebla. Así encontraron una partícula coincidente con la masa que debería tener la partícula de Yukawa, el pión, y la llamaron mesón (del griego medio), porque su masa estaba comprendida entre la del electrón y la del protón. Pero detectaron una discrepancia que consistía en que esta partícula no era afectada por la interacción fuerte, y por tanto, no podía ser un pión. Actualmente nos referimos a esta partícula con la abreviatura μ y el nombre de muón, ya que en realidad era un leptón, hermano gemelo del electrón, pero con 200 veces su masa.

Antes de seguir veamos las partículas elementales de vida superior a 10-20 segundos que eran conocidas en el año 1970.

| Nombre | Símbolo | Masa (MeV) | Carga | Espín | Vida media (s) |

| Fotón | γ | 0 | 0 | 1 | ∞ |

| Leptones (L = 1, B = 0) | |||||

| Electrón | e– | 0’5109990 | – | ½ | ∞ |

| Muón | μ– | 105’6584 | – | ½ | 2’1970 × 10-6 |

| Tau | τ | ||||

| Neutrino electrónico | νe | ~ 0 | 0 | ½ | ~ ∞ |

| Neutrino muónico | νμ | ~ 0 | 0 | ½ | ~ ∞ |

| Neutrino tauónico | ντ | ~ 0 | 0 | ½ | ~ ∞ |

| Mesones (L = 0, B = 0) | |||||

| Pión + | π+ | 139’570 | 2’603 × 10-8 | ||

| Pión – | π– | 139’570 | 2’603 × 10-8 | ||

| Pión 0 | π0 | 134’976 | 0’84 × 10-16 | ||

| Kaón + | k+ | 493’68 | 1’237 × 10-8 | ||

| Kaón – | k– | 493’68 | 1’237 × 10-8 | ||

| Kaón largo | kL | 497’7 | 5’17 × 10-8 | ||

| Kaón corto | kS | 497’7 | 0’893 × 10-10 | ||

| Eta | η | 547’5 | 0 | 0 | 5’5 × 10-19 |

| Bariones (L = 0, B = 1) | |||||

| Protón | p | 938’2723 | + | ½ | ∞ |

| Neutrón | n | 939’5656 | 0 | ½ | 887 |

| Lambda | Λ | 1.115’68 | 0 | ½ | 2’63 × 10-10 |

| Sigma + | Σ+ | 1.189’4 | + | ½ | 0’80 × 10-10 |

| Sigma – | Σ– | 1.1974 | – | ½ | 7’4× 10-20 |

| Sigma 0 | Σ0 | 0 | ½ | 1’48 × 10-10 | |

| Ksi 0 | Ξ0 | 1.314’9 | 0 | ½ | 2’9 × 10-10 |

| Ksi – | Ξ– | 1.321’3 | – | ½ | 1’64 × 10-10 |

| Omega – | Ω– | 1.672’4 | – | 1½ | 0’82 × 10-10 |

Para cada leptón y cada barión existe la correspondiente antipartícula, con exactamente las mismas propiedades a excepción de la carga que es la contraria. Por ejemplo, el antiprotón se simboliza con y el electrón con e+. Los mesones neutros son su propia antipartícula, y el π+ es la antipartícula del π–, al igual que ocurre con k+ y k–. El símbolo de la partícula es el mismo que el de su antipartícula con una barra encima. Las masas y las vidas medias aquí reflejadas pueden estar corregidas en este momento, pero de todas formas son muy aproximadas.

Los símbolos que se pueden ver algunas veces, como s (extrañeza) e i (isoespín) están referidos a datos cuánticos que afectan a las partículas elementales en sus comportamientos.

Debo admitir que todo esto tiene que sonar algo misterioso. Es difícil explicar estos temas por medio de la simple palabra escrita sin emplear la claridad que transmiten las matemáticas, lo que, por otra parte, es un mundo secreto para el común de los mortales, y ese lenguaje es sólo conocido por algunos privilegiados que, mediante un sistema de ecuaciones pueden ver y entender de forma clara, sencilla y limpia, todas estas complejas cuestiones.

Si hablamos del espín (o, con más precisión, el momento angular, que es aproximadamente la masa por el radio por la velocidad de rotación) se puede medir como un múltiplo de la constante de Planck, h, dividido por 2π. Medido en esta unidad y de acuerdo con la mecánica cuántica, el espín de cualquier objeto tiene que ser o un entero o un entero más un medio. El espín total de cada tipo de partícula – aunque no la dirección del mismo – es fijo.

El electrón, por ejemplo, tiene espín ½. Esto lo descubrieron dos estudiantes holandeses, Samuel Gondsmit (1902 – 1978) y George Uhlenbeck (1900 – 1988), que escribieron sus tesis conjuntamente sobre este problema en 1972. Fue una idea audaz que partículas tan pequeñas como los electrones pudieran tener espín, y de hecho, bastante grande. Al principio, la idea fue recibida con escepticismo porque la “superficie del electrón” se tendría que mover con una velocidad 137 veces mayor que la de la luz, lo cual va en contra de la teoría de la relatividad general en la que está sentado que nada en el universo va más rápido que la luz, y por otra parte, contradice E=mc2, y el electrón pasada la velocidad de la luz tendría una masa infinita.

Hoy día, sencillamente, tal observación es ignorada, toda vez que el electrón carece de superficie.

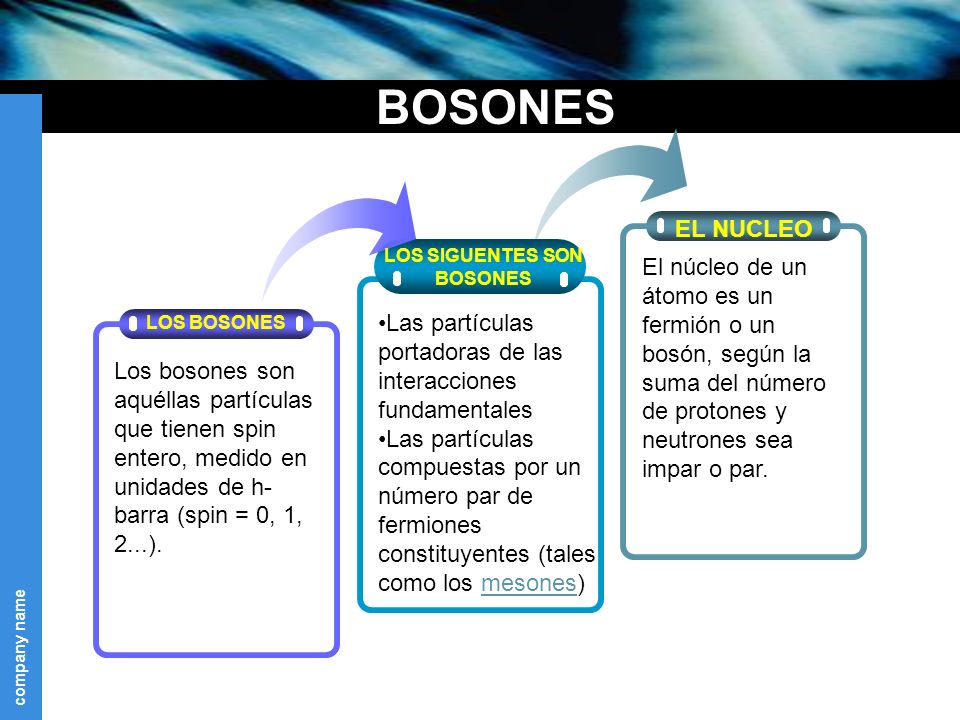

Las partículas con espín entero se llaman bosones, y las que tienen espín entero más un medio se llaman fermiones. Consultado los valores del espín en la tabla anterior podemos ver que los leptones y los bariones son fermiones, y que los mesones y los fotones son bosones. En muchos aspectos, los fermiones se comportan de manera diferente de los bosones. Los fermiones tienen la propiedad de que cada uno de ellos requiere su propio espacio: dos fermiones del mismo tipo no pueden ocupar o estar en el mismo punto, y su movimiento está regido por ecuaciones tales que se evitan unos a otros. Curiosamente, no se necesita ninguna fuerza para conseguir esto. De hecho, las fuerzas entre los fermiones pueden ser atractivas o repulsivas, según las cargas. El fenómeno por el cual cada fermión tiene que estar en un estado diferente se conoce como el principio de exclusión de Pauli. Cada átomo está rodeado de una nube de electrones, que son fermiones (espín ½). Si dos átomos se aproximan entre sí, los electrones se mueven de tal manera que las dos nubes se evitan una a otra, dando como resultado una fuerza repulsiva. Cuando aplaudimos, nuestras manos no se atraviesan pasando la uno a través de la otra. Esto es debido al principio de exclusión de Pauli para los electrones de nuestras manos que, de hecho, los de la izquierda rechazan a los de la derecha.

En contraste con el característico individualismo de los fermiones, los bosones se comportan colectivamente y les gusta colocarse todos en el mismo lugar. Un láser, por ejemplo, produce un haz de luz en el cual muchísimos fotones llevan la misma longitud de onda y dirección de movimiento. Esto es posible porque los fotones son bosones.

Cuando hemos hablado de las fuerzas fundamentales que, de una u otra forma, interaccionan con la materia, también hemos explicado que la interacción débil es la responsable de que muchas partículas y también muchos núcleos atómicos exóticos sean inestables. La interacción débil puede provocar que una partícula se transforme en otra relacionada, por emisión de un electrón y un neutrino. Enrico Fermi, en 1934, estableció una fórmula general de la interacción débil, que fue mejorada posteriormente por George Sudarshan, Robert Marschak, Murray Gell-Mann, Richard Feynman y otros. La fórmula mejorada funciona muy bien, pero se hizo evidente que no era adecuada en todas las circunstancias.

Uno de los protones se transmuta en un neutrón por medio de la interacción débil, transformando un quark “up”, en “down”. Este proceso consume energía (el neutrón tiene ligeramente más masa que..

En 1970, de las siguientes características de la interacción débil sólo se conocían las tres primeras:

- La interacción actúa de forma universal sobre muchos tipos diferentes de partículas y su intensidad es aproximadamente igual para todas (aunque sus efectos pueden ser muy diferentes en cada caso). A los neutrinos les afecta exclusivamente la interacción débil.

- Comparada con las demás interacciones, ésta tiene un alcance muy corto.

- La interacción es muy débil. Consecuentemente, los choques de partículas en los cuales hay neutrinos involucrados son tan poco frecuentes que se necesitan chorros muy intensos de neutrinos para poder estudiar tales sucesos.

- Los mediadores de la interacción débil, llamados W+, W– y Z0, no se detectaron hasta la década de 1980. al igual que el fotón, tienen espín 1, pero están eléctricamente cargados y son muy pesados (esta es la causa por la que el alcance de la interacción es tan corto). El tercer mediador, Z0, que es responsable de un tercer tipo de interacción débil que no tiene nada que ver con la desintegración de las partículas llamada “corriente neutra”, permite que los neutrinos puedan colisionar con otras partículas sin cambiar su identidad.

A partir de 1970, quedó clara la relación de la interacción débil y la electromagnética (electrodébil de Weinberg-Salam).

La interacción fuerte (como hemos dicho antes) sólo actúa entre las partículas que clasificamos en la familia llamada de los hadrones, a los que proporciona una estructura interna complicada. Hasta 1972 sólo se conocían las reglas de simetría de la interacción fuerte y no fuimos capaces de formular las leyes de la interacción con precisión.

Como apuntamos, el alcance de esta interacción no va más allá del radio de un núcleo atómico ligero (10-13 cm aproximadamente).

La interacción es fuerte. En realidad, la más fuerte de todas.

Lo dejaré aquí, en verdad, eso que el Modelo Estándar de la Física, es feo, complejo e incompleto y, aunque hasta el momento es una buena herramienta con la que trabajar, la verdad es que, se necesita un nuevo modelo más avanzado y que incluya la Gravedad.

Veremos que nos trae la nueva etapa del LHC.

emilio silvera

Totales: 83.731.523

Totales: 83.731.523 Conectados: 70

Conectados: 70