Ago

31

Velocidades inimaginables

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

https://youtu.be/6z5AIQ7AmK8

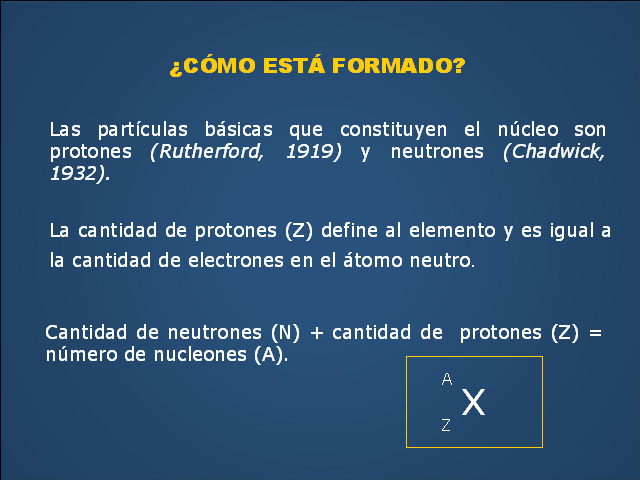

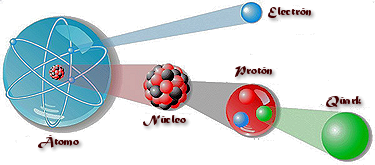

En el centro del átomo se encuentra un pequeño grano compacto aproximadamente 100.000 veces más pequeño que el propio átomo: el núcleo atómico. Su masa, e incluso más aún su carga eléctrica, determinan las propiedades del átomo del cual forma parte. Debido a la solidez del núcleo parece que los átomos, que dan forma a nuestro mundo cotidiano, son intercambiables entre sí, e incluso cuando interaccionan entre ellos para formar sustancias químicas (los elementos). Pero el núcleo, a pesar de ser tan sólido, puede partirse. Si dos átomos chocan uno contra el otro con gran velocidad podría suceder que los núcleos llegaran a chocar entre sí y entonces, o bien se rompen en trozos, o se funden liberando en el proceso partículas sub-nucleares. La nueva física de la primera mitad del siglo XX estuvo dominada por los nuevos acertijos que estas partículas planteaban.

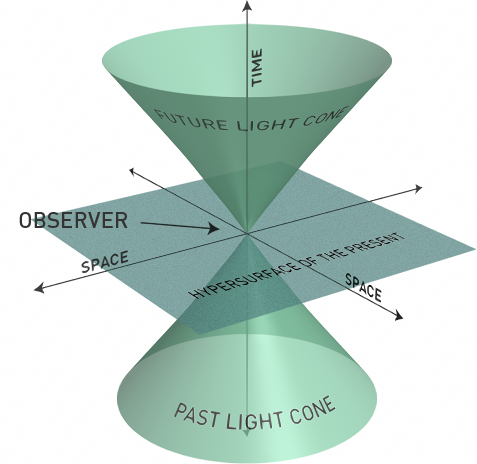

Pero tenemos la mecánica cuántica; ¿es que no es aplicable siempre?, ¿Cuál es la dificultad? Desde luego, la mecánica cuántica es válida para las partículas subatómicas, pero hay más que eso. Las fuerzas con que estas partículas interaccionan y que mantienen el núcleo atómico unido son tan fuertes que las velocidades a las que tienen que moverse dentro y fuera del núcleo están cerca de la velocidad de la luz, c, que es de 299.792’458 Km/s. Cuando tratamos con velocidades tan altas se necesita una segunda modificación a las leyes de la física del siglo XIX; tenemos que contar con la teoría de la relatividad especial de Einstein.

Esta teoría también fue el resultado de una publicación de Einstein de 1905. en esta teoría quedaron sentadas las bases de que el movimiento y el reposo son conceptos relativos, no son absolutos, como tampoco habrá un sistema de referencia absoluto con respecto al cual uno pueda medir la velocidad de la luz.

Pero había más cosas que tenían que ser relativas. En este teoría, la masa y la energía también dependen de la velocidad, como lo hacen la intensidad del campo eléctrico y del magnético. Einstein descubrió que la masa de una partícula es siempre proporcional a la energía que contienen, supuesto que se haya tenido en cuenta una gran cantidad de energía en reposo de una partícula cualquiera, como se denota a continuación:

E = mc2

Como la velocidad de la luz es muy grande, esta ecuación sugiere que cada partícula debe almacenar una cantidad enorme de energía, y en parte esta predicción fue la que hizo que la teoría de la relatividad tuviese tanta importancia para la física (¡y para todo el mundo!). Para que la teoría de la relatividad también sea auto-consistente tiene que ser holista, esto es, que todas las cosas y todo el mundo obedezcan a las leyes de la relatividad. No son sólo los relojes los que se atrasan a grandes velocidades, sino que todos los procesos animados se comportan de la forma tan inusual que describe esta teoría cuando nos acercamos a la velocidad de la luz. El corazón humano es simplemente un reloj biológico y latirá a una velocidad menor cuando viaje en un vehículo espacial a velocidades cercanas a la de la luz. Este extraño fenómeno conduce a lo que se conoce como la “paradoja de los gemelos”, sugerida por Einstein, en la que dos gemelos idénticos tienen diferente edad cuando se reencuentran después de que uno haya permanecido en la Tierra mientras que el otro ha viajado a velocidades relativistas.

Einstein comprendió rápidamente que las leyes de la gravedad también tendrían que ser modificadas para que cumplieran el principio relativista.

Para poder aplicar el principio de la relatividad a la fuerza gravitatoria, el principio tuvo que ser extendido de la siguiente manera: no sólo debe ser imposible determinar la velocidad absoluta del laboratorio, sino que también es imposible distinguir los cambios de velocidad de los efectos de una fuerza gravitatoria.

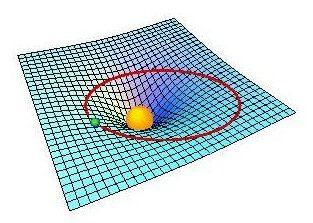

Einstein comprendió que la consecuencia de esto era que la gravedad hace al espacio-tiempo lo que la humedad a una hoja de papel: deformar la superficie con desigualdades que no se pueden eliminar. Hoy en día se conocen muy bien las matemáticas de los espacios curvos, pero en el época de Einstein el uso de estas nociones matemáticas tan abstractas para formular leyes físicas era algo completamente nuevo, y le llevó varios años encontrar la herramienta matemática adecuada para formular su teoría general de la relatividad que describe cómo se curva el espacio en presencia de grandes masas como planetas y estrellas.

Einstein tenía la idea en su mente desde 1907 (la relatividad especial la formuló en 1905), y se pasó 8 años buscando las matemáticas adecuadas para su formulación.

En geometría de Riemann, el tensor métrico es un tensor de rango 2 que se utiliza para definir conceptos métricos como distancia, ángulo y volumen en un espacio localmente euclídeo. Paraboloide de Flamm (solución exterior de Schwarzschild)

Leyendo el material enviado por un amigo al que pidió ayuda, Einstein quedó paralizado. Ante él, en la primera página de una conferencia dada ante el Sindicato de Carpinteros, 60 años antes por un tal Riemann, tenía la solución a sus desvelos: el tensor métrico de Riemann, que le permitiría utilizar una geometría espacial de los espacios curvos que explicaba su relatividad general.

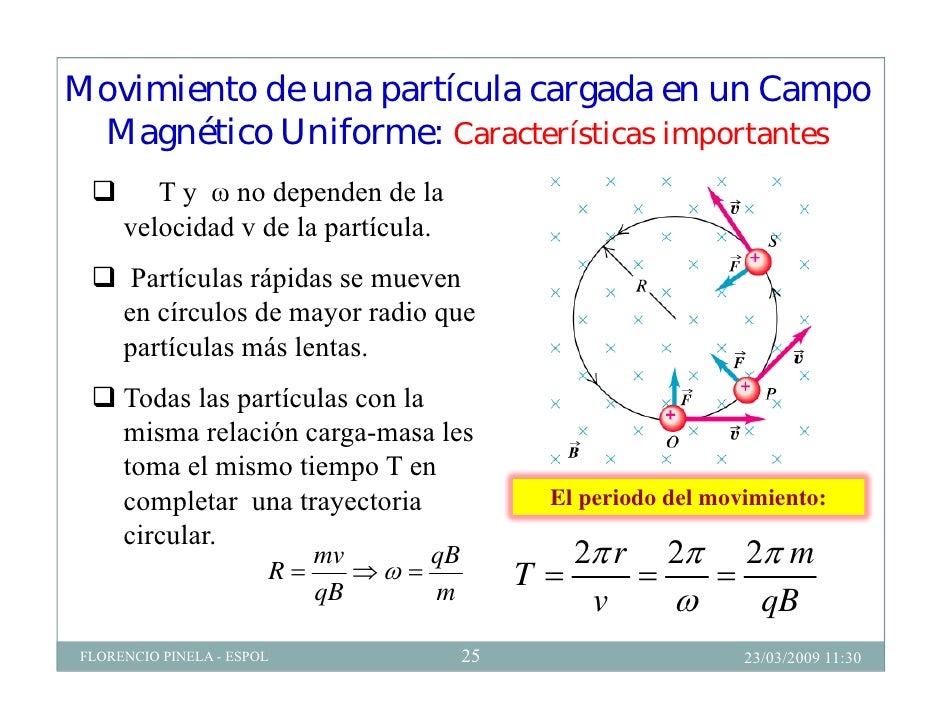

No está mal que en este punto recordemos la fuerza magnética y gravitatoria que nos puede ayudar a comprender mejor el comportamiento de las partículas subatómicas.

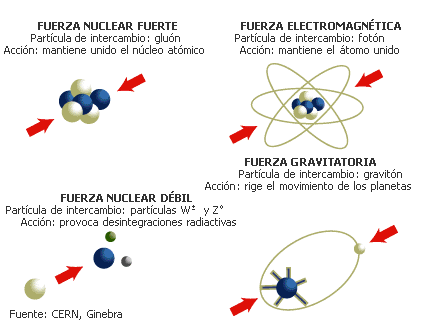

El electromagnetismo, decíamos al principio, es la fuerza con la cual dos partículas cargadas eléctricamente se repelen (si sus cargas son iguales) o se atraen (si tienen cargas de signo opuesto).

La interacción magnética es la fuerza que experimenta una partícula eléctricamente cargada que se mueve a través de un campo magnético. Las partículas cargadas en movimiento generan un campo magnético como, por ejemplo, los electrones que fluyen a través de las espiras de una bobina.

Las fuerzas magnéticas y eléctricas están entrelazadas. En 1873, James Clerk Maxwell consiguió formular las ecuaciones completas que rigen las fuerzas eléctricas y magnéticas, descubiertas experimentalmente por Michael Faraday. Se consiguió la teoría unificada del electromagnetismo que nos vino a decir que la electricidad y el magnetismo eran dos aspectos de una misma cosa.

¿Qué dicen?

La electricidad y el magnetismo no pueden desvanecerse sin más. Una región de un campo eléctrico girando crea un campo magnético perpendicular al giro. Una región de un campo magnético girando crea un campo eléctrico perpendicular al giro, pero en el sentido opuesto.

¿Por qué es importante?

Fue la primera unificación importante de fuerzas físicas, mostrando que la electricidad y el magnetismo están íntimamente interrelacionados, o, son dos aspectos diferentes de la misma cosa.

¿Qué provocó?

La predicción de que las ondas electromagnéticas existen, desplazándose a la velocidad de la luz, de modo que la propia luz es una de dichas ondas. Esto motivó la invención de la radio, el radar, la televisión, las conexiones inalámbricas para los ordenadores y la mayoría de las comunicaciones modernas.

La interacción es universal, de muy largo alcance (se extiende entre las estrellas), es bastante débil. Su intensidad depende del cociente entre el cuadrado de la carga del electrón y 2hc (dos veces la constante de Planck por la velocidad de la luz). Esta fracción es aproximadamente igual a 1/137’036…, o lo que llamamos Alfa (α) y se conoce como constante de estructura fina.

En general, el alcance de una interacción electromagnética es inversamente proporcional a la masa de la partícula mediadora, en este caso, el fotón, sin masa.

También antes hemos comentado sobre la interacción gravitatoria de la que Einstein descubrió su compleja estructura y la expuso al mundo en 1915 con el nombre de teoría general de la relatividad, y la relacionó con la curvatura del espacio y el tiempo. Sin embargo, aún no sabemos cómo se podrían reconciliar las leyes de la gravedad y las leyes de la mecánica cuántica (excepto cuando la acción gravitatoria es suficientemente débil).

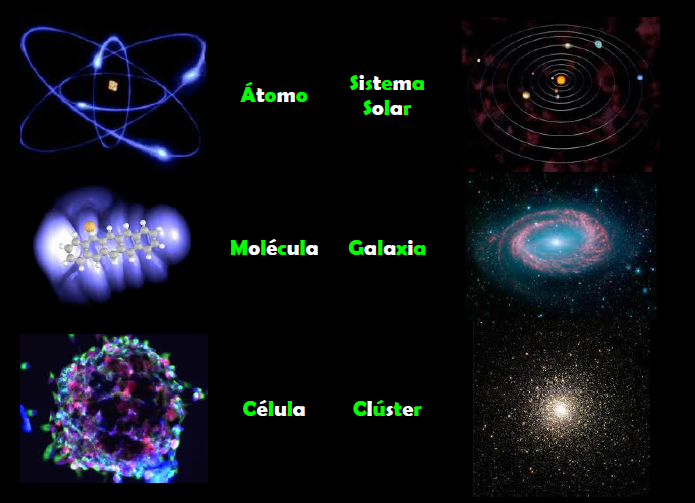

La teoría de Einstein nos habla de los planetas y las estrellas del cosmos. La teoría de Planck, Heisemberg, Schrödinger, Dirac, Feynman y tantos otros, nos habla del comportamiento del átomo, del núcleo, de las partículas elementales en relación a estas interacciones fundamentales. La primera se ocupa de los cuerpos muy grandes y de los efectos que causan en el espacio y en el tiempo; la segunda de los cuerpos muy pequeños y de su importancia en el universo atómico. Cuando hemos tratado de unir ambos mundos se produce una gran explosión de rechazo. Ambas teorías son (al menos de momento) irreconciliables.

- La interacción gravitatoria actúa exclusivamente sobre la masa de una partícula.

- La gravedad es de largo alcance y llega a los más lejanos confines del universo conocido.

- Es tan débil que, probablemente, nunca podremos detectar esta fuerza de atracción gravitatoria entre dos partículas elementales. La única razón por la que podemos medirla es debido a que es colectiva: todas las partículas (de la Tierra) atraen a todas las partículas (de nuestro cuerpo) en la misma dirección.

El gravitón hace tiempo que se ríe de nosotros…y se oculta donde no lo podamos ver

La partícula mediadora es el hipotético gravitón. Aunque aún no se ha descubierto experimentalmente, sabemos lo que predice la mecánica cuántica: que tiene masa nula y espín 2.

La ley general para las interacciones es que, si la partícula mediadora tiene el espín par, la fuerza entre cargas iguales es atractiva y entre cargas opuestas repulsiva. Si el espín es impar (como en el electromagnetismo) se cumple a la inversa.

Pero antes de seguir profundizando en estas cuestiones hablemos de las propias partículas subatómicas, para lo cual la teoría de la relatividad especial, que es la teoría de la relatividad sin fuerza gravitatoria, es suficiente.

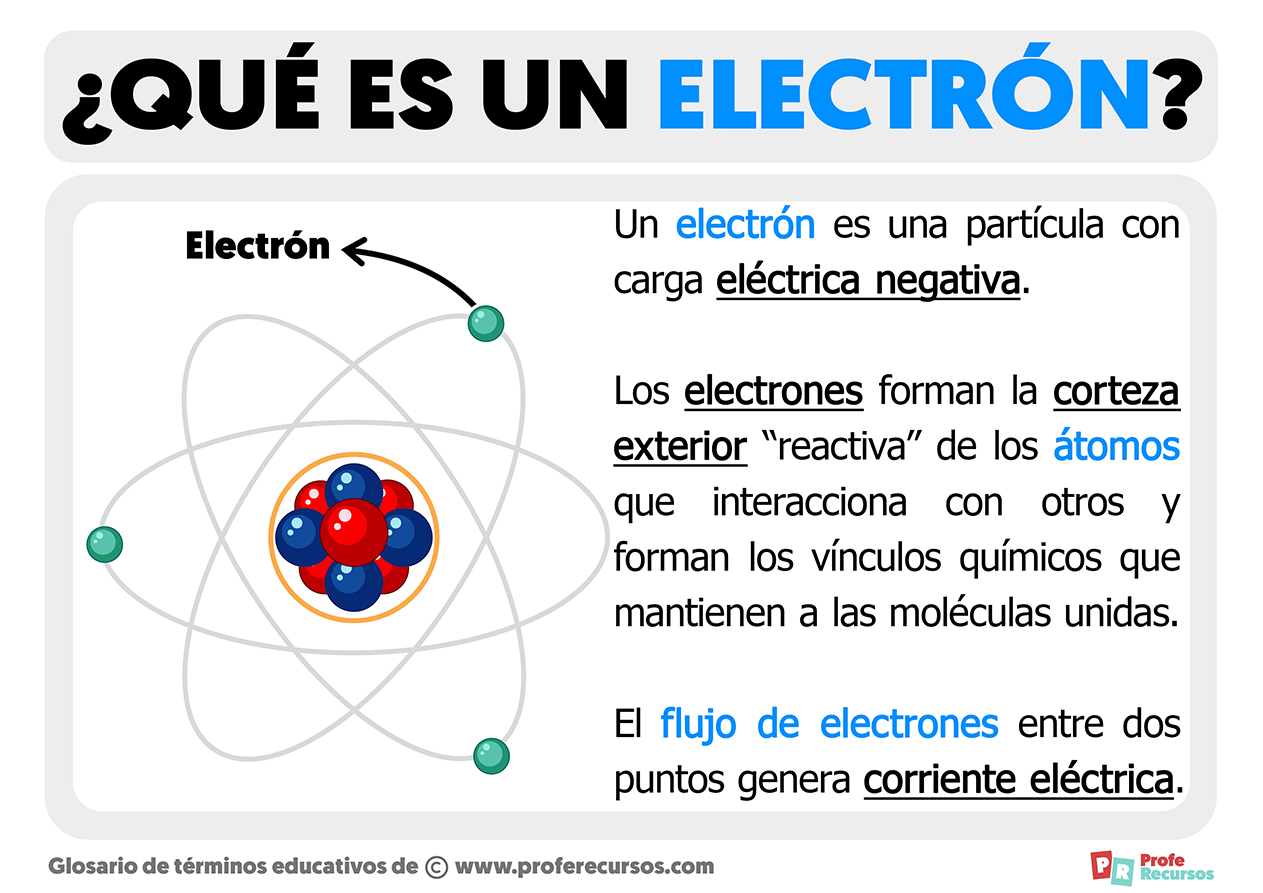

Si viajamos hacia lo muy pequeño tendremos que ir más allá de los átomos, que son objetos voluminosos y frágiles comparados con lo que nos ocupará a continuación: el núcleo atómico y lo que allí se encuentra. Los electrones, que ahora vemos “a gran distancia” dando vueltas alrededor del núcleo, son muy pequeños y extremadamente robustos. El núcleo está constituido por dos especies de bloques: protones y neutrones. El protón (del griego πρώτος, primero) debe su nombre al hecho de que el núcleo atómico más sencillo, que es el hidrógeno, está formado por un solo protón. Tiene una unidad de carga positiva. El neutrón recuerda al protón como si fuera su hermano gemelo: su masa es prácticamente la misma, su espín es el mismo, pero en el neutrón, como su propio nombre da a entender, no hay carga eléctrica; es neutro.

La masa de estas partículas se expresa en una unidad llamada mega-electrón-voltio o MeV, para abreviar. Un MeV, que equivale a 106 electrón-voltios, es la cantidad de energía de movimiento que adquiere una partícula con una unidad de carga (tal como un electrón o un protón) cuando atraviesa una diferencia de potencial de 106 (1.000.000) voltios. Como esta energía se transforma en masa, el MeV es una unidad útil de masa para las partículas elementales.

La mayoría de los núcleos atómicos contienen más neutrones que protones. Los protones se encuentran tan juntos en el interior de un núcleo tan pequeño que se deberían repeles entre sí fuertemente, debido a que tienen cargas eléctricas del mismo signo. Sin embargo, hay una fuerza que los mantiene unidos estrechamente y que es mucho más potente e intensa que la fuerza electromagnética: la fuerza o interacción nuclear fuerte, unas 102 veces mayor que la electromagnética, y aparece sólo entre hadrones para mantener a los nucleones confinados dentro del núcleo. Actúa a una distancia tan corta como 10-15 metros, o lo que es lo mismo, 0’000000000000001 metros.

La interacción fuerte está mediada por el intercambio de mesones virtuales, 8 gluones que, como su mismo nombre indica (glue en inglés es pegamento), mantiene a los protones y neutrones bien sujetos en el núcleo, y cuanto más se tratan de separar, más aumenta la fuerza que los retiene, que crece con la distancia, al contrario que ocurre con las otras fuerzas.

La luz es una manifestación del fenómeno electromagnético y está cuantizada en “fotones”, que se comportan generalmente como los mensajeros de todas las interacciones electromagnéticas. Así mismo, como hemos dejado reseñado en el párrafo anterior, la interacción fuerte también tiene sus cuantos (los gluones). El físico japonés Hideki Yukawa (1907 – 1981) predijo la propiedad de las partículas cuánticas asociadas a la interacción fuerte, que más tarde se llamarían piones. Hay una diferencia muy importante entre los piones y los fotones: un pión es un trozo de materia con una cierta cantidad de “masa”. Si esta partícula está en reposo, su masa es siempre la misma, aproximadamente 140 MeV, y si se mueve muy rápidamente, su masa parece aumentar en función E = mc2. Por el contrario, se dice que la masa del fotón en reposo es nula. Con esto no decimos que el fotón tenga masa nula, sino que el fotón no puede estar en reposo. Como todas las partículas de masa nula, el fotón se mueve exclusivamente con la velocidad de la luz, 299.792’458 Km/s, una velocidad que el pión nunca puede alcanzar porque requeriría una cantidad infinita de energía cinética. Para el fotón, toda su masa se debe a su energía cinética.

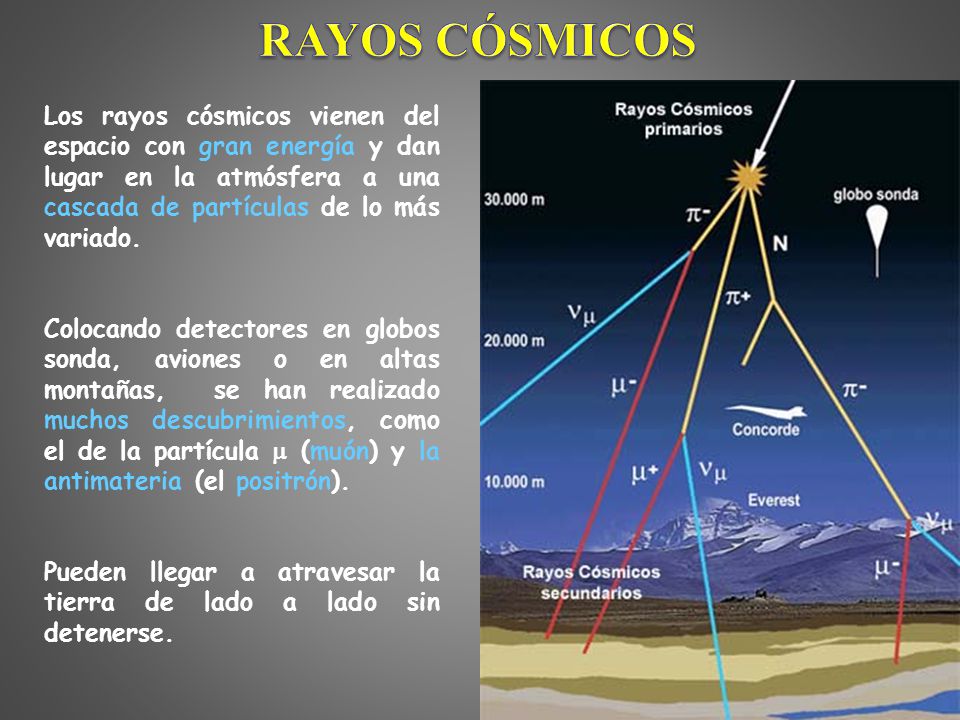

Los físicos experimentales buscaban partículas elementales en las trazas de los rayos cósmicos que pasaban por aparatos llamados cámaras de niebla. Así encontraron una partícula coincidente con la masa que debería tener la partícula de Yukawa, el pión, y la llamaron mesón (del griego medio), porque su masa estaba comprendida entre la del electrón y la del protón. Pero detectaron una discrepancia que consistía en que esta partícula no era afectada por la interacción fuerte, y por tanto, no podía ser un pión. Actualmente nos referimos a esta partícula con la abreviatura μ y el nombre de muón, ya que en realidad era un leptón, hermano gemelo del electrón, pero con 200 veces su masa.

Antes de seguir veamos las partículas elementales de vida superior a 10-20 segundos que eran conocidas en el año 1970.

| Nombre | Símbolo | Masa (MeV) | Carga | Espín | Vida media (s) |

| Fotón | γ | 0 | 0 | 1 | ∞ |

| Leptones (L = 1, B = 0) | |||||

| Electrón | e– | 0’5109990 | – | ½ | ∞ |

| Muón | μ– | 105’6584 | – | ½ | 2’1970 × 10-6 |

| Tau | τ | ||||

| Neutrino electrónico | νe | ~ 0 | 0 | ½ | ~ ∞ |

| Neutrino muónico | νμ | ~ 0 | 0 | ½ | ~ ∞ |

| Neutrino tauónico | ντ | ~ 0 | 0 | ½ | ~ ∞ |

| Mesones (L = 0, B = 0) | |||||

| Pión + | π+ | 139’570 | 2’603 × 10-8 | ||

| Pión – | π– | 139’570 | 2’603 × 10-8 | ||

| Pión 0 | π0 | 134’976 | 0’84 × 10-16 | ||

| Kaón + | k+ | 493’68 | 1’237 × 10-8 | ||

| Kaón – | k– | 493’68 | 1’237 × 10-8 | ||

| Kaón largo | kL | 497’7 | 5’17 × 10-8 | ||

| Kaón corto | kS | 497’7 | 0’893 × 10-10 | ||

| Eta | η | 547’5 | 0 | 0 | 5’5 × 10-19 |

| Bariones (L = 0, B = 1) | |||||

| Protón | p | 938’2723 | + | ½ | ∞ |

| Neutrón | n | 939’5656 | 0 | ½ | 887 |

| Lambda | Λ | 1.115’68 | 0 | ½ | 2’63 × 10-10 |

| Sigma + | Σ+ | 1.189’4 | + | ½ | 0’80 × 10-10 |

| Sigma – | Σ– | 1.1974 | – | ½ | 7’4× 10-20 |

| Sigma 0 | Σ0 | 0 | ½ | 1’48 × 10-10 | |

| Ksi 0 | Ξ0 | 1.314’9 | 0 | ½ | 2’9 × 10-10 |

| Ksi – | Ξ– | 1.321’3 | – | ½ | 1’64 × 10-10 |

| Omega – | Ω– | 1.672’4 | – | 1½ | 0’82 × 10-10 |

Para cada leptón y cada barión existe la correspondiente antipartícula, con exactamente las mismas propiedades a excepción de la carga que es la contraria. Por ejemplo, el antiprotón se simboliza con y el electrón con e+. Los mesones neutros son su propia antipartícula, y el π+ es la antipartícula del π–, al igual que ocurre con k+ y k–. El símbolo de la partícula es el mismo que el de su antipartícula con una barra encima. Las masas y las vidas medias aquí reflejadas pueden estar corregidas en este momento, pero de todas formas son muy aproximadas.

Los símbolos que se pueden ver algunas veces, como s (extrañeza) e i (isoespín) están referidos a datos cuánticos que afectan a las partículas elementales en sus comportamientos.

Debo admitir que todo esto tiene que sonar algo misterioso. Es difícil explicar estos temas por medio de la simple palabra escrita sin emplear la claridad que transmiten las matemáticas, lo que, por otra parte, es un mundo secreto para el común de los mortales, y ese lenguaje es sólo conocido por algunos privilegiados que, mediante un sistema de ecuaciones pueden ver y entender de forma clara, sencilla y limpia, todas estas complejas cuestiones.

Si hablamos del espín (o, con más precisión, el momento angular, que es aproximadamente la masa por el radio por la velocidad de rotación) se puede medir como un múltiplo de la constante de Planck, h, dividido por 2π. Medido en esta unidad y de acuerdo con la mecánica cuántica, el espín de cualquier objeto tiene que ser o un entero o un entero más un medio. El espín total de cada tipo de partícula – aunque no la dirección del mismo – es fijo.

El electrón, por ejemplo, tiene espín ½. Esto lo descubrieron dos estudiantes holandeses, Samuel Gondsmit (1902 – 1978) y George Uhlenbeck (1900 – 1988), que escribieron sus tesis conjuntamente sobre este problema en 1972. Fue una idea audaz que partículas tan pequeñas como los electrones pudieran tener espín, y de hecho, bastante grande. Al principio, la idea fue recibida con escepticismo porque la “superficie del electrón” se tendría que mover con una velocidad 137 veces mayor que la de la luz, lo cual va en contra de la teoría de la relatividad general en la que está sentado que nada en el universo va más rápido que la luz, y por otra parte, contradice E=mc2, y el electrón pasada la velocidad de la luz tendría una masa infinita.

Hoy día, sencillamente, tal observación es ignorada, toda vez que el electrón carece de superficie.

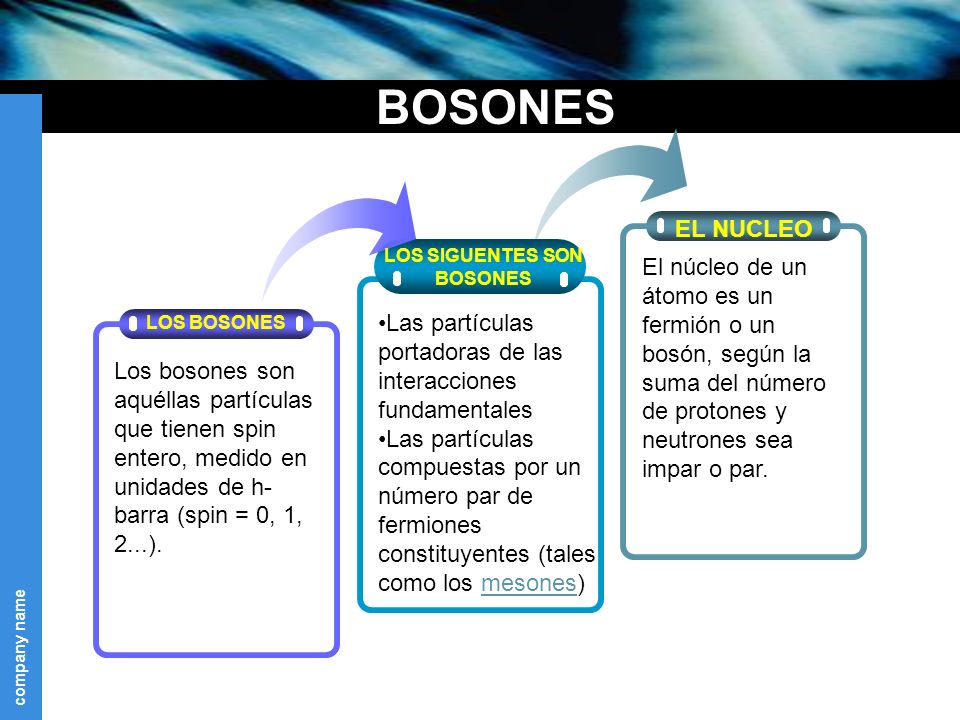

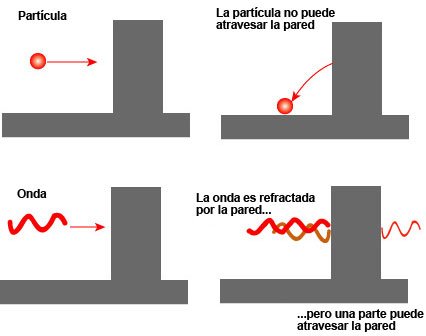

Las partículas con espín entero se llaman bosones, y las que tienen espín entero más un medio se llaman fermiones. Consultado los valores del espín en la tabla anterior podemos ver que los leptones y los bariones son fermiones, y que los mesones y los fotones son bosones. En muchos aspectos, los fermiones se comportan de manera diferente de los bosones. Los fermiones tienen la propiedad de que cada uno de ellos requiere su propio espacio: dos fermiones del mismo tipo no pueden ocupar o estar en el mismo punto, y su movimiento está regido por ecuaciones tales que se evitan unos a otros. Curiosamente, no se necesita ninguna fuerza para conseguir esto. De hecho, las fuerzas entre los fermiones pueden ser atractivas o repulsivas, según las cargas. El fenómeno por el cual cada fermión tiene que estar en un estado diferente se conoce como el principio de exclusión de Pauli. Cada átomo está rodeado de una nube de electrones, que son fermiones (espín ½). Si dos átomos se aproximan entre sí, los electrones se mueven de tal manera que las dos nubes se evitan una a otra, dando como resultado una fuerza repulsiva. Cuando aplaudimos, nuestras manos no se atraviesan pasando la uno a través de la otra. Esto es debido al principio de exclusión de Pauli para los electrones de nuestras manos que, de hecho, los de la izquierda rechazan a los de la derecha.

En contraste con el característico individualismo de los fermiones, los bosones se comportan colectivamente y les gusta colocarse todos en el mismo lugar. Un láser, por ejemplo, produce un haz de luz en el cual muchísimos fotones llevan la misma longitud de onda y dirección de movimiento. Esto es posible porque los fotones son bosones.

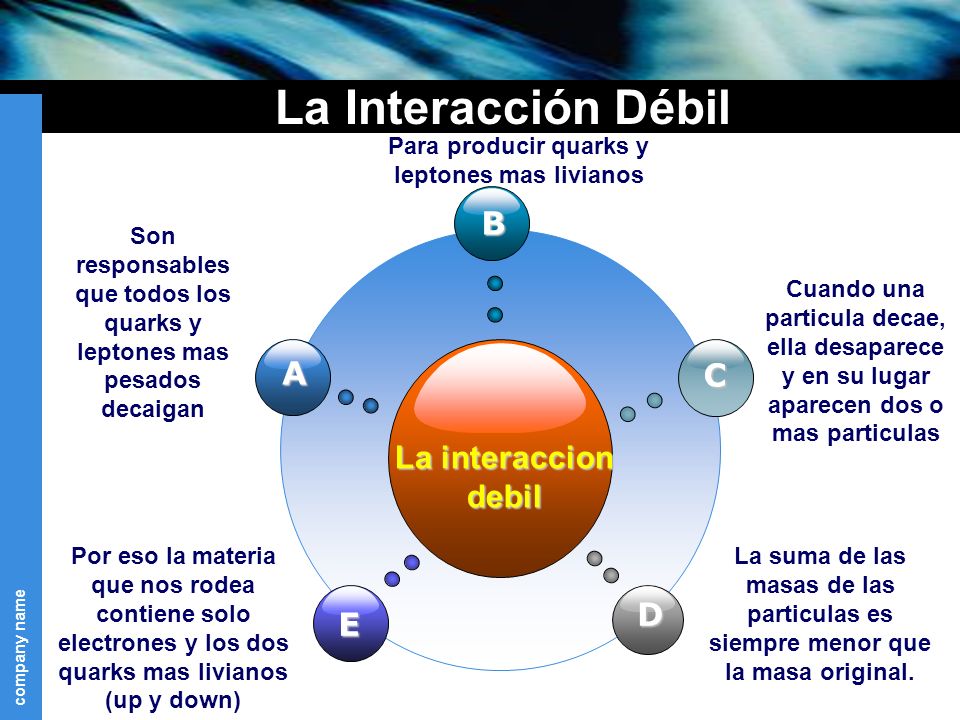

Cuando hemos hablado de las fuerzas fundamentales que, de una u otra forma, interaccionan con la materia, también hemos explicado que la interacción débil es la responsable de que muchas partículas y también muchos núcleos atómicos exóticos sean inestables. La interacción débil puede provocar que una partícula se transforme en otra relacionada, por emisión de un electrón y un neutrino. Enrico Fermi, en 1934, estableció una fórmula general de la interacción débil, que fue mejorada posteriormente por George Sudarshan, Robert Marschak, Murray Gell-Mann, Richard Feynman y otros. La fórmula mejorada funciona muy bien, pero se hizo evidente que no era adecuada en todas las circunstancias.

¿Cuál es la diferencia entre el protón y el neutrón?

Basta con cambiar un quark tipo U a uno tipo D.

Pues justamente esto es lo que ocurre en la naturaleza cuando entra en acción la fuerza nuclear débil. Un quark tipo U cambia a uno tipo D por medio de la interacción débil así

Las otras dos partículas que salen son un anti-electrón y un neutrino.

Este mismo proceso es el responsable del decaimiento radiactivo de algunos núcleos atómicos. Cuando un neutrón se convierte en un protón en el decaimiento radiactivo de un núcleo, aparece un electrón y un neutrino. Este es el origen de la radiación beta (electrónes).

En 1970, de las siguientes características de la interacción débil sólo se conocían las tres primeras:

- La interacción actúa de forma universal sobre muchos tipos diferentes de partículas y su intensidad es aproximadamente igual para todas (aunque sus efectos pueden ser muy diferentes en cada caso). A los neutrinos les afecta exclusivamente la interacción débil.

- Comparada con las demás interacciones, ésta tiene un alcance muy corto.

- La interacción es muy débil. Consecuentemente, los choques de partículas en los cuales hay neutrinos involucrados son tan poco frecuentes que se necesitan chorros muy intensos de neutrinos para poder estudiar tales sucesos.

- Los mediadores de la interacción débil, llamados W+, W– y Z0, no se detectaron hasta la década de 1980. al igual que el fotón, tienen espín 1, pero están eléctricamente cargados y son muy pesados (esta es la causa por la que el alcance de la interacción es tan corto). El tercer mediador, Z0, que es responsable de un tercer tipo de interacción débil que no tiene nada que ver con la desintegración de las partículas llamada “corriente neutra”, permite que los neutrinos puedan colisionar con otras partículas sin cambiar su identidad.

A partir de 1970, quedó clara la relación de la interacción débil y la electromagnética (electrodébil de Weinberg-Salam).

La interacción fuerte (como hemos dicho antes) sólo actúa entre las partículas que clasificamos en la familia llamada de los hadrones, a los que proporciona una estructura interna complicada. Hasta 1972 sólo se conocían las reglas de simetría de la interacción fuerte y no fuimos capaces de formular las leyes de la interacción con precisión.

Como apuntamos, el alcance de esta interacción no va más allá del radio de un núcleo atómico ligero (10-13 cm aproximadamente).

En 1963, cuando se supo que protones y neutrones (los llamados nucleones) están formados por Quarks, se pensó que la fuerza fuerte actúa realmente entre los Quarks.

En la teoría cuántica de campos, a cada tipo de interacción le corresponde una familia de partículas portadoras de la interacción.Las partículas que transportan la fuerza fuerte nuclear que interactúa entre los quarks se denominan gluones.

La fuerza nuclear fuerte se deduce del requisito de que las ecuaciones que describen a los quarks deben ser las mismas, independientemente de cómo se elija la definición de los colores de los quarks.

La interacción es fuerte. En realidad, la más fuerte de todas.

Lo dejaré aquí, en verdad, eso que el Modelo Estándar de la Física, es feo, complejo e incompleto y, aunque hasta el momento es una buena herramienta con la que trabajar, la verdad es que, se necesita un nuevo modelo más avanzado y que incluya la Gravedad.

Veremos que nos trae la nueva etapa del LHC.

Emilio Silvera V.

Ago

30

¿Las estrellas? ¡Sin ellas no estaríamos aquí!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (2)

Comments (2)

Es cierto que cuando vemos las cosas con cierta asiduidad y de forma permanente, esa cotidianidad nos hace perder la perspectiva y no pensamos en lo que realmente esas cosas pueden ser y, con las estrellas nos ocurre algo similar, ya que son algo más, mucho más, que simples puntitos luminosos que brillan en la oscuridad de la noche. Una estrella es una gran bola de gas luminoso que, en alguna etapa de su vida, produce energía por la fusión nuclear del hidrógeno para formar helio. El término estrella por tanto, no sólo incluye estrellas como nuestro Sol, que están en la actualidad quemando hidrógeno, sino también protoestrellas, aún no lo suficientemente calientes como para que dicha combustión haya comenzado, y varios tipos de objetos evolucionados como estrellas gigantes y supergigantes, que están quemando otros combustibles nucleares, o las enanas blancas y las estrellas nucleares, que están formadas por combustible nuclear gastado.

Muchos son los ejemplos de estrellas masivas (más de 100 masas solares) que, para no morir, eyectan material al espacio interestelar y siguen viviendo.

Estrellas masivas que expulsan gases, ya que, cuando la masa es muy grande, su propia radiación las puede destruir y, de esta manera, descongestionan la tensión y evitan un final anticipado. Arriba tenéis una estrella super-masiva que ha expulsado gases formando una nebulosa para evitar su muerte, Eta Carinae ha hecho lo mismo. Estas son estrellas que están congestionadas y, sólo la expulsión de material la puede aliviar y conseguir que siga brillando como estrella evitando explotar como supernova.

Se calcula que la masa máxima de una estrella es de unas 120 masas solares, por encima de la cual sería destruida por su propia radiación. La masa mínima es de 0,08 masas solares; por debajo de ella, los objetos no serían lo suficientemente calientes en sus núcleos como para que comience la combustión del hidrógeno, y se convertirían en enanas marrones.

De la misma forma que al calentar una pieza de metal cambia de color, al principio rojo, luego amarillo hasta llegar al blanco, el color de una estrella varia según su temperatura superficial. Las estrellas más frías son las rojas, y las mas calientes las azules. Estos colores suelen percibirse a simple vista, como por ejemplo Antares (la estrella principal de Scorpius) que es de color rojo, o Rigel (en Orión) de color azul. En astronomía se utiliza la escala Kelvin para indicar temperaturas, donde el cero absoluto es -273 grados Celsius.

El diagrama de Hertzsprung-Russell proporcionó a los astrónomos un registro congelado de la evolución de las estrellas, el equivalente astrofísico del registro fósil que los geólogos estudian en los estratos rocosos. Presumiblemente, las estrellas evolucionan de algún modo, pasan la mayor parte de su tiempo en la serie principal (la mayoría de las estrellas en la actualidad, en el brevísimo tiempo que tenemos para observar, se encuentran allí), pero empiezan y terminan su vida en alguna otra parte, entre las ramas o en el mantillo. Por supuesto, no podemos esperar para ver que esto sucede, pues el tiempo de vida, aún de estrellas de vida corta, se mide en millones de años. Hallar la respuesta exigirá conocer la física del funcionamiento estelar.

El progreso en física, mientras tanto, estaba bloqueado por una barrera aparentemente insuperable. Esto era literal: el agente responsable era conocido como la Barrera de Coulomb, y por un tiempo frustró los esfuerzos de los físicos teóricos para comprender cómo la fusión nuclear podía producir energía en las estrellas.

“La barrera de Coulomb, denominado a partir de la ley de Coulomb, nombrada así del físico Charles-Augustin de Coulomb (1736–1806), es la barrera de energía debida a la interacción electrostática que el núcleo atómico debe superar para experimentar una reacción nuclear. Esta barrera de energía es proporcionada por la energía potencial electrostática:

donde:

- k es la constante de Coulomb = 8.9876×109 N m² C−2;

- ε0 es la permeabilidad en el vacío;

- q1, q2 son las cargas de las partículas que interactúan;

- r es el radio de interacción.”

Un valor positivo de U es debido a una fuerza de repulsión, así que las partículas que interactúan están a mayores niveles de energía cuando se acercan. Un valor negativo de la energía potencial U indica un estado de ligadura, debido a una fuerza atractiva. La línea de razonamiento que conducía a esta barrera era impecable. Las estrellas están formadas en su mayor parte por hidrógeno. Esto se hace evidente en el estudio de sus espectros.) El núcleo del átomo de hidrógeno consiste en un sólo protón, y el protón contiene casi toda la masa del átomo. (Sabemos esto por los experimentos de Rutherford explicados aquí en otra ocasión). Por tanto, el protón también debe contener casi toda la energía latente del átomo de hidrógeno.

(Recordemos que la masa es igual a la Energía: E = mc2. (En el calor de una estrella los protones son esparcidos a altas velocidades -el calor significa que las partículas involucradas se mueven rápidamente- y, como hay muchos protones que se apiñan en el núcleo denso de una estrella, deben de tener muchísimos choques. En resumen, la energía del Sol y las estrellas, puede suponerse razonablemente, implica las interacciones de los protones. esta era la base de conjetura de Eddintong de que la fuente de la energía estelar “difícilmente puede ser otra cosa que energía subatómica, la cual, como se sabe, existe en abundancia en toda la materia”.

Hasta ese punto, todo iba bien, la ciencia estaba cerca de identificar la fusión termonuclear como el secreto de la energía solar. Pero aquí era donde intervenía la Barrera de Coulomb. Los protones están cargados positivamente; las partículas de igual carga se repelen entre sí; y este obstáculo parecía demasiado grande para ser superado, aun a la elevada velocidad a la que los protones se agitaban en el intenso calor del centro de las estrellas. De acuerdo con la física clásica, muy raras veces podían dos protones de una estrella ir con la rapidez suficiente para romper las murallas de sus campos de fuerza electromágnéticos y fundirse en un sólo núcleo. Los cálculos decían que la tasa de colisión de protones no podía bastar para mantener las reacciones de fusión. Sin embargo, allí estaba el Sol, con su rostro radiante y sonriente al ver el esfuerzo y las ecuaciones que decían que no podía brillar.

Dejemos aquí este proceso y digamos que, realmente, la mayoría de las veces el protón rebotará en la Barrera de Coulomb, pero de cuando en cuando la atravesará. Este es el “Efecto Túnel Cuántico”; que permite brillar a las estrellas. George Gamow, ansioso de explotar las conexiones entre la astronomía y la nueva física exótica a la que era adepto, aplicó las probabilidades cuánticas a la cuestión de la fusión nuclear en las estrellas y descubrió que los protones pueden superar la Barrera de Coulomb, o casi. El efecto túnel cuántico se hizo cargo de los cálculos de la desalentadora predicción clásica, que establecía la fusión de los protones a sólo una milésima de la tasa necesaria para explicar la energía liberada por el Sol, y la elevó a una décima de la tasa necesaria. Luego se tardó menos de un año para dar cuenta del deficít restante: la solución fue completada en 1929, cuando Robert Atkinson y Fritz Houterman combinaron los hallazgos de Gamow con lo que se ha llamado teoría maxwelliana de la distribución de velocidades. En la distribución maxwelliana hay siempre unas pocas partículas que se mueven mucho más rápidamente que la media y, Robert Atkinson y Fritz Houterman hallaron que estas pocas partículas veloces bastqaban para compensar la diferencia. Finalmente se hizo claro como podía romperse la Barrera de Coulomb suficientemente a menudo para que la fusión nuclear se produjese en las estrellas.

Pero la figura clave en todos estos desarrollos fue Hans Bhete, un refugiado de la Alemania nazi que había estudiado con Fermi en Roma y fue a enseñar en Cornell en EE. UU. Como su amigo Gamow, el joven Bhete era un pensador efervescente y vivaz, con tanto talento que parecía hacer su trabajo como si de un juego se tratara. Aunque no preparado en Astronomía, Bhete era un estudioso de legendaria rapidez. En 1938 ayudó al discípulo de Gamow y Edward Teller, C.L. Critchfield, a calcular una reacción que empezase con la colisión de dos protones podía generar aproximadamente la energía irradiada por el Sol, 3,86 x 1033 ergios por segundo. Así, en un lapso de menos de cuarenta años, la humanidad había progresado de la ignorancia de la existencia misma de los átomos a la comprensión del proceso de fusión termonuclear primaria que suministra energía al Sol.

Pero la reacción protón. protón no era bastante energética para explicar la luminosidad muy superior de estrellas mucho más grandes que el Sol, estrellas como las supergigantes azules de las Pléyades, que ocupan las regiones más altas del diagrama de Herptzsprung-Russell. Bhete puso remedio a esto antes de que terminase aquel el año 1938.

George Gamow Edward Reller

En abril de 1938, Bhete asistió a una conferencia organizada por Gamow y Teller que tenía el objeto de que físicos y astrónomos trabajaran juntos en la cuestión de la generación de energía en las estrellas. “Allí, los astrofísicos nos dijeron a los físicos todo que sabían sobre la constitución interna de las estrellas -recordoba Bhete-. esto era mucho (aunque) habían obtenido todos los resultados sin conocimiento de la fuente específica de energía.” De vuelta a Cornell, Bhete abordó el problema con celeridad y, en cuestión de semanas logró identificar el ciclo del Carbono, la reacción de fusión crítica que da energía a las estrellas que tiene más de una vez y media la masa del Sol.

Bhete que estaba falto de dinero, retiró el artículo que escribió sobre sus hallazgos y que ya tenía entregado en la Revista Physical Review, para entregarlo en un Concurso postulado por la Academia de Ciencias de Nueva York sobre la producción de energía en las estrellas. Por supuesto, Bhete ganó el primer Premio uy se llevó los 500 dolares que le sirvieron para que su madre pudiera emigrar a EE UU. Después lo volvió a llevar a la Revista que lo publicó y, finalmente, se lo publicaron y tal publicación le hizo ganar el Nobel. Por un tiempo, Bhete había sido el único humano que sabía por qué brillan las estrellas.

Cuando miramos al cielo y podemos contemplar extasiados esas maravillas que ahí arriba, en el espacio interestelar están brillando, y, nos da la sensación de que están haciéndonos guiños, como si quisieran mandarnos un mensaje, decirnos algo y nosotros, no pensamos en todo lo que ahí, en esos “puntitos brillantes” se está fraguando. De lo que allí ocurre, depende que los mundos tengan los materiales que en ellos están presentes y, de entre esos materiales, se destacan aquellos que por su química biológica, permiten que se pueda formar la vida a partir de unos elementos que se hicieron en los hornos nucleares de las estrellas.

El Proceso Triple Alfa

El cinturón de Orión, también llamado en algunos países hispanos “los tres reyes magos” o “las tres Marías”, es un conjunto estacionario de estrellas (asterismo) que forma parte de la constelación de Orión, y que está formado por tres estrellas específicas: Alnitak, Alnilam y Mintaka.

Y sí, es curioso que, mirando en la oscura noche como brillan las estrellas del cielo, nos atrae su titilar engañoso (es la atmósfera terrestre la que hace que lo parezca) y su brillo, Sin embargo, pocos llegan a pensar en lo que verdaderamente está allí ocurriendo. Las transformaciones de fase por fusión no cesan. Esta transformación de materia en energía es consecuencia de la equivalencia materia-energía, enunciada por Albert Einstein en su famosa fórmula E=mc2; donde E es la energía resultante, m es la masa transformada en energía, y c es la velocidad de la luz (300 000 kilómetros por segundo). La cantidad de energía que se libera en los procesos de fusión termonuclear es fabulosa. Un gramo de materia transformado íntegramente en energía bastaría para satisfacer los requerimientos energéticos de una familia mediana durante miles de años.

Es un gran triunfo del ingenio humano el saber de qué, están estructuradas las estrellas y qué materiales se están forjando allí, al inmenso calor de sus núcleos. Recuerdo aquí a aquel Presidente de la Real Society de Londres que, en una reunión multitudinaria, llegó a decir:

“Una cosa está clara, nunca podremos saber de qué están hechas las estrellas”.

El hombre se vistió de gloria con la (desde entonces) famosa frase. Creo que nada, con tiempo por delante, será imposible para nosotros.

Poco tiempo después, llegó ohan Franhufer con sus líneas espectrales y echó al traste aquellas palabras

A nuestro planeta sólo llega una ínfima fracción del calor que se genera en el Sol y, sin embargo, es más que suficiente para mantener aquí la vida. El Sol tiene materia que supone la misma que tendrían 300.000 Tierras. Nuestra estrella madre está situada a una UA (150 millones de kilómetros de nosotros) y, todas esas circunstancias y otras muchas, hacen que todo sea tal como lo vemos a nuestro alrededor. Si cualquiera de esos parámetros fuera diferente o variara tan sólo unas fracciones, seguramente la Tierra sería un planeta muerto y, nosotros, no estaríamos aquí. Sin embargo… ¡Estamos! y, gracias a ello, se pueden producir descubrimientos como los que más arriba hemos relatado y han podido y pueden existir personajes de cuyas mentes surgen ideas creadoras que nos llevan a saber cómo son las cosas.

Lo cierto es que, cada día sabemos mejor como funciona ma Naturaleza que, al fin y al cabo, es la que tiene todas las respuestas que necesitamos conocer.

Emilio Silvera V.

Ago

30

¿La masa perdida? ¿O no entendemos nada?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (0)

Comments (0)

Recreación artística del WHIM en la Pared del Escultor. Fuente: NASA.

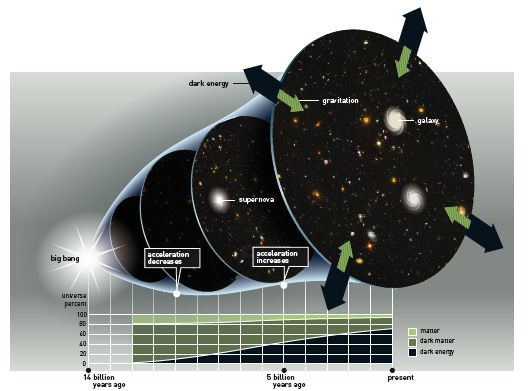

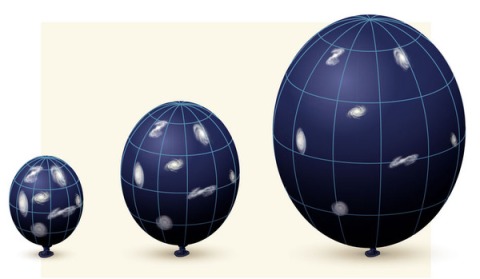

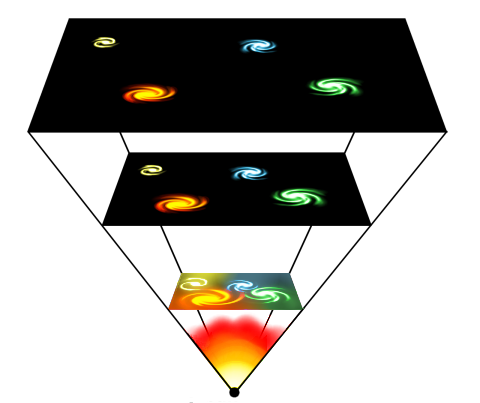

La idea de la masa perdida se introdujo porque la densidad observada de la materia en el universo está cerca del valor crítico (10-29 g/cm3). Sin embargo, hasta comienzo de los ochenta, no hubo una razón teórica firme para suponer que el universo tenía efectivamente la masa crítica. En 1981, Alan Guth, publicó la primera versión de una teoría que desde entonces se ha conocido como “universo inflacionista”. desde entonces la teoría ha sufrido cierto número de modificaciones técnicas, pero los puntos centrales no han cambiado. Lo cierto es que la idea del universo inflacionista, estableció por primera vez una fuerte presunción de que la masa del universo tenía realmente el valor crítico.

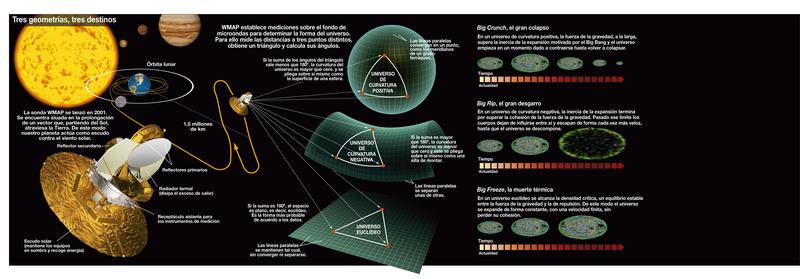

Diagrama de las tres posibles geometrías del universo: cerrado, abierto y plano, correspondiendo a valores del parámetro de densidad Ω0 mayores que, menores que o iguales a 1 respectivamente. En el universo cerrado si se viaja en línea recta se llega al mismo punto, en los otros dos no. ( Ω es lo que los cosmólogos llaman el Omega Negro, es decir, la cantidad de materia que hay en el Universo).

La predicción de Guht viene de las teorías que describen la congelación de la fuerza fuerte en el segundo 10-35 del Big Bang. Entre los muchos otros procesos en marcha en ese tiempo estaba una rápida expansión del universo, un proceso que vino a ser conocido como inflación. Es la presencia de la inflación la que nos lleva a la predicción de que el universo tiene que ser plano.

Se ha tratado de medir la Densidad Crítica del Universo para poder saber en qué clase de universo estamos y, parece que es plano.

Universo cerrado

Si Ω>1, entonces la geometría del espacio sería cerrada como la superficie de una esfera. La suma de los ángulos de un triángulo exceden 180 grados y no habría líneas paralelas. Al final, todas las líneas se encontrarían. La geometría del universo es, al menos en una escala muy grande, elíptico.

En un universo cerrado carente del efecto repulsivo de la energía oscura, la gravedad acabará por detener la expansión del universo, después de lo que empezará a contraerse hasta que toda la materia en el universo se colapse en un punto. Entonces existirá una singularidad final llamada el Big Crunch, por analogía con el Big Bang. Sin embargo, si el universo tiene una gran suma de energía oscura (como sugieren los hallazgos recientes), entonces la expansión será grande.

Universo abierto

Si Ω<1, la geometría del espacio es abierta, p.ej., negativamente curvada como la superficie de una silla de montar. Los ángulos de un triángulo suman menos de 180 grados (llamada primera fase) y las líneas paralelas no se encuentran nunca equidistantes, tienen un punto de menor distancia y otro de mayor. La geometría del universo sería hiperbólica.

Incluso sin energía oscura, un universo negativamente curvado se expandirá para siempre, con la gravedad apenas ralentizando la tasa de expansión. Con energía oscura, la expansión no sólo continúa sino que se acelera. El destino final de un universo abierto es, o la muerte térmica” o “Big Freeze” o “Big Rip”, dónde la aceleración causada por la energía oscura terminará siendo tan fuerte que aplastará completamente los efectos de las fuerzas gravitacionales, electromagnéticas y los enlaces débiles.

Universo plano

Si la densidad media del universo es exactamente igual a la densidad crítica tal que Ω=1, entonces la geometría del universo es plana: como en la geometría ecuclidiana, la suma de los ángulos de un triángulo es 180 grados y las líneas paralelas nunca se encuentran.

Sin energía oscura, un universo plano se expande para siempre pero a una tasa continuamente desacelerada: la tasa de expansión se aproxima asintóticamentre a cero. Con energía oscura, la tasa de expansión del universo es inicialmente baja, debido al efecto de la gravedad, pero finalmente se incrementa. El destino final del universo es el mismo que en un universo abierto, la muerte caliente del universo, el “Big Freeze” o el “Big Rip”. En 2005, se propuso la teoría del destino del universo Fermión-Bosón, proponiendo que gran parte del universo estaría finalmente ocupada por condensado de Bose-Einstein y la quasipartícula análoga al fermión, tal vez resultando una implosión. Muchos datos astrofísicos hasta la fecha son consistentes con un universo plano.

La teoría del Big Crunch es un punto de vista simétrico del destino final del Universo. Justo con el Big Bang empezó una expansión cosmológica, esta teoría postula que la densidad media del Universo es suficiente para parar su expansión y empezar la contracción. De ser así, se vería cómo las estrellas tienden a ultravioleta, por efecto Doppler. El resultado final es desconocido; una simple extrapolación sería que toda la materia y el espacio-tiempo en el Universo se colapsaría en una singularidad espaciotemporal adimensional, pero a estas escalas se desconocen los efectos cuánticos necesarios para ser considerados -se aconseja mirar en Gravedad-Cuántica-..

Este escenario permite que el Big Bang esté precedido inmediatamente por el Big Crunch de un Universo precedente. Si esto ocurre repetidamente, se tiene un universo oscilante. El Universo podría consistir en una secuencia infinita de Universos finitos, cada Universo finito terminando con un Big Crunch que es también el Big Bang del siguiente Universo. Teóricamente, el Universo oscilante no podría reconciliarse con la segunda ley de la termodinámica:

la entropía aumentaría de oscilación en oscilación y causaría la muerte caliente. Otras medidas sugieren que el Universo no es cerrado. Estos argumentos indujeron a los cosmólogos a abandonar el modelo del Universo oscilante. Una idea similar es adoptada por el modelo cíclico, pero esta idea evade la muerte caliente porque de una expansión de branas se diluye la entropía acumulada en el ciclo anterior.

Como podéis comprobar por todo lo anteriormente leído, siempre estamos tratando de saber en qué universo estamos y pretendemos explicar lo que pudo pasar desde aquel primer momento que no hemos podido comprender de manera exacta y científicamente autosuficiente para que sea una ley inamovible del nacimiento del universo. Simplemente hemos creado modelos que se acercan de la mejor manera a lo que pudo ser y a lo que podría ser.

Ago

29

Todo está relacionado… De una u otra manera

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Gustav Mie

Ese ha sido uno de las grandes esfuerzos realizados por desarrollar una teoría que diera cuenta del equilibrio de la electricidad que constituye el electrón y, los trabajos de Mie, han sido apoyados por toda la comunidad de los físicos teóricos, él se basa principalmente en la introducción de un tensor- energía de términos suplementarios que dependen de las componentes del potencial electromagnético, además de los términos de energía de la teoría de Maxwell-Lorentz. Estos nuevos términos que en el espacio exterior no son importantes, son sin embargo efectivos en el interior de los electrones al mantener el equilibrio frente a la repulsión eléctrica.

A pesar de la belleza de la estructura formal de esta teoría, erigida por Mie, Hilbelt y Weyl, sus resultados físicos hasta ahora han sido insatisfactorios. Por una parte, la multiplicidad de posibilidades es desalentadora, y por otra parte dichos términos adicionales no han podido ser formulados de una manera tan simple que la solución pudiera ser satisfactoria,

Hasta ahora la Teoría de la Relatividad General no ha realizado ningún cambio en este estado de la cuestión. Si por el momento no consideramos el término cosmológic0.

Donde G denota el Tensor de curvatura de Riemann contraído, G es el escalar de curvatura formado por contracción repetida, y Tμν el Tensor de energía de “materia”. En fin, explicar toda la ecuación puede llegar a ser engorroso y es toda una larga historia que no siempre entretiene al personal. Así que, lo dejamos.

Muchos son los conceptos que tendríamos que explicar aquí para dilucidar todas estas cuestiones que, implicadas en estas teorías, nos llevan a la cinemática, la simultaneidad, transformaciones de coordenadas, relatividad de longitudes y tiempos, adición de velocidades, lo que nos dijo Maxwell y Lorentz. transformación de nergía en rayos luminosos, la gravedad y la propagación de la luz, la naturaleza física de los campos gravitatorios… y un sin fin de cuestiones que, hacen necesario un gran volumen y, también, un amplio dominio de conocimientos de los que carezco.

Lo cierto es que, la Teoría de la Gravedad, nos lleva a imaginar situaciones que podrían ser y, en alguna ocasión, se nos puede presentar como posibles caminos para solucionar cuestiones que, en el mundo físico que conocemos, nos parecen irresolubles pero… En física, amigos míos, lo imposible parece posible.

¡Encontrar la solución para burlar la velocidad de la luz, y, atravesando portales mágicos, ir a otras galaxias! Es cierto que la mente está muy delante de los hechos pero… Cuando se piensa en algo, ahí queda la posibilidad de plasmarlo en una realidad.

Al menos por el momento, no podemos saber si nuestro Universo es único. Sin embargo, hemos pensado en la posibilidad de que pudiera ser uno de tantos. Como nunca nadie pudo estar en otro Universo, tenemos que imaginarlos y basados en la realidad del nuestro, realizamos conjeturas y comparaciones con otros que podrían ser. ¿Quién puede asegurar que nuestro Universo es único? Realmente nadie puede afirmar tal cosa e incluso, estando limitados a un mundo de cuatro dimensiones espacio-temporales, no contamos con las condiciones físicas necesarias para poder captar (si es que lo hay), ese otro universo paralelo o simbiótico que presentimos junto al nuestro y que sospechamos que está situado en ese “vacío” que no hemos llegado a comprender. Sin embargo, podríamos conjeturar que, ambos universos, se necesitan mutuamente, el uno sin el otro no podría existir y, de esa manera, estaríamos en un universo dual dentro de la paradoja de no poder conocernos mutuamente, al menos de momento, al carecer de los conocimientos necesarios para ello.

Emilio Silvera V.

Ago

29

¡La Vida! ¿Cómo pudo suceder?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y la Vida ~

Clasificado en El Universo y la Vida ~

Comments (3)

Comments (3)

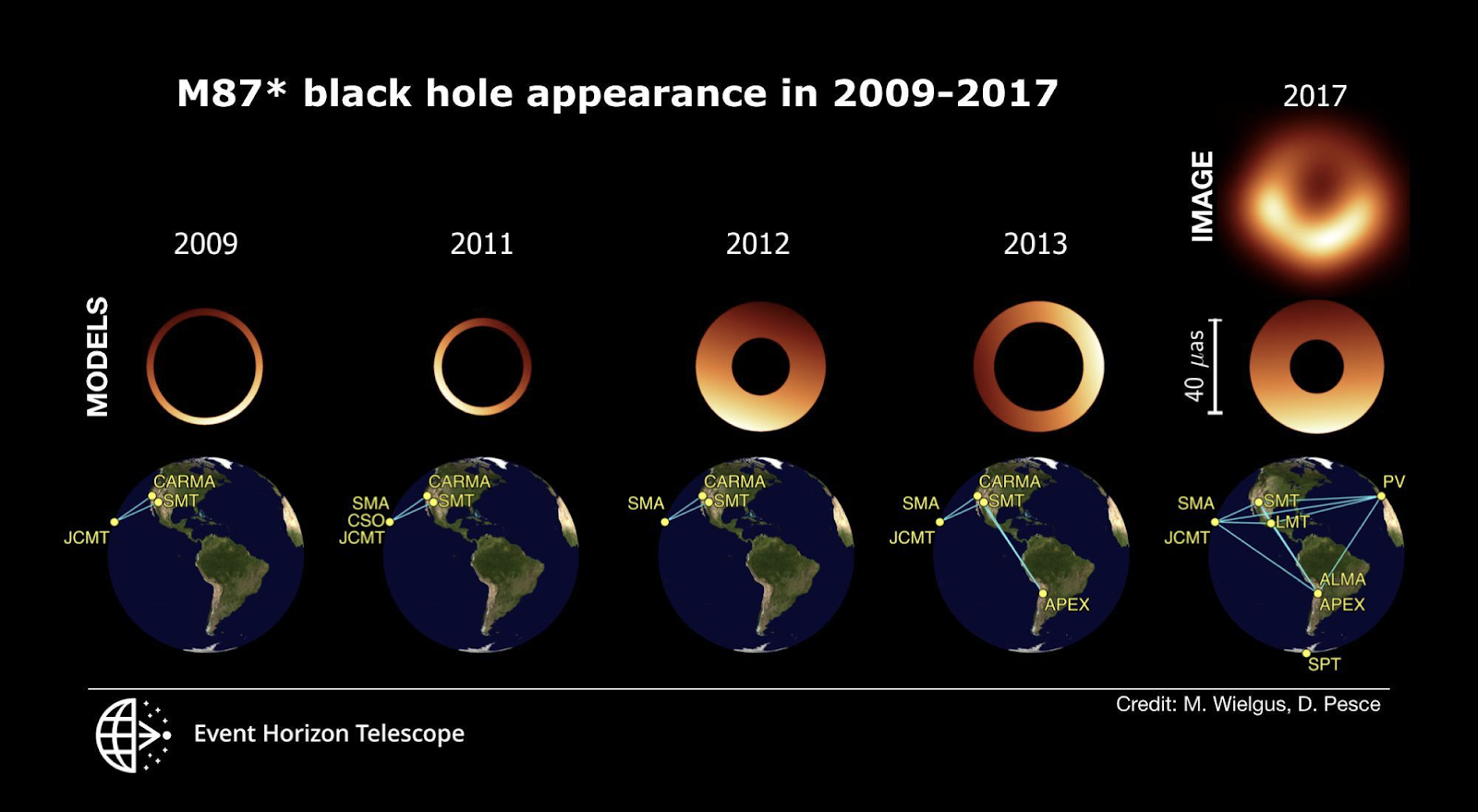

En 2019, la colaboración del Telescopio Horizonte de Sucesos (EHT) publicó la primera imagen de la sombra de un agujero negro, en concreto de M87, el objeto supermasivo situado en el centro de la galaxia M87.

Aprovechando la experiencia adquirida, el equipo del EHT ha analizado observaciones de M87* obtenidas previamente entre los años 2009 y 2013, muchas de los cuales aún no habían visto la luz.

Este completo análisis ha revelado el comportamiento de la imagen del agujero negro a lo largo de varios años. Los resultados muestran variaciones temporales en la orientación de la característica sombra en forma de media luna de M87*, compatibles con un aparente “bamboleo”. Los resultados se publican hoy en The Astrophysical Journal.

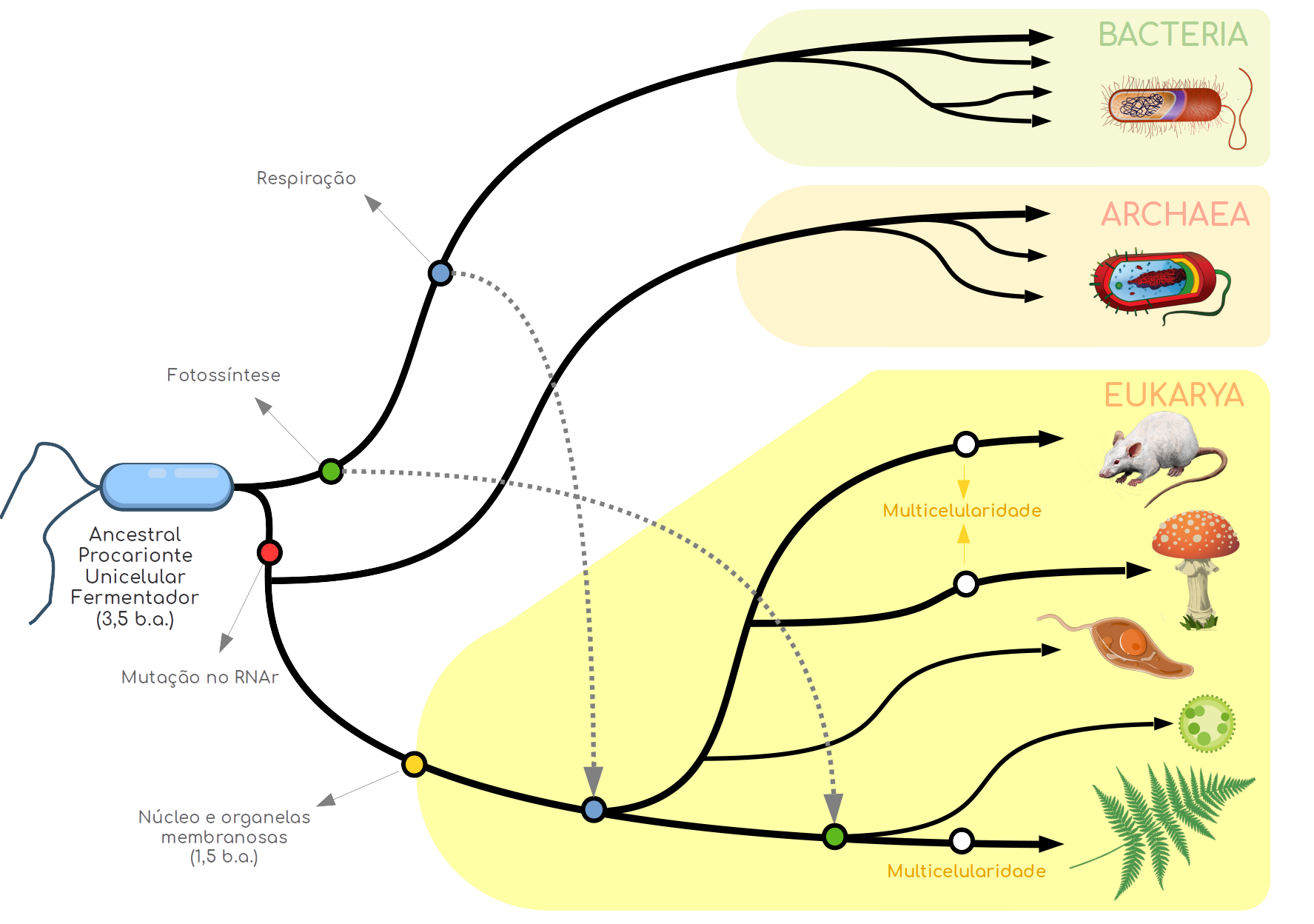

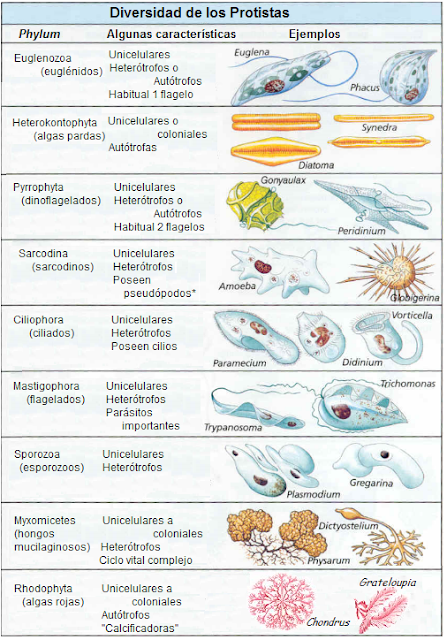

¿Cuál es el antecesor común de todas las formas de vida? Los científicos creen que el origen de toda la vida terrestre surgió una sola vez, en forma de un primitivo microbio. Lo han bautizado como LUCA.

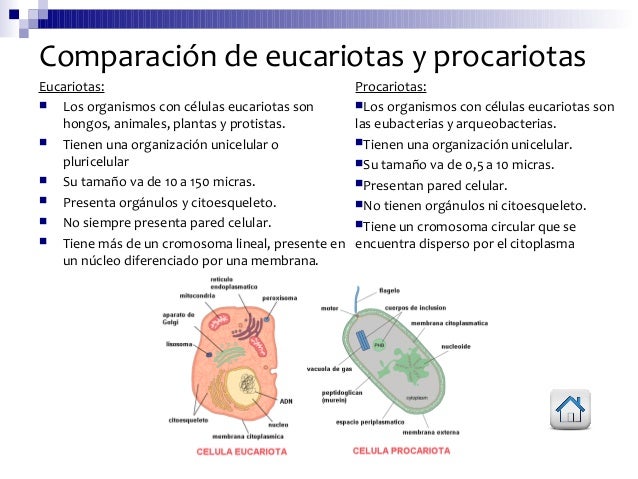

Ésta es sin duda una incógnita de gran importancia, ya que dentro de este esquema se forma el tronco común, de donde emergieron los organismos superiores primitivos (eucariontes), las bacterias y las arqueobacterias.

Aunque no podamos ubicar con exactitud dónde empezó la vida de una manera categórica, parece cada vez más probable que, una vez acabado el bombardeo al que fue sometida la Tierra en su juventud, la vida surgió confinada en lugares situados o bien por debajo del lecho marino, o bien cerca de las chimeneas volcánicas, o dentro de los sistemas hidrotermales en las margenes de las dorsales oceánicas. Una vez establecida al resguardo de lugares semejantes, el camino quedó abierto para la proliferación y diversificación.

Los distintos pasajes nos muestra la Tierra primigenia donde pudo surgir aquella primera célula replicante

Está claro que, a partir de todas estas suposiciones, hemos seguido especulando acerca de lo que pudo ser y, a partir de todo lo anterior, admitamos que aquellos microbios primitivos eran termófilos y que podían soportar temperaturas de entre 100 y 150 grados Celcius. Moraban al menos a un kilómetro bajo la superficie, posiblemente en el lecho marino, pero más probablemente en las rocas porosas que hay debajo. Inmersos en agua supercaliente repleta de minerales, ingerían rápidamente y procesaban hierro, azufre, hidrógeno y otras sustancias disponibles, liberando energía a partir de ciclos químicos primitivos y más bien ineficientes. Estas células primitivas eran comedoras de roca en bruto. Ni la luz ni el oxígeno desempeñaban ningún papel en su metabolismo. Ni tampoco requerían material orgánico, hacían lo que necesitaban directamente, a partir de las rocas y el dióxido de carbono disuelto en el agua.

La primera colonia microbiana tenía todo el mundo a su disposición, y un completo suministro de materiales y energía. Se habría extendido con sorprendente velocidad. La capacidad de los microbios para multiplicarse a velocidad explosiva garantizaba que ellos invadirían rápidamente cualquier nicho accesible. Sin ninguna competencia de los residentes, podrían heredar rápidamente la Tierra. Sin embargo, dada la explosión de población, la colonia habría alcanzado pronto los limites de su habitat. Impedidos para ir a mayor profundidad por las temperaturas crecientes, e incapaces de reproducirse en los estratos superficiales más fríos, los microbios sólo podían expandirse horizontalmente a lo largo de las cordilleras volcánicas, y lateralmente a través del basalto del suelo oceánico.

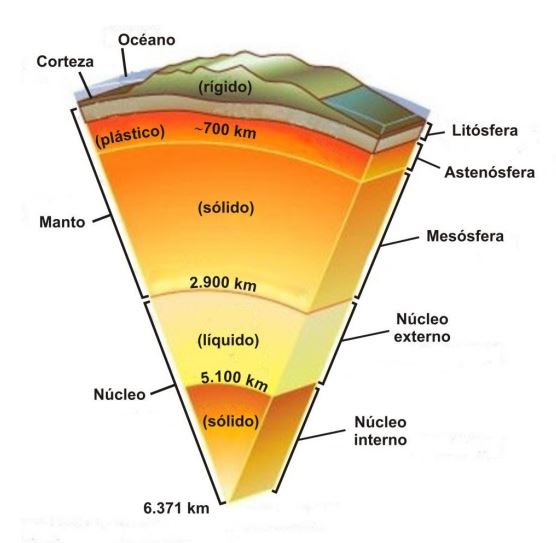

La capa rígida y más externa de la Tierra, que comprende la corteza y el manto superior, es llamada litosfera. La corteza oceánica contiene un 0,147% de la masa de la corteza terrestre. La mayor parte de la corteza terrestre fue creada a través de actividad volcánica. El sistema de cordilleras oceánicas, una red de 40.000 kilómetros de volcanes (25.000 millas), genera nueva corteza oceánica a un ritmo de 17 km3 por año, cubriendo el suelo oceánico con basalto. Hawai e Islandia son dos ejemplos de la acumulación de material basáltico.

En alguna etapa, quizá hace 3.800 millones de años se alcanzó la primera gran división evolutiva, cuando un grupo de microbios se encontraron repentinamente aislados de su hábitat caliente y acogedor debido a alguna catástrofe geológica, como un terremoto o una gran erupción volcánica.

Aquel grupo, aislado de la colonia principal, y encerrados en una región más fría, hizo que los microbios se quedaran en estado latente o simplemente murieron, pues sus membranas eran demasiado rígidas a estas temperaturas inferiores para que su metabolismo pudiera funcionar. Sin embargo, un mutante feliz, que accidentalmente tenía una membrana más flexible, sobrevivió y se multiplicó. Al hacer la transición a condiciones más frías, el microbio mutante allanó el camino para acceder a la superficie inhabitada del planeta. Mientras tanto, para los miembros de la colonia original, confinada confortablemente en el reino subterráneo, la vida ha continuado prácticamente igual hasta nuestros días.

La Vida, se cree que fue evolucionando a partir de simples células unicelulares

Un primer desarrollo clave fue un cambio que hicieron algunos organismos de las sustancias químicas a la luz como fuente de energía, y por entonces la vida debió de extenderse hasta la superficie. Probablemente, el primero de tales “fotótrofos” no utilizaba la moderna fotosíntesis de clorofila, sino algún proceso más elemental. Algunas arqueobacterias del Mar Muerto siguen utilizando una forma más bien primitiva de fotosíntesis basada en una sustancia roja relacionada con la vitamina A. La captura de la luz solar comenzó en serio con las bacterias, que descubrieron una forma de arrancar electrones de minerales, potenciarlos con fotones solares y utilizar la energía almacenada para fabricar material orgánico.

En las profundidades abisales del océano, las bacterias usan hidrógeno y producen materia orgánica. En aquellas profundidades abisales surgieron formas de vida de increíbles conformación.

Un refinamiento posterior los liberó de la dependencia de minerales, permitiendo a las bacterias arrancar electrones del agua y liberar oxígeno en consecuencia. El componente crucial en este ingenioso proceso era la clorofila, la sustancia que da el color verde a las plantas. Puesto que sólo se necesitaba agua, dióxido de carbono y luz, estaba abierto el camino el verdor del planeta.

Todavía queda por responder cómo y aparecieron los tres grandes dominios: arqueobacterias, bacterias y eucarias. Parece probable que la gran división en el árbol de la vida arqueobacterias y bacterias tuvo lugar antes de la invención de la fotosíntesis, quizá tan temprano como hace 3.900 o 4.000 millones de años, bien entrada la era del bombardeo intenso.

La evidencia apunta a que las arqueobacterias sean los organismos más viejos y más primitivos, y que las bacterias aparecieron algo más tarde. Tan profunda era la división entre las arqueobacterias y las bacterias que ellas no han sido nunca rivales; siguen ocupando nichos diferentes después de varios miles de millones de de evolución.

Finalmente, la profunda escisión que produjo el dominio de las eucarias ocurrió probablemente cuando las condiciones eran algo más frías. Por alguna razón, quizá por estar expuestas a los desafíos de un entorno menos estable, las eucarias de temperatura más baja se desarrollaron a un ritmo mucho más rápido.

El posterios florecimiento de la vida, su diversificación en muchas especies, y el enorme aumento de la complejidad biológica derivan directamente de la ramificación de las eucarias en el árbol de la vida. Sin este paso trascendental, es poco probable que nosotros -o cualesquiera otros seres sintientes- existiéramos hoy en la Tierra para poder reflexionar sobre el significado de la vida en la Tierra desde sus comienzos hasta el momento presente.

Mas tarde, en 1969, Robert Whuttaker propone una clasificación de los seres vivos en cinco reinos, en la que incorpora la distinción procariota-eucariota (ésta se considera actualmente mucho más importante que la de vegetal-aminal del sistema tradicional). Así quedan patente las diferencias entre las algas verde-azuladas(cuanolíceas) y las bacterias (ambas sin núcleo patente (procariotas) y todos los demás organismos que tienen un núcleo rodeado por membrana (eucqariotas). Los procariotas fueron incluídos en el reino Monera y los eucariotas en los cuatro restantes.

La regularidad de la Tierra que viene dada por la intensidad de energía que nos envía el Sol, desde 150 millones de kilómetros, y, la intensidad está amortiguada por la rica y densa atmósfera terrestre, y, los seres vivos, tienen un escudo contra las radiaciones nocivas. Una vez pasados aquellos primeros miles de millones de años en los que las formas de vida primitiva pudieron evolucionar, surgieron las condiciones ambientales y ecológicas que dieron lugar a la presencia de formas de vida más avanzadas.

En 1990 el científico Alemán Carl Woese propuso la existencia de tres dominios para clasificar a los seres vivos: Archaea, Bacteria y Eukarya. En el dominio Eukarya se consideran cuatro reinos: protistas,

Pero a partir de la anterior clasificación surgió la de Margulis- Schwartz (1985), también en cinco reinos (es la que aúin aparedce en los libros de texto). Se basa en estudios filogenéticos y tiene la ventaja de hacer grupos más homogéneos. Cambia el reino protistas por el de Protistas, en el que incluye a Protozoos, todas las algas (excepto cianofíceas) y los hongos inferiores.

Difícilmente podríamos aquí, en un simple repaso a lo que fue el comienzo y la evolución de la vida primigenia en nuestro planeta, hacer una relación pormenorizada de todo lo que ello implica y, nos limitamos, como podéis ir comprobando, a dejar trabajos sueltos con retazos de lo que “pudo haber sucedido” para que, de alguna manera, podamos llegar a una más amplia comprensión de tan complejo problema. Nada más y nada menos que…¡La Vida!

La conclusión a la presencia de la Vida en nuestro planeta, después de muchos estudios científicos, concluye para decir que: La Vida está presente en todo el Universo allí donde exista un planeta situado en la zona habitable de su estrella, tenga atmósfera respirable, océanos, y, reciba la radiación de su estrella madre. Y, todo eso es así debido a que el Universo es igual en todas partes y, las cuatro leyes fundamentales y las Constantes Universales, han sido moduladas para que la vida sea posible.

¿Qué tendrá en Mente el Universo en relación a los seres vivos inteligentes?

Bueno, a veces parezco algo loco, y, puedo hablar del Universo como si de alguien se tratara. Pero, lo cierto es que… ¡Yo creo en la existencia de una Conciencia Cósmica! No es posible que todas las maravillas que están aquí presentes sean debidas al Azar.

Emilio Silvera V.

Totales: 83.445.704

Totales: 83.445.704 Conectados: 48

Conectados: 48