May

8

Somos fruto de la evolución del Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (2)

Comments (2)

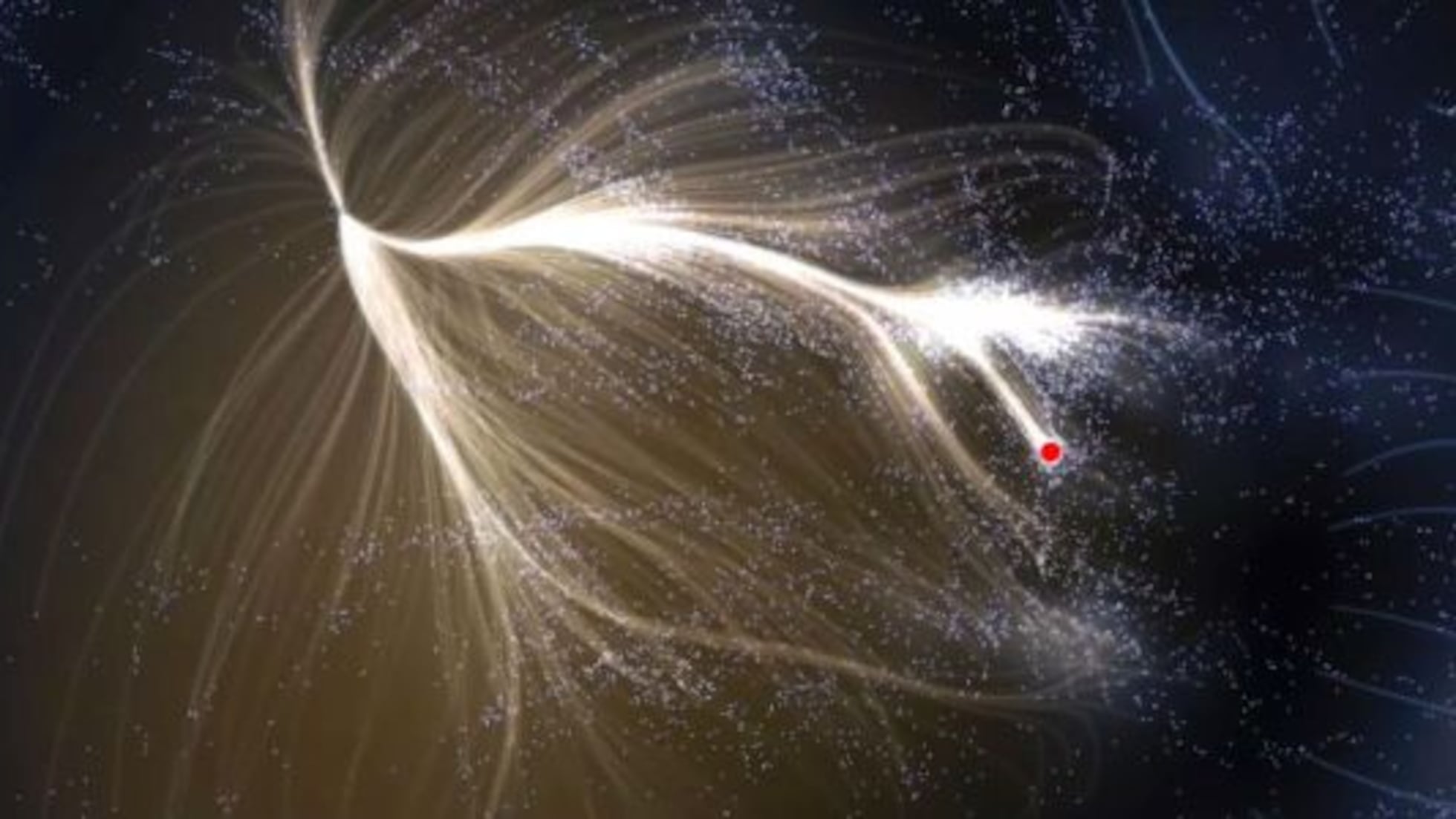

Una Galaxia es simplemente una parte pequeña del Universo, nuestro planeta es, una mínima fracción infinitesimal de esa Galaxia, y, nosotros mismos, podríamos ser comparados (en relación a la inmensidad del cosmos) con una colonia de bacterias pensantes e inteligentes. Sin embargo, todo forma parte de lo mismo y, aunque pueda dar la sensación engañosa de una cierta autonomía, en realidad todo está interconectado y el funcionamiento de una cosa incide directamente en el comportamiento de las otras. La Luna y la Tierra, nosotros con el planeta, el planeta y el resto del Sistema solar, las galaxias del Grupo Local… ¡Todo incide en todo! De alguna manera.

Un multiverso en miniatura (Si consideramos una galaxia como un pequeño universo)

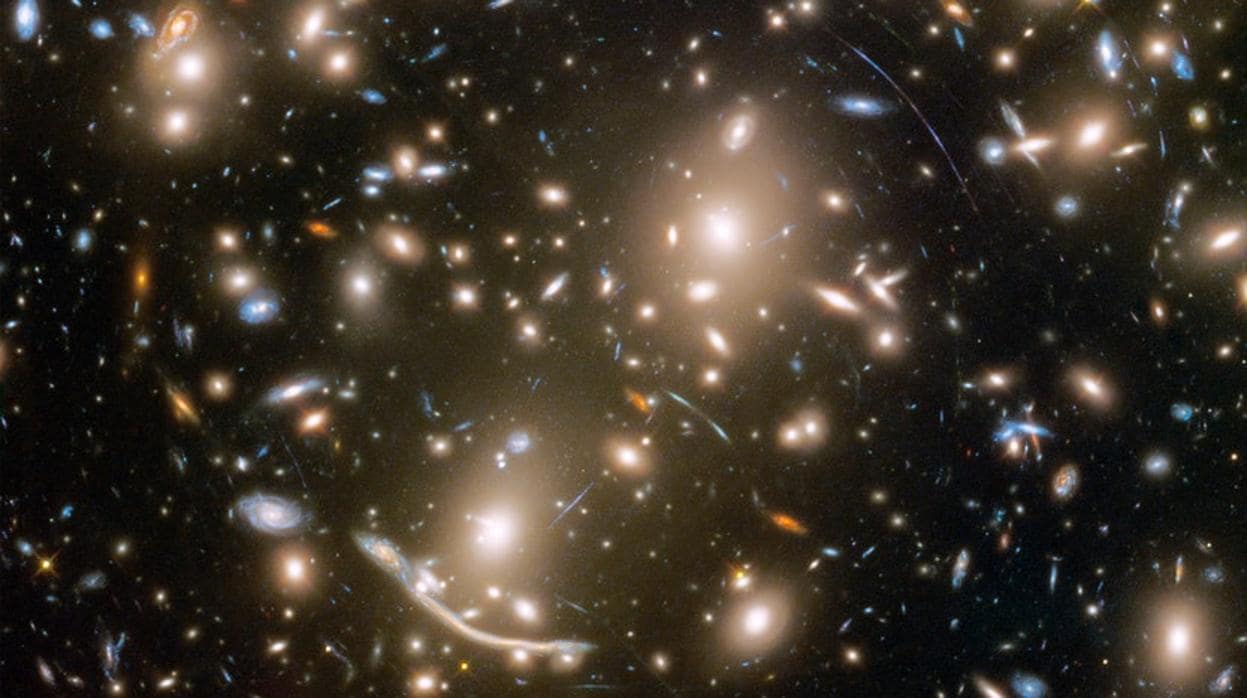

Y, si realmente una galaxia es un universo en miniatura… ¡Entonces existe el universo en miniatura ¿Cuántas galaxias existen en el Universo? Solo en el universo observable 200.000 millones. Y, mirado desde esa perspectiva, podríamos decir que ya hemos podido contemplar el multiverso en los cúmulos de galaxias.

“La nebulosa Cabeza de Caballo (Horsehead Nebula en inglés) o Barnard 33 (B33) es una nube de gas fría y oscura, situada a unos 1500 años luz de la Tierra, al sur del extremo izquierdo del cinturón de Orión. Forma parte del Complejo de Nubes Moleculares de Orión, y mide aproximadamente 3,5 años luz de ancho. Esta nebulosa oscura es visible por contraste, ya que aparece por delante de la nebulosa de emisión IC 434. Por su forma es la más familiar de las nebulosas de absorción. La estrella más brillante, situada a la izquierda de la nebulosa, es la popular Alnitak del Cinturón de Orión junto a sus hermanas Alnilam y Mintaka.

Lo que llama la atención de esta extraña imagen es que, en tantos años, los vientos solares de las estrellas vecinas no hallan podido cambiarla distorsionando la ya familiar figura del caballito de mar.

Pocas dudas pueden caber a estas alturas del hecho de que poder estar hablando de estas cuestiones, es un milagro en sí mismo. Después de miles de millones de años de evolución, se formaron las conciencias primarias que surgieron en los animales con ciertas estructuras cerebrales de alta complejidad que, podían ser capaces de construir una escena mental, pero con capacidad semántica o simbólica muy limitada y careciendo de un verdadero lenguaje.

La conciencia de orden superior (que floreció en los humanos y presupone la coexistencia de una conciencia primaria) viene acompañada de un sentido de la propia identidad y de la capacidad explícita de construir en los estados de vigilia escenas pasadas y futuras. Como mínimo, requiere una capacidad semántica y, en su forma más desarrollada, una capacidad lingüística.

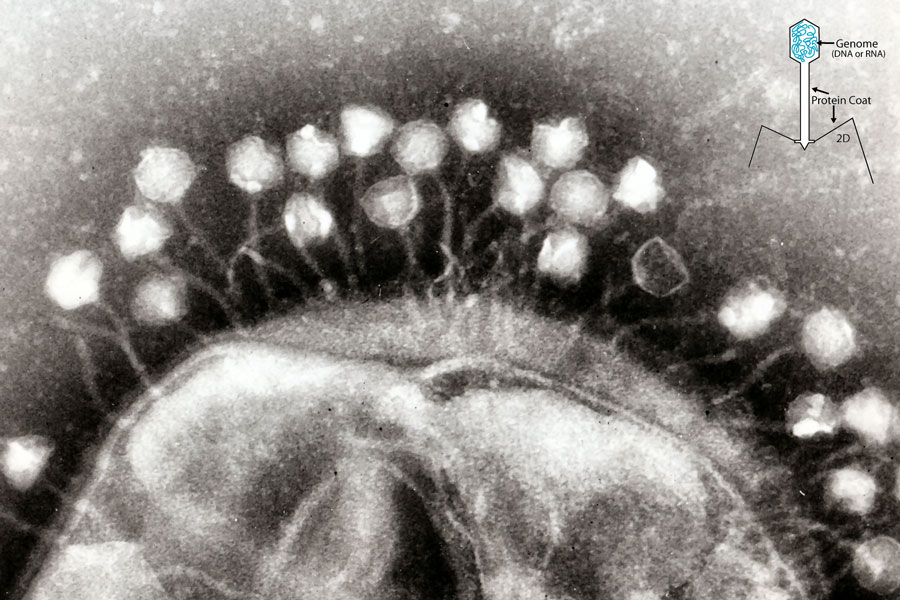

“La sinapsis neuronal es la zona de transmisión de impulsos nerviosos eléctricos entre dos células nerviosas (neuronas) o entre una neurona y una glándula o célula muscular. Una conexión sináptica entre una neurona y una célula muscular se denomina unión neuromuscular, mientras que la transmisión sináptica es el proceso por el que las células nerviosas se comunican entre sí.

Para que se produzca la comunicación entre las neuronas, un impulso eléctrico debe viajar por un axón hasta la terminal sináptica. El cerebro humano contiene alrededor de 100 mil millones de neuronas (o células nerviosas) y muchas más neuroglias (o células gliales) que sirven para apoyar y proteger a las neuronas. Cada neurona puede estar conectada hasta a 10.000 neuronas, transmitiéndose señales entre sí a través de hasta 1.000 billones de conexiones sinápticas, lo que equivale, según algunas estimaciones, a una computadora con un procesador de 1 billón de bits por segundo. Se cree que la capacidad de memoria del cerebro humano varía de entre 1 a 1,000 terabytes.”

Los procesos neuronales que subyacen en nuestro cerebro son en realidad desconocidos y, aunque son muchos los estudios y experimentos que se están realizando, su complejidad es tal que, de momento, los avances son muy limitados. Estamos tratando de conocer la máquina más compleja y perfecta que existe en el Universo.

Si eso es así, resultará que después de todo, no somos tan insignificantes como en un principio podría parecer, y solo se trata de tiempo. En su momento y evolucionadas, nuestras mentes tendrán un nivel de conciencia que estará más allá de las percepciones físicas tan limitadas. Para entonces, sí estaremos totalmente integrados y formando parte, como un todo, del Universo que ahora presentimos.

Algún día, muy lejano aún en el futuro, quizás (digo quizás), podremos saber por fin todo lo que encierra nuestro cerebro, y cómo se pudo formar tal maravilla que conforma un conjunto de complejidad tal, que no hemos sido capaces de poder descorrer el velo que esconde sus secretos.

El carácter especial de la conciencia me hace adoptar una posición que me lleva a decidir que no es un objeto, sino un proceso y que, desde este punto de vista, puede considerarse un ente digno del estudio científico perfectamente legítimo.

La conciencia plantea un problema especial que no se encuentra en otros dominios de la ciencia. En la Física y en la Química se suele explicar unas entidades determinadas en función de otras entidades y leyes. Podemos describir el agua con el lenguaje ordinario, pero podemos igualmente describir el agua, al menos en principio, en términos de átomos y de leyes de la mecánica cuántica. Lo que hacemos es conectar dos niveles de descripción de la misma entidad externa (uno común y otro científico de extraordinario poder explicativo y predictivo. Ambos niveles de descripción) el agua líquida, o una disposición particular de átomos que se comportan de acuerdo con las leyes de la mecánica cuántica (se refiere a una entidad que está fuera de nosotros y que supuestamente existe independientemente de la existencia de un observador consciente.)

En el caso de la conciencia, sin embargo, nos encontramos con una simetría. Lo que intentamos no es simplemente comprender de qué manera se puede explicar las conductas o las operaciones cognitivas de otro ser humano en términos del funcionamiento de su cerebro, por difícil que esto parezca. No queremos simplemente conectar una descripción de algo externo a nosotros con una descripción científica más sofisticada. Lo que realmente queremos hacer es conectar una descripción de algo externo a nosotros (el cerebro), con algo de nuestro interior: una experiencia, nuestra propia experiencia individual, que nos acontece en tanto que observadores conscientes.

Ninguna descripción, por prolija que sea, logrará nunca explicar cabalmente la experiencia subjetiva. Muchos filósofos han utilizado el ejemplo del color para explicar este punto. Ninguna explicación científica de los mecanismos neuronales de la discriminación del color, aunque sea enteramente satisfactorio, bastaría para comprender cómo se siente el proceso de percepción de un color. Ninguna descripción, ninguna teoría, científica o de otro tipo, bastará nunca para que una persona daltónica consiga experimentar un color.

Pensemos por un momento que tenemos un amigo ciego al que contamos lo que estamos viendo un día soleado del mes de abril: El cielo despejado, limpio y celeste, el Sol allí arriba esplendoroso y cegador que nos envía su luz y su calor, los árboles y los arbustos llenos de flores de mil colores que son asediados por las abejas, el aroma y el rumor del río, cuyas aguas cantarinas no cesan de correr transparentes, los pajarillos de distintos plumajes que lanzan alegres trinos en sus vuelos por el ramaje que se mece movido por una brisa suave, todo esto lo contamos a nuestro amigo ciego que, si de pronto pudiera ver, comprobaría que la experiencia directa de sus sentidos ante tales maravillas, nada tiene que ver con la pobreza de aquello que le contamos, por muy hermosas palabras que para hacer la descripción empleáramos.

La mente humana es tan compleja que, no todos ante la misma cosa, vemos lo mismo. Nos enseñan figuras y dibujos y nos piden que digamos (sin pensarlo) la primera cosa que nos sugiere. De entre diez personas solo coinciden tres, los otro siete divergen en la apreciación de lo que el dibujo o la figura les sugiere.

Escoger entre dos caminos y poco más. El mito del Libre Albedrío

Esto nos viene a demostrar la individualidad de pensamiento, el “libre albedrío” para decidir. Sin embargo, la misma prueba, realizada en grupos de conocimientos científicos similares y específicos: Físicos, matemáticos, químicos, etc., hace que el número de coincidencias sea más elevada, más personas ven la misma respuesta al problema planteado. Esto nos sugiere que, la mente está en un estado virgen que cuenta con todos los elementos necesarios para dar respuestas pero que necesita experiencias y aprendizaje para desarrollarse.

¿Debemos concluir entonces que una explicación científica satisfactoria de la conciencia queda para siempre fuera de nuestro alcance?

¿O es de alguna manera posible, romper esa barrera, tanto teórica como experimental, para resolver las paradojas de la conciencia?

Cuando tratamos de llegar a la conciencia para conocerla… ¡Nunca vemos una imagen completa!

La pregunta sobre si alguna vez podremos entender qué es la conciencia es una de las más fascinantes y desafiantes en la filosofía y la ciencia. Aunque la ciencia ha logrado identificar correlaciones entre la actividad cerebral y la conciencia, aún no hemos llegado a esa explicación satisfactoria que nos diga, sin ningún lugar a dudas, lo que la Conciencia es.

La respuesta a estas y otras preguntas, en mi opinión, radica en reconocer nuestras limitaciones actuales en este campo del conocimiento complejo de la mente, y, como en la Física cuántica, existe un principio de incertidumbre que, al menos de momento (y creo que en muchos cientos de años), nos impide saberlo todo sobre los mecanismos de la conciencia y, aunque podremos ir contestando a preguntas parciales, alcanzar la plenitud del conocimiento total de la mente no será nada sencillo, entre otras razones está el serio inconveniente que suponemos nosotros mismos, ya que, con nuestro que hacer podemos, en cualquier momento, provocar la propia destrucción.

Dentro de nuestros cerebros están todos los objetos del Universo y, también, todas las respuestas a las preguntas que planteamos y npo han tenido respuestas. Sin embargo, es sólo cosa de tiempo, a medida que la evolución avance, las respuestas llegaran con el conocimiento de cómo funciona la Naturaleza, la madre de todo lo que pasa a nuestro alrededor y también, de lo que, de momento, no podemos ver.

Una cosa si está clara: ninguna explicación científica de la mente podrá nunca sustituir al fenómeno real de lo que la propia mente pueda sentir. ¿Cómo se podría comparar la descripción de un gran amor con sentirlo, vivirlo física y sensorialmente hablando?

Hay cosas que no pueden ser sustituidas, por mucho que los analistas y especialistas de publicidad y marketing se empeñen, lo auténtico siempre será único. Si acaso, el que más se puede aproximar, a esa verdad, es el poeta.

Emilio Silvera Vázquez

May

7

¿Será único nuestro Universo?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comentarios desactivados en ¿Será único nuestro Universo?

Comentarios desactivados en ¿Será único nuestro Universo?

¿El mayor descubrimiento? ¡Son tántos!

Pudieran existir otros universos que como pompas de jabón se muevan por un Espacio “infinito” que solo podemos imaginar. Como existen otras galaxias y otras estrellas… ¿por qué no otros universos?

Como nunca nadie pudo estar en otro Universo, tenemos que imaginarlos y basados en la realidad del nuestro, realizamos conjeturas y comparaciones con otros que podrían ser. ¿Quién puede asegurar que nuestro Universo es único? Realmente nadie puede afirmar tal cosa e incluso, estando limitados a un mundo de cuatro dimensiones espacio-temporales, no contamos con las físicas necesarias para poder captar (si es que lo hay), ese otro universo paralelo o simbiótico que presentimos junto al nuestro y que sospechamos que está situado en ese “vacío” que no hemos llegado a comprender. Sin embargo, podríamos conjeturar que, ambos universos, se necesitan mutuamente, el uno sin el otro no podría existir y, de esa manera, estaríamos en un universo dual dentro de la paradoja de no poder conocernos mutuamente, al menos de momento, al carecer de los conocimientos necesarios que nos dieran la tecnología que se precisaría para ello.

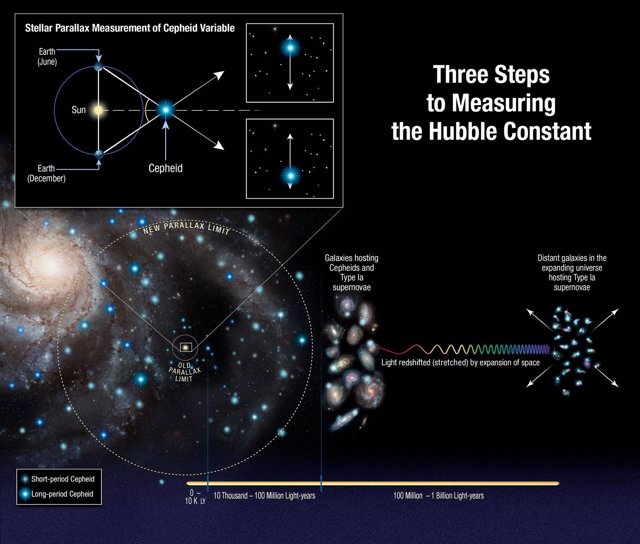

Es curioso como un equipo de astrónomos y cosmólogos estudiante la expansión del Universo y tratando de buscar la verdadera causa de dicho comportamiento (las galaxias se alejan las unas de las otras sin una razón aparente, toda vez que, la cantidad de materia bariónica percibida, no sería suficiente para arrastrarlas de esa manera), de manera denodada y pertinaz buscan el por qué se expande el universo de esa manera que no pueden explicar y, en dicha tarea, dicen haber percibido, más allá del supuesto “borde de nuestro Universo” la presencia de algo grande.

Lo único que se me ocurre pensar es en la presencia de otro universo que tira del nuestro por la fuerza de la gravedad que genera y, al final del camino, como ocurre con las galaxias, terminarán fusionándose los dos universos. Es lo que ocurre con las galaxias pero, aquí sería a escala mayor.

Imagináis la grandiosidad que está presente en una sola Galaxia como la nuestra. Así el poeta, hablando consigo mismo exclamó:

¡Oh mundo de mundos!

¡Oh vida de vidas!

¿Cuál es tu centro?

¿Dónde estamos nosotros?

¿Habrá más de lo que vemos?

¿Debemos prestar atención a las voces que oímos en nuestras mentes?

El Universo (al menos el nuestro), nos ofrece algo más, mucho más que grandes espacios vacíos, oscuros y fríos. En él podemos ver muchos lugares luminosos llenos de estrellas, de mundos y… muy probablemente de vida. Sin embargo, tenemos la sospecha de que, aparte del nuestro, otros universos podrían rondar por ahí y conformar un todo de múltiples Universos de características diversas y no en todos, sería posible la de estrellas y como consecuencia la Vida.

En nuestros deseos de querer saber sobre “esa verdad” que incansables perseguimos, hemos realizados innumerables excursiones por todos los senderos conocidos y otros nuevos que hemos dejado abiertos intentanto llegar a entender y explicar si, las fuerzas fundamentales de la Naturaleza y, las Constantes Universales pudieran estar presentes, en otros Universos de la misma manera que en el nuestro. La conclusión ha sido que no. Otros Universos (si existen) podrían ser iguales al nuestro y también, muy diferentes y todo dependería de su momento inicial que es el que determina la de Universo quen será cualquier universo que pudiera llegar a existir.

No es fácil imaginar cómo serían esos otros universos y como llegar a ellos, o, que criaturas los poblarían. Cualquier como que podamos imaginar podría ser superada por la realidad.

Hemos visto como los cosmólogos contemplan activamente la naturaleza de “otros mundos” en los que las constantes harían la vida imposible. Esto nos plantea la cuestión más profunda de si estos otros mundos “existen” en algún sentido y, si es así, qué los hace diferentes del mundo que vemos nosotros. También ofrece una alternativa al viejo argumento de que el aparente buen ajuste del mundo para que posea todas aquellas propiedades requeridas para la vida es de alguna forma de un diseño especial. Pues si existen todas las alternativas posibles, debemos encontrarnos necesariamente habitando en una de las que permiten que exista la vida. Y podríamos ir aún más lejos y aventurar la conjetura de que podríamos esperar encontrarnos en el tipo más probable de Universo que sustenta la vida.

¿Cómo pasar de uno al otro?

“Si pudiéramos saber que nuestro propio Universo era sólo uno de entre un número indefinido de ellos, con propiedades cambiantes, quizá podríamos invocar una solución análoga al principio de la selección natural; que sólo en ciertos universos, entre los que se incluye el nuestro, se dan las condiciones apropiadas para el surgir de la vida, y a menos que se satisfaga esta condición en otros universos no podría existir observadores para advertir tal hecho.”

¡No saben lo que se pierden! ¡Pobres universos!

Una de las dificultades de concebir siquiera semejante multiverso de todos los universos posibles es que hay muchas cosas que podrían ser diferentes. De nuestro estudio de las matemáticas sabemos que existen lógicas diferentes a la que utilizamos en la práctica, en la que los enunciados son o verdaderos o falsos. Análogamente, hay diferentes estructuras matemáticas; diferentes leyes de la Naturaleza posible; diferentes valores para las constantes de la Naturaleza; diferentes números de dimensiones de Espacio y de Tiempo; diferentes de partida para el Universo; y diferentes resultados aleatorios para secuencias complejas de sucesos. Frente a ello, la colección de todos los mundos posibles tendría que incluir, como mínimo, todas las permutaciones y combinaciones posibles de estas diferentes cosas. Obtener una comprensión de todo este maremágnum sería pedirnos demasiado (al menos por el momento).

Claro que, concebir Universos con más dimensiones que el nuestro… ‘Se nos hace muy cuesta arriba! Nuestras mentes son tridimensionales y, hemos al añadido de esa cuarta dimensión temporal que nos trajo la relatividad especial pero, cuando tratamos de ir más allá, no asimilamos bien y la visión de ese “mundo” de dimensiones extra, no caben en nuestra cabeza. Sin embargo, los números sí lo permiten y pueden configurar universos de 10, 11 y hasta 26 dimensiones y, en ese mundo teórico-matemático, sí pueden convivir todas las fuerzas de nuestro Universo y allí podemos respuestas que, en nuestro Universo cotidiano cuatridimensional, no podemos hallar.

Super gravedad, supersimetría y las cuerdas heteróticas, todas incluidas en la Teoría M

Lo cierto es que, ya hemos visto lo que puede suceder si se realizaran algunos de esos otros mundos posibles, mundos con más dimensiones u otros valores de las constantes cruciales. Sin embargo, no sabemos si estos diferentes mundos son realmente posibles. Está muy bien contemplar cambios en las constantes de la Naturaleza y las cantidades que definen la forma y el tamaño del Universo. Pero ¿hay realmente universos alternativos permitidos o son tan posibles como los círculos cuadrados? Podría ser que la “Teoría de Todo” sea muy restrictiva cuando se trate de dar permiso de planificación para otros universos.

Por imaginar que no quede. Nuestras mentes construyen escenarios que…

El hecho de que podamos concebir muchos universos alternativos, definidos por otros valores de las constantes de la Naturaleza, quizá sea simplemente un reflejo de nuestra ignorancia acerca de “la prisión” en la que está confinada la consistencia lógica que exige una Teoría de Todo. Cuando se trata de contemplar otros universos tenemos dos formas de abordar el problema.

Existe la aproximación conservadora que produce mundos alternativos haciendo pequeños cambios en las propiedades de nuestro mundo; pequeños cambios en los valores de algunas de las constantes de la Naturaleza, propiedades ligeramente diferentes del Universo astronómico, quizá, pero no cambios en las propias leyes de la Naturaleza. Normalmente estos muestran que si “los pequeños cambios” son demasiado grandes hay consecuencias adversas para la existencia de la vida tal como la conocemos. Nuestro tipo de vida puede seguir existiendo si hubiera un cambio de una parte en cien mil millones en el valor de la constante de estructura fina, pensamos nosotros, pero no si hubiera un cambio de una parte entre diez.

Sin duda habrá mundos como Pandora donde sus criaturas estén en simbiosis con la Naturaleza

¿Quién sabe? Con unas constantes diferentes podríamos tener cualquier clase de Universo incluso ¿Alguno en la sombra? Claro que grandes cambios pueden alterar otras cosas como las leyes, la lógica matemática subyacente o el de dimensiones del espacio tiempo. Tiene que concebir tipos de “vida” que ni podemos imaginar, serían completamente nuevos y que podrían existir en ambientes tan diferentes al nuestro que, incluso, teniéndolos a nuestro lado, no lo podríamos ver y, claro, al llegar a este punto nos suscita tener que hacer un examen más detallado de qué entendemos por vida, dado que esa vida de ese otro universo, sería tan vida como la del nuestro.

Ante todas estas ideas… al ver escenas de nuestro mundo como la que arriba contemplamos, no puedo dejar de imaginar lo que pensarían seres de otros mundos que nos pudieran estar observando. Fabricamos “colmenas” que nos sirven de habitad y que están adecuadas a las de nuestro mundo. En otros mundos mucho mayores, de tener presente la vida, dada su enorme gravedad, ésta tendría que ser pequeña ¿De insectos quizá?

No sería nada visitar otro Universo en cuyos mundos sólo vivieran insectos de dos metros, o, aquellos otros que, poblados de sofisticados robots tuvieran una Sociedad constituida sobre una continuada replicación y su único objetico sería el de poblar mundos y más mundos en los que, como sería lógico pensar, no cabrían otros seres que, como nosotros, vinieran de un origen natural que serían, seguramente, los seres primigenios del planeta que construyeron a los que hoy dominan esos mundos.

Haber podido conquistar algunos conocimientos que nos hablan de la inmensidad del Universo, de la diversidad de infinitas estrellas y de la multiplicidad de mundos que existen en las galaxias que pueblan el Cosmos, no podemos dejar de imaginar los mundos que, con propiedades diferentes a las de la Tierra, puedan albergar a criaturas que, unas veces habrán alcanzado la consciencia y otras no. Cuando podamos alcanzar la tecnología necesaria para visitar otros mundos que orbitan a estrellas similares y diferentes al Sol, entonces, y sólo entonces, podremos comprender que la vida en el Universo es de muchas maneras y que no estamos solos en tan vasto espacio.

Cientos de miles de millones de estrellas y de mundos y… de formas de vida

Negarlo no lo podemos negar y, hasta es muy probable que sí puedan existir esos otros Universos. Sin embargo, yo me quedo con el nuestro que, poco a poco, se va dejando descorrer el velo que esconde sus secretos y estamos llegando a un nivel aceptable de comprensión de lo que su Naturaleza pudiera ser. Ningún Universo como el nuestro para vivir y tratar de llevar a cabo nuestros proyectos de futuro. Y, si finalmente nos vemos abocados a tener que “mudarnos” a uno de esos otros Universos, lo esencial será comprobar antes que, las son exactas o muy parecidas a las del nuestro.

Los cúmulos de galaxias se separan los unos de los otros y el frío se apodera de todo. Cuando llegue el Cero absoluto… -273,15 ºC, ni los átomos se moverán, no se formarán nuevas estrellas ni nuevos mundos ni vida nueva.

Este escenario evolutivo de nuestro Universo tiene la característica clave de que las físicas en el pasado no eran las mismas que las actuales o las futuras. Hubo épocas en que la vida no podía existir porque había demasiado calor para los átomos; hubo épocas previas a las estrellas y habrá un tiempo en el que todas las estrellas hayan muerto. En este escenario hay un intervalo preferido de la historia cósmica durante el que es más probable que los observadores evolucionen por primera vez y hagan sus observaciones del Universo y, si hemos hecho nuestra tarea, también sabremos de esos otros universos que nos pudieran acoger en ese momento final del nuestro.

¡Es todo tan complicado! ¡Sabemos tan poco!

¿Estaría programada la presencia de los seres vivos inteligentes en el Universo?

Por fuerza la cosmología conduce a cuestiones fronterizas entre ciencia experimental, filosofía y religión. No es solo el caso de los sabios antiguos. También los físicos de hoy se plantean preguntas de esa clase, sobre todo a propósito del llamado “principio antrópico”. A partir de los conocimientos actuales, este principio señala que las leyes y magnitudes físicas fundamentales parecen cuidadosamente afinadas para que la formación y el desarrollo del universo pudieran dar lugar a la vida en la Tierra y en otros planetas idóneos para acogerla.

El “Principio Copernicano”, invocado frecuentemente en la Cosmología moderna, insiste en la homogeneidad del Universo, negando cualquier primacía de posición o propiedades asociadas con la existencia humana. En cualquier parte del Universo podrán estar presentes los seres vivos.

El “Principio Copernicano” como habréis deducido ya, toma su nombre de la propuesta de Copérnico (ya anteriormente formulada por Aristarco) de desplazar a la Tierra de la posición central ocupada en el sistema de Tolomeo, aunque tal centralidad se debiese a la falta de paralaje estelar y no a una sobrevaloración de nuestra existencia en el planeta.

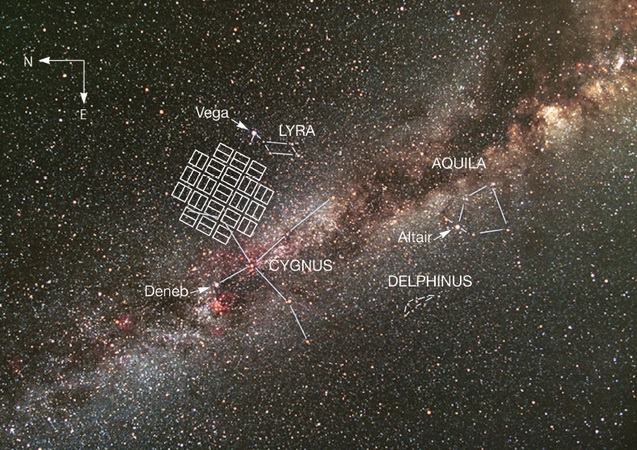

Ahí estamos en el interior del Brazo de Orión lejos del centro

El paso siguiente lo dio Shapley hace un siglo, al mostrar que tampoco el Sol ocupa el centro de la Via Láctea. Finalmente, el Universo “finito pero ilimitado” de Einstein niega la posibilidad de encontrar un centro en su volumen tridimensional, y afirma la equivalencia de posición de todos los puntos del espacio. No tiene sentido preguntar dónde estamos en el continuo expandirse de un Universo que contiene probablemente más de 100.000 millones de galaxias, y que vuelve a la insignificancia aun la majestuosa estructura de la Vía Láctea, nuestra ciudad cósmica.

Sí, son muchas las conexiones y las cosas que no hemos llegado a comprender. Nuestra presencia en el Universo, el discurrir de nuestros pensamientos, …

Sin embargo, a partir de la década de los años 30, se da una reacción interesante, que afirma, cada vez con argumentos más fuertes y detallados, que el Hombre está en un tiempo y un lugar atípicos y privilegiados en muchos aspectos, que obligan a preguntarnos si nuestra existencia está ligada en un modo especial a características muy poco comunes en el Universo. Esta pregunta adquiere un significado especial al considerar las consecuencias previsibles (según las leyes físicas) de cualquier alteración en las condiciones iniciales del Universo. Con un eco de las palabras de Einstein: ¿tuvo Dios alguna alternativa al crear?. No solamente debemos dar razón de que el Universo exista, sino de que exista de tal manera y con tales propiedades que la vida inteligente puede desarrollarse en él. Tal es la razón de que se formule el Principio Antrópico, en que el Hombre (entendido en el sentido filosófico de “animal racional”, independientemente de su hábitat y su morfología corporal) aparece como condición determinante de que el Universo sea como es.

No hemos logrado ese contacto pero…llegará y, al menos yo, no las tengo todas conmigo.

Las primeras sugerencias de una conexión entre vida inteligente y las propiedades del Universo en su momento actual aparecen en las relaciones adimensionales hechas notar por Eddington: la razón de intensidad entre fuerza electromagnética y fuerza gravitatoria entre dos electrones, entre la edad del Universo y el tiempo en que la luz cruza el diámetro clásico de un electrón, entre el radio del Universo observable y el tamaño de una partícula subatómica, nos da cifras del orden de 10 elevado a la potencia 40. El número de partículas nucleares en todo el cosmos se estima como el cuadrado de ese mismo número. ¿Son éstas coincidencias pueriles o esconden un significado profundo?. La hipótesis de los grandes números sugiere que el Hombre solamente puede existir en un lugar y momento determinado, cuando tales coincidencias se dan, aunque nadie hasta el momento ha podido dar una explicación de estas relaciones.

Arthur Eddintong

Eddintong, un gran astrónomo, nos ayudo a comprender mucho mejor el Universo y sus ideas germinaron en el saber de esa ciencia que nos lleva a conocer el inmenso entorno al que pertenecemos.

Si la carga del electrón, la masa del protón o la velocidad de la luz, variaran tan sólo una diezmilésima parte… ¡La vida tal como la conocemos no existiría! Es decir, estamos ante el problema del ajuste fino que significa que las las constantes fundamentales de un modelo físico para el universo deben ser ajustados de forma precisa para permitir la existencia de vida. Sobre estas constantes fundamentales no hay nada en la teoría que nos indique que deban tomar esos valores que toman. Podemos fijarlas de acuerdo con las observaciones, pero esto supone fijarlas de entre un rango de valores colosal. Esto da la impresión de cierta arbitrariedad y sugiere que el universo podría ser una realización improbable entre tal rango de valores. He ahí el problema.

El principio antrópico nos invita al juego mental de probar a “cambiar” las constantes de la naturaleza y entrar en el juego virtual de ¿Qué hubiera pasado si…? Ya hemos hablado aquí muchas otras veces de lo que pasaría si el valor de las constantes fueran diferentes.

¿Viviríamos en un mundo de revés?

Especulamos con lo que podría haber sucedido si algunos sucesos no hubieran ocurrido de tal o cual manera para ocurrir de esta otra. ¿Qué hubiera pasado en el planeta Tierra si no aconteciera en el pasado la caída del meteorito que acabó con los dinosaurios? ¿Habríamos podido estar aquí hoy nosotros? ¿Fue ese cataclismo una bendición para nosotros y nos quitó de encima a unos terribles rivales?

Fantasean con lo que pudo ser…. Es un ejercicio bastante habitual; sólo tenemos que cambiar la realidad de la historia o de los sucesos verdaderos para pretender fabricar un presente distinto. Cambiar el futuro puede resultar más fácil, nadie lo conoce y no pueden rebatirlo con certeza. ¿Quién sabe lo que pasará mañana?

¿Serán ellos y no nosotros los que dominen el futuro?

Siempre estamos imaginando el futuro que vendrá. Los hombres tratan de diseñarlo pero, finalmente, será el Universo el que tome la última palabra de lo que deba ser. Por mucho que nosotros nos empeñemos, las estructuras del Universo nunca podrán ser cinceladas por nuestras manos ni por nuestros ingenios, sólo las inmensas fuerzas de la Naturaleza puede transformar las estrellas, las galaxias o los mundos…lo demás, por muy bello que pudiera ser, siempre será lo artificial.

Lo que ocurra en la naturaleza del universo está en el destino de la propia naturaleza del cosmos, de las leyes que la rigen y de las fuerzas que gobiernan su mecanismo sometido a principios y energías que, en la mayoría de los casos se pueden escapar a nuestro actual conocimiento.

Subimos por una escalera de la que no vemos el final ni sabemos a qué lugar nos llevará

Lo que le pueda ocurrir a nuestra civilización, además de estar supeditada al destino de nuestro planeta y de nuestro Sol, incluso de nuestro Sistema Solar y de la Galaxia, de alguna manera, también está en manos de los propios individuos que forman esta civilización y que, con sensibilidades distintas y muchas veces dispares, hace impredecibles los acontecimientos que puedan provocar individuos que participan con el poder individual de libre albedrío. Fijaos hoy mismo lo que puede dar de sí esa insensata polémica (que dura ya milenios) entre los palestinos y los israelitas.

Siempre hemos sabido especular con lo que pudo ser o con lo que podrá ser si… Lo que en la mayoría de las veces, es el signo de cómo queremos ocultar nuestra ignorancia. Bien es cierto que sabemos muchas cosas pero, también es cierto que son más numerosas las que no sabemos.

Emilio Silvera Vázquez

May

7

¿Será único nuestro Universo? II

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (1)

Comments (1)

Lo que faltó del trabajo que aparece a continuación de esta terminación (No se como se perdió al publicarlo pero faltó este trozo que ahora os pongo aquí).

Subimos por una escalera de la que no vemos el final ni sabemos a qué lugar nos llevará

Lo que le pueda ocurrir a nuestra civilización, además de estar supeditada al destino de nuestro planeta y de nuestro Sol, incluso de nuestro Sistema Solar y de la Galaxia, de alguna manera, también está en manos de los propios individuos que forman esta civilización y que, con sensibilidades distintas y muchas veces dispares, hace impredecibles los acontecimientos que puedan provocar individuos que participan con el poder individual de libre albedrío. Fijaos hoy mismo lo que puede dar de sí esa insensata polémica (que dura ya milenios) entre los palestinos y los israelitas.

Siempre hemos sabido especular con lo que pudo ser o con lo que podrá ser si… Lo que en la mayoría de las veces, es el signo de cómo queremos ocultar nuestra ignorancia. Bien es cierto que sabemos muchas cosas pero, también es cierto que son más numerosas las que no sabemos.

Cuando el Sol agote todo su combustible nuclear, estará acercándose el final de la Tierra como planeta que albergó la vida. Los cambios serán irreversibles, los océanos se evaporarán y sus aguas hirvientes comenzarán a llenar la atmósfera de gases. La Gigante roja engullirá a los planetas Mercurio, Venus y probablemente se quedará muy cerca de la Tierra calcinada y sin vida.

Sabiendo que el destino irremediable de nuestro mundo, el planeta Tierra, es de ser calcinado por una estrella gigante roja en la que se convertirá el Sol cuando agote la fusión de su combustible de hidrógeno, helio, carbono, etc, para que sus capas exteriores de materia exploten y salgan disparadas al espacio exterior, mientras que, el resto de su masa se contraerá hacia su núcleo bajo su propio peso, a merced de la gravedad, convirtiéndose en una estrella enana blanca de enorme densidad y de reducido diámetro. Sabiendo eso, el hombre está poniendo los medios para que, antes de que llegue ese momento (dentro de algunos miles de millones de años), poder escapar y dar el salto hacia otros mundos lejanos que, como la Tierra ahora, reúna las condiciones físicas y químicas, la atmósfera y la temperatura adecuadas para acogernos.

Cualquiera de estas figuras podría ser la Nebulosa planetaria formada por el Sol cuando “muera”

En el inmenso Universo, eso es lo que podría quedar nuestro Sol, una insignificante Nebulosa Planetaria y, la consecuencia de tal transición de fase será, una Tierra sin vida y un Sistema solar de objetos muertos.

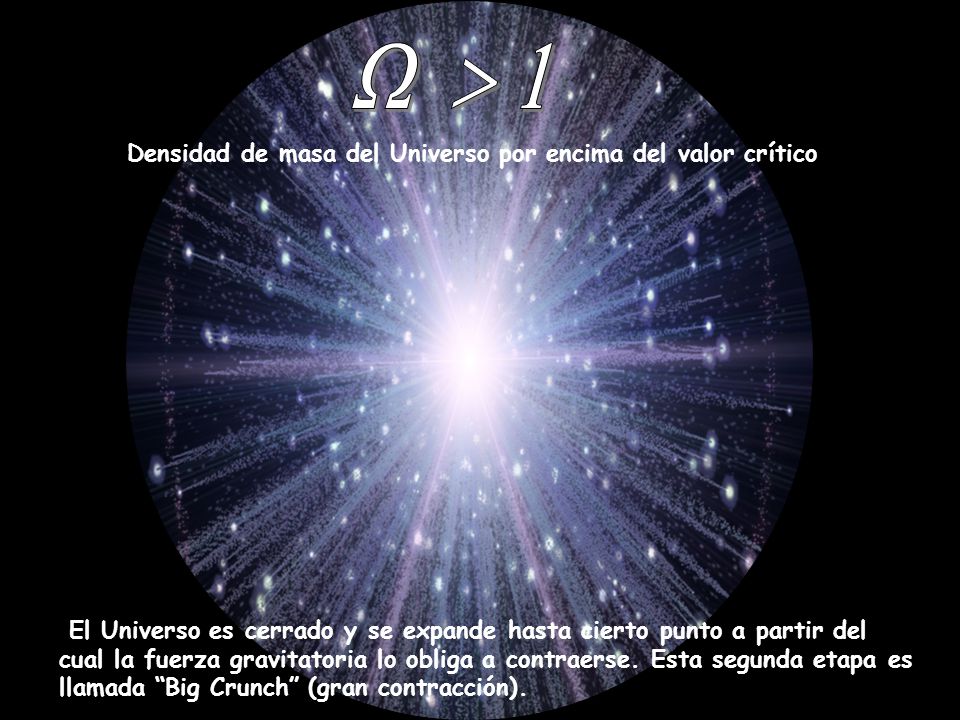

Pero el problema no es tan fácil y se extiende a la totalidad del universo que, aunque mucho más tarde, también está abocado a la muerte térmica, el frío absoluto si se expande para siempre como un universo abierto y eterno, o el más horroroso de los infiernos, si estamos en un universo cerrado y finito en el que, un día, la fuerza de gravedad, detendrá la expansión de las galaxias que comenzarán a moverse de nuevo en sentido contrario, acercándose las unas a las otras de manera tal que el universo comenzará, con el paso del tiempo, a calentarse, hasta que finalmente, se junte toda la materia-energía del universo en una enorme bola de fuego de millones de grados de temperatura, el Big Crunch. Eso daría lugar a otro Big Bang, a otro universo. Sin embargo, según los datos de que se dispone hoy, no parece que el Big Crunch pueda suceder.

Un universo replegándose sobre sí mismo…no parece probable. Según las medidas de la masa del Universo, parece que estamos en un universo plano, con lo cual, el Big Crunch no parece que se produzca.

El irreversible final está entre los dos modelos que, de todas las formas que lo miremos, es negativo para la Humanidad (si es que para entonces aún existe). En tal situación, algunos ya piensan en la manera de escapar a tan terrible futuro. Claro que, ahora no podemos saber si finalmente, nuestro Universo se fundirá con otro como consecuencia de la expansión (el otro también se expande hacia nosotros) y, como se fusionan las galaxias, también deben hacerlo los universos. Si eso es así (que no se sabe), quizá todo diera lugar a un nuevo “amanecer” para la Humanidad.

Stephen Hawking ha llegado a la conclusión de que estamos inmersos en un multiverso, esto es, que existen infinidad de universos conectados los unos a los otros. Unos tienen constantes de la naturaleza que permiten vida igual o parecida a la nuestra, otros posibilitan formas de vida muy distintas y otros muchos no permiten ninguna clase de vida.

Este sistema de inflación auto-reproductora nos viene a decir que cuando el universo se expande (se infla) a su vez, esa burbuja crea otras burbujas que se inflan y a su vez continúan creando otras nuevas más allá de nuestro horizonte visible. Cada burbuja será un nuevo universo, o mini-universo en los que reinarán escenarios diferentes o diferentes constantes y fuerzas.

¿Quién puede saber de lo que seremos capaces mañana?

El posible escenario futuro ha sido explorado y el resultado hallado es que, podrían exisitr otros universos en cada uno de esos universos, puede haber muchas cosas diferentes; pueden terminar con diferentes números de dimensiones espaciales o diferentes constantes y fuerzas de la naturaleza, pudiendo unos albergar la vida y otros no. ¡Qué locura!

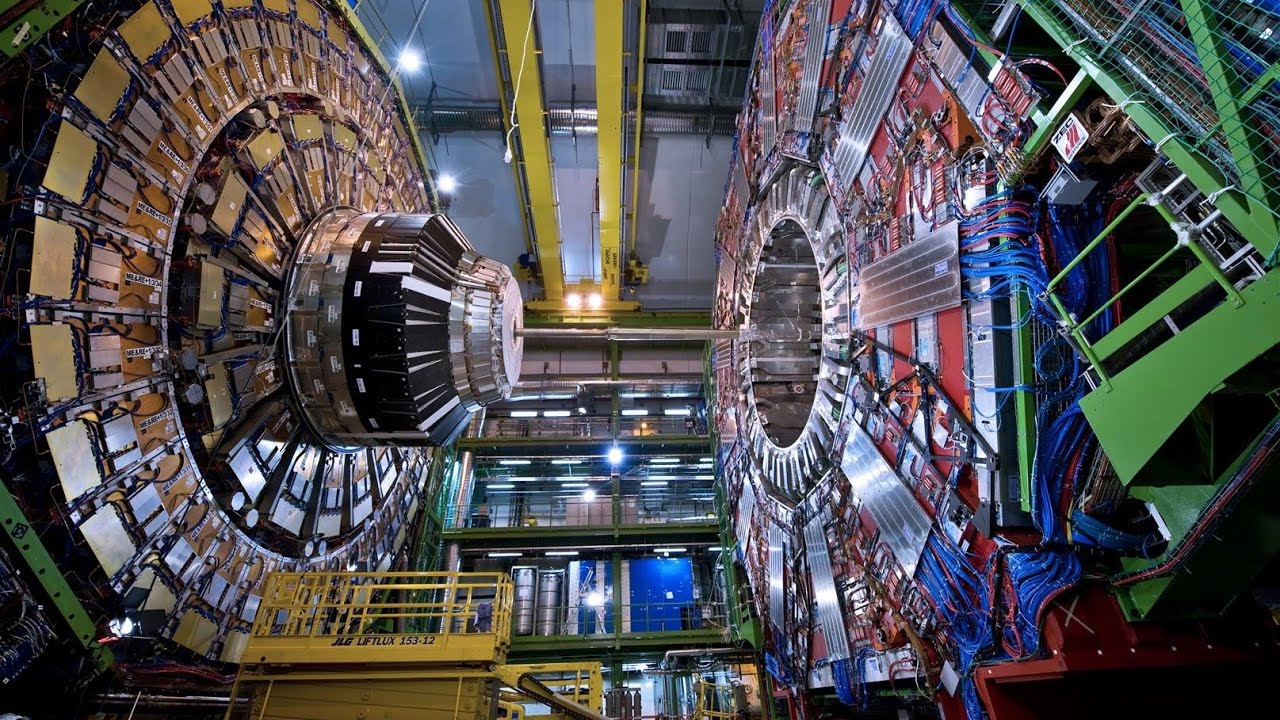

El reto que queda para los cosmólogos es calcular las probabilidades de que emerjan diferenta universos a partir de esta complejidad inflacionaria ¿Son comunes o raros los universos como el nuestro? Existen, como para todos los problemas planteados, diversas conjeturas y consideraciones que influyen en la interpretación de cualquier teoría cosmológica futura cuántico-relativista. Hasta que no seamos capaces de exponer una teoría que incluya la relatividad general de Einstein (la gravedad-cosmos) y la mecánica cuántica de Planck (el cuanto-átomo), no será posible contestar a ciertas preguntas.

Hablando de universos paralelos, Douglas Adams nos dice:

“Lo primero que hay que comprender sobre los universos paralelos… es que no son paralelos. Es importante comprender que ni siquiera son, estrictamente hablando, universos, pero es más fácil si uno lo intenta y lo comprende un poco más tarde, después de haber comprendido que todo lo que ha comprendido hasta el momento no es verdadero.”

La teoría de cuerdas tiene un gancho tremendo. Te transporta a un mundo de 11 dimensiones, universos paralelos, y partículas formadas por cuerdecitas casi invisibles vibrando a diferentes frecuencias. Además, te dice que no se trata de analogías sino de la estructura más profunda de la realidad, y que ésta podría ser la teoría final que unificara por fin a toda la física. ¿No estaremos hablando de Filosofía?

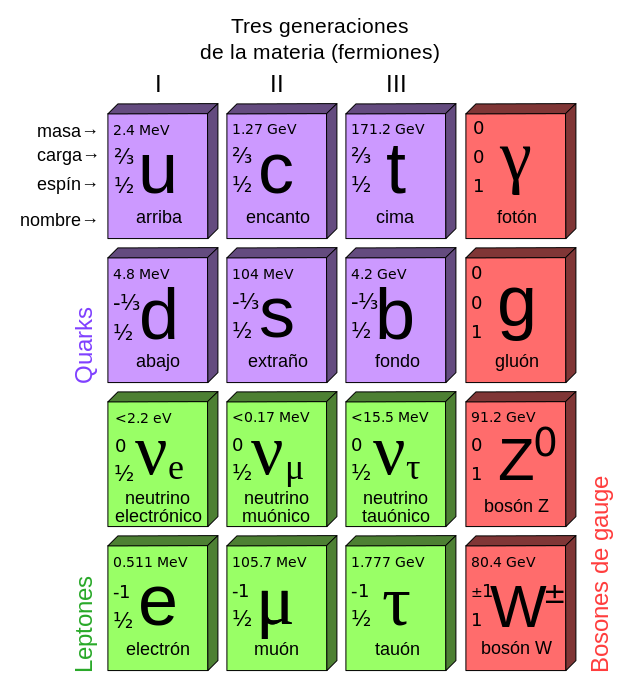

Todas las soluciones que buscamos parecen estar situadas en teorías más avanzadas que, al parecer, sólo son posibles en dimensiones superiores, como es el caso de la teoría de supercuerdas situada en 10, 11 ó 26 dimensiones. Allí, si son compatibles la relatividad y la mecánica cuántica, hay espacio más que suficiente para dar cabida a las partículas elementales, las fuerzas gauge de Yang-Mill, el electromagnetismo de Maxwell y, en definitiva, al espacio-tiempo y la materia, la descripción verdadera del universo y de las fuerzas que en él actúan.

Científicamente, la teoría del hiperespacio lleva los nombres de Teoría de Kaluza-Klein y super-gravedad. Pero en su formulación más avanzada se denomina Teoría de Supercuerdas, una teoría que desarrolla su potencial en nueve dimensiones espaciales y una de tiempo: diez dimensiones. Así pues, trabajando en dimensiones más altas, esta teoría del hiperespacio puede ser la culminación que conoce dos milenios de investigación científica: la unificación de todas las fuerzas físicas conocidas. Como el Santo Grial de la Física, la “teoría de todo” que esquivó a Einstein que la buscó los últimos 30 años de su vida (sin tener las herramientas matemáticas necesarias para ello).

¿Quién sabe si los caminos hacia otros universos no estarán ya imaginados?

Es cierto, los mejores siempre han buscado el Santo Grial de la Física. Una Teoría que lo pueda explicar todo, la más completa que, mediante una sencilla ecuación, responda a los misterios del Universo. Claro que tal hazaña, no depende siquiera de la inteligencia del explorador que la busca, es más bien un problema de que las herramientas necesarias (matemáticas) para hallarla, aún no han sido inventadas.

Durante el último medio siglo, los científicos se han sentido intrigados por la aparente diferencia entre las fuerzas básicas que mantienen unido al cosmos: la Gravedad, el electromagnetismo y las fuerzas nucleares fuerte y débil. Los intentos por parte de las mejores mentes del siglo XX para proporcionar una imagen unificadora de todas las fuerzas conocidas han fracasado. Sin embargo, la teoría del hiperespacio permite la posibilidad de explicar todas las fuerzas de la naturaleza y también la aparentemente aleatoria colección de partículas subatómicas, de una forma verdaderamente elegante. En esta teoría del hiperespacio, la “materia” puede verse también como las vibraciones que rizan el tejido del espacio y del tiempo. De ello se sigue la fascinante posibilidad de que todo lo que vemos a nuestro alrededor, desde los árboles y las montañas a las propias estrellas, no son sino vibraciones del hiperespacio.

Queremos llegar a manejar los mundos, las galaxias, el universo… Y para ello imaginamos

Antes mencionábamos los universos burbujas nacidos de la inflación y, normalmente, el contacto entre estos universos burbujas es imposible, pero analizando las ecuaciones de Einstein, los cosmólogos han demostrado que podría existir una madeja de agujeros de gusano, o tubos, que conectan estos universos paralelos.

Aunque muchas consecuencias de esta discusión son puramente teóricas, el viaje en el hiperespacio puede proporcionar eventualmente la aplicación más práctica de todas: salvar la vida inteligente, incluso a nosotros mismos, de la muerte de este universo cuando al final llegue el frío o el calor.

Esta nueva teoría de supercuerdas tan prometedora del hiperespacio es un cuerpo bien definido de ecuaciones matemáticas. Podemos calcular la energía exacta necesaria para doblar el espacio y el tiempo o para cerrar agujeros de gusano que unan partes distantes de nuestro universo. Por desgracia, los resultados son desalentadores. La energía requerida excede con mucho cualquier cosa que pueda existir en nuestro planeta. De hecho, la energía es mil billones de veces mayor que la energía de nuestros mayores colisionadores de átomos. Debemos esperar siglos, o quizás milenios, hasta que nuestra civilización desarrolle la capacidad técnica de manipular el espacio-tiempo utilizando la energía infinita que podría proporcionar un agujero negro para de esta forma poder dominar el hiperespacio que, al parecer, es la única posibilidad que tendremos para escapar del lejano fin que se avecina. ¿Qué aún tardará mucho? Sí, pero el tiempo es inexorable, la debacle del frío o del fuego llegaría.

¿Doblar el Hiperespacio…? ¡Encontrar la manera de burlar la velocidad de la luz!

No existen dudas al respecto, la tarea es descomunal, imposible para nuestra civilización de hoy, ¿pero y la de mañana?, ¿no habrá vencido todas las barreras? Creo que el hombre es capaz de plasmar en hechos ciertos todos sus pensamientos e ideas, sólo necesita tiempo:

¡El Tiempo! ¿Tendremos mucho por delante? ¿Sabremos aprovecharlo?

Emilio Silvera Vázquez

May

7

¿Un Universo complejo? ¿Y nosotros qué?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo asombroso ~

Clasificado en El Universo asombroso ~

Comments (0)

Comments (0)

13.750 millones de años y sigue la expansión desbocada, más rápida que la velocidad de la luz

Cuando pensamos en la edad y el tamaño del universo lo hacemos generalmente utilizando medidas de tiempo y espacio como años, kilómetros o años-luz. Como ya hemos visto, estas medidas son extraordinariamente antropomórficas. ¿Por qué medir la edad del universo con un “reloj” que hace “tic” cada vez que nuestro planeta completa una órbita alrededor de su estrella madre, el Sol? ¿Por qué medir su densidad en términos de átomos por metro cúbico? Las respuestas a estas preguntas son por supuesto la misma: porque es conveniente y siempre lo hemos hecho as.

A medida que examinamos volúmenes cada vez mayores del Universo, la densidad de material que encontramos sigue disminuyendo hasta que salimos de las dimensiones de los cúmulos de galaxias. Cuando llegamos a dicha escala, la acumulación de materia empieza a desvanecerse y se parece cada vez más a una minúscula perturbación aleatoria de un mar uniforme de materia, con una densidad de aproximadamente un átomo por cada metro cúbico.

A medida que buscamos en las mayores dimensiones visibles del Universo, encontramos que las desviaciones de la uniformidad perfecta de la materia y la radiación se quedan en un bajo nivel de sólo una parte en cien mil. Esto nos muestra que el Universo no es lo que se ha llegado a conocerse como un fractal, en donde la acumulación de materia en cada escala parece una imagen ampliada de la escala superior siguiente.

La Densidad Crítica del Universo parece que es la ideal. La cantidad total de Materia del Universo se da generalmente en términos de una cantidad llamada Densidad Crítica, denotada por Omega (Ω). Esta es la densidad de la materia que se necesita para producir un universo plano. Si la Densidad efectivamente observada es menor o mayor que ese parámetro, en el primer caso el Universo es abierto, en el segundo es cerrado. La Densidad Crítica no es muy grande; corresponde aproximadamente a un protón por metro cúbico de espacio (1 protón por m3 de espacio). Puede que no parezca mucho, dado el número inmenso de átomos en un metro cúbico de lodo, pero no debemos olvidar que existe una gran cantidad de espacio “vacío” entre las galaxias.

Que el Universo posea una densidad muy baja no es un accidente. La expansión del Universo relaciona su tamaño y su edad con la atracción gravitatoria del material que contiene. Para que el Universo se expanda el tiempo suficiente para permitir que los ladrillos de la vida se formen en los interiores de las estrellas debe tener una edad de miles de millones de años. Esto significa que debe tener una extensión de de miles de millones de años luz y poseer una densidad de materia promedio muy pequeña y una temperatura muy baja.

George Johnstone Stoney

En su charla de la Reunión de Belfast, Stoney se refirió al electrón como el “electrino” y dio el primer cálculo de su valor esperado. Demostró que el trío mágico de G, c y e podía combinarse de una manera, y sólo de una, de modo que a partir de ellas se creaban una unidad de masa, una unidad de longitud y una unidad de tiempo. Para la velocidad de la luz utilizó un promedio de las medidas existentes, c = 3 × 108 metros por segundo; para la constante de gravitación de Newton utilizó el valor obtenido por John Herschel, G = 6’67259 × 10-11 m3 s-2 Kg-1, y para la unidad de carga del “electrino” utilizó e = 10-20 amperios. Estas fueron las inusuales nuevas unidades que él encontró, en términos de las constantes e, c y G, y en términos de gramo, metros y segundos:

Mi = (e2/g)½ = 10-17 gramos

Li = ( Ge2/c4) ½ = 10-17 metros

Ti = (Ge2/c6)½ = 3 x 10-16 segundos

Estas son cantidades extraordinarias. Aunque una masa de 10-7 gramos no es demasiado espectacular-es similar a la de una mota de polvo- las unidades de longitud y tiempo de Stoney eran muy diferentes de cualquiera que hubieran encontrado antes los científicos. Eran fantásticamente pequeñas, rosando lo inconcebible. No había (y sigue sin haber) ninguna posibilidad de medir directamente tales longitudes y tiempos.

En cierto modo, esto es lo que se podría haber esperado. Estas unidades no están construidas deliberadamente a partir de dimensiones humanas, por conveniencia humana o para utilidad humana. Están definidas por la propia fábrica de la realidad física que determina la Naturaleza de la luz, la electricidad y la gravedad (c, e y G). No se preocupan de nosotros. Stoney triunfó de un modo brillante en su búsqueda de un sistema de unidades sobrehumanas.

Ésta es una situación en donde resulta especialmente apropiado utilizar las unidades “naturales”; la masa, longitud y tiempo de Stoney y Planck, las que ellos introdujeron en la ciencia física para ayudarnos a escapar de la camisa de fuerza que suponía la perspectiva centrada e el ser humano.

Ahí lo único que puedes encontrar es alguna pelotilla

Es fácil caer en la tentación de mirarnos el ombligo y no hacerlo al entorno que nos rodea. Muchas más cosas habríamos evitado y habríamos descubierto si por una sola vez hubiésemos dejado el ego a un lado y, en lugar de estar pendientes de nosotros mismos, lo hubiéramos hecho con respecto a la naturaleza que, en definitiva, es la que nos enseña el camino a seguir.

La edad actual del universo visible ≈ 1060 tiempos de Planck

Tamaño actual del Universo visible ≈ 1060 longitudes de Planck

La masa actual del Universo visible ≈ 1060 masas de Planck

Vemos así que la bajísima densidad de materia en el universo es un reflejo del hecho de que:

Densidad actual del universo visible ≈10-120 de la densidad de Planck

Y la temperatura del espacio, a 3 grados sobre el cero absoluto es, por tanto

Temperatura actual del Universo visible ≈ 10-30 de la Planck

Estos números extraordinariamente grandes y estas fracciones extraordinariamente pequeñas nos muestran inmediatamente que el universo está estructurado en una escala sobrehumana de proporciones asombrosas cuando la sopesamos en los balances de su propia construcción.

Con respecto a sus propios patrones, el universo es viejo. El tiempo de vida natural de un mundo gobernado por la gravedad, la relatividad y la mecánica cuántica es el fugaz breve tiempo de Planck. Parece que es mucho más viejo de lo que debería ser.

Pero, pese a la enorme edad del universo en “tics” de Tiempo de Planck, hemos aprendido que casi todo este tiempo es necesario para producir estrellas y los elementos químicos que traen la vida.

![[cerebro-artificial.jpg]](http://4.bp.blogspot.com/_gB8i9RgQMBM/SZPuHenJ6uI/AAAAAAAAHRg/iKaGbui_WMI/s1600/cerebro-artificial.jpg)

La vida que surgió en el planeta Tierra a partir del polvo de estrellas

¿Por qué nuestro universo no es mucho más viejo de lo que parece ser? Es fácil entender por qué el universo no es mucho más joven. Las estrellas tardan mucho tiempo en formarse y producir elementos más pesados que son las que requiere la complejidad biológica. Pero los universos viejos también tienen sus problemas. Conforme para el tiempo en el universo el proceso de formación de estrellas se frena. Todo el gas y el polvo cósmico que constituyen las materias primas de las estrellas habrían sido procesados por las estrellas y lanzados al espacio intergaláctico donde no pueden enfriarse y fundirse en nuevas estrellas. Pocas estrellas hacen que, a su vez, también sean pocos los sistemas solares y los planetas. Los planetas que se forman son menos activos que los que se formaron antes, la entropía va debilitando la energía del sistema para realizar trabajo. La producción de elementos radiactivos en las estrellas disminuirá, y los que se formen tendrán semividas más largas. Los nuevos planetas serán menos activos geológicamente y carecerán de muchos de los movimientos internos que impulsan el vulcanismo, la deriva continental y la elevación de las montañas en el planeta. Si esto también hace menos probable la presencia de un campo magnético en un planeta, entonces será muy poco probable que la vida evolucione hasta formas complejas.

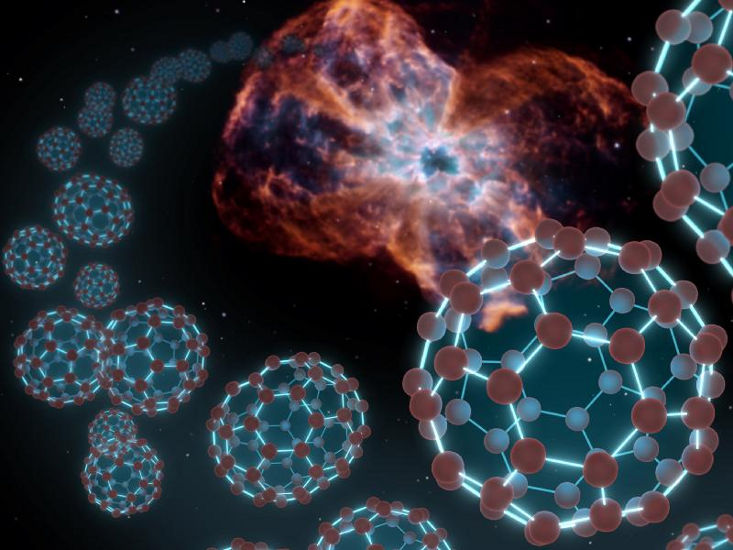

En lugares como este se forman los elementos de la vida

Las estrellas típicas como el Sol, emiten desde su superficie un viento de partículas cargadas eléctricamente que barre las atmósferas de los planetas en órbitas a su alrededor y, a menos que el viento pueda ser desviado por un campo magnético, los posibles habitantes de ese planeta lo podrían tener complicado soportando tal lluvia de radiactividad. En nuestro sistema solar el campo magnético de la Tierra ha protegido su atmósfera del viento solar, pero Marte, que no está protegido por ningún campo magnético, perdió su atmósfera hace tiempo.

Probablemente no es fácil mantener una larga vida en un planeta del Sistema solar. Poco a poco hemos llegado a apreciar cuán precaria es. Dejando a un lado los intentos que siguen realizando los seres vivos de extinguirse a sí mismos, agotar los recursos naturales, propagar infecciones letales y venenos mortales y emponzoñar la atmósfera, también existen serias amenazas exteriores.

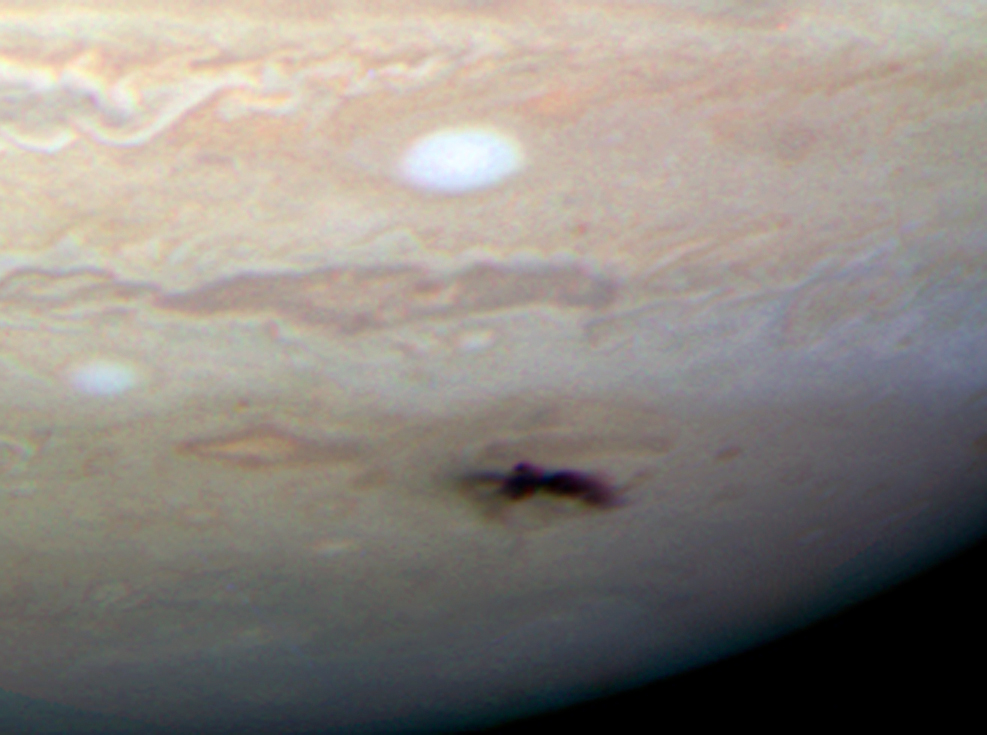

Esta marca oscura y estirada es la última cicatriz de impacto de Júpiter, un penacho de restos creado mientras un pequeño asteroide o un cometa se desintegraba tras zambullirse en el interior de la atmósfera del gigante gaseoso.

Los movimientos de cometas y asteroides, a pesar de tener la defensa de Júpiter, son una seria y cierta amenaza para el desarrollo y persistencia de vida inteligente en las primeras etapas. Los impactos no han sido infrecuentes en el pasado lejano de la Tierra, habiendo tenido efectos catastróficos. Somos afortunados al tener la protección de la Luna y de la enorme masa de Júpiter que atrae hacia sí los cuerpos que llegan desde el exterior desviándolos de su probable trayectoria hacia nuestro planeta. La caída en el planeta de uno de estos enormes pedruscos podría producir extinciones globales y retrasar en millones de años la evolución.

Cuando comento este tema no puedo evitar el recuerdo del meteorito caído en la Tierra que impactó en la península de Yucatán hace 65 millones de años, al final de la Era Mesozoica, cuando según todos los indicios, los dinosaurios se extinguieron. Sin embargo, aquel suceso catastrófico para los grandes lagartos, en realidad supuso que la Tierra fue rescatada de un callejón sin salida evolutivo. Parece que los dinosaurios evolucionaron por una vía que desarrollaba el tamaño físico antes que el tamaño cerebral.

La desaparición de los dinosaurios junto con otras formas de vida sobre la Tierra en aquella época, hizo un hueco para la aparición de los mamíferos. Se desarrolló la diversidad una vez desaparecidos los grandes depredadores. Así que, al menos en este caso concreto, el impacto nos hizo un gran favor, ya que hizo posible que 65 millones de años más tarde pudiéramos llegar nosotros. Los dinosaurios dominaron el planeta durante 150 millones de años; nosotros, en comparación, llevamos tres días y, desde luego, ¡la que hemos formado!

Juntos hubiera sido imposible convivir

Después de los Dinosaurios surgieron otras formas de vida que, evolucionadas, llegaron hasta aquí. Arriba una muestra de los que se fueron, Abajo otra de los que quedaron 65 años después.

En nuestro sistema solar la vida se desarrolló por primera vez sorprendentemente pronto tras la formación de un entorno terrestre hospitalario. Hay algo inusual en esto. El secreto reside en el tiempo biológico necesario para desarrollar la vida y el tiempo necesario para desarrollar estrellas de segunda generación y siguientes que en novas y supernovas cristalicen los materiales complejos necesarios para la vida, tales como el hidrógeno, nitrógeno, oxígeno, carbono, etc.

Parece que la similitud en los “tiempos” no es una simple coincidencia. El argumento, en su forma más simple, lo introdujo Brandon Carter y lo desarrolló John D. Barrow por un lado y por Frank Tipler por otro. Al menos, en el primer sistema solar habitado observado, ¡el nuestro!, parece que sí hay alguna relación entre t(bio) y t(estrella) que son aproximadamente iguales; el t(bio) – tiempo biológico para la aparición de la vida – algo más extenso.

Muchos son los parámetrtos a tener en cuenta para llegar a la formación de nuestra atmósfera planetaria y todo el ecosistema que tenemos y del que podemos disfrutar. Claro que, nadie cae en la cuenta de que, eso lo tenemos y es posible, gracias a unos “seres” infinitesimales, los procariotas que realizan el “milagro”.

La evolución de una atmósfera planetaria que sustente la vida requiere una fase inicial durante la cual el oxígeno es liberado por la foto-disociación de vapor de agua. En la Tierra esto necesitó 2.400 millones de años y llevó el oxígeno atmosférico a aproximadamente una milésima de su valor actual. Cabría esperar que la longitud de esta fase fuera inversamente proporcional a la intensidad de la radiación en el intervalo de longitudes de onda del orden de 1000-2000 ángstroms, donde están los niveles moleculares clave para la absorción de agua.

Este simple modelo indica la ruta que vincula las escalas del tiempo bioquímico de evolución de la vida y la del tiempo astrofísico que determina el tiempo requerido para crear un ambiente sustentado por una estrella estable que consume hidrógeno en la secuencia principal y envía luz y calor a los planetas del Sistema Solar que ella misma forma como objeto principal.

No podemos descartar nada

A muchos les cuesta trabajo admitir la presencia de vida en el universo como algo natural y corriente, ellos abogan por la inevitabilidad de un universo grande y frío en el que es difícil la aparición de la vida, y en el supuesto de que ésta aparezca, será muy parecida a la nuestra.

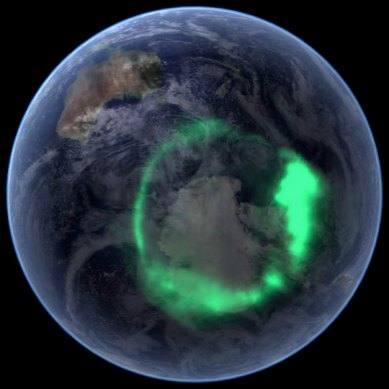

Aurora boreal

Formacion de Auroras Boreales y Australes, Cinturones de Van Allen, Ciclo del Agua, Formación de Nubes, Tipos de Nubes, Cristales de Hielo y Nieve, Niebla, Vientos, Ciclones y Anticiclones, Formación de Tornados, Formación de Huracanes, Relámpagos, Refracción de la Luz, Corrientes Oceánicas, Capa de Ozono, Patrones de Temperatura, Patrones Precipitación, Origen de la Atmosfera, Termómetro, Termimrtro, Barómetro, Pluviómetro.

Los biólogos, sin embargo, parecen admitir sin problemas la posibilidad de otras formas de vida, pero no están tan seguros de que sea probable que se desarrollen espontáneamente, sin un empujón de formas de vida basadas en el carbono. La mayoría de las estimaciones de la probabilidad de que haya inteligencias extraterrestres en el universo se centran en formas de vida similares a nosotros que habiten en planetas parecidos a la Tierra y que necesiten agua y oxígeno o similar con una atmósfera gaseosa y las demás condiciones de la distancia entre el planeta y su estrella, la radiación recibida, etc. En este punto, parece lógico recordar que antes de 1.957 se descubrió la coincidencia entre los valores de las constantes de la Naturaleza que tienen importantes consecuencias para la posible existencia de carbono y oxígeno, y con ello para la vida en el universo.

Múltiples formas de vida, tanto macro como microscópicas, estám presentes en nuestro planeta, y, de la misma manera, lo estarán en otros que, estando en la zona habitable de su estrella, tengan condiciones similares o parecidas a las nuestras.

Hay una coincidencia o curiosidad adicional que existe entre el tiempo de evolución biológico y la astronomía. Puesto que no es sorprendente que las edades de las estrellas típicas sean similares a la edad actual del universo, hay también una aparente coincidencia entre la edad del universo y el tiempo que ha necesitado para desarrollar formas de vida como nosotros.

Si miramos retrospectivamente cuánto tiempo han estado en escena nuestros ancestros inteligentes (Homo Sapiens) vemos que han sido sólo unos doscientos mil años, mucho menos que la edad del universo, trece mil millones de años, o sea, menos de dos centésimos de la Historia del Universo. Pero si nuestros descendientes se prolongan en el futuro indefinidamente, la situación dará la vuelta y cuando se precise el tiempo que llevamos en el universo, se hablará de miles de millones de años.

Brandon Carter y Richard Gott han argumentado que esto parece hacernos bastante especiales comparados con observadores en el futuro muy lejano.

No olvidemos que nuestras mentes son parte de la Galaxia

A veces, nuestra imaginación dibuja mundos de ilusión y fantasía pero, en realidad, son sólo ¿sueños?, o, por el contrario, pudieran estar en alguna parte y nosotros tan solo debemos ser capaces de encontrar. Algunos de esos sueños han dejado de serlo y otros… ¡Tendremos que materializarlos, en hechos!

Podríamos imaginar fácilmente números diferentes para las constantes de la Naturaleza de forma tal que los mundos también serían distintos al planeta Tierra y la vida no sería posible en ellos. Aumentemos la constante de estructura fina más grande y no podrá haber átomos, hagamos la intensidad de la gravedad mayor y las estrellas agotarán su combustible muy rápidamente, reduzcamos la intensidad de las fuerzas nucleares y no podrá haber bioquímica, y así sucesivamente.

Hay cambios infinitesimales que seguramente podrían ser soportados sin notar cambios perceptibles, como por ejemplo en la vigésima cifra decimal de la constante de estructura fina. Si el cambio se produjera en la segunda cifra decimal, los cambios serían muy importantes. Las propiedades de los átomos se alteran y procesos complicados como el plegamiento de las proteínas o la replicación del ADN pueden verse afectados de manera adversa. Sin embargo, para la complejidad química pueden abrirse nuevas posibilidades. Es difícil evaluar las consecuencias de estos cambios, pero está claro que, si los cambios consiguen cierta importancia, los núcleos dejarían de existir, no se formarían células y la vida se ausentaría del planeta, siendo imposible alguna forma de vida.

Las constantes de la naturaleza ¡son intocables!

Un equipo de astrónomos ha conseguido encontrar una vasta reserva de gas intergaláctico situada a unos 400 millones de años luz de la Tierra en la que podría encontrarse la “materia perdida” del Universo que los científicos llevan años buscando.

Miles de millones de galaxias formadas a lo largo de miles de millones de años. Ahí estamos

Ahora sabemos que el universo tiene que tener miles de millones de años para que haya transcurrido el tiempo necesario par que los ladrillos de la vida sean fabricados en las estrellas y la gravitación nos dice que la edad del universo esta directamente ligada con otras propiedades como la densidad, temperatura, y el brillo del cielo.

Puesto que el universo debe expandirse durante miles de millones de años, debe llegar a tener una extensión visible de miles de millones de años luz. Puesto que su temperatura y densidad disminuyen a medida que se expande, necesariamente se hace frío y disperso. Como hemos visto, la densidad del universo es hoy de poco más que 1 átomo por m3 de espacio. Traducida en una medida de las distancias medias entre estrellas o galaxias, esta densidad tan baja muestra por qué no es sorprendente que otros sistemas estelares estén tan alejados y sea difícil el contacto con extraterrestres. Si existen en el universo otras formas de vía avanzada, entonces, como nosotros, habrán evolucionado sin ser perturbadas por otros seres de otros mundos hasta alcanzar una fase tecnológica avanzada.

La expansión del universo es precisamente la que ha hecho posible que el alejamiento entre estrellas, con sus enormes fuentes de radiación, no incidieran en las células orgánicas que más tarde evolucionarían hasta llegar a nosotros. Diez mil millones de años de alejamiento continuado y el enfriamiento que acompaña a dicha expansión permitieron que, con la temperatura ideal y una radiación baja, los seres vivos continuaran su andadura en este planeta minúsculo, situado en la periferia de la galaxia que comparado al conjunto de esta, es sólo una mota de polvo donde unos insignificantes seres laboriosos, curiosos y osados, son conscientes de estar allí y están pretendiendo determinar las leyes, no ya de su mundo o de su galaxia, sino que su osadía ilimitada les lleva a pretender conocer el destino de todo el universo.

El ser humano ha hecho un largo recorrido para que ahora se sienta insignificante.

Cuando a solas pienso en todo esto, la verdad es que no me siento nada insignificante y nada humilde ante la inmensidad de los cielos. Las estrellas pueden ser enormes y juntas, formar inmensas galaxias… pero no pueden pensar ni amar; no tienen curiosidad, ni en ellas está el poder de ahondar en el porqué de las cosas. Nosotros sí podemos hacer todo eso y más.

La estructura de los átomos y las moléculas está controlada casi por completo por dos números: la razón entre las masas del electrón y el protón, b, que es aproximadamente igual a 1/1.836, y la constante de estructura fina, a, que es aproximadamente 1/137. Supongamos que permitimos que estas dos constantes cambien su valor de forma independiente y supongamos también (para hacerlo sencillo) que ninguna otra constante de la Naturaleza cambie. ¿Qué le sucede al mundo si las leyes de la naturaleza siguen siendo las mismas?

Si deducimos las consecuencias pronto encontramos que no hay muchos espacios para maniobrar. Incrementemos β demasiado y no puede haber estructuras moleculares ordenadas porque es el pequeño valor de beta el que asegura que los electrones ocupen posiciones bien definidas alrededor de un núcleo atómico y las cargas negativas de los electrones igualan las cargas positivas de los protones haciendo estable el núcleo y el átomo.

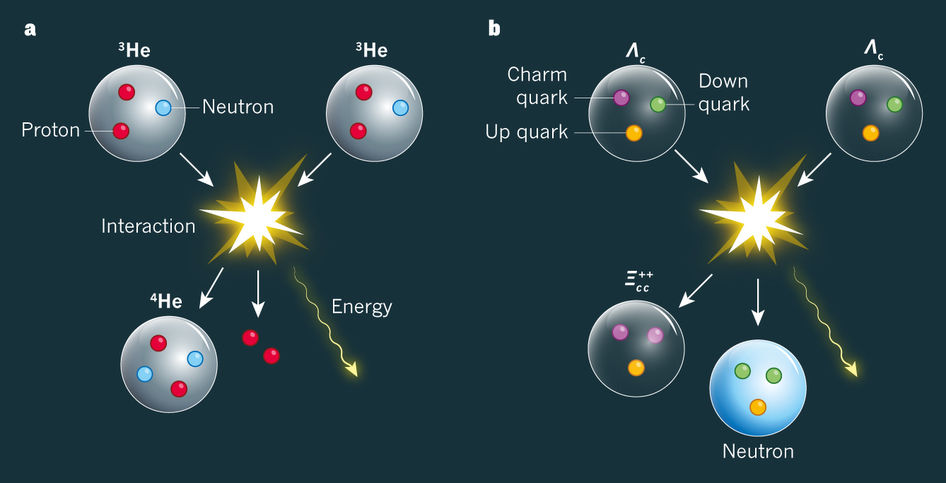

Si en lugar de a versión b, jugamos a cambiar la intensidad de la fuerza nuclear fuerte aF, junto con la de a, entonces, a menos que aF > 0,3 a½, los elementos como el carbono no existirían.

No podrían existir químicos orgánicos, no podrían mantenerse unidos. Si aumentamos aF en solo un 4 por 100, aparece un desastre potencial porque ahora puede existir un nuevo núcleo de helio, el helio-2, hecho de 2 protones y ningún neutrón, que permite reacciones nucleares directas y más rápidas que de protón + protón → helio-2.

Las estrellas agotarían rápidamente su combustible y se hundirían en estados degenerados o en agujeros negros. Por el contrario, si aF decreciera en un 10 por 100, el núcleo de deuterio dejaría de estar ligado y se bloquearía el camino a los caminos astrofísicos nucleares hacia los elementos bioquímicos necesarios para la vida.

Como en esa nube molecular que arriba podemos contemplar… ¡Es todo tan complejo!

Emilio Silvera Vázquez

May

7

Lo pequeño y lo grande, el saber y la ignorancia, el Universo y…...

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y... ¿nosotros? ~

Clasificado en El Universo y... ¿nosotros? ~

Comments (4)

Comments (4)

“Todo estadopresente de una sustancia simple es naturalmente una consecuencia de su estado anterior, de modo que su presente está cargado de su futuro”.

que en el futuro pueda llegar hasta ¡la vida! Ahí, en esa Nebulosa que arriba podemos contemplar, están todos los ingredientes de las estrellas, los mundos, la Vida y… ¡los pensamientos! Que surgirán dentro de algunos miles de millones de años.

que en el futuro pueda llegar hasta ¡la vida! Ahí, en esa Nebulosa que arriba podemos contemplar, están todos los ingredientes de las estrellas, los mundos, la Vida y… ¡los pensamientos! Que surgirán dentro de algunos miles de millones de años.

los núcleos de los átomos hasta los cúmulos de galaxias.

los núcleos de los átomos hasta los cúmulos de galaxias.

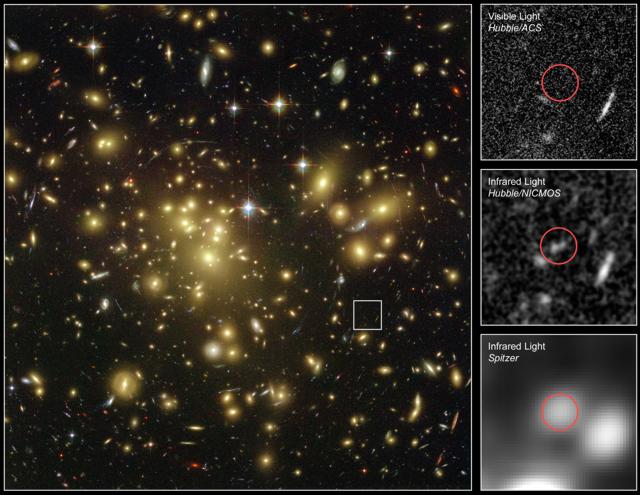

los confines del Universo profundo para ver viejas galaxias de 13.000 millones de años de edad, y, cercanas al del Universo primitivo. Con la nueva generación de Telescopios espaciales, podremos contemplar el Universo cuando

los confines del Universo profundo para ver viejas galaxias de 13.000 millones de años de edad, y, cercanas al del Universo primitivo. Con la nueva generación de Telescopios espaciales, podremos contemplar el Universo cuando aún no existían estrellas y, la materia, se estaba formando.

aún no existían estrellas y, la materia, se estaba formando. decimos, la física y la cosmología hicieron un matrimonio de conveniencia y apresurado, se juntaron dos disciplinas muy diferentes. Los cosmólogos son solitarios y mantienen sus miradas fijas en ese horizonte lejano y profundo de los cúmulos de galaxias situados en el espacio-tiempo profundo y, acumulan, amorosamente sus mensajes construidos de hilillos de antigua luz estelar que les traen noticias y les cuentan las historias pasadas del universo.

decimos, la física y la cosmología hicieron un matrimonio de conveniencia y apresurado, se juntaron dos disciplinas muy diferentes. Los cosmólogos son solitarios y mantienen sus miradas fijas en ese horizonte lejano y profundo de los cúmulos de galaxias situados en el espacio-tiempo profundo y, acumulan, amorosamente sus mensajes construidos de hilillos de antigua luz estelar que les traen noticias y les cuentan las historias pasadas del universo.

, inclinados a curvar cosas, volar cosas y desmontar cosas. Los físicos trabajan dura y rápidamente, obsesionados por la leyenda de que es improbable que tengan muchas ideas nuevas útiles después de cumplir los cuarenta, mientras que los cosmólogos son más a menudo jugadores de finales, adeptos a las visiones de vasto alcance, de quienes cabe esperar que realicen investigaciones productivas cuando sus cabellos blanquean por la edad. Los físicos son los zorros que saben muchas cosas, los cosmólogos son más afines a los erizos, que saben una sola .

, inclinados a curvar cosas, volar cosas y desmontar cosas. Los físicos trabajan dura y rápidamente, obsesionados por la leyenda de que es improbable que tengan muchas ideas nuevas útiles después de cumplir los cuarenta, mientras que los cosmólogos son más a menudo jugadores de finales, adeptos a las visiones de vasto alcance, de quienes cabe esperar que realicen investigaciones productivas cuando sus cabellos blanquean por la edad. Los físicos son los zorros que saben muchas cosas, los cosmólogos son más afines a los erizos, que saben una sola .

“Quien ha visto las cosas presentes ha visto todo, todo lo ocurrido desdela eternidad y todo lo que ocurrirá en el tiempo sin fin: pues todas las cosas son de la misma clase y la misma forma.”

Leyendo ese pensamiento, me digo yo: sólo el paso del tiempo las transforma para finalmente, hacerlas desaparecer para que, de inmediato, puedan surgir otras nuevas que, en realidad, serán las mismas cosas que ya fueron.

finalmente, hacerlas desaparecer para que, de inmediato, puedan surgir otras nuevas que, en realidad, serán las mismas cosas que ya fueron.

Lo que arriba vemos, un día fue como

nuestro Sol

setenta, los físicos de partículas se aventuraron a acudir a seminarios de cosmología a estudiar las galaxias y los cuásares, mientras que los cosmólogos alquilaron del CERN y el Fermilab para trabajar en física de altas energías en instalaciones subterráneas desde

setenta, los físicos de partículas se aventuraron a acudir a seminarios de cosmología a estudiar las galaxias y los cuásares, mientras que los cosmólogos alquilaron del CERN y el Fermilab para trabajar en física de altas energías en instalaciones subterráneas desde donde se veían las estrellas. Algún famoso físico de aquellos tiempos dijo: “La física de partículas elementales y el estudio del universo primitivo, las dos ramas fundamentales de la ciencia de la Naturaleza, se han fundido esencialmente”.

donde se veían las estrellas. Algún famoso físico de aquellos tiempos dijo: “La física de partículas elementales y el estudio del universo primitivo, las dos ramas fundamentales de la ciencia de la Naturaleza, se han fundido esencialmente”.

llegar a un todo que, nos mostrará la verdadera naturaleza del Universo, la materia que contiene y…¿por qué no? también de la vida misma.

llegar a un todo que, nos mostrará la verdadera naturaleza del Universo, la materia que contiene y…¿por qué no? también de la vida misma. físicos y cosmólogos fue el Big Bang. los físicos identificaron simetrías en la naturaleza que hoy están rotas pero que estuvieron intactas en un entorno de altas energías. Los cosmólogos informaron que el universo estuvo antaño en tal estado

físicos y cosmólogos fue el Big Bang. los físicos identificaron simetrías en la naturaleza que hoy están rotas pero que estuvieron intactas en un entorno de altas energías. Los cosmólogos informaron que el universo estuvo antaño en tal estado de alta energía, durante las etapas iniciales del Big Bang. Unidas ambas cosas, aparece el de un universo perfectamente simétrico cuyas simetrías se quebraron a medida que se expandió y se enfrió, creando las partículas de materia y energía que encontramos hoy a nuestro alrededor y estampándoles las pruebas de su genealogía.

de alta energía, durante las etapas iniciales del Big Bang. Unidas ambas cosas, aparece el de un universo perfectamente simétrico cuyas simetrías se quebraron a medida que se expandió y se enfrió, creando las partículas de materia y energía que encontramos hoy a nuestro alrededor y estampándoles las pruebas de su genealogía.

Claro que si no existieran simetrías, en la Tierra habría días de 24 horas y otros de cinco minutos ; viviríamos en un planeta deforme en la gravedad proyectaría objetos en todas direcciones; habría explosiones inexplicables. Sería un mundo peligrosamente caprichoso. Sin embargo, por muy atrás que podamos mirar en el tiempo, siempre podremos ver como se ha ido conformando un universo simétrico en el que las figuras se repiten una y otra vez. Lo que no quiere decir que todo sea igual, toda vez que, nuestro universo, dentro de esa simetría creadora que podemos contemplar en la Naturaleza, es al mismo tiempo diverso y de una belleza sin igual. ¡Cuanta grandeza!

; viviríamos en un planeta deforme en la gravedad proyectaría objetos en todas direcciones; habría explosiones inexplicables. Sería un mundo peligrosamente caprichoso. Sin embargo, por muy atrás que podamos mirar en el tiempo, siempre podremos ver como se ha ido conformando un universo simétrico en el que las figuras se repiten una y otra vez. Lo que no quiere decir que todo sea igual, toda vez que, nuestro universo, dentro de esa simetría creadora que podemos contemplar en la Naturaleza, es al mismo tiempo diverso y de una belleza sin igual. ¡Cuanta grandeza!

Por fortuna, hay simetrías, hay reglas que nos dicen que los planetas son esféricos, que los rostros son simétricos, que todos los días duran lo mismo, que hay frío y calor, día y noche, que hay positivo y negativo, que todo en el universo se rige por el equilibrio que se consigue en la igualdad de fuerzas contrapuestas, y, de esa manera, se llega a la simetría que nos rodea y podemos contemplar por todas partes. Sin embargo, nuestro Universo es el de simetrías rotas.

Tres Físicos recibieron el Nobel por las “simetrías rotas de la Naturaleza”. Dos japoneses y un estadounidense. Ganaron el Premio Nobel de Física del 2008 por cosas que ayudan a explicar el comportamiento de las partículas más pequeñas de materia.

Makoto Kobayashi, Toshihide Masukaway el japonés nacido estadounidense, Yoichiro Nambu

En física, la idea de simetría refiere a un tipo de igualdad o equivalencia en una situación. En el nivel subatómico, por ejemplo, no deberías poder decir si estás viendo desplegados directamente en un espejo, o si una película de esos eventos está corriendo adelante o atrás. Y las partículas deberían comportarse justo como

de igualdad o equivalencia en una situación. En el nivel subatómico, por ejemplo, no deberías poder decir si estás viendo desplegados directamente en un espejo, o si una película de esos eventos está corriendo adelante o atrás. Y las partículas deberían comportarse justo como sus alter egos, llamadas antipartículas.

sus alter egos, llamadas antipartículas.

Si cualquiera de estas reglas es violada, la simetría se rompe.

Finalmente prevaleció la materia

Una gran simetría rota surgió inmediatamente después del Big Bang, cuando sólo una infinitesimal fracción más de materia que antimateria fue creada. Debido a que estos dos tipos de partículas se aniquilan entre sí al encontrarse, ese exceso de materia fue el que prevaleció, en forma de bariones, es decir, la materia que emite radiación y podemos ver. En el suceso tuvo lugar la rotura de la simetría de la “fuerza única” que contenía todos los mecanismos y leyes de aquel primer universo. Sin embargo, no cabe ninguna duda de que existe un ingrediente más elemental e invisible que permea el universo entero, es la sustancia cósmica que nadie sabe explicar y a la que le dan raros nombres que coinciden con la realidad.

sí al encontrarse, ese exceso de materia fue el que prevaleció, en forma de bariones, es decir, la materia que emite radiación y podemos ver. En el suceso tuvo lugar la rotura de la simetría de la “fuerza única” que contenía todos los mecanismos y leyes de aquel primer universo. Sin embargo, no cabe ninguna duda de que existe un ingrediente más elemental e invisible que permea el universo entero, es la sustancia cósmica que nadie sabe explicar y a la que le dan raros nombres que coinciden con la realidad.

Nadie pudo estar allí para tomar una instantánea de aquel Universo primitivo

tomar una instantánea de aquel Universo primitivo

Al principio, cuando el universo era simétrico, sólo existía una sola fuerza que unificaba a todas las que conocemos, la gravedad, las fuerzas electromagnéticas y las nucleares débil y fuerte, todas emergían de aquel plasma opaco de alta energía que lo inundaba todo. Más tarde, cuando el universo comenzó a enfriarse, se hizo transparente y apareció la luz, las fuerzas se separaron en las cuatro conocidas, emergieron los primeros quarks para y formar protones y neutrones los primeros núcleos aparecieron para atraer a los electrones que formaron aquellos primeros átomos. Doscientos millones de años más tarde, se formaron las primeras estrellas y galaxias. Con el paso del tiempo, las estrellas sintetizaron los elementos pesados de nuestros cuerpos, fabricados en supernovas que estallaron, incluso antes