Aprecien como se forma la red de fibras que hace posible la cicatrización de una herida.

IMPRESIÓN NO PERMITIDA - TEXTO SUJETO A DERECHOS DE AUTOR

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Estar equivocados nos sorprende y, al mismo tiempo, nos enseña algo sobre nosotros mismos. No solo hay cosas que no sabemos, sino que las cosas que creemos saber pueden no ser ciertas. Como nos dice la filosofía, nada es como se ve a primera vista, todo depende bajo el punto de vista desde el que miremos las cosas y, si es el correcto, estaremos en esa verdad que incansables buscamos.

No resulta nada fácil descubrir los caminos por los que deambula la Naturaleza y las razones que ésta tiene para recorrerlos de la manera que lo hace y no de otra. Una cosa es cierta, la Naturaleza siempre trata de conseguir sus fines con el menor esfuerzo posible y, cuestiones que nos parece muy complicadas, cuando profundizamos en ellas como la ciencia nos exige, llegan a parecernos más sencillas y comprensibles. Todas las respuestas están ahí, en la Naturaleza.

“Este es un ensayo de Viktor Frankl neurólogo, psiquiatra, sobreviviente del holocausto y el fundador de la disciplina; que conocemos hoy como Logoterapia.

No eres Tú, soy Yo…

¿Quién te hace sufrir? ¿Quién te rompe el corazón? ¿Quién te lastima? ¿Quién te roba la felicidad o te quita la tranquilidad? ¿Quién controla tu vida?…

¿Tus padres? ¿Tu pareja? ¿Un antiguo amor? ¿Tu suegra? ¿Tu jefe?…

Podrías armar toda una lista de sospechosos o culpables. Probablemente sea lo más fácil. De hecho sólo es cuestión de pensar un poco e ir nombrando a todas aquellas personas que no te han dado lo que te mereces, te han tratado mal o simplemente se han ido de tu vida, dejándote un profundo dolor que hasta el día de hoy no entiendes.”

No veo que profesor pregunte por qué el llegar a saber también, nos puede hacer sufrir. Estamos en aquello de…, ” ojos que no ven, corazón que no siente”.

Hay historias del pasado que te hablan de pueblos y Civilizaciones que llegaron a tener una enorme visión del mundo. Sus sociedades alcanzaron cotas increibles en el saber de cuestiones que, aún hoy, nos parecen difíciles de creer y, sin embargo, ahí han quedado las huellas materiales de que, esos pueblos, mucho antes que nosotros, supieron entender el mundo y, de alguna manera, fueron incluso más prácticvos y naturales que nosotros muchos siglos después.

¿Cómo podríamos ensamblar una explicación científica de la génesis de la vida? A simple vista nos puede parecer una tarea sin esperanzas. No creo que buscar fósiles en las rocas más antiguas sea suficiente y nos ofrezca todas las claves necesarias. La mayoría de las delicadas moléculas prebióticas que dieron lugar a la vida habrán sido erradicadas por el inexorable paso del tiempo y la destructora entropía que todo en polvo lo convierte. Es posible, que podamos esperar el hallazgo de algún residuo químico ya degradado de aquellos organismos ancestrales a partir de los cuales evolucionó la vida celular que conocemos.

Claro que, aparte de los fósiles que podamos encontrar en las rocas, existe otra línea de evidencia que, de la misma manera, se remonta al pasado lejano y oscuro, pero que existe aquí y ahora, dentro de las formas de la vida presente. Los biólogos están convencidos de que ciertas reliquias de organismos antiguos siguen viviendo en las estructuras y procesos bioquímicos de sus descendientes, incluyéndonos a nosotros, los seres humanos.

Todo comienza siendo una cosa y con el tiempo, se transforma en otra diferente: Evolución por la energía. En el universo en que vivimos, nada desaparece; con el tiempo se cumplen los ciclos de las cosas y se convierten en otra distinta, es un proceso irreversible que podemos contemplar a nuestro alrededor con el paso inexorable del tiempo se van cumpliendo las fases y los ciclos, y, no necesarimente siempre son de desgaste y envejecimiento, sino que, otras son de creación y resurgimiento. Cuando las estrellas masivas viejas esplotan en Supernovas, el espacio interetelar queda ocupado, en grandes regiones, por una nube enorme que, a veces, abarca varios años luz. El tiempo transcurre y, de esos restos de estrella “muerta”, con ayuda de la gravedad, nacen nuevas estrellas. Es la entropía negativa que lucha contra aquella otra que todo lo quiere destruir. Nosotros, de alguna manera, hacemos lo mismo con la descendencia y creamos entropía negativa que hace que lo nuevo, de alguna manera, esté venciendo a ese destino irreversible que nos habla de que la Eternidad… ¡No existe, para nada ni para nadie!

El gas y el polvo se transforma en una brillante estrella que vive diez mil millones de años y termina en Nebulosa planeta con una enana blanca en el centro. Entonces la estrella que tenía un diámetro de 1.500 km, se reduce hasta unas pocas decenas, 20 0 30 Km y, su densidad, es inmensa, emitiendo radiación ultravioleta durante mucjho tiempo hasta que se enfría y se convierte en un cadáver estelar.

En lo concerniente a cambios y transformaciones, el que más me ha llamado siempre la atención es el de las estrellas que se forman a partir de gas y polvo cósmico. Nubes enormes de gas y polvo se van juntando. Sus moléculas cada vez más apretadas se rozan, se ionizan y se calientan hasta que en el núcleo central de esa bola de gas caliente, la temperatura alcanza millones de grados. La enorme temperatura posible la fusión de los protones y, en ese instante, nace la estrella que brillará miles de millones de años y dará luz y calor. Su ciclo de vida estará supeditado a su masa. Si la estrella es supermasiva, varias masas solares, su vida será más corta, ya que consumirá el combustible nuclear de fusión (hidrógeno, helio, litio, oxígeno, etc) con más voracidad que una estrella mediana como nuestro Sol, de vida más duradera.

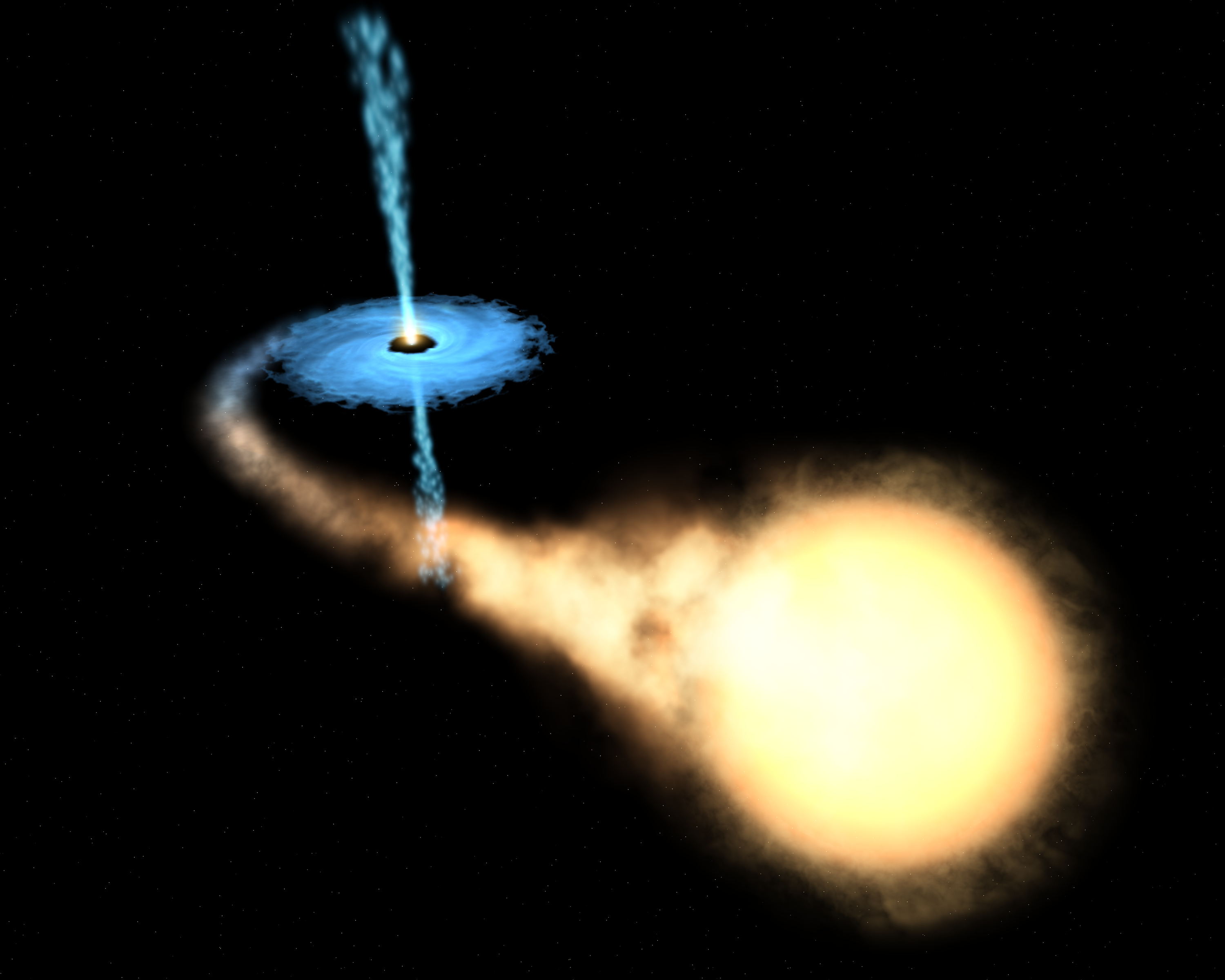

Una estrella, como todo en el universo, está sostenida por el equilibrio de dos fuerzas contrapuestas; en caso, la fuerza que tiende a expandir la estrella (la energía termonuclear de la fusión) y la fuerza que tiende a contraerla (la fuerza gravitatoria de su propia masa). Cuando finalmente el proceso de fusión se detiene por agotamiento del combustible de fusión, la estrella pierde la fuerza de expansión y queda a merced de la fuerza de gravedad; se hunde bajo el peso de su propia masa, se contrae más y más, y en el caso de estrellas súper masivas, se convierten en una singularidad, una masa que se ha comprimido a tal extremo que acaba poseyendo una fuerza de gravedad de una magnitud difícil de imaginar el común de los mortales.

La singularidad con su inmensa fuerza gravitatoria atrae a la estrella vecina

La Tierra, un objeto minúsculo en comparación con esos objetos súper masivos estelares, genera una fuerza de gravedad que, para escapar de ella, una nave o cohete espacial tiene que salir disparado la superficie terrestre a una velocidad de 11’18 km/s; el sol exige 617’3 km/s. Es lo que se conoce como velocidad de escape, que es la velocidad mínima requerida escapar de un campo gravitacional que, lógicamente, aumenta en función de la masa del objeto que la produce. El objeto que escapa puede ser una cosa cualquiera, desde una molécula de gas a una nave espacial. La velocidad de escape de un cuerpo está dada por , donde G es la constante gravitacional, M es la masa del cuerpo y R es la distancia del objeto que escapa del centro del cuerpo. Un objeto que se mueva con una velocidad menor que la de escape entra en una órbita elíptica; si se mueve a una velocidad exactamente igual a la de escape, sigue una órbita , y si el objeto supera la velocidad de escape, se mueve en una trayectoria hiperbólica y rompe la atadura en que la mantenía sujeto al planeta, la estrella o el objeto que emite la fuerza gravitatoria.

La mayor velocidad que es posible alcanzar en nuestro universo es la de la luz, c, velocidad que la luz alcanza en el vacío y que es de 299.793’458 km/s.

Sí, se pudo confirmar que los neutrinos respetan la supremacía el fotón y la luz, sigue siendo la más rápida del Universo. Y sin embargo, no escapar de la atracción de un Aguero Negro.

Pues bien, es tal la fuerza de gravedad de un agujero negro que ni la luz puede escapar de allí; la singularidad la absorbe, la luz desaparece en su interior, de ahí su nombre de agujero negro, la estrella supermasiva se contrae, llega a un punto que desaparece de nuestra vista. De acuerdo con la relatividad general, cabe la posibilidad de que una masa se comprima y reduzca sin límites su tamaño y se auto confine en un espacio infinitamente pequeño que encierre una densidad y una energía infinitos. Allí, el espacio y el tiempo dejan de existir.

Las singularidades ocurren en el Big Bang, en los agujeros negros y en el Big Crunch (que se podría considerar una reunión de todos los agujeros negros generados por el paso del tiempo en el universo y que nos llevará a un fin que será el comienzo).

Las singularidades de los agujeros negros están rodeados por una circunferencia invisible a su alrededor que marca el límite de su influencia. El objeto que traspasa ese límite es atraído, irremisiblemente, la singularidad que lo engulle, sea una estrella, una nube de gas o cualquier otro objeto cósmico que ose traspasar la línea que se conoce como horizonte de sucesos del agujero negro.

La existencia de los agujeros negros fue deducida por Schwarzschild, en el año 1.916, a partir de las ecuaciones de Einstein de la relatividad general. Este astrónomo alemán predijo su existencia, pero el de agujero negro se debe a Johb Wheeler.

Señalamos la singularidad del Big Bang pero… ¿fue así?

Así, el conocimiento de la singularidad está dado por las matemáticas de Einstein y más tarde por la observación de las señales que la presencia del agujero generan. Es una fuente emisora de rayos X que se producen al engullir materia que traspasa el horizonte de sucesos y es atrapada la singularidad, donde desaparece siempre sumándose a la masa del agujero cada vez mayor.

En el centro de nuestra galaxia, la Vía Láctea, ha sido detectado un enorme agujero negro, ya muy famoso, llamado Cygnus X-1.

Después de todo, la velocidad de la luz, la máxima del universo, no vencer la fuerza de gravedad del aujero negro que la tiene confinada para siempre.

En nuestra galaxia, con cien mil años luz de diámetro y unos doscientos mil millones de estrellas, ¿cuántos agujeros negros habrá?

Para mí, la cosa está clara: el tiempo es imparable, el reloj cósmico sigue y sigue andando sin que nada lo pare, miles o cientos de miles, millones y millones de estrellas súper masivas explotarán en brillantes supernovas para convertirse en temibles agujeros negros.

Llegará un momento que el de agujeros negros en las galaxias será de tal magnitud que comenzarán a fusionarse unos con otros que todo el universo se convierta en un inmenso Agujero negro, una enorme singularidad, lo único que allí estará presente: la gravedad.

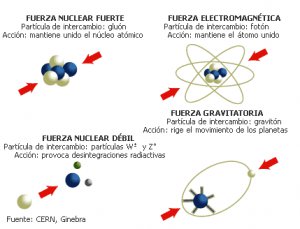

Esa fuerza de la naturaleza que está sola, no se puede juntar con las otras fuerzas que, como se ha dicho, tienen sus dominios en la mecánica cuántica, mientras que la gravitación residen en la inmensidad del cosmos; las unas ejercen su dominio en los confines microscópicos del átomo, mientras que la otra sólo aparece de manera significativa en presencia de grandes masas estelares. Allí, a su alrededor, se aposenta curvando el espacio y distorsionando el tiempo.

Esa reunión final de agujeros negros será la causa de que la Densidad Crítica sea superior a la ideal. La gravedad generada por el inmenso agujero negro que se irá formando en cada galaxia tendrá la consecuencia de parar la expansión actual del universo. Todas las galaxias que ahora están separándose las unas de las otras se irán frenando parar y, despacio al principio pero más rápido después, comenzarán a recorrer el camino hacia atrás. Finalmente, toda la materia será encontrada en un punto común donde chocará violentamente formando una enorme bola de fuego, el Big Crunch, que como sabéis, es sólo una de las variadas teorías del final del universo.

Claro que, antes de que eso llegue, tendremos que resolver el primer problema: La visita de Andrómeda, la salida de la Tierra de la Zona habitable, o, la muerte del Sol que se convertirá en una gigante roja primero y en una nebulosa planetaria con una estrella enana blanca en el centro después.

Los científicos se han preguntado a veces qué sucederá eventualmente a los átomos de nuestros cuerpos mucho tiempo después de que hayamos muerto. La posibilidad más probable es que nuestras moléculas vuelvan al Sol. En páginas anteriores he explicado el destino del Sol: se agotará su combustible de hidrógeno y fusionará helio; se hinchará en gigante roja y su órbita es probable que sobrepase la Tierra y la calcine; las moléculas que hoy constituyen nuestros cuerpos serán consumidas por la atmósfera solar.

Carl Sagan pinta el cuadro siguiente:

“Dentro de miles de millones de años a partir de , habrá un último día perfecto en la Tierra… Las capas de hielo Ártica y Antártica se fundirán, inundando las costas del mundo. Las altas temperaturas oceánicas liberarán más vapor de agua al aire, incrementando la nubosidad y escondiendo a la Tierra de la luz solar retrasando el final. Pero la evolución solar es inexorable. Finalmente los océanos hervirán, la atmósfera se evaporará en el espacio y nuestro planeta será destruido por una catástrofe de proporciones que ni podemos imaginar.”

En una escala de tiempo de varios miles de millones de años, debemos enfrentarnos al hecho de que la Vía Láctea, en la que vivimos, morirá. Más exactamente, vivimos en el brazo espiral Orión de la Vía Láctea. miramos al cielo nocturno y nos sentimos reducidos, empequeñecidos por la inmensidad de las luces celestes que puntúan en el cielo, estamos mirando realmente una minúscula porción de las estrellas localizadas en el brazo de Orión. El resto de los 200 mil millones de estrellas de la Vía Láctea están tan lejanas que apenas pueden ser vistas como una cinta lechosa que cruza el cielo nocturno.

Aproximadamente a dos millones de años luz de la Vía Láctea está nuestra galaxia vecina más cercana, la gran galaxia Andrómeda, dos o tres veces mayor que nuestra galaxia. Las dos galaxias se están aproximando a unos 500 km/s, y chocarán en un periodo de entre 3 y 4 mil millones de años. Como ha dicho el astrónomo Lars Hernquist de la California en Santa Cruz, esta colisión será “parecida a un asalto. Nuestra galaxia será literalmente consumida y destruida“. Aunque, lo cierto es que aunque en el choque algo se detruya, lo cierto es que todo quedará en forma de una galaxia mucho mayor.

Así las cosas, no parece que la Humanidad del futuro lo tenga nada fácil. Primero tendrá que escapar, dentro de unos 4.000 millones de años del gigante rojo en que se convertirá el Sol que calcinará al planeta Tierra. Segundo, en unos 10.000 millones de años, la escapada tendrá que ser aún más lejana; la destrucción será de la propia galaxia que se fusionará con otra mayor sembrando el caos cósmico del que difícilmente se podría escapar quedándonos aquí. Por último, el final anunciado, aunque más largo tiempo, es el del propio universo que, por congelación o fuego, tiene los eones contados.

Por todas estas catástrofes anunciadas por la ciencia, científicos como Kip S. Thorne y Stephen Hawking sugieren a otros universos paralelos a través de agujeros de gusano en el hiperespacio. Sería la única puerta de salida para que la Humanidad no se destruyera.

Si lo alcanzaremos o no, es imposible de contestar, no tenemos los necesarios para ello. Incluso se podría decir que aparte de estas catástrofes futuras que sabemos a ciencia cierta que ocurrirán, seguramente existan otras que están ahí latentes en la incertidumbre de si finalmente ocurren o no, sólo pendiente de decidir lo uno o lo otro por parámetros ocultos que no sabemos ni que puedan existir.

En esta situación de impotencia, de incapacidad física e intelectual, nos tenemos que dar y admitir que, verdaderamente, comparados con el universo y las fuerzas que lo rigen, somos insignificantes, menos que una mota de polvo flotando en el haz de luz que entra, imparable, por la ventana entre-abierta de la habitación.

Sin embargo, tampoco es así. Que se sepa, no existe ningún otro grupo inteligente que esté capacitado tratar de todas estas cuestiones. Que la especie humana sea consciente de dónde vino y hacia dónde va, en verdad tiene bastante mérito, y más, si consideramos que nuestro origen está a partir de materia inerte evolucionada y compleja que, un día, hace probablemente miles de millones de años, se fraguó en estrellas muy lejanas.

A finales de los 60, un joven físico italiano, Gabriele Veneziano, buscaba un grupo de ecuaciones que explicara la fuerza nuclear fuerte. Este pegamento tan fuerte que mantenía unidos los protones y neutrones del núcleo de cada átomo. Parece ser que por casualidad se encontró con un libro antiguo de matemáticas y en su interior encontró una ecuación de más de 200 años de antigüedad creada por un matemático suizo llamado Leonhard Euler. Veneziano descubrió con asombro que las ecuaciones de Euler, consideradas desde siempre una simple curiosidad matemática, parecían describir la fuerza nuclear fuerte. Después de un año de de profundos estudios, experimentos, intuición e imaginación, se podría decir que elaboraron la Teoría de Cuerdas de manera fortuita.

Tras circular entre compañeros, la ecuación de Euler acabó escrita frente a Leonard Susskind, quien se retiro a su ático para investigar. Creía que aquella antigua fórmula describía matemáticamente la fuerza nuclear fuerte, pero descubrió algo nuevo. Lo primero que descubrió fue que describía una especie de partícula con una estructura interna que vibraba y que mostraba un comportamiento que no se limitaba al de una partícula puntual. Dedujo que se trataba de una cuerda, un hilo elástico, como una goma cortada por la mitad. Esta cuerda se estiraba y contraía además de ondear y coincidía exactamente con la fórmula. Susskind redactó un artículo donde explicaba el descubrimiento de las cuerdas, pero nunca llegó a publicarse.

Muchos buscaron la 5ª dimensión… ¡sin fortuna! Aquí sólo hay tres y el espacio.

Claro que, ya he comentado otras veces que la teoría de cuerdas tiene un origen real en las ecuaciones de Einstein en las que se inspiro Kaluza para añadir la quinta dimensión y perfeccionó Klein (teoría Kaluza-Klein). La teoría de cuerdas surgió a partir de su descubrimiento accidental por Veneziano y , y a partir de ahí, la versión de más éxito es la creada por los físicos de Princeton David Gross, Emil Martinec, Jeffrey Harvey y Ryan Rohm; ellos son conocidos en ese mundillo de la física teórica como “el cuarteto de cuerdas”. Ellos han propuesto la cuerda heterótica (híbrida) y están seguros de que la teoría de cuerdas resuelve el problema de “construir la propia materia a partir de la pura geometría: eso es lo que en cierto sentido hace la teoría de cuerdas, especialmente en su versión de cuerda heterótica, que es inherentemente una teoría de la gravedad en la que las partículas de materia, tanto las otras fuerzas de la naturaleza, emergen del mismo modo que la gravedad emerge de la geometría“.

La Gravedad cuántica está en algunas mentes , ¿Estará en la Naturaleza?

La característica más notable de la teoría de cuerdas ( ya he señalado), es que la teoría de la gravedad de Einstein está contenida automáticamente en ella. De hecho, el gravitón (el cuanto de gravedad) emerge como la vibración más pequeña de la cuerda cerrada, es más, si simplemente abandonamos la teoría de la gravedad de Einstein como una vibración de la cuerda, entonces la teoría se vuelve inconsistente e inútil. , de hecho, es la razón por la que Witten se sintió inicialmente atraído hacia la teoría de cuerdas.

Witten está plenamente convencido de que “todas las ideas realmente grandes en la física, están incluidas en la teoría de cuerdas“.

No entro aquí a describir el modelo de la teoría de cuerdas que está referido a la “cuerda heterótica”, ya que su complejidad y profundidad de detalles podría confundir al lector no iniciado. Sin embargo, parece justo que deje constancia de que consiste en una cuerda cerrada que tiene dos tipos de vibraciones, en el sentido de las agujas del reloj y en el sentido contrario, que son tratadas de diferente.

Las vibraciones en el sentido de las agujas de reloj viven en un espacio de diez dimensiones. Las vibraciones de sentido contrario viven en un espacio de veintiséis dimensiones, de las que dieciséis han sido compactificadas (recordemos que en la teoría pentadimensional Kaluza-Klein, la quinta dimensión se compactificaba curvándose en un circulo). La cuerda heterótica debe su al hecho de que las vibraciones en el sentido de las agujas de reloj y en el sentido contrario viven en dos dimensiones diferentes pero se combinan para producir una sola teoría de supercuerdas. Esta es la razón de que se denomine según la palabra griega heterosis, que significa “vigor híbrido”.

En conclusión, las simetrías que vemos a nuestro alrededor, el arcoiris a las flores y a los cristales, pueden considerarse en última instancia como manifestaciones de fragmentos de la teoría decadimensional original. Riemann y Einstein habían confiado en llegar a una comprensión geométrica de por qué las fuerzas pueden determinar el movimiento y la naturaleza de la materia.

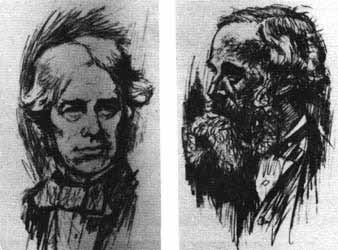

La teoría de cuerdas, a partir del descubrimiento Veneziano-Suzuki, estaba evolucionando atrás buscando las huellas de Faraday, Riemann, Maxwell y Einstein poder construir una teoría de campos de cuerdas. De hecho, toda la física de partículas estaba basada en teoría de campos. La única teoría no basada en teoría de campos era la teoría de cuerdas.

De la teoría de cuerdas combinada con la supersimetría dio lugar a la teoría de supercuerdas. La cuerda es un objeto unidimensional que en nueva teoría se utiliza remplazando la idea de la partícula puntual de la teoría cuántica de campos. La cuerda se utiliza en la teoría de partículas elementales y en cosmología y se representa por una línea o lazo (una cuerda cerrada). Los estados de una partícula pueden ser producidos por ondas estacionarias a lo largo de esta cuerda.

En teoría se trata de unificar a todas las fuerzas fundamentales incorporando simetría y en la que los objetos básicos son objetos unidimensionales que tienen una escala de 10-35 metros y, como distancias muy cortas están asociadas a energías muy altas, este caso la escala de energía requerida es del orden de 1019 GeV, que está muy por encima de la que hoy en día pueda alcanzar cualquier acelerador de partículas.

antes expliqué, las cuerdas asociadas con los bosones sólo son consistentes como teorías cuánticas en un espacio-tiempo de 26 dimensiones; aquella asociadas con los fermiones sólo lo son en un espacio tiempo de 10 dimensiones. Ya se ha explicado que las dimensiones extras, además de las normales que podemos constatar, tres de espacio y una de tiempo, como la teoría de Kaluza-Klein, están enrolladas en una distancia de Planck. De , inalcanzables.

Una de las características más atractivas de la teoría de supercuerdas es que dan lugar a partículas de espín 2, que son identificadas con los gravitones (las partículas que transportan la gravedad y que aún no se han podido localizar). Por tanto, una teoría de supercuerdas automáticamente contiene una teoría cuántica de la interacción gravitacional. Se piensa que las supercuerdas, al contrario que ocurre con otras teorías ( ellas el Modelo Estándar), están libres de infinitos que no pueden ser eliminados por renormalización, que plagan todos los intentos de construir una teoría cuántica de campos que incorpore la gravedad. Hay algunas evidencias de que la teoría de supercuerdas está libre de infinitos, pero se está a la búsqueda de la prueba definitiva.

Aunque no hay evidencia directa de las supercuerdas, algunas características de las supercuerdas son compatibles con los hechos experimentales observados en las partículas elementales, como la posibilidad de que las partículas no respeten paridad, lo que en efecto ocurre en las interacciones débiles.

Extrañas configuraciones a las que, algunos físicos le quieren sacar lo que seguramente no se encuentra en ellas

Estoy convencido de que la teoría de supercuerdas será finalmente corroborada por los hechos y, ello, se necesitará algún tiempo; no se puede aún comprobar ciertos parámetros teóricos que esas complejas matemáticas a las que llaman topología nos dicen que son así.

Habrá que tener siempre a mano las ecuaciones de Einstein, las funciones modulares de Ramanujan y el Supertensor métrico de ese genio matemático que, al igual que Ramanujan, fue un visionario llamado Riemann.

Las historias de estos dos personajes, en cierto modo, son muy parecidas. Tanto Riemann como Ramanujan murieron antes de cumplir los 40 años y, también en ambos casos, en difíciles. Estos personajes desarrollaron una actividad matemática sólo comparable al trabajo de toda la vida de muchos buenos matemáticos.

¿Cómo es posible que, para proteger la simetría conforme original por su destrucción por la teoría cuántica, deben ser milagrosamente satisfechas cierto de identidades matemáticas, que precisamente son las identidades de la función modular de Ramanujan?

En este he expresado que las leyes de la naturaleza se simplifican cuando se expresan en dimensiones más altas. Sin embargo, a la luz de la teoría cuántica, debo corregir algo esta afirmación, y para decirlo correctamente debería decir: las leyes de la naturaleza se simplifican cuando se expresan coherentemente en dimensiones más altas. Al añadir la palabra coherentemente hemos señalado un punto crucial. ligadura nos obliga a utilizar las funciones modulares de Ramanujan, que fijan en diez de dimensiones del espacio-tiempo. Esto a su vez, puede facilitarnos la clave decisiva para explicar el origen del universo.

emilio silvera

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

Nuestro Universo es de Luz, todo lo que podemos observar es posible gracias a la luz que incide en los objetos y se refleja en nuestras retinas, así podemos contemplar los planetas y las estrellas del cielo y cualquier coda que, hecha de materia boriónica, es decir, materia radiante, se deja ver por nosotros. Decía Leonard Susskind que, para comprender la realidad en sus niveles más elementales, basta con conocer el comportamiento de dos elementos: el electrón y el fotón.

Todo el argumento de la electrodinámica cuántica (QED) gira en torno a un proceso fundamental: la emisión de un único fotón por un único electrón.

Cuando el movimiento de un electrón es alterado súbitamente, puede responder desprendiendo un fotón. La emisión de un fotón es el suceso básico de la mecánica cuántica:

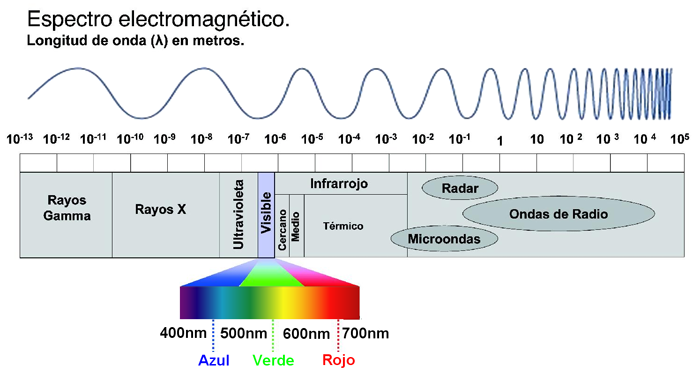

Toda la luz visible que vemos, así como las ondas de radio, la radiación infrarroja y los rayos X, está compuesta de fotones que han sido emitidos por electrones, ya sea en el Sol, el filamento de una bombilla, una antena de radio o un aparato de rayos.

Los electrones no son las únicas partículas que pueden emitir fotones. Cualquier partícula eléctricamente cargada puede hacerlo, incluido el protón. Esto significa que los fotones pueden saltar entre dos protones o incluso entre un protón y un electrón. Este hecho es de enorme importancia para toda la ciencia y la vida en general. El intercambio continuo de fotones entre el núcleo y los electrones atómicos proporciona la fuerza que mantiene unido al átomo. Sin estos fotones saltarines, el átomo se desharía y toda la materia dejaría de existir.

Mientras que un electrón pertenece al grupo de partículas llamadas fermiones, los fotones pertenecen a la familia de los bosones. Intentemos comprender esta película que es la existencia…

…protagonizada por bosones…

Los fermiones hacen posible la materia “al estilo tradicional”, mientras que los bosones son elementos muy raros desde la forma de pensar a que estamos acostumbrados el común de los mortales. Para no complicarnos, la tabla periódica de elementos existe porque los fermiones no pueden “ser iguales”: no pueden solaparse uno sobre otro y se repelen si los obligamos. Es lo que damos por hecho cuando hablamos de materia, que cada pedazo de ésta ocupa su lugar y tiene sus propias cualidades.

En cambio, los bosones carecen de este sentido de la individualidad, digamos que poseen “alma grupal” y, en su estado más puro, todos forman una misma “superpartícula”.

Para entenderlo mejor, conviene recordar que las partículas no son bolitas como nos siguen enseñando en la escuela, sino que más allá de esta imagen existen como ondas o, al menos, sus funciones se equiparan al comportamiento de una onda.

En la década de 1920, Albert Einstein y el hindú Satyendra Nath Bose pronosticaron un quinto estado de la materia: el condensado de Bose-Einstein (BEC), el cual fue conseguido en laboratorio en 1995, algo que le valió el premio Nobel de 2001 a los científicos que lo lograron.

Imagínese una taza de té caliente, las partículas que contiene circulan por toda la taza. Sin embargo cuando se enfría y queda en reposo, las partículas tienden a ir en reposo hacia el fondo. Análogamente, las partículas a temperatura ambiente se encuentran a muchos niveles diferentes de energía. Sin embargo, a muy bajas temperaturas, una gran proporción de éstas alcanza a la vez el nivel más bajo de energía, el estado fundamental. (Fuente: wikipedia)

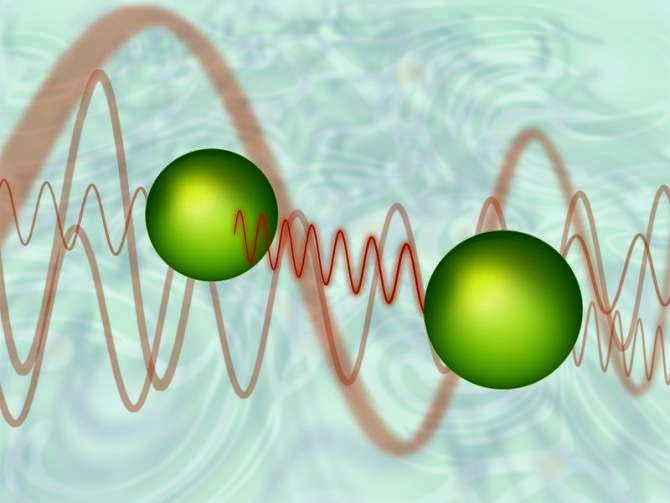

Cuando ciertas formas de materia [bosones] se enfrían hasta casi el cero absoluto, sus átomos se ponen en el estado de energía más baja, de modo que todos sus átomos vibran al unísono y se hacen coherentes. Las funciones de onda de todos los átomos se solapan, de manera que, en cierto sentido, un BEC [condensado de Bose-Einstein] es como un “superátomo” gigante en donde todos los átomos individuales vibran al unísono.

Al enfriar los átomos, su velocidad disminuye hasta que las longitudes de onda de cada uno de ellos se vuelven casi planas, superponiéndose unas a otras para formar una única onda que los describe a todos.

Así que un BEC se forma cuando los átomos en un gas sufren la transición de comportarse como “bolas de billar” al estilo de la física clásica, a comportarse como una onda gigante de materia al estilo de mecánica cuántica:

Un BEC es un grupo de unos cuantos millones de átomos que se unen para formar una sola onda de materia de aproximadamente un milímetro de diámetro. Si creamos dos BECs y los colocamos juntos, no se mezclan como gases ordinarios ni rebotan como lo harían dos sólidos. Donde los dos BECs se superponen, ellos “interfieren” como las ondas: delgadas capas paralelas de materia son separadas por capas delgadas de espacio vacío. El patrón se forma porque las dos ondas se suman donde sus crestas coinciden, y se cancelan donde una cresta se encuentra con un valle — a lo cual llamamos interferencia “constructiva” y “destructiva” respectivamente. El efecto es similar al de dos ondas que se superponen cuando dos piedras son lanzadas a un lago.

(Fuente: ciencia NASA)

…ambientada en: el vacío…

El hecho de que se puedan intercambiar partículas virtuales modifica el vacío alrededor de los átomos, y esto lleva a una fuerza. De las llamadas fluctuaciones de vacío pueden surgir, partículas virtuales y quién sabe que cosas más… Hasta un nuevo Universo.

Y ahora, retrocedamos un poco más en este asunto del misterio que nos ocupa. Gracias a la tecnología láser, la física ha podido comprobar el extremo poder de la luz. Los láseres pueden hacer que las partículas virtuales se vuelvan reales. Pero, primero, aclaremos conceptos…

Las “partículas virtuales” son partículas fundamentales que están constantemente surgiendo aparentemente de la nada y permanecen en el espacio-tiempo la friolera de una milésima de trillonésima de segundo –una cantidad que se forma poniendo una veintena de ceros a la derecha de la coma—. A pesar de denominarse “virtuales”, sus efectos son muy reales: la constante agitación de este burbujeo cuántico de partículas hace que el vacío tenga energía. Y esto es algo que afecta a la realidad, pues en ésta las fuerzas de atracción y repulsión dependen de la masa, y la masa no es sino energía expresada en unidades diferentes: E=mc².

En el uso corriente la palabra vacío significa espacio vacío, espacio del que se ha extraído todo el aire, vapor de agua u otro material. Eso es también lo que significa para un físico experimental que trabaja con tubos de vacío y bombas de vacío. Pero para un físico teórico, el término vacío tiene muchas más connotaciones. Significa una especie de fondo en el que tiene lugar el resto de la física. El vacío representa un potencial para todas las cosas que pueden suceder en ese fondo. Significa una lista de todas las partículas elementales tanto como de las constantes de la Naturaleza que se pondrían de manifiesto mediante experimentos en dicho vacío. En resumen, significa un ambiente en el que las leyes de la física toman una forma particular. […] Un vacío diferente significa leyes de la física diferentes; cada punto en el paisaje representa un conjunto de leyes que son, con toda probabilidad, muy diferentes de las nuestras pero que son, en cualquier caso, posibilidades consistentes. El modelo estándar es meramente un punto en el paisaje de posibilidades.

… la energía del vacío es tomada como la base para la constante cosmológica. A nivel experimental, la energía del punto cero genera el efecto Casimir, … Se dice que:

La energía del vacío es, por tanto, la suma total de las energías de todas las partículas posibles. Es la llamada “energía oscura” que hace que el universo se expanda, haciendo frente a la atracción de la gravedad, y que proporciona alrededor del 80% de la materia-energía al universo –un 26% es “materia oscura”, y sólo un 4% es la materia conocida hasta el momento—.

Pero, ¿cómo una partícula virtual se convierte en real? Es decir, ¿cómo queda “atrapada” en el espacio-tiempo de forma más estable?

La teoría de cuerdas, también llamada de supercuerdas, pues la supersimetría es necesaria para incluir los quarks y otros fermiones, es una teoría …

La teoría de la supersimetría establece que, por cada partícula de materia, nace una gemela de antimateria. La antimateria es igual que la materia, pero con carga opuesta. Por ejemplo, el electrón tiene carga negativa, y su partícula de antimateria, el positrón, positiva. Materia y antimateria se aniquilan mutuamente pero, por algún motivo aún no aclarado, la simetría se rompió en algún momento, surgiendo más materia que antimateria, de ahí que nuestro universo, materia, pueda existir.

Pero hay algo más en todo esto. Y para ello, la luz es la clave.

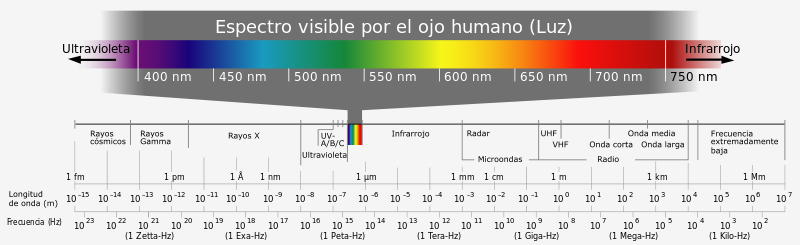

Si nos movemos en el espectro electromagnético, los fotones con longitud de onda ultravioleta pueden expulsar a los electrones de los átomos. Pero veámos.

…starring “light” as itself…

Ya en los años 30, los físicos predijeron que un campo eléctrico muy fuerte, que no es sino un espacio alterado por la actividad de un montón de fotones coordinados, podría impulsar a las partículas virtuales con carga opuesta en diferentes direcciones, impidiendo que la materia y la antimateria se aniquilen.

Según el efecto de creación de pares, un fotón con energía suficiente, lo que equivale a tener el doble de la energía que posee un electrón en reposo, da lugar a una pareja de electrón y positrón. Aunque esto ya se consiguió en los años 90 a pequeña escala, gracias al desarrollo de la tecnología láser los científicos creen que estarán cerca de conseguir crear materia “en serie” mediante este proceso en unos pocos años. Por otra parte, una vez que existen las partículas, los fotones interactuan sin cesar con ellas, siendo absorbidos y emitidos por las mismas de manera ininterrumpida.Y de ello nace el movimiento gracias al cual todo existe en el espacio-tiempo. Sin movimiento, nuestra realidad desaparecería.

Así, si el fotón tiene suficiente energía, el par será electrón-positrón, caso contrario será un par virtual (absorción), si la energía del fotón fuere mayor, la diferencia estará dada por la velocidad opuesta de las antipartículas (masa de las antipartículas), correspondiente a la energía “sobrante” de acuerdo a E=mc2. Si la energía del fotón fuere suficiente, como para llegar al umbral mínimo, se creará un protón-antiprotón, y si fuere mayor, se manifestará en velocidad opuesta (masa de las antipartículas). La energía del fotón (cantidad de movimiento, efecto Compton) será la energía correspondiente al total de las dos antipartículas (masa, E=mc2)

La carencia de masa de un fotón está ligada a su movimiento. Para que un cuerpo alcance la velocidad de la luz, su masa ha de ser cero. Y, como Einstein explicó en su día, la luz se mueve siempre a la velocidad de la luz. Si pretendemos que un fotón se pare, en lugar de ralentizarse observaremos que desaparece. Y, como se ha dicho al principio, si estos “fotones saltarines” desaparecieran, toda la materia dejaría de existir.

Su esencia es el movimiento y su misión, según parece, hacer girar la rueda de la existencia.

Ello es así debido al impacto de los fotones sobre las partículas elementales. La energía transmitida por un fotón es inversamente proporcional a su longitud de onda. Cuanto menos longitud de onda, más energía. Así, un fotón de luz visible tiene la energía suficiente para hacer reaccionar a un bastón de la retina. Si nos movemos en el espectro electromagnético, los fotones con longitud de onda ultravioleta pueden expulsar a los electrones de los átomos. Más allá, los rayos gamma pueden romper protones y neutrones…

Cuando la tensión llega a un punto insostenible la corteza de neutrones revienta en un temblor estelar, dejando escapar rayos gamma y rayos X. En una potencia descomunal capaz de destruir otras particulas cuando interaccionan.

Y ahora, vayamos al meollo de la cuestión e indaguemos en la cita con que se iniciaba este artículo: ¿qué hace que los electrones absorban y emitan fotones? Esto, en otros términos, vendría a ser lo mismo que preguntarnos: ¿por qué existe nuestro universo?

…con un misterio: el 137…

¿Qué determina el momento exacto en que un electrón emite un fotón? La física cuántica dice que nada lo hace, pues la Naturaleza es caprichosa en sus niveles más elementales. Aunque no es caótica en extremo, sólo probabilística.

A diferencia de la física newtoniana, la mecánica cuántica nunca predice el futuro en función del pasado. En su lugar, ofrece reglas muy precisas para computar la probabilidad de varios resultados alternativos de un experimento.

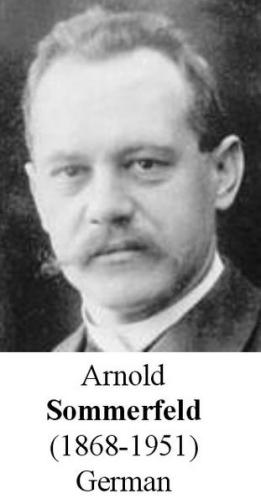

La constante de estructura fina fue introducida en la física en 1916 por Arnol Sommerfeld, como una medida relativista de las desviaciones en las lineas espectrales atómicas de las predicciones hechas por el modelo de Bohr.

Históricamente, la primera interpretación física de la constante de estructura fina,  , fue el cociente de la velocidad del electrón en la primera órbita circular del átomo de Bohr relativista con la velocidad de la luz en el vacío. De igual forma, era el cociente entre el momento angular mínimo permitido por la relatividad para una órbita cerrada bajo fuerza electromagnética y el momento angular mínimo permitido por la mecánica cuántica. Aparece de forma natural en el análisis de Sommerfeld y determina el tamaño de la separación o estructura fina de las lineas espectrales del hidrógeno.

, fue el cociente de la velocidad del electrón en la primera órbita circular del átomo de Bohr relativista con la velocidad de la luz en el vacío. De igual forma, era el cociente entre el momento angular mínimo permitido por la relatividad para una órbita cerrada bajo fuerza electromagnética y el momento angular mínimo permitido por la mecánica cuántica. Aparece de forma natural en el análisis de Sommerfeld y determina el tamaño de la separación o estructura fina de las lineas espectrales del hidrógeno.

La QED predice una relación entre el momento magnético sin dimensiones del electrón (o el g-factor de Lande,  ) y la constante de estructura fina

) y la constante de estructura fina  . Una nueva medida de

. Una nueva medida de  usando un ciclotrón cuántico de un electrón, junto con un cálculo QED que involucra 891diagrama de Feynman, determina el valor actual más preciso de

usando un ciclotrón cuántico de un electrón, junto con un cálculo QED que involucra 891diagrama de Feynman, determina el valor actual más preciso de  :

:

esto es, una medida con una precisión de 0.70 partes por mil millones. Las incertidumbres son 10 veces más pequeñas que aquellas de los métodos rivales más próximos. Las comparaciones de los valores medidos y los calculados de  suponen un test muy fuerte de QED, y ponen un límite para cualquier estructura interna del electrón posible.

suponen un test muy fuerte de QED, y ponen un límite para cualquier estructura interna del electrón posible.

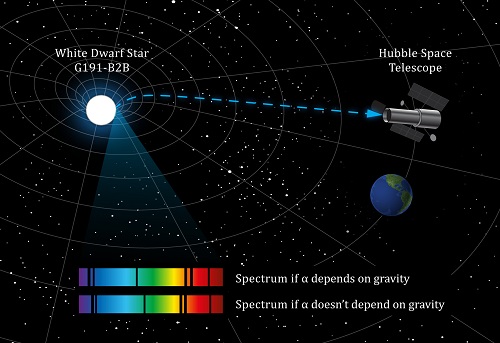

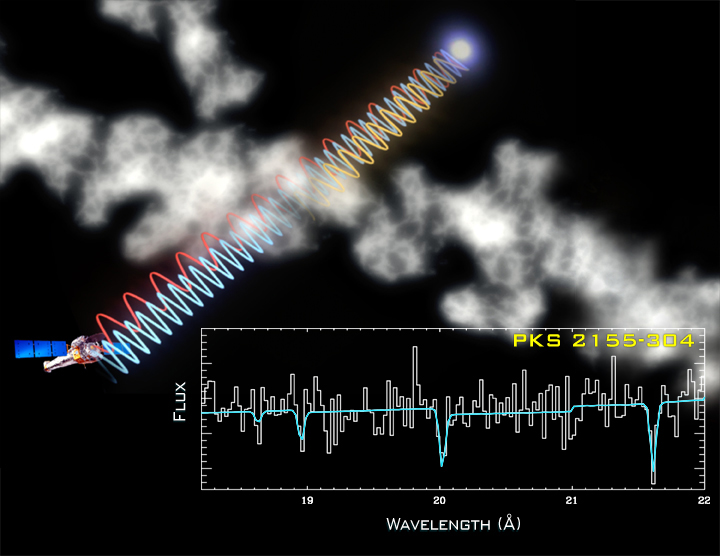

En 2010, el científico John Webb publicó un estudio en el que revelaba datos que afirmaban que la constante no era igual en todo el universo y que se observaban cambios graduales en torno a un eje concreto de éste.

Algunos científicos sostienen que las constantes de la naturaleza no sean en realidad constantes, y la constante de estructura fina no escapa a estas afirmaciones.

Físicos de la University of New Wales (UNSW) tienen una teoría cuando menos controvertida, y es la de que la constante de estructura fina, α (alpha), en realidad no es constante. Y estudian los alrededores de una enana blanca lejana, con una gravedad más de 30.000 veces mayor que la de la tierra, para comprobar su hipótesis.

Recientemente, la detección de los mapas de enlace-dimensional de la constante de estructura fina

Y la probabilidad de que un electrón emita o absorba un fotón es la constante de estructura fina. El valor de esa constante es 1/137.

En otras palabras, sólo un afortunado electrón de cada 137 emite un fotón. Este es el significado de alfa: es la probabilidad de que un electrón, cuando se mueve a lo largo de su trayectoria, emita caprichosamente un fotón.

El inverso de la constante de estructura fina es 137. Desde su descubrimiento, éste número ha traído de cabeza a los grandes científicos.

Fue Richard Feynman, precisamente, quien sugirió que todos los físicos pusiesen un cartel en sus despachos o en sus casas que les recordara cuánto es lo que no sabemos. En el cartel no pondría nada más que esto: 137. Ciento treinta y siete es el inverso de algo que lleva el nombre de constante de estructura fina. Este número guarda relación con la probabilidad de que un electrón emita o absorba un fotón. La constante de estructura fina responde también al nombre de alfa, y sale de dividir el cuadrado de la carga del electrón por el producto de la velocidad de la luz y la constante de Planck. Tanta palabra no significa otra cosa sino que ese solo número, 137, encierra los meollos del electromagnetismo (el electrón), la relatividad (la velocidad de la luz) y la teoría cuántica (la constante de Planck). Menos perturbador sería que la relación entre todos estos importantes conceptos hubiera resultado ser un uno o un tres o quizás un múltiplo de pi. Pero ¿137?

“Lo más notable de este notable número es su adimensionalidad. La velocidad de la luz es de unos 300.000 kilómetros por segundo. Abraham Lincoln medía 1,98 metros. La mayoría de los números vienen con dimensiones. Pero resulta que cuando uno combina las magnitudes que componen alfa, ¡se borran todas las unidades! El 137 está solo: se exhibe desnudo a donde va. Esto quiere decir que a los científicos de Marte, o a los del decimocuarto planeta de la estrella Sirio, aunque usen Dios sabe qué unidades para la carga y la velocidad y qué versión de la constante de Planck, también les saldrá 137. Es un número puro.”

(Leon Ledderman, La partícula divina)

Uno de los padres de la mecánica cuántica, Wolfgang Pauli, se obsesionó tanto con este número que dijo que, de poder hacerle una pregunta a Dios, sería esta: “¿Por qué 137?”

Gracias a su gran amistad con Carl G. Jung, Pauli conoció el mundo “alternativo” de los estudios sobre la psique y accedió a la tradición esotérica que ha acompañado al hombre desde el principio de los tiempos. Es así como supo que 137 se aproxima al valor correspondiente al ángulo áureo. Esto es, la versión circular del número áureo o φ (phi).

En realidad, el ángulo de oro es, más o menos, 137,5º, y está presente en todo proceso natural donde se dé una combinación de espirales. Así, por ejemplo, las hojas de una planta surgen a lo largo del tallo cada 137,5º, pues así se logra la mayor eficiencia de espacio y de captación de la luz solar, ya que únicamente con éste ángulo es posible evitar que ninguna hoja obstaculice a las demás en la toma de luz sin que existan espacios muertos o vacíos.

Esta semejanza entre los valores de la constante de estructura fina y el ángulo áureo llevó a la doctora Raji Heyrovska a buscar el ángulo áureo en el universo atómico (véase versión en español de su estudio).

Que esto sea así no debería extrañarnos, pues si el número áureo es una constante en toda la Naturaleza, su versión angular es la apropiada para estar presente en el universo cuántico, donde, recordemos, los elementos básicos de la realidad se reducen a funciones de onda.

…y un final místico.

Los fotones no tienen masa ni carga eléctrica. Sin embargo, pueden “extraer” del vacío partículas con masa y carga, tanto negativa como positiva.

Más allá de la matería y la energía, del tiempo y del espacio, el concepto de función de onda nos introduce en una realidad abstracta de donde surge todo. Y si, como hemos dicho, a menor longitud de onda mayor energía, también es posible afirmar que, en eso que David Bohm llamaba “orden implicado”, cuanto menor es la longitud de una onda cuántica, mayor es la presencia de masa en el espacio-tiempo.

Para la física, las matemáticas se han mostrado como la realidad que subyace a la materia. Todo se puede reducir a números, entidades que forman y organizan el espacio-tiempo. En este nivel de realidad, ni la materia ni la energía existen como tales, sino que demuestran ser el resultado de la interacción de entidades abstractas.

Fuentes diversas.

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

Quién sabe cómo nos veremos nosotros dentro de unos cientos de años

Entre los teóricos, el casamiento de la relatividad general y la teoría cuántica es el problema central de la física moderna. A los esfuerzos teóricos que se realizan con ese propósito se les llama “supergravedad”, “súpersimetría”, “supercuerdas” “teoría M” o, en último caso, “teoría de todo o gran teoría unificada”. Lo cierto es que, para que las dos teorías, cuántica y relativista se reúnan sin que surjan los dichosos infinitos, se tiene que plantear dentro de una teoría de dimensiones extra. Esas teorías de más dimensiones, requieren de complejas formulaciones que no todos, podemos entender.

Ahí tenemos unas matemáticas exóticas que ponen de punta hasta los pelos de las cejas de algunos de los mejores matemáticos del mundo (¿y Perelman? ¿Por qué nos se ha implicado?). Hablan de 10, 11 y 26 dimensiones, siempre, todas ellas espaciales menos una que es la temporal. Vivimos en cuatro: tres de espacio (este-oeste, norte-sur y arriba-abajo) y una temporal. No podemos, ni sabemos o no es posible instruir, en nuestro cerebro (también tridimensional), ver más dimensiones. Pero llegaron Kaluza y Klein y compactaron, en la longitud de Planck las dimensiones que no podíamos ver. ¡Problema solucionado!

¿Quién puede ir a la longitud de Planck para verla?

Ni vemos la longitud de Planck ni las dimensiones extra

La puerta de las dimensiones más altas quedó abierta y, a los teóricos, se les regaló una herramienta maravillosa. En el Hiperespacio, todo es posible. Hasta el matrimonio de la relatividad general y la mecánica cuántica, allí si es posible encontrar esa soñada teoría de la Gravedad cuántica.

Así que, los teóricos, se han embarcado a la búsqueda de un objetivo audaz: buscan una teoría que describa la simplicidad primigenia que reinaba en el intenso calor del universo en sus primeros tiempos, una teoría carente de parámetros, donde estén presentes todas las respuestas. Todo debe ser contestado a partir de una ecuación básica.

¿Dónde radica el problema?

Nuestro es tridimensional y no podemos ver otro más allá… ¡si existe!

El problema está en que la única teoría candidata no tiene conexión directa con el mundo de la observación, o no lo tiene todavía si queremos expresarnos con propiedad. La energía necesaria para ello, no la tiene ni el nuevo acelerador de partículas LHC que con sus 14 TeV no llegaría ni siquiera a vislumbrar esas cuerdas vibrantes de las que tanto se habla.

La verdad es que, la teoría que ahora tenemos, el Modelo Estándar, concuerda de manera exacta con todos los datos a bajas energías y contesta cosas sin sentido a altas energías.

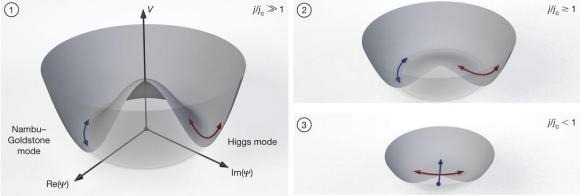

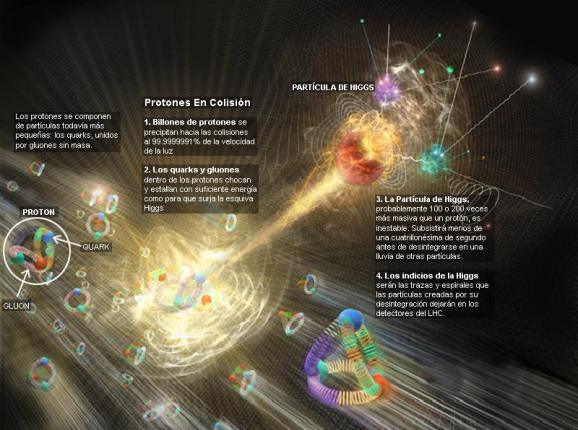

Con sus 20 parámetros aleatorios (parece que uno de ellos ha sido hallado -el bosón de Higgs-), el Modelo estándar de la física de partículas que incluye sólo tres de las interacicones fundamentales -las fuerzas nucleares débil y fuerte y el electromagnetismo-, ha dado un buen resultado y a permitido a los físicos trabajar ampliamente en el conocimiento del mundo, de la Naturaleza, del Universo. Sin embargo, deja muchas preguntas sin contestar y, lo cierto es que, se necesitan nuevas maneras, nuevas formas, nuevas teorías que nos lleven más allá.

¡Necesitamos algo más avanzado!

Se ha dicho que la función de la partícula de Higgs es la de dar masa a las partículas que conocemos y están incluidas en el Modelo estándar, se nos ha dicho que ha sido encontrada pero, nada se ha dicho de cómo ésta partícula transmite la masa a las demás. Faltan algunas explicaciones.

El secreto de todo radica en conseguir la simplicidad: el átomo resulto ser complejo lleno de esas infinitesimales partículas electromagnéticas que bautizamos con el nombre de electrones, resultó que tenía un núcleo que contenía, a pesar de ser tan pequeño, casi toda la masa del átomo. El núcleo, que siendo infinitesimal, estaba compuesto de otros objetos más pequeños aún, los quarks que estaban instalados en nubes de otras partículas llamadas gluones y, ahora, queremos continuar profundizando, sospechamos, que después de los quarks puede haber algo más.

Los del LHC dicen haber encontrado el Bosón de Higgs pero, no he podido leer ni oir, alguna explicación clara y precisa de cómo le dá masa a las demás partículas (la mejor explicación sobre el tema la he leido de nuestro amigo y contertulio Ramón Marquez. Él dice que la masa de las partículas es el resultado del efecto frenado al viajar por los océanos de Higgs, una idea brillante, sencilla de entender y razonable para explicar tal fenómeno). Espero que, el Nobel se justifique y que expongan con detalle lo que pasa en los llamados “océanos de Higgs” por el que las partículas circulan para adquirir sus masas que les “proporciona” el recien “hallado” bosón.

¿Cómo llegamos aquí? Bueno, la idea nueva que surgió es que el espacio entero contiene un campo, el campo de Higgs, que impregna el vacío y es el mismo en todas partes. Es decir, que si miramos a las estrellas en una noche clara estamos mirando el campo de Higgs. Las partículas influidas por este campo, toman masa. Esto no es por sí mismo destacable, pues las partículas pueden tomar energía de los campos (gauge) de los que hemos comentado, del campo gravitatorio o del electromagnético. Si llevamos un bloque de plomo a lo alto de la Torre Eiffel, el bloque adquiriría energía potencial a causa de la alteración de su posición en el campo gravitatorio de la Tierra.

Como E=mc2, ese aumento de la energía potencial equivale a un aumento de la masa, en este caso la masa del Sistema Tierra-bloque de plomo. Aquí hemos de añadirle amablemente un poco de complejidad a la venerable ecuación de Einstein. La masa, m, tiene en realidad dos partes. Una es la masa en reposo, m0, la que se mide en el laboratorio cuando la partícula está en reposo. La partícula adquiere la otra parte de la masa en virtud de su movimiento (como los protones en el acelerador de partículas, o los muones, que aumentan varias veces su masa cuando son lanzados a velocidades cercanas a c) o en virtud de su energía potencial de campo. Vemos una dinámica similar en los núcleos atómicos. Por ejemplo, si separamos el protón y el neutrón que componen un núcleo de deuterio, la suma de las masas aumenta.

Peor la energía potencial tomada del campo de Higgs difiere en varios aspectos de la acción de los campos familiares. La masa tomada de Higgs es en realidad masa en reposo. De hecho, en la que quizá sea la versión más

apasionante de la teoría del campo de Higgs, éste genera toda la masa en reposo. Otra diferencia es que la cantidad de masa que se traga del campo es distinta para las distintas partículas. Los teóricos dicen que las masas de las partículas de nuestro modelo estándar miden con qué intensidad se acoplan éstas al campo de Higgs.

La influencia de Higgs en las masas de los quarks y de los leptones, nos recuerda el descubrimiento por Pieter Zeeman, en 1.896, de la división de los niveles de energía de un electrón cuando se aplica un campo magnético al átomo. El campo (que representa metafóricamente el papel de Higgs) rompe la simetría del espacio de la que el electrón disfrutaba.

Hasta ahora no tenemos ni idea de que reglas controlan los incrementos de masa generados por el Higgs (de ahí la expectación creada por el nuevo acelerador de partículas LHC). Pero el problema es irritante: ¿por qué sólo esas masas –Las masas de los W+, W–, y Zº, y el up, el down, el encanto, el extraño, el top y el bottom, así como los leptones – que no forman ningún patrón obvio?

No dejamos de experimentar para saber ccómo es nuestro mundo, la Naturaleza, el Universo que nos acoge

Las masas van de la del electrón 0’0005 GeV, a la del top, que tiene que ser mayor que 91 GeV. Deberíamos recordar que esta extraña idea (el Higgs) se empleó con mucho éxito para formular la teoría electrodébil (Weinberg-salam). Allí se propuso el campo de Higgs como una forma de ocultar la unidad de las fuerzas electromagnéticas y débiles. En la unidad hay cuatro partículas mensajeras sin masa –los W+, W–, Zº y fotón que llevan la fuerza electrodébil. Además está el campo de Higgs, y, rápidamente, los W y Z chupan la esencia de Higgs y se hacen pesados; el fotón permanece intacto. La fuerza electrodébil se fragmenta en la débil (débil porque los mensajeros son muy gordos) y la electromagnética, cuyas propiedades determina el fotón, carente de masa. La simetría se rompe espontáneamente, dicen los teóricos. Prefiero la descripción según la cual el Higgs oculta la simetría con su poder dador de masa.

Las masas de los W y el Z se predijeron con éxito a partir de los parámetros de la teoría electrodébil. Y las relajadas sonrisas de los físicos teóricos nos recuerdan que Gerard ^t Hooft y Veltman dejaron sentado que la teoría entera esta libre de infinitos.

La asignatura pendiente de la física teórica del siglo XX ha sido la unificación de la relatividad general y la mecánica cuántica. Las aproximaciones que se han hecho van desde la cuantificación canónica del campo gravitatorio hasta la ampliación de las simetrías en la teoría de supercuerdas. Existen también teorías que buscan una nueva interpretación de las teorías del espacio-tiempo, como se vio en el congreso sobre la ontología del espacio-tiempo que tuvo lugar en junio de 2006 en Montreal.

Penrose es actualmente Profesor emérito de Matemáticas de la Universidad de Oxford, y ya en los años 60 presentó su teoría de los “spin networks” que después fue tomada por Ashtekar y Rovelli, y otros, en la teoría de la gravitación cuántica.

A partir de los años 70, Penrose presentó su teoría de los “twistor”, que algunos físicos han aplicado a la teoría de las supercuerdas para resolver el enigma de las 11 dimensiones del espacio-tiempo. En su último libro “El camino a la Realidad” Penrose ha reivindicado la paternidad de las teorías de los “spin networks” y de los “twistors” que se empieza a utilizar por los físicos teóricos y que nosotros vamos a resumir brevemente.

Roger Penrose es uno de los nuevos humanistas del siglo que se ha interesado por los problemas de las matemáticas, de la física, de la biología, de la psicología y de la filosofía. Siguiendo el modelo de Popper de los tres mundos, ha trabajado sobre la flecha del mundo 1 de la física, al mundo 2 de la conciencia, y del mundo 3 de las matemáticas, al mundo 1.

En esta última dirección ha publicado numerosos libros y artículos, donde aborda la asignatura pendiente de la unificación de la mecánica cuántica y la teoría del campo gravitatorio. El camino que ha seguido Penrose es encontrar una base común a ambas.

Para ello ha introducido dos modelos: los “spin networks” y los “twistors”, el primero discreto, con una métrica intrínseca, no relativista, previo al concepto de espacio, el segundo continuo, con una métrica extrínseca, relativista e inmerso en un espacio-tiempo dado.

Con estos modelos intenta Penrose responder a la pregunta sobre el “por qué” de la realidad física, en vez del “cómo”. Nos encontramos así ante uno de los grandes misterios de la razón humana que nos acercan al misterio del Universo.

“Spin networks” y gravedad cuántica

El modelo de los “twistors” se ha aplicado con éxito a la clasificación de las partículas elementales y a la formulación de la relatividad general. Pero recientemente algunos modelos de la gravedad cuántica han retomado la idea de los “spin networks” de Penrose para desarrollar un modelo discreto llamado loop quantum gravity donde el espacio subyacente está discretizado.

Claro que son varias las corrientes que quieren abrirse camino hacia otras físicas nuevas.

La teoría de supercuerdas tiene tantas sorpresas fantásticas que cualquiera que investigue en el tema reconoce que está llena de magia. Es algo que funciona con tanta belleza… Cuando cosas que no encajan juntas e incluso se repelen, si se acerca la una a la otra alguien es capaz de formular un camino mediante el cual, no sólo no se rechazan, sino que encajan a la perfección dentro de ese sistema, como ocurre ahora con la teoría M que acoge con naturalidad la teoría de la relatividad general y la teoría mecánico-cuántica; ahí, cuando eso se produce, está presente la belleza.

Lo que hace que la teoría de supercuerdas sea tan interesante es que el marco estándar mediante el cual conocemos la mayor parte de la física es la teoría cuántica y resulta que ella hace imposible la gravedad. La relatividad general de Einstein, que es el modelo de la gravedad, no funciona con la teoría cuántica. Sin embargo, las supercuerdas modifican la teoría cuántica estándar de tal manera que la gravedad no sólo se convierte en posible, sino que forma parte natural del sistema; es inevitable para que éste sea completo.

¿Por qué es tan importante encajar la gravedad y la teoría cuántica? Porque no podemos admitir una teoría que explique las fuerzas de la naturaleza y deje fuera a una de esas fuerzas. Así ocurre con el Modelo Estándar que deja aparte y no incluye a la fuerza gravitatoria que está ahí, en la Naturaleza.

La teoría de supercuerdas se perfila como la teoría que tiene implicaciones si tratamos con las cosas muy pequeñas, en el microcosmos; toda la teoría de partículas elementales cambia con las supercuerdas que penetra mucho más; llega mucho más allá de lo que ahora es posible.

Se habla de cuerdas abiertas, cerradas o de lazos, de p branas donde p denota su dimensionalidad (así, 1 brana podría ser una cuerda y 2.

La topología es, el estudio de aquellas propiedades de los cuerpos geométricos que permanecen inalteradas por transformaciones continuas. La topología es probablemente la más joven de las ramas clásicas de las matemáticas. En contraste con el álgebra, la geometría y la teoría de los números, cuyas genealogías datan de tiempos antiguos, la topología aparece en el siglo diecisiete, con el nombre de analysis situs, ésto es, análisis de la posición.

De manera informal, la topología se ocupa de aquellas propiedades de las figuras que permanecen invariantes, cuando dichas figuras son plegadas, dilatadas, contraídas o deformadas, de modo que no aparezcan nuevos puntos, o se hagan coincidir puntos diferentes. La transformación permitida presupone, en otras palabras, que hay una correspondencia biunívoca entre los puntos de la figura original y los de la transformada, y que la deformación hace corresponder puntos próximos a puntos próximos. Esta última propiedad se llama continuidad, y lo que se requiere es que la transformación y su inversa sean ambas continuas: así, trabajarnos con homeomorfismos.

Aunque creo que aíun nos esconde algún secreto, todos sabemos ya cuál es, el «pegamento» que mantiene unidas a las grandes estructuras que podemos observar a nuestro alrededor (galaxias, cúmulos y supercúmulos) La Relatividad General vino a definir lo que ahora es una auténtica cosmología que nos marcaron los parámetros de cómo funciona el Universo a gran escala.

En cuanto a nuestra comprensión del universo a gran escala (supercúmulos de galaxias, ondas gravitacionales, posibles estrellas de Quarks-Gluones… el propio Big Bang…), creo que afectará a nuestra idea presente, al esquema que hoy rige y, como la nueva teoría, el horizonte se ampliará enormemente; el cosmos se presentará ante nosotros como un todo, con un comienzo muy bien definido y un final muy bien determinado. El Tiempo y la Entropía tienen mucho que decir en todo eso y, por el camino hacia el conocimiento pleno, tendremos que comprender, de manera completa y exacta que es la Luz, la Gravedad y… ¡tántas cosas!

Para cuando eso llegue, sabremos lo que es, como se genera y dónde están situados los orígenes de esa “fuerza”, “materia”, o, “energía” que ahora no sabemos ver para explicar el movimiento de las galaxias o la expansión del espacio mismo, la posible existencia de otros universos…

emilio silvera

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

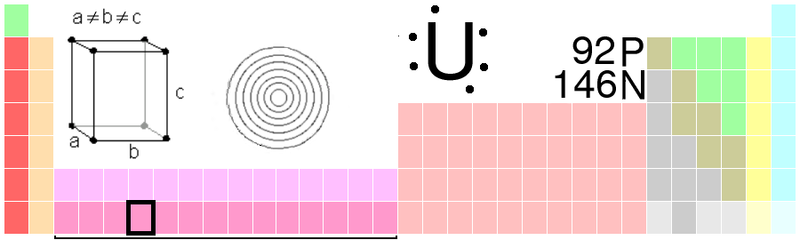

Hablar de una Naturaleza simétrica sería condenar a nuestro Universo a la monotonía de la igualdad, y, todos sabemos que en él se encuentra todo lo que existe, la Materia, el Tiempo y el Espacio, todo ello acompañado por fuerzas que hacen de nuestro universo el que conocemos y, dentro de toda esa inmensidad, también se encuentran la simetría y la asimetría, como en nuestro mundo el día y la noche, las Estaciones, los Océanmos y las montañas, los Valles y los desiertos… ¡La diversidad! La riqueza de la diversidad que conforma ese todo que el Universo es.

La exploración de la simetría y la asimetría en la Naturaleza comenzaba con el mayor de los objetos naturales: ¡El propio Universo! Y, hemos ido reduciendo gradualmente la escala de tamaños con estructuras cada vez más pequeñas. En otras ocasiones hemos tenido aquí mismo la oportunidad de hablar de la simetría que encontramos en la Naturaleza de las plantas y de los animales. Ahora, desvíamos nuestra atención hacia estructuras todavía menores, las diversas subunidades que constituyen todas las sustancias materiales, vivas o inertes.

Antes de continuar y para aquellos que lo puedan desconocer, será conveniente que tengan una conciencia clara de qué son exactamente estas unidades inferiores. Comenzando con las más pequeñas y yendo después en sentido ascendente, la escala sería:

Las partículas elementales que están descritas en el Modelo estándar actual de la física de partículas que conforman la materia y las fuerzas con las que interaccionan y que, hasta donde hemos podido saber, están divididas en familias:

Leptones: partículas puntuales con una dimensión espacial inapreciable. Los seis leptones conocidos son el electrón, el muón y el tauón, y el neutrino asociado a cada uno de ellos, el neutrino electrónico, muónico y tauónico.

Hadrones: Son aquellas partículas que se cree que están compuestas de pequeñas partículas puntuales llamadas quarks. Se han identificado cientos de hadrones, de los cuales los más importantes son el protón y el neutrón, ya que junto con el electrón forman la materia ordinaria.

Bosones: Partículas de “cambio”, partículas “soporte”, partículas “mensajeras” o partículas “indicadoras”. Contienen o son intermediarias de las cuatro fuerzas: electromagnetismo (conducido por el fotón), la fuerza débil (conducida por los vectores bosones intermedios), la gran fuerza nuclear (por los gluones) y la gravedad (por el gravitón aún no detectado). A finales de lños años setenta, las fuerzas elecdtromagnética y débil se unificaron en lo que ahora llamamos la fuerza electrodébil. La teoría electrodébil predice un bosón masivo denominado partícula de Higgs que, según nos han dicho los del LHC, ha sido encontrado. Veremos que explicaciones nos facilitan sobre ese hallazgo que… ¡ha quedado huérfano de los datos precisos que nos convenzan de su existencia real!

Representación de los tres bosones intermediarios en la fuerza electrodébil

Una vez descritas, muy someramente, las partículas de la materia y las fuerzas que rigen el universo conocido, tendríamos que pasar, de inmediato, al paso próximo que estaría representado por el átomo que, hasta donde conocemos, es la menor unidad estructural en la que puede dividirse la materia sin que pierda sus propiedades. En el centro de todo átomo está el núcleo, que debe contener al menos un protón, pero habitualmente está formado por una mezcla de protones y neutrones. Alrededor del núcleo, agrupados en “capas”, están los electrones. El átomo más sencillo, el de Hidrógeno, tiene un núcleo con un protón, alrededor del cual se mueve un único electrón. El átomo más complejo que se ha encontrado en la Naturaleza es el del Uranio, con 92 electrones. En el laboratorio se han encontrado algunos elementos más complejos a los que se llaman transuránicos, es decir, que van más allá del uranio y que no se encuentran en la Naturaleza, son artificiales.

Como podéis ver, el Uranio tiene 92 Protones y 146 Neutrones. Para equilibrar el átomo, el número de eletrones es también de 92, ya que al tener el elecdtrón, carga negativa equivalente a la carga positiva del protón, se consigue el equilibrio entre ambas y se alcanza la estabilidad, es decir, que el átomo sea neutro. Si un átomo pierde un electrón de su capa más externa se convierte en un átomo con carga positiva. Si gana uno, queda con carga negativa. Los átomos con carga eléctrica reciben el nombre de iones.

La molécula es una agrupación ordenada de átomos y constituye la mínima unidad de un elemento que puede subsistir de manera independiente. Mediante la afinidad química, los átomos están capacitados se unen entre sí y forman moléculas, que tienen un tamaño de alrededor de un millonésimo de milímetro. La afinidad de los átomos depende de la cantidad de electrones que giren alrededor del núcleo. Los átomos que tienen en la órbita externa ocho electrones no se unen a ningún otro elemento, dado que se encuentran equilibrados; estos constituyen los llamados gases nobles: helio, neón, argón, criptón, xenón y radón. Los demás átomos tratan de completar el número de ocho electrones hasta configurarse como los gases nobles. Es decir, los que tienen un electrón se combinan con los que tienen siete electrones.

Un equipo de científicos del Instituto de Astrofísica de las Canarias (IAC) y la Universidad de Texas lograron identificar una de las moléculas orgánicas más complejas encontradas hasta ahora en la materia entre las estrellas, el llamado espacio interestelar. El descubrimiento del antraceno podría ayudar a resolver un misterio astrofísico de décadas de antigüedad sobre la producción de las moléculas orgánicas en el espacio.

Buscar moléculas de azucar en el espacio exterior, sería una manera de acercarnos a posibles formas de vida en las que, estas moléculas están presentes y, como sabéis (la imagen de arriba lo demuestra), han sido halladas tales moléculas por el potente radioteslecopio ALMA en el norte de Chile que permitió detectarlas moléculas en torno a una estrella joven, similar al sol, un inédito hallazgo para la ciencia, según el Observatorio Europeo Austral (ESO).

Este espectro tomado por el telescopio espacial de infrarrojos HERSCHEL ilustra la variedad molecular existente en una nube interestelar como la de Orión. Agua, monóxido de carbono, metanol, formaldehído, cianuro de hidrógeno, óxidos de azufre y otras moléculas (de las cuales hay muchas aún sin identificar) dejan sus firmas inequívocas en la emisión del infrarrojo lejano que se origina en la nebulosa. El espectro se muestra superpuesto a una imagen (también infrarroja) tomada por el telescopio espacial Spitzer.

Muchas son ya las moléculas de la vida ahí encontradas. Si una sustancia está formada por un único tipo de átomos, diremos que es un elemento. Cuando una molécula está formada por átomos de distintos tipos, la sustancia se llama compuesto. El agua es un compuesto: su molécula consta de dos átomos de hidrógeno unidos por un enlace químico (electromagnético) a un átomo de oxígeno. El número de átomos que constiruyen la molécula de un compuesto puede variar desde dos o tres hasta las decenas de miles que conforman la molécula de un complejo proteínico.

Si miramos esta imagen de visión de rayos X de un cristal de hielo que tiene simetría exagonal, es la equivalente a multiplicar el original por 100000000. Los átomos de oxíogeno se representan como bolas rojas y los de Hidrógeno como bolas azules más pequeñas. Todos los enlaces entre estos átomos se representan como barras blancas para resaltar la red hexagonal en forma de colmena que forma el conjunto de moléculas de H2O.

En el agua líquida también hay molécuklas de H2O, pero en ese caso se encuentran más calientes que en el hielo. Lo que significa que se mueven mñás libremente y de hecho esa es la razón de que el agua sea un líquido sin forma propia y se adapta al recipiente que lo contiene. Pero si el agua se congela, las fuerzas de interacción entre las moléculas de H2O ganan a las fuerzas derivadas del movimiento térmico y forman un conjunto rígido que presenta su estado más estable (de menor energía) cuando se ordenan… precisamente con simetría Hexagonal.

Por eso los cristales de nieve son siempre hexagonales. La estructura de los cristales a nivel atómico determina su forma final. Y este no es un ejemplo aislado. La composición y la estructura a nivel atómico y molecular es la clave que determina la estructura, dureza y demás propiedades en general de todos los materiales que nos rodean. Hasta aquí llegan las escalas de estructuras básicas.

Naturalmente, podemos hablar de unidades todavía mayores, como los minerales y las rocas. Un mineral es, simplemente un elemento o un compuesto en estado sólido que se encuentra en la Naturaleza y que no es el resultado de un proceso biológico; pero si un mineral presenta una, se trata de una estructura cristalina derivada de la colocación de sus moléculas. Las rocas son, sencillamente, mezclas de uno o más minerales diferentes. Como sabemos, las rocas presentan a veces algún tipo de dibujo , como los estratos horizontales de las rocas sedimentarias, pero el trazado es de tan bajo nivel que no se piueden llegar a tomar en consideración cuestiones de simetría como las que antes hemos referido.

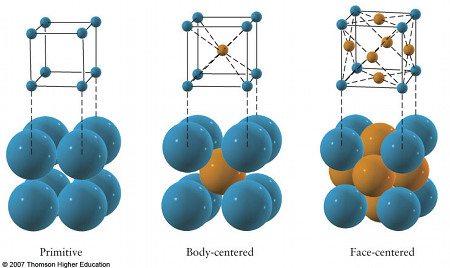

Si comenzamos por la parte más alta de la escala, con la estructura de los cristales y seguir bajando por dicha escala hasta la selva subatómica de las partículas elementales. Sólo los sólidos tienen estructura cristalina. Las moléculas de un gas están tan alejadas las unas de las otras que tienen la libertad de moverse al azar, y es imposible encontrar un modelo geométrico sistemático en su disposición. Os acordáis las formas arabescar de increíble belleza que adoptan, los gases en algunas Nebulosas.

Si hablamos de las moléculas de un líquido, asl contrario de lo que ocurre con las moléculas de los gases, éstas están más juntas y próximas entre ellas, pero todavía son lo suficientemente libres en sus movimientos como para que no se puedan formar modelos fijos. Los sólidos, por otra parte, tienen moléculas que se aprietan estrechamente entre sí para poder crear una estructura rígida y estable. (En realidad, los átomos de un sólido siguen oscilando, pero las fuerzas electromagnéticas las enlazan tan estrechamente que sus oscilaciones son practicamente posiciones fijas. Para nuestro propósito supondremos que los átomos no tienen movimiento alguno.) En casi todos los casos se estereotipa esta dispoosición sistemática, que constituye la estructura cristalina del sólido.

El agua en sus tres estados: hielo, agua líquida y vapor en las nubes

Consideremos el agua. Tanto en su estado gaseoso (vapor) como líquido, sus moléculas están en una disposición caótica, pero cuando se hiela y pasa al estado sólido, las moléculas se agrupan entre sí en forma de figuras geométricas. El bello cristal de nieve, con simetría hexagonal, como el dibujo de un caleidoscopio, toma su forma directamente d ela forma cristalina subyacente de las moléculas de hielo de su congelador a los gigantescos Icebergs del Ártico, todos tienen la misma estructura cristalina.

Casi todas las sustancias sólidas son cristalinas, aunque el vidrio es una excepción sobresaliente; se origina al enfriarse determinados líquidos de manera tan rápida que las moléculas se agrupan estrechamente antes de tener la menor opción a disponerse de forma ordenada. Sólido o no no, un cristal no es cristalino. El vidrio tallado de un bello jarrón que es “cristal” para el dependiente de la tienda, no es cristal para el físico.

Las pitonisas que utilizan esferas pulidas procedentes de grandes cristales de cuarzo simples para predecir el futuro mirando a su través, hoy en día lo hacen a menudo a través de esferas de vidrio, puesto que son más baratas. Sería interesante saber si el futuro parece más claro mirándolo por un material en desorden o bien a través de una estructura ordenada.

Los sólidos no cristalinos se llaman amorfos; algunos químicos hablan de ellos como sólidos líquidos ya que, igual que éstos últimos, , carecen de estructura cristalina. El carbón vegetal, las breas y ciertos plásticos, son ejemplos familiares, sustancias que participan con los líquidos en la tendencia a “fluir”, aunque la capacidad de flujo puede ser extremadamente lenta. Incluso el vidrio acabaría fluyendo fuera de su forma si no se tocara durante algunos cientos de años.

La forma geométrica subyacente de cualquier sustancia cristalina se denomina la red de la misma. Unas veces es una configuración de átomos; otras de moléculas. El dióxido de Carbono, por ejemplo, se encuentra en la naturaleza en forma de gas; cuando su temperatura disminuye lo suficiente, se solidifica y se convierte en lo que se llama hielo seco. (Recibe el nombre de seco porque nunca se convierte en líquido, como el hielo ordinario; pasa directamente de sólido a gas.) En él, las moléculas de dióxido de carbono se agrupan entre sí formando la red cúbica con estructura semejante a las vigas de acero de un edificio de oficinas. Las moléculas situadas en las caras de cada cubo dan a esta red concreta el nombre de red cúbica de caras centradas, es decir, así:

Aquí, cada unidad es una molécula de Dióxido de Carbono.

La sal es uno de los minerales que más abunda en la Tierra. Su nomenclatura química, Cloruro de Sodio, se debe a sus dos iones componentes: cloro y sodio. La estructura de este compuesto, es un cristal con forma de cubo, en la que los átomos de cloro y sodio, dispuestos alternadamente, forman una red cúbica que se va repitiendo con la misma orientación en toda la sustancia, formando una red cristalina.

La sal no sólo sirve para sazonar. Sus iones son fundamentales para la transmisión de impulsos nerviosos, para los latidos del corazón, para la contracción muscular y para desencadenar una respuesta inmune. ¡La próxima vez que aliñen una ensalada, piensen en esto!

No se debe pensar que, por estar por debajo del campo de visión de un microscopio, estas estructuras reticulares no son sino construcciones teóricas que los físicos no han sido capaces de observar. Hubo un tiempo en que esto era así, pero en la actualidad existen muchas técnicas que permiten “ver” estructuras mucho más pequeñas que las que pueden ser vistas directamente. Hoy día, los microscopios electrónicos nos permiten ver lo que nunca pudimos.

Aprecien como se forma la red de fibras que hace posible la cicatrización de una herida.

Aqui podemos ver un cristal de óxido de zinc, unido a una malla amorfa de carbono.

Lo que vemos aquí es el cuerpo tratando de curarse a sí mismo. Los objetos con forma de cigarro de color amarillo son las bacterias de la tuberculosis. En torno a ella aparecen los macrófagos. Un macrófago es un fagocito, son células que nos protegen de objetos extraños.

Las esferas que pueden verse aquí son las esporas creadas por el hongo Emericella nidulans. Producen la hidrofobina proteína que hace que las esporas resistentes al agua.

¿Ha tenido caries en los dientes? Caries es causada por la bacteria Streptococcus mutans que convierte el azúcar queda en la superficie de sus dientes a los ácidos. Ese ácido corroe el esmalte dental provocando la caries. Aquí en color azul los Streptococcus mutans está atacando la superficie de un diente.

Explorar el misterio del spin del protón ha sido uno de los objetivos de la investigación científica fundamental en el RHIC

Hemos podido alcanzar a “ver” objetos y figuras estacionadas en esas distancias infinitesimales, nuestros ingenios tecnológicos pueden aumentar, en millones de veces, las proporciones físicas de pequeños objetos y sistemas. Hasta tal punto es así que, si pudiéramos tener delante de nuestros ojos lo que esos experimentos han logrado, nos parecería estar, en un mundo diferente, tan extraña y figuras podríamos contemplar en ese ámbito de lo muy pequeño.