Sep

20

¡Qué misterio esconde la materia? ¿Qué es la luz?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (3)

Comments (3)

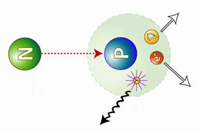

Decaimiento β– de un núcleo. Se ilustra cómo uno de los neutrones se convierte en un protón a la vez que emite un electrón (β–) y un antineutrino electrónico. La desintegración beta se debe a la interacción nuclear débil, que convierte un neutrón en un protón (desintegración β–), o viceversa (β+), y crea un par leptón–antileptón. Así se conservan los números bariónico (inicialmente 1) y leptónico (inicialmente 0). Debido a la aparente violación al principio de conservación de la energía, estas reacciones propiciaron precisamente que se propusiera la existencia del neutrino. Precisamente de eso hablamos aquí.

Una vez escenificados los conceptos, diremos que, los físicos se vieron durante mucho tiempo turbados por el hecho de que a menudo, la partícula beta emitida en una desintegración del núcleo no alberga energía suficiente para compensar la masa perdida por el núcleo. En realidad, los electrones no eran igualmente deficitarios. Emergían con un amplio espectro de energías, y el máximo (conseguido por muy pocos electrones), era casi correcto, pero todos los demás no llegaban a alcanzarlo en mayor o menor grado. Las partículas alfa emitidas por un nucleido particular poseían iguales energías en cantidades inesperadas. En ese caso, ¿qué era errónea en la emisión de partículas beta? ¿Qué había sucedido con la energía perdida?

En 1.922, Lise Maitner se hizo por primera vez esta pregunta, y, hacia 1.930, Niels Bohr estaba dispuesto a abandonar el gran principio de conservación de la energía, al menos en lo concerniente a partículas subatómicas. En 1.931, Wolfgang Pauli sugirió una solución para el enigma de la energía desaparecida.

La radiación alfa está compuesta por un núcleo de helio y puede ser detenida por una hoja de papel. La radiación beta, compuesta por electrones, es detenida por una hoja de papel de aluminio. La radiación gamma es absorbida cuando penetra en un material denso

Digamos que la solución de Pauli para explicar la masa perdida, era muy simple: junto con la partícula beta del núcleo se desprendía otra, que se llevaba la energía desaparecida. Esa misteriosa segunda partícula tenía propiedades bastante extrañas. No poseía carga ni masa. Lo único que llevaba mientras se movía a la velocidad de la luz era cierta cantidad de energía. A decir verdad, aquello parecía un cuerpo ficticio creado exclusivamente para equilibrar el contraste de energías.

Sin embargo, tan pronto como se propuso la posibilidad de su existencia, los físicos creyeron en ella ciegamente. Y esta certeza se incrementó al descubrirse el neutrón y al saberse que se desintegraba en un protón y se liberaba un electrón, que, como en la decadencia beta, portaba insuficientes cantidades de energía. Enrico Fermi dio a esta partícula putativa el nombre de “neutrino”, palabra italiana que significa “pequeño neutro”.

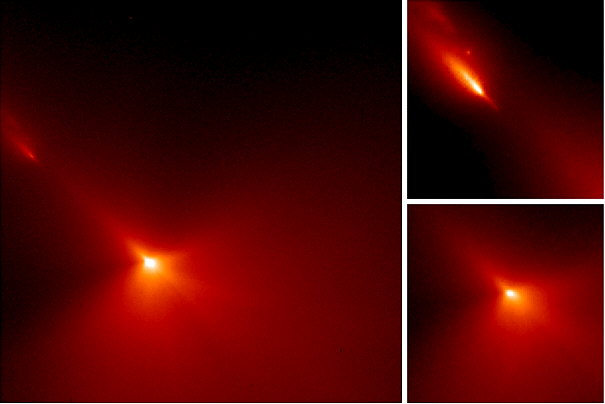

Primera observación de un neutrino en una cámara de burbujas, en 1970 en el Argonne National Laboratory de EE. UU., la observación se realizo gracias a las líneas observadas en la Cámara de burbujas basada en hidrógeno líquido. Siempre hemos tenido imaginación para idear aparatos que nos ayudaran a desvelar los secretos de la Naturaleza. Más tarde, la cámara de burbujas, fue sustituida por la cámara de chispas.

El neutrón dio a los físicos otra prueba palpable de la existencia del neutrino. Como ya he comentado otras veces, casi todas las partículas describen un movimiento rotatorio. Esta rotación se expresa, más o menos, en múltiplos de una mitad según la dirección del giro. Ahora bien, el protón, el neutrón y el electrón tienen rotación de una mitad. Por tanto, si el neutrón con rotación de una mitad origina un protón y un electrón, cada uno con rotación de una mitad, ¿qué sucede con la ley sobre conservación del momento angular? Aquí hay algún error. El protón y el electrón totalizan una mitad con sus rotaciones (si ambas rotaciones siguen la misma dirección) o cero (si sus rotaciones son opuestas); pero sus rotaciones no pueden sumar jamás una mitad. Sin embargo, por otra parte, el neutrino viene a solventar la cuestión.

Supongamos que la rotación del neutrón sea +½. Y admitamos también que la rotación del protón sea +½ y la del electrón -½, para dar un resultado neto de cero. Demos ahora al neutrino una rotación de +½, y la balanza quedará equilibrada.

+½(n) = +½(p) – ½(e) + ½(neutrino)

Pero aun queda algo por equilibrar. Una sola partícula (el neutrón) ha formado dos partículas (el protón y el electrón), y, si incluimos el neutrino, tres partículas. Parece más razonable suponer que el neutrón se convierte en dos partículas y una antipartícula. En otras palabras: lo que realmente necesitamos equilibrar no es un neutrino, sino un antineutrino.

El propio neutrino surgiría de la conversación de un protón en un neutrón. Así, pues, los productos serían un neutrón (partícula), un positrón (antipartícula) y un neutrino (partícula). Esto también equilibra la balanza. En otras palabras, la existencia de neutrinos y antineutrinos debería salvar no una, sino tres, importantes leyes de conservación: la conservación de la energía, la de conservación del espín y la de conservación de partícula/antipartícula.

Para un electrón, protón o neutron la cantidad de espín es siempre 1/2 del valor mínimo de momento permitido (ħ).

Es importante conservar esas leyes puesto que parece estar presentes en toda clase de reacciones nucleares que no impliquen electrones o positrones, y sería muy útil si también se hallasen presentes en reacciones que incluyesen esas partículas.

Las más importantes conversiones protón-neutrón son las relaciones con las reacciones nucleares que se desarrollan en el Sol y en los astros. Por consiguiente, las estrellas emiten radiaciones rápidas de neutrinos, y se calcula que tal vez pierdan a causa de esto el 6 u 8 % de su energía. Pero eso, sería meternos en otra historia y, por mi parte, con la anterior explicación solo trataba de dar una muestra del ingenio del hombre que, como habréis visto, no es poco.

Aunque sólo una cinco mil millonésima de la luz solar llega a la Tierra, ha sido suficiente para dar a esta calor y vida, así como bípedos bastante listos para calcular al detalle su deuda con el Sol que, si pusiera intereses, nunca podríamos pagar.

Desde que puedo recordar, he sido un amante de la Física. Me asombran cuestiones como la luz, su naturaleza de un conglomerado de colores, ondas y partículas, su velocidad que nos marca el límite máximo que se puede desplazar cualquier cosa en nuestro Universo, y en fin, muchos otros misterios que encierra esa maravilla cotidiana que nos rodea y lo inunda todo haciendo posible que podamos ver por donde vamos, que las plantas vivan y emitan oxígeno o que nos calentemos. Realmente, sin luz, nuestra vida no sería posible.

Me gustaría que alguien contestara: ¿Qué es realmente la luz?

Muchos (casi todos) opinan que es algo inmaterial. Los objetos materiales, grandes o muy pequeños como las galaxias o los electrones, son materia. La luz, sin embargo, se cree que es inmaterial, dos rayos de luz se cruzan sin afectarse el uno al otro. Sin embargo, yo que deberíamos profundizar un poco más y, sabiendo que la luz está formada por fiotones, que los fotones son energía, que la energía es un aspecto de la masa… ¿Qué es realmente la luz? Nosotros mismos, el última instancia ¿No serémos luz?

Está claro que los estudiosos de la época antigua y medieval estaban por completo a oscuras acerca de la naturaleza de la luz. Especulaban sobre que consistía en partículas emitidas por objetos relucientes o tal vez por el mismo ojo. Establecieron el hecho de que la luz viajaba en línea recta, que se reflejaba en un espejo con un ángulo igual a aquel con el que el rayo choca con el espejo, y que un rayo de luz se inclina (se refracta) cuando pasa del aire al cristal, al agua o a cualquier otra sustancia transparente.

Cuando la luz entra en un cristal, o en alguna sustancia transparente, de una forma oblicua (es decir, en un ángulo respecto de la vertical), siempre se refracta en una dirección que forma un ángulo menor respecto de la vertical. La exacta relación entre el ángulo original y el ángulo reflejado fue elaborada por primera vez en 1.621 por el físico neerlandés Willerbrord Snell. No publicó sus hallazgos y el filósofo francés René Descartes descubrió la ley, independientemente, en 1.637.

Los primeros experimentos importantes acerca de la naturaleza de la luz fueron llevados a cabo por Isaac Newton en 1.666, al permitir que un rayo de luz entrase en una habitación oscura a través de una grieta e las persianas, cayendo oblicuamente sobre una cara de un prisma de cristal triangular. El rayo se refracta cuando entra en el cristal y se refracta aún más en la misma dirección cuando sale por una segunda cara del prisma. (Las dos refracciones en la misma dirección se originan por que los dos lados del prisma de se encuentran en ángulo en vez de en forma paralela, como sería el caso en una lámina ordinaria de cristal.)

Newton atrapó el rayo emergente sobre una pantalla blanca para ver el efecto de la refracción reforzada. Descubrió que, en vez de formar una mancha de luz blanca, el rayo se extendía en una gama de colores: rojo, anaranjado, amarillo, verde, azul, y violeta, en este orden. Newton dedujo de ello que la luz blanca corriente era una mezcla de varias luces que excitaban por separado nuestros ojos para producir las diversas sensaciones de colores. La amplia banda de sus componentes se denominó spectrum (palabra latina que significa “espectro” fantasma).

Newton llegó a la conclusión de que la luz se componía de diminutas partículas (“corpúsculos”), que viajaban a enormes velocidades.

Le surgieron y se planteó algunas inquietantes cuestiones. ¿Por qué se refractaban las partículas de luz verde más que los de luz amarilla? ¿Cómo se explicaba que dos rayos de luz se cruzaran sin perturbase mutuamente, es decir, sin que se produjeran colisiones entre partículas?

En 1.678, el físico neerlandés christian Huyghens (un científico polifacético que había construido el primer reloj de péndulo y realizado importantes trabajos astronómicos) propuso una teoría opuesta: la de que la luz se componía de minúsculas ondas. Y si sus componentes fueran ondas, no sería difícil explicar los diversos difracciones de los diferentes tipos de luz a través de un medio refractante, siempre y cuando se aceptara que la luz se movía más despacio en ese medio refractante que en el aire. La cantidad de refracción variaría con la longitud de las ondas: cuanto más corta fuese tal longitud, tanto mayor sería la refracción. Ello significaba que la luz violeta (la más sensible a este fenómeno) debía de tener una longitud de onda mas corta que la luz azul, ésta, más corta que la verde, y así sucesivamente.

Se encuentra la galaxias más lejana nacida después del big bang

Gracias a las radiaciones electromagnéticas podemos ver el Universo como fue hace ahora miles de millones de años. Cuando la luz, nos trae la imágen de galaxias situadas a distancias inconmensurables. ¿Quién podría haber pensado, en el pasado, que tal cosa fuese posible? hace

Lo que permitía al ojo distinguir los colores eran esas diferencias entre longitudes de onda. Y, como es natural, si la luz estaba integrada por ondas, dos rayos podrían cruzarse sin dificultad alguna. (Las ondas sonoras y las del agua se cruzan continuamente sin perder sus respectivas identidades.)

Pero la teoría de Huyqhens sobre las ondas tampoco fue muy satisfactoria. No explicaba por qué se movían en línea recta los rayos luminosos; ni por qué proyectaban sobras recortadas; ni aclaraba por qué las ondas luminosas no podían rodear los obstáculos, del mismo modo que pueden hacerlo las ondas sonoras y las ondas marinas. Por añadidura, se objetaba que si la luz consistía en ondas, ¿cómo podía viajar por el vacío, ya que cruzaba el espacio desde el Sol y las Estrellas? ¿Cuál era esa mecánica ondulatoria?

Así que, la vieja idea de Newton de que la luz estaba formada por partículas, en contra de la teoría ondulatoria de su contemporáneo Huygens corroborada por posteriores experimentos en el siglo XIX y por la teoría electromagnética de Maxwell, volvía a ser vigente en parte. La radiación electromagnética estaba formada por paquetes de energía llamados fotones, tenía una doble naturaleza: ondulatoria y corpuscular. La doble naturaleza ondulatoria y corpuscular de la luz, hizo pensar al físico francés Louis de Broglie que el resto de partículas podían disfrutar de esa cualidad y estableció que cualquier partícula lleva asociada una onda de longitud igual al cuanto de acción (h) dividido por su masa y por su velocidad (cualquier objeto macroscópico también tiene su onda asociada, pero debido al valor tan pequeño del cuanto de acción su efecto es despreciable). De hecho, cuando se diseña un experimento, dependiendo de las restricciones que se impongan a la partícula se pone de manifiesto su naturaleza ondulatoria o corpuscular pero, esa es, otra historia.

emilio silvera

Sep

14

La fascinación de los minúsculos objetos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (4)

Comments (4)

El Universo de las partículas es fascinante. Cuando las partículas primarias chocan con átomos y moléculas en el aire, aplastan sus núcleos y producen toda clase de partículas secundaria. En esta radiación secundaria (aún muy energética) la que detectamos cerca de la Tierra, por los globos enviados a la atmósfera superior han registrado la radiación primaria.

El físico estadounidense Robert Andrews Millikan, que recogió una gran cantidad de información acerca de esta radiación (y que le dio el nombre de rayos cósmicos), decidió que debería haber una clase de radiación electromagnética. Su poder de penetración era tal que, parte del mismo, atravesaba muchos centímetros de plomo. Para Millikan, esto sugería que la radiación se parecía a la de los penetrantes rayos gamma, pero con la longitud de onda más corta.

Otros, sobre todo el físico norteamericano Holly Compton, no estaban de acuerdo en que los rayos cósmicos fuesen partículas. Había un medio para investigar este asunto. Si se trataba de partículas cargadas, deberían ser rechazadas por el campo magnético de la Tierra al aproximarse a nuestro planeta desde el espacio exterior. Compton estudió las mediciones de la radiación cósmica en varias latitudes y descubrió que en realidad se curvaban con el campo magnético: era más débil cerca del ecuador magnético y más fuerte cerca de los polos, donde las líneas de fuerza magnética se hundían más en la Tierra.

Las partículas cósmicas primarias, cuando entran en nuestra atmósfera llevan consigo unas energías fantásticas, muy elevadas. En general, cuanto más pesado es el núcleo, más raro resulta entre las partículas cósmicas. Núcleos tan complejos como los que forman los átomos de hierro se detectaron con rapidez, en 1968, otros núcleos tan complejos como los del uranio. Los núcleos de uranio constituyen sólo una partícula entre 10 millones. También se incluirán aquí electrones de muy elevada energía.

Ahora bien, la siguiente partícula inédita –después del neutrón- se descubrió en los rayos cósmicos. A decir verdad, cierto físico teórico había predicho ya este descubrimiento.

Paul Adrien Maurice Dirac había aducido, fundándose en un análisis matemático de las propiedades inherentes a las partículas subatómicas, que cada partícula debería tener su “antipartícula”. (Los científicos desean no sólo que la Naturaleza sea simple, sino también simétrica.) Así pues, debería haber un “antielectron”, salvo por su carga, que sería positiva, y no negativa, idéntico al electrón, y un “antiprotón” con carga negativa en vez de positiva.

Sep

12

Dos verdades incompatibles

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

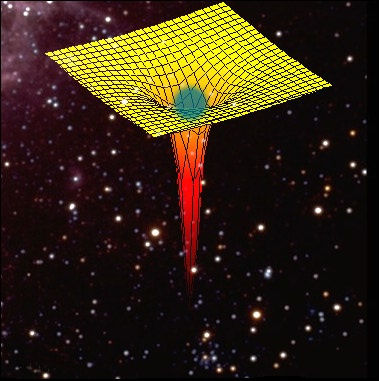

El “universo” de lo muy pequeño y el de lo muy grande… ¡Parecen incompatibles y, sin embargo…

El mundo de la Física tiene planteado un gran problema y los físicos son muy conscientes de ello, conocen su existencia desde hace décadas. El problema es el siguiente:

Existen dos pilares fundamentales en los cuales se apoya toda la física moderna. Uno es la relatividad general de Albert Einstein, que nos proporciona el marco teórico para la comprensión del universo a una escala máxima: estrellas, galaxias, cúmulos (o clusters) de galaxias, y aún más allá, hasta la inmensa expansión del propio universo.

El otro pilar es la mecánica cuántica, que en un primer momento vislumbro Max Planck y posteriormente fue desarrollada por W. Heisemberg, Schrödinger, el mismo Einstein, Dirac, Niels Bohr y otros, que nos ofrece un marco teórico para comprender el universo en su escala mínima: moléculas, átomos, y así hasta las partículas subatómicas, como los electrones y quarks.

Durante años de investigación, los físicos han confirmado experimentalmente, con una exactitud casi inimaginable, la practica totalidad de las predicciones que hacen las dos teorías. Sin embargo, estos mismos instrumentos teóricos nos llevan a una conclusión inquietante: tal como se formulan actualmente, la relatividad general y la mecánica cuántica no pueden ser ambas ciertas a la vez.

Nos encontramos con que las dos teorías en las que se basan los enormes avances realizados por la física durante el último siglo (avances que han explicado la expansión de los cielos y la estructura fundamental de la materia) son mutuamente incompatibles. Cuando se juntan ambas teorías, aunque la formulación propuesta parezca lógica, aquello explota; la respuesta es un sinsentido que nos arroja un sin fin de infinitos a la cara.

Así que si tú, lector, no has oído nunca previamente hablar de este feroz antagonismo, te puedes preguntar a que será debido. No es tan difícil encontrar la respuesta. Salvo en algunos casos muy especiales, los físicos estudian cosas que son o bien pequeñas y ligeras (como los átomos y sus partes constituyentes), o cosas que son enormes y pesadas (como estrellas de neutrones y agujeros negros), pero no ambas al mismo tiempo. Esto significa que sólo necesitan utilizar la mecánica cuántica, o la relatividad general, y pueden minimizar el problema que se crea cuando las acercan demasiado; las dos teorías no pueden estar juntas. Durante más de medio siglo, este planteamiento no ha sido tan feliz como la ignorancia, pero ha estado muy cerca de serlo.

No obstante, el universo puede ser un caso extremo. En las profundidades centrales de un agujero negro se aplasta una descomunal masa hasta reducirse a un tamaño minúsculo. En el momento del Bing Bang, la totalidad del universo salió de la explosión de una bolita microscópica cuyo tamaño hace que un grano de arena parezca gigantesco. Estos contextos son diminutos y, sin embargo, tienen una masa increíblemente grande, por lo que necesitan basarse tanto en la mecánica cuántica como en la relatividad general.

Por ciertas razones, las fórmulas de la relatividad general y las de la mecánica cuántica, cuando se combinan, empiezan a agitarse, a traquetear y a tener escapes de vapor como el motor de un viejo automóvil. O dicho de manera menos figurativa, hay en la física preguntas muy bien planteadas que ocasionan esas respuestas sin sentido, a que me referí antes, a partir de la desafortunada amalgama de las ecuaciones de las dos teorías.

Aunque se desee mantener el profundo interior de un agujero negro y el surgimiento inicial del universo envueltos en el misterio, no se puede evitar sentir que la hostilidad entre la mecánica cuántica y la relatividad general está clamando por un nivel más profundo de comprensión.

¿Puede ser creíble que para conocer el universo en su conjunto tengamos que dividirlo en dos y conocer cada parte por separado? Las cosas grandes una ley, las cosas pequeñas otra.

No creo que eso pueda ser así. Mi opinión es que aún no hemos encontrado la llave que abre la puerta de una teoría cuántica de la gravedad, es decir, una teoría que unifique de una vez por todas las dos teorías más importantes de la física: mecánica cuántica + relatividad general.

La teoría de supercuerdas ha venido a darme la razón. Los intensos trabajos de investigación llevada a cabo durante los últimos 20 años demuestran que puede ser posible la unificación de las dos teorías cuántica y relativista a través de nuevas y profundas matemáticas topológicas que han tomado la dirección de nuevos planteamientos más avanzados y modernos, que pueden explicar la materia en su nivel básico para resolver la tensión existente entre las dos teorías.

En esta nueva teoría de supercuerdas se trabaja en 10, 11 ó en 26 dimensiones, se amplía el espacio ahora muy reducido y se consigue con ello, no sólo el hecho de que la mecánica cuántica y la relatividad general no se rechacen, sino que por el contrario, se necesitan la una a la otra para que esta nueva teoría tenga sentido. Según la teoría de supercuerdas, el matrimonio de las leyes de lo muy grande y las leyes de lo muy pequeño no sólo es feliz, sino inevitable.

Esto es sólo una parte de las buenas noticias, porque además, la teoría de las supercuerdas (abreviando teoría de cuerdas) hace que esta unión avance dando un paso de gigante. Durante 30 años, Einstein se dedicó por entero a buscar esta teoría de unificación de las dos teorías, no lo consiguió y murió en el empeño; la explicación de su fracaso reside en que en aquel tiempo, las matemáticas de la teoría de supercuerdas eran aún desconocidas. Sin embargo, hay una curiosa coincidencia en todo esto, me explico:

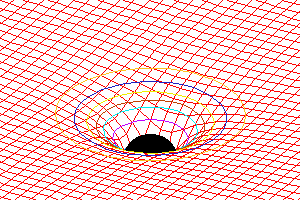

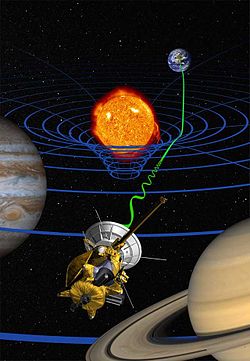

Tensor de curvatura de Einstein: ecuación

Representación de la curvatura dada por la ecuación de campo de Einstein sobre el plano de la eclíptica de una estrella esférica: Dicha ecuación relaciona la presencia de materia con la curvatura adquirida por el espacio-tiempo

Cuando los físicos trabajan con las matemáticas de la nueva teoría de supercuerdas, Einstein, sin que nadie le llame, allí aparece y se hace presente por medio de las ecuaciones de campo de la relatividad general que, como por arte de magia, surgen de la nada y se hacen presentes en la nueva teoría que todo lo unifica y también todo lo explica; posee el poder demostrar que todos los sorprendentes sucesos que se producen en nuestro universo (desde la frenética danza de una partícula subatómica que se llama quark hasta el majestuoso baile de las galaxias o de las estrellas binarias bailando un valls, la bola de fuego del Big Bang y los agujeros negros) todo está comprendido dentro de un gran principio físico en una ecuación magistral.

Esta nueva teoría requiere conceptos nuevos y matemáticas muy avanzados y nos exige cambiar nuestra manera actual de entender el espacio, el tiempo y la materia. Llevará cierto tiempo adaptarse a ella hasta instalarnos en un nivel en el que resulte cómodo su manejo y su entendimiento. No obstante, vista en su propio contexto, la teoría de cuerdas emerge como un producto impresionante pero natural, a partir de los descubrimientos revolucionarios que se han realizado en la física del último siglo. De hecho, gracias a esta nueva y magnifica teoría, veremos que el conflicto a que antes me refería existente entre la mecánica cuántica y la relatividad general no es realmente el primero, sino el tercero de una serie de conflictos decisivos con los que se tuvieron que enfrentar los científicos durante el siglo pasado, y que fueron resueltos como consecuencia de una revisión radical de nuestra manera de entender el universo.

El primero de estos conceptos conflictivos, que ya se había detectado nada menos que a finales del siglo XIX, está referido a las desconcertantes propiedades del movimiento de la luz.

Isaac Newton y sus leyes del movimiento nos decía que si alguien pudiera correr a una velocidad suficientemente rápida podría emparejarse con un rayo de luz que se esté emitiendo, y las leyes del electromagnetismo de Maxwell decían que esto era totalmente imposible. Einstein, en 1.905, vino a solucionar el problema con su teoría de la relatividad especial y a partir de ahí le dio un vuelco completo a nuestro modo de entender el espacio y el tiempo que, según esta teoría, no se pueden considerar separadamente y como conceptos fijos e inamovibles para todos, sino que por el contrario, el espacio-tiempo era una estructura maleable cuya forma y modo de presentarse dependían del estado de movimiento del observador que lo esté midiendo.

El escenario creado por el desarrollo de la relatividad especial construyó inmediatamente el escenario para el segundo conflicto. Una de las conclusiones de Einstein es que ningún objeto (de hecho, ninguna influencia o perturbación de ninguna clase) puede viajar a una velocidad superior a la de la luz. Einstein amplió su teoría en 1915 – relatividad general – y perfeccionó la teoría de la gravitación de Newton, ofreciendo un nuevo concepto de la gravedad que estaba producida por la presencia de grandes masas, tales como planetas o estrellas, que curvaban el espacio y distorsionaban el tiempo.

Tales distorsiones en la estructura del espacio y el tiempo transmiten la fuerza de la gravedad de un lugar a otro. La luna no se escapa y se mantiene ahí, a 400.000 Km de distancia de la Tierra, porque está influenciada por la fuerza de gravedad que ambos objetos crean y los mantiene unidos por esa cuerda invisible que tira de la una hacia la otra y viceversa. Igualmente ocurre con el Sol y la Tierra que, separados por 150 millones de kilómetros, están influidos por esa fuerza gravitatoria que hace girar a la Tierra (y a los demás planetas del Sistema Solar) alrededor del Sol.

Así las cosas, no podemos ya pensar que el espacio y el tiempo sean un telón de fondo inerte en el que se desarrollan los sucesos del universo, al contrario; según la relatividad especial y la relatividad general, son actores que desempeñan un papel íntimamente ligado al desarrollo de los sucesos.

El descubrimiento de la relatividad general, aunque resuelve un conflicto, nos lleva a otro. Durante tres décadas desde 1.900, en que Max Planck publicó su trabajo sobre la absorción o emisión de energía de manera discontinua y mediante paquetes discretos a los que él llamo cuantos, los físicos desarrollaron la mecánica cuántica en respuesta a varios problemas evidentes que se pusieron de manifiesto cuando los conceptos de la física del siglo XIX se aplicaron al mundo microscópico. Así que el tercer conflicto estaba servido, la incompatibilidad manifiesta entre relatividad general y mecánica cuántica.

La forma geométrica ligeramente curvada del espacio que aparece a partir de la relatividad general, es incompatible con el comportamiento microscópico irritante y frenético del universo que se deduce de la mecánica cuántica, lo cual era sin duda alguna el problema central de la física moderna.

Las dos grandes teorías de la física, la relatividad general y la mecánica cuántica, infalibles y perfectas por separado, no funcionaban cuando tratábamos de unirlas resulta algo incomprensible, y, de todo ello podemos deducir que, el problema radica en que debemos saber como desarrolar nuevas teorías que modernicen a las ya existentes que, siendo buenas herramientas, también nos resultan incompletas para lo que, en realidad, necesitamos.

emilio silvera

Sep

11

El “universo” de lo muy pequeño. ¡Resulta fasciante!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (5)

Comments (5)

¿Os acordais? ¿Cuántos niños no habrán soñado con escenas como estas?

Cuando hablo de lo muy pequeño, puedo llegar a entender muy bien lo que es, lo que son, “licencias literarias” el papel de nada se queja y el lápiz puede escribir lo que quiera y pience el que lo sostiene, según le dicte su imaginación. Claro que, cuando comparamos ese mundo de ilusiones e imaginación y lo comparamos con el mundo real, todo el edificio se viene abajo. ¡Lástima!

Todos los niños pequños juegan con pequeños muñecos que son soldados, guerreros o seres de otras galaxias con poderes mágicos y,ellos, en su inocente mundo sin maldad, los dirigen con sus manitas gordezuelas al desarrollo de luchas y aventuras sin fin. Jonathan Swift, nos deleitó con aquellas aventuras de Gulliver, un aventurero que llegó a las tierras de Lilliput: Allí, todo era muy pequeño, la naturaleza, las plantas, los habitantes del lugar y sus casas y palacios, embarcaciones y todos los animales.

Gulliver era allí un gigante de proporciones inmensas: Incluso llegó a extinguir un fuego con una simple chorrada (es decir, hizo pipí) y acabço de inmediato con el (para ellos) enorme fuego.

Su tamaño podía, sin dificultad alguna, decidir el resultado de una guerra entre aquellos pequeñísimos seres que, ante un gigante como él, no tenían defensa alguna y, sus armas, resultaban ridículas para poder causarle algún daño. Dormido lo tucieron que coger para poder atarlo.

Durante otro viaje, las fuerzas ignotas del destino llevaron a Gulliver a un pais llamado Brobdingnag, donde la gente y todos los seres animados e inanimados eran mucho más grandes que él. Allí era un enano, mimado por una niña pequeña llamada Glumdalclitch. Al final, Gulliver es recogido en una jaula por un águila que lo deja caer en el mar de donde lo rescataron unos marineros a los que, al contarles esas historias, pusieron incrédulas caras de asombro.

Claro que, cuando nos trasladamos al mundo real, las cosas no suelen ser de esa manera. Poco importa lo fascinantes que las historias de este tipo nos puedan resultar. Las cosas no funcionan de esa manera. Todos sabemos, por ejemplo que la llama de una vela pequeña y la de una vela grande, son aproximadamente del mismo tamaño. ¿De qué tamaño serían las llamas de las velas de Lilliput? Y, desde luego, si pensamos un poco, más cuestiones nos surgen: ¿Cómo serían las gotas de lluvia en Lilliput y en Brobdingnag?, ¿eran las leyes físicas para el agua diferentes allí que en nuestro propio mundo? Y, finalmente, los físicos se preguntarían: ¿De qué tamaño eran los átomos en esos lugares?, ¿qué clase de reacciones químicas podrían tener lugar con los átomos del cuerpo de Gulliver?

Claro que, con esas preguntas esas historias fallan. La verdadera razón por la que los mundos de Los Viajes de Gulliver no pueden existir es que las leyes de la Naturaleza no permanecen exactamente iguales cuando se cambian las escalas. A veces, esto es evidente en las películas de desastres, donde quizá se ha construído una maqueta a escala para simular una gran ola o un rascacielos en llamas.

El ojo experto puede, sin problemas, distinguir entre la maqueta y la realidad. Los mejores resultados se obtienen cuando el factor de esacala para el tiempo se elige igual a la raíz cuadrada de la escala espacial. Así, si el rascacielos de turno se construye a escala 1:9, hay que rodar la película a un 1/3 de su velocidad real. Pero incluso así, como antes señalo, el ojo entrenado distingue la diferencia entre lo que sucede en la película y lo que se observaría en el mundo real.

En resumen, las leyes que gobiernan el mundo físico tienen dos características importantes: muchas leyes de la naturaleza permanecen inalterables, no se alteran cuando cambia la escala, pero hay otros fenómenos, tales como una vela encendida o las gotas de agua, que no cambian del mismo modo. La implicación final es que el mundo de los objetos muy pequeños será completamente diferente del mundo ordinario.

Justamente en el mundo de los seres vivos la escala crea importantes diferencias. En muchos aspectos, la anatomía de un ratón se podría consuiderar (más o menos y, guardando las distancias) como una copia de la de un elefante, pero mientras que un ratón puede trepar por una pared de piedra prácticamente vertical sin mucha dificultad (incluso se puede caer desde una altura varias veces mayor que su tamaño sin hacerse gran daño), un elefante sería incapaz de realizar tal hazaña. Así llegamosm a comprender que la Gravedad, se deja sentir en menor grado a medida que los objetos disminuyen de tamaño.

Cuando llegamos a los seres unicelulares, se ve que para ellos no hay distinción entre arriba y abajo. Para ellos, la tensión superficial del agua es mucho más importante que la fuerza de gravedad. Basta observar que la tensión superficial es la fuerza que da forma a una gota de agua y comparar el tamaño de esa gota con los seres unicelulares, muchísimo menores, para que sea evidente que la tensión superficial es muy importante a esta escala.

La tensión superficial es una consecuencia de que todas las moléculas y los átomos se atraen unos a otros con una fuerza que nosotros llamamos fuerza de Van der Vaalls. esta fuerza tiene un alcance muy corto. para ser más precisos, diremos que la intensidad de esta fuerza a una distancia r es aproximadamente proporcional a 1/r7. Esto significa que si se reduce la distancia entre dos átomos a la mitad, la fuerza de Van der Vaalls con la que se atraen uno a otro se hace 2 x 2 x 2 x 2 x 2 x 2 x 2 = 128 veces más intensa. Cuando los átomos y las moléculas se acercan mucho unos a otros quedan unidos muy fuertemente a través de esta fuerza.

Ahora tendríamos que hablar algo de la mecánica cuántica y, en ese ámbito, las reglas de la mecánica cuántica funcionan tan bien que resultaría realmente difícil refutarlas.

Acordaos de los trucos ingeniosos descubiertos por Werner Hesinberg, Paul Dirac, o, Schrödinger que vinieron a mejorar y completar las reglas generales. Sin embargo, algunos de aquellos pioneros (Einstein y el mismo Schrödinger), sin embargo, presentaron serias objeciones a dicha interpretación de la naturaleza de lo muy pequeño.

Podríamos formular una simple pregunta que pondría en un brete a más de uno: ¿Dónde está realmente el electrón, en el punto x o en el punto y? En pocas palabras, ¿dónde está en realidad? Si prestamos ate4nción a Bohr, no tiene ningún sentido buscar tal realidad. Las reglas de la mecánica cuántica, por sí mismas, y las observaciones realizadas con detectores serían las únicas realidades a las que deberíamos prestar atención y de las que podemos hablar.

Muchas veces me sorprende oír a muchos “científicos” que hablan con una seguridad de lo que dicen como si, de una verdad inamovible se tratara. Ellos (en realidad) creen que saben y, no llegan a darse cuenta de que están hablando de un Modelo que ha sido construído matemáticamente hablando, para poder explicar eso que, nosotros, los humanos, creemos que es la realidad del mundo. Sin embargo, más de una vez hemos tenido que cambiar esos modelos y rectificar esa “realidad” por otra que, resultó ser “más real”.

¡Sabemos tan poco

emilio silvera

Sep

10

De cómo llegamos hasta los Quarks

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (5)

Comments (5)

Ahora todos hablamos del LHC. Sin embargo, la historia de los aceleradores no comenzó con éste moderno y complejo conglomerado de sofisticadas estructuras que hacen posible que visitemos lugares muy lejanos en el corazón de la materia. Tendríamos que recordar al acelerador lineal también llamado LINAC (linear accelerator) es un tipo de acelerador que le proporciona a la partícula subatómica cargada pequeños incrementos de energía cuando pasa a través de una secuencia de campos eléctricos alternos.

Mientras que el generador de Van de Graaff proporciona energía a la partícula en una sola etapa, el acelerador lineal y el ciclotrón proporcionan energía a la partícula en pequeñas cantidades que se van sumando. El acelerador lineal, fue propuesto en 1924 por el físico sueco Gustaf Ising. El ingeniero noruego Rolf Wideröe construyó la primera máquina de esta clase, que aceleraba iones de potasio hasta una energía de 50.000 eV.

Durante la Segunda Guerra Mundial se construyeron potentes osciladores de radio frecuencia, necesarios para los radares de la época. Después se usaron para crear aceleradores lineales para protones que trabajaban a una frecuencia de 200 MHz, mientras que los aceleradores de electrones trabajan a una frecuencia de 3000 MHz.

El acelerador lineal de protones diseñado por el físico Luis Alvarez en 1946, tenía 875 m de largo y aceleraba protones hasta alcanzar una energía de 800 MeV (800 millones). El acelerador lineal de la universidad de Stanford es el más largo entre los aceleradores de electrones, mide 3.2 km de longitud y proporciona una energía de 50 GeV (50 billones). En la industria y en la medicina se usan pequeños aceleradores lineales, bien sea de protones o de electrones.

El SLAC, ubicado al sur de San Francisco, acelera electrones y positrones a lo largo de algo más de tres kilómetros hacia varios blancos, anillos y detectores ubicados en su finalización. Este acelerador hace colisionar electrones y positrones, estudiando las partículas resultantes de estas colisiones. Construido originalmente en 1962, se ha ido ampliando y mejorando para seguir siendo uno de los centros de investigación de física de partículas mas avanzados del mundo. El centro ha ganado el premio nobel en tres ocasiones. Y, una vez recordada de manera breve la historia, pasaremos directamente al tema que en realidad nos ha tríado aquí: ¡El descubrimiento de los Quarks!

Ahora los medios con los que cuentan los físicos del LHC son inmensamente más eficaces y están más adelantados que aquellos viejos aceleradores que, sin embargo, fueron los pioneros y los que hicieron posible adquirir conocimientos que nos han traído hasta el moderno LHC.

En 1967 se emprendió una serie de experimentos de dispersión mediante los nuevos haces de electrones del SLAC. El objetivo era estudiar más incisivamente la estructura del protón. Entra el electrón de gran energía, golpea un protón en un blanco de hidrógeno y sale un electrón de energía mucho menor, pero en una dirección que forma un ángulo grande con respecto a su camino original. La estructura puntual dentro del protón actúa, en cierto sentido, como el núcleo con las partículas alfa de Rutherford. Pero el problema era aquí más sutíl.

Richard Edward Taylor

“Richard Edward Taylor fue uno de los veintidós científicos que trabajó intensamente en el acelerador lineal de Stanford (SLAC), en una serie de pruebas experimentales que vinieron a demostrar que los protones y los neutrones son poseedores de una estructura interna, lo que a su vez confirma las predicciones teóricas del neoyorquino Murray Gell-Mann (1929- ), acerca de la existencia de los denominados quarks.

Junto con sus colegas de Stanford junto con Jerome I. Friedman y Henry W. Kendall -con los que luego habría de compartir el Nobel-, Taylor investigó sobre la estructura interna de la materia, en su mínima expresión, para lo que partió del modelo teórico de los quarks, postulado por Gell-Mann y -de forma independiente- G. Zweig. Tras sus descubrimientos experimentales en el acelerado lineal de Stanford, Taylor perfeccionó dicho modelo añadiéndole la existencia de unas subpartículas desconocidas hasta entonces, que luego fueron denominadas leptones; además, introdujo en el modelo teórico de Gell-Mann otras partículas no estructurales, sino de intercambio de fuerza, a las que en Stanford comenzaron a llamar bosones.”

Richard Feynman

Los dos últimos párrafos los he tomado prestados de www.mcnbiografias.com., que es lo que se explica de este tema en casi todas partes. Sin embargo, pocos cuentan que, el equipo de Stanford, dirigido por el físico del SLAC por Richard Taylor y los otros dos físicos del MIT, Jerome Friedman y Henry Kendall, tuvieron la gran suerte de que, Richard Feynman y James Bjorken, metieran sus narices en el proyecto llevados por la curiosidad y como habían prestado su energía y su imaginación a las interacciones fuertes y se preguntaban: ¿que habrá dentro del protón?

Amnos, Feynman y Bjorken visitaban con frecuencia Stanford desde su base en el Cal Tech, en Pasadena. Bjorken, teórico de Stanford, estaba muy interesado en el proyecto experimental y en las reglas que regían unos datos aparentemente incompletos. Estas reglas, razonaba Bjorken, serían indicadoras de las leyes básicas (dentro de la “caja negra”) que controlaba la estructura de los hadrones.

No estaría mal echar una mirada hacia atrás en el tiempo y recordar, en este momento, a Demócrito que, con sus postulados, de alguna manera venía a echar un poco de luz sobre el asunto, dado que él decía que para determinar si algo era un á-tomo habría que ver si era indivisible. En el modelo de los quarks, el protón, en realidad, un conglomerado pegajoso de tres quarks que se mueven rápidamente. Pero como esos quarks están siempre ineludiblemente encadenados los unos a los otros, experimentalmente el protón aparece indivisible.

Acordémonos aquí de que Boscovich decía que, una partícula elemental, o un “á-tomo”, tiene que ser puntual. Y, desde luego, esa prueba, no la pasaba el protón. El equipo del MIT y el SLAC, con la asesoría de Feynman y Bjorken, cayó en la cuenta de que en este caso el criterio operativo era el de los “puntos” y no el de la indivisibilidad. La traducción de sus datos a un modelo de constituyentes puntuales requería una sutileza mucho mayor que el experimento de Rutherford.

Precisamente por eso era tan conveniente fue tan conveniente para Richard Edward Taylor y su equipo, tener a dos de los mejores teóricos del mundo en el equipo aportando su ingenio, agudeza e intuición en todas las fases del proceso experimental. El resultado fue que los datos indicaron, efectivamente, la presencia de objetos puntuales en movimiento dentro del protón.

En 1990 Taylor, Friedman y Kendall recogieron su premio Nobel por haber establecido la realidad de los quarks. Sin embargo, a mí lo que siempre me ha llamado más la atención es el hecho cierto de que, este descubrimiento como otros muchos (el caso del positrón de Dirac, por ejemplo), han sido posible gracias al ingenio de los teóricos que han sabido vislumbrar cómo era en realidad la Naturaleza.

A todo esto, una buena pregunta sería: ¿cómo pudieron ver este tipo de partículas de tamaño infinitesimal, si los quarks no están libres y están confinados -en este caso- dentro del protón? Hoy, la respuesta tiene poco misterio sabiendo lo que sabemos y hasta donde hemos llegado con el LHC que, con sus inmensas energías “desmenuza” un protón hasta dejar desnudos sus más íntimos secretos.

Este es, el resultado ahora de la colisión de protones en el LHC

Lo cierto es que, en su momento, la teoría de los Quarks hizo muchos conversos, especialmente a medida que los teóricos que escrutaban los datos fueron imbuyendo a los quarks una realidad creciente, conociendo mejor sus propiedades y convirtiendo la incapacidad de ver quarks libres en una virtud. La palabra de moda en aquellos momentos era “confinamiento”. Los Quarks están confinados permanentemente porque la energía requerida para separarlos aumenta a medida que la distancia entre ellos crece. Esa es, la fuerza nuclear fuerte que está presente dentro del átomo y que se encarga de transmitir los ocho Gluones que mantienen confinados a los Quarks.

Así, cuando el intento de separar a los Quarks es demasiado intenso, la energía se vuelve lo bastante grande para crear un par de quark-anti-quark, y ya tenemos cuatro quarks, o dos mesones. Es como intentar conseguir un cabo de cuerda. Se corta y… ¡ya tenemos dos!

¿Cuerdas? Me parece que estoy confundiendo el principal objetivo de este trabajo y, me quiero situar en el tiempo futuro que va, desde los quarks de Gell-Mann hasta las cuerdas de Veneziano y John Schwarz y más tarde Witten. Esto de la Física, a veces te juega malas pasadas y sus complejos caminos te llevan a confundir conceptos y momentos que, en realidad, y de manera individualizada, todos han tenido su propio tiempo y lugar.

¿Cuántas veces no habré pensado, en la posibilidad de tomar el elixir de la sabiduría para poder comprenderlo todo? Sin embargo, esa pósima mágica no existe y, si queremos saber, el único camino que tenemos a nuestro alcance es la observación, el estudio, el experimento… ¡La Ciencia!, que en definitiva, es la única que nos dirácomo es, y como se comporta la Naturaleza y, si de camino podemos llegar a saber, por qué lo hace así…¡mucho mejor!

emilio silvera

Totales: 83.811.058

Totales: 83.811.058 Conectados: 66

Conectados: 66