Aprecien como se forma la red de fibras que hace posible la cicatrización de una herida.

IMPRESIÓN NO PERMITIDA - TEXTO SUJETO A DERECHOS DE AUTOR

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

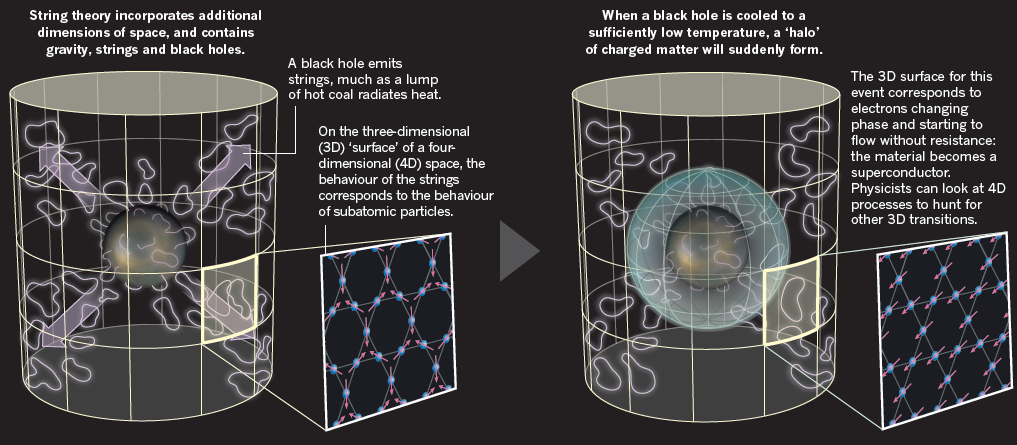

¿Queremos imitar el salto cuántico y viajar más rápido sin tener recorrer el espacio que separan el punto de partida y el de llegada?

A finales del siglo XIX y principios del XX algunos podían creer que los secretos de la Naturaleza estaban todos descubiertos gracias a los hallazgos que en el pasado hicieran Newton y otros y más recientemente Maxwell, Planck, Einstein y otros muchos que, con sus trabajos nos desvelaron cómo funcionaba la gravedad, qué era en realidad la electricidad y el magnetismo y también, nos llevaron el fascinante mundo de lo muy pequeño con el cuanto de acción, h, de Planck que nos trajo poco más tarde, la mecánica cuántica.

La mecánica, la óptica, la electricidad… todo estaba descubierto y explicado. Los científicos de la época pansaban que sus futuros colegas sólo se dedicarían a realizar medidas para obtener las constantes con mayor precisión vez. Después de todo aquello, se siguió avanzando y continuamos haciéndonos preguntas creyendo que nos llevarían a las respuestas últimas.

Si, por ejemplo, las supercuerdas nos conducen a las respuestas últimas, entonces, ¿en qué dirección debemos nuestra investigación?, ¿es que nos hemos introducido tanto en el mundo de lo desconocido y lo ininteligible que estamos a punto de ahogarnos en un mar de lo absurdo?, ¿estamos enterrados bajo tántas preguntas de los imposibles que deberíamos considerarnos perdidos?, ¿tiene algún sentido especular acerca de la “Teoria de Todo” en un mundo extraño de las unidades de Planck?

Bueno, si queremos ser sinceros…, podemos discrepar de algunas de las cuestiones que hoy se están debatiendo y ser críticos con otras. Sin embargo, no podremos negar los avances que realmente se están logrando en el mundo de las nuevas tecnologías que, gracias a la Física, ya están en el futuro y, en nuestras vidas cotidianas lo estamos viendo continuamente.

Por otra , nada despierta más nuestra curiosidad que lo ininteligible y, precisamente por eso, tiene tanto éxito y llama la atención teorías como la de las supercuerdas. Miremos, por ejemplo, lo que es tan curioso en el mundo de la longitud de Planck es que no podemos encontrar absolutamente ningún modelo que nos pueda dar una descripción razonablemente autoconsistente de partículas que interaccionan entre sí con fuerzas gravitatorias tan intensas y que, al mismo tiempo, obedezcan a las leyes de la mecánica cuántica. Por tanto, incluso si hubiéramos sido capaces de realizar experimentos con choques de partículas con energías planckianas, no hubiéramos sabido como comparar los resultados con una teoría. Aquí hay para los físicos: hacer una teoría. No nos importa demasiado como describa esa teoría la interacción gravitatoria, pero tenemos suficientes requisitos en la lista como para que encontrar esa candidata a ser la teoría sea una labor extremadamente difícil. La Teoría de Supercuerdas parecía estar a punto de conseguirlo, pero falló en los últimos momentos. Dicen que necesitamos la energía de Planck para poder verificarla y, si es así, nos queda espera para rato.

Mientras buscamos esas teorías que están más allá de nuestras posibilidades reales de hoy, la Ciencia no se para y sigue avanzando en otros muchos campos que, como antes decía, nos están llevando a pasos agigantados un futuro que ya está con nosotros y, lo está haciendo con tal rapidez que ni nos hemos percatado de ello.

En cuanto a esa soñada Teoria de Todo, en primer lugar debe ser matemáticamente exacta y tiene que permitirnos calcular con extrema precisión el comportamiento de las partículas bajo todas las circunstancias imaginables. Por ahí circulan una y mil “teorías” que exponen las ideas más variopintas que imaginarnos podamos pero, desgraciadamente, son inútiles para los físicos porque sus descripciones no reúnen el rigor ni la prcisión que deben estar presentes en toda buena teoría. Por otra , los físicos prefieren que la teoría trate la fuerza gravitatoria de tal manera que esté de acuerdo con la obtenida en la formulación de la teoría de la relatividad general de Einstein. Sabemos que la fuerza gravitatoria cuerpos pesados como las estrellas y los planetas obedece a esta teoría con gran exactitud (como ha sido confirmado espectacularmente en las observaciones de los púlsares, estrellas compactas que rotan a gran velocidad. Nuestra teoría candidata debería explicar estas observaciones).

No digamos de los intrincados caminos que la Física ha sobrevolado cuando se ha querido meter en la posibilidad de viajes en el Tiempo y, los físicos se encontraron con una y mil paradojas extrañas. Además, como nos ocurre con la Teoría de cuerdas, al meternos en un sendero desconocido y de intrincados peligros…nunca hemos podido llegar al final después de largos y costosos recorridos. ¿Servirá para algo los muchos esfuerzos realizados?

Por otra somos conscientes y conocedores de que las leyes de la mecánica cuántica son inexorables y, por tanto, queremos que nuestra teoría sea formulada en términos de la mecánica cuántica. Tanto la mecánica cuántica como la teoría de la relatividad tienen la propiedad de que, tan pronto como uno admita la más pequeña desviación de esos principios, ambas darían lugar a una teoría totalmente diferente, que de ninguna manera se parecería al mundo que conocemos (o pensamos conocer). “Un poco relativista” o “un poco mecanicuántico” tan poco sentido como “un poco embarazado”. Podríamos imaginar, por otra parte, que la mecánica cuántica o la relatividad general, o ambas, serían marcos demasiado restrictivos nuestra avanzada teoría, de manera que habría que extender sus principios, llegar más lejos.

La cuerda es cuántica y gravitatoria, de sus entrañas surge, por arte de magia, la partícula mensajera de la fuerza de gravedad: el gravitón. Funde de natural las dos teorías físicas más poderosas de que disponemos, la mecánica cuántica y la relatividad general, y se convierte en supercuerda -con mayores grados de libertad- es capaz de describir bosones y fermiones, partículas de fuerza y de materia. La simple vibración de una cuerda infinitesimal podría unificar todas la fuerzas y partículas fundamentales.

Parece que todo está hecho de cuerdas, incluso el espacio y el tiempo podrían emerger de las relaciones, más o menas complejas, cuerdas vibrantes. La materia-materia, que tocamos y nos parece tan sólida y compacta, ya sabíamos que está casi vacía, pero no imaginábamos que era tan sutil como una cuerda de energía vibrando. Los átomos, las galaxias, los agujeros negros, todo son marañas de cuerdas y supercuerdas vibrando en diez u once dimensiones espaciotemporales.

Está claro que no trato de explicar aquí una teoría que no comprendo y, el tratar el tema se debe a la curiosidad de tratar de indicar el camino, o, los caminos, por los que se podría llegar más lejos, al , algo más allá. De una cosa si que estoy seguro: ¡Las cuatro fuerzas fundamentales del Universo, un día fueron una sola fuerza!

En el universo existen numerosas estrellas cuyas masas son considerablemente mayores que las del Sol, debido a lo cual, la fuerza gravitotoria en su superficie es considerablemente más intensa que sobre la Tierra o sobre el Sol. La enorme cantidad de materia de una de esas estrellas causa una presión inimaginablemente alta en su interior, pero como las tenperaturasd en el interior de las estrellas es también altísima, se produce una presión contraria que evita que la estrella se colapse. La estrella, sin embargo, pierde calor continuamente. Al proncipio de su vida, en las estrellas se producen todo de reacciones nucleares que mantienen su temperatura alta y que incluso la pueden elevar, pero antes o después el combustible nuclear se acaba. Cuanto más pesada sea la estrella, mayor es la prsión y la temperatura, y más rápidamente se consume su combustible. La contrapresión disminuye progresivamente y la estrella se va colapsando bajo la presión, según dismunye el tamaño de la estrella, la fuerza gravitatoria aumenta hasta que finalmente se produce una implosión -un colapso repentino y completo- que no puede ser evitado por más tiempo: ¡ha nacido un agujero negro!

Según todos los indicios, cuando la estrella es muy masiva, la Improsión finaliza convirtiendo toda la inmensa masa de la estrella en un A. N., pero antes, explota como supernova y llena el espacio de los materiales coplejos que han sido fabricados en sus nucleares, siembra el espacio con una Nebulosa de la que, años más tarde, nacerán nuevas estrellas y nuevos mundos…Y, ¿quién sabe? ¡Si nuevas formas de Vida!

A menudo implosión libera tanto calor que las capas exteriores de la estrella explotan por la presión de la radiación, y la implosión queda interrumpida produciéndose una esfera extremadamente compacta de “material nuclear” que conocemos como una estrella de neutrones. Algunas veces, estas estrellas de neutrones rotan con una tremenda velocidad (más de 500 revoluciones/segundo), y, debido a irregularidades en la superficie, emiten una señal de radio que pulsa con esa velocidad.

Si todos estos sucesos pudieran ser observados una distancia segura, las señales emitidas por el material durante la implosión pronto serían demasiado débiles para ser detectadas y, en el caso de un afgujero negro, el objeto se vuelve de ese color y desaparece de nuestra vista convertido en una “bola de gravedad pura”, se pueden calcular sus propiedades con precisión matemática. Sólo se necesitan tres parámetros para caracterizar completamente al agujero negro: su masa, su movimiento angular (cantidad de movimiento de rotación) y su carga eléctrica.

También se calcular como se comportan los chorros de partículas cuando se aventuiran cerca del agujero negro. Hawking ya nos habló de ello y explicó con suficiente claridad, lo que pasaba era que, en contra de lo que pudiéramos pensar, el agujero emite un débil flujo de partículas en ciertas circunstancias. ¿Esas partículas son reales! Agujero Negro está emitiendo un flujo constante de partículas de todas las especies concebibles.

El Telescopio Espacial Hubble y Chandra han captado la imagen de un impresionante anillo de Agujeros negros. La fotografía corresponde al conjunto Arp 147, en el que aparecen 2 galaxias interactuando entre sí y que se ubican a una distancia de 430 millones de años luz de la Tierra. La NASA combinó datos del Chandra con imágenes del Hubble. Mientras los tonos rojos, azules y verdes fueron resultado del trabajo del Hubble; los de color magenta, del Chandra. La captura muestra un anillo formado por estrellas masivas que evolucionaron rápidamente y explotaron en supernovas, como consecuencia de una colisión galáctica. Es así como dejaron densas estrellas de neutrones y posiblemente, también agujeros negros.

En el Universo ocurren sucesos que no podemos ni imaginar, tales son las fuerzas y energías que ahí están presentes y que dan lugar a maravillas que desembocan en transiciones de fase que convierten unas cosas en otras muy distintas haciendo que la diversidad exista, que la belleza permanezca, que la monotonía no sea el camino.

Es cierto que nunca hemos podido estar tan cerca de un agujero negro como poder comprobar, in situ, la radiación Hawking que, para su formulación, sólo utilizó leyes bien establecidas de la naturaleza y que, por tanto, el resultado debería ser incuestionable, pero no es del todo cierto por dos razones:

La primera razón es que nunca ( he dicho) hemos sido capaces de observar un agujero negro de cerca y mucho de un tamaño tan pequeño que su radiación Hawking pueda ser detectada. Ni siquiera sabemos si tales miniagujeros negros existen en nuestro universo, o si sólo forman una minoría extremadamente escasa entre los objetos del cielo. Aunque pensemos conocer la teoría, no nos habría hecho ningún daño haber podido comprobar sus predicciones de una o de otra. ¿Sucede todo exactamente como pensamos actualmente que debería suceder?

Otros, como Gerald ´t Hooft, consiguieron construir otro de teorías alternativas y le dieron resultados distintos a los de Hawking, en la que el Agujero Negro podia radiar con una intensidad considerablemente mayor que la que la teoría de Stephen predecía.

Hay un aspecto relacionado con la radiación Hawking mucho más importante. El agujero negro disminuye su tamaño al emitir partículas, y la intensidad de su radiación crece rápidamente según se reduce su tamaño. Justo de llegar a los estadios finales, el tamaño del agujero negro se hará comparable a la longitud de Planck y toda la masa llegará a ser sólo un poco mayor que la masa de Planck, Las energías de las partículas emitidas corresponderan a la masa de Planck.

¡Solamente una teoría completa de la Gravedad Cuántica podrá predecir y describir exactamente lo que sucede al agujero negro en ese ! es la importancia de los Agujeros Negros la teoría de partículas elementales en la Longitud de Planck. Los agujeros negros serían un laboratorio ideal para experimentos imaginarios. Todos alcanzan, por sí mismos, el régimen de energía de los números de Planck, y una buena teoría debe ser capaz de decirnos como calcular en ese caso. casi una década, Gerad ´t Hoofft ha resaltando esa objeción en la teoría de supercuerdas: no nos dice nada de los agujeros negros y mucho de cómo un agujero negro comenzar su vida como un agujero negro de tamaño “astronómico” y acabar su vida explosivamente.

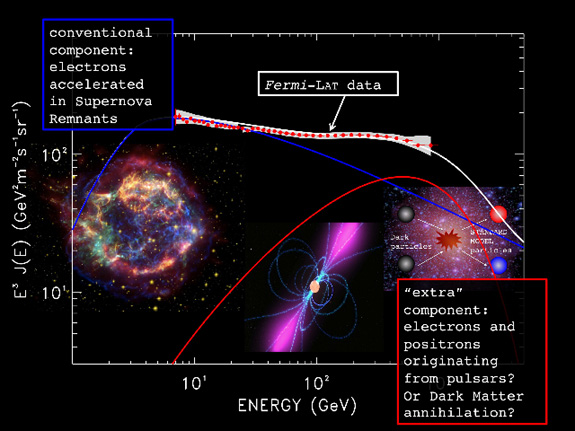

Lo cierto es que, andamos un poco perdidos y no pocos físicos (no sabemos si de manera interesada), insisten una y otra vez, en cuestiones que parecen no llevar a ninguna parte y que, según las imposibilidades que nos presentan esos caminos, no sería conveniente elegir otros derroteros para indagar nuevas físicas mientras tanto, avanzan las tecnologías, se adquieren más potentes y nuevas formas de energías que nos puedan permitir llegar a sondear las cuerdas y poder vislumbrar si es cierto, que pueda existir alguna “materia oscura”, o, si existen bosones dadores de masa, o…¡tántas cosas más que, la lista, sería interminable! de las cosas que no sabemos. De hecho, el Modelo Estándar de la física de partículas ha tenido que dejar fuera a una de las fuerzas fundamentales, la Gravedad, no quiere cuentas con las otras fuerzas, y, además, una veintena de parámetros aleatorios conforman esa teroía que, habiendo sido (y lo sigue siendo) una buena herramienta de trabajo para los físicos, tiene muchas dudas pendientes de despejar. Aunque parece que el Bosón de Higgs, una de ellas, ha sido despejada y, esperamos que nos den muchas más explicaciones de su encuentro y de cómo ejerce sus funciones o cometidos de dar mas a las demás partículas.

emilio silvera

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Si hablamos de las partículas no podemos dejar a un lado el tema del movimiento rotatorio de las mismas. Usualmente se ve cómo la partícula gira sobre su eje, a semejanza de un trompo, o como la Tierra o el Sol, o nuestra galaxia o, si se me permite decirlo, como el propio universo. En 1.925, los físicos holandeses George Eugene Uhlenbeck y Samuel Abraham Goudsmit aludieron por primera vez a esa rotación de las partículas.

Los campos magnéticos no realizan trabajo sobre las partículas y no modifican su energía cinética. Veamos la imagen. cabe notar en la imagen que la fuerza magnética es perpendicular a la velocidad de la partícula haciendo que se mueva en una órbita circular. La fuerza magnética proporciona la fuerza centrípeta necesaria para que la partícula adquiera la aceleración v2 /r del movimiento circular.

Los campos magnéticos no realizan trabajo sobre las partículas y no modifican su energía cinética. Veamos la imagen. cabe notar en la imagen que la fuerza magnética es perpendicular a la velocidad de la partícula haciendo que se mueva en una órbita circular. La fuerza magnética proporciona la fuerza centrípeta necesaria para que la partícula adquiera la aceleración v2 /r del movimiento circular.

Las partículas al girar, generan un minúsculo campo electromagnético; tales campos han sido objeto de medidas y exploraciones, principalmente por parte del físico alemán Otto Stern y el físico norteamericano Isaac Rabi, quienes recibieron los premios Nobel de Física en 1.943 y 1.944 respectivamente, por sus trabajos sobre dicho fenómeno.

Esas partículas (al igual que el protón, el neutrón y el electrón), que poseen espines que pueden medirse en números mitad, se consideran según un sistema de reglas elaboradas independientemente, en 1.926, por Fermi y Dirac; por ello, se las llama y conoce como estadísticas Fermi-dirac. Las partículas que obedecen a las mismas se denominan fermiones, por lo cual el protón, el electrón y el neutrón son todos fermiones.

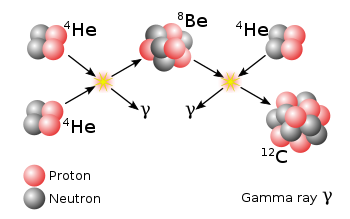

Hay también partículas cuya rotación, al duplicarse, resulta igual a un número par. Para manipular sus energías hay otra serie de reglas, ideadas por Einstein y el físico indio S. N. Bose. Las partículas que se adaptan a la estadística Bose-Einstein son bosones, como por ejemplo la partícula alfa.

Las reglas de la mecánica cuántica tienen que ser aplicadas si queremos describir estadísticamente un sistema de partículas que obedece a reglas de esta teoría en vez de los de la mecánica clásica. En estadística cuántica, los estados de energía se considera que están cuantizados. La estadística de Bose-Einstein se aplica si cualquier número de partículas puede ocupar un estado cuántico dado. Dichas partículas (como dije antes) son bosones, que tienden a juntarse.

Los bosones tienen un momento angular nh/2π, donde n es 0 o un entero, y h es la constante de Planck. Para bosones idénticos, la función de ondas es siempre simétrica. Si sólo una partícula puede ocupar un estado cuántico, tenemos que aplicar la estadística Fermi-Dirac y las partículas (como también antes dije) son los fermiones que tienen momento angular (n + ½)h / 2π y cualquier función de ondas de fermiones idénticos es siempre antisimétrica. La relación entre el espín y la estadística de las partículas está demostrada por el teorema espín-estadística.

En un espacio de dos dimensiones es posible que haya partículas (o cuasipartículas) con estadística intermedia entre bosones y fermiones. Estas partículas se conocen con el nombre de aniones; para aniones idénticos, la función de ondas no es simétrica (un cambio de fase de +1) o antisimétrica (un cambio de fase de -1), sino que interpola continuamente entre +1 y -1. Los aniones pueden ser importantes en el análisis del efecto Hall cuántico fraccional y han sido sugeridos como un mecanismo para la superconductividad de alta temperatura.

Debido al principio de exclusión de Pauli, no es imposible que dos fermiones ocupen el mismo estado cuántico (al contrario de lo que ocurre con los bosones). La condensación Bose-Einstein es de importancia fundamental para explicar el fenómeno de la superfluidez. A temperaturas muy bajas (del orden de 2×10-7 K) se puede formar un condensado de Bose-Einstein, en el que varios miles de átomos dorman una única entidad (un superátomo). Este efecto ha sido observado con átomos de rubidio y litio. Como ha habréis podido suponer, la condensación Bose-Einstein es llamada así en honor al físico Satyendra Nath Bose (1.894 – 1.974) y a Albert Einstein. Así que, el principio de exclusión de Pauli tiene aplicación no sólo a los electrones, sino también a los fermiones; pero no a los bosones.

Un condensado de Bose-Einstein

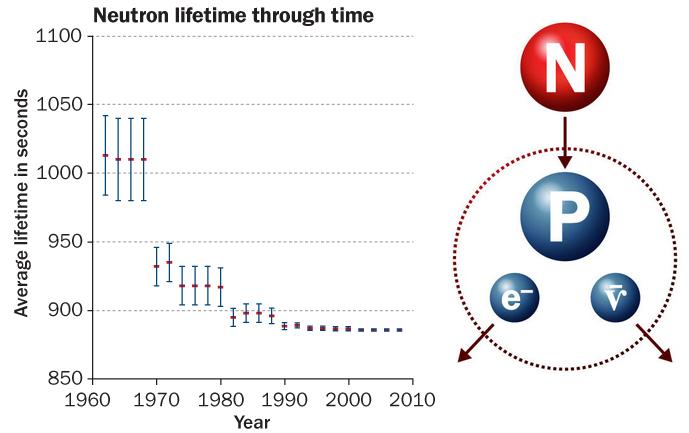

Si nos fijamos en todo lo que estamos hablando aquí, es fácil comprender cómo forma un campo magnético la partícula cargada que gira, pero ya no resulta tan fácil saber por qué ha de hacer lo mismo un neutrón descargado. Lo cierto es que cuando un rayo de neutrones incide sobre un hierro magnetizado, no se comporta de la misma forma que lo haría si el hierro no estuviese magnetizado. El magnetismo del neutrón sigue siendo un misterio; los físicos sospechan que contiene cargas positivas y negativas equivalente a cero, aunque por alguna razón desconocida, logran crear un campo magnético cuando gira la partícula.

Particularmente creo que, si el neutrón tiene masa, si la masa es energía (E = mc2), y si la energía es electricidad y magnetismo (según Maxwell), el magnetismo del neutrón no es tan extraño, sino que es un aspecto de lo que en realidad es materia. La materia es la luz, la energía, el magnetismo, en definitiva, la fuerza que reina en el universo y que está presente de una u otra forma en todas partes (aunque no podamos verla).

Todo lo que rota crea un campo magnético

Todo lo que rota crea un campo magnético

Sea como fuere, la rotación del neutrón nos da la respuesta a esas preguntas:

¿Qué es el antineutrón? Pues, simplemente, un neutrón cuyo movimiento rotatorio se ha invertido; su polo sur magnético, por decirlo así, está arriba y no abajo. En realidad, el protón y el antiprotón, el electrón y el positrón, muestran exactamente el mismo fenómeno de los polos invertidos.

Es indudable que las antipartículas pueden combinarse para formar la antimateria, de la misma forma que las partículas corrientes forman la materia ordinaria.

La primera demostración efectiva de antimateria se tuvo en Brookhaven en 1.965, donde fue bombardeado un blanco de berilio con 7 protones BeV y se produjeron combinaciones de antiprotones y antineutrones, o sea, un antideuterón. Desde entonces se ha producido el antihelio 3, y no cabe duda de que se podría crear otros antinúcleos más complicados aún si se abordara el problema con más interés.

Pero, ¿existe en realidad la antimateria? ¿Hay masas de antimateria en el universo? Si las hubiera, no revelarían su presencia a cierta distancia. Sus efectos gravitatorios y la luz que produjeran serían idénticos a los de la materia corriente. Sin embargo, cuando se encontrasen las masas de las distintas materias, deberían ser claramente perceptibles las reacciones masivas del aniquilamiento mutuo resultante del encuentro. Así pues, los astrónomos observan especulativamente las galaxias, para tratar de encontrar alguna actividad inusual que delate interacciones materia-antimateria.

No parece que dichas observaciones fuesen un éxito. ¿Es posible que el universo esté formado casi enteramente por materia, con muy poca o ninguna antimateria? Y si es así, ¿por qué? Dado que la materia y la antimateria son equivalente en todos los aspectos, excepto en su oposición electromagnética, cualquier fuerza que crease una originaría la otra, y el universo debería estar compuesto de iguales cantidades de la una y de la otra.

Este es el dilema. La teoría nos dice que debería haber allí antimateria, pero las observaciones lo niegan, no lo respaldan. ¿Es la observación la que falla? ¿Y qué ocurre con los núcleos de las galaxias activas, e incluso más aún, con los quásares? ¿Deberían ser estos fenómenos energéticos el resultado de una aniquilación materia-antimateria? ¡No creo! Ni siquiera ese aniquilamiento parece ser suficiente, y los astrónomos prefieren aceptar la noción de colapso gravitatorio y fenómenos de agujeros negros, como el único mecanismo conocido para producir la energía requerida.

Con esto de la antimateria me ocurre igual que con el hecho, algunas veces planteado, de la composición de la materia en lugares lejanos del universo. “Ha caído una nave extraterrestre y nuestros científicos han comprobado que está hecha de un material desconocido, casi indestructible”. Este comentario se ha podido oír en alguna película de ciencia ficción. Podría ser verdad (un material desconocido), sin embargo, no porque la nave esté construida por una materia distinta, sino porque la aleación es distinta y más avanzada a partir de los materiales conocidos del universo. En cualquier parte del universo, por muy lejana que pueda estar, rigen los mismos principios y las mismas fuerzas: la materia y la energía son las mismas en cualquier parte. Lo único que puede diferir es la forma en que se utilice, el tratamiento que se le pueda dar, y sobre todo, el poseer el conocimiento y la tecnología necesarios para poder obtener el máximo resultado de las propiedades que dicha materia encierra, porque, en última instancia, ¿es en verdad inerte la materia?

Tiene y encierra tantos misterios la materia que estamos aún a años luz de saber y conocer sobre su verdadera naturaleza. Nos podríamos preguntar miles de cosas que no sabríamos contestar. Nos maravillan y asombran fenómenos naturales que ocurren ante nuestros ojos, pero que tampoco sabemos, en realidad, a qué son debidas. Sí, sabemos ponerles etiquetas como la fuerza nuclear débil, la fisión espontánea que tiene lugar en algunos elementos como el protactinio o el torio, y con mayor frecuencia, en los elementos que conocemos como transuránicos.

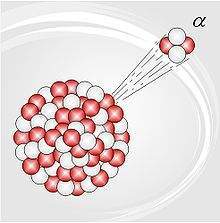

A medida que los núcleos se hacen más grandes, la probabilidad de una fisión espontánea aumenta. En los elementos más pesados de todos (einstenio, fermio y mendelevio), esto se convierte en el método más importante de su ruptura, sobrepasando a la emisión de partículas alfa. ¡Parece que la materia está viva! Son muchas las cosas que desconocemos, y nuestra curiosidad nos empuja continuamente a buscar esas respuestas.

El electrón y el positrón son notables por sus pequeñas masas (sólo 1/1.836 de la del protón, el neutrón, el antiprotón o el antineutrón), y por lo tanto, han sido denominados leptones (de la voz griega leptos, que dignifica “delgado”).

Aunque el electrón fue descubierto en 1.897 por el físico británico Joseph John Thomson (1.856 – 1.940), el problema de su estructura, si la hay, aún no está resuelto. Conocemos su masa y su carga negativa que responden a 9’1093897 (54) × 10-31 Kg la primera, y 1’60217733 (49) × 10-19 culombios la segunda, y también su radio clásico r0 igual a e2/(mc2) = 2’82 × 10-13 cm. No se ha descubierto aún ninguna partícula que sea menos masiva que el electrón (o positrón) y que lleve una carga eléctrica, sea la que fuese (sabemos cómo actúa y cómo medir sus propiedades, pero aún no sabemos qué es), que tenga asociada un mínimo de masa.

Lo cierto es que el electrón es una maravilla en sí mismo. El universo no sería como lo conocemos si el electrón fuese distinto a como es; bastaría un cambio infinitesimal para que, por ejemplo, nosotros no pudiéramos estar aquí ahora.

Aquí, un electrón e desviado por el campo eléctrico de un núcleo atómico produce prenorradiación. El cambio de energía E2 − E1 determina la fecuencia f del fotón emitido. ¡No por pequeño se el insignificante!

Aquí, un electrón e desviado por el campo eléctrico de un núcleo atómico produce prenorradiación. El cambio de energía E2 − E1 determina la fecuencia f del fotón emitido. ¡No por pequeño se el insignificante!

Recordémoslo, todo lo grande está hecho de cosas pequeñas. En realidad, existen partículas que no tiene asociada ninguna masa en absoluto, es decir, ninguna masa en reposo. Por ejemplo, las ondas de luz y otras formas de radiación electromagnética se comportan como partículas (Einstein en su efecto fotoeléctrico y De Broglie en la difracción de electrones). Esta manifestación en forma de partículas de lo que, de ordinario, concebimos como una onda, se denomina fotón, de la palabra griega que significa “luz”.

El fotón tiene una masa de 1, una carga eléctrica de 0, pero posee un espín de 1, por lo que es un bosón. ¿Cómo se puede definir lo que es el espín? Los fotones toman parte en las reacciones nucleares, pero el espín total de las partículas implicadas antes y después de la reacción deben permanecer inmutadas (conservación del espín). La única forma de que esto suceda en las reacciones nucleares que implican a los fotones radica en suponer que el fotón tiene un espín de 1. El fotón no se considera un leptón, puesto que este término se reserva para la familia formada por el electrón, el muón y la partícula tau, con sus correspondiente neutrinos: υe, υμ y υτ.

Existen razones teóricas para suponer que cuando las masas se aceleran (como cuando se mueven en órbitas elípticas en torno a otra masa o llevan a cabo un colapso gravitacional), emiten energía en forma de ondas gravitaciones. Esas ondas pueden, así mismo, poseer aspecto de partícula, por lo que toda partícula gravitacional recibe el nombre de gravitón.

La forma gravitatoria es mucho, mucho más débil que la fuerza electromagnética. Un protón y un electrón se atraen gravitacionalmente con sólo 1/1039 de la fuerza en que se atraen electromagnéticamente. El gravitón (aún sin descubrir) debe poseer, correspondientemente, menos energía que el fotón, y por tanto, ha de ser inimaginablemente difícil de detectar.

Parece que los tenemos a todos bien localizados pero… ¿Dónde está el Gravitón?

Parece que los tenemos a todos bien localizados pero… ¿Dónde está el Gravitón?

Seguramente riéndose de nuestra ignorancia

Seguramente riéndose de nuestra ignorancia

De todos modos, el físico norteamericano Joseph Weber emprendió en 1.957 la formidable tarea de detectar el gravitón. Llegó a emplear un par de cilindros de aluminio de 153 cm de longitud y 66 de anchura, suspendidos de un cable en una cámara de vacío. Los gravitones (que serían detectados en forma de ondas) desplazarían levemente esos cilindros, y se empleó un sistema para detectar el desplazamiento que llegase a captar la cienbillonésima parte de un centímetro. Las débiles ondas de los gravitones, que proceden del espacio profundo, deberían chocar contra todo el planeta, y los cilindros separados por grandes distancias se verán afectados de forma simultánea. En 1.969, Weber anunció haber detectado los efectos de las ondas gravitacionales. Aquello produjo una enorme excitación, puesto que apoyaba una teoría particularmente importante (la teoría de Einstein de la relatividad general). Desgraciadamente, nunca se pudo comprobar mediante las pruebas realizadas por otros equipos de científicos que duplicaron el hallazgo de Weber.

En cualquier caso, no creo que a estas alturas alguien pueda dudar de la existencia de los gravitones, el bosón mediador de la fuerza gravitatoria. La masa del gravitón es 0, su carga es 0, y su espín es 2. Como el fotón, no tiene antipartícula; ellos mismos hacen las dos versiones.

emilio silvera

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

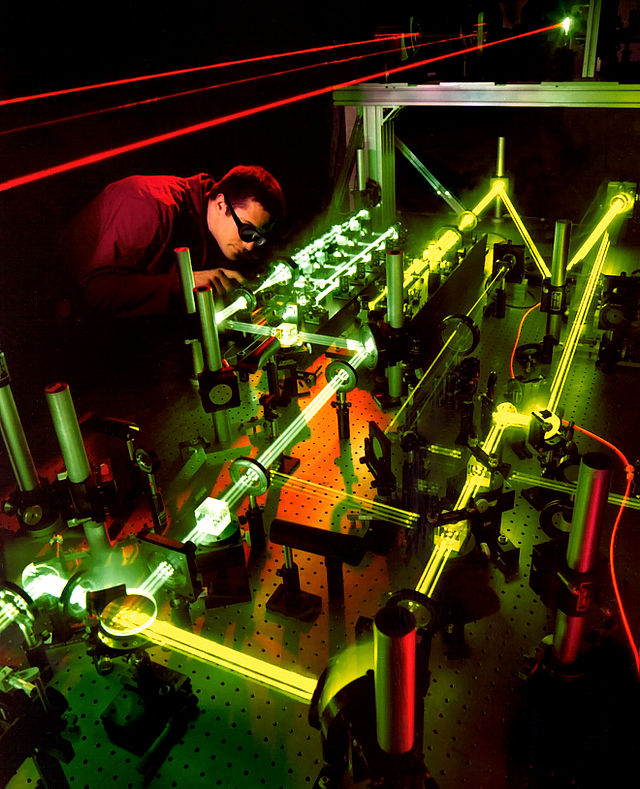

La velocidad de la luz

Un haz de Láser en el aire viajando cerca del 99.97% de la rapidez de la luz en el vacío

Está claro que la luz se desplaza a enormes velocidades. Si pulsamos el interruptor apagado de la lámpara de nuestro salón, todo queda a oscuras de manera instantánea. La velocidad del sonido es más lenta; por ejemplo, si vemos a un leñador que está cortando leña en un lugar alejado de nosotros, sólo oiremos los golpes momentos después de que caiga el hacha. Así pues, el sonido tarda cierto tiempo en llegar a nuestros oídos. En realidad es fácil medir la velocidad de su desplazamiento: unos 1.206 Km/h en el aire y a nivel del mar.

No parece el mejor método para medir la velocidad de la luz, el empleado por Galileo. Claro que, en aquellos tiempos…¿Qué se podía hacer?

Galileo fue el primero en intentar medir la velocidad de la luz. Se colocó en lo alto de una colina, mientras que su ayudante se situaba en otro lugar alto de la colina vecina; luego sacó una linterna encendida. Tan pronto como su ayudante vio la luz, hizo una señal con otra linterna. Galileo repitió el experimento a distancias cada vez mayores, suponiendo que el tiempo requerido por su ayudante para responder mantendría una uniformidad constante, por lo cual, el intervalo entre la señal de su propia linterna y la de su ayudante representaría el tiempo empleado por la luz para recorrer cada distancia. Aunque la idea era lógica, la luz viajaba demasiado aprisa como que Galileo pudiera percibir las sutiles diferencias con un método tan rudimentario.

Un tránsito doble sombra en Júpiter. Los dos satélites visibles, Io y Europa, justo a la derecha del planeta son responsables de las sombras. (La imagen fue generada por computadora.) Todos los planetas y lunas del Sistema solar han sido estudiado muy a fondo por los Astrónomos que, cada día descubren nuevos dsecretos de estos grandes y pequeños “mundos”.

En 1.676, el astrónomo danés Olaus Roemer logró cronometrar la velocidad de la luz a escala de distancias astronómicas. Estudiando los eclipses de Júpiter en sus cuatro grandes satélites, Roemer observó que el intervalo entre eclipses consecutivos era más largo cuando la Tierra se alejaba de Júpiter, y más corto cuando se movía en su órbita hacia dicho astro. Al parecer, la diferencia entre las duraciones del eclipse reflejaba la diferencia de distancias entre la Tierra y Júpiter. Y trataba, pues, de medir la distancia partiendo del tiempo empleado por la luz para trasladarse desde Júpiter hasta la Tierra. Calculando aproximadamente el tamaño de la órbita terrestre y observando la máxima discrepancia en las duraciones del eclipse que, según Roemer, representaba el tiempo que necesitaba la luz para atravesar el eje de la órbita terrestre, dicho astrónomo computó la velocidad de la luz. Su resultado, de 225.000 Km/s, parece excelente si se considera que fue el primer intento, y resultó bastante asombroso como para provocar la incredulidad de sus coetáneos.

James Bradley descubrió la aberración estelar

Sin embargo, medio siglo después se confirmaron los cálculos de Roemer en un campo completamente distinto. Allá por 1.728, el astrónomo británico James Bradley descubrió que las estrellas parecían cambiar de posición con los movimientos terrestres; y no por el paralaje, sino porque la traslación terrestre alrededor del Sol era una fracción mensurable (aunque pequeña) de la velocidad de la luz. La analogía empleada usualmente es la de un hombre que camina con el paraguas abierto bajo un temporal. Aun cuando las gotas caigan verticalmente, el hombre debe inclinar hacia delante el paraguas, porque ha de abrirse paso entre las gotas. Cuanto más acelere su paso, tanto más deberá inclinar el paraguas. De manera semejante, la Tierra avanza entre los ligeros rayos que caen desde las estrellas, y el astrónomo debe inclinar un poco su telescopio y hacerlo en varias direcciones, de acuerdo con los cambios de la trayectoria terrestre (no olvidemos que nuestro planeta Tierra es como una enorme nave espacial que nos lleva en un viaje eterno, alrededor del Sol, a la velocidad de 30 Km/s). Mediante ese devío aparente de los astros (“aberración de la luz”), Bradley pudo evaluar la velocidad de la luz y calcularla con gran precisión. Sus cálculos fueron de 285.000 Km/s, bastante más exactos que los de Roemer, pero aún un 5’5% más bajos.

Poco a poco, con medios tecnológicos más sofisticados y más conocimientos matemáticos, los científicos fueron obteniendo medidas más exactas aún, conforme se fue perfeccionando la idea original de Galileo y sus sucesores.

En 1.849, el físico francés Armand-Hippolyte-Louis Fizeau ideó un artificio mediante el cual se proyectaba la luz sobre un espejo situado a 8 Km de distancia, que devolvía el reflejo al observador. El tiempo empleado por la luz en su viaje de ida y vuelta no rebasó apenas la 1/20.000 de segundo, pero Fizean logró medirlo colocando una rueda dentada giratoria en la trayectoria del rayo luminoso. Cuando dicha rueda giraba a cierta velocidad, la luz pasaba entre los dientes y se proyectaba contra el siguiente, al ser devuelta por el espejo; así, Fizeau, colocando tras la rueda, no pudo verla. Entonces se dio más velocidad a la rueda y el reflejo pasó por la siguiente muesca entre los dientes, sin interacción alguna. De esa forma, regulando y midiendo la velocidad de la rueda giratoria, Fizean pudo calcular el tiempo trascurrido y, por consiguiente, la velocidad a la que se movía el rayo de luz.

Animación del Péndulo de Foucault oscilando en el hemisferio sur

Un año más tarde, Jean Foucault (quien realizaría poco después su experimento con los péndulos) precisó más estas medidas empleando un espejo giratorio en vez de una rueda dentada. Entonces se midió el tiempo transcurrido desviando ligeramente el ángulo de reflexión mediante el veloz espejo giratorio. Foucault obtuvo un valor de la velocidad de la luz de 300.883 Km/s. También el físico francés utilizó su método para determinar la velocidad de la luz a través de varios líquidos. Averiguó que era notablemente inferior a la alcanzada en el aire. Esto concordaba con la teoría ondulatoria de Huyghens.

Michelson fue más preciso aún en sus medidas. Este autor, durante cuarenta años largos a partir de 1.879, fue aplicando el sistema Fizean-Foucault cada vez con mayor refinamiento, para medir la velocidad de la luz. Cuando se creyó lo suficientemente informado, proyectó la luz a través del vacío, en vez de hacerlo a través del aire, pues éste frena ligeramente su velocidad, y empleó para ello tuberías de acero cuya longitud era superior a 1’5 Km. Según sus medidas, la velocidad de la luz en el vacío era de 299.730 Km/s (sólo un 0’006% más bajo). Demostraría también que todas las longitudes de ondas luminosas viajan a la misma velocidad en el vacío.

En 1.972 un equipo de investigadores bajo la dirección de Kenneth M. Evenson efectuó unas mediciones aún más exactas y vio que la velocidad de la luz era de 299.727’74 Km/s. Una vez se conoció la velocidad de la luz con semejante precisión, se hizo posible usar la luz, o por lo menos formas de ella, para medir distancias.

Aunque para algunos resulte algo tedioso el tema anterior, no he podido resistirme a la tentación de exponerlo; así podrá saber algo más sobre la luz, y habrán conocido a personajes que hicieron posible el que ahora nosotros la conozcamos mejor.

Podría continuar hasta el final de este trabajo hablando de la luz y sus distintas formas o aplicaciones: ondas de luz a través del espacio, de cómo se transmite la luz en el “vacío”, nos llega a través del espacio desde galaxias situadas a miles de millones de años luz; las líneas de fuerzas electromagnéticas de Faraday y Maxwell de campos eléctricos y magnéticos cambiantes (todo ello explicado en un simple conjunto de cuatro ecuaciones, que describían casi todos los fenómenos referentes a esta materia electromagnética), o de los enigmas aún por descubrir (aunque predichos).

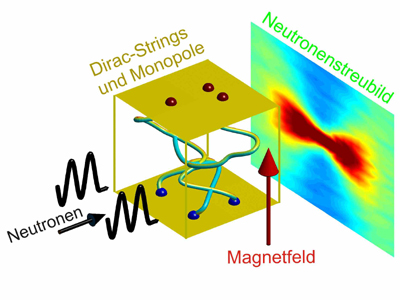

En 1.931, Dirac, acometiendo el asunto de una forma matemática, llegó a la conclusión de que si los monopolos magnéticos existían (si existía siquiera uno en cualquier parte del universo), sería necesario que todas las cargas eléctricas fuesen múltiplos exactos de una carga más pequeña, como en efecto así es. Y dado que todas las cargas eléctricas son múltiplos exactos de alguna carga más pequeña, ¿no debería, en realidad, existir los monopolos magnéticos?

En 1.974, un físico neerlandés (yo lo he mencionado antes en este mismo trabajo), Gerard’t Hooft, y un físico soviético, Alexander Poliakov, mostraron independientemente que podía razonarse, a partir de las grandes teorías unificadas, que los monopolos magnéticos debían así mismo existir, y que debían poseer una masa enorme. Aunque un monopolo magnético sería incluso más pequeño que un protón, debería tener una masa que sería de 10 trillones a 10 cuatrillones mayor que la del protón. Eso equivaldría a la masa de una bacteria comprimida en una diminuta partícula subatómica.

Semejantes partículas sólo podían haberse formado en el momento de la gran explosión (otra vez volvemos al origen). Desde entonces no ha existido la suficientemente alta concentración de energía necesaria para formarla. Esas grandes partículas deberían avanzar a unos 225 Km/s, aproximadamente, y la combinación de una enorme masa y un pequeño tamaño le permitiría deslizarse a través de la materia sin dejar el menor rastro de presencia. Esta propiedad, de hecho, está relacionada directamente con el fracaso obtenido en su búsqueda. Los físicos están tratando de idear un mecanismo capaz de poder detectar con claridad el paso de monopolos magnéticos.

Todos los imanes tienen dos polos. Si cortas una imán por la mitad sigue teniendo dos polos. ¿Existen imanes con un sólo polo magnético? Los llamados monopolos magnéticos han sido buscados por mucho tiempo desde que en 1931 Dirac afirmó que la mecánica cuántica no prohibía su existencia. Los monopolos de Dirac eran “bestias” de enorme masa (miles de billones de veces la masa del protón). Ville Pietilä y Mikko Möttönen han demostrado teóricamente cómo se pueden observar monopolos de Dirac en la estructura de espín de estados condensados de Bose-Einstein.

Podríamos decir que un monopolo magnético es una entidad magnética consistente en un polo norte o sur elemental aislado. Ha sido postulado como una enorme fuente de campo magnético en analogía a la forma en que las partículas eléctricamente cargadas producen un campo eléctrico.

Se han diseñado numerosos experimentos ingeniosos para detectar monopolos, pero hasta ahora ninguno ha producido un resultado definitivo. Los monopolos magnéticos son predichos en ciertas teorías gauge con bosones de Higgs. En particular, algunas teorías de gran unificación predicen monopolos muy pesados (con masas del orden de 1016 GeV). Los monopolos magnéticos también son predichos en las teorías de Kaluza-Klein (5 dimensiones) y en teoría de supercuerdas (10 y 26 dimensiones).

Preludio a la relatividad. Las ecuaciones de Lorentz-Fitzgerald

En 1.893 el físico irlandés George Fancis Fitzgerald emitió una hipótesis para explicar los resultados negativos del experimento conocido de Michelson-Morley. Adujo que toda la materia se contrae en la dirección del movimiento, y que esa contracción es directamente proporcional al ritmo (velocidad) del movimiento.

La contracción de Lorentz es un efecto relativista que consiste en la contracción de la longitud de un cuerpo en la dirección del movimiento a medida que su velocidad se acerca a la velocidad de la luz. Originalmente fue un concepto introducido por Lorentz como una forma de explicar la ausencia de resultados positivos en el experimento de Michelson-Morley. Posteriormente fue aplicado por Albert Einstein en el contexto de la relatividad especial.

La contracción de Lorentz viene descrita por la siguiente expresión

donde  es el llamado factor de Lorentz, L0 es la longitud medida por un observador estacionario (longitud propia) y L1 es la longitud medida por un observador que se desplaza a una velocidad v (longitud impropia) siendo c la velocidad de la luz.

es el llamado factor de Lorentz, L0 es la longitud medida por un observador estacionario (longitud propia) y L1 es la longitud medida por un observador que se desplaza a una velocidad v (longitud impropia) siendo c la velocidad de la luz.

Dado que siempre cumple que

es decir

la longitud impropia L1 siempre se ve contraída respecto a la longitud propia L0.

La contracción de Lorentz también puede entenderse como el efecto de dilatación del tiempo y como el aumento de la masa inercial de un cuerpo o partícula. Según tal interpretación, el interferómetro se quedaba corto en la dirección del “verdadero” movimiento terrestre, y lo hacía precisamente en una cantidad que compensaba con toda exactitud la diferencia de distancias que debería recorrer el rayo luminoso. Por añadidura, todos los aparatos medidores imaginables, incluyendo los órganos sensoriales humanos, experimentarían ese mismo fenómeno.

Parecía como si la explicación de Fitzgerald insinuara que la naturaleza conspiraba con objeto de impedir que el hombre midiera el movimiento absoluto, para lo cual introducía un efecto que anulaba cualquier diferencia aprovechable para detectar dicho movimiento.

Este asombroso fenómeno recibió el nombre de contracción de Fitzgerald, y su autor formuló una ecuación para el mismo, que referido a la contracción de un cuerpo móvil, fue predicha igualmente y de manera independiente por H. A. Lorente (1.853 – 1.928) de manera que, finalmente, se quedaron unidos como contracción de Lorentz-Fitzgerald.

A la contracción, Einstein le dio un marco teórico en la teoría especial de la relatividad. En esta teoría, un objeto de longitud l0 en reposo en un sistema de referencia parecerá, para un observador en otro sistema de referencia que se mueve con velocidad relativa v con respecto al primero, tener longitud , donde c es la velocidad de la luz. La hipótesis original atribuía esta contracción a una contracción real que acompaña al movimiento absoluto del cuerpo. La contracción es en cualquier caso despreciable a no ser que v sea del mismo orden o cercana a c.

Un objeto que se moviera a 11.2 Km/s (la velocidad de escape de nuestro planeta) experimentaría sólo una contracción equivalente a 2 partes por cada 1.000 millones en el sentido del vuelo. Pero a velocidades realmente elevadas, tal contracción sería sustancial. A unos 150.000 Km/s (la mitad de la velocidad de la luz) sería del 15%; a 262.000 Km/s (7/8 de la velocidad de la luz), del 50%. Es decir, que una regla de 30 cm que pasara ante nuestra vista a 262.000 Km/s nos parecería que mide sólo 15’24 cm, siempre y cuando conociéramos alguna manera para medir su longitud en pleno vuelo. Y a la velocidad de la luz, es decir, 300.000 Km/s en números redondos, su longitud en la dirección del movimiento sería cero. Puesto que, presuntamente, no puede existir ninguna longitud inferior a cero, se deduce que la velocidad de la luz en el vacío es la mayor que puede imaginarse el universo.

Nada puede viajar a la velocidad de la luz

El físico holandés Henrik Antón Lorentz, como hemos dicho, promovió esta idea pensando en los rayos catódicos (que ocupaban su actividad por aquellas fechas). Se hizo el siguiente razonamiento: si se comprimiera la carga de una partícula para reducir su volumen, aumentaría su masa. Por consiguiente, una partícula voladora, escorzada en la dirección de su desplazamiento por la contracción de Fitzgerald, debería crecer en términos de masa. Lorentz presentó una ecuación sobre el acrecentamiento de la masa, que resultó muy similar a la ecuación de Fitzgerald sobre el acortamiento. A 149.637 Km/s la masa de un electrón aumentaría en un 15%; a 262.000 Km/s, en un 100% (es decir, la masa se duplicaría); y a la velocidad de la luz, su masa sería infinita. Una vez más pareció que no podría haber ninguna velocidad superior a la de la luz, pues, ¿cómo podría ser una masa mayor que infinita?

El efecto Fitzgerald sobre longitudes y el efecto Lorentz sobre masas mantuvieron una conexión tan estrecha que aparecieron a menudo agrupadas como las ecuaciones Lorentz-Fitzgerald.

A velocidades relativistas aumenta la masa del objeto viajero

Mientras que la contracción Fitzgerald no podía ser objeto de mediciones, el efecto Lorentz sobre masas sí podía serlo, aunque indirectamente. De hecho, el muón tomó 10 veces su masa original cuando fue lanzado, a velocidades relativistas, en el acelerador de partículas, lo que confirmó la ecuación de Lorentz. Los experimentos posteriores han confirmado las ecuaciones de ambos: a velocidades relativistas, las longitudes se contraen y las masas se incrementan.

Como es conocido por todos, Einstein adoptó estos descubrimientos y los incorporó a su teoría de la relatividad especial, que aunque mucho más amplia, recoge la contracción de Fitzgerald y el aumento de la masa de Lorentz cuando se alcanzan grandes velocidades.

Einstein supo aunar las ideas de muchos a una teoría que, como se ha visto, nos enseñó un “mundo” nuevo

Algunas veces pienso que los artistas en general, y los poetas en particular, tendrían que adaptar e incluir en sus esquemas artísticos y poéticos los adelantos científicos, para asimilarlos en las diversas expresiones y sentimientos que serán después puestos al servicio del consumo humano. Estos adelantos científicos serían así coloreados con las pasiones humanas, y transformados, de alguna forma, en la sangre, y por qué no, los sentimientos de la naturaleza humana. Posiblemente, de haberlo hecho, el grado general de conocimiento sería mayor.

Sólo uno de cada tres puede definir una molécula o nombrar a un solo científico vivo. De veinticinco licenciados escogidos al azar en la ceremonia de graduación de Harvard, sólo dos pudieron explicar por qué hace más calor en verano que en invierno. La respuesta, dicho sea de paso, no es “porque el Sol está más cerca”; no está más cerca. El eje de rotación de la Tierra está inclinado, así que cuando el hemisferio norte se inclina hacia el Sol, los rayos son más perpendiculares a la superficie, y la mitad del globo disfruta del verano. Al otro hemisferio llegan rayos oblicuos: es invierno. Es triste ver cómo aquellos graduados de Harvard podían ser tan ignorantes. ¡Aquí los tenemos con faltas de ortografía!

Por supuesto, hay momentos brillantes en los que la gente se sorprende. Hace años, en una línea de metro de Manhattan, un hombre mayor se las veía y deseaba con un problema de cálculo elemental de su libro de texto de la escuela nocturna; no hacía más que resoplar. Se volvió desesperado hacia el extraño que tenía a su lado, sentado junto a él, y le preguntó si sabía cálculo. El extraño afirmó con la cabeza y se puso a resolverle al hombre el problema. Claro que no todos los días un anciano estudia cálculo en el metro al lado del físico teórico ganador del Nobel T. D. Lee.

emilio silvera

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Acelerador lineal de Generador de Giutenberg de una sola etapa de 2 MeV. No todos los aceleradores que pudimos construir eran como el LHC, y, los comienzos fueron más elementales. Los aceleradores de partículas imitan, en cierta forma, la acción de los rayos cósmicos sobre la atmósfera terrestre, lo cual produce al azar una lluvia de partículas exóticas e inestables. Sin embargo, los aceleradores prestan un entorno mucho más controlado para estudiar estas partículas generadas, y su proceso de desintegración. Ese estudio de partículas, tanto inestables como estables, puede ser en un futuro útil para el desarrollo de la medicina, la exploración espacial, tecnología, electrónica, etcétera. Hay dos tipos básicos de aceleradores de partículas: los lineales y los circulares. El tubo de rayos catódicos de un televisor es una forma simple de acelerador de partículas.

Demos un repaso sencillo sobre los Aceleradores de Partículas para que nos lleve a percatarnos de lo que, en realidad, allí se busca:

Estas dos líneas de actuación son en buena medida complementarias y, como en su día demostraron los experimentos en LEP, las medidas de precisión a una determinada energía permiten vislumbrar que clase de fenómenos aparecerán a más altas energías y anticipar las regiones de interés.

Aquí se muestra lo que era el túnel LEP en el CERN.

LEP (Large Electron-Positron collider) era un acelerador-colisionador e– e+ (electrón positrón)circular de unos 27 km de longitud, creado en 1989 y situado a 100 metrosbajo tierra en la frontera entre Francia y Suiza. Hasta que fue reemplazado por el LHC. Era el último paso del complejo de aceleradores del CERN, y en él los electrones y positrones eran inyectados y acelerados hasta la energía final de colisión mediante el uso de cavidades de radiofrecuencia. Un sistema de imanes dipolares curvaba los haces de electrones y positrones obligándoles a seguir una trayectoria circular.

En el LEP, los electrones y los positrones circulaban en sentidos opuestos a velocidades relativistas (cercanas a c, agrupados en paquetes de aproximadamente 1,6 centímetros de longitud y una sección de 0,3 × 0,01 mm2. Existían ocho puntos de colisión, en cuatro de los cuales había instalados varios experimentos: ALEPH, DELPHI, L3 y OPAL. LEP empezó a operar en agosto de 1989y aunque originalmente fue diseñado para la producción de bosones Z0 (cuya masa es de 91,2 GeV/c2), con energías por haz previstas para su primera fase en torno a los 45 GeVy luminosidades de 1031 cm-2· s-1, las distintas mejoras que años más tarde se introdujeron en él (incluyendo la instalación de cavidades superconductoras) permitieron alcanzar energías por haz de hasta 104,5 GeV. En la segunda fase aumentó su energía en el centro de masas hasta los 130 GeV. Este incremento permitió la producción de pares de bosones W± y Z0. Se esperaba que los sucesivos incrementos supusieran, incluso, el alcance del umbral de producción de nuevas partículas, como, por ejemplo, el Bosón de Higgs.

Las diferencias con el moderno LHC son notables y nos habla de lo que hemos avanzado

LEP anticipó con claridad que el Bosón de Higgs del Modelo Estándar era una partícula ligera, de masa probablemente inferior a 250 GeV. También sugirió la escala de -1 TeV como umbral muy probable para la puesta de manifiesto de una nueva fenomenología que podría incluir partículas supersimétricas, tecnicolar, dimensiones extras o supergravedad a bajas energías, entre otras fascinantes propuestas de Nueva Física.

La exploración directa de esta región de energía y la posibilidad de realizar medidas de precisión es la razón de ser del LHC, la gran instalación científica que desde su puesta en marcha nos ha dado algunas sorpresas. Las pruebas que allí han sido realizadas nos hablan de otra dimensión del del universo, de la materia, del espaciotiempo y, deja en el aire promesas de secretos que podemos descubrir.

Es la construcción científica más grande de la Historia de la Humanidad y, aunque está situado a 100 metros bajo tierra, ésta alta tecnología nos puede decir cómo es, en realidad, nuestro universo. Existen secretos que no han sido desvelados y que pueden quedar al descubierto utilizando en el LHC las altas energías nunca jamás imaginadas.

El Colisionador LHC ha permitido estudiar colisiones protón-protón a 14 TeV en el centro de masas e interacciones plomo-plomo a 1300 TeV en el centro de masas. Cuando comenzaron los experimentos existía la firme convicción de que el LHC establecería la naturaleza de la observada rotura de la simetría electrodébil (el mecanismo de Higgs frente a otras alternativas), dejaría al descubierto la posible existencia de partículas supersimétricas -o de otro tipo- así como nuevas interacciones, pondría de manifiesto el desconfinamiento de los quarks y la transición de fase hadrones-plasma de quarks y gluones y ayudaría a profundizar en el conocimiento de los sabores pesados (quarks botton y top) y en procesos mediados por violaciones de la simetría CP.

Los resultados de todas estas investigaciones han tenido influencias en campos estrechamente relacionados con la Física de Partículas como son la Astrofísica y la Cosmología y también, han ayudado a mejorar algunos otros campos que han mejorado nuestras vidas cotidianas. Y, aunque aún no ha llegado el momento, seguro que en el futuro nos dirá algo sobre esa sustancia cósmica que todos buscan y llaman la “materia oscura” y de la propia existencia de la materia bariónica (asimetría materia-antimateria). En definitiva, con el LHC se inició el asalto, tal vez definitivo, a algunas de las cuestiones y desafíos intelectuales más fundamentales en investigación básica. Claro que, esto no ha hecho más que empezar.

Tratamos de desentrañar los secretos de la Naturaleza por todas partes, en el Cosmos buscamos estrellas de Quarks y en los aceleradores de partículas nuevas partículas. La identificación de una EQ requiere señales observacionales consistentes. Con esto nos referimos a propiedades físicas de la estrella tales como su masa máxima, radio, período mínimo de rotación, enfriamiento por emisión de neutrinos. Todas estas propiedades dependen de una única ecuación de estado para la materia densa de quarks que aún no ha sido completamente establecida. Sin embargo, existe un rango de valores aceptados para las cantidades antes mencionadas, con base en datos observacionales recientes, que marcarían importantes diferencias entre las posibles EQs y los demás objetos compactos.

Ya dije aquí mismo en otra ocasión que, antes de que pasen otros 50 años, se hablará de otro nuevo Super Colisionador, ya éste, el LHC, habrá cumplido su cometido, nos habrá dicho todo lo que puede decir, y, estaremos buscando nuevos horizontes que nos lleven algo más lejos, toda vez que, el que obtengamos ahora se nos quedará corto en unos pocos años.

Tened en cuenta que el punto de partida del LHC se remonta a marzo de 1984 (reunión de Lausana del Comité ECFA, European Comité for Future Acelerators) aunque la posibilidad de instalar un colisionador hadrónico en el CERN se había previsto años antes al aprobar la construcción de LEP y dimensionar el diámetro del túnel para que pudiesen cohabitar dos grandes colisionadores: LEP y el LHC. El Proyecto de éste último fue aprobado por el Consejo del CERN en Diciembre de 1994 pero con unas restricciones de financiación tales que imponían un proceso de construcción estructurado en dos fases, algo verdaderamente comprometido al tratarse de una máquina superconductora.

La ingente obra para construir el LHC se puede considerar un triunfo de la Humanidad

Afortunadamente en 1996, el Consejo del CERN autorizó un perfil de endeudamiento, que se prolongó hasta el 2010, y que permió construir el LHC en una sola fase. En enero de 1996 se aprobó la construcción de dos experimentos de carácter genérico, ATLAS y CMS, y algo más tarde se aprobó la construcción de ALICE y LHCb diseñados específicamente para el estudio de las colisiones de iones ultrarelativistas y la producción de partículas con quark b respectivamente.

Podría continuar explicando la enormidad de este proyecto y lo complejo de cada uno de sus componentes, pero eso sería entrar en una serie de explicaciones técnicas de una profundidad que, no en pocos casos, se escapan de mi comprensión, así que, como una aportación de datos y un poco de historia de éste inmenso proyecto, aquí lo dejo. Esperemos que todo esto acabe felizmente y la Física (también, aunque parezca raro, la Astronomía) encuentre ese eslabón que nos lleve hacia el futuro.

emilio silvera

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Hablar de una Naturaleza simétrica sería condenar a nuestro Universo a la monotonía de la igualdad, y, todos sabemos que en él se encuentra todo lo que existe, la Materia, el Tiempo y el Espacio, todo ello acompañado por fuerzas que hacen de nuestro universo el que conocemos y, dentro de toda esa inmensidad, también se encuentran la simetría y la asimetría, como en nuestro mundo el día y la noche. La riqueza de la diversidad que conforma ese todo que el Universo es.

La exploración de la simetría y la asimetría en la Naturaleza comenzaba con el mayor de los objetos naturales: ¡El propio Universo! Y, hemos ido reduciendo gradualmente la escala de tamaños con estructuras cada vez más pequeñas. En otras ocasiones hemos tenido aquí mismo la oportunidad de hablar de la simetría que encontramos en la Naturaleza de las plantas y de los animales. Ahora, desvíamos nuestra atención hacia estructuras todavía menores, las diversas subunidades que constituyen todas las sustancias materiales, vivas o inertes.

Antes de continuar y para aquellos que lo puedan desconocer, será conveniente que tengan una conciencia clara de qué son exactamente estas unidades inferiores. Comenzando con las más pequeñas y yendo después en sentido ascendente, la escala sería:

Las partículas elementales que están descritas en el Modelo estándar actual de la física de partículas que conforman la materia y las fuerzas con las que interaccionan y que, hasta donde hemos podido saber, están divididas en familias:

Leptones: partículas puntuales con una dimensión espacial inapreciable. Los seis leptones conocidos son el electrón, el muón y el tauón, y el neutrino asociado a cada uno de ellos, el neutrino electrónico, muónico y tauónico.

Hadrones: Son aquellas partículas que se cree que están compuestas de pequeñas partículas puntuales llamadas quarks. Se han identificado cientos de hadrones, de los cuales los más importantes son el protón y el neutrón, ya que junto con el electrón forman la materia ordinaria.

Bosones: Partículas de “cambio”, partículas “soporte”, partículas “mensajeras” o partículas “indicadoras”. Contienen o son intermediarias de las cuatro fuerzas: electromagnetismo (conducido por el fotón), la fuerza débil (conducida por los vectores bosones intermedios), la gran fuerza nuclear (por los gluones) y la gravedad (por el gravitón aún no detectado). A finales de lños años setenta, las fuerzas elecdtromagnética y débil se unificaron en lo que ahora llamamos la fuerza electrodébil. La teoría electrodébil predice un bosón masivo denominado partícula de Higgs que, según nos han dicho los del LHC, ha sido encontrado. Veremos que explicaciones nos facilitan sobre ese hallazgo que… ¡ha quedado huérfano de los datos precisos que nos convenzan de su existencia real!

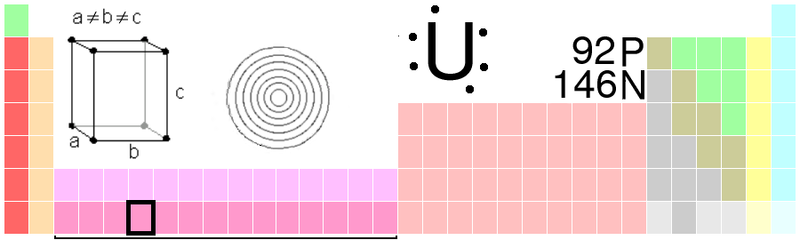

Representación de los tres bosones intermediarios en la fuerza electrodébil

Una vez descritas, muy someramente, las partículas de la materia y las fuerzas que rigen el universo conocido, tendríamos que pasar, de inmediato, al paso próximo que estaría representado por el átomo que, hasta donde conocemos, es la menor unidad estructural en la que puede dividirse la materia sin que pierda sus propiedades. En el centro de todo átomo está el núcleo, que debe contener al menos un protón, pero habitualmente está formado por una mezcla de protones y neutrones. Alrededor del núcleo, agrupados en “capas”, están los electrones. El átomo más sencillo, el de Hidrógeno, tiene un núcleo con un protón, alrededor del cual se mueve un único electrón. El átomo más complejo que se ha encontrado en la Naturaleza es el del Uranio, con 92 electrones. En el laboratorio se han encontrado algunos elementos más complejos a los que se llaman transuránicos, es decir, que van más allá del uranio y que no se encuentran en la Naturaleza, son artificiales.

Como podéis ver, el Uranio tiene 92 Protones y 146 Neutrones. Para equilibrar el átomo, el número de eletrones es también de 92, ya que al tener el elecdtrón, carga negativa equivalente a la carga positiva del protón, se consigue el equilibrio entre ambas y se alcanza la estabilidad, es decir, que el átomo sea neutro. Si un átomo pierde un electrón de su capa más externa se convierte en un átomo con carga positiva. Si gana uno, queda con carga negativa. Los átomos con carga eléctrica reciben el nombre de iones.

La molécula es una agrupación ordenada de átomos y constituye la mínima unidad de un elemento que puede subsistir de manera independiente. Mediante la afinidad química, los átomos están capacitados se unen entre sí y forman moléculas, que tienen un tamaño de alrededor de un millonésimo de milímetro. La afinidad de los átomos depende de la cantidad de electrones que giren alrededor del núcleo. Los átomos que tienen en la órbita externa ocho electrones no se unen a ningún otro elemento, dado que se encuentran equilibrados; estos constituyen los llamados gases nobles: helio, neón, argón, criptón, xenón y radón. Los demás átomos tratan de completar el número de ocho electrones hasta configurarse como los gases nobles. Es decir, los que tienen un electrón se combinan con los que tienen siete electrones.

Un equipo de científicos del Instituto de Astrofísica de las Canarias (IAC) y la Universidad de Texas lograron identificar una de las moléculas orgánicas más complejas encontradas hasta ahora en la materia entre las estrellas, el llamado espacio interestelar. El descubrimiento del antraceno podría ayudar a resolver un misterio astrofísico de décadas de antigüedad sobre la producción de las moléculas orgánicas en el espacio.

Buscar moléculas de azucar en el espacio exterior, sería una manera de acercarnos a posibles formas de vida en las que, estas moléculas están presentes y, como sabéis (la imagen de arriba lo demuestra), han sido halladas tales moléculas por el potente radioteslecopio ALMA en el norte de Chile que permitió detectarlas moléculas en torno a una estrella joven, similar al sol, un inédito hallazgo para la ciencia, según el Observatorio Europeo Austral (ESO).

Este espectro tomado por el telescopio espacial de infrarrojos HERSCHEL ilustra la variedad molecular existente en una nube interestelar como la de Orión. Agua, monóxido de carbono, metanol, formaldehído, cianuro de hidrógeno, óxidos de azufre y otras moléculas (de las cuales hay muchas aún sin identificar) dejan sus firmas inequívocas en la emisión del infrarrojo lejano que se origina en la nebulosa. El espectro se muestra superpuesto a una imagen (también infrarroja) tomada por el telescopio espacial Spitzer.

Muchas son ya las moléculas de la vida ahí encontradas. Si una sustancia está formada por un único tipo de átomos, diremos que es un elemento. Cuando una molécula está formada por átomos de distintos tipos, la sustancia se llama compuesto. El agua es un compuesto: su molécula consta de dos átomos de hidrógeno unidos por un enlace químico (electromagnético) a un átomo de oxígeno. El número de átomos que constiruyen la molécula de un compuesto puede variar desde dos o tres hasta las decenas de miles que conforman la molécula de un complejo proteínico.

Si miramos esta imagen de visión de rayos X de un cristal de hielo que tiene simetría exagonal, es la equivalente a multiplicar el original por 100000000. Los átomos de oxíogeno se representan como bolas rojas y los de Hidrógeno como bolas azules más pequeñas. Todos los enlaces entre estos átomos se representan como barras blancas para resaltar la red hexagonal en forma de colmena que forma el conjunto de moléculas de H2O.

En el agua líquida también hay molécuklas de H2O, pero en ese caso se encuentran más calientes que en el hielo. Lo que significa que se mueven mñás libremente y de hecho esa es la razón de que el agua sea un líquido sin forma propia y se adapta al recipiente que lo contiene. Pero si el agua se congela, las fuerzas de interacción entre las moléculas de H2O ganan a las fuerzas derivadas del movimiento térmico y forman un conjunto rígido que presenta su estado más estable (de menor energía) cuando se ordenan… precisamente con simetría Hexagonal.

Por eso los cristales de nieve son siempre hexagonales. La estructura de los cristales a nivel atómico determina su forma final. Y este no es un ejemplo aislado. La composición y la estructura a nivel atómico y molecular es la clave que determina la estructura, dureza y demás propiedades en general de todos los materiales que nos rodean. Hasta aquí llegan las escalas de estructuras básicas.

Naturalmente, podemos hablar de unidades todavía mayores, como los minerales y las rocas. Un mineral es, simplemente un elemento o un compuesto en estado sólido que se encuentra en la Naturaleza y que no es el resultado de un proceso biológico; pero si un mineral presenta una, se trata de una estructura cristalina derivada de la colocación de sus moléculas. Las rocas son, sencillamente, mezclas de uno o más minerales diferentes. Como sabemos, las rocas presentan a veces algún tipo de dibujo , como los estratos horizontales de las rocas sedimentarias, pero el trazado es de tan bajo nivel que no se piueden llegar a tomar en consideración cuestiones de simetría como las que antes hemos referido.

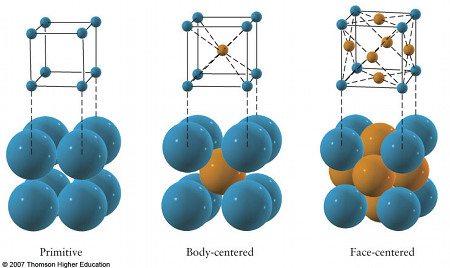

Si comenzamos por la parte más alta de la escala, con la estructura de los cristales y seguir bajando por dicha escala hasta la selva subatómica de las partículas elementales. Sólo los sólidos tienen estructura cristalina. Las moléculas de un gas están tan alejadas las unas de las otras que tienen la libertad de moverse al azar, y es imposible encontrar un modelo geométrico sistemático en su disposición. Os acordáis las formas arabescar de increíble belleza que adoptan, los gases en algunas Nebulosas.

Si hablamos de las moléculas de un líquido, asl contrario de lo que ocurre con las moléculas de los gases, éstas están más juntas y próximas entre ellas, pero todavía son lo suficientemente libres en sus movimientos como para que no se puedan formar modelos fijos. Los sólidos, por otra parte, tienen moléculas que se aprietan estrechamente entre sí para poder crear una estructura rígida y estable. (En realidad, los átomos de un sólido siguen oscilando, pero las fuerzas electromagnéticas las enlazan tan estrechamente que sus oscilaciones son practicamente posiciones fijas. Para nuestro propósito supondremos que los átomos no tienen movimiento alguno.) En casi todos los casos se estereotipa esta dispoosición sistemática, que constituye la estructura cristalina del sólido.

El agua en sus tres estados: hielo, agua líquida y vapor en las nubes

Consideremos el agua. Tanto en su estado gaseoso (vapor) como líquido, sus moléculas están en una disposición caótica, pero cuando se hiela y pasa al estado sólido, las moléculas se agrupan entre sí en forma de figuras geométricas. El bello cristal de nieve, con simetría hexagonal, como el dibujo de un caleidoscopio, toma su forma directamente d ela forma cristalina subyacente de las moléculas de hielo de su congelador a los gigantescos Icebergs del Ártico, todos tienen la misma estructura cristalina.

Casi todas las sustancias sólidas son cristalinas, aunque el vidrio es una excepción sobresaliente; se origina al enfriarse determinados líquidos de manera tan rápida que las moléculas se agrupan estrechamente antes de tener la menor opción a disponerse de forma ordenada. Sólido o no no, un cristal no es cristalino. El vidrio tallado de un bello jarrón que es “cristal” para el dependiente de la tienda, no es cristal para el físico.

Las pitonisas que utilizan esferas pulidas procedentes de grandes cristales de cuarzo simples para predecir el futuro mirando a su través, hoy en día lo hacen a menudo a través de esferas de vidrio, puesto que son más baratas. Sería interesante saber si el futuro parece más claro mirándolo por un material en desorden o bien a través de una estructura ordenada.

Los sólidos no cristalinos se llaman amorfos; algunos químicos hablan de ellos como sólidos líquidos ya que, igual que éstos últimos, , carecen de estructura cristalina. El carbón vegetal, las breas y ciertos plásticos, son ejemplos familiares, sustancias que participan con los líquidos en la tendencia a “fluir”, aunque la capacidad de flujo puede ser extremadamente lenta. Incluso el vidrio acabaría fluyendo fuera de su forma si no se tocara durante algunos cientos de años.

La forma geométrica subyacente de cualquier sustancia cristalina se denomina la red de la misma. Unas veces es una configuración de átomos; otras de moléculas. El dióxido de Carbono, por ejemplo, se encuentra en la naturaleza en forma de gas; cuando su temperatura disminuye lo suficiente, se solidifica y se convierte en lo que se llama hielo seco. (Recibe el nombre de seco porque nunca se convierte en líquido, como el hielo ordinario; pasa directamente de sólido a gas.) En él, las moléculas de dióxido de carbono se agrupan entre sí formando la red cúbica con estructura semejante a las vigas de acero de un edificio de oficinas. Las moléculas situadas en las caras de cada cubo dan a esta red concreta el nombre de red cúbica de caras centradas, es decir, así:

Aquí, cada unidad es una molécula de Dióxido de Carbono.

La sal es uno de los minerales que más abunda en la Tierra. Su nomenclatura química, Cloruro de Sodio, se debe a sus dos iones componentes: cloro y sodio. La estructura de este compuesto, es un cristal con forma de cubo, en la que los átomos de cloro y sodio, dispuestos alternadamente, forman una red cúbica que se va repitiendo con la misma orientación en toda la sustancia, formando una red cristalina.

La sal no sólo sirve para sazonar. Sus iones son fundamentales para la transmisión de impulsos nerviosos, para los latidos del corazón, para la contracción muscular y para desencadenar una respuesta inmune. ¡La próxima vez que aliñen una ensalada, piensen en esto!

No se debe pensar que, por estar por debajo del campo de visión de un microscopio, estas estructuras reticulares no son sino construcciones teóricas que los físicos no han sido capaces de observar. Hubo un tiempo en que esto era así, pero en la actualidad existen muchas técnicas que permiten “ver” estructuras mucho más pequeñas que las que pueden ser vistas directamente. Hoy día, los microscopios electrónicos nos permiten ver lo que nunca pudimos.

Aprecien como se forma la red de fibras que hace posible la cicatrización de una herida.

Aqui podemos ver un cristal de óxido de zinc, unido a una malla amorfa de carbono.

Lo que vemos aquí es el cuerpo tratando de curarse a sí mismo. Los objetos con forma de cigarro de color amarillo son las bacterias de la tuberculosis. En torno a ella aparecen los macrófagos. Un macrófago es un fagocito, son células que nos protegen de objetos extraños.

Las esferas que pueden verse aquí son las esporas creadas por el hongo Emericella nidulans. Producen la hidrofobina proteína que hace que las esporas resistentes al agua.

¿Ha tenido caries en los dientes? Caries es causada por la bacteria Streptococcus mutans que convierte el azúcar queda en la superficie de sus dientes a los ácidos. Ese ácido corroe el esmalte dental provocando la caries. Aquí en color azul los Streptococcus mutans está atacando la superficie de un diente.

Explorar el misterio del spin del protón ha sido uno de los objetivos de la investigación científica fundamental en el RHIC

Hemos podido alcanzar a “ver” objetos y figuras estacionadas en esas distancias infinitesimales, nuestros ingenios tecnológicos pueden aumentar, en millones de veces, las proporciones físicas de pequeños objetos y sistemas. Hasta tal punto es así que, si pudiéramos tener delante de nuestros ojos lo que esos experimentos han logrado, nos parecería estar, en un mundo diferente, tan extraña y figuras podríamos contemplar en ese ámbito de lo muy pequeño.

Descendiendo muchísimo en la escala y si consideramos las moléculas como unidades individuales, completamente diferenciadas en los que puedan estar sumergidasa, ¿tienen siempre una estructura simétrica? Si es así, cuando un compuesto dse halla en la Naturaleza o bien se crea en el laboratorio, sus moléculas serán siempre iguales y el compuesto tendrá siempre las mismas propiedades, pero si una molécula está formada por una estructura asimétrica de átomos, sería posible encontrar, o crear en el laboratorio, dos formas completamente distintas del mismo compuesto. Una de ellas contrendría exclusivamente moléculas orientadas hacia la derecha; la otra, moléculas orientadas hacia la izquierda. Las dos imágenes serían la imagen especular de las de la otra.

Una molécula con n estereocentros tiene un máximo de 2n estereoisómeros.

Me gustaría contaros aquí y en este momento, la sensacional historia del descubrimiento de los esteroisómeros pero, no teniendo mucho espacio para finalizar el trabajo, lo dejaré para otra ocasión. Digamos, sin embargo que, el descubrimiento de las moléculas con orientación iaquierda o derecha comenzó en Francia durante la primera parte del siglo XIX. Jean Baptiste Biot, un renombrado físico y químico francés, había descubierto la propiedad de los cristales de cuarzo de desviar un plano de luz polarizada. Una sustancia que tenga esa propiredad se dice que es ópticamente activa.

Bueno amigos lectores, no siempre tenemos que hablar de grandes galaxias y espacios inconmensurables, y, de vez en cuando, conviene bajar a las profundidades del “universo infinitesimal” en el que viven partículas, átomos y moléculas que, como todo en la Naturaleza están sometidas a una serie de leyes que rigen sus comportamientos y, conocerlos, saber lo que allí pueda pasar, es bastante lucrativo para poder aplicar, dichos conocimientos a este mundo macroscópico nuestro y saber, por qué ocurren ciertas cosas en nuestro “gran mundo”.

Ya sabéis: ¡Todo lo grande está hecho de cosas pequeñas!

emilio silvera