Dic

15

De nuevo con el LHC

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

La gran máquina científica “abrirá nuevos horizontes de la física”, dice el director del CERN. Tratará de duplicar su energía.

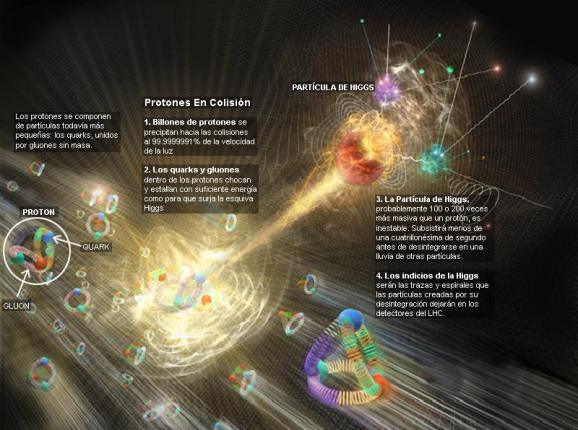

“Tras dos años parado para acometer el reacondicionamiento técnico necesario, el gran acelerador de partículas LHC, junto a Ginebra, empieza a prepararse para que vuelva a estar operativo, en la próxima primavera, casi al doble de energía de la alcanzada hasta ahora. Los científicos, que descubrieron en las colisiones de partículas generadas en esa gran máquina el histórico bosón de Higgs, en el verano de 2012, se preparan ahora para llevar más lejos todavía la exploración del universo subatómico. Todo el anillo de 27 kilómetros del acelerador, instalado en un túnel bajo la frontera entre Francia y Suiza, está ya enfriado hasta los 1,9 grados sobre el cero absoluto (271 grados centígrados bajo cero) que exige su funcionamiento. Con las operaciones técnicas acometidas en estos dos años, el LHC funcionará a partir de ahora, y durante un par de años al menos, a 13 teralectronvoltios (TeV), casi la energía para la que fue diseñado (14 TeV) y casi el doble de la alcanzada en su operación durante la fase anterior (de 2010 y 2013), que llegó a los ocho TeV en las colisiones. Esta misma semana todos los imanes de un sector del acelerador (un octavo del anillo) han recibido ya energía hasta el nivel necesario para alcanzar los 13 TeV. El resto se irá activando en los próximos dos o tres meses.

“Después de muchísimo trabajo realizado en los últimos dos años, el LHC es casi como una nueva máquina”, ha declarado Fréderick Bordry, director de Aceleradores y Tecnología del Laboratorio Europeo de Física de Partículas (CERN), donde está el acelerador. “El rearranque de este extraordinario acelerador está lejos de ser una operación rutinaria”, continúa. “Pese a ello, confío en que cumpliremos el calendario para proporcionar colisiones de partículas a los científicos en mayo”.

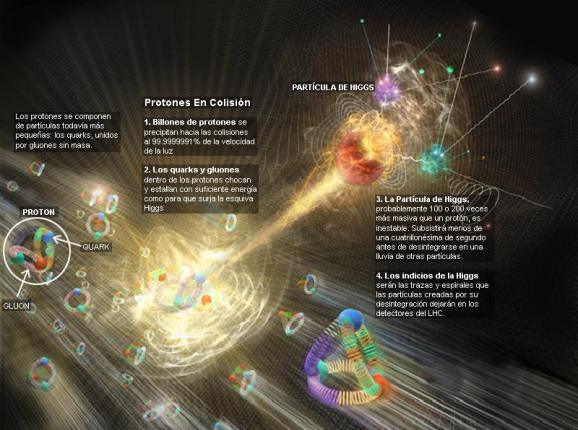

En el LHC circulan, en direcciones opuestas, haces de protones acelerados casi hasta la velocidad de la luz que se hacen chocar frontalmente en los cuatro puntos del anillo donde están los cuatro enormes detectores (ATLAS, CMS, LHCb y ALICE) con los que los físicos registran los resultados de esas colisiones. Cada haz debe llegar ahora a 6,5 TeV (se llegó a 4 TeV en la fase anterior de operación), de manera que la energía en las colisiones sea de 13 TeV. El análisis de esos datos sobre las partículas que se destruyen y se crean como resultado de los billones de choques por segundo, permite profundizar en el conocimiento de los componentes elementales de todo lo que existe y las leyes por las que se rigen.

“Con el nuevo nivel de energía, el LHC abrirá nuevos horizontes de la física y de futuros descubrimientos. Estoy ansioso por ver qué nos tiene preparada la naturaleza”, comenta el director del CERN, Rolf Heuer en un comunicado de la institución.

Ningún acelerador de partículas existente en el mundo ha llegado a los 8 TeV del LHC, y mucho menos a los 13 TeV en las colisiones que ahora debe alcanzar. En septiembre de 2008, al poco tiempo de iniciarse la inyección de haces de protones, una avería provocó graves daños en la máquina, lo que exigió 14 meses de reparaciones antes de volver a ponerla en marcha. Una mala conexión entre grandes imanes hizo que perdieran su condición de superconductores (enfriados hasta casi el cero absoluto pierden su resistencia eléctrica), generándose daños mecánicos en un tramo de casi 800 metros del acelerador así como pérdida del helio refrigerante. Tras la reparación se decidió arrancar y operar el acelerador pero no a la máxima energía planeada y aplazar algunas reformas técnicas necesarias para alcanzarla.

Estoy ansioso por ver qué nos tiene preparada la naturaleza”

El acelerador está formado por más de 1200 grandes imanes superconductores y los potentes campos magnéticos generados permiten guiar los haces de partículas que se hacen colisionar. Para ponerlo a punto ahora ha sido necesario, entre otras operaciones de seguridad, reforzar 1.700 conexiones entre imanes. El sector ya preparado, un octavo de la circunferencia, está formado por 154 imanes que han alcanzado ya los 11.000 amperios necesarios (unas mil veces más que un dispositivo eléctrico casero) para generar campos magnéticos suficientemente intensos que curven la trayectoria de las partículas a una energía de 6,5 TeV.

La puesta en marcha del acelerador es una operación compleja. “Igual que los atletas de alto nivel, los imanes del LHC tienen que pasar un intenso programa de entrenamiento para alcanzar la energía requerida”, explica el CERN. En los imanes se va a aumentando gradualmente la corriente eléctrica porque se pueden generar pequeños movimientos con el riesgo de provocar la pérdida de su condición de superconductores. Tras el primer octavo del anillo, el resto de sectores tienen que ir poco a poco pasando este entrenamiento hasta que estén todos listos para recibir los primeros haces de protones. Luego hay que ajustar y calibrar los haces para obtener las colisiones de la máxima calidad que los físicos requieren en sus detectores para extraer la información científica.”

Fuente: El Pais

Dic

15

El vacío superconducto – La máquina de Higgs-Kibble

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (5)

Comments (5)

Lo único que no resulta ser lo mismo cuando se mira a través del microscopio (o, en la jerca de la física teórica, cuando se realiza una transformación de escala) es la masa de la partícula. Esto se debe a que el alcance de la fuerza parece mayor a través del microscopìo y, por lo tanto, la masa de la partícula parece ser menor. Nótese que esta situación es la opuesta a la que se presenta en vida corriente donde un grano de arena parece mayor -¿más pesado, por lo tanto?- cuando se observa con un microscopio.

Granos de arena vistos al microscopio

Una consecuencia de todo esto es que en una teoría de Yang-Mills el termino de masa parece desaparecer cuando se realiza una transformación de escala, lo que implica que a través del microscopio se recupera la invariancia gauge. Esto es lo que causa la dificultad con la que se enfrentó Veltman. ¿Se puede observar directamente el potencial vector de Yang-Mills? Parece que puede observa4rse en el mundo de las cosas grandes, pero no en el mundo de lo pequeño. Esto es una contradicción y es una raz´`on por la que ese esquema nunca ha podido funcionar adecuadamente.

En 2009, la empresa canadiense D-Wave Systems, conjuntamente con la NASA, desarrolló un ordenador cuántico de 128 cubits. Rainer contiene 128 dispositivos físicos (pequeños aros de metal niobidio) que a muy baja temperatura actúan como sistemas cuánticos con dos niveles (es decir, cubits) como consecuencia de la superconductividad.

¡Había una salida! Pero ésta procede de una rama muy diferente de la física teórica, la física de los metales a muy bajas temperaturas. A esas temperaturas, los “fenómenos cuánticos” dan lugar a efectos muy sorprendentes, que se describen con teorías cuánticas de campos, exactamente iguales a las que se utilizan en la física de partículas elementales. La física de partículas elementales no tienen nada que ver con la física de bajas temperaturas, pero las matemáticas son muy parecidas.

En algunos materiales, el “campo” que se hace importante a temperaturas muy bajas podría ser el que describe cómo los átomos oscilan alrededor de sus posiciones de equilibrio, o el que describe a los electrones en este tipo de material. A temperaturas muy baja nos encontramos con los “cuantos” de esos campos. Por ejemplo, el “fonón” es el cuanto del sonido. Su comportamiento recuerda al fotón, el cuanto de la luz, salvo que los números son muy diferentes: los fonones se propagan con la velocidad del sonido, a cientos o quizá miles de metros por segundo, y los fotones lo hacen a la velocidad de la luz que es de 300.000 km/s, ¡aproximadamente un millón de veces más deprisa! Las partículas elementales en las que estamos interesados generalmente tienen velocidades cercanas a las de la luz.

El fonon es la partícula elemental del sonido, como el foton lo es en la luz...

Uno de los “fenómenos cuánticos” más espectaculares que tienen lugar en los materiales muy fríos es la llamada superconductividad, fenómeno consistente en el hecho de que la resistencia que presenta ese material al paso de la corriente eléctrica se hace cero. Una de las consecuencias de ese estado es que el material no admite la más mínima diferencia de potencial eléctrico, porque ésta sería inmediatamente neutralizada por una corriente eléctrica “ideal”. El material tampoco admite la presencia de campos magnéticos porque, de acuerdo con las ecuaciones de Maxwell, la creación del campo magnético está asociada con una corriente eléctrica inducida, que al no encontrar resistencia neutralizaría completamente el campo magnético. Por lo tanto, en el interior de un superconductor no se puede crear ni un campo electrónico ni magnético. Esta situación sólo cambia si las corrientes inducidas son muy elevadas, como ocurre cuando se somete el superconductor a los campos de imanes muy potentes y que perturban el material. No siendo capaz de resistir una fuerza tan brutal, pierde la superconductividad y se rinde permitiendo la existencia de un campo magnético en su interior.

¿Pero, qué tiene que ver un superconductor con las partículas elementales? Bien, un material superconductor se puede entender como un sistema en el cual el campo electromagnético es un campo de muy corto alcance. Está siendo apantallado y, sin embargo, es un campo de Maxwell, un campo gauge. ¡Esto es lo que hace interesante un superconductor para alguien que quiera describir la interacción débil entre partículas como una teoría gauge! ¡Qué característica tan bella de la física teórica! Se pueden comparar dos mundos completamente diferentes simplemente porque obedecen a las mismas ecuaciones matemáticas.

¿Cómo funciona un superconductor? La verdadera causa de este fenómeno peculiar la descubrieron John Bardeen, Leon N. Cooper y John R. Schrieffer por lo que recibieron el premio Nobel en 1972). Los electrones de un trozo sólido de material tienen que reunir al mismo tiempo dos condiciones especiales para dar lugar a la superconductividad: la primera es apareamiento y la segunda condensación de Bose.

“Apareamiento” significa que los electrones forman pares y actúan en pares, y los que producen la fuerza que mantiene los pares unidos son los fonones. En cada par, los electrones rotan alrededor de su propio eje, pero en direcciones opuestas, de manera que el par (llamado “par de Cooper”), en su conjunto, se comporta como si no tuviera rotación (“momento angular”). Así, un par de Cooper se comporta como una “partícula” con espín 0 y carga eléctrica -2.

La “condensación de Bose” es un fenómeno típicamente mecánico-cuántico. Sólo se aplica a partículas con espín entero (bosones). Al igual que los lemmings, los bosones se agrupan juntos en el estado de menor energía posible, Recuérdese que a los bosones les gusta hacer a todos la misma cosa. En este estado todavía se puede mover, pero no pueden perder más energía y, en consecuencia, no sufren ninguna resistencia a su movimiento. Los pares de Cooper se mueven libremente, de manera que pueden crear corrientes eléctricas que no encuentran ninguna resistencia. Un fenómeno parecido tiene lugar en el helio líquido a muy bajas temperaturas. Aquí los átomos de helio forman una condensación de Bose y el líquido que forman puede fluir a través de los agujeros más pequeños sin la más mínima resistencia.

Condensado de Bose-Einstein

Como los electrones por separado tienen espín ⅟₂ no pueden sufrir una condensación de Bose. Las partículas cuyo espín es igual a un entero más un medio (fermiones) tienen que estar en estados cuánticos diferentes debido al principio de exclusión de Pauli. Esta es la razón por la que la superconductividad sólo se puede producir cuando se forman pares. Sí, comprendo que estas afirmaciones le sugerirán varias preguntas y me disculpo por adelantado, pero de nuevo he traducido fórmulas a palabras, lo que implica que el razonamiento pueda parecer poco satisfactorio. ¡Simplemente tome esto como una cierta “lógica cuántica” difícil de manejar! Fueron el belga François Englert, el americano Robert Brout y el inglés Peter Higgs los que descubrieron que la superconductividad podría ser importante para las partículas elementales. Propusieron un modelo de partículas elementales en el cual partículas eléctricamente cargadas, sin espín, sufrían una condensación de Bose. Esta vez, sin embargo, la condensación no tenía lugar en el interior de la materia sino el vacío. Las fuerzas entre las partículas tenían que ser elegidas de tal manera que se ahorrara más energía llenando el vacío de estas partículas que dejándolo vacío. Estas partículas no son directamente observables, pero podríamos sentir el estado, en cuyo espacio y tiempo están moviéndose las partículas de Higgs (como se las conoce ahora) con la mínima energía posible, como si el espacio tiempo estuviera completamente vacío.

Haber encontrado el bosón de Higgs puede resolver el misterio de la composición de masa de todos los objetos. Esta masa está presente en las partículas subatómicas y sin ellas la materia sólida no podría existir. El bosón de Higgs está relacionado a un campo energético, que se llama el campo de Higgs, el mismo que está presente en todo el universo de igual forma como el agua inunda una piscina. Es formando parte de ese campo, que las diversas partículas, como los protones, neutrones, electrones y otras, adquieren su masa. Las partículas más pequeñas encuentran menos dificultades para desplazarse, y las más grandes lo hacen con mayor dificultad. De todas las maneras, quedan muchas por explicar. Fandila nos prguntaba que, ¿de dónde adquiere su masa el mismo Bosón de Higgs?

Las partículas de Higgs son los cuantos del “campo de Higgs”. Una característica de este campo es que su energía es mínima cuando el campo tiene una cierta intensidad, y no cuando es nulo. Lo que observamos como espacio vacío no es más que la configuración de campo con la menor energía posible. Si pasamos de la jerga de campos a la de partículas, esto significa que el espacio vacío está realmente lleno de partículas de Higgs que han sufrido una condensación Bose”.

Este espacio vacío tiene muchas propiedades en común con el interior de un superconductor. El campo electromagnético aquí también es de corto alcance. Esto está directamente relacionado con el hecho de que, en tal mundo, el fotón tiene una cierta masa en reposo.

Y aún tenemos una simetría gauge completa, es decir, la invariancia gauge no se viola en ningún sitio. Y así, sabemos cómo transformar un fotón en una partícula “con masa” sin violar la invariancia gauge. Todo lo que tenemos que hacer es añadir estas partículas de Higgs a nuestras ecuaciones.

La razón por la que el efecto de invariancia gauge en las propiedades del fotón es tan diferente ahora es que las ecuaciones están completamente alteradas por la presencia del campo de Higgs en nuestro estado vacío. A veces se dice que “el estado vacío rompe la simetría espontáneamente”. Esto no es realmente correcto, pero el fenómeno está muy relacionado con otras situaciones en las que se produce espontáneamente una rotura de simetría.

Higgs sólo consideró campos electromagnéticos “ordinarios”, pero, desde luego, sabemos que el fotón ordinario en un vacío auténtico no tiene masa en reposo. Fue Thomas Kibble el que propuso hacer una teoría de Yang-Mills superconductora de esta forma, simplemente añadiendo partículas sin espín, con carga de Yang-Mills en vez de carga ordinaria, y suponer que estas partículas podían experimentar una condensación de Bose. Entonces el alcance de las interacciones de Yang-Mills se reduce y los fotones de Yang-Mills se convierten en partículas con espín igual a 1 y masa distinta de cero.

La discontinuidad manifiesta junto con la invariancia de escala (autosemejanza), que presenta la energía de las fluctuaciones del vacío cuántico. Las consecuencias de la existencia del cuanto mínimo de acción fueron revolucionarios para la comprensión del vacío. Mientras la continuidad de la acción clásica suponía un vacío plano, estable y “realmente” vacío, la discontinuidad que supone el cuanto nos dibuja un vacío inestable, en continuo cambio y muy lejos de poder ser considerado plano en las distancias atómicas y menores. El vacío cuántico es de todo menos vacío, en él la energía nunca puede quedar estabilizada en valor cero, está fluctuando sobre ese valor, continuamente se están creando y aniquilando todo tipo de partículas, llamadas por eso virtuales, en las que el producto de su energía por el tiempo de su existencia efímera es menor que el cuanto de acción. Se llaman fluctuaciones cuánticas del vacío y son las responsables de que exista un campo que lo inunda todo llamado campo de punto cero.

Algunos físicos proponen una controvertida teoría en la que un extraño tipo de materia, el Singlet de Higgs, se movería hacia el pasado o el futuro en el LHC. ¡Qué imaginación! Claro que, puestos a imaginar…

Bien sabido es que mientras más profundizamos en el conocimiento de los secretos del mundo que nos rodea, más interrogantes y misterios sin resolver se nos muestran. Cada vez que abrimos una puerta, llegamos a una habitación que tiene otras muchas por abrir. Es la búsqueda incesante del hombre, su insoslayable afán por saber el por qué, el cómo y el cuándo de todas las cosas.

¿Estaremos entrando en una especie de locura?

Bueno…

Por su parte, el científico británico Peter Higgs, de 80 años, que dio su nombre a la llamada “partícula divina” en 1964, afirmó que cree que su Bosón seríaá hallado gracias al Gran Colisionador. “Creo que es bastante probable” dijo pocas horas después de que entrara en funcionamiento el gigantesco acelerador. Y, según parece, se está saliendo con la suya.

De todas las maneras, estaría bien saber, a ciencia cierta, cómo es el campo de Higgs del que toman la masa todas las partículas, y conocer, mediante que sistema se transfieren la masa, o, si cuando las partículas entran en el campo de Higgs e interracionan con él, es el efecto frenado el que les otorga la masa como nos dice nuestro amigo Ramón Marques en su teoría.

emilio silvera

Dic

9

En Física hablamos de masa, inercia…, ¡de tántas cosas! Pero, son...

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (2)

Comments (2)

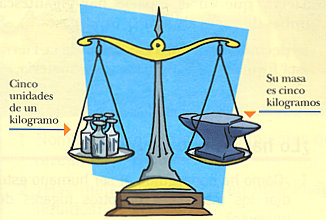

Cuando hablamos de masa, nos estamos refiriendo a la medida de la inercia de un cuerpo, es decir, su resistencia a la aceleración. Todos sabemos la inmensa cantidad de combustible que se necesita para enviar al espacio exterior a esos transbordadores que llevan suministros y astronáutas al espacio exterior para el mantenimeinto de la Estación Espacial Internacional. El esfuerzo, es vencer la masa que se quiere transportar hasta que esta, alcanzando los 11 km/s de velocidad, pueda escapar de la fuerza de gravedad de la Tierra y poder así, cumplir con su cometido.

De acuerdo con las leyes de Newton del movimiento, si dos masas distintas, m1 y m2, son hechas colisionar en ausencia de cualquier otra fuerza, ambas experimentaran la misma fuerza de colisión. Si los dos cuerpos adquieren aceleraciones a1 y a2, como resultado de la colisión, entonces m1 a1 = m2 a2. Esta ecuación permite comparar dos masas. Si una de las masas se considera como una masa estándar, la masa de todas las demás puede ser medida comparándola con esta masa estándar. El cuerpo utilizado para este fin es un cilíndro de un kilógramo de una aleación de platino iridio. llamado el estándar internacional de masa. La masa definida de esta forma es llamada masa inercial del cuerpo.

Las masas también se pueden definir midiendo la fuerza gravitacional que producen. Por tanto, de acuerdo con la ley de gravitación de Newton, mg = Fd2 / MG, donde M es la masa de un cuerpo estándar situado a una distancia d del cuerpo de masa mg; F es la fuerza gravitacional entre ellos, y G es la constante gravitacional. La masa definida de esta forma es la masa gravitacional. En el siglo XIX, Roland Eötvös (1848-1919) demostró experimentalmente que las masas inerciales y gravitatorias son indistinguibles, es decir, m1 = mg.

Aunque la masa se define formalmente utilizando el concepto de inercia, es medida habitualmente por gravitación. El peso (W) de un cuerpo es la fuerza con la que un cuerpo es atraído gravitacionalmente a la Tierra, corregido por el efecto de la rotación, y es igual al producto de la masa del cuerpo y la aceleración en caída libre (g), es decir, W = mg.

Kilogramo patrón.

El kilogramo (unidad de masa) tiene su patrón en: la masa de un cilindro fabricado en 1880, compuesto de una aleación de platino-iridio (90 % platino – 10 % iridio), creado y guardado en unas condiciones exactas, y que se guarda en la Oficina Internacional de Pesos y Medidas en Sevres, cerca de París.

|

| Una balaza mide solo cantidad de masa. |

La masa es la única unidad que tiene este patrón, además de estar en Sevres, hay copias en otros países que cada cierto tiempo se reúnen para ser regladas y ver si han perdido masa con respecto a la original.

No olvidemos que medir es comparar algo con un patrón definido universalmente.

¿Y el peso?

De nuevo, atención a lo siguiente: la masa (la cantidad de materia) de cada cuerpo es atraída por la fuerza de gravedad de la Tierra. Esa fuerza de atracción hace que el cuerpo (la masa) tenga un peso, que se cuantifica con una unidad diferente: el Newton (N).

La UNIDAD DE MEDIDA DEL PESO ES EL NEWTON (N)

Entonces, el peso es la fuerza que ejerce la gravedad sobre una masa y ambas magnitudes son proporcionales entre sí, pero no iguales, pues están vinculadas por el factor aceleración de la gravedad.

En el lenguaje común, el peso y la masa son frecuentemente usados como sinónimos; sin embargo, para fines científicos son muy diferentes. La masa es medida en kilogramos; el peso, siendo una fuerza, es medido en newtons (símbolo N. Unidad del SI de la fuerza, siendo la fuerza requerida para comunicar a una masa de un kilogramo una aceleración de 1 m s –2). Es más, el peso depende de donde sea medido, porque el valor de g es distintos en diferentes puntos de la superficie de la Tierra. La masa, por el contrario, es constante donde quiera que se mida, sujeta a la teoría especial de la relatividad. De acuerdo con esta teoría, publicada por Albert Einstein en 1905, la masa de un cuerpo es una medida de su contenido total de energía.

Por tanto, si la energía del cuerpo crece, por ejemplo, por un aumento de su energía cinética o temperatura, entonces su masa también crece. De acuerdo con esta ley, un aumento de energía ΔE está acompañado de un aumento de masa Δm, en conformidad con la ecuación de masa-energía Δm = ΔE/c2, donde c es la velocidad de la luz. Por tanto, si un kilo de agua se eleva de temperatura en 100 K, su energía interna aumentará en 4 x 10 –12 kg. Este es, por supuesto, un incremento despreciable y la ecuación de masa-energía es sólo significativa para energías extremadamente altas. Por ejemplo, la masa de un electrón es siete veces mayor si se mueve con relación a un observador al 99% de la velocidad de la luz.

Ya sabemos que, se ha comprobado una y mil veces que, la teoría de Einstein de la relatividad especial es cierta en el sentido de que, al ser la velocidad de la luz el límite de velocidad del Universo, nada puede ir más rápido que la luz, cuando un cuerpo viaja a velocidades cercanas a la de la luz, a medida que se acerca a ella, puede ver como su masa aumenta, ya que, la energía de movimiento se convierte en masa al no poder conseguir su objetivo de marchar más rápido que la luz.

En los anillos enterrados en las entrañas de la Tierra, haces de partículas son lanzadas a la velocidad de la luz para que colisionen y, su peso aumenta conforme se van acercando a ese límite marcado por el universo.

La masa relativista de un cuerpo medida por un observador (un físico del LHC que mide el aumento de masa de los protones a medida que adquieren velocidad en el acelerador de partículas del CERN) con respecto al cual este cuerpo se mueve. De acuerdo con la teoría de Einstein, la masa m de un cuerpo moviendose a velocidad v está dada por m = m0/√ (1 – v2 / c2), donde m0 es su masa en reposo y c es la velocidad de la luz. La masa relativista solo difiere significativamente de la masa en reposo si su velocidad es una fracción apreciable de la velocidad de la luz. Si v = c/2, por ejemplo, la masa relativista es un 15% mayor que la masa en reposo.

Según las consecuencias obtenidas en el proyecto Manhattan, lo que sí es seguro es que, una pequeña fracción de materia, contiene una gran cantidad de energía. Según nos decía Asimov: “…un sólo gramo de materia se podría convertir en energía eléctrica que bastaría para mantener luciendo continuamente una bombilla de 100 vatios durante unos 28.200 años. O bien, la energía que representa un sólo gramo de materia es equivalente a la que se obtendría de quemar unos 32 millones de litros de gasolina”.

Una cosa si que nos puede quedar muy clara: Aunque sabemos algunas cosas sobre la masa y lo que entendemos por la energía, no podemos decir que, al día de hoy, “sepamos de verdad”, lo que la masa y la energía son.

Seguiremos aprendiendo. Sin embargo, nunca dejes de tener en cuenta que, lo que es cierto hoy, mañana será una verdad distinta. Todo dependen de la teoría aceptada en el momento, toda vez que, con el paso del tiempo las ideas evolucionan y todo es mejorables a medida que nuestros conocimientos avanzan. Así que la idea que podamos tener de Gravedad, masa, energía e inercia, mañana podría ser distinta a la que hoy podamos tener.

emilio silvera

Dic

7

Consecuencias Biológicas si las constante fuesen variables

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Lo que sucede primero, no es necesariamente el principio. Antes de ese “Principio”, suceden algunas cosas que nosotros no hemos podido o sabido percibir. Sin embargo, hay cosas que no cambian nunca. Hace tiempo, los sucesos que constituían historias eran las irregularidades de la experiencia. Sabemos que lo que no cambia son las Constantes de la Naturaleza pero, tampoco cambia el Amor de una madre por un hijo, la salida y la puesta del Sol, nuestra curiosidad, y otras muchas cosas que conviven con nosotros en lo cotidiano.

No varían con el paso del Tiempo. Existen muchas constantes físicas; algunas de las más conocidas son la constante de Planck racionalizada  , la constante de gravitación

, la constante de gravitación  , la velocidad de la luz

, la velocidad de la luz  , la permitividad en el vacío

, la permitividad en el vacío  psilon, La constante de estructura fina α, la permeabilidad magnética en el vacío

psilon, La constante de estructura fina α, la permeabilidad magnética en el vacío  y la carga elemental

y la carga elemental  . Todas éstas, por ser tan fundamentales, son llamadas constantes universales. La Constante de Gravedad es la más imprecisa de todas ellas y nunca la hemos sabido medir con una gran precisión a pesar de Newton y Einstein. La Gravedad, también es una constante porque se comporta siempre de la misma manera en circunstancias similares. El resultado de sus mediciones resultarán exactamente iguales en las mismas circunstancias y lugares. Aunque la precisión no sea tan grande como las que pueden ser obtenidas al medir otras constantes como la de la luz, por ejemplo.

. Todas éstas, por ser tan fundamentales, son llamadas constantes universales. La Constante de Gravedad es la más imprecisa de todas ellas y nunca la hemos sabido medir con una gran precisión a pesar de Newton y Einstein. La Gravedad, también es una constante porque se comporta siempre de la misma manera en circunstancias similares. El resultado de sus mediciones resultarán exactamente iguales en las mismas circunstancias y lugares. Aunque la precisión no sea tan grande como las que pueden ser obtenidas al medir otras constantes como la de la luz, por ejemplo.

Poco a poco, los científicos llegaron a apreciar el misterio de la regularidad y lo predecible del mundo. Pese a la concatenación de movimientos caóticos e impredecibles de átomos y moléculas, nuestra experiencia cotidiana es la de un mundo que posee una profunda consistencia y continuidad. Nuestra búsqueda de la fuente de dicha consistencia atendía primero a las leyes de la Naturaleza que son las que gobiernan como cambian las cosas. Sin embargo, y al mismo tiempo, hemos llegado a identificar una colección de números misteriosos arraigados en la regularidad de la apariencia. Son las Constantes de la Naturaleza que, como la carga y la masa del electrón o la velocidad de la luz, le dan al Universo un carácter distintivo y lo singulariza de otros que podríamos imaginar. Todo esto, unifica de una vez nuestro máximo conocimiento y también, nuestra infinita ignorancia.

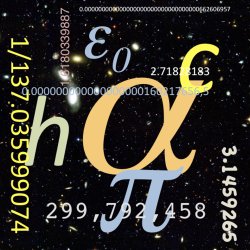

Esos números misteriosos (el valor de esas constantes fundamentales), son medidos con una precisión cada vez mayor y modelamos nuestros patrones fundamentales de masa y tiempo alrededor de su invariancia. Sin embargo, no podemos explicar sus valores. ¿Por qué la constante de estructura fina vale 1/137? Nadie puede contestar a esa “simple” pregunta. Sabemos que ahí, en esa constante, están involucrados los tres guarismos h, e, y c. El primero es la constante de Planck (la mecánica cuántica), el segundo el Electrón (el electromagnetismo), y, el tercero, la velocidad de la luz (la relatividad especial de Eisntein).

A pesar del cambio incesante y la dinámica del mundo visible, existen aspectos misteriosos del ritmo del Universo que son inquebrantables en su constancia, así lo podemos comprobar en la fuerza gravitatoria o en la velocidad de la luz en el vacío entre otros. Son estas misteriosas cosas invariables las que hacen de nuestro Universo el que es y lo distingue de otros muchos que pudiéramos imaginar. Existe un hilo invisble que teje incesante una continuidad a lo largo y a lo ancho de toda la Naturaleza: Algunas cosas cambian para que todo siga igual.

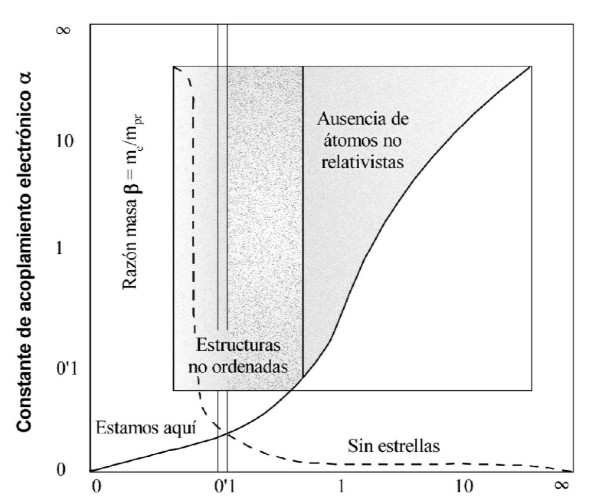

El problema de si las constantes físicas son constantes se las trae. Aparte del trabalenguas terminológico arrastra tras de sí unas profundas consecuencias conceptuales. Ahora unos experimentos han obtenido resultados que van encaminados hacia el hecho de que la constante de estrucutra fina, pudiera ser variante con el tiempo y el lugar, lo cual, al menos a mí no me cuadra por muchos gráficos que nos quieran presentar como el de abajo.

En verde, los datos obtenidos únicamente a través del telescopio Keck. El azul, solo los del VLT y la región roja es la combinación de ambos. La parte gris corresponde a la vía láctea. Todo está representado en coordenadas ecuatoriales (ascensión recta y declinación).

Si la constante variara de forma espacial esto tocaría la fibra sensible de la Relatividad aunque no es algo que pille de nuevas porque hay ya algunas teorías que plantean que esto pueda suceder. Si la variación es muy suave también podría significar que el universo es mucho mayor que la parte observable del mismo y entonces estaríamos hablando de un universo que incluso podría ser infinitamente grande donde las constantes variaran muy poco en el radio del universo observable, lo bastante poco para que nos parecieran constantes hasta que nos fijáramos lo suficiente.

Si las constantes fuesen variables… ¿Tendríamos un mundo del revés? O, simplemente no tendríamos ningún mundo. Bueno, el cambio de las constantes no es que pusiera el mundo del revés, sino que, simplemente, el mundo tal como lo conocemos, no sería. Igualmente, el Universo sería también distinto y, vaya usted a saber que clase de universos y mundos serían. ¿Un electrón diferente? ¿Qué pasaría con los átomos y la materia, y las estrellas y…nosotros?

Pero esto no es tan simple. Un pequeño cambio ya hace que no sean constantes y eso trae problemas a nivel teórico. También nos complicaría un poco la vida pensar en cómo sería el universo en otras regiones donde las constantes tengan valores muy distintos a los que conocemos actualmente. Es tan antinatural que, no creo que alfa, la constante de estrucutra fina, no sea invariante.

La constante de estructura fina de Sommerfeld (símbolo  ) es la constante física fundamental la que caracteriza la fuerza de la interacción electromagnética. Es una cantidad sin dimensiones, por lo que su valor numérico es independiente del sistema de unidades usado.

) es la constante física fundamental la que caracteriza la fuerza de la interacción electromagnética. Es una cantidad sin dimensiones, por lo que su valor numérico es independiente del sistema de unidades usado.

La expresión que la define y el valor recomendado por acodata en 2002 es:

.

donde:

es la carga elemental,

es la carga elemental,

es la constante racionalizada de Planck,

es la constante racionalizada de Planck,

es la velocidad de la luz en el vacío, y

es la velocidad de la luz en el vacío, y es la permitividad del vacío.

es la permitividad del vacío.

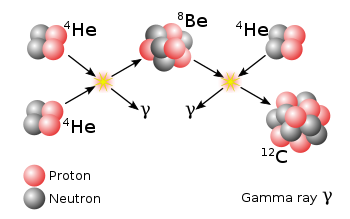

Sí, las Constantes Universales siempre dieron mucho que hablar. El Universo es como es gracias a equilibrios entre fuerzas y, por ejemplo, en un átomo la carga negativa de los electrones es similar a la carga positiva de los protones, y, tal equilibrio de fuerzas hace posible la estabilidad para que se formen y se junten para formar moléculas y materia. En las estrellas, una fuerza, la fusión tienede a expandir a la estrella, otra fuerza, la de Gravedad, tiende a comprimirla, y, de esta manera, aparece el equilibrio necesario para que las estrellas brillen durante miles de millones de años y lancen al espacio interestelar su luz y su calor, creen elementos complejos, y, en su final, hagan que sea posible sembrar de materiales diversos en inmensas nubes la materia primigenia para la vida, y, todo ello, en presencia de las fuerzas fundamentales y las constantes de la naturaleza.

Todo lo que vemos y que está presente en nuestro Universo es denbido a que las constantes son las que son y no otras diferentes, a que tienen los valores que tienen y no otros, a que funcionan de la manera que hemos podido observar y no otra. Con otras constantes diferentes, también el Universo sería otro universo y no el nuestro, el que conocemos y nos deja estar aquí para contarlo.

Así que, sería preferible que las constantes de la Naturaleza se queden tal cual. ¿Qué ganaríamos nosotros si cambiaran? ¿Desaparecer? No gracias. Aunque no como quisieramos pero, estamos bien aquí, al menos hay una oportunidad para cambiar las cosas.

Si esas constantes variaran, ¿que sería de nosotros? Sabemos que, universos con las constantes ligeramente alteradas nacerían muertos, privados del potencial para desarrollar y sostener el tipo de complejidad organizada que llamamos vida. ¿Son las Constantes de la Naturaleza realmente constantes? Un experimento llevado a buen fin por un grupo de investigadores, han puesto en práctica un método por ellos ideado mediante el cual, han podido examinar las Constantes de la Naturaleza durante los últimos 11.000 millones de años de la historia del Universo. Considerando las pautas atómicas que son similares a códigos de barras en la luz que nos llega de Cuásares lejanos, podemos mirar y ver cómo eran los átomos cuando la luz inició su viaje hace miles de millones de años. Así, ¿fueron siempre iguales las constantes de la Naturaleza? La respuesta, inesperada y escandalosa, plantea nuevas posibilidades para el Universo y las leyes que lo rigen.

¿Qué secretos tan profundos se esconden detrás de esta simple ecuación? Desde el comienzo de la “buena” Física, los mejores han tratado de desvelar lo que ahí está escondido. Es la Constante de estructura Fina, otra vez el número puro y adimensional, 137 que guarda los misterios del electromagnetismo, e, la Relatividad de Einstein, c, y, la constante de Planc, h. A pesar del cambio incesante y la dinámica del mundo visible, existen aspectos de la fábrica del Universo misteriosos en su inquebrantable constancia. Son esas misteriosas cosas invariables las que hacen de nuestro Universo el que es y lo distingue de otros que pudieran existir. Está presente un hilo dorado que teje una continuidad a través del espacio-tiempo y que, afecta a toda la Naturaleza que, de esa manera, se conforma como un todo, como un Sistema cerrado en el que, las constantes marcan un ritmo de funcionamiento y las leyes o fuerzas naturales dicen como deben cambiar las cosas.

Esas constantes de la Naturaleza están estrechamente emparentadas con las constantes de nuestros cuerpos que, como todo en el Universo, están conectados por unos hilos invisibles, a los parámetros de constantes y fuerzas que todo lo rigen. Descubrir si las constantes que las definen están determinadas y conformadas por alguna consistencia lógica superior o sigue habiendo un papel para el Azar. Nuestras primeras ojeadas revelan una situación muy peculiar, Mientras parece que ciertas constantes estuvieran fijadas, otras tienen espacio para ser distintas de las que son y algunas no parecen afectadas por ninguna otra cosa en el Universo. ¿Caen sus valores al Azar? ¿Podrían ser realmente diferentes? Y, si lo fueran, ¿Podría existir vida en el Universo?

Allí lejos, en esos otros mundos que, situados en galaxias lejanas son parecidos al nuestro, seguramente también, pasarán las mismas cosas que aquí si se dan las mismas circunstancias que están presentes en nuestro mundo. Situación y distancia del centro galáctico, zona habitable de su estrella… Océanos y atmósfera… ¡La vida!

En regiones lejanas del Universo, por muy extrañas que nos pudieran parecer, también estarían regidas por las mismas constantes de la Naturaleza que en la nuestra, el Sistema solar. Esas constantes están presentes en todas partes y, al igual que las cuatro fuerzas fundamentales, disponen que todo transcurra como debe ser.

Así que, tomando como patrón universal esas constantes, podemos esperar que ciertas cosas sean iguales en otros lugares del espacio además de la Tierra, lo único que in situ, conocemos. Hasta donde nuestros conocimientos han llegado también parece razonable pensar que dichas constantes fueron y serán las mismas en otros tiempos además de hoy, ya que, para algunas cosas, ni la historia ni la geografía importan. De hecho, quizá sin un substrato semejante de realidades invariables no podrían existir corrientes superficiales de cambio ni ninguna complejidad de mente y materia. Todos sabemos, por ejemplo que, si la carga del electrón variara aunque sólo fuese una diez millonésima parte de la que es, la vida no podría existir.

Constantes que hacen posible nuestra presencia

La invariancia de las constantes hace posible que nuestro Universo contenga las maravillas que podemos en él observar. Sin embargo, a lo largo de la historia muchos se han empeñado en hacerlas cambiar…, pero no lo consiguieron. No pocas veces tenemos que leer en la prensa o revistas “especializadas” noticas como estas:

“Nueva evidencia sostiene que los seres humanos vivimos en un área del Universo que está hecha especialmente para nuestra existencia. ¿Según los cientificos? Esto es lo que más se aproxima a la realidad. El controversial hallazgo se obtuvo observando una de las constantes de la naturaleza, la cual parece ser diferente en distintas partes del cosmos.”

El problema de si las constantes físicas son constantes se las trae. Aparte del trabalenguas terminológico arrastra tras de sí unas profundas consecuencias conceptuales. Lo primero, uno de los pilares fundamentales de la relatividad especial es el postulado de que las leyes de la física son las mismas con independencia del observador. Esto fue una generalización de lo que ya se sabía cuando se comenzó a estudiar el campo electromagnético, pero todo lo que sabemos en la actualidad nos lleva a concluir que Lo que ocurra en la Naturaleza del Universo está en el destino de la propia Naturaleza del Cosmos, de las leyes que la rigen y de las fuerzas que gobiernan sus mecanismos sometidos a principios y energías que, en la mayoría de los casos, se pueden escapar a nuestro actual conocimiento.

Yo aconsejaría a los observadores que informaron y realizaron “el estudio” (que se menciona más arriba) que prestaran más atención o que cambiaran los aparatos e instrumentos de los que se valieron para llevarlo a cabo, toda vez que hacer tal afirmación, además de tratarse de una osadía, se les podría calificar de incompetentes.

De estar en lo cierto, tal informe se opondría al principio de equivalencia de Albert Einstein, el cual postula que las leyes de la física son las mismas en cualquier región del Universo. “Este descubrimiento fue una gran sorpresa para todos”, dice John Webb, de la Universidad de New South Wales, en Sidney (Australia ), líder del estudio que sigue diciendo: Aún más sorprendente es el hecho de que el cambio en la constante parece tener una orientación, creando una “dirección preferente”, o eje, a través del Universo. Esa idea fue rechazada más de 100 años atrás con la formulación de la teoría de la relatividad de Einstein que, de momento, no ha podido ser derrocada (aunque muchos lo intentaron)

Los autores de tal “estudio” se empeñaron en decir que:

“La Tierra se ubica en alguna parte del medio de los extremos, según la constante “alpha”. Si esto es correcto, explicaría por qué dicha constante parece tener un valor sutilmente sintonizado que permite la química, y por lo tanto la vida, como la conocemos.

Con un aumento de 4% al valor de “alpha”, por ejemplo, las estrellas no podrían producir carbón, haciendo nuestra bioquímica imposible, según información que hemos podido obtener de profundos estudios sobre el tema que nos dicen que si la constante de estructura fina α, fuese variable, no se podría producir el proceso triple Alfa que produce el Carbono.

Siendo cierto que una pequeña variación de Alfa, no ya el 4%, sino una simple diezmillonésima, la vida no podría existir en el Universo. Está claro que algunos, no se paran a la hora de adquirir una efímera notoriedad, ya que, finalmente, prevalecerá la verdad de la invariancia de las constantes que, a lo largo de la historia de la Física y la Cosmología, muchas veces han tratado de hacerlas cambiantes a lo largo del tiempo, y, sin embargo, ahí permanecen con su inamovible estabilidad.

Veamos por encima, algunas constantes:

Veamos por encima, algunas constantes:

La Constante de Gravitación Universal: G

La primera constante fundamental es G, la que ponemos delante de la fórmula de la gravedad de Newton. Es una simple constante de proporcionalidad pero tambien ajusta magnitudes: se expresa en N*m2/Kg2.

Es tal vez la constante peor medida (sólo se está seguro de las tres primeras cifras…), y como vemos la fuerza de la gravedad es muy débil (si no fuera porque siempre es atractiva ni la sentiríamos).

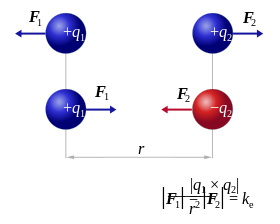

La Constante Electrica: K

No confundir con la constante K de Bolzman para termodinamica y gases…

La ley de Coulom es practicamente igual a la de la gravitación de Newton, si sustituimos las masas por las cargas, es inversa al cuadrado de la distancia y tiene una constante de proporcionalidad llamada K. La constante es la de de Coulomb y su valor para unidades del SI es K = 9 * 109 * N * m2 / C2

La constante K no es realmente fundamental. F/m es la Permitividad del Medio en el Vacío. Así pues, la constante importante es la Permitividad del Vacío. Hay un paralelismo casi total con el campo magnético, donde definimos la “Permeabilidad Magnética de un material” como la Permitividad Relativa por la Permitividad del Vacío, μ = μrμ0, donde la importante es de nuevo la del vacío.

La velocidad de la luz c

c= 299.792.458 m/s y se suele aproximar por 3·10^8m/s

Según la teoría de la relatividad de Einstein, ninguna información puede viajar a mayor velocidad que la luz. Científicos australianos afirman, sin embargo, haber desarrollado las fórmulas que describen viajes más allá de este límite.

Que la velocidad de la luz es una constante se comprobó hasta la saciedad en diversos experimentos, como el famoso experimento Michelson-Morley que determinó mediante un interferómetro que la velocidad de la luz no dependía de la velocidad del objeto que la emitía, esto descartó de golpe la suposición de que hubiera un “eter” o sustancia necesaria por la que se propagara la luz.

En su lugar aparecieron las famosas transformaciones de Lorentz. La contracción de Lorentz explicaba el resultado del experimento. La rapidez constante de la luz es uno de los postulados fundamentales (junto con el principio de causalidad y la equivalencia de los marcos de inercia) de la Teoría de la Relatividad Especial.

Así que, amigos míos, esas cantidades conservarán su significado natural mientras la ley de gravitación y la de la propagación de la luz en el vacío y los dos principios de la termodinámica sigan siendo válidos. A tal respecto Max Planck solía decir:

“Por lo tanto, al tratarse de números naturales que no inventaron los hombres, siempre deben encontrarse iguales cuando sean medidas por las inteligencias más diversas con los métodos más diversos” .

En sus palabras finales alude a la idea de observadores situados en otros lugares del Universo que definen y entienden esas cantidades de la misma manera que nosotros, sin importar que aparatos o matemáticas pudieran emplear para realizar sus comprobaciones.

Estaba claro que Planck apelaba a la existencia de constantes universales de la Naturaleza como prueba de una realidad física completamente diferente de las mentes humanas. Pero él quería ir mucho más lejos y utilizaba la existencia de estas constantes contra los filósofos positivistas que presentaban la ciencia como una construcción enteramente humana: puntos precisos organizados de una forma conveniente por una teoría que con el tiempo sería reemplazada por otra mejor. Claro que Planck reconocía que la inteligencia humana, al leer la naturaleza había desarrolado teorías y ecuaciones para poder denotarlas pero, sin embargo, en lo relativo a las constantes de la naturaleza, éstas habían surgido sin ser invitadas y, como mostraban claramente sus unidades naturales (unidades de Planck) no estaban escogidas exclusivamente por la conveniencia humana.

Las constantes de la Naturaleza inciden en todos nosotros y, sus efectos, están presentes en nuestras mentes que, sin ellas, no podrían funcionar de la manera creadora e imaginativa que lo hacen. Ellas le dan el ritmo al Universo y hacen posible que todo transcurra como debe transcurrir.

Es curioso comprobar que, una de las paradojas de nuestro estudio del Universo circundante es que a medida que las descripciones de su funcionamiento se hacen más precisas y acertadas, también se alejan cada vez más de toda la experiencia humana que, al estar reducidas a un ámbito muy local y macroscópico, no puede ver lo que ocurre en el Universo en su conjunto y, por supuesto, tampoco en ese otro “universo” de lo infinitesimal que nos define la mecánica cuántica en el que, cuando nos acercamos, podemos observar cosas que parecen fuera de nuestro mundo, aunque en realidad, sí que están aquí.

La revolución de la mecánica cuántica empieza a materializarse, y el qubit es el principal protagonista. Siendo la unidad mínima de información de este extraño mundo, permitirá procesar toda la información existente en segundos. La revolución de la mecánica cuántica empieza a materializarse, y el qubit es el principal protagonista. Siendo la unidad mínima de información de este extraño mundo, permitirá procesar toda la información existente en segundos.

No podemos descartar la idea de que, en realidad, puedan existir “seres también infiniotesimales” que, en sus “pequeños mundos” vean transcurrir el tiempo como lo hacemos nosotros aquí en la Tierra. En ese “universo” especial que el ojo no puede ver, podrían existir otros mundos y otros seres que, como nosotros, desarrollan allí sus vidas y su tiempo que, aunque también se rigen por las invariantes constantes univerales, para ellos, por su pequeñez, el espacio y el tiempo tendrán otros significados. Si pensamos por un momento lo que nosotros y nuestro planeta significamos en el contexto del inmenso universo… ¿No viene a suponer algo así?Claro que, por muy pequeños que podamos ser en el contexto inmenso del Universo, nadie podrá nevgar que somos parte de él, y, eso amigos míos… ¡Tiene una importancia vital! No somos tan insignificantes como a primera vista nos pueda parecer, sino que formamos parte de un complejo engranaje en el que tenemos un función: La de pensar y descubrir.

Einstein nos dejó dichas muchas cosas interesantes sobre las constantes de la Naturaleza en sus diferentes trabajos. Fue su genio e intuición sobre la teoría de la relatividad especial la que dotó a la velocidad de la luz en el vacío del status especial como máxima velocidad a la que puede transmitirse información en el Universo. El supo revelar todo el alcance de lo que Planck y Stoney simplemente habían supuesto: que la velocidad de la luz era una de las constantes sobrehumanas fundamentales de la Naturaleza.

La luz se expande por nuestro Universo de manera isotrópica, es decir, se expande por igual en todas las direcciones. Así actúan las estrellas que emiten su luz o la bombilla de una habitación. Cuando es anisotrópica, es decir que sólo se expande en una dirección, tendríamos que pensar, por ejemplo, en el foco de un teatro que sólo alumbra a cantante.

La luz de las estrellas: Podemos ver como se expande por igual en todas las direcciones del espacio (Isotrópica)

Claro que, cuando hablamos de las constantes, se podría decir que algunas son más constantes que otras. La constante de Boltzmann es una de ellas, es en realidad una constante aparente que surje de nuestro hábito de medir las cosas en unidades. Es sólo un factor de conversión de unidades de energía y temperatura. Las verdaderas constantes tienen que ser números puros y no cantidades con “dimensiones”, como una velocidad, una masa o una longitud.

Las cantidades con dimensiones siempre cambian sus valores numéricos si cambiamos las unidades en las que se expresan.

Las constantes fundamentales determinan el por qué, en nuestro Universo, las cosas son como las observamos.

Y, a todo esto, la teoría cuántica y de la Gravitación gobierna reinos muy diferentes que tienen poca ocasión para relacionarse entre sí. Mientras la una está situada en el mundo infinitesimal, la otra, reina en el macrocosmos “infinito” del inmenso Universo. Sin embargo, las fuerzas que rigen en el mundo de los átomos son mucho más potentes que las que están presentes en ese otro mundo de lo muy grande. ¡Qué paradoja!

¿Dónde están los límites de la teoría cuántica y los de la relatividad general? Somos afortunados al tener la respuesta a mano, Las unidades de Planck nos dan la respuesta a esa pregunta:

Supongamos que tomamos toda la masa del Universo visible y determinamos la longitud de onda cuántica. Podemos preguntarnos en que momento esa longitud de onda cuántica del Universo visible superará su tamaño. La respuesta es: Cuando el Universo sea más pequeño que la longitud de Planck (10-33 centímetros), más joven que el Tiempo de Planck (10-43 segundos) y supere la Temperatura de Planck (1032 grados). Las unidades de Planck marcan la frontera de aplicación de nuestras teorías actuales. Para comprender a qué se parece el mundo a una escala menor que la Longitud de Planck tenemos que comprender plenamente cómo se entrelaza la incertidumbre cuántica con la Gravedad.

El satélite Planck un observatorio que explora el universo lleva el mismo nombre del fundador de la teoría cuántica será pura coincidencia?. Credito: ESA. La Gravedad cuántica queda aún muy lejos de nuestro entendimiento.

La Relatividad General la teoría de Einstein de la gravedad, nos da una base útil para matemáticamente modelar el universo a gran escala -, mientras que la Teoría Cuántica nos da una base útil para el modelado de la física de las partículas subatómicas y la probabilidad de pequeña escala, de la física de alta densidad de energía de los inicios del universo – nanosegundos después del Big Bang – en la cuál la relatividad general sólo la modela como una singularidad y no tiene nada más que decir sobre el asunto.

Las teorías de la Gravedad Cuántica pueden tener más que decir, al extender la relatividad general dentro de una estructura cuantizada del espacio tiempo puede ser que nosotros podamos salvar la brecha existente entre la física de gran escala y de pequeña escala, al utilizar por ejemplo la Relatividad Especial Doble o Deformada.

¡Es tanto lo que nos queda por saber! Pero finalicemos volviendo de nuevo a la constante de estructura fina, α (alfa):

El día que se profundice y sepamos leer todos los mensajes subyacentes en el número puro y adimensional 137, ese día, como nos decía Heinsemberg, se habrán secado todas las fuentes de nuestra ignorancia. Ahí, en el 137, Alfa (α) Constante de estructura Fina, residen los secretos de la Relatividad Especial, la Velocidad de la Luz, c, el misterio del electromagnetismo, el elextrón, e, y, la Mecánica Cuántica, es decir el cuanto de acción de Planck, h.

¡Quién tuviera el intelecto necesario para comprender todos esos mensajes y poder desvelar sus secretos!

emilio silvera

Nov

21

Buscando la Gravedad cuántica

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

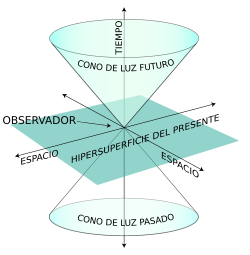

Quién sabe cómo nos veremos nosotros dentro de unos cientos de años

Entre los teóricos, el casamiento de la relatividad general y la teoría cuántica es el problema central de la física moderna. A los esfuerzos teóricos que se realizan con ese propósito se les llama “supergravedad”, “súpersimetría”, “supercuerdas” “teoría M” o, en último caso, “teoría de todo o gran teoría unificada”. Lo cierto es que, para que las dos teorías, cuántica y relativista se reúnan sin que surjan los dichosos infinitos, se tiene que plantear dentro de una teoría de dimensiones extra. Esas teorías de más dimensiones, requieren de complejas formulaciones que no todos, podemos entender.

Ahí tenemos unas matemáticas exóticas que ponen de punta hasta los pelos de las cejas de algunos de los mejores matemáticos del mundo (¿y Perelman? ¿Por qué nos se ha implicado?). Hablan de 10, 11 y 26 dimensiones, siempre, todas ellas espaciales menos una que es la temporal. Vivimos en cuatro: tres de espacio (este-oeste, norte-sur y arriba-abajo) y una temporal. No podemos, ni sabemos o no es posible instruir, en nuestro cerebro (también tridimensional), ver más dimensiones. Pero llegaron Kaluza y Klein y compactaron, en la longitud de Planck las dimensiones que no podíamos ver. ¡Problema solucionado!

¿Quién puede ir a la longitud de Planck para verla?

Ni vemos la longitud de Planck ni las dimensiones extra

La puerta de las dimensiones más altas quedó abierta y, a los teóricos, se les regaló una herramienta maravillosa. En el Hiperespacio, todo es posible. Hasta el matrimonio de la relatividad general y la mecánica cuántica, allí si es posible encontrar esa soñada teoría de la Gravedad cuántica.

Así que, los teóricos, se han embarcado a la búsqueda de un objetivo audaz: buscan una teoría que describa la simplicidad primigenia que reinaba en el intenso calor del universo en sus primeros tiempos, una teoría carente de parámetros, donde estén presentes todas las respuestas. Todo debe ser contestado a partir de una ecuación básica.

¿Dónde radica el problema?

Nuestro es tridimensional y no podemos ver otro más allá… ¡si existe!

El problema está en que la única teoría candidata no tiene conexión directa con el mundo de la observación, o no lo tiene todavía si queremos expresarnos con propiedad. La energía necesaria para ello, no la tiene ni el nuevo acelerador de partículas LHC que con sus 14 TeV no llegaría ni siquiera a vislumbrar esas cuerdas vibrantes de las que tanto se habla.

La verdad es que, la teoría que ahora tenemos, el Modelo Estándar, concuerda de manera exacta con todos los datos a bajas energías y contesta cosas sin sentido a altas energías.

Con sus 20 parámetros aleatorios (parece que uno de ellos ha sido hallado -el bosón de Higgs-), el Modelo estándar de la física de partículas que incluye sólo tres de las interacicones fundamentales -las fuerzas nucleares débil y fuerte y el electromagnetismo-, ha dado un buen resultado y a permitido a los físicos trabajar ampliamente en el conocimiento del mundo, de la Naturaleza, del Universo. Sin embargo, deja muchas preguntas sin contestar y, lo cierto es que, se necesitan nuevas maneras, nuevas formas, nuevas teorías que nos lleven más allá.

¡Necesitamos algo más avanzado!

Se ha dicho que la función de la partícula de Higgs es la de dar masa a las partículas que conocemos y están incluidas en el Modelo estándar, se nos ha dicho que ha sido encontrada pero, nada se ha dicho de cómo ésta partícula transmite la masa a las demás. Faltan algunas explicaciones.

El secreto de todo radica en conseguir la simplicidad: el átomo resulto ser complejo lleno de esas infinitesimales partículas electromagnéticas que bautizamos con el nombre de electrones, resultó que tenía un núcleo que contenía, a pesar de ser tan pequeño, casi toda la masa del átomo. El núcleo, tan pequeño, estaba compuesto de otros objetos más pequeños aún, los quarks que estaban instalados en nubes de otras partículas llamadas gluones y, ahora, queremos continuar profundizando, sospechamos, que después de los quarks puede haber algo más.

Los del LHC dicen haber encontrado el Bosón de Higgs pero, no he podido leer ni oir, alguna explicación clara y precisa de cómo le dá masa a las demás partículas. Espero que, el Nobel se justifique y que expongan con detalle lo que pasa en los llamados “océanos de Higgs” por el que las partículas circulan para adquirir sus masas que les “proporciona” el recien “hallado” bosón.

¿Cómo llegamos aquí? Bueno, la idea nueva que surgió es que el espacio entero contiene un campo, el campo de Higgs, que impregna el vacío y es el mismo en todas partes. Es decir, que si miramos a las estrellas en una noche clara estamos mirando el campo de Higgs. Las partículas influidas por este campo, toman masa. Esto no es por sí mismo destacable, pues las partículas pueden tomar energía de los campos (gauge) de los que hemos comentado, del campo gravitatorio o del electromagnético. Si llevamos un bloque de plomo a lo alto de la Torre Eiffel, el bloque adquiriría energía potencial a causa de la alteración de su posición en el campo gravitatorio de la Tierra.

Como E=mc2, ese aumento de la energía potencial equivale a un aumento de la masa, en este caso la masa del Sistema Tierra-bloque de plomo. Aquí hemos de añadirle amablemente un poco de complejidad a la venerable ecuación de Einstein. La masa, m, tiene en realidad dos partes. Una es la masa en reposo, m0, la que se mide en el laboratorio cuando la partícula está en reposo. La partícula adquiere la otra parte de la masa en virtud de su movimiento (como los protones en el acelerador de partículas, o los muones, que aumentan varias veces su masa cuando son lanzados a velocidades cercanas a c) o en virtud de su energía potencial de campo. Vemos una dinámica similar en los núcleos atómicos. Por ejemplo, si separamos el protón y el neutrón que componen un núcleo de deuterio, la suma de las masas aumenta.

Peor la energía potencial tomada del campo de Higgs difiere en varios aspectos de la acción de los campos familiares. La masa tomada de Higgs es en realidad masa en reposo. De hecho, en la que quizá sea la versión más

apasionante de la teoría del campo de Higgs, éste genera toda la masa en reposo. Otra diferencia es que la cantidad de masa que se traga del campo es distinta para las distintas partículas. Los teóricos dicen que las masas de las partículas de nuestro modelo estándar miden con qué intensidad se acoplan éstas al campo de Higgs.

La influencia de Higgs en las masas de los quarks y de los leptones, nos recuerda el descubrimiento por Pieter Zeeman, en 1.896, de la división de los niveles de energía de un electrón cuando se aplica un campo magnético al átomo. El campo (que representa metafóricamente el papel de Higgs) rompe la simetría del espacio de la que el electrón disfrutaba.

Hasta ahora no tenemos ni idea de que reglas controlan los incrementos de masa generados por el Higgs (de ahí la expectación creada por el nuevo acelerador de partículas LHC). Pero el problema es irritante: ¿por qué sólo esas masas –Las masas de los W+, W–, y Zº, y el up, el down, el encanto, el extraño, el top y el bottom, así como los leptones – que no forman ningún patrón obvio?

No dejamos de experimentar para saber ccómo es nuestro mundo, la Naturaleza, el Universo que nos acoge

Las masas van de la del electrón 0’0005 GeV, a la del top, que tiene que ser mayor que 91 GeV. Deberíamos recordar que esta extraña idea (el Higgs) se empleó con mucho éxito para formular la teoría electrodébil (Weinberg-salam). Allí se propuso el campo de Higgs como una forma de ocultar la unidad de las fuerzas electromagnéticas y débiles. En la unidad hay cuatro partículas mensajeras sin masa –los W+, W–, Zº y fotón que llevan la fuerza electrodébil. Además está el campo de Higgs, y, rápidamente, los W y Z chupan la esencia de Higgs y se hacen pesados; el fotón permanece intacto. La fuerza electrodébil se fragmenta en la débil (débil porque los mensajeros son muy gordos) y la electromagnética, cuyas propiedades determina el fotón, carente de masa. La simetría se rompe espontáneamente, dicen los teóricos. Prefiero la descripción según la cual el Higgs oculta la simetría con su poder dador de masa.

Las masas de los W y el Z se predijeron con éxito a partir de los parámetros de la teoría electrodébil. Y las relajadas sonrisas de los físicos teóricos nos recuerdan que Gerard ^t Hooft y Veltman dejaron sentado que la teoría entera esta libre de infinitos.

En esta última dirección ha publicado numerosos libros y artículos, donde aborda la asignatura pendiente de la unificación de la mecánica cuántica y la teoría del campo gravitatorio. El camino que ha seguido Penrose es encontrar una base común a ambas.

Para ello ha introducido dos modelos: los “spin networks” y los “twistors”, el primero discreto, con una métrica intrínseca, no relativista, previo al concepto de espacio, el segundo continuo, con una métrica extrínseca, relativista e inmerso en un espacio-tiempo dado.

Claro que son varias las corrientes que quieren abrirse camino hacia otras físicas nuevas.

La teoría de supercuerdas tiene tantas sorpresas fantásticas que cualquiera que investigue en el tema reconoce que está llena de magia. Es algo que funciona con tanta belleza… Cuando cosas que no encajan juntas e incluso se repelen, si se acerca la una a la otra alguien es capaz de formular un camino mediante el cual, no sólo no se rechazan, sino que encajan a la perfección dentro de ese sistema, como ocurre ahora con la teoría M que acoge con naturalidad la teoría de la relatividad general y la teoría mecánico-cuántica; ahí, cuando eso se produce, está presente la belleza.

Lo que hace que la teoría de supercuerdas sea tan interesante es que el marco estándar mediante el cual conocemos la mayor parte de la física es la teoría cuántica y resulta que ella hace imposible la gravedad. La relatividad general de Einstein, que es el modelo de la gravedad, no funciona con la teoría cuántica. Sin embargo, las supercuerdas modifican la teoría cuántica estándar de tal manera que la gravedad no sólo se convierte en posible, sino que forma parte natural del sistema; es inevitable para que éste sea completo.

¿Por qué es tan importante encajar la gravedad y la teoría cuántica? Porque no podemos admitir una teoría que explique las fuerzas de la naturaleza y deje fuera a una de esas fuerzas. Así ocurre con el Modelo Estándar que deja aparte y no incluye a la fuerza gravitatoria que está ahí, en la Naturaleza.

La teoría de supercuerdas se perfila como la teoría que tiene implicaciones si tratamos con las cosas muy pequeñas, en el microcosmos; toda la teoría de partículas elementales cambia con las supercuerdas que penetra mucho más; llega mucho más allá de lo que ahora es posible.

La topología es, el estudio de aquellas propiedades de los cuerpos geométricos que permanecen inalteradas por transformaciones continuas. La topología es probablemente la más joven de las ramas clásicas de las matemáticas. En contraste con el álgebra, la geometría y la teoría de los números, cuyas genealogías datan de tiempos antiguos, la topología aparece en el siglo diecisiete, con el nombre de analysis situs, ésto es, análisis de la posición.

De manera informal, la topología se ocupa de aquellas propiedades de las figuras que permanecen invariantes, cuando dichas figuras son plegadas, dilatadas, contraídas o deformadas, de modo que no aparezcan nuevos puntos, o se hagan coincidir puntos diferentes. La transformación permitida presupone, en otras palabras, que hay una correspondencia biunívoca entre los puntos de la figura original y los de la transformada, y que la deformación hace corresponder puntos próximos a puntos próximos. Esta última propiedad se llama continuidad, y lo que se requiere es que la transformación y su inversa sean ambas continuas: así, trabajarnos con homeomorfismos.

En cuanto a nuestra comprensión del universo a gran escala (supercúmulos de galaxias, ondas gravitacionales, posibles estrellas de Quarks-Gluones… el propio Big Bang…), creo que afectará a nuestra idea presente, al esquema que hoy rige y, como la nueva teoría, el horizonte se ampliará enormemente; el cosmos se presentará ante nosotros como un todo, con un comienzo muy bien definido y un final muy bien determinado. El Tiempo y la Entropía tienen mucho que decir en todo eso y, por el camino hacia el conocimiento pleno, tendremos que comprender, de manera completa y exacta que es la Luz, la Gravedad y… ¡tántas cosas!

Para cuando eso llegue, sabremos lo que es, como se genera y dónde están situados los orígenes de esa “fuerza”, “materia”, o, “energía” que ahora no sabemos ver para explicar el movimiento de las galaxias o la expansión del espacio mismo, la posible existencia de otros universos…

emilio silvera

Totales: 83.772.362

Totales: 83.772.362 Conectados: 60

Conectados: 60