Oct

1

Buscando la Gravedad cuántica

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (1)

Comments (1)

Quién sabe cómo nos veremos nosotros dentro de unos cientos de años

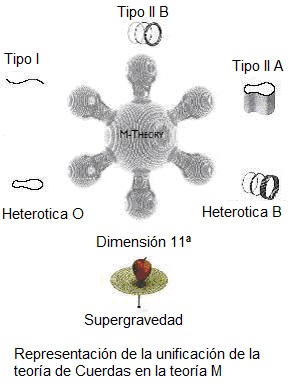

Entre los teóricos, el casamiento de la relatividad general y la teoría cuántica es el problema central de la física moderna. A los esfuerzos teóricos que se realizan con ese propósito se les llama “supergravedad”, “súpersimetría”, “supercuerdas” “teoría M” o, en último caso, “teoría de todo o gran teoría unificada”. Lo cierto es que, para que las dos teorías, cuántica y relativista se reúnan sin que surjan los dichosos infinitos, se tiene que plantear dentro de una teoría de dimensiones extra. Esas teorías de más dimensiones, requieren de complejas formulaciones que no todos, podemos entender.

Ahí tenemos unas matemáticas exóticas que ponen de punta hasta los pelos de las cejas de algunos de los mejores matemáticos del mundo (¿y Perelman? ¿Por qué nos se ha implicado?). Hablan de 10, 11 y 26 dimensiones, siempre, todas ellas espaciales menos una que es la temporal. Vivimos en cuatro: tres de espacio (este-oeste, norte-sur y arriba-abajo) y una temporal. No podemos, ni sabemos o no es posible instruir, en nuestro cerebro (también tridimensional), ver más dimensiones. Pero llegaron Kaluza y Klein y compactaron, en la longitud de Planck las dimensiones que no podíamos ver. ¡Problema solucionado!

¿Quién puede ir a la longitud de Planck para verla?

Ni vemos la longitud de Planck ni las dimensiones extra

La puerta de las dimensiones más altas quedó abierta y, a los teóricos, se les regaló una herramienta maravillosa. En el Hiperespacio, todo es posible. Hasta el matrimonio de la relatividad general y la mecánica cuántica, allí si es posible encontrar esa soñada teoría de la Gravedad cuántica.

Así que, los teóricos, se han embarcado a la búsqueda de un objetivo audaz: buscan una teoría que describa la simplicidad primigenia que reinaba en el intenso calor del universo en sus primeros tiempos, una teoría carente de parámetros, donde estén presentes todas las respuestas. Todo debe ser contestado a partir de una ecuación básica.

¿Dónde radica el problema?

Nuestro es tridimensional y no podemos ver otro más allá… ¡si existe!

El problema está en que la única teoría candidata no tiene conexión directa con el mundo de la observación, o no lo tiene todavía si queremos expresarnos con propiedad. La energía necesaria para ello, no la tiene ni el nuevo acelerador de partículas LHC que con sus 14 TeV no llegaría ni siquiera a vislumbrar esas cuerdas vibrantes de las que tanto se habla.

La verdad es que, la teoría que ahora tenemos, el Modelo Estándar, concuerda de manera exacta con todos los datos a bajas energías y contesta cosas sin sentido a altas energías.

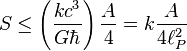

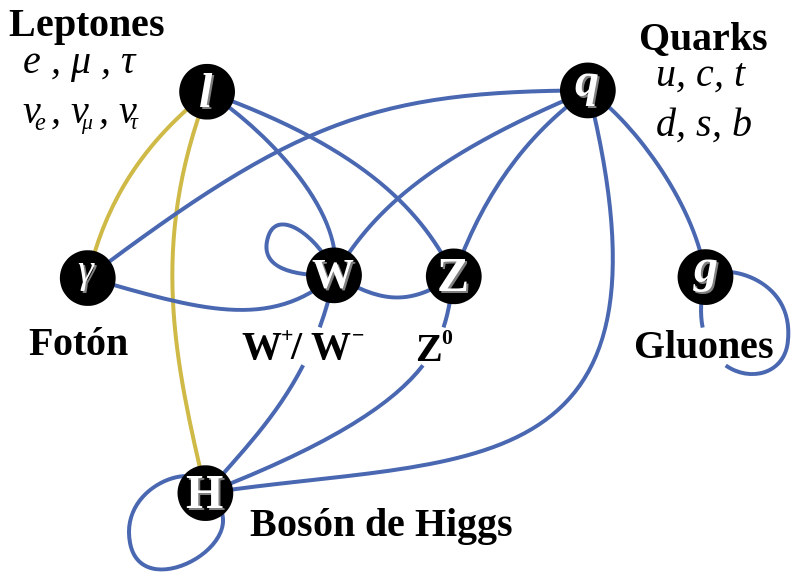

Con sus 20 parámetros aleatorios (parece que uno de ellos ha sido hallado -el bosón de Higgs-), el Modelo estándar de la física de partículas que incluye sólo tres de las interacicones fundamentales -las fuerzas nucleares débil y fuerte y el electromagnetismo-, ha dado un buen resultado y a permitido a los físicos trabajar ampliamente en el conocimiento del mundo, de la Naturaleza, del Universo. Sin embargo, deja muchas preguntas sin contestar y, lo cierto es que, se necesitan nuevas maneras, nuevas formas, nuevas teorías que nos lleven más allá.

¡Necesitamos algo más avanzado!

Se ha dicho que la función de la partícula de Higgs es la de dar masa a las partículas que conocemos y están incluidas en el Modelo estándar, se nos ha dicho que ha sido encontrada pero, nada se ha dicho de cómo ésta partícula transmite la masa a las demás. Faltan algunas explicaciones.

El secreto de todo radica en conseguir la simplicidad: el átomo resulto ser complejo lleno de esas infinitesimales partículas electromagnéticas que bautizamos con el nombre de electrones, resultó que tenía un núcleo que contenía, a pesar de ser tan pequeño, casi toda la masa del átomo. El núcleo, que siendo infinitesimal, estaba compuesto de otros objetos más pequeños aún, los quarks que estaban instalados en nubes de otras partículas llamadas gluones y, ahora, queremos continuar profundizando, sospechamos, que después de los quarks puede haber algo más.

Los del LHC dicen haber encontrado el Bosón de Higgs pero, no he podido leer ni oir, alguna explicación clara y precisa de cómo le dá masa a las demás partículas (la mejor explicación sobre el tema la he leido de nuestro amigo y contertulio Ramón Marquez. Él dice que la masa de las partículas es el resultado del efecto frenado al viajar por los océanos de Higgs, una idea brillante, sencilla de entender y razonable para explicar tal fenómeno). Espero que, el Nobel se justifique y que expongan con detalle lo que pasa en los llamados “océanos de Higgs” por el que las partículas circulan para adquirir sus masas que les “proporciona” el recien “hallado” bosón.

¿Cómo llegamos aquí? Bueno, la idea nueva que surgió es que el espacio entero contiene un campo, el campo de Higgs, que impregna el vacío y es el mismo en todas partes. Es decir, que si miramos a las estrellas en una noche clara estamos mirando el campo de Higgs. Las partículas influidas por este campo, toman masa. Esto no es por sí mismo destacable, pues las partículas pueden tomar energía de los campos (gauge) de los que hemos comentado, del campo gravitatorio o del electromagnético. Si llevamos un bloque de plomo a lo alto de la Torre Eiffel, el bloque adquiriría energía potencial a causa de la alteración de su posición en el campo gravitatorio de la Tierra.

Como E=mc2, ese aumento de la energía potencial equivale a un aumento de la masa, en este caso la masa del Sistema Tierra-bloque de plomo. Aquí hemos de añadirle amablemente un poco de complejidad a la venerable ecuación de Einstein. La masa, m, tiene en realidad dos partes. Una es la masa en reposo, m0, la que se mide en el laboratorio cuando la partícula está en reposo. La partícula adquiere la otra parte de la masa en virtud de su movimiento (como los protones en el acelerador de partículas, o los muones, que aumentan varias veces su masa cuando son lanzados a velocidades cercanas a c) o en virtud de su energía potencial de campo. Vemos una dinámica similar en los núcleos atómicos. Por ejemplo, si separamos el protón y el neutrón que componen un núcleo de deuterio, la suma de las masas aumenta.

Peor la energía potencial tomada del campo de Higgs difiere en varios aspectos de la acción de los campos familiares. La masa tomada de Higgs es en realidad masa en reposo. De hecho, en la que quizá sea la versión más

apasionante de la teoría del campo de Higgs, éste genera toda la masa en reposo. Otra diferencia es que la cantidad de masa que se traga del campo es distinta para las distintas partículas. Los teóricos dicen que las masas de las partículas de nuestro modelo estándar miden con qué intensidad se acoplan éstas al campo de Higgs.

La influencia de Higgs en las masas de los quarks y de los leptones, nos recuerda el descubrimiento por Pieter Zeeman, en 1.896, de la división de los niveles de energía de un electrón cuando se aplica un campo magnético al átomo. El campo (que representa metafóricamente el papel de Higgs) rompe la simetría del espacio de la que el electrón disfrutaba.

Hasta ahora no tenemos ni idea de que reglas controlan los incrementos de masa generados por el Higgs (de ahí la expectación creada por el nuevo acelerador de partículas LHC). Pero el problema es irritante: ¿por qué sólo esas masas –Las masas de los W+, W–, y Zº, y el up, el down, el encanto, el extraño, el top y el bottom, así como los leptones – que no forman ningún patrón obvio?

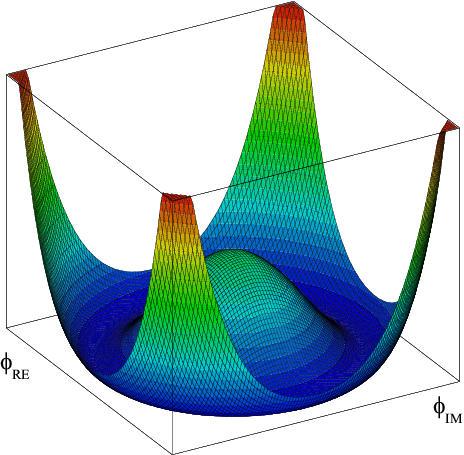

No dejamos de experimentar para saber ccómo es nuestro mundo, la Naturaleza, el Universo que nos acoge

Las masas van de la del electrón 0’0005 GeV, a la del top, que tiene que ser mayor que 91 GeV. Deberíamos recordar que esta extraña idea (el Higgs) se empleó con mucho éxito para formular la teoría electrodébil (Weinberg-salam). Allí se propuso el campo de Higgs como una forma de ocultar la unidad de las fuerzas electromagnéticas y débiles. En la unidad hay cuatro partículas mensajeras sin masa –los W+, W–, Zº y fotón que llevan la fuerza electrodébil. Además está el campo de Higgs, y, rápidamente, los W y Z chupan la esencia de Higgs y se hacen pesados; el fotón permanece intacto. La fuerza electrodébil se fragmenta en la débil (débil porque los mensajeros son muy gordos) y la electromagnética, cuyas propiedades determina el fotón, carente de masa. La simetría se rompe espontáneamente, dicen los teóricos. Prefiero la descripción según la cual el Higgs oculta la simetría con su poder dador de masa.

Las masas de los W y el Z se predijeron con éxito a partir de los parámetros de la teoría electrodébil. Y las relajadas sonrisas de los físicos teóricos nos recuerdan que Gerard ^t Hooft y Veltman dejaron sentado que la teoría entera esta libre de infinitos.

Lo cierto es que, la Gravedad, se ha negado a ser incluída en el Modelo estándard de la física de partículas.

La asignatura pendiente de la física teórica del siglo XX ha sido la unificación de la relatividad general y la mecánica cuántica. Las aproximaciones que se han hecho van desde la cuantificación canónica del campo gravitatorio hasta la ampliación de las simetrías en la teoría de supercuerdas. Existen también teorías que buscan una nueva interpretación de las teorías del espacio-tiempo, como se vio en el congreso sobre la ontología del espacio-tiempo que tuvo lugar en junio de 2006 en Montreal.

Penrose es actualmente Profesor emérito de Matemáticas de la Universidad de Oxford, y ya en los años 60 presentó su teoría de los “spin networks” que después fue tomada por Ashtekar y Rovelli, y otros, en la teoría de la gravitación cuántica.

A partir de los años 70, Penrose presentó su teoría de los “twistor”, que algunos físicos han aplicado a la teoría de las supercuerdas para resolver el enigma de las 11 dimensiones del espacio-tiempo. En su último libro “El camino a la Realidad” Penrose ha reivindicado la paternidad de las teorías de los “spin networks” y de los “twistors” que se empieza a utilizar por los físicos teóricos y que nosotros vamos a resumir brevemente.

Roger Penrose es uno de los nuevos humanistas del siglo que se ha interesado por los problemas de las matemáticas, de la física, de la biología, de la psicología y de la filosofía. Siguiendo el modelo de Popper de los tres mundos, ha trabajado sobre la flecha del mundo 1 de la física, al mundo 2 de la conciencia, y del mundo 3 de las matemáticas, al mundo 1.

En esta última dirección ha publicado numerosos libros y artículos, donde aborda la asignatura pendiente de la unificación de la mecánica cuántica y la teoría del campo gravitatorio. El camino que ha seguido Penrose es encontrar una base común a ambas.

Para ello ha introducido dos modelos: los “spin networks” y los “twistors”, el primero discreto, con una métrica intrínseca, no relativista, previo al concepto de espacio, el segundo continuo, con una métrica extrínseca, relativista e inmerso en un espacio-tiempo dado.

Con estos modelos intenta Penrose responder a la pregunta sobre el “por qué” de la realidad física, en vez del “cómo”. Nos encontramos así ante uno de los grandes misterios de la razón humana que nos acercan al misterio del Universo.

“Spin networks” y gravedad cuántica

El modelo de los “twistors” se ha aplicado con éxito a la clasificación de las partículas elementales y a la formulación de la relatividad general. Pero recientemente algunos modelos de la gravedad cuántica han retomado la idea de los “spin networks” de Penrose para desarrollar un modelo discreto llamado loop quantum gravity donde el espacio subyacente está discretizado.

Claro que son varias las corrientes que quieren abrirse camino hacia otras físicas nuevas.

La teoría de supercuerdas tiene tantas sorpresas fantásticas que cualquiera que investigue en el tema reconoce que está llena de magia. Es algo que funciona con tanta belleza… Cuando cosas que no encajan juntas e incluso se repelen, si se acerca la una a la otra alguien es capaz de formular un camino mediante el cual, no sólo no se rechazan, sino que encajan a la perfección dentro de ese sistema, como ocurre ahora con la teoría M que acoge con naturalidad la teoría de la relatividad general y la teoría mecánico-cuántica; ahí, cuando eso se produce, está presente la belleza.

Lo que hace que la teoría de supercuerdas sea tan interesante es que el marco estándar mediante el cual conocemos la mayor parte de la física es la teoría cuántica y resulta que ella hace imposible la gravedad. La relatividad general de Einstein, que es el modelo de la gravedad, no funciona con la teoría cuántica. Sin embargo, las supercuerdas modifican la teoría cuántica estándar de tal manera que la gravedad no sólo se convierte en posible, sino que forma parte natural del sistema; es inevitable para que éste sea completo.

¿Por qué es tan importante encajar la gravedad y la teoría cuántica? Porque no podemos admitir una teoría que explique las fuerzas de la naturaleza y deje fuera a una de esas fuerzas. Así ocurre con el Modelo Estándar que deja aparte y no incluye a la fuerza gravitatoria que está ahí, en la Naturaleza.

La teoría de supercuerdas se perfila como la teoría que tiene implicaciones si tratamos con las cosas muy pequeñas, en el microcosmos; toda la teoría de partículas elementales cambia con las supercuerdas que penetra mucho más; llega mucho más allá de lo que ahora es posible.

Se habla de cuerdas abiertas, cerradas o de lazos, de p branas donde p denota su dimensionalidad (así, 1 brana podría ser una cuerda y 2.

La topología es, el estudio de aquellas propiedades de los cuerpos geométricos que permanecen inalteradas por transformaciones continuas. La topología es probablemente la más joven de las ramas clásicas de las matemáticas. En contraste con el álgebra, la geometría y la teoría de los números, cuyas genealogías datan de tiempos antiguos, la topología aparece en el siglo diecisiete, con el nombre de analysis situs, ésto es, análisis de la posición.

De manera informal, la topología se ocupa de aquellas propiedades de las figuras que permanecen invariantes, cuando dichas figuras son plegadas, dilatadas, contraídas o deformadas, de modo que no aparezcan nuevos puntos, o se hagan coincidir puntos diferentes. La transformación permitida presupone, en otras palabras, que hay una correspondencia biunívoca entre los puntos de la figura original y los de la transformada, y que la deformación hace corresponder puntos próximos a puntos próximos. Esta última propiedad se llama continuidad, y lo que se requiere es que la transformación y su inversa sean ambas continuas: así, trabajarnos con homeomorfismos.

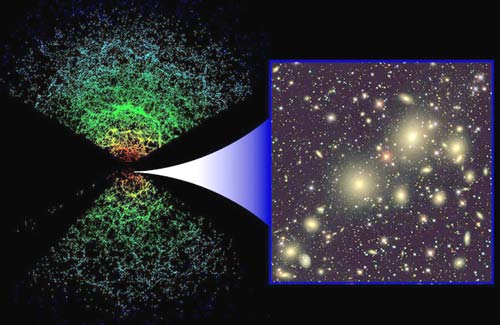

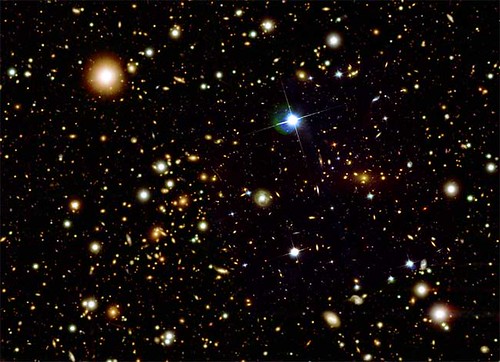

Aunque creo que aíun nos esconde algún secreto, todos sabemos ya cuál es, el «pegamento» que mantiene unidas a las grandes estructuras que podemos observar a nuestro alrededor (galaxias, cúmulos y supercúmulos) La Relatividad General vino a definir lo que ahora es una auténtica cosmología que nos marcaron los parámetros de cómo funciona el Universo a gran escala.

En cuanto a nuestra comprensión del universo a gran escala (supercúmulos de galaxias, ondas gravitacionales, posibles estrellas de Quarks-Gluones… el propio Big Bang…), creo que afectará a nuestra idea presente, al esquema que hoy rige y, como la nueva teoría, el horizonte se ampliará enormemente; el cosmos se presentará ante nosotros como un todo, con un comienzo muy bien definido y un final muy bien determinado. El Tiempo y la Entropía tienen mucho que decir en todo eso y, por el camino hacia el conocimiento pleno, tendremos que comprender, de manera completa y exacta que es la Luz, la Gravedad y… ¡tántas cosas!

Para cuando eso llegue, sabremos lo que es, como se genera y dónde están situados los orígenes de esa “fuerza”, “materia”, o, “energía” que ahora no sabemos ver para explicar el movimiento de las galaxias o la expansión del espacio mismo, la posible existencia de otros universos…

emilio silvera

Sep

20

La simetría CP y otros aspectos de la Física

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

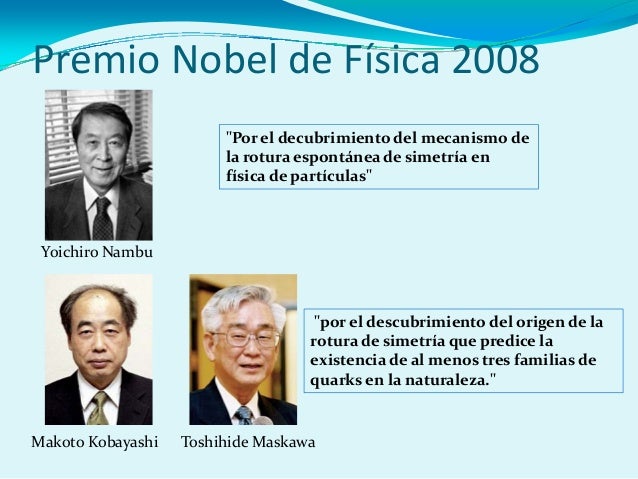

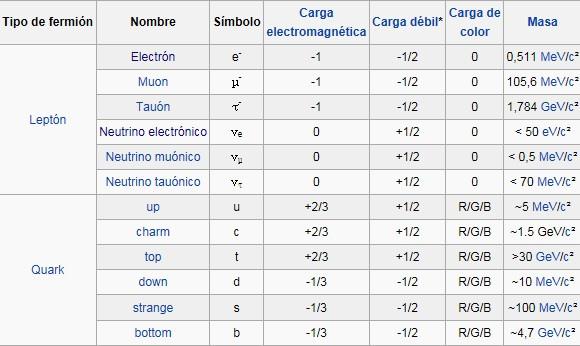

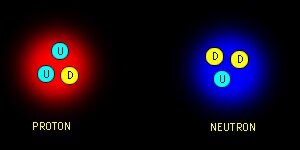

Los quarks al otro lado del espejo. Científicos del Laboratorio Nacional Jefferson Lab (EEUU) han verificado la rotura de la simetría de paridad (también llamada simetría del espejo) en los quarks mediante el bombardeo de núcleos de deuterio con electrones de alta energía. Los núcleos de deuterio están formados por un protón y un neutrón, es decir, por tres quarks arriba y tres quarks abajo. La dispersión inelástica entre un electrón y un quark, es decir, su colisión, está mediada por la interacción electrodébil, tanto por la fuerza electromagnética como por la fuerza débil. Esta última es la única interacción fundamental que viola la simetría de paridad.

Tenemos que saber cómo la violación de la simetría CP (el proceso que originó la materia) aparece, y, lo que es más importante, hemos de introducir un nuevo fenómeno, al que llamamos campo de Higgs, para preservar la coherencia matemática del modelo estándar. La idea de Higgs, y su partícula asociada, el bosón de Higgs, cuenta en todos los problemas que he mencionado antes. Parece, con tantos parámetros imprecisos (19) que, el modelo estándar se mueve bajo nuestros pies.

Entre los teóricos, el casamiento de la relatividad general y la teoría cuántica es el problema central de la física moderna. A los esfuerzos teóricos que se realizan con ese propósito se les llama “supergravedad”, “súpersimetría”, “supercuerdas” “teoría M” o, en último caso, “teoría de todo o gran teoría unificada”.

La Física nos lleva de vez en cuando a realizar viajes alucinantes. Se ha conseguido relacionar y vibrar a dos diamantes en el proceso conocido como entrelazamiento cuántico. El misterioso proceso, al que el propio Eisntein no supo darle comprensión completa, supone el mayor avance la fecha y abre las puertas de la computación cuántica. que nos hagamos una idea del hallazgo, en 1935 Einstein lo llegó a denominar la “acción fantasmal a distancia”. Un efecto extraño en donde se conecta un objeto con otro de manera que incluso si están separados por grandes distancias, una acción realizada en uno de los objetos afecta al otro.

Ahí tenemos unas matemáticas exóticas que ponen de punta hasta los pelos de las cejas de algunos de los mejores matemáticos del mundo (¿y Perelman? ¿Por qué nos se ha implicado?). Hablan de 10, 11 y 26 dimensiones, siempre, todas ellas espaciales menos una que es la temporal. Vivimos en cuatro: tres de espacio (este-oeste, norte-sur y arriba-abajo) y una temporal. No podemos, ni sabemos o no es posible instruir, en nuestro cerebro (también tridimensional), ver más dimensiones. Pero llegaron Kaluza y Klein y compactaron, en la longitud de Planck las dimensiones que no podíamos ver. ¡Problema solucionado! Pero se sigue hablando de partículas supersimétricas.

¿Quién puede ir a la longitud de Planck para verlas?

La puerta de las dimensiones más altas quedó abierta y, a los teóricos, se les regaló una herramienta maravillosa. En el Hiperespacio, todo es posible. Hasta el matrimonio de la relatividad general y la mecánica cuántica, allí si es posible encontrar esa soñada teoría de la Gravedad cuántica.

Así que, los teóricos, se han embarcado a la búsqueda de un objetivo audaz: buscan una teoría que describa la simplicidad primigenia que reinaba en el intento calor del universo en sus primeros tiempos, una teoría carente de parámetros, donde estén presentes todas las respuestas. Todo debe ser contestado a partir de una ecuación básica.

¿Dónde radica el problema?

El problema está en que la única teoría candidata no tiene conexión directa con el mundo de la observación, o no lo tiene todavía si queremos expresarnos con propiedad. La energía necesaria para ello, no la tiene ni la nueva capacidad energético del acelerador de partículas LHC . Ni sumando todos los aceleradores de partículas de nuestro mundo, podríamos lograr una energía de Planck (1019 GeV), que sería necesaria para poder llegar hasta las cuerdas vibrantes de la Teoría. Ni en las próximas generaciones seremos capaces de poder utilizar tal energía.

La verdad es que, la teoría que ahora tenemos, el Modelo Estándar, concuerda de manera exacta con todos los datos a bajas energías y contesta cosas sin sentido a altas energías. Sabemos sobre las partíoculas elementales que conforman la materia bariónica, es decir, los átomos que se juntan para formar moléculas, sustancias y cuerpos… ¡La materia! Pero, no sabemos si, pudiera haber algo más elemental aún más allá de los Quarks y, ese algo, pudieran ser esas cuerdas vibrantes que no tenemos capacidad de alcanzar.

¡Necesitamos algo más avanzado!

Se ha dicho que la función de la partícula de Higgs es la de dar masa a las Cuando su autor lanzó la idea al mundo, resultó además de nueva muy extraña. El secreto de todo radica en conseguir la simplicidad: el átomo resulto ser complejo lleno de esas infinitesimales partículas electromagnéticas que bautizamos con el nombre de electrones, resultó que tenía un núcleo que contenía, a pesar de ser tan pequeño, casi toda la masa del átomo. El núcleo, tan pequeño, estaba compuesto de otros objetos más pequeños aún, los quarks que estaban instalados en nubes de otras partículas llamadas gluones y, ahora, queremos continuar profundizando, sospechamos, que después de los quarks puede haber algo más.

Con 7 TeV ha sido suficiente para encontrar la famosa partícula de Higgs pero…

Bueno, la idea nueva que surgió es que el espacio entero contiene un campo, el campo de Higgs, que impregna el vacío y es el mismo en todas partes. Es decir, que si miramos a las estrellas en una noche clara estamos mirando el campo de Higgs. Las partículas influidas por este campo, toman masa. Esto no es por sí mismo destacable, pues las partículas pueden tomar energía de los campos (gauge) de los que hemos comentado, del campo gravitatorio o del electromagnético. Si llevamos un bloque de plomo a lo alto de la Torre Eiffel, el bloque adquiriría energía potencial a causa de la alteración de su posición en el campo gravitatorio de la Tierra.

Como E=mc2, ese aumento de la energía potencial equivale a un aumento de la masa, en este caso la masa del Sistema Tierra-bloque de plomo. Aquí hemos de añadirle amablemente un poco de complejidad a la venerable ecuación de Einstein. La masa, m, tiene en realidad dos partes. Una es la masa en reposo, m0, la que se mide en el laboratorio cuando la partícula está en reposo. La partícula adquiere la otra parte de la masa en virtud de su movimiento (como los protones en el acelerador de partículas, o los muones, que aumentan varias veces su masa cuando son lanzados a velocidades cercanas a c) o en virtud de su energía potencial de campo. Vemos una dinámica similar en los núcleos atómicos. Por ejemplo, si separamos el protón y el neutrón que componen un núcleo de deuterio, la suma de las masas aumenta.

Peor la energía potencial tomada del campo de Higgs difiere en varios aspectos de la acción de los campos familiares. La masa tomada de Higgs es en realidad masa en reposo. De hecho, en la que quizá sea la versión más apasionante de la teoría del campo de Higgs, éste genera toda la masa en reposo. Otra diferencia es que la cantidad de masa que se traga del campo es distinta para las distintas partículas.

Los teóricos dicen que las masas de las partículas de nuestro modelo estándar miden con qué intensidad se acoplan éstas al campo de Higgs.

La influencia de Higgs en las masas de los quarks y de los leptones, nos recuerda el descubrimiento por Pietez Zeeman, en 1.896, de la división de los niveles de energía de un electrón cuando se aplica un campo magnético al átomo. El campo (que representa metafóricamente el papel de Higgs) rompe la simetría del espacio de la que el electrón disfrutaba.

Hasta ahora no tenemos ni idea de que reglas controlan los incrementos de masa generados por el Higgs (de ahí la expectación creada por el nuevo acelerador de partículas LHC). Pero el problema es irritante: ¿por qué sólo esas masas -Las masas de los W+, W–, y Zº, y el up, el down, el encanto, el extraño, el top y el bottom, así como los leptones – que no forman ningún patrón obvio?

Las masas van de la del electrón 0’0005 GeV, a la del top, que tiene que ser mayor que 91 GeV. Deberíamos recordar que esta extraña idea (el Higgs) se empleó con mucho éxito para formular la teoría electrodébil (Weinberg-salam). Allí se propuso el campo de Higgs como una forma de ocultar la unidad de las fuerzas electromagnéticas y débiles. En la unidad hay cuatro partículas mensajeras sin masa -los W+, W–, Zº y fotón que llevan la fuerza electrodébil. Además está el campo de Higgs, y, rápidamente, los W y Z chupan la esencia de Higgs y se hacen pesados; el fotón permanece intacto. La fuerza electrodébil se fragmenta en la débil (débil porque los mensajeros son muy gordos) y la electromagnética, cuyas propiedades determina el fotón, carente de masa. La simetría se rompe espontáneamente, dicen los teóricos. Prefiero la descripción según la cual el Higgs oculta la simetría con su poder dador de masa.

Las masas de los W y el Z se predijeron con éxito a partir de los parámetros de la teoría electrodébil. Y las relajadas sonrisas de los físicos teóricos nos recuerdan que ^t Hooft y Veltman dejaron sentado que la teoría entera esta libre de infinitos.

Todos los intentos y los esfuerzos por hallar una pista del cuál era el origen de la masa fallaron. Feynman escribió su famosa pregunta: “¿Por qué pesa el muón?”. Ahora, por lo menos, tenemos una respuesta parcial, en absoluto completa. Una vez potente y segura nos dice: “!Higgs¡” Durante más de 60 años los físicos experimentadores se rompieron la cabeza con el origen de la masa, y ahora el campo Higgs presenta el problema en un contexto nuevo; no se trata sólo del muón. Proporciona, por lo menos, una fuente común para todas las masas. La nueva pregunta feynmariana podría ser: ¿Cómo determina el campo de Higgs la secuencia de masas, aparentemente sin patrón, que da a las partículas de la matería?

La variación de la masa con el estado de movimiento, el cambio de masa con la configuración del sistema y el que algunas partículas (el fotón seguramente y los neutrinos posiblemente) tengan masa en reposo nula son tres hechos que ponen entre dicho que el concepto de masa sea una tributo fundamental de la materia. Habrá que recordar aquel cálculo de la masa que daba infinito y nunca pudimos resolver; los físicos sólo se deshicieron del “renormalizándolo”, ese truco matemático que emplean cuando no saben hacerlo bien.

Ese es el problema de trasfondo con el que tenemos que encarar el problema de los quarks, los leptones y los vehículos de las fuerzas, que se diferencian por sus masas. Hace que la historia de Higgs se tenga en pie: la masa no es una propiedad intrinseca de las partículas, sino una propiedad adquirida por la interacción de las partículas y su entorno.

La idea de que la masa no es intrinseca como la carga o el espín resulta aún más plausible por la idílica idea de que todos los quarks y fotones tendrían masa cero. En ese caso, obedecerían a una simetría satisfactoria, la quiral, en laque los espines estarían asociados para siempre con su dirección de movimiento. Pero ese idilio queda oculto por el fenómeno de Higgs.

¡Ah, una cosa más! Hemos hablado de los bosones gauge y de su espín de una unidad; hemos comentado también las partículas fermiónicas de la materia (espin de media unidad). ¿Cuál es el pelaje de Higgs? Es un bosón de espin cero. El espín supone una direccionalidad en el espacio, pero el campo de Higgs de masa a los objetos dondequiera que estén y sin direccionalidad. Al Higgs se le llama a veces “bosón escalar” [sin dirección] por esa razón.

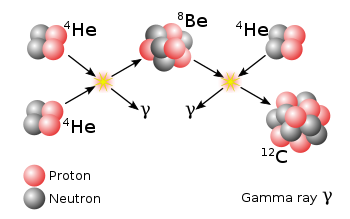

Basta con cambiar un quark tipo U a uno tipo D.

Pues justamente esto es lo que ocurre en la naturaleza cuando entra en acció la fuerzxa nuclear débil. Un quark tipo U cambia a uno tipo D por medio de la interacción débil así

Las otras dos partículas que salen son un anti-electrón y un neutrino. Este mismo proceso es el responsable del decaimiento radiactivo de algunos núcleos atómicos. Cuando un neutrón se convierte en un protón en el decaimiento radiactivo de un núcleo, aparece un electrón y un neutrino. Este es el origen de la radiación beta (electrónes).

La interacción débil, recordareis, fue inventada por E.Fermin para describir la desintegración radiactiva de los núcleos, que era básicamente un fenómeno de poca energía, y a medida que la teoría de Fermi se desarrolló, llegó a ser muy precisa a la hora de predecir un enorme número de procesos en el dominio de energía de los 100 MeV. Así que ahora, con las nuevas tecnologías y energías del LHC, las esperanzas son enormes para, por fin, encontrar el bosón Higgs origen de la masa… y algunas cosas más.

Hay que responder montones de preguntas. ¿Cuáles son las propiedades de las partículas de Higgs y, lo que es más importante, cuál es su masa? ¿Cómo reconoceremos una si nos la encontramos en una colisión de LHC? ¿Cuántos tipos hay? ¿Genera el Higgs todas las masas, o solo las hace incrementarse? ¿Y, cómo podemos saber más al respecto? Como s su partícula, nos cabe esperar que la veamos ahora después de gastar más de 50.000 millones de euros en los elementos necesarios para ello.

También a los cosmólogos les fascina la idea de Higgs, pues casi se dieron de bruces con la necesidad de tener campos escalares que participasen en el complejo proceso de la expansión del Universo, añadiendo, pues, un peso más a la carga que ha de soportar el Higgs.

El campo de Higgs, tal y como se lo concibe ahora, se puede destruir con una energía grande, o temperaturas altas. Estas generan fluctuaciones cuánticas que neutralizan el campo de Higgs. Por lo tanto, el cuadro que las partículas y la cosmología pintan juntas de lo que un universo primitivo puso y de resplandeciente simetría es demasiado caliente para Higgs. Pero cuando la temperatura cae bajo los 10′5 grados kelvin o 100 GeV, el Higgs empieza a actuar y hace su generación de masas. Así por ejemplo, antes de Higgs teníamos unos W, Z y fotones sin masa y la fuerza electrodébil unificada.

El Universo se expande y se enfría, y entonces viene el Higgs (que engorda los W y Z, y por alguna razón ignora el fotón) y de ello resulta que la simetría electrodébil se rompe.

Tenemos entonces una interacción débil, transportada por los vehículos de la fuerza W+, W–, Z0, y por otra parte una interacción electromagnética, llevada por los fotones. Es como si para algunas partículas del campo de Higgs fuera una especie de aceite pesado a través del que se moviera con dificultad y que las hiciera parecer que tienen mucha masa. Para otras partículas, el Higgs es como el agua, y para otras, los fotones y quizá los neutrinos, es invisible.

De todas las maneras, es tanta la ignorancia que tenemos sobre el origen de la masa que, nos agarramos como a un clavo ardiendo el que se ahoga, en este caso, a la partícula de Higgs que, algunos, han llegado a llamar, de manera un poco exagerada:

¡La partícula Divina!

¡Ya veremos en que termina todo esto! Y que explicación se nos ofrece desde el CERN en cuanto al auténtico escenario que según ellos, existe en el Universo para que sea posible que las partículas tomen su masa de ese oceáno de Higgs, en el que, según nuestro amigo Ramón Márquez, las partículas se frenan al interaccionar con el mismo y toman su masa, el lo llama el “efecto frenado”.

Peter Higgs, de la Universidad de Edimburgo, introdujo la idea en la física de partículas. La utilizaron los teóricos steven Weinberg y Abdus Salam, que trabajaban por separado, para comprender como se convertía la unificada y simétrica fuerza electrodébil, transmitida por una feliz familia de cuatro partículas mensajeras de masa nula, en dos fuerzas muy diferentes: la QED con un fotón carente de masa y la interacción débil con sus W+, W– y Z0 de masa grande. Weinberg y Salam se apoyaron en los trabajos previos de Sheldon Glasgow, quien tras los pasos de Julian Schwinger, sabía sólo que había una teoría electrodébil unificada, coherente, pero no unió todos los detalles. Y estaban Jeffrey Goldstone y Martines Veltman y Gerard’t Hooft. También hay otras a los que había que mencionar, pero lo que siempre pasa, quedan en el olvido de manera muy injusta. Además, ¿Cuántos teóricos hacen falta para encender una bombilla?

La verdad es que, casi siempre, han hecho falta muchos. Recordemos el largo recorrido de los múltiples detalle sueltos y físicos que prepararon el terreno para que, llegara Einstein y pudiera, uniéndolo todos, exponer su teoría relativista. (Mach, Maxwell, Lorentz… y otros).

Sobre la idea de Peter Higgs, Veltman, uno de sus arquitectos, dice que es una alfombra bajo la que barremos nuestra ignorancia. Glasgow es menos amable y lo llamó retrete donde echamos las incoherencias de nuestras teorías actuales. La objeción principal: que no tenemos la menor prueba experimental.

Ahora, por fin la tenemos con el LHC, y ésta pega, se la traspasamos directamente a la teoría de supercuerdas y a la materia oscura que, de momento, están en la sombra y no brillan con luz propia, toda vez que ninguna de ellas ha podido ser verificada, es decir, no sabemos si el Universo atiende a lo que en ellas se predice.

El modelo estándar es lo bastante fuerte para decirnos que la partícula de Higgs de menor masa (podría haber muchas) debe “pesar” menos de 1 TeV. ¿Por qué? Si tiene más de 1 TeV, el modelo estándar se vuelve incoherente y tenemos la crisis de la unitariedad.

Después de todo esto, llego a la conclusión de que, el campo de Higgs, el modelo estándar y nuestra idea de cómo pudo surgir el Universo no dependen de que se encuentre el bosón de Higgso se averigue si realmente existe la materia oscura, Aunque sepamos llegar al fondo de la Teoría de Cuerdas y confirmarla, Poder crear esa Teoría cuántica de la Gravedad…Y, en fín, seguir descubriendo los muchos misterios que no nos dejan saber lo que el Universo es. Ahora, por fin, tenemos grandes aceleradores y Telescopisos con la energía necesaria y las condiciones tecnológicas suficientes para que nos muestre todo eso que queremos saber y nos digan dónde reside esa verdad que incansables perseguimos. Sin embargo, siempre seguiremos haciendo preguntas y siempre, también, serán insuficientes, los aparatos que podamos construir para que nos digan como es el Universo y cómo funciona la Naturaleza. Saberlo todo, nunca sabremos.

¡La confianza en nosotros mismos, no tiene límites! Pero, no siempre ha estado justificada.

emilio silvera

Sep

18

¿Qué será la materia?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

« ¿Qué habrá en los Océanos de Higgs? ¡Si existen!

En primaria, nos decían que estaba en tres estados. Se profundizaba poco más y, el desconocimiento de la materia era grande

Tiene y encierra tantos misterios la materia que estamos aún y años-luz de saber y conocer sobre su verdadera naturaleza. Nos podríamos preguntar miles de cosas que no sabríamos contestar. Nos maravillan y asombran fenómenos naturales que ocurren ante nuestros ojos pero que tampoco sabemos, en realidad, a que son debidos. Si, sabemos ponerles etiquetas como, por ejemplo, la fuerza nuclear débil, la fisión espontánea que tiene lugar en algunos elementos como el protactinio o el torio y, con mayor frecuencia, en los elementos que conocemos como transuránicos.

A medida que los núcleos se hacen más grandes, la probabilidad de una fisión espontánea aumenta. En los elementos más pesados de todos (einstenio, fermio y mendelevio), esto se convierte en el método más importante de ruptura, sobrepasando a la emisión de partículas alfa.

Maravillas como el proceso triple Alfa nos hace pensar que la materia está viva. La radiación ha sido muy bien estudiada y hoy se conocen sus secretos. Sin embargo, son muchas las cosas que desconocemos y, nuestra curiosidad nos empuja continuamente a buscar esas respuestas.

El electrón y el positrón son notables por sus pequeñas masas (sólo 1/1.836 de la del protón, el neutrón, el antiprotón o antineutrón), y, por lo tanto, han sido denominados leptones (de la voz griega lepto que significa “delgado”).

El electrón es onda y partícula

Aunque el electrón fue descubierto en 1.897 por el físico británico Josepth John Thomson (1856-1940), el problema de su estructura, si la hay, no está resuelto. Conocemos su masa y su carga negativa que responden a 9,1093897 (54)x10-31kg la primera y, 1,602 177 33 (49)x10-19 culombios, la segunda, y también su radio clásico. No se ha descubierto aún ninguna partícula que sea menos masiva que el electrón (o positrón) y que lleve una carga eléctrica, sea lo que fuese (sabemos como actúa y cómo medir sus propiedades, pero aun no sabemos qué es), tenga asociada un mínimo de masa, y que esta es la que se muestra en el electrón.

Josepth John Thomson

Lo cierto es que, el electrón, es una maravilla en sí mismo. El Universo no sería como lo conocemos si el electrón (esa cosita “insignificante”), fuese distinto a como es, bastaría un cambio infinitesimal para que, por ejemplo, nosotros no pudiéramos estar aquí ahora.

(“Aunque no se trata propiamente de la imagen real de un electrón, un equipo de siete científicos suecos de la Facultad de Ingeniería de la Universidad de Lund consiguieron captar en vídeo por primera vez el movimiento o la distribución energética de un electrón sobre una onda de luz, tras ser desprendido previamente del átomo correspondiente.

Previamente dos físicos de la Universidad Brown habían mostrado películas de electrones que se movían a través de helio líquido en el International Symposium on Quantum Fluids and Solids del 2006. Dichas imágenes, que mostraban puntos de luz que bajaban por la pantalla fueron publicadas en línea el 31 de mayo de 2007, en el Journal of Low Temperature Physics.

En el experimento que ahora nos ocupa y dada la altísima velocidad de los electrones el equipo de investigadores ha tenido que usar una nueva tecnología que genera pulsos cortos de láser de luz intensa (“Attoseconds Pulses”), habida cuenta que un attosegundo equivalente a la trillonésima parte de un segundo”.)

¡No por pequeño, se es insignificante! Recordémoslo, todo lo grande está hecho de cosas pequeñas. Las inmensas galaxias son el conjunto de muchos pequeños átomos unidos para formar moléculas que a su vez se juntan y forman cuerpos. Los océanos de la Tierra, las montañas de Marte, los lagos de metaño de Titán, los hielos de Europa… ¡Todo está hecho de materia bariónica! Es decir, son pequeños Quarks y Leptones que conforman los átomos de lo que todo está hecho en nuestro Universo. Bueno, al menos todo lo que podemos ver.

Un “simple” átomo está conformado de una manera muy compleja. Por ejemplo, un protón está hecho de tres quarks: 2 up y 1 down. Mientras tanto, un neutrón está constituido de 2 quarks down y 1 quark up. Los protones y neutrones son hadrones de la rama barión, es decir, que emiten radiación. También son fermiones y, debido a su función en el átomo, se les suele llamar nucleones. Dichos quarks existen confinados dentro de los protones y neutrones inmersos en una especie de pegamento gelatinoso formado por unas partículas de la familia de los Bosones que se llaman Gluones y son los transmisores de la Fuerza nuclear fuerte. Es decir, si los quarks se quieren separar son atrapados por esa fuerza que los retiene allí confinados.

Louis de Broglie

Estudiar el “universo” de las partículas subatómicas es fascinante y se pueden llegar a entender las maravillas que nos muestra la mecánica cuántica, ese extraño mundo que nada tiene que ver con el nuestro cotidiano situado en el macromundo. En realidad, existen partículas que no tienen en absoluto asociada en ellas ninguna masa (es decir, ninguna masa en reposo). Por ejemplo, las ondas de luz y otras formas de radiación electromagnéticas se comportan como partículas (Einstein en su efecto fotoeléctrico y De Broglie en la difracción de electrones.)

Imagen ilustrativa de la dualidad onda-partícula, en el cual se puede ver cómo un mismo fenómeno puede tener dos percepciones distintas. Esta manifestación en forma de partículas de lo que, de ordinario, concebimos como una onda se denomina fotón, de la palabra griega que significa “luz”. Recientemente he podido leer que unos científicos han logrado (de alguna manera) “congelelar” la luz y hacerla sólida. Cuando recabe más información os lo contaré con todo detalle. El fotón, el cuanto de luz, es en sí mismo una maravilla.

El fotón tiene una masa de 1, una carga eléctrica de 0, pero posee un espín de 1, por lo que es un bosón. ¿Cómo se puede definir lo que es el espín? Los fotones toman parte en las reacciones nucleares, pero el espín total de las partículas implicadas antes y después de la reacción deben permanecer inmutadas (conservación del espín). La única forma que esto suceda en las reacciones nucleares que implican a los fotones radica en suponer que el fotón tiene un espín de 1. El fotón no se considera un leptón, puesto que este termino se reserva para la familia formada por el electrón, el muón y la partícula Tau con sus correspondientes neutrinos: Ve, Vu y VT.

Existen razones teóricas para suponer que, cuando las masas se aceleran (como cuando se mueven en órbitas elípticas en torno a otra masa o llevan a cabo un colapso gravitacional), emiten energía en forma de ondas gravitacionales. Esas ondas pueden así mismo poseer aspecto de partícula, por lo que toda partícula gravitacional recibe el nombre de gravitón.

La fuerza gravitatoria es mucho, mucho más débil que la fuerza electromagnética. Un protón y un electrón se atraen gravitacionalmente con sólo 1/1039 de la fuerza en que se atraen electromagnéticamente. El gravitón (aún sin descubrir) debe poseer, correspondientemente, menos energía que el fotón y, por tanto, ha de ser inimaginablemente difícil de detectar.

El gravitón parece estar riéndose de todos y no se deja ver. El gravitón es la partícula elemental responsable de la fuerza de la gravedad. Todavía no ha sido descubierto experimentalmente. Teóricamente debería tener masa en reposo nula. ¿Qué límites para la masa del gravitón ofrece el fondo cósmico de microondas? El gravitón es la partícula elemental responsable de la “versión” cuántica de gravedad. No ha sido descubierto aún, aunque pocos dudan de su existencia. ¿Qué propiedades tiene? Debe ser un bosón de espín 2 y como la gravedad parece ser una fuerza de largo alcance, debe tener masa en reposo muy pequeña (billones de veces más pequeña que la del electrón), posiblemente es exactamente cero (igual que parecer ser la del fotón).

De todos modos, el físico norteamericano Joseph Weber emprendió en 1.957 la formidable tarea de detectar el gravitón. Llegó a emplear un par de cilindros de aluminio de 153 cm., de longitud y 66 de anchura, suspendidos de un cable en una cámara de vacío. Los gravitones (que serían detectados en forma de ondas), desplazarían levemente esos cilindros, y se empleó un sistema para detectar el desplazamiento que llegare a captar la cienmillonésima parte de un centímetro.

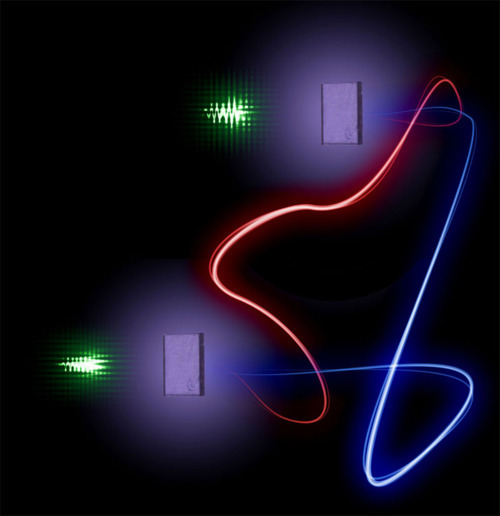

Para detectar ondas gravitacionales necesitamos instrumentos extremadamente precisos que puedan medir distancias en escalas diminutas. Una onda gravitacional afecta longitudes en escalas de una millonésima de billonésima de metro, así que ¡necesitamos un instrumento que sea lo suficientemente sensible para “ver” a esas escalas!

El interferómetro funciona enviando un haz de luz que se separa en dos haces; éstos se envían en direcciones diferentes a unos espejos donde se reflejan de regreso, entonces los haces al combinarse presentarán interferencia.

Las débiles ondas de los gravitones, que producen del espacio profundo, deberían chocar contra todo el planeta, y los cilindros separados por grandes distancias se verán afectados de forma simultánea. En 1.969, Weber anunció haber detectado los efectos de las ondas gravitatorias. Aquello produjo una enorme excitación, puesto que apoyaba una teoría particularmente importante (la teoría de Einstein de la relatividad general). Desgraciadamente, nunca se pudo comprobar mediante las pruebas realizadas por otros equipos de científicos que duplicaran el hallazgo de Weber.

De todas formas, no creo que, a estas alturas, nadie pueda dudar de la existencia de los gravitones, el bosón mediador de la fuerza gravitatoria. La masa del gravitón es 0, su carga es 0, y su espín de 2. Como el fotón, no tiene antipartícula, ellos mismos hacen las dos versiones.

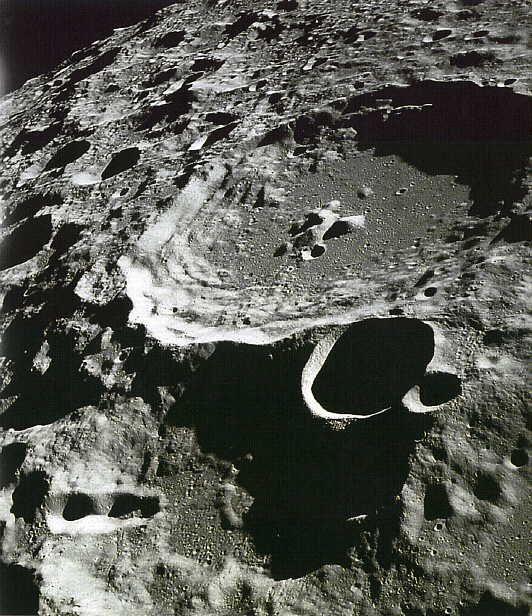

Tenemos que volver a los que posiblemente son los objetos más misteriosos de nuestro Universo: Los agujeros negros. Si estos objetos son lo que se dice (no parece que se pueda objetar nada en contrario), seguramente serán ellos los que, finalmente, nos faciliten las respuestas sobre las ondas gravitacionales y el esquivo gravitón.

Imagen de un agujero negro en el núcleo de una galaxia arrasando otra próxima- NASA

La onda gravitacional emitida por el agujero negro produce una ondulación en la curvatura del espacio-temporal que viaja a la velocidad de la luz transportada por los gravitones. Algunos proyectos como LIGO, están a la caza de esas ondas gravitatotias y, los expertos dicen que, cuando podamos leer sus mensajes, se presentará ante nosotros todo un nuevo universo que aíun no conocemos. Ahora, todo lo que captamos, las galaxias y estrellas lejanas, son gracias a la luz que viaja desde miles de millones de años luz hasta nosotros, los telescopios la captan y nos muestran esas imágenes de objetos lejanos pero, ¿qué veremos cuando sepamos captar esas ondas hgravitatorias que viajan por el Espacio a la velocidad de la luz como los fotones y, son el resultado del choque de galaxias, de agujeros negros y de estrellas de nuetrones?

Hay aspectos de la física que me dejan totalmente sin habla, me obligan a pensar y me transporta de este mundo material nuestro a otro fascinante donde residen las maravillas del Universo. Hay magnitudes asociadas con las leyes de la gravedad cuántica. La longitud de Planck-Wheeler, ![]() es la escala de longitud por debajo de la cual el espacio tal como lo conocemos deja de existir y se convierte en espuma cuántica. El tiempo de Planck-Wheeler (1/c veces la longitud de Planck-Wheeler o aproximadamente 10-43 segundos), es el intervalo de tiempo más corto que puede existir; si dos sucesos están separados por menos que esto, no se puede decir cuál sucede antes y cuál después. El área de Planck-Wheeler (el cuadrado de la longitud de Planck-Wheeler, es decir, 2,61×10-66cm2) juega un papel clave en la entropía de un agujero negro.

es la escala de longitud por debajo de la cual el espacio tal como lo conocemos deja de existir y se convierte en espuma cuántica. El tiempo de Planck-Wheeler (1/c veces la longitud de Planck-Wheeler o aproximadamente 10-43 segundos), es el intervalo de tiempo más corto que puede existir; si dos sucesos están separados por menos que esto, no se puede decir cuál sucede antes y cuál después. El área de Planck-Wheeler (el cuadrado de la longitud de Planck-Wheeler, es decir, 2,61×10-66cm2) juega un papel clave en la entropía de un agujero negro.

Me llama poderosamente la atención lo que conocemos como las fluctuaciones de vacío, esas oscilaciones aleatorias, impredecibles e ineliminables de un campo (electromagnético o gravitatorio), que son debidas a un tira y afloja en el que pequeñas regiones del espacio toman prestada momentáneamente energía de regiones adyacentes y luego la devuelven. Hace un par de días que hablamos de ello.

Ordinariamente, definimos el vacío como el espacio en el que hay una baja presión de un gas, es decir, relativamente pocos átomos o moléculas. En ese sentido, un vacío perfecto no contendría ningún átomo o molécula, pero no se puede obtener, ya que todos los materiales que rodean ese espacio tienen una presión de vapor finita. En un bajo vacío, la presión se reduce hasta 10-2 pascales, mientras que un alto vacío tiene una presión de 10-2-10-7 pascales. Por debajo de 10-7 pascales se conoce como un vacío ultraalto.

El primer gran vacío en ser detectado fue el de Boötes en 1.981; tiene un radio de unos 180 millones de años luz y su centro se encuentra a aproximadamente 500 millones de años luz de la Vía Láctea. La existencia de grandes vacíos no sorprende a la comunidad de astrónomos y cosmólogos, dada la existencia de cúmulos de galaxias y supercúmulos a escalas muy grandes. Claro que, según creo yo personalmente, ese vacío, finalmente, resultará que está demasiado lleno, hasta el punto de que su contenido nos manda mensajes que, aunque lo hemos captado, no lo sabemos descifrar.

No puedo dejar de referirme al vaciotheta (vació θ) que, es el estado de vacío de un campo gauge no abeliano (en ausencia de campos fermiónicos y campos de Higgs). En el vacío theta hay un número infinito de estados degenerados con efecto túnel entre estos estados. Esto significa que el vacío theta es análogo a una fundón de Bloch en un cristal.

Se puede derivar tanto como un resultado general o bien usando técnicas de instantón. Cuando hay un fermión sin masa, el efecto túnel entre estados queda completamente suprimido. Cuando hay campos fermiónicos con masa pequeña, el efecto túnel es mucho menor que para campos gauge puros, pero no está completamente suprimido.

emilio silvera

Sep

13

Espaciotiempo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Curvatura del Espacio-Tiempo

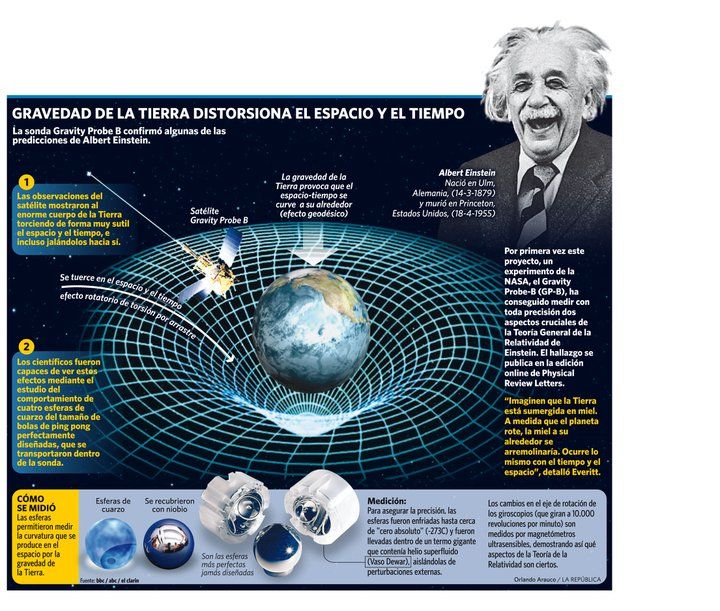

Hay que entender que el espaciotiempo es la descripción en cuatro dimensiones del universo en la que la posición de un objeto se especifica por tres coordenadas en el espacio y una en el tiempo.

De acuerdo con la relatividad especial, no existe un tiempo absoluto que pueda ser medido con independencia del observador, de manera que eventos simultáneos para un observador ocurren en instantes diferentes vistos desde otro lugar. El tiempo puede ser medido, por tanto, de manera relativa, como lo son las posiciones en el espacio (Euclides) tridimensional, y esto puede conseguirse mediante el concepto de espaciotiempo. La trayectoria de un objeto en el espaciotiempo se denomina por el nombre de línea de universo. La relatividad general nos explica lo que es un espaciotiempo curvo con las posiciones y movimientos de las partículas de materia. La relatividad especial nos explica otras cosas, complementando así, una teoría completa y precisa de la Naturaleza del Universo.

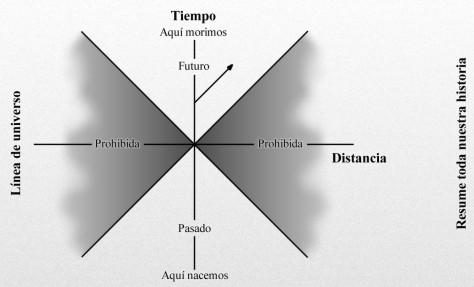

Nuestra línea de universo resume toda nuestra historia, desde que nacemos hasta que morimos. Cuanto más rápido nos movemos más se inclina la línea de Universo. Sin embargo, la velocidad más rápida a la que podemos viajar es la velocidad de la luz. Por consiguiente, una parte de este diagrama espacio – temporal está “prohibida”; es decir, tendríamos que ir a mayor velocidad que la luz para entrar en esta zona prohibida por la relatividad especial de Einstein que, nos dice que nada en nuestro Universo puede viajar a velocidades superiores a C.

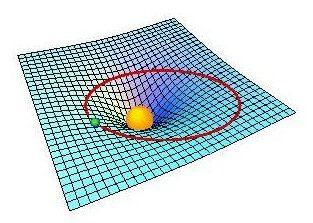

La curvatura del espaciotiempo es la propiedad del espaciotiempo en la que las leyes familiares de la geometría no son aplicables en regiones donde los campos gravitatorios son intensos. La relatividad general de Einstein, nos explica y demuestra que el espaciotiempo está íntimamente relacionado con la distribución de materia en el universo, y nos dice que el espacio se curva en presencia de masas considerables como planetas, estrellas o galaxias (entre otros).

Einstein lo dedujo en una fórmula matemática que relaciona la geometría del espaciotiempo con la distribución de masa y energía: esta fórmula se conoce como ecuación de Einstein y es el centro medular de la teoría de la relatividad general.

La equivalencia aceleración-gravitación llevó a Einstein, de forma genial, a la concepción de la fuerza de la gravedad como una curvatura del espaciotiempo. La visualización de este hecho la podemos observar en la figura: una superficie elástica (semejante al espaciotiempo) se curva bajo la acción de objetos pesados (las grandes masas, de intensos campos gravitatorios), de forma que las trayectorias (geodésicas) que pueden seguir los objetos pequeños cuando están cerca de los grandes se acercan a los mismos. Einstein formuló una ecuación que muestra el grado de curvatura del espaciotiempo en función de la cantidad de masa, relaciona masa con curvatura: materia (o energía) con deformación del espaciotiempo.

Así, en un espacio de sólo dos dimensiones, como una lámina de goma plana, la geometría de Euclides se aplica de manera que la suma de los ángulos internos de un triángulo en la lámina es de 180°. Si colocamos un objeto masivo sobre la lámina de goma, la lámina se distorsionará y los caminos de los objetos que se muevan sobre ella se curvaran. Esto es, en esencia, lo que ocurre en relatividad general.

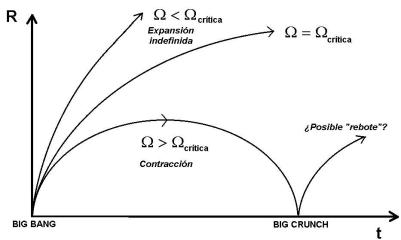

En los modelos cosmológicos más sencillos basados en los modelos de Friedmann, la curvatura de espaciotiempo está relacionada simplemente con la densidad media de la materia, y se describe por una función matemática denominada métrica de Robertson-Walker. Si un universo tiene una densidad mayor que la densidad crítica, se dice que tiene curvatura positiva, queriendo decir que el espaciotiempo está curvado sobre sí mismo, como la superficie de una esfera; la suma de los ángulos de un triángulo que se dibuje sobre la esfera es entonces mayor que 180°. Dicho universo sería infinito y se expandiría para siempre, es el universo abierto. Un universo de Einstein-de Sitter tiene densidad crítica exacta y es, por consiguiente, espacialmente plano (euclideo) infinito en el espacio y en el tiempo.

- universo de Einstein-de Sitter Wm= 1, Wl= 0

- Universo cerrado Wm= 2, Wl= 0

- modelo favorito actualmente con Wl= 0.75, Wm= 0.25

- Wl= 0, Wm= 0

- universo de de Sitter sin Big Bang Wl= 1, Wm= 0

Representación gráfica de los espacios que dan lugar a los tres posibles formas de universo antes referida en función de la densidad crítica que hará un universo plano, un universo abierto o un universo curvo y cerrado.

Hemos mencionado antes la relatividad del tiempo que para el mismo suceso será distinto en función de quién sea el que cronometre; por ejemplo, el tiempo transcurre más despacio para el astronauta que en nave espacial viaja a velocidades próximas a c, la velocidad de la luz. Según la teoría de la relatividad especial de Einstein, en el caso antes señalado, el tiempo del astronauta viajero avanza más lentamente en un factor que denotamos con la ecuación , cuando lo mide un sistema de referencia que viaja a una velocidad v relativa al otro sistema de referencia; c es la velocidad de la luz. Este principio ha sido verificado de muchas maneras; por ejemplo, comparando las vidas medias de los muones rápidos, que aumentan con la velocidad de las partículas en una cantidad predicha en este factor de la anterior ecuación.

Un ejemplo sencillo de la dilatación del tiempo es la conocida paradoja de los gemelos. Uno viaja al espacio y el otro lo espera en la Tierra. El primero hace un viaje a la velocidad de la luz hasta Alfa de Centauri y regresa. Cuando baja de la nave espacial, tiene 8’6 años más que cuando partió de la Tierra. Sin embargo, el segundo gemelo que esperó en el planeta Tierra, al regreso de su hermano, era ya un viejo jubilado. El tiempo transcurrido había pasado más lento para el gemelo viajero.

Otra curiosidad de la relatividad especial es la que expresó Einstein mediante su famosa fórmula de E = mc2, que nos viene a decir que masa y energía son dos aspectos de una misma cosa. Podríamos considerar que la masa (materia), es energía congelada. La bomba atómica demuestra la certeza de esta ecuación.

Uno de los gráficos anteriores, que es una muestra de las tres posibles maneras en que puede estar conformado nuestro universo, dependerá finalmente, de la densidad critica, es decir, de la masa que realmente contenga el universo. Claro que, según dicen, hay por ahí una materia desconocida que denominamos “oscura” y que, al parecer, confroma la mayor parte de la materia del universo.

“Es un tipo de masa invisible que posee gran atracción gravitatoria. El descubrimiento lo realizó, por medios de rayos X, el laboratorio Chandra perteneciente a la NASA. (Pongamos en cuarentena lo de “descubrimiento”).

Los astrónomos dicen que han encontrado las mejores pruebas hasta la fecha sobre la “Materia Oscura”, la misteriosa sustancia invisible que se cree constituye la mayor parte de la masa del universo. En la imagen de arriba han querido significar, diferenciándola en colores, las dos clases de materia, la bariónica y la oscura que, en este caso, sería la azulada -según dicen-. Sin embargo, la imagen no refleja la proporción que dicen existe entre la una y la otra.

En el Universo, como ocurre en los átomos, casi todo son espacios vacíos

La densidad crítica está referida a la densidad media de materia requerida para que la gravedad detenga la expansión de nuestro universo. Así que si la densidad es baja se expandirá para siempre, mientras que una densidad muy alta colapsará finalmente. Si tiene exactamente la densidad crítica ideal, de alrededor de 10-29 g/cm3, es descrito por el modelo al que antes nos referimos conocido como de Einstein-de Sitter, que se encuentra en la línea divisoria de estos dos extremos. La densidad media de materia que puede ser observada directamente en nuestro universo representa sólo el 20% del valor crítico. Puede haber, sin embargo, una gran cantidad de materia oscura que elevaría la densidad hasta el valor crítico. Las teorías de universo inflacionario predicen que la densidad presente debería ser muy aproximada a la densidad crítica; estas teorías requieren la existencia de materia oscura.

Conforme a lo antes dicho, la densidad media de materia está referida al hecho de distribuir de manera uniforme toda la materia contenida en las galaxias a lo largo de todo el universo. Aunque las estrellas y los planetas son más densos que el agua (alrededor de 1 g/cm3), la densidad media cosmológica es extremadamente baja, como se dijo antes, unos 10-29 g/cm3, o 10-5 átomos/cm3, ya que el universo está formado casi exclusivamente de espacios vacíos, virtualmente vacíos, entre las galaxias. La densidad media es la que determinará si el universo se expandirá o no para siempre.

Arriba tenemos uan visión del enorme cúmulo de galaxias Abell 2218, ubicado en la constelación de Draco a unos dos mil millones de años-luz de la Tierra.

En presencia de grandes masas de materia, tales como planetas, estrellas y galaxias y supercúmulos de galaxias, está presente el fenómeno descrito por Einstein en su teoría de la relatividad general, la curvatura del espaciotiempo, eso que conocemos como gravedad, una fuerza de atracción que actúa entre todos los cuerpos y cuya intensidad depende de las masas y de las distancias que los separan; la fuerza gravitacional disminuye con el cuadrado. La gravitación es la más débil de las cuatro fuerzas fundamentales de la naturaleza. Isaac Newton formuló las leyes de la atracción gravitacional y mostró que un cuerpo se comporta gravitacionalmente como si toda su masa estuviera concentrada en su centro de gravedad. Así, pues, la fuerza gravitacional actúa a lo largo de la línea que une los centros de gravedad de las dos masas (como la Tierra y la Luna, por ejemplo).

En la teoría de la relatividad general, la gravitación se interpreta como una distorsión del espacio que se forma alrededor de la masa que provoca dicha distorsión, cuya importancia iría en función de la importancia de la masa que distorsiona el espacio que, en el caso de estrellas con gran volumen y densidad, tendrán una importancia considerable, igualmente, la fuerza de gravedad de planetas, satélites y grandes objetos cosmológicos, es importante.

Esta fuerza es la responsable de tener cohexionado a todo el universo, de hacer posible que existan las galaxias, los sistemas solares y que nosotros mismos tengamos bien asentados los pies a la superficie de nuestro planeta Tierra, cuya gravedad tira de nosotros para que así sea.

La fuerza de gravedad hace posible la cohexión del Sistema Solar

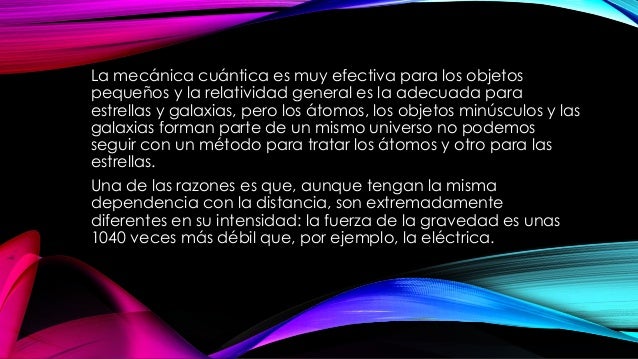

No obstante, a escala atómica la fuerza gravitacional resulta ser unos 1040 veces más débil que la fuerza de atracción electromagnética, muy potente en el ámbito de la mecánica cuántica donde las masas de las partículas son tan enormemente pequeñas que la gravedad es despreciable.

La gravitación cuántica es la teoría en la que las interacciones gravitacionales entre los cuerpos son descritas por el intercambio de partículas elementales hipotéticas denominadas gravitones. El gravitón es el cuanto del campo gravitacional. Los gravitones no han sido observados, aunque se presume que existen por analogía a los fotones de luz.

Tener en nuestras manos la Gravitación Cuántica, es cosa del futuro

La teoría cuántica es un ejemplo de talento que debemos al físico alemán Max Planck (1.858 – 1.947) que, en el año 1.900 para explicar la emisión de radiación de cuerpo negro de cuerpos calientes, dijo que la energía se emite en cuantos, cada uno de los cuales tiene una energía igual a hv, donde h es la constante de Planck (E = hv o ħ = h/2π) y v es la frecuencia de la radiación. Esta teoría condujo a la teoría moderna de la interacción entre materia y radiación conocida como mecánica cuántica, que generaliza y reemplaza a la mecánica clásica y a la teoría electromagnética de Maxwell. En la teoría cuántica no relativista se supone que las partículas no son creadas ni destruidas, que se mueven despacio con respecto a la velocidad de la luz y que tienen una masa que no cambia con la velocidad. Estas suposiciones se aplican a los fenómenos atómicos y moleculares y a algunos aspectos de la física nuclear. La teoría cuántica relativista se aplica a partículas que viajan cerca de la velocidad de la luz, como por ejemplo, el fotón

De todas las maneras, los misterios cuánticos serán desvelados por nuestras mentes poderosas de la misma manera que hemos podido traspasar otras barreras del saber. Llegará ese tiempo futuro en el cual, dejará de ser un misterio esa compleja unión de la Gravedad de Eintein con la Cuántica de Planck. Claro que, como decía por alguna parte, el futuro estará cargado de nuestro presente y, si no hacemos ahora lo que debemos…mal pintarán las cosas.

emilio silvera

Sep

11

¿La Física? ¡Una maravilla! Nos dice cómo funciona la Naturaleza

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Ylia Prigogine ¡Qué personaje!

El Universo y la Vida… ¡Nuestra imaginación!

En su Libro Partículas, Gerard ´t Hofft, Premio Nobel de Física, nos cuenta:

“En el mundo de los seres vivos, la escala o tamaño crea importantes diferencias. En muchos aspectos, la anatomía de un ratón es una copia de la de un elefante, pero mientras que un ratón trepar por una pared prácticamente vertical sin mucha dificultad (y se puede caer desde una altura varias veces mayor que su propio tamaño sin hacerse daño), un elefante no sería capaz de realizar tal hazaña. Con bastante generalidad se puede afirmar que los efectos de la gravedad son menos importantes cuanto menores sean los objetos que consideremos (sean vivos o inanimados).”

Cuando llegamos a los seres unicelulares, se ve que ellos no hay distinción entre arriba y abajo. Para ellos, la tensión superficial del agua es mucho más importante que la fuerza de la gravedad a esa escala. Tranquilamente se pueden mover y desplazar por encima de una superficie acuática. Los pluricelulares no pueden hacer tal cosa.

La tensión superficial es una consecuencia de que todas las moléculas y los átomos se atraen unos a otros con una fuerza que nosotros llamamos de Van der Waals. fuerza tiene un alcance muy corto; para ser precisos, diremos que la intensidad de esta fuerza a una distancia r es aproximadamente 1/r7. Esto significa que si se reduce la distancia dos átomos a la mitad de la fuerza de Van der Waals con la que se atraen uno a otro se hace 2 × 2 × 2 × 2 × 2 × 2 × 2 = 128 veces más intensa. Cuando los átomos y las moléculas se acercan mucho unos a otros quedan unidos muy fuertemente a través de esta fuerza. El conocimiento de esta fuerza se debe a Johannes Diderik Van der Waals (1837 – 1923) con su tesis sobre la continuidad del líquido y gaseoso que le haría famoso, ya que en esa época (1873), la existencia de las moléculas y los átomos no estaba completamente aceptado.

La tensión superficial del agua, es el efecto físico (energía de atracción entre las moléculas) que “endurece” la capa superficial del agua en reposo y permite a algunos insectos, como el mosquito y otros desplazarse por la superficie del agua sin hundirse.

El famoso físico inglés James Clerk Maxwell, que formuló la teoría del electromagnetismo de Faraday, quedó muy impresionado por este de Van der Waals.

Los tamaños de los seres uniceculares, animales y vegetales, se miden en micrómetros o “micras”, donde 1 micra es 1/1.000 de milímetro, aproximadamente el tamaño de los detalles más pequeños que se pueden observar con un microscopio ordinario. El mundo de los microbios es fascinante, pero no es el objeto de este trabajo, y continuaremos el viaje emprendido las partículas elementales que forman núcleos, átomos, células y materia, así como las fuerzas que intervienen en las interacciones fundamentales del universo y que afecta a todo lo que existe.

Hemos hablado del electrón que rodea el núcleo, de su carga eléctrica negativa que complementa la positiva de los protones y hace estable al átomo; una masa de solamente 1/1.836 de la del núcleo más ligero (el del hidrógeno). La importancia del electrón es vital en el universo.

Pero busquemos los “cuantos”. La física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck propuso una posible solución a un problema que había intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menor intensidad, por los objetos más fríos (radiación de cuerpo negro).

Estaba bien aceptado entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía. Pero si utilizamos las leyes de la termodinámica para calcular la intensidad de una radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano y, luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico a una cierta longitud de onda característica, y que la intensidad disminuye tanto para longitudes mayores como para menores. Esta longitud de onda característica es inversamente proporcional a la temperatura absoluta de objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273º bajo cero). Cuando a 1.000º C un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de luz visible.

Radiación de Cuerpo Negro

Un cuerpo negro es un objeto teórico o ideal que absorbe toda la luz y toda la energía radiante que incide sobre él. Nada de la radiación incidente se refleja o pasa a través del cuerpo negro. A pesar de su , el cuerpo negro emite luz y constituye un modelo ideal físico para el estudio de la emisión de radiación electromagnética. El nombre Cuerpo negro fue introducido por Gustav Kirchhoff en 1862.

La luz emitida por un cuerpo negro se denomina radiación de cuerpo negro. Todo cuerpo emite energía en de ondas electromagnéticas, siendo esta radiación, que se emite incluso en el vacío, tanto más intensa cuando más elevada es la temperatura del emisor. La energía radiante emitida por un cuerpo a temperatura ambiente es escasa y corresponde a longitudes de onda superiores a las de la luz visible (es decir, de menor frecuencia). Al elevar la temperatura no sólo aumenta la energía emitida sino que lo hace a longitudes de onda más cortas; a esto se debe el cambio de color de un cuerpo cuando se calienta. Los cuerpos no emiten con igual intensidad a todas las frecuencias o longitudes de onda, sino que siguen la ley de Planck.

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en paquetes de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de onda, y por tanto, proporcional a la frecuencia de radiación emitida. La fórmula es E = h?, donde E es la energía del paquete, ? es la frecuencia y h es una nueva constante fundamental de la naturaleza, la constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo nueva condición, el resultado coincidió perfectamente con las observaciones.

Poco tiempo después, en 1905, Einstein formuló esta teoría de una manera mucho más tajante: él sugirió que los objetos calientes no son los únicos que emiten radiación en paquetes de energía, sino que toda la radiación consiste en múltiplos del paquete de energía de Planck. El príncipe francés Louis-Victor de Broglie, dándole otra vuelta a la teoría, propuso que no sólo cualquier cosa que oscila tiene energía, sino que cualquier cosa con energía se debe comportar una “onda” que se extiende en una cierta región del espacio, y que la frecuencia ? de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilantes de campos de fuerza, esto lo veremos más adelante.

El curioso comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de de Broglie. Poco después, en 1926, Edwin Schrödinger descubrió cómo escribir la teoría ondulatoria de de Broglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños quedaba exactamente determinado por las recién descubiertas “ecuaciones de ondas cuánticas”.

Está bien comprobado que la mecánica cuántica funciona de maravilla…, pero, sin embargo, surge una pregunta muy formal: ¿qué significan realmente estas ecuaciones?, ¿qué es lo que están describiendo? Isaac Newton, allá en 1867 formuló cómo debían moverse los planetas alrededor del Sol, estaba claro todo el mundo qué significaban sus ecuaciones: que los planetas estaban siempre en una posición bien definida des espacio y que sus posiciones y sus velocidades en un momento concreto determinan inequívocamente cómo evolucionarán las posiciones y las velocidades en el tiempo.

Pero los electrones todo es diferente. Su comportamiento parece estar envuelto en misterio. Es como si pudieran “existir” en diferentes lugares simultáneamente, como si fueran una nube o una onda, y esto no es un efecto pequeño. Si se realizan experimentos con suficiente precisión, se puede determinar que el electrón parece capaz de moverse simultáneamente a lo largo de trayectorias muy separadas unas de otras. ¿Qué puede significar todo esto?

Niels Bohr consiguió responder a esta pregunta de tal que con su explicación se pudo seguir trabajando, y muchos físicos siguen considerando su respuesta satisfactoria. Se conoce como la interpretación de Copenhague de la mecánica cuántica.

Si la mecánica cuántica tiene cosas extrañas y el espín es una de ellas. Y si uno piensa que la intuición le ayudará a comprender todo esto, pues no lo hará, o es poco probable que lo haga. Las partículas tienen un espín fundamental. Al igual que la carga eléctrica o la masa, el espín ayuda a definir que de partícula es cada una.

Las leyes de la mecánica cuántica han sido establecidas con mucha precisión; permite cómo calcular cualquier cosa que queramos saber. Pero si queremos “interpretar” el resultado, nos encontramos con una curiosa incertidumbre fundamental: que varias propiedades de las partículas pequeñas no pueden estar bien definidas de manera simultánea. Por ejemplo, podemos determinar la velocidad de una partícula con mucha precisión, pero entonces no sabremos exactamente dónde se encuentra; o a la inversa, podemos determinar la posición con precisión, pero entonces su velocidad queda mal definida. Si una partícula tiene espín (rotación alrededor de su eje), la dirección alrededor de la cual está rotando (la orientación del eje) no puede ser definida con gran precisión.

La posición y el momento de una partícula nunca lo podremos saber con precisión ilimitada.

No es fácil explicar de forma sencilla de dónde viene esta incertidumbre, pero existen ejemplos en la vida cotidiana que tienen algo parecido. La altura de un tono y la duración en el tiempo durante el cual oímos el tono tienen una incertidumbre mutua similar. Para afinar un instrumento se debe escuchar una nota durante un cierto intervalo de tiempo y compararla, por ejemplo, con un diapasón que debe vibrar también durante un tiempo. Notas muy breves no tienen bien definido el tono.

Para que las reglas de la mecánica cuántica funcionen, es necesario que todos los fenómenos naturales en el mundo de las cosas pequeñas estén regidos por las mismas reglas. Esto incluye a los virus, bacterias e incluso a las personas. Sin embargo, cuando más grande y más pesado es un objeto, más difícil es observar las desviaciones de las leyes del movimiento “clásicas” debidas a la mecánica cuántica. Me gustaría referirme a exigencia tan importante y tan peculiar de la teoría con la palabra “holismo”. Esto no es exactamente lo mismo que entienden algunos filósofos por holismo, y que podría definir como “el todo es más que la suma de sus partes”. Si la física nos ha enseñado algo es justo lo contrario. Un objeto compuesto de un gran de partículas puede ser entendido exactamente si se conocen las propiedades de sus partes (partículas); basta que sepamos sumar correctamente (¡y esto no es nada fácil en mecánica cuántica!). Lo que entiendo por holismo es que, efectivamente, el todo es la suma de las partes, pero sólo se puede hacer la suma si todas las partes obedecen a las mismas leyes. Por ejemplo, la constante de Planck, h, que es igual a 6’626075… × 10-34 Julios segundo, debe ser exactamente la misma para cualquier objeto en cualquier sitio, es decir, debe ser una constante universal.

La mecánica cuántica es muy extraña a nuestro “sentido común”, sabemos que se desenvuelve en ese “universo” de lo muy pequeño, alejado de nuestra vida cotidiana en el macrocosmos tetradimensional que, no siempre coincide con lo que, en aquel otro ininitesimal acontece.

Las reglas de la mecánica cuántica funcionan tan bien que refutarlas resulta realmente difícil. Los trucos ingeniosos descubiertos por Werner Heisemberg, Paul Dirac y muchos otros mejoraron y completaron las reglas generales. Pero Einstein y otros pioneros como Erwin Schrödinger siempre presentaron serias objeciones a interpretación. Quizá funcione bien, pero ¿dónde está exactamente el electrón?, ¿en el punto x o en el punto y? En pocas palabras, ¿dónde está en realidad?, y ¿cuál es la realidad que hay detrás de nuestras fórmulas? Si tenemos que creer a Bohr, no tiene sentido buscar tal realidad. Las reglas de la mecánica cuántica, por sí mismas, y las observaciones realizadas con detectores son las únicas realidades de las que podemos hablar.

Es cierto que, existe otro universo dentro de nuestro del que, aún, nos queda mucho por aprender.

La mecánica cuántica puede ser definida o resumida así: en principio, con las leyes de la naturaleza que conocemos se puede predecir el resultado de cualquier experimento, en el sentido que la predicción consiste en dos factores: el primer factor es un cálculo definido con exactitud del efecto de las fuerzas y estructuras, tan riguroso como las leyes de Isaac Newton para el movimiento de los planetas en el Sistema Solar; el segundo factor es una arbitrariedad estadística e incontrolable definida matemáticamente de estricta. Las partículas seguirán una distribución de probabilidades dadas, primero de una forma y luego de otra. Las probabilidades se pueden calcular utilizando la ecuación de Schrödinger de función de onda (?) que, con muchas probabilidades nos indicará el lugar probable donde se encuentra una partícula en un dado.

Muchos estiman que esta teoría de las probabilidades desaparecerá cuando se consiga la teoría que explique, de forma completa, todas las fuerzas; la buscada teoría del todo, lo que implica que nuestra descripción actual incluye variables y fuerzas que (aún) no conocemos o no entendemos. Esta interpretación se conoce como hipótesis de las variables ocultas.”

También Gerard ‘t Hooft es el autor de lo que han dado en llamar l principio holográfico es una conjetura especulativa acerca de las teorías de la Gravedad Cuántica propuesta en 1993 por este autor, y mejorada y promovida por Leonard Susskin en 1995. Postula que toda la información contenida en cierto volumen de un espacio concreto se puede conocer a partir de la información codificable sobre la frontera de dicha región. Una importante consecuencia es que la cantidad máxima de información que puede contener una determinada región de espacio rodeada por una superficie diferenciable está limitada por el área total de dicha superficie.

Por ejemplo, se pueden modelar todos los eventos que ocurran en un cuarto o una habitación creando una teoría en la que sólo tome en cuenta lo que suceda en sus paredes. En el principio holográfico también se afirma que por cada cuatro Unidades de Planck existe al menos un grado de libertad (o una unidad constante de Bolttzmann k de máxima entropía). Esto se conoce como frontera de Bekenstein:

donde S es la entropía y A es la unidad de mensura considerada. En unidades convencionales la fórmula anterior se escribe:

donde:

, es la constante de Boltzmann.

, es la constante de Boltzmann.

, es la vecolcidad de la luz.

, es la vecolcidad de la luz.

, es la constante gravitacional universal.

, es la constante gravitacional universal.

, es la constante de Planck racionalizada.