Abr

12

El Vacío superconductor: La máquina de Higgs Kibble

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (1)

Comments (1)

De vez en cuándo debemos mirar atrás.

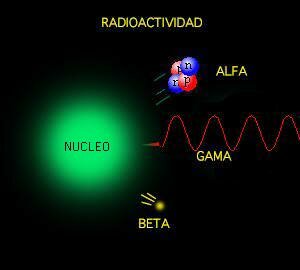

Resulta que el vacío está lleno a rebosar de partículas virtuales y…

Por su parte, el científico británico Peter Higgs, de más años, que dio su nombre a la llamada “partícula divina” en 1964, afirmó que cree que su Bosón seríaá hallado gracias al Gran Colisionador. “Creo que es bastante probable” dijo pocas horas después de que entrara en funcionamiento el gigantesco acelerador. Y, según parece, se está saliendo con la suya.

De todas las maneras, estaría bien saber, a ciencia cierta, cómo es el campo de Higgs del que toman la masa todas las partículas, y conocer, mediante que sistema se transfieren la masa, o, si cuando las partículas entran en el campo de Higgs e interracionan con él, es el efecto frenado el que les otorga la masa.

Claro que, esa, como otras conjeturas sobre los Océanos de Higgs y su dichosa Partícula “repartidora de masa”, no son más que conjeturas que, más adelante, debemos ir comprobando para poder escribirlas con letras de oro en el Libro de la Física, o, por el contrario, desecharlas como se ha hecho con tántas otras ideas y teorías frustradas que nunca llegaron a ninguna parte.

¡Los fotones de Yang-Mills adquieren su masa y el proncipio gauge se sigue cimpliendo! Al principio esta visión no mereció la atención que merecía. Por una parte, la gente penso que el modelo era feo. El principio gauge estaba ahí, pero ya no era el tema central. El “Campo de Higgs” había sido puesto ahí “a propósito” y la “partícula de Higgs”, en sí misma, no era una “partícula gauge”. Si se admitía esto, ¿por qué no introducir más partículas y campos arbitrarios? Estas ideas se consideraron como simples modelos con los que jugart, sin mucho significado fundamental al que ahora se quiere llegar con el LHC pretendiendo hacer bueno todo aquello y, al menos los físicos, insisten en que, el campo y la partícula están ahí…¡ya veremos en qué queda todo esto! Son muchos los cabos sueltos y las cosas sin explicar.

En segundo lugar estaba lo que se llamó “teorema de Goldstone”. Ya se habían priducido antes modelos de partículas con “rotura espontánea de simetría”, pero para la mayoría de esos modelos, Jeoffrey Goldstone habia probado que siempre contenían partículas sin masa y sin espín. Muchos investigadores, por lo tanto, pensaron que la teoría de Higgs también debía contener esa partícula de Goldstone, sin masa y que esto era un inconveniente porque entre las partículas conocidas no había ninguna partícula de Goldstone. Incluso el propio Goldstone había advertido que el Modelo de Higgs no satisfaccía las condiciones para su demostración, así que no tenía que ser válido para este caso, pero todo el mundo estaba tan impresionado con las matemáticas del teorema que el Modelo de Huggs-Kibble no tuvo éxito durante mucho tiempo.

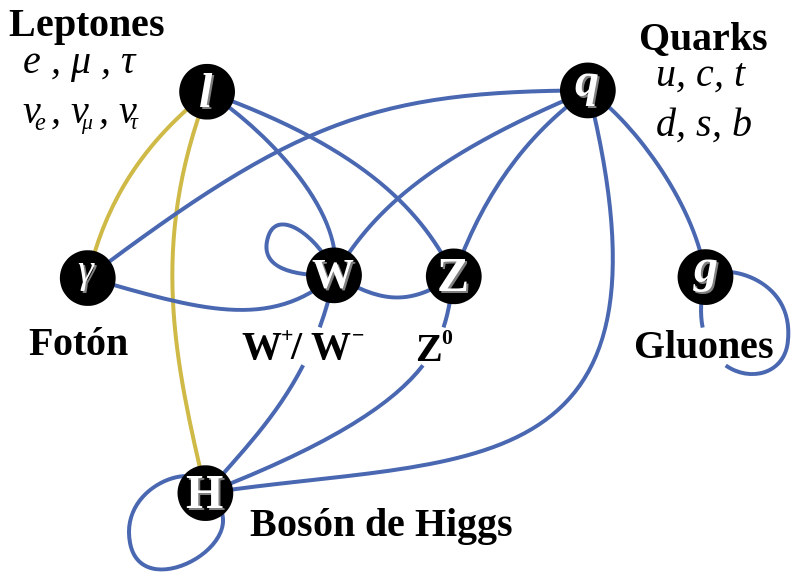

El bosón de Higgs pretende ser una parte integral de nuestra comprensión de la Naturaleza. Se trata de una partícula que es una excitación de lo que se llama el campo de Higgs. El campo de Higgs impregna todo el espacio y cuando algunas de las partículas fundamentales que viajan a través de este campo adquieren masa (al interaccionar con el Campo dónde, probablemente, ve frenada su marcha y su desplazamiento es más lento debido al medio por el que discurre su viaje). La cantidad de masa que adquieren depende de la fuerza en que interactúan con el campo de Higgs. Algunas particulas, como el electrón adquieren una pequeña masa, mientras que otras adquieren una masa mucho mayor.

Y así, el teorema de Goldstone se utilizó como un “teorema de imposibilidad”: si el espacio vacío no es simétrico, entonces no se puede evitar la presencia de partículas sin masa y sin espín. Ahora sabemos que, en nuestro caso, la letra pequeña invalida el teorema; las partículas de Goldstone se hacen incisibles debido a la invariancia gauge y no son más que las “partículas fantasmas” que encontró Feynman en sus cáculos. Además, debemos recordar que el Mecanismo Higgs no es una auténtica rotura de simetría.

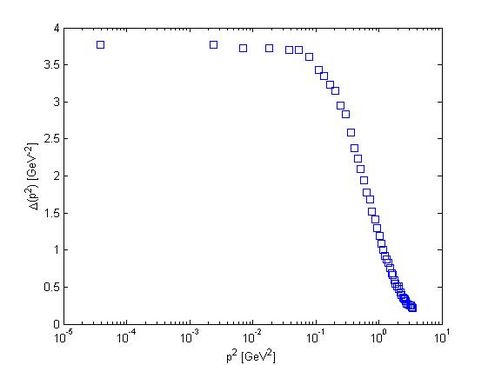

Ingenios que quieren entrar en los campos de Higgs

Un aspecto peculiar de esto es que este campo de Higgs que impregna en todo el espacio es parte de lo que llamamos espacio vacío o el vacío. Es sólo su impacto sobre las partículas que viajan a través de él y el bosón de Higgs que podemos observar en el laboratorio. El bosón de Higgs vive por un lapso muy corto de tiempo, así que no lo observan directamente, sino que más bien se observa que las partículas se descompone en y tienen que inferir su existencia a partir de eso. En la teoría actual que tenemos para comprender la naturaleza podemos hacer afirmaciones precisas acerca de qué fracción del tiempo que se desintegra en dos fotones en comparación con dos quarks abajo.

Claro que, algunos, me piden más profundidad en las explicaciones y, no se conforman con pasar por encima de las cuestiones, hay que entrar más en materia y dejar sentados algunos de los parámetros maemáticos que en todo esto están presente, y, para ellos…

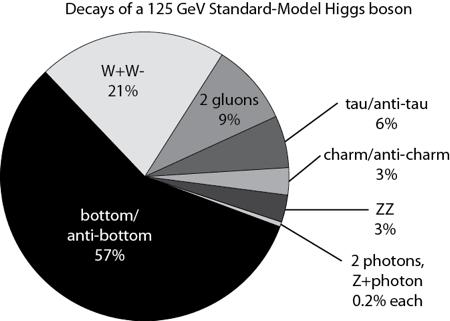

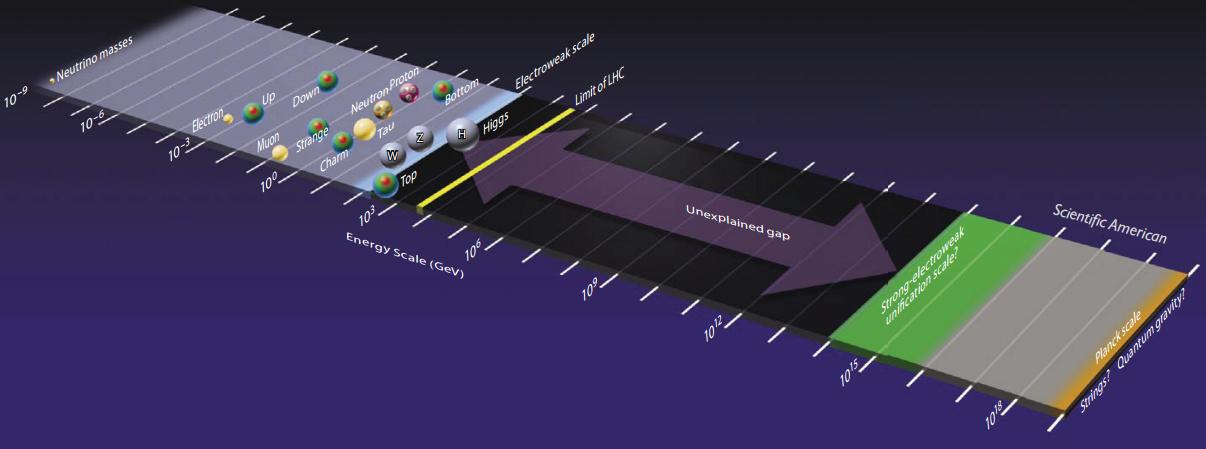

Los físicos han buscado al bosón de Higgs por cerca de 50 años porque su descubrimiento completaría el Modelo Estándar de la física de partículas. El bosón de Higgs y su campo asociado explican cómo la simetría electrodébil se rompió justo después del Big Bang, lo que le dio a ciertas partículas elementales la propiedad de la masa. Sin embargo del Modelo Estándar no predice la masa de Higgs, y varios programas experimentales en el LEP del CERN, en el Tevatron de Fermilab y ahora el LHC del CERN habían intentado medir la masa de la partícula.

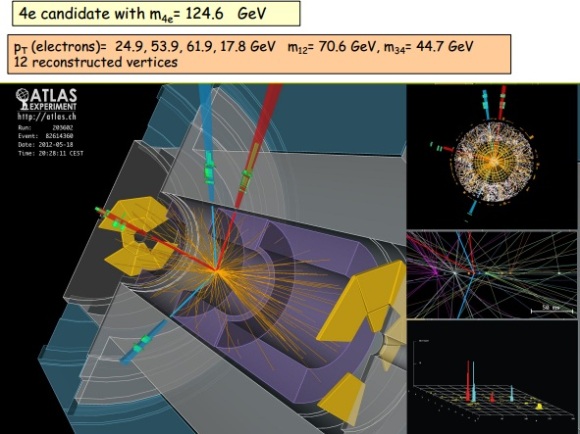

En el seminario llevado a cabo hoy en CERN como preludio a la mayor conferencia de física de partículas de este año, el ICHEP2012 en Melbourne, los experimentos ATLAS y CMS presentaron sus resultados preliminares en la búsqueda del Bosón de Higgs. Ambos experimentos observaron una nueva partícula en la región de masa entre 125-126 GeV.

“Observamos en nuestros datos claras señales de una nueva partícula, al nivel de 5 sigma, en la región de masa alrededor de 126 GeV. El impresionante rendimiento del LHC y ATLAS y el gran esfuerzo de mucha gente nos trajo a esta excitante etapa”, dijo la presentadora del experimento ATLAS Fabiola Gianotti, “pero se necesita más tiempo para preparar estos resultados para su publicación”

“Los resultados son preliminares pero la señal 5 sigma alrededor de 125 Gev que estamos viendo es dramática. Ésta es de hecho una nueva partícula. Sabemos que tiene que ser un bosón y es el bosón más pesado que hemos encontrado hasta ahora,” dijo el presentador del experimento CMS Joe Incandela. “Las implicaciones son muy significantes y es precisamente por esta razón que debemos ser extremadamente diligentes en todos nuestros estudios.”

¿Donde aparece el Higgs en todo esto?

Pues pasemos a hablar de teoría cuántica de campos, en ese tendremos unas densidades lagrangianas que dependerán del campo de cada partícula, dependiendo de su spin será un lagrangiano o otro, por ejemplo para N (a = 1,….N) campos escalares(omito fórmula).

.Al buscar el mínimo del potencial (en realidad un extremal de la acción, pero para lo que nos interesa a nosotros serán mínimos) resulta que hay varios posibles (con el mismo valor) pero para que la energía se minimice hace falta fijar un vacío (debido a que el Hamiltoniano depende del potencial y de unos términos positivos que van con las derivadas del campo). Ahora bien, inicialmente nuestra acción podría tener una simetría gauge global, es decir que al efectuar una transformación de un grupo sobre los campos la acción no cambia, al fijar el vacío la simetría se reduce a un subgrupo

y algunos campos obtienen masa (originalmente ninguno tiene masa), pues bien el teorema de Goldstone lo que dice es que

campos se quedan sin masa, estos son los bosones de Goldstone.

¿Y el higgs?

Ya llegamos, en el apartado anterior hemos considerado transformaciones globales, pero por ejemplo en electromagnetismo tenemos transformaciones locales, así que hay que mirar lo que pasa en las transformaciones locales. Lo primero que pasa es que la derivada parcial no preserva los vectores (lo que hemos llamado antes psi igual que pasa en relatividad general, al hacer una transformación que depende de las coordenadas la derivada ya no es covariante, así que hay que buscar una covariante para seguir con lo que sabemos (en este caso la transformación se debe a un grupo gauge arbitrario, que no tiene porque ser el de difeomorfismos como en relatividad general. En este contexto aparecen los campos gauge que jugaran un papel similar al de la conexión en relatividad general y en el caso del electromagnetismo el campo gauge es el potencial electromagnético). Ahora al ser transformaciones locales, aparecen campos gauge que por similitud con el electromagnetismo escribiremos el lagrangiano de Yang-Mills

igual que en el electromagnetismo F depende de los campos gauge, pero debido a que

no es abeliano hay un termino extra que tiene que ver con las constantes de estructura del álgebra de Lie,

. Ahora ya vien lo bueno, aparte del lagrangiano de la partícula también tenemos el de Yang-Mills, resulta que debido a la simetría local:

- Los bosones de Goldstone desaparecen, es decir no son partículas físicas.

campos gauge obtienen masa

Pues eso es el efecto Higgs. Ahora para llegar ya al famoso bosón, en el modelo estandar no se pueden construir terminos de masa para las partículas debido a que no se pueden acoplar adecuadamente para ese propósito los campos de Yang-Mills y las partículas, debido a las simetrías que deben satisfacer (en general el famoso aunque cada campo tendrá una simetría concreta) y ahí es donde entra el bosón de Higgs, ya que el modelo más sencillo para añadir masa es justamente ese, añadir un doblete de campos escalares complejos y al romper la simetría …….. Higgs !!!!

Dos prestigiosos investigadores habñían sugerido de forma independiente que se podían construir modelos realistas dde partículas en los cuales, el sistema de Yang-Mills fuera responsable de la interacción débil y el mecanismo de Higgs-Kibble la causa de su corto alcance. Uno de ellos era el paquistaní Abdus Salam que estaba buscando modelos estéticos de partículas y pensó que la belleza de la idea de Yan-Mills era razón suficiente para intentar construir con ella un modelo de interacción débil. La partícula mediadora de la interacción débil tenía que ser un fotón de Yang-Mills y el mecanismo de Higgs-Kibble la única explicación aceptable para que esta partícula tuviera una cierta cantidad de masa en reposo.

Una simetría puede ser perfecta en el plano de las ecuaciones y resultar rota en el plano de las soluciones. Como decía Weinberg: «Aunque una teoría postule un alto grado de simetría, no es necesario que los estados de las partículas muestren la simetría. Nada me parece tan halagüeño en física como la idea de que una teoría puede tener un alto grado de simetría que se nos oculta en la vida ordinaria».

La teoría que unifica las interacciones electromagnéticas y débil se debe a Glashow, Salam y Weinberg que obtuvieron por ella el Premio Nobel de física de 1979. La dificultad esencial de esta teoría es que los bosones del estado inicial simétrico debían ser de masa nula (masa nula de los bosones de interacción origina una fuerza a gran distancia), mientras que se necesitan bosones intermedios (partículas que originan la fuerza) muy masivos para justificar la interacción débil (corto alcance) . El mecanismo de Higgs, permite resolver esa dificultad, mediante la ruptura espontánea de simetría hace masivos los bosones W y Z (interacción débil) y mantiene nula la masa del fotón (interacción electromagnética).

Los famosos diagramas de Feynaman, nos explican algunos mecanismos de los que se pueden producir (de hecho se producen) en ese misterioso campo de las partículas elementales cuando están presentes en cuertos lugares y se juntas con otros individuos de la especie.

Salam que estaba muy cerca de poder alcanzar la gloria…no llegaba a poder explicar y aplicar las reglas de Feynman y tuvo quer admitir que la teoría parecía estar llena de partículas fantasmas que estaban a punto de estropearlo todo. En estas, llegó el otro investigador, Steven Weinberg, que supo dar un paso más al formular con mucho más detalle un modelo sencillo en el cual indicaba con precisión los campos que existían y cómo podían interactuar. Pero se limitó a los leptones. Weinberg comprendió que, junto al fotón ordinario tenía que haber tres fotones de Yang-Mills pesados::

– Uno cargado positivamente.

– Otro cargado negativamente.

– Otro Neutro.

El panorama completo

En lo que se refiere a los fotones cargados, todo el mundo estaba de acuerdo en que estos se necesitarían para describir la interacción débil: serían los famoso bosones vectoriales intermediarios, W+ y W–. De acuierdo con Weinberg, sus masas tenían que ser mayores de 60.000 MeV. Pero solos, estos bosones, vectoriales cargados eran suficientes para explicar todos los procesos de interacción débil que conocían en aquella época. Que aparte de ellos y del fotón ordinario, y, también se necesita otro componente neutro (Weinberg le llamó Zº) no era evidente en absoluto. Se encontró que la masa del Zº tenía que ser un poco mayor que la de los bosones cargados.

De todo aquello surgió una tería para las interacciones débiles en las cuales jugaban un papel dominante distintos diagramas de Feynman, de los que se podían plasmar un número infinito para mostrar, de manera gráfica, los sucesos que acontecían en aquellos fenómenos de la radiación producida en la interacción débil. Pasado el tiempo y mirado con una mejor perspectiva, es fácil comprender todo aquello pero, en aquellos momentos en que se estaba gestando, las cosas no resultaban tan fáciles.

Después de todo aquello, se prestó más atención al mecanismo Higgs-Kibble y, algunos, como Veltman fueron muy escépticos con aquellas ideas, y, desde luego, no fue fácil converlo de que pudiéramos llamar vacío a algo lleno de partículas invisibles. ¿No delatarían dijo, su presencia por sus campos gravitatorios? La teoría puede ser formulada de tal manera que esos campos gravitatorios se compensen exactamente con otras partículas invibles o por una contribución misteriosa del propio espacio vacío.

Cómo consigue la Naturaleza enmascarar tan exacta y eficientemente esos factores de la gravedad que no podemos notar nada, es un misterio que continua siendo muy debatido hoy en día. Claro que, todo esto dejará de ser un misterio cuando un día (lejos aún en el futuro), podamos comprender la Gravedad Cuántica.

Miehntras todo esto sucede… ¡Dejémos volar nuestra imaginación! con ideas y teorías como la de los ¡Campos de Higgs! ¡Bosones que, generosos ellos, regalan masas a otras partículas! ¡Materia que no podemos ver pero que, dem manera acérrima, nos empeñamos en que sí está! ¡Fluctiaciones de vacío que rasgan el espacio-tiempo, y, que de vez en cuando, hace surgir nuevos universos! ¡Universos paralelos que nacieron sin vida! ¡Ciclos eternos en el que las cosas se repetin una y otra vez hasta el infinito! ¡Nuevos Big Bangs después del nuestro! ¡Agujeros negros en nuestro universo y, blancos al otro lado, en otro universo. Aquí recoge materia y, allú, la expulsa por el contrario, un Agujero Blanco! ¡Agujeros de Gusano que nos podrían llevar a otras galaxias! ¡El sueño de vencer (mejor burlar) a la velocidad de la luz, ese muro que nos tiene confinados en nuestro pequeño mundo, el Sistema Solar!

Después de leer todo esto, ¿por qué no dedicais aunque sólo sea una hora para pensar sobre ello?

emilio silvera

Abr

12

¡Fluctuaciones de vacío! ¿Que son?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (2)

Comments (2)

Un fuerte campo gravitatorio puede inducir un efecto desbocado en las fluctuaciones cuánticas que se producen en el espacio, aparentemente vacío, …

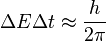

En física cuántica, la fluctuación cuántica es un cambio temporal en la cantidad de energía en un punto en el espacio como resultado del Principio de Incertidumbre que imaginó Werner Heisenberg. De acuerdo a una formulación de este principio energía y tiempo se relacionan de la siguiente forma:

Esto significa que la conservación de la energía puede parecer violada, pero sólo por breves lapsos. Esto permite la creación de pares partícula-antipartícula de partículas virtuales. El efecto de esas partículas es medible, por ejemplo, en la carga efectiva del electrón, diferente de su carga “desnuda”. En una formulación actual, la energía siempre se conserva, pero los estados propios del Hamiltoniano no son los mismos que los del operador del número de partículas, esto es, si está bien definida la energía del sistema no está bien definido el número de partículas del mismo, y viceversa, ya que estos dos operadores no conmutan.

Las fluctuaciones del vacío entre una esfera y una superficie plana

En un estudio realizado por un equipo de físicos con avanzados aparatos, han hallado un resultado del que nos dicen:

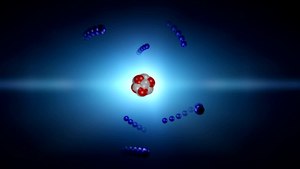

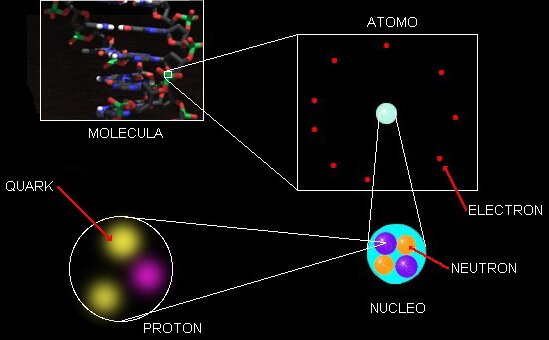

La materia se construye sobre fundamentos frágiles. Los físicos acaban de confirmar que la materia, aparentemente sustancial, es en realidad nada más que fluctuaciones en el vació cuántico. Los investigadores simularon la frenética actividad que sucede en el interios de los protones y neutrones, que como sabéis son las partículas que aportan casi la totalidad de la masa a la materia común.

Cada protón (o neutrón) se compone de tres quarks – véase ilustración – pero las masas individuales de estos quarks apenas comprenden el 1% del total de la masa del protón ¿Entonces de dónde sale el resto? La teoría sostiene que esta masa es creada por la fuerza que mantiene pegados a los quarks, y que se conoce como fuerza nuclear fuerte. En términos cuánticos, la fuerza fuerte es contenida por un campo de partículas virtuales llamadas gluones, las cuales irrumpen aleatoriamente en la existencia para desaparecer de nuevo. La energía de estas fluctuaciones del vacío debe sumarse a la masa total del neutrón y del protón.

En nuestras mentes se acumulan signos y fórmulas que quieren ser los exponentes de la verdadera razón y origen de la materia pero… ¡Estaremos acertando!

Tiene y encierra tantos misterios la materia que estamos aún y años-luz de y conocer sobre su verdadera naturaleza. Es algo que vemos en sus distintas formas materiales que configuran y conforman todo lo material desde las partículas elementales hasta las montañas y los océanos. Unas veces está en estado “inerte” y otras, se eleva hasta la vida que incluso, en ocasiones, alcanza la consciencia de SER. Sin embargo, no acabamos de dilucidar de dónde viene su verdadero origen, su esencia, lo que era antes de “ser” materia. ¿Existe acaso una especie de sustancia cósmica anterior a la materia? Y, si realmente existe esa sustancia… ¿Dónde está?

Claro que hemos llegado a saber que las llamadas fluctuaciones del vacío son oscilaciones aleatorias, impredecibles e ineliminables de un campo de fuerza (electromagnético o gravitatorio) que son debidas a un “tira y afloja” en el que pequeñas regiones del espacio toman prestada, momentáneamente, energía de regiones adyacentes y luego las devuelven. Pero…

– ¿Qué regiones adyacentes?

Acaso universos paralelos, acaso deformaciones del espacio-tiempo a escalas microscópicas, micros agujeros negros que pasan a ser agujeros blancos salidos de estas regiones o campos de fuerza que no podemos ver pero sí sentir, y, en última instancia, ¿por qué se forman esas partículas virtuales que de inmediato se aniquilan y desaparecen antes de que puedan ser capturadas? ¿Qué sentido tiene todo eso?

Las consecuencias de la existencia del cuanto mínimo de acción fueron revolucionarios para la comprensión del vacío. Mientras la continuidad de la acción clásica suponía un vacío plano, estable y “realmente” vacío, la discontinuidad que supone el cuanto nos dibuja un vacío inestable, en continuo cambio y muy lejos de poder ser considerado plano en las distancias atómicas y menores. El vacío cuántico es de todo menos vacío, en él la energía nunca puede quedar estabilizada en valor cero, está fluctuando sobre ese valor, continuamente se están creando y aniquilando todo tipo de partículas, llamadas por eso virtuales, en las que el producto de su energía por el tiempo de su existencia efímera es menor que el cuanto de acción. Se llaman fluctuaciones cuánticas del vacío y son las responsables de que exista un que lo inunda todo llamado campo de punto cero.

Pero volvamos de nuevo a las fluctuaciones de vacío, que al igual que las ondas “reales” de energía positiva, están sujetas a las leyes de la dualidad onda/partícula; es decir, tienen tanto aspectos de onda como aspectos de partícula.

Las ondas fluctúan de forma aleatoria e impredecible, con energía positiva momentáneamente aquí, energía negativa momentáneamente allí, y energía cero en promedio. El aspecto de partícula está incorporado en el concepto de partículas virtuales, es decir, partículas que pueden nacer en pares (dos partículas a un tiempo), viviendo temporalmente de la energía fluctuacional tomada prestada de regiones “vecinas” del , y que luego se aniquilan y desaparecen, devolviendo la energía a esas regiones “vecinas”. Si hablamos de fluctuaciones electromagnéticas del vacío, las partículas virtuales son fotones virtuales; en el caso de fluctuaciones de la gravedad en el vacío, son gravitones virtuales.

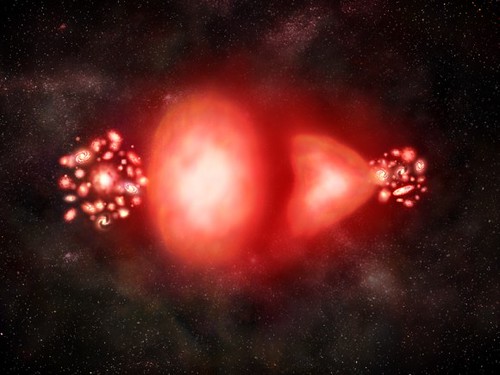

De las llamadas fluctuaciones de vacío pueden surgir, partículas virtuales y quién sabe que cosas más… Hasta un nuevo Universo.

Son muchas las preguntas que no tienen respuestas

Parece que las fluctiuaciones ocurren en cualquier lugar, pero que, son tan minúsculas que ningún observador o experimentador las ha detectado de una manera franca hasta la fecha y, se sabe que están ahí por experimentos que lo han confirmado. Estas fluctuaciones son más poderosas cuanto menos escala se considera en el espacio y, por debajo de la longitud de Planck-Wheeler las fluctuaciones de vacío son tan enormes que el espacio tal como lo conocemos “pareciera estar hirviendo” para convertirse en una especie de espuma cuántica que parece que en realidad, cubre todo el espacio “vacío cuántico” que sabemos que está ahí y es el campo del que surgen esas partículas virtuales que antes menccionaba.

¿Espuma cuántica? Si profundizamos mucho en la materia… Podríamos ver otro universo distinto al nuestro. Las cosas miles de millones de veces más pequeñas que en nuestro mundo cotidiano, no parecen las mismas cosas.

Hay magnitudes asociadas con las leyes de la gravedad cuántica. La longitud de Planck-Wheeler, ![]() es la escala de longitud por debajo de la cual el tal como lo conocemos deja de existir y se convierte en espuma cuántica. El tiempo de Planck-Wheeler (1/c veces la longitud de Planck-Wheeler o aproximadamente 10-43 segundos), es el intervalo de tiempo más corto que puede existir; si dos sucesos están separados por menos que esto, no se puede decir cuál sucede antes y cuál después. El área de Planck-Wheeler (el cuadrado de la longitud de Planck-Wheeler, es decir, 2,61×10-66cm2) juega un papel clave en la entropía de un agujero negro. ¡Qué locura!

es la escala de longitud por debajo de la cual el tal como lo conocemos deja de existir y se convierte en espuma cuántica. El tiempo de Planck-Wheeler (1/c veces la longitud de Planck-Wheeler o aproximadamente 10-43 segundos), es el intervalo de tiempo más corto que puede existir; si dos sucesos están separados por menos que esto, no se puede decir cuál sucede antes y cuál después. El área de Planck-Wheeler (el cuadrado de la longitud de Planck-Wheeler, es decir, 2,61×10-66cm2) juega un papel clave en la entropía de un agujero negro. ¡Qué locura!

En el complejo general, por ahí, en alguna parte, permanece oculta esa teoría cuántica de la gravedad que incansables (pero sin ningún éxito hasta el momento) buscamos. Cuando sepamos unir las dos teorías de lo pequeño y lo grande, lo tendremos todo.

Como tantas veces hemos comentado, los trabajos que se han realizado sobre poder construir una teoría cuántica de la gravedad nos llevan a un sorprendente de implicaciones. Por un lado, sólo se ha podido conceptuar a la gravedad cuántica, siempre y cuando, el universo tenga más de cuatro dimensiones. Además, se llega a considerar que en la era de Planck, tanto el universo como la gravedad pudieron ser una sola cosa compacta estructurada por objetos cuánticos infinitamente diminutos, como los que suponemos que conforman las supercuerdas. A esta escala, el mismísimo espaciotiempo estaría sometido a imprescindibles fluctuaciones muy semejantes a las que causan las partículas al nacer y desaparecer de la existencia en el espaciotiempo ordinario. Esta noción ha conducido a los teóricos a describir el universo de la era cuántica como una especie de extremadamente densa y agitada espuma que pudo haber contenido las vibrantes cuerdecillas que propugnan los cosmólogos cuerdistas.

Los físicos especulan que el cosmos ha crecido a desde una «nada» primigenia que al nacer comenzó el principio del tiempo y que, en ese parto, contenía toda la materia y toda la energía.

En física como en todas las demás disciplinas científicas, los conocimientos avanzan y las teorías que sostuvieron los cimientos de nuestros conocimientos se van haciendo viejas y van teniendo que ser reforzadas con las nuevas y más poderosas “vigas” de las nuevas ideas y los nuevos hallazgos científicos que hacen posible ir perfeccionando lo que ya teníamos.

Recientemente se han alzado algunas voces contra el Principio de Incertidumbre de Heisenberg. He podido leer en un artíoculo de la prestigiosa Revista Nature, un artículo del premio Nobel de Física Gerald ´t Hoofft, en el que propone que la naturaleza probabilistica de la mecánica cuántica, desaparecería a la escala de Planck, en la que el comportamiento de la materia sería determinista; a longitudes mayores, energías más pequeñas.

El mundo de lo muy pequeño (el micro espacio), a nivel atómico y subatómico, es el dominio de la física cuántica, así nunca podríamos saber, de acuerdo m con el principio de incertidumbre, y, en un momento determinado, la posición y el estado de una partícula. Este estado podría ser una función de la escala espacio-temporal. A esta escala tamaños todo sucede demasiado deprisa para nosotros.

El “universo cuántico” nada es lo que parece a primera vista, allí entramos en otro mundo que en nada, se parece al nuestro

Cuando hablamos de la mecánica cuántica, tenemos mirar un poco hacia atrás en el tiempo y podremos darnos del gran impacto que tuvo en el devenir del mundo desde que, en nuestras vidas, apareció el átomo y, más tarde, sus contenidos. Los nombres de Planck, Einstein, Bohr, Heisenberg, Schrödinger, Pauli, Bardeen, Roentgen, Dirac y muchos otros, se pudieron a la cabeza de la lista de las personas más famosas. Aquel primer premio Nobel de Física otorgado en 1900 a Roentgen por descubrir los rayos X, en el mismo año llegaría el ¡cuanto! De Planck que inspiró a Einstein para su trabajo sobre el Efecto fotoeléctrico que también, le valdría el Nobel, y, a partir de ese momento, se desencadenó una especie de alucinante por saber sobre el átomo, sus contenidos, y, de qué estaba hecha la materia.

La conocida como Paradoja EPR y los conceptos de Tiempo y , presente, pasado y futuro.

“Nadie ha resuelto la paradoja del gato de Schroedinger, ni la paradoja de Einstein-Podolsky-Rosen. El principio de incertidumbre no se ha explicado y se asume como un dogma, lo mismo pasa con el spin. El spin no es un giro pero es un giro. Aquí hay un desafío al pensamiento humano. ¡Aquí hay una aventura del pensamiento!”

Fueron muchas las polémicas desatadas a cuenta de las aparentes incongruencias de la moderna Mecánica Cuántica. La paradoja de Einstein-Podolsky-Rosen, denominada “Paradoja EPR”, trata de un experimento mental propuesto por Albert Einstein, Boris Podolsky y Nathan Rosen en 1935. Es relevante, pues pone de manifiesto un problema aparente de la mecánica cuántica, y en las décadas siguientes se dedicaron múltiples esfuerzos a desarrollarla y resolverla.

A Einstein (y a muchos otros científicos), la idea del entrelazamiento cuántico le resultaba extremadamente perturbadora. Esta particular característica de la mecánica cuántica permite preparar estados de dos o más partículas en los cuales es imposible obtener útil sobre el estado total del sistema haciendo sólo mediciones sobre una de las partículas.

Por otro lado, en un entrelazado, manipulando una de las partículas, se puede modificar el estado total. Es decir, operando sobre una de las partículas se puede modificar el estado de la otra a distancia de manera instantánea. Esto habla de una correlación entre las dos partículas que no tiene paralaje en el mundo de nuestras experiencias cotidianas. Cabe enfatizar pues que cuando se mide el estado de una partícula, enseguida sabemos el estado de la otra, lo cual aparentemente es instantáneo, es decir, sin importar las distancias a las que se encuentren las partículas, una de la otra, ambas saben instantáneamente el estado de la otra.

El experimento planteado por EPR consiste en dos partículas que interactuaron en el pasado y que quedan en un estado entrelazado. Dos observadores reciben cada una de las partículas. Si un observador mide el momento de una de ellas, sabe cuál es el momento de la otra. Si mide la posición, gracias al entrelazamiento cuántico y al principio de incertidumbre, puede la posición de la otra partícula de forma instantánea, lo que contradice el sentido común.

Animación que muestra dos átomos de oxígeno fusionándose para formar una molécula de O2 en su estado cuántico fundamental. Las nubes de color representan los orbitales atómicos. Los orbitales 2s y 2p de cada átomo se combinan para formar los orbitales σ y π de la molécula, que la mantienen unida. Los orbitales 1s, más interiores, no se combinan y permiten distinguir a cada núcleo. Lo que ocurre a escalas tan pequeñas es fascienante.

Si nos pudiéramos convertir en electrones, por ejemplo, sabríamos dónde y cómo estamos en cada momento y podríamos ver asombrados, todo lo que estaba ocurriendo a nuestro alrededor que, entonces sí, veríamos transcurrir a un ritmo más lento del que podemos detectar en los electrones desde nuestro macroestado espacio temporal. El electrón, bajo nuestro punto de vista se mueve alrededor del núcleo atómico a una velocidad de 7 millones de km/h.

A medida que se asciende en la escala de tamaños, hasta el tiempo se va ajustando a esta escala, los objetos, a medida que se hacen mayores se mueven más despacio y, además, tienen más duración que los pequeños objetos infinitesimales del micro mundo cuántico. La vida media de un neutron es de unos 15 minutos, por ejemplo, mientras que la vida media de una estrellas se puede contar en miles de millones de años.

En nuestra macroescala, los acontecimientos y ,los objetos se mueven a velocidades que a nosotros nos parecen normales. Si se mueven con demasiada lentitud nos parece que no se mueven. Así hablamos de escala de tiempo geológico, para referirnos al tiempo y velocidad de la mayor parte de los acontecimientos geológicos que afectan a la Tierra, el tiempo transcurre aquí en millones de años y nosotros ni lo apreciamos; nos parece que todo está inmóvil. Nosotros, los humanos, funcionamos en la escala de años (tiempo biológico).

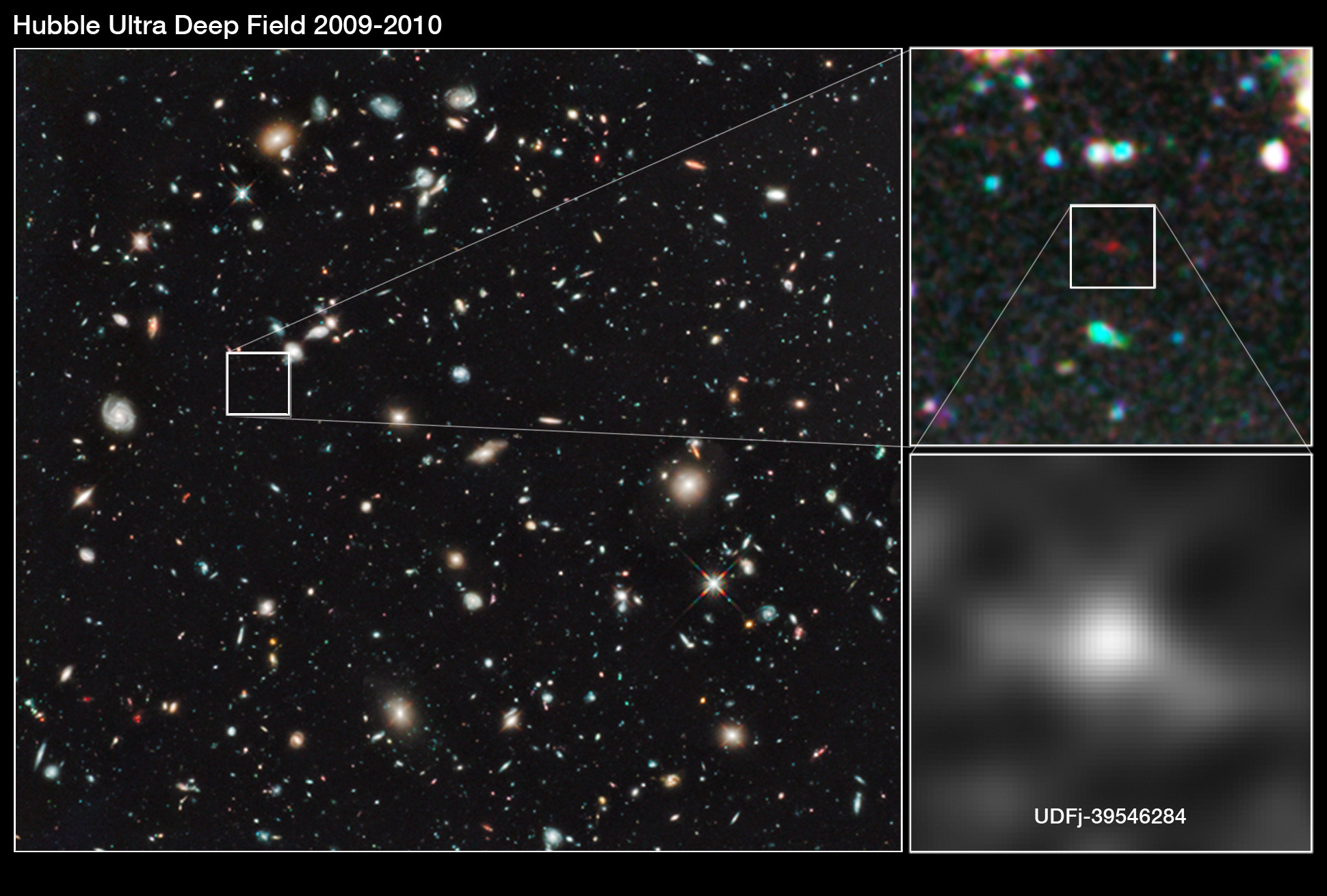

El Tiempo Cosmológico es aún mucho más dilatado y los objetos cósmicos (mundos, estrellas y galaxias), tienen una mayor duración aunque su movimiento puede ser muy rápido debido a la inmensidad del espacio universal en el que se mueven. La Tierra, por ejemplo, orbita alrededor del Sol a una velocidad media de 30 Km/s., y, el Sol, se desplaza por la Galaxia a una velocidad de 270 km/s. Y, además, se puede incrementar el tiempo y el espacio en su andadura al estar inmersos y ligados en una misma maya elñástica.

Así, el espacio dentro de un átomo, es muy pequeño; dentro de una célula, es algo mayor; dentro de un animal, mayor aún y así sucesivamente… hasta llegar a los enormes espaciosa que separan las estrellas y las galaxias en el Universo.

Distancias astronómicas separan a las estrellas entre sí, a las galaxias dentro del cúmulo, y a los cúmulos en los supercúmulos.

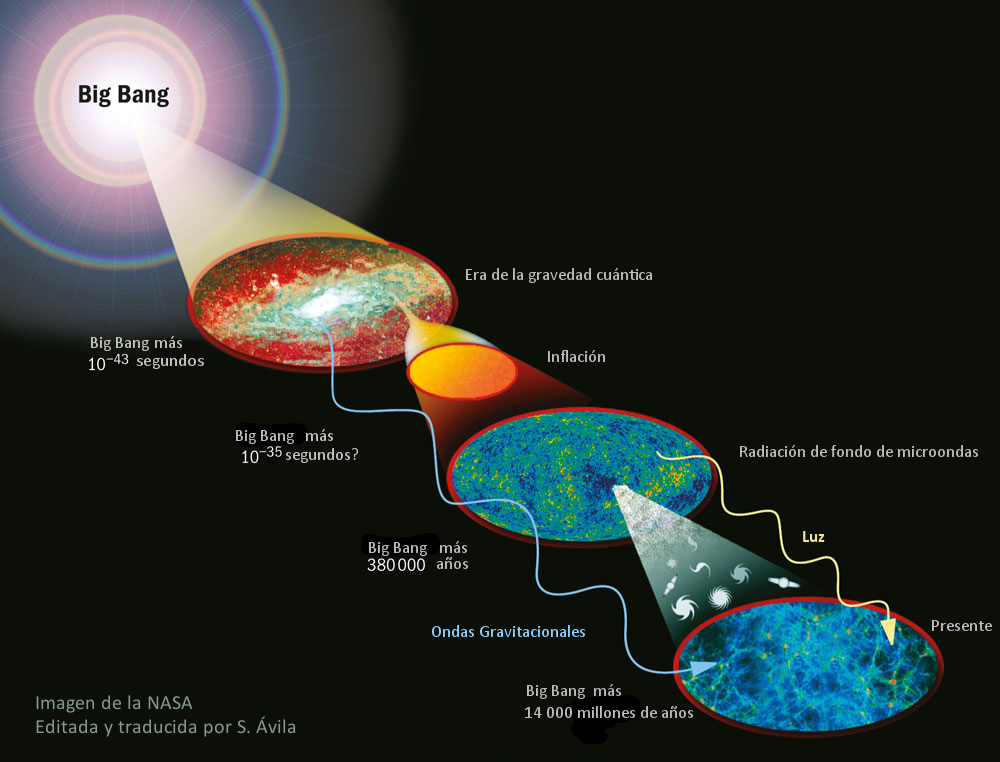

Las distancias que separan a los objetos del Cosmos se tienen que medir con unidades espaciales, tal es su inmensa magnitud que, nuestras mentes, aunque podamos hablar de ellas de manera cotidiana, en realidad, no han llegado a asimilarlas.Y, a todo ésto, los físicos han intentado con denuedo elaborar una teoría completa de la gravedad que incluya la mecánica cuántica. Los cálculos de la mayoría de las teorías propuesta de la «gravedad cuántica» arrojan numerosos infinitos. Los físicos no están seguros si el problema es técnico o conceptual. No obstante, incluso prescindiendo de una teoría completa de gravedad cuántica, se puede deducir que los efectos de la teoría cuántica, habrían cruciales durante los primeros 10-43 segundos del inicio del universo, cuando éste tenía una densidad de 1093 gramos por centímetro cúbico y mayor. (El plomo sólido tiene una densidad de aproximadamente diez gramos por centímetro cúbico.) Este período, que es el que corresponde a la era de Planck, y a su estudio se le llama cosmología cuántica. Como el universo en su totalidad habría estado sujeto a grandes incertidumbres y fluctuaciones durante la era de Planck o era cuántica, con la materia y la energía apareciendo y desapareciendo de un vacío en grandes cantidades, el concepto de un principio del universo podría no tener un significado bien definido. En todo caso, la densidad del universo durante este período es de tal magnitud que escapa a nuestra comprensión. Para propósitos prácticos, la era cuántica podría considerarse el estado inicial, o principio, del universo. En consecuencia, los procesos cuánticos ocurridos durante este período, cualquiera sea su naturaleza, determinaron las iniciales del universo.

Una cosa nos ha podido quedar clara: Los científicos para lograr conocer la estructura del universo a su escala más grande, deben retroceder en el tiempo, centrando sus teorías en el momento en que todo comenzó. Para ello, como todos sabeis, se han formulado distintas teorías unificadoras de las cuatro fuerzas de la naturaleza, con las cuales se han modelado acontecimiento y en el universo primitivo casi a todo lo largo del camino hasta el principio. Pero cómo se supone que debió haber habido un «antes», aparece una barrera que impide ir más allá de una frontera que se halla fijada a los 10-43 [s] después del Big Bang, un instante conocido como «momento de Planck», en homenaje al físico alemán Max Planck.

Esta barrera existe debido a que antes del momento de Planck, durante el período llamado la «era de Planck o cuántica», se supone que las cuatro fuerza fundamentales conocidas de la naturaleza eran indistinguibles o se hallaban unificadas , que era una sola fuerza. Aunque los físicos han diseñado teorías cuánticas que unen tres de las fuerzas, una por una, a través de eras que se remontan al momento de Planck, hasta ahora les ha prácticamente imposible armonizar las leyes de la teoría cuántica con la gravedad de la relatividad de Einstein, en un sólo modelo teórico ampliamente convincente y con posibilidades claras de ser contrastado en experimentos de laboratorio y, mucho menos, con observaciones.

Y después de todo ésto, sólo una caso me queda clara: ¡Lo poco que sabemos! A pesar de la mucha imaginación que ponemos en las cosas que creemos conocer.

emilio silvera

Abr

9

Cosas de la Mecánica Cuántica

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (1)

Comments (1)

¡La Física! Esa maravilla que está presente en todo lo que podemos ver y en aquello donde la vista no llega. La infinitud de las partículas elementales que forman todo cuanto existe en la Naturaleza, no siempre se dejan ver ni hacen posible que podamos observar las maravillas que pueden llevar a cabo.

Las sustancias formadas por una sola clase de átomos se llaman elementos químicos, y, si está conformada por distintos átomos, son compuestos. La palabra “átomo” procede del griego ατομος, que significa “indivisible” y el uso de la palabra “elemento” sugiere que se ha llegado a los ladrillos básicos con los que está formada la materia. De hecho, esta es la imagen que se tenía a mediados del siglo XIX cuando se acuñaron estos términos. Sin embargo, hoy sabemos que todo esto es falso, que los átomos se pueden dividir y que, de esta manera, los elementos han dejado de ser verdaderamente elementales. Los físicos continúan con esta nomenclatura aunque sea formalmente incorrecta, ya que, la costumbre, como dicen los juristas, no pocas veces rigen la jerga de las leyes.

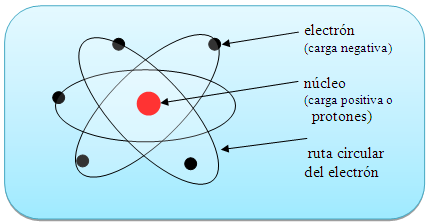

A todo esto y hablando de los átomos, por fuerza, nos tenemos que acordar del electrón que da al átomo su forma esférica. Son partículas cargadas eléctricamente que se mueven alegremente alrededor del núcleo. El electrón es muy ligero: su masa es solamente 1/1.8836 de la del núcleo más ligero (el hidrógeno). La carga eléctrica del electrón es de signo opuesto a la del núcleo, de manera que los electrones están fuertemente atraídos hacia el núcleo y se repelen mutuamente. Si la carga eléctrica total de los electrones en un átomo iguala a la del núcleo, para lo que generalmente se necesitan varios electrones, se dice que el átomo está en equilibrio o que es eléctricamente neutro.

Claro que, no debemos olvidarnos de que, ¡Todo lo grande está hecho de cosas pequeñas! Una inmensa galaxia se conforma de un conjunto inmenso de átomos inifinitesimales que juntos, hace ese gran todo.

La fuerza a la que obedecen los electrones, la denominada fuerza electrostática o de Coulomb, es matemáticamente bastante sencilla y, sin embargo, los electrones son los responsables de las importantes propiedades de los “enlaces químicos”. Esto se debe a que las leyes de movimiento de los electrones están regidas completamente por la “mecánica cuántica”, teoría que se completó a principios del siglo XX. Es una teoría paradójica y difícil de entender y explicar, pero al mismo tiempo es muy interesante, fantástica y revolucionaria. Cuando uno se introduce en las maravillas de la mecánica cuántica es como si hiciera un viaje a un universo que está situado fuera de este mundo nuestro, ya que, las cosas que allí se ven, desdicen todo lo que dicta nuestro sentido común de cómo tiene que ser el mundo que nos rodea.

La perfecta sincronía Está en la Naturaleza

No solamente los electrones, sino también los núcleos atómicos y los átomos en su conjunto obedecen y se rigen por la mecánica cuántica. La Física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck, escribió un artículo de ocho páginas y allí propuso una posible solución a un problema que había estado intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menos intensidad, por los objetos más fríos.

Estaban bien aceptados entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía. Pero si usamos las leyes de la termodinámica para calcular la intensidad de la radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano, y, desde luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico a una cierta longitud de onda característica, y que la intensidad disminuye tanto para las longitudes mayores como para las longitudes menores. Esta longitud característica es inversamente proporcional a la temperatura absoluta del objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273 ºC bajo cero). Cuando a 1.000 ºC un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de luz visible.

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en paquetes de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de la onda y, por lo tanto, proporcional a la frecuencia de la radiación emitida. La sencilla fórmula es:

E = h x v

Donde E es la energía del paquete, v la frecuencia y h es una nueva constante fundamental de la naturaleza, la constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo esta nueva condición, el resultado coincidió perfectamente con las observaciones.

Los cuantos de energía etán presentes por todas partes y en todos los objetos

Poco tiempo después, en 1905, Einstein formuló esta teoría de una forma mucho más tajante: el sugirió que los objetos calientes no son los únicos que emiten radiación en paquetes de energía, sino que toda la radiación consiste en múltiplos de los paquetes de energía de Planck. El príncipe francés Louis-Victor de Broglie, dándole otra vuelta a la teoría, propuso que no sólo cualquier cosa que oscila tiene una energía, sino que cualquier cosa con energía se debe comportar como una “onda” que se extiende en una cierta región del espacio, y que la frecuencia, v, de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse como una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilatorias de campos de fuerza.

El curioso comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de De Broglie. Poco después, en 1926, Erwin Schrödinger descubrió como escribir la teoría ondulatoria de Debroglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños estaban exactamente determinados por la recién descubiertas “ecuaciones de onda cuánticas”.

Pocas dudas nos pueden caber a estas alturas de que la mecánica cuántica (de Planck) y, la Relatividad –tanto especial como general- (de Einstein), además de ser las dos teorías más importantes de la Física de nuestro tiempo, funcionan de tal forma que uno, cuando profundiza en sus predicciones y las compara con lo que ocurre en el Universo, no puede por menos que, asombrarse, al comprobar como unas mentes humanas han sido capaces de llegar a estos profundos pensamientos que nos acerca a la realidad de la Naturaleza.

emilio silvera

Mar

23

De lo pequeño a lo grande y, conocer la Naturaleza…¡No será...

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

“Una formulación muy hermosa que, creo, procede de América es la siguiente: alguien que ha golpeado a otro afirma que sólo ha movido sus puños libremente; el juez, sin embargo, replica: «La libertad de movimiento de tus puños está limitada por la nariz de tu vecino».

Debido al principio de exclusión de Pauli, es imposible que dos fermiones ocupen el mismo cuántico (al contrario de lo que ocurre con los bosones). La condensación Bose-Einstein es de importancia fundamental explicar el fenómeno de la superfluidez. A temperaturas muy bajas (del orden de 2×10-7º K) se formar un condensado de Bose-Einstein, en el que varios miles de átomos forman una única entidad (un superátomo). efecto ha sido observado con átomos de rubidio y litio. Como ha habréis podido suponer, la condensación Bose-Einstein es llamada así en honor al físico Satyendra Nath Bose (1.894 – 1.974) y a Albert Einstein. Así que, el principio de exclusión de Pauli tiene aplicación no sólo a los electrones, sino también a los fermiones; pero no a los bosones.

Las reglas de la mecánica cuántica tienen que ser aplicadas si queremos describir estadísticamente un sistema de partículas que obedece a reglas de ésta teoría en vez de las de la mecánica clásica. En estadística cuantica, los estados de energía se considera que están cuantizados. La estadística de Bose-Einstein se aplica si cualquier de partículas puede ocupar un estado cuántico dado. Dichas partículas (como dije antes) son los bosones que, tienden a juntarse.

Los bosones tienen un angular n h / 2p, donde n es cero o un entero y h es la constante de Planck. bosones idénticos, la función de ondas es siempre simétrica. Si solo una partícula puede ocupar un cuántico, tenemos que aplicar la estadística Fermi-Dirac y las partículas (como también antes dije) son los fermiones que tienen momento angular (n+½) h/2p y cualquier función de ondas de fermiones idénticos es siempre antisimétrica.

La mejor teoría explicar el mundo subatómico nació en 1928 cuando el teórico Paul Dirac combinó la mecánica cuántica con la relatividad especial para explicar el comportamiento del electrón. El resultado fue la mecánica cuántica relativista, que se transformó en un ingrediente primario en la teoría cuántica de campos. Con unas pocas suposiciones y ajustes ad-hoc, la teoría cuántica de campos ha probado ser suficientemente poderosa para formar la base del modelo estándar de las partículas y las fuerzas.

La relación el espín y la estadística de las partículas está demostrada por el teorema espín-estadística. En un espacio de dos dimensiones es posible que existan partículas (o cuasipartículas) con estadística intermedia entre bosones y fermiones. Estas partículas se conocen con el de aiones; para aniones idénticos la función de ondas no es simétrica (un cambio de fase de+1) o antisimétrica (un cambio de fase de -1), sino que interpola continuamente entre +1 y -1. Los aniones pueden ser importantes en el análisis del efecto Hall cuántico fraccional y han sido sugeridos como un mecanismo para la superconductividad de alta temperatura.

Resulta fácil comprender cómo un campo magnético la partícula cargada que gira, pero ya no resulta tan fácil saber por qué ha de hacer lo mismo un neutrón descargado. Lo cierto es que cuando un rayo de neutrones incide sobre un hierro magnetizado, no se comporta de la misma forma que lo haría si el hierro no estuviese magnetizado. El magnetismo del neutrón sigue siendo un misterio; los físicos sospechan que contiene cargas positivas y negativas equivalente a cero, aunque por alguna razón desconocida, logran crear un campo magnético cuando gira la partícula.

Particularmente creo que, si el neutrón masa, si la masa es energía (E = mc2), y si la energía es electricidad y magnetismo (según Maxwell), el magnetismo del neutrón no es tan extraño, sino que es un aspecto de lo que en realidad es materia. La materia es la luz, la energía, el magnetismo, en definitiva, la fuerza que reina en el universo y que está presente de una u otra forma en todas partes (aunque no podamos verla).

Sea fuere, la rotación del neutrón nos da la respuesta a esas preguntas:

La primera demostración efectiva de antimateria se tuvo en Brookhaven en 1.965

¿Qué es el antineutrón? Pues, simplemente, un neutrón cuyo movimiento rotatorio se ha invertido; su polo sur magnético, por decirlo así, está arriba y no abajo. En realidad, el protón y el antiprotón, el electrón y el positrón, muestran exactamente el mismo fenómeno de los polos invertidos. Es indudable que las antipartículas pueden combinarse para formar la antimateria, de la misma que las partículas corrientes forman la materia ordinaria.

La primera demostración efectiva de antimateria se tuvo en Brookhaven en 1.965, donde fue bombardeado un blanco de berilio con 7 protones BeV y se produjeron combinaciones de antiprotones y antineutrones, o sea, un antideuterón. entonces se ha producido el antihelio 3, y no cabe duda de que se podría crear otros antinúcleos más complicados aún si se abordara el problema con más interés.

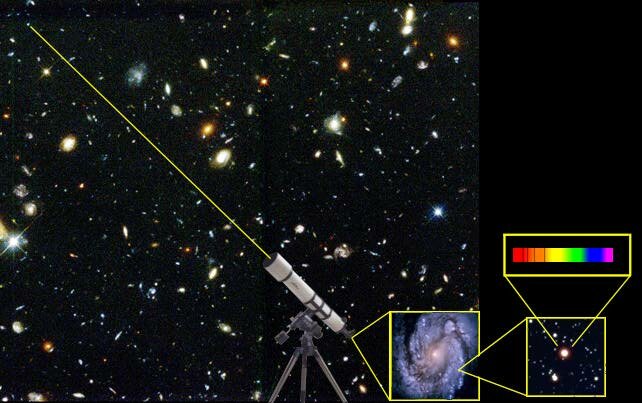

Pero, ¿existe en realidad la antimateria? ¿Hay masas de antimateria en el universo? Si las hubiera, no revelarían su presencia a cierta distancia. Sus efectos gravitatorios y la luz que produjeran serían idénticos a los de la materia corriente. Sin embargo, cuando se encontrasen las masas de las distintas materias, deberían ser claramente perceptibles las reacciones masivas del aniquilamiento mutuo resultante del encuentro. Así pues, los astrónomos observan especulativamente las galaxias, tratar de encontrar alguna actividad inusual que delate interacciones materia-antimateria.

…, ¿Hay masas de antimateria en el Universo? ¿Galaxias de antimateria?

Bueno, sabemos que no son las galaxias las que se alejan, sino que es el espacio el que se expande. Lo que no sabemos es encontrar antimateria en el espacio interestelar y, si la hay y está presente… ¡Aún no la hemos podido localizar! Algunos dicen que hay galaxias de antimateria y, yo digo que tengo un pariente en la galaxia Astrinia del cúmulo Ultramón a diez mil millones de años-luz de nuestra región.

No parece que dichas observaciones, al menos hasta el , hayan sido un éxito.

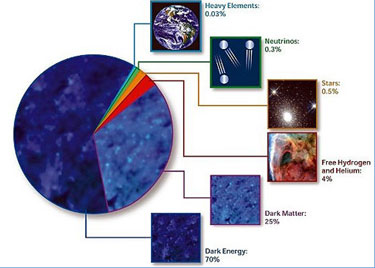

Según estimaciones recientes, resumidas en gráfico de la NASA, alrededor del 70% del contenido energético del Universo consiste en energía oscura, cuya presencia se infiere en su efecto sobre la expansión del Universo pero sobre cuya naturaleza última no se sabe casi nada.

¿Es posible que el Universo este formado casi enteramente por materia, con muy poca o ninguna antimateria? Y si es así, ¿por qué? dado que la materia y la antimateria son equivalentes en todos los aspectos, excepto en su oposición electromagnética, cualquier fuerza que crease una originaria la otra, y el Universo debería estar compuesta de iguales cantidades de la una y de la otra.

Este es el dilema. La teoría nos dice que debería haber allí antimateria, pero las observaciones lo niegan, no lo respaldan. ¿Es la observación la que falla? ¿Y qué ocurre con los núcleos de las galaxias activas, e incluso más aún, con los causares? ¿Deberían ser estos fenómenos energéticos el resultado de una aniquilación materia-antimateria? ¡No creo! Ni siquiera ese aniquilamiento parece ser suficiente, y los astrónomos prefieren aceptar la noción de colapso gravitatorio y fenómenos de agujeros negros como el único mecanismo conocido para producir la energía requerida.

Estábamos hablando de mecánica cuántica y me pasé, sin que me diera , al ámbirto de la antimateria y el espacio del macro universo de las galaxias. Sin embargo, y aunque parezcan temas dispares, lo cierto es que, a medida que profundizamos en estas cuestiones, todas nos llevan, de una u otra manera, a relacionar el “mundo de lo muy pequeño” con el “mundo” de lo muy grande que, al fín y al cabo, está hecho de lo que existe en el primero, es decir, partículas infinitesimales de materia y… ¡de antimateria! para que todo quede compensado.

Sus dimensiones y masa le permiten ¡lo imposible! para nosotros. La tensión superficial es una consecuencia de que todas las moléculas y los átomos se atraen unos a otros con una fuerza que nosotros llamamos fuerza de Van der Vaalls. esta fuerza tiene un alcance muy corto. para ser más precisos, diremos que la intensidad de esta fuerza a una distancia r es aproximadamente proporcional a 1/r7. Esto significa que si se reduce la distancia entre dos átomos a la mitad, la fuerza de Van der Vaalls con la que se atraen uno a otro se hace 2 x 2 x 2 x 2 x 2 x 2 x 2 = 128 veces más intensa. Cuando los átomos y las moléculas se acercan mucho unos a otros quedan unidos muy fuertemente a través de esta fuerza.

La mecánica cuántica domina en el micromundo de los átomos y de las partículas “elementales”. Nos enseña que en la naturaleza cualquier masa, por sólida o puntual que pueda parecer, tiene un aspecto ondulatorio. Esta onda no es como una onda de agua. Se parece más a una ola de histeria que se expande: es una onda de información. Nos indica la probabilidad de detectar una partícula. La longitud de onda de una partícula, la longitud cuántica, se hace menor cuanto mayor es la masa de esa partícula.

Por el contrario, la relatividad general era siempre necesaria cuando se trataba con situaciones donde algo viaja a la velocidad de la luz, o está muy cerca o donde la gravedad es muy intensa. Se utiliza para describir la expansión del universo o el comportamiento en situaciones extremas, como la formación de agujeros negros.

La fuerza nuclear fuerte es la más potente del Universo

Sin embargo, la gravedad es muy débil comparada con las fuerzas que unen átomos y moléculas y demasiado débil para tener cualquier efecto sobre la estructura del átomo o de partículas subatómicas, se trata con masas tan insignificantes que la incidencia gravitatoria es despreciable. Todo lo contrario que ocurre en presencia de masas considerables como planetas, estrellas y galaxias, donde la presencia de la gravitación curva el espacio y distorsiona el tiempo.

Como resultado de estas propiedades antagónicas, la teoría cuántica y la teoría relativista gobiernan reinos diferentes, muy dispares, en el universo de lo muy pequeño o en el universo de lo muy grande. Nadie ha encontrado la manera de unir, sin fisuras, estas dos teorías en una sola y nueva de Gravedad-Cuántica.

¿Cuáles son los límites de la teoría cuántica y de la teoría de la relatividad general de Einstein? Afortunadamente, hay una respuesta simple y las unidades de Planck nos dicen cuales son. En realidad, es la propia Naturaleza la que marca esos límites que Stoney-Planck, supieron plasmar en ecuaciones que los marcan.

Supongamos que tomamos toda la masa del universo visible y determinamos su longitud de onda cuántica. Podemos preguntarnos en qué momento esta longitud de onda cuántica del universo visible superará su tamaño. La respuesta es: cuando el universo sea más pequeño en tamaño que la longitud de Planck, es decir, 10-33 de centímetros, más joven que el tiempo de Planck, 10-43 segundos y supere la temperatura de Planck de 1032 grados. Las unidades de Planck marcan la frontera de aplicación de nuestras teorías actuales. Para comprender en que se parece el mundo a una escala menor que la longitud de Planck tenemos que comprender plenamente cómo se entrelaza la incertidumbre cuántica con la gravedad. Para entender lo que podría haber sucedido cerca del suceso que estamos tentados a llamar el principio del universo, o el comienzo del tiempo, tenemos que penetrar la barrera de Planck. Las constantes de la naturaleza marcan las fronteras de nuestro conocimiento existente y nos dejan al descubierto los límites de nuestras teorías.

En los intentos más recientes de crear una teoría nueva para describir la naturaleza cuántica de la gravedad ha emergido un nuevo significado para las unidades naturales de Planck. Parece que el concepto al que llamamos “información” tiene un profundo significado en el universo. Estamos habituados a vivir en lo que llamamos “la edad de la información”. La información puede ser empaquetada en formas electrónicas, enviadas rápidamente y recibidas con más facilidad que nunca antes. Nuestra evolución en el proceso rápido y barato de la información se suele mostrar en una forma que nos permite comprobar la predicción de Gordon Moore, el fundador de Intel, llamada ley de Moore, en la que, en 1.965, advirtió que el área de un transistor se dividía por dos aproximadamente cada 12 meses. En 1.975 revisó su tiempo de reducción a la mitad hasta situarlo en 24 meses. Esta es “la ley de Moore” cada 24 meses se obtiene una circuiteria de ordenador aproximadamente el doble, que corre a velocidad doble, por el mismo precio, ya que, el coste integrado del circuito viene a ser el mismo, constante.

Globulos estelares con millones de estrellas

Siempre hemos tratado de buscar información del Universo para saber de nuestro entorno, de nuestro Sistema solar, de nuestra Galaxias, de las galaxias lejanas, y, de las mismas estrellas que alumbran los mundos y permite la vida con su luz y su calor. Hemos llegado a saber que somos “polvo de estrellas”, que los materiales que nos conforman están “fabricados” en sus “hornos nucleares”, la fusión creaelementos que, más tarde, forman parte de los mundos y de los seres vivos.

La velocidad de la luz en el vacío es por definición una constante universal de valor 299.792.458 m/s (suele aproximarse a 3·108 m/s), o lo que es lo mismo 9,46·1015 m/año; la segunda cifra es la usada para definir al intervalo llamado año luz. La información se transmitirá a esa velocidad como máximo, nuestro Universo, no permite mayor rapidéz, al menos, por los métodos convencionales.

Los límites últimos que podemos esperar para el almacenamiento y los ritmos de procesamiento de la información están impuestos por las constantes de la naturaleza. En 1.981, el físico israelí, Jacob Bekenstein, hizo una predicción inusual que estaba inspirada en su estudio de los agujeros negros. Calculó que hay una cantidad máxima de información que puede almacenarse dentro de cualquier volumen. Esto no debería sorprendernos.

(Longitud de Planck que al cuadrado sería de 10-66 cm2)

(Longitud de Planck que al cuadrado sería de 10-66 cm2)

Lo que debería hacerlo es que el valor máximo está precisamente determinado por el área de la superficie que rodea al volumen, y no por el propio volumen. El número máximo de bits de información que puede almacenarse en un volumen viene dado precisamente por el cómputo de su área superficial en unidades de Planck. Supongamos que la región es esférica. Entonces su área superficial es precisamente proporcional al cuadrado de su radio, mientras que el área de Planck es proporcional a la longitud de Planck al cuadrado, 10-66 cm2. Esto es muchísimo mayor que cualquier capacidad de almacenamiento de información producida hasta ahora. Asimismo, hay un límite último sobre el ritmo de procesamiento de información que viene impuesto por las constantes de la naturaleza.

Stoney Planck

No debemos descartar la posibilidad de que seamos capaces de utilizar las unidades de Planck-Stoney para clasificar todo el abanico de estructuras que vemos en el universo, desde el mundo de las partículas elementales hasta las más grandes estructuras astronómicas. Este fenómeno se puede representar en un gráfico que recree la escala logarítmica de tamaño desde el átomo a las galaxias.

Todas las estructuras del universo existen porque son el equilibrio de fuerzas dispares y competidoras que se detienen o compensan las unas a las otras; la atracción y la repulsión. Ese es el equilibrio de las estrellas donde la repulsión termonuclear tiende a expandirla y la atracción (contracción) de su propia masa tiende a comprimirla; así, el resultado es la estabilidad de la estrella. En el caso del planeta Tierra, hay un equilibrio entre la fuerza atractiva de la gravedad y la repulsión atómica que aparece cuando los átomos se comprimen demasiado juntos. Todos estos equilibrios pueden expresarse aproximadamente en términos de dos números puros creados a partir de las constantes e, h, c, G y mprotón

“Tras medir alfa en unas 300 galaxias lejanas, vimos un patrón constante: este número, que nos dice la fuerza del electromagnetismo, no es igual en otras partes que en la Tierra, y parecer variar de forma continua a lo largo de un eje”. Algunos se empeñan en variar la constante de estructura fina y, si eso llegara a producirse… las consecuencias serían funestas para nosotros. Otros estudios nos dicen que esa constante, no ha variado a lo largo de los miles de millones de años del Universo y, así debe ser, o, si varió, lo hizo en una escala ínfima.

|

α = 2πe2 / hc ≈ 1/137 |

|

αG = (Gmp2)2 / hc ≈ 10-38 |

Si varian algunas de las dos en sólo una diezmillonésima, muchas de las cosas que conforman el Universo serían imposible y, la consecuencia sería, la ausencia de vida. La identificación de constantes adimensionales de la naturaleza como a (alfa) y aG, junto con los números que desempeñan el mismo papel definitorio para las fuerzas débil y fuerte de la naturaleza, nos anima a pensar por un momento en mundos diferentes del nuestro. Estos otros mundos pueden estar definidos por leyes de la naturaleza iguales a las que gobiernan el universo tal como lo conocemos, pero estarán caracterizados por diferentes valores de constantes adimensionales. Estos cambios numéricos alterarán toda la fábrica de los mundos imaginarios. Los átomos pueden tener propiedades diferentes. La gravedad puede tener un papel en el mundo a pequeña escala. La naturaleza cuántica de la realidad puede intervenir en lugares insospechados.

Lo único que cuenta en la definición del mundo son los valores de las constantes adimensionales de la naturaleza (así lo creían Einstein y Planck). Si se duplica el valor de todas las masas no se puede llegar a saber, porque todos los números puros definidos por las razones de cualquier par de masas son invariables.

“Todos los físicos del mundo, deberían tener un letrero en el lugar más visible de sus casas, para que al mirarlo, les recordara lo que no saben. En el cartel sólo pondría esto: 137. Ciento treinta y siete es el inverso de algo que lleva el nombre de constante de estructura fina”

Lederman

Este número guarda relación con la posibilidad de que un electrón emita un fotón o lo absorba. La constante de estructura fina responde también al nombre de “alfa” y sale de dividir el cuadrado de la carga del electrón, por el producto de la velocidad de la luz y la constante de Planck. Tanta palabrería y numerología no significan otra cosa sino que ese solo numero, 137, encierra los misterios del electromagnetismo (el electrón, e–), la relatividad (la velocidad de la luz, c), y la teoría cuántica (la constante de Planck, h).

Todo eso está relacionado: leyes fundamentales, constantes, materia y espacio tiempo… ¡nosotros! Es posible (digo posible), que finalmente no seámos ni tanto ni tan poco como a veces creemos. Dejémos en un término medio nuestra valia en el contexto del Universo, aunque, poder crear ideas y pensamientos… ¡No es cosa valadí!

emilio silvera

Mar

23

¿La Física? Mucho más de lo que nos pueda parecer

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Para ser llamado científico, un método de investigación debe basarse en lo empírico y en la medición, sujeto a los principios específicos de las pruebas y el razonamiento, hay que demostrar con certeza la teoría.

Empecé a estudiar física hace ahora unos 50 años. Y poco a poco he ido viendo que una parte de la física iba dejando de ser ciencia, olvidando el método de Galileo, y avanzando hacia un sistema dogmático, místico e iniciático. Recordemos que el método dogmático es aquel en el cual se exige aceptar una afirmación que no esta apoyada en ningún hecho comprobable: La afirmación de que las tablas de la ley las había entregado una deidad, por ejemplo. Hoy es imposible, en el campo de la física, no aceptar la afirmación incomprobable, de que el mundo empezó en un Big-Bang, con una cierta energía que no se sabe que era, y moviéndose de una forma que exige un razonamiento circular que pasa de energía a frecuencias de algo que se desconoce, a energías de caracter desconocido a frecuencias de ….., y así indefinidamente.

Pero como con las tablas de la ley, nadie puede subir a la montaña a verificar las afirmaciones expresadas, que sin embargo hay que creer bajo pena de excomunión. Nadie puede volar en el tiempo hacia atrás hasta hace unos miles de millones de años, para verificar la hipótesis.

El sistema avanza hacia el misticismo: ¿Que otra cosa es la idea de las supercuerdas, una idea que para Steven Weinberg, padre de la Gran Unificacion, era ilusionante, pero se ha revelado incapaz de tener algo que ver con la realidad? O la SUSY, la supersimetría que postula que, por ejemplo, los electrones, con spin fraccionario, tengan simétricos con spin entero, selectrones que nadie ha medido ni de lejos.

Claro que, todas estas hipótesis, son ilusionantes y nos gustaría (en algunos casos) que fueran ciertas. Una cosa está clara: No tenemos en la actualidad ningún medio de verificarlas, como nos pasa con la Teoría de Cuerdas que, según han calculado, para llevar a cabo un experimento que nos posibilitará encontrarlas, necesitaríamos disponer de la Energía de Planck, es decir, 1019 GeV, una energía que ni uniendo todos los sistemas de nuestro mundo podríamos alcanzar hoy.

Y se está convirtiendo en iniciático. Para ”descubrir” el Higgs, el CERN cerró las puertas y aisló a sus dos equipos durante años, en un sistema indigno de la idea de la ciencia, que había sido pública y abierta para todos hasta ese momento. El CERN ha publicado los resultados de sus dos equipos pero, o estoy muy equivocado, no ha distribuido los datos originales, las fotografías de las trazas de los productos de desintegración de los productos de desintegración. Cuando se dio a conocer el hallazgo del Bosón de Higgs, se hizo a bombo y platillo, con una parafernaliz impropia de un proyecto científico y más parecido a una Feria. Claro que, todo ese montaje obedecía a obtener máyores presupuestos.

En las sociedades místicas, tras un periodo de iniciación para los elegidos, las verdades se revelaban siempre en ceremonias secretas bajo la terrible promesa de no revelar los ritos nunca fuera de la institución.

Otro de los padres de la Gran Unificación, el físico Abdus Salam, daba como razón poderosa para la búsqueda de la misma su fé en un único dios. Según él, la naturaleza debería tener una única fuerza, correspondiente a esa única deidad.

El padre de la mecánica cuántica, Niels Bohr, apremiado por Einstein, entre otros, llegó a decir que de esa forma de analizar el mundo atómico y sub-atómico, de esa mecánica cuántica había que tomar las reglas de cálculo, pero que había que renunciar a entender lo que pasaba en él. Esto dicho por un supuesto científico que había renunciado a entender la naturaleza, pero que controló, hasta su muerte, la concesión de los premios Nobel de física.

Es tremendamente importante considerar esto que he escrito aquí, en todos los caminos de la ciencia. Hoy la presión es publicar, aunque lo que se publique sea mera copia no entendida de otros trabajos publicados anterior o simultáneamente. Esos trabajos se acumulan en las revistas científicas, de donde no salen a las empresas ni hacia la técnica. Los resultados de un enorme tanto por ciento de la investigación no son aprovechados por aquellos que la han financiado, que dejan que esos resultados caigan en el olvido.

Mientras que un científico como Avelino Coma desarrolla hasta sus úlñtimos extremos la Ciencia, en su trabajo de laboratorio, y sus resultados se aprovechan para la sociedad, y lo mismo hacen otros cientos de miles de ellos, inmensas cantidades de dinero (esfuerzo) se tiran en desarrollos místicos sin utilidad alguna (por ejemplo, las investigaciones sobre la fusión del hidrógeno) o abiertamente carentes de relación con la naturaleza (las supercuerdas).

Edward Witten revisita la teoría de supercuerdas perturbativa en Strings 2012

Aún hay ciencia. Pero hay disciplinas que se están, tristemente, alejando de ella aunque se consideran públicamente, y así lo afirman, como los que marcan el camino del futuro de la misma. Terminarán olvidadas, como ha ocurrido con toda la mística iniciática. Pero de momento aún nos dicen, como los sufíes, que son los únicos que están cerca de la verdad.

La Ciencia es una cosa de la que todos sabemos como anda sus caminos y cuando se puede considerar digna de su nombre, otra cosa muy distinta será el especular y aventurar “teorías” que no llegan a ninguna parte, toda vez que tienen la imposibilidad de ser demostradas y, eso, amigos míos, es como hablar de la existencia de Dios.

Claro que, si realmente existiera el “todo poderoso”, nuestro mundo sería de otra manera, no tendríamos las humillantes desigualdeades que podemos comtemplar en algunas regiones del mundo, y, la vida, sería mucho más placentera. Algunos quieren soslayar sus propias responsabilidades dejando en manos de “Dios”, la solución que sólo está en nuestras manos.

emilio silvera

Totales: 83.644.489

Totales: 83.644.489 Conectados: 50

Conectados: 50