Jun

19

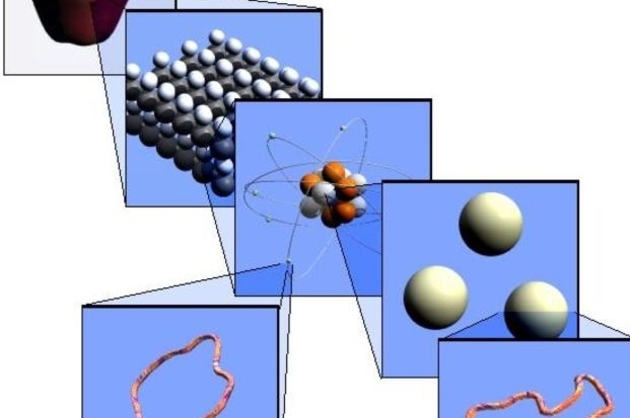

La complejidad del átomo y la Química de elementos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (1)

Comments (1)

Demócrito de Abdera

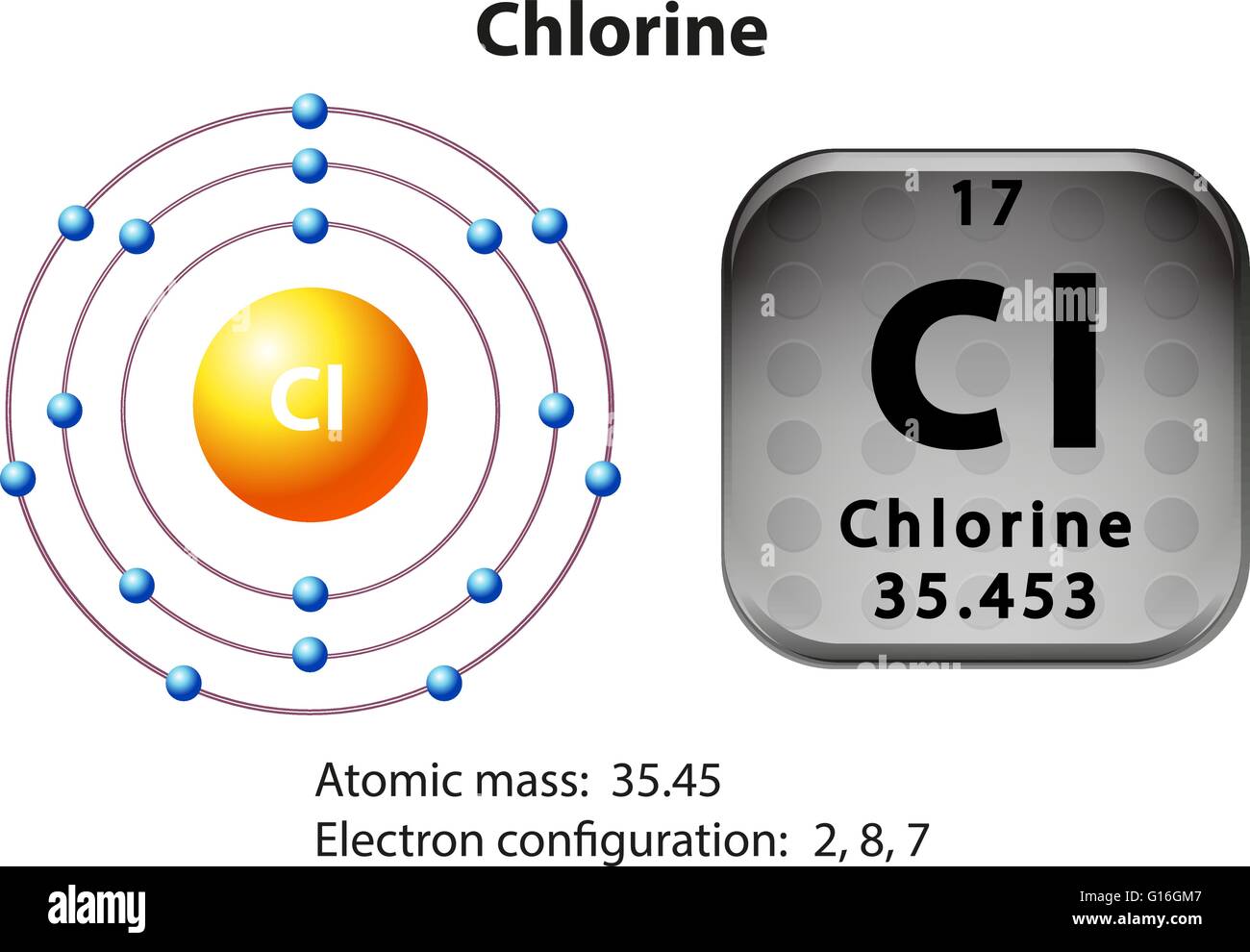

Hacia 1.900 se sabía que el átomo no era una partícula simple e indivisible, como predijo Demócrito, pues contenía, al menos, un corpúsculo subatómico: el electrón, cuyo descubridor fue J. J. Thomson, el cual supuso que los electrones se arracimaban como uvas en el cuerpo principal del átomo de carga positiva.

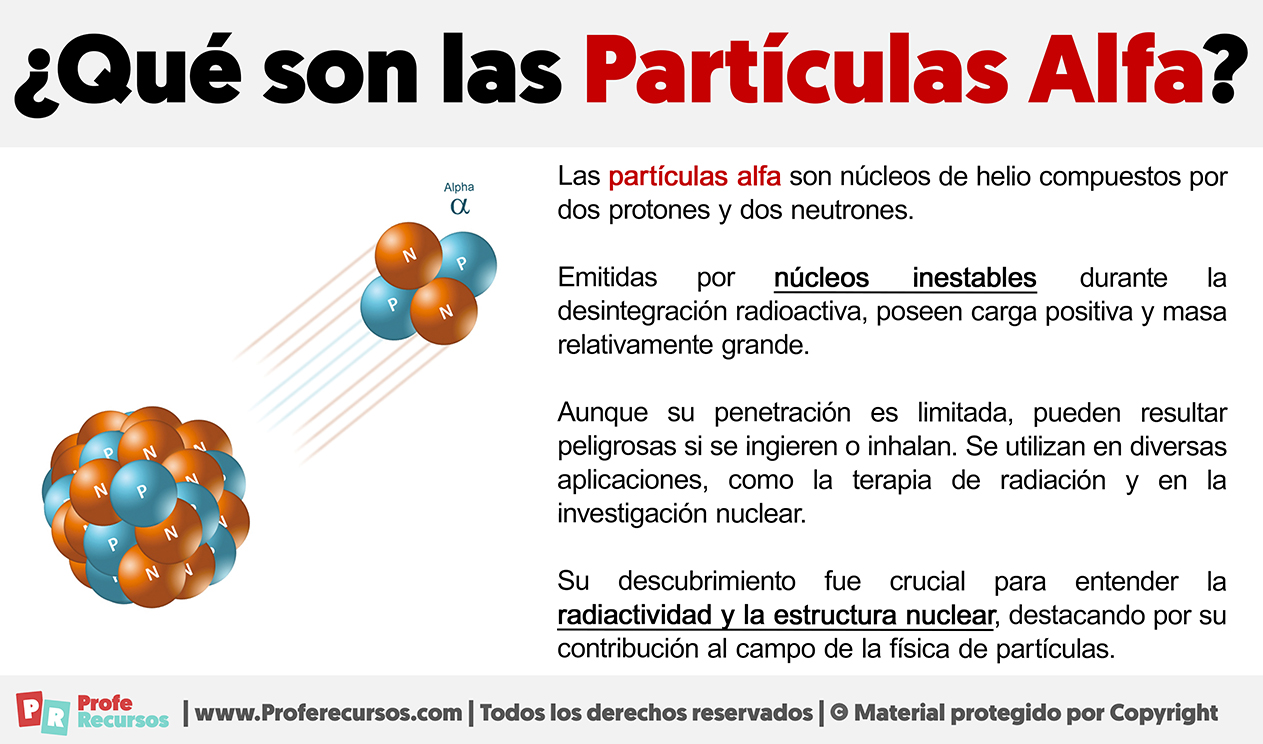

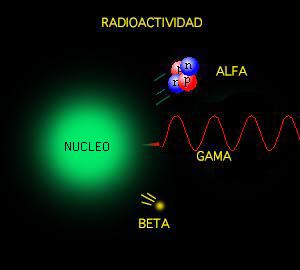

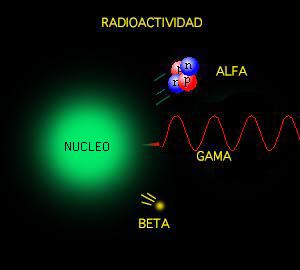

Poco tiempo después resultó evidente que existían otras subpartículas en el interior del átomo. Cuando Becquerel descubrió la radiactividad, identificó como emanaciones constituidas por electrones algunas de las radiaciones emitidas por sustancias radiactivas. Pero también quedaron al descubierto otras emisiones. Los Curie en Francia y Ernest Rutherford en Inglaterra detectaron una emisión bastante menos penetrante que el flujo electrónico. Rutherford la llamó rayos alfa, y denominó rayos beta a la emisión de electrones.

Partículas beta. Las partículas beta son electrones moviéndose a gran velocidad (próxima a la de la luz 0.98. c = 270000 km/s). Las radiaciones Alfa, Beta y Gamma con potencia diferentes

Los electrones volantes constitutivos de esta última radiación son, individualmente, partículas beta. Así mismo, se descubrió que los rayos alfa estaban formados por partículas, que fueron llamadas partículas alfa. Como ya sabemos, alfa y beta son las primeras letras del alfabeto griego y se escriben con los gráficos α y β.

Entretanto, el químico francés Paul Ulrico Villard descubría una tercera forma de emisión radiactiva, a la que dio el nombre de rayos gamma, es decir, la tercera letra del alfabeto griego (γ). Pronto se identificó como una radiación análoga a los rayos X, aunque de menor longitud de onda.

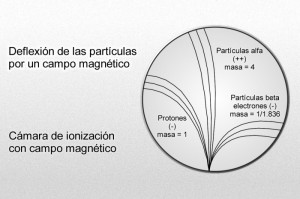

Mediante sus experimentos, Rutherford comprobó que un campo magnético desviaba las partículas alfa con mucho menos fuerza que las partículas beta. Por añadidura, las desviaba en dirección opuesta, lo cual significaba que la partícula alfa tenía una carga positiva, es decir, contraria a la negativa del electrón. La intensidad de tal desviación permitió calcular que la partícula alfa tenía como mínimo una masa dos veces mayor que la del hidrogenión, cuya carga positiva era la más pequeña conocida hasta entonces.

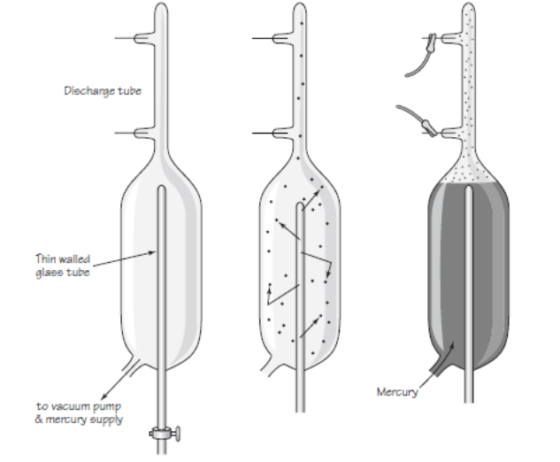

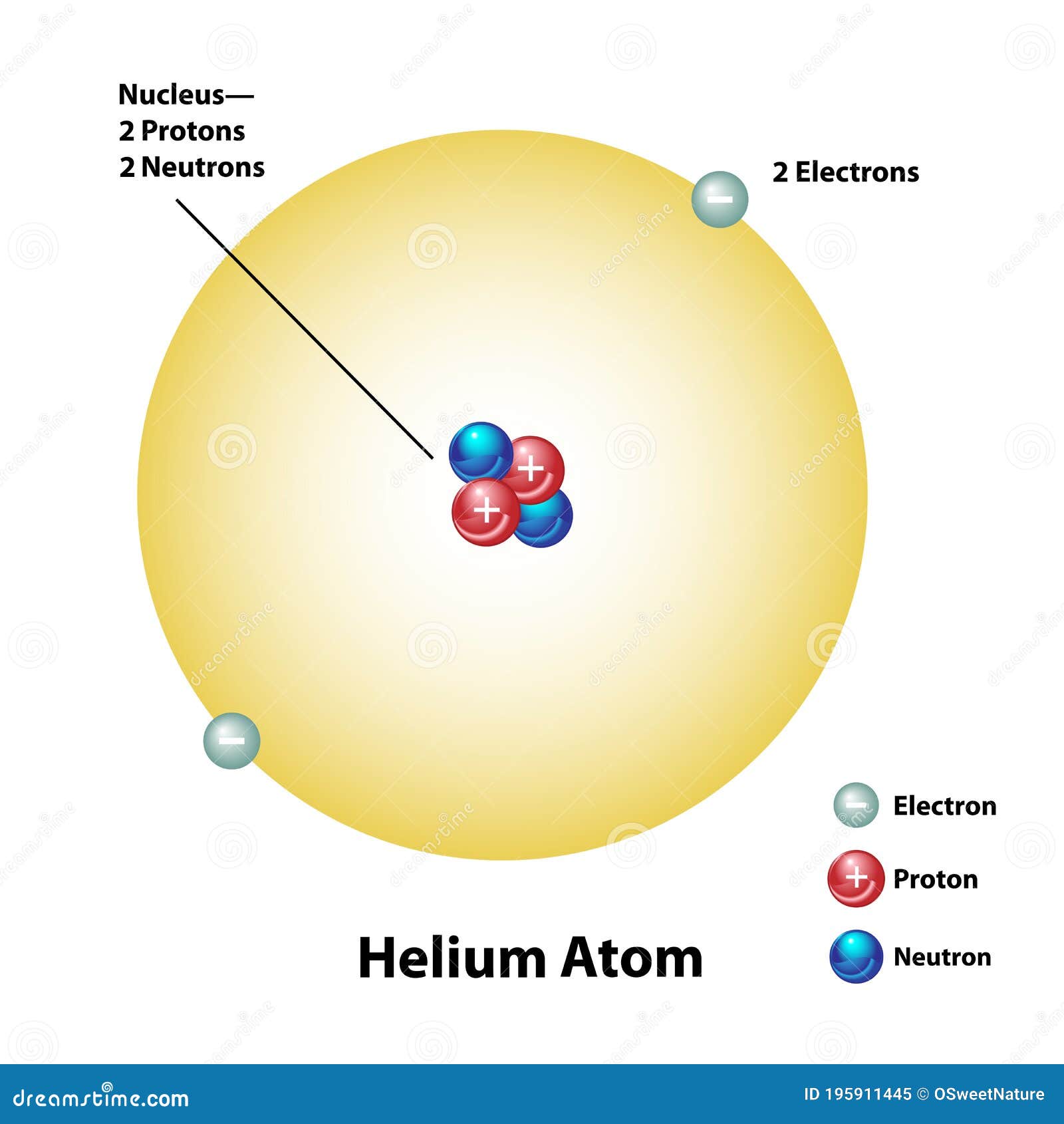

En 1.909, Rutherford pudo aislar las partículas alfa. Puso material radiactivo en un tubo de vidrio fino rodeado por vidrio grueso, e hizo el vacío entre ambas superficies. Las partículas alfa pudieron atravesar la pared fina, pero no la gruesa, lo que dio lugar a que las partículas quedaran aprisionadas entre ambas, y Rutherford recurrió entonces a la descarga eléctrica para excitar las partículas alfa, hasta llevarlas a la incandescencia. Entonces mostraron los rayos espectrales del helio.

Hay pruebas de que las partículas alfa producidas por sustancias radiactivas en el suelo constituyen el origen del helio en los pozos de gas natural.

Si la partícula alfa es helio, su masa debe ser cuatro veces mayor que la del hidrógeno. Ello significa que la carga positiva de éste último equivale a dos unidades, tomando como unidad la carga del hidrogenión.

Más tarde, Rutherford identificó otra partícula positiva en el átomo. A decir verdad, había sido detectada y reconocida ya muchos años antes. En 1.886, el físico alemán Eugen Goldstein, empleando un tubo catódico con un cátodo perforado, descubrió una nueva radiación que fluía por los orificios del cátodo en dirección opuesta a la de los rayos catódicos. La denominó rayos canales.

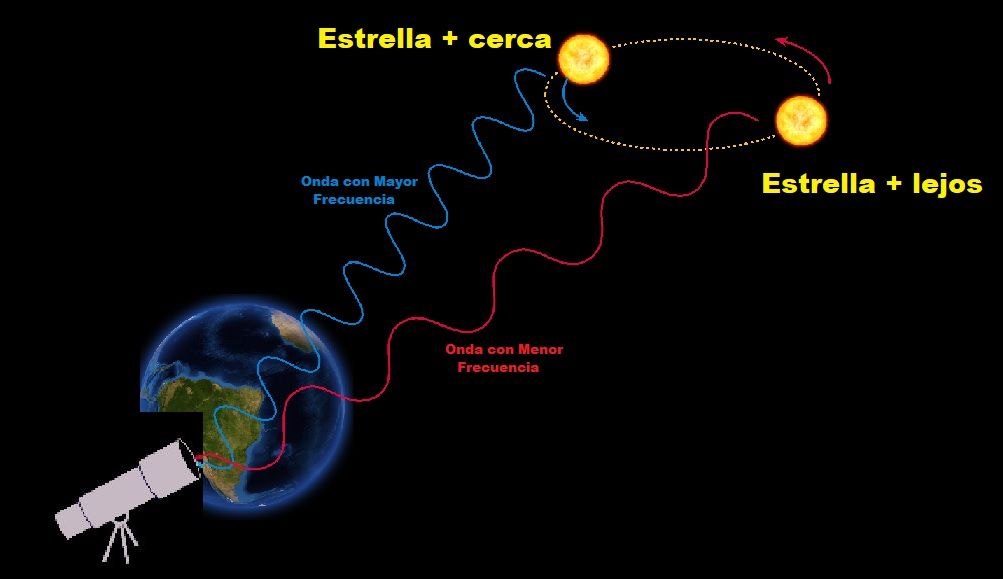

En 1.902, esta radiación sirvió para detectar por vez primera el efecto Doppler-Fizean respecto a las ondas luminosas de origen terrestre. El físico alemán de nombre Johannes Stara orientó un espectroscopio de tal forma que los rayos cayeron sobre éste, revelando la desviación hacia el violeta. Por estos trabajos se le otorgó el premio Nobel de Física en 1.919.

Puesto que los rayos canales se mueven en dirección opuesta a los rayos catódicos de carga negativa, Thomson propuso que se diera a esta radiación el nombre de rayos positivos. Entonces se comprobó que las partículas de rayos positivos podían atravesar fácilmente la materia. De aquí que fuesen considerados, por su volumen, mucho más pequeños que los iones corrientes o átomos. La desviación determinada, en su caso, por un campo magnético, puso de relieve que la más ínfima de estas partículas tenía carga y masa similares a los del hidrogenión, suponiendo que este ión contuviese la misma unidad posible de carga positiva.

Por consiguiente se dedujo que la partícula del rayo positivo era la partícula positiva elemental, o sea, el elemento contrapuesto al electrón; Rutherford lo llamó protón (del neutro griego proton, “lo primero”).

Protón carga positiva y electrón negativa. Ambas de la misma potencia

Desde luego, el protón y el electrón llevan cargas eléctricas iguales, aunque opuestas; ahora bien, la masa del protón, referida al electrón, es 1.836 veces mayor (como señalo en el gráfico anterior).

Parecía probable pues que el átomo estuviese compuesto por protones y electrones, cuyas cargas se equilibraran entre sí. También parecía claro que los protones se hallaban en el interior del átomo y no se desprendían, como ocurría fácilmente con los electrones. Pero entonces se planteó el gran interrogante: ¿cuál era la estructura de esas partículas El núcleo atómico

El núcleo atómico

El propio Rutherford empezó a vislumbrar la respuesta. Entre 1.906 y 1.908 (hace ahora un siglo) realizó constantes experimentos disparando partículas alfa contra una lámina sutil de metal (como oro o platino), para analizar sus átomos. La mayor parte de los proyectiles atravesaron la barrera sin desviarse (como balas a través de las hojas de un árbol), pero no todos. En la placa fotográfica que le sirvió de blanco tras el metal, Rutherford descubrió varios impactos dispersos e insospechados alrededor del punto central. Comprobó que algunas partículas habían rebotado. Era como si en vez de atravesar las hojas, algunos proyectiles hubiesen chocado contra algo más sólido. Rutherford supuso que aquella “balas” habían chocado contra una especie de núcleo denso, que ocupaba sólo una parte mínima del volumen atómico y ese núcleo de intensa densidad desviaban los proyectiles que acertaban a chocar contra él. Ello ocurría en muy raras ocasiones, lo cual demostraba que los núcleos atómicos debían ser realmente ínfimos, porque un proyectil había de encontrar por fuerza muchos millones de átomos al atravesar la lámina

Experimento de Rutherford que descubrió el núcleo atómico

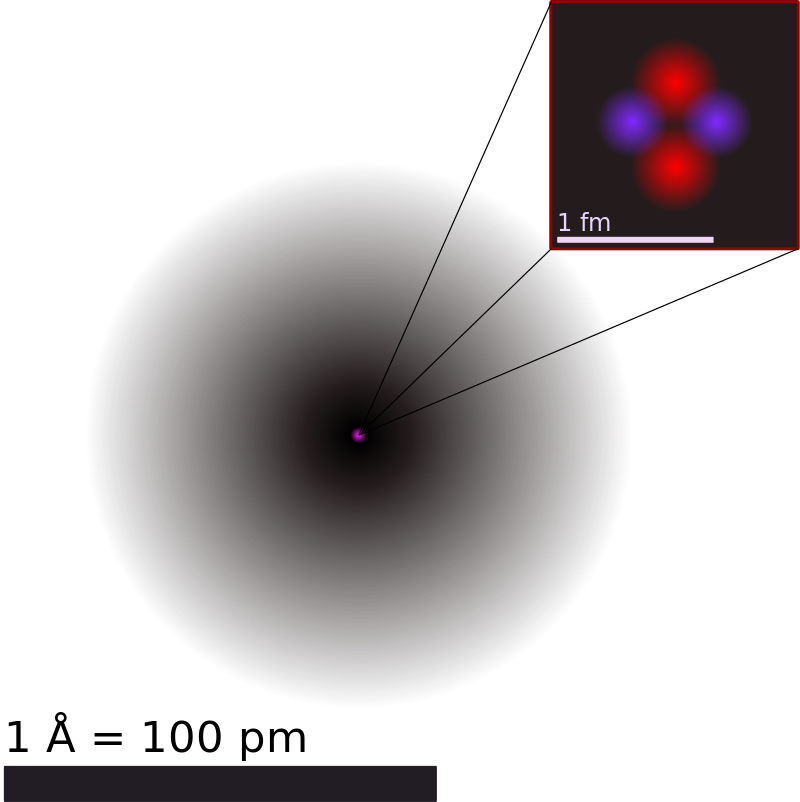

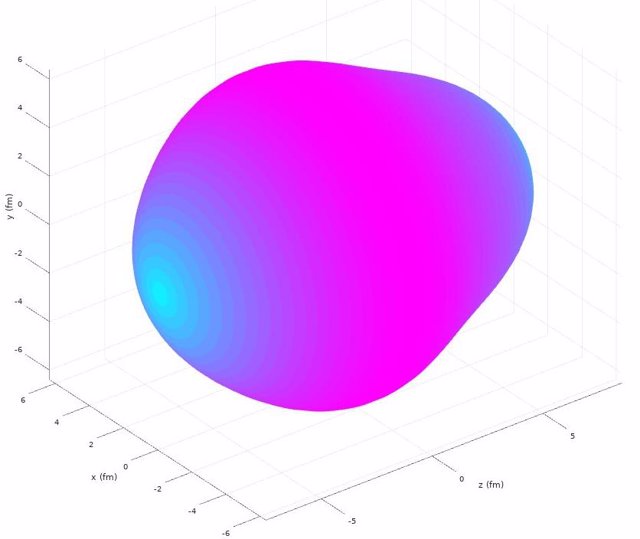

Era lógico suponer, pues, que los protones constituían ese núcleo duro. Rutherford representó los protones atómicos como elementos apiñados alrededor de un minúsculo “núcleo atómico” que servía de centro (después de todo eso, hemos podido saber que el diámetro de ese núcleo equivale a algo más de una cienmilésima del volumen total del átomo).

En 1.908 se concedió a Rutherford el premio Nobel de Química por su extraordinaria labor de investigación sobre la naturaleza de la materia. Él fue el responsable de importantes descubrimientos que permitieron conocer la estructura de los átomos en esa primera avanzadilla.

El átomo de Hidrógeno

Desde entonces se pueden describir con términos más concretos los átomos específicos y sus diversos comportamientos. Por ejemplo, el átomo de hidrógeno posee un solo electrón. Si se elimina, el protón restante se asocia inmediatamente a alguna molécula vecina; y cuando el núcleo desnudo de hidrógeno no encuentra por este medio un electrón que participe, actúa como un protón (es decir, una partícula subatómica), lo cual le permite penetrar en la materia y reaccionar con otros núcleos si conserva la suficiente energía.

El helio, que posee dos electrones, no cede uno con tanta facilidad. Sus dos electrones forman un caparazón hermético, por lo cual el átomo es inerte. No obstante, si se despoja al helio de ambos electrones, se convierte en una partícula alfa, es decir, una partícula subatómica portadora de dos unidades de carga positiva.

:format(jpg)/f.elconfidencial.com%2Foriginal%2Febb%2F97b%2F31e%2Febb97b31e26102fac36eba521365a96d.jpg)

“El litio es un metal altamente valioso y muy demandado por ser un elemento clave en la industria aeroespacial y para producir baterías. Físicamente, es un metal suave, blanco y brillante y varias de sus aleaciones y compuestos se producen a escala industrial, ya que se emplean para producir una variedad de dispositivos eléctricos y por ser clave en la apuesta por energías renovables. A pesar de que se ha popularizado su uso, este metal no abunda y los principales yacimientos se ubican en Chile, China, Argentina y Australia. No obstante, se han descubierto recientemente reservas de litio en Ucrania. En este sentido, se está cuestionando si las motivaciones de la invasión liderada por Putin pueden estar ligadas a estas estimaciones.”

Hay un tercer elemento, el litio, cuyo átomo tiene tres electrones. Si se despoja de uno o dos, se transforma en ión, y si pierde los tres, queda reducida a un núcleo desnudo, con una carga positiva de tres unidades.

Las unidades de carga positiva en el núcleo atómico deben ser numéricamente idénticas a los electrones que contiene por norma, pues el átomo suele ser un cuerpo neutro, y esta igualdad de lo positivo con lo negativo es el equilibrio. De hecho, los números atómicos de sus elementos se basan en sus unidades de carga positiva, no en las de carga negativa, porque resulta fácil hacer variar el número de electrones atómicos dentro de la formación iónica, pero en cambio se encuentran grandes dificultades si se desea alterar el número de sus protones.

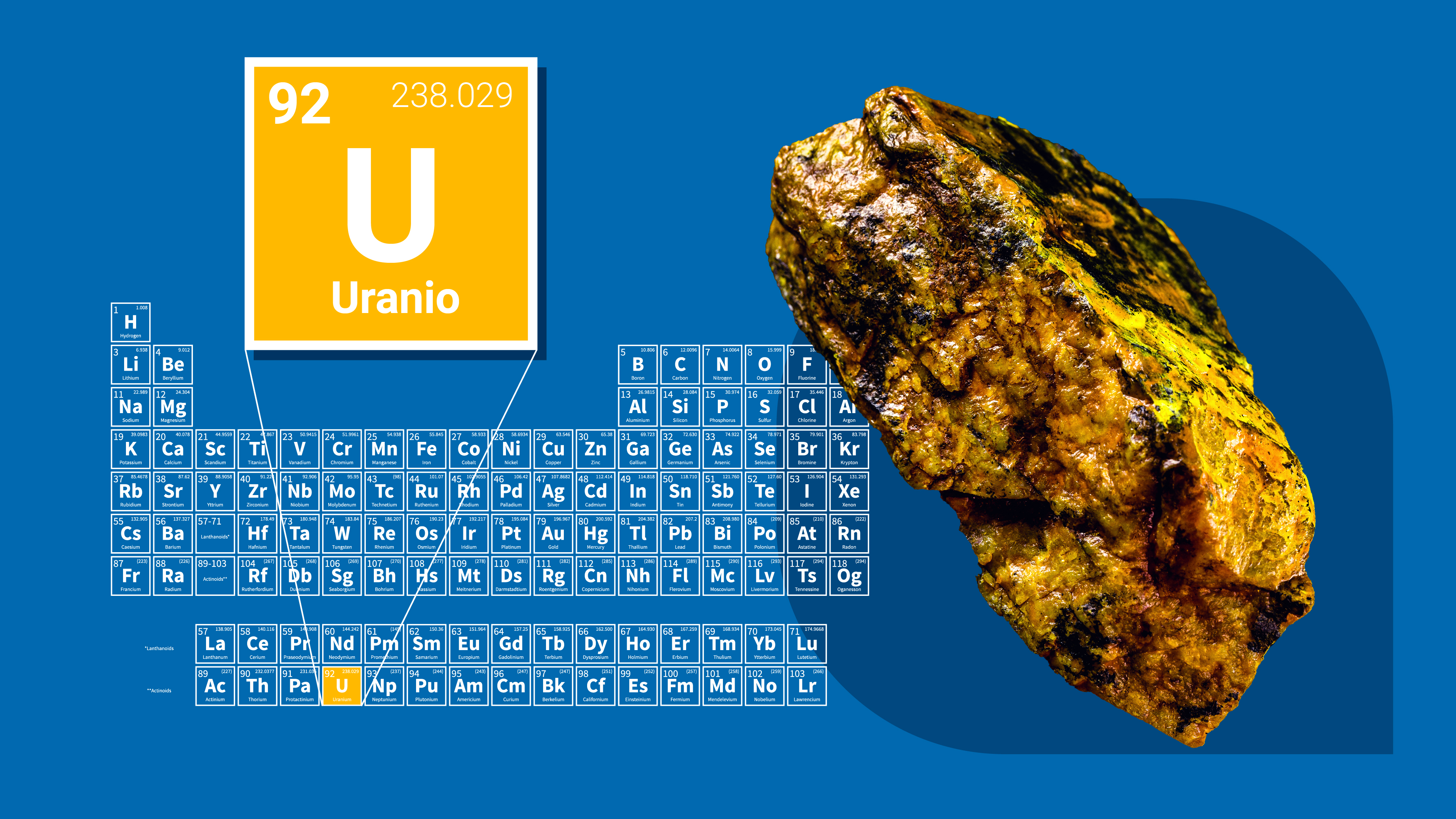

Apenas esbozado este esquema de la construcción atómica, surgieron nuevos enigmas. El número de unidades con carga positiva en un núcleo no equilibró, en ningún caso, el peso nuclear ni la masa, exceptuando el caso del átomo de hidrógeno. Para citar un ejemplo, se averiguó que el núcleo de helio tenía una carga positiva dos veces mayor que la del núcleo de hidrógeno; pero como ya se sabía, su masa era cuatro veces mayor que la de este último. Y la situación empeoró progresivamente a medida que se descendía por la tabla de elementos, e incluso cuando se alcanzó el uranio, se encontró un núcleo con una masa igual a 238 protones, pero una carga que equivalía sólo a 92.

¿Cómo era posible que un núcleo que contenía cuatro protones (según se suponía el núcleo de helio) tuviera sólo dos unidades de carga positiva? Según la más simple y primera conjetura emitida, la presencia en el núcleo de partículas cargadas negativamente y con peso despreciable neutralizaba dos unidades de carga. Como es natural, se pensó también en el electrón. Se podría componer el rompecabezas si se suponía que en núcleo de helio estaba integrado por cuatro protones y dos electrones neutralizadores, lo cual deja libre una carga positiva neta de dos, y así sucesivamente, hasta llegar al uranio, cuyo núcleo tendría, pues, 238 protones y 146 electrones, con 92 unidades libres de carga positiva. El hecho de que los núcleos radiactivos emitieran electrones (según se había comprobado ya, por ejemplo, en el caso de las partículas beta), reforzó esta idea general. Dicha teoría prevaleció durante más de una década, hasta que por caminos indirectos, llegó una respuesta mejor como resultado de otras investigaciones.

Pero entre tanto se habían presentado algunas objeciones rigurosas contra dicha hipótesis. Por lo pronto, si el núcleo estaba constituido esencialmente de protones, mientras que los ligeros electrones no aportaban prácticamente ninguna contribución a la masa, ¿Cómo se explicaba que las masas relativas de varios núcleos no estuvieran representadas por número enteros? Según los pesos atómicos conocidos, el núcleo del átomo cloro, por ejemplo, tenía una masa 35’5 veces mayor que la del núcleo de hidrógeno. ¿Acaso significaba esto que contenía 35’5 protones? Ningún científico (ni entonces ni ahora) podía aceptar la existencia de medio protón.

Este singular interrogante encontró una respuesta incluso antes de solventar el problema principal, y ello dio lugar a una interesante historia.

Isótopos; construcción de bloques uniformes

Allá por 1.816, el físico inglés William Prout había insinuado ya que el átomo de hidrógeno debía entrar en la constitución de todos los átomos. Con el tiempo se fueron desvelando los pesos atómicos, y la teoría de Prout quedó arrinconada, pues se comprobó que muchos elementos tenían pesos fraccionarios (para lo cual se tomó el oxígeno, tipificado al 16). El cloro, según dije antes, tiene un peso atómico aproximado de 35’5, o para ser exactos, 35’457. otros ejemplos son el antimonio, con un peso atómico de 121’75, el galio con 137’34, el boro con 10’811 y el cadmio con 112’40.

Hacia principios de siglo se hizo una serie de observaciones desconcertantes, que condujeron al esclarecimiento. El inglés William Crookes (el del tubo Crookes) logró disociar del uranio una sustancia cuya ínfima cantidad resultó ser mucho más radiactiva que el propio uranio. Apoyándose en su experimento, afirmó que el uranio no tenía radiactividad, y que ésta procedía exclusivamente de dicha impureza, que él denominó uranio X. Por otra parte, Henri Becquerel descubrió que el uranio purificado y ligeramente radiactivo adquiría mayor radiactividad con el tiempo, por causas desconocidas. Si se deja reposar durante algún tiempo, se podía extraer de él repetidas veces uranio activo X. Para decirlo de otra manera, por su propia radiactividad, el uranio se convertía en el uranio X, más radiactivo aún.

Un isótopo del torio para explicar el misterio materia-antimateria

Por entonces, Rutherford, a su vez, separó del torio un torio X muy radiactivo, y comprobó también que el torio seguía produciendo más torio X. Hacia aquellas fechas se sabía ya que el más famoso de los elementos radiactivos, el radio, emitía un gas radiactivo, denominado radón. Por tanto, Rutherford y su ayudante, el químico Frederick Soddy, dedujeron que durante la emisión de sus partículas los átomos radiactivos se transformaron en otras variedades de átomos radiactivos.

Varios químicos que investigaron tales transformaciones lograron obtener un surtido muy variado de nuevas sustancias, a las que dieron nombres tales como radio A, radio B, mesotorio I, mesotorio II y actinio C. Luego los agruparon todos en tres series, de acuerdo con sus historiales atómicos. Una serie se originó del uranio disociado; otra del torio, y la tercera del actinio (si bien más tarde se encontró un predecesor del actinio, llamado protactinio).

“El origen etimológico de su nombre proviene del término actinio y el griego protos ( πρῶτος), que significa primero. La conjunción de estos términos significa entonces “padre del actinio” porque, entre otras cosas, el actinio (Ac) surge como un producto de la desintegración radiactiva del protactinio. De cierto modo, el protactinio fue mencionado o predecido por el gran Dimitri Mendeleev ya en 1871, aunque el descubrimiento en sí se le atribuye al químico alemán Otto Hahn y la física austriaca Lise Meitner. Sin embargo, el protactinio no fue aislado hasta 1934, cuando así lo consiguió el químico nuclear Aristid von Grosse, de origen germano.”

En total se identificaron unos cuarenta miembros de esas series, y cada uno se distinguió por su peculiar esquema de radiación. Pero los productos finales de las tres series fueron idénticos: en último término, todas las cadenas de sustancias conducían al mismo elemento, el plomo.

El último elemento de la Tabla Periódica que son todos naturales. Existen otros artificiales “Los Transuránicos“

En química, los Elementos transuránicos (conocidos también como elementos transuránicos) son elementos químicos con número atómico mayor que 92, el número atómico del elemento uranio. El nombre de trans-uránidos significa “más allá del uranio”

Todos los elementos transuránicos son muy radiactivos como el Plutonio

Lista de los elementos transuránicos

|

Ahora bien, esas cuarenta sustancias no podían ser, sin excepción, elementos disociados. Entre el uranio (92) y el plomo (82) había sólo diez lugares en la tabla periódica, y todos ellos, salvo dos, pertenecían a elementos conocidos.

Emilio Silvera Vázquez

Jun

19

La Imaginación: ¡Mucho más rápida que la Luz!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (8)

Comments (8)

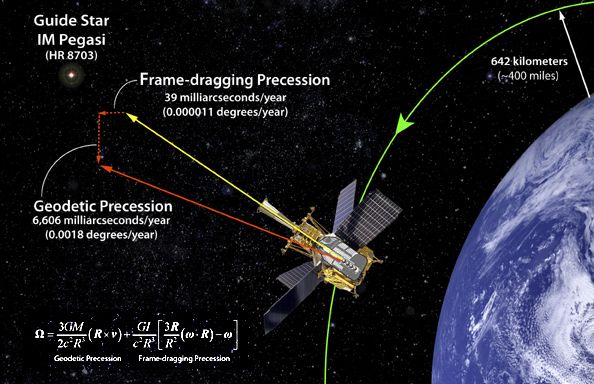

Satélite Gravity Probe B.

Dedicado a medir la curvatura del campo gravitatorio terrestre debido a la teoría de la relatividad de Einstein. La gravedad ha sido medida y comprobada de muchas maneras pero… ¡Gravedad cuántica! ¿qué es eso? La imaginación anda más rápida que los conocimientos. Sin embargo, así hemos ido avanzando en el transcurrir del Tiempo.

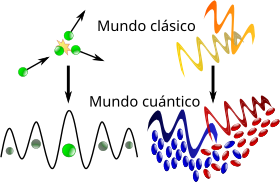

La llamada gravedad cuántica trata de fundir en una sola las dos teorías físicas más soberbias con las que contamos, la relatividad general y la mecánica cuántica, que en el estado actual de nuestro conocimiento parecen incompatibles. Su estudio, ahora mismo, es en algunos aspectos análogo a la física de hace cien años, cuando se creía en los átomos, pero se ignaraban los detalles de su estructura.

Desde aquel día en que Kaluza, le escribió a Einstein una carta con su teoría de las cinco dimensiones, en la que unía la Gravedad con el Electromagnetismo, la puerta de las dimensiones más altas quedó abierta y a los teóricos se les regaló una herramienta maravillosa: el hiperespacio; todo es posible. Hasta el matrimonio de la relatividad general y la mecánica cuántica, allí sí es posible encontrar esa soñada teoría de la gravedad cuántica.

Así que las teorías se han embarcado a la búsqueda de un objeto audaz: buscan una teoría que describa la simplicidad primigenia que reinaba en el intenso calor del universo en sus primeros tiempos; una teoría carente de parámetros, donde estén presentes todas las respuestas. Todo debe ser contestado a partir de una ecuación básica.

![59 - Curso de Relatividad General [Ecuaciones de Campo & Constante Cosmológica] - YouTube](https://i.ytimg.com/vi/HI3m80zLo24/maxresdefault.jpg)

Hay que reconocer que nos dice mucho

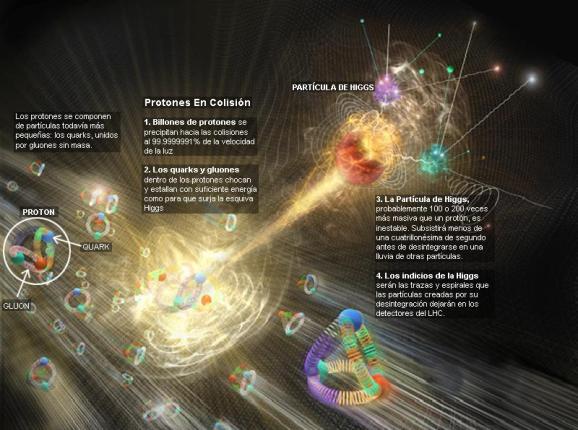

Claro que saber, lo que el universo es, leyendo una ecuación, por muy ingeniosa que ésta sea y por mucho que la misma pueda abarcar… Parece poco probable. ¿Dónde radica el problema? El problema está en que la única teoría candidata no tiene conexión directa con el mundo de la observación, o no lo tiene todavía si queremos expresarnos con propiedad. La energía necesaria para ello, no la tiene ni el nuevo acelerador de partículas LHC, la máquina más potente del mundo hasta el momento.

La verdad es que la teoría que ahora tenemos, el modelo estándar, concuerda de manera exacta con todos los datos a bajas energías y contesta cosas sin sentido a altas energías. ¡Necesitamos algo más avanzado!

A pesar de su grandeza, se queda corto para que nos pueda decir, lo que necesitamos saber: Si nos habla del Bosón de Higgs, ya estará bien

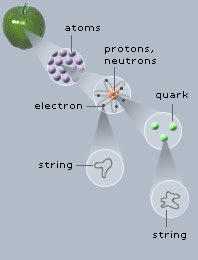

Se ha dicho que la función de la partícula de Higgs es la de dar masa a las partículas que carecen de ella, disfrazando así la verdadera simetría del mundo. Cuando su autor lanzó la idea a la comunidad científica, resultó además de nueva, muy extraña. El secreto de todo radica en conseguir la simplicidad: el átomo resultó ser complejo, lleno de esas infinitesimales partículas electromagnéticas que bautizamos con el nombre de electrones. Resultó que tenía un núcleo que contenía, a pesar de ser tan pequeño, casi toda la masa del átomo. El núcleo, tan pequeño, estaba compuesto de otros objetos más pequeños aún; los quarks que estaban instalados en nubes de otras partículas llamadas gluones, y ahora queremos continuar profundizando, sospechando que después de los quarks puede haber algo más.

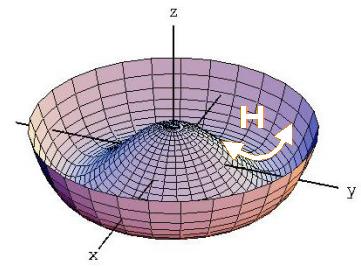

Ahí las partículas toman su masa por el efecto frenado

Nos dicen que existen lugares que llaman los Océanos de Higgs, y, por ellos, circula libremente el dichoso Bosón que, también según nos dicen, proporciona la masa al resto de las partículas. Todo el Universo está permeado por esa especie de sustancia -como el viejo éter- que los griegos llamaban Ylem cósmico y que, a medida que el tiempo avanza, le vamos cambiando el nombre. Pues bien, ahí, en ese “océano” dicen que está el Bosón dador de masas.

Bueno, la idea nueva que surgió es que el espacio entero contiene un campo, el campo de Higgs, que impregna el vacío y es el mismo en todas partes, es decir, que si miramos a las estrellas en una noche clara, estamos mirando el campo de Higgs. Las partículas influidas por este campo toman masa. Esto no es por sí mismo destacable, pues las partículas pueden tomar energía de los campos (gauge) de los que hemos comentado otras veces, tales como: del campo gravitatorio o del electromagnético.

Si llevamos un bloque de plomo a lo alto de la Torre Eiffel, el bloque adquirirá energía potencial a causa de la alteración de su posición en el campo gravitatorio de la Tierra. Como E = mc2, ese aumento de la energía potencial equivale a un aumento de la masa, en este caso la masa del sistema Tierra-bloque de plomo. Aquí hemos de añadirle amablemente un poco de complejidad a la venerable ecuación de Einstein: la masa, m, tiene en realidad dos partes; una es la masa en reposo, m0, la que se mide en el laboratorio cuando la partícula está en reposo. La partícula adquiere la otra parte de la masa en virtud de su movimiento (como los protones en el acelerador de partículas, o los muones, que aumentan varias veces su masa cuando son lanzados a velocidades cercanas a c) en los aceleradores, o en virtud de su energía potencial de campo. Vemos una dinámica similar en los núcleos atómicos. Por ejemplo, si separamos el protón y el neutrón que componen un núcleo de deuterio, la suma de las masas aumenta.

Pero la energía potencial tomada del campo de Higgs difiere en varios aspectos de la acción de los campos familiares. La masa tomada de Higgs es en realidad masa en reposo. De hecho, en la que quizá sea la versión más apasionante de la teoría del campo de Higgs, éste genera toda la masa en reposo. Otra diferencia es que la cantidad de masa que se traga del campo es distinta para las distintas partículas. Los teóricos dicen que las masas de las partículas de nuestro modelo estándar miden con qué intensidad se acoplan éstas al campo de Higgs.

La influencia de Higgs en las masas de los quarks y de los leptones nos recuerda el descubrimiento por Pieter Zeeman, en 1.896, de la división de los niveles de energía de un electrón cuando se aplica un campo magnético al átomo. El campo (que representa metafóricamente el papel de Higgs) rompe la simetría del espacio de la que el electrón disfrutaba.

Hasta ahora no tenemos ni idea de qué reglas controlan los incrementos de masa generados por Higgs (de ahí la expectación creada por el nuevo acelerador de partículas LHC), pero el problema es irritante: ¿por qué sólo esas masas - las masas de los W+, W–, Z0, y el up, down, encanto, extraño, top y bottom, así como los leptones – que no forman ningún patrón obvio?

Las masas van desde la del electrón (0’0005 GeV) a la del top, que tiene que ser mayor que 91 GeV. Deberíamos recordar que esta extraña idea (el Higgs) se empleó con mucho éxito para formular la teoría electrodébil (Weinberg-Salam). Allí se propuso el campo de Higgs como una forma de ocultar la unidad de las fuerzas electromagnética y débil. En la unidad hay cuatro partículas mensajeras sin masa – los W+, W–, Z0 y el fotón – que llevan la fuerza electrodébil. Además está el campo de Higgs, y rápidamente, los W y Z absorben la esencia de Higgs y se hacen pesados; el fotón permanece intacto. La fuerza electrodébil se fragmenta en la débil (débil porque los mensajeros son muy gordos), y la electromagnética, cuyas propiedades determina el fotón, carente de masa. La simetría se rompe espontáneamente, dicen las teorías. Prefiero la descripción según la cual el Higgs oculta la simetría con su poder dador de masa.

Tampoco el Higgs es una partícula especial porque sea una excitación del del campo de Higgs que nos permita explorar sus propiedades, porque en las teorías sin Higgs o con Higgs compuesto también hay excitaciones del vacío que nos permiten explorar el campo.”

Eso nos dicen en el magnifico Blog de Francis (th)E mule Science’s News.

| Partícula | Símbolo | Masa (en GeV/c2) | Carga eléctrica | Espín | Interacción |

|---|---|---|---|---|---|

| Fotón |  |

0 | 0 | 1 | electromagnética |

| Bosón W | W± | 80,4 | ± 1 | 1 | débil |

| Bosón Z | Z0 | 91,187 | 0 | 1 | débil |

| Gluón | g | 0 | 0 | 1 | fuerte |

Las masas de los W y Z se predijeron con éxito a partir de los parámetros de la teoría electrodébil, y las relajadas sonrisas de los físicos teóricos nos recuerdan que Hooft y Veltman dejaron sentado que la teoría entera está libre de infinitos.

Todos los intentos y los esfuerzos por hallar una pista de cuál era el origen de la masa fallaron. Feynman escribió su famosa pregunta: “¿por qué pesa el muón?”. Ahora, por lo menos, tenemos una respuesta parcial, en absoluto completa. Una voz potente y segura nos dice “¡Higgs!”. Durante más de sesenta años los físicos experimentadores se rompieron la cabeza con el origen de la masa, y ahora el campo de Higgs presenta el problema en un contexto nuevo; no se trata sólo del muón. Proporciona, por lo menos, una fuente común para todas las masas. La nueva pregunta feynmaniana podría ser: ¿Cómo determina el campo de Higgs la secuencia de masas, aparentemente sin patrón, que da a las partículas de la materia?

La variación de la masa con el estado de movimiento, el cambio de masa con la configuración del sistema y el que algunas partículas (el fotón seguramente, y los neutrinos posiblemente) tengan masa en reposo nula son tres hechos que ponen en entredicho que el concepto de masa sea un atributo fundamental de la materia. Habrá que recordar aquel cálculo de la masa que daba infinito y nunca pudimos resolver; los físicos sólo se deshicieron de él “renormalizándolo”, ese truco matemático que emplean cuando no saben hacerlo bien.

¿Sabremos alguna vez cómo adquieren masa las partículas?

Ese es el problema de trasfondo con el que tenemos que encarar el problema de los quarks, los leptones y los vehículos de las fuerzas, que se diferencian por sus masas. Hace que la historia de Higgs se tenga en pie: la masa no es una propiedad intrínseca de las partículas, sino una propiedad adquirida por la interacción de las partículas y su entorno.

La idea de que la masa no es intrínseca como la carga o el espín resulta aún más plausible por la idílica idea de que todos los quarks y fotones tendrían masa cero. En ese caso, obedecerían a una simetría satisfactoria, la quiral, en la que los espines estarían asociados para siempre con su dirección de movimiento. Pero ese idilio queda oculto por el fenómeno de Higgs.

Una cosa más; hemos hablado de los bosones gauge y de su espín de una unidad. Hemos comentado también las partículas fermiónicas de la materia (espín de media unidad). ¿Cuál es el pelaje de Higgs? Es un bosón de espín cero. El espín supone una direccionalidad en el espacio, pero el campo de Higgs da masa a los objetos donde quiera que estén y sin direccionalidad. Al Higgs se le llama a veces “bosón escalar” (sin dirección) por esa razón.

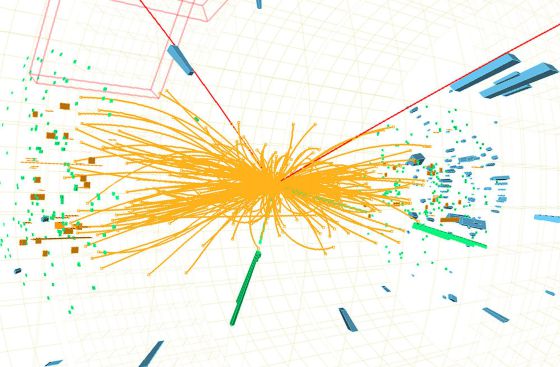

La interacción débil, recordaréis, fue inventada por E. Fermi para describir la desintegración radiactiva de los núcleos, que era básicamente un fenómeno de poca energía, y a medida que la teoría de Fermi se desarrolló, llegó a ser muy precisa a la hora de predecir un enorme número de procesos en el dominio de energía de los 100 MeV. Así que ahora, con las nuevas tecnologías y energías del LHC, las esperanzas son enormes para, por fin, encontrar el bosón de Higgs origen de la masa… y algunas cosas más.

Hay que responder montones de preguntas: ¿cuáles son las propiedades de las partículas de Higgs? y, lo que es más importante, ¿cuál es su masa? (Bueno, parece que, en el último experimento apareció se localizó un bosón con ~125 GeV que, según parece, podría ser el esquivo Hihhs)¿Cómo reconoceremos una si nos la encontramos en una colisión del LHC? ¿Cuántos tipos hay? ¿Genera el Higgs todas las masas o sólo las hace incrementarse? ¿Cómo podemos saber más al respecto? Cómo es su partícula, nos cabe esperar que la veremos ahora después de gastar más de 50.000 millones de euros en los elementos necesarios para ello.

También a los cosmólogos les fascina la idea de Higgs, pues casi se dieron de bruces con la necesidad de tener campos escalares que participasen en el complejo proceso de la expansión del universo, añadiendo pues, un peso más a la carga que ha de soportar el Higgs.

El campo de Higgs, tal como se lo concibe ahora, se puede destruir con una energía grande, o temperaturas altas. Éstas generan fluctuaciones cuánticas que neutralizan el campo de Higgs. Por lo tanto, el cuado que las partículas y la cosmología pintan juntas de un universo primitivo puro y de resplandeciente simetría es demasiado caliente para Higgs. Pero cuando la temperatura cae bajo los 10-5 grados Kelvin o 100 GeV, el Higgs empieza a actuar y hace su generación de masas. Así, por ejemplo, antes del Higgs teníamos unos W, Z y fotones sin masa y la fuerza electrodébil unificada.

No, esto no es el Higgs, es, simplemente, una burbuja multicolor

El universo se expande y se enfría, y entonces viene el Higgs (que “engorda” los W y Z, y por alguna razón ignora el fotón) y de ello resulta que la simetría electrodébil se rompe. Tenemos entonces una interacción débil, transportada por los vehículos de la fuerza W+, W–, Z0, y por otra parte una interacción electromagnética, llevada por los fotones. Es como si para algunas partículas del campo de Higgs fuera una especie de aceite pesado a través del que se moviera con dificultad y que les hiciera parecer que tienen mucha masa. Para otras partículas, el Higgs es como el agua, y para otras, los fotones y quizá los neutrinos, es invisible.

De todas formas, es tanta la ignorancia que tenemos sobre el origen de la masa que nos agarramos como a un clavo ardiendo, en este caso, a la partícula de Higgs, que algunos han llegado a llamar “la partícula divina”. Lo mismo nos pasa con la dichosa “materia oscura” para ocultar lo que no sabemos sobre la expansión del Universo.

¡Ya veremos en qué termina todo esto!

Arriba tenemos nada más y nada menos que: a John Mather, Carlo Rubbia, Martinus Veltman, Gerardus ‘t Hooft at the Lindau Nobel Meetings 2010. Si científicos como ellos no vienen a nuestro rescate, y nos sacan del atolladero en el que estamos inmerso y hasta el cuelo de ignorancia…¡Mal irán las cosas!

Peter Higgs, de la Universidad de Edimburgo, introdujo la idea en la física de partículas. La utilizaron los teóricos Steven Weinberg y Abdus Salam, que trabajaban por separado, para comprender cómo se convertía la unificada y simétrica fuerza electrodébil, transmitida por una feliz familia de cuatro partículas mensajeras de masa nula, en dos fuerzas muy diferentes: la QED con un fotón carente de masa y la interacción débil con sus W+, W– y Z0 de masa grande. Weinberg y Salam se apoyaron en los trabajos previos de Sheldon Glashow, quien, tras los pasos de Julian Schwinger, sabía sólo que había una teoría electrodébil unificada, coherente, pero no unió todos los detalles. Y estaban Jeffrey Goldstone y Martinus Veltman y Gerard’t Hooft. También hay otros a los que habría que mencionar, pero lo que siempre pasa, quedan en el olvido de manera injusta. Además, ¿Cuántos teóricos hacen falta para encender una bombilla? La verdad es que, casi siempre, han hecho falta muchos. Recordemos el largo recorrido de los múltiples detalles sueltos y físicos que prepararon el terreno para que llegara Einstein y pudiera, uniéndolo todo, exponer su teoría relativista.

Lo cierto es que (al menos de momento), la materia y energía oscura, las supercuerdas, y el bosón de Higss, sí son la alfonbra que decía Veltman, aquel físico serio y Premio Nobel que, no confesaba con ciertas ruedas de molino. Él, quería hablar de cosas tamgibles y, tampoco le gustaban las partículas virtuales.

Sobre la idea de Peter Higgs, Veltman, uno de sus arquitectos, dice que es una alfombra bajo la que barremos nuestra ignorancia. Glashow es menos amable y lo llamó retrete donde echamos las incoherencias de nuestras teorías actuales. La objeción principal: que no tenemos la menor prueba experimental. Ahora, por fin, la tendremos con el LHC. El modelo estándar es lo bastante fuerte para decirnos que la partícula de Higgs de menor masa (podría haber muchas) debe “pesar” menor de 1 TeV, ¿por qué?; si tiene más de 1 TeV el modelo estándar se vuelve incoherente y tenemos la crisis de la unitariedad.

Después de todo esto, llego a la conclusión de que el campo de Higgs, el modelo estándar y nuestra idea de surgió el universo dependen de que se encuentre el bosón de Higgs. Y ahora, por fin, tenemos un acelerador con la energía necesaria para que nos la muestre, y que con su potencia pueda crear para nosotros una partícula que pese nada menos que 1 TeV.

Emilio Silvera Vázquez

Jun

19

Será por soñar

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (2)

Comments (2)

Jun

19

¿La sustancia cósmica? ¡La semilla de la materia!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en La ignorancia nos acompaña siempre ~

Clasificado en La ignorancia nos acompaña siempre ~

Comments (3)

Comments (3)

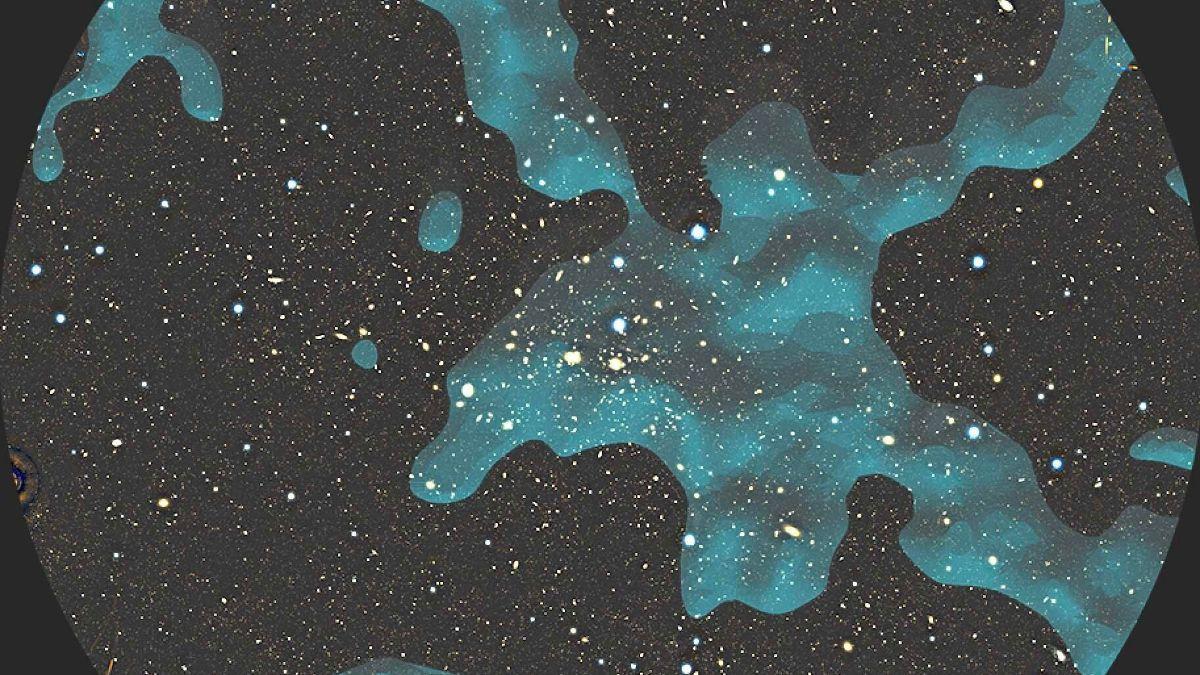

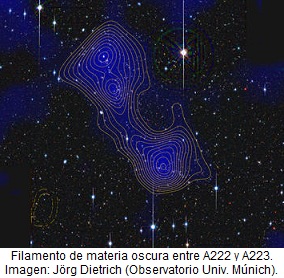

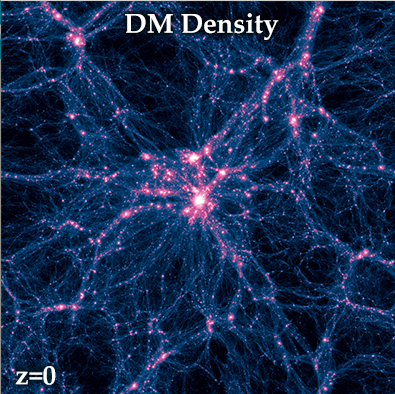

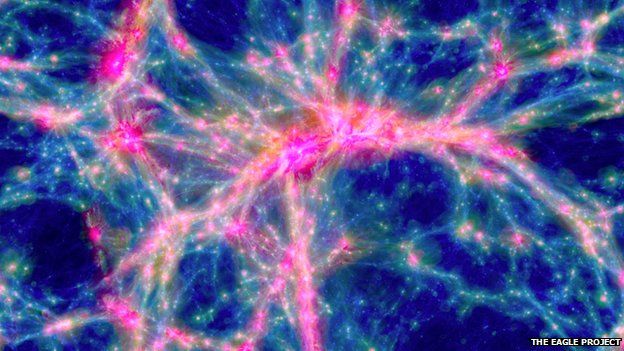

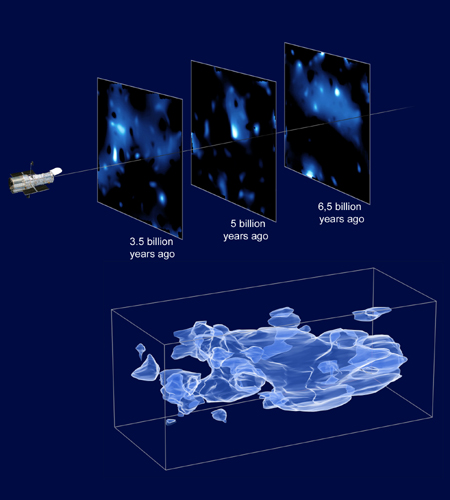

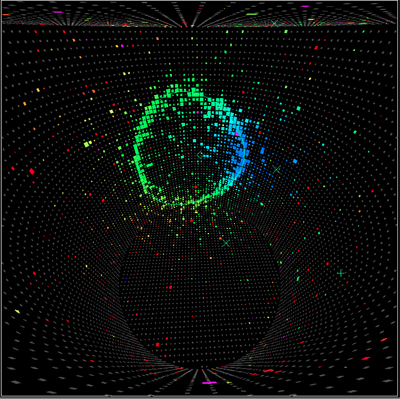

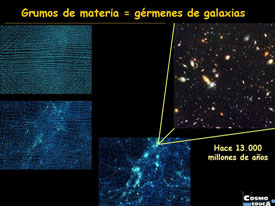

Debajo de éstas imágenes se puede leer:

“Hallan indicios de materia oscura unida al Cosmos. La evidencia muestra nuevos fenómenos físicos que podrían ser la extraña y desconocida materia oscura o la energía que se origina de los pulsares. Un detector de rayos cósmicos de dos mil millones de dólares en la Estación Espacial Internacional halló la huella de algo que pudiera ser la materia oscura, la misteriosa sustancia que se cree mantiene unido al cosmos.”

“Pero los primeros resultados del Espectrómetro Magnético Alfa (AMS, por sus siglas en inglés) son casi tan enigmáticos como la materia oscuraen sí, la cual nunca ha sido observada directamente. Muestran evidencia de nuevos fenómenos físicos que podrían ser la extraña y desconocida materia oscura o la energía que se origina de los pulsares, anunciaron un miércoles científicos en el laboratorio europeo de física de partículas cerca de Ginebra.”

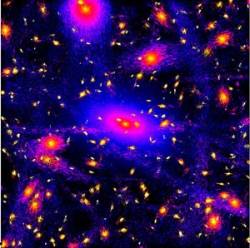

Todo lo que podemos observar en el Universo está hecho de esa materia, es decir, la que está compuesta de Quarks (que constituyen hadrones) y Leptones. Forman los átomos y éstos las moléculas que construyen los cuerpos y las sustancias que emiten radiación y generan Gravedad, lo contrario de la hipotética “materia oscura” a la que adjudican el 23% de la materia del Universo (sin que la podamos ver, sin que sepamos nada de ella, sin haberla detectado…), el resto lo dejan para la “energía oscura”… ¡Qué cosas!

Hablan de ella como si la tuviéramos a la vista, la pudiéramos pesar y medir, o, en una palabra, como si de algo real se tratara. En realidad se deberían referir a “ella” diciendo: Parece que las galaxias se comportan de manera tan extraña porque podría existir una especie de materia que no podemos ver, una sustancia cósmica o semilla primordial que está pendiente de confirmar su verdadera existencia.

Sí, y, materia oscura congelada, materia oscura sonriente, materia oscura dormida… Y, añado Yo: ¿Materia Oscura inexistente?

“Si, se ha detectado materia oscura alrededor de las galaxias. Los científicos no pueden ver la materia oscura directamente, pero deducen su presencia a través de sus efectos gravitacionales en las estrellas y galaxias. La materia oscura parece influir en la forma en que las galaxias giran y se agrupan, y también afecta a la luz que pasa cerca de ellas, causando un efecto de lente gravitacional. “

Como no me canso de repetir, cualquiera de estas noticias nos vienen a decir que, de la “materia oscura”, nada sabemos. Sería conveniente, para que las cuentas cuadren, que exista esa dichosa clase de materia o lo que pueda ser, toda vez que, sin ella, no resulta fácil llegar a una conclusión lógica de cómo se pudieron formar las galaxias, o, de por qué se mueven las estrellas de la manera que lo hacen y las galaxias se alejan las unas de las otras a la velocidad inusual, más rápido que lo harían si la materia existente en nuestro Universo sólo fuese la Bariónica, la que podemos ver, la que emite radiación, de la que están hechas todas las cosas que podemos ver incluidos los seres vivos.

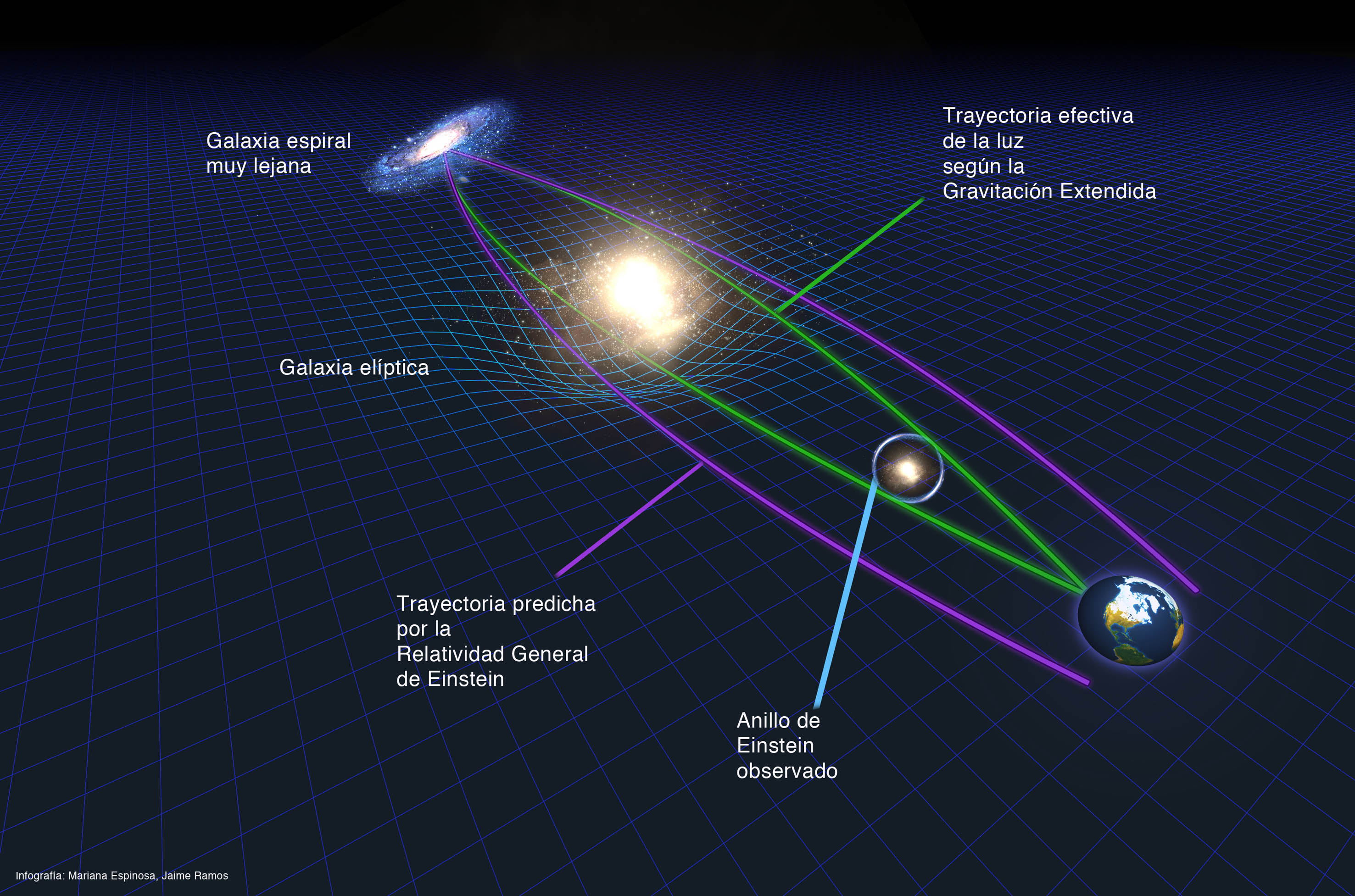

Hace treinta años, los astrofísicos se enfrentan a este dilema: o bien las galaxias tienen mucha materia que no vemos, pero que causa una fuerte atracción gravitatoria sobre las estrellas externas (que por ello orbitarían tan rápido) o bien ni la ley de la gravedad de Newton ni la de Einstein serían válidas esas regiones externas de las galaxias. Las dos opciones son revolucionarias para la física: la primera implica la existencia de materia oscura en el universo (materia que no vemos pero que sí afecta al movimiento de las estrellas y galaxias), y la segunda implica que una ley básica (la de Newton/Einstein de la gravitación) es incorrecta.

En el momento actual, no sabemos cual de esas dos opciones es la buena (podrían incluso ser buenas las dos, es decir, que existiera materia oscura y además que la teoría de Newton/Einstein estuviera mal. No creo que sea ese el problema, debe haber una tercera opción desconocida que debemos encontrar). La gran mayoría de los astrofísicos prefieren explicarlo con la materia oscura (un camino cómodo y fácil) antes que dudar de las leyes de la gravitación de Newton/Einstein. Esto no es sólo cuestión de gustos, es que las leyes de la gravitación funcionan con una increíble exactitud en todos los demás casos donde las hemos puesto a prueba (en los laboratorios, en las naves espaciales y los interplanetarios, en la dinámica del Sistema Solar, etc.).

El problema de la materia oscura (si es que realmente existe y no es que las leyes de Newton/Einstein sean incompletas) es uno de los más importantes con los que se enfrenta la astrofísica hoy en día.

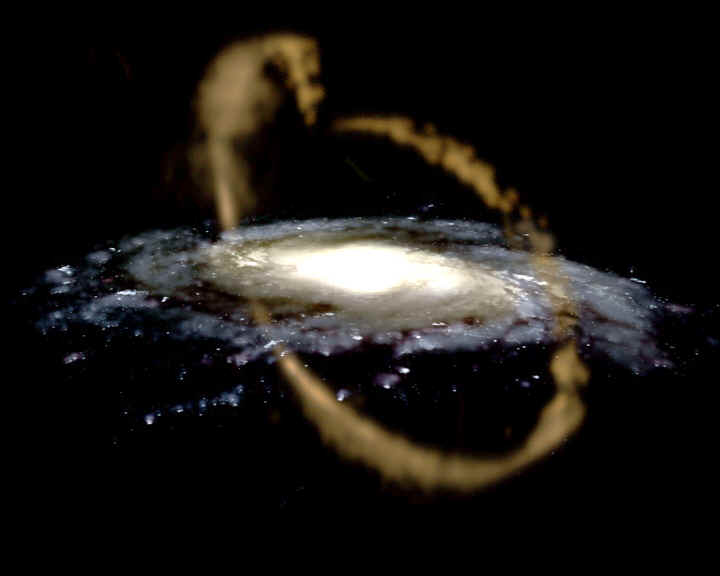

Cuando pienso en la existencia ineludible de esa “materia cósmica” primigenia, la primera y más sencilla clase de materia que se formó en las primeras fracciones del primer segundo del Big Bang, en la mente se me aparece una imagen llena de belleza creadora a partir de la cual, todo lo que ahora podemos contemplar es posible. La belleza de la idea es que toma dos problemas -la ventana del tiempo inadecuada para la formación de las galaxias y la existencia de la “materia oscura”- y los une para conformar una solución al dilema central de la estructura del universo.

La “materia oscura”, por hipótesis, tiene una ventana de tiempo mucho más larga que la materia ordinaria, porque se desapareja más pronto en el Big Bang. Tiene mucho tiempo para acumularse antes de que la materia ordinaria sea libre para hacerlo y formar los átomos. La “materia oscura o sustancia cósmica primera, es de porte más sencillo y no tiene ni requiere la complejidad de la materia bariónica para formarse, es totalmente translúcida y se sitúa por todas partes, es decir, permea todo el universo invadiendo todas sus regiones a medida que este se expande más y más. Y fue esa “invisible” sustancia cósmica, la que realmente hizo posible que las galaxias se pudieran formar a pesar de la expansión de Hubble.

El hecho de que la materia ordinaria caiga entonces en el agujero gravitatorio creado de este modo sirve para explicar por qué encontramos galaxias rodeadas por un halo de algo que hemos dado en llamar “materia oscura”. Tal hipótesis mata dos pájaros de un sólo tiro.

Pero debemos recordar que en este punto sólo tenemos una idea que puede funcionar, no una teoría bien construida. Para pasar de la idea a la teoría, tenemos que responder dos preguntas importantes y difíciles:

1. ¿Cómo explicamos la estructura de la “materia oscura”?

2. ¿Qué es la “materia oscura”?

Se habla de materia oscura caliente y fría. También, algunas veces me veo sorprendido por las ocurrencias que tienen algunos científicos de hoy que, como los antiguos, imaginan respuestas para acomodar las cuestiones que realmente desconocen y, buscan así, una salida airosa sin que se note la inmensa ignorancia que llevan consigo.

Podríamos comenzar a examinar estas cuestiones pensando en el modo en que la “materia oscura” pudo separarse de la nube caliente en expansión, de materiales que constituía el universo en sus comienzos. Por analogía de la discusión del desemparejamiento (acción de separar o desigualar algo que estaba unido), de la materia ordinaria después de la formación de los átomos, llamaremos también desemparejamiento a la separación de la “materia oscura” de aquella fuente “infinita” de energía primera. Una transformación como la que condujo a la formación de los átomos es necesaria para que ocurra el desemparejamiento. Todo lo que tiene que suceder es que la fuerza de la interacción de las partículas que forman la “materia oscura” caigan por debajo del punto en que el resto del universo puede ejercer una presión razonable sobre él. Después de esto, la “materia oscura” continuará a su aire, indiferente a todo lo que la rodee.

Resulta que desde el punto de vista de la creación de la estructura observada del universo, la característica más importante del proceso de desemparejamiento para la “materia oscura” es la velocidad de las partículas cuando son libres. Si el desemparejamiento tiene lugar muy pronto en el Big Bang, la “materia oscura” puede salir con sus partículas moviéndose muy rápidamente, casi a la velocidad de la luz. Si es así, decimos que la “materia oscura” está caliente. Si el desemparejamiento tiene lugar cuando las partículas están moviéndose poco a poco -velocidad significativamente menor que la de la luz- decimos que la materia está fría.

De los tipos de “materia oscura” que los cosmólogos toman en consideración, los neutrinos serán el mejor ejemplo de “materia oscura” caliente. Los neutrinos han llamado la atención de los científicos en relación a la “materia oscura” durante mucho tiempo. Para tener una idea aproximada del número de neutrinosdel universo, podríamos decir que existe actualmente un neutrino por cada reacción nuclear que tuvo lugar desde siempre. Los cálculos indican que hubo aproximadamente mil millones de neutrinosproducidos durante el Big Bang por cada protón, neutrón o electrón. Cada volumen del espacio del tamaño de nuestro cuerpo contiene unos diez millones de estos neutrinos-reliquias y en ellos no se encuentran los que se produjeron más tarde en las estrellas. Está claro que toda partícula tan corriente como ésta podría tener en principio un efecto muy grande sobre la estructura del Cosmos, si tuviera una masa.

La materia oscura caliente se mueve a la velocidad de la luz, la fría es mucho más lenta (¿)

Pero resulta que la “materia oscura” caliente, actuando sola, casi con toda seguridad no podría explicar lo que observamos en el universo y que el escenario de “materia oscura-fria” debe modificarse por completo si queremos mantenerla como candidata a esa teoría última de la materia que “debe” existir en el universo pero, que no sabemos lo que es y la llamamos, precisamente por eso “materia oscura”.

El tema de la materia desconocida, invisible, oculta y misteriosa que hace que nuestro universo se comporte como la hace… ¿sigue siendo una gran incógnita! Nadie sabe el por qué las galaxias se alejan las unas de las otras, el motivo de que las estrellas en la periferia de las galaxias se muevan a mayor velocidad de lo que deberían y otros extraños sucesos que, al desconocer los motivos, son achacados a la “materia oscura”, una forma de evadirse y cerrar los ojos ante la inmensa ignorancia que tenemos que soportar en relación a muchos secretos del Universo a los que no podemos dar explicación.

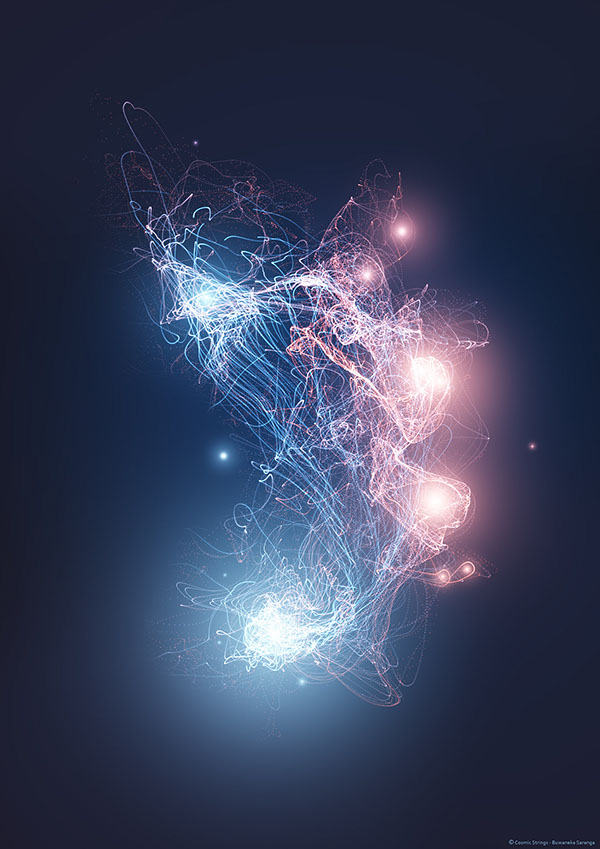

Sí, las cuerdas son unas buenas candidatas para la “materia oscura”. Otros postularon los Agujeros Negros

Claro que otros, han imaginado cuestiones y motivos diferente para explicar las cosas

Aunque no todas si son muchas las GUT y teorías de supersimetría las que predicen la de cuerdas en la congelación del segundo 10-35 después del comienzo del tiempo, cuando la fuerza fuerte se congeló y el Universo se infló. Las cuerdas se deben considerar un subproducto del proceso mismo de congelación. Es cierto que aunque las diversas teorías no predicen cuerdas idénticas, sí predicen cuerdas con las mismas propiedades generales.

Predicen muchas cosas que no han podido ser verificadas. Para llegar a hasta las cuerdas, según resultado de cálculos muy exactos, se necesita la Energía de Planck, es decir 1019 GeV. Esta energía no existe en nuestro mundo.

En primer lugar las cuerdas son extremadamente masivas y también extremadamente delgadas; la anchura de una cuerda es mucho menor que la anchura de un protón. Las cuerdas no llevan carga eléctrica, así que no interaccionan con la radiación como las partículas ordinarias. Aparecen en todas las formas; largas líneas ondulantes, lazos vibrantes, espirales tridimensionales, etc. Sí, con esas propiedades podrían ser un candidato perfecto para la “materia oscura”. Ejercen una atracción gravitatoria y no pueden ser rotas por la presión de la radiación en los inicios del Universo.

El espesor estimado de una cuerda es de 10-30 centímetros, comparados con los 10-13 de un protón. Además de ser la más larga, y posiblemente la más vieja estructura del universo conocido, una cuerda cósmica sería la más delgada: su diámetro sería 100.000.000.000.000.000 veces más pequeño que el de un protón.. Y la cuerda sería terriblemente inquieta, algo así como un látigo agitándose por el espacio casi a la velocidad de la luz. Las curvas vibrarían como enloquecidas bandas de goma, emitiendo una corriente continua de ondas gravitacionales: rizos en la misma tela del espacio-tiempo. ¿Qué pasaría si una cuerda cósmica tropezara con un planeta? Al ser tan delgada, podría traspasarlo sin tropezar con un solo núcleo atómico. Pero de todos modos, su intenso campo gravitatorio causaría el caos.

Como nunca las hemos visto, la escenificamos de muchas maneras

Lo cierto es que todavía no se ha encontrado ninguna cuerda de este tipo. Si bien en los últimos años han surgido muchas candidatas a estar formadas por un efecto de lente de este tipo, la mayoría han resultado ser dos cuerpos distintos pero muy similares entre sí. Pese a ello, los astrofísicos y los teóricos de cuerdas no pierden la esperanza de encontrar en los próximos años, y gracias a telescopios cada vez más potentes, como el GTC y aceleradores como el LHC las evidencias directas de la existencia de este tipo de cuerdas; evidencias que no sólo nos indicarían que las teorías de cuerdas van por buen camino, sino que el modelo del Big Bang es un modelo acertado.

Simulación del efecto de lente generado por una cuerda cósmica. Crédito: PhysicsWorld.com

Por tanto, cuando observásemos un objeto con una cuerda cósmica en la trayectoria de nuestra mirada, deberíamos ver este objeto dos veces, con una separación entre ambas del orden del defecto de ángulo del cono generado por la curvatura del espacio-tiempo. Esta doble imagen sería característica de la presencia de una cuerda cósmica, pues otros cuerpos, como estrellas o agujeros negros, curvan el espacio-tiempo de manera distinta. Por tanto, una observación de este fenómeno no podría dar lugar a un falso positivo.

En este sentido, el nombre de cuerda cósmica está justificado debido a que son impresionantemente pesadas, pasando a ser objetos macroscópicos aun cuando su efecto es pequeño. Una cuerda de seis kilómetros de longitud cuya separación entre ambas geodésicas es de apenas 4 segundos de arco tendría ¡la masa de la Tierra!. Evidentemente, cuerdas de este calibre no se espera que existan en la naturaleza, por lo que los defectos de ángulo esperados son aún menores y, por tanto, muy difíciles de medir.

Efecto Lente

Una de las virtudes de la teoría es que puede detectarse por la observación. Aunque las cuerdas en sí son invisibles, sus efectos no tienen por qué serlo. La idea de las supercuerdas nació de la física de partículas, más que en el de la cosmología (a pesar de que, la cuerdas cósmicas, no tienen nada que ver con la teoría de las “supercuerdas”, que mantiene que las partículas elementales tienen forma de cuerda). Surgió en la década de los sesenta cuando los físicos comenzaron a entrelazar las tres fuerzas no gravitacionales – electromagnetismo y fuerzas nucleares fuertes y débiles – en una teoría unificada.

En 1976, el concepto de las cuerdas se había hecho un poco más tangible, gracias a Tom Kibble. Kibble estudiaba las consecuencias cosmológicas de las grande teorías unificadas. Estaba particularmente interesado en las del 10^-35 segundo después del Big Bang.

Podrían estar por todas partes

Aunque no todas si son muchas las Grandes Teorías Unificadas y teorías de supersimetría las que predicen la formación de cuerdas en la congelación del segundo 10-35 después del comienzo del tiempo, cuando la fuerza fuerte se congeló y el universo se infló. Las cuerdas se deben considerar un subproducto del proceso mismo de congelación. Es cierto que aunque las diversas teorías no predicen cuerdas idénticas, sí predicen cuerdas con las mismas propiedades generales. En primer lugar las cuerdas son extremadamente masivas y también extremadamente delgadas; la anchura de una cuerda es mucho menor que la anchura de un protón. Las cuerdas no llevan carga eléctrica, así que no interaccionan con la radiación como las partículas ordinarias. Aparecen en todas las formas; largas lineas ondulantes, lazos vibrantes, espirales tridimensionales, etc. Sí, con esas propiedades podrían un candidato perfecto la “materia oscura”. Ejercen una atracción gravitatoria, no pueden ser rotas por la presión de la radiación en los inicios del Universo.

¡Es tanto lo que no sabemos! Por eso lo único que hacemos es conjeturar lo que podría ser

Como habéis podido comprender, todas estas teorías están por demostrar y sólo son conjeturas derivadas de profundos pensamientos de lo que puso ser y de lo que podría ser. Nada relacionado con la materia oscura, las supercuerdas o las cuerdas cósmicas ha sido demostrado ni se han observado por medio alguno en nuestro Universo. Sin embargo, no descartar nada y hacer lo posible por demostrarlas, es la obligación de los científicos que tratan de buscar una explicación irrefutable de cómo es el Universo y por qué es así.

El misterioso “universo” de los campos cuánticos que nadie sabe lo que esconde

A los cosmólogos les gusta visualizar esta revolucionaria transición como una especie de “cristalización”: el espacio, en un principio saturado de energía, cambió a la más vacía y más fría que rodea actualmente nuestro planeta. Pero la cristalización fue, probablemente, imperfecta. En el cosmos recién nacido podría haberse estropeado con defectos y grietas, a medida que se enfriaba rápidamente y se hinchaba. En fin, muchas elucubraciones y conjeturas que surgen siempre que no sabemos explicar esa verdad que la Naturaleza esconde y, mientras tanto nosotros, simples mortales de la especie Homo, seguimos dejando volar nuestra imaginación que trata, cargada siempre de curiosidad, de desvelar esos misterios insondables del Universo.

Bueno, al menos yo reconozco mi inmensa ignorancia, ya me gustaría saber… ¡De tantas cosas!

Finalmente sabremos sobre esa sustancia cósmica que impregna todo el universo pero, no será la “materia oscura” de la que todos hablan, será otra cosa muy diferente e inimaginable en estos momentos en los que, nuestra ignorancia, echa mano de cualquier cosa para poder ocultarla… ¡materia oscura! ¿Qué es eso? Posiblemente (como decía aquel gran físico premio Nobel), la “materia oscura” será la alfombra bajo la cual, los cosmólogos, barren su ignorancia.

Emilio Silvera Vázquez

Jun

19

Y… ¡Seguiremos imaginando! Cómo es, el Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo de Ayar y el Universo de Hoy ~

Clasificado en El Universo de Ayar y el Universo de Hoy ~

Comments (1)

Comments (1)

Desde Ptolomeo con su modelo del universo de esferas cristalinas, hasta el más reciente modelo de los universos burbujas. Desde los modelos geocéntrico, estacionario, infinito, inflacionario… Siempre hemos tenido modelos de universos que nuestras mentes han creado según nos han ido dictando los siempre escasos conocimientos que del universo hemos tenido y, a medida que estos conocimientos fueron avanzando, el modelo se hizo mejor pero…, no definitivo.

Precisamente por eso me choca ver y escuchar como pretendidos “expertos” en la materia, dicen que ellos conocen lo que es el Universo, o, lo que pasó en los primeros tres minutos a partir del supuesto Big Bang. Hablan con desparpajo y “seguridad” de todo ello a la audiencia que, no siempre en posesión del conocimiento requerido para ello, es receptora de las palabras que pretenden ser esa verdad que, en realidad, nadie ha tenido nunca. Lo cierto es que, se están refiriendo a que tienen un modelo del Universo temprano, y que este modelo encaja con los resultados que hasta el momento han obtenido mediante observaciones y diversas comprobaciones.

Tycho Brahe

Está claro que el modelo de universo de los sumerios, babilonios y otros pueblos antiguos, era muy diferente al que ya nos dibujó Copérnico, Tycho Brahe o el mismo Einstein. Los modelos han ido evolucionando y, de la misma manera, el modelo que hoy tenemos y que denominamos Big Bang, será mejorado a medida que nuevos descubrimientos y nuevos conocimientos incrementen nuestro saber del mundo y, para ello, creamos esos modelos que nos ayudan para poder alcanzar ese saber que incansables perseguimos.

Los Modelos empíricos: Se sustentan en la identificación de relaciones estadísticamente significativas entre ciertas variables que se asumen como esenciales y suficientes para modelar el comportamiento del sistema. Con tal motivo, debe disponerse previamente de una base de datos de tamaño adecuado. Pueden subdividirse en tres categorías diferentes:

De Caja Negra: Sólo se analizan los datos de entrada y de salida del modelo.

De Caja Gris: Se explican algunos detalles del conocimiento existente sobre el comportamiento del sistema.

De Caja Blanca: Se conocen y explican todos los detalles del comportamiento del Sistema.

ESTOCÁSTICOS: Consisten en la generación de series de datos sintéticas a partir de las propiedades estadísticas de las poblaciones de datos existentes. Son muy útiles con objeto de generar secuencias de datos que alimenten a modelos empíricos o a los basados sobre leyes físicas, cuando tan sólo se dispone de información recogida durante periodos de observación breves.

DE SOPORTE FÍSICO: Elaborados con ecuaciones matemáticas al objeto de describir los procesos involucrados en el modelo, teniendo en cuenta las leyes de conservación de masas y energía, etc.

DIGITALES: Modelos estocásticos, de soporte físico, etc. Basados en el uso de ordenadores digitales capaces de procesar una gran cantidad de datos que desembocan en la recreación de Sistema que tratamos de descubrir.

Hoy podemos crear modelos para todo

No siempre los modelos científicos son una fiel imagen de la realidad. Los átomos y las moléculas que componen el aire que respiramos, por ejemplo, se pueden describir en términos de un modelo en el que imaginamos cada partícula como si fuera una pequeña esfera perfectamente elástica, con todas las pequeñas esferas rebotando unas contra otras y contra las paredes del recipiente que las contiene.

Esa es la imagen mental, pero es sólo la mitad del modelo; lo que lo hace modelo científico es describir el modo como se mueven las esferas y rebotan unas contra otras mediante un grupo de leyes físicas, escritas en términos de ecuaciones matemáticas. En este caso, éstas son esencialmente las leyes del movimiento descubiertas por Newton hace más de trescientos años. Utilizando estas leyes matemáticas es posible predecir, por ejemplo, que le pasará a la presión ejercida por un gas si se aplasta hasta la mitad de su volumen inicial. Si hacemos el experimento, y, el resultado que se obtiene encaja con la predicción del modelo, este será un buen modelo.

En la década de 1930, los físicos teóricos, en particular, Einstein, consideró la posibilidad de un modelo cíclico para el universo como una alternativa a la del Big Bang. Sin embargo, el trabajo de Richard Tolman reveló que estos primeros intentos fracasaron debido al problema que la entropía encumbra, que según la mecánica estadística, ésta aumenta debido a la segunda ley de la termodinámica. Esto implica que en sucesivos ciclos el universo crece más y más en cada ciclo. Y extrapolando hacia atrás en el tiempo, los ciclos antes de convertirse en el presente ciclo eran menores y más cortos, y en un punto hubo un ciclo iniciado por un Big Bang, no pudiendo eliminarlo de la teoría cíclica. Esta situación siguió siendo desconcertante para muchos, hasta las primeras décadas del siglo 21 cuando la recién descubierta energía oscura sembró una nueva esperanza para la cosmología cíclica.

Un nuevo modelo cíclico es el modelo basado en la cosmología de branas sobre la formación del universo, derivado del anterior modelo ecpirótico. Se propuso en 2001 por Paul Steinhardt de la Universidad de Princeton y Neil Turok de la Universidad de Cambridge. La teoría describe un universo emergiendo hacia la existencia no sólo una vez, sino en repetidas ocasiones a través del tiempo. La teoría podría explicar por qué una misteriosa forma repulsiva de energía conocida como la “constante cosmológica” está acelerando la expansión del universo, que es de varios órdenes de magnitud menor que la predicha por el modelo estándar del Big Bang.

El modelo Steinhardt–Turok

En este modelo cíclico basado en la cosmología de branas, rival del modelo inflacionario, dos láminas tridimensionales o 3-branas colisionan periódicamente. Según esta teoría la parte visible del universo de cuatro dimensiones representa una de esas branas, quedando la otra brana oculta a todas las fuerzas de la naturaleza excepto la gravedad. Cada ciclo consiste en que cada una de las branas dentro de un espacio-tiempo tetradimensional y separadas por una dimensión espacial muy corta y seis enrolladas chocan con cierta periodicidad creando condiciones parecidas a las del big bang del modelo inflacionario.

Según la teoría, después de millones de años, al aproximarse el final de cada ciclo la materia y la radiación se diluyen a casi cero debido a una expansión acelerada del universo alisando las dos branas pero con pequeños rizos o fluctuaciones cuánticas aún presentes que imprimirán en el próximo choque con no uniformidades que crearán grumos o cúmulos que generarán estrellas y galaxias.

Otro modelo: El Big Bounce ( gran rebote) es un modelo científico teórico relacionado con la formación del Universo conocido. Se deriva del modelo cíclico o Universo oscilante e interpreta el Big Bang como el primer evento cosmológico resultado del colapso de un universo anterior.

Según algunos teóricos de Universo oscilante, el Big Bang fue simplemente el comienzo de un período de expansión que siguió a un período de contracción. Desde este punto de vista, se podría hablar de un Big Crunch seguido por un Big Bang, o, más sencillamente, un Big Bounce. Esto sugiere que podría se estar viviendo en el primero de todos los universos, pero se tiene la misma probabilidad de estar viviendo en el universo 2 mil millones (o cualquier otro de una secuencia infinita de otros universos).

La idea principal detrás de la teoría cuántica del “gran rebote” es que, a medida que se acerca la densidad a lo infinito, el comportamiento de la espuma cuántica cambia. Todas las llamadas constantes físicas fundamentales, incluida la velocidad de la luz en el vacío, no eran tan constantes durante el Big Crunch, especialmente en el intervalo de estiramiento 10-43 segundos antes y después del punto de inflexión. (Una unidad de Tiempo de Planck es de aproximadamente 10-43 segundos.)

Si las constantes físicas fundamentales se determinaron en un quantum de forma mecánica durante el Big Crunch, entonces sus valores aparentemente inexplicables en este universo no serían tan sorprendentes, entendiendo que aquí un universo es lo que existe entre un Big Bang y su Big Crunch. Como podeis comprobar, por falta de modelos no podemos quejarnos. Sin embargo, todo esto nos lleva a plantear una pregunta: ¿Será alguno de estos modelos el que refleje la realidad?

La respuesta a la pregunta anterior es ¡NO! De hecho, todos los modelos científicos tienen aplicabilidad limitada. Ninguno de ellos es “la verdad”. Cuando un científico afirma, por ejemplo, que el núcleo de un átomo está compuesto por partículas denominadas protones y neutrones, lo que en realidad debería decir es que el núcleo de un átomo se comporta, bajo determinadas circunstancias, como si estuviera formado de protones y neutrones. Los mejores científicos toman el “como sí “, pero entienden que sus modelos son, efectivamente, sólo modelos; científicos menores a menudo olvidan esta diferencia crucial.

Los científicos menores, y muchos no-científicos, tienen otra idea equivocada. A menudo piensan que el papel de los científicos hoy en día es llevar a cabo experimentos que probarán la exactitud de sus modelos con una precisión cada vez mayor (hacia posiciones con más y más decimales). ¡En absoluto! La razón para llevar a cabo experimentos que demuestren predicciones previas no comprobadas es descubrir dónde fallan los modelos. Encontrar defectos en sus modelos es la esperanza abrigada por los mejores científicos, porque esos defectos destacarán los lugares donde necesitamos una nueva comprensión, con modelos mejores, para progresar.

El arquetípico ejemplo de esto es la gravedad. La ley de la gravedad de Isaac Newton se consideró la pieza clave de la física durante más de doscientos años, desde la década de 1680 hasta comienzos del siglo XX. Pero había unas pocas, aparentemente insignificantes, cosas que el modelo newtoniano no podía explicar o predecir, referente a la órbita del planeta mercurio y al modo como la luz se curva cuando pasa cerca del Sol. El modelo de gravedad de Albert Einstein, basado en su teoría general explica lo mismo que el modelo de Newton pero también explica esos detalles sutiles de órbitas planetarias y curvatura de la luz. En ese sentido, es un modelo mejor que el anterior, y hace predicciones correctas (en particular, sobre el Universo en general) que el viejo modelo no hace. Pero el modelo de Newton todavía es todo lo que se necesita si se está calculando el vuelo de una sonda espacial desde la Tierra a la Luna.

¿SABEMOS COMO COMENZÓ EL UNIVERSO?

Está ahora ampliamente aceptado -de manera provisional- que el Universo donde habitamos surgió a partir de una singularidad con densidad y energía “infinitas” que dio lugar a una bola de fuego caliente y densa a la que llamamos Big Bang. En los años veinte y treinta, los astrónomos descubrieron por primera vez que nuestra Galaxia es simplemente una isla de estrellas dispersa entre muchas galaxias similares, y que grupos de estas galaxias se están apartando las unas de las otras a medida que el espacio se expande. Esta idea del Universo en expansión fue realmente predicha por la teoría general de la relatividad de Einstein, terminada en 1916 pero no se tomó en serio hasta que los observadores hicieron sus descubrimientos. Cuando se tomó en serio los matemáticos descubrieron que las ecuaciones describían exactamente el tipo de expansión que observamos, con la implicación de que si las galaxias se van alejando con el tiempo entonces deberían haber estado más juntas en el pasado, y hace mucho tiempo toda la materia en el Universo debería estar acumulada en una densa bola de fuego.

Es la combinación de la teoría y de la observación la que hace que la idea del Big Bang sea tan convincente; en los años sesenta llegó una clara evidencia, con el descubrimiento de un siseo débil de ruído de radio, la radiación cósmica de fondo, que viene de todas las direcciones del espacio y se interpreta como la radiación restante del mismo Big-Bang.

El descubrimiento de la radiación cósmica de fondo (RCF) por Penzias y Wilson en 1965 fue definitivo para “probar” el origen caliente del universo. Sin embargo, después de estas mediciones aun permanecían algunas dudas por resolver. Si la radiación detectada por Penzias y Wilson proviene realmente del universo recién formado hace 14 mil millones de años, ésta debe mostrar ciertas características. Para poder afirmar con certeza que el origen de la RCF es cósmico se deben verificar las siguientes observaciones:

Como la expansión del Universo, la existencia de esta radiación de fondo fue predicha por la teoría antes de ser observada experimentalmente. A finales del siglo XX, la combinación de teoría y observaciones había establecido que el tiempo que ha pasado desde el Big Bang es de unos 14 mil millones de años, y que existen cientos de miles de millones de galaxias como la nuestra dispersas de un extremo al otro del Universo en expansión.

La pregunta a la que se están enfrentando ahora los cosmólogos es ¿cómo empezó el mismo Big Bang?

El punto de partida para enfrentarnos a esta pregunta es el modelo estándar propio de los cosmólogos, que combina todo lo que han aprendido de las observaciones del universo en expansión con el entendimiento teórico del espacio y el tiempo incorporado a la teoría general de Einstein. El establecimiento de este modelo se ha visto favorecido por el hecho de que cuanto más lejos miramos del Universo, más tiempo atrás vemos. Debido a que la luz viaja a una velocidad finita, cuando miramos galaxias alejadas millones de años luz, la vemos como si estuvieran presentes como eran millones de años antes, cuando salió la luz que llega ahora a nuestros telescopios.

Con telescopios potentes, los astrónomos pueden ver qué aspecto tenía el Universo cuando era más joven (y la radiación cósmica de fondo nos permite “ver”-con radiotelescopios- la última etapa de la bola de fuego que fue el Big bang).

Lo más atrás que hemos visto, el origen de la radiación de fondo corresponde a un tiempo unos pocos cientos de miles de años después del momento del Big Bang, cuando todo el Universo estaba lleno de gas caliente (conocido técnicamente como plasma) a aproximadamente la misma temperatura que la que tiene la superficie del Sol hoy en día, unos pocos miles de grados Celsius. En ese momento, lo que ahora es el Universo visible entero era solo una milésima parte de su tamaño actual y no había objetos individuales en la escala de las estrellas o galaxias en el remolino de material caliente.

Moviéndonos hacia delante en el tiempo, las irregularidades observadas en la radiación de fondo son justamente del tamaño y estructura correctos que podrían explicar el origen de las galaxias y de los grupos de galaxias, pudieran ser las semillas a partir de las cuáles creció la estructura que vemos en el Universo hoy.

Yendo hacia atrás en el tiempo, la estructura de las pequeñas irregularidades vistas en la radiación de fondo nos habla sobre el tipo de irregularidades que había en el Universo cuando era incluso más joven, justo hasta ese momento atrás en que la teoría general por sí misma se rompe y, no nos deja pasar más allá del Tiempo de Planck.

Lo primero, y más importante, que hay que decir sobre estas irregularidades en la radiación de fondo es que son diminutas. Son tan pequeñas que al principio era imposible medirlas, y la radiación parecía que viniera perfectamente uniforme desde todas las direcciones en el espacio (isotropía). Si la radiación fuera perfectamente uniforme, todo el modelo estándar del Universo se desbarataría, ya que si no hubiera habido irregularidades en la bola de fuego del Big Bang no habría habido semillas desde donde las galaxias pudieran crecer, y nosotros al no haberse formado las estrellas y fabricado en sus núcleos los materiales complejos de los que estamos hechos, no estaríamos aquí. El hecho de que los científicos estén tratando de resolver estas preguntas han convencido a los astrónomos de que debería haber irregularidades en la radiación de fondo, sólo había que desarrollar instrumentos sensibles para medirlas.

En este sentido podríamos citar el satélite de la NASA COBE que fue capaz de hacer medidas suficientemente sensibles para demostrar que había efectivamente minúsculas ondulaciones en la radiación de fondo. Las dos preguntas clave derivadas del descubrimiento son: ¿por qué la radiación de fondo es casi lisa?, ¿Qué crea las ondulaciones?

La primera pregunta es más profunda de lo que se pueda pensar, porque incluso hoy, 14 mil millones de años después, el Universo es todavía casi liso. Esto no es obvio si contrastamos la luminosidad de una galaxia como nuestra Vía Láctea con la oscuridad del espacio entre las galaxias pero enseguida se hace evidente a mayores escalas. El Universo no es exactamente uniforme, pero incluso en términos de distribución de las galaxias es uniforme en cierto sentido. Si tomamos una fotografía de las galaxias vistas en una pequeña zona del cielo se parecerá mucho a otra fotografía de una zona del mismo tamaño de otra parte del cielo. La radiación de fondo es incluso más uniforme, y parece exactamente la misma desde todos los puntos del espacio dentro de una fracción del 1 por ciento. La profundidad de esta observación descansa en el hecho de que no ha pasado el tiempo suficiente desde el Big Bang para que todas las diferentes partes del Universo interactúen unas con otras y deje de ser liso.

Esta homogeneidad está relacionada con otra característica extraña del Universo denominada subplanitud. La teoría general de la relatividad nos dice que el espacio (en sentido estricto, el espacio-tiempo) se puede curvar y deformar por la presencia de materia. Localmente, cerca de un objeto como el Sol o la Tierra, esta deformación del espacio-tiempo produce el efecto que llamamos gravedad. Cósmicamente, en el espacio entre las estrellas y las galaxias el efecto combinado de toda la materia en el universo puede producir una curva gradual en el espacio en uno de los dos sentidos.

Aquí tendríamos que continuar hablando de la densidad crítica y de la clase de universo que tendríamos en función de la cantidad de materia que este contenga. Sin embargo, dejaremos ese punto del universo cerrado, abierto o plano, ya que, en uno de los comentarios muy recientes de esta colaboración ya quedaron explicados de manera suficiente.

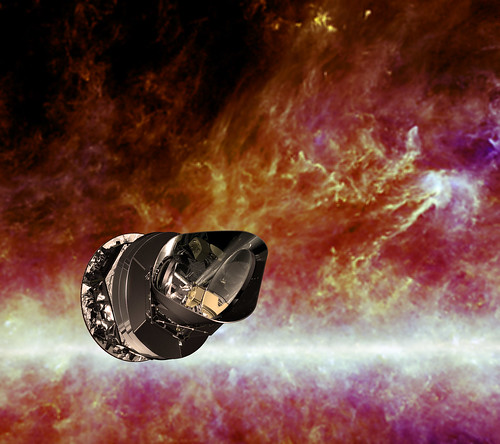

Sonda Planck – Crédito ESA

El explorador Planck fue una misión propuesta por la ESA que se puso en órbita en el año 2007 y operando en las bandas infrarroja y submilimétrica, tomó imágenes de las anisotropías de la radiación cósmica de fondo en todo el cielo con resolución y sensibilidad excepcionales.

Estudios cada vez más sofisticados de la radiación de fondo, que culminaron con las observaciones hechas por el satélite WAP de la NASA a principios de éste siglo XXI y del Planck Explorer de ESA un poco más tarde, mostraron que el Universo efectivamente está indistinguiblemente cerca de la plenitud, de modo que su densidad debería estar indistinguiblemente cerca de la Densidad crítica. Esto dio lugar al rompecabezas de donde estaba la masa “desaparecida” (esa que llamamos materia oscura que, nunca se ha visto, ni produce radiación, ni sabemos como se pudo formar, de qué clase de partículas está conformada -si es que son partículas- y, un sin fin de interrogantes más que, de momento, no sabemos contestar).

En realidad, la teoría de la inflación es todavía un trabajo en progreso, y, como en el caso de la GUT, existen diferentes variaciones o modelos sobre el tema. Lo que está claro de todo esto es que, no se puede negar, ni el esfuerzo realizado, ni el éxito alcanzado que, sin ser aún lo que se desea, sí es un paso importante en el conocimiento del Cosmos. Ahora sabemos de él muchísimo más que se sabía en los tiempos de Galileo, y, tanto la técnica, como las matemáticas y la física, han desarrollado la Astronomía y la Astrofísica, hasta unos niveles encomiables, teniendo en cuenta que estamos estudiando una cosa muy, muy grande y cuyos objetos están muy, muy lejos.

Estas galaxias están a más de 13.000 Millones de años-luz de nosotros

Sin embargo, podemos obtener imágenes de galaxias lejanas y de nebulosas que se encuentran a miles y miles de millones de años-luz de la Tierra y, mediante técnicas del estudio del espectro, saber, de que materiales están formados esos objetos cosmológicos que pueblan nuestro universo en regiones tan remotas que nuestras mentes, no pueden asimilar.

Es aún muy grande el espacio oscuro que tenemos que alumbrar para conocer en plenitud nuestro vasto Universo, son muchas las zonas que están en la penumbra, y, debemos y tenemos la obligación de continuar profundizando en el saber del Universo que nos acoge.

Yo, que me considero un simple aficionado -eso sí-, muy enamorado del Universo y apasionado de todas las maravillas que encierra y que producen en mi esa fascinación que me inunda de asombro y, también, de maravilla. A veces pienso que todo el vasto Universo podría haber surgido de una fluctuación cuántica del “vacío”, ese lugar misterioso que resulta estar lleno a rebosar y que, gracias a la combinación de inflación y a una curiosa propiedad de la gravedad, dio lugar a la creación de un nuevo universo de los muchos que podrían ser.

Esta curiosa propiedad de la gravedad es que guarda energía negativa. Cuando algo (¡cualquier cosa!) cae hacia debajo de un campo gravitacional (como el agua que se precipita desde la montaña) la energía es liberada………Pero eso, será otra historia que ya contaremos. Ahora, para no cerrar en falso el comentario, diré que, no existe ningún límite, en principio, en cuanta masa (en sentido estricto masa-energía, teniendo en mente E=mc2) puede tener una fluctuación cuántica, aunque cuanto más masiva sea una fluctuación, menos probable es que suceda.

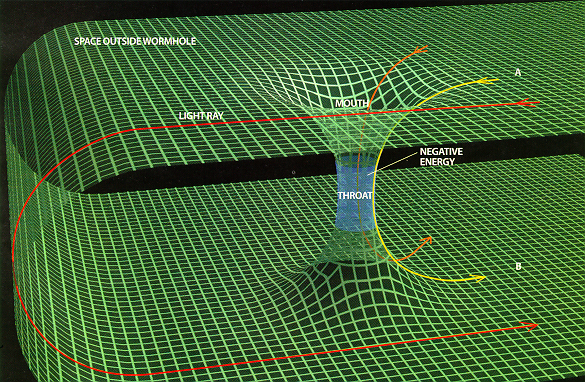

Las ondas de luz normalmente tienen una densidad de energía positiva o cero en diferentes puntos del espacio (arriba). Pero en un estado comprimido, la densidad de la energía, en un instante determinado en el tiempo, puede llegar a ser negativa en algunos lugares (abajo). Para compensar esto, el pico de densidad positiva debe aumentar.

¡Son tántas, las cosas que no sabemos!

El cosmólogo americano Ed Tyron señaló que en principio una fluctuación cuántica que contiene la masa-energía de todo el Universo visible podría salir de la “nada”, y que aunque la masa-energía de tal fluctuación sería enorme, en las circunstancias correctas la energía gravitacional negativa del campo gravitacional asociado a toda esta masa equilibraría perfectamente esto, de modo que la energía total de la fluctuación sería cero.

La implicación, naturalmente, es que nuestro Universo nació (o brotó) de este modo desde el espacio-tiempo de otro universo, y que no hubo principio y no habrá final. Sólo un mar infinito de universos burbujas interconectados como han propuestos algunos.

emilio silvera

Totales: 86.099.095

Totales: 86.099.095 Conectados: 72

Conectados: 72