Nov

16

Partículas, antipartículas, fuerzas…

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

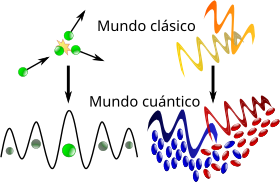

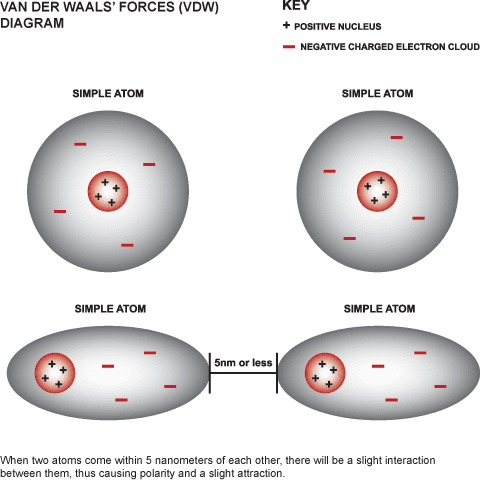

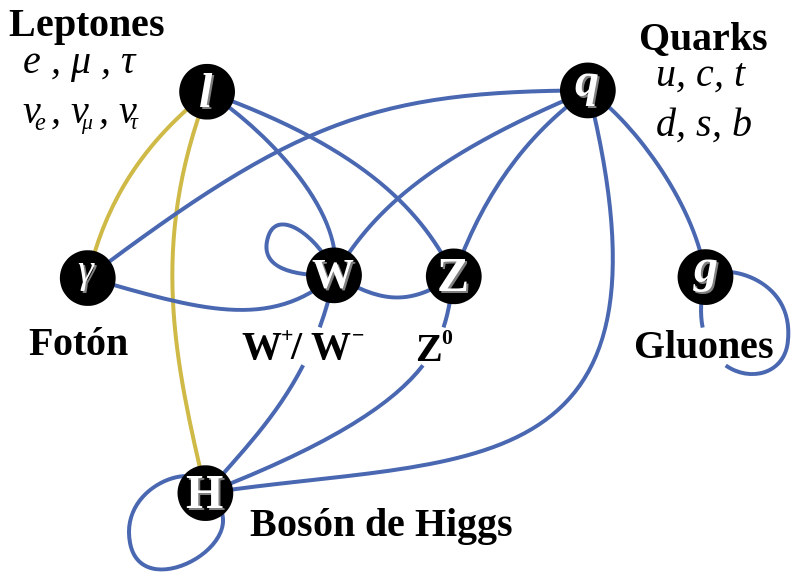

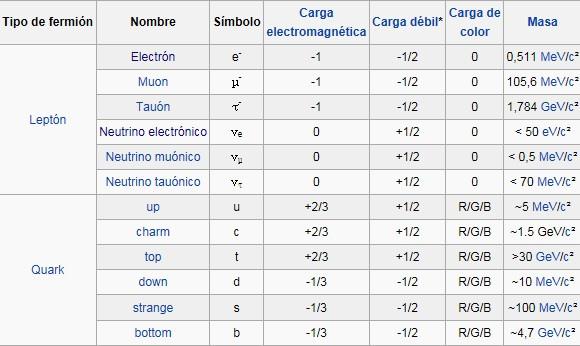

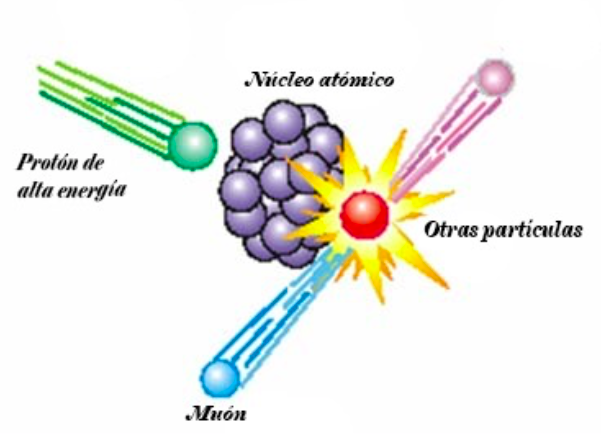

Bajo la “definición basada en quarks y leptones”, las partículas elementales y compuestas formadas de quarks (en púrpura) y leptones (en verde) serían la “materia”; mientras los bosones “izquierda” (en rojo) no serían materia. Sin embargo, la energía de interacción inherente a partículas compuestas (por ejemplo, gluones, que implica a los neutrones y los protones) contribuye a la masa de la materia ordinaria.

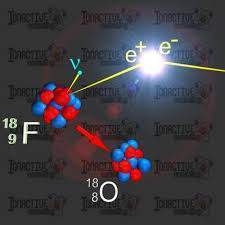

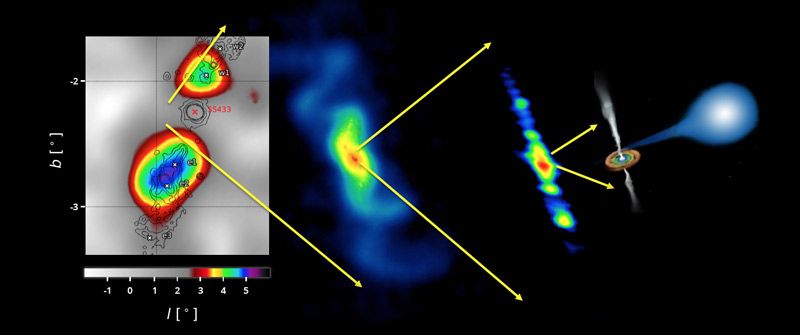

Esquema de una aniquilación electrón-positrón.

Ya hemos descrito en trabajos anteriores las dos familias de partículas elementales: Quarks y Leptones. Pero hasta ahí, no se limita la sociedad del “universo” infinitesimal. Existen además las antifamilias. A quarks y electrones se asocian, por ejemplo, antiquarks y antielectrones. A cada partícula, una antipartícula.

Uno de los primeros éxitos de la teoría relativista del campo cuántico fue la predicción de las antipartículas: nuevos cuantos que eran la imagen especular de las partículas ordinarias. Las antipartículas tienen la misma masa y el mismo spin que sus compañeras las partículas ordinarias, pero cargas inversas. La antipartícula del electrón es el positrón, y tiene, por tanto, carga eléctrica opuesta a la del electrón. Si electrones y positrones se colocan juntos, se aniquilan, liberando la energía de sus masas según la equivalencia masa-energía einsteniana.

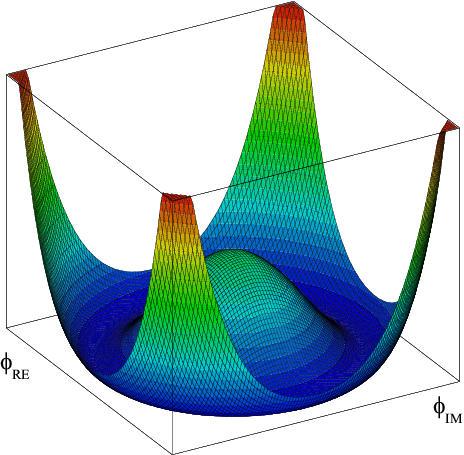

¿Cómo predijeron los físicos la existencia de anti-partículas? Bueno, por la «interpretación estadística» implicaba que la intensidad de un campo determinaba la probabilidad de hallar sus partículas correspondientes. Así pues, podemos imaginar un campo en un punto del espacio describiendo la creación o aniquilación de sus partículas cuánticas con una probabilidad concreta. Si esta descripción matemática de la creación y aniquilación de partículas cuánticas se inserta en el marco de la teoría relativista del campo cuántico, no podemos contar con la posibilidad de crear una partícula cuántica sin tener también la de crear un nuevo género de partícula: su anti-partícula. La existencia de antimateria es imprescindible para una descripción matemáticamente coherente del proceso de creación y aniquilación según la teoría de la relatividad y la teoría cuántica.

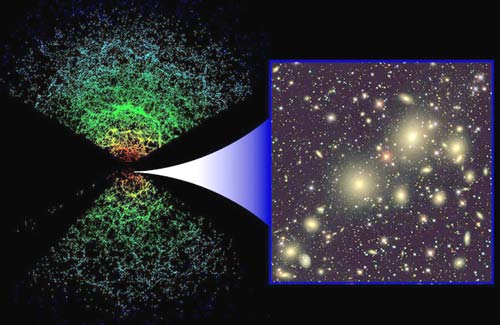

La misteriosa sustancia conocida como “materia oscura” puede ser en realidad una ilusión, creada por la interacción gravitacional entre partículas de corta vida de materia y antimateria. Un mar hirviente de partículas en el espacio puede crear la gravedad repulsiva.

Puede ser posible que las cargas gravitacionales en el vacío cuántico podrían proporcionar una alternativa a la “materia oscura”. La idea se basa en la hipótesis de que las partículas y antipartículas tienen cargas gravitacionales de signo opuesto. Como consecuencia, los pares de partícula-antipartícula virtuales en el vacío cuántico y sus dipolos de forma gravitacional (una carga gravitacional positivos y negativos) pueden interactuar con la materia bariónica para producir fenómenos que se suele atribuir a la materia oscura. Fue el físico del CERN, Dragan Slavkov Hajdukovic, quien propuso la idea, y demostró matemáticamente que estos dipolos gravitacionales podrían explicar las curvas de rotación de las galaxias observadas sin la materia oscura en su estudio inicial. Sin embargo, señaló que quedaba mucho por hacer.

Pero sigamos con la cuántica…

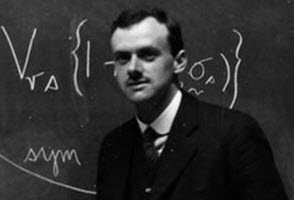

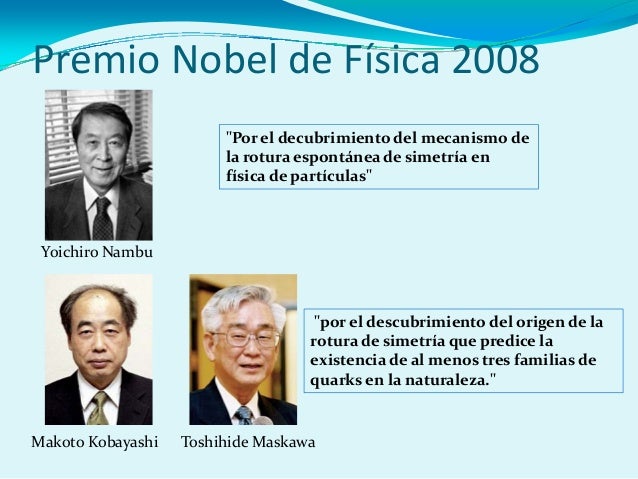

El pionero en comprender que era necesario que existiesen anti-partículas fue el físico teórico Paul Dirac, que hizo varías aportaciones importantes a la nueva teoría cuántica. Fue él quien formuló la ecuación relativista que lleva hoy su nombre, y a la que obedece el campo electrónico; constituye un descubrimiento comparable al de las ecuaciones del campo electromagnético de Maxwell. Cuando resolvió su ecuación, Dirac se encontró con que además de describir el electrón tenía soluciones adicionales que describían otra partícula con una carga eléctrica opuesta a la del electrón. ¿Qué significaría aquello? En la época en que Dirac hizo esta observación, no se conocían más partículas con esta propiedad que el protón. Dirac, que no deseaba que las partículas conocidas proliferasen, decidió que las soluciones adicionales de su ecuación describían el protón.

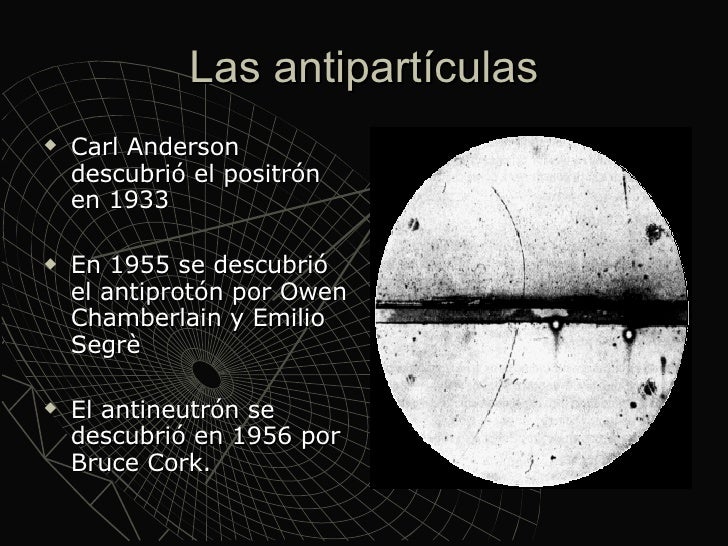

Pero, tras un análisis más meticuloso, se hizo evidente que las partículas que describían las soluciones adicionales tenían que tener exactamente la misma masa que el electrón. Quedaba así descartado el protón, cuya masa es por lo menos, 1.800 veces mayor que la del electrón. Por tanto, las soluciones adicionales tenían que corresponder a una partícula completamente nueva de la misma masa que el electrón, pero de carga opuesta: ¡El antielectrón! Esto quedó confirmado a nivel experimental en 1932 cuando Carl Anderson, físico del Instituto de Tecnología de Calífornia, detectó realmente el antielectrón, que hoy se llama positrón.

Antes de empezar, debemos recordar que el Premio Nobel de Física de 1936 se repartió a partes iguales entre Victor Franz Hess y Carl David Anderson. Merece la pena leer la Nobel Lecture de Carl D. Anderson, “The production and properties of positrons,” December 12, 1936, quien nos explica que en esta imagen un “electrón” de 63 MeV atraviesa un placa de plomo de 6 mm y emerge con una energía de 23 MeV, pero lo hace con la curvatura “equivocada” como si fuera una partícula de carga positiva, como si fuera un protón pero con la masa de un electrón. La Nobel Lecture muestra muchas otras fotografías de positrones y electrones. Anderson afirma: “The present electron theory of Dirac provides a means of describing many of the phenomena governing the production and annihilation of positrons.”

Por otro lado, el Premio Nobel de Física de 1933 se repartió a partes iguales entre Erwin Schrödinger y Paul Adrien Maurice Dirac. También vale la pena leer la Nobel Lecture de Paul A. M. Dirac, “Theory of electrons and positrons,” December 12, 1933, aunque no cuente la historia de su descubrimiento, afirma que su ecuación predice el “antielectrón” de soslayo: ”There is one other feature of these equations which I should now like to discuss, a feature which led to the prediction of the positron.” (fuente: Francis (th)E mule Science’s News).

La aparición de las anti-partículas cambió definitivamente el modo de pensar de los físicos respecto a la materia. Hasta entonces, se consideraba la materia permanente e inmutable. Podían alterarse las moléculas, podían desintegrarse los átomos en procesos radiactivos, pero los cuántos fundamentales se consideraban invariables. Sin embargo, tras el descubrimiento de la anti-materia realizado por Paul Dirac hubo que abandonar tal criterio. Heisenberg lo expresaba así:

“Creo que el hecho de que Dirac haya descubierto partículas y antipartículas, ha cambiado toda nuestra visión de la física atómica… creo que, hasta entonces, todos los físicos habían concebido las partículas elementales siguiendo los criterios de la filosofía de Demócrito, es decir, considerando esas partículas elementales como unidades inalterables que se hallan en la naturaleza como algo dado y son siempre lo mismo, jamás cambian, jamás pueden transmutarse en otra cosa. No son sistemas dinámicos, simplemente existen en sí mismas. Tras el descubrimiento de Dirac, todo parecía distinto, porque uno podía preguntar: ¿por qué un protón no podría ser a veces un protón más un par electrón-positrón, etc.?… En consecuencia, el problema de la división de la materia había adquirido una dimensión distinta.”

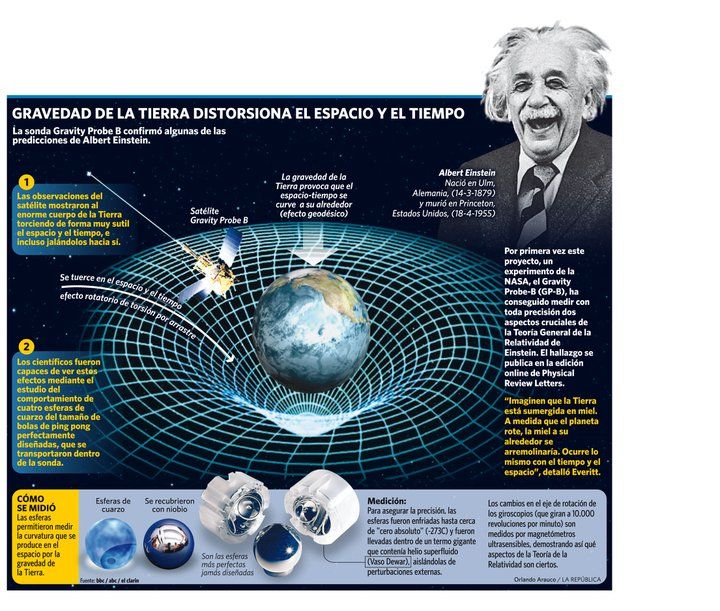

Dado que la anti-materia tiene la misma masa que la materia, es decir son de la misma magnitud y signo (la definición de masa es positiva siempre), el efecto gravitacional de la anti-materia no debe ser distinto de la materia, es decir, siempre sera un efecto atractivo. Pero, ¿acaso no importa la equivalencia establecida de anti-partícula viajando al futuro = partícula viajando al pasado?

Existe un “universo” que se nos escapa de la comprensión

La respuesta es sí. Dicha equivalencia proviene de algo llamado simetría CPT (Charge-Parity-Time), y nos dice que la equivalencia entre las partículas y anti-partículas no solo corresponde a realizar una transformación sobre la carga, sino también sobre la paridad y el tiempo. La carga no afecta la gravedad, pero la paridad y el tiempo si la afectan. En otras palabras, al modificarse el tiempo (poner el tiempo al revés) y el espacio (la paridad es “girar” el espacio), estamos alterando el espacio-tiempo, y como la teoría general de la relatividad lo afirma, es la geometría de este el que determina la gravedad.

El carácter mutable de la materia se convirtió en piedra angular de la nueva física de partículas. El hecho de que partículas y antipartículas puedan crearse juntas a partir del vacío si se aporta energía suficiente, no sólo es importante para entender cómo se crean las partículas en aceleradores de alta energía, sino también para entender los procesos cuánticos que se produjeron en el Big Bang.

Como ya lo hemos expresado, el conocimiento que se obtuvo sobre la existencia de anti-familias de partículas o familias de anti-partículas es una consecuencia de la aplicación de la teoría relativista del campo cuántico, para cada partícula existe una partícula que tiene la misma masa pero cuya carga eléctrica (y otras llamadas cargas internas) son de signo opuesto. Estas son las anti-partículas. Así, al conocido electrón, con carga negativa, le corresponde un «electrón positivo» como anti-partícula, llamado positrón, descubierto en 1932. El anti-protón, descubierto en 1956, tiene la misma masa que el protón, pero carga eléctrica negativa de igual valor. El fotón, que no tiene masa ni carga eléctrica, puede ser considerada su propia anti-partícula.

Un agujero negro es un objeto que tiene tres propiedades: masa, espín y carga eléctrica. La forma del material en un agujero negro no se conoce, en parte porque está oculta para el universo externo, y en parte porque, en teoría, el material continuaría colapsando hasta tener radio cero, punto conocido como Singularidad, de densidad infinita.

Un agujero negro tiene tres propiedades: masa, espín y carga eléctrica. La forma del material de un agujero negro no se conoce, en parte porque está oculta para el universo externo, y en parte porque, en teoría, el material continuaría colapsando hasta tener radio cero, punto conocido como singularidad, de densidad infinita.

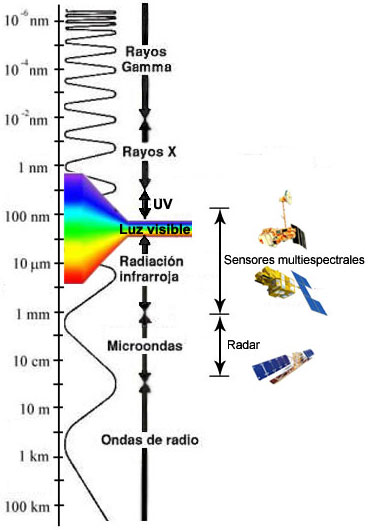

La luz (fotones), no son una onda distinta que un electrón o protón, etc.

1°- “No se dispersan”, no son más pequeñas, como las ondas del agua (olitas) cuando tiramos una piedra, a medida que se alejan de su centro; sino que en el caso de la luz son menos partículas, pero son siempre el mismo tipo de onda (determinada frecuencia), igual tamaño.

2°- Las ondas con más energía son más grandes, los fotones al igual que las partículas son más pequeñas, contra toda lógica (contracción de Lorentz).

3°- No necesitan de un medio material para desplazarse. Viajan en el vacío. El medio que usan para viajar, es el mismísimo espacio.

4°- Su cualidad de onda no es diferente de las partículas. Lo podemos ver en la creación de pares y la cualidad de onda de las partículas, etc. En ningún momento la partícula, es una cosa compacta (ni una pelotita), siempre es una onda, que no se expande. En la comparación con la ola, sería como un “montón” o un “pozo” de agua, con una dirección, lo que conocemos como ecuación de Schrödinger. En ningún momento la partícula, es una pelotita; la ola sobre el agua, no es un cuerpo que se mueve sobre el agua, no es un montón de agua que viene (aunque parece), sino una deformación del agua. Así la partícula, no es un montón de algo, sino una deformación del espacio.

La curvatura está relacionadas con la probabilidad de presencia, no es una bolita que está en uno de esos puntos, sino que es una onda en esa posición. El fotón es una onda que no necesita de un medio material para propagarse, se propaga por el espacio vacío. Así como una onda de sonido es una contracción-expansión del medio en que se propaga, el fotón es una contracción-expansión del espacio (del mismísimo espacio), razón por la cual entendemos que el espacio se curva, se contrae y expande. La rigidez del medio, da la velocidad de la deformación (velocidad de la onda), en el caso de la rigidez del espacio da una velocidad “c”.Esta onda por causa de la contracción del tiempo (velocidad “c”), no se expande, sino que se mantiene como en su origen (para el observador ), como si fuese una “burbuja”, expandida o contraída, en cada parte, positiva-negativa.

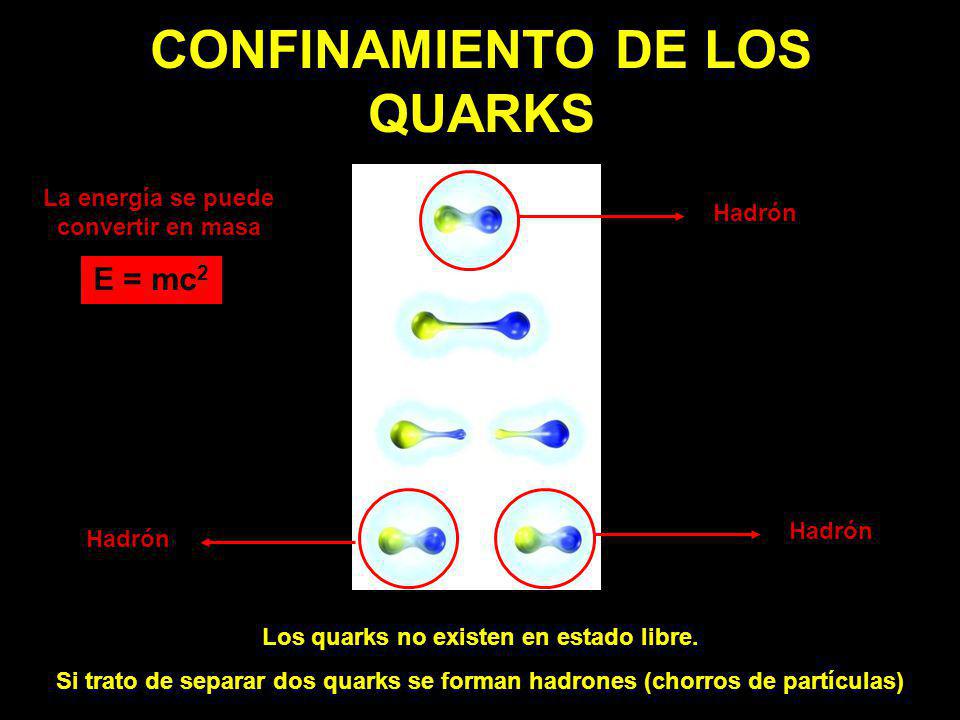

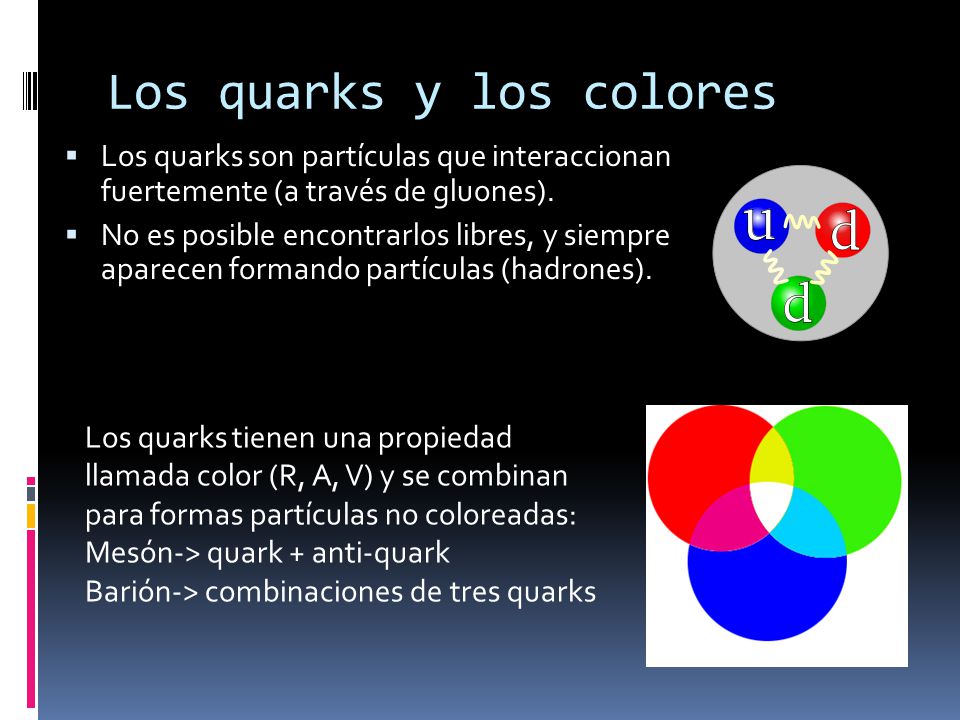

Cada partícula está caracterizada por un cierto número de parámetros que tienen valores bien definidos: su masa, carga eléctrica, spin o rotación interna y otros números, conocidos como cuánticos. Estos parámetros son tales que, en una reacción, su suma se mantiene y sirve para predecir el resultado. Se dice que hay conservación de los números cuánticos de las partículas. Así, son importantes el número bariónico, los diversos números leptónicos y ciertos números definidos para los quarks, como la extrañeza, color, etc. Estos últimos y sus antipartículas tienen cargas eléctricas (± 1/3 o ± 2/3) y números bariónicos (±1/3) fraccionarios. No todos los números asociados a cada partícula han sido medidos con suficiente precisión y no todas las partículas han sido detectadas en forma aislada, por lo menos de su ligamento, como el caso de

loquarksy de los gluones.

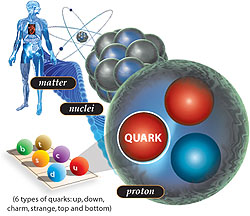

Los gluones son una especie de «partículas mensajeras» que mantienen unidos a los quarks. Su nombre proviene del término inglés “glue”, que significa pegamento, en español quizás podría ser gomón. Ahora, en cuanto a los quarks, ya hicimos referencia de ellos anteriormente. Pero recordemos aquí, que fueron descubiertos en 1964 por Murray Gell-Mann, como los componentes más reducidos de la materia. Hasta entonces se pensaba que los átomos consistían simplemente en electrones rodeando un núcleo formado por protones y electrones.

En estado natural, quarks y gluones no tienen libertad. Pero si se eleva la temperatura a niveles 100.000 veces superiores, como se ha hecho en aceleradores de partículas, a la del centro del Sol, se produce el fenómeno del desconfinamiento y por un brevísimo tiempo quedan libres. En ese preciso momento aparece lo que se suele llamar plasma, «una sopa de quarks y gluones» que equivale al estado en que se podría haber encontrado la naturaleza apenas una milésima de segundo luego del Big Bang.

Recientemente se ha descubierto un nuevo estado de la materia, esta vez a niveles muy altos de energía, que los científicos han denominado Plasma Gluón-Quark. La transición ocurre a temperaturas alrededor de cien mil millones de grados y consiste en que se rompen las fuertes ligaduras que mantienen unidos los quarks dentro de los núcleos atómicos. Los protones y neutrones están formados, cada uno, por 3 quarks que se mantienen unidos gracias a los gluones (El gluón es la partícula portadora de interacción nuclear fuerte, fuerza que mantiene unida los núcleos atómicos). A temperaturas superiores se vence la fuerza nuclear fuerte y los protones y neutrones se dividen, formando esta sopa denominada plasma Gluón-Quark.

Pero por ahora aquí, nos vamos a quedar con los quarks al natural. Normalmente, los quarks no se encuentra en un estado separados, sino que en grupos de dos o tres. Asimismo, la duración de las vidas medias de las partículas, antes de decaer en otras, es muy variable (ver tablas).

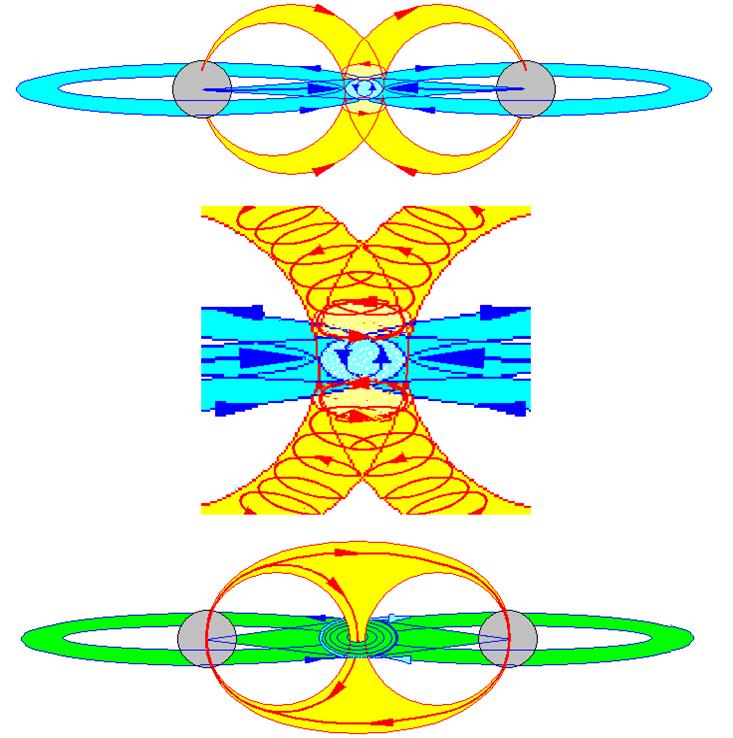

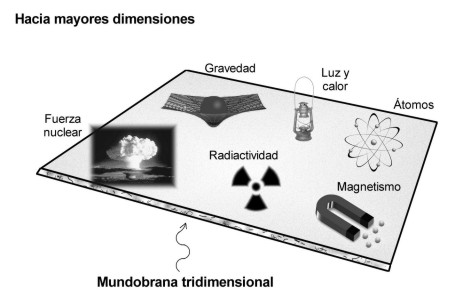

Por otra parte, las partículas presentan una o más de las siguientes interacciones o fuerzas fundamentales entre ellas. Por un lado se tiene la gravitación y el electromagnetismo, conocidas de la vida cotidiana. Hay otras dos fuerzas, menos familiares, que son de tipo nuclear y se conocen como interacciones fuertes y débiles.

La gravitación afecta a todas las partículas, es una interacción universal. Todo cuerpo que tiene masa o energía está sometido a esta fuerza. Aunque es la más débil de las interacciones, como las masas son siempre positivas y su alcance es infinito, su efecto es acumulativo. Por ello, la gravitación es la fuerza más importante en cosmología.

Los campos magnéticos están presentes por todo el Universo

La fuerza electromagnética se manifiesta entre partículas con cargas eléctricas. A diferencia de las demás, puede ser de atracción (entre cargas de signos opuestos) o de repulsión (cargas iguales). Esta fuerza es responsable de la cohesión del átomo y las moléculas. Mantiene los objetos cotidianos como entidades con forma propia. Un vaso, una piedra, un auto, el cuerpo humano. Es mucho más fuerte que la gravitación y aunque es de alcance infinito, las cargas de distinto signo se compensan y sus efectos no operan a grandes distancias. Dependiendo de las circunstancias en que actúen, estas interacciones pueden manifestarse como fuerzas eléctricas o magnéticas solamente, o como una mezcla de ambos tipos.

La Fuerza Nuclear Débil: otra fuerza nuclear, considerada mucho más débil que la Fuerza Nuclear Fuerte. El fenómeno de decaimiento aleatorio de la población de las partículas subatómicas (la radioactividad) era difícil de explicar hasta que el concepto de esta fuerza nuclear adicional fue introducido.

La interacción nuclear débil es causa de la radioactividad natural y la desintegración del neutrón. Tiene un rol capital en las reacciones de fusión del hidrógeno y otros elementos en el centro de las estrellas y del Sol. La intensidad es débil comparada con las fuerzas eléctricas y las interacciones fuertes. Su alcance es muy pequeño, sólo del orden de 10-15 cm.

La interacción fuerte es responsable de la cohesión de los núcleos atómicos. Tiene la intensidad más elevada de todas ellas, pero es también de corto alcance: del orden de 10-13 cm. Es posible caracterizar las intensidades de las interacciones por un número de acoplamiento a, sin dimensión, lo que permite compararlas directamente:

Fuerte as = 15

Electromagnéticas a = 7,3 x 10-3

Débil aw 3,1 x 10-12

Gravitacional aG = 5,9 x 10-39

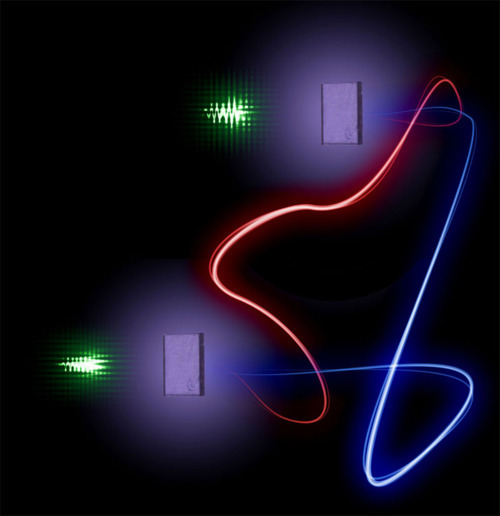

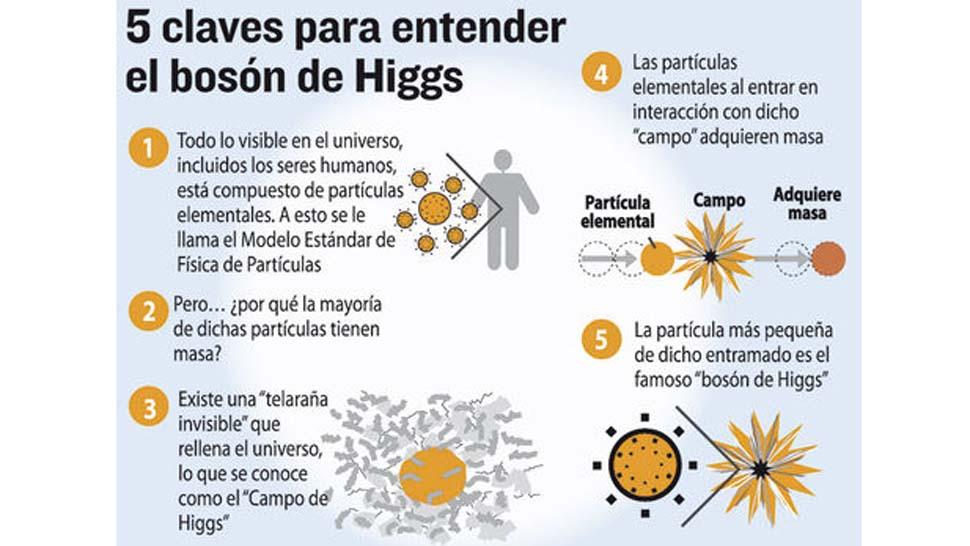

Por otro lado, la mecánica cuántica considera que la interacción de dos partículas se realiza por el intercambio de otras llamadas «virtuales». Tienen ese nombre porque no son observables: existen por un tiempo brevísimo, tanto más corto cuanto mayor sea su masa, siempre que no se viole el principio de incertidumbre de Heisenberg de la teoría cuántica (que en este contexto dice que el producto de la incertidumbre de la energía por el tiempo de vida debe ser igual o mayor que una constante muy pequeña). Desaparecen antes de que haya tiempo para que su interacción con otras partículas delate su existencia.

El fotón virtual común se desplaza hacia la partícula menos energética.

Dos partículas interactúan al emitir una de ellas una partícula virtual que es absorbida por la otra. Su emisión y absorción cambia el estado de movimiento de las originales: están en interacción. Mientras menos masa tiene la partícula virtual, más lejos llega, mayor es el rango de la interacción. El alcance de la interacción es inversamente proporcional a la masa de la partícula portadora o intermedia. Por ejemplo, la partícula portadora de la fuerza electromagnética es el fotón, de masa nula y, por lo tanto, alcance infinito. La interacción gravitacional también tiene alcance infinito y debe corresponder a una partícula de masa nula: se le denomina gravitón. Naturalmente tiene que ser neutro. (Aún no ha sido vistos ni en pelea de perros).

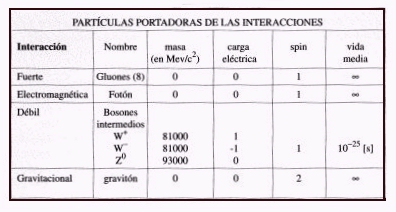

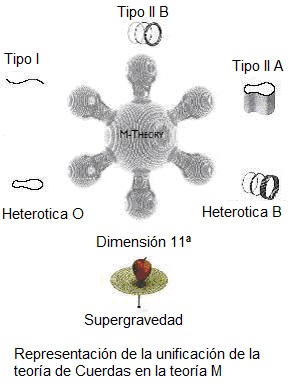

Como ya hicimos mención de ello, a las fuerzas nucleares se les asocian también partículas portadoras. Para la interacción débil estas partículas se llaman bosones intermedios, expresados como W+, W- y Zº (neutro). El W- es anti-partícula del W+. Los W tienen masas elevadas comparadas con las otras partículas elementales. Lo de bosones les viene porque tienen spin entero, como el fotón y el gravitón, que también los son, pero que tienen masas nulas. Las fuerzas fuertes son mediadas por unas partículas conocidas como gluones, de los cuales habría ocho. Sin embargo, ellos no tienen masa, pero tienen algunas de las propiedades de los quarks, que les permiten interactuar entre ellos mismos. Hasta ahora no se han observado gluones propiamente tal, ya que lo que mencionamos en párrafos anteriores corresponde a un estado de la materia a la que llamamos plasma. Claro está, que es posible que un tiempo más se puedan detectar gluones libres cuando se logre aumentar, aún más, la temperatura, como está previsto hacerlo en el acelerador bautizado como “Relativistic Heavy Ion Collider”, empotrado en Estados Unidos de Norteamérica.

TABLA DE LAS PRINCIPALES PROPIEDADES DE LAS PARTÍCULAS PORTADORAS DE LAS INTERACCIONES FUNDAMENTALES

Una partícula y su antipartícula no pueden coexistir si están suficientemente cerca como para interactuar. Si ello ocurre, ellas se destruyen mutuamente: hay aniquilación de las partículas. El resultado es radiación electromagnética de alta energía, formada por fotones gamma. Así, si un electrón está cercano a un positrón se aniquilan en rayos gamma. Igual con un par protón-antiprotón muy próximos.

La reacción inversa también se presenta. Se llama «materialización o creación de partículas» de un par partícula-antipartícula a partir de fotones, pero se requieren condiciones físicas rigurosas. Es necesario que se creen pares partícula-antipartícula y que los fotones tengan una energía mayor que las masas en reposo de la partículas creadas. Por esta razón, se requieren fotones de muy alta energía, de acuerdo a la relación de Einstein E=mc2 . Para dar nacimiento a electrones/positrones es necesario un campo de radiación de temperaturas mayores a 7×109 °K. Para hacer lo mismo con pares protón/antiprotón es necesario que ellas sean superiores a 2×1012 °K. Temperaturas de este tipo se producen en los primeros instantes del universo.

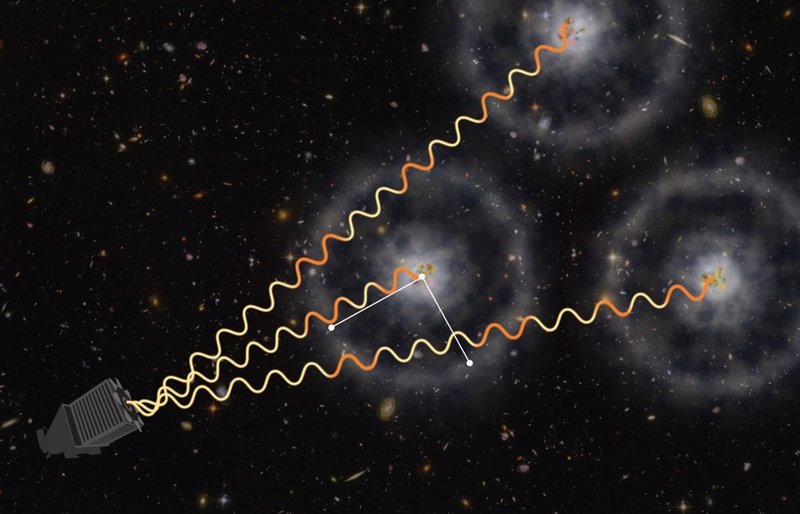

Imagen: El pasado 12 de abril, uno de los instrumentos del observatorio espacial, el Telescopio de Área Grande (LAT), concebido y ensamblado en el National Accelerator Laboratory SLAC del Departamento de Energía, operado en la Universidad de Stanford, California, obtuvo el hito histórico con su detección 1.000.000.000 (mil millones) de rayos gamma extraterrestres.

“Luego de tres años de observación y análisis de los datos recabados a partir de observar día y noche tres cuartas partes de la bóveda celeste, identificamos una fuente de rayos gamma de TeVs muy particular. Se trata de un sistema binario conformado por una estrella de neutrones de unas 16 masas solares y una estrella supergigante de tipo A de 40 masas solares, las cuales orbitan una alrededor de otra a una distancia equivalente a un tercio de la distancia entre el Sol y Mercurio.”

Los rayos gamma están presentes en explosiones de supernovas, colisión de estrellas de neutrones… Todos los sucesos de altas energías los hace presente para que nuestros ingenios los detecten y podamos conocer lo que la materia esconde en lo más profundo de sus “entrañas”. Aún no hemos podido conocer en profundidad la materia ni sabemos, tampoco, lo que realmente es la luz.

emilio silvera

Nov

15

La importancia del Carbono para la Vida y otros

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Bioquímica ~

Clasificado en Bioquímica ~

Comments (0)

Comments (0)

El concepto de Gaia, considera a la Tierra como un Ente Vivo que evoluciona y se recicla

Nuestro planeta, la Tierra, forma parte del Universo, y, es una prueba indiscutible de que sus componentes biológicos y físicos forman parte de una única red que funciona de un modo autorregulado, y, de esa forma, mantiene las condiciones que son ampliamente adecuadas para la existencia de vida, pero que sufren fluctuaciones a todas las escalas (incluidos los ritmos de alternancia de glaciaciones y periodos interglaciales, así como las extinciones masivas). En un sentido real, la Tierra es el lugar que alberga una red de vida como seguramente estará presente en muchos otros mundos en el que se den las circunstancias adecuadas, y la existencia de esta red (Gaia) sería visible para cualquier forma de vida inteligente que hubiera en Marte o en cualquier otro planeta y que fuera capaz de aplicar la prueba conocida de Lovelock y buscar señales de reducción de la entropía.

Cuando Lovelock publicó la hipótesis de Gaia, provoco una sacudida en muchos científicos, sobre todo en aquellos con una mente más lógica que odiaban un concepto que sonaba tan místico. Les producía perplejidad, y lo más desconcertante de todo era que Lovelock era uno de ellos. Tenía fama de ser algo inconformista, pero sus credenciales científicas eran muy sólidas. Entre otros logros a Lovelock se le conocía por ser el científico que había diseñado los instrumentos de algunos de los experimentos para buscar vida que la nave estadounidense Viking había llevado a cabo en la superficie de Marte.

Cuando Lovelock publicó la hipótesis de Gaia, provoco una sacudida en muchos científicos, sobre todo en aquellos con una mente más lógica que odiaban un concepto que sonaba tan místico. Les producía perplejidad, y lo más desconcertante de todo era que Lovelock era uno de ellos. Tenía fama de ser algo inconformista, pero sus credenciales científicas eran muy sólidas. Entre otros logros a Lovelock se le conocía por ser el científico que había diseñado los instrumentos de algunos de los experimentos para buscar vida que la nave estadounidense Viking había llevado a cabo en la superficie de Marte.

Ni la NASA, tomó nunca la prueba de Lovelock lo suficientemente en serio como para aplicarla a la búsqueda de vida en el Sistema Solar; pero si se lo tomó en serio para buscar vida más allá del Sistema Solar. Pero recapacitaron y comenzaron a enviar al planeta Marte, una serie de ingenios en forma de pequeñas navez robotizadas como la Mars Phoenix que comenzó encontrando hielo de agua diluyendo porciones de la tierra marciana en agua y debidamente tratada, hallaron la presencia de magnesio, sodio, potasio y cloruros. Uno de los científicos responsables llegó a decir:

“Hay más que evidencia de agua porque las sales están ahí. Además hemos encontrado los compuestos químicos necesarios para la vida como la conocemos. y, lo sorprendente de Marte es que no es un mundo extraño, sino que, en muchos aspectos es igual que la Tierra.”

Se están analizando los gases y los compuestos químicos del suelo y del hielo allí encontrados, y, todo ello, debidamente procesado nos dará una respuesta de lo que allí existe.

Lo que para mí está muy claro es que, los mecanismos del Universo son los mismos en cualquier región del cielo, y, las estrellas y los planetas surgen en todas partes de la misma manera. Y, si eso es así, sería lógico pensar que la vida podría estar en cualquier parte, y, además, con muchas probabilidades de que sea más o menos tal como la conocemos, ya que, la nuestra, basada en el Carbono y el Nitrógeno (siempre en presencia de agua), es la más natural dadas las características de estos elementos para unirse.

La historia de la vida en el Universo es otro ejemplo de complejidad superficial construida sobre cimientos de una profunda sencillez. Actualmente la prueba de que el universo tal como lo conocemos surgió a partir de un estado denso y caliente (Big Bang) hace unos 14.000 millones de años, es poco discutida.

Con los elementos primordiales creados en las estrellas, miles de años más tarde, en los mundos situados en las zonas habitables de sus estrellas, se habrán podido conformar células replicantes que habrían dado comienzo a la aventura de la vida. En la Tierra, el único planeta con vida que conocemos (por el momento), las formas de vida y especies que han estado aquí y siguen estando ha sido de una rica variedad y de asombrosos metabolismos.

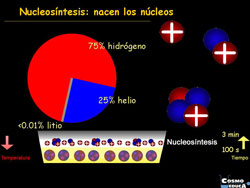

Los bloques de construcción básicos que emergieron del big bang fueron el hidrógeno y el helio, casi exactamente en una proporción de 3:1. Todos los demás elementos químicos (excepto unos leves vestigios de unos pocos elementos muy ligeros, como el litio) han sido fabricados en el interior de las estrellas y dispersados por el espacio cuando estas se dilataron y expulsaron materiales, o, al final de sus vidas, agotado el combustible nuclear de fusión, explotaron como Supernovas regando grandes regiones con Nebulosas creadoras de nuevas estrellas y nuevos mundos.

Una estrella como el Sol genera calor convirtiendo hidrógeno en helio dentro de su núcleo; en otras estrellas los procesos cruciales incluyen fusiones sucesivas de núcleos de helio. Dado que cada núcleo de helio es una unidad que contiene cuatro “nucleones” (dos protones y dos neutrones), y este elemento se denomina abreviadamente helio-4, esto significa que los elementos cuyos núcleos contienen un número de nucleones que es múltiplo de cuatro son relativamente comunes en el universo, excepto el berilio-8, que es inestable.

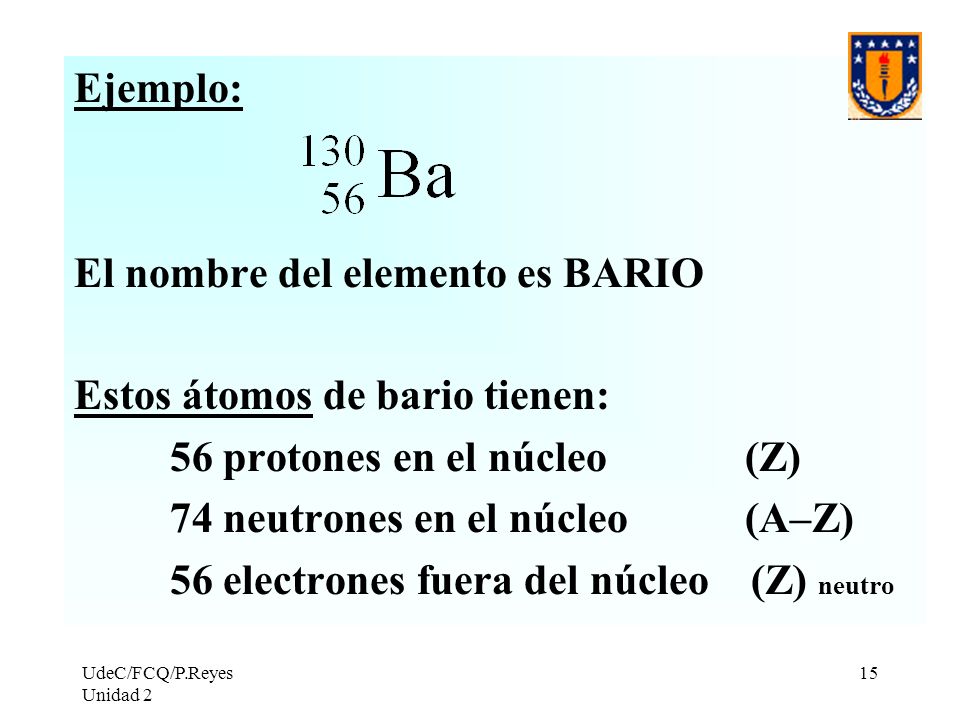

El carbono-12 es el más abundante de los dos isótopos estables del elemento Carbono, representando el 98,89% de todo el carbono terrestre. Está conformado por 6 protones, 6 neutrones y 6 electrones.

Adquiere particular importancia al usarse como patrón para el cálculo de la masa atómica de los distintos nucleidos existentes en la naturaleza; dado que la masa atómica del 12C es, por definición, 12 umas.

Concretamente, en las primeras etapas de este proceso se produce carbono-12 y oxígeno-16, y resulta que el nitrógeno-14, aunque no contiene un número entero de núcleos de helio-4, se obtiene como subproducto de una serie de interacciones en las que participan núcleos de oxígeno y de carbono que operan en estrellas de masa un poco mayor que la de nuestro Sol.

Como consecuencia, estos son, con gran diferencia, los elementos más comunes, aparte del hidrógeno y del helio. Dado que éste último es un gas inerte (noble) que no reacciona químicamente, se deduce que los cuatro elemenbtos reactivos más comunes en el universo son el Carbono, el Hidrógeno, el Oxígeno y el Nitrógeno, conocidos en el conjunto por el acrónimo CHON.

No es casualidad que los cuatro elementos químicos que participan con una aplastante mayoría en la composición de los seres vivos de la Tierra sean el carbono, el hidrógeno, el oxígeno y el nitrógeno.

En estado puro y dependiendo de cómo estén dispuestos sus átomos, este elemento puede formar tanto el mineral más duro que ocurre en la naturaleza, el diamante, como uno de los más blandos, el grafito. Organizados en hexágonos y formando láminas, los átomos de carbono dan lugar al grafeno, un material del que habréis oído hablar estos últimos años por sus “increíbles” propiedades

Estructuras basadas en el Carbono

El Carbono desarrolla el papel clave en el desarrollo de la vida, porque un solo átomo de este elemento es capaz de combinarse químicamente nada menos que con otros cuatro átomos al mismo tiempo (incluídos otros átomos de carbono, que pueden estar unidos a su vez a más átomos de carbono, formando anillos y cadenas), de tal modo que este elemento tiene una química excepcionalmente rica. Así decimos con frecuencia que la vida en la Tierra está basada en el Carbono, el elemento más ductil y crucial en nuestra formación.

Claro que, tal comentario, no implica la negación de que pudieran existir otras clases de vida basadas en el Silicio o en cualquier otra combinación química, pero todas las pruebas que aporta la Astronomía sugieren que es mucho mayor la probabilidad de que la vida más allá de nuestras fronteras esté basada también en el CHON.

Claro que, tal comentario, no implica la negación de que pudieran existir otras clases de vida basadas en el Silicio o en cualquier otra combinación química, pero todas las pruebas que aporta la Astronomía sugieren que es mucho mayor la probabilidad de que la vida más allá de nuestras fronteras esté basada también en el CHON.

Es inadmisible lo poco que la gente común sabe del Universo al que pertenecen y también lo poco que se valora el trabajo de Astrónomos, Astrofísicos y Cosmólogos, ellos son los que realizan las pruebas y las comprobaciones que finalmente nos llevan al conocimiento que hoy tenemos del cielo y de los objetos que lo pueblan y de las fuerzas que allí actúan.

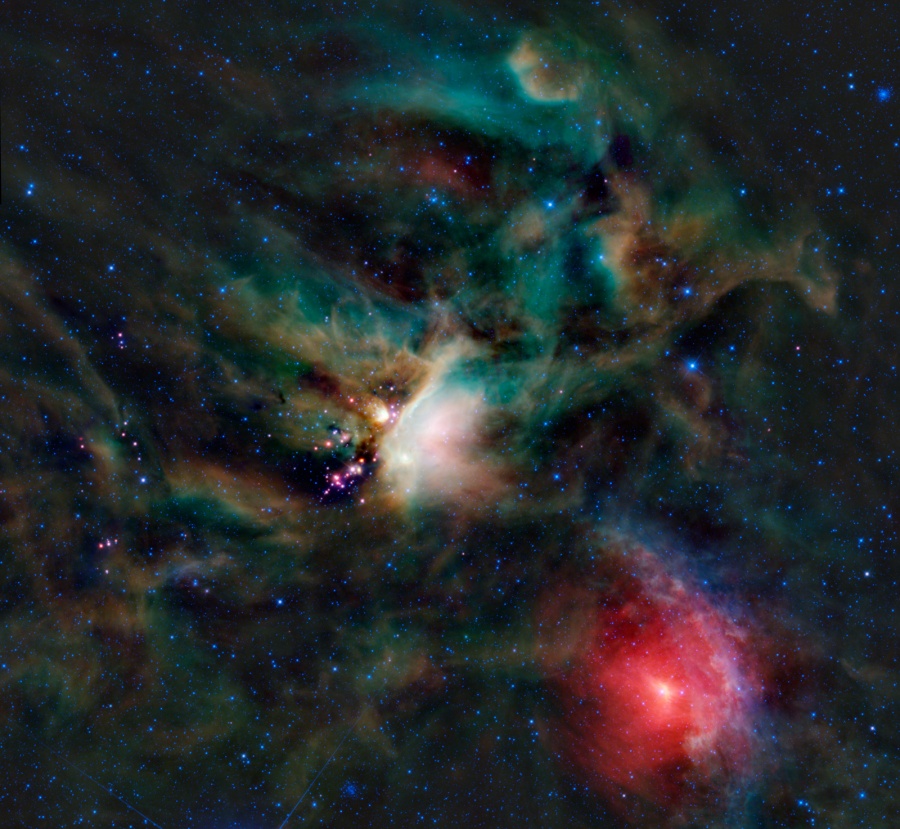

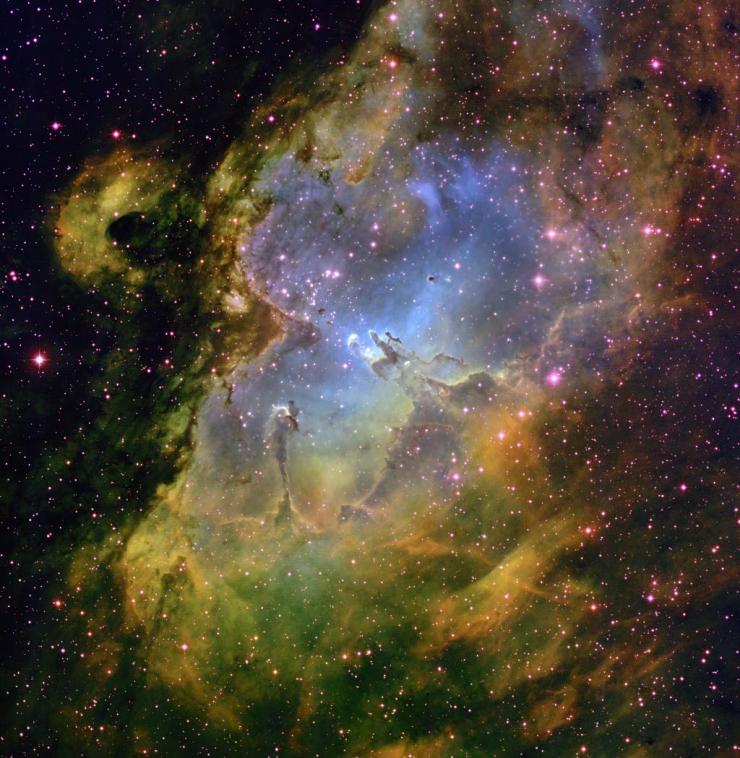

La Nebulosa de la Quilla, una de las regiones de nacimiento de estrellas más grandes del universo: pilares de 3 años luz de altura que parecen abultados como las velas de un barco por la fuerza tirante de los astros que, literalmente, da a luz en su interior.

Gran parte de estas pruebas proceden del análisis espectroscópico del material que está presente en las Nebulosas, esas inmensas nubes de gas y polvo que se encuentran en el espacio como resultado de explosiones de supernovas o de otros fenómenos que en el Universo son de lo más frecuente. A partir de esas nubes se forman los sistemas planetarios como nuestro sistema solar, allí, nacen nuevas estrellas que contienen los mismos materiales expulsados por estrellas de generaciones anteriores.

En estas nubes hay muchos compuestos construidos en torno a átomos de carbono, y este elemento es tan importante para la vida que sus compuestos reciben en general el nombre de compuestos “orgánicos”. Entre los compuestos detectados en nubes interestelares hay sustancias muy sencillas, como metano y dióxido de carbono, pero también materiales orgánicos mucho más complejos, entre los que cabe citar el formaldehído, el alcohol etílico, e incluso al menos un aminoácido, la glicina. Lo que constituye un descubrimiento muy esclarecedor, porque es muy probable que toso los materiales existentes en las nubes interestelares hayan estado presentes en la nube a partir de la cual se formó nuestro Sistema Solar, hace unos cinco milo millones de años.

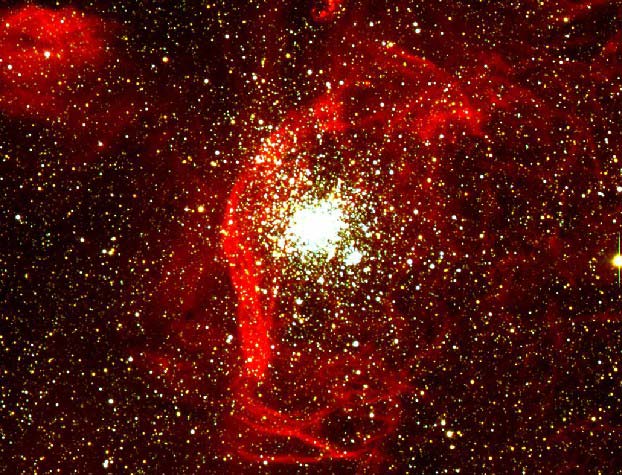

En este cúmulo estelar llamado NGC 602, cerca de la Pequeña Nube de Magallanes, millones de estrellas jóvenes emiten radiación y energía en forma de ondas que erosionan el material que las rodea creando formaciones visualmente interesantes. El tamaño de lo que se ve en la foto abarca 200 años luz de lado a lado

A partir de estos datos, equipos científicos han llevado a cabo en la Tierra experimentos en los que unas materias primas, debidamente tratadas simulando las condiciones de densidad y energías de aquellas nubes interestelares (ahora en laboratorio), dieron como resultado el surgir expontáneo de tres aminoácidos (glicina, serina y alanina). Todos conocemos el experimento de Miller.

En otro experimento utilizando otra mezcla de ingredientes ligeramente distinta, se producian no menos de dieciseis aminoácidos y otros compuestos orgánicos diversos en unas condiciones que eran las existentes en el espacio interestelar.

Para hacernos una idea, las proteínas de todos los seres vivos de la Tierra están compuestas por diversas combinaciones de tan sólo veinte aminoácidos. Todas las evidencias sugieren que este tipo de materia habría caído sobre los jóvenes planetas durante las primeras etapas de formación del sistema planetario, deposita por cometas que habría sido barridos por la influencia gravitatoria de unos palnetas que estaban aumentando de tamaño.

En idénticas condiciones de temperatura y presión que el universo de hace 4.600 millones de años, Experimentos llevados a cabo en el laboratorio, han logrado originar ribosa, la molécula que luego acabó convirtiéndose en ADN.

Como hemos podido deducir, una sopa de aminoácidos posee la capacidad de organizarse por sí sóla, formando una red con todas las propiedades que ha de tener la vida. De esto se deduce que los aminoácidos que estuvieron formando durante largos períodos de tiempo en las profundidades del espacio (utilizando energias proporciona por la luz de las estrellas), serían transportados a la superficie de cualquier planeta joven, como la Tierra.

Algunos planetas pueden resultar demasiado calientes para que se desarrolle la vida, y otros demasiado fríos. Pero ciertos planetas como la propia Tierra (existentes a miles de millones), estarían justo a la temperatura adecuada. Allí, utilizando la expresión de Charles Darwin, en alguna “pequeña charca caliente” tendrían la oportunidad de organizarse en sistemas vivos.

Sopa primigenia de la que surgió la primera célula replicante precursora de la Vida

Claro que, por mi parte, como dijo aquel famoso Astrofísico inglés del que ahora no recuerdo el nombre: ” milagro no es que aparezca vida fuera de la Tierra, el verdadero milafro sería que no apareciera”.

Y, en cuanto a las condiciones para que haga posible la existencia de vida, conviene ser reservados y no emitir un juicio precipitado, ya que, todos sabemos de la existencia de vida en condiciones que se podrían comparar o denominar de infernales. Así que, estaremos a la espera de que, el Universo nos de una respuesta.

Veamos algunos conceptos: Nova.

Antiguamente, a una estrella que aparecía de golpe donde no había nada, se le llamaba nova o ” estrella nueva “. Pero este nombre no es correcto, …

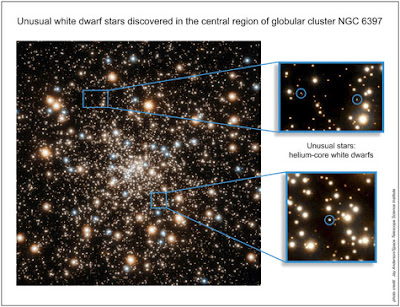

En realidad es una estrella que durante el periodo de sólo unos pocos días, se vuelve 103-104 veces más brillantes de lo que era. Ocurren 10 ó 15 sucesos de ese tipo cada año en la Vía Láctea. Las novas se cree que son binarias próximas en las que, uno de sus componentes es usualmente una enana blanca y la otra una gigante roja.

La materia se transfiere de la gigante roja a la enana blanca, en cuya superficie se acumula, dando lugar a una explosión termonuclear, y, a veces se convierte en una estrella de neutrones al ver incrementada su masa.

Nucleones.

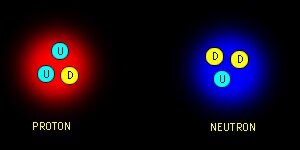

Protones y neutrones, los constituyentes de los núcleos atómicos que, a su vez, están conformados por tripletes de Quarks. Un protón está hecho por 2 Quarks up y 1 Quark Down, mientras que un Neutrón está conformado por 2 Quarks Down y 1 Quark up. Son retenidos en el núcleo por los Bosones llamados Gluones que son transmisores de la fuerza nuclear fuerte.

Núcleo.

Corazón central de un átomo que contiene la mayor parte de su masa. Está positivamente cargado y constituido por uno o más nucleones (protones y neutrones).

La carga positiva del núcleo está determinada por el número de protones que contiene (número atómico) y en el átomo neutro está compensada por un número igual de electrones, que se mueven alrededor del núcleo y cuya carga eléctrica negativa anula o compensa a la positiva de los (electro) protones.

El núcleo más simple es el núcleo de hidrógeno, consistente en un único protón. Todos los demás núcleos contienen además uno o más neutrones.

Los neutrones contribuyen a la masa atómica, pero no a la carga nuclear.

El núcleo más masivo que se encuentra en la Naturaleza es el Uranio-238, que contiene 92 protones y 146 neutrones.

Nucleosíntesis, nucleogénesis.

Fusión de nucleones para crear los núcleos de nuevos átomos más complejos. La nucleosíntesis tiene lugar en las estrellas y, a un ritmo más acelerado, en las supernovas.

La nucleosíntesis primordial tuvo lugar muy poco después del Big Bang, cuando el Universo era extremadamente caliente y, ese proceso fue el responsable de la abundancia de elementos ligeros, por todo el cosmos, como el Helio y el Hidrógeno que, en realidad es la materia primordial de nuestro Universo, a partir de estos elementos se obtienen todos los demás en los procesos estelares de fusión.

Omega negro

El Omega negro se refiere a la cantidad de materia que hay en el Universo

Índice de densidad de materia del Universo, definida como la razón entre la actual densidad y la “Densidad crítica” requerida para “cerrar” el Universo y, con el tiempo, detener su expansión.

Para la materia oscura se dirá: “Omega Negro”.

Si Omega es mayor que 1, el Universo se detendrá finalmente y las galaxias recorrerán, a la inversa, el camino recorrido para colapsar en una gran Bola de fuego, el Big Crunch, estaríamos en un Universo cerrado.

Se dice que, un Universo con exactamente 1, la Densidad crítica ideal, estará alrededor de 10-29 g/cm3 de materia, lo que esta descrito por el modelo e Universo descrito por Einstein-de Setter.

En cualquier caso, sea cual fuere Omega, no parece muy atractivo el futuro de nuestro Universo que según todos los datos que tenemos acabará en el hielo o en el fuego y, en cualquier de estos casos.

¿Dónde nos meteremos?

Onda, función.

Función, denotada por Y (w,y,z), que es solución de la ecuación de Schrödinger en la mecánica cuántica. La función de ondas es una expresión matemática que depende de las coordenadas de una partícula en el espacio.

Si la función de ondas (ecuación de Schrödinger) puede ser resuelta para una partícula en un sistema dado (por ejemplo, un electrón en un átomo), entonces, dependiendo de las colisiones en la frontera, la solución es un conjunto de soluciones, mejor de funciones de onda permitidas de la partícula (autofunciones), cada una correspondiente a un nivel de energía permitido.

El significado físico de la función de ondas es que el cuadrado de su valor absoluto en un punto, [Y]2, es proporcional a la probabilidad de encontrar la partícula en un pequeño elemento de volumen, dxdydz, en torno a ese punto. Para un electrón de un átomo, esto da lugar a la idea de orbitales atómicos moleculares.

elimino ecuación para no confundir al lector no versado.

donde Y es la función de ondas, Ñ2 es el operador Laplace, h es la constante de Planck, m es la masa de la partícula, E la energía total= y È la energía potencial.

Colaboración de Emilio Silvera.

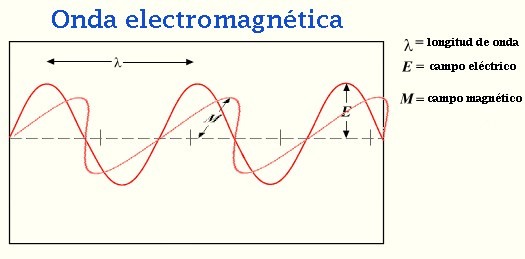

Ondas.

La velocidad de una estrella puede generar enormes onda

Propagación de la energía mediante una vibración coherente.

Está referido a la perturbación periódica en un medio o en el espacio. En una onda viajera (u onda progresiva) la energía es transferida de un lugar a otro por las vibraciones. En el Espacio puede estar causada por el movimiento de las estrellas.

En una onda que atraviesa la superficie del agua, por ejemplo, el agua sube y baja al pasar la onda, pero las partículas del agua en promedio no se mueven. Este tipo de onda se denomina onda transversal, porque las perturbaciones están en ángulo recto con respecto a la dirección de propagación. La superficie del agua se mueve hacia arriba y abajo mientras que la onda viaja a lo largo de la superficie del agua.

Las ondas electromagnéticas son de este tipo, con los campos eléctricos y, magnéticos variando de forma periódica en ángulo recto entre sí y a la dirección de propagación.

En las ondas de sonido, el aire es alternativamente comprimido y rarificado por desplazamiento en la dirección de propagación. Dichas ondas se llaman longitudinales.

Las principales características de una onda es su velocidad de propagación, su frecuencia, su longitud de onda y su amplitud. La velocidad de propagación y la distancia cubierta por la onda en la unidad de tiempo. La frecuencia es el número de perturbaciones completas (ciclos) en la unidad de tiempo, usualmente expresada en hertzios. La longitud de onda es la distancia en metros entre puntos sucesivos de igual fase de onda es la distancia en metros entre puntos sucesivos de igual fase de onda. La amplitud es la diferencia máxima de la cantidad perturbada medida con referencia a su valor medio.

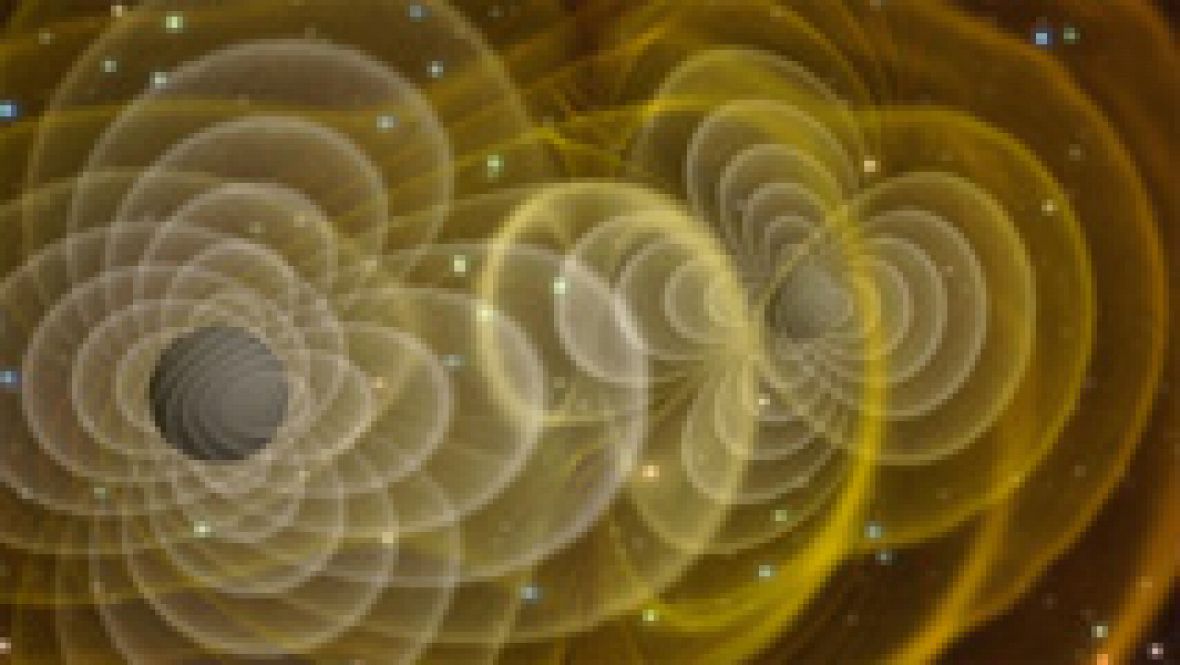

Recuerdo cuando allá por el año 2009 publiqué: “Pronto oiremos que Kip S. Thorne ha detectado y medido las ondas gravitacionales de los Agujeros Negros.” Y, en el presente es noticias pasada.

Las ondas gravitacionales son aquellas que se propagan a través de un campo gravitacional. Cuando eso suceda, tendremos nuevos conocimientos sobre el Universo, ya que, el que ahora conocemos sólo está dado por las lecturas de las ondas electromagnéticas, no de las gravitatorias.

La predicción de que una masa acelerada radia ondas gravitacionales (y pierde energía) proviene de la teoría general de la relatividad. Por ejemplo cuando dos agujeros negros chocan y se fusionan.

El Experimento LIGO se afanó en localizar y medir estas ondas y, a la cabeza del proyecto, como he dicho, está el experto en agujeros negros, el físico y cosmólogo norteamericano, amigo de Stephen Hawking, kip S.Thorne, que está buscando las pulsaciones de estos monstruos del espacio, cuya energía infinita (según él), algún día podrá ser aprovechada por la humanidad cuando la tecnología lo permita.

Aunque podríamos continuar hablando sobre onda continua, onda cósmica, onda cuadrada, onda de choque, onda de espín (magnón), onda de tierra, onda estacionaria, onda ionosférica, onda portadora, onda sinuosidad, onda viajera, onda sísmica, onda submilimétrica, onda de ecuación, etc., sería salirse del objeto perseguido aquí.

Oort, nube de ; Constante de.

La nube de Oort está referida a un halo aproximadamente esférico de núcleos cometarios que rodea al Sol hasta quizás unas 100.000 UA (más de un tercio de la distancia a la estrella más próxima). Su existencia fue propuesta en 1950 por J.H.Oort (1900-1992) astrónomo holandés, para explicar el hecho de que estén continuamente acercándose al Sol nuevos cometas con órbitas altamente elípticas y con todas las inclinaciones.

La nube Oort sigue siendo una propuesta teórica, ya que no podemos en la actualidad detectar cometas inertes a tan grandes distancias. Se estima que la nube contiene unos 1012 cometas restantes de la formación del Sistema Solar. Los miembros más distantes se hallan bastante poco ligados por la gravedad solar.

Puede exitir una mayor concentración de cometas relativamente cerca de la eclíptica, a 10.000-20.000 ÈA del Sol, extendiéndose hacia adentro para unirse al Cinturón de kuiper. Los comentas de la Nube de Oort se ven afectados por la fuerza gravitatoria de los estrellas cercanas, siendo perturbadas ocasionalmente poniéndoles en órbitas que los llevan hacia el Sistema Solar interior.

La constante de Oort está referida a dos parámetros definidos por J.H.Oort para describir las características más importantes de la rotación diferencial de nuestra Galaxia en la vecindad del Sol. Son usualmente expresadas en unidades de kilómetros por segundo por kiloparsec. Los dos parámetros están dados por los símbolos A y B. Restando B de A se obtiene la velocidad angular del estándar local de repaso alrededor del centro de la Galaxia, que corresponde al periodo de unos 200 millones de años.

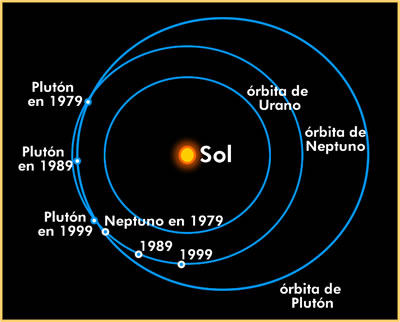

Órbita.

En astronomía es el camino a través del espacio de un cuerpo celeste alrededor de otro. Para un cuerpo pequeño que se mueve en el campo gravitacional de otro, la órbita es una cónica. La mayoría de esas órbitas son elípticas y la mayoría de las órbitas planetarias en el sistema solar son casi circulares. La forma y tamaño de una órbita elíptica se determina por su excentricidad, e, y la longitud de su semieje mayor, a.

En física, la órbita esta referida al camino de un electrón al viajar alrededor del núcleo del átomo (ver orbitales).

emilio silvera

Nov

15

Moléculas, sustancias, cuerpos…

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Moléculas precursoras de la vida ~

Clasificado en Moléculas precursoras de la vida ~

Comments (0)

Comments (0)

Es allí, en las estrellas, en sus hornos nucleares y en las explosiones de supernovas, donde a miles de millones de grados de temperatura, se crean los elementos más complejos que el hidrógeno y el helio. Aparece el litio, el carbono, el silicio o el nitrógeno y el hierro.

De estos materiales estamos nosotros hechos, y, lógicamente, se fabricaron en las estrellas.

En una supernova, en orden decreciente tenemos la secuencia de núcleos H, He, O, C, N, Fe, que coincide bastante bien con una ordenación en la tabla periódica que es:

H, He, (Li, Be, B) C, O, N…… Fe

¿Apreciáis la maravilla? Las estrellas brillan en el cielo para hacer posible que nosotros estemos aquí descubriendo los enigmas del Universo y…. de la vida inteligente.

El telescopio VLT (Very Large Telescope) de ESO ha obtenido imágenes de una fascinante región de formación de estrellas en la Gran Nube de Magallanes — una de las galaxias satélite de la Vía Láctea. Esta precisa imagen revela dos peculiares y brillantes nubes de gas: la rojiza NGC 2014 y su vecina azulada NGC 2020. Pese a que son muy diferentes, ambas fueron esculpidas por potentes vientos estelares procedentes de estrellas recién nacidas extremadamente calientes que también irradian el gas, provocando que brille de forma intensa. (para verla entera hay que pasar la rgla hacia la derecha).

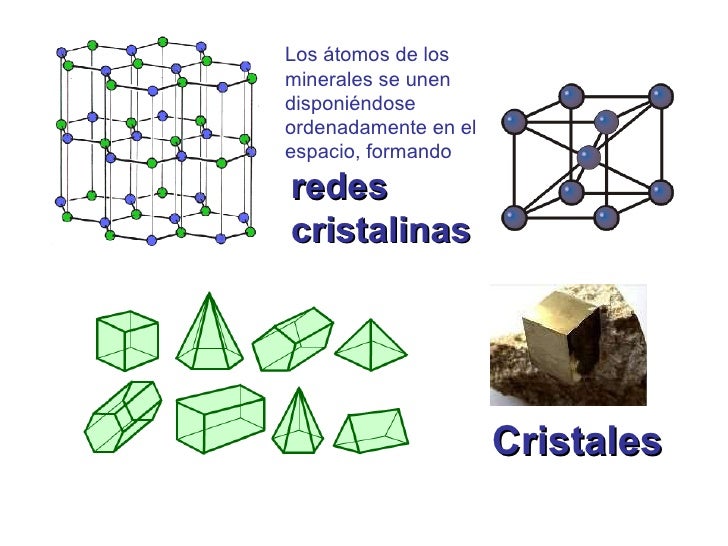

Pero está claro que, todo el proceso estelar evolutivo inorgánico nos condujo desde el simple gas y polvo cósmico a la formación de estrellas y nebulosas solares hasta los planetas, la Tierra en particular, en cuyo medio ígneo describimos la formación de las estructuras de los silicatos, desplegándose con ello una enorme diversidad de composiciones, formas y colores, asistiéndose, por primera vez en la historia de la materia, a unas manifestaciones que contrastan con las que hemos mencionado en relación al proceso de las estrellas.

Desde el punto de vista del orden es la primera vez que nos encontramos con objetos de tamaño comparables al nuestro, en los que la ordenación de sus constituyentes es el rasgo más característico.

Al mismo tiempo nos ha parecido reconocer que esos objetos, es decir, sus redes cristalinas “reales”, almacenan información (memoria) que se nos muestra muy diversa y que puede cobrar interés en ciertos casos, como el de los microcristales de arcilla, en los que, según Cairos-Swith, puede incluso llegar a transmitirse.

Porque ¿qué sabemos en realidad de lo que llamamos materia inerte? Lo único que sabemos de ella son los datos referidos a sus condiciones físicas de dureza, composición, etc., en otros aspectos, ni sabemos si pueden existir otras propiedades distintas a las meramente-físicas.

¿No os hace pensar que nosotros estemos hechos, precisamente, de lo que llamamos materia inerte?

Pero el mundo inorgánico es sólo una parte del inmenso mundo molecular. El resto lo constituye el mundo orgánico, que es el de las moléculas que contienen carbono y otros átomos y del que quedan excluidos, por convenio y características especiales, los carbonatos, bicarbonatos y carburos metálicos, los cuales se incluyen en el mundo inorgánico.

Los Quarks u y d se hallan en el seno de los nucleones (protones y neutrones) y, por tanto, en los núcleos atómicos. Hoy día, estos se consideran como una subclase de los hadrones.

La composición de los núcleos (lo que en Química se llama análisis cualitativo) es extraordinariamente sencilla ya que, como es sabido, constan de neutrones y protones que se pueden considerar como unidades que, dentro del núcleo, mantienen su identidad. Tal simplicidad cualitativa recuerda, por ejemplo, el caso de las series orgánicas, siendo la de los hidrocarburos saturados la más conocida. Recordad que su fórmula general es , lo que significa que una molécula de hidrocarburo contiene n átomos de carbono (símbolo C) y (2n+2) átomos de hidrógeno (símbolo H).

Protones y neutrones determinan el elemento

El número de protones y neutrones determina al elemento, desde el hidrógeno (el más simple), al Uranio (el más complejo), siempre referido a elementos naturales que son 92, el resto, son artificiales, los conocidos transuránicos en cuyo grupo están el Einstenio o el Plutonio, artificiales todos ellos.

Los núcleos, como sistemas dinámicos de nucleones, pertenecen obviamente a la microfísica y, por consiguiente, para su descripción es necesario acudir a la mecánica cuántica. La materia, en general, aunque presumimos de conocerla, en realidad, nos queda mucho por aprender de ella.

Hablemos un poco de moléculas.

El papel primordial del agua en el metabolismo de los seres vivos se debe sus propiedades físicas y químicas, derivadas de la estructura molecular.

El número de especímenes atómicos es finito, existiendo ciertas razones para suponer que hacia el número atómico 173 los correspondientes núcleos serían inestables, no por razones intrínsecas de inestabilidad “radiactiva” nuclear, sino por razones relativistas. Ya antes me referiría a las especies atómicas, naturales y artificiales que son de unos pocos millares; en cambio; el número de moléculas conocidas hasta ahora comprende varios millones de especímenes, aumentando continuamente el número de ellas gracias a las síntesis que se llevan a cabo en numerosos laboratorios repartidos por todo el mundo.

Una molécula es una estructura, con individualidad propia, constituida por núcleos y electrones. Obviamente, en una molécula las interacciones deben tener lugar entre núcleos y electrones, núcleos y núcleos y electrones y electrones, siendo del tipo electromagnético.

Proteína supresora de tumores p53 encajada a una secuencia de ADN

Debido al confinamiento de los núcleos, el papel que desempeñan, aparte del de proporcionar la casi totalidad de la masa de la molécula, es poco relevante, a no ser que se trate de moléculas livianas, como la del hidrógeno. De una manera gráfica podríamos decir que los núcleos en una molécula constituyen el armazón de la misma, el esqueleto, cuya misión sería proporcionar el soporte del edificio. El papel más relevante lo proporcionan los electrones y en particular los llamados de valencia, que son los que de modo mayoritario intervienen en los enlaces, debido a que su energía es comparativamente inferior a la de los demás, lo que desempeña muy importante papel en la evolución.

Desde las moléculas más sencilla, como la del hidrógeno, con un total de 2 electrones, hasta las más complejas, como las de las proteínas, con muchos miles de ellos, existe toda una gama, según decía, de varios millones. Esta extraordinaria variedad de especies moleculares contrasta con la de las especies nucleares e incluso atómicas.

Sin entrar en las posibles diferencias interpretativas de estas notables divergencias, señalaré que, desde el punto de vista de la información, las especies moleculares la poseen en mucho mayor grado que los nucleares y atómicas.

Dejando aparte los núcleos, la información que soportan los átomos se podría atribuir a la distribución de su carga eléctrica, y en particular a la de los electrones más débilmente ligados. Concretando un poco se podría admitir que la citada información la soportan los orbitales atómicos, pues son precisamente estos orbitales las que introducen diferencias “geométricas” entre los diferentes electrones corticales.

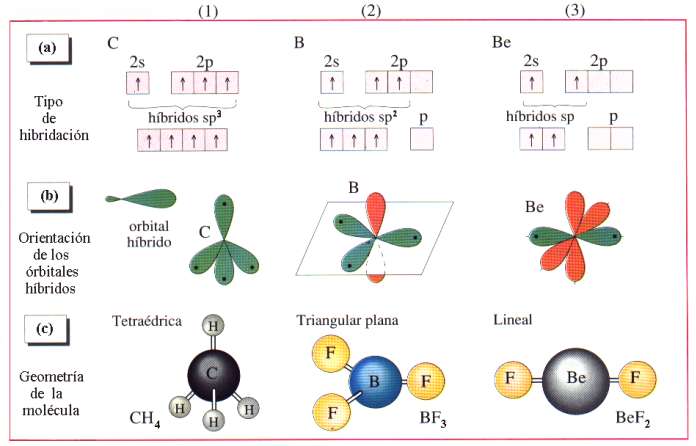

Justamente esa información es la que va a determinar las capacidades de unión de unos átomos con otros, previo el “reconocimiento” entre los orbitales correspondientes. De acuerdo con la mecánica cuántica el número de orbitales se reduce a unos pocos. Se individualizan por unas letras hablándose de orbitales, s, p, d, f, g, h. Este pequeño número nos proporciona una gran diversidad.

La llamada hibridación (una especie de mezcla) de orbitales es un modo de aumentar el número de mensajes, esto es, la información, bien entendido que esta hibridación ocurre en tanto y en cuanto dos átomos se preparan para enlazarse y formar una molécula. En las moléculas, la información, obviamente, debe de abarcar a todo el edificio, por lo que en principio parece que debería ser más rica que en los átomos. La ganancia de información equivale a una disminución de entropía; por esta razón, a la información se la llama también negantropía.

En términos electrónicos, la información se podría considerar proporcionada por un campo de densidad eléctrica, con valles, cimas, collados, etc., es decir, curvas isoelectrónicas, equivalentes formalmente a las de nivel en topografía. Parece razonable suponer que cuanto más diverso sean los átomos de una molécula, más rica y variada podrá ser su información, la información que pueda soportar.

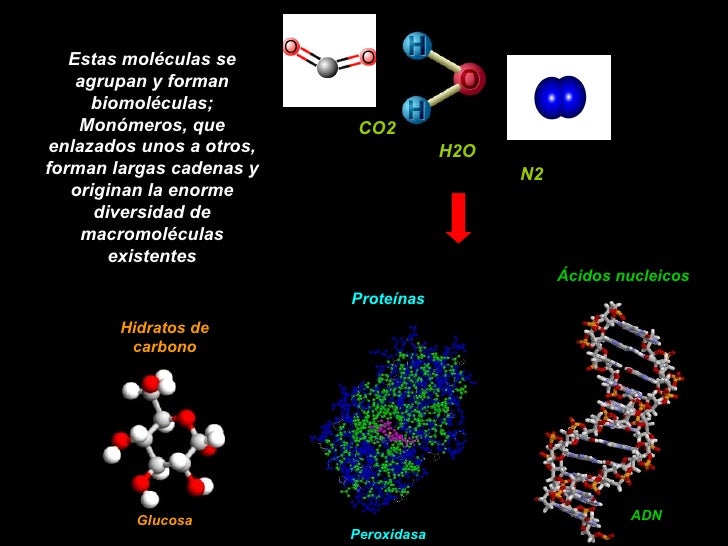

La enorme variedad de formas, colores, comportamientos, etc., que acompaña a los objetos, incluidos los vivientes, sería una consecuencia de la riqueza en la información que soportan las moléculas (y sus agregados) que forman parte de dichos objetos. Ello explicaría que las moléculas de la vida sean en general de grandes dimensiones (macromoléculas). La inmensa mayoría de ellas contiene carbono. Debido a su tetravalencia y a la gran capacidad que posee dicho átomo para unirse consigo mismo, dichas moléculas pueden considerarse como un esqueleto formado por cadenas de esos átomos.

Estas moléculas se agrupan y forman biomoléculas; Monómeros, que enlazados unos a otros, forman largas cadenas y originan la enorme diversidad de macromoléculas existentes CO2 H2O N2 Hidratos de carbono Glucosa Peroxidasa.

El carbono no es el único átomo con capacidad para formar los citados esqueletos. Próximos al carbono en la tabla periódica, el silicio, fósforo y boro comparten con dicho átomo esa característica, si bien en un grado mucho menor.

Refiriéndonos al silicio, que para nosotros es el más importante, señalaremos que las “moléculas” que dicho átomo forma con el oxígeno y otros átomos, generalmente metálicos, poseyendo gran nivel de información, difieren, en varios aspectos, de las moléculas orgánicas, es decir, de las que poseen un esqueleto de átomos de carbono.

![]()

Las cadenas resultantes, polidimetildioxano, pueden ser lineales o ramificadas. La longitud de las cadenas puede varias desde unas pocas unidades hasta …

Los compuestos formados solo por carbono e hidrógeno se conocen como hidrocarburos, y estructuralmente son el tipo más simple de moléculas orgánicas.

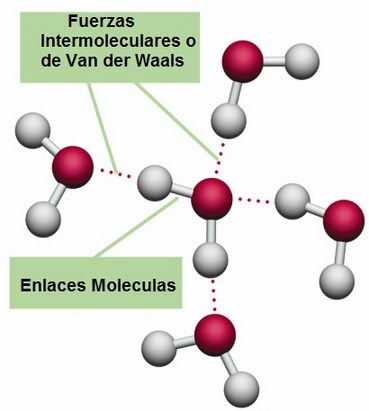

El mundo de los silicatos es de una gran diversidad, existiendo centenares de especies minerológicas. Esas diferencias se refieren, fundamentalmente, a que el enlace químico en el caso de las moléculas orgánicas es covalente, y cuando se forma la sustancia correspondiente (cuatrillones de moléculas) o es un líquido, como es el caso de los aceites, o bien un sólido que funde fácilmente. Entre las moléculas que lo forman se ejercen unas fuerzas, llamadas de van der Waals, que, pueden considerarse como residuales de las fuerzas electromagnéticas, algo más débiles que éstas. En cambio, en los silicatos sólidos (como en el caso del topacio) el enlace covalente o iónico no se limita a una molécula, sino que se extiende en el espacio ocupado por el sólido, resultando un entramado particularmente fuerte.

Al igual que para los cristales de hielo, en la mayoría de los silicatos la información que soportan es pequeña, aunque conviene matizar este punto. Para un cristal ideal así sería en efecto, pero ocurre que en la realidad el cristal ideal es una abstracción, ya que en el cristal real existen aquí y allá los llamados defectos puntuales que trastocan la periodicidad espacial propia de las redes ideales. Precisamente esos defectos puntuales podían proporcionar una mayor información.

Las moléculas orgánicas con enlaces dobles ó triples tienen también formas características.

Si prescindimos de las orgánicas, el resto de las moléculas que resultan de la combinación entre los diferentes átomos no llega a 100.000, frente a los varios millones de las primeras. Resulta ranozable suponer que toda la enorme variedad de moléculas existentes, principalmente en los planetas rocosos, se haya formado por evolución de los átomos, como corresponde a un proceso evolutivo. La molécula poseería mayor orden que los átomos de donde procede, esto es, menor entropía. En su formación, el ambiente se habría desordenado al ganar entropía en una cierta cantidad tal, que arrojarse un balance total positivo.

No puedo, dejar pasar la oportunidad, aunque sea de pasada, de mencionar las sustancias.

Tipos de energía que se almacena en moléculas orgánicas

Las así llamadas, son cuerpos formados por moléculas idénticas, entra las cuales pueden o no existir enlaces químicos. Veremos varios ejemplos. Las sustancias como el oxígeno, cloro, metano, amoníaco, etc., se presentan en estado gaseoso en condiciones ordinarias de presión y temperatura. Para su confinamiento se embotellan, aunque existen casos en que se encuentran mezcladas en el aire (os podéis dar una vueltecita por el Polo químico de Huelva).

En cualquier caso, un gas como los citados consiste en un enjambre de las moléculas correspondientes. Entre ellas no se ejercen fuerzas, salvo cuando colisionan, lo que hacen con una frecuencia que depende de la concentración, es decir, del número de ellas que están concentradas en la unidad de volumen; número que podemos calcular conociendo la presión y temperatura de la masa de gas confinada en un volumen conocido.

Decía que no existen fuerzas entre las moléculas de un gas. En realidad, es más exacto que el valor de esas fuerzas es insignificante porque las fuerzas residuales de las electromagnéticas, a las que antes me referí, disminuyen más rápidamente con la distancia que las fuerzas de Coulomb; y esta distancia es ordinariamente de varios diámetros moleculares.

Podemos conseguir que la intensidad de esas fuerzas aumente tratando de disminuir la distancia media entre las moléculas. Esto se puede lograr haciendo descender la temperatura, aumentando la presión o ambas cosas. Alcanzada una determinada temperatura, las moléculas comienzan a sentir las fuerzas de Van der Waals y aparece el estado líquido; si se sigue enfriando aparece el sólido. El orden crece desde el gas al líquido, siendo el sólido el más ordenado. Se trata de una red tridimensional en la que los nudos o vértices del entramado están ocupados por moléculas.

Todas las sustancias conocidas pueden presentarse en cualquiera de los tres estados de la materia (estados ordinarios y cotidianos en nuestras vidas del día a día).

Si las temperaturas reinantes, como decíamos en páginas anteriores, es de miles de millones de grados, el estado de la materia es el plasma, el material más común del Universo, el de las estrellas (aparte de la materia oscura, que no sabemos ni lo que es, ni donde está, ni que “estado” es el suyo).

En condiciones ordinarias de presión, la temperatura por debajo de la cual existe el líquido y/o sólido depende del tipo de sustancia. Se denomina temperatura de ebullición o fusión la que corresponde a los sucesivos equilibrios(a presión dada) de fases: vapor <-> líquido <-> sólido. Estas temperaturas son muy variadas. Por ejemplo, para los gases nobles son muy bajas; también para el oxígeno (O2) e hidrógeno (H2). En cambio, la mayoría de las sustancias son sólidos en condiciones ordinarias (grasas, ceras, etc.)

Las sustancias pueden ser simples y compuestas, según que la molécula correspondiente tenga átomos iguales o diferentes. El número de las primeras es enormemente inferior al de las segundas.

El concepto de molécula, como individuo-físico y químico, pierde su significado en ciertas sustancias que no hemos considerado aun. Entre ellas figuran las llamadas sales, el paradigma de las cuales es la sal de cocina. Se trata de cloruro de sodio, por lo que cualquier estudiante de E.G.B. escribiría sin titubear, su fórmula: Cl Na. Sin embargo, le podríamos poner en un aprieto si le preguntásemos donde se puede encontrar aisladamente individuos moleculares que respondan a esa composición. Le podemos orientar diciéndole que en el gas Cl H o en el vapor de agua existen moléculas como individualidades. En realidad y salvo casos especiales, por ejemplo, a temperaturas elevadas, no existen moléculas aisladas de sal, sino una especie de molécula gigante que se extiende por todo el cristal. Este edificio de cristal de sal consiste en una red o entramado, como un tablero de ajedrez de tres dimensiones, en cuyos nudos o vértices se encuentran, alternativamente, las constituyentes, que no son los átomos de Cl y Na sino los iones Cl– y Na+. El primero es un átomo de Cl que ha ganado un electrón, completándose todos los orbitales de valencia; el segundo, un átomo de Na que ha perdido el electrón del orbital s.

Cuando los átomos de Cl y Na interaccionan por aproximarse suficientemente sus nubes electrónicas, existe un reajuste de cargas, porque el núcleo de Cl atrae con más fuerza los electrones que el de Na, así uno pierde un electrón que gana el otro. El resultado es que, la colectividad de átomos se transforma en colectividad de iones, positivos los de Na y negativos los de Cl. Las fuerzas electromagnéticas entre esos iones determinan su ordenación en un cristal, el ClNa. Por consiguiente, en los nudos de la red existen, de manera alternativa, iones de Na e iones de Cl, resultando una red mucho más fuerte que en el caso de que las fuerzas actuantes fueran de Van der Waals. Por ello, las sales poseen puntos de fusión elevados en relación con los de las redes moleculares.

Hablemos de cuerpos.

Me referiré en primer lugar a los que constituyen nuestro entorno ordinario, que sería todo el entorno que abarca nuestro planeta. En segundo lugar considerare los demás cuerpos y objetos del Universo. El análisis de muestras de esos diversos cuerpos ha puesto de manifiesto que, en función de la composición, los cuerpos pueden ser simples y compuestos. Los primeros son, precisamente, los llamados elementos químicos, a las que el insigne Lavoisier (conocido como padre de la Química), consideró como el último término a que se llega mediante la aplicación del análisis químico.

Hoy sabemos que son colectividades de átomos isotópicos.

La mayoría de ellos son sólidos y se encuentran en la Naturaleza (nuestro entorno terráqueo) en estado libre o en combinación química con otros elementos, formando los diversos minerales.

La ordenación de los iones en las redes se manifiesta externamente en multitud de formas y colores. No obstante, debo señalar que, aun siendo abundante esta variedad, no es tan rica como la que corresponde a los cuerpos vivos, tanto animales como vegetales. La explicación se basa en que el número de especímenes moleculares y su complejidad son mucho mayores que en el reino inorgánico

Químico inorgánico a todos aquellos compuesto que están formados por distintos elementos, pero en los que su componente principal no siempre es el carbono, siendo el agua el más abundante. En los compuestos inorgánicos se podría decir que participan casi la totalidad de elementos conocidos. Mientras que un compuesto orgánico se forma de manera natural tanto en animales como en vegetales.

Los minerales son sustancias químicas esenciales para el organismo humano que se encuentran en la naturaleza. Los podemos obtener principalmente de las plantas, (que a su vez los toman de la tierra) y del agua que bebemos.

Nuestro organismo es incapaz de sintetizarlos, por lo que debemos ingerirlos a través de la dieta diaria.

Como me pasa a veces, me desvío del tema principal, aquí lo dejamos por hoy.

emilio silvera

Nov

14

¡Las estrellas! Mucho más que puntitos brillantes en el cielo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (10)

Comments (10)

“¿Está el Corazón y el Alma de nuestra Galaxia localizadas en Casiopeia? Posiblemente no, pero ahí es donde dos brillantes nebulosa de emisión apodadas Corazón y Alma descansan. La Nebulosa del Corazón, oficialmente catalogada como IC 1805 y visible en la parte superior derecha, tiene una forma en luz visible que nos recuerda a un clásico símbolo de un corazón. La imagen de arriba, sin embargo , fue realizada en luz infrarroja por el recientemente lanzado telescopio WISE. La luz infrarroja penetra bien dentro de las enormes y complejas burbujas creadas por la formación estelar en el interior de estas dos regiones de formación de estrellas.

Los estudios de estrellas y polvo como éstos encontrados en las Nebulosas Corazón y Alma se han focalizado en cómo se forman las estrellas masivas y cómo les afecta su entorno. La luz tarda unos 6.000 años en llegarnos desde estas nebulosas, que juntas abarcan unos 300 años luz.” (APOD)

Ubicadas en el brazo de Perseo de nuestra galaxia, la nebulosa Corazón (derecha) y la nebulosa Alma (izquierda) son muy brillantes (a pesar de eso es necesario un telescopio para verlas) en una region de la galaxia donde muchas estrellas se están formando. IC 1805 (la nebulosa Corazón) es a menudo llamada también como la nebulosa del Perro Corriendo, debido obviamente a la apariencia de la nebulosa vista desde un telescopio.

Es curioso que, mirando en la oscura noche como brillan las estrellas del cielo, nos atrae su titilar engañoso (es la atmósfera terrestre la que hace que lo parezca) y su brillo, Sin embargo, pocos llegan a pensar en lo que verdaderamente está allí ocurriendo. Las transformaciones de fase por fusión no cesan. Esta transformación de materia en energía es consecuencia de la equivalencia materia-energía, enunciada por Albert Einstein en su famosa fórmula E=mc2; donde E es la energía resultante, m es la masa transformada en energía, y c es la velocidad de la luz (300 000 kilómetros por segundo). La cantidad de energía que se libera en los procesos de fusión termonuclear es fabulosa. Un gramo de materia transformado íntegramente en energía bastaría para satisfacer los requerimientos energéticos de una familia mediana durante miles de años.

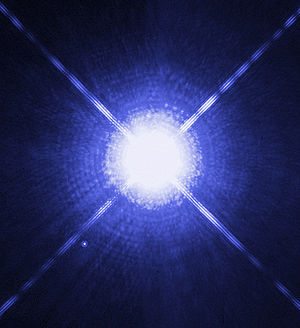

Imagen de Sirio A (estrella grande) y Sirio B (estrella pequeña abajo a la izquierda) tomadas por el Telescopio Hubble (Créd. NASA). Sirio es la quinta estrella más cercana y tiene una edad de 300, millones de años. Es una estrella blanca de la secuencia principal de tipo espectral A1V con temperatura superficial de 10 000 K y situada a 8,6 años luz de la Tierra. Es una estrella binaria y, de ella, podríamos contar muchas historias. La estrella fue importante en las vidas de Civilizaciones pasadas como, por ejemplo, la egipcia.

Lo que conocemos como estrella es una bola de gas luminosa que, durante una etapa de su vida, produce energía por la fusión nuclear del hidrógeno en helio. El término estrella, por tanto, no sólo incluye estrellas como el Sol, que están en la actualidad quemando hidrógeno, sino también protoestrellas, aún en formación y no lo suficientemente calientes como para que dicha combustión nuclear haya comenzado, y también varios tipos de objetos más evolucionados como estrellas gigantes y supergigantes, que están quemando otros combustibles nucleares, o las enanas blancas y las estrellas nucleares, que están formadas por combustible nuclear gastado.

Seguimos en la Nebulosa del Corazón (otra región)

Las estrellas se forman a partir de enormes nubes de gas y polvo que a veces tienen hasta años-luz de diámetro. Las moléculas de polvo, unidas a las de los gases, se rozan y se ionizan, se calientan y la nube comienza a girar lentamente. El enorme conglomerado, poco a poco se va juntando y la temperatura aumenta. Tal enormidad de materia crea una fuerza gravitatoria que hace contraerse la nube sobre sí misma; su diámetro y su temperatura en el núcleo es tal que se produce la fusión de los protones de hidrógeno que se transforman en un material más complejo, el helio, y ese es el momento en que nace la estrella que, a partir de ahí, puede estar miles de millones de años brillando y produciendo energía termonuclear.

La masa máxima de las estrellas puede rondar las 120 masas solares, es decir, ser 120 veces mayor que nuestro Sol, y por encima de este límite sería destruida por la enorme potencia de su propia radiación. La masa mínima para poder ser una estrella se fija en 0’08 masas solares; por debajo de ella, los objetos no serían lo suficientemente calientes en sus núcleos como para que comience la combustión del hidrógeno y se convertirían en enanas marrones. Las luminosidades de las estrellas varían desde alrededor de medio millón de veces la luminosidad del Sol para las más calientes hasta menos de la milésima de la del Sol para las enanas más débiles. Aunque las estrellas más prominentes visibles a simple vista son más luminosas que el Sol, la mayoría de las estrellas son en realidad más débiles que éste y, por tanto, imperceptibles a simple vista.

* La estrella Sirio es la más brillante y tiene el doble de tamaño que nuestro Sol

Eta Carinae (NGC 3372) tiene 400 veces el diámetro del Sol, se encuentra inmersa en esa Nebulosa que la esconde dentro de grandes “montañas” de gas y el polvo.Eta Carinae es una estrella del tipo variable luminosa azul hipermasiva, situada en la constelación de la Quilla. Su masa está en el límite y oscila entre 100 y 150 veces la masa del Sol. lo que la convierte en una de las estrellas más masivas conocidas en nuestra Galaxia. Asimismo, posee una altísima luminosidad, de alrededor de cuatro millones de veces la del Sol. debido a la gran cantidad de polvo existente a su alrededor, Eta Carinae irradia el 99% de su luminosidad en la parte infrarroja del espectro. lo que la convierte en el objeto más brillante del cielo en el intervalo de longitudes de ondas entre 10 y 20 μm (la millonésima parte de un metro).

* Betelgeuse tiene 1.000 veces el díámetro de nuestro Sol

Pero la estrella más grande conocida es:

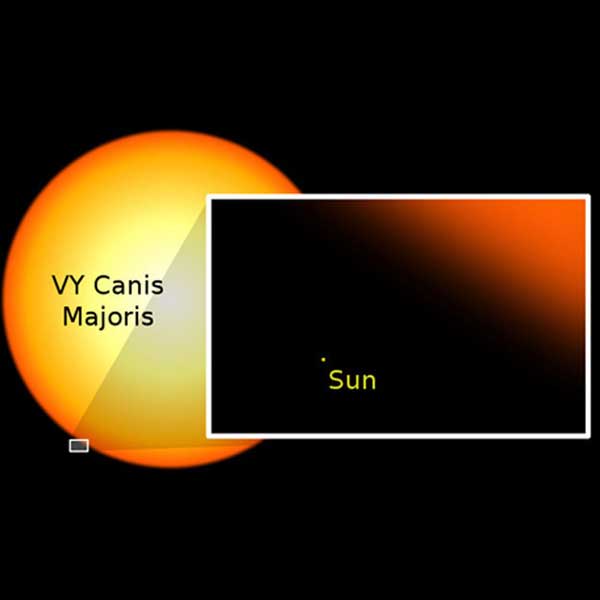

VY Canis Majoris, supergigante roja que es aproximadamente 2.100 veces más grande que nuestro Sol.

El brillo de las estrellas (la luz y el calor) es el resultado de la conversión de masa en energía (E = mc2), por medio de reacciones nucleares, las enormes temperaturas de millones de grados de su núcleo, hace posible que los protones de los átomos del hidrógeno se fusionen y se conviertan en átomos de helio. Por cada kilogramo de hidrógeno quemado de esta manera, se convierten en energía aproximadamente siete gramos de masa. De acuerdo con la famosa ecuación de Einstein (arriba reseñada), los siete gramos equivalen a una energía de 6’3 × 1014 julios. Las reacciones nucleares no sólo aportan la luz y el calor de las estrellas, sino que también producen elementos pesados, más complejos que el hidrógeno y el helio que, posteriormente, son distribuidos por el universo, cuando al final de la estrella, esta explota en supernova, lanzando sus capas exteriores al espacio que de esta forma, deja “sembrado” de estos materiales el “vacío” estelar.

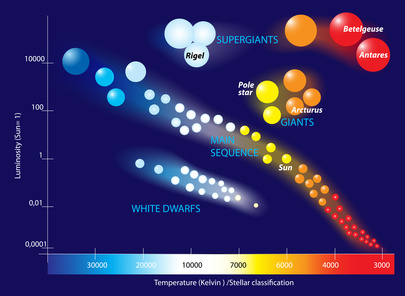

Las estrellas pueden clasificarse de muchas maneras. Una manera es mediante su etapa evolutiva: en presecuencia principal, secuencia principal, gigante, supergigante, enana blanca, estrella de neutrones y agujeros negros. Estas últimas son la consecuencia del final de sus vidas como tales estrellas, convirtiéndose en objetos estelares de una u otra clase en función de sus masas originales. Estrellas como nuestro Sol, al agotar el combustible nuclear se transforman en gigantes rojas, explotan en novas y finalmente quedan como enanas blancas. Si la masa es mayor serán estrellas de neutrones, y si aún son mayores, su final está en agujeros negros.

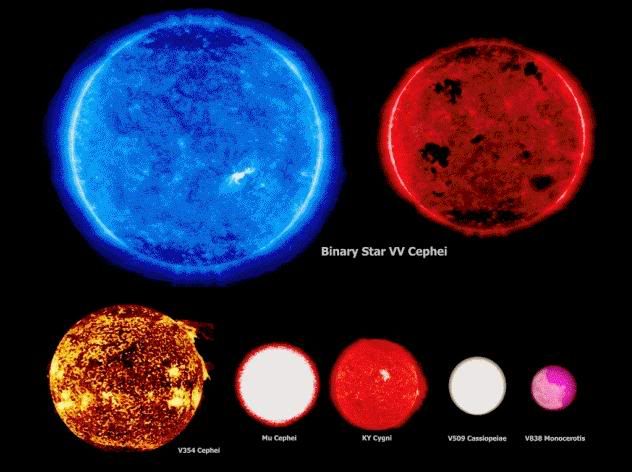

Nuestro Sol, nos parece un objeto enorme, grandioso que, es capaz, con su actividad de enviar a la Tierra luz y calor (radiación) para que podamos vivir los seres que la pueblan. Sin embargo, a pesar de su “grandeza”, la comparamos con otros objetos celestes y, desde luego, nos podemos quedar asombrados de que puedan existir cosas tan grandes como VY Canis Majoris. Podéis observar en ellas su tamaño en comparación con nuestro Sol.

El Color de las estrellas indican de qué materiales están conformadas y, así se compruena mediante el estudio de sus espectros.

- Color azul, como la estrella I Cephei

- Color blanco-azul, como la estrella Spica

- Color blanco, como la estrella Vega

- Color blanco-amarillo, como la estrella Proción

- Color amarillo, como el Sol

- Color naranja, como Arcturus

- Color rojo, como la estrella Betelgeuse.

Otra clasificación es a partir de sus espectros, que indican su temperatura superficial. También por el color. Otra manera es en poblaciones I, II y III, que engloban estrellas con abundancias progresivamente menores de elementos pesados, indicando paulatinamente una mayor edad. También evolución estelar y magnitudes aparentes y absolutas y el tipo espectral con la distancia en a. L., es otra de las clasificaciones.

Después de estas clasificaciones genéricas tenemos otras mas particulares y definidas referidas a estrellas binarias, estrellas capullo, con baja velocidad, con envoltura, con exceso de ultravioleta, de alta velocidad, de baja luminosidad, de baja masa, de bario, de bariones, de campo, de carbono, de circonio, de estroncio, de helio, estrella de la población I extrema, de la población intermedia, de la rama gigante asintótica, estrella de litio, de manganeso, de manganeso-mercurio y, viceversa, estrella de metales pesados, de neutrones, estrellas de quarks (hipotética con densidad intermedia entre la estrella de neutrones y el agujero negro), estrella de referencia, de silicio, de tecnecio, de tiempo intermedio, de tipo tardío, de tipo temprano, estrella del polo, estrella doble, estrella enana, estándar, evolucionada, etc.

La luz proveniente de la superficie caliente del Sol pasa a través de la atmósfera solar más fría, es absorbida en parte, por eso llega a nosotros presentando las características líneas oscuras en su espectro. Las líneas oscuras del espectro del sol coinciden con líneas de los espectros de algunos elementos y revelan la presencia de estos elementos en la superficie solar. Las longitudes de onda de las radiaciones se indican en nanometros (nm).

El Sol

De qué está hecho el Sol

La posición e intensidad de las líneas oscuras del espectro solar han permitido establecer que casi las tres cuartas partes de la masa del Sol son hidrógeno, el elemento más simple. Casi todo el resto es helio, el segundo elemento más simple. En suma, entre hidrógeno y helio suman alrededor del 98 por ciento de la masa solar. El 2% restante está compuesto, aproximadamente, por la siguiente proporción de elementos: 0,8% de oxígeno, 0,6% de carbono, 0,2% de neón, 0,15% de nitrógeno, 0,05% de magnesio, y, en menor porcentaje aún, hierro, sodio y silicio.

La composición química de una estrella varía según la generación a la que pertenezca. Cuánto más antigua sea, más baja será su metalicidad. Al inicio de su vida una estrella similar al Sol contiene aproximadamente 75% de hidrógeno y 23% de helio. El 2% restante lo forman elementos más pesados, aportados por estrellas que finalizaron su ciclo antes que ella. Estos porcentajes son en masa; en volumen, la relación es 90% de hidrógeno y 10% de helio.

En la Vía Láctea las estrellas se clasifican según su riqueza en metales en dos grandes grupos. Las que tienen una cierta abundancia se denominan de la población I, mientras que las estrellas pobres en metales forman parte de la población II. Normalmente la metalicidad está directamente relacionada con la edad de la estrella. A más elementos pesados, más joven es la estrella.