Dic

22

¡Qué cosas!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Cosas que pasan ~

Clasificado en Cosas que pasan ~

Comments (5)

Comments (5)

Dic

22

¿La Mecçanica Cuántica? ¡Una gran Disciplina!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

Universo, Ciencia, Consciencia…¡Futuro!

El “principio antrópico”

¿Estaría programada la presencia de los seres vivos inteligentes en el Universo?

Por fuerza la cosmología conduce a cuestiones fronterizas entre ciencia experimental, filosofía y religión. No es solo el caso de los sabios antiguos. También los físicos de hoy se plantean preguntas de esa clase, sobre todo a propósito del llamado “principio antrópico”. A partir de los conocimientos actuales, este principio señala que las leyes y magnitudes físicas fundamentales parecen cuidadosamente afinadas para que la formación y el desarrollo del universo pudieran dar lugar a la vida en la Tierra y en otros planetas idóneos para acogerla.

El universo de las partículas es fascinante. Cuando las partículas primarias chocan con átomos y moléculas en el aire, aplastan sus núcleos y producen toda clase de partículas secundarias. En esta radiación secundaria (aún muy energética) la que detectamos cerca de la Tierra, por los globos enviados a la atmósfera superior, han registrado la radiación primaria. Esa radiación, al chocar con los elementos que envuelven nuestro planeta y su atmósfera, en algunos lugares de la Tierra producen las fascinantes auroras boreales y australes.

Esta espectacular aurora boreal fue captada sobre la aldea de Ersfjordbotn cerca de Tromso, en el norte de Noruega, en el amanecer del 21 de febrero. Las auroras son causadas por la interacción entre las partículas energéticas cargadas del Sol y las moléculas de gas en la atmósfera superior de la Tierra, a unos 100 kilómetros de altura.El viento solar exhalado por el sol con especial volumen hace poco a una velocidad de aproximadamente 500 kilómetros por segundo colaboró en la espectacularidad en este caso.

Al llegar a la Tierra, las partículas cargadas son atraídas por el campo magnético terrestre en los polos, donde chocan con las moléculas de gas en la atmósfera superior, haciendo que emitan luz.

El físico estadounidense Robert Andrews Millikan, que recogió una gran cantidad de información acerca de esta radiación (y que le dio el nombre de rayos cósmicos), decidió que debería haber una clase de radiación electromagnética. Su poder de penetración era tal que, parte del mismo, atravesaba muchos centímetros de plomo. Para Millikan, esto sugería que la radiación se parecía a la de los penetrantes rayos gamma, pero con una longitud de onda más corta.

Otros, sobre todo el físico norteamericano Holly Compton, no estaban de acuerdo en que los rayos cósmicos fuesen partículas. Había un medio para investigar este asunto; si se trataba de partículas cargadas, deberían ser rechazadas por el campo magnético de la Tierra al aproximarse a nuestro planeta desde el espacio exterior. Compton estudió las mediciones de la radiación cósmica en varias latitudes y descubrió que en realidad se curvaban con el campo magnético: era más débil cerca del ecuador magnético y más fuerte cerca de los polos, donde las líneas de fuerza magnética se hundían más en la Tierra.

rayos cósmicos contra las células cuando se producen grandes erupciones solares

Las partículas cósmicas primarias, cuando entran en nuestra atmósfera, llevan consigo unas energías fantásticas, muy elevadas. En general, cuanto más pesado es el núcleo, más raro resulta entre las partículas cósmicas. Núcleos tan complejos como los que forman los átomos de hierro se detectaron con rapidez; en 1.968, otros núcleos como el del uranio. Los núcleos de uranio constituyen sólo una partícula entre 10 millones. También se incluirán aquí electrones de muy elevada energía.

Ahora bien, la siguiente partícula inédita (después del neutrón) se descubrió en los rayos cósmicos. A decir verdad, cierto físico teórico había predicho ya este descubrimiento. Paul Adrien Dirac había aducido, fundándose en un análisis matemático de las propiedades inherentes a las partículas subatómicas, que cada partícula debería tener su antipartícula (los científicos desean no sólo que la naturaleza sea simple, sino también simétrica). Así pues, debería haber un antielectrón, salvo por su carga que sería positiva y no negativa, idéntico al electrón; y un antiprotón, con carga negativa en vez de positiva.

En 1.930, cuando Dirac expuso su teoría, no llamó demasiado la atención en el mundo de la ciencia. Pero, fiel a la cita, dos años después apareció el antielectrón. Por entonces, el físico americano Carl David Anderson trabajaba con Millikan en un intento por averiguar si los rayos cósmicos eran radiación electromagnética o partículas. Por aquellas fechas, casi todo el mundo estaba dispuesto a aceptar las pruebas presentadas por Compton, según las cuales, se trataría de partículas cargadas; pero Millikan no acababa de darse por satisfecho con tal solución.

Arriba una imagen que ilustra a la Heliosfera, la parte del espacio que está directamente afectada por el Sol a través del viento solar. Es la estructura magnética del viento solar quien hace de escudo contra las enérgicas partículas de los rayos cósmicos. Las variaciones en el viento solar (o en la actividad solar) cambia el flujo de los rayos cósmicos que llegan hasta la Tierra.

Anderson se propuso averiguar si los rayos cósmicos que penetraban en una cámara de ionización se curvaban bajo la acción de un potente campo magnético. Al objeto de frenar dichos rayos lo suficiente como para detectar la curvatura, si la había, puso en la cámara una barrera de plomo de 6’35 mm de espesor. Descubrió que, cuando cruzaba el plomo, la radiación cósmica trazaba una estela curva a través de la cámara; y descubrió algo más. A su paso por el plomo, los rayos cósmicos energéticos arrancaban partículas de los átomos de plomo. Una de esas partículas dejó una estela similar a la del electrón. ¡Allí estaba, pues, el antielectrón de Dirac! Anderson le dio el nombre de positrón. Tenemos aquí un ejemplo de radiación secundaria producida por rayos cósmicos. Pero aún había más, pues en 1.963 se descubrió que los positrones figuraban también entre las radiaciones primarias.

Abandonado a sus propios medios, el positrón es tan estable como el electrón (¿y por qué no habría de serlo si el idéntico al electrón, excepto en su carga eléctrica?). Además, su existencia puede ser indefinida. Ahora bien, en realidad no queda abandonado nunca a sus propios medios, ya que se mueve en un universo repleto de electrones. Apenas inicia su veloz carrera (cuya duración ronda la millonésima de segundo), se encuentra ya con uno.

Primer Congreso Solvay (1911), financiado por el “rey de la sosa cáustica”, el belga Ernest Solvay y en el que tomaron parte todas las luminarias de la ciencia. Nernst, Poincaré, Langevin, Rutherford, Lorentz, Planck y Marie Curie están en primera fila de la fotografía y no es difícil reconocer a Einstein junto a ellos. Terminado el Congreso, Marie relató a Louis de Broglie los debates sobre el fotón y su naturaleza dual, de onda y partícula. De Broglie, ante los resultados de Compton, se preguntaba en la tesis doctoral que presentó en 1924 si acaso la inversa del efecto Compton sería cierta: si las ondas son partículas ¿no serán ondas las partículas? Al recibir el premio Nobel en 1929, Louis de Broglie diría: “Para ambas, materia y radiación, la luz en especial, es necesario introducir los conceptos de partícula y de onda a la vez. En otras palabras, se tiene que suponer siempre la existencia de partículas acompañadas por ondas.”

Así, durante un momento relampagueante quedaron asociados el electrón y el positrón; ambas partículas girarán en torno a un centro de fuerza común. En 1.945, el físico americano Arthur Edwed Ruark sugirió que se diera el nombre de positronio a este sistema de dos partículas, y en 1.951, el físico americano de origen austriaco Martin Deutsch consiguió detectarlo guiándose por los rayos gamma característicos del conjunto.

Pero no nos confundamos, aunque se forme un sistema positronio, su existencia durará, como máximo, una diezmillonésima de segundo. El encuentro del electrón-positrón provoca un aniquilamiento mutuo; sólo queda energía en forma de radiación gamma. Ocurre pues, tal como había sugerido Einstein: la materia puede convertirse en energía y viceversa. Por cierto, que Anderson consiguió detectar muy pronto el fenómeno inverso: desaparición súbita de rayos gamma para dar origen a una pareja electrón-positrón. Este fenómeno se llama producción en pareja. Anderson compartió con Hess el premio Nobel de Física de 1.936.

1936. Victor Franz Hess & Carl David Anderson

Poco después, los Joliot-Curie detectaron el positrón por otros medios, y al hacerlo así realizaron, de paso, un importante descubrimiento. Al bombardear los átomos de aluminio con partículas alfa, descubrieron que con tal sistema no sólo se obtenían protones, sino también positrones. Cuando suspendieron el bombardeo, el aluminio siguió emitiendo positrones, emisión que sólo con el tiempo se debilitó. Aparentemente habían creado, sin proponérselo, una nueva sustancia radiactiva. He aquí la interpretación de lo ocurrido según los Joliot-Curie: cuando un núcleo de aluminio absorbe una partícula alfa, la adición de los dos protones transforma el aluminio (número atómico 13) en fósforo (número atómico 15). Puesto que las partículas alfa contienen cuatro nucleones en total, el número masivo se eleva 4 unidades, es decir, del aluminio 27 al fósforo 31. Ahora bien, si al reaccionar se expulsa un protón de ese núcleo, la reducción en una unidad de sus números atómicos y masivos hará surgir otro elemento, o sea, el silicio 30.

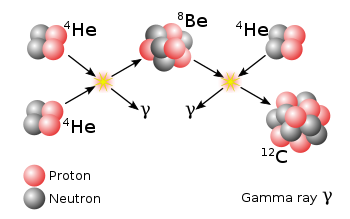

Arriba teneis el proceso conocido como triple alfa: Una maravilla de la que se vale la Naturaleza para fabricar el Carbono en las estrellas.

Puesto que la partícula alfa es el núcleo del helio, y un protón es el núcleo del hidrógeno, podemos escribir la siguiente ecuación de esta reacción nuclear:

aluminio 27 + helio 4 = silicio 30 + hidrógeno 1

Nótese que los números másicos se equilibran:

27 + 4 = 30 + 1

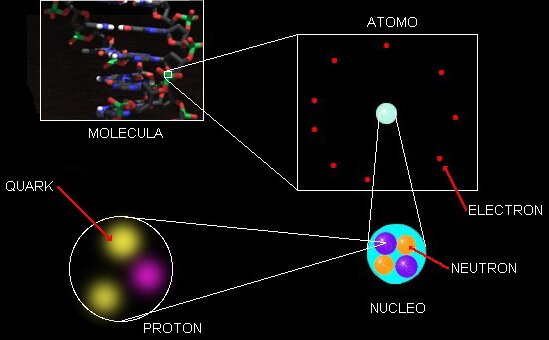

Adentrarse en el universo de las partículas que componen los elementos de la tabla periódica, y en definitiva, la materia conocida, es verdaderamente fantástico.

Joliot – Curie

Tan pronto como los Joliot-Curie crearon el primer isótopo radiactivo artificial, los físicos se lanzaron en tropel a producir tribus enteras de ellas. En realidad, las variedades radiactivas de cada elemento en la tabla periódica son producto de laboratorio. En la moderna tabla periódica, cada elemento es una familia con miembros estables e inestables, algunos procedentes de la naturaleza, otros sólo del laboratorio. Por ejemplo, el hidrógeno presenta tres variedades: en primer lugar, el corriente, que tienen un solo protón. En 1.932, el químico Harold Urey logró aislar el segundo. Lo consiguió sometiendo a lenta evaporación una gran cantidad de agua, de acuerdo con la teoría de que los residuos representarían una concentración de la forma más pesada del hidrógeno que se conocía, y, en efecto, cuando se examinaron al espectroscopio las últimas gotas de agua no evaporadas, se descubrió en el espectro una leve línea cuya posición matemática revelaba la presencia de hidrógeno pesado.

Núcleos de hidrógeno pesado. … También como “hidrógeno pesado”. El deuterio es un combustible fundamental de las estrellas, durante la fusión nuclear dos núcleos de deuterio se …

El núcleo de hidrógeno pesado está constituido por un protón y un neutrón. Como tiene un número másico de 2, el isótopo es hidrógeno. Urey llamó a este átomo deuterio (de la voz griega deutoros, “segundo”), y el núcleo deuterón. Una molécula de agua que contenga deuterio se denomina agua pesada, que tiene puntos de ebullición y congelación superiores al agua ordinaria, ya que la masa del deuterio es dos veces mayor que la del hidrógeno corriente. Mientras que ésta hierve a 100º C y se congela a 0º C, el agua pesada hierve a 101’42º C y se congela a 3’79º C. El punto de ebullición del deuterio es de -23’7º K, frente a los 20’4º K del hidrógeno corriente. El deuterio se presenta en la naturaleza en la proporción de una parte por cada 6.000 partes de hidrógeno corriente. En 1.934 se otorgó a Urey el premio Nobel de Química por su descubrimiento del deuterio.

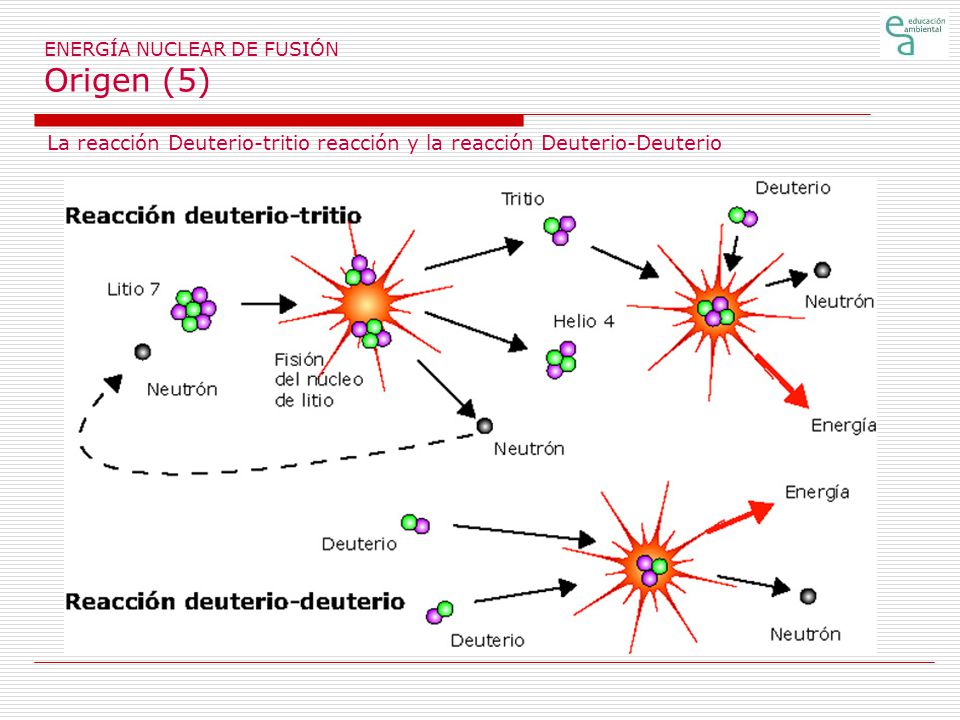

Reacciones de fusión nuclear

Reacciones de deuterio – tritio:

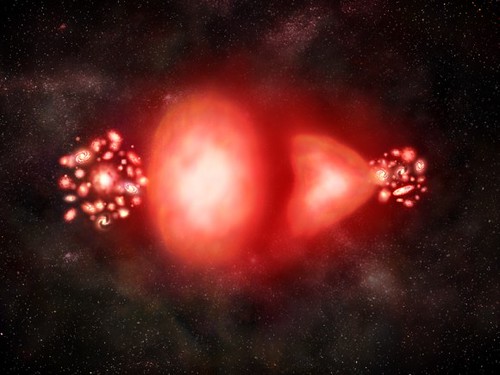

Esta es una de las dos reacciones de fusión nuclear más básicas que se conocen: en ella intervienen como reactivos un núcleo de deuterio (D) y uno de tritio (T). Si dichos reactivos se aproximan entre sí a velocidades adecuadas, se unen formando un núcleo compuesto (centro), que es inestable y se desintegra rápidamente produciendo un núcleo de helio (He) y un neutrón. El proceso de formación del núcleo compuesto se denomina fusión nuclear (de deuterio y tritio en el caso que estamos considerando). El tritio es radioactivo, el deuterio no. Esta es una de las dos reacciones de fusión nuclear más básicas que se conocen: en ella intervienen como reactivos un núcleo de deuterio.

El deuterio resultó ser una partícula muy valiosa para bombardear los núcleos. En 1934, el físico australiano Marcus Lawrence Edwin Oliphant y el austriaco P. Harteck atacaron el deuterio con deuterones y produjeron una tercera forma de hidrógeno, constituido por un protón y dos neutrones. La reacción se planteó así:

hidrógeno 2 + hidrógeno 2 = hidrógeno 3 + hidrógeno 1

Este nuevo hidrógeno superpesado se denominó tritio (del griego tritos, “tercero”); su ebullición a 25º K y su fusión a 20’5º K.

Reacciones de deuterio – deuterio:

En ella, dos núcleos de deuterio se fusionan formando un núcleo compuesto inestable (centro) que rápidamente decae siguiendo uno de dos posibles caminos: el ilustrado en la parte superior, que produce un núcleo de helio y un neutrón; y el indicado en la parte de abajo, donde se produce un núcleo de tritio y un protón. El camino que seguirá el núcleo compuesto para decaer, es impredecible con exactitud. Sólo puede afirmarse que el 50% de las veces, la naturaleza sigue el de arriba, y el 50% restante, el de abajo.

Reactor de fusión Tokamaka

Instalaciones donde se produce la fusión nuclear: Lograr fusión nuclear en la Tierra es complicado: se requieren reactores especiales.

Como es mi costumbre, me desvío del tema y sin poderlo evitar, mis ideas (que parecen tener vida propia), cogen los caminos más diversos. Basta con que se cruce en el camino del trabajo que realizo un fugaz recuerdo; lo sigo y me lleva a destinos distintos de los que me propuse al comenzar. Así, en este caso, me pasé a la química, que también me gusta mucho y está directamente relacionada con la física; de hecho son hermanas: la madre, las matemáticas, la única que finalmente lo podrá explicar todo.

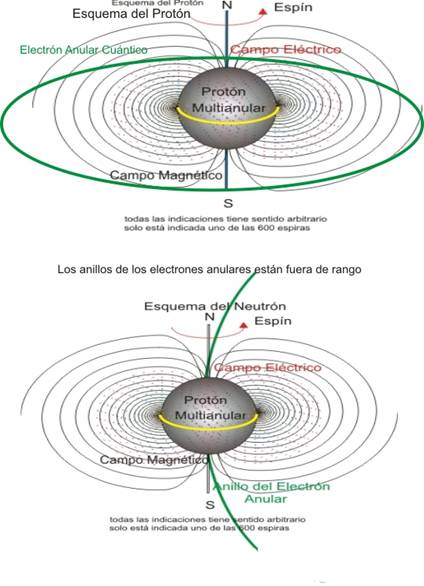

Estamos hablando de las partículas y no podemos dejar a un lado el tema del movimiento rotatorio de las mismas. Usualmente se ve cómo la partícula gira sobre su eje, a semejanza de un trompo, o como la Tierra o el Sol, o nuestra galaxia o, si se me permite decirlo, como el propio universo. En 1.925, los físicos holandeses George Eugene Uhlenbeck y Samuel Abraham Goudsmit aludieron por primera vez a esa rotación de las partículas. Éstas, al girar, generan un minúsculo campo electromagnético; tales campos han sido objeto de medidas y exploraciones, principalmente por parte del físico alemán Otto Stern y el físico norteamericano Isaac Rabi, quienes recibieron los premios Nobel de Física en 1.943 y 1.944 respectivamente, por sus trabajos sobre dicho fenómeno.

Esas partículas (al igual que el protón, el neutrón y el electrón), que poseen espines que pueden medirse en números mitad, se consideran según un sistema de reglas elaboradas independientemente, en 1.926, por Fermi y Dirac; por ello, se las llama y conoce como estadísticas Fermi-Dirac. Las partículas que obedecen a las mismas se denominan fermiones, por lo cual el protón, el electrón y el neutrón son todos fermiones.

Hay también partículas cuya rotación, al duplicarse, resulta igual a un número par. Para manipular sus energías hay otra serie de reglas, ideadas por Einstein y el físico indio S. N. Bose. Las partículas que se adaptan a la estadística Bose-Einstein son bosones, como por ejemplo la partícula alfa.

Las reglas de la mecánica cuántica tienen que ser aplicadas si queremos describir estadísticamente un sistema de partículas que obedece a reglas de esta teoría en vez de los de la mecánica clásica. En estadística cuántica, los estados de energía se considera que están cuantizados. La estadística de Bose-Einstein se aplica si cualquier número de partículas puede ocupar un estado cuántico dad. Dichas partículas (como dije antes) son bosones, que tienden a juntarse.

Los bosones tienen un momento angular nh/2π, donde n es 0 o un entero, y h es la constante de Planck. Para bosones idénticos, la función de ondas es siempre simétrica. Si sólo una partícula puede ocupar un estado cuántico, tenemos que aplicar la estadística Fermi-Dirac y las partículas (como también antes dije) son los fermiones que tienen momento angular (n + ½)h / 2π y cualquier función de ondas de fermiones idénticos es siempre antisimétrica. La relación entre el espín y la estadística de las partículas está demostrada por el teorema espín-estadística.

El Spín

Añadiendo el espín como un cuarto número cuántico, se logró dar una explicación más completa de las características de los espectros de átomos que poseen un solo electrón. Actualmente, la existencia del espín del electrón está confirmada por muchos resultados experimentales.

Añadiendo el espín como un cuarto número cuántico, se logró dar una explicación más completa de las características de los espectros de átomos que poseen un solo electrón. Actualmente, la existencia del espín del electrón está confirmada por muchos resultados experimentales.

El Spín es una propieded intrínseca de las partículas elementales, es una propiedad física, esta propiedad fué introducidad por Ulembeck y Gouldsmith, descubrieron el spín del electrón, que hace referencia a sus propiedades de giro. Su valor está cuantizado, es decir solo puede tener como valor números enteros o semienteros. Para electrones, protones y neutrones este valor es de 1/2. Existen otros valores para otras partículas elementales, las matrices de Pauli nos dicen conceptos del spin del electrón.

En un espacio de dos dimensiones es posible que haya partículas (o cuasipartículas) con estadística intermedia entre bosones y fermiones. Estas partículas se conocen con el nombre de aniones; para aniones idénticos, la función de ondas no es simétrica (un cambio de fase de +1) o antisimétrica (un cambio de fase de -1), sino que interpola continuamente entre +1 y -1. Los aniones pueden ser importantes en el análisis del efecto Hall cuántico fraccional y han sido sugeridos como un mecanismo para la superconductividad de alta temperatura.

Debido al principio de exclusión de Pauli, es imposible que dos fermiones ocupen el mismo estado cuántico (al contrario de lo que ocurre con los bosones). La condensación Bose-Einstein es de importancia fundamental para explicar el fenómeno de la superfluidez. A temperaturas muy bajas (del orden de 2×10-7 K) se puede formar un condensado de Bose-Einstein, en el que varios miles de átomos dorman una única entidad (un superátomo). Este efecto ha sido observado con átomos de rubidio y litio. Como ha habréis podido suponer, la condensación Bose-Einstein es llamada así en honor al físico Satyendra Nath Bose (1.894 – 1.974) y a Albert Einstein. Así que, el principio de exclusión de Pauli tiene aplicación no sólo a los electrones, sino también a los fermiones; pero no a los bosones.

Si nos fijamos en todo lo que estamos hablando aquí, es fácil comprender cómo forma un campo magnético la partícula cargada que gira, pero ya no resulta tan fácil saber por qué ha de hacer lo mismo un neutrón descargado. Lo cierto es que cuando un rayo de neutrones incide sobre un hierro magnetizado, no se comporta de la misma forma que lo haría si el hierro no estuviese magnetizado. El magnetismo del neutrón sigue siendo un misterio; los físicos sospechan que contiene cargas positivas y negativas equivalente a cero, aunque por alguna razón desconocida, logran crear un campo magnético cuando gira la partícula.

Particularmente creo que, si el neutrón tiene masa, si la masa es energía (E = mc2), y si la energía es electricidad y magnetismo (según Maxwell), el magnetismo del neutrón no es tan extraño, sino que es un aspecto de lo que en realidad es materia. La materia es la luz, la energía, el magnetismo, en definitiva, la fuerza que reina en el universo y que está presente de una u otra forma en todas partes (aunque no podamos verla).

Sea como fuere, la rotación del neutrón nos da la respuesta a esas preguntas.

¿Qué es el antineutrón? Pues, simplemente, un neutrón cuyo movimiento rotatorio se ha invertido; su polo sur magnético, por decirlo así, está arriba y no abajo. En realidad, el protón y el antiprotón, el electrón y el positrón, muestran exactamente el mismo fenómeno de los polos invertidos.

Es indudable que las antipartículas pueden combinarse para formar la antimateria, de la misma forma que las partículas corrientes forman la materia ordinaria.

La primera demostración efectiva de antimateria se tuvo en Brookhaven en 1.965, donde fue bombardeado un blanco de berilio con 7 protones BeV y se produjeron combinaciones de antiprotones y antineutrones, o sea, un antideuterón. Desde entonces se ha producido el antihelio 3, y no cabe duda de que se podría crear otros antinúcleos más complicados aún si se abordara el problema con más interés.

Pero, ¿existe en realidad la antimateria? ¿Hay masas de antimateria en el universo? Si las hubiera, no revelarían su presencia a cierta distancia. Sus efectos gravitatorios y la luz que produjeran serían idénticos a los de la materia corriente. Sin embargo, cuando se encontrasen las masas de las distintas materias, deberían ser claramente perceptibles las reacciones masivas del aniquilamiento mutuo resultante del encuentro. Así pues, los astrónomos observan especulativamente las galaxias, para tratar de encontrar alguna actividad inusual que delate interacciones materia-antimateria.

emilio silvera

Dic

22

Solsticio de Invierno

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Curiosidades ~

Clasificado en Curiosidades ~

Comments (0)

Comments (0)

Diagrama de las estaciones de la Tierra, bajo una perspectiva nórdica. Extremo derecho: solsticio de invierno.

El solsticio de invierno corresponde al instante en que la posición del Sol en el cielo se encuentra a la mayor distancia angular negativa del ecuador celeste. Dependiendo de la correspondencia con el calendario, el evento del solsticio de invierno tiene lugar entre el 20 y el 23 de diciembre todos los años en el hemisferio norte, y entre el 20 y el 23 de junio en el hemisferio sur.

El significado estacional del solsticio de invierno se manifiesta en la reversión de la tendencia al alargamiento de la duración de las noches y al acortamiento de las horas diurnas. Distintas culturas definen esto de diversas maneras, puesto que en algunas ocasiones se considera que, astronómicamente, puede señalar, ya sea el comienzo o la mitad del invierno del hemisferio. El invierno es una palabra de significado subjetivo, puesto que no tiene un principio o mitad que esté científicamente establecido, sin embargo en el caso del solsticio de invierno podemos calcular con exactitud el segundo en el que ocurre. Aunque en teoría el solsticio de invierno solo dura un instante, este término también se usa normalmente para referirse a las 24 horas del día en que tiene lugar.

Salida y puesta del Sol

Debido a la órbita elíptica y axial de la Tierra, ni la inclinación, la primera ni la última puesta de sol o salida del sol caen exactamente en el solsticio de invierno. La primera puesta de sol se produce antes de que el solsticio (por unos pocos días), y la última salida del sol más tarde. Para una o dos semanas en torno a los dos solsticios, tanto el amanecer y el atardecer son un poco antes o más tarde en cada día. Incluso en el ecuador, el amanecer y el atardecer cambia varios minutos hacia adelante y hacia atrás a lo largo del año, junto con el mediodía solar. Este efecto se representa por un analema.

Fuente: Wikipedia.

Dic

21

De lo pequeño a lo grande y, conocer la Naturaleza…¡No será...

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Sin categoría ~

Clasificado en Sin categoría ~

Comments (0)

Comments (0)

“Una formulación muy hermosa que, creo, procede de América es la siguiente: alguien que ha golpeado a otro afirma que sólo ha movido sus puños libremente; el juez, sin embargo, replica: «La libertad de movimiento de tus puños está limitada por la nariz de tu vecino».

Debido al principio de exclusión de Pauli, es imposible que dos fermiones ocupen el mismo cuántico (al contrario de lo que ocurre con los bosones). La condensación Bose-Einstein es de importancia fundamental explicar el fenómeno de la superfluidez. A temperaturas muy bajas (del orden de 2×10-7º K) se formar un condensado de Bose-Einstein, en el que varios miles de átomos forman una única entidad (un superátomo). efecto ha sido observado con átomos de rubidio y litio. Como ha habréis podido suponer, la condensación Bose-Einstein es llamada así en honor al físico Satyendra Nath Bose (1.894 – 1.974) y a Albert Einstein. Así que, el principio de exclusión de Pauli tiene aplicación no sólo a los electrones, sino también a los fermiones; pero no a los bosones.

Las reglas de la mecánica cuántica tienen que ser aplicadas si queremos describir estadísticamente un sistema de partículas que obedece a reglas de ésta teoría en vez de las de la mecánica clásica. En estadística cuantica, los estados de energía se considera que están cuantizados. La estadística de Bose-Einstein se aplica si cualquier de partículas puede ocupar un estado cuántico dado. Dichas partículas (como dije antes) son los bosones que, tienden a juntarse.

Los bosones tienen un angular n h / 2p, donde n es cero o un entero y h es la constante de Planck. bosones idénticos, la función de ondas es siempre simétrica. Si solo una partícula puede ocupar un cuántico, tenemos que aplicar la estadística Fermi-Dirac y las partículas (como también antes dije) son los fermiones que tienen momento angular (n+½) h/2p y cualquier función de ondas de fermiones idénticos es siempre antisimétrica.

La mejor teoría explicar el mundo subatómico nació en 1928 cuando el teórico Paul Dirac combinó la mecánica cuántica con la relatividad especial para explicar el comportamiento del electrón. El resultado fue la mecánica cuántica relativista, que se transformó en un ingrediente primario en la teoría cuántica de campos. Con unas pocas suposiciones y ajustes ad-hoc, la teoría cuántica de campos ha probado ser suficientemente poderosa para formar la base del modelo estándar de las partículas y las fuerzas.

La relación el espín y la estadística de las partículas está demostrada por el teorema espín-estadística. En un espacio de dos dimensiones es posible que existan partículas (o cuasipartículas) con estadística intermedia entre bosones y fermiones. Estas partículas se conocen con el de aiones; para aniones idénticos la función de ondas no es simétrica (un cambio de fase de+1) o antisimétrica (un cambio de fase de -1), sino que interpola continuamente entre +1 y -1. Los aniones pueden ser importantes en el análisis del efecto Hall cuántico fraccional y han sido sugeridos como un mecanismo para la superconductividad de alta temperatura.

Resulta fácil comprender cómo un campo magnético la partícula cargada que gira, pero ya no resulta tan fácil saber por qué ha de hacer lo mismo un neutrón descargado. Lo cierto es que cuando un rayo de neutrones incide sobre un hierro magnetizado, no se comporta de la misma forma que lo haría si el hierro no estuviese magnetizado. El magnetismo del neutrón sigue siendo un misterio; los físicos sospechan que contiene cargas positivas y negativas equivalente a cero, aunque por alguna razón desconocida, logran crear un campo magnético cuando gira la partícula.

Particularmente creo que, si el neutrón masa, si la masa es energía (E = mc2), y si la energía es electricidad y magnetismo (según Maxwell), el magnetismo del neutrón no es tan extraño, sino que es un aspecto de lo que en realidad es materia. La materia es la luz, la energía, el magnetismo, en definitiva, la fuerza que reina en el universo y que está presente de una u otra forma en todas partes (aunque no podamos verla).

Sea fuere, la rotación del neutrón nos da la respuesta a esas preguntas:

La primera demostración efectiva de antimateria se tuvo en Brookhaven en 1.965

¿Qué es el antineutrón? Pues, simplemente, un neutrón cuyo movimiento rotatorio se ha invertido; su polo sur magnético, por decirlo así, está arriba y no abajo. En realidad, el protón y el antiprotón, el electrón y el positrón, muestran exactamente el mismo fenómeno de los polos invertidos. Es indudable que las antipartículas pueden combinarse para formar la antimateria, de la misma que las partículas corrientes forman la materia ordinaria.

La primera demostración efectiva de antimateria se tuvo en Brookhaven en 1.965, donde fue bombardeado un blanco de berilio con 7 protones BeV y se produjeron combinaciones de antiprotones y antineutrones, o sea, un antideuterón. entonces se ha producido el antihelio 3, y no cabe duda de que se podría crear otros antinúcleos más complicados aún si se abordara el problema con más interés.

Pero, ¿existe en realidad la antimateria? ¿Hay masas de antimateria en el universo? Si las hubiera, no revelarían su presencia a cierta distancia. Sus efectos gravitatorios y la luz que produjeran serían idénticos a los de la materia corriente. Sin embargo, cuando se encontrasen las masas de las distintas materias, deberían ser claramente perceptibles las reacciones masivas del aniquilamiento mutuo resultante del encuentro. Así pues, los astrónomos observan especulativamente las galaxias, tratar de encontrar alguna actividad inusual que delate interacciones materia-antimateria.

…, ¿Hay masas de antimateria en el Universo? ¿Galaxias de antimateria?

Bueno, sabemos que no son las galaxias las que se alejan, sino que es el espacio el que se expande. Lo que no sabemos es encontrar antimateria en el espacio interestelar y, si la hay y está presente… ¡Aún no la hemos podido localizar! Algunos dicen que hay galaxias de antimateria y, yo digo que tengo un pariente en la galaxia Astrinia del cúmulo Ultramón a diez mil millones de años-luz de nuestra región.

No parece que dichas observaciones, al menos hasta el , hayan sido un éxito.

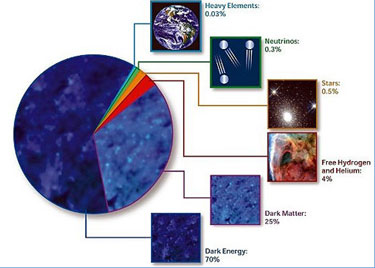

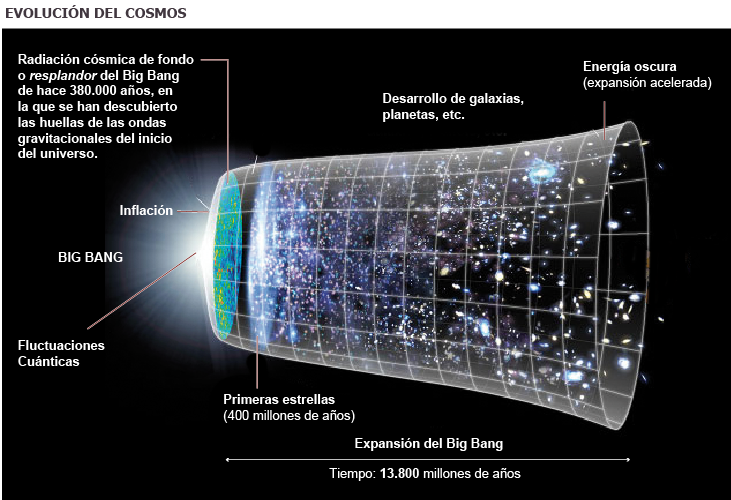

Según estimaciones recientes, resumidas en gráfico de la NASA, alrededor del 70% del contenido energético del Universo consiste en energía oscura, cuya presencia se infiere en su efecto sobre la expansión del Universo pero sobre cuya naturaleza última no se sabe casi nada.

¿Es posible que el Universo este formado casi enteramente por materia, con muy poca o ninguna antimateria? Y si es así, ¿por qué? dado que la materia y la antimateria son equivalentes en todos los aspectos, excepto en su oposición electromagnética, cualquier fuerza que crease una originaria la otra, y el Universo debería estar compuesta de iguales cantidades de la una y de la otra.

Este es el dilema. La teoría nos dice que debería haber allí antimateria, pero las observaciones lo niegan, no lo respaldan. ¿Es la observación la que falla? ¿Y qué ocurre con los núcleos de las galaxias activas, e incluso más aún, con los causares? ¿Deberían ser estos fenómenos energéticos el resultado de una aniquilación materia-antimateria? ¡No creo! Ni siquiera ese aniquilamiento parece ser suficiente, y los astrónomos prefieren aceptar la noción de colapso gravitatorio y fenómenos de agujeros negros como el único mecanismo conocido para producir la energía requerida.

Estábamos hablando de mecánica cuántica y me pasé, sin que me diera , al ámbirto de la antimateria y el espacio del macro universo de las galaxias. Sin embargo, y aunque parezcan temas dispares, lo cierto es que, a medida que profundizamos en estas cuestiones, todas nos llevan, de una u otra manera, a relacionar el “mundo de lo muy pequeño” con el “mundo” de lo muy grande que, al fín y al cabo, está hecho de lo que existe en el primero, es decir, partículas infinitesimales de materia y… ¡de antimateria! para que todo quede compensado.

Sus dimensiones y masa le permiten ¡lo imposible! para nosotros. La tensión superficial es una consecuencia de que todas las moléculas y los átomos se atraen unos a otros con una fuerza que nosotros llamamos fuerza de Van der Vaalls. esta fuerza tiene un alcance muy corto. para ser más precisos, diremos que la intensidad de esta fuerza a una distancia r es aproximadamente proporcional a 1/r7. Esto significa que si se reduce la distancia entre dos átomos a la mitad, la fuerza de Van der Vaalls con la que se atraen uno a otro se hace 2 x 2 x 2 x 2 x 2 x 2 x 2 = 128 veces más intensa. Cuando los átomos y las moléculas se acercan mucho unos a otros quedan unidos muy fuertemente a través de esta fuerza.

La mecánica cuántica domina en el micromundo de los átomos y de las partículas “elementales”. Nos enseña que en la naturaleza cualquier masa, por sólida o puntual que pueda parecer, tiene un aspecto ondulatorio. Esta onda no es como una onda de agua. Se parece más a una ola de histeria que se expande: es una onda de información. Nos indica la probabilidad de detectar una partícula. La longitud de onda de una partícula, la longitud cuántica, se hace menor cuanto mayor es la masa de esa partícula.

Por el contrario, la relatividad general era siempre necesaria cuando se trataba con situaciones donde algo viaja a la velocidad de la luz, o está muy cerca o donde la gravedad es muy intensa. Se utiliza para describir la expansión del universo o el comportamiento en situaciones extremas, como la formación de agujeros negros.

La fuerza nuclear fuerte es la más potente del Universo

Sin embargo, la gravedad es muy débil comparada con las fuerzas que unen átomos y moléculas y demasiado débil para tener cualquier efecto sobre la estructura del átomo o de partículas subatómicas, se trata con masas tan insignificantes que la incidencia gravitatoria es despreciable. Todo lo contrario que ocurre en presencia de masas considerables como planetas, estrellas y galaxias, donde la presencia de la gravitación curva el espacio y distorsiona el tiempo.

Como resultado de estas propiedades antagónicas, la teoría cuántica y la teoría relativista gobiernan reinos diferentes, muy dispares, en el universo de lo muy pequeño o en el universo de lo muy grande. Nadie ha encontrado la manera de unir, sin fisuras, estas dos teorías en una sola y nueva de Gravedad-Cuántica.

¿Cuáles son los límites de la teoría cuántica y de la teoría de la relatividad general de Einstein? Afortunadamente, hay una respuesta simple y las unidades de Planck nos dicen cuales son. En realidad, es la propia Naturaleza la que marca esos límites que Stoney-Planck, supieron plasmar en ecuaciones que los marcan.

Supongamos que tomamos toda la masa del universo visible y determinamos su longitud de onda cuántica. Podemos preguntarnos en qué momento esta longitud de onda cuántica del universo visible superará su tamaño. La respuesta es: cuando el universo sea más pequeño en tamaño que la longitud de Planck, es decir, 10-33 de centímetros, más joven que el tiempo de Planck, 10-43 segundos y supere la temperatura de Planck de 1032 grados. Las unidades de Planck marcan la frontera de aplicación de nuestras teorías actuales. Para comprender en que se parece el mundo a una escala menor que la longitud de Planck tenemos que comprender plenamente cómo se entrelaza la incertidumbre cuántica con la gravedad. Para entender lo que podría haber sucedido cerca del suceso que estamos tentados a llamar el principio del universo, o el comienzo del tiempo, tenemos que penetrar la barrera de Planck. Las constantes de la naturaleza marcan las fronteras de nuestro conocimiento existente y nos dejan al descubierto los límites de nuestras teorías.

En los intentos más recientes de crear una teoría nueva para describir la naturaleza cuántica de la gravedad ha emergido un nuevo significado para las unidades naturales de Planck. Parece que el concepto al que llamamos “información” tiene un profundo significado en el universo. Estamos habituados a vivir en lo que llamamos “la edad de la información”. La información puede ser empaquetada en formas electrónicas, enviadas rápidamente y recibidas con más facilidad que nunca antes. Nuestra evolución en el proceso rápido y barato de la información se suele mostrar en una forma que nos permite comprobar la predicción de Gordon Moore, el fundador de Intel, llamada ley de Moore, en la que, en 1.965, advirtió que el área de un transistor se dividía por dos aproximadamente cada 12 meses. En 1.975 revisó su tiempo de reducción a la mitad hasta situarlo en 24 meses. Esta es “la ley de Moore” cada 24 meses se obtiene una circuiteria de ordenador aproximadamente el doble, que corre a velocidad doble, por el mismo precio, ya que, el coste integrado del circuito viene a ser el mismo, constante.

Siempre hemos tratado de buscar información del Universo para saber de nuestro entorno, de nuestro Sistema solar, de nuestra Galaxias, de las galaxias lejanas, y, de las mismas estrellas que alumbran los mundos y permite la vida con su luz y su calor. Hemos llegado a saber que somos “polvo de estrellas”, que los materiales que nos conforman están “fabricados” en sus “hornos nucleares”, la fusión creaelementos que, más tarde, forman parte de los mundos y de los seres vivos.

La velocidad de la luz en el vacío es por definición una constante universal de valor 299.792.458 m/s (suele aproximarse a 3·108 m/s), o lo que es lo mismo 9,46·1015 m/año; la segunda cifra es la usada para definir al intervalo llamado año luz. La información se transmitirá a esa velocidad como máximo, nuestro Universo, no permite mayor rapidéz, al menos, por los métodos convencionales.

Los límites últimos que podemos esperar para el almacenamiento y los ritmos de procesamiento de la información están impuestos por las constantes de la naturaleza. En 1.981, el físico israelí, Jacob Bekenstein, hizo una predicción inusual que estaba inspirada en su estudio de los agujeros negros. Calculó que hay una cantidad máxima de información que puede almacenarse dentro de cualquier volumen. Esto no debería sorprendernos.

(Longitud de Planck que al cuadrado sería de 10-66 cm2)

(Longitud de Planck que al cuadrado sería de 10-66 cm2)

Lo que debería hacerlo es que el valor máximo está precisamente determinado por el área de la superficie que rodea al volumen, y no por el propio volumen. El número máximo de bits de información que puede almacenarse en un volumen viene dado precisamente por el cómputo de su área superficial en unidades de Planck. Supongamos que la región es esférica. Entonces su área superficial es precisamente proporcional al cuadrado de su radio, mientras que el área de Planck es proporcional a la longitud de Planck al cuadrado, 10-66 cm2. Esto es muchísimo mayor que cualquier capacidad de almacenamiento de información producida hasta ahora. Asimismo, hay un límite último sobre el ritmo de procesamiento de información que viene impuesto por las constantes de la naturaleza.

Stoney Planck

No debemos descartar la posibilidad de que seamos capaces de utilizar las unidades de Planck-Stoney para clasificar todo el abanico de estructuras que vemos en el universo, desde el mundo de las partículas elementales hasta las más grandes estructuras astronómicas. Este fenómeno se puede representar en un gráfico que recree la escala logarítmica de tamaño desde el átomo a las galaxias.

Todas las estructuras del universo existen porque son el equilibrio de fuerzas dispares y competidoras que se detienen o compensan las unas a las otras; la atracción y la repulsión. Ese es el equilibrio de las estrellas donde la repulsión termonuclear tiende a expandirla y la atracción (contracción) de su propia masa tiende a comprimirla; así, el resultado es la estabilidad de la estrella. En el caso del planeta Tierra, hay un equilibrio entre la fuerza atractiva de la gravedad y la repulsión atómica que aparece cuando los átomos se comprimen demasiado juntos. Todos estos equilibrios pueden expresarse aproximadamente en términos de dos números puros creados a partir de las constantes e, h, c, G y mprotón

“Tras medir alfa en unas 300 galaxias lejanas, vimos un patrón constante: este número, que nos dice la fuerza del electromagnetismo, no es igual en otras partes que en la Tierra, y parecer variar de forma continua a lo largo de un eje”. Algunos se empeñan en variar la constante de estructura fina y, si eso llegara a producirse… las consecuencias serían funestas para nosotros. Otros estudios nos dicen que esa constante, no ha variado a lo largo de los miles de millones de años del Universo y, así debe ser, o, si varió, lo hizo en una escala ínfima.

|

α = 2πe2 / hc ≈ 1/137 |

|

αG = (Gmp2)2 / hc ≈ 10-38 |

Si varian algunas de las dos en sólo una diezmillonésima, muchas de las cosas que conforman el Universo serían imposible y, la consecuencia sería, la ausencia de vida. La identificación de constantes adimensionales de la naturaleza como a (alfa) y aG, junto con los números que desempeñan el mismo papel definitorio para las fuerzas débil y fuerte de la naturaleza, nos anima a pensar por un momento en mundos diferentes del nuestro. Estos otros mundos pueden estar definidos por leyes de la naturaleza iguales a las que gobiernan el universo tal como lo conocemos, pero estarán caracterizados por diferentes valores de constantes adimensionales. Estos cambios numéricos alterarán toda la fábrica de los mundos imaginarios. Los átomos pueden tener propiedades diferentes. La gravedad puede tener un papel en el mundo a pequeña escala. La naturaleza cuántica de la realidad puede intervenir en lugares insospechados.

Lo único que cuenta en la definición del mundo son los valores de las constantes adimensionales de la naturaleza (así lo creían Einstein y Planck). Si se duplica el valor de todas las masas no se puede llegar a saber, porque todos los números puros definidos por las razones de cualquier par de masas son invariables.

“Todos los físicos del mundo, deberían tener un letrero en el lugar más visible de sus casas, para que al mirarlo, les recordara lo que no saben. En el cartel sólo pondría esto: 137. Ciento treinta y siete es el inverso de algo que lleva el nombre de constante de estructura fina”

Lederman

Este número guarda relación con la posibilidad de que un electrón emita un fotón o lo absorba. La constante de estructura fina responde también al nombre de “alfa” y sale de dividir el cuadrado de la carga del electrón, por el producto de la velocidad de la luz y la constante de Planck. Tanta palabrería y numerología no significan otra cosa sino que ese solo numero, 137, encierra los misterios del electromagnetismo (el electrón, e–), la relatividad (la velocidad de la luz, c), y la teoría cuántica (la constante de Planck, h).

Todo eso está relacionado: leyes fundamentales, constantes, materia y espacio tiempo… ¡nosotros! Es posible (digo posible), que finalmente no seámos ni tanto ni tan poco como a veces creemos. Dejémos en un término medio nuestra valia en el contexto del Universo, aunque, poder crear ideas y pensamientos… ¡No es cosa valadí!

emilio silvera

Dic

20

Muevas maneras de observar el Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (4)

Comments (4)

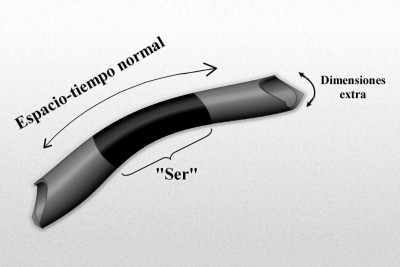

El gráfico representa un modelo de manguera de un espacio-tiempo de dimensiones más altas de tipo Kaluza-Kleim donde la longitud, o mejor, la dimensión a lo largo de la longitud de la manguera representa el 4-espacio-tiempo normal, y la dimensión alrededor de la manguera representa la dimensión extra “pequeñas” (quizá escala de Planck). Imaginemos un “ser” que habite en este mundo, que rebasa estas dimensiones extra “pequeñas”, y por ello no es realmente consciente de ellas.

Las últimas noticias que llegan sobre descubrimientos del Cosmos, siguen siendo publicadas en todos los medios.

“Un equipo internacional de científicos ha detectado los sutiles temblores del universo un instante después de su origen. Un telescopio estadounidense en el mismísimo polo Sur ha logrado captar esas huellas en el cielo que suponen un espaldarazo definitivo a la teoría que mejor explica los primeros momentos del cosmos, denominada inflación y propuesta hace más de tres décadas. Esa inflación fue un crecimiento enorme y muy rápido del espacio-tiempo inicial y, a partir de ese momento, el universo siguió expandiéndose pausadamente, hasta ahora, 13.800 millones de años después. Es la teoría del Big Bang, pero con un complemento fundamental al principio de todo. Como dice Alan Guth, el científico estadounidense que propuso, a principio de los ochenta, la inflación cósmica, “exploramos el bang del Big Bang”.

Lo que sí parece cierto es que, cuando sepamos capturar y leer las ondas gravitatorias que estamos buscando para tratar de traducir los mensajes que nos envían muchos fenómenos que ocurrieron y siguen ocurriendo en el Univero, entonces, habremos logrado decorrer el velo que ahora impide conocer un nuevo “universo” con otros escenarios y otras perspectivas. Muchos son los autores que nos han hablado de ellas y, por fín, parece que van siendo localizadas.

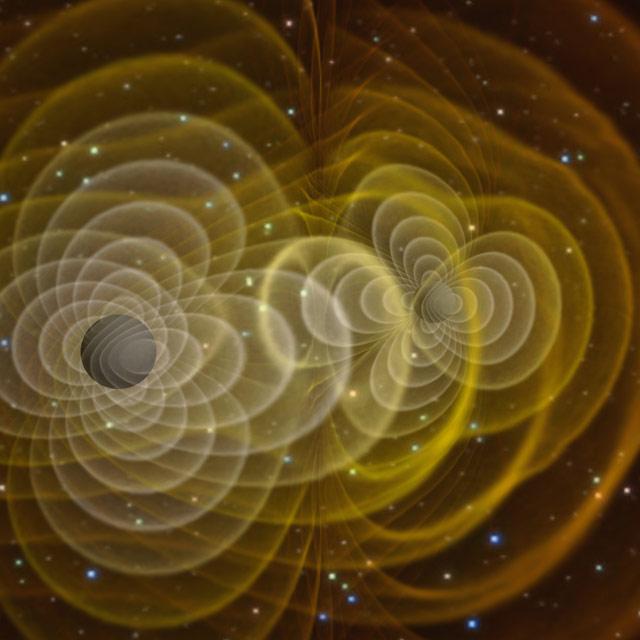

Ondas gravitatorias que salen de un agujero negro pulsante expandiéndose por el espacio a inconmensurables distancias, como si de las ondas formadas en un tranquilo lago se tratara, las de gravedad, funcionan de forma similar.

Ondas gravitatorias de un Agujero Negro pulsante (que los hay)

Desde sus comienzos la Astronomía ha dominada por el uso de instrumentos que detectan luz, desde los primeros telescopios ópticos hasta los más modernos detectores de rayos X y gamma. Fruto de este desarrollo han sido grandes descubrimientos que han ido configurando nuestra de comprender el Universo. Durante el siglo pasado se han empezado a desarrollar nuevas formas de Astronomía basadas en mensajeros diferentes a la luz: detectores de rayos cósmicos, de neutrinos y de ondas gravitacionales. Las ondas gravitacionales son una consecuencia de la Teoría General de la Relatividad de Einstein y corresponden a oscilaciones de la geometría del espacio-tiempo que se propagan de similar a las ondas electromagnéticas.

Tenemos que buscar la manera de “ver” y “detectar” las ondas gravitacionales

La debilidad de la fuerza gravitatoria hace que la detección de estas ondas suponga un gran reto tecnológico. Sin embargo, desde el punto de vista científico son una gran , ya que transportan información prácticamente incorrupta de las fuentes que la generaron, la cual en muchos de los casos es difícil o imposible de obtener por otros medios. Este artículo es una introducción a la Astronomía de Ondas Gravitatorias, a sus métodos, a su estado actual y sobre todo a las grandes perspectivas que ofrece con la apertura de una nueva ventana a la exploración del Universo que tendrá un gran impacto tanto en Astrofísica como en Cosmología e incluso en Física Fundamental.

Dentro del marco de la Física Teórica, la gravedad aparece una de las cuatro interacciones fundamentales, siendo las otras tres la electromagnética y las interacciones nucleares débil y fuerte. Electromagnetismo y gravitación son las dos únicas interacciones de largo rango de acción (en principio ilimitado), en contraposición a las dos interacciones nucleares, cuyo rango de acción está limitado esencialmente a regiones cuyo tamaño es del orden de un núcleo atómico o inferior. Una consecuencia directa de esto es que las interacciones nucleares no pueden transportar información a distancias macroscópicas y por lo tanto no son de utilidad la Astronomía. Las otras dos, electromagnetismo y gravedad, se propagan a través del espacio a la velocidad de la luz, tal y como nos indican las teorías de Maxwell y Einstein respectivamente, y tal como comprobamos en diferentes observaciones y experimentos.

Muchos son los fenómenos que no sabemos entender

Lo que determina la fuerza que estas interacciones producen son su intensidad y las correspondientes susceptibilidades de la materia a ellas, lo que denominamos cargas, la carga eléctrica en el caso electromagnético y la masa en el caso gravitatorio. En la naturaleza observamos que la interacción electromagnética produce fuerzas que son muchos órdenes de magnitud superiores a la de la gravitatoria, que es la más débil de todas las interacciones. Por lo tanto, no es de extrañar que la Astronomía haya dominada completamente por detectores de ondas electromagnéticas y fotones (las partículas cuánticas asociadas a campos electromagnéticos), telescopios ópticos hasta detectores de rayos X y gamma, incluyendo antenas de radio. Gracias a estos instrumentos la Astronomía ha producido grandes revoluciones que han cambiado nuestra percepción del Universo: la Copernicana, que comenzó en el siglo XVI, hasta los descubrimientos en cosmología, que comenzaron en el siglo XX y continúan hoy día.

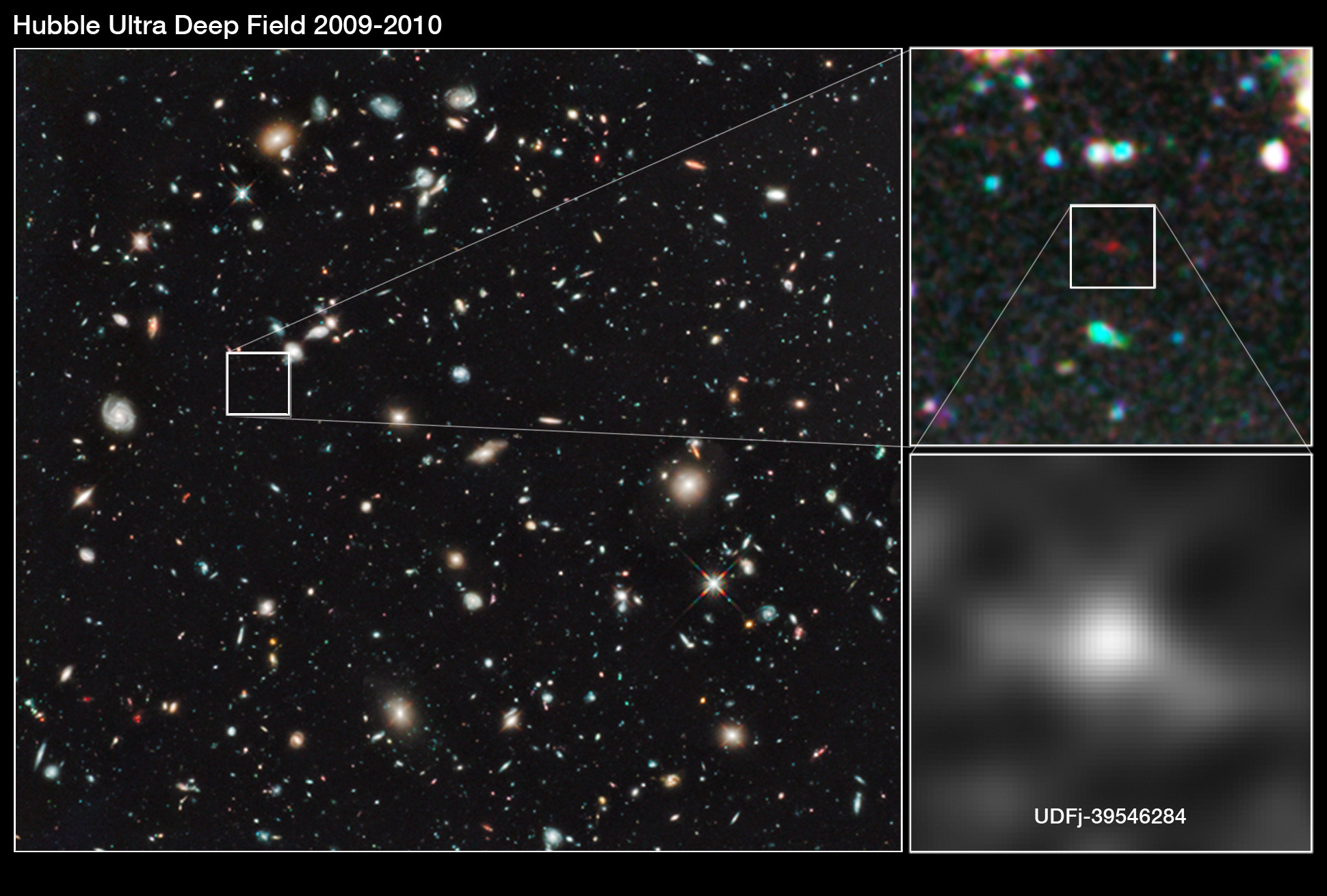

Vistas como esta son posibles gracias a la luz y a los telescopios

Pero no todo lo que se mide u observa en astronomía es luz, hay otros mensajeros que nos informan sobre lo que sucede en diferentes lugares de nuestro Universo: meteoritos, neutrinos, rayos cósmicos (protones, electrones, etc.), ondas gravitatorias. Los meteoritos nos dan información de nuestro entorno local, principalmente del Sistema Solar. Los neutrinos y rayos cósmicos pueden provenir nuestro entorno local hasta galaxias muy distantes. La detección de estas partículas, mediante técnicas similares a las empleadas en aceleradores de partículas, ha dado lugar a una nueva área de investigación muy activa denominada Astropartículas. El mensajero del que trata este artículo son las ondas gravitatorias y su para la investigación astronómica constituye lo que denominamos Astronomía de Ondas Gravitatorias.

Las ondas gravitatorias son una predicción de la Teoría General de la Relatividad (conocida comúnmente como Relatividad General) propuesta por Albert Einstein (1915) para incluir la gravitación en la estructura espacio-temporal propuesta por él mismo en su Teoría Especial de la Relatividad (1905). Uno de los aspectos más destacados de esta teoría es que el espacio deja de ser un simple contenedor de los fenómenos físicos para convertirse en un objeto dinámico, en el sentido que su geometría cambia conforme a los movimientos y distribuciones de masas y energía. No solo eso, al tiempo físico le sucede algo similar, de que su transcurso también depende de la distribución de masa y energía. En la Teoría de la Relatividad espacio y tiempo aparecen como una única estructura que denominamos espacio-tiempo, cuya geometría está determinada por la distribución de masa y energía, y a su vez, la geometría determina el movimiento de la materia y de la energía.

La geometría del espaciotiempo que nos da toda la sensación de estar determinada por la presencia de grandes masas de materia que curvan el espacio y distorsionan el tiempo a su alrededor, El Agujero negro es el exponente más claro de esto.

De esta , la gravedad aparece como una manifestación de la geometría espacio-tiempo, una elegante implementación del principio Galileano de que todos los objetos, independientemente de su masa y composición, caen con la misma aceleración. Una consecuencia del carácter dinámico del espacio-tiempo en la Relatividad General es que las oscilaciones de su geometría se propagan como ondas con una velocidad, medida localmente, exactamente igual a la velocidad de la luz. Las ondas gravitatorias, al cambiar la geometría local de las regiones que atraviesan, cambian la distancia física objetos, siendo dicho cambio proporcional a la distancia misma y a la amplitud de ondas. Como en el caso electromagmético este es un efecto transverso, es decir, los cambios en la distancia se producen en el plano perpendicular a la dirección de propagación de la onda gravitatoria. Además, tanto ondas electromagnéticas como gravitatorias tienen dos estados de polarización independientes, aunque en teorías de la gravedad alternativas a la Relatividad General puede haber hasta seis polarizaciones independientes.

Una diferencia importante ondas electromagnéticas y gravitatorias tiene que ver con su generación. En el contexto astronómico, las ondas electromagnéticas se generan por cargas aceleradas (emisión predominantemente dipolar), como por ejemplo electrones, cuyo tamaño es muy inferior al de los objetos de los que forman y como consecuencia, pueden emitir luz en una longitud de onda suficientemente pequeña como para realizar imágenes de objetos astronómicos. En contraste, las ondas gravitatorias se generan por cambios temporales de la distribución de masa-energía de un objeto (radiación predominantemente cuadrupolar), y por este motivo sus longitudes de onda suelen ser del orden del tamaño del objeto que las genera o mayores, con lo cual no es posible en general realizar imágenes. En ese sentido se podría decir que la Astronomía de Ondas Gravitatorias está más cercana a la Acústica que a la Óptica.

Es previsible que, dos objetos masivos (estrellas de neutrones, por ejmplo) se encuentran y giran el uno alrededor del otro, deben desprender una serie de ondas gravitacionales que, captadas a cientos o miles de años-luz de la fuente, deben contar el suceso al científico experto.

La relativa debilidad de la gravedad es la causa de que las ondas gravitatorias tengan una amplitud relativamente pequeña y que su detección sea una empresa extremadamente complicada. Ondas gravitatorias producidas por fuentes galácticas, la colisión de dos estrellas de neutrones, inducen desplazamientos del orden del tamaño de un núcleo atómico o inferiores en un detector terrestre de un kilómetro de tamaño. La gran ventaja que proporcionan las ondas gravitatorias es que por su débil interacción con la materia transportan información prácticamente incorrupta de las fuentes astronómicas que las generaron.

La construcción de un detector de ondas gravitatorias supone un gran reto tecnológico, y tal empresa no comenzó hasta los años sesenta, con el pionero de Joseph Weber en detectores resonantes. El principio de funcionamiento de estos detectores de basa en que una onda gravitatoria que atraviese un sólido cambiará su tamaño de forma oscilatoria, excitando de esta forma sus modos propios de oscilación. La idea por lo tanto es crear un dispositivo que sea sensible a las oscilaciones del sólido y nos permita extraer la señal gravitatoria que las ha producido. Varios detectores de este tipo, la mayoría con forma cilíndrica, se han construido en varias partes del mundo y, contrariamente a las aseveraciones de detección de Weber en los años 70, no han conseguido hasta la fecha detectar ondas gravitatorias. De hecho, ningún tipo de detector las ha detectado. Entonces, ¿estamos seguros de que las ondas gravitatorias existen? ¿Tenemos alguna evidencia de su existencia?

No por falta de empeño y proyectos , todavía no se han observado (directamente) las ondas gravitatorias predichas por la teoría de la relatividad de Einstein, aunque hay importantes evidencias (indirectas) sobre su existencia. Son extremadamente débiles, por lo que observarlas es extremedamente difícil.

La respuesta a estas preguntas es que sí, y el principal argumento nos lo proporcionó el descubrimiento en 1974 del primer pulsar binario, PSR B1913+16, por Russell Hulse y Joseph Taylor, lo que les valió el premio Nobel de Física en el año 1993. Los púlsares son estrellas de neutrones dotadas de un enorme campo magnético que acelera partículas cargadas produciendo la emisión de un haz de radiación electromagnética en la dirección del eje magnético. Como el eje magnético no suele estar alineado con el eje de rotación, emisión electromagnética describe un cono, convirtiendo los púlsares en faros cósmicos. Si nuestro planeta se encuentra en la dirección del cono de emisión del púlsar observaremos una serie de pulsos de radio, que en caso de los púlsares con rotación más rápida se dan con un ritmo tan uniforme que los convierte en relojes de precisión comparable a los relojes atómicos (¡el púlsar más rápido conocido completa más de 700 revoluciones por segundo! El de Hulse y Taylor!).

El primer púlsar binario conocido, PSR 1913+16, fue descubierto en 1974. Consiste en un púlsar que tiene 17 pulsaciones por segundo, en una órbita altamente excéntrica con un período de 7,75 horas alrededor de una segunda estrella de neutrones en la que no se han observado pulsaciones. Cada estrella tiene unas 1,4 masas solares, próxima al límite de Chandrasekhar, y el período orbital se está acortando gradualmente debido a la pérdida de energía a través de radiación gravitacional.

Otro púlsar binario destacable es PSR 1957 + 20, llamado en ocasiones púlsar de la viuda negra, en el que la intensa radiación procedente del pulsar está evaporando su pequeña estrella compañera. Algunos púlsares binarios se saben que son púlsares reciclados que han adquirido altas velocidades de rotación debido a la acreción de gas procedente del compañero.

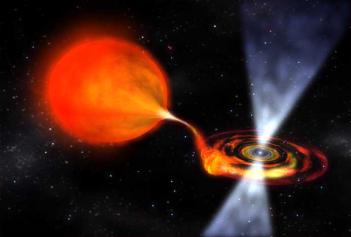

Escenas como son corrientes en las galaxias

Esto permite observaciones astronómicas de una precisión sin precedentes. El púlsar de Hulse y Taylor orbita alrededor de otra estrella de neutrones de que el tamaño de la órbita es suficientemente pequeño (la distancia mínima entre ellas es aproximadamente la mitad de la distancia de la Tierra al Sol) como para que estas estrellas tan compactas (tienen una masa un poco inferior a una vez y media la masa del Sol pero un radio de tan sólo unos diez kilómetros) se muevan de forma que los efectos relativistas importen para un descripción precisa de sistema. En concreto, el movimiento orbital periódico de tales masas con velocidades considerables (cientos de kilómetros por segundo respecto del centro de masas del sistema binario) produce cambios periódicos significativos en la geometría del espacio-tiempo de su entorno. Y estos cambios periódicos en la geometría no son más que ondas gravitatorias que se propagan en todas las direcciones llevándose consigo energía y momento angular del sistema.

emisión gravitatoria afecta a su vez al movimiento orbital, disminuyendo su tamaño y periodo orbital, tal y como se observa. También se pueden observar otros efectos relativistas como la precesión del periastro de la órbita. Los 35 años de observaciones del púlsar binario de Hulse y Taylor han permitido comprobar que la evolución de su órbita coincide con la predicha por el mecanismo de emisión de radiación gravitatoria de la Relatividad General con una precisión relativa del 0.2%. Actualmente se conocen otros púlsares binarios y algunos de ellos se encuentran en un régimen relativista. El denominado púlsar doble, PSR J0737-3039A/B, un sistema binario compuesto por dos púlsares, se ha convertido recientemente en el mejor test disponible de la Relatividad General, alcanzado precisiones relativas del 0.05%.

Uno de los dos detectores LIGO, situado en Livingston (Luisiana), con brazos de cuatro kilómetros de longitud.- LIGO/CALIFORNIA INSTITUTE OF TECHNOLOGY. Se han ideado para localizar las ondas gravitacionales que vienen del pasado salidas de sucesos como el big bang o agujeros negros que colisionan, estrellas de neutrones que se fusionan y otros eventos cosmológicos que nos pueden contar muchas cosas del Universo que ahora no conocemos.

Estos descubrimientos han contribuido a impulsar el desarrollo de detectores de ondas gravitatorias, y los que hoy en día han alcanzado una mayor sensibilidad son los llamados detectores interferométricos. Son básicamente interferómetros del tipo Michelson-Morley dispuestos en una de L y el concepto de funcionamiento es relativamente simple: cuando una onda gravitatoria incide perpendicularmente al plano del detector produce cambios en la longitud de los brazos del interferómetro, de forma que mientras uno se acorta el otro se alarga y viceversa. Estos cambios dan lugar a interferencias de las cuales se puede inferir el patrón de las ondas gravitatorias que han atravesado el detector. Actualmente hay varios detectores interferométricos terrestres en operación: LIGO en los Estados Unidos (dos de 4 km y uno de 2 km de brazo); VIRGO en Italia con participación de varios países europeos (3 km de brazo); GEO600 en Alemania con participación británica (600 m de brazo). Aparte hay varios proyectos en desarrollo en diversas partes del planeta, como por ejemplo el LCGT en Japón 83 km de brazo), un ambicioso proyecto recientemente aprobado que sustituye al anterior detector TAMA y al prototipo CLIO, y que se convertirá en el primer detector interferométrico de tipo criogénico. La banda de frecuencias a la que operan está contenida en el rango 10- 10000 Hz. A frecuencias más bajas están limitados por ruido sísmico y el gradiente gravitatorio, mientras que a frecuencias más altas están limitados por el ruido de los fotodetectores.

Pese a que no se han realizado aún detecciones, observaciones de LIGO han servido producir nueva ciencia mediante el análisis de las consecuencias de las no detecciones al nivel de sensibilidad actual. Se pueden destacar dos resultados: (1) En la constelación del Cangrejo hay un púlsar joven resultado de una supernova (explosión de una estrella). La frecuencia rotacional de púlsar disminuye con el tiempo. LIGO ha limitado a un 4% la contribución de una hipotética emisión de radiación gravitatoria, lo cual excluye diversos modelos astrofísicos que trataban de explicar fenómeno. (2) La teoría cosmológica de la gran explosión (Big Bang) requiere una fase primitiva de gran expansión del Universo que daría lugar, entre otras cosas, a un fondo de radiación gravitatoria. Las observaciones de LIGO han puesto límites a la densidad de energía almacenada en este fondo, mejorando los límites impuestos por la teoría de de elementos primordiales, parte a su vez del modelo estándar de la Cosmología. Durante el presente año, tanto LIGO como VIRGO pararán las operaciones para incorporar tecnología avanzada: mejora de los sistemas de vacío, láseres de precisión más potentes y mejoras de los sistemas ópticos y mecánicos. Con esto se logrará una mejora de un orden de magnitud en la sensibilidad, lo cual equivale a aumentar en tres órdenes de magnitud el volumen del cosmos que cubrirán. Al mismo tiempo se realizará la construcción del detector criogénico LCGT en la mina de Kamioka (Japón). Una vez estos modelos avanzados entren en operación se espera que realicen detecciones de radiación gravitatoria con un ritmo, de acuerdo con los pronósticos astrofísicos sobre la información de las fuentes de ondas gravitatorias relevantes, de 10-1000 eventos por año.

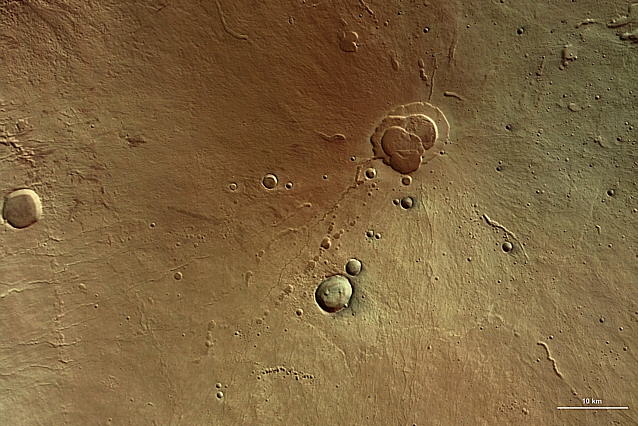

En lugares como este, la gravedad interviene para formar estrellas nuevas. La imagen es de NGC 604, una región H II gigante en la galaxia del Triángulo. En estos lugares, la fuerza de Gravedad, las ondas que se emiten al choque del material ahí presente, los vientos estelares… Son el motivo de que el gas y el polvo ahí presentes se distorsionen y formen figuras arabescas que, no pocas veces, están llenas de belleza.

Las principales fuentes astrofísicas y cosmológicas para estos detectores terrestres son: colisiones de sistemas binarios formados por agujeros negros estelares y/o estrellas de neutrones; oscilaciones de estrellas relativistas; supernovas; fondos cosmológicos de diverso origen. Estas observaciones revelarán información clave para entender la de objetos compactos estelares, la ecuación de estado de estrellas de neutrones, la validez de la Relatividad General, etc.

Por otra parte, la Agencia Europea del Espacio (ESA) y la Administración Nacional para el Espacio y la Aeronáutica norteamericana (NASA) colaboran en la construcción de un observatorio espacial de ondas gravitatorias, la Antena Espacial de Interferometría Láser (LISA), que se espera que se lance durante la década de 2020. Hay dos motivos de peso para construir un observatorio espacial. El primero es cubrir la banda de bajas frecuencias, en el rango 3x10⁻⁵ – 0.1 Hz, inaccesible a los detectores terrestres. El segundo es que banda de frecuencias da acceso a fuentes de ondas gravitatorias y a una ciencia completamente diferente, con muchas más implicaciones para el panorama de la Astrofísica y la Cosmología. LISA se compone de tres naves espaciales dispuestas en un triángulo equilátero, de 5 millones de kilómetros de lado, y que siguen una órbita alrededor del Sol. Para que la dinámica propia de cada nave preserve lo más posible la configuración triangular, esta ha de estar inclinada 60º respecto del plano de la eclíptica. De esta el triángulo gira sobre su baricentro una vez por año/órbita, lo cual introduce una modulación en las señales gravitatorias que es muy útil para localizar los objetos que las emitieron. LISA es una misión con una tecnología muy novedosa y exigente que una misión precursora de la ESA, LISA PathFinder, se encargará de demostrar. Nuestro grupo en el Instituto de Ciencias del Espacio (CSIC-IEEC) participa en el desarrollo de esta misión contribuyendo con algunos instrumentos fundamentales, como por ejemplo el ordenador que controlará el denominado LISA Technology Package, el conjunto de experimentos que LISA PathFinder realizará.

LISA hará sus observaciones en un intervalo de frecuencia bajo que no es posible con detectores basados en la Tierra. Estos detectores están afectados por el ruido ambiental de la Tierra, causado por los terremotos y otras vibraciones, y sólo pueden hacer observaciones a frecuencias mayores de 1 hertzio. Sin embargo, los detectores terrestres, tales como el Observatorio de Ondas Gravitacionales por Interferometría Láser (LIGO) o VIRGO, y LISA se complementarán. En el espacio, LISA “oirá” el ruido sordo largo y bajo de las ondulaciones del espacio-tiempo. En la Tierra, LIGO y otros sistemas “oirán” las ondulaciones del espacio-tiempo de frecuencia más alta. LISA observará los binarios miles de años antes de que éstos choquen. Los detectores terrestres observarán otros binarios justo antes de chocar, cuando sus velocidades orbitales son mucho más altas. Se necesitan ambos tipos de observatorios para oír el amplio espectro de ondulaciones en el espacio-tiempo.

Pasando a la científica de LISA, uno de los principales puntos a resaltar es el hecho de que actualmente LISA es el único proyecto de detector de radiación gravitatoria del que conocemos fuentes garantizadas. Se trata de sistemas binarios galácticos con periodos inferiores a 2 horas, conocidos como binarias de verificación ya que serán muy útiles para la calibración de LISA. Además, se espera que LISA observe principalmente las siguientes fuentes de ondas gravitatorias: Sistemas estelares binarios en nuestra galaxia y algunos extragalácticos. LISA detectará varios millones de estos sistemas, la mayor de los cuales formarán un fondo de radiación gravitatoria y los más brillantes podrán resolverse y separarse de este fondo. Caída orbital y colisión de agujeros negros supermasivos. Las observaciones astronómicas nos proporcionan evidencia de que prácticamente todas las galaxias contienen un agujero negro en su núcleo central y que estas, a lo largo de su historia, han sufrido varias colisiones con otras galaxias. Cuando dos galaxias colisionan para formar una nueva, sus respectivos agujeros negros migran hacia el nuevo núcleo debido a la fricción dinámica, donde forman un sistema binario cuya órbita, a partir de un determinado momento, se reducirá por emisión de radiación gravitatoria hasta la colisión final, que resultará en la de un único agujero negro.

Un equipo, con participación del Instituto de Astrofísica de Canarias (IAC), ha descubierto, por casualidad, una docena de sistemas estelares binarios con peculiaridades jamás vistas. Se trata de sistemas compuestos por pares de enanas blancas más ligeras de lo habitual y que, según sus cálculos, acabarán fusionándose en un único objeto.

LISA será capaz de detectar todas estas colisiones dentro de nuestro Universo observable. La captura y posterior caída orbital de objetos estelares compactos (enanas blancas, estrellas de neutrones, agujeros negros estelares) hacia agujeros negros supermasivos. En el núcleo galáctico, en torno a los agujeros negros supermasivos, hay una gran concentración de objetos estelares compactos. Eventualmente, y debido a interacciones gravitatorias entre ellos, uno de estos objetos estelares puede ser capturado por la gravedad del agujero negro supermasivo e una larga caída en espiral hacia este (debido a la emisión de radiación gravitatoria del sistema) hasta ser finalmente absorbido por él. Esta caída es lenta. De tal forma que LISA podrá detectar la radiación gravitatoria emitida durante cientos de miles de órbitas durante el último año de uno de estos sistemas, y esto supone que podremos extraer sus parámetros físicos co una gran precisión. Fondos de radiación gravitatoria de origen cosmológico. De acuerdo con esa mayoría de mecanismos teóricos que los predicen, el espectro de estos fondos es muy amplio (en algunos casos es plano o ligeramente inclinado) y pueden ser observados por detectores que operen en diferentes partes del espectro gravitatorio.

La detección de las fuentes descritas permitirá desarrollar una ciencia muy amplia y revolucionaria, que influenciará tanto la Astrofísica y la Cosmología como la Física Fundamental. Sobre la ciencia que se espera desarrollar con LISA podemos destacar: comprensión de la dinámica de los núcleos galácticos; comprobar la validez de diferentes modelos de de galaxias; comprobar si los agujeros negros son como los describe la Relatividad General (caracterizados únicamente por su masa y momento angular intrínseco); poner a prueba teorías alternativas a la Relatividad General; etc.

Aparte de los detectores de ondas gravitatorias descritos, se ha propuesto otra de detectar ondas gravitatorias basada en el ajuste temporal (timing) de un conjunto de púlsares con periodos del orden de milisegundos. Cuando una onda gravitatoria pasa a través de la región entre los púlsares y la Tierra produce cambios en los tiempos de llegada de los pulsos. Con una tecnología adecuada, un buen de púlsares (un par de decenas) y un tiempo de observación suficientemente largo (unos diez años), la presencia de ondas gravitatorias, en la banda ultra baja, entre 10⁻⁹ y 10⁻⁷ Hz, puede ser detectada. Las fuentes en banda incluyen los agujeros negros más masivos, con masas superiores a cientos de millones de veces la masa del Sol, y fondos de radiación gravitatoria de origen diverso.

La Astronomía de Ondas Gravitatorias se inició durante la segunda mitad del siglo pasado y ha de tener su época de esplendor a lo largo de la primera mitad del presente, con la puesta en funcionamiento de la segunda generación de detectores terrestres como LIGO, VIRGO, Y LCGT, con el futuro observatorio espacial LISA, con la observación de múltiples púlsares y con el desarrollo de proyectos de tercera generación que están siendo actualmente debatidos y diseñados. Cada vez que en Astronomía se ha abierto una nueva ventana a la exploración del Universo (infrarroja, radio, rayos X, rayos gamma, etc.) se han realizado grandes descubrimientos. Muchos de ellos han consistido en la aparición de nuevos objetos astronómicos y/o nuevos fenómenos físicos, la mayoría de veces de forma inesperada. La Astronomía de Ondas Gravitatorias abrirá una nueva ventana usando una nueva herramienta, un mensajero cósmico, la gravedad, y con ello nos esperan nuevas sorpresas y grandes descubrimientos que pueden cambiar nuestra forma de ver el Universo.

Excepto algunos adornos personales.

La Fuente: Revista de Física, volumen 25 nº 2/2011

Autores: Alberto Lobo y Carlos F. Sopuerta

Totales: 82.297.823

Totales: 82.297.823 Conectados: 52

Conectados: 52