May

20

Biosfera, hidrosfera…¡La Tierra!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en La magia de la Tierra ~

Clasificado en La magia de la Tierra ~

Comments (1)

Comments (1)

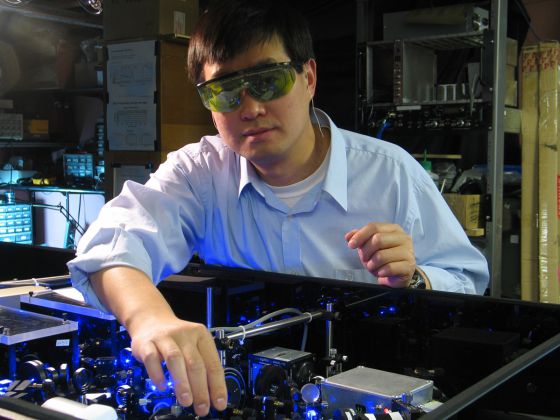

La BIOSFERA en realidad no es una capa de la Tierra; es el conjunto de todos los ecosistemas existentes en la Tierra, es decir, de todos los seres vivos junto con el medio en el que viven. Por eso, la biosfera es parte de la corteza terrestre, pero también es parte de la hidrosfera y de la atmósfera.

En este dibujo puedes observar lo que supone el agua respecto al conjunto de nuestro Planeta. Recuerda que el 97% del agua de la Tierra es salada y solo un 3% es agua dulce.

La biosfera y la hidrosfera están estrechamente relacionadas: el agua es el elemento esencial de todas las formas de vida, y la distribución del agua en el planeta (es decir, los límites de la hidrosfera) condiciona directamente la distribución de los organismos (los límites de la biosfera). El término biosfera, de reciente creación, indica el conjunto de zonas de la Tierra donde hay vida, y se circunscribe a una estrecha región de unos 20 Km de altura comprendida entre las cimas montañosas más elevadas y los fondos oceánicos más profundos. Sólo pueden hallarse formas de vida en la biosfera, donde las condiciones de temperatura, presión y humedad son adecuadas para las más diversas formas orgánicas de la Tierra.

Ciclo del agua

Obviamente, las fronteras de dicha “esfera” son elásticas y su extensión coincide con la de la hidrosfera; se superpone a las capas más bajas de la atmósfera y a las superficiales de la litosfera, donde se sumerge, como máximo, unos 2 Km. Sin embargo, si por biosfera se entiende la zona en la que hay vida así como la parte inorgánica indispensable para la vida, deberíamos incluir en este concepto toda la atmósfera, sin cuyo “escudo” contra las radiaciones más fuertes no existiría ningún tipo de vida; o la corteza terrestre entera y las zonas superiores del manto, sin las cuales no existiría la actividad volcánica, que resulta necesaria para enriquecer el suelo con nuevas sustancias minerales.

Por tanto, la biosfera es un ecosistema tan grande como el planeta Tierra y en continua modificación por causas naturales y (desgraciadamente) artificiales.

Es importante cuidar los ecosistemas de la Tierra, es mucho lo que nos jugamos en ello

Las modificaciones naturales se producen a escalas temporales muy variables: en tiempos larguísimos determinados por la evolución astronómica y geológica, que influyen decididamente en las características climáticas de los distintos ambientes (por ejemplo, durante las glaciaciones), o en tiempos más breves, relacionados con cambios climáticos desencadenados por sucesos geológicos-atmosféricos imprevistos (por ejemplo, la erupción de un volcán, que expulsa a la atmósfera grandes cantidades de cenizas capaces de modificar el clima de extensas áreas durante periodos considerables).

En cambio, las modificaciones artificiales debidas a la actividad humana tienen efectos rápidos: la deforestación producida en África por las campañas de conquista romanas contribuyó a acelerar la desertificación del Sahara, como tampoco hay duda de que la actividad industrial de los últimos siglos determina modificaciones dramáticas y repentinas en los equilibrios biológicos.

La biosfera es el punto de encuentro entre las diversas “esferas” en las que se subdivide la Tierra: está surcada por un flujo continuo de energía procedente tanto del interior del planeta como del exterior, y se caracteriza por el intercambio continuo de materia, en un ciclo incesante que une todos los entornos.

La biosfera es el ecosistema global. Comprende todos los ecosistemas y organismos vivos en la atmósfera, en la tierra (biosfera terrestre), o en los océanos (biosfera marina), incluida materia orgánica muerta derivada (por ejemplo, basura, materia orgánica en suelos y desechos oceánicos).

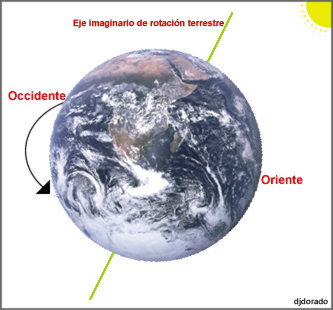

Pero no por esta razón hay vida por todas partes, pues la vida requiere condiciones particulares e imprescindibles. Existen determinados elementos físicos y químicos que “limitan” el desarrollo de la vida. La presencia y disponibilidad de agua es el primero y el más importante. El agua es el disolvente universal para la química de la vida; es el componente primario de todos los organismos y sin agua la vida es inconcebible (Tales de Mileto fue el primero en darse cuenta de ello). Pero no sólo es eso: al pasar del estado sólido al líquido y al gaseoso y viceversa, el agua mantiene el “efecto invernadero natural”, capaz de conservar la temperatura del planeta dentro de los niveles compatibles con la vida (es decir, poco por debajo de los 0º C y poco por encima de los 40º C).

La presión, que no deberá superar mucho el kilogramo por centímetro cuadrado (como sucede alrededor de los 10 m de profundidad en el mar), así como una amplia disponibilidad de sales minerales y de luz solar (indispensable – como expliqué antes – para la vida de las plantas) son también factores que marcan las posibilidades de vida.

Muchos son los misterios que se esconden en las profundidades marinas

Está claro que se nos ha dado un lugar privilegiado, que reúne todas y cada una de las condiciones excepcionales para la vida, y somos tan ignorantes que aún siendo un bien escaso (en nuestro enorme Sistema Solar, parece que el único), nos lo queremos cargar. Pero sin querer, me marcho por las ramas y me desvío del tema principal, la evolución por la energía, y como está directamente implicada, hablemos un poco de nuestra casa.

El planeta Tierra

Cinturones de Van Allen: Fuerzas invisibles actúan para preservarnos de energías nosivas provenientes del espacio interestelar.

Las fuerzas que actúan sobre la Tierra, como planeta en el espacio, tiene profundas implicaciones energéticas. La gravitación ordena y orienta, y obstaculiza y facilita los flujos de energía cinética. La rotación genera la fuerza centrífuga y la de Coriolis: la primera achata el planeta por los polos ensanchándolo por el ecuador, y la segunda desvía los vientos y las corrientes de los océanos (a la derecha del hemisferio norte y a la izquierda en el hemisferio sur). La rotación es también la causa de los ritmos diarios de las plantas y animales, y de la desaceleración de la Tierra, que alarga el día un promedio de 1’5 ms cada siglo, lo que representa una pérdida de tres teravatios por fricción de mareas.

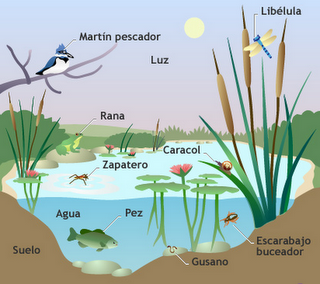

La tierra presenta varios movimientos en su viaje anual alrededor del Sol. Los más conocidos son el movimiento de Rotación y el movimiento de Traslación.

En el movimiento de Rotación, la Tierra da una vuelta sobre si misma en 24 horas alrededor de un eje imaginario. Es decir en lo que denominamos un día. El de traslación se computa por un año.

Pero ni la gravitación ni la rotación (fricción) hacen de la Tierra un planeta único entre los cuerpos celestes de nuestro entorno. Su exclusividad procede de sus propiedades térmicas internas, que causan los ciclos geotectónicos que modifican la superficie, y de su atmósfera, océanos y plantas que transforman la radiación solar que reciben. Los orígenes de estos procesos no están claros.

Podemos fijar la edad de la Tierra en algo más de los 4.000 millones de años por la desintegración de los isótopos radiactivos, pero poco podemos asegurar sobre la formación del planeta o sobre la energética de la Tierra primitiva. Sobre el tema circulan varias teorías, y es muy plausible que el origen del Sistema Solar planetario fuera una nube interestelar densa en la que el Sol se formó por una inestabilidad gravitatoria y que la posterior aglomeración del resto de esta materia dispersa, que giraba a distintas distancias, a su alrededor, diera lugar a los planetas. No está claro si al principio la Tierra estaba extremadamente caliente o relativamente fría. Me inclino por lo primero y estimo que el enfriamiento fue gradual con los cambios de atmósferas y la creación de los océanos.

Los océanos de la Tierra vistos desde el espacio

Las incertidumbres geológicas básicas se extienden hasta el presente. Diferentes respuestas a cuestiones como la cantidad de 40K en el núcleo terrestre o sobre la convección del magma en el manto (hay una o dos celdas) dan lugar a diferentes explicaciones para el flujo de calor y la geotectónica de la Tierra. Lo que sí está claro es que el flujo interno de calor, menos de 100 mW/m2, tiene un efecto pequeño comparado con la reflexión, absorción y emisión de la radiación solar.

El balance de la radiación terrestre (Rp) en la capa alta de la atmósfera es la suma de la radiancia extraterrestre (la constante sola Q0) reducida por el albedo planetario y el flujo saliente de larga longitud de onda (Qi): Rp = Q0(1-ap) + Qi = 0. El flujo emitido es igual a la suma de la radiación atmosférica y la terrestre: Qi = Qea + Qes. Los balances de la radiación en la atmósfera (Ra) y en la superficie de la Tierra (Rs) son iguales, respectivamente, a la diferencia entre la correspondiente absorción y emisión: Ra = Qaa + Qea y Rs = Qas + Qes, de manera que Rp = Ra + Rs = 0. Hay que continuar explicando la radiación saliente con los flujos irradiados y emitidos por la superficie terrestre, el flujo de radiación medio absorbida, etc., etc., etc., con una ingente reseña de símbolos y tedioso esquemas que, a mi parecer, no son legibles para el lector normal y no versado en estos conocimientos. Así que, aunque sea mutilar el trabajo, desisto de continuar por ese camino y prosigo por senderos más amenos y sugestivos para el lector.

La fuente más importante del calentamiento atmosférico proviene de la radiación terrestre de longitud de onda larga, porque el flujo de calor latente es una contribución secundaria y el flujo de calor sensible sólo es importante en las regiones áridas donde no hay suficiente agua para la evaporación. Los océanos y los continentes también reciben indirectamente, irradiadas por la atmósfera, la mayor parte de su calor en forma de emisiones de longitudes de onda larga (4 – 50 μm). En este flujo de radiación reenviado hacia la superficie terrestre por los gases invernadero, domina a la radiación del vapor de agua, que con una concentración variable, emite entre 150 y 300 W/m2, y al que también contribuye el CO2 con unos 75 W/m2.

El intercambio de radiación de longitud de onda larga entre la superficie y la atmósfera sólo retrasa temporalmente las emisiones de calor terrestre, pero controla la temperatura de la biosfera. Su máximo es casi 400 W/m2 en los trópicos nubosos, pero es importante en todas las estaciones y presenta significativas variaciones diarias. El simple paso de una nube puede aumentar el flujo en 25 W/m2. Las mayores emisiones antropogénicas de gases invernadero han aumentado este flujo en cerca de un 2’5 W/m2 desde finales del siglo XIX.

Como era de esperar, las observaciones de los satélites confirman que el balance de energía de la Tierra está en fase con la radiación solar incidente (Q0), pero la radiación media saliente (Qi) está desfasada con la irradiancia, alcanzando el máximo durante el verano en el hemisferio norte. La distribución asimétrica de los continentes y el mar explica este fenómeno. En el hemisferio norte, debido a la mayor proporción de masa terrestre, se experimentan mayores cambios estacionales que dominan el flujo global de la radiación saliente.

Quizás el resultado más sorprendente que se deriva de las observaciones por satélite sea que, estacionalmente, se observan cierto déficit y superávit de radiación y el balance de la radiación en el planeta no es igual a cero, pero sin embargo, en cada hemisferio la radiación anual está en equilibrio con el espacio exterior. Además, la contribución atmosférica por transporte de energía hacia los polos es asimétrica respecto al ecuador con valores extremos de unos 3 PW cerca de los 45º N, y -3 PW cerca de 40º S.

Podría continuar hablando sobre los vientos, los terremotos, las lluvias y otros fenómenos atmosféricos, sin embargo, no creo que, por ser estos fenómenos naturales muy conocidos de todos, pudieran tener gran interés. Pasemos pues a comentar sobre los océanos.

Las lluvias tan necesarias para todos y para todo

Agua, mejor que Tierra, habría sido el nombre adecuado para el tercer planeta, puesto que los océanos cubren más del 70 por ciento de la superficie terrestre, con una profundidad media de 3’8 Km. Debido a las especiales propiedades térmicas del agua, éstas constituyen un extraordinario regulador del balance energético del planeta.

Este líquido tiene cinco ventajas termodinámicas importantes: un punto de ebullición inusualmente alto, debido a su capacidad para formar enlaces de hidrógeno intermoleculares; un calor específico de 2’5 a 3’3 veces más elevado que el del suelo; una capacidad calorífica (calor específico por unidad de volumen) aproximadamente seis veces mayor que la tierra seca; un altísimo calor de vaporización que le permite transportar una gran cantidad de calor latente; y su relativamente baja viscosidad, que le convierte en un eficiente transportador de calor en los océanos mediante miríadas de remolinos y caudalosas corrientes.

No es sorprendente, pues, que los océanos, que tienen cerca del 94 por ciento de toda el agua, sean determinantes en el balance energético del planeta. Cuatro quintas partes de la radiación solar que llega a la Tierra entra en la atmósfera que cubre los océanos, los cuales con un albedo superior al 6% absorben la energía con una tasa cercana a 65 PW, casi el doble de la absorción atmosférica total y cuatro veces mayor que la continental. Inevitablemente, los océanos también absorben la mayor parte, casi dos tercios, del calor rerradioirradiado hacia abajo por la atmósfera elevando su ritmo de calentamiento a los 175 PW.

Arrecife poco profundos y ecosistemas

Salvo en los océanos menos profundos, la interacción aire-mar no afecta directamente a las aguas profundas. Las oscuras y frías aguas de las profundidades marinas están aisladas de la atmósfera por la capa mixta, una capa de poca profundidad que va de pocos metros a pocos cientos de metros y que está afectada por los vientos y el oleaje.

A pesar de que el alto calor específico del agua limita el rango de variación, las temperaturas de esta capa sufren importantes fluctuaciones diarias y estacionales. Sin embargo, variaciones relativamente pequeñas de la temperatura de la superficie de los océanos tienen importantes consecuencias climáticas: quizás el mejor ejemplo de esta teleconexión climática sea el fenómeno del Niño, que consiste en una extensión en forma de lengua de las aguas superficiales calientes hacia el este, cuyos efectos se extienden desde Canadá hasta África del sur.

Debido a que la conductividad térmica del agua es muy baja, la transferencia de energía de la capa mixta hacia las profundidades se realiza fundamentalmente mediante corrientes convectivas. Estas corrientes compensan la extremadamente baja fuerza ascensional de las aguas profundas, más calientes, que son desplazadas por el movimiento hacia el ecuador de las corrientes frías provenientes de los polos. En contraste con el gradual ascenso general de las aguas oceánicas, la convección hacia abajo se produce en corrientes bien delimitadas que forman gigantescas cataratas oceánicas. Seguramente la mayor es la que fluye hacia el sur bajo el estrecho de Dinamarca, entre Islandia y Groenlandia, y se sumerge unos 3’5 Km transportando 5 millones de m3/s, un caudal veinte veces mayor que el del Amazonas.

El agua de la vida

Miríadas de corrientes oceánicas, que a menudo viajan cientos de kilómetros a diferentes profundidades, transportan considerables cantidades de energía y sal. Quizás el ejemplo más importante de estas combinaciones de transportes sea la corriente de agua caliente y salada que sale del Mediterráneo a través del estrecho de Gibraltar. Este flujo caliente pero denso desciende sobre la pendiente de la plataforma continental hasta alcanzar el equilibrio entre el peso y el empuje ascensional a unos mil metros de profundidad. Aquí se separa en dos celdas lenticulares que se mueven durante siete años hacia el este y hacia el sur, respectivamente, hasta que decaen o chocan contra alguna elevación marina.

Un mapa global de los flujos de calor desde la superficie oceánica hasta las capas profundas muestra claramente máximos longitudinales a lo largo del ecuador y a lo largo de aproximadamente 45º S en los océanos Atlántico e Índico. Esta transferencia es también importante en algunas áreas costeras donde se producen intensos flujos convectivos ascendentes que intercambian calor entre las aguas superficiales y las profundas, como ocurre en la costa de California y al oeste de África. Un flujo en dirección contraria, que calienta la atmósfera, se produce en las dos mayores corrientes oceánicas calientes, la corriente del Golfo en el Atlántico y la de Kuroshio en el Pacífico oriental.

Aguas termales y sulfurosas

Todas la regiones donde se produce este ascenso de aguas calientes (a lo largo de las costas del continente americano, África, India y la zona ecuatorial del Pacífico occidental) se distinguen fácilmente por los elevados niveles de producción de fitoplancton, causados por un importante enriquecimiento de nutrientes, comparados con los que, de otra manera, corresponderían normalmente a las aguas superficiales oligotrópicas.

La radiación transporta la mayor parte (casi 4/5) de la energía que fluye desde la capa mixta hasta la atmósfera, y el resto del flujo calorífico se produce por calor latente en forma de vapor de agua y lluvias.

Aún no se ha realizado una valoración cuantitativa del transporte total para cada latitud, pero en el océano Atlántico hay transferencia de calor hacia el norte a lo largo de toda su extensión, alcanzando en el trópico un valor aproximado de 1 PW, flujo equivalente al que se produce en el Pacífico norte. En el Pacífico sur, el flujo de calor hacia el polo a través del trópico es de 0’2 PW. La parte occidental del Pacífico sur puede constituir la mayor reserva de calor del Atlántico sur, de igual modo que es probable que el océano Índico sur constituya una reserva del Pacífico.

Ahora tocaría comentar algo sobre los ríos del planeta, sin embargo, lo obvio y me dirijo directamente a comentar sobre el calor de la Tierra.

Aunque la Tierra se formara inicialmente a partir de materia fría (material cósmico) que se contrajo por acción de la gravedad, durante la formación posterior del núcleo líquido y en los periodos de intensa actividad volcánica se ha liberado una enorme cantidad de calor. Los frecuentes impactos de objetos pesados también han contribuido al calentamiento de la superficie. Hay mucha incertidumbre sobre la historia térmica de la Tierra de los últimos 3.000 millones de años, durante los cuales el planeta se ha ido enfriando y una gran parte de este flujo de calor ha alimentado los movimientos geotectónicos globales, creando nueva corteza en las dorsales oceánicas; un proceso que ha ido acompañado de terremotos recurrentes y erupciones volcánicas de lava, cenizas y agua caliente.

Solamente hay dos posibles fuentes de calor terrestre, pero la importancia relativa de las respectivas contribuciones no está aún muy clara. El calor basal, liberado por un lento enfriamiento del núcleo terrestre debe representar una gran parte del flujo total, si bien cálculos basados en la desintegración radiactiva del U235, U238, Th232 y K40 sugieren que éste representa al menos la mitad y quizás hasta nueve décimos del flujo total de calor del planeta. Esta disparidad obedece a la incertidumbre en la concentración de K40 en la corteza terrestre. Pero sea cual sea la proporción, el flujo total, basado en miles de medidas realizadas desde los años cincuenta, está próximo a los 40 TW.

Aunque inicialmente se pensó que los flujos continentales y oceánicos eran aproximadamente iguales, en realidad difieren de forma sustancial. Las regiones del fondo oceánico más recientes contribuyen con más de 250 mW/m2, cantidad que supera hasta tres veces las zonas continentales más recientes. El flujo medio para todo el fondo marino es aproximadamente igual a 95 mW/m2, lo que representa un 70% más que el correspondiente a la corteza continental. El flujo medio global es de 80 mW/m2, unos tres órdenes de magnitud inferior al valor medio del flujo de calor de la radiación solar global.

Llegados a este punto, tengo que respirar. ¡Qué maravilla! ¡La Tierra!

emilio silvera

May

14

LLa física aplicada ayuda a descifrar las causas de la muerte súbita

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Enigmas del Corazón ~

Clasificado en Enigmas del Corazón ~

Comments (0)

Comments (0)

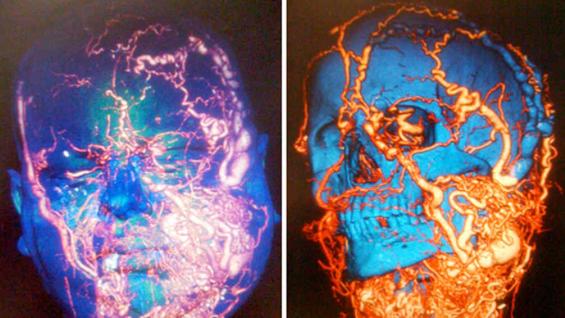

Investigadores del Departamento de Física Aplicada de la UPC, en España, junto con un equipo de la California State University de los Estados Unidos, han demostrado por primera vez que la transición en la alternancia cardiaca, una arritmia potencialmente mortal, comparte características con el ordenamiento ferromagnético de los metales. La investigación ayuda a entender mejor cómo se origina la muerte súbita y abre la puerta a diseñar nuevos fármacos para evitarla.

Las muertes súbitas cardíacas representan aproximadamente el 10% de los casos de muerte natural y la mayoría se deben a la fibrilación ventricular. En los Estados Unidos esto representa unas 300.000 muertes al año y en España, unas 20.000. Investigadores del Departamento de Física Aplicada de la Universitat Politècnica de Catalunya (UPC), junto con científicos de la California State University han demostrado, por primera vez, que la transición a la alternancia cardiaca, una arritmia relacionada con un mayor riesgo de muerte súbita, comparte características comunes con el ordenamiento ferromagnético de los metales. Esta nueva medida física permite entender mejor las causas de la muerte súbita y permitirá avanzar en el diseño de fármacos que puedan evitarlo. El artículo, titulado Calcium Alternans is Due to an Order-Disorder Phase Transition in Cardiac Cells, ha sido publicado en la revista científica Physical Review Letters.

Hoy en día, las enfermedades cardíacas suponen una de las principales causas de muerte en los países desarrollados. De particular relevancia es la muerte súbita cardiaca, donde se produce una pérdida brusca de la función cardiaca. En situaciones normales, el corazón actúa como una bomba donde el orden de contraerse y bombear sangre se origina por pequeños cambios en las propiedades eléctricas de las células miocárdicas. Una parte importante de los casos de muerte súbita se deben a problemas en la sincronización de esta orden eléctrica, dando lugar a una contracción desordenada del corazón conocida como fibrilación ventricular. En este estadio, el corazón no es capaz de bombear la sangre y la muerte ocurre en pocos minutos, a menos que se administre un choque desfibrilador.

Uno de los posibles desencadenantes de la fibrilación ventricular es una arritmia conocida como alternancia cardiaca, donde la contracción del corazón se produce de manera coordinada en cada latido, pero su intensidad varía dando lugar a una contracción fuerte y débil en latidos alternativos. Para entender el origen de esta arritmia es necesario estudiar cómo se produce la contracción dentro de la célula, donde existen cientos de pequeñas subunidades compuestas por agrupaciones de canales que liberan iones de calcio cuando reciben la orden eléctrica. Esto es lo que marca la intensidad de la contracción: si liberan más calcio, la contracción es más fuerte; en cambio, si casi no liberan, hay poca contracción.

![Blas Echebarria, del Departamento de Física Aplicada de la Universitat Politècnica de Catalunya. (Foto: UPC) [Img #26821]](http://noticiasdelaciencia.com/upload/img/periodico/img_26821.jpg)

Blas Echebarria, del Departamento de Física Aplicada de la Universitat Politècnica de Catalunya. (Foto: UPC)

Los científicos Enric Álvarez-Lacalle y Blas Echebarria, del Departamento de Física Aplicada de la UPC, junto con investigadores de la California State University, han demostrado, mediante modelos de simulación, que la alternancia se produce debido a un tipo de transición que ha intrigado a los físicos desde hace décadas, una transición de desorden en el orden estudiada originalmente para entender la pérdida de las características ferromagnéticas al aumentar la temperatura por encima de un umbral límite.

Un material ferromagnético está formado por pequeños imanes que pueden enfocarse en una dirección o en otra. Si cada uno de estos imanes apunta en una dirección diferente, es decir, si el sistema está desordenado, su efecto magnético se anula. En cambio, por debajo de una cierta temperatura, todos los pequeños imanes comienzan a enfocarse hacia la misma dirección y el sistema se ordena. Esto hace que todo el conjunto se comporte como un gran imán.

En el caso del corazón, cada subunidad dentro de la célula encargada de liberar calcio puede decidir hacerlo o no. Cuando esto sucede de una manera desordenada, hay tantas células que liberan como que no, y el calcio total liberado es siempre el mismo, no varía. En cambio, en algunas situaciones se da una transición hacia un estado ordenado, como ocurre en los materiales ferromagnéticos. En este estado, todas las células deciden liberar o no liberar calcio al mismo tiempo, dando lugar a una secuencia de contracciones fuertes y débiles y, en último caso, a una transición hacia la fibrilación ventricular. La conclusión parece ser que el orden, en algunos casos, mata.

Según los científicos, entender bien cómo se produce la transición que causa la muerte súbita puede ayudar a diseñar fármacos que la eviten. Los resultados obtenidos de la investigación abren la puerta a estudiar posibles aplicaciones.

Sobre el siguiente paso de la investigación, Blas Echebarria explica que “actualmente estamos estudiando si el mismo efecto se observa en las células auriculares. Esto supondría un paso para entender la fibrilación auricular que, a pesar de no provocar la muerte súbita como la ventricular, conlleva un elevado riesgo de embolia y presenta una prevalencia muy alta, sobre todo en personas mayores de 60 años, disminuyendo su calidad de vida “. Para ello cuentan con el apoyo de científicos del Instituto de Ciencias Cardiovasculares de Cataluña (ICCC-CSIC), los experimentos de los que intentan modelizar. (Fuente: UPC)

May

12

El reloj más preciso del mundo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Físicos estadounidenses crean un reloj atómico de estroncio que retrasa o adelanta un segundo cada 15.000 millones de años.

“Tendrían que pasar 15.000 millones de años para que el nuevo reloj atómico creado por físicos de EE UU retrasara un segundo. Para hacerse una idea, la edad del universo apenas llega a los 14.000 millones de años. El reloj ofrece tal precisión y estabilidad que podrían alumbrar descubrimientos científicos ni siquiera aún imaginados.

Como los relojes mecánicos, los atómicos se aprovechan de las oscilaciones. Pero en su interior no llevan un minúsculo engranaje o péndulo ni cuarzo al que se hace vibrar, sino átomos que oscilan de forma natural a una determinada frecuencia (expresada en hercios). El primer reloj atómico se creó en 1949 y 20 años más tarde, la Oficina Internacional de Pesos y Medidas adoptó esta tecnología para fijar la duración exacta del segundo: 9.192.631.770 ciclos de un átomo de cesio 133 a una temperatura de cero absoluto. Los relojes atómicos de cesio más avanzados adelantan o atrasan un segundo cada 300 millones de años.

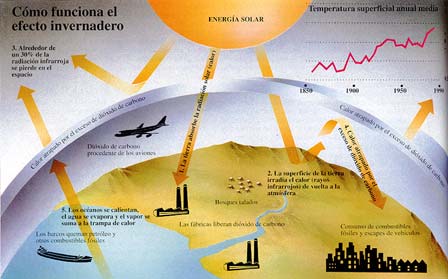

Físicos del Instituto Nacional de Estándares y Tecnología (NIST), de EE UU, de donde salió el primer reloj atómico en 1949, han logrado un doble récord de precisión con un reloj experimental que usa átomos de estroncio en vez de los de cesio. Sus cálculos apuntan a que los agentes que afectan al tictac atómico, como la gravedad o los campos electromagnéticos, necesitarían 15.000 millones de años para que el reloj atrasara o adelantara un segundo.

El enorme incremento en la precisión tiene una base natural y objetiva. Mientras los átomos de cesio 133 tienen aquellos 9.000 millones de ciclos por segundo, los del estroncio lo hacen a un ritmo de 431 billones por segundo. Además de preciso el nuevo reloj atómico es muy estable. En el campo de la cronometría, la estabilidad se refiere a la coincidencia en la duración de cada tictac con los demás. Aquí, esta bestia del tiempo ha mejorado en un 50% respecto a la marca obtenida por este mismo equipo de investigadores el año pasado, según explican en Nature Communications.

Para funcionar, los relojes atómicos usan una red creada con rayos láser que se entrecruzan atrapando los átomos en su baile oscilatorio dentro de una cámara de vacío. Esta malla es una de sus grandes ventajas, ya que apoyan sus mediciones en una nube de átomos y no en uno solo. Además, no hay que enfriar de forma artificial los átomos.

“El reloj opera a temperatura ambiente”, dice en una nota el físico del centro conjunto de investigación del NIST y la Universidad Boulder de Colorado (EE UU), Jun Ye. “Esto es uno de los aspectos más importantes de nuestro enfoque, ya que podemos operar el reloj con una configuración sencilla y mantener al mismo tiempo la incertidumbre por la radiación de cuerpo negro al mínimo”, añade. Esta radiación, relacionada con la temperatura, podría afectar a la precisión del reloj.

Entre las aplicaciones que se podrían aprovechar de esta mejora, están todos los sistemas que necesitan de una medida precisa y estable del tiempo, como el GPS, los sistemas de navegación autónoma o las misiones espaciales. Por ejemplo, las actuales transacciones de alta frecuencia en la bolsa exigen estar referenciadas a algún sistema basado en relojes atómicos.

El físico del NIST, Jun Ye, lleva una década investigando con relojes atómicos basado en átomos de estroncio. / J. Burrus/NIST

Pero estos relojes de estroncio y otros elementos como el iterbio son tan precisos y estables que, dándole una vuelta a su uso, podrán servir para investigar las propias fuerzas que han sido las tradicionales enemigas de la medición exacta del tiempo. Al ser casi inmunes a la acción de la gravedad, los campos magnéticos o la temperatura, podrían convertirse en los mejores sensores para medir el más pequeño cambio en ellas.”

¿Hasta dónde queremos llegar?

May

11

Seguimos avanzando en Física

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

La existencia y estabilidad de los átomos depende en gran medida del hecho de que los neutrones son un poco más masivos que los protones. Las masas difieren solo en alrededor de un 0,14 por ciento. Un valor ligeramente más pequeño o más grande de la diferencia de masas habría llevado a un universo radicalmente distinto, con demasiados neutrones, hidrógeno insuficiente, o una escasez excesiva de elementos pesados. La diminuta diferencia de masa es la razón por la que los neutrones libres se desintegran en promedio en alrededor de diez minutos, mientras que los protones (los inmutables ladrillos de la identidad de cada elemento químico) permanecen estables durante un período prácticamente ilimitado.

En 1972, unos 40 años después del descubrimiento del neutrón por Chadwick en 1932, Harald Fritzsch (Alemania), Murray Gell-Mann (Estados Unidos) y Heinrich Leutwyler (Suiza) presentaron una teoría coherente de las partículas y fuerzas que forman el neutrón y el protón, conocida como cromodinámica cuántica.

Ejemplo de estructura de color de un neutrón. Puede observarse la composición de Quarks y la carga de “color” que adopta.

Hoy en día, sabemos que los protones y los neutrones están compuestos por “quarks u” (por la palabra inglesa Up o Arriba) y “quarks d” (por la palabra inglesa Down o abajo). El protón está hecho de un quark d y dos quarks u, mientras que el neutrón está compuesto de un quark u y dos quarks d.

![La supercomputadora JUQUEEN. (Foto: © Forschungszentrum Jülich) [Img #26440]](http://noticiasdelaciencia.com/upload/img/periodico/img_26440.jpg)

Las simulaciones en superordenadores realizadas durante los últimos años confirmaron que la mayor parte de la masa del protón y del neutrón resulta de la energía transportada por los quarks que los constituyen, de acuerdo con la fórmula de Einstein E=mc2. Sin embargo, una pequeña aportación del campo electromagnético que rodea al protón cargado eléctricamente debería hacerlo aproximadamente un 0,1 por ciento más masivo que el neutrón, que es neutro. El hecho de que la masa medida del neutrón sea mayor es debido a cierta interacción sutil entre efectos electromagnéticos y efectos asociados a diferencia de masas entre quarks, tal y como un equipo de físicos de Francia, Alemania y Hungría, encabezado por Zoltán Fodor, ha conseguido ahora mostrar mediante simulaciones extremadamente complejas en un trabajo para el que ha sido fundamental la labor de cálculo realizada por la supercomputadora JUQUEEN, del Centro de Investigación de Jülich en Alemania.

Los resultados de este trabajo abren la puerta a una nueva generación de simulaciones que serán empleadas para determinar las propiedades de quarks, gluones y otras partículas.”

Lo que nos debe quedar claro es el hecho de que, la Física nunca duerme, y, cada día que pàsa, imaginamos nuevas maneras para desentrañar los secretos de la Naturaleza y la verdadera condición de la materia que, creemos conocer, y, sin embargo, nos esconde, en forma de secretos por desvelar, muchas y sorprendentes verdades que necesitamos conocer para que, la Humanidad, tenga un futuro más esperanzador que el que, en la actualidad tenemos.

May

11

Nuevas maneras de mirar el Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Ondas gravitacionales ~

Clasificado en Ondas gravitacionales ~

Comments (1)

Comments (1)

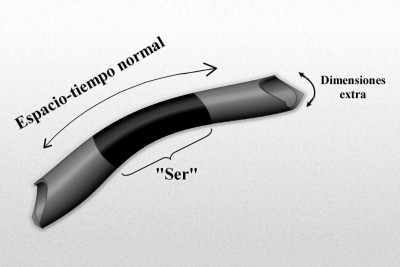

El gráfico representa un modelo de manguera de un espacio-tiempo de dimensiones más altas de tipo Kaluza-Kleim donde la longitud, o mejor, la dimensión a lo largo de la longitud de la manguera representa el 4-espacio-tiempo normal, y la dimensión alrededor de la manguera representa la dimensión extra “pequeñas” (quizá escala de Planck). Imaginemos un “ser” que habite en este mundo, que rebasa estas dimensiones extra “pequeñas”, y por ello no es realmente consciente de ellas.

Las últimas noticias que llegan sobre descubrimientos del Cosmos, siguen siendo publicadas en todos los medios.

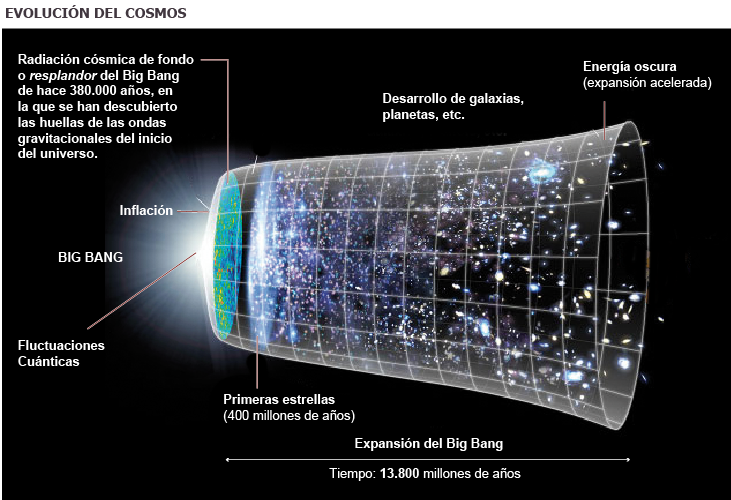

“Un equipo internacional de científicos ha detectado los sutiles temblores del universo un instante después de su origen. Un telescopio estadounidense en el mismísimo polo Sur ha logrado captar esas huellas en el cielo que suponen un espaldarazo definitivo a la teoría que mejor explica los primeros momentos del cosmos, denominada inflación y propuesta hace más de tres décadas. Esa inflación fue un crecimiento enorme y muy rápido del espacio-tiempo inicial y, a partir de ese momento, el universo siguió expandiéndose pausadamente, hasta ahora, 13.800 millones de años después. Es la teoría del Big Bang, pero con un complemento fundamental al principio de todo. Como dice Alan Guth, el científico estadounidense que propuso, a principio de los ochenta, la inflación cósmica, “exploramos el bang del Big Bang”.

Lo que sí parece cierto es que, cuando sepamos capturar y leer las ondas gravitatorias que estamos buscando para tratar de traducir los mensajes que nos envían muchos fenómenos que ocurrieron y siguen ocurriendo en el Univero, entonces, habremos logrado decorrer el velo que ahora impide conocer un nuevo “universo” con otros escenarios y otras perspectivas. Muchos son los autores que nos han hablado de ellas y, por fín, parece que van siendo localizadas.

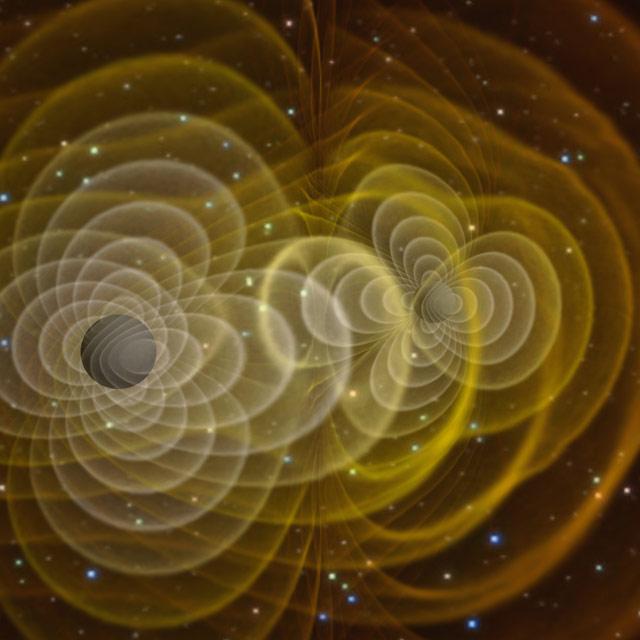

Ondas gravitatorias que salen de un agujero negro pulsante expandiéndose por el espacio a inconmensurables distancias, como si de las ondas formadas en un tranquilo lago se tratara, las de gravedad, funcionan de forma similar.

Ondas gravitatorias de un Agujero Negro pulsante (que los hay)

Desde sus comienzos la Astronomía ha dominada por el uso de instrumentos que detectan luz, desde los primeros telescopios ópticos hasta los más modernos detectores de rayos X y gamma. Fruto de este desarrollo han sido grandes descubrimientos que han ido configurando nuestra de comprender el Universo. Durante el siglo pasado se han empezado a desarrollar nuevas formas de Astronomía basadas en mensajeros diferentes a la luz: detectores de rayos cósmicos, de neutrinos y de ondas gravitacionales. Las ondas gravitacionales son una consecuencia de la Teoría General de la Relatividad de Einstein y corresponden a oscilaciones de la geometría del espacio-tiempo que se propagan de similar a las ondas electromagnéticas.

Tenemos que buscar la manera de “ver” y “detectar” las ondas gravitacionales

La debilidad de la fuerza gravitatoria hace que la detección de estas ondas suponga un gran reto tecnológico. Sin embargo, desde el punto de vista científico son una gran , ya que transportan información prácticamente incorrupta de las fuentes que la generaron, la cual en muchos de los casos es difícil o imposible de obtener por otros medios. Este artículo es una introducción a la Astronomía de Ondas Gravitatorias, a sus métodos, a su estado actual y sobre todo a las grandes perspectivas que ofrece con la apertura de una nueva ventana a la exploración del Universo que tendrá un gran impacto tanto en Astrofísica como en Cosmología e incluso en Física Fundamental.

Dentro del marco de la Física Teórica, la gravedad aparece una de las cuatro interacciones fundamentales, siendo las otras tres la electromagnética y las interacciones nucleares débil y fuerte. Electromagnetismo y gravitación son las dos únicas interacciones de largo rango de acción (en principio ilimitado), en contraposición a las dos interacciones nucleares, cuyo rango de acción está limitado esencialmente a regiones cuyo tamaño es del orden de un núcleo atómico o inferior. Una consecuencia directa de esto es que las interacciones nucleares no pueden transportar información a distancias macroscópicas y por lo tanto no son de utilidad la Astronomía. Las otras dos, electromagnetismo y gravedad, se propagan a través del espacio a la velocidad de la luz, tal y como nos indican las teorías de Maxwell y Einstein respectivamente, y tal como comprobamos en diferentes observaciones y experimentos.

Muchos son los fenómenos que no sabemos entender

Lo que determina la fuerza que estas interacciones producen son su intensidad y las correspondientes susceptibilidades de la materia a ellas, lo que denominamos cargas, la carga eléctrica en el caso electromagnético y la masa en el caso gravitatorio. En la naturaleza observamos que la interacción electromagnética produce fuerzas que son muchos órdenes de magnitud superiores a la de la gravitatoria, que es la más débil de todas las interacciones. Por lo tanto, no es de extrañar que la Astronomía haya dominada completamente por detectores de ondas electromagnéticas y fotones (las partículas cuánticas asociadas a campos electromagnéticos), telescopios ópticos hasta detectores de rayos X y gamma, incluyendo antenas de radio. Gracias a estos instrumentos la Astronomía ha producido grandes revoluciones que han cambiado nuestra percepción del Universo: la Copernicana, que comenzó en el siglo XVI, hasta los descubrimientos en cosmología, que comenzaron en el siglo XX y continúan hoy día.

Vistas como esta son posibles gracias a la luz y a los telescopios

Pero no todo lo que se mide u observa en astronomía es luz, hay otros mensajeros que nos informan sobre lo que sucede en diferentes lugares de nuestro Universo: meteoritos, neutrinos, rayos cósmicos (protones, electrones, etc.), ondas gravitatorias. Los meteoritos nos dan información de nuestro entorno local, principalmente del Sistema Solar. Los neutrinos y rayos cósmicos pueden provenir nuestro entorno local hasta galaxias muy distantes. La detección de estas partículas, mediante técnicas similares a las empleadas en aceleradores de partículas, ha dado lugar a una nueva área de investigación muy activa denominada Astropartículas. El mensajero del que trata este artículo son las ondas gravitatorias y su para la investigación astronómica constituye lo que denominamos Astronomía de Ondas Gravitatorias.

Las ondas gravitatorias son una predicción de la Teoría General de la Relatividad (conocida comúnmente como Relatividad General) propuesta por Albert Einstein (1915) para incluir la gravitación en la estructura espacio-temporal propuesta por él mismo en su Teoría Especial de la Relatividad (1905). Uno de los aspectos más destacados de esta teoría es que el espacio deja de ser un simple contenedor de los fenómenos físicos para convertirse en un objeto dinámico, en el sentido que su geometría cambia conforme a los movimientos y distribuciones de masas y energía. No solo eso, al tiempo físico le sucede algo similar, de que su transcurso también depende de la distribución de masa y energía. En la Teoría de la Relatividad espacio y tiempo aparecen como una única estructura que denominamos espacio-tiempo, cuya geometría está determinada por la distribución de masa y energía, y a su vez, la geometría determina el movimiento de la materia y de la energía.

La geometría del espaciotiempo que nos da toda la sensación de estar determinada por la presencia de grandes masas de materia que curvan el espacio y distorsionan el tiempo a su alrededor, El Agujero negro es el exponente más claro de esto.

De esta , la gravedad aparece como una manifestación de la geometría espacio-tiempo, una elegante implementación del principio Galileano de que todos los objetos, independientemente de su masa y composición, caen con la misma aceleración. Una consecuencia del carácter dinámico del espacio-tiempo en la Relatividad General es que las oscilaciones de su geometría se propagan como ondas con una velocidad, medida localmente, exactamente igual a la velocidad de la luz. Las ondas gravitatorias, al cambiar la geometría local de las regiones que atraviesan, cambian la distancia física objetos, siendo dicho cambio proporcional a la distancia misma y a la amplitud de ondas. Como en el caso electromagmético este es un efecto transverso, es decir, los cambios en la distancia se producen en el plano perpendicular a la dirección de propagación de la onda gravitatoria. Además, tanto ondas electromagnéticas como gravitatorias tienen dos estados de polarización independientes, aunque en teorías de la gravedad alternativas a la Relatividad General puede haber hasta seis polarizaciones independientes.

Una diferencia importante ondas electromagnéticas y gravitatorias tiene que ver con su generación. En el contexto astronómico, las ondas electromagnéticas se generan por cargas aceleradas (emisión predominantemente dipolar), como por ejemplo electrones, cuyo tamaño es muy inferior al de los objetos de los que forman y como consecuencia, pueden emitir luz en una longitud de onda suficientemente pequeña como para realizar imágenes de objetos astronómicos. En contraste, las ondas gravitatorias se generan por cambios temporales de la distribución de masa-energía de un objeto (radiación predominantemente cuadrupolar), y por este motivo sus longitudes de onda suelen ser del orden del tamaño del objeto que las genera o mayores, con lo cual no es posible en general realizar imágenes. En ese sentido se podría decir que la Astronomía de Ondas Gravitatorias está más cercana a la Acústica que a la Óptica.

Es previsible que, dos objetos masivos (estrellas de neutrones, por ejmplo) se encuentran y giran el uno alrededor del otro, deben desprender una serie de ondas gravitacionales que, captadas a cientos o miles de años-luz de la fuente, deben contar el suceso al científico experto.

La relativa debilidad de la gravedad es la causa de que las ondas gravitatorias tengan una amplitud relativamente pequeña y que su detección sea una empresa extremadamente complicada. Ondas gravitatorias producidas por fuentes galácticas, la colisión de dos estrellas de neutrones, inducen desplazamientos del orden del tamaño de un núcleo atómico o inferiores en un detector terrestre de un kilómetro de tamaño. La gran ventaja que proporcionan las ondas gravitatorias es que por su débil interacción con la materia transportan información prácticamente incorrupta de las fuentes astronómicas que las generaron.

La construcción de un detector de ondas gravitatorias supone un gran reto tecnológico, y tal empresa no comenzó hasta los años sesenta, con el pionero de Joseph Weber en detectores resonantes. El principio de funcionamiento de estos detectores de basa en que una onda gravitatoria que atraviese un sólido cambiará su tamaño de forma oscilatoria, excitando de esta forma sus modos propios de oscilación. La idea por lo tanto es crear un dispositivo que sea sensible a las oscilaciones del sólido y nos permita extraer la señal gravitatoria que las ha producido. Varios detectores de este tipo, la mayoría con forma cilíndrica, se han construido en varias partes del mundo y, contrariamente a las aseveraciones de detección de Weber en los años 70, no han conseguido hasta la fecha detectar ondas gravitatorias. De hecho, ningún tipo de detector las ha detectado. Entonces, ¿estamos seguros de que las ondas gravitatorias existen? ¿Tenemos alguna evidencia de su existencia?

No por falta de empeño y proyectos , todavía no se han observado (directamente) las ondas gravitatorias predichas por la teoría de la relatividad de Einstein, aunque hay importantes evidencias (indirectas) sobre su existencia. Son extremadamente débiles, por lo que observarlas es extremedamente difícil.

La respuesta a estas preguntas es que sí, y el principal argumento nos lo proporcionó el descubrimiento en 1974 del primer pulsar binario, PSR B1913+16, por Russell Hulse y Joseph Taylor, lo que les valió el premio Nobel de Física en el año 1993. Los púlsares son estrellas de neutrones dotadas de un enorme campo magnético que acelera partículas cargadas produciendo la emisión de un haz de radiación electromagnética en la dirección del eje magnético. Como el eje magnético no suele estar alineado con el eje de rotación, emisión electromagnética describe un cono, convirtiendo los púlsares en faros cósmicos. Si nuestro planeta se encuentra en la dirección del cono de emisión del púlsar observaremos una serie de pulsos de radio, que en caso de los púlsares con rotación más rápida se dan con un ritmo tan uniforme que los convierte en relojes de precisión comparable a los relojes atómicos (¡el púlsar más rápido conocido completa más de 700 revoluciones por segundo! El de Hulse y Taylor!).

El primer púlsar binario conocido, PSR 1913+16, fue descubierto en 1974. Consiste en un púlsar que tiene 17 pulsaciones por segundo, en una órbita altamente excéntrica con un período de 7,75 horas alrededor de una segunda estrella de neutrones en la que no se han observado pulsaciones. Cada estrella tiene unas 1,4 masas solares, próxima al límite de Chandrasekhar, y el período orbital se está acortando gradualmente debido a la pérdida de energía a través de radiación gravitacional.

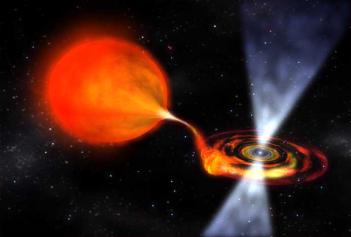

Otro púlsar binario destacable es PSR 1957 + 20, llamado en ocasiones púlsar de la viuda negra, en el que la intensa radiación procedente del pulsar está evaporando su pequeña estrella compañera. Algunos púlsares binarios se saben que son púlsares reciclados que han adquirido altas velocidades de rotación debido a la acreción de gas procedente del compañero.

Escenas como son corrientes en las galaxias

Esto permite observaciones astronómicas de una precisión sin precedentes. El púlsar de Hulse y Taylor orbita alrededor de otra estrella de neutrones de que el tamaño de la órbita es suficientemente pequeño (la distancia mínima entre ellas es aproximadamente la mitad de la distancia de la Tierra al Sol) como para que estas estrellas tan compactas (tienen una masa un poco inferior a una vez y media la masa del Sol pero un radio de tan sólo unos diez kilómetros) se muevan de forma que los efectos relativistas importen para un descripción precisa de sistema. En concreto, el movimiento orbital periódico de tales masas con velocidades considerables (cientos de kilómetros por segundo respecto del centro de masas del sistema binario) produce cambios periódicos significativos en la geometría del espacio-tiempo de su entorno. Y estos cambios periódicos en la geometría no son más que ondas gravitatorias que se propagan en todas las direcciones llevándose consigo energía y momento angular del sistema.

emisión gravitatoria afecta a su vez al movimiento orbital, disminuyendo su tamaño y periodo orbital, tal y como se observa. También se pueden observar otros efectos relativistas como la precesión del periastro de la órbita. Los 35 años de observaciones del púlsar binario de Hulse y Taylor han permitido comprobar que la evolución de su órbita coincide con la predicha por el mecanismo de emisión de radiación gravitatoria de la Relatividad General con una precisión relativa del 0.2%. Actualmente se conocen otros púlsares binarios y algunos de ellos se encuentran en un régimen relativista. El denominado púlsar doble, PSR J0737-3039A/B, un sistema binario compuesto por dos púlsares, se ha convertido recientemente en el mejor test disponible de la Relatividad General, alcanzado precisiones relativas del 0.05%.

Uno de los dos detectores LIGO, situado en Livingston (Luisiana), con brazos de cuatro kilómetros de longitud.- LIGO/CALIFORNIA INSTITUTE OF TECHNOLOGY. Se han ideado para localizar las ondas gravitacionales que vienen del pasado salidas de sucesos como el big bang o agujeros negros que colisionan, estrellas de neutrones que se fusionan y otros eventos cosmológicos que nos pueden contar muchas cosas del Universo que ahora no conocemos.

Estos descubrimientos han contribuido a impulsar el desarrollo de detectores de ondas gravitatorias, y los que hoy en día han alcanzado una mayor sensibilidad son los llamados detectores interferométricos. Son básicamente interferómetros del tipo Michelson-Morley dispuestos en una de L y el concepto de funcionamiento es relativamente simple: cuando una onda gravitatoria incide perpendicularmente al plano del detector produce cambios en la longitud de los brazos del interferómetro, de forma que mientras uno se acorta el otro se alarga y viceversa. Estos cambios dan lugar a interferencias de las cuales se puede inferir el patrón de las ondas gravitatorias que han atravesado el detector. Actualmente hay varios detectores interferométricos terrestres en operación: LIGO en los Estados Unidos (dos de 4 km y uno de 2 km de brazo); VIRGO en Italia con participación de varios países europeos (3 km de brazo); GEO600 en Alemania con participación británica (600 m de brazo). Aparte hay varios proyectos en desarrollo en diversas partes del planeta, como por ejemplo el LCGT en Japón 83 km de brazo), un ambicioso proyecto recientemente aprobado que sustituye al anterior detector TAMA y al prototipo CLIO, y que se convertirá en el primer detector interferométrico de tipo criogénico. La banda de frecuencias a la que operan está contenida en el rango 10- 10000 Hz. A frecuencias más bajas están limitados por ruido sísmico y el gradiente gravitatorio, mientras que a frecuencias más altas están limitados por el ruido de los fotodetectores.

Pese a que no se han realizado aún detecciones, observaciones de LIGO han servido producir nueva ciencia mediante el análisis de las consecuencias de las no detecciones al nivel de sensibilidad actual. Se pueden destacar dos resultados: (1) En la constelación del Cangrejo hay un púlsar joven resultado de una supernova (explosión de una estrella). La frecuencia rotacional de púlsar disminuye con el tiempo. LIGO ha limitado a un 4% la contribución de una hipotética emisión de radiación gravitatoria, lo cual excluye diversos modelos astrofísicos que trataban de explicar fenómeno. (2) La teoría cosmológica de la gran explosión (Big Bang) requiere una fase primitiva de gran expansión del Universo que daría lugar, entre otras cosas, a un fondo de radiación gravitatoria. Las observaciones de LIGO han puesto límites a la densidad de energía almacenada en este fondo, mejorando los límites impuestos por la teoría de de elementos primordiales, parte a su vez del modelo estándar de la Cosmología. Durante el presente año, tanto LIGO como VIRGO pararán las operaciones para incorporar tecnología avanzada: mejora de los sistemas de vacío, láseres de precisión más potentes y mejoras de los sistemas ópticos y mecánicos. Con esto se logrará una mejora de un orden de magnitud en la sensibilidad, lo cual equivale a aumentar en tres órdenes de magnitud el volumen del cosmos que cubrirán. Al mismo tiempo se realizará la construcción del detector criogénico LCGT en la mina de Kamioka (Japón). Una vez estos modelos avanzados entren en operación se espera que realicen detecciones de radiación gravitatoria con un ritmo, de acuerdo con los pronósticos astrofísicos sobre la información de las fuentes de ondas gravitatorias relevantes, de 10-1000 eventos por año.

En lugares como este, la gravedad interviene para formar estrellas nuevas. La imagen es de NGC 604, una región H II gigante en la galaxia del Triángulo. En estos lugares, la fuerza de Gravedad, las ondas que se emiten al choque del material ahí presente, los vientos estelares… Son el motivo de que el gas y el polvo ahí presentes se distorsionen y formen figuras arabescas que, no pocas veces, están llenas de belleza.

Las principales fuentes astrofísicas y cosmológicas para estos detectores terrestres son: colisiones de sistemas binarios formados por agujeros negros estelares y/o estrellas de neutrones; oscilaciones de estrellas relativistas; supernovas; fondos cosmológicos de diverso origen. Estas observaciones revelarán información clave para entender la de objetos compactos estelares, la ecuación de estado de estrellas de neutrones, la validez de la Relatividad General, etc.

Por otra parte, la Agencia Europea del Espacio (ESA) y la Administración Nacional para el Espacio y la Aeronáutica norteamericana (NASA) colaboran en la construcción de un observatorio espacial de ondas gravitatorias, la Antena Espacial de Interferometría Láser (LISA), que se espera que se lance durante la década de 2020. Hay dos motivos de peso para construir un observatorio espacial. El primero es cubrir la banda de bajas frecuencias, en el rango 3x10⁻⁵ – 0.1 Hz, inaccesible a los detectores terrestres. El segundo es que banda de frecuencias da acceso a fuentes de ondas gravitatorias y a una ciencia completamente diferente, con muchas más implicaciones para el panorama de la Astrofísica y la Cosmología. LISA se compone de tres naves espaciales dispuestas en un triángulo equilátero, de 5 millones de kilómetros de lado, y que siguen una órbita alrededor del Sol. Para que la dinámica propia de cada nave preserve lo más posible la configuración triangular, esta ha de estar inclinada 60º respecto del plano de la eclíptica. De esta el triángulo gira sobre su baricentro una vez por año/órbita, lo cual introduce una modulación en las señales gravitatorias que es muy útil para localizar los objetos que las emitieron. LISA es una misión con una tecnología muy novedosa y exigente que una misión precursora de la ESA, LISA PathFinder, se encargará de demostrar. Nuestro grupo en el Instituto de Ciencias del Espacio (CSIC-IEEC) participa en el desarrollo de esta misión contribuyendo con algunos instrumentos fundamentales, como por ejemplo el ordenador que controlará el denominado LISA Technology Package, el conjunto de experimentos que LISA PathFinder realizará.

LISA hará sus observaciones en un intervalo de frecuencia bajo que no es posible con detectores basados en la Tierra. Estos detectores están afectados por el ruido ambiental de la Tierra, causado por los terremotos y otras vibraciones, y sólo pueden hacer observaciones a frecuencias mayores de 1 hertzio. Sin embargo, los detectores terrestres, tales como el Observatorio de Ondas Gravitacionales por Interferometría Láser (LIGO) o VIRGO, y LISA se complementarán. En el espacio, LISA “oirá” el ruido sordo largo y bajo de las ondulaciones del espacio-tiempo. En la Tierra, LIGO y otros sistemas “oirán” las ondulaciones del espacio-tiempo de frecuencia más alta. LISA observará los binarios miles de años antes de que éstos choquen. Los detectores terrestres observarán otros binarios justo antes de chocar, cuando sus velocidades orbitales son mucho más altas. Se necesitan ambos tipos de observatorios para oír el amplio espectro de ondulaciones en el espacio-tiempo.

Pasando a la científica de LISA, uno de los principales puntos a resaltar es el hecho de que actualmente LISA es el único proyecto de detector de radiación gravitatoria del que conocemos fuentes garantizadas. Se trata de sistemas binarios galácticos con periodos inferiores a 2 horas, conocidos como binarias de verificación ya que serán muy útiles para la calibración de LISA. Además, se espera que LISA observe principalmente las siguientes fuentes de ondas gravitatorias: Sistemas estelares binarios en nuestra galaxia y algunos extragalácticos. LISA detectará varios millones de estos sistemas, la mayor de los cuales formarán un fondo de radiación gravitatoria y los más brillantes podrán resolverse y separarse de este fondo. Caída orbital y colisión de agujeros negros supermasivos. Las observaciones astronómicas nos proporcionan evidencia de que prácticamente todas las galaxias contienen un agujero negro en su núcleo central y que estas, a lo largo de su historia, han sufrido varias colisiones con otras galaxias. Cuando dos galaxias colisionan para formar una nueva, sus respectivos agujeros negros migran hacia el nuevo núcleo debido a la fricción dinámica, donde forman un sistema binario cuya órbita, a partir de un determinado momento, se reducirá por emisión de radiación gravitatoria hasta la colisión final, que resultará en la de un único agujero negro.

Un equipo, con participación del Instituto de Astrofísica de Canarias (IAC), ha descubierto, por casualidad, una docena de sistemas estelares binarios con peculiaridades jamás vistas. Se trata de sistemas compuestos por pares de enanas blancas más ligeras de lo habitual y que, según sus cálculos, acabarán fusionándose en un único objeto.

LISA será capaz de detectar todas estas colisiones dentro de nuestro Universo observable. La captura y posterior caída orbital de objetos estelares compactos (enanas blancas, estrellas de neutrones, agujeros negros estelares) hacia agujeros negros supermasivos. En el núcleo galáctico, en torno a los agujeros negros supermasivos, hay una gran concentración de objetos estelares compactos. Eventualmente, y debido a interacciones gravitatorias entre ellos, uno de estos objetos estelares puede ser capturado por la gravedad del agujero negro supermasivo e una larga caída en espiral hacia este (debido a la emisión de radiación gravitatoria del sistema) hasta ser finalmente absorbido por él. Esta caída es lenta. De tal forma que LISA podrá detectar la radiación gravitatoria emitida durante cientos de miles de órbitas durante el último año de uno de estos sistemas, y esto supone que podremos extraer sus parámetros físicos co una gran precisión. Fondos de radiación gravitatoria de origen cosmológico. De acuerdo con esa mayoría de mecanismos teóricos que los predicen, el espectro de estos fondos es muy amplio (en algunos casos es plano o ligeramente inclinado) y pueden ser observados por detectores que operen en diferentes partes del espectro gravitatorio.

La detección de las fuentes descritas permitirá desarrollar una ciencia muy amplia y revolucionaria, que influenciará tanto la Astrofísica y la Cosmología como la Física Fundamental. Sobre la ciencia que se espera desarrollar con LISA podemos destacar: comprensión de la dinámica de los núcleos galácticos; comprobar la validez de diferentes modelos de de galaxias; comprobar si los agujeros negros son como los describe la Relatividad General (caracterizados únicamente por su masa y momento angular intrínseco); poner a prueba teorías alternativas a la Relatividad General; etc.

Aparte de los detectores de ondas gravitatorias descritos, se ha propuesto otra de detectar ondas gravitatorias basada en el ajuste temporal (timing) de un conjunto de púlsares con periodos del orden de milisegundos. Cuando una onda gravitatoria pasa a través de la región entre los púlsares y la Tierra produce cambios en los tiempos de llegada de los pulsos. Con una tecnología adecuada, un buen de púlsares (un par de decenas) y un tiempo de observación suficientemente largo (unos diez años), la presencia de ondas gravitatorias, en la banda ultra baja, entre 10⁻⁹ y 10⁻⁷ Hz, puede ser detectada. Las fuentes en banda incluyen los agujeros negros más masivos, con masas superiores a cientos de millones de veces la masa del Sol, y fondos de radiación gravitatoria de origen diverso.

La Astronomía de Ondas Gravitatorias se inició durante la segunda mitad del siglo pasado y ha de tener su época de esplendor a lo largo de la primera mitad del presente, con la puesta en funcionamiento de la segunda generación de detectores terrestres como LIGO, VIRGO, Y LCGT, con el futuro observatorio espacial LISA, con la observación de múltiples púlsares y con el desarrollo de proyectos de tercera generación que están siendo actualmente debatidos y diseñados. Cada vez que en Astronomía se ha abierto una nueva ventana a la exploración del Universo (infrarroja, radio, rayos X, rayos gamma, etc.) se han realizado grandes descubrimientos. Muchos de ellos han consistido en la aparición de nuevos objetos astronómicos y/o nuevos fenómenos físicos, la mayoría de veces de forma inesperada. La Astronomía de Ondas Gravitatorias abrirá una nueva ventana usando una nueva herramienta, un mensajero cósmico, la gravedad, y con ello nos esperan nuevas sorpresas y grandes descubrimientos que pueden cambiar nuestra forma de ver el Universo.

Excepto algunos adornos personales.

La Fuente: Revista de Física, volumen 25 nº 2/2011

Autores: Alberto Lobo y Carlos F. Sopuerta

Totales: 77.278.376

Totales: 77.278.376 Conectados: 67

Conectados: 67