Mar

15

Siempre buscaremos nuevas teorías de la Física del Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Teorísa del Todo ~

Clasificado en Teorísa del Todo ~

Comments (1)

Comments (1)

Una reacción nuclear “desafiante”

Una nueva clase de reacción de fisión nuclear observada en el CERN ha mostrado importantes puntos débiles en nuestro entendimiento actual del núcleo atómico. La fisión del mercurio-180 se suponía una reacción “simétrica” que daría lugar a dos fragmentos iguales, pero en lugar de ello ha producido dos núcleos con masas bastante diferentes, una reacción “asimétrica” que plantea un serio desafío a los teóricos.

La Ciencia no duerme. En todo el mundo (ahora también fuera de él -en el espacio), son muchos los Científicos que trabajan de manera tenaz para buscar nuevas formas de alcanzar lo ahora inalcanzable y, para ello, se emplean las más sofisticadas estructuras técnicas de avanzados sistemas tecnológicos que hacen posible llegar allí donde nunca nadie había llegado.

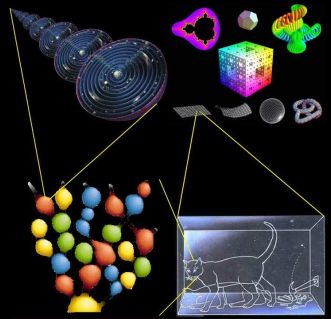

Entre los teóricos, el casamiento de la relatividad general y la teoría cuántica es el problema central de la física moderna. A los esfuerzos teóricos que se realizan con ese propósito se les llama “supergravedad”, “súpersimetría”, “supercuerdas” “teoría M” o, en último caso, “teoría de todo o gran teoría unificada”.

Vista hemisférica de Venus. (Cortesía de NASA)

El segundo planeta a partir del Sol. Tiene la órbita más circular de todos los planetas. Su albedo geométrico medio, 0,65, es el mayor de todos los planetas, como resultado de su cubierta de nubes blancas sin fracturas. En su máximo alcanza magnitud -4,7, mucho más brillante que cualquier otro planeta. Su eje de rotación está inclinado casi 180º con respecto a la vertical, de manera que su rotación es retrógrada. Rota alrededor de su eje cada 243 días, y, por tanto, muestra siempre la misma cara hacia la Tierra cuando los dos planetas se encuentran en su máxima aproximación.

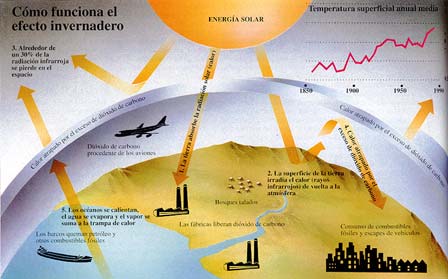

La atmósfera de Venus es en un 96,5% de dióxido de carbono y un 3,5 de nitrógeno, con trazas de dióxido de azufre, vapor de agua, argón, hidrógeno y monóxido de carbono. La presión en la superficie es de 92 bares (es decir, 92 veces la presión a nivel del mar en la Tierra). La temperatura superficial promedio es de 460 ºC debido al “efecto invernadero” en la atmósfera del planeta. Los rayos son muy frecuentes. Existe una densa capa de nubes a una altitud de unos 45/65 Km. compuesta de ácido sulfúrico y gotitas de agua.

VENUS: El Planeta Imposible

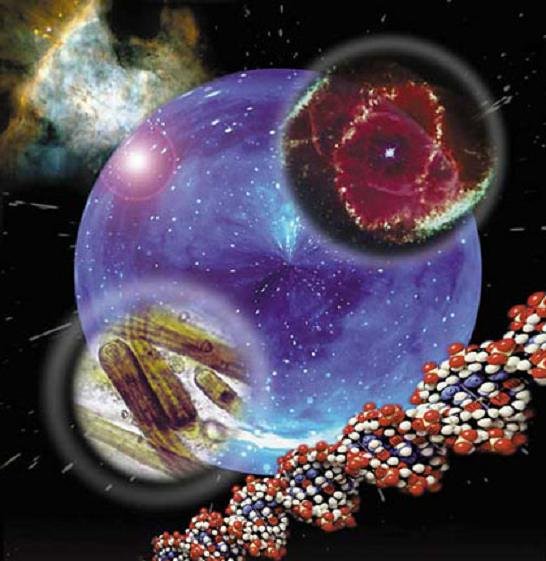

Mundos inimaginables que tendrán, como en el nuestro, formas de vida de una rica diversidad que ni podemos imaginar

Nuestros sueños de visitar mundos remotos, y, en ellos, encontrar otras clases de vida, otras inteligencias, es un sueño largamente acariaciado por nuestras mentes que, se resisten a estar sólas en un vasto Universo que, poseyendo miles de millones de mundos, también debe estar abarrotado de una diversidad de clases de vida que, al igual que ocurre aquí en la Tierra, pudieran (algunas de ellas) estar haciéndose la misma pregunta: ¿Estaremos sólos en tan inmenso Universo.

Hace algún tiempo que los medios publicaron la noticias:

“Físicos británicos creen que el bosón de Higgs y su relación con la gravedad puede ser la clave para crear una ecuación única que explique el Universo entero.”

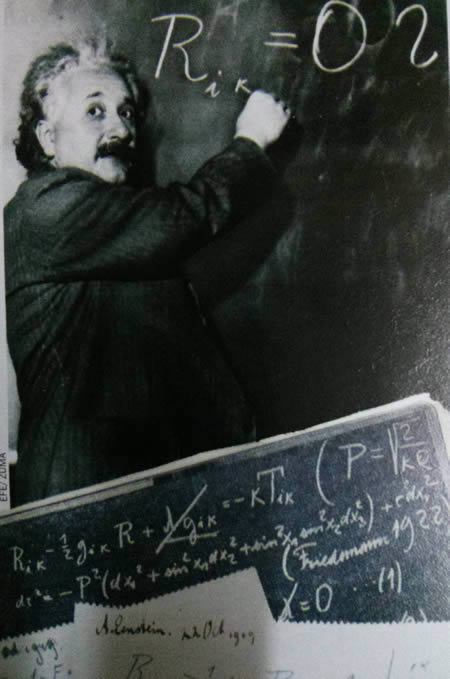

“La teoría del todo, también conocida como teoría unificada, fue el sueño que Einstein nunca pudo cumplir. Consiste en una teoría definitiva, una ecuación única que explique todos los fenómenos físicos conocidos y dé respuesta a las preguntas fundamentales del Universo. Esa teoría unificaría la mecánica cuántica y la relatividad general, dos conocimientos aceptados pero que describen el Cosmos de forma muy diferente. Albert Einstein no consiguió formularla. Tampoco nadie después de él, pero sigue siendo la ambición de muchos científicos. En este empeño, físicos de la británica Universidad de Sussex han dado un nuevo paso para probar que solo hay una fuerza fundamental en la naturaleza. Creen haber observado como el campo de Higgs interactúa con la Gravedad.”

Si hablamos de nuestra Galaxia, la Vía Láctea, lo havcemos de algo que tiene 100.000 millones de años-luz de diámetro y más de ciento cincuenta mil millones de estrellas, no digamos de mundos y otra infinidad de objetos de exótica estructura e increíbles conformaciones que, como los púlñsares, los agujeros negros o los manétares, no dejan de asombrarnos. Somos, una especie viviente que ha llegado a poder generar pensamientos y crear teorías encaminadas a descubrir la verdad de la Naturaleza, y, nuestra aparente “insignificante presencia”, podría ser un signo de que, el universo “ha permitido” observadores para que lo expliquen y se pueda comprender.

Tenemos el Universo dentro de nuestras mentes

El universo es un lugar tan maravilloso, rico y complejo que el descubrimiento de una teoría final, en el sentido en el que está planteada la teoría de supercuerdas, no supondría de modo alguno el fin de la ciencia ni podríamos decir que ya lo sabemos todo y para todo tendremos respuestas. Más bien será, cuando llegue, todo lo contrario: el hallazgo de esa teoría de Todo (la explicación completa del universo en su nivel más microscópico, una teoría que no estaría basada en ninguna explicación más profunda) nos aportaría un fundamento mucho más firme sobre el que podríamos construir nuestra comprensión del mundo y, a través de estos nuevos conocimientos, estaríamos preparados para comenzar nuevas empresas de metas que, en este momento, nuestra ignorancia no nos dejan ni vislumbrar. La nueva teoría de Todo nos proporcionaría un pilar inmutable y coherente que nos daría la llave para seguir explorando un universo más comprensible y por lo tanto, más seguro, ya que el peligro siempre llega de lo imprevisto, de lo desconocido que surge sin aviso previo; cuando conocemos bien lo que puede ocurrir nos preparamos para evitar daños.

Algunos dicen que para cuando tengamos una Teoría de Todo, el mundo habrá cambiado, habrá pasado tanto tiempo que, para entonces, la teoría habrá quedado vieja y se necesitará otra nueva teoría más avanzada. Eso significa, si es así, que nunca tendremos una explicación de todo y siempre quedarán cuestiones enigmáticas que tendremos que tesolver. ¡Menos mal!

La búsqueda de esa teoría final que nos diga cómo es el Universo, el Tiempo y el Espacio, la Materia y los elementos que la conforman, las Fuerzas fundamentales que interaccionan con ella, las constantes universales y en definitiva, una formulación matemática o conjunto de ecuaciones de las que podamos obtener todas las respuestas, es una empresa nada fácil y sumamente complicada; la teoría de cuerdas es una estructura teórica tan profunda y complicada que incluso con los considerables progresos que se han realizado durante las últimas décadas, aún nos queda un largo camino antes de que podamos afirmar que hemos logrado dominarla completamente. Se podría dar el caso de que el matemático que encuentre las matemáticas necesarias para llegar al final del camino, aún no sepa ni multiplicar y esté en primaria en cualquier escuela del mundo civilizado. Por otra parte, siempre andamos inventando ecuaciones para todo, que expliquen este o aquel enigma que deseamos conocer.

Lo cierto es que, no conocemos el futuro que le espera a la Humanidad pero, tal desconocimiento no incide en el hecho cierto de que siempre estemos tratando de saber el por qué de las cosas y, seguramente, si Einstein hubiera conocido la existencia de las cuatro fuerzas fundamentales, habría podido avanzar algo más, en su intento de lograr esa ecuación maravillosa que “todo” lo pudiera explicar.

Muchos de los grandes científicos del mundo (Einstein entre ellos), aportaron su trabajo y conocimientos en la búsqueda de esta teoría, no consiguieron su objetivo pero sí dejaron sus ideas para que otros continuaran la carrera hasta la meta final. Por lo tanto, hay que considerar que la teoría de cuerdas es un trabajo iniciado a partir de las ecuaciones de campo de la relatividad general de Einstein, de la mecánica cuántica de Planck, de las teorías gauge de campos, de la teoría de Kaluza-Klein, de las teorías de… hasta llegar al punto en el que ahora estamos.

La armoniosa combinación de la relatividad general y la mecánica cuántica es un éxito muy importante. Además, a diferencia de lo que sucedía con teorías anteriores, la teoría de cuerdas tiene la capacidad de responder a cuestiones primordiales que tienen relación con las fuerzas y los componentes fundamentales de la naturaleza. Allí, en sus ecuaciones, aparece el esquivo gravitón implicándo con ello que la teoría contiene implicitamente una teoría cuántica de la Gravedad.

Ahora, en la nueva etapa del LHC, tratarán de buscar partículas supersimétricas

Igualmente importante, aunque algo más difícil de expresar, es la notable elegancia tanto de las respuestas que propone la teoría de cuerdas, como del marco en que se generan dichas respuestas. Por ejemplo, en la teoría de cuerdas muchos aspectos de la Naturaleza que podrían parecer detalles técnicos arbitrarios (como el número de partículas fundamentales distintas y sus propiedades respectivas) surgen a partir de aspectos esenciales y tangibles de la geometría del universo. Si la teoría de cuerdas es correcta, la estructura microscópica de nuestro universo es un laberinto multidimensional ricamente entrelazado, dentro del cual las cuerdas del universo se retuercen y vibran en un movimiento infinito, marcando el ritmo de las leyes del cosmos.

Lejos de ser unos detalles accidentales, las propiedades de los bloques básicos que construyen la naturaleza están profundamente entrelazadas con la estructura del espacio-tiempo. En nuestro Universo, aunque no pueda dar esa sensación a primera vista, cuando se profundiza, podemos observar que, de alguna manera, todo está conectado, de la misma manera, nuestras mentes son parte del universo y, en ellas, están todas las respuestas.

Claro que, siendo todos los indicios muy buenos, para ser serios, no podemos decir aún que las predicciones sean definitivas y comprobables para estar seguros de que la teoría de cuerdas ha levantado realmente el velo de misterio que nos impide ver las verdades más profundas del universo, sino que con propiedad se podría afirmar que se ha levantado uno de los picos de ese velo y nos permite vislumbrar algo de lo que nos podríamos encontrar, a través de esa fisura parece que se escapa la luz de la comprensión que, en su momento, se podría alcanzar.

Muchos sueñan con encontrar esa Teoría del Todo

Mientras que la soñada teoría llega, nosotros estaremos tratando de construir ingenios que como el GEO600, el más sensible detector de ondas gravitacionales que existe ( capaz de detectar ínfimas ondulaciones en la estructura del espacio-tiempo ), nos pueda hablar de otra clase de universo. Hasta el momento el universo conocido es el que nos muestran las ondas electromagnéticas de la luz pero, no sabemos que podríamos contemplar si pudiéramos ver ese otro universo que nos hablan de la colisión de agujeros negros…por ejemplo.

GEO 600

La teoría de cuerdas, aunque en proceso de elaboración, ya ha contribuido con algunos logros importantes y ha resuelto algún que otro problema primordial como por ejemplo, uno relativo a los agujeros negros, asociado con la llamada entropía de Bekenstein-Hawking, que se había resistido pertinazmente durante más de veinticinco años a ser solucionada con medios más convencionales. Este éxito ha convencido a muchos de que la teoría de cuerdas está en el camino correcto para proporcionarnos la comprensión más profunda posible sobre la forma de funcionamiento del universo, que nos abriría las puertas para penetrar en espacios de increíble “belleza” y de logros y avances tecnológicos que ahora ni podemos imaginar.

Como he podido comentar en otras oportunidades, Edward Witten, uno de los pioneros y más destacados experto en la teoría de cuerdas, autor de la versión más avanzada y certera, conocida como teoría M, resume la situación diciendo que: “la teoría de cuerdas es una parte de la física que surgió casualmente en el siglo XX, pero que en realidad era la física del siglo XXI“.

Witten, un físico-matemático de mucho talento, máximo exponente y punta de lanza de la teoría de cuerdas, reconoce que el camino que está por recorrer es difícil y complicado. Habrá que desvelar conceptos que aún no sabemos que existen.

Ellos nos legaron parte de las teorías que hoy manejamos en el mundo para tratar de conocer el Universo pero, sigue siendo insuficientes… ¡Necesitamos Nuevas Teorías! que nos lleven al conocimientos más profundos de la realidad en que se mueve la Naturaleza, sólo de esa manera, podremos seguir avanzando.

El hecho de que nuestro actual nivel de conocimiento nos haya permitido obtener nuevas perspectivas impactantes en relación con el funcionamiento del universo es ya en sí mismo muy revelador y nos indica que podemos estar en el buen camino al comprobar que las ecuaciones topológicas complejas de la nueva teoría nos habla de la rica naturaleza de la teoría de cuerdas y de su largo alcance. Lo que la teoría nos promete obtener es un premio demasiado grande como para no insistir en la búsqueda de su conformación final.

La expansión del universo se ha estudiado de varias maneras diferentes, pero la misión WMAP completada en 2003, representa un paso importante en la precisión y los resultados presentados hasta el momento con mayor precisión para saber, en qué clase de Universo estamos, cómo pudo comenzar y, cuál podría ser su posible final. Todo ello, es un apartado más de ese todo que tratamos de buscar para saber, en qué Universo estamos, cómo funcionan las cosas y por qué lo hacen de esa determinada manera y no de otra diferente.

La relatividad general nos dijo cómo es la geometría del Universo

El universo, la cosmología moderna que hoy tenemos, es debida a la teoría de Einstein de la relatividad general y las consecuencias obtenidas posteriormente por Alexandre Friedmann. El Big Bang, la expansión del universo, el universo plano y abierto o curvo y cerrado, la densidad crítica y el posible Big Crunch.

Un comienzo y un final que abarcará miles y miles de millones de años de sucesos universales a escalas cosmológicas que, claro está, nos afectará a nosotros, insignificantes mortales habitantes de un insignificante planeta, en un insignificante sistema solar creado por una insignificante y común estrella.

Pero… ¿somos en verdad tan insignificantes?

Los logros alcanzados hasta el momento parecen desmentir tal afirmación, el camino recorrido por la humanidad no ha sido nada fácil, los inconvenientes y dificultades vencidas, las luchas, la supervivencia, el aprendizaje por la experiencia primero y por el estudio después, el proceso de humanización (aún no finalizado), todo eso y más nos dice que a lo mejor, es posible, pudiera ser que finalmente, esta especie nuestra pudiera tener un papel importante en el conjunto del universo. De momento y por lo pronto ya es un gran triunfo el que estemos buscando respuestas escondidas en lo más profundo de las entrañas del cosmos.

Tengo la sensación muy particular, una vez dentro de mi cabeza, un mensaje que no sé de dónde pero que llega a mi mente que me dice de manera persistente y clara que no conseguiremos descubrir plenamente esa ansiada teoría del todo, hasta tanto no consigamos dominar la energía de Planck que hoy por hoy, es inalcanzable y sólo un sueño.

Sus buenas aportaciones a la Física fueron bien recompensadas de muchas maneras.

En mecánica cuántica es corriente trabajar con la constante de Planck racionalizada, (ħ = h/2p = 1’054589×10-34 Julios/segundo), con su ley de radiación (Iv = 2hc-2v3/[exp(hv/KT)-1]), con la longitud de Planck , con la masa de Planck, y otras muchas ecuaciones fundamentales para llegar a lugares recónditos que, de otra manera, nunca podríamos alcanzar.

Todo lo anterior son herramientas de la mecánica cuántica que en su conjunto son conocidas como unidades de Planck, que como su mismo nombre indica son un conjunto de unidades, usado principalmente en teorías cuánticas de la gravedad, en que longitud, masa y tiempo son expresadas en múltiplos de la longitud, masa y tiempo de Planck, respectivamente. Esto es equivalente a fijar la constante gravitacional (G), como la velocidad de la luz (c), y la constante de Planck racionalizada (ħ) iguales todas a la unidad. Todas las cantidades que tienen dimensiones de longitud, masa y tiempo se vuelven adimensionales en unidades de Planck. Debido a que en el contexto donde las unidades de Planck son usadas es normal emplear unidades gaussianas o unidades de Heaviside-Lorentz para las cantidades electromagnéticas, éstas también se vuelven adimensionales, lo que por otra parte ocurre con todas las unidades naturales. Un ejemplo de esta curiosidad de adimiensionalidad, está presente en la constante de estructura fina (2pe2/hc) de valor 137 (número adimensional) y cuyo símbolo es la letra griega a (alfa).

Estas unidades de Planck nos llevan a la cosmología del nacimiento del universo y nos proporciona un marco elegante, coherente y manejable mediante cálculos para conocer el universo remontándonos a los primeros momentos más breves posteriores a la explosión o Big Bang. El tiempo de Planck por ejemplo, expresado por , tiene un valor del orden de 10-43 segundos, o lo que es lo mismo, el tiempo que pasó desde la explosión hasta el tiempo de Planck fue de: 0,000.000.000.000.000.000.000.000.000.000.000.000.000.001 de 1 segundo. En la fórmula, G es la constante universal de Newton, ħ es la constante de Planck racionalizada y c es la velocidad de la luz.

Es una unidad de tiempo infinitesimal, como lo es el límite de Planck que se refiere al espacio recorrido por un fotón (que viaja a la velocidad de la luz) durante una fracción de tiempo de ínfima duración y que es de 0,000.000.000.000.000.000.000.000.000.000.001 de cm.

Hasta tal punto llegan los físicos en sus cálculos para tratar de adecuar los conocimientos a la realidad por medio del experimento. Buscamos incansables…¡las respuestas! Hasta que no podamos tocar con nuestras propias manos esa partícula final…

Sin embargo, cuando hablamos de estas unidades tan pequeñas, no debemos engañarnos. Precisamente, para tratar de llegar hasta esos límites tan profundos se necesitan máquinas que desarrollan inmensas energías: los aceleradores de partículas, que como el Fermilab o el LHC en el CERN, han facilitado a los físicos experimentadores entrar en las entrañas de la materia y descubrir muchos de los secretos antes tan bien guardados. Ahora, disponiendo de 14 TeV, tratán de nbuscar partículas supersimñétricas y el origen de la “materia oscurta”.

Desgraciadamente, aún no se han fabricado aceleradores tan potentes como para poder detectar la partícula de Higgs, esa partícula responsable de proporcionar masa a todas las demás partículas. Y, por supuesto, más lejos queda la posibilidad de que podamos construir un acelerador que pudiera alcanzar la energía de Planck, del orden de 1019 eV (1 eV = 10-19 julios) = 1’60210×10-19. Hoy por hoy, ni nuestra tecnología ni todos los recursos que tenemos disponibles si empleáramos todo el presupuesto bruto de todos los países del globo unidos, ni así digo, podríamos alcanzar esta energía necesaria para comprobar experimentalmente la existencia de “cuerdas” vibrantes que confirmen la teoría de Todo.

Claro que, pudiera ser que, todo se pudiera alcanzar de manera mucho más simple y que, teniéndolo a la vista, no hemos sabido ver. Habrá que agudizar el ingenio para resolver estas y otras cuestiones que, como la de la Velocidad de la Luz, nos tienem atados y bien atados a este granito de arena inmerso en un vasto universo y que, nosotros, llamamos mundo.

emilio silvera

Mar

14

Plasma, Nebulosas, Gases, elementos, moléculas.

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Plasma: cuarto estado de la materia ~

Clasificado en El Plasma: cuarto estado de la materia ~

Comments (2)

Comments (2)

El Plasma, ese otro estado de la Materia (el cuarto dicen) que, según sabemos, resulta ser el más abundante del Universo. Todos desde pequeños aprendimos aquellos tres estados de la materia que cantábamos en el patio del centro educativo durante el recreo, donde todos a una gritábamos como papagayos: “Sólido, líquido y gaseoso”. Nada nos decían del Plasma, ese estado que, en realidad, cubre el 99% del estado de la materia en nuestro Universo (bueno, hablamos de la materia conocida, esa que llamamos bariónica y está formada por átomos de Quarks y Leptones). Sospecho que hay otros estados de la materia que nos son desconocidos.

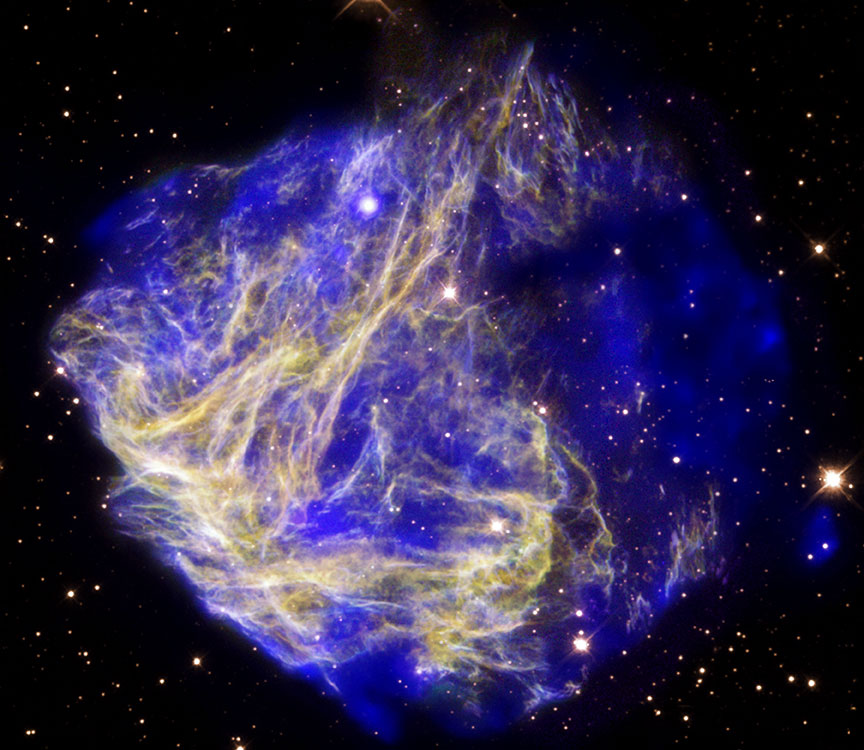

El plasma está en las estrellas, en remanentes ee Supernovas y… ¡en tántos lugares!

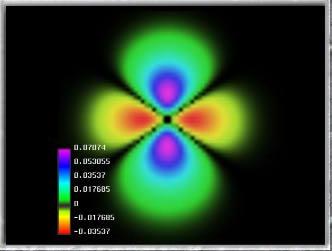

Según la energía de sus partículas, los plasmas (como digo), constituyen el cuarto estado de agregación de la materia, tras los sólidos, liquidos y gases. Parqa cambiar de uno al otro, es necesario que se le aporte energía que aumente la temperatura. Si aumentamos de manera conasiderable la temperatura de un gas, sus átomos o moléculas adquieren energía suficiente para ionizarse al chocar entre sí. de modo que a ~ 20.000 K muchos gases presentan una ionización elevada. Sin embargo, átomos y moléculas pueden ionizarse también por impacto electrónico, obsorción de plasma en las nebulosas donde están presentes elementos y moléculas ionizados y donde se producen reacciones químicas o nucleares y otros procesos.

Aquí podemos contemplar una enorme región ionizada en la Nebulosa del Pelícano. Estrellas nuevas emiten potente radiación ultravioleta que ataca el espesor de la Nebulosa molecular y hace que, el gas se ionice fuertemente creando una luminosidad que “viste” de azul claro todo el contorno que circunda el radio de acción de las estrellas.

Un plasma es un gas muy ionizado, con igual número de cargas negativas y positivas. Las cargas otorgan al Plasma un comportamiento colectivo, por las fuerzas de largo alcance existente entre ellas. En un gas, cada partícula, independientemente de las demás, sigue una trayectoria rectilinea, hasta chocar con otra o con las grandes paredes que la confinan. En un plasma, las cargas se desvían atraídas o repelidas por otras cargas o campos electromagnéticos externos, ejecutando trayectorias curvilineas entre choque y choque. Los gases son buenos aislantes eléctricos, y los plasmas buenos conductores.

En la Tierra, los plasmas no suelen existir en la naturaleza, salvo en los relámpagos, que son trayectorias estrechas a lo largo de las cuales las moléculas de aire están ionizadas aproximadamente en un 20%, y en algunas zonas de las llamas. Los plasmas de electrones libres de un metal también pueden ser considerados como un plasma. La mayor parte del Universo está formado por materia en estado plasmático (sólo tenemos que pensar en la cantidad de estrellas que existen en las galaxias, en los remanentes supernovas y otros fenómenos físicos que se producen en el Cosmos). La ionización está causada por las elevadas temperaturas, como ocurre en el Sol y las demás estrellas, o por la radiación, como sucede en los gases interestelares o en las capas superiores de la atmósfera (ver trabajo más abajo), donde produce el fenómeno denominado aurora.

Así que, aunque escasos en la Tierra, el Plasma constituye la materia conocida más abundante del Universo, más del 99%. Abarcan desde altísimos valores de presión y temperatura, como en los núcleos estelares, hasta otros asombrosamente bajos en ciertas regiones del espacio. Uno de sus mayores atractivos es que emiten luz visible, con espectros bien definidos, particulares en cada especie. Algunos objetos radiantes, como un filamento incandescente, con espectro continuo similar al cuerpo negro, o ciertas reacciones químicas productoras de especies excitadas, no son plasmas, sin embargo, lo son la mayoría de los cuerpos luminosos.

Bombilla de incandescencia

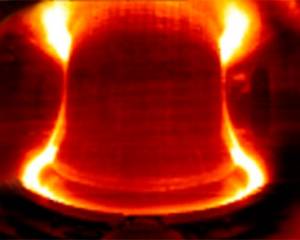

Los Plasmas se clasifican según la energía media (o temperatura) de sus partículas pesadas (iones y especies neutras). Un primer tipo son los Plasmas calientes, prácticamente ionizados en su totalidad, y con sus electrones en equilibrio térmico con las partículas más pesadas. Su caso extremo son los Plasmas de Fusión, que alcanzan hasta 108 K, lo que permite a los núcleos chocar entre sí, superándo las enormes fuerzas repulsivas internucleares, y lñograr su fusión. Puede producirse a presiones desde 1017 Pa, como en los núcleos estelares, hasta un Pa, como en los reactores experimentales de fusión.

Los reactores de fusión nuclear prácticos están ahora un poco más cerca de la realidad gracias a nuevos experimentos con el reactor experimental Alcator C-Mod del MIT. Este reactor es, de entre todos los de fusión nuclear ubicados en universidades, el de mayor rendimiento en el mundo.

Los nuevos experimentos han revelado un conjunto de parámetros de funcionamiento del reactor, lo que se denomina “modo” de operación, que podría proporcionar una solución a un viejo problema de funcionamiento: cómo mantener el calor firmemente confinado en el gas caliente cargado (llamado plasma) dentro del reactor, y a la vez permitir que las partículas contaminantes, las cuales pueden interferir en la reacción de fusión, escapen y puedan ser retiradas de la cámara.

Otros Plasmas son los llamados térmicos, con e ~lectrones y especies pesadas en equilibrio, pero a menor temperatura ~ 103 – 104 K, y grados de ionización intermedios, son por ejemplo los rayos de las tormentas o las descargas en arcos usadas en iluminación o para soldadura, que ocurren entre 105 y ~ 102 Pa. Otro tipo de Plasma muy diferente es el de los Plasmas fríos, que suelen darse a bajas presiones ( < 102 Pa), y presentan grados de ionización mucho menores ~ 10-4 – 10-6. En ellos, los plasmas, nebulosas, gases, elementos, moleculas y electrones pueden alcanzar temperaturas ~ 105 K, mientras iones y neutros se hallan a temperatura ambiente. Algunos ejemplos son las lámparas de bajo consumo y los Plasmas generados en multitud de reactores industriales para producción de películas delgadas y tratamientos superficiales.

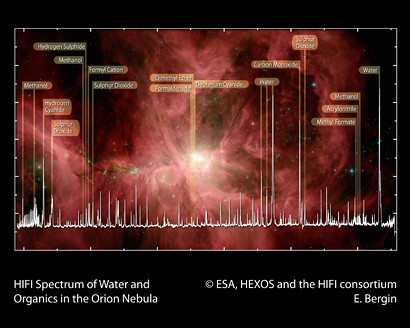

El Observatorio Espacial Herschel de la ESA ha puesto de manifiesto las moléculas orgánicas que son la llave para la vida en la Nebulosa de Orión, una de las regiones más espectaculares de formación estelar en nuestra Vía Láctea. Este detallado espectro, obtenido con el Instrumento Heterodino para el Infrarrojo Lejano (Heterodyne Instrument for the Far Infrared, HIFI) es una primera ilustración del enorme potencial de Herschel-HIFI para desvelar los mecanismos de formación de moléculas orgánicas en el espacio. Y, para que todo eso sea posible, los Plasmas tienen que andar muy cerca.

En los Plasmas calientes de precursores moleculares, cuanto mayor es la ionización del gas, más elevado es el grado de disociación molecular, hasta poder constar solo de plasma de electrones y especies atómicas neutras o cargadas; en cambio, los Plasmas fríos procedentes de especies moleculares contienen gran proporción de moléculas y una pequeña parte de iones y radicales, que son justamente quienes proporcionan al Plasma su característica más importante: su altísima reactividad química, pese a la baja temperatura.

En la Naturaleza existen Plasmas fríos moleculares, por ejemplo, en ciertas regiones de las nubes interestelares y en las ionosfera de la Tierra y otros planetas o satélites. Pero también son producidos actualmente por el ser humano en gran variedad para investigación y multitud de aplicaciones.

En un número de la Revista Española de Física dedicado al vacío, el tema resulta muy apropiado pues no pudieron generarse Plasmas estables en descargas eléctricas hasta no disponer de la tecnología necesaria para mantener presiones suficientemente bajas; y en el Universo, aparecen Plasmas fríos hasta presiones de 10 ⁻ ¹⁰ Pascales, inalcanzable por el hombre.

Lo que ocurre en las Nubes moleculares es tan fantástico que, llegan a conseguir los elementos necesarios para la vida prebiótica que, más tarde situados en el planeta y ambiente adecuados, tras cumplirse las reglas y cubrir los parámetros adecuados, dan lugar al surgir de la vida.

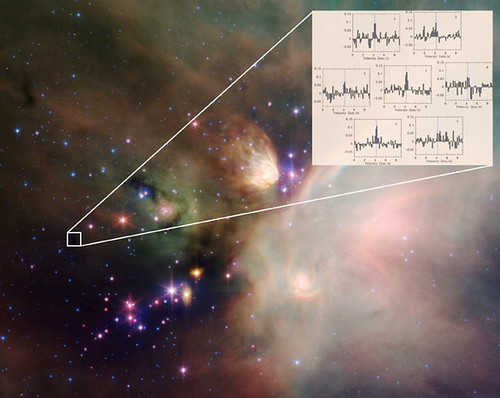

El papel de las moléculas en Astronomía se ha convertido en un área importante desde el descubrimiento de las primeras especies poliatómicas en el medio interestelar. Durante más de 30 años, han sido descubiertas más de 180 especies moleculares en el medio interestelar y gracias al análisis espectral de la radiación. Muchas resultan muy exóticas para estándares terrestres (iones, radicales) pero buena parte de estas pueden reproducirse en Plasma de Laboratorio. Aparte del interés intrínseco y riqueza de procesos químicos que implican, estas especies influyen en la aparición de nuevas estrellas por su capacidad de absorber y radiar la energía resultante del colapso gravitatorio, y de facilitar la neutralización global de cargas, mucho más eficientemente que los átomos.

Su formación en el espacio comienza con la eyección de materia al medio interestelar por estrellas en sus últimas fases de evolución y la transformación de éstas por radiación ultravioleta, rayos cósmicos y colisiones; acabando con su incorporación a nuevas estrellas y Sistemas planetarios, en un proceso cíclico de miles de millones de años.

En las explosiones supernovas se producen importantes transformaciones en la materia que, de simple se transforma en compleja y dan lugar a todas esas nuevas especies de moléculas que nutren los nuevos mundos en los que podemos encontrar elementos como el oro y el platino que han sido creados en sucesos de una magnitud aterradora donde las fuerzas desatadas del Universo han quedado sueltas para transformarlo todo.

El H₂ y otras moléculas diatómicas homonucleares carecen de espectro rotacional. Detectando las débiles emisiones cuadrupolares del H₂ en infrarrojo, se ha estimado una proporción de H₂ frente a H abrumadoramente alto ( ~ 104) en Nubes Interestelares con densidades típicas de ~ 104 partículas /cm3; pero dada la insuficiente asociación radiativa del H para formar H2, ya mencionada, el H2 debe producirse en las superficies de granos de polvo interestelar de Carbono y Silicio, con diámetros ~ 1 nm — μm, relativamente abundantes en estas nubes.

Experimentos muy recientes de desorción programada sobre silicatos ultrafríos, demuestran que tal recombinación ocurren realmente vía el mecanismo de Langmuir-Hinshelwood, si bien los modelos que expliquen las concentraciones de H2 aún deben ser mejorados.

Por otro lado, ciertas regiones de las nubes en etapas libres de condensación estelar presentan grados de ionización ~ 10-8 – 10-7 a temperaturas de ~ 10 K. La ionización inicial corresponde principalmente al H2 para formar H2 +, que reacciona eficientemente con H2, dando H3 + + H (k = 2• 10-9 cm3 • s-1.

El H3, de estructura triangular, no reacciona con H2 y resulta por ello muy “estable” y abundante en esas regiones de Nebulosas intelestelares, donde ha sido detectado mediante sus absorciones infrarrojas caracterizadas por primera vez en 1980 en descargas de H2 en Laboratorio.

La constelación de Orión contiene mucho más de lo que se puede ver, ahí están presentes los elementos que como el H2 que venimos mencionando, tras procesos complejos y naturales llegan a conseguir otras formaciones y dan lugar a la parición de moléculas significativas como el H2O o HCN y una gran variedad de Hidrocarburos, que podrían contribuir a explicar en un futuro próximo, hasta el origen de la vida.

La detección por espectroscopia infrarroja de COH+ y N2H+, formados en reacciones con H3 + a partir de CO y N2, permite estimar la proporción de N2/CO existente en esas regiones, ya que el N2 no emite infrarrojos. Descargas de H2 a baja presión con trazas de las otras especies en Laboratorio conducen casi instantáneamente a la aprición de tales iones y moléculas, y su caracterización puede contribuir a la comprensión de este tipo de procesos.

Así amigos míos, hemos llegado a conocer (al menos en parte), algunos de los procesos asombrosos que se producen continuamente en el Espacio Interestelar, en esa Nebulosas que, captadas por el Hubble y otros telescopios, miramos asombrados maravilándonos de sus colores y fantásticas figuras arabescas que se forman por el choque del material allí existente con los vientos solares y la radiación de las estrellas radiantes nuevas que, en realidad, llevan mensajes que nos están diciendo el por qué se producen y que elementos son los causantes de que brillen deslumbrantes cuando la radiación estelar choca de lleno en esas nubes en la que nacen las estrellas y los nuevos mundos…y, si me apurais un poco, también la vida.

emilio silvera

Mar

14

Nuevos Materiales, nuevos procesos, nuevos dispositivos. II

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Nanotecnología ~

Clasificado en Nanotecnología ~

Comments (0)

Comments (0)

Una investigación ha desarrollado una nueva estructura cuántica capaz de emitir fotones individuales de color rojo. El avance, que se publica en la revista Nature Materials, se basa en el confinamiento cuántico que se genera en cada uno de los puntos y que les permite modular la energía de la luz que emiten.

En este trabajo han participado investigadores de la Universidad de Zaragoza, el Institut de Recerca en Energia de Catalunya (IREC), la Universidad de Barcelona y del Instituto de Ciencia de Materiales de Barcelona del CSIC. El investigador Jordi Arbiol de este último explica:

“El resultado final son hilos unidimensionales, de tamaño nanométrico, compatibles con la tecnología electrónica actual, que permitirían crear dispositivos a mayor escala con un control total de la emisión de luz, fotón a fotón”.

Pero centrémonos en el trabajo que aquí se prenta hoy y que comienza hablando de los…

Nanohilos

No sólo las moléculas, los Nanotubos o el grafeno son las apuestas para sustituir al silicio. Otros elementos como los Nanohilos fabricados a partir de materiales semiconductores o los Nanohilos metálicos tendrán también cierto protagonismo. En concreto, los Nanohilos semiconductores presentan un gran potencial como transistores pero también presentan aplicaciones en campos como octoelectrónica o en la fabricación de censores biológicos. Por otro lado los Nanohilos metálicos, cuya síntesis controlada es más difícil, poseen gran interés como interconectores. En el caso de los Nanohilos formados de materiales Ni, Co o Fe se puede aprovechar también su potencial comportamiento magnetorresisitivo para ser usados en dispositivos de almacenamiento magnético. Los Nanohilos metálicos son interesantes a su vez porque los efectos de tamaño inducen en ellos la aparición de transiciones de fase martensíticas y la aparición de configuraciones no cristalinas.” Veamos que pasa con las Nanopartículas.

Nanopartículas

Quizás, junto a los nanotubos de carbono, las nanopartículas representan los materiales que tienen una repercución tecnológica más inmediata. Además de sus propiedades intrínsecas, las nanopartículas representan los materiales que tienen una repercusión tecnológica más inmediata. Además de sus propiedades intrínsecas, las nanopartículas, debido a su pequeño tamaño, pueden convertirse en diminutos dispositivos capaces de realizar otras funciones, como transportar un medicamento específico por el torrente sanguíneo sin obstruirlo. Para lograr esto, las nanopartículas deben ser el soporte de capas de moléculas autoensambladas que confieren una funcionalidad adicional a las mismas.

Como su propio nombre indica, el término “nanopartícula” designa una agrupación de átomos o moléculas que dan lugar a una partícula con dimensiones nanométricas. Es decir, que su tamaño está comprendido entre 1 y 100 nm. Dependiendo de cuáles sean los átomos o moléculas que se agrupan se originarán diferentes tipos de nanopartículas. Así, por ejemplo, tendremos nanopartículas de oro, de plata o nanopartículas magnéticas si están formadas por átomos de Fe o Co. Su pequeño tamaño hace que la relación superficie/volumen crezca y por tanto que estas estructuras tengan unas propiedades características y esencialmente distintas a las que presenta el material en volumen.

Una estrategia para la formación de nanopartículas es recubrirlas con distintas capas de manera tal que cada una aporte funcionalidades diferentes al sistema. Así, por ejemplo, recientemente se han descrito nanopartículas cuyo interior está formado por un material magnético, como el Co, seguido de una capa intermedia de SiO2 que aporta estabilidad al sistema y finalmente una superficie de oro.

El tamaño final de la nanopartícula es de 3 nm, y esta estructura laminar hace que tengan un núcleo magnético que posibilite su guiado, y una superficie de oro que facilite el autoensamblado de moléculas orgánicas o biológicas para diferentes aplicaciones. Entre éstas destaca su uso como biosensores. Para ello se inmoviliza material biológico, como ácido desoxirribonucleico (ADN) o el llamado ácido nucléico péptidico (PNA, del inglés peptide nucleic acid), que siendo un ácido nucléico artificial, presenta un “esqueleto” molecular formado por enlaces peptidicos y una estructura de bases nucleicas exactamente igual a la del ADN. El PNA puede reconocer cadenas complementarias de ADN, incluso con mayor eficiencia para la hibridación que la que representa el ADN para reconocer su hebra complementaria. Por este motivo, el PNA se ha propuesto como sonda para la fabricación de biosensores altamente eficientes. Estas macromoléculas unidas a superficies o nanopartículas son capaces de detectar diferentes analítos de interés, particularmente otars moléculas biológicas.

Sin embargo, el concepto de nanopartícula debe concebirse en un sentido más amplio ya que no sólo puede estar basada en un núcleo inorgánico, pudiéndose sintetizar nanopartículas poliméricas. Yendo un poco más allá una cápsida vírica puede entenderse como una nanopartícula formada por una carcasa proteica. Esta cápsida vírica tiene dimensiones nanométricas y, en muchos casos, burla con facilidad las membranas celulares. Por esta razón este tipo de “nanopartículas” se proponen para su uso en nanomedicina, y son el objeto de estudios básicos en los que las herramientas como los microscopios de fuerzas atómicas juegan un papel esencial. En particular, estas herramientas nos permiten caracterizar las propiedades mecánicas y las condiciones de ruptura de cápsidas víricas así como la forma en la que dichas cápsidas se comportan ante, por ejemplo, cambios controlados de humedad.

En un discurso recientemente impartido en la Universidad Europea de Madrid, William F. Clinton, ex-Presidente de los EE.UU, afirmó que ” el cometido del siglo XXI será salvar al mundo del cambio climático, regenerar la economía y crear empleo. El futuro más allá será la Nanotecnología y la biotecnología”. El propio W.F. Clinton fue el impulsor de la Iniciativa Nacional de Nanotecnología durante su mandato, convirtiendo durante los últimos 10 años a EE.UU en el líder mundial en la generación de conocimientos básicos y aplicados en el ámbito de la Nanotecnología.

Nadie pone en duda las afirmaciones de W.F. Clinton sobre el papel de la Nanotecnología en nuestro futuro a medio y largo plazo, por lo uqe es imperativo estar suficientemente preparados para construir este nuevo paradigma científico. En el caso concreto de España, las dos últimas ediciones del Plan Nacional de I+D+I han encumbrado las investigaciones en Nanociencia y Nanotecnología a la categoría de Acción Estratégica. En la actualidad se están poniendo en marcha varios centros dedicados a Nanotecnología. Dichas iniciativas son producto, por lo general, de costosos impulsos puntuales, locales, dirigidos por científicos con iniciativa, pero no son fruto de una actuación de conjunto, planificada siguiendo una estrategia quiada por unos objetivos ambiciosos, en los que impere la coordinación y el uso eficiente de los recursos. La actual coyuntura económica no invita al optimismo a este respecto, por lo que sería necesario poner en marcha iniciativas que promuevan la adquisición de infraestructuras, la formación de técnicos, la coordinación entre centros emergentes, etc.

Otro punto sobre el que no hay que descuidarse tiene que ver con la formación, en todos los niveles educativos, en Nanotecnología. En este sentido son numerosas las universidades españolas que ofrecen cursos de master y/o doctorado con contenidos relacionados con la Nanotecnología. Sin embargo, muchos de estos cursos tienen pocos estudiantes inscritos, al igual que ocurre con muchos estudios de grado relacionados con las ciencias básicas. La tarea de fascinar y atraer a nuestros jóvenes hacia la ciencia debe comenzar mucho antes. En este sentido, los conceptos inherentes a la Nanotecnología deben formar parte del conocimiento que debe llegar a los estudiantes de educación secundaria, como ocurre en países como Alemania, Finlandia, Taiwán, Japón, EE.UU., etc. Además, la Nanotecnología es una materia que causa cierta fascinación a los adolescentes por lo que puede ser un buen punto de partida para incentivar las vocaciones científicas. Esta ha sido una de las principales razones por las que los autores de este artículo junto con otros investigadores (Carlos Briones del Centro de Astrobiología y Elena Casero de la Universidad Autónoma de Madrid) accedieron a la petición de la Fundación Española de Ciencia y Tecnología (FECyT) para escribir una Unidad Didáctica de Ciencia y Tecnología. Dicho libro ya se encuentra en todos los institutos españoles de educación secundaria y bachillerato, y se puede descargar desde la web de la FECyT. Esperemos que esta pequeña contribución, junto con otras de mayor calado que deben promoverse desde las diversas administraciones públicas, permita tomar la senda que nos lleve a medio plazo hacia la tan ansiada sociedad basada en el conocimiento.

Fuente: Revista Española de Física. Volumen 23 Nº 4 de 2009

Los Autores:

D. José Ángel Martín Gago, del Instituto de Ciencia de Materiales de Madrid, Concejo Superior de Investigaciones científicas, Centro de Astrobiología /CSIC/INTA), Instituto Nacional de Técnica Aerpespacial, y, D. Pedro A. Serena Domingo, del Instituo de Ciencia y Materiales de Madrid y del Consejo Superior de Investigaciones Científicas.

Mar

14

Buscan materia oscura en una antigua mina de oro

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Noticias ~

Clasificado en Noticias ~

Comments (0)

Comments (0)

Ciencia

Ciencia

Ponen en marcha un nuevo detector que busca, en la más completa oscuridad bajo el suelo de Dakota del Sur (EE.UU.), un diminuto «flash» que suponga un hito en el mundo de la ciencia

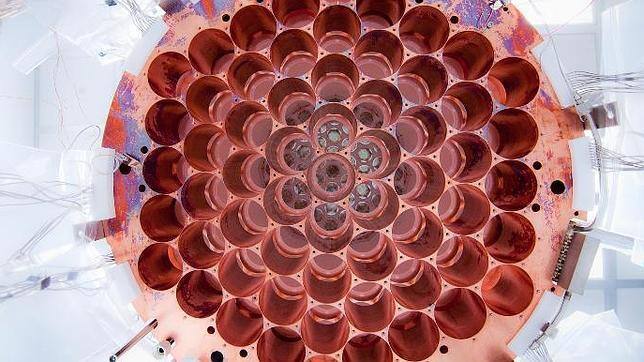

A 1,5 kilómetros bajo la superficie terrestre, un grupo de científicos está intentando descubrir la identidad exacta de la materia oscura. Con un nuevo detector, que empezaron a construir en 2008 y han puesto en funcionamiento ahora, investigadores de 17 universidades de todo el mundo participan en el experimento LUX en las profundidades de una antigua mina de oro. Se trata de buscar en el ambiente más oscuro posible, a salvo de cualquier haz de luz de cualquier longitud de onda, un minúsculo flash que indicaría una colisión entre una partícula de materia oscura y una partícula de materia normal.

Los científicos que participan en el experimento Large Underground Xenon (LUX) han informado de unos primeros resultados prometedores, tanto desde el punto de vista tecnológico como científico. Este experimento se ha creado para determinar la naturaleza de la materia oscura, una sustancia invisible que los físicos creen que está a nuestro alrededor y que constituiría la mayor parte de la materia en el universo, pero que apenas tiene efecto en nuestras vidas cotidianas. Los científicos acaban de publicar los primeros resultados que, dicen, validan el diseño y el rendimiento de la prueba. Esta investigación desafía estudios previos que afirmaban ‘avistamientos’ de la materia oscura, y ahora está comenzando el proceso de descubrir la identidad exacta de la partícula de materia oscura, un proceso equivalente al trabajo realizado por el Large Hadron Collider en la identificación del bosón de higgs.

El nuevo laboratorio está situado en una antigua mina de oro cerca de un kilómetro y medio por debajo de las montañas Black Hills, en el estado norteamericano de Dakota del Sur. Los trabajos en el LUX comenzaron en 2008, y el experimento quedó listo para una primera prueba a principios de 2013. En este entorno los científicos están operando algunos de los equipos más sensibles del mundo en un ambiente extremadamente protegido, porque están buscando los minúsculos y extremadamente raros flashes de luz que indicarían una colisión entre una partícula de materia oscura y una partícula de materia normal.

“Hacen falta muchos años para construir estos instrumentos, y siempre estamos empujando las nuevas tecnologías al límite”, afirma el Dr. Enrique Araújo, del Departamento de Física del Imperial College de Londres, quien dirige el equipo de esta universidad que está trabajando en LUX. “Es muy significativo que estuvimos trabajando mucho tiempo en el diseño de LUX hasta que finalmente pudimos presionar el botón “on”. Muchos experimentos nunca alcanzan esta etapa”. Los físicos creen que la materia oscura constituye alrededor de un cuarto de la energía del Universo. Esto es mucho si lo comparamos con la materia ordinaria, que constituye sólo una vigésima parte. El resto se compone de una energía oscura aún más misteriosa.

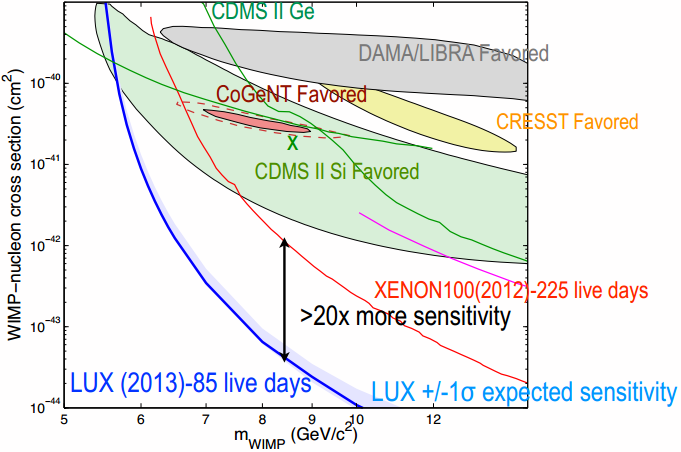

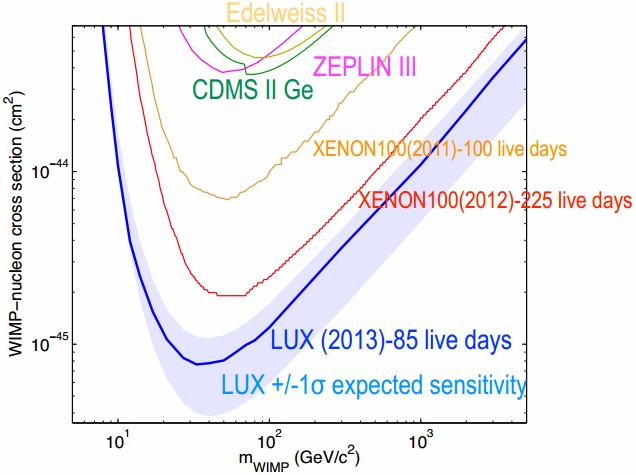

Datos de mayo de 2004. La zona verde representa el resultado del experimento DAMA, en comparación con los límites de precisión de los experimentos CDMS y EDELWEISS. (como podréis ver, son muchos los experimentos que han buscado las partículas de “materia oscura” sin resultado alguno (introducción del blog que nada tiene que ver con el reportaje).

Desde que el experimento fue instalado bajo tierra en febrero, los investigadores han estado buscando han estado buscando Particulas Masivas de Interacción Débild, WIWPs (Weakly Interacting Massive Particles), que son las principales candidatas a constituir la materia oscura en nuestra galaxia y en el resto del universo. Estas partículas se cree que tienen masa como las partículas normales y que crean una pequeña fuerza de gravedad, pero no pueden ser observados directamente ya que no emiten ni rebotan la luz en ninguna longitud de onda. En escalas más grandes su presencia puede inferirse a partir del movimiento de las estrellas en las galaxias, y de las galaxias individuales en los cúmulos galácticos.

Procedentes del espacio

Las colisiones entre las WIMPs y la materia normal son raras y muy difíciles de detectar porque las partículas de rayos cósmicos provenientes del espacio pueden enmascarar los ya tenues destellos que se esperan de las WIMPs. Sin embargo, pocos rayos cósmicos pueden penetrar tan profundamente como para alcanzar el subterráneo en el que han instalado el experimento LUX y, además, el detector está protegido de la radiación de fondo porque está sumergido en un tanque de blindaje de agua ultra-pura.

“Somos capaces de detectar las tenues destellos de luz usando de manera muy eficaz buenos materiales reflectores y sensores de fotones muy sensibles”, dice el Dr. Araújo, quien añade que “LUX tiene significativamente una mayor sensibilidad que los mejores experimentos sobre materia oscura que se han hecho anteriormente en el mundo, especialmente para las WIMPs más ligeras, que causan las señales más débiles . “

El experimento LUX no encuentra partículas WIMPs de “materia oscura” de menos de 33 GeV (Giga electrón Voltio).

El nuevo resultado LUX desafía las evidencias de otros experimentos, como el CoGeNT y el DAMA, en los que los científicos afirmaron previamente disponer de datos sobre la naturaleza de las WIMPs. El Dr. Araújo cree que “una serie de resultados previos vieron unas WIMPs con una masa especialmente baja. Aunque esta situación pudiera llegar a darse, los nuevos datos revelan que, en esas ocasiónes, se trataba de un caso de identidad equivocada”.

Hace una década, los científicos del programa ZEPLIN, dirigido por el Reino Unido, desplegaron el primer detector de materia oscura de este tipo bajo tierra, en la mina Boulby en North Yorkshire. “Hemos tenido un papel pionero en lo que ha sido la más sensible tecnología de búsqueda de la materia oscura del mundo al construir y operar con tres detectores en Boulby”, explica Araújo. “El último y más sensible, el ZEPLIN III, permitió concluir nuestro programa en 2011, y poco después disfrutamos de LUX”.

Científicos como el Dr. Araújo ya están diseñando, y pronto comenzarán la construcción, del experimento de nueva generación LZ, que es la unión de los dos programas LUX y ZEPLIN. Con 7 toneladas de xenón líquido como objetivo, el LZ será 30 veces mayor que el LUX y tendrá más de 100 veces mejor alcance. Será tan sensible que estará solamente limitado por la interferencia de las señales de fondo de los neutrinos astrofísicos. Estas partículas igualmente teóricas fueron hace tiempo candidatas a explicar el problema de la materia oscura, pero los físicos ya saben hoy que no son lo suficientemente masivas como para conseguir este objetivo.

El detector de LUX contiene 370 kg de xenón líquido, de los que 250 kg son útiles para la búsqueda de materia oscura. El análisis de los resultados de LUX durante los primeros 100 días de ejecución del experimento equivalen a un estudio de 85,3 días de un volumen de 118 ± 6,5 kg de xenón. La eficiencia de detección de LUX es excelente, como muestra esta comparación de los eventos observados con las simulaciones por ordenador (en el caso de que no haya partículas WIMP de baja masa).

Como muestra esta figura se han observado 160 sucesos (unos 2 al día) entre 2 y 30 phe (S1), siendo todos ellos consistentes con el fondo esperado, es decir, con la hipótesis nula (que no hay partículas WIMP de baja masa).

Este resultado de LUX es unas 20 veces más sensible que los resultados publicados a día de hoy por su competencia: Edelweiss II, CDMS II, ZEPLIN-III y XENON100. La ausencia de partículas WIMP de baja masa contradice los resultados (o indicios) sobre la modulación anual observada en CoGeNT y DAMA/LIBRA, que deben tener otro tipo de explicación. Por supuesto, los resultados de LUX tratan la búsqueda de partículas WIMP cuya interacción elástica con los nucleones del núcleo de xenón es independiente del espín (interaccionan por igual con neutrones y protones). Por ello no se puede descartar la existencia de partículas WIMP cuya interacción con los nucleones sea dependiente del espín.

LUX continuará tomando datos durante 2014 y 2015 lo que mejorará su sensibilidad de forma significativa, aunque no se mejoras espectaculares. Lo dicho, un nuevo resultado negativo en la búsqueda la materia oscura, que cada día parece más escondida en lugares recónditos del espacio posible de parámetros.

Corazón de titanio

El corazón del experimento LUX es un “termo” de titanio de casi dos metros de altura con un tercio de tonelada de xenón líquido enfriado a menos 100 grados centígrados. Cuando una WIMP impacta contra un átomo de xenón retrocede -como una bola de billar blanca cuando golpea el triángulo de apertura de bolas de colores en el snooker- y se emiten fotones de luz al tiempo que se liberan electrones de los átomos circundantes. Los electrones son atraídos hacia arriba por un campo eléctrico y son absorbidos en una capa delgada de gas xenón en la parte superior del tanque, liberando más fotones.

Los detectores de luz en la parte superior y la parte inferior del tanque son cada uno capaz de detectar estas dos firmas de fotones. Las ubicaciones de las dos señales se puede establecer claramente en el espacio de unos pocos milímetros. La energía de la interacción puede medirse con precisión a partir de la luminosidad de los pulsos de luz. Las partículas que interactúan en el xenón causarán estas señales, pero se espera que las interacciones de las WIMP tengan tamaños característicos muy diferentes de los causados por las partículas ordinarias.

Mar

13

Conocer mejor el planeta Tierra

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en La Tierra y su energía ~

Clasificado en La Tierra y su energía ~

Comments (0)

Comments (0)

Esta es nuestra casa y, debemos procurar mantenerla limpia (no por si viene una visita, que espero que no sea pronto), sino que, es vital para nosotros y para vida en general. No siempre somos conscientes del daño que muchas de nuestras actividades pueden hacer al planeta que nos cobija. Pero veámos algunos detalles que definen a este planeta único en nuestro entorno espacial.

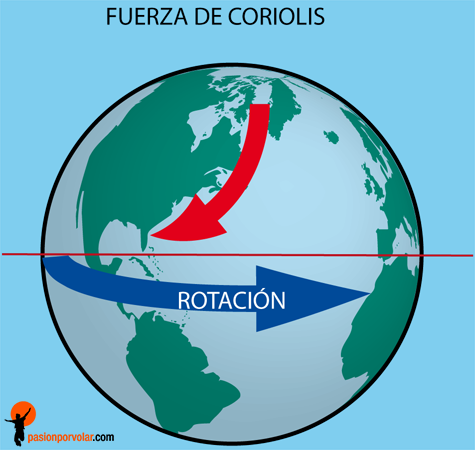

Las fuerzas que actúan sobre la Tierra, como planeta en el espacio, tiene profundas implicaciones energéticas. La gravitación ordena y orienta, y obstaculiza y facilita los flujos de energía cinética. La rotación genera la fuerza centrífuga y la de Coriolis: la primera achata el planeta por los polos ensanchándolo por el ecuador, y la segunda desvía los vientos y las corrientes de los océanos (a la derecha del hemisferio norte y a la izquierda en el hemisferio sur). La rotación es también la causa de los ritmos diarios de las plantas y animales, y de la desaceleración de la Tierra, que alarga el día un promedio de 1’5 ms cada siglo, lo que representa una pérdida de tres teravatios por fricción de mareas.

Pero ni la gravitación ni la rotación (fricción) hacen de la Tierra un planeta único entre los cuerpos celestes de nuestro entorno. Su exclusividad procede de sus propiedades térmicas internas, que causan los ciclos geotectónicos que modifican la superficie, y de su atmósfera, océanos y plantas que transforman la radiación solar que reciben. Los orígenes de estos procesos no están claros.

Podemos fijar la edad de la Tierra en algo más de los 4.000 millones de años por la desintegración de los isótopos radiactivos, pero poco podemos asegurar sobre la formación del planeta o sobre la energética de la Tierra primitiva. Sobre el tema circulan varias teorías, y es muy plausible que el origen del Sistema Solar planetario fuera una nube interestelar densa en la que el Sol se formó por una inestabilidad gravitatoria y que la posterior aglomeración del resto de esta materia dispersa, que giraba a distintas distancias, a su alrededor, diera lugar a los planetas. No está claro si al principio la Tierra estaba extremadamente caliente o relativamente fría. Me inclino por lo primero y estimo que el enfriamiento fue gradual con los cambios de atmósferas y la creación de los océanos.

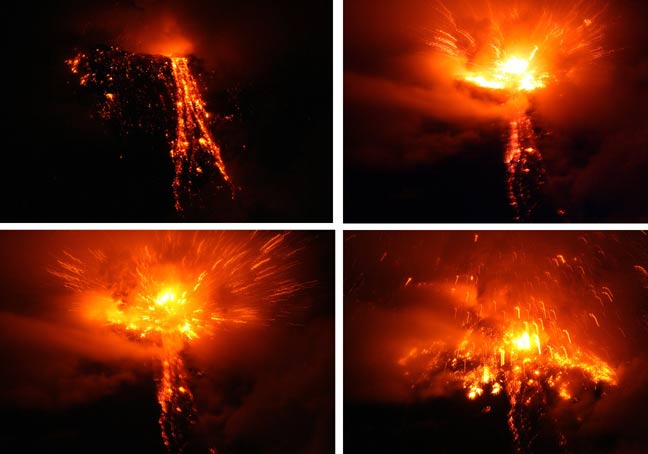

Esta de arriba podría ser una imagen cotidiana en la Tierra primitiva

Las incertidumbres geológicas básicas se extienden hasta el presente. Diferentes respuestas a cuestiones como la cantidad de 40K en el núcleo terrestre o sobre la convección del magma en el manto (hay una o dos celdas) dan lugar a diferentes explicaciones para el flujo de calor y la geotectónica de la Tierra. Lo que sí está claro es que el flujo interno de calor, menos de 100 mW/m2, tiene un efecto pequeño comparado con la reflexión, absorción y emisión de la radiación solar.

El balance de la radiación terrestre (Rp) en la capa alta de la atmósfera es la suma de la radiancia extraterrestre (la constante sola Q0) reducida por el albedo planetario y el flujo saliente de larga longitud de onda (Qi): Rp = Q0(1-ap) + Qi = 0. El flujo emitido es igual a la suma de la radiación atmosférica y la terrestre: Qi = Qea + Qes. Los balances de la radiación en la atmósfera (Ra) y en la superficie de la Tierra (Rs) son iguales, respectivamente, a la diferencia entre la correspondiente absorción y emisión: Ra = Qaa + Qea y Rs = Qas + Qes, de manera que Rp = Ra + Rs = 0. Hay que continuar explicando la radiación saliente con los flujos irradiados y emitidos por la superficie terrestre, el flujo de radiación medio absorbida, etc., etc., etc., con una ingente reseña de símbolos y tedioso esquemas que, a mi parecer, no son legibles para el lector normal y no versado en estos conocimientos. Así que, aunque sea mutilar el trabajo, desisto de continuar por ese camino y prosigo por senderos más amenos y sugestivos para el lector.

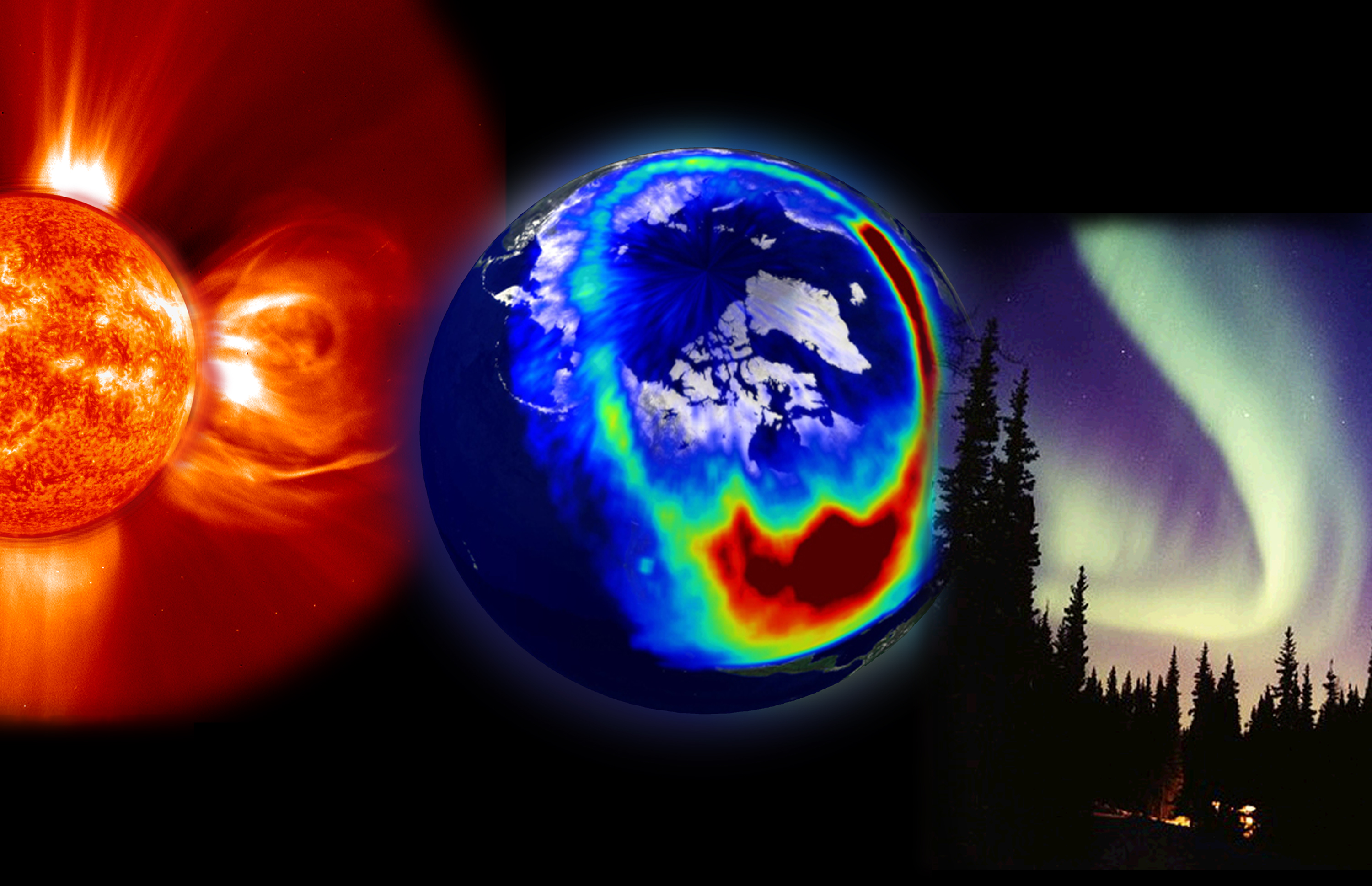

El impacto de la radiación solar en la atmósfera terrestre, en una gran tormenta solar de 2003. (Crédito: NASA / Goddard

La fuente más importante del calentamiento atmosférico proviene de la radiación terrestre de longitud de onda larga, porque el flujo de calor latente es una contribución secundaria y el flujo de calor sensible sólo es importante en las regiones áridas donde no hay suficiente agua para la evaporación. Los océanos y los continentes también reciben indirectamente, irradiadas por la atmósfera, la mayor parte de su calor en forma de emisiones de longitudes de onda larga (4 – 50 μm). En este flujo de radiación reenviado hacia la superficie terrestre por los gases invernadero, domina a la radiación del vapor de agua, que con una concentración variable, emite entre 150 y 300 W/m2, y al que también contribuye el CO2 con unos 75 W/m2.

El intercambio de radiación de longitud de onda larga entre la superficie y la atmósfera sólo retrasa temporalmente las emisiones de calor terrestre, pero controla la temperatura de la biosfera. Su máximo es casi 400 W/m2 en los trópicos nubosos, pero es importante en todas las estaciones y presenta significativas variaciones diarias. El simple paso de una nube puede aumentar el flujo en 25 W/m2. Las mayores emisiones antropogénicas de gases invernadero han aumentado este flujo en cerca de un 2’5 W/m2 desde finales del siglo XIX.

Como era de esperar, las observaciones de los satélites confirman que el balance de energía de la Tierra está en fase con la radiación solar incidente (Q0), pero la radiación media saliente (Qi) está desfasada con la irradiancia, alcanzando el máximo durante el verano en el hemisferio norte. La distribución asimétrica de los continentes y el mar explica este fenómeno. En el hemisferio norte, debido a la mayor proporción de masa terrestre, se experimentan mayores cambios estacionales que dominan el flujo global de la radiación saliente.

Quizás el resultado más sorprendente que se deriva de las observaciones por satélite sea que, estacionalmente, se observan cierto déficit y superávit de radiación y el balance de la radiación en el planeta no es igual a cero, pero sin embargo, en cada hemisferio la radiación anual está en equilibrio con el espacio exterior. Además, la contribución atmosférica por transporte de energía hacia los polos es asimétrica respecto al ecuador con valores extremos de unos 3 PW cerca de los 45º N, y -3 PW cerca de 40º S.

Podría continuar hablando sobre los vientos, los terremotos, las lluvias y otros fenómenos atmosféricos, sin embargo, no creo que, por ser estos fenómenos naturales muy conocidos de todos, pudieran tener gran interés. Pasemos pues a comentar sobre los océanos.

El agua de la vida

Agua, mejor que Tierra, habría sido el nombre adecuado para el tercer planeta, puesto que los océanos cubren más del 70 por ciento de la superficie terrestre, con una profundidad media de 3’8 Km. Debido a las especiales propiedades térmicas del agua, éstas constituyen un extraordinario regulador del balance energético del planeta.

Este líquido tiene cinco ventajas termodinámicas importantes: un punto de ebullición inusualmente alto, debido a su capacidad para formar enlaces de hidrógeno intermoleculares; un calor específico de 2’5 a 3’3 veces más elevado que el del suelo; una capacidad calorífica (calor específico por unidad de volumen) aproximadamente seis veces mayor que la tierra seca; un altísimo calor de vaporización que le permite transportar una gran cantidad de calor latente; y su relativamente baja viscosidad, que le convierte en un eficiente transportador de calor en los océanos mediante miríadas de remolinos y caudalosas corrientes.

Los océanos de la Tierra vistos desde el espacio

No es sorprendente, pues, que los océanos, que tienen cerca del 94 por ciento de toda el agua, sean determinantes en el balance energético del planeta. Cuatro quintas partes de la radiación solar que llega a la Tierra entra en la atmósfera que cubre los océanos, los cuales con un albedo superior al 6% absorben la energía con una tasa cercana a 65 PW, casi el doble de la absorción atmosférica total y cuatro veces mayor que la continental. Inevitablemente, los océanos también absorben la mayor parte, casi dos tercios, del calor rerradioirradiado hacia abajo por la atmósfera elevando su ritmo de calentamiento a los 175 PW.

Salvo en los océanos menos profundos, la interacción aire-mar no afecta directamente a las aguas profundas. Las oscuras y frías aguas de las profundidades marinas están aisladas de la atmósfera por la capa mixta, una capa de poca profundidad que va de pocos metros a pocos cientos de metros y que está afectada por los vientos y el oleaje.

A pesar de que el alto calor específico del agua limita el rango de variación, las temperaturas de esta capa sufren importantes fluctuaciones diarias y estacionales. Sin embargo, variaciones relativamente pequeñas de la temperatura de la superficie de los océanos tienen importantes consecuencias climáticas: quizás el mejor ejemplo de esta teleconexión climática sea el fenómeno del Niño, que consiste en una extensión en forma de lengua de las aguas superficiales calientes hacia el este, cuyos efectos se extienden desde Canadá hasta África del sur.

En esta “coreografía” acuática, también tiene un papel significativo el Estrecho de Dinamarca, que se alimentan de las aguas más profundas de la AMOC y las devuelve al sur a través de brechas en la cordillera de Groenlandia y Escocia. En este sentido, los científicos explican que, durante años, se ha pensado que el estrecho danés, que ha aumentado considerablemente su capacidad como consecuencia del deshielo, se abastecía de una corriente adyacente a Groenlandia.

Debido a que la conductividad térmica del agua es muy baja, la transferencia de energía de la capa mixta hacia las profundidades se realiza fundamentalmente mediante corrientes convectivas. Estas corrientes compensan la extremadamente baja fuerza ascensional de las aguas profundas, más calientes, que son desplazadas por el movimiento hacia el ecuador de las corrientes frías provenientes de los polos. En contraste con el gradual ascenso general de las aguas oceánicas, la convección hacia abajo se produce en corrientes bien delimitadas que forman gigantescas cataratas oceánicas. Seguramente la mayor es la que fluye hacia el sur bajo el estrecho de Dinamarca, entre Islandia y Groenlandia, y se sumerge unos 3’5 Km transportando 5 millones de m3/s, un caudal veinte veces mayor que el del Amazonas.

Miríadas de corrientes oceánicas, que a menudo viajan cientos de kilómetros a diferentes profundidades, transportan considerables cantidades de energía y sal. Quizás el ejemplo más importante de estas combinaciones de transportes sea la corriente de agua caliente y salada que sale del Mediterráneo a través del estrecho de Gibraltar. Este flujo caliente pero denso desciende sobre la pendiente de la plataforma continental hasta alcanzar el equilibrio entre el peso y el empuje ascensional a unos mil metros de profundidad. Aquí se separa en dos celdas lenticulares que se mueven durante siete años hacia el este y hacia el sur, respectivamente, hasta que decaen o chocan contra alguna elevación marina.

Si el Estrecho de Gibraltar pudiera contar su historia…

Un mapa global de los flujos de calor desde la superficie oceánica hasta las capas profundas muestra claramente máximos longitudinales a lo largo del ecuador y a lo largo de aproximadamente 45º S en los océanos Atlántico e Índico. Esta transferencia es también importante en algunas áreas costeras donde se producen intensos flujos convectivos ascendentes que intercambian calor entre las aguas superficiales y las profundas, como ocurre en la costa de California y al oeste de África. Un flujo en dirección contraria, que calienta la atmósfera, se produce en las dos mayores corrientes oceánicas calientes, la corriente del Golfo en el Atlántico y la de Kuroshio en el Pacífico oriental.

Todas la regiones donde se produce este ascenso de aguas calientes (a lo largo de las costas del continente americano, África, India y la zona ecuatorial del Pacífico occidental) se distinguen fácilmente por los elevados niveles de producción de fitoplancton, causados por un importante enriquecimiento de nutrientes, comparados con los que, de otra manera, corresponderían normalmente a las aguas superficiales oligotrópicas.

La radiación transporta la mayor parte (casi 4/5) de la energía que fluye desde la capa mixta hasta la atmósfera, y el resto del flujo calorífico se produce por calor latente en forma de vapor de agua y lluvias.

Océano Atrlántico

Aún no se ha realizado una valoración cuantitativa del transporte total para cada latitud, pero en el océano Atlántico hay transferencia de calor hacia el norte a lo largo de toda su extensión, alcanzando en el trópico un valor aproximado de 1 PW, flujo equivalente al que se produce en el Pacífico norte. En el Pacífico sur, el flujo de calor hacia el polo a través del trópico es de 0’2 PW. La parte occidental del Pacífico sur puede constituir la mayor reserva de calor del Atlántico sur, de igual modo que es probable que el océano Índico sur constituya una reserva del Pacífico.

Ahora tocaría comentar algo sobre los ríos del planeta, sin embargo, lo obvio y me dirijo directamente a comentar sobre el calor de la Tierra.

Aunque la Tierra se formara inicialmente a partir de materia fría (material cósmico) que se contrajo por acción de la gravedad, durante la formación posterior del núcleo líquido y en los periodos de intensa actividad volcánica se ha liberado una enorme cantidad de calor. Los frecuentes impactos de objetos pesados también han contribuido al calentamiento de la superficie. Hay mucha incertidumbre sobre la historia térmica de la Tierra de los últimos 3.000 millones de años, durante los cuales el planeta se ha ido enfriando y una gran parte de este flujo de calor ha alimentado los movimientos geotectónicos globales, creando nueva corteza en las dorsales oceánicas; un proceso que ha ido acompañado de terremotos recurrentes y erupciones volcánicas de lava, cenizas y agua caliente.

Solamente hay dos posibles fuentes de calor terrestre, pero la importancia relativa de las respectivas contribuciones no está aún muy clara. El calor basal, liberado por un lento enfriamiento del núcleo terrestre debe representar una gran parte del flujo total, si bien cálculos basados en la desintegración radiactiva del U235, U238, Th232 y K40 sugieren que éste representa al menos la mitad y quizás hasta nueve décimos del flujo total de calor del planeta. Esta disparidad obedece a la incertidumbre en la concentración de K40 en la corteza terrestre. Pero sea cual sea la proporción, el flujo total, basado en miles de medidas realizadas desde los años cincuenta, está próximo a los 40 TW.

Aunque inicialmente se pensó que los flujos continentales y oceánicos eran aproximadamente iguales, en realidad difieren de forma sustancial. Las regiones del fondo oceánico más recientes contribuyen con más de 250 mW/m2, cantidad que supera hasta tres veces las zonas continentales más recientes. El flujo medio para todo el fondo marino es aproximadamente igual a 95 mW/m2, lo que representa un 70% más que el correspondiente a la corteza continental. El flujo medio global es de 80 mW/m2, unos tres órdenes de magnitud inferior al valor medio del flujo de calor de la radiación solar global.

Publica: emilio silvera

La fuente del presente trabajo, aunque variada en texto e imágenes, en su mayor parte está en una guía ilustrada de la biosfera y la civilización de Vaclav Smil.

Totales: 67.251.858

Totales: 67.251.858 Conectados: 38

Conectados: 38