Dic

7

Una sola teoría para todas las fuerzas del Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (1)

Comments (1)

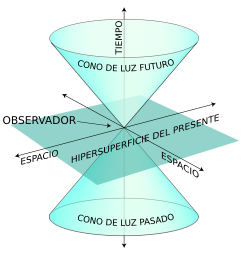

La discusión de la unificación de las leyes de la Naturaleza fue más bien abstracta, y lo habría seguido siendo si Einstein no hubiese dado el siguiente paso decisivo. Él comprendió que si el espacio y el tiempo pueden unificarse en una sola entidad, llamada espaciotiempo, entonces quizá la materia y la energía pueden unirse también en una relación dialéctica. Si las reglas pueden contraerse y los relojes pueden frenarse, razonó, entonces cualquier cosa que midamos con regla y relojes también debe cambiar. (Es deseable dejar aquí una nota aclaratoria de que, todo lo que ahora se cuenta de Einstein, en parte, tiene su fuente en otros científicos que, aportaron la base de sus ideas en las que él se inspiró para llegar hasta la relatividad, y, su efecto fotoeléctrico -que le valió el Nobel de Física- le llegó desde la mente de Planck que, con su cuento de acción, h, le abrió el camino a aquel trabajo).

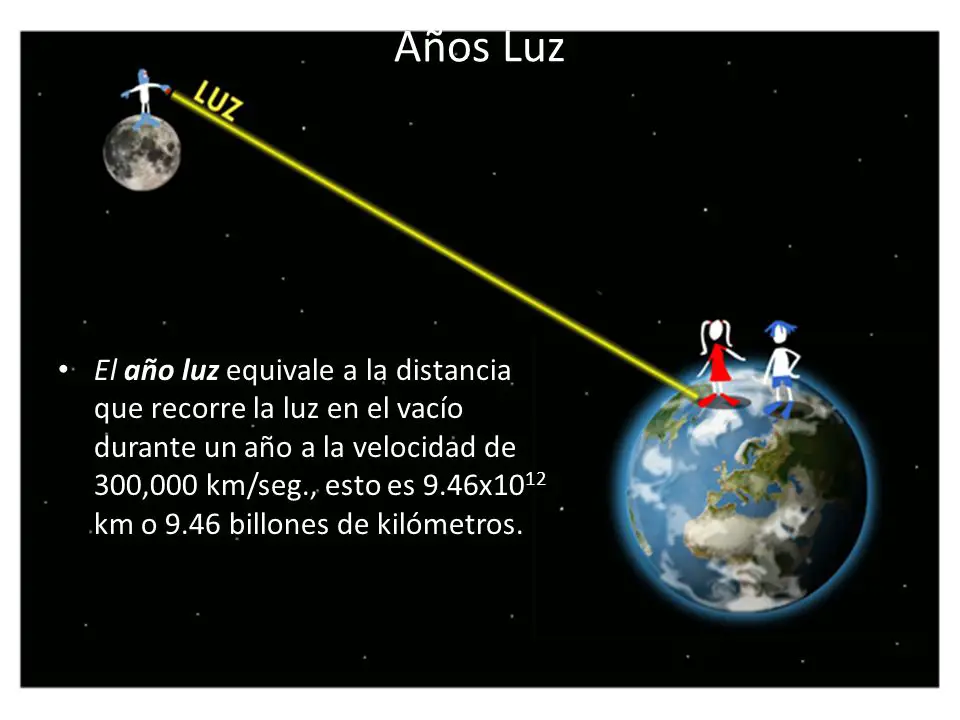

Más rápido que la luz, en nuestro Universo conocido, nada puede ir. Ni información, ni objetos inanimados, ni seres vivos. La velocidad de la luz recorre la distancia de la Tierra a la Luna en poco más de un segundo.

Sin embargo, casi todo en el laboratorio de un físico se mide con regla y relojes. Esto significa que los físicos tendrán que recalibrar todas las magnitudes del laboratorio que una vez dieron por hecho que eran constantes.

En concreto, la energía es una cantidad que depende de cómo midamos las distancias y los intervalos de tiempo. Un automóvil de prueba que choca a gran velocidad contra una pared de ladrillos tiene obviamente energía. No obstante, si el veloz automóvil se aproxima a la velocidad de la luz, sus propiedades se distorsionan. Se contrae como un acordeón y los relojes en su interior se frenan.

Lo que es más importante, Einstein descubrió que la masa del automóvil también aumenta cuando reacelera. Pero ¿de dónde procede este exceso de masa? Y él concluyó que procedía de la energía. La masa relativista es la masa de un cuerpo medida por un observador con respecto al cual ese cuerpo se mueve. De acuerdo con la teoría de Einstein, esta masa está dada por:

donde m0 es su masa en reposo y c es la velocidad de la luz. La masa relativista sólo difiere de la masa en reposo si su velocidad es una fracción apreciable de la velocidad de la luz. Si V= c/2, por ejemplo, la masa relativista es un 15% mayor que la masa en reposo.

De hecho, cuando una partícula se acerca a la velocidad de c, su masa … ¡aumenta! El muón, aumentó su masa m´ñas de diez veces al llegar cerca de la velocidad de la luz.

Esto tuvo consecuencias perturbadoras. Dos de los grandes descubrimientos de la física del siglo XIX fueron la conservación de la masa y la conservación de la energía; es decir, la masa total y la energía total de un sistema cerrado, tomadas por separado, no cambian.

Sin embargo, Einstein decía que cuando un cuerpo material se acerca a la velcoidad de la luz, su masa aumenta y, si puediera llegar a la velocidad de c, se haría infinita. Por eso precisamente, nada, en el Universo, puede ir más rápido que la luz. Esa es la frontera que impone el Universo para la velocidad. Nació un nuevo principio de conservación que decía que la suma total de la masa y la energía debe siempre permanecer constante. La materia no desaparece repentinamente, ni la energía brota de la nada. En este sentido, la materia desaparece sólo para liberar enormes cantidades de energía o viceversa.

¿Sabremos alguna vez qué energía es la que sale del “vacío”?

Cuando Einstein tenía 26 años, calculó exactamente cómo debía cambiar la energía si el principio de la relatividad era correcto, y descubrió la relación E=mc2. Puesto que la velocidad de la luz al cuadrado (c2) es un número astronómicamente grande, una pequeña cantidad de materia puede liberar una enorme cantidad de energía. Dentro de las partículas más pequeñas de materia hay un almacén de energía, más de un millón de veces la energía liberada en una explosión química. La materia, en cierto sentido, puede verse como un depósito casi inagotable de energía; es decir, la materia es en realidad, energía condensada.

La materia del Universo…¿donde está? ¡Esa que no podemos ver!

Einstein supo ver que las dimensiones más altas tienen un propósito: unificar los principios de la Naturaleza. Al añadir dimensiones más altas podía unir conceptos físicos que, en un mundo tridimensional, no tienen relación, tales como la materia y la energía o el espacio y el tiempo que, gracias a la cuarta dimensión de la relatividad especial, quedaron unificados.

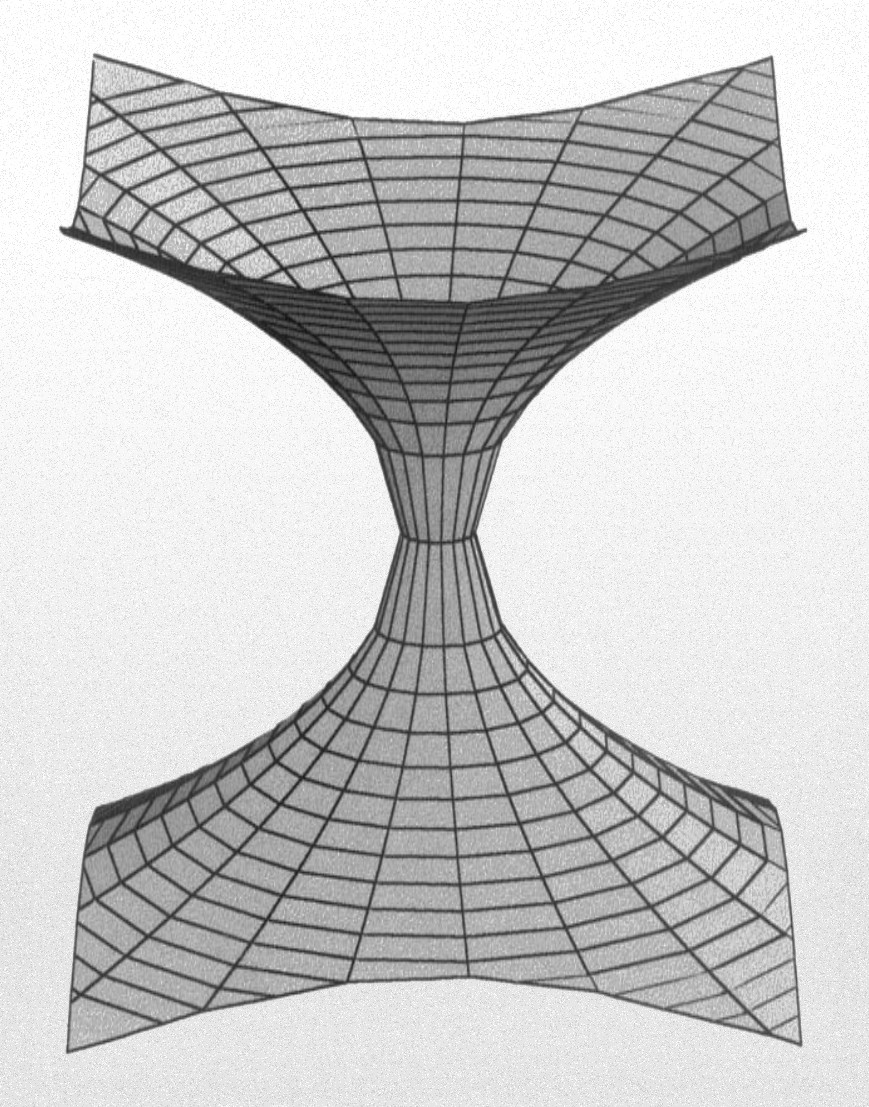

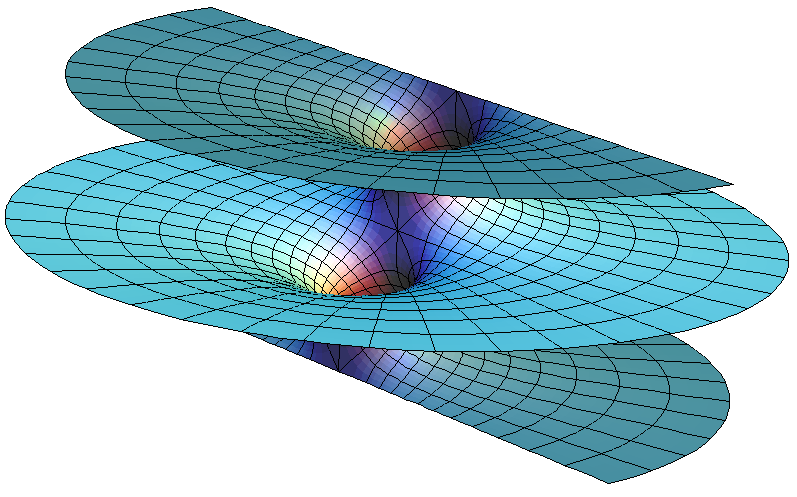

¿Que pensaba Einstein del puente Einstein-Rosen?

El puente de Einstein-Rosen conecta universos diferentes. Einstein creía que cualquier cohete que entrara en el puente sería aplastado, haciendo así imposible la comunicación entre estos dos universos. Sin embargo, cálculos más recientes muestran que el viaje a través del puente, aunque podría ser muy difícil, no sería imposible; existen ciertas posibilidades de que algún día se pudiera realizar

Posteriormente, los puentes de Einstein-Rosen se encontraron pronto en otras soluciones de las ecuaciones gravitatorias, tales como la solución de Reisner-Nordstrom que describe un agujero eléctricamente cargado. Sin embargo, el puente de Einstein-Rosen siguió siendo una nota a pie de página curiosa pero olvidada en el saber de la relatividad.

Roy Patrick Kerr (16-05-1934- ) es un matemático neozelandés, famoso por haber encontrado en 1963 una solución exacta de la ecuación de campo de la relatividad general, aplicada a un agujero negro en rotación.

Las cosas comenzaron a cambiar con la solución que el trabajo matemático presentado por el neozelandés Roy Kerr, presentado en 1.963, encontró otra solución exacta de las ecuaciones de Einstein. Kerr supuso que cualquier estrella colapsante estaría en rotación. Así pues, la solución estacionaria de Schwarzschild para un Agujero Negro no era la solución físicamente más relevante de las ecuaciones de Einstein.

La solución de Kerr causó sensación en el campo de la relatividad cuando fue propuesta. El astrofísico Subrahmanyan Chandrasekhar llegó a decir:

“La experiencia que ha dejado más huella en mi vida científica, de más de cuarenta años, fue cuando comprendí que una solución exacta de las ecuaciones de Einstein de la relatividad general, descubierta por el matemático Roy Kerr, proporciona la representación absolutamente exacta de innumerables agujeros negros masivos que pueblan el universo. Este estremecimiento ante lo bello, este hecho increíble de que un descubrimiento motivado por una búsqueda de la belleza en matemáticas encontrará su réplica exacta en la naturaleza, es lo que me lleva a decir que la belleza es aquello a lo que lleva la mente humana en su nivel más profundo“.

Si queremos saber, tendremos que desvelar lo que ocurrió y, según la información que el agujero negro retenga de los entes cósmicos que generaron su origen o de las propiedades de su anterior vida como masiva estrella.

La solución de Kerr de un agujeros negros giratorio permite que una nave espacial pase a través del centro del agujero por el eje de rotación y sobrevivir al viaje a pesar de los enormes pero finitos campos gravitorios en el centro, y seguir derecha hacia el otro universo especular sin ser destruida por la curvatura infinita.

Desde entonces, estos conceptos, los tenemos que clasificar, no por separado, sino siempre juntos como dos aspectos de un mismo ente materia-energía por una parte y espacio-tiempo por la otra. El impacto directo del trabajo de Einstein sobre la cuarta dimensión fue, por supuesto, la bomba de hidrógeno, que se ha mostrado la más poderosa creación de la ciencia del siglo XX. Claro que, en contra del criterio de Einstein que era un pacifista y nunca quiso participar en proyectos de ésta índole.

Ernest Mach

Einstein completó su teoría de la relatividad con una segunda etapa que, en parte, estaba inspirada por lo que se conoce como principio de Mach, la guía que utilizó Einstein para crear esta parte final y completar su teoría de relatividad general.

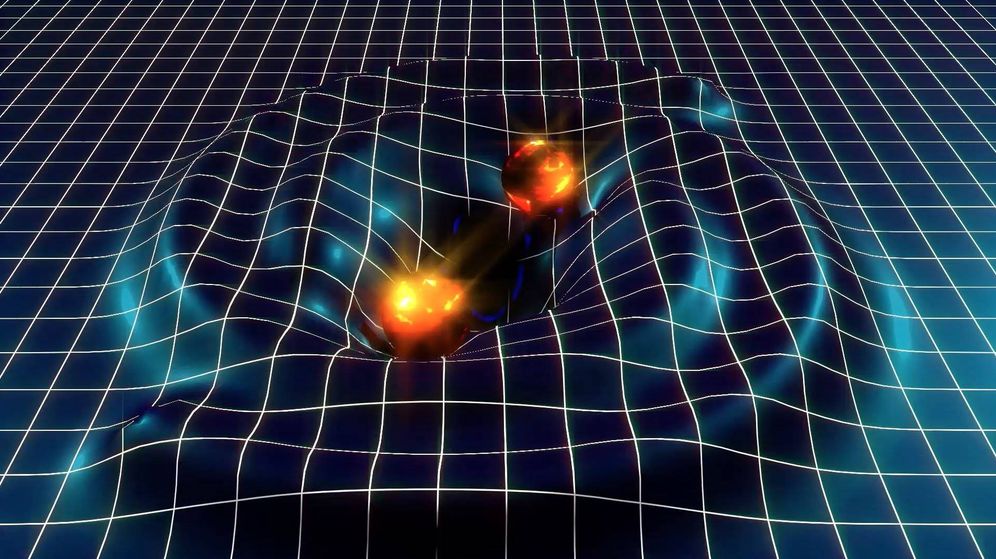

Einstein enunció que, la presencia de materia-energía determina la curvatura del espacio-tiempo a su alrededor. Esta es la esencia del principio físico que Riemann no logró descubrir: la curvatura del espacio está directamente relacionada con la cantidad de energía y materia contenida en dicho espacio.

Esto, a su vez, puede resumirse en la famosa ecuación de Einstein que, esencialmente afirma:

![]()

La ecuación anterior expresa que el contenido material determina la curvatura del espacio-tiempo.

Materia-energía determina la curvatura del espacio-tiempo.

Esa ecuación de arriba de la imagen, engañosamente corta es uno de los mayores triunfos de la mente humana (me he referido a ella en otras muchas ocasiones). De ella emergen los principios que hay tras los movimientos de las estrellas y las galaxias, los agujeros negros, el big bang, y seguramente el propio destino del Universo.

Es curiosa la similitud que se da entre la teoría del electromagnetismo y la relatividad general, mientras que Faraday experimentó y sabía los resultados, no sabía expresarlos mediante las matemáticas y, apareció Maxwell que, finalmente formuló la teoría.

Einstein, al igual que Faraday, había descubierto los principios físicos correctos, pero carecía de un formulismo matemático riguroso suficientemente potente para expresarlo (claro que Faraday no era matemático y Einstein si lo era). Carecía de una versión de los campos de Faraday para la Gravedad. Irónicamente, Riemann tenía el aparato matemático, pero no el principio físico guía, al contrario que Einstein. Así que, finalmente, fue Einstein el que pudo formular la teoría con las matemáticas de Riemann.

Mediante el Tensor métrico de Rieman, Einstein pudo formular su famosa teoría de la relatividad General, sonde el espacio y el tiempo se distorsionan en presencia de grandes masas. El tensor métrico de Riemann le permitió erigir un potente aparato para describir espacios de cualquier dimensión con curvatura arbitraría. Para su sorpresa, encontró que todos estos espacios están bien definidos y son autoconsistentes. Previamente, se pensaba que aparecerían terribles contradicciones al investigar el mundo prohibido de dimensiones más altas. Riemann no encontró ninguna. De hecho, resultaba casi trivial extender su trabajo a un espacio N-dimensional. El tensor métrico se parecía ahora a un tablero de ajedrez de N x N casillas

El tensor de Riemann contiene toda la información necesaria para poder describir un espacio curvo en N-dimensiones. Se necesita dieciséis números para describir el tensor métrico en un espacio tetradimensional. Estos números pueden disponerse en una matriz cuadrada (seis de dichos números son realmente redundantes; de modo que el tensor métrico tiene diez números independientes).

“¡Qué extraño sería que la teoría final se descubriera durante nuestra vida! El descubrimiento de las leyes finales de la Naturaleza marcará una discontinuidad en la Historia del intelecto humano, la más abrupta que haya ocurrido desde el comienzo de la ciencia moderna del siglo XVII. ¿Podemos imaginar ahora como sería?” Así se expresó Steven Weinberg que comprendia la complejidad de la empresa. Él, se refería a las modernas versiones de la teoría de cuerdas.

¿Es la belleza un principio Físico?

Cuando hablamos de las teorías de supercuerdas (todas las versiones), lo hacemos sobre otro universo…En este, de momento, las cuerdas no aparecen y, por lo que parece, durante bastante tiempo no aparecerán.Es una teoría, como nos dice Witten, adelantada a su tiempo y, no disponemos ni de la energía necesaria para poder llegar a ellas (si es que finalmente existen) ni tampoco, las matemáticas actuales son lo suficientemente potentes para poder explicarlas en toda su grandeza.

Un universo de cuerdas que vibran en el espacio-tiempo para producirm partículas…¡Todo podríam ser!

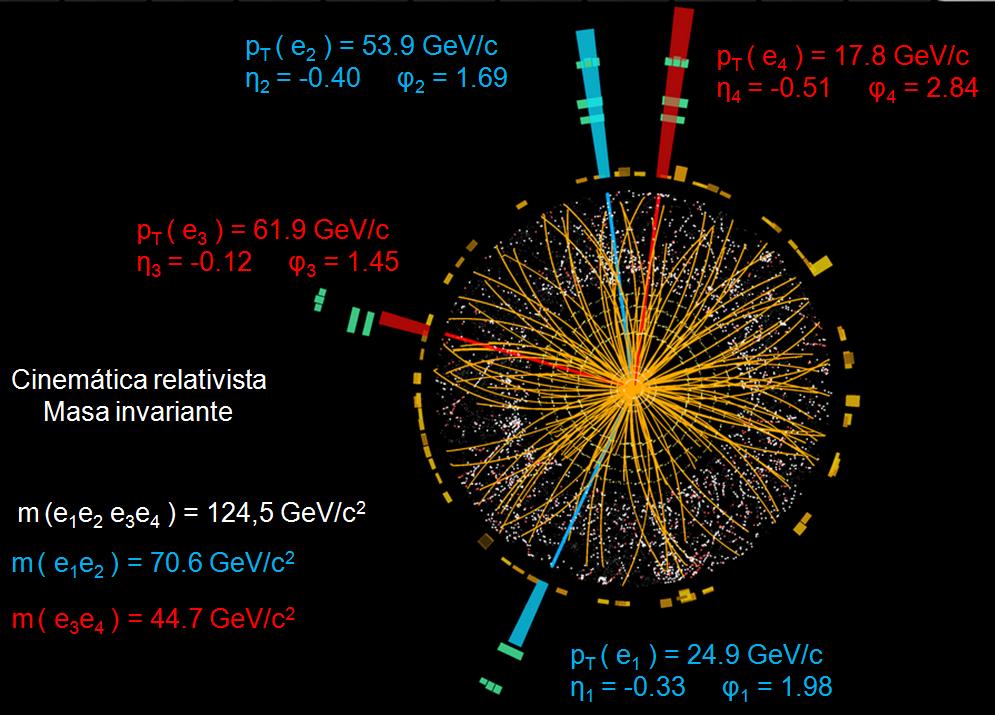

La teoría de supercuerdas nos da una formulación convincente de la teoría del Universo, sin embargo, el problema fundamental radica en que una comprobación de dicha teoría, está más allá de nuestras posibilidades actuales. De hecho, la misma teoría predice que la unificación de todas las fuerzas ocurre a la energía de Planck, o 1019 miles de millones de electronvoltios (eV), que como sabéis, es alrededor de mil billones de veces mayor que las energías actualmente disponibles en nuestros aceleradores de partículas.

Ni el LHC con toda su moderna tecnología, podría encontrar las cuerdas. No dispone de la energía de Planck, es decir 1019 GeV que es la que se calcula podría alcanzar las hipóteticas cuerdas, y, esa energía, está lejos de que la podamos manejar.

Los creadores de la QED: Feynman, Tomonaga, Schwinger y Dyson

Ya he comentado otras veces que el físico David Gross (el de más edad de los miembros conocidos como el “cuarteto de cuerdas” y autores de la teoría llamada la cuerda heterótica) dijo en una ocasión: “El coste de generar esta fantástica energía, necesitaría el dinero de las tesorerías de todos los países del mundo juntos, y quizá, no llegara. Es verdaderamente astronómico.”

Siendo así, de momento estamos condenados a no poder verificar experimentalmente este motor (parado) que haría marchar el vehículo de la Física. La teoría decadimensional está paralizada en dos sentidos: el económico y el técnico – matemático. El primero por falta de dinero que nos pudiera construir aceleradores tan potentes como para descubrir la partícula de Higgs (la única descubierta) los quarks e incluso las cuerdas vibrantes, esos previsibles y minúsculos objetos primordiales que conforman la materia. En segundo lugar, las formulaciones matemáticas complejas que, según parece, aún no se han inventado. Parece que hoy, ni siquiera Witten o Perelman, conocen el secreto de los números mágicos que nos puedan llevar hasta el final del camino iniciado con Einstein y Kaluza-Klein.

Particularmente opino que la teoría de cuerdas nos dará muchas alegrías y que en ella están las respuestas a muchas preguntas que no sabemos contestar. Incluso estaría por apostar alguna cosa (un café), sobre la posibilidad de que, aunque con mucho menos energía de la necesaria para hallar las cuerdas, en el LHC podrían aparecer…las sombras de las mismas.

No, de estas cuerdas no hablamos

Dentro del mundo de la Física, los hay de todas las opiniones: en contra y a favor. Es famosa la postura detractora del Nóbel Sheldoy Glasgow de Harvard, no quiere ni oír hablar de la teoría de supercuerdas a la que califica de física de Teatro.

Otros muchos, la mayoría, como Murray Gell-Marn, Steven Weinberg (ambos Premios Nóbel) o el mismo. E. Witten (Medalla Field), opinan lo contrario y ven en esta teoría de dimensiones más altas el futuro de la Física.

Ya sabemos que en física toda teoría debe ser verificada, una y otra vez, en uno y en otro lugar, experimentalmente, obteniendo siempre el mismo resultado, es la única manera de que sea aceptada por la comunidad científica, mientras tanto, la teoría no es fiable y queda a la espera de ser comprobada, verificada sin ningún lugar para la duda.

Pero, ¿Se puede recrear la creación?

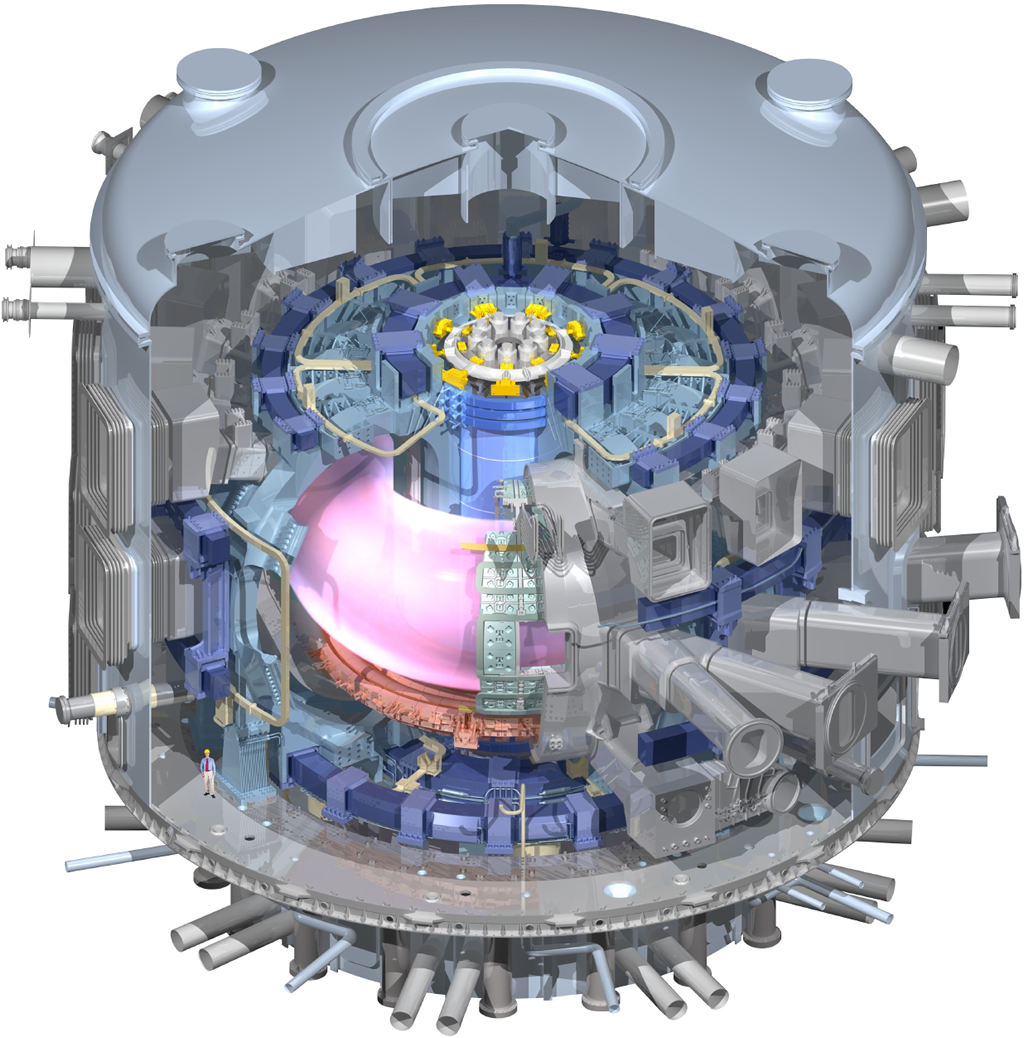

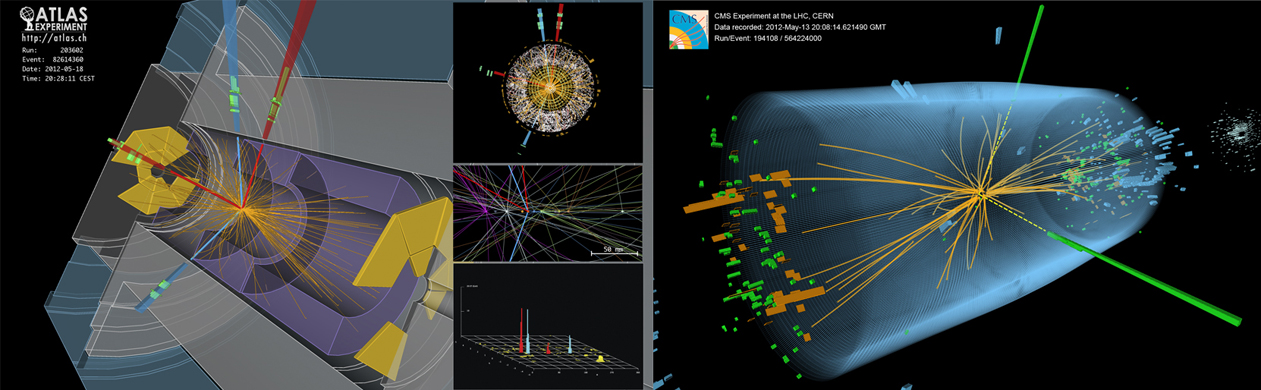

Eso es, precisamente, lo que tratan de hacer aquí, recrear los primeros instantes del Universo

La teoría de supercuerdas trata de eso. Quiere explicarnos todos los misterios del Universo a partir de ese primer momento, ¡la creación!

¿Cuántas y cuántas páginas no habré leído y escrito sobre estos temas fascinantes de los secretos del Universo, las fuerzas que lo rigen, la materia de las Galaxias y de los objetos que lo pueblan?

No podría decirlo. Sin embargo, hay una cosa que sí puede decir: ¡Cuánto más profundizo en estas cuestiones, cuánto más conocimientos adquiero, más fascinación siento y desde luego, mi capacidad de asombro, más crece! Qué verdad dijo aquel sabio: “Siempre seremos aprendices” ¿Porque, quién puede saberlo todo? Es raro el día que nos acostamos sin haber aprendido algo nuevo.

La degradación de los cables superconductores en el corazón de la máquina de fusión ITERamenaza con provocar mayores retrasos. El ITER (International Thermonuclear Experimental Reactor) Son muchos los proyectos que tienen vía libre y otros han sido desechados por su alto costo.

El acelerador de partículas más grande del mundo está abandonado en Texas

¡Qué lastima que no se construyera el súper colisionador superconductor! (SSC), que encontrara los vestigios subatómicos que mostrara una señal característica de la supercuerda, tal como la súpersimetría. Aunque ni con este monstruoso SSC se hubiera podido sondear la distante energía de Planck, si podría habernos ofrecido una evidencia muy fuerte (aunque indirecta) de la corrección de la teoría de supercuerdas.

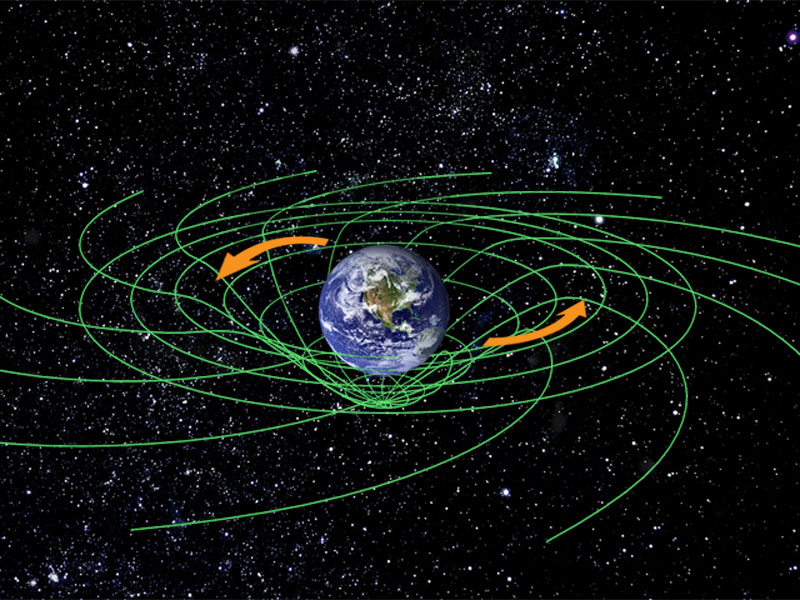

Este súper colisionador que se hubiese completado en las afueras de Dallas, Texas, hubiera contado con un tubo gigantesco de 85 km. De circunferencia rodeado de enormes bobinas magnéticas. Lanzaría protones a velocidades muy cercanas a la de la luz que, viajarían en el sentido de las aguas del reloj y el sentido contrario, para en un momento dado, hacerlos colisionar a una energía de 40 billones de electronvoltios (TeV), generando una intensa ráfaga de residuos subatómicos analizados por detectores que, en contrarían partículas exóticas que hubieran arrojado luz sobre la forma esencial de la materia. Los campos magnéticos para guiar los protones y los antiprotones dentro del tubo son tan excepcionalmente grandes (del orden de 100.000 veces el campo magnético de la Tierra) que, hubieran sido necesarios procedimientos extraordinarios para generarlos y mantenerlos.

Además del enfriamiento de las bobinas hasta casi el cero absoluto (-273°) y otros problemas que hubieran obligado a enormes avances tecnológicos. Sin embargo, la política, se cargó el proyecto y nos quedamos sin la esperada partícula de Higgs que es la que genera la ruptura de simetría y es por tanto el origen de la masa de los quarks, así que, habríamos podido descubrir el origen de la masa. Sin embargo, no podemos perder la esperanza, el LHC está en marcha y pronto, nos dará muchas alegrías.

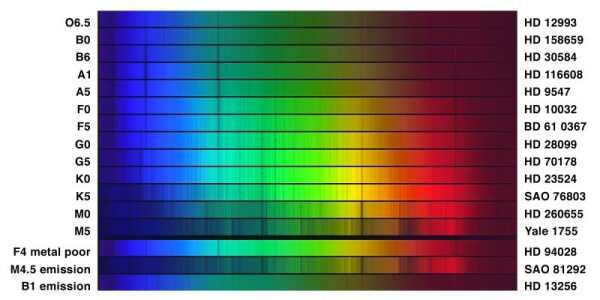

Me viene a la memoria que en el siglo XIX, algunos científicos declararon que la composición de las estrellas estaría siempre fuera del alcance del experimento. En 1.825, el filósofo y crítico social francés Auguste Comte, al escribir el Curso de Filosofía, declaraba que nunca conoceríamos las estrellas de otra forma que como inalcanzables puntos de luz en el cielo debido a su enorme distancia de nosotros. Las máquinas del siglo XIX, o de cualquier siglo, argumentaba, no eran suficientemente potentes para escapar de la Tierra y alcanzar las estrellas.

Así que parecía que el determinar la composición de las estrellas era imposible, y, lo curioso es que, casi al mismo tiempo, el físico alemán Joseph Von Fraunhofer estuviera haciendo precisamente eso. Utilizando un prisma y un espectroscópio, pudo descomponer la luz blanca emitida desde las estrellas lejanas y determinar la composición química de dichas estrellas.

De la misma manera, pudiera, en este mismo instante, estar trabajando un físico-matemático en profundizar en la teoría de supercuerdas y estar formulando otro respetable avance hacia nuestro futuro.

¿Qué sería de nosotros sin la Física?

emilio silvera

Dic

6

¡Cuántas maravillas!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

No sería descabellado decir que las simetrías que vemos a nuestro alrededor, un arco iris a las flores y a los cristales, pueden considerarse en última instancia como manifestaciones de fragmentos de la teoría decadimensional original. Riemann y Einstein habían confiado en llegar a una comprensión geométrica de por qué las fuerzas pueden determinar el movimiento y la naturaleza de la materia. Por ejemplo, la fuerza de Gravedad generada por la presencia de la materia, determina la geometría del espacio-tiempo.

Dado el enorme poder de sus simetrías, no es sorprendente que la teoría de supercuerdas sea radicalmente diferente de cualquier otro de física. De hecho, fue descubierta casi por casualidad. Muchos físicos han comentado que si este accidente fortuito no hubiese ocurrido, entonces la teoría no se hubiese descubierto hasta bien entrado el siglo XXI. Esto es así porque supone una neta desviación de todas las ideas ensayadas en este siglo. No es una extensión natural de tendencias y teorías populares en este siglo que ha pasado; permanece aparte.

Por el contrario, la teoría de la relatividad general de Einstein tuvo una evolución normal y lógica. En primer lugar, su autor, postula el principio de equivalencia. Luego reformuló principio físico en las matemáticas de una teoría de campos de la gravitación basada en los campos de Faraday y en el tensor métrico de Riemann. Más tarde llegaron las “soluciones clásicas”, tales el agujero negro y el Big Bang. Finalmente, la última etapa es el intento actual de formular una teoría cuántica de la gravedad. Por lo tanto, la relatividad general siguió una progresión lógica, un principio físico a una teoría cuántica.

Geometría → teoría de campos → teoría clásica → teoría cuántica.

Contrariamente, la teoría de supercuerdas ha evolucionando hacia atrás desde su descubrimiento accidental en 1.968. Esta es la razón de que nos parezca extraña y poco familiar, estamos aún buscando un principio físico subyacente, la contrapartida del principio de equivalencia de Einstein.

La teoría nació casi por casualidad en 1.968 cuando dos jóvenes físicos teóricos, Gabriel Veneziano y Mahiko Suzuki, estaban hojeando independientemente libros de matemáticas. Figúrense ustedes que estaban buscando funciones matemáticas que describieran las interacciones de partículas fuertemente interactivas. Mientras estudiaban en el CERN, el Centro Europeo de Física Teórica en Ginebra, Suiza, tropezaron independientemente con la función beta de Euler, una función matemática desarrollada en el S. XIX por el matemático Leonhard Euler. Se quedaron sorprendidos al que la función beta de Euler ajustaba casi todas las propiedades requeridas para describir interacciones fuertes de partículas elementales.

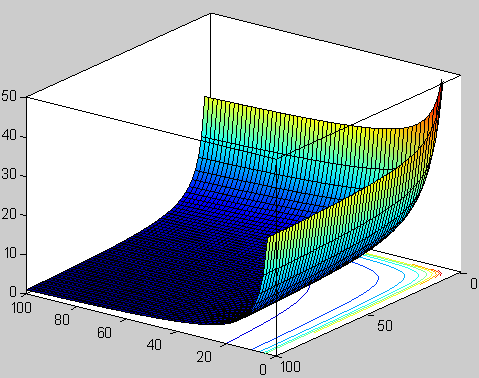

Función beta. Representación de la función valores reales positivos de x e y.

Según he leído, durante un almuerzo en el Lawrence Berkeley Laboratory en California, con una espectacular vista del Sol brillando sobre el puerto de San Francisco, Suzuki le explicó a Michio Kaku mientras almorzaban la excitación de descubrir, prácticamente por casualidad, un resultado parcialmente importante. No se suponía que la física se pudiera hacer de ese modo casual.

Tras el descubrimiento, Suzuki, muy excitado, mostró el hallazgo a un físico veterano del CERN. Tras oír a Suzuki, el físico veterano no se impresionó. De hecho le dijo a Suzuki que otro físico joven (Veneziano) había descubierto la misma función unas semanas antes. Disuadió a Suzuki de publicar su resultado. Hoy, esta función beta se conoce con el de modelo Veneziano, que ha inspirado miles de artículos de investigación iniciando una importante escuela de física y actualmente pretende unificar todas las leyes de la física.

Gabriele Veneziano es un físico italiano

En 1.970, el Modelo de Veneziano-Suzuki (que contenía un misterio), fue parcialmente explicado cuando Yoichiro Nambu, de la Universidad de Chicago, y Tetsuo Goto, de la Nihon University, descubrieron que una cuerda vibrante yace detrás de sus maravillosas propiedades. Así que, la teoría de cuerdas fue descubierta hacia atrás y por casualidad, los físicos aún no conocen el principio físico que subyace en la teoría de cuerdas vibrantes y sus maravillosas propiedades. El último paso en la evolución de la teoría de cuerdas (y el primer paso en la evolución de la relatividad general) aún está pendiente de que alguien sea capaz de darlo.

Así, Witten dice:

“Los seres humanos en el planeta tierra nunca dispusieron del marco conceptual que les llevara a concebir la teoría de supercuerdas de manera intencionada, surgió por razones del azar, por un feliz accidente. Por sus propios méritos, los físicos c del siglo XX no deberían haber tenido el privilegio de estudiar teoría muy avanzada a su tiempo y a su conocimiento. No tenían (ni tenemos ahora mismo) los conocimientos y los prerrequisitos necesarios para desarrollar dicha teoría, no tenemos los conceptos correctos y necesarios.”

Actualmente, como ha quedado dicho en este mismo , Edwar Witten es el físico teórico que, al frente de un equipo de físicos de Princeton, lleva la bandera de la teoría de supercuerdas con aportaciones muy importantes en el desarrollo de la misma. De todas las maneras, aunque los resultados y avances son prometedores, el camino por andar es largo y la teoría de supercuerdas en su conjunto es un edificio con muchas puertas cerradas de las que no tenemos las llaves acceder a su interior y mirar lo que allí nos aguarda.

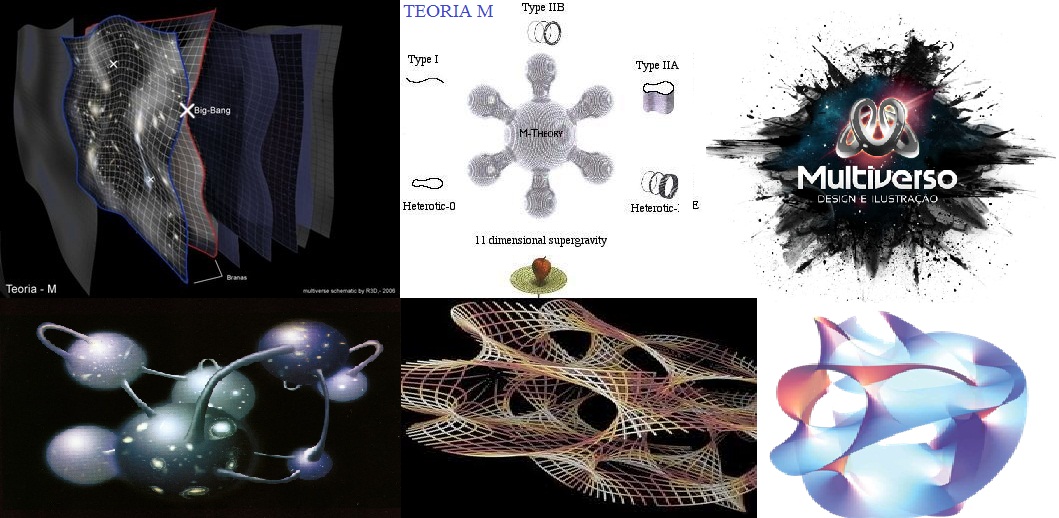

Ni con colección de llaves podremos abrir la puerta que nos lleve a la Teoría cuántica de la gravedad que, según dicen, subyace en la Teoría M, la más moderna versión de la cuerdas expuesta por E. Witten y que, según contaron los que estuvieron presentes en su presentación, Witten les introdujo en un “universo” fascinante de inmensa belleza que, sin embargo, no puede ser verificado por el experimento.

El problema está en que nadie es lo suficientemente inteligente para resolver la teoría de campos de cuerdas o cualquier otro enfoque no perturbativo de esta teoría. Se requieren técnicas que están actualmente más allá de nuestras capacidades. Para encontrar la solución deben ser empleadas técnicas no perturbativas, que son terriblemente difíciles. Puesto que el 99 por ciento de lo que conocemos sobre física de altas energías se basa en la teoría de perturbaciones, esto significa que estamos totalmente perdidos a la hora de encontrar la verdadera solución de la teoría.

¿Por qué diez dimensiones?

Uno de los secretos más profundos de la teoría de cuerdas, que aún no es comprendido, es por qué está definida sólo en diez, once y veintiséis dimensiones. Si calculamos cómo se rompen y se vuelven a juntar las cuerdas en el espacio N-dimensional, constantemente descubrimos que pululan términos absurdos que destruyen las maravillosas propiedades de la teoría. Afortunadamente, estos términos indeseados aparecen multiplicados por (N-10). Por consiguiente, para hacer que desaparezcan estas anomalías, no tenemos otra elección cuántica que fijar N = 10. La teoría de cuerdas, de hecho, es la única teoría cuántica conocida que exige completamente que la dimensión del espacio-tiempo esté fijada en un número único, el diez.

Por desgracia, los teóricos de cuerdas están, por el , completamente perdidos para explicar por qué se discriminan las diez dimensiones. La respuesta está en las profundidades de las matemáticas, en un área denominada funciones modulares.

Al manipular los diagramas de lazos1 de Kikkawa, Sakita y Virasoro creados por cuerdas en interacción, allí están esas extrañas funciones modulares en las que el 10 aparecen en los lugares más extraños. Estas funciones modulares son tan misteriosas como el hombre que las investigó, el místico del este. Quizá si entendiéramos mejor el trabajo de este genio indio, comprenderíamos por qué vivimos en nuestro universo actual.

nos asomamos a la Teoría de cuerdas, entramos en un “mundo” lleno de sombras en los que podemos ver brillar, a lo lejos, un resplandor cegador. Todos los físicos coinciden en el hecho de que es una teoría muy prometedora y de la que parece se podrán obtener buenos rendimientos en el futuro pero, de momento, es imposible verificarla.

El misterio de las funciones modulares podría ser explicado por quien ya no existe, Srinivasa Ramanujan, el hombre más extraño del mundo de los matemáticos. Igual que Riemann, murió de cumplir cuarenta años, y como Riemann antes que él, trabajó en total aislamiento en su universo particular de números y fue capaz de reinventar por sí mismo lo más valioso de cien años de matemáticas occidentales que, al estar aislado del mundo en las corrientes principales de los matemáticos, le eran totalmente desconocidos, así que los buscó sin conocerlos. Perdió muchos años de su vida en redescubrir matemáticas conocidas.

Dispersas oscuras ecuaciones en sus cuadernos están estas funciones modulares, que figuran entre las más extrañas jamás encontradas en matemáticas. Ellas reaparecen en las ramas más distantes e inconexas de las matemáticas. Una función que aparece una y otra vez en la teoría de las funciones modulares se denomina (como ya he dicho otras veces) hoy día “función de Ramanujan” en su honor. Esta extraña función contiene un término elevado a la potencia veinticuatro.

La magia esconde una realidad

El 24 aparece repetidamente en la obra de Ramanujan. Este es un ejemplo de lo que las matemáticas llaman números mágicos, que aparecen continuamente donde menos se esperan por razones que nadie entiende. Milagrosamente, la función de Ramanujan aparece también en la teoría de cuerdas. El número 24 que aparece en la función de Ramanujan es también el origen de las cancelaciones milagrosas que se dan en la teoría de cuerdas. En la teoría de cuerdas, cada uno de los veinticuatro modos de la función de Ramanujan corresponde a una vibración física de la cuerda. Cuando quiera que la cuerda ejecuta sus movimientos complejos en el espacio-tiempo dividiéndose y recombinándose, deben satisfacerse un gran número de identidades matemáticas altamente perfeccionadas. Estas son precisamente las entidades matemáticas descubiertas por Ramanujan. Puesto que los físicos añaden dos dimensiones más cuando cuentan el número total de vibraciones que aparecen en una teoría relativista, ello significa que el espacio-tiempo debe tener 24 + 2 = 26 dimensiones espacio-temporales.

Para comprender este misterioso factor de dos (que añaden los físicos), consideramos un rayo de luz que tiene dos modos físicos de vibración. La luz polarizada vibrar, por ejemplo, o bien horizontal o bien verticalmente. Sin embargo, un campo de Maxwell relativista Aµ cuatro componentes, donde µ = 1, 2, 3, 4. Se nos permite sustraer dos de estas cuatro componentes utilizando la simetría gauge de las ecuaciones de Maxwell. Puesto que 4 – 2 = 2, los cuatro campos de Maxwell originales se han reducido a dos. Análogamente, una cuerda relativista vibra en 26 dimensiones. Sin embargo, dos de estos modos vibracionales pueden ser eliminados rompemos la simetría de la cuerda, quedándonos con 24 modos vibracionales que son las que aparecen en la función de Ramanujan.

Cuando se generaliza la función de Ramanujan, el 24 queda reemplazado por el 8. Por lo tanto, el número crítico para la supercuerda es 8+2=10. Este es el origen de la décima dimensión que exige la teoría. La cuerda vibra en diez dimensiones porque requiere estas funciones de Ramanujan generalizadas para permanecer auto consistente. Dicho de otra manera, los físicos no tienen la menor idea de por qué 10 y 26 dimensiones se seleccionan como dimensión de la cuerda. Es como si hubiera algún tipo de numerología profunda que se manifestara en estas funciones que nadie comprende. Son precisamente estos números mágicos que aparecen en las funciones modulares elípticas los que determinan que la dimensión del espacio-tiempo sea diez.

En el análisis final, el origen de la teoría decadimensional es tan misterioso como el propio Ramanujan. Si alguien preguntara a cualquier físico del mundo por qué la naturaleza debería existir en diez dimensiones, estaría obligado a responder “no lo sé”. Se sabe en términos difusos, por qué debe seleccionarse alguna dimensión del espacio tiempo (de lo contrario la cuerda no puede vibrar de una cuánticamente autoconsistente), pero no sabemos por qué se seleccionan estos números concretos.

Godfrey Harold Hardy

G. H. Hardy, el mentor de Ramanujan, trató de estimar la capacidad matemática que poseía Ramanujan. Concedió a David Hilbert, universalmente conocido y reconocido uno de los mayores matemáticos occidentales del siglo XIX, una puntuación de 80. A Ramanujan le asignó una puntuación de 100. Así mismo, Hardy se concedió un 25.

Por desgracia, ni Hardy ni Ramanujan parecían interesados en la psicología a los procesos de pensamiento mediante los cuales Ramanujan descubría estos increíbles teoremas, especialmente cuando diluvio material brotaba de sus sueños con semejante frecuencia. Hardy señaló:

“Parecía ridículo importunarle sobre como había descubierto este o ese teorema conocido, cuando él me estaba mostrando media docena día, de nuevos teoremas”.

Ramanujan

Hardy recordaba vivamente:

-”Recuerdo una vez que fui a visitarle cuando estaba enfermo en Putney. Yo había tomado el taxi 1.729, y comenté que el numero me parecía bastante feo, y que esperaba que no fuese mal presagio.”

– No. -Replicó Ramanujan postrado en su cama-. Es un número muy interesante; es el número más pequeño expresable como una suma de dos cubos en dos formas diferentes.

(Es la suma de 1 x 1 x 1 y 12 x 12 x 12, y la suma de 9 x 9 x 9 y 10 x 10 x 10).

Era capaz de recitar en el acto teoremas complejos de aritmética cuya demostración requeriría un ordenador moderno.

En 1.919 volvió a casa, en la India, donde un año más tarde murió enfermo.

El legado de Ramanujan es su obra, que consta de 4.000 fórmulas en cuatrocientas páginas que llenan tres volúmenes de notas, todas densamente llenas de teoremas de increíble fuerza pero sin ningún comentario o, lo que es más frustrante, sin ninguna demostración. En 1.976, sin embargo, se hizo un nuevo descubrimiento. Ciento treinta páginas de borradores, que contenían los resultados del último año de su vida, fueron descubiertas por casualidad en una caja en el Trinity Collage. Esto se conoce ahora con el de “Cuaderno Perdido” de Ramanujan.

Comentando cuaderno perdido, el matemático Richard Askey dice:

“El de este año, mientras se estaba muriendo, era el equivalente a una vida entera de un matemático muy grande”. Lo que él consiguió era increíble. Los matemáticos Jonathan Borwien y Meter Borwein, en relación a la dificultad y la ardua tarea de descifrar los cuadernos perdidos, dijeron: “Que nosotros sepamos nunca se ha intentado una redacción matemática de este alcance o dificultad”.

Por mi creo que, Ramanujan, fue un genio matemático muy adelantado a su tiempo y que pasaran algunos años hasta que podamos descifrar al cien por ciento sus trabajos, especialmente, sus funciones modulares que guardan el secreto de la teoría más avanzada de la física moderna, la única capaz de unir la mecánica quántica y la Gravedad.

Fórmula de Ramanujan determinar los decimales de pi

Las matemáticas de Ramanujan son como una sinfonía, la progresión de sus ecuaciones era algo nunca vísto, él trabajaba otro nivel, los números se combinaban y fluían de su cabeza a velocidad de vértigo y con precisión nunca antes conseguida por nadie. Tenía tal intuición de las cosas que éstas simplemente fluían de su cerebro. Quizá no los veía de una manera que sea traducible y el único lenguaje eran los números.

saben los físicos, los “accidentes” no aparecen sin ninguna razón. Cuando están realizando un cálculo largo y difícil, y entonces resulta de repente que miles de términos indeseados suman milagrosamente cero, los físicos saben que esto no sucede sin una razón más profunda subyacente. Hoy, los físicos conocen que estos “accidentes” son una indicación de que hay una simetría en juego. Para las cuerdas, la simetría se denomina simetría conforme, la simetría de estirar y deformar la hoja del Universo de la cuerda.

Nuestro mundo asimétrico hermosas simetrias

Aquí es precisamente donde entra el trabajo de Ramanujan. Para proteger la simetría conforme original contra su destrucción por la teoría cuántica, deben ser milagrosamente satisfechas cierto número de identidades matemáticas que, son precisamente las identidades de la función modular de Ramanujan. ¡Increíble , cierto.

Aunque el perfeccionamiento matemático introducido por la teoría de cuerdas ha alcanzado alturas de vértigo y ha sorprendido a los matemáticos, los críticos de la teoría aún la señalan su punto más débil. Cualquier teoría, afirman, debe ser verificable. Puesto que ninguna teoría definida a la energía de Planck de 1019 miles de millones de eV es verificable, ¡La teoría de cuerdas no es realmente una teoría!

El principal problema, es teórico más que experimental. Si fuéramos suficientemente inteligentes, podríamos resolver exactamente la teoría y encontrar la verdadera solución no perturbativa de la teoría. Sin embargo, esto no nos excusa de encontrar algún medio por el que verificar experimentalmente la teoría, debemos esperar señales de la décima dimensión.

Volviendo a Ramanujan…

Es innegable lo sorprendente de su historia, un muchacho pobre con escasa preparación y arraigado pocos a sus creencias y tradiciones, es considerado como una de los mayores genios de las matemáticas del siglo XX. Su legado a la teoría de números, a la teoría de las funciones theta y a las series hipergeométricas, además de ser invaluable aún sigue estudiándose por muchos prominentes matemáticos de todo el mundo. Una de sus fórmulas más famosas es

Utilizada para realizar aproximaciones del número Pi con más de dos millones de cifras decimales. Otra de las sorprendentes fórmulas descubiertas por Ramanujan es un igualdad en que era “casi” un entero (la diferencia era de milmillonésimas). De hecho, durante un tiempo se llegó a sospechar que el número era efectivamente entero. No lo es, pero este hallazgo sirvió de base para la teoría de los “Cuasi enteros”. A veces nos tenemos que sorprender al comprobar hasta donde puede llegar la mente humana que, prácticamente de “la nada”, es capaz de sondear los misterios de la Naturaleza para dejarlos al descubierto ante nuestros asombros ojos que, se abren como platos ante tales maravillas.

Publica: emilio silvera

Dic

6

¡Una Singularidad! Extraño Objeto

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

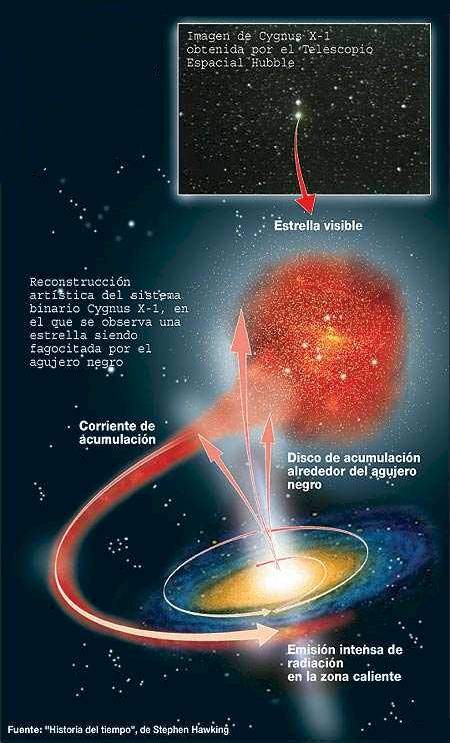

El concepto mismo de “singularidad” desagradaba a la mayoría de los físicos, pues la idea de una densidad infinita se alejaba de toda comprensión. La naturaleza humana está mejor condicionada a percibir situaciones que se caracterizan por su finitud, cosas que podemos medir y pesar, y que están alojadas dentro de unos límites concretos; serán más grande o más pequeñas pero, todo tiene un comienzo y un final pero… infinito, es difícil de digerir. Además, en la singularidad, según resulta de las ecuaciones, ni existe el tiempo ni existe el espacio. Parece que se tratara de otro universo dentro de nuestro universo toda la región afectada por la singularidad que, eso sí, afecta de manera real al entorno donde está situada y además, no es pacífica, ya que se nutre de cuerpos estelares circundantes que atrae y engulle.

La complejidad que supone la idea de una singularidad, como he dicho en otras ocasiones, deben ser dejadas a la Metafísica, la rama de la Física que estudia la naturaleza de las cosas complejas como el Ser. la Existencia, el Ente, la causalidad, el Tiempo…

La noción de singularidad empezó a adquirir un mayor crédito cuando Robert Oppenheimer, junto a Hartlan S. Snyder, en el año 1.939 escribieron un artículo anexo de otro anterior de Oppenheimer sobre las estrellas de neutrones. En este último artículo, describió de manera magistral la conclusión de que una estrella con masa suficiente podía colapsarse bajo la acción de su propia gravedad hasta alcanzar un punto adimensional; con la demostración de las ecuaciones descritas en dicho artículo, la demostración quedó servida de forma irrefutable que una estrella lo suficientemente grande, llegado su final al consumir todo su combustible de fusión nuclear, continuaría comprimiéndose bajo su propia gravedad, más allá de los estados de enana blanca o de estrella de neutrones, para convertirse en una singularidad.

Los cálculos realizados por Oppenheimer y Snyder para la cantidad de masa que debía tener una estrella para terminar sus días como una singularidad estaban en los límites másicos de M =~ masa solar, estimación que fue corregida posteriormente por otros físicos teóricos que llegaron a la conclusión de que sólo sería posible que una estrella se transformara en singularidad, la que al abandonar su fase de gigante roja retiene una masa residual como menos de 2 – 3 masas solares.

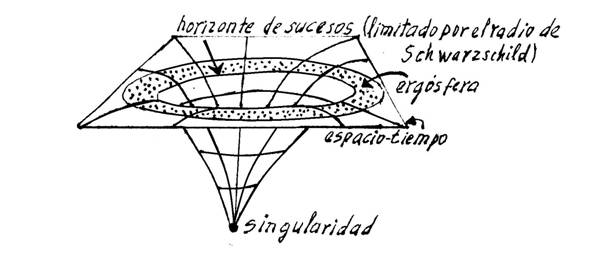

La figura de la izquierda representa a la nube de polvo en colapso de Oppenhieimer y Snyder, que ilustra una superficie atrapada.

El modelo de Oppenhieimer y Snyder posee una superficie atrapada, que corresponde a una superficie cuya área se iOppenheimer y Snyder desarrollaron el primer ejemplo explícito de una solución a las ecuaciones de Einstein que describía de manera cierta a un agujero negro, al desarrollar el planteamiento de una nube de polvo colapsante. En su interior, existe una singularidad, pero no es visible desde el exterior, puesto que está rodeada de un horizonte de suceso que no deja que nadie se asome, la vea, y vuelva para contarlo. Lo que traspasa los límites del horizonte de sucesos, ha tomado el camino sin retorno. Su destino irreversible, la singularidad de la que pasará a formar parte.

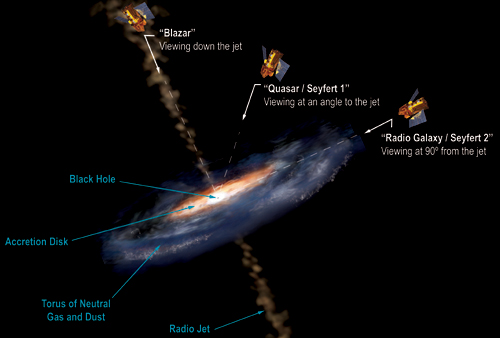

Desde entonces, muchos han sido los físicos que se han especializado profundizando en las matemáticas relativas a los agujeros negros. John Wheeler (que los bautizó como agujeros negros), Roger Penrose, Stephen Hawking, Kip S. Thorne, Kerr y muchos otros nombres que ahora no recuerdo, han contribuido de manera muy notable al conocimiento de los agujeros negros, las cuestiones que de ellas se derivan y otras consecuencias de densidad, energía, gravedad, ondas gravitacionales, etc, que son deducidas a partir de estos fenómenos del cosmos.

Se afirma que las singularidades se encuentran rodeadas por un horizonte de sucesos, pero para un observador, en esencia, no puede ver nunca la singularidad desde el exterior. Específicamente implica que hay alguna región incapaz de enviar señales al infinito exterior. La limitación de esta región es el horizonte de sucesos, tras ella se encuentra atrapado el pasado y el infinito nulo futuro. Lo anterior nos hace distinguir que en esta frontera se deberían reunir las características siguientes:

- Debe ser una superficie nula donde es pareja, generada por geodésicas nulas;

- contiene una geodésica nula de futuro sin fin, que se origina a partir de cada punto en el que no es pareja, y que

- el área de secciones transversales espaciales jamás pueden disminuir a lo largo del tiempo.

Pueden existir agujeros negros supermasivos (de 105 masas solares) en los centros de las galaxias activas. En el otro extremo, mini agujeros negros con un radio de 10-10 m y masas similares a las de un asteroide pudieron haberse formado en las condiciones extremas que se dieron poco después delBig Bang. Diminutos agujeros negros podrían ser capaces de capturar partículas a su alrededor, formando el equivalente gravitatorio de los átomos.

Todo esto ha sido demostrado matemáticamente por Israel, 1.967; Carter, 1.971; Robinson, 1.975; y Hawking, 1.978 con límite futuro asintótico de tal espaciotiempo como el espaciotiempo de Kerr, lo que resulta notable, pues la métrica de Kerr es una hermosa y exacta formulación para las ecuaciones de vacío de Einstein y, como un tema que se relaciona con la entropía en los agujeros negros.

No resulta arriesgado afirmar que existen variables en las formas de las singularidades que, según las formuladas por Oppenheimer y su colaborador Snyder, después las de Kerr y más tarde otros, todas podrían existir como un mismo objeto que se presenta en distintas formas o maneras.

Ahora bien, para que un ente, un objeto o un observador pueda introducirse dentro de una singularidad como un agujero negro, en cualquiera que fuese su forma, tendría que traspasar el radio de Schwarzschild (las fronteras matemáticas del horizonte de sucesos), cuya velocidad de escape es igual a la de la luz, aunque esta tampoco puede salir de allí una vez atrapada dentro de los límites fronterizos determinados por el radio. Este radio de Schwarzschild puede ser calculado usándose la ecuación para la velocidad de escape:

Para el caso de fotones u objeto sin masa, tales como neutrinos, se sustituye la velocidad de escape por la de la luz c2. “En el modelo de Schrödinger se abandona la concepción de los electrones como esferas diminutas con carga que giran en torno al núcleo, … Es cierto que en mecánica cuántica quedan muchos enigmas por resolver. Pero hablando de objetos de grandes masas, veámos lo que tenemos que hacer para escapar de ellos.

Podemos escapar de la fuerza de gravedad de un planeta pero, de un A.N., será imposible.

La velocidad de escape está referida a la velocidad mínima requerida para escapar de un campo gravitacional. El objeto que escapa puede ser cualquier cosa, desde una molécula de gas a una nave espacial. Como antes he reflejado está dada por , donde G es la constante gravitacional, M es la masa del cuerpo y R es la distancia del objeto que escapa del centro del cuerpo del que pretende escapar (del núcleo). Un objeto que se mueva a velocidad menor a la de escape entra en una órbita elíptica; si se mueve a una velocidad exactamente igual a la de escape, sigue una órbita parabólica, y si el objeto supera la velocidad de escape, se mueve en una trayectoria hiperbólica.

Así hemos comprendido que, a mayor masa del cuerpo del que se pretende escapar, mayor será la velocidad que necesitamos para escapar de él. Veamos algunas:

|

Objeto |

Velocidad de escape |

| La Tierra |

………….11,18 Km/s |

| El Sol |

………….617,3 Km/s |

| Júpiter |

………….59,6 Km/s |

| Saturno |

………….35,6 Km/s |

| Venus |

………….10,36 Km/s |

| Agujero negro |

…….+ de 299.000 Km/s |

Como se ve en el cuadro anterior, cada objeto celeste, en función de su masa, tiene su propia velocidad de escape para que cualquier cosa pueda salir de su órbita y escapar de él.

La excepción está en el último ejemplo, la velocidad de escape necesaria para vencer la fuerza de atracción de un agujero negro que, siendo preciso superar la velocidad de la luz 299.792’458 Km/s, es algo que no está permitido, ya que todos sabemos que conforme determina la teoría de la relatividad especial de Einstein, la velocidad de la luz es la velocidad límite en nuestro universo; nada puede ir más rápido que la velocidad de la luz, entre otras razones porque el objeto sufriría la transformación de Lorentz y su masa sería infinita.

Podría continuar explicando otros aspectos que rodean a los agujeros negros, pero estimo que el objetivo que perseguía de hacer conocer lo que es un agujero negro y el origen del mismo, está sobradamente cumplido.

Existen aspectos del A.N. que influyen en el mundo cuántico, y, por ejemplo, el máximo radio que puede tener un agujero negro virtual está dado aproximadamente por

![]()

que equivale a unos 10-³³ centímetros. Esta distancia se conoce como longitud de Planck y es la única unidad de distancia que se puede construir con las tres constantes fundamentales de la naturaleza: G, h y c. La longitud de Planck es tan extremadamente pequeña (10²° veces menor que el radio de un electrón) que debe ser la distancia característica de otro nivel de la naturaleza, subyacente al mundo subatómico, donde rigen las leyes aún desconocidas de la gravedad cuántica.

Así como el océano presenta un aspecto liso e inmóvil cuando se observa desde una gran distancia, pero posee fuertes turbulencias y tormentas a escala humana, el espacio-tiempo parece “liso” y estático a gran escala, pero es extremadamente turbulento en el nivel de la longitud de Planck, donde los hoyos negros se forman y evaporan continuamente. En el mundo de Planck, las leyes de la física deben ser muy distintas de las que conocemos hasta ahora.

La estructura macroscópica del espacio-tiempo parece plana, pero éste debe ser extremadamente turbulento en el nivel de la escala de Planck. Escala en la que parece que entramos en otro mundo… ¡El de la mecánica cuántica! que se aleja de ese mundo cotidinao que conocemos en el que lo macroscópico predomina por todas partes y lo infinitesimal no se deja ver con el ojo desnudo.

La estructura macroscópica del espacio-tiempo parece plana, pero éste debe ser extremadamente turbulento en el nivel de la escala de Planck. Escala en la que parece que entramos en otro mundo… ¡El de la mecánica cuántica! que se aleja de ese mundo cotidinao que conocemos en el que lo macroscópico predomina por todas partes y lo infinitesimal no se deja ver con el ojo desnudo.

¡Existen tantos secretos!

emilio silvera

Nov

30

¡La máquina de Higgs-Kibble! El Vacío superconductor

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

“El Premio de la Sociedad de Física Americana (APS) para contribuciones a la Física de Partículas Teórica (J. J. Sakurai Prize for Theoretical Particle Physics) de 2010 le fue concedido a Carl R. Hagen (University of Rochester), Francois Englert (Universite Libre de Bruxelles), Gerald S. Guralnik (Brown University), Peter W. Higgs (University of Edinburgh), Robert Brout (Universite Libre de Bruxelles), y T.W.B. Kibble (Imperial College) por sus contribuciones al mecanismo de Higgs–Brout–Englert–Guralnik–Hagen–Kibble para explicar la ruptura espontánea de la simetría electrodébil, mecanismo normalmente abreviado a mecanismo de Higgs.”

(Brout fallecido en 2.011, también era acreedor al Nobel de Física de 2.013)

Como complemento del trabajo que se presenta hoy referido a la concesión del Nobel de Física de 2.013, aquí he recuperado éste trabajo que viene a explicar un poco, lo que antes de todo este jaleo del Higgs, habián hecho los físicos que ahora son premiados. Perdonad que lo expuesto sea algo complejo de comprender para algunos pero, hay veces que no se pueden evitar los guarismos, ecuaciones y signos que, en Física, es el lenguaje que suple a las palabras.

Investigación experimental

Higgs” />

Higgs” />

En aquella fecha, el bosón de Higgs no ha sido observado experimentalmente, a pesar de los esfuerzos de los grandes laboratorios de investigación como el CERN o el Fermilab. La no observación de pruebas claras permite estimar un valor mínimo experimental de masa 114.4 GeV para el bosón de Higgs del modelo estándar, con un nivel de confianza del 95%.[6] Experimentalmente se ha registrado un pequeño número de eventos no concluyentes en el colisionador LEP en el CERN. Éstos han podido ser interpretados como resultados de los bosones de Higgs, pero la evidencia no es concluyente.[7] Se espera que el Gran Colisionador de Hadrones, ya construido en el CERN, pueda confirmar o desmentir la existencia de este bosón. El anillo de 27 km de circunferencia (llamado Large Hadron Collider) fue encendido el 10 de septiembre de 2008, como estaba previsto, pero un fallo en el sistema de enfriamiento que debe mantener los imanes a una temperatura aproximada de -271,3 °C detuvo el experimento, hasta el 20 de noviembre del 2009, fecha en que volvió a ser encendido, desde 450 GeV a 2.23 TeV. Pero fue apagado para realizar ajustes, y el 30 de marzo volvió a ser encendido, aunque a potencia de 7 TeV. Eso si, no será hasta 2016 cuando funcione a pleno rendimiento.

La búsqueda del bosón de Higgs es también el objetivo de ciertos experimentos del Tevatrón en el Fermilab

Los cuatro experimentos implicados en el resultado: CDF y DZero (Tevatron

Alternativas al mecanismo de Higgs para la ruptura espontánea de simetría electrodébil

Desde los años en los que fue propuesto el bosón de Higgs, han existido muchos mecanismos alternativos. Todas las otras alternativas usan una dinámica que interactúa fuertemente para producir un valor esperado del vacío que rompa la simetría electrodébil. Una lista parcial de esos mecanismos alternativos es:

Technicolor es la clase de modelo que intenta imitar la dinámica de la fuerza fuerte como camino para romper la simetría electrodébil.

El modelo de Abbott-Farhi de composición de los bosones de vectores W y Z.

Campo de Higgs

El Campo de Higgs es un campo cuántico, que, de acuerdo con una hipótesis del modelo estándar de física de partículas expuesta por el físico Peter Higgs, permearía el universo entero, y cuyo efecto sería que las partículas se comportaran como dotadas de masa, debido a la interacción asociada de partículas elementales, con el bosón de Higgs, cuya existencia aún no ha sido probada directamente y que por la interacción consigo mismo también “adquiriría” masa. Se espera que el Gran Colisionador de Hadrones sirva para probar las hipótesis de Higgs.

Mecanismo de Higgs

Dobletes de Higgs. Potencial de doble pozo en una teoría de campos con ruptura espontánea de simetría.

El mecanismo de Higgs, ideado por Peter Higgs entre otros, es uno de los mecanismos posibles para producir la ruptura espontánea de simetría electrodébil en una Teoría Gauge invariante. Permitió establecer, la unificación entre la teoría electromagnética y la teoría nuclear débil, que se denominó Teoría del campo unificado dando premio Nobel en año 1979 a Steven Weinberg, Sheldon Lee Glashow y Abdus Salam

Este mecanismo también es conocido como mecanismo de Brout–Englert–Higgs, mecanismo de Higgs–Brout–Englert–Guralnik–Hagen–Kibble, o mecanismo de Anderson–Higgs. En 1964, fue inicialmente propuesto por Robert Brout y François Englert, e independientemente por Peter Higgs y por Gerald Guralnik, C. R. Hagen, y Tom Kibble.Fue inspirado en la Teoría BCS de rompimiento de simetría en superconductividad basado en Teoría Ginzburg-Landau, los trabajos de la estructura del vacío de Yoichiro Nambu, y las ideas de Philip Anderson según las cuales la superconductividad podía ser relevante en la relatividad, el electromagnetismo y otros fenomenos clásicos. El nombre de mecanismo de Higgs fue dado por Gerardus ‘t Hooft en 1971. Los tres artículos originales de Guralnik, Hagen, Kibble, Higgs, Brout, y Englert en donde se propone este mecanismo fueron reconocidos como fundamentales en la celebración del aniversario 50 de la revista Physical Review Letters

Campos y partículas

La segunda mitad del siglo XX fue un tiempo de descubrimiento de nuevas partículas elementales, nuevas fuerzas y, sobre todo, nuevos campos. El espacio puede llenarse con una amplia variedad de influencias invisibles que tienen todo tipo de efectos sobre la materia ordinaria. De todos los nuevos campos que se descubrieron, el que tiene más que enseñarnos sobre el paisaje es el campo de Higgs. Existe una relación general entre partículas y campos. Por cada tipo de partícula de la naturaleza hay un campo y por cada tipo de campo hay una partícula. Así campos y partículas llevan el mismo nombre. El campo electromagnético podría denominarse campo de fotones. El electrón tiene un campo, también lo tienen el qua.rk, el gluón y cada miembro del reparto de personajes del modelo Standard, incluida la partícula de Higgs.

El campo de Higgs

En la concepción del Modelo estándar de física de partículas, el boson de Higgs así como otros bosones (encontrados ya experimentalmente) y ligados en esta teoría, se interpretan desde el Bosón de Goldstone donde cada parte del rompimiento de simetría genera un campo, para el cual los elementos que viven en este campo son sus respectivos bosones. Existen teorías creadas a partir del miedo de la no existencia del boson de Higgs donde no es necesaria su aparición. El campo de Higgs es el ente matemático donde existe, su interpretación con la teoría es el producto de él con los otros campos que sale por el mecanismo de ruptura, este producto nos da el acople y la interacción de él, con esta interacción con los otros campos legamos la caracteristica de generador de masa.

Me resistía pero…Formulación matemática

Introducimos un campo adicional ? que rompa la simetría SU(2)L × U(1)Y ? U(1)em. Debido a las condiciones que se exigen a la teoría será un doblete (de SU(2)L) de campos escalares complejos (doblete de Higgs):

![]()

Dobletes de Higgs

El número total de entradas (número dimensional del vector) de Higgs no está determinado por la teoría y podría ser cualquiera. No obstante la versión mínima del SM posee uno solo de estos dobletes.

El sistema vendrá entonces descrito por un Lagrangiano de la forma:

![]()

tal que:

![]()

donde V(phi) es el potencial renormalizable (y por tanto que mantiene la invarianza gauge) más sencillo. Para que se produzca ruptura espontánea de simetría es necesario que el valor esperado del campo de Higgs en el vacío sea no nulo. Para lambda mayor que 0, si mu 2 menor que 0, el potencial posee infinitas soluciones no nulas (ver figura 1), en las cuales sólo la norma del campo de Higgs está definida:

![]()

Estado fundamental

El estado fundamental está, por consiguiente, degenerado y no respeta la simetría del grupo SU(2)L × U(1)Y. Sin embargo, sí conserva la simetría del grupo U(1)em. El valor de cup ? indica la escala de energía a la que se produce la ruptura de la simetría electrodébil. La ruptura SU(2)L × U(1)Y Phi U(1)em se produce cuando se selecciona un estado del vacío concreto. La elección habitual es aquella que hace que Phi 3 sea no nulo:

![]()

Espectro de partículas

Enormes energías para poder profundizar tanto en el conocimiento de lo muy pequeño

El espectro de partículas físicas resultantes se construye realizando pequeñas oscilaciones en torno al vacío, que pueden ser parametrizadas en la forma:

![]()

donde el vector  y el escalar h(x) son campos pequeños correspondientes a los cuatro grados de libertad reales del campo . Los tres campos

y el escalar h(x) son campos pequeños correspondientes a los cuatro grados de libertad reales del campo . Los tres campos  son los bosones de Goldstone, de masa nula, que aparecen cuando una simetría continua es rota por el estado fundamental (teorema de Goldstone).

son los bosones de Goldstone, de masa nula, que aparecen cuando una simetría continua es rota por el estado fundamental (teorema de Goldstone).

En este punto aún tenemos 4 bosones gauge (Wi?(x) y B?(x)) y 4 escalares ( y h(x)), todos ellos sin masa, lo que equivale a 12 grados de libertad (Conviene notar que un bosón vectorial de masa nula posee dos grados de libertad, mientras que un bosón vectorial masivo adquiere un nuevo grado de libertad debido a la posibilidad de tener polarización longitudinal: 12 = 4[bosones vectoriales sin masa] × 2 + 4[escalares sin masa]). P. W. Higgs fue el primero en darse cuenta de que el teorema de Goldstone no es aplicable a teorías gauge, o al menos puede ser soslayado mediante una conveniente selección de la representación. Así, basta con escoger una transformación:

y h(x)), todos ellos sin masa, lo que equivale a 12 grados de libertad (Conviene notar que un bosón vectorial de masa nula posee dos grados de libertad, mientras que un bosón vectorial masivo adquiere un nuevo grado de libertad debido a la posibilidad de tener polarización longitudinal: 12 = 4[bosones vectoriales sin masa] × 2 + 4[escalares sin masa]). P. W. Higgs fue el primero en darse cuenta de que el teorema de Goldstone no es aplicable a teorías gauge, o al menos puede ser soslayado mediante una conveniente selección de la representación. Así, basta con escoger una transformación:

![]()

de forma que:

con lo cual desaparecen los tres campos de Higgs no físicos  . Debemos aplicar estas transformaciones sobre la suma de las Lagrangianas para bosones y fermiones:

. Debemos aplicar estas transformaciones sobre la suma de las Lagrangianas para bosones y fermiones:

![]()

Al final del proceso, tres de los cuatro bosones gauge adquieren masa al absorber cada uno de los tres grados de libertad eliminados del campo de Higgs, gracias a los acoplamientos entre los bosones gauge y el campo Phi presentes en la componente cinética de la Lagrangiana SBS:

![]()

Por otro lado, el vacío de la teoría debe ser eléctricamente neutro, razón por la que no existe ningún acoplamiento entre el fotón y el campo de Higgs, h(x), de forma que aquél mantiene una masa nula. Al final, obtenemos tres bosones gauge masivos (W±?, Zµ), un bosón gauge sin masa (A?) y un escalar con masa (h), por lo que seguimos teniendo 12 grados de libertad (del mismo modo que antes: 12 = 3[bosones vectoriales masivos] × 3 + 1[bosón vectorial sin masa] × 2 + 1[escalar]). Los estados físicos de los bosones gauge se expresan entonces en función de los estados originales y del ángulo de mezcla electrodébil ?W:

Ángulo de mezcla

El ángulo de mezcla ?W, se define en función de las constantes de acoplamiento débil, g, y electromagnética, g´, según:

![]()

Las predicciones de las masas de los bosones a nivel de árbol son:

donde (e es la carga eléctrica del electrón):

![]()

Masa del bosón de Higgs

No creo que Homer Simpson predijera la masa del Higgs

La masa del bosón de Higgs se expresa en función de ? y del valor de la escala de ruptura de simetría, ?, como:

![]()

La medida de la anchura parcial de la desintegración:

![]()

a bajas energías en el SM permite calcular la constante de Fermi, GF, con gran precisión. Y puesto que:

![]()

se obtiene un valor de ? = 246 GeV. No obstante el valor de ? es desconocido y por tanto la masa del bosón de Higgs en el SM es un parámetro libre de la teoría.

Bosones gauge y fermiones

Análogamente al caso de los bosones gauge, los fermiones adquieren masa mediante los denominados acoplamientos de Yukawa, que se introducen a través de una serie de nuevos términos en la Lagrangiana:

![]()

donde:

Del mismo modo que antes, se aplica la transformación sobre la parte levógira de los fermiones, mientras que la parte dextrógira no se transforma:

![]()

![]()

Y finalmente se obtienen las masas de los fermiones según:

Es conveniente hacer notar en este punto, que la determinación de la masa del bosón de Higgs, no explica directamente las masas fermiónicas ya que dependen de las nuevas constantes ?e, ?u, ?d, … Por otro lado, se deduce también el valor de los acoplamientos del bosón de Higgs con los distintos fermiones y bosones, los cuales son proporcionales a las constantes de acoplamiento gauge y a la masa de cada partícula.

Ya tendremos más sobre el tema

Nov

24

Anti-partículas, fuerzas…

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (1)

Comments (1)

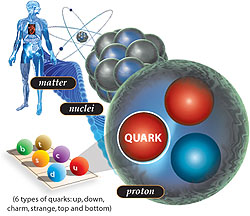

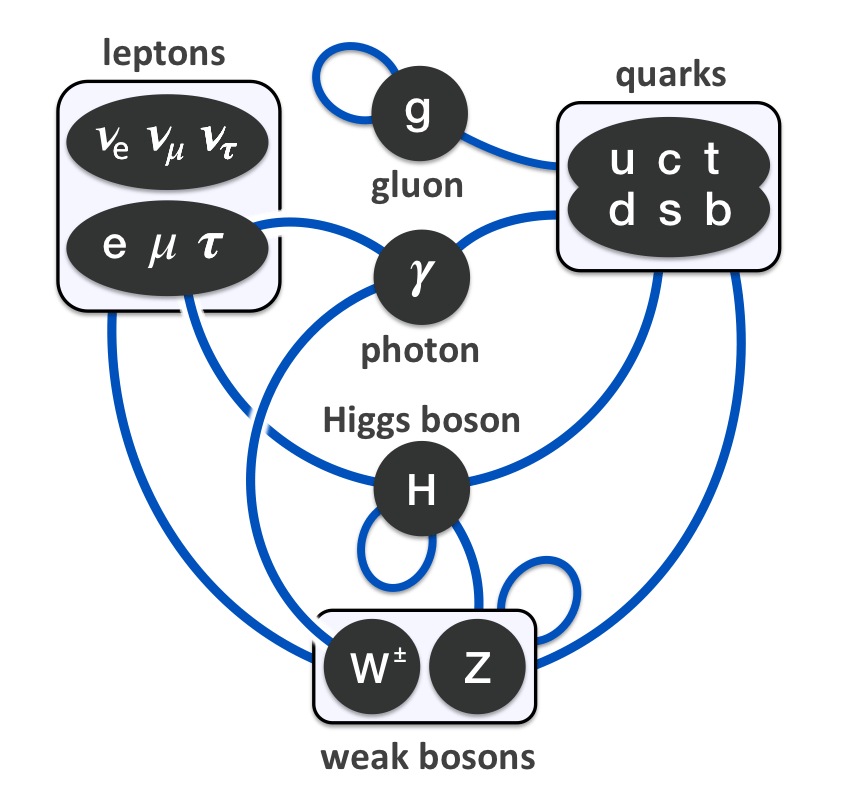

Bajo la “definición basada en quarks y leptones”, las partículas elementales y compuestas formados de quarks (en púrpura) y leptones (en verde) serían la “materia”; mientras los bosones “izquierda” (en rojo) no serían materia. Sin embargo, la energía de interacción inherente a partículas compuestas (por ejemplo, gluones, que implica a los neutrones y los protones) contribuye a la masa de la materia ordinaria.

Ya hemos descrito en trabajos anteriores las dos familias de partículas elementales: Quarks y Leptones. Pero hasta ahí, no se limita la sociedad del universo infinitesimal. Existen además las anti-familias. A quarks y electrones se asocian, por ejemplo, anti-quarks y anti-electrones. A cada partícula, una anti-partícula.

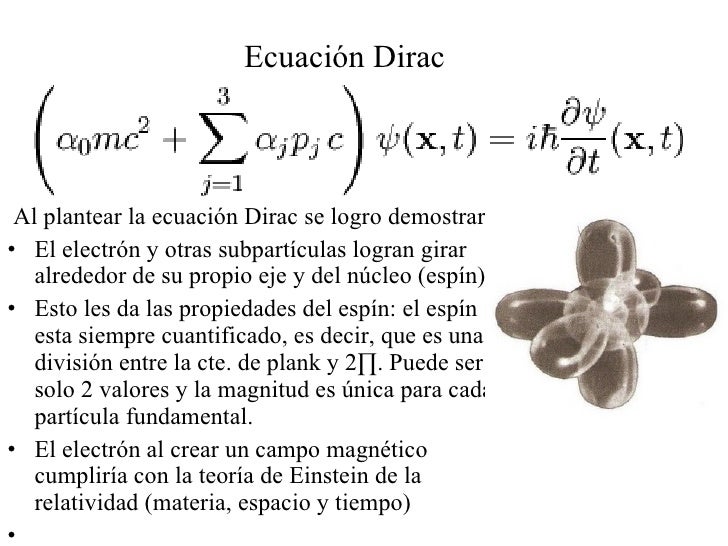

Uno de los primeros éxitos de la teoría relativista del campo cuántico fue la predicción de las antipartículas: nuevos cuantos que eran la imagen especular de las partículas ordinarias. Las antipartículas tienen la misma masa y el mismo spin que sus compañeras las partículas ordinarias, pero cargas inversas. La antipartícula del electrón es el positrón, y tiene, por tanto, carga eléctrica opuesta a la del electrón. Si electrones y positrones se colocan juntos, se aniquilan, liberando la energía inmensa de su masa según la equivalencia masa-energía einstiana.

¿Cómo predijeron los físicos la existencia de anti-partículas? Bueno, por la «interpretación estadística» implicaba que la intensidad de un campo determinaba la probabilidad de hallar sus partículas correspondientes. Así pues, podemos imaginar un campo en un punto del espacio describiendo la creación o aniquilación de sus partículas cuánticas con una probabilidad concreta.

Si esta descripción matemática de la creación y aniquilación de partículas cuánticas se inserta en el marco de la teoría relativista del campo cuántico, no podemos contar con la posibilidad de crear una partícula cuántica sin tener también la de crear un nuevo género de partícula: su antipartícula. La existencia de antimateria es imprescindible para una descripción matemáticamente coherente del proceso de creación y aniquilación según la teoría de la relatividad y la teoría cuántica.

Las cargas gravitacionales en el vacío cuántico podrían proporcionar una alternativa a la materia oscura. La idea se basa en la hipótesis de que las partículas y antipartículas tienen cargas gravitacionales de signo opuesto. Como consecuencia, los pares de partícula-antipartícula virtuales en el vacío cuántico y sus dipolos de forma gravitacional (una carga gravitacional positivos y negativos) pueden interactuar con la materia bariónica para producir fenómenos que se suele atribuir a la materia oscura.

Las ondas gravitacionales han sido detectadas pero… ¡Los dipolos gravitacionales!

Aunque el físico del CERN, Dragan Slavkov Hajdukovic, quien propuso la idea, demostró matemáticamente que estos dipolos gravitacionales podrían explicar las curvas de rotación de las galaxias observadas sin la materia oscura en su estudio inicial, señaló que quedaba mucho por hacer.

Pero sigamos con la cuántica…

El pionero en comprender que era necesario que existiesen anti-partículas fue el físico teórico Paul Dirac, que hizo varías aportaciones importantes a la nueva teoría cuántica. Fue él quien formuló la ecuación relativista que lleva hoy su nombre, y a la que obedece el campo electrónico; constituye un descubrimiento comparable al de las ecuaciones del campo electromagnético de Maxwell. Cuando resolvió su ecuación, Dirac se encontró con que además de describir el electrón tenía soluciones adicionales que describían otra partícula con una carga eléctrica opuesta a la del electrón. ¿Qué significaría aquello? En la época en que Dirac hizo esta observación, no se conocían más partículas con esta propiedad que el protón. Dirac, que no deseaba que las partículas conocidas proliferasen, decidió que las soluciones adicionales de su ecuación describían el protón. Pero, tras un análisis más meticuloso, se hizo evidente que las partículas que describían las soluciones adicionales tenían que tener exactamente la misma masa que el electrón. Quedaba así descartado el protón, cuya masa es por lo menos, 1.800 veces mayor que la del electrón. Por tanto, las soluciones adicionales tenían que corresponder a una partícula completamente nueva de la misma masa que el electrón, pero de carga opuesta: ¡El antielectrón! Esto quedó confirmado a nivel experimental en 1932 cuando Carl Anderson, físico del Instituto de Tecnología de Calífornia, detectó realmente el antielectrón, que hoy se llama positrón.

El trabajo de Dirac sobre el electrón nada tiene que envidiarle al de Einstein de la Relatividads

La aparición de las anti-partículas cambió definitivamente el modo de pensar de los físicos respecto a la materia. Hasta entonces, se consideraba la materia permanente e inmutable. Podían alterarse las moléculas, podían desintegrarse los átomos en procesos radiactivos, pero los cuántos fundamentales se consideraban invariables. Sin embargo, tras el descubrimiento de la anti-materia realizado por Paul Dirac hubo que abandonar tal criterio. Heisenberg lo expresaba así:

“Creo que el hecho de que Dirac haya descubierto partículas y anti-partículas, ha cambiado toda nuestra visión de la física atómica… creo que, hasta entonces, todos los físicos habían concebido las partículas elementales siguiendo los criterios de la filosofía de Demócrito, es decir, considerando esas partículas elementales como unidades inalterables que se hallan en la naturaleza como algo dado y son siempre lo mismo, jamás cambian, jamás pueden transmutarse en otra cosa. No son sistemas dinámicos, simplemente existen en sí mismas. Tras el descubrimiento de Dirac, todo parecía distinto, porque uno podía preguntar: ¿por qué un protón no podría ser a veces un protón más un par electrón-positrón, etc.?… En consecuencia, el problema de la división de la materia había adquirido una dimensión distinta.”

Dado que la antimateria tiene la misma masa que la materia, es decir son de la misma magnitud y signo (la definición de masa es positiva siempre), el efecto gravitacional de la antimateria no debe ser distinto de la materia, es decir, siempre sera un efecto atractivo. Pero, ¿acaso no importa la equivalencia establecida de antipartícula viajando al futuro = partícula viajando al pasado?

La respuesta es sí. Dicha equivalencia proviene de algo llamado simetría CPT (Charge-Parity-Time), y nos dice que la equivalencia entre las partículas y anti-partículas no solo corresponde a realizar una transformación sobre la carga, sino también sobre la paridad y el tiempo. La carga no afecta la gravedad, pero la paridad y el tiempo si la afectan. En otras palabras, al modificarse el tiempo (poner el tiempo al reves) y el espacio (la paridad es “girar” el espacio), estamos alterando el espacio-tiempo, y como la teoría general de la relatividad lo afirma, es la geometría de este el que determina la gravedad.

El carácter mutable de la materia se convirtió en piedra angular de la nueva física de partículas. El hecho de que partículas y anti-partículas puedan crearse juntas a partir del vacío si se aporta energía suficiente, no sólo es importante para entender cómo se crean las partículas en aceleradores de alta energía, sino también para entender los procesos cuánticos que se produjeron en el Big Bang.

Como ya lo hemos expresado, el conocimiento que se obtuvo sobre la existencia de anti-familias de partículas o familias de anti-partículas es una consecuencia de la aplicación de la teoría relativista del campo cuántico, para cada partícula existe una partícula que tiene la misma masa pero cuya carga eléctrica (y otras llamadas cargas internas) son de signo opuesto. Estas son las anti-partículas. Así, al conocido electrón, con carga negativa, le corresponde un «electrón positivo» como anti-partícula, llamado positrón, descubierto en 1932. El an-tiprotón, descubierto en 1956, tiene la misma masa que el protón, pero carga eléctrica negativa de igual valor. El fotón, que no tiene masa ni carga eléctrica, puede ser considerada su propia anti-partícula.

Un agujero negro es un objeto que tiene tres propiedades: masa, espin y carga eléctrica. La forma del material en un agujero negro no se conoce, en parte porque está oculta para el universo externo, y en parte porque, en teoría, el material continuaría colapsando hasta tener radio cero, punto conocido como Singularidad, de densidad infinita.

Un agujero negro tiene tres propiedades: masa, espín y carga eléctrica. La forma del material de un agujero negro no se conoce, en parte porque está oculta para el universo externo, y en parte porque, en teoría, el material continuaría colapsando hasta tener radio cero, punto conocido como singularidad, de densidad infinita.

Cada partícula está caracterizada por un cierto número de parámetros que tienen valores bien definidos: su masa, carga eléctrica, spin o rotación interna y otros números, conocidos como cuánticos. Estos parámetros son tales que, en una reacción, su suma se mantiene y sirve para predecir el resultado. Se dice que hay conservación de los números cuánticos de las partículas. Así, son importantes el número bariónico, los diversos números leptónicos y ciertos números definidos para los quarks, como la extrañeza, color, etc. Estos últimos y sus antipartículas tienen cargas eléctricas (± 1/3 o ± 2/3) y números bariónicos (±1/3) fraccionarios. No todos los números asociados a cada partícula han sido medidos con suficiente precisión y no todas las partículas han sido detectadas en forma aislada, por lo menos de su ligamento, como el caso de los quarks y de los gluones.

Los gluones son una especie de «partículas mensajeras» que mantienen unidos a los quarks. Su nombre proviene del término inglés “glue”, que significa pegamento, en español quizás podría ser gomón. Ahora, en cuanto a los quarks, ya hicimos referencia de ellos anteriormente. Pero recordemos aquí, que fueron descubiertos en 1964 por Murray Gell-Mann, como los componentes más reducidos de la materia. Hasta entonces se pensaba que los átomos consistían simplemente en electrones rodeando un núcleo formado por protones y electrones.

En estado natural, quarks y gluones no tienen libertad. Pero si se eleva la temperatura a niveles 100.000 veces superiores, como se ha hecho en aceleradores de partículas, a la del centro del Sol, se produce el fenómeno del desconfinamiento y por un brevísimo tiempo quedan libres. En ese preciso momento aparece lo que se suele llamar plasma, «una sopa de quarks y gluones» que equivale al estado en que se podría haber encontrado la naturaleza apenas una milésima de segundo luego del Big Bang.

Recientemente se ha descubierto un nuevo estado de la materia, esta vez a niveles muy muy altos de energía, que los científicos han denominado Plasma Gluón-Quark. La transición ocurre a temperaturas alrededor de cien mil millones de grados y consiste en que se rompen las fuertes ligaduras que mantienen unidos los quarks dentro de los núcleos atómicos. Los protones y neutrones están formados, cada uno, por 3 quarks que se mantienen unidos gracias a los gluones (El gluón es la partícula portadora de interacción nuclear fuerte, fuerza que mantiene unida los núcleos atómicos). A temperaturas superiores se vence la fuerza nuclear fuerte y los protones y neutrones se dividen, formando esta sopa denominada plasma Gluón-Quark.

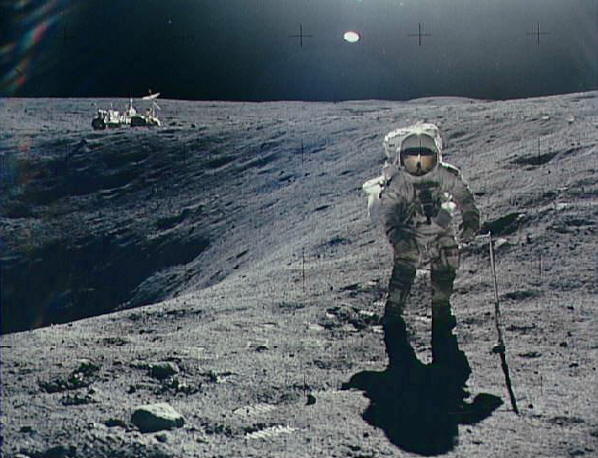

Pero por ahora aquí, nos vamos a quedar con los quarks al natural. Normalmente, los quarks no se encuentra en un estado separados, sino que en grupos de dos o tres. Asimismo, la duración de las vidas medias de las partículas, antes de decaer en otras, es muy variable (ver tablas).

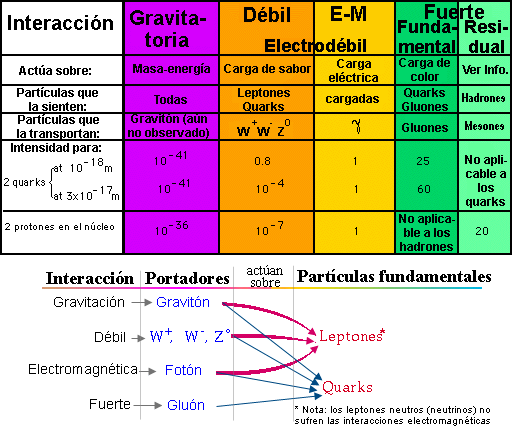

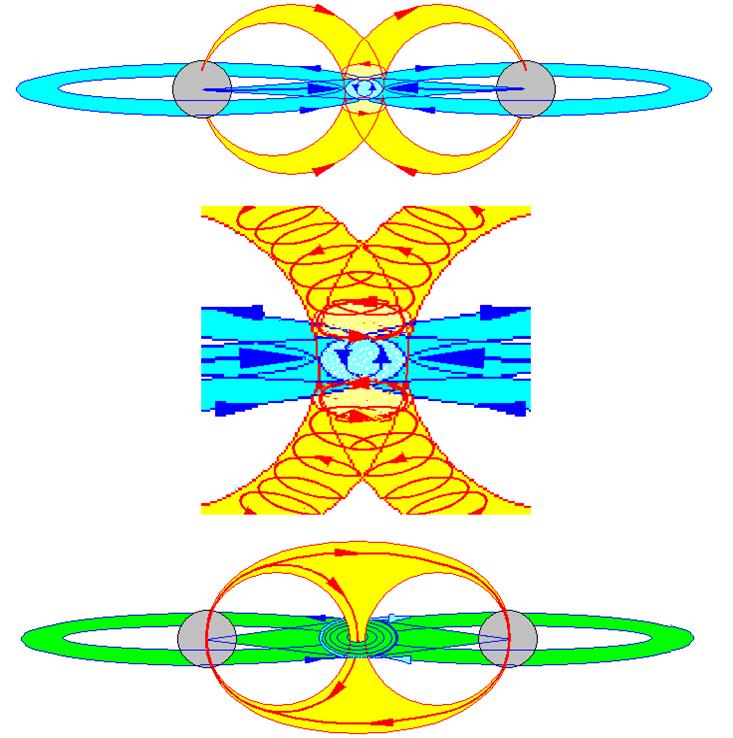

Por otra parte, las partículas presentan una o más de las siguientes interacciones o fuerzas fundamentales entre ellas. Por un lado se tiene la gravitación y el electromagnetismo, conocidas de la vida cotidiana. Hay otras dos fuerzas, menos familiares, que son de tipo nuclear y se conocen como interacciones fuertes y débiles.

La gravitación afecta a todas las partículas, es una interacción universal. Todo cuerpo que tiene masa o energía está sometido a esta fuerza. Aunque es la más débil de las interacciones, como las masas son siempre positivas y su alcance es infinito, su efecto es acumulativo. Por ello, la gravitación es la fuerza más importante en cosmología.

Fluido ferroso que se agrupa cerca de los polos de un imán

La fuerza electromagnética se manifiesta entre partículas con cargas eléctricas. A diferencia de las demás, puede ser de atracción (entre cargas de signos opuestos) o de repulsión (cargas iguales). Esta fuerza es responsable de la cohesión del átomo y las moléculas. Mantiene los objetos cotidianos como entidades con forma propia. Un vaso, una piedra, un auto, el cuerpo humano. Es mucho más fuerte que la gravitación y aunque es de alcance infinito, las cargas de distinto signo se compensan y sus efectos no operan a grandes distancias. Dependiendo de las circunstancias en que actúen, estas interacciones pueden manifestarse como fuerzas eléctricas o magnéticas solamente, o como una mezcla de ambos tipos.

La Fuerza Nuclear Débil: otra fuerza nuclear, considerada mucho más débil que la Fuerza Nuclear Fuerte. El fenómeno de decaimiento aleatorio de la población de las partículas subatómicas (la radioactividad) era difícil de explicar hasta que el concepto de esta fuerza nuclear adicional fue introducido.

La interacción nuclear débil es causa de la radioactividad natural y la desintegración del neutrón. Tiene un rol capital en las reacciones de fusión del hidrógeno y otros elementos en el centro de las estrellas y del Sol. La intensidad es débil comparada con las fuerzas eléctricas y las interacciones fuertes. Su alcance es muy pequeño, sólo del orden de 10-15 cm.

La interacción fuerte es responsable de la cohesión de los núcleos atómicos. Tiene la intensidad más elevada de todas ellas, pero es también de corto alcance: del orden de 10-13 cm.

Es posible caracterizar las intensidades de las interacciones por un número de acoplamiento a, sin dimensión, lo que permite compararlas directamente:

Fuerte as = 15

Electromagnéticas a = 7,3 x 10-3

Débil aw 3,1 x 10-12

Gravitacional aG = 5,9 x 10-39

Por otro lado, la mecánica cuántica considera que la interacción de dos partículas se realiza por el intercambio de otras llamadas «virtuales». Tienen ese nombre porque no son observables: existen por un tiempo brevísimo, tanto más corto cuanto mayor sea su masa, siempre que no se viole el principio de incertidumbre de Heisenberg de la teoría cuántica (que en este contexto dice que el producto de la incertidumbre de la energía por el tiempo de vida debe ser igual o mayor que una constante muy pequeña). Desaparecen antes de que haya tiempo para que su interacción con otras partículas delate su existencia.

El fotón virtual común se desplaza hacia la partícula menos energética.