Abr

6

Extraña partícula de antimateria matusalénica

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Descubren una extraña partícula de antimateria de tiempos del Big Bang

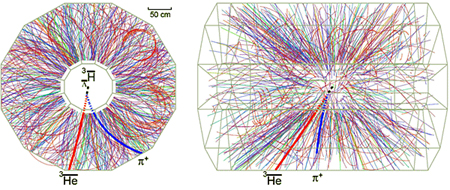

La colisión de dos átomos de oro emite cientos de partículas / RHIC

Crean en laboratorio las condiciones posteriores al Big Bang

¿Es ésta la primera partícula de materia oscura?

¿Se ha encontrado, por fin, una partícula de materia oscura?

Confirmado: Einstein tenía razón

Fuente: ABC.es | MADRID

Actualizado Lunes , 08-03-10 a las 10 : 34

Un equipo internacional de científicos que estudia colisiones de alta energía de iones de oro en el Relativistic Heavy Ion Collider (RHIC) -un acelerador situado en Nueva York y parecido a la «máquina de Dios» de Ginebra (Suiza), pero mucho más pequeño-, ha conseguido encontrar algo excepcional: la forma más extraña de antimateria nunca vista hasta ahora, una antiparticula que podría haber existido en los primeros momentos del Big Bang, la gran explosión que dio origen al Universo. Estos investigadores son los mismos que hace tan sólo unos días anunciaron al mundo que habían sido capaces de recrear en laboratorio las condiciones posteriores a la gran explosión en una especie de «sopa» de materia 250.000 veces más caliente que el centro de nuestro Sol.

Para conseguir este logro, los investigadores del colisionador, un túnel de poco más de 3 kilómetros ubicado en el Laboratorio Nacional Brookhaven (BNL), provocaron el choque de iones de oro en la circunferencia. De esta forma detectaron una partícula (más bien antipartícula) de antimateria muy antigua, que pudo estar en los primeros instantes del nacimiento del Universo, y algo que no se había visto jamás. Se trata del antihipertritón, el núcleo del antihipertritio, que contiene un antiprotón, un antineutrón y una antipartícula lambda.

Como en el Big BangResulta muy complejo para los profanos, pero se trata de un «descubrimiento experimental que puede tener consecuencias sin precedentes para nuestra visión del mundo», ha asegurado el físico teórico Horst Stoecker, vicepresidente de la Asociación Helmholtz de laboratorios nacionales de Alemania. «Esta antimateria abre la puerta a nuevas dimensiones en el campo nuclear, una idea que hace sólo unos pocos años habría sido vista como imposible». El descubrimiento podría ayudar a esclarecer la composición de las estrellas de neutrones y a un conocimiento más profundo del Universo.

Las colisiones en el RHIC producen fugazmente las condiciones que existían pocos microsegundos después del Big Bang hace 13,7 mil millones de años. Hace tan sólo unos días, estos los físicos de Brookhaven anunciaban que habían conseguido crear una especie de «sopa» de materia 250.000 veces más caliente que el centro de nuestro Sol y que reúne condiciones similares a las que se produjeron justo después del nacimiento del Universo. Es materia más caliente nunca creada en laboratorio, tanto que puede «derretir los protones y los neutrones».

Sin embargo, «entender exactamente cómo y por qué ha un predominio de la materia sobre la antimateria sigue siendo un problema no resuelto de la física», indica el físico Zhanbu Xu, uno de los autores principales del estudio. Ahora, los investigadores del RHIC intentarán progresar en sus investigaciones y esperan recoger nuevos datos en los próximos diez años.

¿Qué cosas veremos a primeros del siglo que viene?

emilio silvera

Abr

2

Sí ¡Tenemos que Saber! Para avanzar

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

David Hilbert

El nombre de David Hilbert (1862–1942) ocupa un lugar muy especial en el imaginario colectivo de los matemáticos . Sin duda se trata del matemático más famoso del siglo XX, a lo que contribuyeron de manera muy especial su aportación a la configuración de los métodos axiomáticos actuales, sus profundos resultados en álgerbra, teoría de números, geometría y teoría de funciones [análisis complejo], los celebérrimos “problemas matemáticos” que dejó planteados en 1900, y las venturas y desventuras de sus intentos de resolver la cuestión de los fundamentos de la matemática.

Esas letras que se ven gravadas abajo, en la piedra, lo que dicen es su célebre: ” “wir müssen wissen, wir werden wissen” [debemos saber; llegaremos a saber].

Pero yo quería hablar de los físicos y del hecho cierto de que son conscientes de que, en el panorama de su disciplina, en el lejano horizonte, vislumbran oscuros nubarrones que empañan el paisaje, oscurecen el futuro y pertuban sus pensamientos al ver con diáfana claridad las dificultades que tendrán que solventar si quieren continuar en el camino del progreso desvelando los secretos de la naturaleza.

Ellos, los físicos, son muy conscientes de que toda la física moderna está apoyada sobre la base de dos imponentes columnas: La Relatividad General de Einstein, que proporciona un marco teórico para la comprensión del universo en la escala más alta: estrellas, galaxias, cúmulos de galaxias y más allá, hasta los confines del universo observable en su contínua expansión. La otra columna es la Mecánica Cuántica, que les ofrece el marco teórico para la comprensión del Universo en sus mínimas escalas: Átomos y moléculas comenzando por las partículas que todo lo conforman como los Quarks y los electrones.

El estudio de fenómenos a escala microscópica mediante las hipótesis de la cuantización de la energía y la dualidad onda-partícula fue desarrolado bajo el nombre de Mecánica cuántica por Erwin Schrödinger, Werner Heisenberg, Paul Dirac y el mismo Einstein entre otros muchos, a partir de la idea seminal de Max Planck con su cuanto de acción, h, allá por los alrededores de 1925-1926, Aunque el trabajo de Einstein, inspirado en el de Planck, sobre el Efecto fotoeléctrico fue antes (creo).

A partir de 1930 la mecánica cuántica se aplicó con mucho éxito a problemas relacionados con núcleos atómicos, moléculas y materia en estado sólido. La mecánica cuántica hizo posible comprender un extenso conjunto de datos, de otra manera enigmáticos. Sus predicciones han sido de una exactitud notable. Ejemplo de ésto último es la increíble precisión de diesciciete cifras significativas del momento magnético del electrón calculadas por la EDC (Electrodinámica Cuántica) comparadas con el experimento.

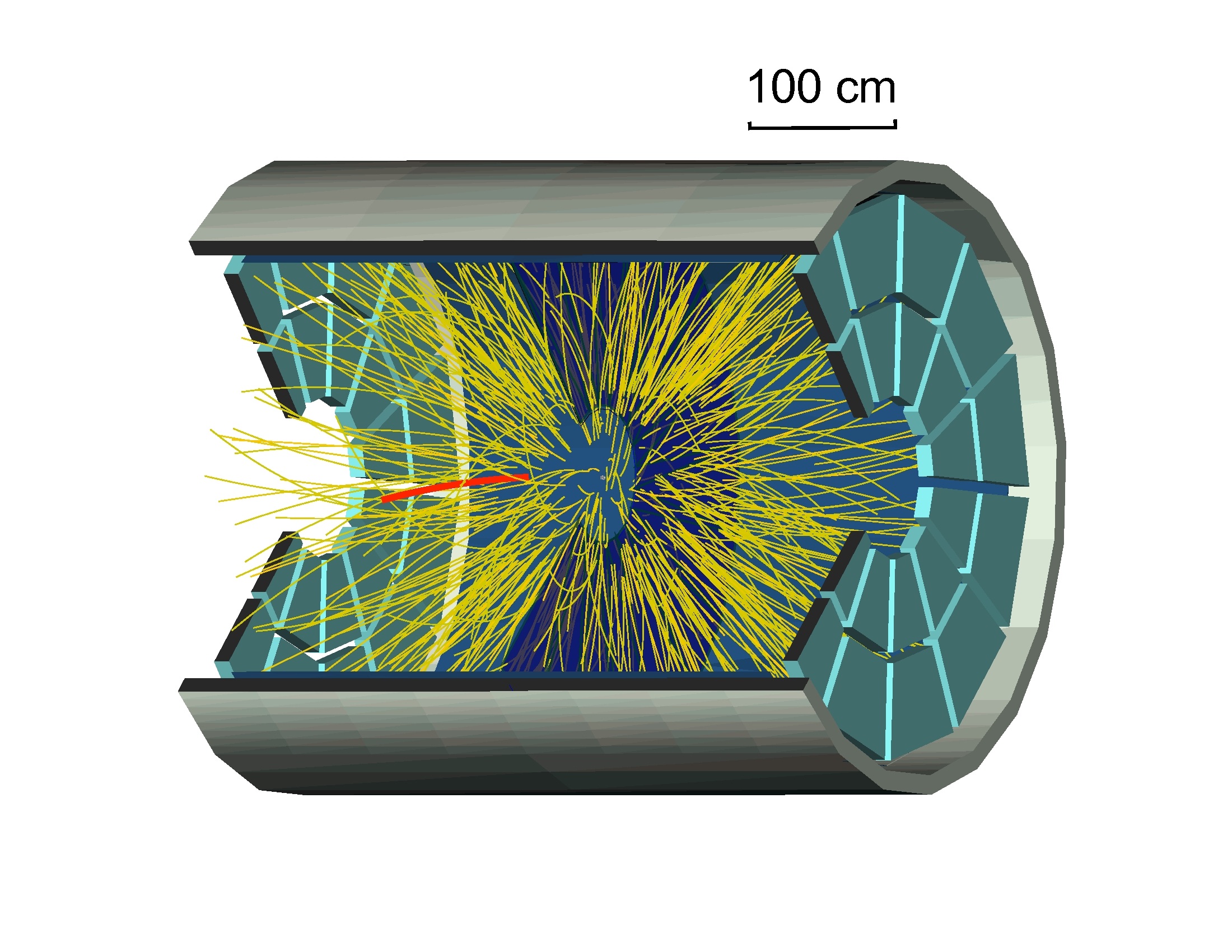

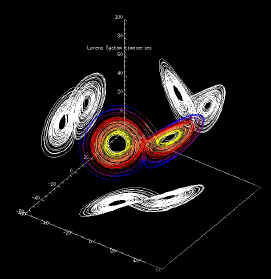

Imagen ilustrativa de la dualidad onda-partícula, en el que se aprecia cómo un mismo fenómeno puede ser percibido de dos modos distintos. La mecánica cuántica describe, en su visión más ortodoxa, cómo en cualquier sistema físico –y por tanto, en todo el universo- existe una diversa multiplicidad de estados, los cuales habiendo sido descritos mediante ecuaciones matemáticas por los físicos, son denominadoss estados cuánticos. De esta forma la mecánica cuántica puede explicar la existencia del átomo y desvelar los misterios de la estructura atómica, tal como hoy son entendidos; fenómenos que no puede explicar debidamente la física o más propiamente la mecánica clásica.

Pocas dudas nos pueden caber sobre el hecho cierto de que, la Mecánica cuántica ha sido uno de los más grandes avances de la Humanidad y, gracias a ella, hemos podido tener acceso a grandes logros e inventos que hoy hacen más cómoda nuestras vidas y también, en el campo de las nuevas tenologías este apartado de la física, ha tenido mucho que decir: Explica el comportamiento de lamateria y de la energía. Su aplicación ha hecho posible el descubrimiento y desarrollo de muchas tenologías, como por ejemplo, los transistores, componentes profusamente utilizados en casi todos los aparatos que tengan alguna parte funcional electrónica y muchos más cuya lista pormenorizada no cabría aquí en un simple comentario.

A lo largo de años de investigación, los físicos han confirmado experimentalmente, con una exactitud casi inimaginable, la práctica totalidad de las predicciones que hace cada una de estas dos teorías (la Relatividad General y la Mecánica Cuántica). Sin embargo, estos mismos instrumentos teóricos conducen a otra conclusión inquietante: tal como se formulan actualmente, la rrlatividad general y la mecánica cuántica no pueden ambas ser ciertas a la vez. Las dos teorías en las que se bazan los enormes avances realizados por la física durante los últimos cien años -unos avances que han explicado la expansión de los cielos y las estructuras fundamentales de la materia- son mutuamente incompatibles.

Las ideas de Einstein siempre estuvieron unidas al Universo

Creo que todos hemos podido hablar, en alguna ocasión, de la incompatibilidad de estas dos teorías que, siendo ciertas por separado hasta límites insospechados, cuando se juntan, aquello resulta un auténtico desastre. ¿Por qué será? Bueno, la respuesta podría estar en el hecho cierto de que, los físicos, estudian cosas muy pequeñas y ligeras (como los átomos y sus partes constituyentes), o cosas que son enormes y muy pesadas (como los mundos, las estrellas y las galaxias), pero no estudian ambas al mismo tiempo. Y, siendo así (que lo es), no necesitan utilizar las dos teorías al mismo tiempo, sino que, dependiendo del estudio a realizar de lo muy pequeño (la mecánica cuántica) y de lo muy grande (la relatividad general) y, de esta manera, ahogan el grito que mientras operan, les lanza la otra teoría, la que no están utilizando. Así, durante las últimas décadas, este planteamiento no ha sido tan feliz como la ignorancia, pero ha estado muy cerca de serlo. Lo único que ha enturbiado la paz, ha sido el hecho cierto de que, los físicos, han sido muy conscientes de que se necesita encontrar esa teoría de la Gravedad-Cuántica que, al parecer, sólo en el ámbito de la Teoría de Supercuerdas pueden encontrar.

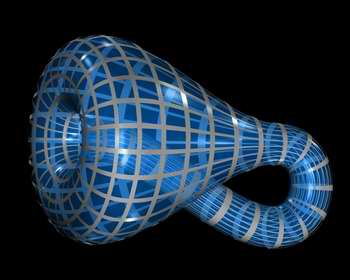

Cuerda cerrada en forma de botella de Klein

Algunos veces hemos podido llegar apensar que, el Universo, puede encontrar en casos extremos: Unas veces en las profundidades nucleares de un agujero negro donde se aplasta una inmensa cantidad de masa que se reduce hasta un minúsculo tamaño. Estos dos conceptos del tamaño diminuto y de la inmensa masa, nos requieren para poder explicarlos, a los dos teorías: La Mecánica cuántica y la Relatividad General y, sin embargo, cuando hemos tratado de unir las fórmulas de ambas teorías, los “tornillos” de sus estructuras saltan y aquello parece explotar, la incompatibilidad es manifiesta.

La Teoría de supercuerdas, una advenidiza que se mueve en las arenas movedizas de no poder ser verificada, en comparación con los dos venerables edificios de la M.C. y la R.G., que por el contrario no tienen nada que demostrar más allá de lo ya demostrado, y, sin embargo, la llegada de esta incipiente teoría (aunque lleve muchos años en el candelero), nos viene a decir lo que, las otras dos no han podido: Que en ella (en la Teoría de Cuerdas), no sólo se puede explicar la materia en su nivel más básico sino que, además, se resuelve la tensión existente entre las dos teorías incompatibles hasta el momento y, además, hace posible que la unión de ambas avance dando un paso de gigante. De hecho, la teoría de las supercuerdas muestra aún más: dentro de este nuevo marco, la relatividad general y la mecánica cuántica, se necesitan la una a la otra para que esta teoría tenga sentido y pueda explicar el universo en su conjunto. Según la teoría de supercuerdas, , el matrimonio entre las leyes de lo muy grande y lo muy pequeño no sólo es feliz, sino inevitable.

Por otra parte, la teoría bosónica no habla tampoco de los fermiones sino sólo a bosones como los fotones. Pero sabemos que los bosones son un caso particular de comportamiento, y que muchas otras partículas observan conductas muy distintas. ¿Qué haremos si no podemos explicar a los fermiones como los quarks, componentes fundamentales de la materia y la energía? Algunas nuevas teorías como la supersimetría intentan describir tanto a bosones como fermiones, y todas ellas juntas han llevado a los nuevos modelos que tenemos actualmente.

Una cinta de Moebius, posible en esta teoría

En nuestra mirada del siglo XXI, si las cuerdas determinan una realidad plana, es posible imaginar a las partículas y sus interacciones como “ondas” o “montículos” e incluso “ondas concéntricas” sobre ese plano. Las cuerdas pueden dividirse (como un hilo en forma de Y) o reunirse, entrecruzarse y fundirse, y todas estas conductas repercutirán en la topología del plano que determinan. Varias cuerdas de tipo cerrado pueden juntarse y converger en un solo tubo único, emitir ramales laterales e incluso cerrarse sobre sí mismas para configurar un mundo con la forma del cuerpo geométrico conocido como toro. O una cinta de Moebius. O una botella de Klein. O lo que se nos ocurra o nos guste imaginar. En este caso, podríamos imaginar a las partículas como ondulaciones que se desplazaran por los tubos. La adición de una partícula se vería como cuerdas que convergen, y la emisión como ramales divergentes.

Cuerdas toroidales

La gravedad, por su parte (protagonista fundamental de las interacciones del universo) puede representarse fácilmente como tres tubos unidos en forma de H. El Sol atrae a la Tierra: los tubos verticales son las partículas del Sol y de nuestro planeta, y el trazo horizontal es el gravitón del Sol que viaja desde él hacia nosotros. Las formas determinadas por las cuerdas tienen una cantidad de dimensiones que varían de acuerdo con la teoría que se considere. Si la supersimetría es correcta, el universo tiene 10 u 11 dimensiones. Si la teoría bosónica es la que tiene razón, la realidad consta de nada menos que 26 dimensiones. El problema, como es fácil comprender, es que todo ello entra en conflicto directo con nuestro universo espaciotemporal de 4 dimensiones, que cualquiera puede observar, medir y confirmar.

Algunos científicos postulan hoy que la teoría de las cuerdas no merece ni siquiera que se le aplique el método científico, porque no es capaz de describir el universo ni siquiera a un grado básico. Otros creen que algún día demostraremos que existen gigantescas cuerdas uniendo inclusive las galaxias a nivel universal. Esta cuerdas irradiarían grandes ondas gravitatorias en todas direcciones y podrían explicar algunos fenómenos de gran escala que hoy en día no podemos explicar. La realidad es que hay que darle tiempo. No hemos tenido, hasta hoy, ocasión de chequear todas la complejas implicaciones de la teoría (LAS teorías) de cuerdan en cuanto a explicaciones completas, coherentes e inatacables de la realidad que observamos. Tal vez algún día, en un futuro no tan lejano, podamos probarlas o descartarlas definitivamente.

- Materia.

- Estructura molecular.

- Átomos.

- Electrones.

- Quarks.

- Cuerdas.

Claro que, aparte de que no tenemos la energía de Planck para poder llegar hasta ellas (1019 GeV), además, nos topamos con el hecho cierto de que nos encontramos anclados a las viejas teorías (R.G. y M.C.) y, si queremos avanzar, las características encontradas en las teorías de cuerdas, nos ecigen que cambiémos drácticamente nuestra manera de entender el espacio, el tiempo y la materia, y, esa ttarea amigos míos, no será nada fácil. No estamos (yo diría que estamos lejos) en ese nivel en el que mnos resultaría cómodo manejar esas nuevas teorías.

¿Pero las cuerdas? Las cuerdas no parecen ser una estructura preferida por la naturaleza en el diseño de los cielos. No vemos cuerdas en el espacio exterior. De hecho no las vemos por ninguna parte. ¡A que va a resultar que, la verdadera semilla de la materia y el componente esencial del Universo, va a resultar ser, finalmente, algo tan pequeño que reside fuera de nuestro alcance?

Un momento de reflexión, sin embargo, revelará que la naturaleza ha reservado un papel especial a las cuerdas, como un ladrillo básico para otras formas. Por ejemplo, la característica esencial de la vida en el planeta Tierra es la molécula de ADN similar a una cuerda, que contiene la información compleja y el código de la propia vida. Para construir la materia de la vida, tanto como la materia subatómica, las cuerdas parecen ser la respuesta perfecta. En ambos casos, queremos encerrar una gran cantidad de información en una estructura reproducible y relativamente simple. La característica distintiva de una cuerda es que es una de la forma más compacta de almacenar grandes cantidades de datos de un modo en que la información pueda ser replicada.

Para los seres vivos la naturaleza utiliza la doble cadena de la molécula de ADN, que se separa y forma copias duplicadas de cada una de ellas. Nuestros cuerpos también contienen millones de millones de cadenas de proteínas, formadas de ladrillos de aminoácidos. Nuestro cuerpo, en cierto sentido, puede ser considerado como una enorme colección de cuerdas: moléculas de proteínas que revisten nuestros huesos. Sin embargo, nadie puede dar una explicación de nuestro entendimiento, de la inteligencia que se crea y que llevamos con nosotros desde el mismo momento del nacimiento, está ahí presente, a la espera de que se la despierte, es la inteligencia dormida y evolucionada por el conocimiento de las cosas. La conciencia de SER a la que llamamos alma, y que de alguna manera es inmortal, ya que lo que sabemos lo cedemos y lo dejamos aquí para los que nos siguen en la tarea emprendida por la humanidad desde que, en el preciso momento en que surgió aquella primera célula original que fue capaz de dividirse para replicarse a sí misma, se dio el primer paso para el nacimiento de la vida en nuestro planeta. Pero esa es otra cuestión que será tratada en otro próximo trabajo, ahora volvamos al tema de la teoría de cuerdas de la física.

Se habla de cuerdas abiertas, cerradas o de lazos, de p branas donde p denota su dimensionalidad (así, 1 brana podría ser una cuerda y 2.Brana una membrana) o D-Branas (si son cuerdas abiertas) Y, se habla de objetos mayores y diversos que van incorporados en esa teoría de cuerdas de diversas familias o modelos que quieren sondear en las profundidades del Universo físico para saber, como es.

Claro que, a todo esto, no debemos perder de vista ni olvidar que, la teoría de cuerdas emerge como un producto impresionante, pero natural, a partir de los descubrimientos revolucionarios que ha realizado la física durante los últimos cien años. De hecho, veremos que el conflicto existente entre la reltiviad general y la mecánica cuántica no es precisamente el primero, sino el tercero de una serie de conflictos decisivos con los que se tuvieron que enfrentar los científicos durante el siglo pasado, y que han resuelto como consecuencia de una revisión radical de nuestro modo de comprender en universo.

Uno de aquellos conflictos eran las desconcertante propiedades del movimiento de la Luz. Dicho resumidamente, según las leyes del movimiento de Isaac Newton, si alguien corre a una velocidad suficientemente rápida podría emparejarse con un rayo de luz que se esté emitiendo, mientras que, según las leyes del electromagnetismo de james Clerl Maxwell, esto es imposible. Einstein resolvió el conflicto mediante su teoría de la relatividad especial y así dio un vuelco completo a nuestro modo de entender el espacio y el tiempo que ya no podían entenderse como conceptos universales grabados en piedra y percibidos por todos los individuos de forma idéntica.

El desarrollo de la relatividad especial creó inmediatamente el escenario para el segundo conflicto. Una de las conclusiones del trabajo de Eisntein es que ningún objeto -de hecho, ninguna influencia o perturbación de ninguna clase- puede viajar a una velocidad mayor que la de la luz. Sin embargo, como hemos podido leer muchas veces, la teoría universal de la gravedad de Newton, que experimentalmente funciona tan bien y es tan grata para la intuición, habla de influencias que se transmiten en el espacio a grandes distancias instantáneamente. De nuevo fue Eisntein el que intervino en el conflicto y lo resolvió ofreciendo un nuevo concepto de la Gravedad en su teoría general de la relatividad.

No es sólo que el Espacio y el Tiempo estén influidos por el esatado del movimiento del observador, sino que, además, pueden alabearse y curvarse en respuesta a la presencia de materia o energía. Tales distorsiones en la estructura del Espacio y el Tiempo, transmiten la fuerza de Gravedad de un lugar a otro que, más cercano o más lejano, recibe la influencia de esta fuerza fundamental. Así que, desde entonces, no se puede ya pensar que el Espacio y el Tiempo sean un telón de fondo inamovible e inerte en el que se desarrollan los sucesos del universo; al contrario, según la relatividad especial y la relatividad general, son actores de primera fila que desempeñan un papel óntimamente ligado al desarrollo de todos los hechos que en el universo ocurren.

Una vez más el modelo se repite: el descubrimiento de la relatividad general, aunque resuleve un cnflicto, nos lleva a otro. A lo largo de tres décadas a partir de 1900, los físicos desarrollaron la me´canica cuántica en respuesta a varios problemas evidentes que se pusieron de manifiesto cuando los conceptos de la física del siglo XIX se aplicaron al mundo microscópico. Como he mencionado anteriormente, el tercer conflicto, el más trascendental, surge de la incompatibilidad entrem la mecánica cuántica y la relatividad general. La forma geométrica ligeramente curvada del esapcio, que aparece a partir de la relatividad general, es incompatible con el comportamiento microscópico irritante y frenético del universo que se deduce de la mecánica cuántica.

Y, volvemos otra vez al principio: Tenemos que persistir en aquellos trabajos de los años ochenta, cuando se presentó la solución que ofrecía la teoría de cuerdas para este tercer conflicto o problema. En realidad, es el mayor conflicto que se nos presenta en la física moderna. Necesitamos ya, para poder explicar muchas cosas y seguir avanzando, una teoría cuántica de la gravedad -si eso fuera posible-. Estamos parados, no podemos avanzar como sería deseable y, desde luego muchas son las iniciativas que se intentan: Teoría de Cuerdas, Teoría Luz-luz, o, energía masa, y otras muchas que están, en la mente de los mejores físicos del mundo pero que, no acaban de germinar.

Esperémos que, a no tardar mucho, alguna de esas teorías venga a decirnos algo más, del mundo que nos acoge, de la Naturaleza, y, del Universo en fin que contiene todo lo que existe y que de manera inexorable, irá cambiando hacia el futuro y, ¡las teorías también! Todo cambiará, incluso nosotros.

emilio silvera.

Abr

2

¡Las constantes universales! Ese fino equilibrio

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Existen muchas constantes físicas; algunas de las más conocidas son la constante de Planc racionalizada  , la constante de gravitación

, la constante de gravitación  , la velocidad de la luz

, la velocidad de la luz  , la permitividad en el vacío

, la permitividad en el vacío  , la constante de estructura fina α, la permeabilidad magnética en el vacío

, la constante de estructura fina α, la permeabilidad magnética en el vacío  y la carga elemental

y la carga elemental  . Todas éstas, por ser tan fundamentales, son llamadas constantes universales.

. Todas éstas, por ser tan fundamentales, son llamadas constantes universales.

¿Serán variables con el paso del Tiempo, esos parámetros que llamamos Constantes? Aún hoy en día algunos se empeñan en cambiarlas y transformarlas para más o para menos a medida que el tiempo transcurre y, en algunos casos incluso se llegó a decir que el cambio en alguna de aquellas constantes universales podría, incluso, convertir nuestro universo en un océano hirviente. No podemos negar que nuestro universo sea un océano hirviente de causas y efectos que, de camnbiar su dinámica, en fracciones de segundo podría cambiarlo todo.

Esta imagen apocalíptica es la foto del telescopio Hubble de la súper estrella Eta Carinae. La espectacular explosión de gas en expansión globular que se llama el Homunculus y que hace que la estrella aguante -de momento- y no explote como supernova para crear allí, en toda aquella región una gran nebulosa y en su centro, un agujero negro.

Es cierto que cambios muy pequeños en las fuerzas y constantes que nos rodean y pululan por el Universo, lo podrían cambiar todo y hacer inhabitable los planetas o que las estrellas explotaran al cambiar, aunque sea de manera casi imperceptible, los parámetros y fuerzas que se contraponen en el Cosmos para crear la estabilidad que podemos percibir.

Sobre el cambio de algunas constantes, George Gamow respondió al problema del océano hirviente sugiriendo que podía paliarse si se suponía que las coincidencias propuestas por Dirac eran debidas a una variación temporal en e, la carga del electrón, con e2 aumentando con el tiempo como requiere la ecuación e2/Gmp = t

Por desgracia, la propuesta de Gamow de una e variable tenía todo tipo de consecuencias inaceptables para la vida sobre la Tierra. Pronto se advirtió que la sugerencia de Gamow hubiera dado como resultado que el Sol habría agotado hace tiempo todo su combustible nuclear, no estaría brillando hoy si e2 crece en proporción a la edad del universo. Su valor en el pasado demasiado pequeño habría impedido que se formaran estrellas como el Sol. Las consecuencias de haber comprimido antes su combustible nuclear, el hidrógeno, hubiera sido la de convertirse primero en gigante roja y después en enana blanca y, por el camino, en el proceso, los mares y océanos de la Tierra se habrían evaporado y la vida habría desaparecido de la faz del planeta.

Gamow tuvo varias discusiones con Dirac sobre estas variantes de su hipótesis de G variable. Dirac dio una interesante respuesta a Gamow con respecto a su idea de la carga del electrón, y con ello la constante de estructura fina (α = 1/137), pudiera estar variando.

Recordando sin duda la creencia inicial de Eddington en que la constante de estructura fina era un número racional, escribe a Gamow en 1.961 hablándole de las consecuencias cosmológicas de su variación con el logaritmo de la edad del universo.

G. Gamov

“Es difícil formular cualquier teoría firme sobre las etapas primitivas del universo porque no sabemos si hc/e2 es constante o varía proporcionalmente a log(t). Si hc/e2 fuera un entero tendría que ser una constante, pero los experimentadores dicen ahora que no es un entero, de modo que bien podría estar variando. Si realmente varía, la química de las etapas primitivas sería completamente diferente, y la radiactividad también estaría afectada. Cuando empecé a trabajar sobre la gravedad esperaba encontrar alguna conexión entre ella y los neutrinos, pero esto ha fracasado.”

Paul A. M. Dirac

Dirac no iba a suscribir una e variable fácilmente, como solución al problema de los grandes números. Precisamente, su trabajo científico más importante había hecho comprensible la estructura de los átomos y el comportamiento del electrón, y dijo que existía el positrón. Todo ello basado en la hipótesis, compartida por casi todos, de que e era una verdadera constante, la misma en todo tiempo y todo lugar en el universo, un electrón y su carga negativa eran exactas en la Tierra y en el más alejado planeta de la más alejada estrella de la galaxia Andrómeda. Así que Gamow pronto abandonó la teoría de la e variable y concluyo que:

El Peñón de Gibraltar

“El valor de e se mantiene en pie como el Peñón de Gibraltar durante los últimos 6×109 años.” (el tiempo de 6.000 millones de años en que se cifraba la edad del Universo).

Pero lo que está claro es que, como ocurre siempre en ciencia, la propuesta de Dirac levantó una gran controversia que llevó a cientos de físicos a realizar pruebas y buscar más a fondo en el problema, lo que dio lugar a nuevos detalles importantes sobre todo aquello.

Alain Turing, pionero de la criptografía, estaba fascinado por la idea de la gravedad variable de Dirac, y especuló sobre la posibilidad de probar la idea a partir de la evidencia fósil, preguntando si “un paleontólogo podría decir, a partir de la huella de un animal extinto, si su peso era el que se suponía”.

Huella fósil de un dinosaurio

El gran biólogo J.B.S. Haldane se sintió también atraído por las posibles consecuencias biológicas de las teorías cosmológicas en que las “constantes” tradicionales cambian con el paso del tiempo o donde los procesos gravitatorios se despliegan de acuerdo con un reloj cósmico diferente del de los procesos atómicos (¿será precisamente por eso que la relatividad general – el cosmos -, no se lleva bien con la mecánica cuántica – el átomo -?).

Tales universos de dos tiempos habían sido propuestos por Milne y fueron las primeras sugerencias de que G podría no ser constante. Unos procesos, como la desintegración radiactiva o los ritmos de interacción molecular, podrían ser constantes sobre una escala de tiempo pero significativamente variables con respecto a la otra. Esto daba lugar a un escenario en el que la bioquímica que sustentaba la vida sólo se hacía posible después de una particular época cósmica, Haldane sugiere que:

“Hubo, de hecho, un momento en el que se hizo posible por primera vez vida de cualquier tipo, y las formas superiores de vida sólo pueden haberse hecho posibles en una fecha posterior. Análogamente, un cambio en las propiedades de la materia puede explicar algunas de las peculiaridades de la geología precámbrica.”

Es cierto que si la constante gravitatoria fuese variable con el paso del tiempo, todo se trastornaría

Este imaginativo escenario no es diferente del que ahora se conoce como “equilibrio interrumpido”, en el que la evolución ocurre en una sucesión discontinua de brotes acelerados entre los que se intercalan largos periodos de cambio lento. Sin embargo, Haldane ofrece una explicación para los cambios.

Lo que tienen en común todas estas respuestas a las ideas de Eddington y Dirac es una apreciación creciente de que las constantes de la naturaleza desempeñan un papel cosmológico vital:

Existe un lazo entre la estructura del universo en conjunto y las condiciones locales internas que se necesitan para que la vida se desarrolle y persista. Si las constantes tradicionales varían, entonces las teorías astronómicas tienen grandes consecuencias para la biología, la geología y la propia vida.

No podemos descartar la idea ni abandonar la posibilidad de que algunas “constantes” tradicionales de la naturaleza pudieran estar variando muy lentamente durante el transcurso de los miles de millones de años de la historia del universo. Es comprensible por tanto el interés por los grandes números que incluyen las constantes de la naturaleza. Recordemos que Newton nos trajo su teoría de la Gravedad Universal, que más tarde mejora Einstein y que, no sería extraño, en el futuro mejorará algún otro con una nueva teoría más completa y ambiciosa que explique lo grande (el cosmos) y lo pequeño (el átomo), las partículas (la materia) y la energía por interacción de las cuatro fuerzas fundamentales.

¿Será la teoría de Supercuerdas ese futuro?

Lo cierto es que la Física está dominada por los paradigmas impuestos desde hace cien años por la mecánica cuántica y la relatividad que son dos teorías fundamentales que parten de principios rectores a partir de los cuales las teorías se construyen de una manera casi sistemática. En estos ejemplos es fácil de identificar ese principio rector:

En la Relatividad el principio es la constancia de la velocidad de la luz o, lo que es equivalente, que la velocidad de la luz determina una cota máxima sobre la velocidad de transmisión de información. Una vez aceptado este principio, el resto se da casi por añadidura. La constancia de la velocidad de la luz implica un espacio tiempo con una determinada geometría, la equivalencia entre masa y energía, así como el resto de los resultados de la Dinámica y la Cinemática Relativistas.

No podemos perder de vista el hecho cierto de que, la razón por la que la Relatividad se convierte en una auténtica Teoría autónoma es precisamente porque eleva la constancia de la velocidad de la luz a principio rector, a postulado. No se trata de explicar o modelar dinámicamente por qué la velocidad de la luz es la velocidad máxima sino que, muy por el contrario, se trata de derivar toda una cinemática, de hecho la propia naturaleza geométrica del espacio y el tiempo, a partir de dicho postulado.

El Universo de la Mecánica Cuántica nos es fantasmagórico e irreal, es un mundo aparte en el que podemos ver cosas inusuales y sorprendentes, allí no rigen las mismas leyes que podemos constatar a nuestro alrededor en el mundo macroscópico, o, si están presentes, funcionan de otra manera que se alejada de nuestro propio mundo, no hemos llegado a comprenderla… -del todo-.

Nos decía el filósofo Karl Popper:

“La Ciencia será siempre una búsqueda, jamás un descubrimiento real. Es un viaje, nunca una llegada.”

El hombre llevaba toda la razón toda vez que, emprendemos la aventura de la Ciencia y tratamos de buscar “cosas” y “comportamientos” que nos digan por qué, la Naturaleza, funciona de esta o de aquella otra manera. Vamos desvelendo escenarios y obteniendo algunas respuestas pero, el viaje no acaba nunca, a cada puerta abierta, nos encontramos con otro nuevo espacio en el que también, existen muchas puertas cerradas cuyas llavez tendremos que encontrar y, siempre será, de esa manera: ¡Un viaje interminable!

En el caso de la Mecánica Cuántica el principio rector es el Principio de Incertidumbre de Heisenberg. De nuevo este principio se postula como principio básico y a partir de allí se deduce como tiene que ser el espacio de estados físicos, que se convierte en un espacio de naturaleza completamente nueva como lo es un espacio de Hilbert.

Esto da lugar a fenómenos tan sorprendentes como el entrelazamiento cuántico o la estabilidad atómica.

Robert Dicke

Me referiré ahora aquí a un físico extraño. Se sentía igualmente cómodo como matemático, como físico experimental, como destilador de datos astronómicos complicados o como diseñador de sofisticados instrumentos de medida. Tenía los intereses científicos más amplios y diversos que imaginarse pueda. Él decía que al final del camino todos los conocimientos convergen en un solo punto, el saber.

Así de curioso, ya podéis imaginar que fue uno de los que de inmediato se puso manos a la obra para comprobar la idea de la constante gravitatoria variable de Dirac que podía ser sometida a una gran cantidad de pruebas observacionales, utilizando los datos de la geología, la paleontología, la astronomía, la física de laboratorio y cualquier otro que pudiera dar una pista sobre ello. No estaba motivado por el deseo de explicar los grandes números. Hacia mediados de la década de los 60 hubo una motivación adicional para desarrollar una extensión de la teoría de la gravedad de Einstein que incluye una G variable. En efecto, durante un tiempo pareció que las predicciones de Einstein no coincidían en lo referente o sobre el cambio de órbita de Mercurio que era distinta a las observaciones cuando se tenía en cuentra la forma ligeramente achatada del Sol.

Si la constante de gravitación fuese variable, hasta la imagen de arriba sería otra, o, no sería

Robert Dicke, que este era el nombre del extraño personaje, y su estudiante de investigación Carl Brans, en 1.961, demostraron que si se permitía una variación de G con el tiempo, entonces podía elegirse un ritmo de cambio para tener un valor que coincidiera con las observaciones de la órbita de Mercurio. Lamentablemente, se descubrió que todo esto era una pérdida de tiempo. El desacuerdo con la teoría de Einstein a inexactitudes de nuestros intentos de medir el diámetro del Sol que hacían que este pareciera tener una forma de órbita diferente a la real. Con su turbulenta superficie, en aquel tiempo, no era fácil medir el tamaño del Sol. Así que, una vez resuelto este problema en 1.977, desapareció la necesidad de una G variable para conciliar la observación con la teoría.

De todas las maneras, lo anterior no quita importancia al trabajo realizado por Dicke que preparó una revisión importante de las evidencias geofísicas, paleontológicas y astronómicas a favor de posibles variaciones de las constantes físicas tradicionales. Hizo la interesante observación de explicar los “grandes números” de Eddington y Dirac bajo el apunte de que allí tenía que subyacer algún aspecto biológico que de momento no éramos capaces de ver.

“El problema del gran tamaño de estos números es ahora fácil de explicar… Hay un único número adimensional grande que tiene su origen estático. Este es el número de partículas del universo. La edad del universo “ahora” no es aleatoria sino que está condicionada por factores biológicos… porque algún cambio en los valores de grandes números impedirían la existencia del hombre para considerar el problema”.

Cuatro años más tarde desarrolló esta importante intuición con más detalle, con especial referencia a las coincidencias de los grandes números de Dirac, en una breve carta que se publicó en la revista Nature. Dicke argumentaba que formas de vidas bioquímicas como nosotros mismos deben su propia base química a elementos tales como el carbono, nitrógeno, el oxígeno y el fósforo que son sintetizados tras miles de millones de años de evolución estelar en la secuencia principal. (El argumento se aplica con la misma fuerza a cualquier forma de vida basada en cualesquiera elementos atómicos más pesados que el helio). Cuando las estrellas mueren, las explosiones que constituyen las supernovas dispersan estos elementos biológicos “pesados” por todo el espacio, de donde son incorporados en granos, planetesimales, planetas, moléculas “inteligentes” auto replicantes como ADN y, finalmente, en nosotros mismos que, en realidad, estamos hechos de polvo de estrellas.

Esta escala temporal está controlada por el hecho de que las constantes fundamentales de la naturaleza sean:

t(estrellas) ≈ (Gmp2 / hc)-1 h/mpc2 ≈ 1040 ×10-23 segundos ≈ 10.000 millones de años.

No esperaríamos estar observando el universo en tiempos significativamente mayores que t(estrellas), puesto que todas las estrellas estables se habrían expandido, enfriado y muerto. Tampoco seríamos capaces de ver el universo en tiempos mucho menores que t(estrellas) porque no podríamos existir; no había estrellas ni elementos pesados como el carbono. Parece que estamos amarrados por los hechos de la vida biológica para mirar el universo y desarrollar teorías cosmológicas una vez que haya transcurrido un tiempo t(estrellas) desde el Big Bang.

Así pues, el valor que del gran número nos dio Dirac N(t) no es en absoluto aleatorio. Debe tener un valor próximo al que toma N(t) cuando t esta cercano el valor t(estrella).

Todo lo que la coincidencia de Dirac dice es que vivimos en un tiempo de la Historia Cósmica posterior a la formación de las estrellas y anterior a su muerte. Esto no es sorprendente. Dicke nos está diciendo que no podríamos dejar de observar la coincidencia de Dirac: es un requisito para que exista vida como la nuestra

De esta forma Dicke nos vino a decir que:

“Para que el universo del Big Bang contenga las ladrillos básicos necesarios para la evolución posterior de la complejidad biológica-química debe tener una edad al menos tan larga, como el tiempo que se necesita para las reacciones nucleares en las estrellas produzcan esos elaborados elementos.”

Esto significa que el universo observable debe tener al menos diez mil millones de años y por ello, puesto que se está expandiendo, debe tener un tamaño de al menos diez mil millones de años luz. No podríamos existir en un universo que fuera significativamente más pequeño.

Un argumento hermosamente simple con respecto a la inevitabilidad del gran tamaño del universo para nosotros aparece por primera vez en el texto de las Conferencias Bampton impartidas por el teólogo de Oxford, Eric Mascall. Fueron publicadas en 1.956 y el autor atribuye la idea básica a Gerad Whitrow.

Estimulado por las sugerencias Whitrow, escribe:

“Si tenemos tendencia a sentirnos intimidados sólo por el tamaño del universo, está bien recordar que en algunas teorías cosmológicas existe una conexión directa entre la cantidad de materia en el universo y las condiciones en cualquier porción limitada del mismo, de modo que en efecto puede ser necesario que el universo tenga el enorme tamaño y la enorme complejidad que la astronomía moderna ha revelado para que la Tierra sea un posible hábitat para seres vivos.”

Esta simple observación puede ampliarse para ofrecernos una comprensión profunda de los sutiles lazos que existen entre aspectos superficialmente diferentes del universo que vemos a nuestro alrededor y las propiedades de la alquimia estelar.

emilio silvera

Abr

1

¿Se ha encontrado ya el Bosón de Higgs?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

¿Se ha descubierto “el” Bosón de Higgs?

Con ese título, D.Francisco Matorras Weinig, Catedrático de física atómica, molecular y nuclear, Instituto de Física de Cantabria (Universidad de Cantabria – CSIC) Web de la Real Sociedad Española de Física, el trabajo siguiente.

Recientemente ha llegado a los medios de comunicación una noticia en la que se aseguraba el descubrimiento del bosón de Higgs (al que llamaré aquí BEH, bosón de Brout-Englert-Higgs, de acuerdo con la tendencia actual de reconocer la contribución de estos tres físicos en el desarrollo de esta idea o simplemente Higgs, de acuerdo con la jerga habitual). Puede que ante ella muchos se hayan sentido perplejos planteándose muchas preguntas. Desde el ¿es esto cierto? al ¿pero no se había descubierto ya? o incluso ¿qué es el bosón de Higgs? Mediante estas líneas intentaré aclarar la situación y explicar en qué resultados se basa esta noticia.

Respecto de la última pregunta se ha escrito bastante y no es mi intención dar aquí una descripción detallada de lo que es el BEH y de su importancia en la Física de Partículas. Simplemente intentaré resumir en dos líneas las ideas principales. El BEH es una partícula elemental predicha en el contexto del llamado Modelo Estándar (en adelante referido como SM por sus siglas en inglés) hace cerca de 50 años, pero que no había sido observada pese a la realización de multitud de experimentos con este objetivo. El SM ha demostrado un poder predictivo impresionante y ha explicado con precisión todos los experimentos y observaciones del mundo de las partículas elementales. Sin embargo, por argumentos que no voy a entrar a discutir aquí, el modelo necesita la existencia de un campo que llena el Universo (el campo de Higgs). Si el campo existe, también debería existir un nuevo tipo de partículas, precisamente los bosones de Higgs, con unas propiedades peculiares. Encontrar esta partícula se convirtió en uno de los problemas clave de la física de partículas en las últimas décadas, para confirmar la consistencia del modelo en el que se basa nuestro actual entendimiento del universo a esta escala o para desecharlo, obligando a replantear toda la Física de Partículas.

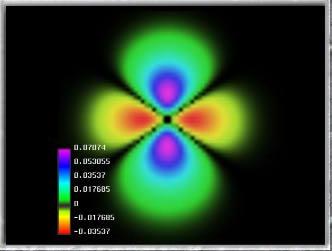

Respecto a la perplejidad de quienes daban por hecho que ya se había descubierto, es cierto que ya circularon noticias parecidas hace unos meses. A finales de 2011 se presentó a los medios (y más adelante se publicó en revistas especializadas) la “evidencia” de una señal compatible con el BEH y posteriormente en Julio de 2012, con más datos, la “observación” de esta señal. El acelerador LHC había sido capaz de realizar colisiones a unas energías jamás alcanzadas y dos complejos detectores ATLAS y CMS, habían sido capaces de identificar entre ellas algunas compatibles con la producción de BEH. Quiero recordar que cada uno de estos experimentos se lleva a cabo por grupos de dos o tres mil científicos, entre los que se encuentran investigadores de universidades.

y centros de investigación españoles1. Aclarar a quien pueda haber llamado la atención, que la diferencia entre evidencia y observación, consiste en la significación estadística de la señal observada. En este tipo de búsqueda, como en muchos casos en Física de Partículas, se trata de discriminar una tenue señal producida por colisiones “interesantes” por encima de un fondo producido por colisiones “normales”, que nada tienen que ver con el Higgs, pero dejan una señal similar en los detectores. La diferencia entre no decir nada, indicar una evidencia o una observación estriba en cuán improbable es que la señal observada sea una fluctuación del fondo. Pues bien, los resultados indicaban la existencia de cierto tipo de colisiones que encajaban con las predichas por la existencia del BEH y con una probabilidad despreciable de provenir de fluctuaciones de fondo. En concreto, se hablaba de un exceso “compatible” con lo esperado en producción y desintegración de un BEH de acuerdo con el SM. La partícula tenía que ser un bosón (dado que se desintegra a pares de fotones, dos objetos de spin 1), no era compatible con ningún otro proceso o partícula conocidos hasta ahora y encajaba razonablemente con lo predicho para un BEH. Sin embargo, no existe la seguridad de que sea exactamente “el” bosón de Higgs, exactamente lo predicho por el modelo. El mensaje de los experimentos fue cauto: “se ha descubierto una nueva partícula elemental, esta partícula es un bosón y se parece a lo que esperaríamos para un BEH, sin embargo no podemos confirmar que sus todas sus propiedades coincidan con las esperadas para un Higgs”. Por lo tanto, en ese momento no se afirmó que se había descubierto “el” bosón de Higgs.

¿Cuál ha sido el cambio de estas últimas semanas? El CERN, basándose en los últimos resultados presentados por las colaboraciones ATLAS y CMS en las series de conferencias “Rencontres de Moriond” emitió una nota de prensa en la que se anunciaba: “Nuevos resultados indican que la partícula encontrada en el CERN es el bosón de Higgs”. Ambas colaboraciones presentaron numerosos resultados, que completaban el análisis de las colisiones del LHC registradas en 2011 y 2012, incluían nuevas formas de producción y desintegración y, sobre todo, las primeras medidas de las propiedades de esta partícula. De todos los nuevos resultados presentados destacar cuatro, más allá del hecho fundamental del que nadie duda ya, de que se confirma la existencia de esta nueva partícula.

- Estudio de la producción de Higgs. Ambos experimentos comienzan a proporcionar medidas razonablemente precisas de la sección eficaz de producción, que están de acuerdo con las predichas por el SM (aunque ATLAS obtiene un valor ligeramente más alto y CMS uno ligeramente más bajo). Además se comienzan a observar procesos de producción menos probables, también de acuerdo con las predicciones, los llamados VBH (producción por fusión de bosones vectoriales) y VH (producción de un bosón de Higgs acompañado de un bosón Z o W).

- Estudio de la desintegración del Higgs. Se aportan ya un conjunto bastante completo de observaciones para muchos de los posibles canales de desintegración. El descubrimiento se realizó fundamentalmente en base a los llamados canales ZZ y gg, en que el Higgs se detecta por su desintegración a pares de bosones Z o de fotones. Además de refinar las medidas en estos canales, se han complementado con las de otros como el WW (dos bosones W), bb (pares de quarks beauty) o tt (pares de leptones tau). Contrariamente a algunos indicios iniciales, en ninguno de los casos se observan desviaciones significativas de lo esperado para el SM. De todos estos resultados se ha derivado información sobre la intensidad de los acoplamientos a bosones y fermiones y, una vez más, no hay desviaciones del SM (Figura 1).

- Masa de la partícula. Se ha medido la masa de esta partícula con bastante precisión, situándola entre 125 y 126 GeV/c2. Aunque el SM no proporciona una predicción sobre la masa del Higgs (éste es uno de los motivos de la dificultad de su búsqueda), ésta interviene de forma indirecta en los cálculos de todas las predicciones del SM. El valor obtenido está dentro del (amplio) rango permitido.

- Spin y paridad. Finalmente, más novedoso y probablemente más importante, se han comenzado a realizar medidas del spin y la paridad de la partícula encontrada. Dentro del SM, el Higgs debe ser un escalar, esto es, debe ser una partícula de spin cero y paridad positiva. Del estudio de correlaciones angulares en las desintegraciones de canales bosónicos se ha excluido la mayoría de las combinaciones spin/paridad posibles, y de los casos restantes el más favorable es precisamente el deseado (un ejemplo se muestra en la figura 2). Aún no se puede confirmar al 100%, pero todo indica que efectivamente el estado observado corresponde con un bosón escalar.

En este punto uno está tentado de parafrasear el dicho anglosajón del pato, “si se produce como un Higgs, se desintegra como un Higgs y tiene el spin de un Higgs entonces…” Sin embargo los experimentos ATLAS y CMS siguen siendo cautos y se limitan a trasmitir los resultados, que es cierto parecen confirmar que la partícula observada se comporta de una forma muy parecida a lo que esperamos de un BEH en el SM. Primero hay que esperar a que estos resultados preliminares sigan el proceso habitual en estos casos tras su presentación en una conferencia: revisión interna adicional dentro del experimento y publicación en una revista tras revisión externa. Incluso si todos estos resultados se confirman tras estos filtros adicionales, quedaría al menos una pregunta importante que resolver para poder decir con completa confianza que se ha detectado “el” bosón de Higgs. He hablado antes de los acoplamientos, que ajustaban a lo esperado por el SM. Sin embargo, los datos registrados son insuficientes para garantizar con precisión la propiedad fundamental de que el acoplamiento es proporcional a la masa de las partículas al cuadrado. Habrá que esperar algunos años para tener más luz en estos aspectos.

Y si somos atrevidos y aceptamos sin reservas estos resultados, olvidamos la cautela e ignoramos los aspectos pendientes que acabo de citar, entonces ¿podríamos decir que es “el” Higgs? Para muchos físicos de partículas, ni siquiera así podríamos decirlo propiamente. A pesar del gran éxito del SM en reproducir las observaciones, existen distintos argumentos teóricos que hacen sospechar que no es la teoría última a escala de las partículas elementales, sino que es un subconjunto o una adaptación de otro modelo más general (de forma parecida a como la mecánica newtoniana es un caso particular de la relatividad especial). La extensión preferida del SM se basa en la llamada supersimetría. Dentro de este conjunto de modelos, no habría uno, sino varios tipos de bosones de Higgs. Podríamos estar observando el más ligero de todos ellos, con unas propiedades muy similares a las del BEH del SM. De la simple medida de estas propiedades, el LHC no será capaz de distinguir entre ambos. La búsqueda actual se centra en encontrar los higgses adicionales u otras nuevas partículas que también son predichas por estos modelos. En ese sentido, para todos aquellos que confían en este tipo de modelos, no es “el” sino “un” Higgs,.

Por lo tanto, en respuesta a las preguntas planteadas y desde mi punto de vista como físico experimental, creo que aún no podemos decir con certeza científica que se ha descubierto el bosón de Higgs, pero sí podemos afirmar que se ha observado una nueva partícula elemental, que es un bosón, que con gran seguridad es un escalar (tiene spin 0 y paridad positiva) y que sus acoplamientos a las partículas elementales hasta el momento son compatibles con lo predicho para el Higgs. En resumen, si no es el bosón de Higgs se le parece mucho. Próximas medidas nos irán reduciendo aún más las ambigüedades restantes, indicándonos si es exactamente lo que se predijo como bosón de Higgs (lo que sería la demostración de un gran éxito del SM) o no (en cuyo caso se abriría nuevos y muy interesantes interrogantes en la física de partículas).

Referencias: Los resultados aquí mencionados aún no han sido publicados en revistas científicas convencionales o lo han sido sólo de forma parcial, se basan en los artículos enviados a la citada conferencia de Rencontres de Moriond que pueden encontrarse en las respectivas páginas de las colaboraciones ATLAS y CMS

1En ATLAS participan el Instituto de Física Corpuscular (IFIC, centro mixto CSIC y la Universitat de València), el Instituto de Microelectrónica de Barcelona (CNM-IMB-CSIC), Institut de Fisica d’Altes Energies (IFAE, consorcio Generalitat de Catalunya y Universitat Autònoma de Barcelona) y la Universidad Autónoma de Madrid (UAM). En CMS participan el Centro de Investigaciones Energéticas, Medioambientales y Tecnológicas (CIEMAT), el Instituto de Física de Cantabria (IFCA, centro mixto del CSIC y la Universidad de Cantabria), la Universidad de Oviedo (UO) y la UAM

Abr

1

¡Partículas subatómicas! Esos misteriosos objetos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

Están por todas partes y todo está conformado, de una u otra manera por ellas

Partículas, espín, familias, materia…

Conforme a lo que aceptamos hoy en día, toda la materia estaría constituida a partir de estados ligados de Quarks y Leptones, es decir de los quarks u “up” y d “down”, electrones e y neutrinos ѵ, y sus antipartículas. De todos estos objetos, pueden existir hasta un total de otras dos familias más en las que los quarks reciben otras denominaciones y los leptones, en vez de electrones podrían ser muones μ y partícula tau τ. Señalamos que estos objetos poseen distintas masas. Sin embargo, todas tienen en común que son partículas de espín ½. Si a estos objetos le añadimos los Bosones de espín 1, que son los responsables de las interacciones entre ellos, resulta que el poseer esa propiedad mecánica llamada espín es una de las características más importantes de los objetos elementales que constituyen la materia y de los vehículos que utilizan estas partículas elementales para su comunicación. Toda la materia que nos rodea se mueve y rota.

El espín del muón es ½. Cuando el espín de una partícula es semi-entero, se la clasifica como perteneciente al grupo denominado fermiones. La carga eléctrica de un muón es igual que la del electrón, pero su existencia es de sólo 2,2 microsegundos. En cambio el electrón es un elemento estable en la Naturaleza.

En el modelo físico de la mecánica cuántica, el muón es una partícula puntual y no tiene volumen. Pero no hay ningún problema para que se le asigne un momento angular (una rotación).

Podemos pensar en que el muón es como una bolita que gira sobre sí misma. Este momento angular se denomina espín y está cuantizado; es decir, que no puede tener cualquier valor, sino múltiplos de una cantidad mínima, que es 1/2. Este valor 1/2 se refiere a la constante reducida de Planck

El muón, al igual que todas las partículas elementales (cuatro en cada una de la tres familias), tiene espín de valor 1/2. A las partículas que tienen espín 1/2, se las denomina fermiones, en honor del físico italiano Enrico Fermi (1901-1954).

Como decía al principio, toda la materia que nos rodea se mueve y rota. Las partículas constituyentes no podían ser menos, de ahí que no es de extrañar que las partículas elementales tengan momento angular, que es la expresión mecánica de la medida de su estado interno de rotación. La sorpresa es, quizá, que todas estas partículas tengan exclusivamente el valor no nulo, más bajo posible, que predice la mecánica cuántica.

Claro que, a todo esto, también tenemos que decir que todas estas partículas tienen su contraria, es decir, su antipartícula y, precisamente una nueva evidencia surgida de estudios realizados nos dicen que Materia y Antimateria pueden ser más distintas de lo que hasta ahora se había creído.

Los neutrinos, partículas elementales generadas por las reacciones nucleares en el Sol, padecen una “crisis de identidad” cuando cruzan el universo, metamorfoseándose entre tres “sabores” diferentes. Sus homólogos de antimateria (que son idénticos en masa pero opuestos en la carga y el espín) experimentan también una crisis de identidad. Sin embargo un equipo de físicos ha descubierto ahora diferencias sorprendentes entre neutrinos y antineutrinos en lo que se refiere a su conducta de cambio de “sabor”. Si se confirma, el hallazgo podría ayudar a explicar por qué es la materia y no la antimateria la que domina en nuestro universo.Cada partícula de materia tiene una antipartícula correspondiente de antimateria. Los electrones son partículas negativamente cargadas que rodean el núcleo de cada átomo. El positrón es una antipartícula con la misma masa y magnitud de carga del electrón pero exhibiendo una carga positiva. Cuando la materia ordinaria, como por ejemplo un electrón, se combina con una cantidad igual de antimateria, como por ejemplo un positrón, ambas se aniquilan mutuamente.

Si por el telescopio descubriéramos una galaxia lejana de antimateria…, no lo sabríamos, su comportamiento en todos los órdenes, sería el mismo que tendría una galaxia de materia como la Vía Láctea o Andrómeda. Seríamos conscientes de su naturaleza si alguna galaxia cercana se acercara y la gravedad tratara de unirlas, en el momento de la fusión… ¡Todo estallaría!

El aparentemente ineludible hecho de que las partículas de materia y antimateria se destruyen entre sí al contacto, ha desconcertado a los físicos desde hace tiempo, preguntándose cómo la vida, el Universo, o cualquier cosa puede existir. Pero unos nuevos resultados de un experimento de acelerador de partículas sugieren que la materia parece ganar finalmente.

Teniendo en cuenta esto último, así como que ambas fueron creadas en la formación del universo, y que el universo actual alberga materia pero virtualmente nada de antimateria, debe haber alguna razón por la cual la materia se acabó imponiendo a la antimateria. La única explicación es que, las partículas de materia excedían en número a las de antimateria y, una ves destruidas todas las antagonistas, quedarían sólo las de materia que eran más y, esas son las que podemos ver ahora formando estrellas y planetas entre otras cosas.

Todo está hecho de esas pequeñas partículas que conocemos por Quarks y Leptones y, si miramos la imagen de arriba, podemos contemplar esa maravillosa imagen en la que la estrella masiva IRS 4 comienza a desplegar sus alas. Nacida hace sólo unos 100.000 años, el material expulsado de esta estrella “recién” nacida ha formado la nebulosa llamada Sharpless 2-106 (S106). El gran disco de polvo y de gas que orbita la fuente infrarroja IRS 4, visible en rojo oscuro cerca del centro de la imagen, da a la nebulosa la forma de un reloj de arena o de una mariposa.

El gas de S106 cerca de 4 IRS actúa como una nebulosa de emisión ya que emite luz después de haber sido ionizado, mientras que el polvo lejano procedente de IRS4 refleja la luz de la estrella central y, por tanto, actúa como una nenulosa de reflexión. El examen detallado de imágenes como esta, ha revelado la existencia de cientos de estrellas marrones de masa baja que rondan por el gas de la nebulosa. S106 se extiende unos 2 años luz y se encuentra a unos 2.000 años-luz de distancia en la constelación del Cisne ( Cygnus ). Todo ese bello conjunto que podemos admirar, en realidad sólo son átomos formados por partículas subatómicas y la energía que está presente emitida por los objetos que forman en el Universo.

Demócrito

Aquella idea del átomo que nos dejó Demócrito, de que la materia se puede dividir en porciones cada vez más pequeñas hasta que este proceso tenga un final, puede ser o no cierta. No sabemos si lo que hoy consideramos como una partícula elemental, por ejemplo el electrón, se descubre en un futuro que está a su vez compuesto de otros objetos todavía por descubrir (aunque para mí, no parece que tal cosa sea posible en el electrón que, por sus características, no parece prestarse a ello). Pero, si finalmente existen esos objetos últimos, indivisibles, que hoy en vez de átomos les denominaríamos partículas elementales, es legítimo tratar de clarificar desde un punto de vista teórico qué es lo que distingue a un objeto elemental de otro que no lo es, es decir, encontrar una definición plausible de partícula elemental.

Modelo Estándar de Partículas Elementales.

Una definición por exclusión podría ser que una partícula elemental es un sistema mecánico que no posee estados escitados, es decir, que no es posible modificar su estructura. Podremos aniquilarla, destruirla, pero nunca modificarla. En sentido positivo diríamos que se trata de un sistema mecánico cuyos únicos estados permitidos son solamente modificaciones cinemáticas de uno cualquiera de ellos. Conocido un estado cualquiera de la partícula, el resto de los estados posibles en los que la podamos encontrar son solamente las diferentes descripciones que de ese estado hacen el resto de los observadores inerciales, Esto también quiere decir que, un cierto observador inercial hace una descripción del estado en que se e4ncuentra una partícula elemental y debido a alguna influencia externa este estado cambia, siempre es posible encontrar otro observador inercial que, en el nuevo instante, describa la partícula exactamente en el mismo estado que en el instante anterior lo describía el otro observador.

Cualquier cambio en el valor de alguna de las variables que caracterizan el estado de una partícula elemental puede ser siempre compensado, mediante un cambio de sistema de referencia inercial, para lograr describir el sistema en el mismo estado, es decir, con exactamente los mismos valores de todas las variables que definen de forma única el estado del sistema.

Existen sofisticadas máquinas que nos permiten observar partículas y hacer exámenes granulométricos de las mismas, Cada día podemos acercarnos más y más a ese infinitesimal “universo de lo muy pequeño”, claro que, el mismo aparato que utilizamos que es un sistema electrónico, al emitir la luz que trata enfocar esas partículas, lanza miríadas de fotones sobre ellas y, en ese momento, se producen sucesos que impiden saber, de manera exacta donde está la partícula o, hacia donde se dirige. Es el Principicio de Incertidumbre de Heisenberg.

Esta forma de definir un objeto elemental puede parecer una trivialidad, pero supone sin embargo una enorme restricción con respecto al tipo de variables clásicas que podemos utilizar para describir sus estados. Para empezar, tenemos que conocer cómo estas variables cambian cuando cambiamos de sistema de referencia. Más aún, dados dos valores posibles de una cualquiera de estas variables, debe existir un cambio de sistema de referencia que nos relacione un valor con el otro, y así para todas las variables básicas que configuren el estado del sistema. Vemos por lo tanto la importancia que juega el Principio de Realtividad no solo a la hora de definir el conjunto de observadores inerciales equivalentes, sino también en la propia definición de partícula elemental, ya que condiciona el tipo de variables clásicas que podemos utilizar. Es ésta la definiciónn de partícula elmental que vamos a adoptar y vamos a intentar hacer una descripción Lagrangiana de aquellos sistemas mecánicos sujetos a esta definición.

De todas las maneras, en esto de las partículas nos tenemos que andar con pies de plomo, nada se puede dar por hecho, y, es bien sabido que lo que nos dice la mecánica cuántica no siempre coincide con lo que nos dicta el sentido común. Y, sí, en la relatividad están inmersas transformaciones que no debemos dejar de lado cuando tratamos con partículas elementales, veamos por ejempo:

Que el grupo de Lorentz realiza una foliación del espacio en hipérbolas diferenciadas. Ahora bien… ¿qué ocurre si tenemos una partícula en la región para v>c? Al ser la hipérbola vertical, ¡¡una transformación desplaza punto en el tiempo!!. Por tanto, podría ocurrir que lo que para alguien es pasado, para otro sea futuro… Para entenderlo mejor supongamos la situación siguiente en la que una partícula, vista por un observador, va del punto A al punto B a una velocidad mayor que la de la luz. (¿Serán los neutrinos de aquellos italianos del Proyecto Opera?

Consideremos el movimiento de una partícula superlumínica del punto A al punto B. Si aplicamos una transformación de Lorentz, al desplazar el punto B sobre la hipérbola, podría darse el caso de que este quedase por debajo de A, como en la figura siguiente:

Al aplicar la transformación, el punto B pasa del futuro al pasado. Por lo que, para este observador, ¡la partícula ha viajado en el tiempo! Claro que, nos topoamos de nuevo con el límite de la velocidad de la luz. Ni aquellos neutrinos de hace unos días, han podido quitarle el Record de velocidad a los fotones.

Una característica importante del principio de raltividad es que lleva asociado un grupo de transformaciones espaciotemporales. Este grupo es el que nos indica la forma en que los diferentes observadores inerciales relacionan sus medidas respectivas de las tres coordenadas espaciales y una temporal de un mismo acontecimiento espacio-temporal. En la física Newtoniana o no relativista, este grupo es el grupo de Galileo, mientras que la física relativista toma como grupo cinemático de base el Grupo de Poincaré, que además de rotaciones y traslaciones, como en el caso del grupo de Galileo, contiene transformaciones de Lorentz puras entre observadores, con velocidad relativa constante. El arranque del formalismo comienza con aceptar uno de estos grupos G como el grupo que deja invariante las ecuaciones dinámicas.

Desde el punto de vista académico, el estudio general de la geometría de la cuarta dimensión en gran parte resultado de los trabajos de Bernhard Riemann.

Los trabajos matemáticos sobre geometrías multidimensionales y geometrías no euclídeas habían sido considerado por los físicos como simples abstracciones matemáticas hasta que Henri Poincaré probó que el grupo de transformaciones de Lorentz que dejaban invariantes las ecuaciones del electromagnetismo podían ser interpretadas como “rotaciones” en un espacio de cuatro dimensiones. Más tarde, los trabajos de Einstein y la interpretación geométrica de estos por parte de Hermann Minkowski llevaron a la aceptación de la cuarta dimensión como una descripción necesaria para explicar los hechos observados relacionados con el electromagnetismo. Sin embargo, aquí la “cuarta dimensión” no era un lugar separado del espacio tridimensional (como en varias de las obras de ficción de la época) ni tampoco una dimensión espacial análoga a las otras tres dimensiones espaciales, sino una dimensión temporal que sólo puede recorrerse hacia el futuro. En la teoría general de la relatividad el campo gravitatorio es explicado como un efecto geométrico de la curvatura de un espacio-tiempo de cuatro dimensiones.

Más tarde, la teoría de Kaluza-Klein propuso que no sólo el campo gravitatorio podía ser interpretado de forma más sencilla como curvatura de un “espacio” de más de tres dimensiones, sino que si se introducía una nueva dimensión espacial enrollada o «compactificada», también el campo electromagnético podía ser interpretado como un efecto geométrico de la curvatura de dimensiones superiores. Así, la Kaluza proponía una teoría de campo unificado del electromagnetismo y la gravedad en un espacio-tiempo de cinco dimensiones, con una dimensión temporal, tres dimensiones espaciales extendidas y una dimensión espacial «compactificada» adicional, que, debido a su condición de compactificada, no era directamente visible pero su efecto era perceptible en forma de campo electromagnético.

Bueno, como de costumbre (eo pasar una mosca y me distrae), me paso de las partículas a los grupos de Poincaré y Lorentz o, a la cuarta dimensión de Minkowski, son cosas de la mente que, no siempre actúa como nos propusimos al comenzar un trabajo que, la mayoría de las veces finaliza, de manera misteriosa, de manera direfente a la que nos propusimos al comenzar.

El Físico Martin del Riva del Departamento de Física Teórica del pais Vasco, tiene mucho que ver con todo lo que aquí contamos. Desde aquí le agradecemos sus conocimientos.

emilio silvera

Totales: 83.884.037

Totales: 83.884.037 Conectados: 43

Conectados: 43