Jul

10

¡La evidencia experimental! Será el único camino

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

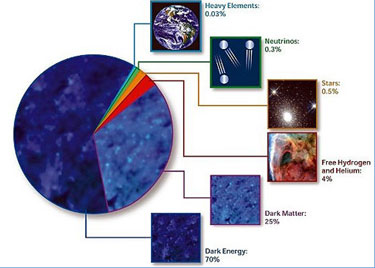

¿De qué está hecho el Universo?

¿Qué lo mantiene Unido?

¿Qué es, en realidad la materia?

Muchos han sido los medios que lanzando las campanas al vuelo, se atrevieron decir: “¡Por fín, se encontró la “partícula de Dios!” Cuando lo cierto es que, simplemente se publicó (31/07/2012), en los experimentos ATLAS y CMS del LHC se ha descubieto una partícula, nunca antes vista. Un Bosón con una masa cercana a los 126 GeV que, es la masa que habían pensado tendría el Higgs.

El descubrimiento se enmarca dentro de la búsqueda del Bosón de Higgs del Modelo estándar de las interacciones fundamentales, si bien no es posible afirmar aún si dicha partícula predice las propiedades intuidas por la teoría, y, siendo así (que lo es), no podemos afirmar que sea, el buscado Bosón de Higgs esa partícula observada.

Nos dicen que existen lugares que llaman los Océanos de Higgs, y, por ellos, circula libremente el dichoso Bosón que, también según nos dicen, proporciona la masa al resto de las partículas.

El modelo estándar de la física de partículas es una teoría que describe las relaciones entre las interacciones fundamentales conocidas y las partículas elementales que componen toda la materia. Es una teoría cuántica de campos desarrollada entre 1970 y 1973 que es consistente con la mecánica cuántica y la relatividad especial. Hasta la fecha, casi todas las pruebas experimentales de las tres fuerzas descritas por el modelo estándar están de acuerdo con sus predicciones. Sin embargo, el modelo estándar no alcanza a ser una teoría completa de las interacciones fundamentales debido a que no incluye la gravedad, la cuarta interacción fundamental conocida, y debido también al número elevado de parámetros numéricos (tales como masas y constantes que se juntan) que se deben poner a mano en la teoría (en vez de derivarse a partir de primeros principios).

Todo ese galimatias de más abajo, es, el Modelo estándar y aún más: Veréis…

¿Impresionados? No era mi intención asustar, solo he he puesto la fórmula para que te fijes en un detalle y comprendas por qué se empeñan los científicos en buscar el bosón de Higgs. Vuelve a mirar la ecuación y fíjate en las “H“. Ese valor representado en la fórmula es elbosón de Higgs y, aunque no lo hemos encontrado, es fundamental para que el Universo se comporte como se comporta, ya que cada vez que ponemos en marcha la ecuación, nuestras predicciones funcionan. (fuente fórmula blog inti-illimani).

Se cree que el Higgs guarda , por tanto, una relación íntima con el concepto de unificación de fuerzas y con el origen de la masa. Se trataría además de la primera partícula escalar con caracter fundamental, esto es, que no necesita estar compuesta por entidades más pequeñas. No es por tanto sorprendente que el descubrimiento reciente en el LHC de un nuevo Bosón con una masa de unos 126 GeV, con unas propiedades compatibles con el Bosón de Higgs, tanga de fiesta a toda la comunicad cientñifica del CERN que, de ser cierto el hallazgo, verían de cerca el Nobel que les otorgarían.

Claro que nadie sabe como sería el Bosón de Higgs, qué condiciones físicas debe tener y que masa, las predicciones teóricas no lo dicen en el modelo mH Es natural pensar que sea del mismo orden que la escala caracterísitica de la interacción electrodébil. mH ≈ 100 GeV – 1 TeV, y de hecho, la mayor parte de las predicciones conducen de una forma u otra a este intervalo de masas. La masa debe ser por tanto determinada experimentalmente. Una vez conocida esta, las propiedades de producción y desintegración del Bosón de Higgs están realmente determinadas por la teoría.

Ya veremos si realmente, la experimentación corrobora lo que predice la teoría y, podemos verificar los mecanismos mediante los cuáles, el Bosón de Higgs, puede “dar” masa a las partículas. Claro que, siempre en un escenario cercano al Modelo Estándar, eunbosón de higgs de 126 GeV posee una anchura de desintegración de unos pocos megas electrón voltios. Incluso para los aceleradores de mayor energía, esta anchura es aún suficientemente grande como para que la longitud media de desintegración del Bosón de Higgs sea inferior a una milésima de micra, demasiado pequeña para ser visible en un detector.

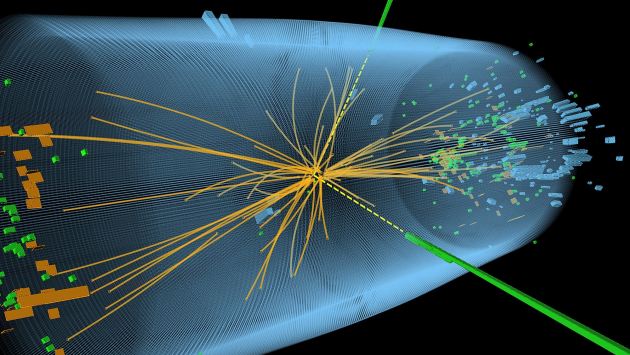

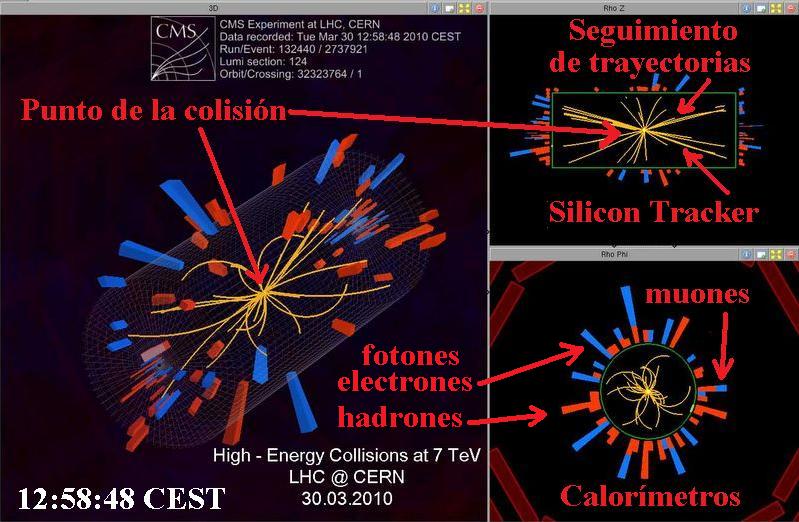

El choce de los haces de hadrones, produce una miríada de infinitesimales objetos producto de los protones rotos y que, de entre tanta “basura”, tendremos que localizar la probable partícula llamada Bosón de Higgs, lo cual, no resultará nada fácil.

El Bosón de Higgs debe aparecer por tanto como una partícula que se desintegra inmediatamente en el punto en el que los haces colisionan, además, la medida de su masa no estará condicionada por su anchura de desintegración, sino por la resolcuión energética del detector, que, en general, es al menos del orden de 1 GeV.

El Higgs se produce predominantemente en el LHC a través de un proceso de fusión de gluones: gg→ H. En cuanto se refiere a modos de desintegración, una masa de unos 126 GeV es especialmente interesante porque permite el acceso a varios canales diferentes.

Si bien la desintegración dominante para esta masa es en un par de Quarks b, el fondo enorme de otros procesos con este mismo estado final impide una búsqueda directa a partir del proceso gg→ H. Afortunadamnete existen varios canales alternativos con fracciones de desintegración aceptables, como pares de Bosones W o Z. Por último, el canal de desintegración en dos fotones, H → γγ, a pesar de su baja frecuencia, es extremadamente limpio desde el punto de vista experimental.

En todos los canales citados anteriormente, únicamente H → γγ y H → ZZ, y este último en un estado final con electrones o muones, permiten una medida precisa de mH al nivel de 1 GeV, y por tanto observar al Bosón de Higgs como exceso en el espectro de masas. Las colaboraciones ATLAS y CMS han medido mH = 120.0 ± o,4 GeV y mH = 125.3 ± 0,4 (stat.) ± 0,5 (syst.) GeV , respectivamente.

Está claro que la búsqueda del Bosón de Higgs no está nada clara y que, son muchos los parámetros que nos pueden llevar a tomar, alguna partícula parecida por ese extraño Bosón que se dedica a dar masa a las demás partículas, y, debemos comprobar, si aparece por fin, de qué mecanismo se vale para tal “milagro”, o, mejor maravilla.

Sí, se han hecho los experimentos necesarios para encontrar al dichoso Bosón y, según la masa de alguno, podría ser el que buscamos y que tanto necesita el Modelo Estándar para poder cuadrar sus cuentas… ¡En parte! Ya que otros parámetros metidos mcon calzador también ntendrán que ser justificados.

Los componentes fundamentales de la materia son tres familias de Quarks y otras tres familias de Leptonez, puntuales a 1 am, que interaccionan fuerte y débilmente de acuerdo con el Modelo. Las constantes de acoplo vienen dado por:

GF = (1.166371 ± 0,000006) 10-5 GeV-2

α-1 = 1.37.035999710 ± 0,000000000096

sin2 θW = 0,23149 ± 0,00013

M(Zº) = 91.1876 ± 0.0021

αs(Zº) = 0.1217 ± 0.0017

La constante de estructura fina y la constante de acoplo fuerte dependen de la escala a la que se han medido de acuerdo a las predicciones del grupo de renormalización.

La constante de acoplamiento resulta de gran utilidad en la teoría cuántica de campos. Un papel especial es representado en las teorías cuánticas relativistas por las constantes de acoplamiento que no poseen dimensiones, es decir, son números puros. Un ejemplo es la constante de estructura fina)

(donde e es la carga del electrón, ε0es la permitividad del vacío,  es la constante de Planck racionalizada y c es la es la velocidad de la luz) es tal constante de acoplamiento sin dimensiones que determina la intensidad de la fuerza electromagnética sobre un electrón.

es la constante de Planck racionalizada y c es la es la velocidad de la luz) es tal constante de acoplamiento sin dimensiones que determina la intensidad de la fuerza electromagnética sobre un electrón.

Claro que, todo este recorrido nos lleva a pensar que no estamos en posesión de verdad alguna, hemos podido alcanzar algunos conocimientos que nos acercan a ella y, lo cierto es que, esa verdad que buscamos, está en poder de la Naturaleza que, celosamente la esconde hasta que, nos crea preparados para que la podamos desvelar y, mientras tanto, nos deja “jugar” a física para que, nuestra curiosidad, no se sienta frustrada… del todo.

Publica: emilio silvera

Se agradece la aportación realizada por los físicos Juan Alcaráz, Javier Cuevas, Carmen García y Mario Martinez que, con su trabajo publicado en el volumen 26, número 4, de 2012, han ayudado a entender, algo mejor, el complejo tema del Bosón de Higgs.

Jul

10

¡La misteriosa Mecánica cuántica! y, “sus alrededores”

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (5)

Comments (5)

Se cuenta que una vez Albert Einstein alagó al actor Charles Chaplin diciéndole: “Lo que siempre he admirado de Usted es que su arte es universal, todo el mundo le comprende a admira”. A esto Chaplin respondió a Einstein: “Lo suyo es mucho más digno de respeto, todo el mundo le admira y prácticamente nadie le comprende”.

Es cierto lo que Chaplin decía, todos admiraban a Einstein y pocos comprendían sus postulados. De hecho, cuando estaba buscando la teoría de Todo, la gente se amontonaban, literalmente, ante los escaparates de la Quinta Avenida para ver las Ecuaciones que pocos entendían…¡Así somos los Humanos! Lo que no comprendemos nos produce temor o admiración, o, las dos cosas a la vez.

Gerad ´t Hooft

Em Noviembre del año pasado, me desplace a Madrid invitado para asistir a una Conferencia que sobre el LHC y el Bosón de Higgs impartía el físico y premio Nobel de Física Gerad ´t Hooft. La charla de ‘t Hooft se inscribía en el ciclo La ciencia y el cosmos, y, entre otras cosas nos decía a los presentes que, La física, en concreto la física de partículas, ha sido siempre su gran pasión. “cuando era joven, la física estaba cambiando el mundo radicalmente: la energía nuclear, la televisión, los ordenadores, las primeras misiones espaciales….yo quería formar parte de todo eso”. Y las partículas elementales “eran el mayor misterio de todos”, añade. “En cierto modo aún lo son, aunque ahora sabemos de ellas muchísimo más que entonces. Hoy los ordenadores siguen siendo emocionantes, la biología y el código del ADN, la astronomía y los vuelos espaciales… Sigue habiendo muchas cosas capaces de estimular la imaginación de jóvenes deseosos de aprender cosas nuevas impulsados por el deseo de estar ahí, en el momento en que se están haciendo los descubrimientos que cambian el mundo”.

Gerard ‘t Hooft explicó lo que significa, en los modelos teóricos, el famoso bosón: “El campo de la partícula de Higgs actúa como una especie de árbitro; proyectado contra otras partículas, este campo determina su comportamiento, si tienen carga o masa y hasta qué punto se diferencian de otras partículas. Si no encontramos el Higgs, si realmente no está, necesitaremos algo más que haga ese papel de árbitro”. Eso significaría, continuaba el Nobel, que “nuestras teorías ya no funcionan, y han funcionado tan bien hasta ahora que eso es difícil de imaginar”.

Sí al LHC se le resiste el Bosón de Higgs…, bueno, si es que anda por ahí

Fue en 199 cuando ‘t Hooft recibió el premio Nobel de Física 1999 (junto con su colega y director de tesis Martinus Veltman), por “dilucidar la estructura cuántica de las interacciones electrodébiles” -según palabras de la Academia sueca- de la física de las partículas elementales.

Acera del Gran Colisionador de Hadrones (el acelerador LHC situado en el Laboratorio Europeo de Física de partículas, CERN, junto a Ginebra), el científico holandés explica que se trata “de una máquina única en el mundo” y continúa: “Esperamos descubrir nuevas cosas con él y poner a prueba teorías que, hasta donde hemos podido comprobar hasta ahora, funcionan muy bien, pero necesitamos ir más allá”.

El descubrimiento de la partícula de Higgs, o bosón de Higgs, es el objetivo número uno del LHC, y tras un largo período de funcionamiento del acelerador, los miles de físicos que trabajan en los detectores, han logrado acotar el terreno de búsqueda, aunque, insisten, seguramente necesitarán tomar muchos más datos para descubrirlo. O tal vez descubrir que no existe, lo que supondría una revolución en la física de partículas, al obligar a replantear el llamado Modelo Estándar, que describe todas las partículas elementales y sus interacciones, y que hasta ahora funciona con altísima precisión aunque, dicen los expertos, está incompleto.

Gerard ‘t Hooft, uno de los grandes físicos teóricos de partículas elementales, considera que será muy difícil desarrollar una teoría del todo, un cuerpo teórico capaz de explicar todas las fuerzas que actúan en la naturaleza aunando la Relatividad General de Einstein y la Mecánica Cuántica, tan eficaces por separado en la descripción del macrocosmos y el microcosmos, respectivamente. “Mi impresión es que esta teoría unificadora, una teoría del todo, aún requerirá el trabajo de muchas nuevas generaciones de investigadores jóvenes y listos”, afirma. “No llegaremos a ella de un momento a otro por la simple razón de que el universo es demasiado complejo para que una única teoría lo abarque todo. Vale, no digo que sea imposible, pero me parece muy improbable. Y mientras llega, queda mucho por descubrir, incluso hallazgos espectaculares”.

Por otra parte, el científico holandés ha señalado que el LHC realiza más actividades que intentar encontrar el bosón de Higgs. En este sentido, ha destacado que se buscan también partículas que podrían construir la materia oscura, un tipo de materia de la que los físicos tienen la certeza de que es cinco veces más abundante que el universo que la materia ‘normal’, pero que no absorbe, refleja ni emite luz, lo que hace muy difícil su detección y, por tanto, estudiar su naturaleza. Del mismo modo, también se está desarrollando una teoría capaz de unificar la teoría de la relatividad general de Einstein y la mecánica cuántica que, según ha explicado Hooft, “permitiría descubrir lo que ocurre dentro de los átomos”.

Recuerdo un pasaje escrito por él al principio de su interesante e instructivo libro “Partículas Elemetales”, que decía:

“Mi intención es narrar los últimos 25 años de investigación sobre las partículas más pequeñas que constituyen la materia. Durante esos 25 años, yo empecé a ver la Naturaleza como un test de inteligencia para toda la humanidad en su conjunto, como un gigantesco puzzle con el que podemos jugar. Una y otra vez, nos tropezamos con nuevas piezas, grandes i pequeñas, que encajan maravillosamente con las que ya tenemos. Yo quiero compartir con ustedes la sensación de triunfo que sentimos en esos momentos.”

Tenía la intención (si se presentaba la oportunidad), de preguntarle sobre “su Principio Holográfico” pero, no pudo ser. Sólo pude saludarlo e intercambiar unas breves palabras junto con Ignacio Cirac presente también en el evento.

Publicó el principio holográfico, el cual explica que la información de una dimensión extra es visible como una curvatura del espacio tiempo con una menos dimensiones. Por ejemplo, los hologramas son imágenes de 3 dimensiones colocadas en una superficie de 2 dimensiones, el cual da a la imagen una curvatura cuando el observador se mueve. Similarmente, en relatividad general, la cuarta dimensión esta manifestada en 3 dimensiones observables como la curvatura de un sendero de un movimiento de partícula (criterio) infinitesimal. Hooft ha especulado que la quinta dimensión es realmente la fábrica del espacio-tiempo.

Acordaos de que, a mediados del año 2,003 apareció la noticia de que la “información sería el componente fundamental de la naturaleza” postulada por un grupo de físicos entre los que se incluyen el Premio Nóbel danés Gerard t´Hooft y el físico de la Universidad de California Raphael Bousso, basadas en el “Principio Holográfico”. Esta teoría, por singular y chocante que pareciese en su momento ha tenido a lo largo de estos siete años una influencia notable tanto en la sociedad científica como en los círculos alternativos.

Personajes tan influyentes como Deepak Chopra sin ir más lejos habla del ámbito cuántico como el campo de información de donde parte todo lo conocido, materia, emociones, pensamientos. El controvertido joven físico Nassam Haramein defiende un universo basado en el holograma. Científicos japoneses -al igual que del resto del mundo- investigan con hologramas creando imágenes 3D o explican el funcionamiento del mundo físico basado en los campos de energía e información. Hay hasta “farmacología holográfica” a cargo de empresas farmaceúticas. El año pasado el físico Craig Hogan tras la detección de un extraño ruido en el detector de ondas gravitacionalesel GEO 600, afirma que podría probar que, efectivamente, vivimos en un holograma.

La información sería el componente fundamental de la naturaleza. Es la que especifica el cuándo, dónde, cómo y cuánto del espacio, del tiempo y de la materia. El Big Bang que dio lugar al nacimiento del Universo tendría más que ver con una gigantesca “bajada” de bytes de información por parte de un superordenador, que con una explosión masiva de materia, según una nueva teoría que establece que en su origen la naturaleza está formada únicamente por pequeños paquetes de información pura que son los que especifican el cuándo, dónde, cómo y cuánto del espacio, del tiempo y de la materia.

El ser humano continúa con su carrera particular para descubrir lo que siempre ha querido saber: quiénes somos y de dónde venimos. Esas dos preguntas esenciales son, en realidad, el motor gracias al cual se mueve gran parte de la investigación científica de todos los tiempos.

En esta carrera por buscar certezas, cosas tan inquebrantables para explicar el origen del mundo como son los átomos o los quarks están quedando relegados a segundo término para dar paso a nuevas teorías.

Una de las más interesantes, postulada por un grupo de físicos entre los que se incluyen el Premio Nóbel danés Gerard t´Hooft y el físico de la Universidad de California Raphael Bousso, afirma que en el origen de la naturaleza podría haber únicamente ultrapequeños paquetes de información pura.

Aunque parezca raro la información no viaja en un bloque como lo haría una carta, sino que esta se divide en pequeños paquetes de información, viajando a través de los diferentes canales de la red y llegando todos al mismo punto. Para esto es preciso que todos los ordenadores hablen el mismo idioma, o lo que es decir el Protocolo TCP/IP, (que es el idioma) que en un principio empezó a usarse en 1983 para dirigir el tráfico de los paquetes de información por Arpanet, garantizando así que todos lleguen a su destino.

La @ que parece que nació a partir de internet se utilizaba en la antigüedad, como unidad de peso o incluso para decir a cuanto costaba algo en libros de contabilidad. Sin embargo se puso de moda gracias al ingeniero estadounidense Ray Tomilson, que diseñaba un sistema de correo electrónico para Arpanet, simplemente bajo los ojos al teclado y eligió un signo que no se utilizara en los nombres de usuario.

Según explica al respecto Newsfactor, esta teoría, basada en el “Principio holográfico”, establece que la información (“información” en este caso significa bits fundamentales de materia y las leyes físicas que los gobiernan) especifica el cuándo, dónde, cómo y cuánto del espacio, del tiempo y de la materia. La información sería pues, una variable para llegar a una “teoría del todo”.

Y, más allá de las cuerdas…

Según la teoría cuerdas, el espacio está descrito por la vibración, en miles de maneras, de diminutas cuerdas de una dimensión. Una cuerda vibrando arriba y abajo a cierta frecuencia podría crear un átomo de helio o una ola gravitacional, tal y como las cuerdas de una guitarra crean diferentes sonidos a diferentes frecuencias.

Los teóricos de esta teoría han mantenido hace mucho tiempo que estas cuerdas son el componente fundamental de la naturaleza. El “Principio Holográfico”, sin embargo, cambia esta noción y mantiene que, mirando más de cerca una cuerda, se ven bits cuánticos, llamados “baldosas de Planck”, que, engarzados, dicen a las cuerdas como tienen que vibrar.

Estas “baldosas de Planck” son bits cuadrados que delimitan un “área de Planck”, o lo que es lo mismo, un trillón de un trillón, de un trillón de un trillón de un trillón de un trillón de un centímetro cuadrado. Una cuerda de baldosas de Plank sería la versión natural de un byte.

El “Principio Holográfico”, descrito por Gerard t´Hooft y Leonard Susskind y refinado por Bousso, nos permite saber cuántos datos (bits y bytes) son necesarios para decirnos en detalle cada cosa que ocurre en cualquier región del espacio.

¡Por imaginación que no quede!

emilio silvera

Jul

10

El complejo universo de lo muy pequeño

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (5)

Comments (5)

En 1970, de las siguientes características de la interacción débil sólo se conocían las tres primeras:

- La interacción actúa de forma universal sobre muchos tipos diferentes de partículas y su intensidad es aproximadamente igual para todas (aunque sus efectos pueden ser muy diferentes en cada caso). A los neutrinos les afecta exclusivamente la interacción débil.

- Comparada con las demás interacciones, ésta tiene un alcance muy corto.

- La interacción es muy débil. Consecuentemente, los choques de partículas en los cuales hay neutrinos involucrados son tan poco frecuentes que se necesitan chorros muy intensos de neutrinos para poder estudiar tales sucesos.

- Los mediadores de la interacción débil, llamados W+, W– y Z0, no se detectaron hasta la década de 1980. al igual que el fotón, tienen espín 1, pero están eléctricamente cargados y son muy pesados (esta es la causa por la que el alcance de la interacción es tan corto). El tercer mediador, Z0, que es responsable de un tercer tipo de interacción débil que no tiene nada que ver con la desintegración de las partículas llamada “corriente neutra”, permite que los neutrinos puedan colisionar con otras partículas sin cambiar su identidad.

A partir de 1970, quedó clara la relación de la interacción débil y la electromagnética (electrodébil de Weinberg-Salam).

La interacción fuerte (como hemos dicho antes) sólo actúa entre las partículas que clasificamos en la familia llamada de los hadrones, a los que proporciona una estructura interna complicada. Hasta 1972 sólo se conocían las reglas de simetría de la interacción fuerte y no fuimos capaces de formular las leyes de la interacción con precisión.

Como apuntamos, el alcance de esta interacción no va más allá del radio de un núcleo atómico ligero (10-13 cm aproximadamente).

La interacción es fuerte. En realidad, la más fuerte de todas.

Bajo la influencia de esta interacción, las partículas que pueden desintegrarse, las “resonancias” lo hacen muy rápidamente. Un ejemplo es la resonancia Δ, con una vida media de 0’6 × 10-23 s. Esta colisión es extremadamente probable cuando dos hadrones se encuentran a una distancia cercana a 10-13 cm.

Jul

8

Partículas, luz, Física… ¡Naturaleza!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

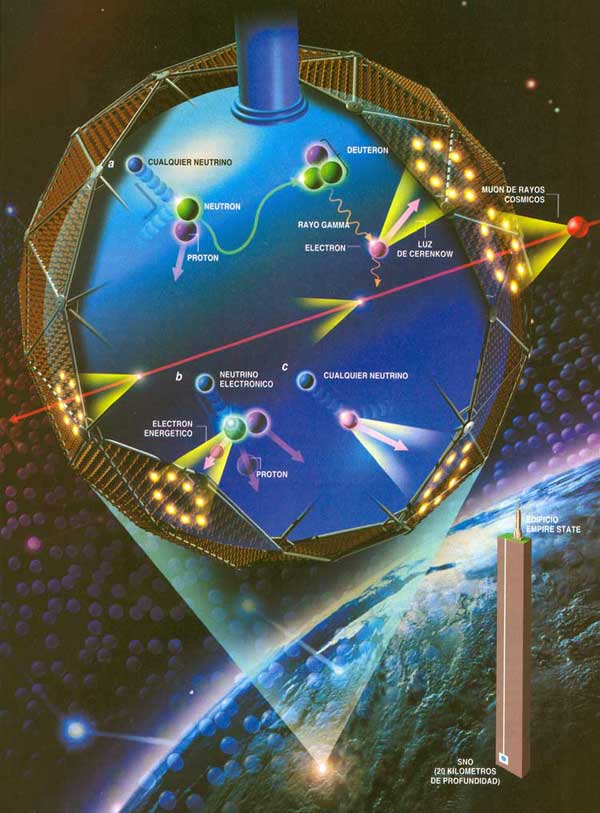

Decaimiento β– de un núcleo. Se ilustra cómo uno de los neutrones se convierte en un protón a la vez que emite un electrón (β–) y un antineutrino electrónico. La desintegración beta, emisión beta o decaimiento beta es un proceso mediante el cual un nucleido o núclido inestable emite una partícula beta (un electrón o positrón) para compensar la relación de neutrones y protones del núcleo atómico.

Los físicos se vieron durante mucho tiempo turbados por el hecho de que a menudo, la partícula beta emitida en una desintegración del núcleo no alberga energía suficiente para compensar la masa perdida por el núcleo. En realidad, los electrones no eran igualmente deficitarios. Emergían con un amplio espectro de energías, y el máximo (conseguido por muy pocos electrones), era casi correcto, pero todos los demás no llegaban a alcanzarlo en mayor o menor grado. Las partículas alfa emitidas por un nucleido particular poseían iguales energías en cantidades inesperadas. En ese caso, ¿qué era errónea en la emisión de partículas beta? ¿Qué había sucedido con la energía perdida?

En 1922, Lise Maitner se hizo por primera vez esta pregunta, y, hacia 1930, Niels Bohr estaba dispuesto a abandonar el gran principio de conservación de la energía, al menos en lo concerniente a partículas subatómicas. En 1931, Wolfgang Pauli sugirió una solución para el enigma de la energía desaparecida.

Tal solución era muy simple: junto con la partícula beta del núcleo se desprendía otra, que se llevaba la energía desaparecida. Esa misteriosa segunda partícula tenía propiedades bastante extrañas. No poseía carga ni masa. Lo único que llevaba mientras se movía a la velocidad de la luz era cierta cantidad de energía. A decir verdad, aquello parecía un cuerpo ficticio creado exclusivamente para equilibrar el contraste de energías.

Sin embargo, tan pronto como se propuso la posibilidad de su existencia, los físicos creyeron en ella ciegamente. Y esta certeza se incrementó al descubrirse el neutrón y al saberse que se desintegraba en un protón y se liberaba un electrón, que, como en la decadencia beta, portaba insuficientes cantidades de energía. Enrico Fermi dio a esta partícula putativa el nombre de “neutrino”, palabra italiana que significa “pequeño neutro”.

El neutrón es una partícula sin carga presente en el núcleo de los átomos, descubierta por el físico James Chadwick, hace 80 años. Lo cierto es que el neutrón dio a los físicos otra prueba palpable de la existencia del neutrino. Como ya he comentado en otra página de este trabajo, casi todas las partículas describen un movimiento rotatorio. Esta rotación se expresa, más o menos, en múltiples de una mitad según la dirección del giro. Ahora bien, el protón, el neutrón y el electrón tienen rotación de una mitad. Por tanto, si el neutrón con rotación de una mitad origina un protón y un electrón, cada uno con rotación de una mitad, ¿qué sucede con la ley sobre conservación del momento angular? Aquí hay algún error. El protón y el electrón totalizan una mitad con sus rotaciones (si ambas rotaciones siguen la misma dirección) o cero (si sus rotaciones son opuestas); pero sus rotaciones no pueden sumar jamás una mitad. Sin embargo, por otra parte, el neutrino viene a solventar la cuestión.

Supongamos que la rotación del neutrón sea +½. Y admitamos también que la rotación del protón sea +½ y la del electrón -½, para dar un resultado neto de cero. Demos ahora al neutrino una rotación de +½, y la balanza quedará equilibrada.

+½(n) = +½(p) – ½(e) + ½ (neutrino)

Esas partículas (al igual que el protón, el neutrón y el electrón), que poseen espines que pueden medirse en números mitad, se consideran según un sistema de reglas elaboradas independientemente, en 1.926, por Fermi y Dirac; por ello, se las llama y conoce como estadísticas Fermi-dirac. Las partículas que obedecen a las mismas se denominan fermiones, por lo cual el protón, el electrón y el neutrón son todos fermiones.

Pero aun queda algo por equilibrar. Una sola partícula (el neutrón) ha formado dos partículas (el protón y el electrón), y, si incluimos el neutrino, tres partículas. Parece más razonable suponer que el neutrón se convierte en dos partículas y una antipartícula. En otras palabras: lo que realmente necesitamos equilibrar no es un neutrino, sino un antineutrino.

El propio neutrino surgiría de la conversación de un protón en un neutrón. Así, pues, los productos serían un neutrón (partícula), un positrón (antipartícula) y un neutrino (partícula). Esto también equilibra la balanza.

En otras palabras, la existencia de neutrinos y antineutrinos debería salvar no una, sino tres, importantes leyes de conservación: la conservación de la energía, la de conservación del espín y la de conservación de partícula/antipartícula.

Es importante conservar esas leyes puesto que parece estar presentes en toda clase de reacciones nucleares que no impliquen electrones o positrones, y sería muy útil si también se hallasen presentes en reacciones que incluyesen esas partículas.

Las más importantes conversiones protón–neutrón son las relaciones con las reacciones nucleares que se desarrollan en el Sol y en los astros. Por consiguiente, las estrellas emiten radiaciones rápidas de neutrinos, y se calcula que tal vez pierdan a causa de esto el 6 u 8 % de su energía. Pero eso, sería meternos en otra historia y, por mi parte, con la anterior explicación solo trataba de dar una muestra del ingenio del hombre que, como habréis visto, no es poco.

Desde que puedo recordar, he sido un amante de la Física. Me asombran cuestiones como la luz, su naturaleza de un conglomerado de colores, ondas y partículas, su velocidad que nos marca el límite del máximo que podemos correr en nuestro Universo, y en fin, muchos otros misterios que encierra esa cosa tan cotidiana que nos rodea y lo inunda todo haciendo posible que podamos ver por donde vamos, que las plantas vivan y emitan oxígeno o que nos calentemos. Realmente, sin luz, nuestra vida no sería posible.

La luz que, con sus contrastes nos hacen disfrutar de las maravillas de nuestro mundo

Entonces, ¿qué es realmente la luz? Bueno, en realidad, es una forma de radiación electromagnética a la que el ojo humano es sensible y sobre la cual depende nuestra consciencia visual del universo y las maravillas que contiene, Podríamos decir que sin la luz, no es que no pudiéramos ver los objetos que el universo nos muestra, es mucho más que eso, sin luz, posiblemente nosotros no podr´ñiamos estar aquí, ya que, el último término, ¿qué somos nosotros mismos? Creo que somos luz concentrada y hecha materia evolucionada que ha podido alcanzar el poder de emitir ideas y pensamientos.

Muchos (casi todos) opinan que es algo inmaterial. Los objetos materiales, grandes o muy pequeños como las galaxias o los electrones, son materia. La luz, sin embargo, se cree que es inmaterial, dos rayos de luz se cruzan sin afectarse el uno al otro. ¡Qué gran equivocación! La luz es mucho más y, el día que sepamos su verdadera naturaleza…

Hemos tenido que crear la luz artificial para poder desarrollar todo tipo de actividades

Está claro que, los estudiosos de la época antigua y medieval estaban por completo a oscuras acerca de la naturaleza de la luz. Especulaban sobre que consistía en partículas emitidas por objetos relucientes o tal vez por el mismo ojo. Establecieron el hecho de que la luz viajaba en línea recta, que se reflejaba en un espejo con un ángulo igual a aquel con el que el rayo choca con el espejo, y que un rayo de luz se inclina (se refracta) cuando pasa del aire al cristal, al agua o a cualquier otra sustancia transparente.

En épocas pasadas la única luz era la emitida por el Sol y no se conocía su naturaleza

Cuando la luz entra en un cristal, o en alguna sustancia transparente, de una forma oblicua (es decir, en un ángulo respecto de la vertical), siempre se refracta en una dirección que forma un ángulo menor respecto de la vertical. La exacta relación entre el ángulo original y el ángulo reflejado fue elaborada por primera vez en 1621 por el físico neerlandés Willerbrord Snell. No publicó sus hallazgos y el filósofo francés René Descartes descubrió la ley, independientemente, en 1637.

Los primeros experimentos importantes acerca de la naturaleza de la luz fueron llevados a cabo por Isaac Newton en 1666, al permitir que un rayo de luz entrase en una habitación oscura a través de una grieta e las persianas, cayendo oblicuamente sobre una cara de un prisma de cristal triangular. El rayo se refracta cuando entra en el cristal y se refracta aún más en la misma dirección cuando sale por una segunda cara del prisma. (Las dos refracciones en la misma dirección se originan por que los dos lados del prisma de se encuentran en ángulo en vez de en forma paralela, como sería el caso en una lámina ordinaria de cristal.)

Newton atrapó el rayo emergente sobre una pantalla blanca para ver el efecto de la refracción reforzada. Descubrió que, en vez de formar una mancha de luz blanca, el rayo se extendía en una gama de colores: rojo, anaranjado, amarillo, verde, azul, y violeta, en este orden. Newton dedujo de ello que la luz blanca corriente era una mezcla de varias luces que excitaban por separado nuestros ojos para producir las diversas sensaciones de colores. La amplia banda de sus componentes se denominó spectrum (palabra latina que significa “espectro” fantasma), y, llegó a la conclusión de que la luz se componía de diminutas partículas (“corpúsculos”), que viajaban a enormes velocidades.

Le surgieron y se planteó algunas inquietudes y cuestiones. ¿Por qué se refractaban las partículas de luz verde más que los de luz amarilla? ¿Cómo se explicaba que dos rayos de luz se cruzaran sin perturbase mutuamente, es decir, sin que se produjeran colisiones entre partículas?

En 1678, el físico neerlandés christian Huyghens (un científico polifacético que había construido el primer reloj de péndulo y realizado importantes trabajos astronómicos) propuso una teoría opuesta: la de que la luz se componía de minúsculas ondas. Y si sus componentes fueran ondas, no sería difícil explicar los diversos difracciones de los diferentes tipos de luz a través de un medio refractante, siempre y cuando se aceptara que la luz se movía más despacio en ese medio refractante que en el aire. La cantidad de refracción variaría con la longitud de las ondas: cuanto más corta fuese tal longitud, tanto mayor sería la refracción. Ello significaba que la luz violeta (la más sensible a este fenómeno) debía de tener una longitud de onda mas corta que la luz azul, ésta, más corta que la verde, y así sucesivamente.

Lo que permitía al ojo distinguir los colores eran esas diferencias entre longitudes de onda. Y, como es natural, si la luz estaba integrada por ondas, dos rayos podrían cruzarse sin dificultad alguna. (Las ondas sonoras y las del agua se cruzan continuamente sin perder sus respectivas identidades.)

Pero la teoría de Huyqhens sobre las ondas tampoco fue muy satisfactoria. No explicaba por qué se movían en línea recta los rayos luminosos; ni por qué proyectaban sombras recortadas; ni aclaraba por qué las ondas luminosas no podían rodear los obstáculos, del mismo modo que pueden hacerlo las ondas sonoras y de agua. Por añadidura, se objetaba que si la luz consistía en ondas, ¿cómo podía viajar por el vacío, ya que cruzaba el espacio desde el Sol y las Estrellas? ¿Cuál era esa mecánica ondulatoria?

Como veréis, la luz desde siempre, ha venido planteando dilemas y que hemos podido ir desvelando y, algunos, están aún por descubrir.

emilio silvera

Jul

7

¡Las leyes de la Física! ¿Cuando dejarán de causarnos asombro?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

Algunos creen que desde que Einstein sacó a la luz su relatividad especial, las leyes de Newton habían quedado olvidadas en un cuarto oscuro y, nada más lejos de la realidad. La física newtoniana siguen utilizándose ampliamente en la vida cotidiana, en la mayoría de los campos de la ciencia y en la mayor parte de la tecnología. No prestamos atención a la dilatación del tiempo cuando hacemos un viaje en avión, y los ingenieros no se preocupan por la contracción de la longitud cuando diseña la nave. La dilatación y la contracción son demasiado pequeñas para que sean tomadas en consideración.

Por supuesto, podríamos utilizar, si quisoéramos, las leyes de Einstein en lugar de las leyes de Newton en la vida de cada día. Las dos dan casi exactamente las mismas predicciones para todos los efectos físicos, puesto que la vida diaria implica velocidades relativas que son muy pequeñas comparadas con la velocidad de la luz.

Las predicciones de Einstein y Newton comienzan a diferir fuertemente sólo cuando las velocidades relativasd se aproximan a la velcoidad de la luz, Entonces, y sólo entonces debemos abandonar las predicciones de Newton y atenernos estrictamente a las de Eonstein. Este es un ejemplo de una pauta muy general. Es una pauta que se ha repetido una y otra vez a lo largo de la historia de la física del siglo XX: un conjunto de leyes (en este caso las leyes newtonianas) es ampliamente aceptado al principio, porque concuerda muy bien con el experimento.

Pero los experimentos cada vez se hacen más prcisos y este conjunto de leyes resultan funcionar bien sólo en un dominio limitado, su dominio de validez (para las leyes de Newton) el dominio de velocidades pequeñas comparadas con la velocidad de la luz en el vacío. Entonces los físicos se esfuerzan, experimental y teóricamente, para comprender qué está pasando en el límite de dicho dominio de validez, finalmente formulan un nuevo conjunto de leyes que es muy acertado dentro, cerca y más allá del límite (en el caso de Newton, la relatividad especial de Einstein, que sí es válida a velocidades próximas a las de la luz tanto como a más bajas velocidades.

Hoy día, el mundo moderno de la física se funda notablemente en dos teorías principales, la realtividad general y la mecánica cuántica, aunque ambas teorías parecen contradecirse mutuamente. Los postulados que definen la teoría de la realtividad de Einstein y la teoría del quántum estan incuestionablemente apoyados por rigurosa y repetida evidencia empiríca. Sin embargo, ambas se resisten a ser incorporadas dentro de un mismo modelo coherente.

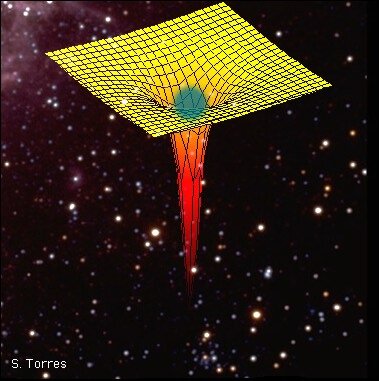

Nuevas maneras de sondear la Naturaleza y desvelar sus secretos están en marcha y, más adelante en el futuro, saldrán a la luz nuevas formas y nuefvas teorías que, para entonces, sí que se podrán comprobar de manera experimental. Pero sigamos con la relatividad ede Einstein que, en su primera fase, la relatividad especial comienza a fracasar cuando se hace presente la Gravedad dde una manera importante, entonces, tiene que ser reemplazada por un nuevo conjunto de leyes que llamamos relatividad general; ésta fracasa en presencia de una singularidad interna de un agujero negro y, entonces, debe ser reemplazada por otro nuevo conjunto de leyes que conocemos como Gravedad Cuántica y que aún, no hemos podido dominar.

Einstein nos decía que el espacio se curva en presencia de grandes masas

Lo cierto que es que, se ha dado una carqacterística sorprendente en cada transición de un viejo conjunto de leyes a otro nuevo: en casa caso, los físicos (si demostraban ser suficientemente inteligentes) no necesitaban ninguna guía experimental que les dijera dónde empezaría a fallar el viejo conjunto, es decir, que les indicara el límite de su dominio de validez. Ya hemos podido ver eso para la física newtoniana: las leyes de la electrodinámica de Maxwell no encajaban bien con el espacio absoluto de la física newtoniana. En reposo en el espacio absoluto (en aquel sistema del éter), las leyes de Maxwell eran simples y bellas -por ejemplo, las lineas de campo magnético no tienen extremo. En los sistmas en movimiento se vuelven complicadas y feas- las lineas de campo magnético tienen a vedces extremos. Sin embargo, las complicaciones tienen una influencia despreciable sobre el resultado de los experimentos cuando los sistmas se mueven., con relación al espacio absoluto, a velocidades pequeñas comparadasd con la de la luz; entonces casi nuinguna linea de campo tiene extremos. Sólo a velocidades que se aproximan a la de la luz era previsible que las feas complicaciones tuvierqan una influencia suficientemente grande como para ser medidas con facilidad: montenes de extremos. De este modo, eera razonable sospechar, incluso en ausencia del experimento de Michelson-Morley, que el dominio de validez de la física newtoniana podría ser el de las velocidades pequeñas comparadas con la de la Luz, y que las leyes newtonianas podrían venirse abajo a velocidades cercanas a la de la luz.

El LHC es un esfuerzo internacional, donde participan alrededor de siete mil físicos de 80 países. Consta de un túnel en forma de anillo, con dimensiones interiores parecidas a las del metro subterráneo de la Ciudad de México, y una circunferencia de 27 kilómetros. Está ubicado entre las fronteras de Francia y Suiza, cerca de la ciudad de Ginebra, a profundidades que van entre los 60 y los 120 metros debido a que una parte se encuentra bajo las montañas del Jura.

Claro que, hablando de lo quen nos ocupa, al contemplar la secuencia anterior de conjuntos de leyes (física newtoniana, relativisdata especial, relativista general, gravedad cuántica), y una secuencia similar de leyes que gobiernan la estructura de la materia y las partículas elementales, la mayoría de los físicos tienen a creer que estas secuencias están convergiendo hacia un conjunto de leyes últimas que verdaderamente gobiernan el Universo, leyes que obligan al Universo a mostrarse como es y comportarse como nosotros vemos que lo hace, que obligan a la lluvia a condensarse en las cristaleras de las ventanas, obliga al Sol a quemar combistible nuclear para convertir lo elemental y sencillo en más complejo que, más tasrde tendrá su función determinada, obliga a los agujeros negros a producir ondas gravitatorias cuando colisionan entre ellos, a que las estrellas masivas, al final de sus vidas explotan como supernovas para formar hermosas Nebulosas y conformar nuevos objetos masivos como púlsares, estrellas de neutrones y agujeros negros… Y, por eso…

¡La Gravedad! Siempre está presente e incide en los comportamientos de la materia

Todo esto ha podido ser comprendido con el paso del tiempo y a medida que se sumaban los descubrimientos y los pensamientos de unos y otros, y, por ejemplo, Einstein también concluyó que si un cuerpo pierde una energía L, su masa disminuye en L/c2. Einstein generalizó esta conclusión al importante postulado de que la masa de un cuerpo es una medida de su contenido en energía, de acuerdo con la ecuación m=E/c2 ( o la más popular E=mc2).

Otras de las conclusiones de la teoría de Einstein en su modelo especial, está en el hecho de que para quien viaje a velocidades cercanas a c (la velocidad de la luz en el vacío), el tiempo transcurrirá más lento. Dicha afirmación también ha sido experimentalmente comprobada.

Todos estos conceptos, por nuevos y revolucionarios, no fueron aceptados por las buenas y en un primer momento, algunos físicos no estaban preparados para comprender cambios tan radicales que barrían de un plumazo, conceptos largamente arraigados.

Todo lo grande está hecho de cosas pequeñas

Claro que, podríamos objetar que, cada conjunto de leyes en la secuencia “tiene un aspecto” muy diferente del conjunto precedente. (Por ejemplo, el tiempo absoluto de la física newtoniana tiene un aspecto muy diferente de los muchos flujos de tiempos diferentes de la relatividad especial.) ¿Por qué, entonces, deberíamos esperar una convergencia? La respuesta es que hay que distinguir claramente entre las predicciones hechas a partir de un conjunto de leyes y las imágenes mentales que las leyes transmiten (lo que las leyes “aparentan”). Yo espero la convergencia en términos de predicciones, pero esto es todo lo que finalmente cuenta. Las Imágenes mentales (un tiempo absoluto en la Física newtoniana frente a los muchos flujos de tiempo en la física relativista) no son importantes para la naturaleza última de la realidad.

Se podría objetar que cada conjunto de leyes en la secuencia, tiene su propio su aspecto y que, no tienen porque converger. El mismo conjunto de leyes de Newton tiene un aspecto muy diferente de los muchos flujos de tiempos diferentes de la relatividad especial. En los aspectos de las leyes no existe ningún tipo de convergencia y, desde luego, las caracteristicas de cada conjunto de leyes, aunque sean diferentes, no son importantes esas diferencias para el resulta último final de la realidad última a la que la Naturaleza quiere llegar.

Un agujero negro es lo definitivo en distorsión espaciotemporal, según las ecuaciones de Einstein: está hecho única y exclusivamente a partir de dicha distorsión. Su enorme distorsión está causada por una inmensa cantidad de energía compactada: energía que reside no en la materia, sino en la propia distorsión. La distorsión genera más distorsión sin la ayuda de la materia. Esta es la esencia del agujero negro.

En cuanto al espacio y el tiempo, tenemos que Hermann Mynkowski los unificaba el espacio y Einstein los distorsionaba mediante la fuerza gravitatoria.

“Las ideas de espacio u tiempo que deseo exponer ante ustedes han brotado del suelo de la física experimental, y en ello reside su fuerza. Son radicales. En lo sucesio, el espacio por sí mismo, y el tiempo por sí mismo, están condenados a desvanecerse en meras sombras, y sólo un tipo de unión de ambos conservará una realidad independiente: ¡El Espaciotiempo!”

Con esas palabras proféticas Minkiwski reveló al mundo, en septiembre de 1908, un nuevo descuberimiento sobre la naturaleza del espacio y el tiempo. Einstein había demostrado que el espacio u el tiempo eran “relativos”. La longitud de un objeto y el flujo del tiempo eran diferentes cuando se miran desde diferentes sistemas de referencia.

Minkouski comprendió, de manera perfecta, la profundidad y el verdadero mendaje que la teoría de Eisntein llevaba consigo y, habiéndola entendido a la pefección, le expuso al mundo el nacimiento del espaciotiempo: Ambos, Tiempo y Espacio conformados como un todo.

Hay una historia (adaptada de Tauylor y Wheeler (1992) que ilusta la idea subyacente al descubrimiento de Minkowski pero, la dejaré para otra ocasión. El tema de las leyes de Newton, las dos versiones relativistas y la no hallada gravedad cuántica, nos daría para glunos abultados tomos que, no pueden ser escritos aquí

emilio silvera

Totales: 83.835.298

Totales: 83.835.298 Conectados: 34

Conectados: 34