Oct

22

Riemann y Euclides

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (26)

Comments (26)

La ruptura decisiva con la geometría euclidiana llegó cuando Gauss pidió a su discípulo Riemann que preparara una presentación oral sobre los “fundamentos de la geometría”. Gauss estaba muy interesado en ver si su discípulo podía desarrollar una alternativa a la geometría de Euclides.

Riemann desarrolló su teoría de dimensiones más altas.

Finalmente, cuando hizo su presentación oral en 1.854, la recepción fue entusiasta. Visto en retrospectiva, esta fue, sin discusión, una de las conferencias públicas más importantes en la historia de las matemáticas. Rápidamente se entendió por toda Europa la noticia de que Riemann había roto definitivamente los límites de la geometría de Euclides que había regido las matemáticas durante dos milenios.

Riemann creó su tensor métrico para que, a partir de ese momento, otros dispusieran de una poderosa herramienta que les hacía posible expresarse, a partir del famoso teorema de Pitágoras (uno de los grandes descubrimientos de los griegos en matemáticas que establece la relación entre las longitudes de los tres lados de un triángulo rectángulo: afirma que la suma de los cuadrados de los lados menores es igual al cuadrado del lado mayor, la hipotenusa; es decir, si a y b son los longitudes de los dos catetos, y c es la longitud de la hipotenusa, entonces a2 + b2 = c2. El teorema de Pitágoras, por supuesto, es la base de toda la arquitectura; toda estructura construida en este planeta está basada en él. Claro que, es una herramienta para utilizar en un mundo tridimensional).

Oct

21

Buscando la Gravedad cuántica

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (4)

Comments (4)

Entre los teóricos, el casamiento de la relatividad general y la teoría cuántica es el problema central de la física moderna. A los esfuerzos teóricos que se realizan con ese propósito se les llama “supergravedad”, “súpersimetría”, “supercuerdas” “teoría M” o, en último caso, “teoría de todo o gran teoría unificada”.

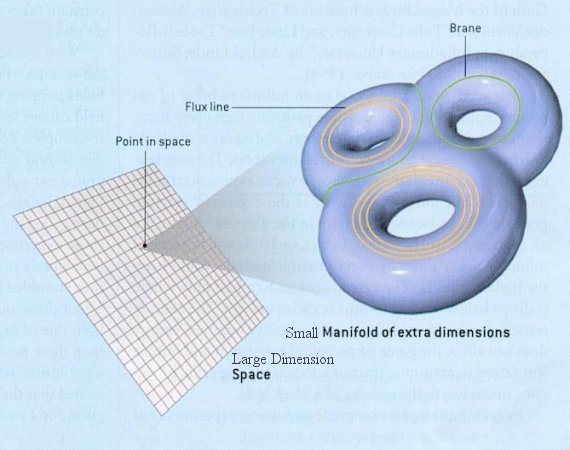

Ahí tenemos unas matemáticas exóticas que ponen de punta hasta los pelos de las cejas de algunos de los mejores matemáticos del mundo (¿y Perelman? ¿Por qué nos se ha implicado?). Hablan de 10, 11 y 26 dimensiones, siempre, todas ellas espaciales menos una que es la temporal. Vivimos en cuatro: tres de espacio (este-oeste, norte-sur y arriba-abajo) y una temporal. No podemos, ni sabemos o no es posible instruir, en nuestro cerebro (también tridimensional), ver más dimensiones. Pero llegaron Kaluza y Klein y compactaron, en la longitud de Planck las dimensiones que no podíamos ver. ¡Problema solucionado!

¿Quién puede ir a la longitud de Planck para verlas?

Ni vemos la longitud de Planck ni las dimensiones extra

La puerta de las dimensiones más altas quedó abierta y, a los teóricos, se les regaló una herramienta maravillosa. En el Hiperespacio, todo es posible. Hasta el matrimonio de la relatividad general y la mecánica cuántica, allí si es posible encontrar esa soñada teoría de la Gravedad cuántica.

Así que, los teóricos, se han embarcado a la búsqueda de un objetivo audaz: buscan una teoría que describa la simplicidad primigenia que reinaba en el intenso calor del universo en sus primeros tiempos, una teoría carente de parámetros, donde estén presentes todas las respuestas. Todo debe ser contestado a partir de una ecuación básica.

¿Dónde radica el problema?

Nuestro es tridimensional y no podemos ver otro más allá… ¡si existe!

El problema está en que la única teoría candidata no tiene conexión directa con el mundo de la observación, o no lo tiene todavía si queremos expresarnos con propiedad. La energía necesaria para ello, no la tiene ni el nuevo acelerador de partículas LHC que con sus 14 TeV no llegaría ni siquiera a vislumbrar esas cuerdas vibrantes de las que tanto se habla.

La verdad es que, la teoría que ahora tenemos, el Modelo Estándar, concuerda de manera exacta con todos los datos a bajas energías y contesta cosas sin sentido a altas energías.

Con sus 20 parámetros aleatorios (parece que uno de ellos ha sido hallado -el bosón de Higgs-), el Modelo estándar de la f´çisica de partículas que incluye sólo tres de las interacicones fundamentales -las fuerzas nucleares débil y fuerte y el electromagnetismo-, ha dado un buen resultado y a permitido a los físicos trabajar ampliamente en el conocimiento del mundo, de la Naturaleza, del Universo. Sin embargo, deja muchas preguntas sin contestar y, lo cierto es que, se necesitan nuevas maneras, nuevas formas, nuevas teorías que nos lleven más allá.

¡Necesitamos algo más avanzado!

Se ha dicho que la función de la partícula de Higgs es la de dar masa a las partículas que conocemos y están incluidas en el Modelo estándar, se nos ha dicho que ha sido encontrada pero, nada se ha dicho de cómo ésta partícula transmite la masa a las demás. Faltan algunas explicaciones.

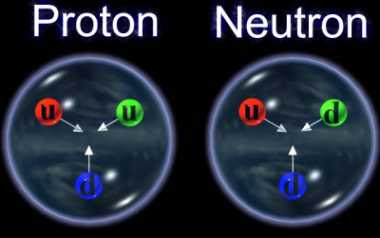

El secreto de todo radica en conseguir la simplicidad: el átomo resulto ser complejo lleno de esas infinitesimales partículas electromagnéticas que bautizamos con el nombre de electrones, resultó que tenía un núcleo que contenía, a pesar de ser tan pequeño, casi toda la masa del átomo. El núcleo, tan pequeño, estaba compuesto de otros objetos más pequeños aún, los quarks que estaban instalados en nubes de otras partículas llamadas gluones y, ahora, queremos continuar profundizando, sospechamos, que después de los quarks puede haber algo más.

¿Acaso las partículas circulan por el campo de Higgs y se ven frenadas por éste que les adosa la masa?

Bueno, la idea nueva que surgió es que el espacio entero contiene un campo, el campo de Higgs, que impregna el vacío y es el mismo en todas partes. Es decir, que si miramos a las estrellas en una noche clara estamos mirando el campo de Higgs. Las partículas influidas por este campo, toman masa. Esto no es por sí mismo destacable, pues las partículas pueden tomar energía de los campos (gauge) de los que hemos comentado, del campo gravitatorio o del electromagnético. Si llevamos un bloque de plomo a lo alto de la Torre Eiffel, el bloque adquiriría energía potencial a causa de la alteración de su posición en el campo gravitatorio de la Tierra.

Como E=mc2, ese aumento de la energía potencial equivale a un aumento de la masa, en este caso la masa del Sistema Tierra-bloque de plomo. Aquí hemos de añadirle amablemente un poco de complejidad a la venerable ecuación de Einstein. La masa, m, tiene en realidad dos partes. Una es la masa en reposo, m0, la que se mide en el laboratorio cuando la partícula está en reposo. La partícula adquiere la otra parte de la masa en virtud de su movimiento (como los protones en el acelerador de partículas, o los muones, que aumentan varias veces su masa cuando son lanzados a velocidades cercanas a c) o en virtud de su energía potencial de campo. Vemos una dinámica similar en los núcleos atómicos. Por ejemplo, si separamos el protón y el neutrón que componen un núcleo de deuterio, la suma de las masas aumenta.

Peor la energía potencial tomada del campo de Higgs difiere en varios aspectos de la acción de los campos familiares. La masa tomada de Higgs es en realidad masa en reposo. De hecho, en la que quizá sea la versión más

apasionante de la teoría del campo de Higgs, éste genera toda la masa en reposo. Otra diferencia es que la cantidad de masa que se traga del campo es distinta para las distintas partículas.

Los teóricos dicen que las masas de las partículas de nuestro modelo estándar miden con qué intensidad se acoplan éstas al campo de Higgs.

La influencia de Higgs en las masas de los quarks y de los leptones, nos recuerda el descubrimiento por Pieter Zeeman, en 1.896, de la división de los niveles de energía de un electrón cuando se aplica un campo magnético al átomo. El campo (que representa metafóricamente el papel de Higgs) rompe la simetría del espacio de la que el electrón disfrutaba.

Hasta ahora no tenemos ni idea de que reglas controlan los incrementos de masa generados por el Higgs (de ahí la expectación creada por el nuevo acelerador de partículas LHC). Pero el problema es irritante: ¿por qué sólo esas masas –Las masas de los W+, W–, y Zº, y el up, el down, el encanto, el extraño, el top y el bottom, así como los leptones – que no forman ningún patrón obvio?

No dejamos de experimentar para saber ccómo es nuestro mundo, la Naturaleza, el Universo que nos acoge

Las masas van de la del electrón 0’0005 GeV, a la del top, que tiene que ser mayor que 91 GeV. Deberíamos recordar que esta extraña idea (el Higgs) se empleó con mucho éxito para formular la teoría electrodébil (Weinberg-salam). Allí se propuso el campo de Higgs como una forma de ocultar la unidad de las fuerzas electromagnéticas y débiles. En la unidad hay cuatro partículas mensajeras sin masa –los W+, W–, Zº y fotón que llevan la fuerza electrodébil. Además está el campo de Higgs, y, rápidamente, los W y Z chupan la esencia de Higgs y se hacen pesados; el fotón permanece intacto. La fuerza electrodébil se fragmenta en la débil (débil porque los mensajeros son muy gordos) y la electromagnética, cuyas propiedades determina el fotón, carente de masa. La simetría se rompe espontáneamente, dicen los teóricos. Prefiero la descripción según la cual el Higgs oculta la simetría con su poder dador de masa.

Las masas de los W y el Z se predijeron con éxito a partir de los parámetros de la teoría electrodébil. Y las relajadas sonrisas de los físicos teóricos nos recuerdan que Gerard ^t Hooft y Veltman dejaron sentado que la teoría entera esta libre de infinitos.

En esta última dirección ha publicado numerosos libros y artículos, donde aborda la asignatura pendiente de la unificación de la mecánica cuántica y la teoría del campo gravitatorio. El camino que ha seguido Penrose es encontrar una base común a ambas.

Para ello ha introducido dos modelos: los “spin networks” y los “twistors”, el primero discreto, con una métrica intrínseca, no relativista, previo al concepto de espacio, el segundo continuo, con una métrica extrínseca, relativista e inmerso en un espacio-tiempo dado.

Claro que son varias las corrientes que quieren abrirse camino hacia otras físicas nuevas.

La teoría de supercuerdas tiene tantas sorpresas fantásticas que cualquiera que investigue en el tema reconoce que está llena de magia. Es algo que funciona con tanta belleza… Cuando cosas que no encajan juntas e incluso se repelen, si se acerca la una a la otra alguien es capaz de formular un camino mediante el cual, no sólo no se rechazan, sino que encajan a la perfección dentro de ese sistema, como ocurre ahora con la teoría M que acoge con naturalidad la teoría de la relatividad general y la teoría mecánico-cuántica; ahí, cuando eso se produce, está presente la belleza.

Lo que hace que la teoría de supercuerdas sea tan interesante es que el marco estándar mediante el cual conocemos la mayor parte de la física es la teoría cuántica y resulta que ella hace imposible la gravedad. La relatividad general de Einstein, que es el modelo de la gravedad, no funciona con la teoría cuántica. Sin embargo, las supercuerdas modifican la teoría cuántica estándar de tal manera que la gravedad no sólo se convierte en posible, sino que forma parte natural del sistema; es inevitable para que éste sea completo.

¿Por qué es tan importante encajar la gravedad y la teoría cuántica? Porque no podemos admitir una teoría que explique las fuerzas de la naturaleza y deje fuera a una de esas fuerzas. Así ocurre con el Modelo Estándar que deja aparte y no incluye a la fuerza gravitatoria que está ahí, en la Naturaleza.

La teoría de supercuerdas se perfila como la teoría que tiene implicaciones si tratamos con las cosas muy pequeñas, en el microcosmos; toda la teoría de partículas elementales cambia con las supercuerdas que penetra mucho más; llega mucho más allá de lo que ahora es posible.

La topología es, el estudio de aquellas propiedades de los cuerpos geométricos que permanecen inalteradas por transformaciones continuas. La topología es probablemente la más joven de las ramas clásicas de las matemáticas. En contraste con el álgebra, la geometría y la teoría de los números, cuyas genealogías datan de tiempos antiguos, la topología aparece en el siglo diecisiete, con el nombre de analysis situs, ésto es, análisis de la posición.

De manera informal, la topología se ocupa de aquellas propiedades de las figuras que permanecen invariantes, cuando dichas figuras son plegadas, dilatadas, contraídas o deformadas, de modo que no aparezcan nuevos puntos, o se hagan coincidir puntos diferentes. La transformación permitida presupone, en otras palabras, que hay una correspondencia biunívoca entre los puntos de la figura original y los de la transformada, y que la deformación hace corresponder puntos próximos a puntos próximos. Esta última propiedad se llama continuidad, y lo que se requiere es que la transformación y su inversa sean ambas continuas: así, trabajarnos con homeomorfismos.

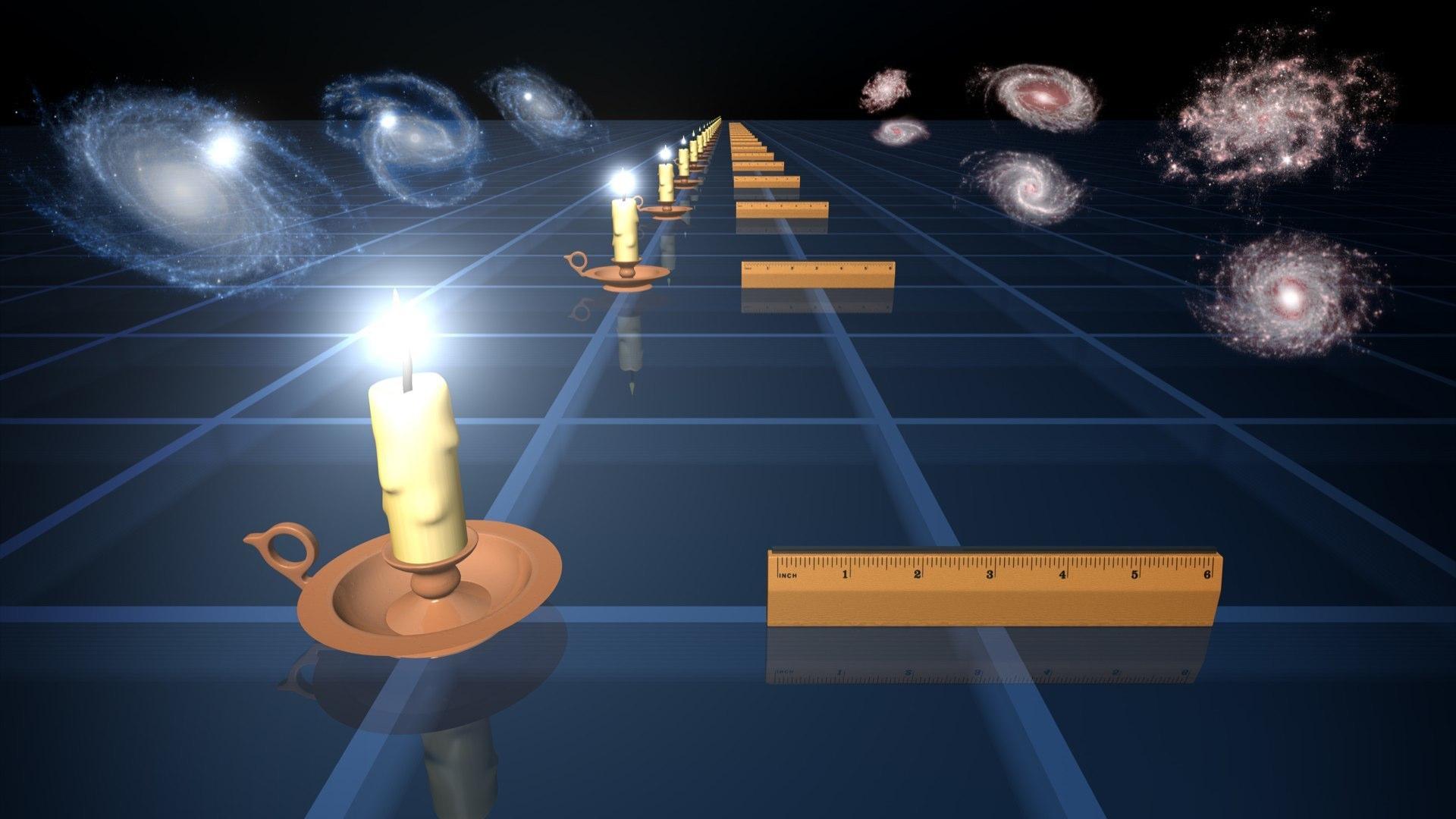

En cuanto a nuestra comprensión del universo a gran escala (galaxias, el Big Bang…), creo que afectará a nuestra idea presente, al esquema que hoy rige y, como la nueva teoría, el horizonte se ampliará enormemente; el cosmos se presentará ante nosotros como un todo, con un comienzo muy bien definido y un final muy bien determinado.

Para cuando eso llegue, sabremos lo que es, como se genera y dónde están situados los orígenes de esa “fuerza”, “materia”, o, “energía” que ahora no sabemos ver para explicar el movimiento de las galaxias o la expansión del espacio mismo.

emilio silvera

Oct

19

¡La Física! Que en su apartado cuántico…¡es extraña!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

Sí, muy extraña pero…funciona. Cuando nos sumergimos en el mundo cuántico somos conscientes de que todo ese mundo fantástico de lo muy pequeño va contra la intuición, en nada se parece a nuestro mundo macroscópico y, allí, suceden cosas que nos parecen imposibles. Allí, en el “universo cuántico” se sustituye la continuidad por lo discreto. Se podría decir que no es el agua compacta que forma un todo, sino que, es como la fina arena que está formada por muchos granos que logran pasar desapercibidos en ese conjunto total.

¿Cómo podríamos suponer el carácter fantasmagórico del experimento de la doble rendija?

“El experimento de Young, también denominado experimento de la doble rendija, fue realizado en 1801 por Thomas Young, en un intento de discernir sobre la naturaleza corpuscular u ondulatoria de la luz. Young comprobó un patrón de interferencias en la luz procedente de una fuente lejana al difractarse en el paso por dos rejillas, resultado que contribuyó a la teoría de la naturaleza ondulatoria de la luz.

Posteriormente, la experiencia ha sido considerada fundamental a la hora de demostrar la dualidad onda corpúsculo, una característica de la mecánica cuántica. El experimento también puede realizarse con electrones, protones o neutrones, produciendo patrones de interferencia similares a los obtenidos cuando se realiza con luz.”

Otro fenómeno que va contra la intuición es el “efecto túnel”. Los electrones son capaces de atravesar un túnel a través de una barrera de potencial estrecha hacia una región que estaría prohibida si los electrones fuesen tratados como partículas clásicas. El que haya una probabilidad finita de que un electrón haga un túnel entre una región clásicamente permitida a otra surge como consecuencia de la mecánica cuántica. El efecto túnel es usado en el diodo túnel. La desintegración alfa es un ejemplo de proceso de efecto túnel.

Nuestra descripción de lo que les pasa a los electrones que se dirigren hacia una barrera de energía o a un electrón atrapado entre dos barreras debe tener en cuenta las ondas probabilistas. Hay una probabilidad finita de que la partícula atrapada aparezca fuera de la trampa. Esto no sólo va contra la intuición, sino que se puede considerar una paradoja de orden mayor, pues el electrón a su paso por la barrera debía tener una energía cinética negativa, lo que, desde el punto de vista clásico, es absurdo.

Claro que, cuando se desarrolla la intuición cuántica, uno puede responder que la condición de que el electrón “esté en el túnel” no mes aobservable y por lo tanto no es un problema de la física. Lo que uno observa es que se sale fuera. Este fenómeno, el paso por efecto túnel, se utilizó (como ya he dicho) para explicar la radiactividad Alfa. Por fantasmagórico que sea, este “efecto túnel” les es esencial a los ordenadores modernos y a otros muchos dispositivos electrónicos.

Partículas puntuales, paso por efecto túnel, radiactividad, la tortura de la rendija doble: todo esto contribuyó a las nuevas intuiciones que los físicos cuánticos necesitaron a medida que fue posible desplegar todo su armamento intelectual a la búsqueda de fenómenos inexplicables.

Todo son átomos: Los mundos con sus ríos y montañas, los seres vivos, las estrellas y las galaxias, todo sin excepción… ¡átomos! Y, lo sorprendente es que, nosotros, hayamos podido llegar tan lejos y conocer lo que la materia es (al menos en parte), poder dilucidar entre esos dos “universo” de lo grande y lo pequeño.

Gracias a los acontecimientos que están recogidos en el período que va desde 1923 a 1927, se pudo comprender el átomo. Aún así, en esos días previos a los ordenadores, sólo se podían utilizar adecuadamente los átomos simples -el hidrógeno, el helio, el litio y los átomos a los que se les han quitado algunos electrones (ionizado)-. Aquí, no cabe más remedio que reconocer el gran avance debido a Wolfgan Pauli, él entendió la mecánica cuántica desde muy joven, con 19 años ya era todo un experto y supo, intuir, dónde estaba la “materia perdida”.

Los físicos se vieron durante mucho tiempo turbados por el hecho de que a menudo, la partícula beta emitida en una desintegración del núcleo no alberga energía suficiente para compensar la masa perdida por el núcleo. En realidad, los electrones no eran igualmente deficitarios. Emergían con un amplio espectro de energías, y el máximo (conseguido por muy pocos electrones), era casi correcto, pero todos los demás no llegaban a alcanzarlo en mayor o menor grado. Las partículas alfa emitidas por un nucleido particular poseían iguales energías en cantidades inesperadas. En ese caso, ¿qué era errónea en la emisión de partículas beta? ¿Qué había sucedido con la energía perdida?

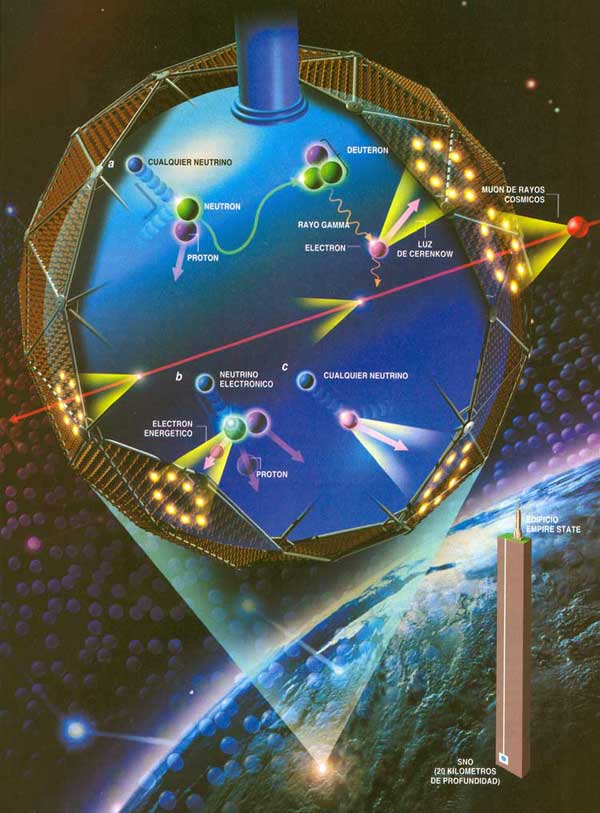

Todo parece indicar que los neutrinos…¡sí tienen masa!

En 1.922, Lise Maitner se hizo por primera vez esta pregunta, y, hacia 1.930, Niels Bohr estaba dispuesto a abandonar el gran principio de conservación de la energía, al menos en lo concerniente a partículas subatómicas. En 1.931, Wolfgang Pauli sugirió una solución para el enigma de la energía desaparecida.

Tal solución era muy simple: junto con la partícula beta del núcleo se desprendía otra, que se llevaba la energía desaparecida. Esa misteriosa segunda partícula tenía propiedades bastante extrañas. No poseía carga ni masa. Lo único que llevaba mientras se movía a la velocidad de la luz era cierta cantidad de energía. A decir verdad, aquello parecía un cuerpo ficticio creado exclusivamente para equilibrar el contraste de energías.

Sin embargo, tan pronto como se propuso la posibilidad de su existencia, los físicos creyeron en ella ciegamente. Y esta certeza se incrementó al descubrirse el neutrón y al saberse que se desintegraba en un protón y se liberaba un electrón, que, como en la decadencia beta, portaba insuficientes cantidades de energía. Enrico Fermi dio a esta partícula putativa el nombre de “neutrino”, palabra italiana que significa “pequeño neutro”.

“Las partículas gamma son radiaciones electromagnéticas de la misma naturaleza que los rayos X pero de menor longitud de onda. Su poder de penetración es muy elevado frente al de las partículas alfa o beta, pudiendo atravesar el cuerpo humano. Quedan frenadas con espesores de 1 m de hormigón o unos pocos cm de plomo, por lo que cuando se utilizan fuentes radiactivas que emiten este tipo de radiación, hay que utilizar blindajes adecuados.”

Pero sigamos con nuestro trabajo de hoy. El neutrón dio a los físicos otra prueba palpable de la existencia del neutrino. Como ya he comentado en otras ocasiones, casi todas las partículas describen un movimiento rotatorio. Esta rotación se expresa, más o menos, en múltiples de una mitad según la dirección del giro. Ahora bien, el protón, el neutrón y el electrón tienen rotación de una mitad. Por tanto, si el neutrón con rotación de una mitad origina un protón y un electrón, cada uno con rotación de una mitad, ¿qué sucede con la ley sobre conservación del momento angular? Aquí hay algún error. El protón y el electrón totalizan una mitad con sus rotaciones (si ambas rotaciones siguen la misma dirección) o cero (si sus rotaciones son opuestas); pero sus rotaciones no pueden sumar jamás una mitad. Sin embargo, por otra parte, el neutrino viene a solventar la cuestión.

Supongamos que la rotación del neutrón sea +½. Y admitamos también que la rotación del protón sea +½ y la del electrón -½, para dar un resultado neto de o. Demos ahora al neutrino una rotación de +½, y la balanza quedará equilibrada.

+½(n)=+½(p)-½(e)+½(neutrino)

Pero aun queda algo por equilibrar. Una sola partícula (el neutrón) ha formado dos partículas (el protón y el electrón), y, si incluimos el neutrino, tres partículas. Parece más razonable suponer que el neutrón se convierte en dos partículas y una antipartícula. En otras palabras: lo que realmente necesitamos equilibrar no es un neutrino, sino un antineutrino.

“25 noviembre 2011. Físicos investigadores trabajando en el experimento Double Chooz han detectado la desaparición de antineutrinos electrónicos durante su recorrido desde el núcleo de los reactores hasta el detector situado a algo mas de 1 Km de distancia.

Este resultado, que ha sido presentado en la Conferencia LowNu de Seul, en Corea, servirá para determinar el valor del hasta ahora desconocido ángulo de mezcla q13, que es un parametro fundamental con importantes implicaciones para la física de partículas y de astropartículas.”

Pero sigamos con lo nuestro. El propio neutrino surgiría de la conversación de un protón en un neutrón. Así, pues, los productos serían un neutrón (partícula), un positrón (antipartícula) y un neutrino (partícula). Esto también equilibra la balanza.

En otras palabras, la existencia de neutrinos y antineutrinos debería salvar no una, sino tres, importantes leyes de conservación: la conservación de la energía, la de conservación del espín y la de conservación de partícula/antipartícula.

Es importante conservar esas leyes puesto que parece estar presentes en toda clase de reacciones nucleares que no impliquen electrones o positrones, y sería muy útil si también se hallasen presentes en reacciones que incluyesen esas partículas.

Las más importantes conversiones protón–neutrón son las relaciones con las reacciones nucleares que se desarrollan en el Sol y en los astros. Por consiguiente, las estrellas emiten radiaciones rápidas de neutrinos, y se calcula que tal vez pierdan a causa de esto el 6 u 8 % de su energía. Pero eso, sería meternos en otra historia y, por mi parte, con la anterior explicación solo trataba de dar una muestra del ingenio del hombre que, como habréis visto, no es poco.

Desde que puedo recordar, he sido un amante de la Física. Me asombran cuestiones como la luz, su naturaleza de un conglomerado de colores, ondas y partículas, su velocidad que nos marca el límite del máximo que podemos correr en nuestro Universo, y en fin, muchos otros misterios que encierra esa cosa tan cotidiana que nos rodea y lo inunda todo haciendo posible que podamos ver por donde vamos, que las plantas vivan y emitan oxígeno o que nos calentemos. Realmente, sin luz, nuestra vida no sería posible.

Entonces, ¿qué es realmente la luz?

Sí, hemos llegado a saber muchas cosas pero… lo que realmente es la luz…queda lejos aún

Generalmente es sabido que “todos” opinan que la luz, es algo inmaterial. Los objetos materiales, grandes o muy pequeños como las galaxias o los electrones, son materia. La luz, sin embargo, se cree que es inmaterial, dos rayos de luz se cruzan sin afectarse el uno al otro. Sin embargo, yo opino que la luz es simplemente una forma de energía lumínica, otra forma en la que se puede presentar la materia. Ya nos lo dijo Einstein: E = mc2, y, si materia es energía y energía materia… ¿qué es el fotón?

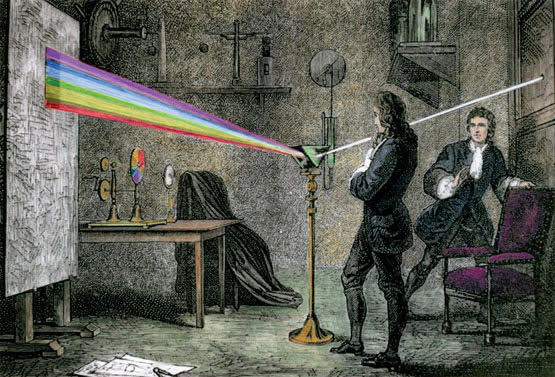

Está claro que, los estudiosos de la época antigua y medieval estaban por completo a oscuras acerca de la naturaleza de la luz. Especulaban sobre que consistía en partículas emitidas por objetos relucientes o tal vez por el mismo ojo. Establecieron el hecho de que la luz viajaba en línea recta, que se reflejaba en un espejo con un ángulo igual a aquel con el que el rayo choca con el espejo, y que un rayo de luz se inclina (se refracta) cuando pasa del aire al cristal, al agua o a cualquier otra sustancia transparente.

Cuando la luz entra en un cristal, o en alguna sustancia transparente, de una forma oblicua (es decir, en un ángulo respecto de la vertical), siempre se refracta en una dirección que forma un ángulo menor respecto de la vertical. La exacta relación entre el ángulo original y el ángulo reflejado fue elaborada por primera vez en 1.621 por el físico neerlandés Willerbrord Snell. No publicó sus hallazgos y el filósofo francés René Descartes descubrió la ley, independientemente, en 1.637.

Los primeros experimentos importantes acerca de la naturaleza de la luz fueron llevados a cabo por Isaac Newton en 1.666, al permitir que un rayo de luz entrase en una habitación oscura a través de una grieta e las persianas, cayendo oblicuamente sobre una cara de un prisma de cristal triangular. El rayo se refracta cuando entra en el cristal y se refracta aún más en la misma dirección cuando sale por una segunda cara del prisma. (Las dos refracciones en la misma dirección se originan por que los dos lados del prisma de se encuentran en ángulo en vez de en forma paralela, como sería el caso en una lámina ordinaria de cristal.)

Newton atrapó el rayo emergente sobre una pantalla blanca para ver el efecto de la refracción reforzada. Descubrió que, en vez de formar una mancha de luz blanca, el rayo se extendía en una gama de colores: rojo, anaranjado, amarillo, verde, azul, y violeta, en este orden.

Newton dedujo de ello que la luz blanca corriente era una mezcla de varias luces que excitaban por separado nuestros ojos para producir las diversas sensaciones de colores. La amplia banda de sus componentes se denominó spectrum (palabra latina que significa “espectro” fantasma). Newton llegó a la conclusión de que la luz se componía de diminutas partículas (“corpúsculos”), que viajaban a enormes velocidades.

Le surgieron y se planteó algunas inquietudes cuestiones. ¿Por qué se refractaban las partículas de luz verde más que los de luz amarilla? ¿Cómo se explicaba que dos rayos de luz se cruzaran sin perturbase mutuamente, es decir, sin que se produjeran colisiones entre partículas?

En 1.678, el físico neerlandés christian Huyghens (un científico polifacético que había construido el primer reloj de péndulo y realizado importantes trabajos astronómicos. Hoy, la sonda en Titán, lleva su nombre) propuso una teoría opuesta: la de que la luz se componía de minúsculas ondas. Y si sus componentes fueran ondas, no sería difícil explicar los diversos difracciones de los diferentes tipos de luz a través de un medio refractante, siempre y cuando se aceptara que la luz se movía más despacio en ese medio refractante que en el aire. La cantidad de refracción variaría con la longitud de las ondas: cuanto más corta fuese tal longitud, tanto mayor sería la refracción. Ello significaba que la luz violeta (la más sensible a este fenómeno) debía de tener una longitud de onda mas corta que la luz azul, ésta, más corta que la verde, y así sucesivamente.

Lo que permitía al ojo distinguir los colores eran esas diferencias entre longitudes de onda. Y, como es natural, si la luz estaba integrada por ondas, dos rayos podrían cruzarse sin dificultad alguna. (Las ondas sonoras y las del agua se cruzan continuamente sin perder sus respectivas identidades.)

Pero la teoría de Huyqhens sobre las ondas tampoco fue muy satisfactoria. No explicaba por qué se movían en línea recta los rayos luminosos; ni por qué proyectaban sobras recortadas; ni aclaraba por qué las ondas luminosas no podían rodear los obstáculos, del mismo modo que pueden hacerlo las ondas sonoras y de agua. Por añadidura, se objetaba que si la luz consistía en ondas, ¿cómo podía viajar por el vacío, ya que cruzaba el espacio desde el Sol y las Estrellas? ¿Cuál era esa mecánica ondulatoria?

Muchos otros han tratado de profundizar en la naturaleza de la Luz, y, aunque sabemos bastante de ella, no por eso podemos decir a ciencia cierta: ¡Sabemos lo que la luz es!, ya que, la Naturaleza, escondealgunos secretos que tenemos que desvelar y, al igual que nos pasa con nuestras mentes, no hemos podido resolver el problema, principalmente, porque nosotros somos parte integrante de él:

¡Somos Universo, Somos luz, Somos Pensamientos!

Pero, ¿no estaba hablando de los extraños fenómenos de la mecánica cuántica? No puedo remediarlo, veo pasar una idea por delante de mi mente y…la sigo. Como nos decía el inolvidable Richard Feyman;

“Creo que es justo decir que nadie comprende la mecánica cuántica. No siga diciéndose a sí mismo, si puede evitarlo, “¿pero cómo puede ser así?” porque usted se meterá “hasta el fondo” en un callejón sin salida del que nadie ha escapado. Nadie sabe como puede ser eso”. De hecho, a menudo se ha dicho que de todas las teorías propuestas en el siglo XX, la más absurda es la teoría cuántica. Algunos dicen que la única cosa que la teoría tiene a su favor es que “es indudablemente correcta”.

La física cuántica empezó a enseñarnos que no debemos estar tan seguros de las reglas del espacio y del tiempo, que hasta ese entonces parecían muy confiables e invariables.

Hace algún tiempo que salió la noticia un descubrimiento en la universidad de Oxford que confirma una polémica teoría sobre el espacio y el tiempo. La teoría de los Muchos Mundos, presentada a la comunidad científica hace exactamente 50 años, proponía que existen un número infinito de realidades: una para cada posible escenario producto de cada decisión que cada ser viviente toma en cada momento de su vida.

Esto nos lleva a un escenario con tantos universos como decisiones e interacciones posibles, multiplicado por tantos seres vivientes como existan. La teoría de los Muchos Mundos se planteó como una respuesta al extraño comportamiento que tiene la materia a nivel subatómico. En la primera mitad del siglo XX la ciencia permitió por primera vez observar lo muy pequeño, y la realidad a ese nivel dejó perplejos a los científicos.

En esas dimensiones hay paradojas que chocan contra el sentido común, como por ejemplo el hecho de que una partícula subatómica puede estar en dos sitios al mismo tiempo. Esta revista puede estar en sus manos o en el librero, pero no puede estar en sus manos y en el librero al mismo tiempo. La física cuántica empezó a enseñarnos que no debemos estar tan seguros de las reglas del espacio y del tiempo, que hasta ese entonces parecían muy confiables e invariables.

Es difícil comprender que podamos estar, al mismo tiempo, en este mundo y en otro mucho más lejano que, situado en otra galaxia, nos pueda estar dando acogida al mismo tiempo que lo hace la Vía Láctea. Sin embargo, en el caso de las partículas subatómicas y, según la extraña mecánica cuántica, eso sería posible.

Sí, amigo Jackie Chan, esto puede volver loco a cualquiera… ¡También a mi!

emilio silvera

Oct

19

La Física es imaginativa

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

Para no viajar muy atrás en el tiempo, fijaremos el punto de partida en 1687, fecha en que salió a la luz la Obra de Newton, sus Principas. El tiempo transcurrió hasta 1900, fecha en la que Planck publicó un artículo de ocho páginas con su idea del cuanto que sería la semilla que daría lugar al nacimiento de la mecánica cuántica. En 1905, aquel joven de la Oficina de Patentes de Berna, sorprendió al mundo de la Física con su Teoría de la Relatividad Especial. Se produjeron muchos desarrollos importantes para nuestras imágenes de la Física Fundamental. Uno de los mayores cambios ocurrido en ese período fue la comprensión, básicamente mediante los trabajos de Faraday y Maxwell en el siglo XIX, de que cierta noción de campo físico, que permea en el espacio, debe cohexistir con la previamente aceptada “realidad newtoniana” de las partículas individuales que interaccionan por medio de fuerzas instantáneas.

Mundos que giran alrededor de una estrella formando sistemas planetarios, galaxias que forman inmensos cúmulos, fuerzas electromagnéticas y de gravedad que hacen posibles fenómenos que ponen en marcha los mecanismos del universo visible y, con su presencia “invisible”, hacen sin embargo posible una serie de resultados físicos que en la vida cotidiana tenemos y constatamos a nuestro alrededor.

La noción de “campo” se convirtió también en un ingrediente crucial de la teoría de la Gravedad en un espaciotiempo curvo a la que llegó Einstein en 1915. Lo que ahora denominamos campos clásicos son el Campo Electromagnético de Maxwell y el Campo Gravitatorio de Einstein.

Estamos inmersos en un Universo regido por cuatro fuerzas fundamentales que hacen posible, entre otras cosas, que estemos aquí.

La presencia del campo gravitatorio de una masa afecta al tiempo y al espacio. La gravedad hace que dos relojes atrasen. Un reloj en la superficie de la Tierra atrasa con respecto a un reloj en la Luna, toda vez que el campo gravitatorio de la Tierra es más potente. De la misma manera, nos podríamos preguntar ¿por qué la gravedad actúa sobre el espacio y alarga el tamaño de los objetos (estirándolos). ¿Dónde podríamos crecer más, si viviéramos en la Tierra o en la Luna?

Pero sigamos. Hoy día sabemos que hay mucho más en la Naturaleza del mundo físico que la sola física clásica. Ya en 1900 -como decimos antes- Max Planck había reveleado los primeros indicios de la necesidad de una “teoría cuántica”, aunque se necesitó un cuarto de siglo más antes de que pudiera ofrecerse una teoría bien formulada y global. También debería quedar claro que, además de todos estos profundos cambios que se han producido en los fundamentos “newtonianos” de la física, ha habido otros desarrollos importantes, tanto previos a dichos cambios como coexistentes con algunos de ellos en forma de poderosos avances matemáticos, dentro de la propia teoría newtoniana.

En 1905 un desconocido Albert Einstein publicaría unos espectaculares estudios sobre la teoría de la relatividad, pero muy pocos científicos, entre ellos Planck, reconocerían inmediatamente la relevancia de esta nueva teoría científica. Tanta fue su importancia que incluso Planck contribuyo a ampliarla.

Pero igualmente, la hipótesis de Einstein sobre la ligereza del quantum (el fotón), basada en el descubrimiento de Philipp Lenard de 1902 sobre el efecto fotoeléctrico fue rechazada por Planck, al igual que la teoría de James Clerk Maxwell sobre la electrodinámica.

En 1910 Einstein desafía la explicación de la física clásica poniendo el ejemplo del comportamiento anómalo del calor específico en bajas temperaturas. Planck y Nernst decidieron organizar la primera Conferencia de Solvay, para clarificar las contradicciones que aparecían en la física. En esta reunión celebrada en Bruselas en 1911, Einstein consiguió convencer a Planck sobre sus investigaciones y sus dudas, lo que hizo forjar una gran amistad entre ambos científicos, y conseguir ser nombrado profesor de física en la universidad de Berlín mientras que Planck fue decano.

Otra área importante de avance sobre la que había que llamar la atención es la termodinámica (y su refinamiento conocido como mecánica estadística). Esta estudia el comportamiento de sistemas de un gran número de cuerpos, donde los detalles de los mocimientos no se consideran importantes y el comportamiento del sistema se describe en términos de promedios de las magnitudes adecuadas. Esta fue una empresa iniciada entre mediados del XIX y principios del XX, y los nombres de Carnot Clausius, Maxwell, Boltzmann, Gibbs y Einstein son los protagonistas.

Termodinámica.- Parte de la física que estudia las relaciones existentes entre los fenómenos dinámicos y los caloríficos. Trata de la transformación de la energía mecánica en calor y del calor en trabajo. También describe y relaciona las propiedades físicas de sistemas macroscópicos de materia y energía. La termodinámica estudia los sistemas que se encuentran en equilibrio. Esto significa que las propiedades del sistema—típicamente la presión, la temperatura, el volumen y la masa— son constantes.

Un concepto esencial de la termodinámica es el de sistema macroscópico, que se define como un conjunto de materia que se puede aislar espacialmente y que coexiste con un entorno infinito e imperturbable. El estado de un sistema macroscópico en equilibrio puede describirse mediante propiedades medibles como la temperatura, la presión o el volumen, que se conocen como variables termodinámicas. Es posible identificar y relacionar entre sí muchas otras variables (como la densidad, el calor específico, la compresibilidad o el coeficiente de expansión térmica), con lo que se obtiene una descripción más completa de un sistema y de su relación con el entorno. Cuando un sistema macroscópico pasa de un estado de equilibrio a otro, se dice que tiene lugar un proceso termodinámico. Las leyes o principios de la termodinámica, descubiertos en el siglo XIX a través de meticulosos experimentos, determinan la naturaleza y los límites de todos los procesos termodinámicos.

¿Cuales son los Principios de la Termodinámica?

Cuando dos sistemas están en equilibrio mutuo, comparten una determinada propiedad. Esta propiedad puede medirse, y se le puede asignar un valor numérico definido. Una consecuencia de ese hecho es el principio cero de la termodinámica, que afirma que si dos sistemas distintos están en equilibrio termodinámico con un tercero, también tienen que estar en equilibrio entre sí. Esta propiedad compartida en el equilibrio es la temperatura. Si uno de estos sistemas se pone en contacto con un entorno infinito situado a una determinada temperatura, el sistema acabará alcanzando el equilibrio termodinámico con su entorno, es decir, llegará a tener la misma temperatura que éste.

Primer Principio.-

La cantidad de calor entregado a un sistema es igual al trabajo realizado por el sistema más la variación de su energía interna. Cuando un sistema se pone en contacto con otro más frío que él, tiene lugar un proceso de igualación de las temperaturas de ambos. Para explicar este fenómeno, los científicos del siglo XVIII conjeturaron que una sustancia que estaba presente en mayor cantidad en el cuerpo de mayor temperatura fluía hacia el cuerpo de menor temperatura. El primer principio es una ley de conservación de la energía. Afirma que, como la energía no puede crearse ni destruirse —dejando a un lado las posteriores ramificaciones de la equivalencia entre masa y energía— la cantidad de energía transferida a un sistema en forma de calor más la cantidad de energía transferida en forma de trabajo sobre el sistema debe ser igual al aumento de la energía interna del sistema. A veces, el primer principio se enuncia como la imposibilidad de la existencia de un móvil perpetuo de primera especie.

Flujo de la energía en los ecosistemas. En los ecosistemas se cumplen pues el primer y segundo principio de la termodinámica.

Segundo Principio.-

El segundo dice que solamente se puede realizar un trabajo mediante el paso del calor de un cuerpo con mayor temperatura a uno que tiene menor temperatura. Al respecto, siempre se observa que el calor pasa espontáneamente de los cuerpos calientes a los fríos hasta quedar a la misma temperatura. La segunda ley afirma que la entropía, o sea, el desorden, de un sistema aislado nunca puede decrecer. Por tanto, cuando un sistema aislado alcanza una configuración de máxima entropía, ya no puede experimentar cambios: ha alcanzado el equilibrio. La naturaleza parece pues ‘preferir’ el desorden y el caos. Puede demostrarse que el segundo principio implica que, si no se realiza trabajo, es imposible transferir calor desde una región de temperatura más baja a una región de temperatura más alta. El segundo principio impone una condición adicional a los procesos termodinámicos. No basta con que se conserve la energía y cumplan así el primer principio. Una máquina que realizara trabajo violando el segundo principio se denomina “móvil perpetuo de segunda especie”, ya que podría obtener energía continuamente de un entorno frío para realizar trabajo en un entorno caliente sin coste alguno. A veces, el segundo principio se formula como una afirmación que descarta la existencia de un móvil perpetuo de segunda especie.

![[espejo.jpg]](http://1.bp.blogspot.com/_RbcHwhHyNUU/ShpFYOgM4zI/AAAAAAAAAYM/_aVI4zFB9pQ/s1600/espejo.jpg)

Tercer principio de termodinámica o principio onfalóscópico, (mirarse el ombligo): La televisión se retroalimenta a sí misma. Se hace televisión para hablar sobre televisión.

Tercer Principio.-

El cero absoluto es el cero en la escala Kelvin, el equivalente a -273,15º C, pero… ¿qué significa? ¿la ausencia de calor? ¿la temperatura más baja posible?

El tercer principio de la termodinámica afirma que el cero absoluto no puede alcanzarse por ningún procedimiento que conste de un número finito de pasos. Es posible acercarse indefinidamente al cero absoluto, pero nunca se puede llegar a él.

Ciclos termodinámicos.-

Todas las relaciones termodinámicas importantes empleadas en ingeniería se derivan del primer y segundo principios de la termodinámica. Resulta útil tratar los procesos termodinámicos basándose en ciclos: procesos que devuelven un sistema a su estado original después de una serie de fases, de manera que todas las variables termodinámicas relevantes vuelven a tomar sus valores originales. En un ciclo completo, la energía interna de un sistema no puede cambiar, puesto que sólo depende de dichas variables. Por tanto, el calor total neto transferido al sistema debe ser igual al trabajo total neto realizado por el sistema. Un motor térmico de eficiencia perfecta realizaría un ciclo ideal en el que todo el calor se convertiría en trabajo mecánico. El científico francés del siglo XIX Sadi Carnot, que concibió un ciclo termodinámico que constituye el ciclo básico de todos los motores térmicos, demostró que no puede existir ese motor perfecto. Cualquier motor térmico pierde parte del calor suministrado. El segundo principio de la termodinámica impone un límite superior a la eficiencia de un motor, límite que siempre es menor del 100%. La eficiencia límite se alcanza en lo que se conoce como ciclo de Carnot.

- Gravitación

- Luz

- Atracción y repulsión eléctricas

- Atracción y repulsión magnéticas

Pero sigamos con el objeto principla de este trabajo del que, como siempre me pasa, me he desviado a la termodinámica (veo pasar una mosca y la sigo). Aquí hablamos de los “campos clásicos” y, sobre las teorías físicas de campos de Maxwell y Einstein: la física “clásica” ¿Cómo pudieron hablar y describir a la perfección suscesos que el ojo no podía ver, y, simplemente con la imaginación, lo hicieron posible, hasta tal punto que, cuando hablamos de campos electromagnéticos o gravitatorios, en nuestras mentes se instalan las imágenes de unos y otros que podemos “ver” con toda precisión.

La teoría del electromagnetismo desempeña también un papel importante en la teoría cuántica, pues proporciona el “campo” arquetípico para el desarrollo posterios de la teoría cuántica de campos. Por el contrario, el enfoque cuántico apropiado del campo gravitatorio sigue siendo enigmático, escurridizo y controvertido y, abordar ahora aquí estas complejas cuestiones, seguramente daría lugar a explicaciones farragosas debido a mi ignorancia profunda en esos conocimientos y a la levedad de los que puedo poseer.

Los campos de fuerza de Faraday han dado lugar a que, la imaginación se desboque y corriendo hacia el futuro, haya imaginado inmensas ciudades que, situadas en lugares imposibles, sostienen sin problema a sus habitantes que, resguardados por un “campo de fuerza” están al resguardo de cualquier peligro que del exterior les pueda venir.

Por ahí arriba me refería al hecho de que ya en el siglo XIX se había iniciado un cambio profundo en los fundamentos newtonianos, antes de las revoluciones de la relatividad y la teoría cuántica en el siglo XX. El primer indicio de que sería necesario un cambio semejante se produjo con los maravillosos descubriumientos experimentales de Faraday (del que hablamos hoy) hacia 1833, y de las representaciones de la realidad que encontró necesarias para acomodar dichos descubrimientos. Básicamente, el cambio fundamental consistió en considerar que las “partículas newtonianas” y las fuerzas” que actúan entre ellas no son los únicos habitantes de nuestro universo.

A partir de ahí había que tomar en serio la idea de un “campo” con una existencia propia incorpórea. Y, fue entonces cuando se produjo la providencial llegada de Maxwell que, al contrario de Faraday, él si entendía bien el complejo mundo de las matemáticas y, en 1864, formuló las ecuaciones que debe satisfacer este “campo” incorpóreo, y quien demostró que estos campos pueden transportar energía de un lugar a otro.

¿ Transmutando energía?

Las ecuaciones de Maxwell unificaban el comportamiento de los campos eléctricos, los campos magnéticos e incluso la luz, y hoy día son conocidas como las ecuaciones de Maxwell, las primeras entre las ecuaciones de campo relativistas. Desde la perspectiva del siglo XX se han hecho profundos cambios y se ha producido profundos avances en las técnicas matemáticas, las ecuaciones de Maxwell parecen tener una naturalidad y simplicidad concincentes que nos hacen preguntarnos cómo pudo considerarse alguna vez que el campo electromagnético pudiera obedecer a otras leyes. Pero semejante perspectiva ignora el hecho de que fueron las propias ecuaciones de Maxwell las que llevaron a muchos de estos desarrollos matemáticos. Fue la forma de estas ecuaciones la que indujo a Lorentz, Poincaré y Einstein a las transformaciones espaciotemporales de la relatividad especial, que, a su vez, condujeron a la concepción de Minkowaki del espaciotiempo.

¡La Mente Humana! ¿Hasta donde podrá llegar? ¿Qué limite tendrá impuesto? La respuesta es sencilla: ¡No hay límites! Y, aunque dicha afirmación la repita en muchos de mis escritos, y, aunque a algunos les parezca un sueño…, esa es….amigos míos, la realidad.

emilio silvera

Oct

17

Súper simetría

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (4)

Comments (4)

En cualquier sitio que miremos nos dirán que la supersimetría en la física de partículas es: La supersimetría es una simetría hipotética propuesta que relacionaría las propiedades de los bosones y los fermiones. Aunque todavía no se ha verificado experimentalmente que la supersimetría sea una simetría de la naturaleza, es parte fundamental de muchos modelos teóricos, incluyendo la teoría de supercuerdas. La supersimetría también es conocida por el acrónimo inglés SUSY.

La Supersimetría tiene unas matemáticas muy bellas y por esa razón los artículos sobre el tema están llenos de ellas. Como ha sucedido antes, por ejemplo, cuando se propuso la teo´ria de Yang – Mills, tenemos un esquema matemático brillante que aún no sabemos como encajar en el conjunto de las leyes naturales. No tiene ningún sentido, todavía, pero esperamos que lo tenga en un tiempo futuro.

Hay otro escenario mucho más atractivo para nuestra imaginación. Hemos podido ver que los átomos están formados por pequeños constituyentes, los fotones, neutrones y electrones. Luego descubrimos que esos constituyentes, a su vez, tienen una subestructura: están formados de quarks y gluones. ¿Por qué, como probablemente hayas pensado tú antes, el proceso no continúa así? Quizñá esos Quarks y Gluones, e igualmente los electrones y todas las demás partículas aún llamadas “elementales” en el Modelo Estándar, estén también construidas de unos granos de materia aún menores y, finalmente, toda esa materia, si seguimos profundizando, nos daría la sorpresa de que toda ella es pura luz, es decir, la esencia de la materia.

Yo he tenido esa idea muy frecuentemente, nadie me quita de la cabeza que la materia, en lo más profundo de su “ser”, es la luz congelada en trozos de materia que, cuando llegan los sucesos, las transiciones de fase, se deja ver y sale a la “luz” del mundo para que la podamos contemplar.

Simetría es nuestra presencia aquí como observadores, la concha de un caracol, una galaxia, una flor

Todos sabemos de las grandes estructuras (inertes o vivas) que, en su inmensidad, transportan dentro de ellas o en la misma superficie, otras estructuras más pequeñas que, no por ello, dejan de ser también complejas. Grandes pulgas transportan pequeñas pulgas en su piel y, al igual que nosotros, llevan en ellas mismas a otros animáculos más pequeños, o, infinitesimales que, también, como nosotros, animales más grandes, tienen una misión encomendada sin la cual, seguramente nosotros, ni podríamos ser. Así que, tenemos que prestar mucha atención a lo que creemos “ínfimo” y que, en la mayoría de las veces, resulta ser más importante de lo que podemos llegar a imaginar.

Si miramos a los Quarks de un protón, por ejemplo, la mecánica cuántica (esa teoría maravillosa que controla todo el micromundo con increíble precisión), exige que el producto de la masa por la velocidad, el llamado “momento”, debe ser inversamente proporcional al tamaño de la “caja” en la cual ponemos nuestro sistema. El protón puede ser considerado como una de tales cajas y es tan pequeño que los quarks en su interior tendrían que moverse con una velocidad cercana a la de la luz. Debido a esto, la masa efectiva de los quarks máss pequeños, u y d, es aproximadamente de 300 MeV, que es mucho mayor que el valor que vemos en las Tablas de Partículas; eso también expñlica porque la masa del Protón es de 900 MeV, mucho mayor que la suma de las masas en reposo de los quarks /y Gluones).

Sí, dentro de los protones y neutrones, seguramente pueda haber mucho más de lo que ahora podemos vislumbrar. Nuestros aceleradores de partículas han podido llegar hasta ciertos límites que nos hablan de Quarks y ahora se buscan partículas supersimétricas o bosones traficantes de masa (como diría Ton Wood), y, nosotros, no sabemos si esos objetos existen o si podremos llegar a encontrarlos pero, por intentarlo… No dudamos en gastar ingentes cantidades y en utilizar cuantos recursos humanos sean precisos. El conocimiento de la Naturaleza es esencial para que, el futuro de la Física, sea la salvación de la Humanidad o, en su caso, de la raza que vendrá detrás de nosotros.

Algunas Teorías, como todos conocemos, han intentado unificar teorías de color con las de supersimetría. Quizá los nuevos Aceleradores de Hadrones (LHC) y otros similares que estarán acabamos poco después de estas primeras décadas del siglo XXI, nos puedan dar alguna pista y desvelar algunos de los nuevos fenómenos asociados a los nuevos esquemas que se dibujan en las nuevas teorías.

Los astrofísicos están muy interesados en estas ideas que predicen una gran cantidad de nuevas partículas superpesadas y, también varios tipos de partículas que interaccionan ultradébilmente. Estas podrían ser las “famosas” WIMPs que pueblan los huecos entre galaxias para cumplir los sueños de los que, al no saber explicar algunas cuestiones, acudieron a la “materia oscura” que, como sabeis, les proporcionó el marco perfecto para ocultar su inmensa ignorancia. “¡La masa perdida!” ¿Qué masa es esa? Y, sin embargo, los Astrofísicos, incansables, se aferran a ella y la siguen buscando…¡Ilusos!

¡El Universo! ¡Son tántas cosas! Desde nosotros los observadores, hasta la más ínfina partícula de materia

Yo, en mi inmensa ignorancia, no puedo explicar lo que ahí pueda existir. Sin embargo, sospecho que, deberíamos ahondar algo más en esa fuerza que llamamos Gravedad y que, me da la sensación de que nos esconde secretos que aún no hemos sabido desvelar. Y, por otra parte, tengo la sospecha de que la Luz, es más de lo que podemos suponer.

emilio silvera

Totales: 83.802.433

Totales: 83.802.433 Conectados: 49

Conectados: 49