Jul

15

La Física no duerme

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

Arnold Sommerfeld percibió que la velocidad de los electrones en el átomo de hidrógeno es una fracción considerable de la velocidad de la luz, así que había que tratarlos conforme a la teoría de la relatividad. Vio que donde la teoría de Bohr predecía una órbita, la nueva teoría predecía dos muy próximas.

Esto explica el desdoblamiento de las líneas. Al efectuar sus cálculos, Sommerfeld introdujo una “nueva abreviatura” de algunas constantes. Se trataba de 2πe2 / hc, que abrevió con la letra griega “α” (alfa). No prestéis atención a la ecuación. Lo interesante es esto: se meten los números conocidos de la carga del electrón, e–, la constante de Planck, h, y la velocidad de la luz, c, sale α = 1/137. Otra vez 137 puro.

Las constantes fundamentales (constantes universales) están referidas a los parámetros que no cambian a lo largo del universo. La carga de un electrón, la velocidad de la luz en el espacio vacío, la constante de Planck, la constante gravitacional, la constante eléctrica y magnética se piensa que son todos ejemplos de constantes fundamentales.

La última lección importante que aprendemos de la manera en que números puros α (alfa) definen el mundo, es el verdadero significado de que los mundos sean diferentes. El número puro que llamamos constante de estructura fina, e indicamos con α, es como hemos dicho antes, una combinación de e, c y h (el electrón, la velocidad de la luz y la constante de Planck). Inicialmente, podríamos estar tentados a pensar que un mundo en el que la velocidad de la luz fuera más lenta sería un mundo diferente. Pero sería un error. Si e, h y c cambian de modo que los valores que tienen en unidades métricas (o cualesquiera otras) fueran diferentes cuando las buscamos en nuestras tablas de constantes físicas, pero el valor de α permaneciera igual; nuevo mundo sería observacionalmente indistinguible de nuestro mundo. Lo único que cuenta en la definición del mundo son los valores de las constantes adimensionales de la naturaleza.

Fue Einstein el que anunció lo que se llamó principio de covariancia: que las leyes de la naturaleza deberían expresarse en una que pareciera la misma para todos los observadores, independientemente de dónde estuvieran situados y de cómo se estuvieran moviendo. Cuando trató de desarrollar este principio, Einstein tuvo dificultades; no encontraba la manera de expresarlo con la formulación matemática adecuada. Pidió ayuda a su amigo Marcel Grossmann, matemático, quien sabiendo de las necesidades exactas de Einstein, le envió la copia de una conferencia que dio un tal Riemann, unos sesenta años .

A la Izquierda Gauus, al que llamaron Príncipe de las matemáticas.

A la Izquierda Gauus, al que llamaron Príncipe de las matemáticas.

Einstein fue muy afortunado, ya que durante la última parte del siglo XIX en Alemania e Italia, matemáticos puros habían estado inmersos en el estudio profundo y detallado de todas las geometrías posibles sobre superficies curvas. Habían desarrollado un lenguaje matemático que automáticamente tenía la propiedad de que toda ecuación poseía una forma que se conservaba las coordenadas que la describían se cambiaban de cualquier manera. Este lenguaje se denominaba cálculo tensorial. Tales cambios de coordenadas equivalen a preguntar qué tipo de ecuación vería alguien que se moviera de una manera diferente.

Einstein se quedó literalmente paralizado al leer la Conferencia de Riemann. Allí, delante de sus propios ojos tenía lo que Riemann denominaba Tensor métrico. Einstein se dio de que era exactamente lo que necesitaba para expresar de manera precisa y exacta sus ideas. Así llegó a ser posible la teoría de la relatividad general.

Einstein pudo expresar su principio de covariancia expresando sus leyes de la naturaleza como ecuaciones tensoriales, que poseían automáticamente la misma forma para todos los observadores.

Este paso de Einstein completó un movimiento espectacular en la concepción física de la naturaleza que ha sido completado en el siglo XX. Está marcado por una evolución que se aleja continuamente de cualquier visión privilegiada del mundo, sea una visión humana, basada en la Tierra, o una visión basada en patrones humanos, la naturaleza tiene sus propios patrones.

Está que pensar siquiera en que en nuestro universo, dependiendo de la región en la que nos encontremos, habrá distintos leyes físicas, sería pensar en un universo chapuza. Lo sensato es pensar como Einstein y creer que en cualquier parte del universo rigen las mismas leyes físicas, que no se encuentre pruebas reales a favor de lo contrario, los científicos suponen con prudencia que, sea cual fueren las causas responsables de las pautas que llamamos “Leyes de la Naturaleza”, es mucho más inteligente adoptar la creencia de la igualdad física en cualquier parte de nuestro universo por muy remota que se encuentre; los elementos primordiales que lo formaron fueron siempre los mismos, que interaccionan con las cuatro fuerzas fundamentales naturales.

sabemos que las fuerzas de la naturaleza, la fuerza nuclear fuerte, la fuerza nuclear débil, el electromagnetismo y la gravedad, no son tan diferentes como parece a primera vista. Parecen tener intensidades muy diferentes y actuar sobre partículas elementales diferentes. eso es ilusorio, es la sensación creada por nuestra necesidad de habitar en un lugar del universo donde la temperatura es más bien baja y, es así, como se manifiestan las fuerzas de la naturaleza que, en dicha temperatura permite la existencia de átomos y moléculas.

Conforme la temperatura aumenta y las partículas elementales de materia colisionan entre sí a energías cada vez más altas, las fuerzas separadas que gobiernan nuestro mundo de baja temperatura, se hacen más parecidas. La fuerza fuerte se debilita, la fuerza débil aumenta y fortalece. Aparecen nuevas partículas a medida que se alcanzan temperaturas más elevadas y consiguen producir interacciones entre las familias separadas de partículas que a temperaturas bajas, parecen estar aisladas entre sí. Poco a poco, a medida que nos acercamos a esas inimaginables de temperatura “última” que Max Planck encontró definida por las cuatro constantes de la naturaleza, G, K, c, h, esperamos que las diferencias entre las fuerzas naturales se vayan borrando completamente para finalmente quedar unificadas en una única fuerza como, por otra parte, se cree que fue al principio de todo, en el Big Bang, el proceso ocurrió al contrario. Había una increíble temperatura, un plasma primordial lo invadía todo y se expansionaba, naciendo el tiempo y el espacio cuando reinaba la simetría total y una sola fuerza lo regía todo.

El universo continuó su expansión y comenzó a enfriarse, la simetría se rompió y lo que era una sola fuerza se dividió en las cuatro que conocemos. Previamente, a partir del plasma, al la temperatura, surgieron los quarks que se juntaron formar protones y neutrones que, a su vez, se juntaron para formar núcleos que, al ser rodeados por los electrones atraídos por la carga positiva de los núcleos, formaron los átomos, que se unieron para formar moléculas, que se juntaron para formar la materia, que más tarde, dio lugar al nacimiento de las primeras estrellas y galaxias con sus variedades de objetos estelares, planetas, satélites, cometas, meteoritos, y, en definitiva, todo lo que exoiste en el universo y que podamos ver o detectar.

Las fuerzas de la naturaleza que gobiernan la electricidad, el magnetismo, la radiactividad y las reacciones nucleares están confinadas a un “mundobrana” tridimensional, mientras que la gravedad actúa en todas las dimensiones y es consecuentemente más débil.

emilio silvera

Jul

10

¡¡La Luz!!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Si hablamos de la Luz, lo cierto es que tendríamos que mensionar a un sin fin de personajes que con ella han estado ligados durante sus vidas. Sin embargo, la cosa sería demasiado larga e incluso aburrida para algunos, así que lo acortamos y hacemos una sencilla reseña o comentario. Se dice que España es uno de los países más fotografiados por los astronautas. Y no es precisamente por su contraste de colores, sino por la cantidad de luz que desprenden las ciudades la noche. Es la llamada contaminación lumínica.

Por último, el exceso de luz afecta a la flora y fauna nocturnas, que precisan de oscuridad para desarrollar sus ciclos vitales. Las aves se deslumbran y desorientan, se alteran los períodos de ascenso y descenso del plancton marino, lo que repercute en la alimentación de otras especies; los insectos modifican sus ciclos reproductivos, aumentan el de plagas en las ciudades… Se rompe, además, el equilibrio poblacional de las especies, porque algunas son ciegas a ciertas longitudes de onda de luz y otras no, con lo cual las depredadoras pueden prosperar mientras se extinguen las depredadas. Respecto a las plantas, se quedan sin insectos que las polinicen. Aunque no hay estudios concretos sobre el tema, se cree que falta de polinización podría influir en la productividad de algunos los cultivos. En definitiva, que no sabemos administrar lo que tenemos.

Todos sabemos lo importante que llegar a ser la luz en nuestras viviendas

La luz es importante en nuestras vidas, tan importante que hasta hemos inventado luz artificial para alumbrar nuestras casas y ciudades y escapar de la fea oscuridad. Es una de radiación electromagnética a la que el ojo humano es sensible y sobre la cual depende nuestra consciencia visual del universo y sus contenidos.

Gracias a la luz podemos contemplar el Universo y todos los objetos que nos rodean

La velocidad finita de la luz fue sospechada por muchos experimentadores en óptica, pero fue establecida en 1.676, O. Roemer (1.644 – 1.710) la midió. Sir Isaac Newton (1.642 – 1.727) investigó el espectro óptico y utilizó los conocimientos existentes establecer una primera teoría corpuscular de la luz, en la que era considerada como un chorro de partículas que provocaban perturbaciones en el “éter” del espacio.

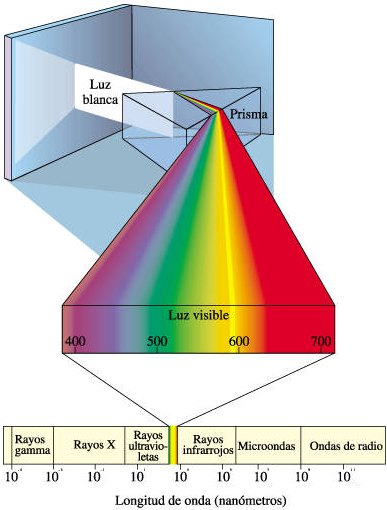

Mediante el sentido de la visión, podemos captar los objetos en los que ésta se refleja. La fuente principal de la luz que vemos es el sol y es el resultado de sumar todos los colores, manifestándose pues de color blanco. La luz blanca se separa en los colores que la componen pasa a través de un prisma. La luz visible es sólo una pequeña parte del gran espectro electromagnético. Con lo cual, un haz de luz está compuesto por pequeños paquetes de energía, denominados cuantos de luz o fotones. Al igual que la luz blanca existen otros principios luminosos que a diferencia de éste no son blancos, la explicación de ello radicaría en que dependiendo de la forma en que fuente genere luz tendremos un color u otro. Por ejemplo, las lámparas incandescentes (tungsteno) muestran un color rojizo.

La luz artificial es imprescindible cuando la luz natural desaparece. Si en una habitación bien decorada no se han tomado en los cambios de luz, todo su encanto desaparece cuando la iluminación se torna deficiente.

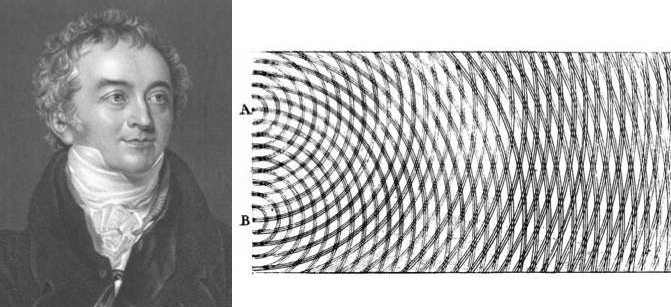

los años 1801 y 1803 Young presentó unos artículos ante la Royal Society exaltando la teoría ondulatoria de la luz y añadiendo a ella un concepto fundamental, el llamado principio de interferencia. Cuando se superponen las ondas provenientes de dos fuentes luminosas puntuales, sobre una pantalla colocada paralela a la línea de unión de los dos orificios, se producen franjas claras y oscuras regularmente espaciadas. Éste es el primer experimento en el que se demuestra que la superposición de luz producir oscuridad. Este fenómeno se conoce como interferencia y con este experimento se corroboraron las ideas intuitivas de Huygens respecto al carácter ondulatorio de la luz

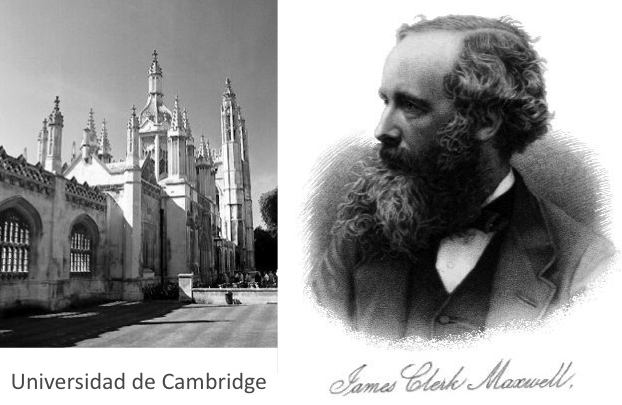

Después de Newton, sucesores adoptaron los corpúsculos, pero ignoraron las perturbaciones con de onda hasta que Thomas Young (1.773 – 1.829) redescubrió la interferencia de la luz en 1.801 y mostró que una teoría ondulatoria era esencial para interpretar este tipo de fenómenos. Este punto de vista fue adoptado durante la mayor parte del siglo XIX y permitió a James Clerk Maxwell (1.831 – 1.879) mostrar que la luz forma parte del espectro electromagnético. En 1.905, Albert Einstein (1.879 – 1.955) demostró que el efecto fotoeléctrico sólo podía ser explicado con la hipótesis de que la luz consiste en un chorro de fotones de energía electromagnética discretos, esto es, pequeños paquetes de luz que él llamó fotones y que Max Planck llamó cuanto. Este renovado conflicto entre las teorías ondulatoria y corpuscular fue gradualmente resuelto con la evolución de la teoría cuántica y la mecánica ondulatoria. Aunque no es fácil construir un modelo que tenga características ondulatorias y cospusculares, es aceptado, de acuerdo con la teoría de Bohr de la complementariedad, que en algunos experimentos la luz parecerá tener naturaleza ondulatoria, mientras que en otros parecerá tener naturaleza corpuscular. Durante el transcurso de la evolución de la mecánica ondulatoria también ha sido evidente que los electrones y otras partículas elementales tienen propiedades de partícula y onda.

El fotón es una partícula con masa en reposo nula consistente en un cuanto de radiación electromagnética (cuanto de luz). El fotón también puede ser considerado una unidad de energía igual a hf, donde h es la constante de Planck y f es la frecuencia de radiación en hertzios. Los fotones viajan a la velocidad de la luz, es decir, a 299.792.458 metros por segundo. Son necesarios explicar (como dijo Einstein) el efecto fotoeléctrico y otros fenómenos que requieren que la luz tenga carácter de partícula unas veces y de onda otras.

– concepto de la estructura de la luz, es una onda y una partícula.

– Las partículas de luz son “cuantos de luz” o fotones.

– El átomo propiedades cuánticas, el electrón .

El artículo sobre el efecto fotoeleléctrico fue enviado por Einstein a la revista Annalen der Physik el 17 de marzo, recibido al siguiente día y publicado el 9 de junio de 1905. Más tarde, por importante contribución, Einstein sería galardonado con el Premio Nobel de Física de 1921.

El conocimiento de la luz (los fotones), ha permitido a la humanidad avances muy considerables en electrónica que, al sustituir los electrones por fotones (fotónica) se han construido dispositivos de transmisión, modulación, reflexión, refracción, amplificación, detección y guía de la luz. Algunos ejemplos son los láseres y las fibras ópticas. La fotónica es muy utilizada en telecomunicaciones, en operaciones quirúrgicas por láseres, en armas de potentes rayos láser y… en el futuro, en motores fotónicos que, sin contaminación, moverán nuestras naves a velocidades súper-lumínicas.

Tanto en medicina, trabajos industriales, o, en armamento, el láser es importante en nuestras vidas.

El electrón, otra partícula elemental importantísima todos nosotros y para el universo mismo, está clasificado en la familia de los leptones, con una masa en reposo (símbolo me) de notación numérica igual a 9’109 3897 (54) ×10-31 Kg y una carga negativa de notación numérica igual a 1’602 177 33 (49) ×10-19 coulombios. Los electrones están presentes en todos los átomos en agrupamientos llamados capas alrededor del núcleo; son arrancados del átomo se llaman electrones libres. La antipartícula del electrón es el positrón cuya existencia fue predicha por el físico Paúl Dirac. El positrón es un hermano gemelo del electrón, a excepción de la carga que es positiva.

El electrón fue descubierto en 1.897 por el físico Joseph John Thomson (1.856 – 1.940). El problema de la estructura (si es que la hay) del electrón no está resuelto; nuestras máquinas no tienen la potencia suficiente poder llegar, en el micromundo, a distancias infinitesimales de ese calibre. Si el electrón se considera como una carga puntual su energía es infinita y surgen dificultades de la ecuación de Lorentz-Dirac.

lo queremos saber todo y llegar al fondo de todo, estamos intentando dividir el electrón, y, no creo que eso nos lleve a nada bueno. El electrón con su masa y su carga es esencial para la vida. ¡Dejemosló estar!

Es posible dar al electrón un tamaño no nulo con un radio r0 llamado el radio clásico del electrón, dado por ro = e2/(mc2) = 2’82×10-13 cm, donde e y m son la carga y la masa, respectivamente, del electrón y c es la velocidad de la luz. modelo también tiene priblemas como la necesidad de postular las tensiones de Poincaré.

se cree que los problemas asociados con el electrón deben ser analizados utilizando electrodinámica cuántica en vez de electrodinámica clásica.

El electrón es uno de los miembros de la familia de leptones: electrón (e), muón (μ), tau (τ) con sus correspondientes neutrinos asociados electrónico, muónico y tauónico.

Un equipo de físicos de las Universidades de Cambridge y de Birmingham ha demostrado que los electrones, que por separado son indivisibles, pueden dividirse en dos partículas nuevas llamadas espinones y holones, se concentran dentro de un estrecho cable. ¡Qué cosas!

Las tres partículas, electrón, muón y tau, son exactas, excepto en sus masas. El muón es 200 veces más masivo que el electrón. La partícula tau es unas 35.600 veces más masiva que el electrón. Los leptones interaccionan por la fuerza electromagnética y la interacción débil. cada leptón hay una antipartícula equivalente de carga opuesta ( explicamos antes, el positrón es la antipartícula del leptón electrón). Los antineutrinos, como los neutrinos, no tienen carga.

La interacción electromagnética es la responsable de las fuerzas que controlan las estructuras atómicas, las reacciones químicas y todos los fenómenos electromagnéticos. Puede explicar las fuerzas las partículas cargadas pero, al contrario que las interacciones gravitacionales, pueden ser tanto atractivas como repulsivas (probar con imanes como las fuerzas desiguales y contrarias – positiva/negativa – se atraen, mientras que cargas iguales – negativa/negativa o positiva/positiva – se repelen).

Un equipo de físicos de las Universidades de Cambridge y de Birmingham ha demostrado que los electrones, que por separado son indivisibles, pueden dividirse en dos partículas nuevas llamadas espinones y holones, se concentran dentro de un estrecho cable.

Algunas partículas neutras se desintegran por interacciones electromagnéticas. La interacción se interpretar tanto como un campo clásico de fuerzas (Ley de Coulomb) como por el intercambio de fotones virtuales. Igual que en las interacciones gravitatorias, el hecho de que las interacciones electromagnéticas sean de largo alcance significa que tienen una teoría clásica bien definida dadas por las ecuaciones de Maxwell. La teoría cuántica de las interacciones electromagnéticas se describen (como antes dije) con la electrodinámica cuántica. fuerza tiene una partícula portadora, el fotón.

Todos oímos con frecuencia la palabra “electrónica”, pero pocos pensamos que estamos hablando de electrones en diseños de dispositivos de control, comunicación y computación, basándose en el movimiento de los electrones en circuitos que contienen semiconductores, válvulas termoiónicas, resistencias, condensadores y bobinas y en la electrónica cuántica1 aplicada a la óptica, se han conseguido verdaderas maravillas que han facilitado grandes avances tecnológicos de distintas aplicaciones como la investigación o la medicina y la cirugía, otros.

pequeño comentario sobre la electrónica y la fotónica que antes habéis leído, demuestra cómo el conocimiento y el dominio sobre estos dos pequeñísimos objetos, el fotón y el electrón, nos ha dado unos beneficios increíbles.

|

Los Quarks están confinados en el núcleo del átomo formando protones y neutrones. La Fuerza nuclear fuerte los retiene que no se puedan separar los unos de los otros a más distancia de la que es necesaria para mantener la estabilidad y, se les consiente lo que se denomina libertad asintótica de los Quarks.

Existen otras partículas aún más diminutas que, en realidad, podríamos decir que son los auténticos ladrillos de la materia, los objetos más pequeños que la conforman: los quarks.

En la antigua Grecia, sabios como Demócrito, Empédocles, Thales de Mileto o Aristóteles, ya sospecharon de la existencia de pequeños objetos que se unían para formar materia. Demócrito de Abdera decía que todo estaba formado por pequeños objetos invisibles e indivisibles a los que llamaba a-tomo o átomos (en griego significa “indivisibles”).

Pasaron muchos años de controversia sobre la existencia de los átomos y, en 1.803, el químico y físico británico John Dalton señaló que los compuestos físicos se combinaban para, en ciertas proporciones, formar agrupamiento de átomos para formar unidades llamadas moléculas.

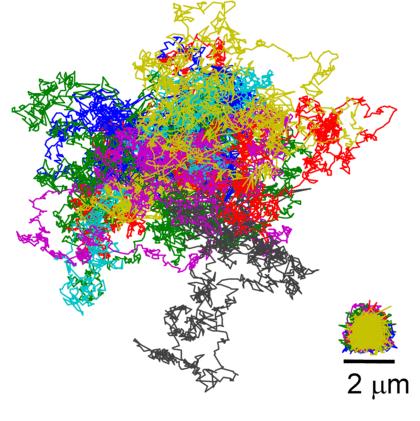

En 1.905 llegó Einstein dar una de las evidencias físicas más importante de la existencia de los átomos, al señalar que el fenómeno conocido como movimiento browniano – el movimiento irregular, aleatorio de pequeñas partículas de polvo suspendidas en un líquido – podía ser explicado por el efecto de las colisiones de los átomos del líquido con las partículas de polvo.

Por aquella época ya había sospechas de que los átomos no eran, después de todo, indivisibles. Hacía varios que J. J. Thomson, de Cambridge, había demostrado la existencia de una partícula material, el electrón, que tenía una masa menor que la milésima de la masa del átomo más ligero. Se comprendió que estos electrones debían provenir de los átomos en sí. Y, en 1.911, el físico británico Ernest Rutherford mostró finalmente que los átomos de la materia tienen verdaderamente una estructura interna: están formados por un núcleo extremadamente pequeño y con carga positiva, alrededor del cual gira un cierto de electrones.

En 1.932, un colega de Rutherford, James Chadwick, descubrió también en Cambridge que el núcleo contenía otras partículas, llamadas neutrones, que tenían casi la misma masa del protón que una carga positiva igual en magnitud a la del electrón que es negativa, con lo cual, como todos los núcleos tienen el mismo de protones que de electrones hay en el átomo, el equilibrio de éste queda así explicado: carga positiva similar a carga negativa = a estabilidad en el átomo.

emilio silvera

Jul

10

¿Dos verdades incompatibles?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

El mundo de la Física tiene planteado un gran problema y los físicos son muy conscientes de ello, conocen su existencia desde décadas. El problema centra la gran aventura de la Física actual y consiste en hallar una formulación que combine las dos grandes teorías de la Ciencia: La Relatividad y la Mecánica Cuántica. Aunque parece que, tal matrimonio, resulta imposible y que, los contrayentes son imcompatibles.

Lo grande y lo pequeño: La Escala del Universo.

Existen dos pilares fundamentales en los cuales se apoya toda la Física moderna. Uno es la relatividad general de Albert Einstein, que nos proporciona el marco teórico para la comprensión del Universo a una escala máxima: estrellas, Galaxias, cúmulos (o clusters) de Galaxias, y aún más allá, hasta la inmensa expansión del propio Universo. Allí donde exista un cuerpo masivo está presente la fuerza gravitatoria que atraerá la masa circundante. Dos galaxias de grandes dimensiones se atraeran siempre hasta unirse en “matrimonio” para una galaxia mayor.

El otro pilar es la mecánica cuántica que, en un primer vislumbro Max Planck y posteriormente fue desarrollada por W.Heisemberg, Schrödinger, el mismo Einstein, Dirac, Niels Bohr y otros y que nos ofrece un marco teórico comprender el Universo en su escala mínima: moléculas, átomos, y así hasta las partículas subatómicas, como los electrones y quarks.

Durante años de investigación los físicos han confirmado experimentalmente, con una exactitud casi inimaginable, la practica totalidad de las que hacen las dos teorías. Sin embargo, estos mismos instrumentos teóricos nos llevan a una conclusión inquietante: Tal como se formulan actualmente, la relatividad general y la mecánica cuántica no ser ambas ciertas a la vez.

Nos encontramos con que las dos teorías en las que se basan los enormes avances realizado por la física el último siglo (avances que han explicado la expansión de los cielos y la estructura fundamental de la materia) son mutuamente incompatibles. Cuando se juntan ambas teorías, aunque la formulación propuesta parezca lógica, aquello explota, la respuesta es un sinsentido que nos arroja un sin fin de infinitos a la cara.

Las diferencias la relatividad general y la mecánica cuántica son tan grandes que, por el , ha fallado cualquier intento de reconciliarlas. Sin embargo, estos intentos han sido completamente teóricos y eso les ofrece una utilidad limitada.

Así que si tú, lector no has oído nunca previamente hablar de este feroz antagonismo, te preguntar a que es debido. No es tan difícil encontrar la respuesta. Salvo en algunos casos muy especiales, los físicos estudian cosas que son o bien pequeñas y ligeras (como los átomos y sus partes constituyentes), o cosas que son enormes y pesadas (como estrellas de Neutrones y Agujeros Negros), pero no ambas al mismo tiempo. Esto significa que sólo necesitan utilizar la mecánica cuántica, o la relatividad general, y pueden minimizar el problema que se crea cuando las acercan demasiado, las dos teorías no pueden estar juntas. Durante más de medio siglo este planteamiento no ha sido tan feliz como la ignorancia, pero ha muy cerca de serlo.

No obstante, el Universo ser un caso extremo. En las profundidades centrales de un agujero negro se aplasta una descomunal masa hasta reducirse a un tamaño minúsculo. En el del Bing Bang, la totalidad del Universo salió de la explosión de una bolita microscópica cuyo tamaño hace que un grano de arena parezca gigantesco. Estos contextos son diminutos y, sin embargo, tienen una masa increíblemente grande, por lo que necesitan basarse tanto en la mecánica cuántica como en la relatividad general.

Según los primeros trabajos sobre la teoría cuántica de la gravedad, el propio espaciotiempo varió en su topografía, dependiendo de las dimensiones del universo recien nacido. Cuando el universo era del tamaño de un núcleo atómico (ver imagen de abajo), las eran relativamente lisas y uniformes; a los 10-30 cm (centro) es evidente una cierta granulidad; y a la llamada longitud de Planck, todavía unas 1.000 veces más pequeño (abajo), el espacio tiempo fluctúa violentamente.

Los físicos han intentado con denuedo elaborar una teoría completa de la gravedad que incluya la mecánica cuántica. Los cálculos de la mayoría de las teorías propuesta de la «gravedad cuántica» arrojan numerosos infinitos. Por ciertas razones, las fórmulas de la relatividad general y las de la mecánica cuántica, se combinan, empiezan a agitarse, a traquetear y tener escapes de vapor como el motor de un viejo automóvil. O dicho de manera menos figurativa, hay en la Física preguntas muy bien planteadas que ocasionan esas respuestas sin sentido, a que me referí antes, a partir de la desafortunada amalgama de las ecuaciones de las dos teorías.

Aunque se desee mantener el profundo interior de un agujero negro y el surgimiento inicial del Universo envueltos en el misterio, no se puede evitar sentir que la hostilidad la mecánica cuántica y la relatividad general está clamando por un nivel más profundo de comprensión.

No creo que el Universo esté dividido en dos partes

¿Puede ser creíble que para conocer el Universo en su conjunto tengamos que dividirlo en dos y, conocer cada por separado? Las cosas grandes una ley, las cosas pequeñas otra.

No creo que eso pueda ser así. Mi opinión es que aún no hemos encontrado la llave que habré la puerta de una teoría cuántica de la gravedad, es decir, una teoría que unifique, de una vez por todas las dos teorías más importantes de la Física: Mecánica Cuántica+Relatividad General. La respuesta, si es que la hay, parece estar en la Teoría de Supercuerdas o la más moderna versión de la Teoría M.

Recordemos que Einstein se pasó los últimos 30 años de su vida en Princeton tratando de buscar la fórmula maravillosa que uniera éstas dos grandes teorías, la R.G. y la M.C., no lo consiguió por que aún no existían las matemáticas necesarias poder llegar a tales profundidades del conocimiento.

Y, aún hoy, tampoco existen.

emilio silvera

Jul

2

¡Conocer la Naturaleza! Nunca resultó fácil

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (3)

Comments (3)

Sus dimensiones y masa le permiten ¡lo imposible! nosotros. La tensión superficial es una consecuencia de que todas las moléculas y los átomos se atraen unos a otros con una que nosotros llamamos fuerza de Van der Vaalls. fuerza tiene un alcance muy corto. para ser más precisos, diremos que la intensidad de esta fuerza a una distancia r es proporcional a 1/r7. Esto significa que si se reduce la distancia entre dos átomos a la mitad, la fuerza de Van der Vaalls con la que se atraen uno a otro se hace 2 x 2 x 2 x 2 x 2 x 2 x 2 = 128 veces más intensa. los átomos y las moléculas se acercan mucho unos a otros quedan unidos muy fuertemente a través de esta fuerza.

La mecánica cuántica domina en el micromundo de los átomos y de las partículas “elementales”. Nos enseña que en la naturaleza cualquier masa, por sólida o puntual que pueda parecer, tiene un aspecto ondulatorio. Esta onda no es una onda de agua. Se parece más a una ola de histeria que se expande: es una onda de . Nos indica la probabilidad de detectar una partícula. La longitud de onda de una partícula, la longitud cuántica, se hace menor cuanto mayor es la masa de esa partícula.

Por el , la relatividad general era siempre necesaria cuando se trataba con situaciones donde algo viaja a la velocidad de la luz, o está muy cerca o donde la gravedad es muy intensa. Se utiliza para describir la expansión del universo o el comportamiento en situaciones extremas, como la de agujeros negros.

Sin embargo, la gravedad es muy débil comparada con las fuerzas que unen átomos y moléculas y demasiado débil para tener cualquier efecto sobre la estructura del átomo o de partículas subatómicas, se trata con masas tan insignificantes que la incidencia gravitatoria es despreciable. Todo lo contrario que ocurre en presencia de masas considerables como planetas, estrellas y galaxias, donde la presencia de la gravitación curva el y distorsiona el tiempo.

Como resultado de estas propiedades antagónicas, la teoría cuántica y la teoría relativista gobiernan reinos diferentes, muy dispares, en el universo de lo muy pequeño o en el universo de lo muy grande. Nadie ha encontrado la manera de unir, sin fisuras, estas dos teorías en una sola y nueva de Gravedad-Cuántica.

¿Cuáles son los límites de la teoría cuántica y de la teoría de la relatividad de Einstein? Afortunadamente, hay una respuesta y las unidades de Planck nos dicen cuales son. En realidad, es la propia Naturaleza la que marca esos límites que Stoney-Planck, supieron plasmar en ecuaciones que los marcan.

Supongamos que tomamos toda la masa del universo visible y determinamos su longitud de cuántica. Podemos preguntarnos en qué esta longitud de onda cuántica del universo visible superará su tamaño. La respuesta es: cuando el universo sea más pequeño en tamaño que la longitud de Planck, es decir, 10-33 de centímetros, más joven que el tiempo de Planck, 10-43 segundos y supere la temperatura de Planck de 1032 grados. Las unidades de Planck marcan la frontera de de nuestras teorías actuales. comprender en que se parece el mundo a una escala menor que la longitud de Planck tenemos que comprender plenamente cómo se entrelaza la incertidumbre cuántica con la gravedad. Para entender lo que podría haber sucedido del suceso que estamos tentados a llamar el principio del universo, o el comienzo del tiempo, tenemos que penetrar la barrera de Planck. Las constantes de la naturaleza marcan las fronteras de nuestro conocimiento existente y nos dejan al descubierto los límites de nuestras teorías.

En los intentos más recientes de crear una teoría nueva para describir la naturaleza cuántica de la gravedad ha emergido un significado para las unidades naturales de Planck. Parece que el concepto al que llamamos “” tiene un profundo significado en el universo. Estamos habituados a vivir en lo que llamamos “la edad de la información”. La información ser empaquetada en formas electrónicas, enviadas rápidamente y recibidas con más facilidad que nunca antes. Nuestra evolución en el proceso rápido y barato de la información se suele en una forma que nos permite comprobar la predicción de Gordon Moore, el fundador de Intel, llamada ley de Moore, en la que, en 1.965, advirtió que el área de un transistor se dividía por dos aproximadamente cada 12 meses. En 1.975 revisó su tiempo de reducción a la mitad hasta situarlo en 24 meses. Esta es “la ley de Moore” cada 24 meses se obtiene una circuiteria de ordenador aproximadamente el doble, que corre a velocidad doble, por el mismo , ya que, el coste integrado del circuito viene a ser el mismo, constante.

La velocidad de la luz en el vacío es por definición una constante universal de valor 299.792.458 m/s (suele aproximarse a 3·108 m/s), o lo que es lo mismo 9,46·1015 m/año; la segunda cifra es la usada definir al intervalo llamado año luz. La se transmitirá a esa velocidad máximo, nuestro Universo, no permite mayor rapidéz, al menos, por los métodos convencionales.

Los límites últimos que podemos esperar para el almacenamiento y los ritmos de procesamiento de la información están impuestos por las constantes de la naturaleza. En 1.981, el físico israelí, Jacob Bekenstein, hizo una predicción inusual que estaba inspirada en su estudio de los agujeros negros. Calculó que hay una cantidad máxima de información que almacenarse dentro de cualquier volumen. Esto no debería sorprendernos.

Existen límites a los que aún no han podido llegar nuestras teorías, y, el Límite de Planck es el que marca las fronteras de las teorías actuales que, nunca han podido llegar tan lejos como lo que nos dice simple ecuación:

(Longitud de Planck que al cuadrado sería de 10-66 cm2)

(Longitud de Planck que al cuadrado sería de 10-66 cm2)

Lo que debería hacerlo es que el valor máximo está precisamente determinado por el área de la superficie que rodea al volumen, y no por el propio volumen. El máximo de bits de información que puede almacenarse en un volumen viene dado precisamente por el cómputo de su área superficial en unidades de Planck. Supongamos que la región es esférica. Entonces su área superficial es precisamente proporcional al cuadrado de su radio, mientras que el área de Planck es proporcional a la longitud de Planck al cuadrado, 10-66 cm2. Esto es muchísimo mayor que cualquier capacidad de almacenamiento de producida hasta . Asimismo, hay un límite último sobre el ritmo de procesamiento de información que viene impuesto por las constantes de la naturaleza.

Stoney Planck

No debemos descartar la posibilidad de que seamos capaces de utilizar las unidades de Planck-Stoney para clasificar todo el abanico de estructuras que vemos en el universo, el mundo de las partículas elementales hasta las más grandes estructuras astronómicas. Este fenómeno se puede representar en un que recree la escala logarítmica de tamaño desde el átomo a las galaxias.

Todas las estructuras del universo porque son el equilibrio de fuerzas dispares y competidoras que se detienen o compensan las unas a las otras; la atracción y la repulsión. Ese es el equilibrio de las estrellas donde la repulsión termonuclear tiende a expandirla y la atracción (contracción) de su propia masa tiende a comprimirla; así, el resultado es la estabilidad de la estrella. En el caso del planeta Tierra, hay un equilibrio la fuerza atractiva de la gravedad y la repulsión atómica que aparece cuando los átomos se comprimen demasiado juntos. Todos estos equilibrios pueden expresarse aproximadamente en términos de dos números puros creados a partir de las constantes e, h, c, G y mprotón

“Tras medir alfa en unas 300 galaxias lejanas, vimos un patrón constante: este , que nos dice la fuerza del electromagnetismo, no es igual en otras partes que en la Tierra, y parecer variar de forma continua a lo largo de un eje”. Algunos se empeñan en variar la constante de estructura fina y, si eso llegara a producirse… las consecuencias serían funestas para nosotros. Otros nos dicen que esa constante, no ha variado a lo largo de los miles de millones de del Universo y, así debe ser, o, si varió, lo hizo en una escala ínfima.

|

α = 2πe2 / hc ≈ 1/137 |

|

αG = (Gmp2)2 / hc ≈ 10-38 |

Si varian algunas de las dos en sólo una diezmillonésima, muchas de las cosas que conforman el Universo serían imposible y, la consecuencia sería, la ausencia de vida. La identificación de constantes adimensionales de la naturaleza a (alfa) y aG, junto con los números que desempeñan el mismo papel definitorio las fuerzas débil y fuerte de la naturaleza, nos anima a pensar por un momento en mundos diferentes del nuestro. Estos otros mundos pueden estar definidos por leyes de la naturaleza iguales a las que gobiernan el universo tal como lo conocemos, pero estarán caracterizados por diferentes valores de constantes adimensionales. Estos cambios numéricos alterarán toda la fábrica de los mundos imaginarios. Los átomos pueden tener propiedades diferentes. La gravedad puede tener un papel en el mundo a pequeña escala. La naturaleza cuántica de la realidad puede intervenir en lugares insospechados.

Lo único que en la definición del mundo son los valores de las constantes adimensionales de la naturaleza (así lo creían Einstein y Planck). Si se duplica el valor de todas las masas no se llegar a saber, porque todos los números puros definidos por las razones de cualquier par de masas son invariables.

“Todos los físicos del mundo, deberían tener un letrero en el lugar más visible de sus casas, que al mirarlo, les recordara lo que no saben. En el cartel sólo pondría esto: 137. Ciento treinta y siete es el inverso de algo que lleva el de constante de estructura fina”

Lederman

guarda relación con la posibilidad de que un electrón emita un fotón o lo absorba. La constante de estructura fina responde también al de “alfa” y sale de dividir el cuadrado de la carga del electrón, por el de la velocidad de la luz y la constante de Planck. Tanta palabrería y numerología no significan otra cosa sino que ese numero, 137, encierra los misterios del electromagnetismo (el electrón, e–), la relatividad (la velocidad de la luz, c), y la teoría cuántica (la constante de Planck, h).

Todo eso está relacionado: leyes fundamentales, constantes, materia y espacio tiempo… ¡nosotros!

emilio silvera

Jun

25

¿La Física? ¡Una maravilla!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Cuando llegamos a los seres unicelulares, se ve que ellos no hay distinción entre arriba y abajo. Para ellos, la tensión superficial del agua es mucho más importante que la fuerza de la gravedad a esa escala.

La tensión superficial es una consecuencia de que todas las moléculas y los átomos se atraen unos a otros con una fuerza que nosotros llamamos de Van der Waals. fuerza tiene un alcance muy corto; para ser precisos, diremos que la intensidad de esta fuerza a una distancia r es aproximadamente 1/r7. Esto significa que si se reduce la distancia dos átomos a la mitad de la fuerza de Van der Waals con la que se atraen uno a otro se hace 2 × 2 × 2 × 2 × 2 × 2 × 2 = 128 veces más intensa. Cuando los átomos y las moléculas se acercan mucho unos a otros quedan unidos muy fuertemente a través de esta fuerza. El conocimiento de esta fuerza se debe a Johannes Diderik Van der Waals (1837 – 1923) con su tesis sobre la continuidad del líquido y gaseoso que le haría famoso, ya que en esa época (1873), la existencia de las moléculas y los átomos no estaba completamente aceptado.

La tensión superficial del agua, es el efecto físico (energía de atracción entre las moléculas) que “endurece” la capa superficial del agua en reposo y permite a algunos insectos, como el mosquito y otros desplazarse por la superficie del agua sin hundirse.

El famoso físico inglés James Clerk Maxwell, que formuló la teoría del electromagnetismo de Faraday, quedó muy impresionado por este de Van der Waals.

Los tamaños de los seres uniceculares, animales y vegetales, se miden en micrómetros o “micras”, donde 1 micra es 1/1.000 de milímetro, aproximadamente el tamaño de los detalles más pequeños que se pueden observar con un microscopio ordinario. El mundo de los microbios es fascinante, pero no es el objeto de este trabajo, y continuaremos el viaje emprendido las partículas elementales que forman núcleos, átomos, células y materia, así como las fuerzas que intervienen en las interacciones fundamentales del universo y que afecta a todo lo que existe.

Hemos hablado del electrón que rodea el núcleo, de su carga eléctrica negativa que complementa la positiva de los protones y hace estable al átomo; una masa de solamente 1/1.836 de la del núcleo más ligero (el del hidrógeno). La importancia del electrón es vital en el universo.

Pero busquemos los “cuantos”. La física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck propuso una posible solución a un problema que había intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menor intensidad, por los objetos más fríos (radiación de cuerpo negro).

Estaba bien aceptado entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía. Pero si utilizamos las leyes de la termodinámica para calcular la intensidad de una radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano y, luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico a una cierta longitud de onda característica, y que la intensidad disminuye tanto para longitudes mayores como para menores. Esta longitud de onda característica es inversamente proporcional a la temperatura absoluta de objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273º bajo cero). Cuando a 1.000º C un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de luz visible.

Radiación de Cuerpo Negro

Un cuerpo negro es un objeto teórico o ideal que absorbe toda la luz y toda la energía radiante que incide sobre él. Nada de la radiación incidente se refleja o pasa a través del cuerpo negro. A pesar de su , el cuerpo negro emite luz y constituye un modelo ideal físico para el estudio de la emisión de radiación electromagnética. El nombre Cuerpo negro fue introducido por Gustav Kirchhoff en 1862.

La luz emitida por un cuerpo negro se denomina radiación de cuerpo negro. Todo cuerpo emite energía en de ondas electromagnéticas, siendo esta radiación, que se emite incluso en el vacío, tanto más intensa cuando más elevada es la temperatura del emisor. La energía radiante emitida por un cuerpo a temperatura ambiente es escasa y corresponde a longitudes de onda superiores a las de la luz visible (es decir, de menor frecuencia). Al elevar la temperatura no sólo aumenta la energía emitida sino que lo hace a longitudes de onda más cortas; a esto se debe el cambio de color de un cuerpo cuando se calienta. Los cuerpos no emiten con igual intensidad a todas las frecuencias o longitudes de onda, sino que siguen la ley de Planck.

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en paquetes de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de onda, y por tanto, proporcional a la frecuencia de radiación emitida. La fórmula es E = hν, donde E es la energía del paquete, ν es la frecuencia y h es una nueva constante fundamental de la naturaleza, la constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo nueva condición, el resultado coincidió perfectamente con las observaciones.

Poco tiempo después, en 1905, Einstein formuló esta teoría de una manera mucho más tajante: él sugirió que los objetos calientes no son los únicos que emiten radiación en paquetes de energía, sino que toda la radiación consiste en múltiplos del paquete de energía de Planck. El príncipe francés Louis-Victor de Broglie, dándole otra vuelta a la teoría, propuso que no sólo cualquier cosa que oscila tiene energía, sino que cualquier cosa con energía se debe comportar una “onda” que se extiende en una cierta región del espacio, y que la frecuencia ν de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilantes de campos de fuerza, esto lo veremos más adelante.

El curioso comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de de Broglie. Poco después, en 1926, Edwin Schrödinger descubrió cómo escribir la teoría ondulatoria de de Broglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños quedaba exactamente determinado por las recién descubiertas “ecuaciones de ondas cuánticas”.

Está bien comprobado que la mecánica cuántica funciona de maravilla…, pero, sin embargo, surge una pregunta muy formal: ¿qué significan realmente estas ecuaciones?, ¿qué es lo que están describiendo? Isaac Newton, allá en 1867 formuló cómo debían moverse los planetas alrededor del Sol, estaba claro todo el mundo qué significaban sus ecuaciones: que los planetas estaban siempre en una posición bien definida des espacio y que sus posiciones y sus velocidades en un momento concreto determinan inequívocamente cómo evolucionarán las posiciones y las velocidades en el tiempo.

Pero los electrones todo es diferente. Su comportamiento parece estar envuelto en misterio. Es como si pudieran “existir” en diferentes lugares simultáneamente, como si fueran una nube o una onda, y esto no es un efecto pequeño. Si se realizan experimentos con suficiente precisión, se puede determinar que el electrón parece capaz de moverse simultáneamente a lo largo de trayectorias muy separadas unas de otras. ¿Qué puede significar todo esto?

Niels Bohr consiguió responder a esta pregunta de tal que con su explicación se pudo seguir trabajando, y muchos físicos siguen considerando su respuesta satisfactoria. Se conoce como la interpretación de Copenhague de la mecánica cuántica.

Si la mecánica cuántica tiene cosas extrañas y el espín es una de ellas. Y si uno piensa que la intuición le ayudará a comprender todo esto, pues no lo hará, o es poco probable que lo haga. Las partículas tienen un espín fundamental. Al igual que la carga eléctrica o la masa, el espín ayuda a definir que de partícula es cada una.

Las leyes de la mecánica cuántica han sido establecidas con mucha precisión; permite cómo calcular cualquier cosa que queramos saber. Pero si queremos “interpretar” el resultado, nos encontramos con una curiosa incertidumbre fundamental: que varias propiedades de las partículas pequeñas no pueden estar bien definidas de manera simultánea. Por ejemplo, podemos determinar la velocidad de una partícula con mucha precisión, pero entonces no sabremos exactamente dónde se encuentra; o a la inversa, podemos determinar la posición con precisión, pero entonces su velocidad queda mal definida. Si una partícula tiene espín (rotación alrededor de su eje), la dirección alrededor de la cual está rotando (la orientación del eje) no puede ser definida con gran precisión.

La posición y el momento de una partícula nunca lo podremos saber con precisión ilimitada.

No es fácil explicar de forma sencilla de dónde viene esta incertidumbre, pero existen ejemplos en la vida cotidiana que tienen algo parecido. La altura de un tono y la duración en el tiempo durante el cual oímos el tono tienen una incertidumbre mutua similar. Para afinar un instrumento se debe escuchar una nota durante un cierto intervalo de tiempo y compararla, por ejemplo, con un diapasón que debe vibrar también durante un tiempo. Notas muy breves no tienen bien definido el tono.

Para que las reglas de la mecánica cuántica funcionen, es necesario que todos los fenómenos naturales en el mundo de las cosas pequeñas estén regidos por las mismas reglas. Esto incluye a los virus, bacterias e incluso a las personas. Sin embargo, cuando más grande y más pesado es un objeto, más difícil es observar las desviaciones de las leyes del movimiento “clásicas” debidas a la mecánica cuántica. Me gustaría referirme a exigencia tan importante y tan peculiar de la teoría con la palabra “holismo”. Esto no es exactamente lo mismo que entienden algunos filósofos por holismo, y que podría definir como “el todo es más que la suma de sus partes”. Si la física nos ha enseñado algo es justo lo contrario. Un objeto compuesto de un gran de partículas puede ser entendido exactamente si se conocen las propiedades de sus partes (partículas); basta que sepamos sumar correctamente (¡y esto no es nada fácil en mecánica cuántica!). Lo que entiendo por holismo es que, efectivamente, el todo es la suma de las partes, pero sólo se puede hacer la suma si todas las partes obedecen a las mismas leyes. Por ejemplo, la constante de Planck, h, que es igual a 6’626075… × 10-34 Julios segundo, debe ser exactamente la misma para cualquier objeto en cualquier sitio, es decir, debe ser una constante universal.

La mecánica cuántica es muy extraña a nuestro “sentido común”, sabemos que se desenvuelve en ese “universo” de lo muy pequeño, alejado de nuestra vida cotidiana en el macrocosmos tetradimensional que, no siempre coincide con lo que, en aquel otro ininitesimal acontece.

Las reglas de la mecánica cuántica funcionan tan bien que refutarlas resulta realmente difícil. Los trucos ingeniosos descubiertos por Werner Heisemberg, Paul Dirac y muchos otros mejoraron y completaron las reglas generales. Pero Einstein y otros pioneros como Erwin Schrödinger siempre presentaron serias objeciones a interpretación. Quizá funcione bien, pero ¿dónde está exactamente el electrón?, ¿en el punto x o en el punto y? En pocas palabras, ¿dónde está en realidad?, y ¿cuál es la realidad que hay detrás de nuestras fórmulas? Si tenemos que creer a Bohr, no tiene sentido buscar tal realidad. Las reglas de la mecánica cuántica, por sí mismas, y las observaciones realizadas con detectores son las únicas realidades de las que podemos hablar.

Es cierto que, existe otro universo dentro de nuestro del que, aún, nos queda mucho por aprender.

La mecánica cuántica puede ser definida o resumida así: en principio, con las leyes de la naturaleza que conocemos se puede predecir el resultado de cualquier experimento, en el sentido que la predicción consiste en dos factores: el primer factor es un cálculo definido con exactitud del efecto de las fuerzas y estructuras, tan riguroso como las leyes de Isaac Newton para el movimiento de los planetas en el Sistema Solar; el segundo factor es una arbitrariedad estadística e incontrolable definida matemáticamente de estricta. Las partículas seguirán una distribución de probabilidades dadas, primero de una forma y luego de otra. Las probabilidades se pueden calcular utilizando la ecuación de Schrödinger de función de onda (Ψ) que, con muchas probabilidades nos indicará el lugar probable donde se encuentra una partícula en un dado.

Muchos estiman que esta teoría de las probabilidades desaparecerá cuando se consiga la teoría que explique, de forma completa, todas las fuerzas; la buscada teoría del todo, lo que implica que nuestra descripción actual incluye variables y fuerzas que (aún) no conocemos o no entendemos. Esta interpretación se conoce como hipótesis de las variables ocultas.”

emilio silvera

Totales: 83.783.833

Totales: 83.783.833 Conectados: 25

Conectados: 25