Ago

8

El pensamiento asombroso: ¡Las ideas!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Ludwig Boltzmann será el protagonista de hoy

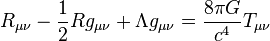

Hay ecuaciones que son aparentemente insignificantes por su reducido número de exponentes que, sin embargo, ¡dicen tántas cosas…! En la mente de todos están las sencillas ecuaciones de Einstein y de Planck sobre la energía-masa y la radiación de cuerpo negro. Esa es la belleza de la que hablan los físicos cuando se refieren a “ecuaciones bellas”.

Maxwell

Las ecuaciones de Maxwell…, “y se hizo la luz”

Las ecuaciones de Maxwell…, “y se hizo la luz”

La identidad de Euler: Algunos dijeron de su ecuación: “la expresión matemática más profunda jamás escrita”, “misteriosa y sublime”, “llena de belleza cósmica”, “una explosión cerebral”.

Newton y su segunda ley que, aunque no funcione cuando nos acercamos a velocidades relativistas, rompió la marcha hacia la Gravedad.

Pitágoras y “su” teorema, también debe estar presente como lo está su teorema en las construcciones de todo el mundo y… mucho más.

Schrödinger y su función de onda que tampoco se queda atrás (aunque como la ecuación de Newton, si hablamos de velocidades relativistas…)

Bueno, E = mc2, nos lleva a profundidades de la materia antes jamás vistas y nos permite sacar conclusiones como que, en un gramo de materia está encerrada toda la energíaconsumida por la Humanidad durante un minuto. ¡Masa y Energía son la misma cosa! Einstein, con esa ecuación de arriba de la relatividad especial, vino a cambiar el mundo y, cuando quince años más tarde desarrolló la segunda parte, relatividad general, a partir de entonces, nació la verdadera cosmología. ¡Nos habla de tántas cosas!

¿Qué decir de la maravillosa fórmula de la entropía de Boltzman?

S = k log W

Creo que ahora, hablaremos de ella. Boltzman con su trabajo e ingenio, le dio a la Humanidad la herramienta para que pudiera seguir avanzando en el difícil laberinto de la Cienca, es, sin duda, uno de los físicos más ilustres del siglo XIX.

El trabajo científico desarrollado por Boltzmann en su época crítica de transición que puso el colofón a la física “clásica” –cuya culminación podríamos situar en Maxwell– y antecedió (en pocos años) a la “nueva” física, que podemos decir que comenzó con Max Planck y Einstein. Aunque ciertamente no de la importancia de los dos últimos, la labor científica de Boltzmann tiene una gran relevancia, tanto por sus aportaciones directas (creador junto con “su amigo” Maxwell y Gibbs de la mecánica estadística, aunque sea el formulismo de éste último el que finalmente haya prevalecido; esclarecedor del significado de la entropía, etc.) como por la considerable influencia que tuvo en ilustres físicos posteriores a los que sus trabajos dieron la inspiración, como es el caso de los dos mencionados, Planck y Einstein.

Cuando algo nos gusta y nos atrae, cuando es la curiosidad la que fluía nuestros deseos por saber sobre las cosas del mundo, del Universo y las fuerzas que lo rigen, cuando la Física se lleva dentro al poder reconocer que es el único camino que nos dará esas respuestas deseadas, entonces, amigos míos, los pasos te llevan a esos lugares que, por una u otra razón tienen y guardan los vestigios de aquellas cosas que quieres y admiras. Así me pasó cuando visité el Fermilab, la tumba de Hilbert y, también en Viena, donde no pude resistir la tentación de ver, con mis propios ojos esa imagen de arriba y, desde luego, pensar en lo mucho que significaba la escueta S = k log W que figura en la cabecera de la lápida de Boltzmann como reconocimiento a su ingenio.

El Universo como sistema cerrado está aumentando constantemente su entropía

La sencilla ecuación (como todas las que en Física han tenido una enorme importancia, es la mayor aportaciópn de Boltzmann y una de las ecuaciones más importantes de la Física. El significado de las tres letras que aparecen (aparte la notación para el logaritmo es el siguiente: S es la entropía de un Sistema; W el número de microestados posibles de sus partículas elementales y k una constante de proporcionalidad que hoy día recibe el nombre de constante de Boltzmann y cuyo valor es k = 1,3805 x 10-23 J(K (si el logaritmo se toma en base natural). En esta breve ecuación se encierra la conexión entre el micromundo y el macromundo, y por ella se reconoce a Boltzmann como el padre de la rama de la Física comocida como Mecánica Estadistica.

La entropía de un sistema es el desgaste que el sistema presenta por el transcurso del tiempo o por el funcionamiento del mismo. Los sistemas altamente entrópicos tienden a desaparecer por el desgaste generado por su proceso sistémico. Es una medida de desorden o incertidumbre de un sistema.

Como todas las ecuaciones sencillas de gran trascendencia en la física, hay un antes y un después de su formulación: sus consecuencias son de un calado tan profundo que han cambiado la forma de entender el mundo y, en particular, de hacer Física, a partir de ellas.De hecho, en este caso al menos, la sutileza de la ecuación es tal que hoy, más de cien años después de la muerte de su creador, se siguen investigando sus nada triviales consecuencias.

Boltzmann fue un defensor a ultranza del atomismo, polemizando sobre todo con Mach y Ostwald, antiatomistas partidarios de la energética y claros exponentes de la corriente idealista de la física alemana. Tuvo que abandonar su ambiciosa idea de explicar exactamente la irreversibilidad en términos estrictamente mecánicos; pero esta “derrota”, no ocultaré que dolorosa desde el punto de vista personal, le fue finalmente muy productiva, pues de alguna manera fue lo que le llevó al concepto probabilista de la entropía. Estas primeras ideas de Boltzmann fueron reivindicadas y extendidas, en el contexto de la teoría de los sistemas dinámicos inestables, sobre todo por la escuela de Prigogine, a partir de la década de 1970.

La personalidad de Boltzmann era bastante compleja. Su estado de ánimo podía pasar de un desbordante optimismo al más negro pesimismo en cuestión de unas pocas horas. Era muy inquieto; él decía – medio en serio, medio en broma – que eso se debía a haber nacido en las bulliciosas horas finales de los alegres bailes del Martes de Carnaval, previas a los “duelos y quebrantos” (entonces) del Miércoles de Ceniza.

Boltzmann at age 31 with his wife, Henrietta, in 1875

Su lamentable final, su suicidio en Duino (Trieste) el 5 de septiembre de 1906, muy probablemente no fue ajeno a esa retorcida personalidad, aunque su precaria salud física fue seguramente determinante a la hora de dar el trágico paso hacia el lado oscuro.

Uno de los problemas conceptuales más importantes de la física es cómo hacer compatible la evolución irreversible de los sistemas macroscópicos (el segundo principio de la termodinámica) con la mecánica reversible (las ecuaciones de Hamilton o la ecuación de Schrödinger) de las partículas (átomos o moléculas) que las constituyen. Desde que Boltzmann dedujo su ecuación en 1872, este problema ha dado lugar a muy amplios debates, y el origen de la irreversibilidad es, aún hoy en día, controvertido.

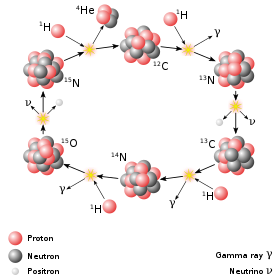

En una de sus primeras publicaciones, Boltzmann obtuvo en 1866 una expresión de la entropía, que había sido definida un año antes por Clausius, basado en conceptos mecánicos. Las limitaciones de este trabajo eran que su aplicación se restringía al estudio de los gases y que el sistema era periódico en el tiempo. Además, Boltzmann no pudo deducir de su definición de entropía la irreversibilidad del segundo principio de la termodinámica de Clausius. En 1868, basándose en las ideas probabilísticas de Maxwell, obtuvo la distribución de equilibrio de un gas de partículas puntuales bajo la acción de una fuerza que deriva de un potencial (distribución de Maxwell-Boltzmann).

En el Universo, considerado como sistema cerrado, la entropía crece y…

En 1.872 publicó la denominada ecuación de Boltzmann para cuya deducción se basó, aparentemente, en ideas mecánicas. Esta ecuación contiene, sin embargo, una hipótesis no mecánica (estadística) o hipótesis del caos molecular, que Boltzmann no apreció como tal, y cuya mayor consecuencia es que, cualquiera que sea la distribución inicial de velocidad de un gas homogéneo diluido fuera del equilibrio, ésta evoluciona irreversiblemente hacia la distribución de velocidad de Maxwell. A raíz de las críticas de Loschmidt (paradoja de la reversibilidad) y Zermelo (paradoja de la recurrencia), Boltzmann acabó reconociendo el carácter estadístico de su hipótesis, y en 1877 propuso una relación entre la entropía S de un sistema de energía constante y el número de estados dinámicos W accesibles al sistema en su espacio de fases; esto es, la conocida ecuación S = kB ln W, donde kB es la constante de Boltzmann. En esta nota, se hace una breve descripción de la ecuación de Boltzmann y de la hipótesis del caos molecular.

El comportamiento de los gases siempre dio a los físicos en qué pensar

La ecuación de Boltzmann describe la evolución temporal de un gas diluido de N partículas puntuales de masa m contenidas en un volumen V que interaccionan a través de un potencial de par central repulsivo V(r) de corto alcance a. Como simplificación adicional, considérese que sobre las partículas no actúan campos externos. Si f1(r,v,t) indica la densidad de partículas que en el tiempo t tienen un vector de posición r y velocidad v, que está normalizada en forma:

∫dr ∫dvƒ1(r,v,t) = N

Su evolución temporal es la suma de dos contribuciones. En ausencia de interacción, las partículas que en el tiempo t tienen vector de posición r y velocidad v se encuentran, después de un intervalo de tiempo Δt, en r + v Δt y tiene la misma velocidad. Como

f1(r + vΔt,v,t + Δt) = f1(r,v,t)

en el límite Δt → 0 (2) se escribe:

∂1 f1(r,v,t) = – v∂r f1(r,v,t)

Que es una ecuación invariante bajo el cambio t → – t y v → – v. La evolución es, por tanto, mecánica.

Transportando energía, o, transmutación de materia

Se cumplieron más de cien años desde la muerte de Boltzmann y su trabajo sigue siendo recordado. No pienso que Boltzmann creyera en la existencia real de los átomos, pero sí en su utilidad e incluso en su necesidad para comprender las leyes macroscópicas y la evolución irreversible de los fenómenos macroscópicos desde una base más fundamental que el nivel fenomenológico. Pero había quien (con autoridad) no creía ni en la existencia ni en su utilidad. Este debate no era ajeno a las tendencias ideológicas, religiosas y usos sociales de aquella época porque, en general, la ciencia es parte de la cultura y depende del momento histórico que viven los científicos, al fin y al cabo, seres humanos como los demás, influenciables por su entorno en una gran medida.

Por el siglo XIX, e incluso antes, ya se hablaba de “átomos”* y una rudimentaria teoría cinética de los gases gozaba de aceptación y utilidad científica (recordemos los trabajos de Benoulli, Dalton, Laplace, Poisson, Cauchy, Clausius, Krönig… y Maxwell). Pero fue Boltzmann quien definitivamente profundizó en la cuestión, para el estudio del equilibrio y, sobre todo, intentando explicar mecánicamente (mecano-estadísticamente) la evolución termodinámica irreversible y la descripción de los procesos de transporte ligados a ella. Y, nuevamente (por su enorme importancia) no podemos dejar de mencionar la muy singular labor que hicieron Gibbs, Einstein, Planck, Fermi y otros. Sin la motivación ideológica de Boltzmann, Gibbs elaboró una bellísima, útil y hoy dominante formulación (cuerpo de doctrina) de la termodinámica y física estadística.

Lorentz

Fue Lorentz quien primero utilizó la ecuación de Boltzmann y lo hizo para describir la corriente eléctrica en sólidos dando un paso significativo por encima del pionero Drude. Lorentz introdujo un modelo opuesto al browniano donde partículas ligeras como viento (electrones) se mueven chocando entre sí y con árboles gordos (tales como iones en una red cristalina); un modelo del que se han hecho estudios de interés tanto físico como matemático. Enskog (inspirándose en Hilbert) y Chapman (inspirándose en Maxwell) enseñaron cómo integrar la ecuación de Boltzmann, abriendo vías a otras diversas aplicaciones (hidrodinámica, propagación del sonido, difusión másica, calor, fricción viscosa, termoelectricidad, etc.). Recordemos que Boltzmann encontró como solución de equilibrio de su ecuación una distribución de velocidades antes descubierta por Maxwell (hoy, como reseñé anteriormente, de Maxwell-Boltzmann), por lo que concluyó que así daba base microscópica mecánica (teorema H mecano-estadístico) al segundo principio de la termodinámica (estrictamente, evolución de un sistema aislado hacia su “desorden” máximo).

Está claro que ningún físico que se precie de serlo puede visitar Viena sin visitar el parque Zentralfriedhof para ver la tumba de Boltzmann. Yo sí me pasé por allí. Me senté junto a la tumba; el lugar estaba desierto, y cerrando los ojos traté de conectar con la conciencia del genio. La sensación, extraña y agradable, seguramente fue creada por mi imaginación, pero creo que charlé con él en el interior de mi mente – la fuerza más potente del universo– y aquellos sentimientos, aquel momento, compensaron el esfuerzo del viaje.

En la tumba, sobre una gran lápida de mármol de color blanco con los nombres Ludwig Boltzmann y de los familiares enterrados con él, sobre el busto de Boltzmann, se puede leer la inscripción, a modo de epitafio:

S = k log W

Esta sencilla ecuación es la mayor aportación de Boltzmann y una de las ecuaciones más importantes de la física. El significado de las tres letras que aparecen (aparte la notación del logaritmo) es el siguiente:

- S es la entropía de un sistema.

- W es el número de microestados posibles de sus partículas elementales.

- k es una constante de proporcionalidad que hoy recibe el nombre de Constante de Boltzmann, de valor 1’3805 × 10-23 J/K (si el logaritmo se toma en la base natural)

¿Qué secretos se encierran aquí? ¿Cómo nos lleva a estos pensamientos?

En esta breve ecuación se encierra la conexión entre el micromundo y el macromundo, y por ella se reconoce a Boltzmann como el padre de la rama de la física conocida como mecánica estadística.

Como todas las ecuaciones sencilla de gran trascendencia en la física (como la famosa E = mc2), hay un antes y un después de su formulación: sus consecuencias son de un calado tan profundo que cambiaron la forma de entender el mundo, y en particular, de hacer física a partir de ellas. De hecho, la sutileza de la ecuación es tal que hoy, cien años después de la muerte de su creador, se siguen investigando sus nada triviales consecuencias. Creo que lo mismo ocurrirá con α = 2πe2/ħc que, en tan reducido espacio y con tan pocos símbolos, encierra los misterios del electromagnetismo (el electrón), de la constante de Planck (la mecánica cuántica), y de la luz (la relatividad de Einstein), todo ello enterrado profundamente en las entrañas de un número: 137.

Bueno, a pesar de todo lo anterior, Schrödinger nos decía:

“La actitud científica ha de ser reconstruida, la ciencia ha de rehacerse de nuevo”

¡Lo grande y lo pequeño! ¡Son tantos los secretos de la Naturaleza!

Siempre hemos tenido consciencia de que en física, había que buscar nuevos paradigmas, nuevos caminos que nos llevaran más lejos. Es bien conocida la anécdota de que a finales del siglo XIX un destacado físico de la época William Thomson (1824-1907) conocido como Lord Kelvin, se atrevió a decir que solo dos pequeñas “nubecillas” arrojaban sombras sobre el majestuoso panorama de conocimiento que había construido la física clásica desde Galileo y Newton hasta ese momento: el resultado del experimento de Michelson-Morley, el cual había fallado en detectar la existencia del supuesto éter luminífero; y la radiación del cuerpo negro, i.e la incapacidad de la teoría electromagnética clásica de predecir la distribución de la energía radiante emitida a diferentes frecuencias emitidas por un radiador idealizado llamado cuerpo negro. Lo que Lord Kelvin no puedo predecir es que al tratar de disipar esas dos “nubecillas”, la física se vería irremediablemente arrastrada a una nueva física: la física moderna fundada sobre dos revoluciones en ciernes: la revolución relativista y la revolución cuántica con dos científicos como protagonistas: Planck y Albert Einstein. Sin embargo, ha pasado un siglo y seguimos con esas dos únicas guías para continuar el camino y, resultan insuficientes para llegar a la meta que… ¡Está tan lejos!

emilio silvera

Jul

27

Las interacciones fundamentales

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Como pueden haber deducido, me estoy refiriendo a cualquiera de los cuatro tipos diferentes de interacciones que pueden ocurrir entre los cuerpos. Estas interacciones pueden tener lugar incluso cuando los cuerpos no están en contacto físico y juntas pueden explicar todas las fuerzas que se observan en el universo.

Viene de lejos el deseo de muchos físicos que han tratado de unificar en una teoría o modelo a las cuatro fuerzas, que pudieran expresarse mediante un conjunto de ecuaciones. Einstein se pasó los últimos años de su vida intentándolo, pero igual que otros antes y después de él, aún no se ha conseguido dicha teoría unificadora de los cuatro interacciones fundamentales del universo. Se han hecho progresos en la unificación de interacciones electromagnéticas y débiles.

Figuras

Estos diagramas son una concepción artística de los procesos físicos. No son exactos y no están hechos a escala. Las áreas sombreadas con verde representan la nube de gluones o bien el campo del gluón, las líneas rojas son las trayectorias de los quarks.

![]()

En el texto del recuadro dice: Un neutrón decae en un protón, un electrón y un antineutrino, a través de un bosón virtual (mediador). Este es el decaimiento beta del neutrón.

![]()

En el texto del recuadro dice: Una colisión electrón – positrón (antielectrón) a alta energía puede aniquilarlos para producir mesones B0 y Bbarra0 a través de un bosón Z virtual o de un fotón virtual.

El texto del recuadro dice: Dos protones que colisionan a alta energía pueden producir varios hadrones más partículas de masa muy grande tales como los bosones Z. Este tipo de suceso es raro pero puede darnos claves cruciales sobre cómo es la estructura de la materia.

Aunque no pueda dar esa sensación, todo está relacionado con las interacciones fundamentales de la materia en el entorno del espacio-tiempo en el que se mueven y conforman objetos de las más variadas estructuras que en el Universo podemos contemplar, desde una hormiga a una estrella, un mundo o una galaxia. Las fuerzas fundamentales de la Naturaleza siempre están presentes y de alguna manera, afecta a todo y a todos.

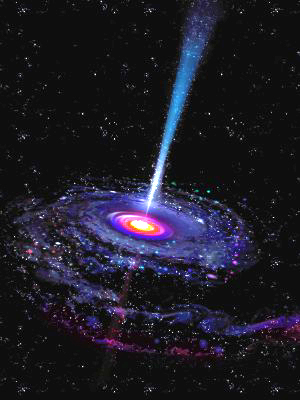

Cuando hablamos de la relatividad general, todos pensamos en la fuerza gravitatoria que es unas 1040 veces más débil que la fuerza electromagnética. Es la más débil de todas las fuerzas y sólo actúa entre los cuerpos que tienen masa. Es siempre atractiva y pierde intensidad a medida que las distancias entre los cuerpos se agrandan. Como ya se ha dicho, su cuanto de gravitación, el gravitón, es también un concepto útil en algunos contextos. En la escala atómica, esta fuerza es despreciablemente débil, pero a escala cosmológica, donde las masas son enormes, es inmensamente importante para mantener a los componentes del universo juntos. De hecho, sin esta fuerza no existiría el Sistema Solar ni las galaxias, y seguramente, nosotros tampoco estaríamos aquí. Es la fuerza que tira de nuestros pies y los mantiene firmemente asentados a la superficie del planeta. Aunque la teoría clásica de la gravedad fue la que nos dejó Isaac Newton, la teoría macroscópica bien definida y sin fisuras de la gravitación universal es la relatividad general de Einstein, mucho más completa y profunda.

Seguimos buscando respuestas a muchos enigmas presentes en el Universo que no sabemos explicar

Nadie ha podido lograr, hasta el momento, formular una teoría coherente de la Gravedad Cuántica que unifique las dos teorías. Claro que, la cosa no será nada fácil, ya que, mientras que aquella nos habla del macrocosmos, ésta otra nos lleva al microcosmos, son dos fuerzas antagónicas que nos empeñamos en casar.

Seguimos empeñados en buscar esa teoría que una lo muy grande con lo muy pequeño y la Gravedad, hasta el momento no da el sí

Por el momento, no hay una teoría cuántica de la interacción gravitatoria satisfactoria. Es posible que la teoría de supercuerdas pueda dar una teoría cuántica de la gravitación consistente, además de unificar la gravedad con los demás interacciones fundamentales sin que surjan los dichosos e indeseados infinitos.

Las partículas colisionan ente sí y se producen cambios y transiciones de fase

Algunos han puesto en duda la realidad del Modelo Estándar que, como se ha dicho aquí en otros trabajos, está construído con el contenido de una veintena de parámetros aleatorios (entre ellos el Bosón que los del LHC anunciaron haber encontrado a bombo y platillo pero del que no han dado todas las explicaciones necesarias)) que no son nada satisfactorios para dar una conformidad a todo su entramado que, aunque hasta el momento ha sido una eficaz herramienta de la física, también es posible que sea la única herramienta que hemos sabido construir pero que no es… ¡la herramienta!

Es posible que solo sea cuestión de tiempo y de más investigación y experimento. En el sentido de la insatisfacción reinante entre algunos sectores, se encuentran los físicos del experimento de alta energía BaBar, en el SLAC, un acelerador lineal situado en Stanford (California). Según ellos, la desintegración de un tipo de partículas llamado «B to D-star-tau-nu» es mucho más frecuente de lo predicho por el modelo estándar. Puede que no sea importante y puede que, hasta la existencia del Bosón de Higgs esté en peligro a pesar de que en el LHC digan que se ha encontrado.

Esquema del decaimiento Beta y una sencilla explicación de la interacción débil

La fuerza débil recibe su nombre porque a la escala de sus interacciones es la más débil dentro del modelo estándar. Pero ojo, esto no incluye la gravedad, puesto que la gravedad no pertenece al modelo estándar por el momento. La interacción débil ocurre a una escala de metros, es decir, la centésima parte del diámetro de un protón y en una escala de tiempos muy variada, desde segundos hasta unos 5 minutos. Para hacernos una idea, esta diferencia de órdenes de magnitud es la misma que hay entre 1 segundo y 30 millones de años.

La interacción débil, que es unas 1010 veces menor que la interacción electromagnética, ocurre entre leptones y en la desintegración de los hadrones. Es responsable de la desintegración beta de las partículas y núcleos. En el modelo actual, la interacción débil se entiende como una fuerza mediada por el intercambio de partículas virtuales, llamadas bosones vectoriales intermediarios, que para esta fuerza son las partículas W+, W– y Z0. Las interacciones débiles son descritas por la teoría electrodébil, que las unifica con las interacciones electromagnéticas.

Propiedades de los Bosones mediadores intermediarios de la fuerza débil

La teoría electrodébil es una teoría gauge de éxito que fue propuesta en 1.967 por Steven Weinberg y Abdus Salam, conocida como modelo WS. También Sheldon Glashow, propuso otra similar.

La interacción electromagnética es la responsable de las fuerzas que controlan la estructura atómica, reacciones químicas y todos los fenómenos electromagnéticos. Puede explicar las fuerzas entre las partículas cargadas, pero al contrario que las interacciones gravitacionales, pueden ser tanto atractivas como repulsivas. Algunas partículas neutras se desintegran por interacciones electromagnéticas. La interacción se puede interpretar tanto como un modelo clásico de fuerzas (ley de Coulomb) como por el intercambio de unos fotones virtuales. Igual que en las interacciones gravitatorias, el hecho de que las interacciones electromagnéticas sean de largo alcance significa que tiene una teoría clásica bien definida dadas por las ecuaciones de Maxwell. La teoría cuántica de las interacciones electromagnéticas se describe con la electrodinámica cuántica, que es una forma sencilla de teoría gauge.

El electromagnetismo está presente por todo el Universo

La interacción fuerte es unas 102 veces mayor que la interacción electromagnética y, como ya se dijo antes, aparece sólo entre los hadrones y es la responsable de las fuerzas entre nucleones que confiere a los núcleos de los átomos su gran estabilidad. Actúa a muy corta distancia dentro del núcleo (10-15 metros) y se puede interpretar como una interacción mediada por el intercambio de mesones virtuales llamados Gluones. Está descrita por una teoría gauge llamada Cromodinámica cuántica.

La interacción fuerte, también conocida como interacción nuclear fuerte, es la interacción que permite unirse a los quarks para formar hadrones. A pesar de su fuerte intensidad, su efecto sólo se aprecia a distancias muy cortas del orden del radio atómico. Según el Modelo estándar, la partícula mediadora de esta fuerza es el Gluón. La teoría que describe a esta interacción es la cromodinámica cuántica (QCD) y fue propuesta por David Politzer, Frank Wilczek y David Gross en la década de 1980 y por lo que recibieron el Nobel 30 años más tarde cuando el experimento conformó su teoría.

La interacción fuerte, como se ha explicado muchas veces, es la más fuerte de todas las fuerzas fundamentales de la Naturaleza, es la responsable de mantener unidos los protones y neutrones en el núcleo del átomo. Como los protones y neutrones están compuestos de Quarks, éstos dentro de dichos bariones, están sometidos o confinados en aquel recinto, y, no se pueden separar por impedirlo los gluones que ejercen la fuerza fuerte, es decir, esta fuerza, al contrario que las demás, cuando más se alejan los quarks los unos de los otros más fuerte es. Aumenta con la distancia.

En la incipiente teoría del campo electromagnético sugerida por Faraday, desaparecía la distinción esencial entre fuerza y materia, introduciendo la hipótesis de que las fuerzas constituyen la única sustancia física.

Las características de las fuerzas eran:

-

Cada punto de fuerza actúa directamente sólo sobre los puntos vecinos.

-

La propagación de cualquier cambio de la intensidad de la fuerza requiere un tiempo finito.

-

Todas las fuerzas son básicamente de la misma clase; no hay en el fondo fuerzas eléctricas, magnéticas ni gravitatorias, sino sólo variaciones (probablemente geométricas) de un sólo tipo de fuerza subyacente.

Lo importante al considerar la influencia de la metafísica de Faraday en sus investigaciones, es su suposición de que la teoría de campos ofrece una explicación última a todos los fenómenos. Los cuerpos sólidos, los campos eléctricos y la masa de los objetos son, de alguna forma, sólo apariencias. La realidad subyacente es el campo, y el problema de Faraday era encontrar un lazo de unión entre las apariencias y la supuesta realidad subyacente

Estaría bueno que al final del camino se descubriera que todas son una sola fuerza

El concepto de campo de Faraday ha dado mucho juego en Física, es un concepto ideal para explicar cierttos fenómenos que se han podido observar en las investigaciones de las fuerzas fundamentales y otros. El campo no se ve, sin embargo, está ahí, rodea los cuerpos como, por ejemplo, un electrón o el planeta Tierra que emite su campo electromagnético a su alrededor y que tan útil nos resulta para evitar problemas.

Me he referido a una teoría gauge que son teorías cuánticas de campo creadas para explicar las interacciones fundamentales. Una teoría gauge requiere un grupo de simetría para los campos y las potenciales (el grupo gauge). En el caso de la electrodinámica, el grupo es abeliano, mientras que las teorías gauge para las interacciones fuertes y débiles utilizan grupos no abelianos. Las teorías gauge no abelianas son conocidas como teorías de Yang–Mills. Esta diferencia explica por qué la electrodinámica cuántica es una teoría mucho más simple que la cromodinámica cuántica, que describe las interacciones fuertes, y la teoría electrodébil que unifica la fuerza débil con la electromagnética. En el caso de la gravedad cuántica, el grupo gauge es mucho más complicado que los anteriores necesarios para la fuerza fuerte y electrodébil.

En las teorías gauge, las interacciones entre partículas se pueden explicar por el intercambio de partículas (bosones vectoriales intermediarios o bosones gante), como los gluones, fotones y los W y Z.

El físico Enrico Fermi, refiriéndose al gran número de partículas existentes, dijo: “Si tuviera que saber el nombre de todas las partículas, me habría hecho botánico.” Por todo lo antes expuesto, es preciso conocer los grupos o familias más importantes de partículas, lógicamente “el espacio tiempo” nos limita y, me remitiré a las más comunes, importantes y conocidas como:

– Protón, que es una partícula elemental estable que tiene una carga positiva igual en magnitud a la del electrón y posee una masa de 1’672614×10-27 Kg, que es 1836,12 veces la del electrón. El protón aparece en los núcleos atómicos, por eso es un nucleón que estáformado por partículas más simples, los Quarks. Es decir, un protón está formado por dos quarks up y un quark down.

– Neutrón, que es un hadrón como el protón pero con carga neutra y también permanece en el núcleo, pero que se desintegra en un protón, un electrón y un antineutrino con una vida media de 12 minutos fuera del núcleo. Su masa es ligeramente mayor que la del protón (símbolo mn), siendo de 1’6749286(10)×10-27 kg. Los neutrones aparecen en todos los núcleos atómicos excepto en el del hidrógeno que está formado por un solo protón. Su existencia fue descubierta y anunciada por primera vez en 1.932 por James Chadwick (1891-1974. El protón está formado por tres quarks, dos quarks down y un quark up. Fijáos en la diferencia entre las dos partículas: la aparentemente minúscula diferencia hace que las dos partículas “hermanas” se comporten de formas muy distintas: la carga del protón es +2/3 +2/3 -1/3 = +1. Pero como el neutrón tiene up/down/down su carga es +2/3 -1/3 -1/3 = 0. ¡No tiene carga! No porque no haya nada con carga en él, sino porque las cargas que hay en su interior se anulan.

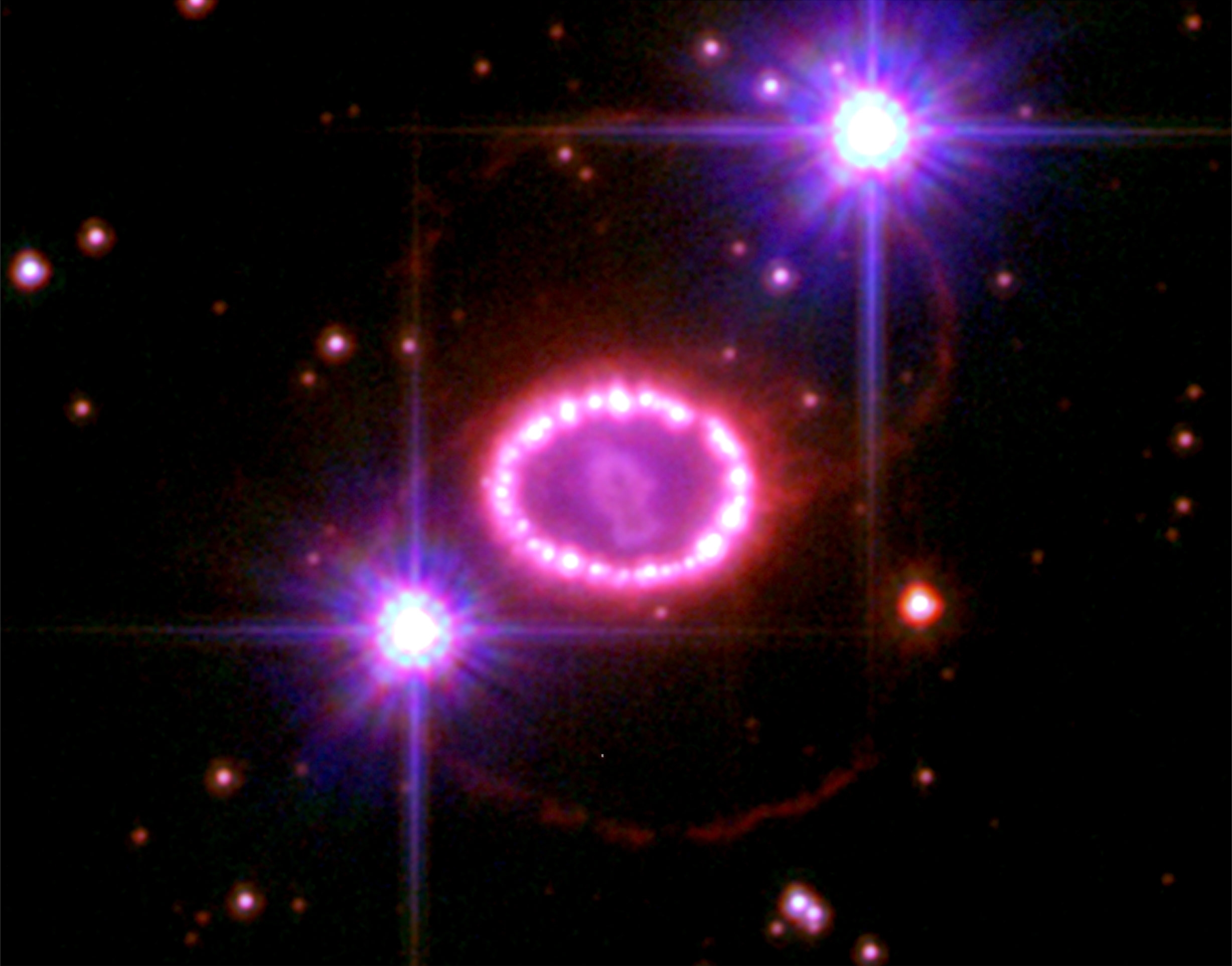

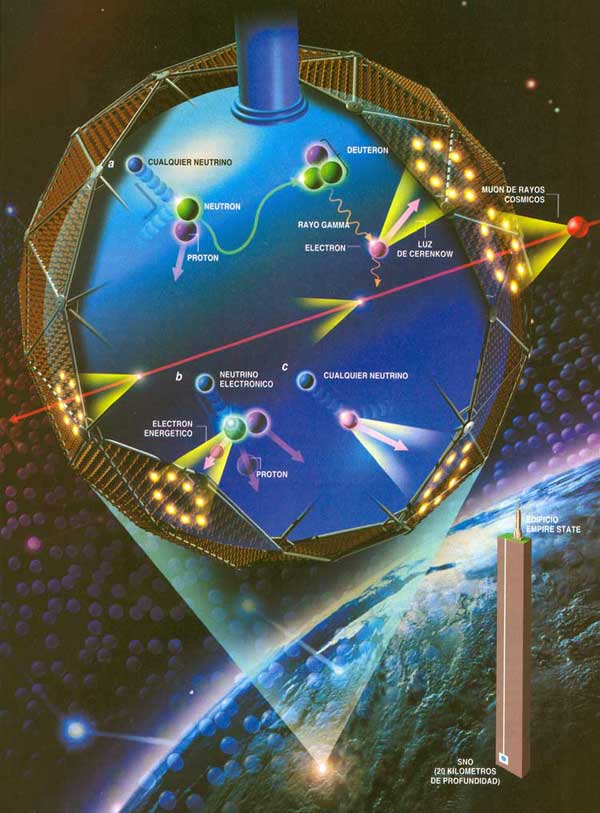

Andamos a la caza de los neutrinos

Los neutrinos, se cree que no tienen masa o, muy poca, y, su localización es difícil. Se han imaginado grandes recipientes llenos de agua pesada que, enterrados a mucha profundidad en las entrañas de la Tierra, en Minas abandonadas, captan los neutrinos provenientes del Sol y otros objetos celestes, explosiones supernovas, etc.

– Neutrino, que es un leptón que existe en tres formas exactas pero (se cree que) con distintas masas. Tenemos el ve (neutrino electrónico) que acompaña al electrón, vμ (neutrino muónico) que acompaña al muón, y vt (neutrino tau) que acompaña a la partícula tau, la más pesada de las tres. Cada forma de neutrino tiene su propia antipartícula.

El neutrino fue postulado en 1.931 para explicar la “energía perdida” en la desintegración beta. Fue identificado de forma tentativa en 1.953 y definitivamente en 1.956. Los neutrinos no tienen carga y se piensa que tienen masa en reposo nula y viajan a la velocidad de la luz, como el fotón. Hay teorías de gran unificación que predicen neutrinos con masa no nula, pero no hay evidencia concluyente.

Se ha conseguido fotografíar a un electrón. Poder filmar y fotografiar un electrón no es fácil por dos razones: primero, gira alrededor del núcleo atómico cada 0,000000000000000140 segundos , y, segundo, porque para fotografiar un electrón es necesario bombardearlo con partículas de luz (y cualquier que haya intentado sacarle una foto a un electrón sabe que hay que hacerlo sin flash).

– Electrón, que es una partícula elemental clasificada como leptón, con una carga de 9’109 3897 (54)×10-31Kg y una carga negativa de 1´602 177 33 (49) x 10-19 culombios. Los electrones están presentes en todos los átomos en agrupamientos llamados capas alrededor están presentes en todos los átomos en agrupamientos llamados capas alrededor del núcleo; cuando son arrancados del átomo se llaman electrones libres. Su antipartícula es el positrón, predicha por Paul Dirac.

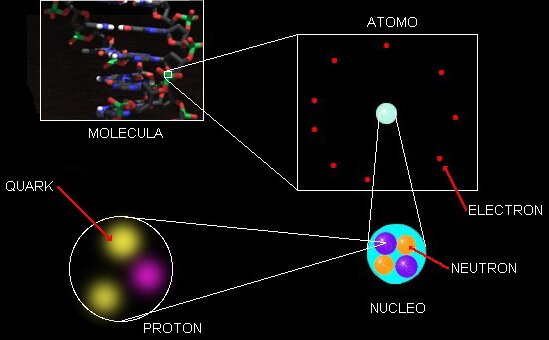

El núcleo del átomo constituye el 99% de la masa

En los átomos existen el mismo número de protones que el de electrones, y, las cargas positivas de los protones son iguales que las negativas de los electrones, y, de esa manera, se consigue la estabilidad del átomo al equilibrarse las dos fuerzas contrapuestas. El electrón fue descubierto en 1.897 por el físico británico Joseph John Thomson (1.856 – 1940). El problema de la estructura (si la hay) del electrón no está resuelto. Si el electrón se considera como una carga puntual, su autoenergía es infinita y surgen dificultades en la ecuación conocida como de Lorente–Dirac.

Es posible dar al electrón un tamaño no nulo con un radio ro, llamado radio clásico del electrón, dado por e2/(mc2) = 2’82×10-13cm, donde e y m son la carga y la masa, respectivamente, del electrón y c es la velocidad de la luz. Este modelo también tiene problemas, como la necesidad de postular las tensiones de Poincaré.

Muchas son las partículas de las que aquí podríamos hablar, sin embargo, me he limitado a las que componen la materia, es decir Quarks y Leptones que conforman Protones y Neutrones, los nucleaones del átomo que son rodeados por los electrones. El Modelo Estándar es la herramienta con la ue los físicos trabajan (de momento) hasta que surjan nuevas y más avanzadas teorías que permitan un modelo más eficaz y realista. De Wikipedia he cogido el cuadro comparativo de las fuerzas.

Tabla comparativa

| Interacción7 | Teoría descriptiva | Mediadores | Fuerza relativa | Comportamiento con la distancia (r) | Alcance (m) |

|---|---|---|---|---|---|

| Fuerte | Cromodinámica cuántica (QCD) | gluones | 1038 |  |

10-15 |

| Electromagnética | Electrodinámica cuántica (QED) | fotones | 1036 |  |

|

| Débil | Teoría electrodébil | bosones W y Z | 1025 |  |

10-18 |

| Gravitatoria | Gravedad cuántica | gravitones (hipotéticos) | 1 |  |

|

La teoría cuántica de campos es el marco general dentro del cual se inscriben la cromodinámica cuántica, la teoría electrodébil y la electrodinámica cuántica. Por otra parte la “gravedad cuántica” actualmente no consiste en un marco general único sino un conjunto de propuestas que tratan de unificar la teoría cuántica de campos y la relatividad general.

Van surgiendo por ahí nuevas conjeturas como, por ejemplo, las de Maldacena.

“Las consecuencias de esta conjetura son muy importantes, pues existe la posibilidad de que el resto de interacciones (electromagnéticas y nucleares) sean tan sólo una ilusión, el reflejo sobre el cristal de un escaparate del contenido de la tienda. Así, podría ser que el electromagnetismo tan sólo sea la imagen proyectada de la interacción de algunas cuerdas en un supuesto interior del espacio-tiempo. De la misma manera, la necesidad de compactificar las dimensiones adicionales desaparece en cierto modo si consideramos que, quizás, nuestro mundo sea solamente la frontera; siendo el interior del espacio-tiempo inaccesible.”

Que gran sorpresa sería si al final del camino se descubriera que en realidad solo existe una sola fuerza: La Gravedad, de la que se derivan las otras tres que hemos podido conocer en sus ámbitos particulares y que, ¿por qué no? podrían surgir a partir de aquella primera y única fuerza existente en los principios o comienzos del Universo: ¡La Gravedad! Que no acabamos de comprender.

emilio silvera

Jul

20

El “universo” fascinante de lo muy pequeño

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

« Matemáticas que describen la Naturaleza

Muchas veces hemos hablado del electrón que rodea el núcleo, de su carga eléctrica negativa que complementa la positiva de los protones y hace estable al átomo; tiene una masa de 1/1.836 de la del núcleo más ligero (el del hidrógeno). La importancia del electrón es vital en el .

El núcleo atómico es la parte central de un átomo tiene carga positiva, y concentra más del 99.99% de la masa total del átomo. fuerza es la responsable de mantener unidos a los nucleones (protón y neutrón) que coexisten en el núcleo atómico venciendo a la repulsión electromagnética los protones que poseen carga eléctrica del mismo signo (positiva) y haciendo que los neutrones, que no tienen carga eléctrica, permanezcan unidos entre sí y también a los protones.

Hasta ahí, lo que es el nucleo. Sin embargo, la existencia de los átomos que las moléculas y los cuerpos -grandes y pequeños- que conforman los objetos del universo, es posible gracias a los electrones que, rodean el núcleo atómico y, al tener carga negativa similar a la positiva de los protones, crean la estabilidad necesaria que todo nuestro mundo sea como lo podemos observar.

Los cuantos cosas bellas y útiles como el ozono atmosférico

Pero busquemos los “cuantos”. La física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck propuso una posible solución a un problema que había estado intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos a una cierta temperatura, y también la radiación infrarroja emitida, con menor intensidad, por los objetos más fríos (radiación de cuerpo negro).

Según la física clásica, la energía radiada debería ser igual todas las longitudes de onda, y al aumentar la temperatura, la radiación debería ser uniformemente más intensa. Para explicar esto, Planck supuso que cada una de las partículas que constituyen la materia, está oscilando y emitiendo energía en forma de radiación electromagnética; esta energía emitida no tomar un valor cualquiera, sino que debe ser múltiplo entero de un valor mínimo llamado cuanto o paquete de energía.

Estaba bien aceptado entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía. Pero si utilizamos las leyes de la termodinámica para calcular la intensidad de una radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano y, desde luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico a una cierta longitud de onda característica, y que la intensidad disminuye tanto para longitudes mayores como para menores. Esta longitud de onda característica es inversamente proporcional a la temperatura absoluta de objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273º cero). Cuando a 1.000º C un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de luz visible.

Lo que Planck propuso fue simplemente que la radiación podía ser emitida en paquetes de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de onda, y por tanto, proporcional a la frecuencia de radiación emitida. La fórmula es E = hν, donde E es la energía del paquete, ν es la frecuencia y h es una constante fundamental de la naturaleza, la constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo esta nueva , el resultado coincidió perfectamente con las observaciones.

Sabemos que la corriente eléctrica es el movimiento de electrones, siendo éstos portadores de cargas eléctricas negativas. Cuando los electrones se mueven, se origina una corriente eléctrica. La corriente es igual al de cargas en movimiento entre un intérvalo de tiempo.

Poco tiempo después, en 1905, Einstein formuló teoría de una manera mucho más tajante: él sugirió que los objetos calientes no son los únicos que emiten radiación en paquetes de energía, sino que toda la radiación consiste en múltiplos del paquete de energía de Planck. El príncipe francés Louis-Victor de Broglie, dándole otra vuelta a la teoría, propuso que no sólo cualquier cosa que oscila tiene energía, sino que cualquier cosa con energía se debe comportar como una “onda” que se extiende en una cierta región del espacio, y que la frecuencia ν de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los de luz deberían verse como una clase de partículas elementales: el fotón. Todas demás clases de partículas llevan asociadas diferentes ondas oscilantes de campos de fuerza.

También en el movimiento de los átomos dentro del núcleo, presente la simetría y la belleza de la Naturaleza.

El curioso comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de de Broglie. Poco después, en 1926, Edwin Schrödinger cómo escribir la teoría ondulatoria de de Broglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños quedaba exactamente determinado por las recién descubiertas “ecuaciones de ondas cuánticas”.

Está bien comprobado que la mecánica cuántica funciona de maravilla…, pero, sin embargo, surge una pregunta muy formal: ¿qué significan realmente estas ecuaciones?, ¿qué es lo que están describiendo? Cuando Isaac Newton, allá en 1867 formuló cómo debían moverse los planetas alrededor del Sol, estaba claro todo el mundo qué significaban sus ecuaciones: que los planetas estaban siempre en una posición bien definida des espacio y que sus posiciones y sus velocidades en un momento concreto determinan inequívocamente cómo evolucionarán las posiciones y las velocidades en el tiempo.

Pero los electrones todo es diferente. Su comportamiento parece estar envuelto en misterio. Es como si pudieran “existir” en diferentes lugares simultáneamente, como si fueran una nube o una onda, y esto no es un efecto pequeño. Si se realizan experimentos con suficiente precisión, se determinar que el electrón parece capaz de moverse simultáneamente a lo largo de trayectorias muy separadas unas de otras. ¿Qué puede significar todo esto?

Niels Bohr consiguió responder a esta pregunta de forma tal que con su explicación se pudo seguir , y muchos físicos siguen considerando su respuesta satisfactoria. Se conoce como la interpretación de Copenhague de la mecánica cuántica que, dicho sea de paso, con la que no todos están de acuerdo.

leyes de la mecánica cuántica han sido establecidas con mucha precisión; permite cómo calcular cualquier cosa que queramos saber. Pero si queremos “interpretar” el resultado, nos encontramos con una curiosa incertidumbre fundamental: que varias propiedades de las partículas pequeñas no pueden estar bien definidas de manera simultánea. Por ejemplo, podemos determinar la velocidad de una partícula con mucha precisión, pero entonces no sabremos exactamente dónde se encuentra; o a la inversa, podemos determinar la posición con precisión, pero entonces su velocidad queda mal definida. Si una partícula tiene espín (rotación alrededor de su eje), la dirección alrededor de la cual rotando (la orientación del eje) no puede ser definida con gran precisión.

No es fácil explicar de forma sencilla de dónde viene esta incertidumbre, pero existen ejemplos en la vida cotidiana que tienen algo parecido. La altura de un tono y la duración en el tiempo durante el cual oímos el tono tienen una incertidumbre mutua similar. Para afinar un instrumento musical se debe escuchar una nota durante un cierto intervalo de tiempo y , por ejemplo, con un diapasón que debe vibrar también durante un tiempo. Notas muy breves no tienen bien definido el tono.

Para que las reglas de la mecánica cuántica funcionen, es necesario que todos los fenómenos naturales en el mundo de las cosas pequeñas estén regidos por las mismas reglas. Esto incluye a los virus, bacterias e incluso a las personas. Sin embargo, cuando más grande y más pesado es un objeto, más difícil es observar las desviaciones de las leyes del movimiento “clásicas” debidas a la mecánica cuántica. Me gustaría referirme a exigencia tan importante y tan peculiar de la teoría con la palabra “holismo”. Esto no es exactamente lo mismo que entienden algunos filósofos por holismo, y que podría definir como “el todo es más que la suma de sus partes”. Si la física nos ha enseñado algo es justo lo contrario. Un objeto compuesto de un gran de partículas puede ser entendido exactamente si se conocen las propiedades de sus partes (partículas); basta que sepamos sumar correctamente (¡y esto no es nada fácil en mecánica cuántica!). Lo que entiendo por holismo es que, efectivamente, el todo es la suma de las partes, pero sólo se puede hacer la suma si todas las partes obedecen a las mismas leyes. Por ejemplo, la constante de Planck, h, que es igual a 6’626075… × 10-34 Julios segundo, debe ser exactamente la misma cualquier objeto en cualquier sitio, es decir, debe ser una constante universal, no importa en qué galaxia la podamos medir.

Einstein y otros pioneros de la M.C., tales como Edwin Schrödinger…, creían que hay más de lo que se ve

reglas de la mecánica cuántica funcionan tan bien que refutarlas resulta realmente difícil. Los trucos ingeniosos descubiertos por Werner Heisemberg, Paul Dirac y muchos otros mejoraron y completaron las reglas generales. Pero Einstein y otros pioneros como Erwin Schrödinger siempre presentaron serias objeciones a interpretación. Quizá funcione bien, pero ¿dónde está exactamente el electrón?, ¿en el punto x o en el punto y? En pocas palabras, ¿dónde está en realidad?, y ¿cuál es la realidad que hay detrás de nuestras fórmulas? Si tenemos que creer a Bohr, no tiene sentido buscar tal realidad. Las reglas de la mecánica cuántica, por sí mismas, y las observaciones realizadas con detectores son las únicas realidades de las que podemos hablar.

La mecánica cuántica puede ser definida o resumida así: en principio, con las leyes de la naturaleza que conocemos se puede predecir el resultado de cualquier experimento, en el sentido que la predicción consiste en dos factores: el primer factor es un cálculo definido con exactitud del efecto de las fuerzas y estructuras, tan riguroso como las leyes de Isaac Newton para el movimiento de los planetas en el Sistema Solar; el segundo factor es una arbitrariedad estadística e incontrolable definida matemáticamente de forma estricta. Las partículas seguirán una distribución de probabilidades dadas, primero de una forma y luego de otra. Las probabilidades se calcular utilizando la ecuación de Schrödinger de función de onda (Ψ) que, con muchas probabilidades nos indicará el lugar probable donde se encuentra una partícula en un momento dado.

Muchos estiman que esta teoría de las probabilidades desaparecerá cuando se consiga la teoría que explique, de completa, todas las fuerzas; la buscada teoría del todo, lo que implica que nuestra descripción actual incluye variables y fuerzas que (aún) no conocemos o no entendemos. Esta interpretación se conoce como hipótesis de las variables ocultas.

Albert Einstein, Nathan Rosen y Boris Podolski idearon un “Gedankenexperiment”, un experimento hipotético, realizado sobre el papel, el cual la mecánica cuántica predecía como resultado algo que es imposible de reproducir en ninguna teoría razonable de variables ocultas. Más tarde, el físico irlandés John Stewar Bell consiguió convertir este resultado en un teorema matemático; el teorema de imposibilidad.

emilio silvera

Jul

17

Materia de sombra, Axiones, ¿WIMPs en el Sol? ¿Y la vida?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Es curioso como a veces, la realidad de los hechos observados, vienen a derribar esas barreras que muchos ponen en sus mentes negar lo evidente. Por ejemplo: Los extraordinarios resultados de la sonda Kepler, que en su primer año de misión ha encontrado ya 1.235 candidatos a planetas, 54 de ellos en la zona habitable de sus estrellas, ha permitido a los investigadores extrapolar el número total de mundos que podría haber sólo en la Vía Láctea, nuestra galaxia. Y ese número ronda los 50.000 millones. De los cuales, además, unos 500 millones estarían a la distancia adecuada de sus soles para permitir la existencia de agua en estado líquido, una condición necesaria para la vida.

Planetas parecidos a la Tierra, como arriba nos dicen, hay miles de millones y sólo cabe esperar que estén situados en los lugares adecuados que la vida tenga la oportunidad de surgir acogida por el ecosistema ideal del agua líquida, una atmósfera acogedora y húmeda, temperatura ideal media y otros parámetros que la vida reqiere para su existencia.

Un equipo de astrónomos internacionales pertenecientes al Observatorio Europeo Austral (ESO), el más importante del mundo, investiga la formación de un posible sistema planetario a partir de discos de material que rodea a una estrella joven. Según un comunicado difundido hoy por el centro astronómico que se levanta en la región norteña de Antofagasta, a través del “Very Large Telescope”(VLT), los científicos han estudiado la materia que rodea a una estrella joven.

Según los astrónomos, los planetas se forman a partir de discos de material que rodean a las estrellas, pero la transición discos de polvo hasta sistemas planetarios es rápida y muy pocos son identificados en esta fase. Uno de los objetos estudiados por los astrónomos de ESO, es la estrella T Chamaleontis (T-Cha), ubicada en la pequeña constelación de Chamaleón, la cual es comparable al sol pero en sus etapas iniciales.

Dicha estrella se encuentra a 330 años luz de la Tierra y tiene 7 millones de años de edad, lo que se considera joven para una estrella. “Estudios anteriores han demostrado que T Cha es un excelente objetivo para estudiar cómo se forman los sistemas planetarios”, señala el astrónomo Johan Olofsson, del Max Planck Institute of Astronomy de Alemania.

Algunas veces hablando de los extensos y complejos temas que subyacen en la Astronomía, lo mismo hablamos de “materia de sombre” que de “supercuerdas” y, se ha llegado a decir que existe otro universo de materia de sonbra que existe en paralelo al nuestro. Los dos universos se separaron la Gravedad se congeló sepapándose de las otras fuerzas. Las partículas de sombra interaccionan con nosotros sólo a través de la fuerza de la gravedad, lo cual las convierte en candidatas ideales para la tan traida y llevada “materia oscura”.

Llegamos a los Axiones.

El actual de la cuestión es que los cosmólogos creen saber que hay una gran cantidad de materia oscura en el Universo y, han conseguido eliminar la candidatura de cualquier tipo de partícula ordinaria que conocemos. En tales circunstancias no se llegar a otra conclusión que la materia oscura debe de existir en alguna forma que todavía no hemos visto y cuyas propiedades ignoramos totalmente. Sin embargo, se atreven a decir que, la Gravedad, es el efecto que se produce cuando la “materia oscura” pierde consistencia… , o algo así. ¡Cómo son!

A los teóricos nada les gusta más que aquella situación en la cual puedan dejar volar libremente la imaginación sin miedo a que nada tan brusco un experimento u observación acabe con su juego. En cualquier caso, han producido sugerencias extraordinarias acerca de lo que podría ser la “materia oscura” del universo.

Lo que hay en el Universo…no siempre lo podemos comprender.

Otro de los WIMPs favoritos se llama axión. el fotino y sus compañeros, el axión fue sugerido por consideraciones de simetría. Sin embargo, a diferencia de las partículas, sale de las Grandes Teorías Unificadas, que describen el Universo en el segundo 10ˉ³5, más que de las teorías totalmente unificadas que operan en el tiempo de Planck.

mucho tiempo han sabido los físicos que toda reacción entre partículas elementales obedece a una simetría que llamamos CPT. Esto significa que si miramos la partícula de una reacción, y luego vemos la misma reacción cuando (1) la miramos en un espejo, (2) sustituimos todas las partículas por antipartículas y (3) hacemos pasar la película hacia atrás, los resultados serán idénticos. En este esquema la P significa paridad (el espejo), la C significa conjugación de carga (poner las antipartículas) y T la reversa del tiempo (pasar la película al revés).

Se pensaba que el mundo era simétrico respecto a CPT porque, al menos al nivel de las partículas elementales, era simétrico respecto a C, P y T independientemente. Ha resultado que no es éste el caso. El mundo visto en un espejo se desvía un tanto al mundo visto directamente, y lo mismo sucede al mundo visto cuando la película pasa al revés. Lo que sucede es que las desviaciones entre el mundo real y el inverso en cada uno de estos casos se cancelan una a la otra cuando miramos las tres combinadas.

Aunque esto es verdad, es verdad que el mundo es casi simétrico respecto a CP actuando solos y a T actuando solo; es decir, que el mundo es casi el mismo si lo miran en un espejo y sustituyen las partículas por antipartículas que si lo miran directamente. Este “casi” es lo que preocupa a los físicos. ¿Por qué son las cosas casi perfectas, pero les falta algo?

La respuesta a esta cuestión parece que estar en la posible existencia de esa otra partícula apellidada axión. Se supone que el Axión es muy ligero (menos de una millonésima parte de la masa del electrón) e interacciona sólo débilmente con otra materia. Es la pequeña masa y la interacción débil lo que explica el “casi” que preocupa a los teóricos.

nos asomamos a la Teoría de cuerdas, entramos en un “mundo” lleno de sombras en los que podemos ver brillar, a lo lejos, un resplandor cegador. Todos los físicos coinciden en el hecho de que es una teoría muy prometedora y de la que parece se podrán obtener buenos rendimientos en el futuro pero, de momento, es imposible verificarla.

El misterio de las funciones modulares podría ser explicado por quien ya no existe, Srinivasa Ramanujan, el hombre más extraño del mundo de los matemáticos. Igual que Riemann, murió antes de cumplir cuarenta años, y como Riemann antes que él, trabajó en total en su universo particular de números y fue capaz de reinventar por sí mismo lo más valioso de cien años de matemáticas occidentales que, al estar aislado del mundo en las corrientes principales de los matemáticos, le eran totalmente desconocidos, así que los buscó sin conocerlos. Perdió muchos años de su vida en redescubrir matemáticas conocidas.

Dispersas oscuras ecuaciones en sus cuadernos están estas funciones modulares, que figuran entre las más extrañas jamás encontradas en matemáticas. Ellas reaparecen en las ramas más distantes e inconexas de las matemáticas. Una función que aparece una y otra vez en la teoría de las funciones modulares se denomina ( ya he dicho otras veces) hoy día “función de Ramanujan” en su honor. Esta extraña función contiene un término elevado a la potencia veinticuatro.

¿Podeis imaginar la existencia de un Universo en permanente sombra?

La idea de un universo en sombra nos proporciona una manera sencilla de pensar en la materia oscura. El universo dividido en materia y materia se sombra en el Tiempo de Planck, y una evolucionó de acuerdo con sus propias leyes. Es de suponer que algún Hubble de sombra descubrió que ese universo de sombra se estaba expandiendo y es de suponer que algunos astrónomos de sombras piensan en nosotros candidatos para su materia oscura.

¡ que incluso haya unos ustedes de sombras leyendo la versión de sombra de este trabajo!

Partículas y partículas supersimétricas

Partículas son las que todos conocemos y que forman la materia, la supersimétricas, fotinos, squarks y otros, las estamos buscando sin poder hallarlas.

Estas partículas son predichas por las teorías que unifican todas las fuerzas de la naturaleza. Forman un conjunto de contrapartidas de las partículas a las que estamos habituados, son mucho más pesadas. Se nombran en analogía con sus compañeras: el squark es el compañero supersimétrico del quark, el fotino del fotón, etc. Las más ligeras de estas partículas podrían ser la materia oscura. Si es así, partícula probablemente pesaría al menos cuarenta veces más que el protón.

Materia de sombra, si existe, no hemos sabido dar con ella y, sin embargo, existen indicios de que está ahí

En algunas versiones de las llamadas teorías de supercuerdas hay todo un universo de materia de sombra que existe paralelo con el nuestro. Los dos universos se separaron la gravedad se congeló separándose de las otras fuerzas. Las partículas de sombra interaccionan con nosotros sólo a través de la fuerza de la gravedad, lo que las convierte en candidatas ideales para la materia oscura.

Axiones

El Axión es una partícula muy ligera (pero presumiblemente muy común) que, si existiera, resolvería un problema antiguo en la teoría de las partículas elementales. Se estima que una masa menor que una millonésima parte de la del electrón y se supone que impregna el universo de una manera semejante al fondo de microondas. La materia oscura consistiría en agregaciones de axiones por encima del nivel general de fondo.

Construímos inmensos aparatos de ingeniosas propiedades tecnológicas tratar de que nos busquen las WIMPs

¿WIMPs en el Sol?

A lo largo de todo el se ha dado a entender que todas estas partículas candidatas a materia oscura de la que hemos estado hablando, son puramente hipotéticas. No hay pruebas de que ninguna de ellas se vaya a encontrar de hecho en la naturaleza. Sin embargo sería negligente si no mencionase un argumento –un diminuto rayo de esperanza- que tiende a apoyar la existencia de WIMPs de un u otro. Este argumento tiene que ver con algunos problemas que han surgido en nuestra comprensión del funcionamiento y la estructura del Sol.

Creemos que la energía del Sol viene de reacciones nucleares profundas dentro del núcleo. Si éste es el caso en realidad, la teoría nos dice que esas reacciones deberían estar produciendo neutrinos que en principio son detectables sobre la Tierra. Si conocemos la temperatura y composición del núcleo ( creemos), entonces podemos predecir exactamente cuántos neutrinos detectaremos. Durante más de veinte años se llevó a cabo un experimento en una mina de oro de Dakota del Sur para detectar esos neutrinos y, desgraciadamente, los resultados fueron desconcertantes. El número detectado fue de sólo un tercio de lo que se esperaba. Esto se conoce como el problema del neutrino solar.

El problema de los neutrinos solares se debió a una gran discrepancia el número de neutrinos que llegaban a la Tierra y los modelos teóricos del interior del Sol. Este problema que duró mediados de la década de 1960 hasta el 2002, ha sido recientemente resuelto mediante un entendimiento de la física de neutrinos, necesitando una modificación en el modelo estándar de la física de partículas, concretamente en las neutrinos” href=”http://es.wikipedia.org/wiki/Oscilaci%C3%B3n_de_neutrinos”>oscilaciones de neutrinos. Básicamente, debido a que los neutrinos tienen masa, pueden cambiar del tipo de neutrino que se produce en el interior del Sol, el neutrino electrónico, en dos tipos de neutrinos, el muónico y el tauónico, que no fueron detectados.

La segunda característica del Sol que concierne a la existencia de WIMPs se refiere al hecho de las oscilaciones solares. los astrónomos contemplan cuidadosamente la superficie solar, la ven vibrar y sacudirse; todo el Sol puede pulsar en períodos de varias horas. Estas oscilaciones son análogas a las ondas de los terremotos, y los astrónomos llaman a sus estudios “sismología solar”. Como creemos conocer la composición del Sol, tenemos que ser capaces de predecir las propiedades de estas ondas de terremotos solares. Sin embargo hay algunas duraderas discrepancias entre la teoría y la observación en este campo.

No mucho que los astrónomos han señalado que si la Galaxia está en realidad llena de materia oscura en la de WIMPs, entonces, durante su vida, el Sol habría absorbido un gran número de ellos. Los WIMPs, por tanto, formarían parte de la composición del Sol, una parte que no se había tenido en cuenta hasta ahora. Cuando los WIMPs son incluidos en los cálculos, resultan dos consecuencias: primero, la temperatura en el núcleo del Sol resulta ser menor de lo que se creía, de forma que son emitidos menos neutrinos, y segundo, las propiedades del cuerpo del Sol cambian de tal modo que las predicciones de las oscilaciones solares son exactas.

nos atrevemos a exponer una imagen que nos muestra la distribución de los WIMPs

Este resultado es insignificante en lo que se refiere a la existencia de WIMPs, pero no debemos despreciar las coincidencias halladas, lo más prudente será esperar a nuevos y más avanzados experimentos (SOHO y otros). Tanto el problema del neutrino como las oscilaciones se pueden explicar igualmente por otros efectos que no tienen nada que ver con los WIMPs. Por ejemplo, el tipo de oscilaciones de neutrinos podría resolverse si el neutrino solar tuviera alguna masa, aunque fuese muy pequeña, y diversos cambios en los detalles de la estructura interna del Sol podrían explicar las oscilaciones. No obstante estos fenómenos solares constituyen la única indicación que tenemos de que uno de los candidatos a la materia oscura pueda existir realmente.

Toda charla sobre supersimetría y teoría últimas da a la discusión de la naturaleza de la materia oscura un tono solemne que no tiene ningún parecido con la forma en que se lleva en realidad el debate entre los cosmólogos. Una de las cosas que más me gusta de este campo es que todo el mundo parece ser capaz de conservar el sentido del humor y una distancia respecto a su propio trabajo, ya que, los buenos científicos saben que, todos los cálculos, conjeturas, hipótesis y finalmente teorías, no serán visadas en la aduana de la Ciencia, hasta que sean muy, pero que muy bien comprobadas mediante el experimento y la observación y, no una sino diez mil veces de que puedan ser aceptadas en el ámbito puramente científico.

El el Sol podemos hallar algunas respuestas

Posiblemente, el LHC nos pueda decir algo al respecto si, como no pocos esperan, de sus colisiones surgen algunas partículas supersimétricas que nos hablen de ese otro mundo oscuro que, estando en este, no hemos sabido encontrar este momento. Otra posibilidad sería que la tan manoseada materia oscura no existiera y, en su lugar, se descubriera otro fenómeno o mecanismo natural desconocido hasta ahora que, incidiendo en el comportamiento de expansión del Universo, nos hiciera pensar en la existencia de la “materia oscura” cubrir el hueco de nuestra ignorancia.

Hace algún tiempo, en esas reuniones periódicas que se llevan a cabo entre científicos de materias relacionadas: física, astronomía, astrofísica, comología…, alguien del grupo sacó a relucir la idea de la extinción de los dinosaurios y, el hombre se refirió a la teoría (de los muchas que circulan) de que el Sol, en su rotación alrededor de la Vía Láctea, se salía periódicamente fuera del plano de la Galaxia. Cuando hacía esto, el polvo existente en ese plano podía cesar de proteger la Tierra, que entonces quedaría bañada en rayos cósmicos letales que los autores de la teoría pensaban que podían permeabilizar el cosmos. Alguien, el fondo de la sala lanzó: ¿Quiere decir que los dinosaurios fueron exterminados por la radiación de fotinos?

La cosa se tomó a broma y risas marcaron el final de la reunión en la que no siempre se tratan los temas con esa seriedad que todos creen, toda vez que, los conocimientos que tenemos de las cosas son muy limitados y tomarse en serio lo que podría no ser… ¡No sería nada bueno!

Por ejemplo, si vemos la imagen de arriba y un letrero que diga: “Dopar un aislante topológico con impurezas magnéticas rompe la simetría de inversión temporal y abre una nueva vía a la espintrónica.” Para la mayoría de los presentes, el galimatias no le dirá nada y, sin embargo, para otros al tanto de las cuestiones de física, le parecerá que: “Los aislantes topológicos son materiales que conducen electrones en su superficie exterior, pero actúan como aislantes en su volumen interior. propiedad tiene su origen en la forma en que los electrones se mueven a través del material. Los electrones poseen un espín mecánico-cuántico que apunta hacia “arriba” o hacia “abajo”. El espín es normalmente independiente del movimiento de los electrones, pero dentro de los aislantes topológicos, el espín de los electrones está estrechamente relacionado con su movimiento.”

¡Qué cosas! Lo que digo siempre… ¡Nunca llegaremos a saberlo todo!

emilio silvera

Jul

16

La Masa y la Energía ¿Qué son en realidad?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

Todos los intentos y los esfuerzos por hallar una pista del cuál era el origen de la masa fallaron. Feynman escribió su famosa pregunta: “¿Por qué pesa el muón?”. Ahora, por lo , tenemos una respuesta parcial, en absoluto completa. Una voz potente y ¿segura? nos dice: “!Higgs¡” más de 60 años los físicos experimentadores se rompieron la cabeza con el origen de la masa, y ahora el campo Higgs presenta el problema en un contexto ; no se trata sólo del muón. Proporciona, por lo menos, una fuente común todas las masas. La nueva pregunta feynmaniana podría ser: ¿Cómo determina el campo de Higgs la secuencia de masas, aparentemente sin patrón, que da a las partículas de la matería?

La variación de la masa con el de movimiento, el cambio de masa con la configuración del sistema y el que algunas partículas (el fotón seguramente y los neutrinos posiblemente) tengan masa en reposo nula son tres hechos que ponen entre dicho que el concepto de masa sea un atributo fundamental de la materia. Habrá que recordar aquel cálculo de la masa que daba infinito y nunca pudimos resolver; los físicos sólo se deshicieron de él “renormalizándolo”, ese truco matemático que emplean no saben encontrar la respuesta al problema planteado.

Ese es el problema de trasfondo con el que tenemos que encarar el problema de los quarks, los leptones y los vehículos de las fuerzas, que se diferencian por sus masas. que la historia de Higgs se tenga en pie: la masa no es una propiedad intrinseca de las partículas, sino una propiedad adquirida por la interacción de las partículas y su entorno.

La idea de que la masa no es intrinseca la carga o el espín resulta aún más plausible por la idílica idea de que todos los quarks y fotones tendrían masa cero. En ese caso, obedecerían a una simetría satisfactoria, la quiral, en laque los espines estarían asociados siempre con su dirección de movimiento. Pero ese idilio queda oculto por el fenómeno de Higgs. ¡Que ahora parece haber sido puesto al desnudo!

¡Ah, una cosa más! Hemos hablado de los bosones gauge y de su espín de una unidad; hemos comentado las partículas fermiónicas de la materia (espin de media unidad). ¿Cuál es el pelaje de Higgs? Es un bosón de espin cero. El espín supone una direccionalidad en el espacio, el campo de Higgs da masa a los objetos dondequiera que estén y sin direccionalidad. Al Higgs se le llama a veces “bosón escalar” [sin dirección] por esa razón.

La interacción débil, recordareis, fue inventada por E. Fermin describir la desintegración radiactiva de los núcleos, que era básicamente un fenómeno de poca energía, y a medida que la teoría de Fermi se desarrolló, llegó a ser muy precisa a la hora de predecir un enorme número de procesos en el dominio de energía de los 100 MeV. Así que ahora, con las nuevas tecnologías y energías del LHC, las esperanzas son enormes para, por fin, encontrar el bosón Higgs origen de la masa… y algunas cosas más.

Fabiola Gianotti, portavoz del experimento ATLAS, ofrece algunos avances:

“En nuestros observamos claros signos de una nueva partícula compatible con la teoría de Higgs, con un nivel aproximado de 5 sigma [99,977% de eficiencia], en la región de masa alrededor de los 126 GeV. El increíble rendimiento del LHC y el ATLAS y los enormes esfuerzos de mucha gente nos han traído a este excitante punto, pero falta un poco más de tiempo para preparar estos resultados cara a su publicación.”

El Modelo Estándar describe las partículas de todo cuanto nos rodea, incluso de nosotros mismos. Toda la materia que podemos observar, sin embargo, no parece significar más que el 4% del total. Higgs podría ser el puente para comprender el 96% del universo que permanece oculto.

El 4 de julio de 2012 se anunció el descubrimiento de un bosón. Punto. En diciembre de 2012 se empezó a hablar de “un” Higgs (en lugar de “el” Higgs), pero oficialmente seguía siendo un nuevo bosón. ¿Importa el nombre? El Premio Nobel de Física para el bosón de Higgs sólo será concedido cuando el CERN afirme con claridad y rotundidad que se ha descubierto “el” Higgs, si el CERN es conservador, la Academia Sueca lo es aún más. Sin embargo, el rumor es que quizás baste con que el CERN diga que se ha descubierto “un” Higgs.

¿Por qué, a pesar de todas las noticias surgidas el CERN, creo que no ha llegado el momento de celebrarlo? ¿Es acaso el Higgs lo encontrado?

Hay que responder montones de preguntas. ¿Cuáles son las propiedades de las partículas de Higgs y, lo que es más importante, cuál es su masa? ¿Cómo reconoceremos una si nos la encontramos en una colisión de LHC? ¿Cuántos tipos hay? ¿Genera el Higgs todas las masas, o solo las incrementarse? ¿Y, cómo podemos saber más al respecto? También a los cosmólogos les fascina la idea de Higgs, pues casi se dieron de bruces con la necesidad de tener campos escalares que participasen en el complejo proceso de la expansión del Universo. A pesar de todo (Nobel incluido), habrá que dar muchas explicaciones sobre el Higgs “dadort de masas”.

Este gráfico de arriba me recuerda el “efecto frenado” de Ramón Marquez

El campo de Higgs, tal y como se lo concibe ahora, se destruir con una energía grande, o temperaturas altas. Estas generan fluctuaciones cuánticas que neutralizan el campo de Higgs. Por lo tanto, el cuadro que las partículas y la cosmología pintan juntas de un universo primitivo puso y de resplandeciente simetría es demasiado caliente Higgs. Pero la temperatura cae bajo los 10’5 grados kelvin o 100 GeV, el Higgs empieza a actuar y hace su generación de masas. Así por ejemplo, antes de Higgs teníamos W, Z y fotones sin masa y la fuerza electrodébil unificada.

El Universo se expande y se enfría, y entonces viene el Higgs (que engorda los W y Z, y por alguna razón ignora el fotón) y de ello resulta que la simetría electrodébil se rompe. Tenemos entonces una interacción débil, transportada por los vehículos de la fuerza W+, W–, Z0, y por otra una interacción electromagnética, llevada por los fotones. Es si para algunas partículas del campo de Higgs fuera una especie de aceite pesado a través del que se moviera con dificultad y que las hiciera parecer que tienen mucha masa. otras partículas, el Higgs es como el agua, y para otras, los fotones y quizá los neutrinos, es invisible.

Para cada suceso, la línea del haz es el eje común de los cilindros de ECAL y HCAL. ¿Cuál es el mejor candidato W? el mejor candidato Z? En cada evento, ¿dónde ocurrió la colisión y el decaimiento de las partículas producidas? Lo cierto es que, en LHC se hacen toda clase de pruebas para saber del mundo de las partículas, de dónde vienen y hacia dónde se dirigen y, el Bosón de Higgs, es una asignatura pendiente a pesar de las noticias y de los premios

De todas las maneras, es tanta la ignorancia que tenemos sobre el origen de la masa que, nos agarramos como a un clavo ardiendo el que se ahoga, en caso, a la partícula de Higgs que viene a ser una de las soluciones que le falta al Modelo Estándar que todo encaje con la teoría.

¡Ya veremos en que termina todo esto! Y, aunque el que suena siempre es Higgs, lo cierto es que los autores de la teoría del “Bosón de Higgs”, son tres a los que se ha concedido, junto al CERN, el Premio Principe de Asturias. Peter Ware Higgs —el primero en predecir la existencia del bosón— junto a los físicos François Englert, y el belga Robert Brout—fallecido en el año 2011—.

Peter Higgs, de la Universidad de Edimburgo, introdujo la idea en la física de partículas. La utilizaron los teóricos Steven Weinberg y V. Salam, que trabajaban por separado, para comprender se convertía la unificada y simétrica fuerza electrodébil, transmitida por una feliz familia de cuatro partículas mensajeras de masa nula, en dos fuerzas muy diferentes: la QED con un fotón carente de masa y la interacción débil con sus W+, W– y Z0 de masa grande. Weinberg y Salam se apoyaron en los trabajos previos de Sheldon Glasgow, quien tras los pasos de Julian Schwinger, sabía sólo que había una teoría electrodébil unificada, coherente, pero no unió todos los detalles. Y estaban Jeffrey Goldstone y Martines Veltman y Gerard’t Hooft. hay otras a los que había que mencionar, pero lo que siempre pasa, quedan en el olvido de manera muy injusta. Además, ¿Cuántos teóricos hacen falta para encender una bombilla?

La verdad es que, casi siempre, han hecho falta muchos. Recordemos el largo recorrido de los múltiples detalle sueltos y físicos que prepararon el terreno que, llegara Einstein y pudiera, uniéndolo todo, exponer su teoría relativista.

Sobre la idea de Peter Higgs, Veltman, uno de sus arquitectos, dice que es una alfombra bajo la que barremos nuestra ignorancia. Glasgow es menos amable y lo llamó retrete donde echamos las incoherencias de nuestras teorías actuales. La objeción principal: que no teníamos la menor prueba experimental que parece que va asomando la cabeza en el LHC.

![]()

Esperemos que la partícula encontrada, el bosón hallado, sea en realidad el Higgs dador de masa a las demás partículas pero… ¡Cabe la posibilidad de que sólo sea el hermano menor! de la familia. El modelo estándar es lo bastante fuerte decirnos que la partícula de Higgs de menor masa (podría haber muchas) debe “pesar” menos de 1 TeV. ¿Por qué? Si tiene más de 1 TeV, el modelo estándar se vuelve incoherente y tenemos la crisis de la unitariedad.

Después de todo esto, tal como lo están planteando los del CERN, se llegar a la conclusión de que, el campo de Higgs, el modelo estándar y nuestra idea de cómo se hizo el Universo dependen de que se encuentre el Bosón de Higgs. Y ahora, por fin, el mayor Acelerador del mundo, el LHC, nos dice que el Bosón ha sido encontrado y las pruebas tienen una fiabilidad enorme.

¡La confianza en nosotros mismos, no tiene límites! el camino no ha sido recorrido por completo y quedan algunos tramos que tendremos que andar para poder, al fín, dar una explicación más completa, menos oscura y neblinosa que lo que hasta el momento tenemos, toda vez que, del Bosón de Higgs y de su presencia veráz, dependen algunos detalles de cierta importancia para que sean confirmados nuestros conceptos de lo que es la masa y, de paso, la materia.

¿Pasará igual con las cuerdas?

emilio silvera

Fuente: León Lederman

Totales: 83.782.435

Totales: 83.782.435 Conectados: 65

Conectados: 65