Feb

2

Nuevas ideas, ideas viejas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

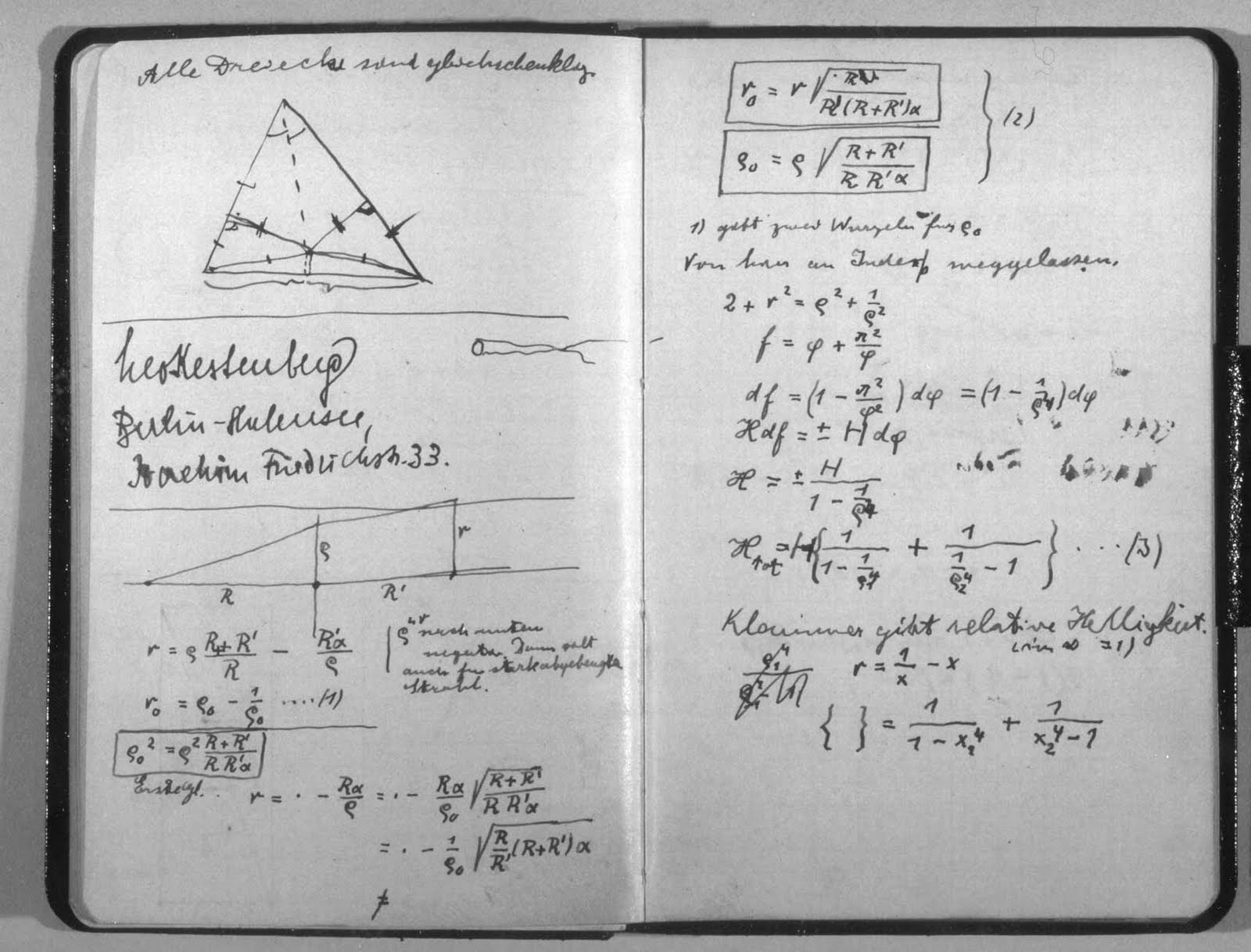

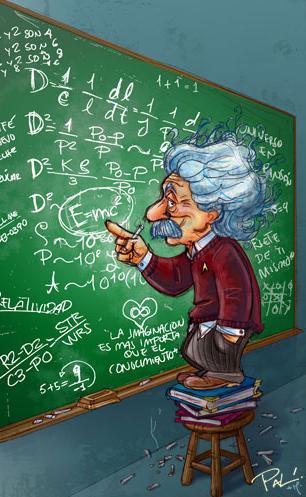

Cuando Einstein irrumpió en la Física, nadie le conocía y sólo era un oscuro empleado de la Oficina de Patentes de Berna en Suiza. Él, sin embargo, no había dejado de estar al día y seguí todo aquello que se pudiera mover en relñación a su pasión: La Física. Los escritos de Mach, de Lorentz, de Maxwell, de Planck… Todo ello le llevó a elaborar su famosa teoría relativista que convulsionó el mundo de la ciencia y, si me apuras mucho, hasta el ámbito filosófico cambió a partir de la relatividad. Una teoría que venía a decir cosas increibles como que la masa era energía congelada, que la luz marcaba el límite de la velocidad del universo, o, que el tiempo se ralentizaba si se marcha a velocidades cercanas a c. Esos estraños postulados no fueron, en un principio, bien entendidos por la física del momento.

Manuscrito de Einstein con la fórmula de la Teoría de la Relatividad. Cuando esto se dio a conocer al mundo, muchos miraron excépcicos la fórmula y las implicaciones que de ella se podrían derivar, aquello podría cambiar lo firmemente establecido: ¡sacrilegio! ¿qué será de la Física si hacemos caso a lo que diga cualquiera?

Siempre ha sido así, el Status Institucional establecido, bien acomodado en los sillones de las academias y corporaciones, hacen la señal de la cruz, como para espantar al diablo, cada vez que aparecen nuevas ideas que, en realidad, les aterra, toda vez que les puede remover de sus asientos y prebendas, ya que, generalmente, dejan al descubierto que todo lo que predomina, está asentado en una falsa base de criterios y teorías que no siempre, son las correctas ni pueden ser demostradas y, mientras tanto eso ocurre, ellos, ¡a vivir que son dos días!

En el trabajo “No siempre la Física se puede explicar con palabras”, el amigo Tom Vood nos deja el siguiente comentario que, al parecerme de interés aquí os lo inserrto para que todos, podais pensar en lo que aquí expone: Creo que sí, deben ser divulgadas.

!”Te dejo una entre muchas “revelaciones” reciente, calentitas solo para ti; que no quisiera que se divulgaran. Pero le dejo a su responsabilidad, si borrarlas, si usted cree que debo seguir como guerrillero de la ciencia o debe ser conocidas estas ideas por toda la comunidad científica. Disculpa, pero no logro discernir eso. Pero como admiras tanto a Einstein y yo soy tan tonto, te la insinúo por arribita: (Según el modelo de la interacción Luz-Luz).

http://www.emiliosilveravazquez.com/blog/2012/05/31/acercarse-a-la-velocidad-de-la-luz-trae-consecuencias/

¿Sabes por que las energíasmasas (partículas, o electromagnéticos confinados) no pueden superar la velocidad de la luz?

Bueno Einstein se moriría por explicárselo; a pesar de que para los modernos físicos esas preguntas ilegales no se le hacen a la física; recuerda el famoso: ¡no preguntes y calcula! Como diciendo, no eres físico, sino físico-matemático. O lo que no se, o no me puedo explicar, no lo puedes preguntar, es de mal gusto hacerlo, o de ignorantes. ¡Que daño Dios!

Bueno, pues una partícula según mi modelo es energíacampo confinada o electromagnético confinado en forma de energíamasa y por lo tanto cuando alcanza la velocidad de la luz, ocurre la ruptura de simetría que lo regresa a ser de nuevo energíacampo.

Más riguroso: Si una energíamasa alcanza la velocidad de la luz, se convierte en energíacampo.

De aquí se extraen miles de corolarios:

-Las energíasmasas (partículas) si alcanzan la velocidad de la luz, solo que una vez que la alcanzan, se rompe su topología de confinación, de energíasmasas y se liberan de nuevo como energíascampos. Algo que nunca dejaron de ser. Es que eso nunca las cinco física anteriores lo prohibían; por algo era. Mi modelo no mutila, incorpora,… Son los físicos, los que al no tener un buen modelo, medio que lo veían implícito así en la teoría; que eso no podía suceder. Pero si sucede, solo que nunca pueden sostenerse así.

Tom parece tener en sus manos las respuesto pero… se les escapa entre los dedos

-Nunca una energíamasa (partícula con masa) podrá superar la velocidad de la luz. La conclusión Eisteniana que nadie se ha podido explicar. Vez que fácil es todo, una vez que se va ha la física.

-La velocidad de la luz no es una barrera, la barrera es la ley que confina la energíacampo, en forma de energíamasa. Esa topología, geometría; o relaciona geometrías/energía.

-Toda aniquilación, desintegración y explosión tipo Big Bang (odio, o no creo lo del Big Bang) de los cuerpos del macrocosmo, es por la misma causa.

-De esto se extrae (del modelo también) la ley universal permitibilidad máxima de energía por unidad de espaciotiempo… El VICEVERSA; porque si no todo fuera energíascampos y la naturaleza no ocurre así: Toda energíacampo (luz,…) se confina como energíamasa, cuando su velocidad se hace cero.

-O lo que es lo mismo, ninguna partícula sin masa puede llegar a alcanzar el estado de reposo. Otra cosa que ningún modelo ha explicado, aunque es evidente que es un principio natural. Como todo lo que les explico. ¡Total, si eso es ilegal para el establishment!

De aquí se infieren muchas preguntas, conclusiones, paradojas, o explicaciones más racionales, a muchas cosas que decimos explicadas o que no hemos explicado todavía.

también nosotros estamos inmersos en un campo de energía-masa

La energíascampos (ustedes siempre piensen en la luz como yo al principio, para que no se pierdan) nunca puede estar en reposo (que la energía no puede estar en reposo es conocido, por eso es energía), pero como si existen circunstancias físicas muy especiales, donde esta puede ir disminuyendo su velocidad hasta que sea cero; la naturaleza resuelve esta paradoja, confinando las energíascampos, en diferentes topologías que donde se conserva como energíascampos (mas fácil verlo si piensan en luz); pero exteriormente se manifiesta como un ente, que puede estar en reposo o moverse como un todo; como lo que llamamos partículas con masa ( para mi energíasmasas).

Otra idea que puede ayudarlos a digerir esto: la energíacampo oscila, están acotadas entre la velocidad cero y la velocidad “c”. Esa oscilación, tipo superficie de agua hirviente, es lo que ocurre en la superficie de un agujero negro. Otra revelación de la riqueza física que despliega el modelo.

Te explico mejor: Cuando una energíacampo (luz) cae en un campo tan intenso como el de un agujero negro, su velocidad comienza a disminuir, llegado al “horizonte” (concepto que hay que ampliar) donde su velocidad seria cero; según mi modelo se confina como una energíamasa y trataría de moverse como un todo. Y aquí pueden ocurrir varias cosas que no te he explicado. Según la geometría que adopte la confinación, podrá ser un fermión izquierdo o derecho (una partícula o una antipartícula); así que puede ocurrir aniquilación…

También podría ocurrir que esa partícula (o energíamasa) alcance la velocidad de la luz; es decir regrese ha ser energíacampo, ya te explique por que. Ahora, la gravitación es energíacampo también, y aquí ocurre que ella penetra a la partícula (el mismo proceso de la aniquilación, todo es lo mismo, hay una regularidad natural entre el micromundo y el macromundo, que nadie ve), satura la estabilidad de su topología, y esta se desintegra (aquí tienes la explicación de todos los procesos de desintegración y con el, los tiempos de vida). Pero desintegración en mi razonamientos, en el modelo; es decaer en otra topología de menor energía y cuando esas topologías estables, quedan agotadas por las leyes naturales, que los físicos llamamos de conservación (carga, spin, Isoespin, CP, CPT,…); no le queda otro remedio a la energíamasa; que volver ha ser una energíacampo.

Estaría bien que Tom pudiera, por fín, atrapar con los dedos de la Mente, su teoría Luz-Luz (débil-fuerte) para asombrar al mundo.

Bueno espero haberte complacido en algo, “tuvisteis la exclusividad”, lo dejo ahí porque para que lo digieran y porque tengo muchos problemas que resolver. Tampoco tengo tiempo de leer lo que escribí (como ya es costumbre); pero ustedes son inteligentes como para no crucificarme, así que corrígeme ha tus Dones. Pueden divulgar a su antojo, como siempre les digo, “mi física de café con leche”. Tómense su tiempo para digerirlo, para acostumbrarse a estas nuevas concepciones físicas, esto párese merecerlo, parece novedoso.

Gracias amigo, te agradecemos las revelaciones que, si al fin se abren camino, nos podrían llevar a terrenos más cercanos a la realidad física del mundo. Daríamos un paso adelante en la comprensión del Universo y, como pasa siempre que obtenemos alguna nueva respuesta…¡Podríamos seguir planteando neuvas preguntas! que por cierto, ahora no podemos hacer por no tener ese conocimiento que tú tratas de entregar al mundo.

Sigamos con la Gravedad Cuántica

La física será incompleta y conceptualmente insatisfactoria en tanto no se disponga de una teoría adecuada de la gravedad cuántica. Todos hemos oido hablar de la incompatibilidad de las dos teorías que sustentan hoy por hoy toda la Física y que, todosm también sabemos que, son teorías incompletas que necesitan de una reunificación en un todo poderoso que todo lo puesda explicar.

Durante el siglo XX, la física se fundamentó, en general, sobre dos grandes pilares: la mecánica cuántica y la teoría de relatividad. Sin embargo, a pesar de los enormes éxitos logrados por cada una de ellas, las dos aparecen ser incompatibles. Esta embarazosa contradicción, en el corazón mismo de física teórica, se ha transformado en uno de los grandes desafíos permanentes en la ciencia.

La teoría de la relatividad general da cuenta a la perfección de la gravitación. Por su parte, la aplicación a la gravedad de la mecánica cuántica requiere de un modelo específico de gravedad cuántica. A primera vista, parecería que la construcción de una teoría de gravedad cuántica no sería más problemático que lo que resultó la teoría de la electrodinámica cuántica (EDC), que ya lleva más de medio siglo con aplicaciones más que satisfactorias.

En lo medular, la EDC describe la fuerza electromagnética en términos de los cambios que experimentan las llamadas partículas virtuales, que son emitidas y rápidamente absorbidas de nuevo; el principio de incertidumbre de Heisenberg nos dice que ellas no tienen que conservar la energía y el movimiento. Así la repulsión electrostática entre dos electrones puede ser considerada como la emisión, por parte de un electrón, de fotones virtuales y que luego son absorbidos por el otro.

La misma mecánica, pero a través de los cambios de la partícula virtual de la gravedad el «gravitón» (el quantum del campo gravitacional), podría considerarse para estimar la atracción gravitacional entre dos cuerpos. Pero gravitones nunca se han visto. La gravedad es tan débil que puede obviarse a escala molecular, donde los efectos cuánticos son importantes. Ahora, si los cambios que podrían realizarse en los gravitones sólo se producen en la interacción entre dos puntos de masa, es posible, entonces, que en los cuerpos masivos se ignore los efectos cuánticos. El principio de incertidumbre de Heisenberg nos señala que no podemos medir simultáneamente la posición y la velocidad de una partícula subatómica, pero esta indeterminación es imperceptible para los planetas, las estrellas o las galaxias.

Sí, pero, ¿qué me dices del gravitón?

Pero el principal obstáculo, sin embargo, es la cantidad de complicados procesos que implica examinar un gran número de gravitones. La gravedad se diferencia crucialmente del electromagnetismo al no ser lineal. Esta inlinealidad surge porque la gravedad posee la energía, y ésta tiene la masa, que gravita. En el lenguaje cuántico, esto implica que gravitones interactúan recíprocamente con otro gravitones, a diferencia de los fotones, que interactúan sólo con cargas y corrientes eléctricas y no con otros fotones. Ahora, como los gravitones interactúan el uno con el otro, las partículas de materia son rodeadas por complejas redes de gravitones virtuales que forman «lazos cerrados», muy semejante a «árboles bifurcados».

En la teoría de campo cuántica, los lazos cerrados son un signo de problema; ellos normalmente producen respuestas infinitas en los cálculos de procesos físicos. En EDC, tales lazos ocurren cuando un electrón emite y absorbe de nuevo su propio fotón. En ese caso, los infinitos son soslayados a través de un procedimiento matemático conocido como renormalización. Si éste es hecho correctamente, se obtienen razonables respuestas. La QED es lo que se llama una teoría renormalizable porque todos los infinitos pueden ser soslayados sistemáticamente; en efecto, solo un conjunto de operaciones matemáticas es suficiente para eliminar los infinitos.

Parece que aquí puede estar la solución

Lamentablemente, tal procedimiento sistemático no es operativo cuando la mecánica cuántica es aplicada a la relatividad general; la teoría es, por lo tanto, «no-renormalizable». Cada proceso que implique progresivamente más lazos cerrados de gravitones introduce nuevas variantes de términos infinitos. Lo anterior, coarta la investigación para muchísimos fenómenos de interés, y sugiere que puede que haya básicamente algo que esté errado en la relatividad general, en la mecánica cuántica, o en ambas.

Pero miremos más allá del problema de renormalización, ¿qué pasaría si nos remontáramos a un momento en que todo lo que podemos ver, y hasta lo que hay más allá de nuestro «horizonte» de 13.000 millones de años luz, estaba comprimido hasta un volumen menor que el de un núcleo atómico? A estas densidades descomunales, que se dieron durante los primeros 10-43 segundos del universo (lo que se conoce como «tiempo de Planck»), tanto los efectos cuánticos como la gravedad habrían sido importantes. ¿Qué pasa cuando los efectos cuánticos convulsionan todo un universo?

Por ello, la física será incompleta y conceptualmente insatisfactoria en tanto no se disponga de una teoría adecuada de la gravedad cuántica. Algunos teóricos creen que ya es tiempo de explorar las leyes físicas que prevalecían en el tiempo de Planck, y han propuesto algunas hipótesis interesantes. Sin embargo, no hay consenso sobre qué ideas hay que descartar. Lo que es seguro es que debemos rechazar nuestras queridas concepciones del espacio y el tiempo basadas en el sentido común: el espaciotiempo a muy pequeña escala podría tener una estructura caótica, espumosa, sin ninguna flecha temporal bien definida; puede que haya una generación y fusión continua de agujeros negros primores y minúsculos. La actividad podría ser lo bastante violenta para generar nuevos dominios espaciotemporales que evolucionarían como universos independientes. Eventos más tardíos (en particular la fase inflacionaria que se describe en el capítulo XVI) podrían haber borrado cualquier rastro de la era cuántica inicial. El único lugar donde podrían observarse efectos cuántico-gravitatorios sería cerca de las singularidades centrales de los agujeros negros (de donde ninguna señal puede escapar). Una teoría sin consecuencias evidentes fuera de estos dominios tan exóticos e inaccesibles no es verificable. Para que se la tome en serio debe estar íntimamente insertada o, en su efecto, articulada en alguna teoría con fundamento empírico, o bien debe percibirse como una conclusión inevitable y convincente.

Durante las últimas décadas, varias tentativas han sido hechas para buscarle una solución al problema de la no-renormalización de la gravedad cuántica y caminar hacia la unificación de todas las fuerzas. La aproximación más esperanzadora para alcanzar ese viejo anhelo de los físicos es la teoría de las «supercuerdas», que ya anteriormente vimos.

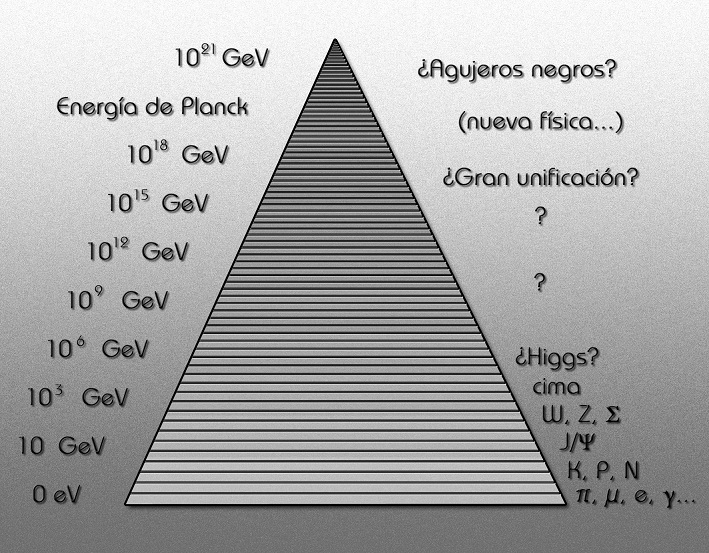

Sin embargo, recordemos aquí que en la teoría de las supercuerdas se presume una escala natural energética determinada por la energía de Planck, alrededor de unos 1019 GeV. Esto es 1017 veces más alto que los tipos de energías que pueden ser producidos en los aceleradores de partículas más grandes, lo que imposibilita contrastar con la teoría la existencia misma de las supercuerdas. No obstante, los teóricos esperan que a escala de energía accesible tanto la física, la relatividad general, el electromagnetismo, las fuerzas nucleares débiles y fuertes, las partículas subatómicas surjan de la teoría de las supercuerdas como una aproximación. Así, se espera conseguir con ese modelo de cuerdas no sólo una ajustada descripción de la gravedad cuántica, sino que también intentar con ella la anhelada unificación de las fuerzas.

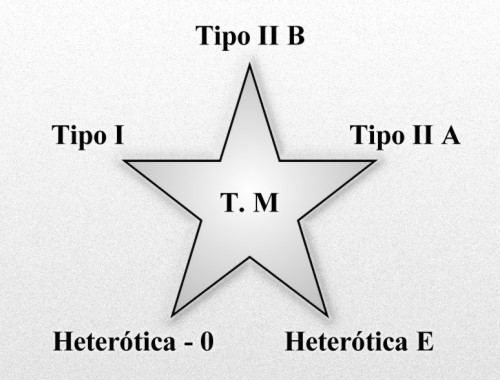

Lamentablemente, no hay un único límite de baja energía para la teoría de las supercuerdas como tampoco un sólo modelo de la teoría. Por un tiempo, lo anterior pareció como una barrera infranqueable, pero en años recientes, y a través de una mayor abstractación matemática, se ha construido un nuevo modelo de supercuerdas conocido como «la teoría M» que amalgama dentro de ella otras teorías de supercuerdas.

Por ahora, es demasiado pronto para pronunciarse si la teoría M es finalmente el medio que reconciliará la gravitación y la mecánica cuántica, pero sí debería poder cumplir con algunas expectativas, como ser las de explicar algunos hechos básicos sobre el mundo físico. Por ejemplo, el espaciotiempo de cuatro dimensional tendría que surgir de la teoría, más bien que ser insertado en ella. Las fuerzas y las partículas de naturaleza también deberían ser descritas, preferentemente incluyendo sus propiedades claves, como fuerzas de interacción y masas. Sin embargo, a no ser que la teoría M, o una variante futura, pueda ser proyectada a la baja energía de los laboratorio de física para poder ser contrastada, corre el riesgo de empezar a ser olvidada y finalmente archivada como uno más de los muchos y elegantes ejercicios matemáticos que se han elaborado para la física en los últimos tiempos.

Cuerdas o filamentos vibrantes en el corazón de la materia

Si la teoría de supercuerda es una pérdida de tiempo o no, ello está por verse. Por ahora, el desafío más duro a superar por la teoría es entender por qué el espacio de 9 dimensiones más el tiempo se «comprime» bajo el aspecto de nuestro espacio habitual tetradimensional (el tiempo más las tres dimensiones espaciales), en vez de hacerlo en tres o cinco dimensiones, y ver cómo sucede esto. Aún hay un espacio infranqueable entre la teoría de supercuerdas y los fenómenos observables. La teoría de supercuerdas plantea problemas demasiado difíciles ahora mismo para los matemáticos. En este aspecto, es muy diferente de la mayor parte de teorías físicas: normalmente, el aparato matemático de las teorías se desarrolla antes que éstas. Por ejemplo, Einstein utilizó conceptos geométricos desarrollados en el siglo XIX, no tuvo que partir de cero para construir las matemáticas que necesitaba.

Por su parte, los físicos cuerdistas se acorralan en lo que es fácil de comprobar, es difícil de calcular y lo que es fácil de calcular, es difícil comprobar. En consecuencia, pareciera que el camino que se está siguiendo es pretender desarrollar la teoría más y más, y hacer cálculos cada vez más difíciles de manera de poder predecir cosas que sean fáciles de observar. ¿El camino tendrá tiempo y final? Nadie tiene por ahora la respuesta.

El físico Eugene Wigner escribió un célebre artículo sobre este particular que llevaba por título «La irrazonable efectividad de la matemática en las ciencias físicas». También es un hecho notable que el mundo exterior muestre tantas estructuras susceptibles de descripción en «lenguaje» matemático (sobre todo cuando tales estructuras se alejan mucho de las experiencias cotidianas que moldearon la evolución de nuestros cerebros). Edward Witten, el principal experto en supercuerdas, describe dicha teoría como «una física del siglo XXI que cayó en el siglo XX». Sin embargo, sería más extraordinario que seres humanos de cualquier siglo llegaran a desarrollar una teoría tan «final» y general como pretenden ser las supercuerdas.

Salvo mejor parecer

Ene

28

¡La Física! en el siglo XIX

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

La Física, como todo, evoluciona

Simplemente con echar una mirada al siglo XIX, nos podemos percatar de que, ese período fue apasionante la Ciencia y la Tecnología que comenzaron a cambiar de manera acelerada produciendo importantes cambios en nuestra Sociedad, sus usos y sus costumbres.

No es extraño encontrar textos de la época en los que, aquella sucesión imparable de inventos y de muchos descubrimientos, marcarían el desarrollo de una nueva Humanidad.

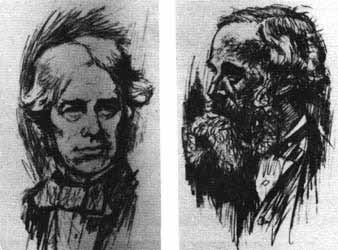

Faraday y J. C. Maxwell.

Las lecturas de la época dejan a veces traslucir sentimientos de asombro, admiración, desconcierto y, a veces, un poco de temor de todos aquellos avances que parecían sacados de una novela de ciencia ficción.

Sí, queremos mostrar episodios referidos a grandes descubrimientos que, por estas razones, llaman la atención. Claro que, si nos trasladamos mentalmente a aquellos momentos y aquella época, podremos comprender mejor, todas aquellas reacciones entonces desencadenadas que , vistas en perspectiva, son lo que sería de esperar y de una total normalidad.

¿Que sería de nuestro mundo sin las personas que aparecen en esta foto?. Sería difícil nombrar a un físico relevante del siglo XX que no aparezca en ella. Corresponde a la quinta conferencia, año 1927, promovida por el filántropo belga Ernerst Solvay. De los 29 asistentes, 17 ya habían, o lo harían poco después, ganado el premio Nobel (al menos una vez). Schrödinger, Einstein (repite en esta lista), M. Curie, Bohr, Planck, Lorentz, Heissenberg, Pauli… científicos inigualables que cambiaron el concepto del mundo, desde el vasto Universo hasta el pequeño átomo.

Aquellos episodios fueron recogidos en lecturas y manuales de Física del siglo XIX, y, lo mismo que fueron saliendo a la luz (sin orden ni concierto), serán aquí comentados. Lo cierto es que, todo aquello nos trajo consecuencias históricas, sociales y educativas.

En general, el siglo XIX es el de la consolidación de la Física como disciplina autónoma. Se manifiesta en ella un afán por establecer un campo de estudio propio, separándose por un lado de la Química, y por el otro de las matemáticas, a la que ha pertenecido hasta entonces como una rama de la misma: las matemáticas mixtas(óptica, estática, astronomía.

En ese momento la Física comienza a adquirir importancia las distintas ramas del saber. Dos factores contribuyen a ello. El primero, la incorporación de nuevos conocimientos que amplían espectacularmente el horizonte de la disciplina. El segundo, el fundamental: el cambio de orientación con relación al espíritu especulativo que estuvo presente hasta bien avanzado el siglo anterior.

Pronto llegarían nuevos conceptos, nuevas teorías

De este modo, la Física asume un enfoque más experimental, al tiempo que dará paso a una utilización creciente de las matemáticas.

Drespretz, en el prólogo de su Física Experimental (1839): “La Física, en el estado á que ha llegado en la actualidad, no tiene de común más que el con la Física llamada escolástica, que los preceptos de Bacón y los ejemplos de Galileo han contribuido felizmente á desterrar de la enseñanza pública.”

La Física de orientación escolástica todavía perdura, especialmente en nuestro país, a principios del siglo XIX. marcar las diferencias, se insiste en que la nueva Física es Física Experimental que se contempla como “ciencia útil” y capaz de incidir con sus aplicaciones en la vida de las personas y en las Sociedades en general.

Aquellos tiempos eran de carruajes que comenzaron a correr sin caballos, máquinas de vapor que “aprovecha la potencia motriz del fuego” que surgieron en Inglaterra del siglo XVIII para sustituir a los animales en el bombeo del agua, cuando ésta inundaba las minas de carbón. La máquina “atmosférica” de Newcomen fue la primera, seguida por la de Watt que mejoró el diseño con un condensador para el vapor, haciéndola mucho más eficiente.

En 1827, el ingeniero francés Marc Seguir inventó la caldera tubular, que obtenía mayor provecho de la fuerza generada por el vapor. Stephenson aplicó sistema a la locomotora The Rocket, que era capaz de transportar 12.942 kilos a 24 km por hora con una pendiente del 2%.

Ninguno de aquellos avances se llevó a cabo con respaldo teórico hasta que aparecen los estudios de Carnot en 1824. En ese nace la termodinámica y a partir de ahí el progreso se dispara.

La Máquina de vapor tiene lugar preferente en los manuales de Física de la época y se describen de manera minuciosa todos y uno de los elementos que intervienen en su funcionamiento. Faltaba sin embargo, la fundamentación teórica, la cual tardaría varias décadas en ser incorporada.

A lo más, los dos únicos principios explicativos que aparecen son la “fuerza elástica del vapor” y “la caída de presión cuando el vapor se condensa”. Claro que, la máquina de vapor adoptó nuevos y más modernos diseños y, de estar fijas en sus lugares de , pasaron a poder desplazarse con la gran ventaja que ello suponía, y, hasta tal punto fue así que, aquella idea del desplazamiento, dio lugar a la llegada del Ferrocarril por una parte y de la Navegación fluvial a vapor por otra, con lo cual, aquello nos llevó en volandas hacia el futuro. Un futuro hasta hacía poco impensable.

“[…] máquinas admirables que lo mismo producen su efecto en puntos fijos, como marchando con una prodigiosa velocidad, ya sobre las barras de hierro, borrando las distancias, ó ya surcando los mares sobre unas tablas, y haciendo vecinos los dos mundos que estos mares separan. (Rodríguez, 1858, p. 320, en su manual de Física general y aplicada a la agricultura y a la industria. Madrid, Aguado (1858).”

Resulta muy curioso en la que eran presentados estos nuevos inventos y las referencias que utilizaban para ello al tratar de transmitir al lector novedades de tal magnitud:

“Igualmente se las ha aplicado á los carruajes que se hacen marchar sin caballerías para transportar cargamentos muy considerables, ó mejor para arrastrar tras de sí un número mayor o menor de carruajes ordinarios cargados de todas las mercancías, ó de otra clase de objetos. (Beudant, 1841, p. 283. Tratado Elemental de Física (3ª Edic.) Madrid, Imprenta de Arias (1841).”

Como vemos, lo era descrito en base a lo ancestral. Se percibe que comienza a producirse cambios de incalculables consecuencias, que hará que el mundo, deje de ser lo que era.

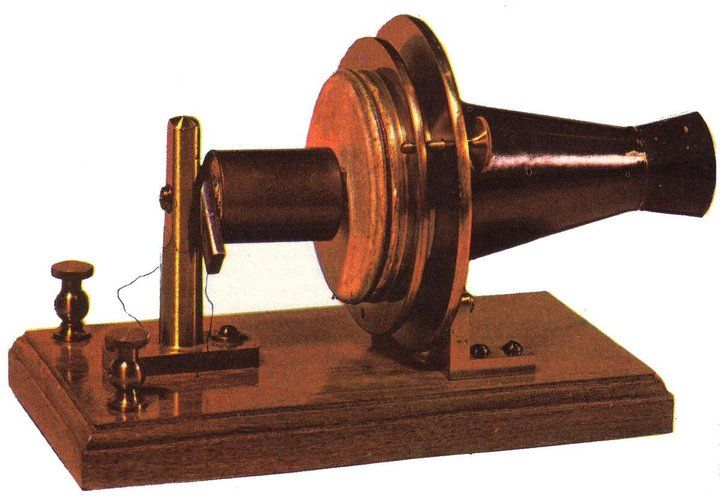

Tras haber pasado desapercibida siglos, la electricidad comienza un desarrollo fulgurante en el siglo XVIII. En ese período se establecen las leyes básicas y surgen las primeras teorías explicativas de los fenómenos conocidos. Coulomb cierra el siglo estableciendo la primera ley cuantitativa e introduciendo la electricidad en el marco de la ciencia newtoniana.

La bateria eléctrica de Volta y las primeras ciudades alumbradas

Volta apiló discos de igual tamaño de cobre y de cinc, sólo o con estaño, alternados, que llevan intercalados cada uno de ellos un paño humedecido. Esta “pila de discos” empieza y termina con discos de diferente tipo. Conectando con un alambre los discos situados en los extremos logró que fluyera un flujo eléctrico. Impregnando el paño en determinadas sales la corriente obtenida era mucho mayor.

Así, en el siglo XIX se abre con una aportación de gran trascendencia: la pila de Volta, cuyos efectos “son tan extraordinarios que sin exageración se puede decir que es el instrumento más maravilloso que ha creado la inteligencia humana” (González Chávarri, 1848). La pila amplia el campo de la electricidad incorporando todos los fenómenos relacionados con la entonces llamada “electricidad galvánica”. Poco más tarde, gracias a los trabajos de Oersted y Faraday, aparece otro dominio de inmensas posibilidades: el electromagnetismo. El descubrimiento de la conexión entre corriente eléctrica e imanes va a ser seguida de la puesta a punto de aparatos y máquinas que serán el soporte de la electricidad industrial y marcarán el tránsito hacia la Sociedad contemporánea.

La Electricidad acuña fama de ser un agente físico poderoso y, al mismo tiempo, sorprendente, vistos los fenómenos y efectos que suele protagonizar. Se presenta como capaz de hacer posible todo lo imaginable e inimaginable. Tanto es así que por ejemplo, es capaz de producir luz ¡sin utilizar fuego! Así, los manuales describen la experiencia realizada por Davy en 1801, que mediante una pila de gran de elementos hace saltar un arco de luz cegadora (arco voltaico) entre dos barras próximas de carbón.

Liebherr, en el emplazamiento británico de Sunderland, se decidió por el moderno procedimiento por arco voltaico pulsado, por lo que utiliza sistemas digitales del TransPuls Synergic 5000 de Fronius.

La luz a diferencia de las chispas se mantenían durante un cierto tiempo, pero las barras se iban consumiendo y llegaba un momento en que cesaba el fenómeno. Con base a experiencia se construyeron aparatos destinados a la iluminación, provistos de un complicado sistema que mantenía las distancias de las barras. El arco estaba protegido de las corrientes de aire por un tubo de vidrio.

Otro inconveniente era la duración muy limitada de pilas y baterías, pero a partir de los años 1860 comenzaron a estar operativas las dinamos y problema quedó solucionado.

No sería justo hablar de la luz sin nombrar a N. Tesla

Poco más tarde, 1880 y gracias a que el espabilado Edison se apropió de las ideas de Tesla, surgió y se impulsó la bombilla de incandescencia, dispositivo durable y de bajo coste de producir luz mediante la corriente. Ha sido el sistema que hemos conocido hasta nuestros días.

Podríamos seguir hasta llegar a lo que hoy es la Fisica, sin embargo, ni el sitio es tan extenso ni el tiempo lo permite.

emilio silvera

Ene

15

La partícula que es materia y antimateria a la vez

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

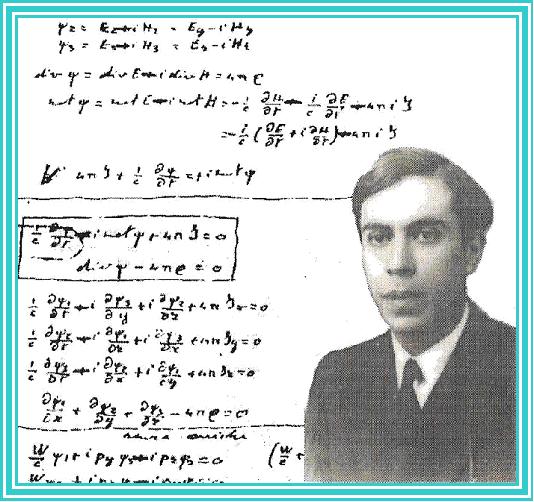

Un equipo de EEUU crea una exótica partícula cuya existencia se predijo hace más de 70 años

En 1937, un joven y brillante físico italiano llamado Ettore Majorana predijo la existencia de una partícula aparentemente imposible. No tenía carga y, por tanto, podía comportarse a la vez como si estuviese hecha de materia y antimateria. Hacía solo unos años que Paul Dirac, otro joven y brillante físico británico, había explicado la teoría moderna de la antimateria. Esta venía a decir que por cada elemento de materia conocida podía haber un reverso con carga opuesta hecha de antimateria. Así, un electrón tendría su positrón y un protón, su antiprotón. Cuando ambos entraban en contacto se desintegraban de forma violenta dejando escapar un estallido de radiación. La excepción era esa exótica partícula predicha por Majorana. Desde entonces, nadie ha conseguido observarla en la naturaleza. Su falta de carga haría que estas partículas, llamadas fermiones de Majorana, no interactuaran con la materia convencional con lo que serían muy difíciles de detectar. Hoy se piensa que partículas similares podrían ser las que componen la esquiva materia oscura, esa sustancia que compone el 23% del universo sin que nadie aún haya conseguido observarla de forma directa. Un año después de hacer su propuesta, como si fuese uno de sus fermiones indetectables, Ettore Majorana desapareció sin dejar rastro mientras viajaba en un barco hacia Nápoles.

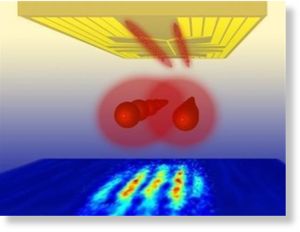

Hoy, un equipo de investigadores de EEUU publica un estudio en el que demuestran haber observado fermiones de Majorana. Tal y como predijo el físico, se trata de partículas que se comportan como si estuviesen hechas de materia y antimateria al mismo tiempo y que serían a la vez una partícula y su propia antipartícula.

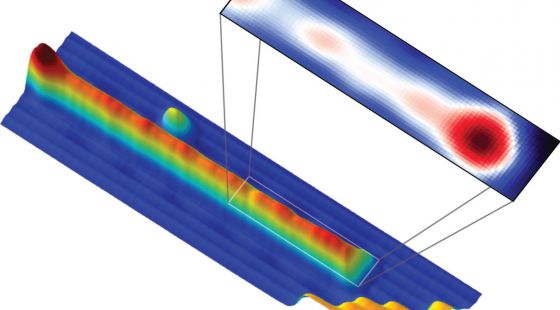

“Hemos tomado una imagen directa del fermión de Majorana”

El hallazgo no se ha hecho en un gran acelerador de partículas, como en el caso del bosón de Higgs, sino en un experimento controlado con materiales superconductores y observado con un microscopio de efecto túnel, que permite ver un material a nivel atómico. Los investigadores tomaron una finísima tira de hierro de un átomo de ancho y la enfriaron hasta rozar el cero absoluto (-273 grados). Fue entonces cuando, a cada extremo de la cadena, aparecieron los esquivos fermiones de Majorana.

“Hemos tomado una imagen directa del fermión de Majorana usando el microscopio de efecto túnel en lugar de detectar su existencia de forma indirecta”, explica a Materia Ali Yazdani, uno de los investigadores de Princeton autores del hallazgo. Sus resultados se publican hoy en la revista Science. En 2012, otro equipo europeo clamó haber observado los mismos fermiones. Pero su detección no era del todo directa y las señales observadas podían deberse a otras causas. Las nuevas pruebas “dan más más credibilidad” a la creación de partículas de Majorana, señala Llorenç Serra, del Instituto nstituto de Física Interdisciplinar y Sistemas Complejos (CSIC-UIB).

Pero, ¿son estas partículas realmente fermiones como los predichos por el desaparecido Majorana? Es una cuestión que enciende a los físicos que trabajan con detectores como el LHC o en grandes sensores para cazar neutrinos. Estos experimentos pueden observar partículas fundamentales naturales, producidas de forma espontánea en el universo o de forma provocada haciendo chocar protones a velocidades cercanas a la de la luz. Por el contrario, las partículas generadas en experimentos como el de Princeton deben su comportamiento a los átomos que las rodean, en este caso de hierro y plomo. No son partículas elementales sino una variante inferior que los físicos denominan “cuasipartículas”. La gran pregunta ahora es si las propiedades que se observan en estas cuasipartículas se dan también en el mundo de las partículas elementales.

Por ejemplo se piensa que el neutrino, que apenas interactúa con la materia, podría ser a la vez partícula y antipartícula. Esto explicaría cómo pudo surgir un universo como el que conocemos, pero nadie, por ahora, lo ha conseguido demostrar. Otras posibles partículas de Majorana aún no confirmadas y también esenciales para entender el universo serían los neutralinos, que compondrían la materia oscura, otro de los grandes interrogantes de la física actual.

“El hecho de que la naturaleza produzca cuasipartículas de Majorana resulta cuando menos sugestivo de que las partículas elementales que pueden serlo, como el neutrino, también lo serán”, opina Juan José Gómez-Cadenas. Este físico del CSIC dirige un experimento en Canfranc con el que pretende ser el primero en detectar a ese esquivo neutrino que es partícula y su contrario. “Da la impresión de que, también aquí se cumple la regla que dice que la naturaleza siempre opta por que si una cosa es posible, entonces va y la implementa”, resalta.

Yazdani añade que “quizás la clave del estudio sea que demostrar un concepto de forma experimental y con precisión en un sistema te puede dar confianza de que quizás esa misma idea juegue un papel en otro sistema”. Y añade “Esta política de preguntarse ‘¿por qué no? es probablemente la que inspiró a Majorana y ha sido clave en muchos hallazgos científicos”.

Después de 76 años, el destino del propio Majorana sigue siendo un misterio.”

Hasta aquí el arículo de El Pais.

Ettore Majorana (1906-¿1938?) solo publicó 10 artículos científicos, el último de ellos póstumo. Sin embargo, muchos lo comparan con Newton, con Galileo y con los grandes genios del siglo XX. Durante su vida muy pocos se dieron cuenta de su genio, salvo quizás Enrico Fermi (1901-1954), Premio Nobel de Física en 1938 por su teoría de la interacción débil, quien le dirigió la tesis de grado en 1929, y Emilio G. Segré (1905-1989), Premio Nobel de Física en 1959 por el descubrimiento del antiprotón, que fue su profesor en 1928. ¿Por qué Majorana es un mito y está considerado uno de los físicos más importantes e influyentes del siglo XX? Hay un tipo de fermiones que recibe su nombre, los fermiones de Majorana, en pie de igualdad con los fermiones de Dirac. Obviamente, solo un gran genio puede poner su nombre al lado de los de Fermi y Dirac. ¿Realmente Majorana fue uno de los padres de la física del siglo XX?

Las Matemáticas

La historia se articula fundamentalmente entorno a la relación de Ettore Majorana (1906-1938), un joven genio de las matemáticas puras, con el físico Enrico Fermi (1901 – 1954). En su primer encuentro, Fermi entra en un aula donde este joven se encuentra solo, escribiendo en una pizarra (la escena puede verse aquí). “¿Has probado tú esa solución?”, le pregunta. Ettore se vuelve ligeramente para ver a su interlocutor, y al momento sigue escribiendo, respondiendo “Fue difícil al principio, pero sólo fueron cuentas”. Fermi se sonríe con sorna (¿sólo cuentas?), y le pregunta sobre el tiempo que le llevó resolverlo. “Es verdad que me ha llevado bastante. Estuve toda una noche”, responde el joven. Fermi, con un tono un poco más severo, responde: “A nosotros nos llevó una semana. Y éramos tres”. A continuación le pregunta por sus intereses como estudiante. Hace ingeniería, aunque afirma no apasionarle demasiado, y explica cómo ve las cosas:

En realidad me gustan las matemáticas, pero me fastidia que todo el mundo se aproveche de ellas. Físicos, ingenieros, generales de artillería… El esfuerzo de resolver un problema debería bastar por sí mismo – un cálculo perfecto debería ser inmediatamente destruido.

En ese instante, después de volver a echar un vistazo a la pizarra, Fermi comienza a borrarla. “¿Qué hace?”, le pregunta Ettore. “Destruyo un cálculo perfecto”, responde. Entonces Fermi le ofrece un libro, y le pide que elija lo que quiera. Ettore abre por una página al azar, y se lo devuelve. “No es fácil”, responde, pero claro, para eso es el gran Enrico Fermi, no le queda más remedio que resolver el ejercicio en cuestión, que resulta ser una integral definida. La escribe. Es la siguiente:

![]()

Mientras Fermi escribe y llena la pizarra de cuentas, Ettore se sienta de espaldas a él sobre la tarima, y escribe en una pequeña libreta (del tamaño de los post-it, aproximadamente). Cuando la cámara muestra lo que ha escrito, mientras Fermi sigue llenando el encerado, vemos la integral, a continuación x = 2cosht, y directamente la expresión de una primitiva (ver la imagen):

![]()

y mentalmente, como en otros momentos de la película, pensativo, acaba escribiendo el resultado: 1,21. Ha terminado mucho antes que Fermi, que sigue llenando la pizarra. Sonríe.

Al poco, Fermi termina y exclama “¡Ya está hecho!” Y recuadra la solución, 1,21. Vemos la pizarra en la imagen, tal y como la haría cualquiera (cualquiera que sepa, por supuesto, que un cambio de variable posible para eliminar la raíz cuadrada es trigonométrico; recuérdense para deducir si necesitamos una razón circular o hiperbólica las identidades sen2x + cos2x = 1, o cosh2x – senh2x = 1). Fermi utiliza el teorema del cambio de variable, etc., etc. Entonces Ettore le lanza el cuadernillo para que compruebe cómo llegó a la misma solución en menor tiempo y necesitando menos espacio.

Si uno se toma la molestia de hacer el cálculo (es pesado, pero “non è difficile”, es un ejercicio de primero de ingeniería; perdón, de grado en ingeniería, aunque tal y como se han pensado estos nuevos estudios (que toman su nombre de una ciudad italiana, precisamente), probablemente ya no la haga nadie, y en el mejor de los casos, se la encomienden al ordenador), comprobará que el resultado de la primitiva (al menos el que me sale a mí) es:

![]() ,

,

que en realidad vale 1.205234942 (y esto último sí lo he hecho con el ordenador). Hay un error en el argumento de la arcotangente, y no sabemos quien es esa misteriosa γ, que por más vueltas que le he dado, no se me ha ocurrido. Pero desde luego, pensando en cómo el cine representa las matemáticas, nada que ver con la integral trivialona de la película española comentada el mes pasado.

Adelanto hacia la computación cuántica

Más allá de los misterios del cosmos, la investigación en este campo tiene otra posible aplicación en el terreno de la computación cuántica. Esta disciplina pretende generar ordenadores millones de veces más potentes que los actuales aprovechando las propiedades cuánticas de ciertas partículas. El hecho de que los fermiones generados sean duales, a la vez materia y antimateria, les da una sorprendente estabilidad respecto a su entorno, lo que podría ayudar a usarlos para componer bits cuánticos más manejables que los que actualmente se diseñan basados en electrones, según una nota de prensa difundida por Princeton. “Son unos experimentos muy sólidos, que dan más credibilidad a que la física de partículas Majorana aparece en los sistemas de materia condensada”, opina Llorenç Serra, que investiga los efectos cuánticos de ciertos materiales en el Instituto nstituto de Física Interdisciplinar y Sistemas Complejos (CSIC-UIB). Serra coincide en que el tipo de materiales usados en este estudio, cadenas de hierro superconductoras, tienen potencial para mejorar la computación cuántica. “La gran ventaja que tienen”, dice, es que los fermiones de Majorana “están deslocalizados en los dos extremos del cable”. Esto, dice, “les hace robustos y un estado cuantico robusto frente a pérdidas de coherencia es imprescindible para un ordenador cuantico”.

Publica: emilio silvera

Ene

13

La Física es la llave del futuro

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (4)

Comments (4)

Alguna vez he leído alguna historia en las que había hadas en el frondoso jardín. Es cierto, no existen pruebas de que así pudiera ser. Sin embargo, tampoco las hay de que no las haya, y, el hecho cierto de que nosotros, los humanos, no la hayamos podido ver, no es prueba de su inexistencia. Hay que tener una imaginación abierta a todo y, de esa manera, evitamos sobresaltos y sorpresas inesperadas que, dicho sea de paso, pueden estar a cada paso que damos. El Universo es eso, un océano de maravillosas sorpresas que nos habla del comportamiento de las grandes energías y de la materia, unas veces disfrazada de estrella, otras de emisiones gamma y no en pocas ocasiones de agujeros negros y púlsares.

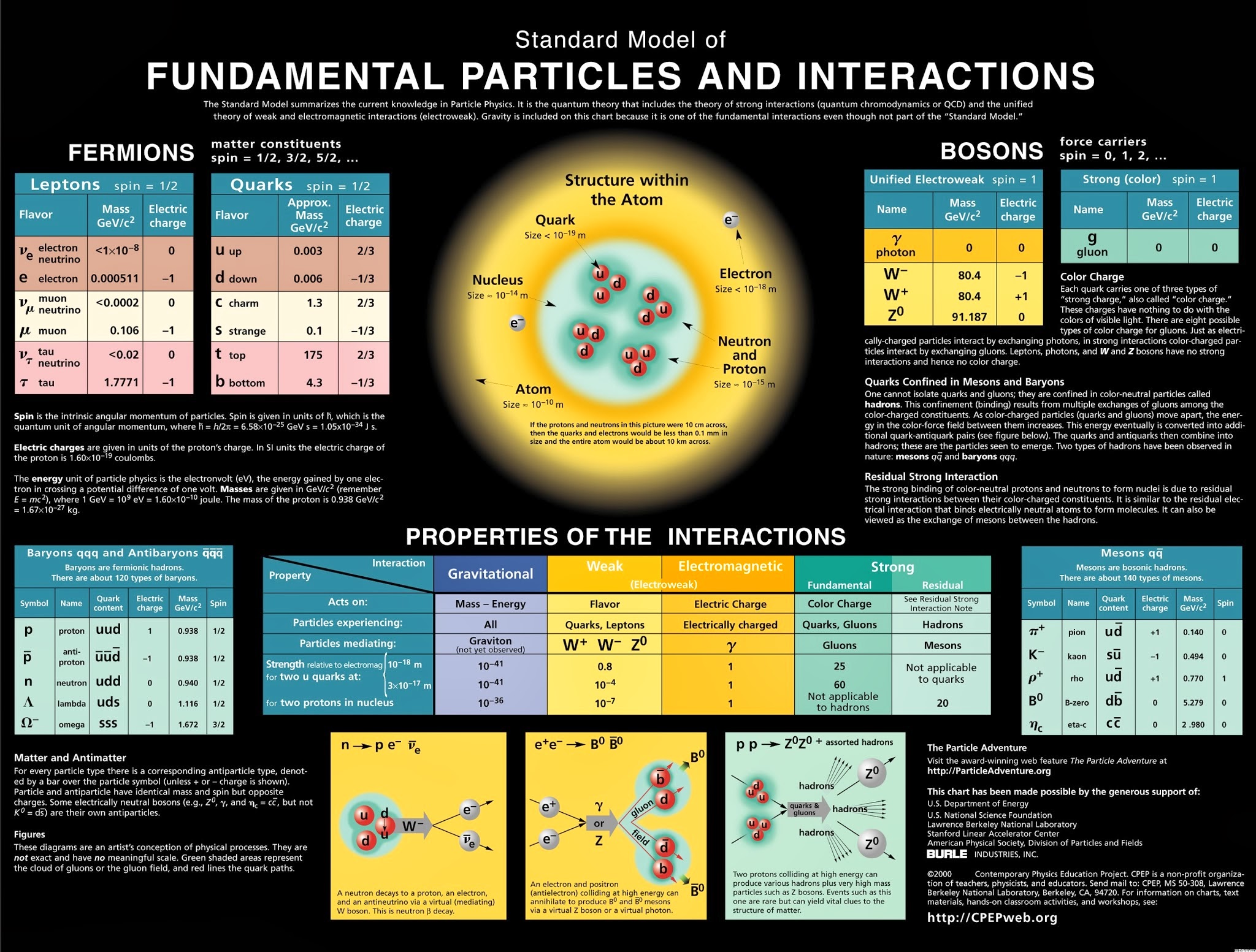

El modelo estándar de partículas fundamentales y sus interacciones

Esta imagen representa todo lo que conocemos, y que se ha podido verificar experimentalmente, sobre la estructura de la materia de la que estamos hechos nosotros y todo lo que hasta ahora hemos observado en el universo, con el nivel de precisión que podemos alcanzar utilizando los instrumentos que tenemos.

Equilibrio, estabilidad: el resultado de dos fuerzas contrapuestas que en el átomo están presentes

Por ahí deambula uno de mis trabajos sobre este mismo tema que titulé ¡La perfección imperfecta! En referencia al Modelo Estándar que no incorpora la Gravedad, y, se ha construido un edificio que nos habla de cómo funciona el universo y, sin embargo, le falta uno de sus pilares, precisamente, ese que nos dice como es su geometría espacial en presencia de grandes masas.

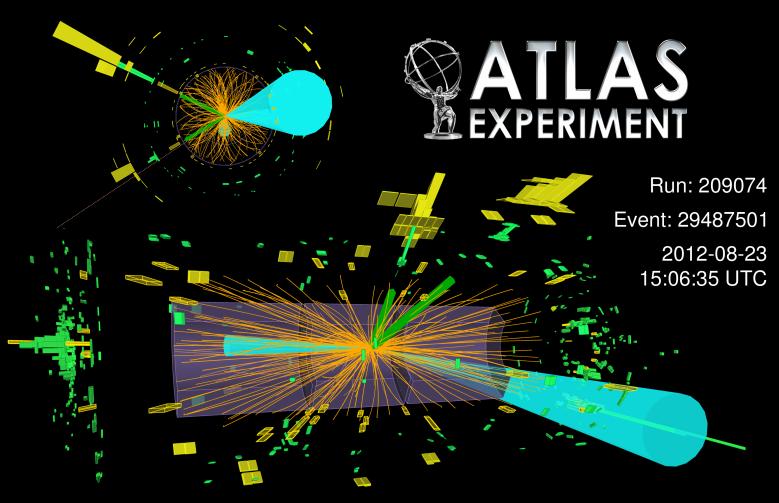

“Colisión del Bosón de Higgs desintegrándose en fermiones”. Primeras evidencias de un nuevo modo de desintegración del bosón de Higgs. Las primeras evidencias de la desintegración del recién descubierto bosón de Higgs en dos partículas denominadas tau, pertenecientes a la familia de partículas que compone la materia que vemos en el Universo. Hasta ahora los experimentos del LHC habían detectado la partícula de Higgs mediante su desintegración en otro tipo de partículas denominadas bosones, portadoras de las fuerzas que actúan en la Naturaleza, mientras las evidencias de desintegraciones en fermiones no eran concluyentes. Esta es la primera evidencia clara de este nuevo modo de desintegración del bosón de Higgs.”

La regla universal en la física de partículas es que cuando las partículas chocan con energías cada vez mayores, los efectos de las colisiones están determinados por estructurtas cada vez menores, más pequeñas en el espacio y en el tiempo. Supongamos por un momento que tenemos a nuestra disposición un Acelerador de Partículas 10.000 veces más potente que el LHC, donde las partículas pueden adquirir esas tantas veces más energías de las alcanzadas actualmente. Las colisiones que tendrían lugar nos dirían algo acerca de los detalles estructurales de esas partículas que ahora no conocemos, que serían mucho más pequeñas que las que ahora podemos contemplar.

Ahora el LHC se prepara para nuevas aventuras y experimentos mayores, con mayores energías. ¿Podeis imaginar conseguir colisiones a 70.000 TeV? ¿Que podríamos ver? Y, entonces, seguramente, podríamos oir en los medios la algarada de las protestas de algunos grupos: “Ese monstruo creado por el hombre puede abrir en el espacio tiempo agujeros de gusano que se tragará el mundo y nos llevará hacia otros universos”

¿Justifica el querer detectar las partículas que conforman la “materia oscura”, o, verificar si al menos, podemos vislumbrar la sombra de las “cuerdas” vibrantes de esa Teoria del Todo, el que se gasten ingentes cantidades de dinero en esos artilugios descomunales? Bueno, a pesar de todos los pesares, la respuesta es que SÍ, el rendimiento y el beneficio que hemos podido recibir de los aceleradores de partículas, justifica de manera amplia todo el esfuerzo realizado, toda vez que, no solo nos ha llevado a conocer muchos secretos que la Naturaleza celosamente guardaba, sino que, de sus actividades hemos tenido beneficios muy directos en ámbitos como la medicina, las comunicaciones y otros que la gente corriente desconocen.

¿Implica el ajuste fino un diseño con propósito? ¿Hay tantos parámetros que deben tener un ajuste fino y el grado de ajuste fino es tan alto, que no parece posible ninguna otra conclusión?

Hoy, el Modelo estándar es una construcción matemática que predice sin ambigüedad cómo debe ser el mundo de las estructuras aún más pequeñas. Pero tenemos algunas razones para sospechar que tales predicciones resultan estar muy alejadas de la realidad, o, incluso, ser completamente falsas. Cuando tenemos la posibilidad de llegar más lejos, con sorpresa podemos descubrir que aquello en lo que habíamos creído durante años, era totalmente diferente. El “mundo” cambia a medida que nos alejamos más y más de lo grande y nos sumergimos en ese otro “mundo” de lo muy pequeño, allí donde habitan los minúsculos objetos que conforman la materia desde los cimientos mismos de la creación.

Así el modelo que tenenos de la física de partículas se llama Modelo Estándard y, nos habla de las interacciones entre partículas y las fuerzas o interraciones que están presentes, las leyes que rigen el Universo físico y que, no hemos podido completar al no poder incluir una de las fuerzas: La Gravedad. Claro que, no es esa la única carencia del Modelo, tiene algunas más y, a estas alturas, se va necesitando un nuevo Modelo, más completo y audaz, que incluya a todas las fuerzas y que no tengá parámetros aleatorios allí donde nuestros conocimientos no llegan.

La fealdad del Modelo Estándar puede contrastarse con la simplicidad de las ecuaciones de Einstein, en las que todo se deducía de primeros principios. Para comprender el contraste estético entre el Modelo Estándar y la teoría de la relatividad general de Einstein debemos comprender que, cuando los físicos hablan de “belleza” en sus teorías, realmente quieren decir que estas “bellas” teorías deben poseer al menos dos características esenciales:

- Una simetría unificadora.

- La capacidad de explicar grandes cantidades de datos experimentales con las expresiones matemáticas más económicas.

E = mc2 . Esta es la mejor prueba de lo que decimos arriba.

El Modelo Estándar falla en ambos aspectos, mientras que la relatividad general los exhibe, ambos, de manera bien patente. Nunca una teoría dijo tanto con tan poco; su sencillez es asombrosa y su profundidad increíble.De hecho, desde que se publicó en 1.915, no ha dejado de dar frutas, y aún no se han obtenido de ella todos los mensajes que contiene.

El principio director del modelo estándar dicta que sus ecuaciones son simétricas. De igual modo que una esfera ofrece el mismo aspecto desde cualquier punto de vista, las ecuaciones del modelo estándar subsisten sin variación al cambiar la perspectiva desde la que son definidas. Las ecuaciones permanecen invariables, además, cuando esta perspectiva se desplaza en distinta magnitud a diferentes puntos del espacio y el tiempo.

Al contrario de la relatividad general, la simetría del Modelo Estándar, está realmente formada empalmando tres simetrías más pequeñas, una por cada una de las fuerzas; el modelo es espeso e incómodo en su forma. Ciertamente no es económica en modo alguno. Por ejemplo, las ecuaciones de Einstein, escritas en su totalidad, sólo ocupan unos centímetros y ni siquiera llenaría una línea de esta página. A partir de esta escasa línea de ecuaciones, podemos ir más allá de las leyes de Newton y derivar la distorsión del espacio, el Big Bang y otros fenómenos astronómicos importantes como los agujeros negros. Por el contrario, sólo escribir el Modelo Estándar en su totalidad requeriría, siendo escueto, un par de páginas y parecería un galimatías de símbolos complejos sólo entendibles por expertos.

Los científicos quieren creer que la naturaleza prefiere la economía en sus creaciones y que siempre parece evitar redundancias innecesarias al crear estructuras físicas, biológicas y químicas.

La luz antigua absorbida por átomos de hidrógeno neutro podría usarse para probar ciertas predicciones de la Teoría de Cuerdas, dicen los cosmólogos de la Universidad de Illinois. Realizar tales medidas, sin embargo, requeriría que se construyese un gigantesco conjunto de radio telescopios en la Tierra, el espacio, o la Luna.

El matemático francés Henri Poincaré lo expresó de forma aún más franca cuando escribió: “El científico no estudia la Naturaleza porque es útil; la estudia porque disfruta con ello, y disfruta con ello porque es bella”

E. Rutherford, quien descubrió el núcleo del átomo (entre otras muchas cosas), dijo una vez: “Toda ciencia es o física o coleccionar sello”.Se refería a la enorme importancia que tiene la física para la ciencia, aunque se le olvidó mencionar que la física está sostenida por las matemáticas que la explica.

Pero, a pesar de todos sus inconvenientes, el Modelo Estándar, desde su implantación, ha cosechado un éxito tras otro, con sus inconvenientes y sus diecinueve parámetros aleatorios, lo cierto es que es lo mejor que tenemos por el momento para explicar las familias de partículas que conforman la materia y cómo actúan las fuerzas de la naturaleza, todas las fuerzas menos la gravedad; esa nos la explica a la perfección y sin fisuras las ecuaciones de Einstein de la relatividad general.

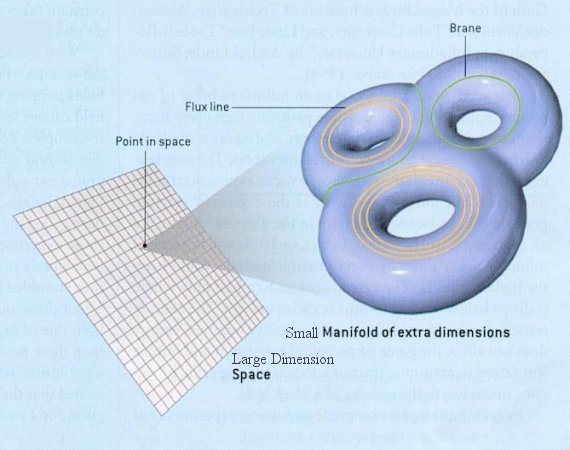

Hace tiempo que los físicos tratan de mejorar el Modelo Estándar con otras teorías más avanzadas y modernas que puedan explicar la materia y el espacio-tiempo con mayor amplitud y, sobre todo, incluyendo la gravedad.Así que retomando la teoría de Kaluza de la quinta dimensión, se propuso la teoría de supergravedad en 1.976 por los físicos Daniel Freedman, Sergio Ferrara y Peter van Nieuwenhuizen, de la Universidad del Estado de Nueva York en Stoney Brook que desarrollaron esta nueva teoría en un espacio de once dimensiones.

Para desarrollar la superteoría de Kaluza-Klein en once dimensiones, uno tiene que incrementarenormemente las componentes del interior del Tensor métrico de Riemann (que Einstein utilizó en cuatro dimensiones, tres de espacio y una de tiempo para su relatividad general y más tarde, Kaluza, añadiendo otra dimensión de espacio, la llevó hasta la quinta dimensión haciendo así posible unir la teoría de Einstein de la gravedad, con la teoría de Maxwell del electromagnetismo), que ahora se convierte en el supertensor métrico de Riemann.

Hasta hoy, no se ha logrado, ni mucho menos, inventar una teoría de campo consistente totalmente unificadora que incluya la gravedad. Se han dado grandes pasos, pero las brechas «científicounificantes» siguen siendo amplias. El punto de partida ha sido siempre la teoría de la relatividad general y conceptos con ella relacionados, por la excelencia que manifiesta esa teoría para explicar la física gravitatoria macrocósmica. El problema que se presenta surge de la necesidad de modificar esta teoría sin perder por ello las predicciones ya probadas de la gravedad a gran escala y resolver al mismo tiempo los problemas de la gravedad cuántica en distancias cortas y de la unificación de la gravedad con las otras fuerzas de la naturaleza.

Su tensor métrico es un tensor de rango 2 que se utiliza para definir … Sin embargo, en otras teorías se ha elevado el rango y se pueden definir múltiples universos de dimensiones más altas.

El tensor métrico se podría adaptar a las necesidades de la búsqueda estableciendo la multiplicidad de dimensiones que la teoría exigía para su desarrollo.

Más allá de lo que nos permiten captar nuestros sentidos físicos, hay que tener nuestra mente abierta a la posibilidad de que puedan existir otras realidades diferentes a lo que nos dicta nuestra experiencia, realidades capaces de ser descubiertas por la fuerza del intelecto cuando nos atrevemos a cuestionar aquello que creíamos como absoluto.

Esta nueva teoría de supergravedad pretendía la unificación de todas las fuerzas conocidas con la materia, y, como en un rompecabezas, encajarlas en el Tensor de Riemann tan solo con elevar el número de dimensiones que exigía más componentes y nos daba el espacio necesario para poder ubicar en sus apartados correspondientes, todas las fuerzas fundamentales y también la materia, la que podía satisfacer, casi en su totalidad, el sueño de Einstein.

A partir de aquí, de estas ecuaciones, surgió todo. Este fue el puerto de donde salió el bajel de la de Kaluza-Gleim, la supergravedad y supersimetría, la cuerda heterótica y la Teoría de cuerdas, todo ello, rematado con la finalmente expuesta, teoría M.

La supergravedad casi consigue satisfacer el sueño de Einstein de dar una derivación puramente geométrica de todas las fuerzas y partículas del universo. Al añadir la supersimetría al Tensor métrico de Riemann, la métrica se duplica en tamaño, dándonos la supersimetría de Riemann. Las nuevas componentes del súper tensor de Riemann corresponden a quarks y leptones, casi todas las partículas y fuerzas fundamentales de la naturaleza: la teoría de la gravedad de Einstein, los campos de Yang-Mills y de Maxwell y los quarks y leptones. Pero el hecho de que ciertas partículas no estén en esta imagen nos obliga a buscar un formalismo más potente:

La materia con todas las fuerzas fundamentales de la naturaleza. Los bosones intermediarios o partículas portadoras de las fuerzas como el fotón para el electromagnetismo, los gluones para la fuerza nuclear fuerte, las partículas W y Z para la nuclear débil y, en la partícula portadora de la gravedad, el gravitón, ponemos el signo de interrogación, ya que se sabe que esta ahí en algún sitio pero hasta la fecha no ha sido detectado.

Antes de continuar con la teoría de súper cuerdas, o con su versión más avanzada la teoría M, parece conveniente recordar que hasta el momento los ladrillos del universo eran los quarks, las partículas más pequeñas detectadas en los aceleradores del CERN y FERMILAB. Pero ¿están hechos de cosas más pequeñas?, eso no lo sabemos. El Modelo Estándar, menos avanzado que las otras teorías, nos dice que los quarks son las partículas más pequeñas y forman protones y neutrones constituyendo la formación interna del átomo, el núcleo. En la actualidad, nuestros aceleradores de partículas no tienen capacidad para ahondar más allá de los quarks y averiguar si a su vez, éstos están formados por partículas aún más pequeñas.

No podemos saber (aún) que es lo que pueda haber (si es que lo hay) más allá de los Quarks, los constituyentes de la materia más pequeños conocidos hasta el momento actual. Sin embargo, no se descarta que puedan existir partículas más simples dentro de los Quarks que, al fin y al cabo, no serían tan elementales.

Por otro lado, los físicos están casi seguros de que los leptones no están compuestos de partículas más pequeñas. Sin embargo, esta sospecha no se tiene en el caso de los quarks; no se sabe qué puede haber detrás de ellos. Tan sólo se ha llegado a desconfinarlos junto con los gluones y por un breve periodo de tiempo de los protones y neutrones que los mantenían aprisionados, formando – en esos breves instantes – una materia plasmosa. No es raro oir dentro de la comunidad científica a los físicos teóricos hablando de prequarks.

Como antes hemos comentado de pasada, el Modelo Estándar agrupa las partículas en familias:

Fermiones y Bosones

Cada leptón grande, es decir, el electrón, el muón y el tau, tiene un primo pequeño. Así el electrón tiene un neutrino electrónico, el muón un neutrino muónico y el tau un neutrino tau. Como se puede ver en la tabla anterior la única diferencia entre el electrón, el muón y el tau es la masa, que va creciendo. Todos tienen carga eléctrica negativa. Los neutrinos en cambio no tienen carga y tienen una masa muy pequeña (pero tienen y es una de las razones por la que se dice que los neutrinos cambian de sabor, es decir cuando salen, por ejemplo, del sol salen en forma de neutrinos electrónicos pero cuando los detectamos en la tierra, vemos que llegan menos neutrinos electrónicos de los que deberían, porque durante el viaje han cambiado de sabor y se han convertido en neutrinos muónicos o tau).

Los bariones se componen de tres quarks o tres antiquarks. En este último caso se denominan antibariones.

Los mesones se componen de dos quarks y obligatoriamente uno es un quark y el otro un antiquark.

Claro, son muchos más. Además de los Bariones, también forman parte de la familia hadrónica los mesones y la lista de unos y otros es larga y cada individuo, como es natural, tiene sus propias características que lo hacen único.

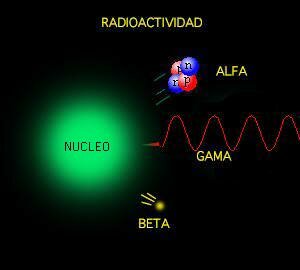

Se llaman bosones porque, al contrario que los fermiones, éstos obedecen la estadística de Bose-Einstein que dice que pueden existir en el mismo estado cuántico muchas bosones al mismo tiempo (recordad que en el caso de los fermiones sólo podía haber dos en el mismo estado cuántico). Algunos bosones tienen la peculiaridad de que son los portadores de las fuerzas fundamentales de la naturaleza, es decir, cada vez que ocurre una interacción entre dos partículas, lo que realmente ocurre es que intercambian un bosón. Estas fuerzas son el electromagnetismo, la fuerza débil y la fuerza fuerte (vienen a continuación). Existe otro bosón, aunque sólo a nivel teórico, conocido como el gravitón que sería el responsable de la fuerza gravitatoria. La fuerza gravitatoria no está explicada por el modelo estándar y por lo tanto el gravitón, no forma parte del mismo.

La fuerza débil es la responsable de las desintegraciones radiactivas, es decir, que una partícula se convierta en otra a través de la emisión de una o más partículas adicionales. Esta interacción es mediada por los bosones W+, W- y Z0. Estos bosones tienen la particularidad de que tienen masa, al contrario que el resto de bosones.

La fuerza fuerte hace que los quarks que componen los núcleos atómicos se mantengan unidos y no se rompan espontáneamente. El bosón encargado de hacer esto es el gluón.

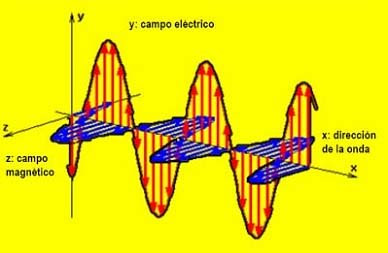

La fuerza electromagnética es la que más conocemos todos, ya que se compone de la fuerza eléctrica y la fuerza magnética (en realidad es una única fuerza que se manifiesta de dos maneras diferentes, de ahí que reciba el nombre de fuerza electromagnética). El bosón portador de esta fuerza es el fotón. Nuestra experiencia diaria se basa principalmente en sufrir los efectos de esta fuerza y cada vez que vemos la luz, sentimos calor, calentamos la comida en el microondas, etc., lo que estamos haciendo es interaccionar con fotones de diversas energías.

Interacciones entre partículas

En la imagen de la izquierda se representa como un neutrón se desintegra para dar un protón, un electrón y un antineutrino electrónico. Esta desintegración es conocida como desintegración beta.

En la imagen central se muestra la colisión entre un electrón y un positrón que da lugar a una desintegración de materia en energía pura, otra vez a través de la ecuación de Einstein E=mc2. La energía se convierte, por la misma ecuación, otra vez en otras partículas diferentes. En este caso se forma un mesón B0 y un antimesón B0.

Por último, en la imagen de la derecha aparece la colisión de dos protones (como los que ocurren en el LHC del CERN) para dar lugar a dos bosones Z0 y varios hadrones, es decir, varias partículas compuestas de diferentes quarks (mesones y bariones).

… Han dejado fuera del Modelo estándar a la Gravedad que se resiste a estar junto a las otras tres fuerzas. Así, continúan persiguiendo ese sueño llamado… ¡Teoría cuántica de la gravedad o Gravedad cuántica!

Y describe las interacciones que estas partículas tienen con las cuatro fuerzas fundamentales de la naturaleza, sobre todo con las nucleares fuerte y débil y la electromagnética; la gravedad se queda aparte del Modelo Estándar, ya que su incidencia con las partículas elementales es inapreciable como consecuencia de las infinitesimales masas de éstas, y ya sabemos que la gravedad se deja sentir y se hace presente cuando aparecen las grandes masas como planetas, estrellas y galaxias.

Grandes estructuras que vienen a ser como pequeños ”universos islas” en los que podemos estudiar, a menos tamaño, todo lo que en el Gran Universo puede pasar. Partiendo de la base de que las leyes del universo son las mismas en todas partes, podemos tomar cualquier región del mismo y ver que, allí está ocurriendo lo mismo que aquí ocurre, es decir, están presentes las fuerzas fundamentales: nucleares débiles y fuertes, electromagnetismo y Gravedad y, todo, absolutamente todo, funciona al ritmo que dichas leyes nos marcan.

Como el Modelo Estándar es limitado, los físicos buscan desesperadamente nuevas teorías que puedan corregir y perfeccionar este modelo. Así aparecieron las teorías de súper simetría, súper gravedad, súper cuerdas, y ahora por último, la teoría M propuesta por Edward Witten en 1.995 y que nos quiere explicar, de manera más perfecta, el universo desde su origen, cómo y por qué está conformado ese universo, las fuerzas que lo rigen, las constantes de la naturaleza que establecen las reglas, y todo ello, a partir de pequeños objetos infinitesimales, las cuerdas, que sustituyen a las partículas del modelo estándar que creíamos elementales.

Esas partículas súper simétricas que pronostican algunas teorías, aún no han sido observadas y se espera que en el LHC puedan aparecer algunas que, desde luego, si así ocurre, sería un buen adelanto para conocer el mundo que nos acoge y la Naturaleza del Universo.

Esta nueva teoría, permite además, unificar o incluir la gravedad con las otras fuerzas, como teoría cuántica de la gravedad, todo ello mediante una teoría estructurada y fundamentada con originalidad y compactificación de las cuatro fuerzas de la naturaleza y dejando un gran espacio matemático para eliminar anomalías o perturbaciones, y se propugna con coherencia quela cuerda es el elemento más básico de la estructura de la materia; lo que estaría bajo los quarks serían unas diminutos círculos semejantes a una membrana vibrante circular y de diferentes conformaciones.

Universos Paralelos, Teorías de Cuerdas, Súper gravedad, La Teoría M, y ¿Los pensamientos de la Mente, podrán dar para tanto?

Una vez se escucha sobre los fundamentos de la teoría cuántica uno no puede mas que sobrecogerse, ampliar la mente y galopar entre las múltiples posibilidades acerca de lo real e imaginario que por momentos y depende que conceptos se entrelazan intercambiables. Lo que llama la atención es que por mucho que hayan sido los físicos cuánticos más prestigiosos entre la sociedad científica los que hayan puesto sobre la mesa conceptos cuanto menos rimbombantes e inverosímiles como las multi-dimensiones, los universos paralelos, los efectos túneles y demás, sean los propios miembros de la academia los que grandilocuentemente se ofenden cuando se hace alusión al paralelismo evidente del comportamiento y extensión de la energía en referencia al universo preconizado por los místicos de muchas culturas. No tenemos los conocimientos necesarios para poder decir que no a esto o aquello, cada cosa tiene su lugar y tendremos que analizarlas muy a fondo y adentrarnos en esos mundos de misterio para poder decidir lo que es y lo que no puede ser.

Aquí hemos llegado a una región de la Física de las partículas donde la energía (por partícula) es mucho mayor de la que actualmente podemos estudiar en nuestros laboratorios. Claro que especulamos, pero con los datos de los que disponemos, la realidad estará muy cerca de la expuesta en el gráfico, y, en él se señalan energía que no están a nuestro alcance para conseguir lo que se quiere saber.

Ed Witten, en su trabajo, presentó amplias evidencias matemáticas de que las cinco teorías obtenidas de la primera revolución, junto con la más reciente conocida como la súper gravedad (súper cuerda después), en 11 dimensiones, eran de hecho parte de una teoría inherentemente cuántica y no perturbativa conocida como teoría M. Las seis teorías están conectadas entre sí por una serie de simetrías de dualidad T, S, y U. Además, de la teoría propuesta por Witten se encuentran implícitas muchas evidencias de que la teoría M no es sólo la suma de las partes, sino que se vislumbra un alentador horizonte que podría concluir como la teoría definitiva tan largamente buscada.

Los resultados de la segunda revolución de las súper cuerdas han demostrado que las cinco teorías de cuerdas forman parte de un solo marco unificado, llamado Teoría M.

Las súper cuerdas, en realidad, sólo es otra manera utilizada por los científicos a la búsqueda de la verdad que la Humanidad necesita y reclama para continuar con su propia evolución que, sin esos conocimientos, quedaría estancada.

Como se puede ver, las partículas implicadas en el Modelo Estándar están en un mundo microscópico de 10-17cm que sí dominan nuestros aceleradores, mientras que la cuerda está en una distancia de 10-33 cm que les está prohibida, allí no podemos llegar, no disponemos de la energía suficiente para ello.

Igual que con la energía disponible por el momento, nos pasa con las distancias, que también nos tiene paralizados en nuestros deseos de visitar mundos lejanos, no podemos, al no disponer de los medios necesarios para poder soslayar las distancias de tantos años-luz como tendríamos que recorrer. ¿Habrá otro camino?

Está muy claro para los físicos que, aunque teóricamente, en la Teoría de Súper cuerdas se pueden unir todas las fuerzas, todavía tenemos que seguir sosteniendo que la gravedad resulta una fuerza solitaria para todos los efectos, ya que ha resistido todos los intentos para saber, con certeza, si finalmente se podrá unir a las otras fuerzas de la Naturaleza. La gravedad está descrita por la teoría de la relatividad general de Einstein y tiene una naturaleza esencialmente geométrica. Se entiende como la curvatura del espacio-tiempo alrededor de un objeto masivo. En los gráficos, generalmente, se representa como un objeto pesado sobre una superficie fina y tensa (una pelota o bola pesada de jugar a los bolos que dejamos encima de una sábana extendida tirando de las cuatro esquinas). El peso de la bola (materia) hundirá la sábana (espacio-tiempo) con mayor intensidad en la distancia más cercana a donde se encuentre masa.

El espacio tiempo se distorsiona allí donde residen objetos pesados como los planetas, las estrellas, galaxias y cualesquiera otros cuerpos masivos.

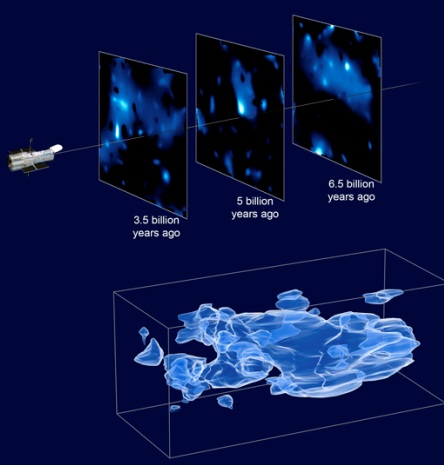

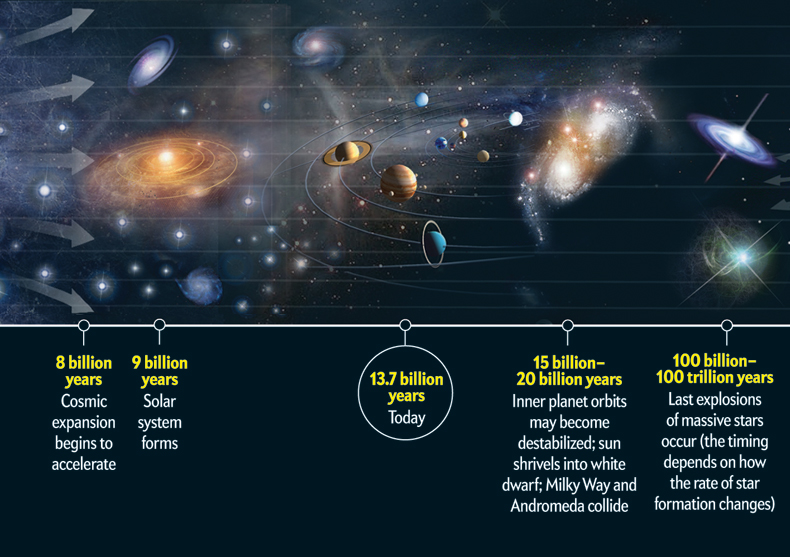

La teoría de Einstein goza de una amplia aceptación debido a los aciertos macroscópicos que han sido verificados de manera experimental. Los más recientes están referidos a los cambios de frecuencia de radiación en púlsares binarios debido a la emisión de ondas gravitacionales, que actualmente estudia Kip S. Thorne, en relación a los agujeros negros. Entre las predicciones que Einstein propugna en su teoría se encuentran, por ejemplo, la existencia de ondas gravitacionales, que el universo está en constante expansión y que, por lo tanto, tuvo un inicio: el Big Bang o los agujeros negros.

Se trata de regiones donde la gravedad es tan intensa que ni siquiera la luz puede escapar de su atracción. Estas regiones se forman por el colapso gravitatorio de estrellas masivas en la etapa final de su existencia como estrella, acabado el combustible nuclear y no pudiendo fusionar hidrógeno en helio, fusiona helio en carbono, después carbono en neón, más tarde neón en magnesio y así sucesivamente hasta llegar a elementos más complejos que no se fusionan, lo que produce la última resistencia de la estrella contra la fuerza de gravedad que trata de comprimirla, se degeneran los neutrones como último recurso hasta que, finalmente, la estrella explota en supernova lanzando al espacio las capaz exteriores de su material en un inmenso fogonazo de luz; el equilibrio queda roto, la fuerza de expansión que contrarrestaba a la fuerza de gravedad no existe, así que, sin nada que se oponga la enorme masa de la estrella supermasiva, se contrae bajo su propio peso, implosiona hacia el núcleo, se reduce más y más, su densidad aumenta hasta lo inimaginable, su fuerza gravitatoria crece y crece, hasta que se convierte en una singularidad, un lugar en el que dejan de existir el tiempo y el espacio.

Allí no queda nada, ha nacido un agujero negro y a su alrededor nace lo que se ha dado en llamar el Horizonte de Sucesos, que es una región del espacio, alrededor del agujero negro que una vez traspasada no se podrá regresar; cualquier objeto que pase esta línea mortal, será literalmente engullida por la singularidad del agujero negro. De hecho, el telescopio espacial Hubble, ha enviado imágenes captadas cerca de Sagitario X-1, en el centro de nuestra galaxia, donde reside un descomunal agujero negro que, en las fotos enviadas por el telescopio, aparece como atrapa la materia de una estrella cercana y se la engulle.

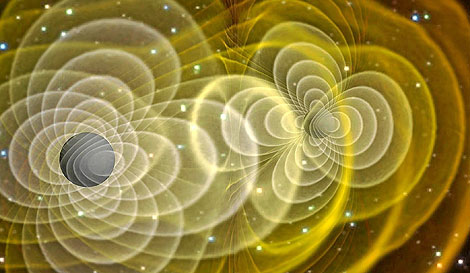

Ondas gravitacionales que se forman a partir de los agujeros negros que, en su dinámica cotidiana y que, actualmente, estamos tratando de captar para saber de un njhuevo Universo que nos diría muchas cosas de las que ocurren a partir de fenómenos que sabemos existen pero, que hasta el momento no hemos podido “leer”.

Esta es la fuerza que se pretende unir a la Mecánica Cuántica en la teoría de supercuerdas, es decir, que Einstein con su relatividad general que nos describe el cosmos macroscópico, se pueda reunir con Max Planck y su cuanto infinitesimal del universo atómico, lo muy grande con lo muy pequeño.

La llamada gravedad cuántica trata de fundir en una sola las dos teorías físicas más soberbias con las que contamos, la relatividad general y la mecánica cuántica, que en el estado actual de nuestro conocimiento parecen incompatibles. Su estudio, ahora mismo, es en algunos aspectos análogo a la física de hace cien años, cuando se creía en los átomos, pero se ignaraban los detalles de su estructura.

Hasta el momento, Einstein se ha negado a esta reunión y parece que desea caminar solo. Las otras fuerzas están presentes en el Modelo Estándar, la gravedad no quiere estar en él, se resiste.

De hecho, cuando se ha tratadode unir la mecánica cuántica con la gravedad, aunque el planteamiento estaba muy bien formulado, el resultado siempre fue desalentador; las respuestas eran irreconocibles, sin sentido, como una explosión entre materia y antimateria, un desastre.

Sin embargo, es preciso destacar que las nuevas teorías de súper-simetría, súper-gravedad, súper-cuerdas o la versión mas avanzada de la teoría M de Ed Witten, tienen algo en común: todas parten de la idea expuesta en la teoría de Kaluza-Klein de la quinta dimensión que, en realidad, se limitaba a exponer la teoría de Einstein de la relatividad general añadiendo otra dimensión en la que se incluían las ecuaciones de Maxwell del electromagnetismo.

Hasta hoy no se ha logrado, ni mucho menos, inventar una teoría de campo que incluya la gravedad. Se han dado grandes pasos, pero la brecha “científicounificante” es aún muy grande. El punto de partida, la base, ha sido siempre la relatividad y conceptos en ella y con ella relacionados, por la excelencia que manifiesta esa teoría para explicar la física gravitatoria cósmica. El problema que se plantea surge de la necesidad de modificar esta teoría de Einstein sin perder por ello las predicciones ya probadas de la gravedad a gran escala y resolver al mismo tiempo el problema de la gravedad cuántica en distancias cortas y de la unificación de la gravedad con las otras fuerzas de la naturaleza. Desde la primera década del siglo XX se han realizado intentos que buscan la solución a este problema, y que han despertado gran interés.

Después de la explosión científica que supuso la teoría de la relatividad general de Einstein que asombró al mundo, surgieron a partir e inspiradas por ella, todas esas otras teorías que antes he mencionado desde la teoría Kaluza-Klein a la teoría M.

Esas complejas teorías cuánticas nos quieren acercar al misterio que encierra la materia: ¡el Espíritu de la Luz!

Es de enorme interés el postulado que dichas teorías expone. Es de una riqueza incalculable el grado de complejidad que se ha llegado a conseguir para desarrollar y formular matemáticamente estas nuevas teorías que, como la de Kaluza-Klein o la de supercuerdas (la una en cinco dimensiones y la otra en 10 ó 26 dimensiones) surgen de otra generalización de la relatividad general tetradimensional einsteniana que se plantea en cuatro dimensiones, tres espaciales y una temporal, y para formular las nuevas teorías se añaden más dimensiones de espacio que, aunque están enrolladas en una distancia de Planck, facilitan el espacio suficiente para incluir todas las fuerzas y todos los componentes de la materia, tratando de postularse como la Teoría de Todo.

Dimensiones enrolladas ¿En un espaciotiempo fractal? La Naturaleza sabe de eso

La Gran Teoría Unificada que todo lo explique es un largo sueño acariciado y buscado por muchos. El mismo Einstein se pasó los últimos treinta años de su vida buscando el Santo Grial de la teoría del todo en la física, unificadora de las fuerzas y de la materia. Desgraciadamente, en aquellos tiempos no se conocían elementos y datos descubiertos más tarde y, en tales condiciones, sin las herramientas necesarias, Einstein no podría alcanzar su sueño tan largamente buscado. Si aún viviera entre nosotros, seguro que disfrutaría con la teoría de súper-cuerdas o la teoría M, al ver como de ellas, sin que nadie las llame, surgen, como por encanto, sus ecuaciones de campo de la relatividad general.

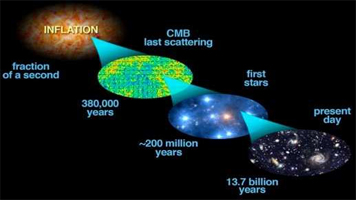

La fuerza de la Naturaleza, en el universo primitivo del Big Bang, era una sola fuerza y el estado de la materia es hoy conocido como “plasma”; las enormes temperaturas que regían no permitía la existencia de protones o neutrones, todo era como una sopa de quarks. El universo era opaco y estaba presente una simetría unificadora.

Más tarde, con la expansión, se produjo el enfriamiento gradual que finalmente produjo la rotura de la simetría reinante. Lo que era una sola fuerza se dividió en cuatro. El plasma, al perder la temperatura necesaria para conservar su estado, se trocó en quarks que formaron protones y neutrones que se unieron para formar núcleos. De la fuerza electromagnética, surgieron los electrones cargados negativamente y que, de inmediato, fueron atraídos por los protones de los núcleos, cargados positivamente; así surgieron los átomos que, a su vez, se juntaron para formar células y éstas para formar los elementos que hoy conocemos.

Después se formaron las estrellas y las galaxias que sirvieron de fábrica para elementos más complejos surgidos de sus hornos nucleares hasta completar los 92 elementos naturales que conforma toda la materia conocida. Existen otros elementos que podríamos añadir a la Tabla, pero estos son artificiales como el plutonio o el einstenio que llamamos transuranidos, es decir, más allá del uranio.

La materia ha evolucionado hasta límites increíbles: ¡la vida! y, aún no sabemos, lo que más allá pueda esperar.

¿Quizás hablar sin palabras, o, Incluso algo más?

¿Muchos mundos y diversas formas de vida?

Estos conocimientos y otros muchos que hoy posee la ciencia es el fruto de mucho trabajo, de la curiosidad innata al ser humano, del talento de algunos y del ingenio de unos pocos, todo ello después de años y años de evolución pasando los descubrimientos obtenidos de generación en generación.

¿Cómo habría podido Einstein formular su teoría de la relatividad general sin haber encontrado el Tensor métrico del matemático alemán Riemann?

¿Qué formulación del electromagnetismo habría podido hacer James C. Maxwell sin el conocimiento de los experimentos de Faraday?

La relatividad especial de Einstein, ¿habría sido posible sin Maxwell y Lorentz?

¿Qué unidades habría expuesto Planck sin los números de Stoney?

En realidad… ¿Cómo comenzaría todo? Mientras encontramos la respuesta, observamos como el Universo se expande y se vuelve viejo y frío.

Así podríamos continuar indefinidamente, partiendo incluso, del átomo de Demócrito, hace ahora más de dos milenios. Todos los descubrimientos e inventos científicos están apoyados por ideas que surgen desde conocimientos anteriores que son ampliados por nuevas y más modernas formulaciones.

Precisamente, eso es lo que está ocurriendo ahora con la teoría M de las supercuerdas de Witten. Él se inspira en teorías anteriores que, a su vez, se derivan de la original de A. Einstein que pudo surgir, como he comentado, gracias al conocimiento que en geometría aportó Riemann con su tensor métrico.