Ene

5

Seguimos con el Modelo Estándar

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (1)

Comments (1)

El hombre se ha preguntado durante largo tiempo, “¿de qué está hecho el mundo?” Demócrito de Abdera nos hablaba del “átomo” y Empédocles de “elemenmtos”, otros, se referían a la sustancia cósmica a la que llamaban Ylem, aquella “semilla” primera que daría lugar a la venida de la materia. ¿No será el Ylem, lo que hoy llaman materia oscura?

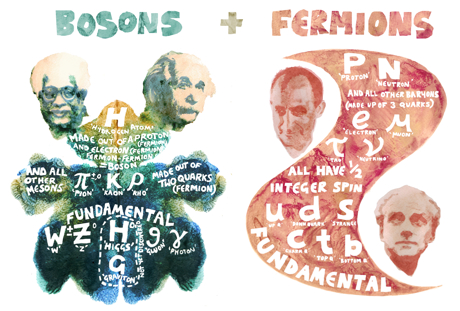

Ahora sabemos que, no sólo nuestro mundo, sino todo el inmenso Universo, está hecho de pequeños objetos infinitesimales a las que hemos denominado partículas subatómicas y que forman varias familias. Unas son más elementales que otras y según, a qué familia pertenezcan, atienden o se rigen por una u otra fuerza elemental.

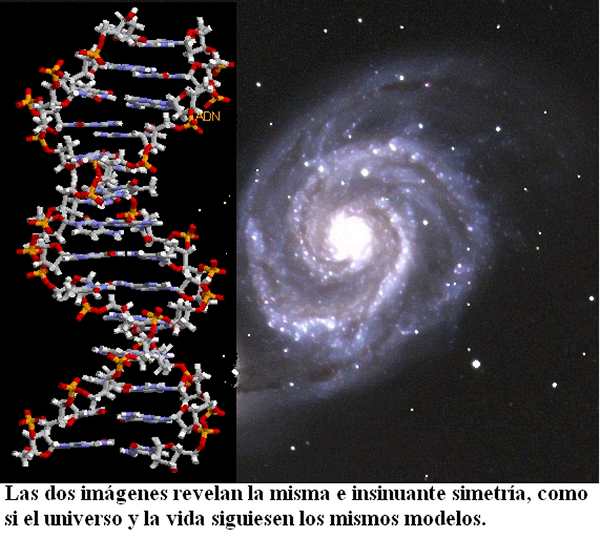

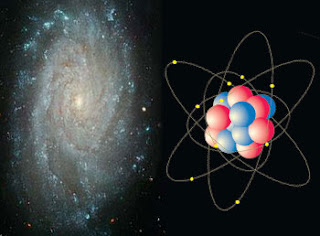

Son los constituyentes fundamentales de toda la materia del Universo (por lo menos de toda la materia conocida y que podemos detectar formando estrellas y mundos, galaxias o seres vivos). Hemos podido llegar a saber que, de esas briznas de materia se forman los núcleos que, rodeados de electrones conforman los átomos de la materia.

Todo lo grande está hecho de “cosas” pequeñas

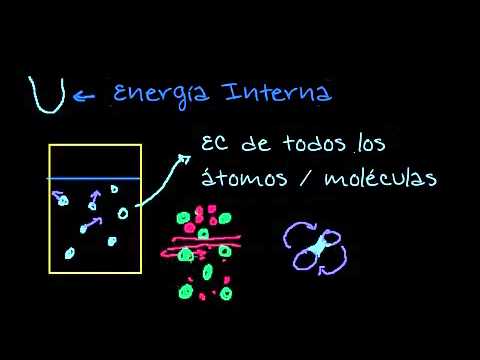

Los grupos de átomos conforman las moléculas que son las unidades fundamentales de los compuestos químicos pero, comencemos por los núcleos atómicos:

Muchas son las veces que aquí mismo he podido explicar, que los quarks u y d se hallan en el interior de los nucleones y, por tanto, su habitat está en los núcleos atómicos donde se encuentran confinados y, en realidad, no intervienen directamente en las propiedades de los núcleos. Sin embargo, no podemos olvidar que la fuerza nuclear fuerte está ahí reteniendo a los quarks por medio de los gluones y, eso hace que, el núcleo sea estable.

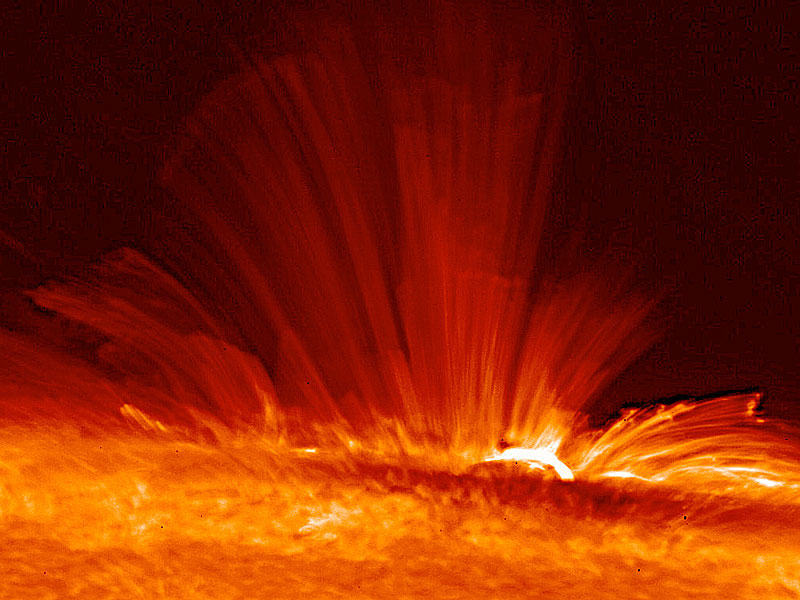

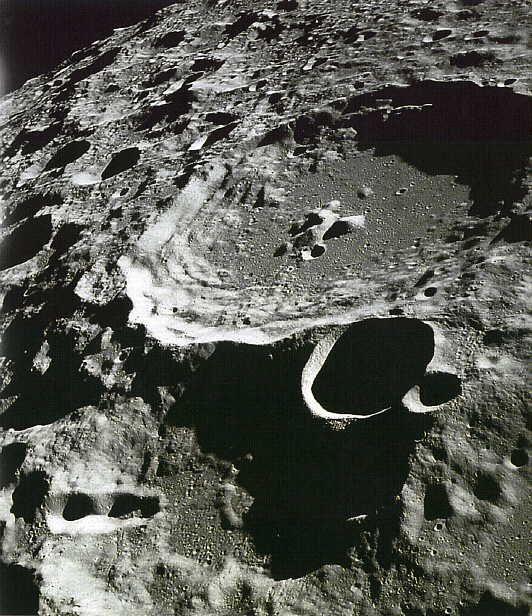

Los núcleos atómicos constituyen un tipo de materia que, aisladamente, de forma individual (si exceptuamos el protón), siempre están en ambientes muy energéticos, por ejemplo, en el interior de las estrellas. En nuestro entorno terráqueo, es raro encontrar núcleos aislados, sino parcial o totalmente confinados dentro de los átomos.

Sabemos que el número de especímenes atómicos es limitado, existiendo ciertas razones para suponer que hacia el número atómico 173 los correspondientes núcleos serían inestables, no por razones intrínsecas de inestabilidad “radiactiva” nuclear, sino por razones relativistas. Ya señalé en otros escritos que, el número de especies atómicas, naturales y artificiales, es de unos pocos miles, en cambio, el número de moléculas conocidas hasta ahora comprenden unos pocos millones de especímenes, aumentando continuamente el número de ellas gracias a la síntesis que se lleva a cabo en numerosos laboratorios repartidos por todo el mundo.

Una molécula es una estructura, con individualidad propia, constituida por un conjunto de núcleos y sus electrones. La molécula más sencilla es la de Hidrógeno que tiene dos electrones, hasta las más complejas como las de las proteínas, con muchos miles de ellos, existen toda una gama de varios millones. Esta extraordinaria variedad de especies moleculares contrasta con la de las especies nucleares e incluso atómicas.

Desde el punto de vista de la información, las especies moleculares la poseen en mucho mayor grado que las nucleares o atómicas. Dejando aparte los núcleos, la información que soportan los átomos se podría atribuir a la distribución de su carga eléctrica, y en particular a los electrones más débilmente ligados. Concretando un poco más, se podría admitir que la citada información la aportan los orbitales atómicos, pues son precisamente estos orbitales los que introducen diferencias “geométricas” entre los diferentes electrones “corticales”.

Las partículas forman átomos, los átomos moléculas y las moléculas sustancias y cuerpos que están hechos por la diversa variedad de elementos que conforma la materia conocida y que, en definitiva, sólo son Quarks y Leptones.

Demos una vuelta por el Modelo Estándar.

El Modelo Estándar de partículas elementales, con los bosones gauge en la columna derecha.

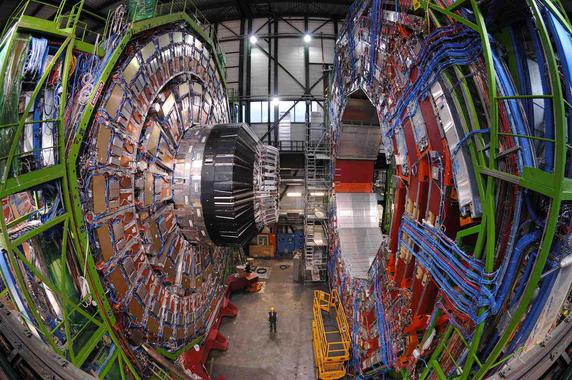

Me quiero referir al Modelo estándar de la física de partículas y de las interacciones fundamentales y, algunos, han llegado a creer que sólo faltan algunos detalles técnicos y, con ellos, la física teórica está acabada. Tenemos un modelo que engloba todo lo que deseamos saber acerca de nuestro mundo físico. ¿Qué más podemos desear? Los pobres ilusos no caen en la cuenta de que el tal Modelo, al que no podemos negarle su valía como una herramienta muy valiosa para la física, no deja de estar incompleto y, además, ha sido construido con algunos parámetros aleatorios (unos veinte) que no tienen justificación. Uno de ellos era el Bosón de Higgs y, según nos han contado los del LHC, ha sido hallado. Sin embargo, esperamos que nos den muchas explicaciones que no han estado presente en todas las algaradas y fanfarrias que dicho “hallazgo” ha producido, incluidos los premios Principe de Asturias y el Nobel. ¡Veremos en que queda todo esto al final!

Bueno, lo que hasta el momento hemos logrado no está mal del todo pero, no llega, ni con mucho, a la perfección que la Naturaleza refleja y que, nosotros perseguimos sin llegar a poder agarrar sus múltiples entrecijos y parámetros que conforman ese todo en el que, sin ninguna clase de excusas, todo debe encajar y, de momento, no es así. Muchos son los flecos sueltos, muchas las incognitas, múltiples los matices que no sabemos perfilar.

Es cierto que, el Modelo estándar, en algunos momento, nos produce y nos da la sensación de que puede ser perfecto. Sin embargo, esa ilusoria perfección, no es permanente y en algunas casos efímera. En primer lugar, podríamos empezar a quejarnos de las casi veinte constantes que no se pueden calcular. Pero si esta fuese la única queja, habría poco que hacer. Desde luego, se han sugerido numerosas ideas para explicar el origen de estos números y se han propuesto varias teorías para “predecir” sus valores. El problema con todas estas teorías es que los argumentos que dan nunca llegan a ser convincentes.

¿Por qué se iba a preocupar la Naturaleza de una fórmula mágica si en ausencia de tal fórmula no hubiera contradicciones? Lo que realmente necesitamos es algún principio fundamental nuevo, tal como el proncipio de la relatividad, pero nos resistimos a abandonar todos los demás principios que ya conocemos; ¡esos, después de todo, han sido enormemente útiles en el descubrimiento del Modelo estándar! una herramienta que ha posibilitado a todos los físicos del mundo para poder construir sus trabajos en ese fascinante mundo de la mecánica cuántica, donde partículas infinitesimales interactúan con las fuerzas y podemos ver, como se comporta la materia en determinadas circunstancias. El mejor lugar para buscar nuevos principios es precisamente donde se encuentran los puntos débiles de la presente teoría.

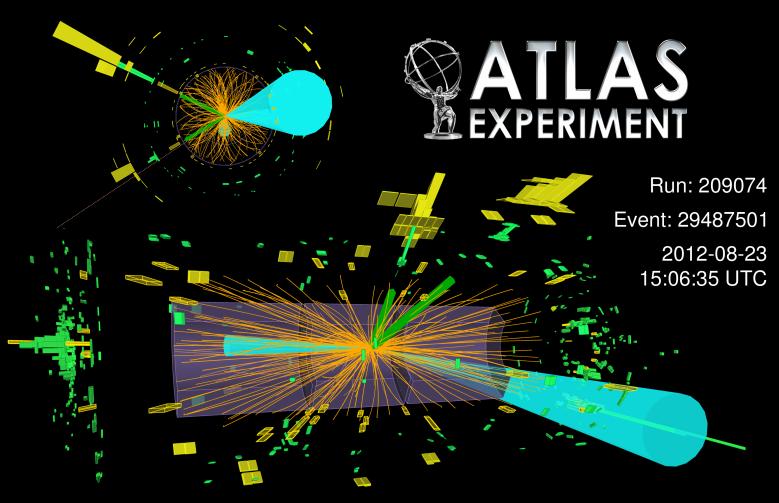

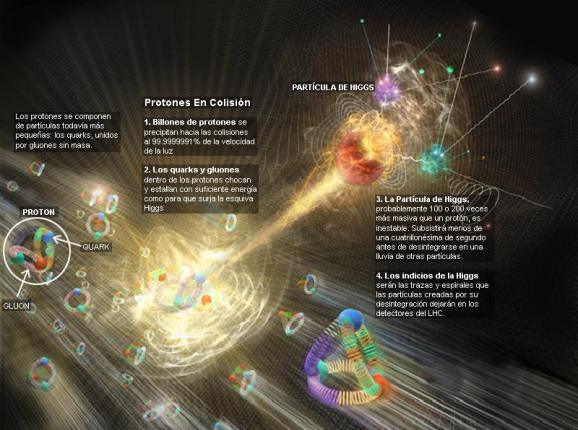

“Colisión del Bosón de Higgs desintegrándose en fermiones”. Primeras evidencias de un nuevo modo de desintegración del bosón de Higgs. Las primeras evidencias de la desintegración del recién descubierto bosón de Higgs en dos partículas denominadas tau, pertenecientes a la familia de partículas que compone la materia que vemos en el Universo. Hasta ahora los experimentos del LHC habían detectado la partícula de Higgs mediante su desintegración en otro tipo de partículas denominadas bosones, portadoras de las fuerzas que actúan en la Naturaleza, mientras las evidencias de desintegraciones en fermiones no eran concluyentes. Esta es la primera evidencia clara de este nuevo modo de desintegración del bosón de Higgs.”

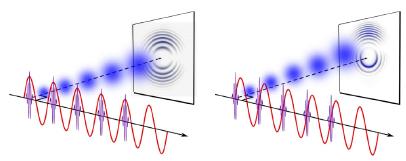

La regla universal en la física de partículas es que cuando las partículas chocan con energías cada vez mayores, los efectos de las colisiones están determinados por estructurtas cada vez menores, más pequeñas en el espacio y en el tiempo. Supongamos por un momento que tenemos a nuestra disposición un Acelerador de Partículas 10.000 veces más potente que el LHC, donde las partículas pueden adquirir esas tantas veces más energías de las alcanzadas actualmente. Las colisiones que tendrían lugar nos dirían algo acerca de los detalles estructurales de esas partículas que ahora no conocemos, que serían mucho más pequeñas que las que ahora podemos contemplar. En este punto se me ocurre la pregunta: ¿Seguiría siendo correcto el Modelo estándar? 0, por el contrario, a medida que nos alejemos en las profundidades de lo muy pequeño, también sus normas podrían variar al mismo tiempo que varían las dimensiones de los productos hallados. Recordad que, el mundo no funciopna de la misma manera en nuestro ámbirto macroscópico que ante ese otro “universo” cuántico de lo infinitesimal.

¿Podeis imaginar conseguir colisiones a 70.000 TeV? ¿Que podríamos ver? Y, entonces, seguramente, podríamos oir en los medios la algarada de las protestas de algunos grupos: “Ese monstruo creado por el hombre puede abrir en el espacio tiempo agujeros de gusano que se tragará el mundo y nos llevará hacia otros universos” Comentarios así estarían a la orden del día. Los hay que siempre están dispuestos a protestar por todo y, desde luego, no siempre llevan razón, toda vez que, la mayoría de las veces, ignoran de qué están hablando y juzgan si el conocimiento de causa necesario para ello. De todas las maneras, sí que debemos tener sumo cuidado con el manejo de fuerzas que… ¡no siempre entendemos! Cuando el LHC se vuelvsa a poner en marcha, se utilizarán energías que llegan hasta los 14 TeV, y, esas son palabras mayores.

¿Justifica el querer detectar las partículas que conforman la “materia oscura”, o, verificar si al menos, podemos vislumbrar la sombra de las “cuerdas” vibrantes de esa Teoria del Todo, el que se gasten ingentes cantidades de dinero en esos artilugios descomunales? Bueno, a pesar de todos los pesares, la respuesta es que SÍ, el rendimiento y el beneficio que hemos podido recibir de los aceleradores de partículas, justifica de manera amplia todo el esfuerzo realizado, toda vez que, no solo nos ha llevado a conocer muchos secretos que la Naturaleza celosamente guardaba, sino que, de sus actividades hemos tenido beneficios muy directos en ámbitos como la medicina, las comunicaciones y otros que la gente corriente desconocen.

Hoy, el Modelo estándar es una construcción matemática que predice sin ambigüedad cómo debe ser el mundo de las estructuras aún más pequeñas. Pero tenemos algunas razones para sospechar que tales predicciones resultan estar muy alejadas de la realidad, o, incluso, ser completamente falsas. Cuando tenemos la posibilidad de llegar más lejos, con sorpresa podemos descubrir que aquello en lo que habíamos creído durante años, era totalmente diferente. El “mundo” cambia a medida que nos alejamos más y más de lo grande y nos sumergimos en ese otro “mundo” de lo muy pequeño, allí donde habitan los minúsculos objetos que conforman la materia desde los cimientos mismos de la creación.

Encendamos nuestro supermicroscopio imaginario y enfoquemosló directamente en el centro de un protón o de cualquier otra partícula. Veremos hordas de partículas fundamentales desnudas pululando. Vistas a través del supermicroscopio, el modelo estándar que contiene veinte constantes naturales, describen las fuerzas que rigen la forma en que se mueven. Sin embargo, ahora esas fuerzas no sólo son bastante fuertes sino que también se cancelan entre ellas de una forma muy especial; están ajustadas para conspirar de tal manera que las partículas se comportan como partículas ordinarias cuando se vuelven a colocar el microscopio en la escala de ampliación ordinaria. Si en nuestras ecuaciones matemáticas cualquiera de estas constantes fueran reemplazadas por un número ligeramente diferente, la mayoría de las partículas obtendrían inmediatamente masas comparables a las gigantescas energías que son relevantes en el dominio de las muy altas energías. El hecho de que todas las partículas tengan masa que corresponden a energías mucho menores repentinamente llega a ser bastante poco natural.

¿Implica el ajuste fino un diseño con propósito? ¿Hay tantos parámetros que deben tener un ajuste fino y el grado de ajuste fino es tan alto, que no parece posible ninguna otra conclusión?

Antes decía: “El hecho de que todas las partículas tengan masa que corresponden a energías mucho menores repentinamente llega a ser bastante poco natural”. Es lo que se llama el “problema del ajuste fino”. Vistas a través del microscopio, las constantes de la Naturaleza parecen estar cuidadosamente ajustadas sin ninguna otra razón aparente que hacer que las partículas parezcan lo que son. Hay algo muy erróneo aquí. Desde un punto de vista matemático, no hay nada que objetar, pero la credibilidad del Modelo estándar se desploma cuando se mira a escalas de tiempo y longitud extremadamente pequeñas o, lo que es lo mismo, si calculamos lo que pasaría cuando las partículas colisionan con energías extremadamente altas.

¿Y por qué debería ser el modelo válido hasta ahí? Podrían existir muchas clases de partículas súper pesadas que no han nacido porque se necesitan energías aún inalcanzables, ellas podrían modificar completamente el mundo que Gulliver planeaba visitar. Si deseamos evitar la necesidad de un delicado ajuste fino de las constantes de la Naturaleza, creamos un nuevo problema:

Es cierto que nuestra imaginación es grande pero… No pocas veces ¡la realidad la supera!

¿Cómo podemos modificar el modelo estándar de tal manera que el ajuste-fino no sea necesario? Está claro que las moficiaciones son necesarias , lo que implica que muy probablemente hay un límite más allá del cual el modelo deja de ser válido. El Modelo estándar no será más que una aproximación matemática que hemos sido capaces de crear, tal que todos los fenómenos observados hasta el presente están de acuerdo con él, pero cada vez que ponemos en marcha un aparato más poderoso, debemos esperar que sean necesarias nuevas modificaciones para ir ajustando el modelo, a la realidad que descubrimos.

¿Cómo hemos podido pensar de otra manera? ¿Cómo hemos tenido la “arrogancia” de pensar que podemos tener la teoría “definitiva”? Mirando las cosas de esta manera, nuestro problema ahora puede muy bien ser el opuesto al que plantea la pregunta de dónde acaba el modelo estándar: ¿cómo puede ser que el modelo estándar funcione tan extraordinariamente bien? y ¿por qué aún no hemos sido capaces de percibir nada parecido a otra generación de partículas y fuerzas que no encajen en el modelo estándar? La respuesta puede estar en el hecho cierto de que no disponemos de la energía necesaria para poder llegar más lejos de lo que hasta el momento hemos podido viajar con ayuda de los aceleradores de partículas.

Los asistentes escuchan la presentación de los resultados del experimento ATLAS, durante el seminario del Centro Europeo de Física de Partículas (CERN) para presentar los resultados de los dos experimentos paralelos que buscan la prueba de la existencia de la “partícula de Higgs, base del modelo estándar de física que, por fín encontraron en 2.012.

La pregunta “¿Qué hay más allá del Modelo estándar”? ha estado facinando a los físicos durante años. Y, desde luego, todos sueñan con llegar a saber, qué es lo que realmente es lo que conforma el “mundo” de la materia, qué partículas, cuerdas o briznas vibrantes. En realidad, lo cierto es que, la Física que conocemos no tiene que ser, necesariamente, la verdadera física que conforma el mundo y, sí, la física que conforma “nuestro mundo”, es decir, el mundo al que hemos podido tener acceso hasta el momento y que no necesariamente tiene que coincidir con el mundo real que no hemos podido alcanzar.

O, como decía aquél: ¡Que mundo más hermoso, parece de verdad!

Siempre hay más de lo que el ojo ve

No todo lo que vemos es, necesariamente, un reflejo de la realidad de la Naturaleza que puede tener escondidos más allá de nuestras percepciones, otros escenarios y otros objetos, a los que, por ahora, no hemos podido acceder, toda vez que, físicamente tenemos carencias, intelectualmente también, y, nuestros conocimientos avanzar despacio para conseguir, nuevas máquinas y tecnologías nuevas que nos posibiliten “ver” lo que ahora nos está “prohibido” y, para ello, como ocurre siempre, necesitamos energías de las que no disponemos.

Hay dos direcciones a lo largo de las cuales se podría extender el Modelo estándar, tal lo conocemos actualmente, que básicamente se caraterizan así:

– Nuevas partículas raras y nuevas fuerzas extremadamente débiles, y

– nuevas partículas pesadas y nuevas estructuras a muy altas energías.

Podrían existir partículas muy difíciles de producir y de detectar y que, por esa razón, hayan pasado desapaercibidas hasta. La primera partícula adicional en la que podríamos pensar es un neutrino rotando a derecha. Recordaremos que si se toma el eje de rotación paralelo a la dirección del movimiento los neutrinos sólo rotan a izquierdas, pero… ¡esa sería otra historia!

Los neutrinos siempre me han fascinado. Siempre se han manifestado como si tuvieran masa estrictamente nula. Parece como si se movieran exactamente con la velocidad de la luz. Pero hay un límite para la precisión de nuestras medidas. Si los neutrinos fueran muy ligeros, por ejemplo, una cienmillonésima de la masa del electrón, seríamos incapaces de detectar en el laboratorio la diferencia éstos y los neutrinos de masa estrictamente nula. Pero, para ello, el neutrino tendría que tener una componente de derechas.

En este punto, los astrónomos se unen a la discusión. No es la primera vez, ni será la última, que la astronomía nos proporciona información esencial en relación a las partículas elementales. Por ejemplo, debido a las interacciones de corriente neutra (las interacciones débiles originadas por un intercambio Zº), los neutrinos son un facto crucial en la explosión supernova de una estrella. sabemos que debido a las interacciones por corriente neutra, pueden colisionar con las capas exteriores de la estrella y volarlas con una fuerza tremenda.

En realidad, los neutrinos nos tienen mucho que decir, todavía y, no lo sabemos todo acerca de ellos, sino que, al contrario, son muchos los y fenómenos que están y subyacen en ellos de los que no tenemos ni la menor idea que existan o se puedan producir. Nuestra ignorancia es grande, y, sin embargo, no nos arredra hablar y hablar de cuestiones que, la mayoría de las veces…ni comprendemos.

Aquí lo dejar´ñe por hoy, el tema es largo y de una fascinación que te puede llevar a lugares en los que no habías pensado al comenzar a escribir, lugares maravillosos donde reinan objetos exóticos y de fascinante porte que, por su pequeñez, pueden vivir en “mundos” muy diferentes al nuestro en los que, ocurren cosas que, nos llevan el asombro y también, a ese mundo mágico de lo fascinante y maravilloso.

Parece que el Modelo estándar no admite la cuarta fuerza y tendremos que buscar más profundamente, en otras teorías que nos hablen y describan además de las partículas conocidas de otras nuevas que están por nacer y que no excluya la Gravedad. Ese es el Modelo que necesitamos para conocer mejor la Naturaleza.

Dicen los expertos que en el Modelo de Cuerdas, y, sobre todo en la Teoría M que unifica todos los que se conocen hasta el momento, subyace la teoría cuántica de la gravedad, es decir, que allí cohabitan cómodamente las dos teorías, la cuántica de Planck y la Relatividad de Einstein. Así, cuando los físicos están desarrollando esta avanzada teoría, sin que nadie las llame, allí aparecen las ecuaciones de campo de Einstein de la Relatividad General.

emilio silvera

Ene

3

Sobre el final del Universo y otros temas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

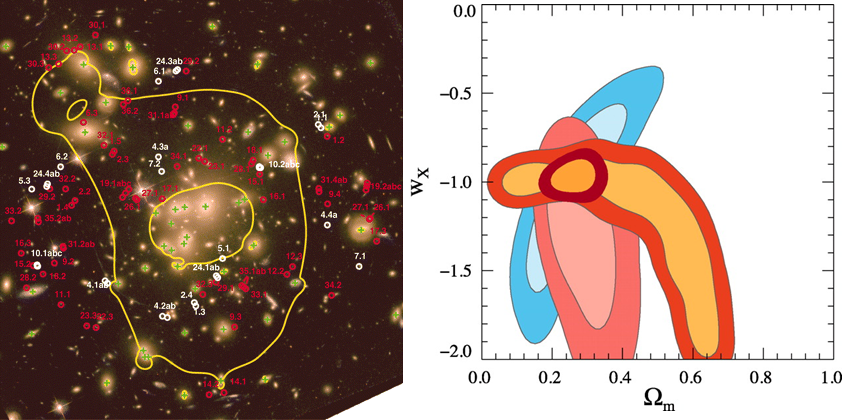

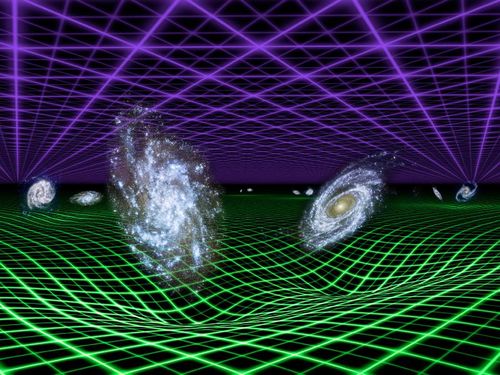

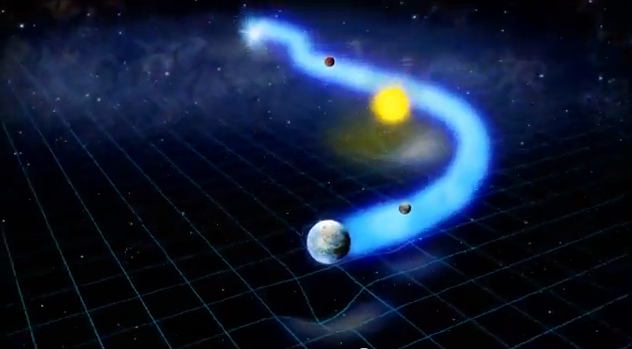

Los cosmólogos llaman Ω a la cantidad de materia que contiene nuestro Universo, y, en función de ella, éste podría ser un universo plano, abierto o cerrado. Conforme a dicha clasificación, podría tener un final u otro.

La Densidad crítica está referida a la densidad media de materia requerida para que la Gravedad detenga la expansión de nuestro Universo. Así que si la densidad es baja se expandirá para siempre, mientras que una densidad muy alta colapsará finalmente. Si tiene exactamente la densidad crítica ideal, de alrededor de 10-29 g/cm3, es descrito por el modelo al que antes nos referimos conocido como de Einstein-de Sitter, que se encuentra en la línea divisoria de estos dos extremos. La densidad media de materia que puede ser observada directamente en nuestro Universo representa sólo el 20% del valor crítico. Puede haber, sin embargo, una gran cantidad de materia oscura que elevaría la densidad hasta el valor crítico. Las teorías de universo inflacionario predicen que la densidad presente debería ser muy aproximada a la densidad crítica; estas teorías requieren la existencia de materia oscura.

Los Modelos Cosmológicos son variados y todos, sin excepción, nos hablan de una clase de universo que está conformado en función de la materia que en él pueda existir. Lo cierto es que no estamos seguros de cuánta materia hay y, los datos que tenemos son referidos a la materia bariónica, esa de la que están formadas las galaxias y también nosotros.

Conforme a lo antes dicho, la densidad media de materia está referida al hecho de distribuir de manera uniforme toda la materia contenida en las galaxias a lo largo de todo el Universo. Aunque las estrellas y los planetas son más densos que el agua (alrededor de 1 g/cm3), la densidad media cosmológica es extremadamente baja, como se dijo antes, unos 10-29 g/cm3, o 10-5 átomos/cm3, ya que el Universo está formado casi exclusivamente de espacios vacíos, virtualmente vacíos, entre las Galaxias. La densidad media es la que determinará si el Universo se expandirá o no para siempre.

Conforme a lo antes dicho, la densidad media de materia está referida al hecho de distribuir de manera uniforme toda la materia contenida en las galaxias a lo largo de todo el Universo. Aunque las estrellas y los planetas son más densos que el agua (alrededor de 1 g/cm3), la densidad media cosmológica es extremadamente baja, como se dijo antes, unos 10-29 g/cm3, o 10-5 átomos/cm3, ya que el Universo está formado casi exclusivamente de espacios vacíos, virtualmente vacíos, entre las Galaxias. La densidad media es la que determinará si el Universo se expandirá o no para siempre.

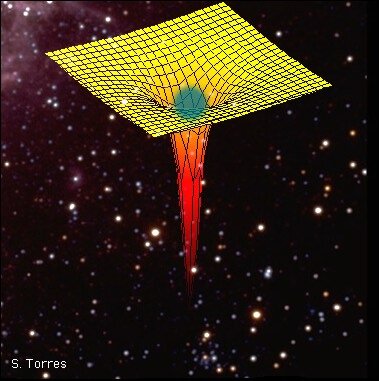

En presencia de grandes masas de materia, tales como planetas, estrellas y Galaxias, está presente el fenómeno descrito por Einstein en su teoría de la relatividad general, la curvatura del espacio-tiempo, eso que conocemos como Gravedad, una fuerza de atracción que actúa entre todos los cuerpos y cuya intensidad depende de las masas y de las distancias que los separan; la fuerza gravitacional disminuye con el cuadrado. La Gravitación es la más débil de las cuatro fuerzas fundamentales de la naturaleza. Isaac Newton formuló las leyes de la atracción gravitacional y mostró que un cuerpo se comporta gravitacionalmente como si toda su masa estuviera concentrada en su centro de Gravedad. Así, pues, la fuerza gravitacional actúa a lo largo de la línea que une los centros de Gravedad de las dos masas (como la Tierra y la Luna, por ejemplo).

En la teoría de la relatividad general, la gravitación se interpreta como una distorsión del espacio que se forma alrededor de la masa que provoca dicha distorsión, cuya importancia iría en función de la importancia de la masa que distorsiona el espacio que, en el caso de estrellas con gran volumen y densidad, tendrán una importancia considerable, igualmente, la fuerza de Gravedad de planetas, satélites y grandes objetos cosmológicos, es importante.

Esta fuerza es la responsable de tener cohexionado a todo el Universo, de hacer posible que existan las Galaxias, los sistemas solares y que, nosotros mismos, tengamos bien asentados los pies a la superficie de nuestro planeta Tierra, cuya gravedad, tira de nosotros para que así sea.

Los cúmulos de galaxias están cohexionados por la Gravedad

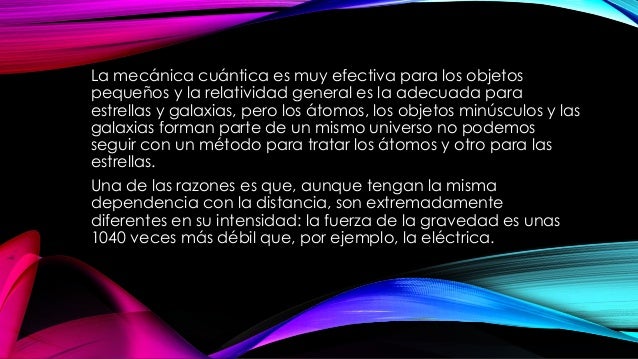

No obstante, a escala atómica la fuerza gravitacional resulta ser unos 1040 veces más débil que la fuerza de atracción electromagnética, muy potente en el ámbito de la mecánica cuántica donde las masas de las partículas son tan enormemente pequeñas que la gravedad es despreciable.

La Gravitación cuántica es la teoría en la que las interacciones gravitacionales entre los cuerpos son descritas por el intercambio de partículas elementales hipotéticas denominadas gravitones. El Gravitón es el cuanto del campo gravitacional. Los gravitones no han sido observados, aunque se presume que existen por analogía a los fotones de luz.

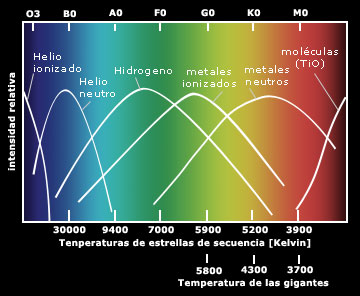

Gráfica que muestra el espectro de cuerpo negro emitido por tres cuerpos a distinta temperatura (4500 K, 6000 K y 7500 K). El eje horizontal es la longitud de onda, mientras que el eje vertical representa la intensidad relativa de la radiación.

La teoría cuántica es un ejemplo de talento que debemos al Físico alemán Max Planck (1.858-1.947) que, en el año 1.900 para explicar la emisión de radiación de cuerpo negro de cuerpos calientes, dijo que la energía se emite en cuantos, cada uno de los cuales tiene una energía igual a hv, donde h es la constante de Planck (E=hv o ħ=h/2л) y v es la frecuencia de la radiación. Esta teoría condujo a la teoría moderna de la interacción entre materia y radiación conocida como mecánica cuántica, que generaliza y reemplaza a la mecánica clásica y a la teoría electromagnética de Maxwell. En la teoría cuántica no relativista se supone que las partículas no son creadas ni destruidas, que se mueven despacio con respecto a la velocidad de la luz y que tienen una masa que no cambia con la velocidad. Estas suposiciones se aplican a los fenómenos atómicos y moleculares y a algunos aspectos de la física nuclear. La teoría cuántica relativista se aplica a partículas que viajan cerca de la velocidad de la luz, como por ejemplo, el fotón.

Por haberlo mencionado antes me veo obligado a explicar brevemente el significado de “cuerpo negro”. Que está referido a un cuerpo hipotético que absorbe toda la radiación que incide sobre él. Tiene, por tanto, una absorbancia y una emisividad de 1. Mientras que un auténtico cuerpo negro es un concepto imaginario, un pequeño agujero en la pared de un recinto a temperatura uniforme es la mejor aproximación que se puede tener de él en la práctica.

La radiación de cuerpo negro es la radiación electromagnética emitida por un cuerpo negro. Se extiende sobre todo el rango de longitudes de onda y la distribución de energía sobre este rango tiene una forma característica con un máximo en una cierta longitud de onda, desplazándose a longitudes de onda más cortas al aumento de temperaturas (ley de desplazamiento de Wien).

La Gravitación cuántica es la teoría en la que las interacciones gravitacionales entre los cuerpos son descritas por el intercambio de partículas elementales hipotéticas denominadas gravitones. El Gravitón es el cuanto del campo gravitacional. Los gravitones no han sido observados, aunque se presume que existen por analogía a los fotones de luz.

Entre los teóricos, el casamiento de la relatividad general y la teoría cuántica es el problema central de la física moderna. A los esfuerzos teóricos que se realizan con ese propósito se les llama “supergravedad”, “súpersimetría”, “supercuerdas” “teoría M” o, en último caso, “teoría de todo o gran teoría unificada”. Lo cierto es que, para que las dos teorías, cuántica y relativista se reúnan sin que surjan los dichosos infinitos, se tiene que plantear dentro de una teoría de dimensiones extra. Esas teorías de más dimensiones, requieren de complejas formulaciones que no todos, podemos entender.

Ahí tenemos unas matemáticas exóticas que ponen de punta hasta los pelos de las cejas de algunos de los mejores matemáticos del mundo (¿y Perelman? ¿Por qué nos se ha implicado?). Hablan de 10, 11 y 26 dimensiones, siempre, todas ellas espaciales menos una que es la temporal. Vivimos en cuatro: tres de espacio (este-oeste, norte-sur y arriba-abajo) y una temporal. No podemos, ni sabemos o no es posible instruir, en nuestro cerebro (también tridimensional), ver más dimensiones. Pero llegaron Kaluza y Klein y compactaron, en la longitud de Planck las dimensiones que no podíamos ver. ¡Problema solucionado!

Nadie ha podido llegar hasta la Longitud de Planck para poder observar lo que allí pueda existir, se denota:

La longitud de Planck forma parte del sistema de unidades naturales, y se calcula a partir de tres constantes fundamentales: la velocidad de la luz en el vacío, la constante de Planck, h, y la constante gravitacional, G. Equivale a la distancia que recorre un fotón, viajando a la velocidad de la luz, en el Tiempo de Planck.

Ni vemos la longitud de Planck ni las dimensiones extra

La puerta de las dimensiones más altas quedó abierta y, a los teóricos, se les regaló una herramienta maravillosa. En el Hiperespacio, todo es posible. Hasta el matrimonio de la relatividad general y la mecánica cuántica, allí si es posible encontrar esa soñada teoría de la Gravedad cuántica.

Así que, los teóricos, se han embarcado a la búsqueda de un objetivo audaz: buscan una teoría que describa la simplicidad primigenia que reinaba en el intenso calor del universo en sus primeros tiempos, una teoría carente de parámetros, donde estén presentes todas las respuestas. Todo debe ser contestado a partir de una ecuación básica.

¿Dónde radica el problema?

Nuestro es tridimensional y no podemos ver otro más allá… ¡si existe!

El problema está en que la única teoría candidata no tiene conexión directa con el mundo de la observación, o no lo tiene todavía si queremos expresarnos con propiedad. La energía necesaria para ello, no la tiene ni el nuevo acelerador de partículas LHC que con sus 14 TeV no llegaría ni siquiera a vislumbrar esas cuerdas vibrantes de las que tanto se habla, para llegar hasta ellas, se necesitaría la energía de Planck, es decir una energía equivalente a 1019 GeV, un sueño que está fuera de nuestras posibilidades humanas en el presente y, seguramenter, durantemuchas generaciones.

La verdad es que, la teoría que ahora tenemos, el Modelo Estándar, concuerda de manera exacta con todos los datos a bajas energías y contesta cosas sin sentido a altas energías.

Con sus 20 parámetros aleatorios (parece que uno de ellos ha sido hallado -el bosón de Higgs-), el Modelo estándar de la física de partículas que incluye sólo tres de las interacicones fundamentales -las fuerzas nucleares débil y fuerte y el electromagnetismo-, ha dado un buen resultado y a permitido a los físicos trabajar ampliamente en el conocimiento del mundo, de la Naturaleza, del Universo. Sin embargo, deja muchas preguntas sin contestar y, lo cierto es que, se necesitan nuevas maneras, nuevas formas, nuevas teorías que nos lleven más allá.

¡Necesitamos algo más avanzado!

Se ha dicho que la función de la partícula de Higgs es la de dar masa a las partículas que conocemos y están incluidas en el Modelo estándar, se nos ha dicho que ha sido encontrada pero, nada se ha dicho de cómo ésta partícula transmite la masa a las demás. Faltan algunas explicaciones.

El secreto de todo radica en conseguir la simplicidad: el átomo resulto ser complejo lleno de esas infinitesimales partículas electromagnéticas que bautizamos con el nombre de electrones, resultó que tenía un núcleo que contenía, a pesar de ser tan pequeño, casi toda la masa del átomo. El núcleo, que siendo infinitesimal, estaba compuesto de otros objetos más pequeños aún, los quarks que estaban instalados en nubes de otras partículas llamadas gluones y, ahora, queremos continuar profundizando, sospechamos, que después de los quarks puede haber algo más.

La influencia de Higgs en las masas de los quarks y de los leptones, nos recuerda el descubrimiento por Pieter Zeeman, en 1.896, de la división de los niveles de energía de un electrón cuando se aplica un campo magnético al átomo. El campo (que representa metafóricamente el papel de Higgs) rompe la simetría del espacio de la que el electrón disfrutaba.

Hasta ahora no tenemos ni idea de que reglas controlan los incrementos de masa generados por el Higgs (de ahí la expectación creada por el nuevo acelerador de partículas LHC) en su nueva andadura en el mes de abril de 2.016. Pero el problema es irritante: ¿por qué sólo esas masas –Las masas de los W+, W–, y Zº, y el up, el down, el encanto, el extraño, el top y el bottom, así como los leptones – que no forman ningún patrón obvio?

No dejamos de experimentar para saber ccómo es nuestro mundo, la Naturaleza, el Universo que nos acoge

Las masas van de la del electrón 0’0005 GeV, a la del top, que tiene que ser mayor que 91 GeV. Deberíamos recordar que esta extraña idea (el Higgs) se empleó con mucho éxito para formular la teoría electrodébil (Weinberg-salam). Allí se propuso el campo de Higgs como una forma de ocultar la unidad de las fuerzas electromagnéticas y débiles. En la unidad hay cuatro partículas mensajeras sin masa –los W+, W–, Zº y fotón que llevan la fuerza electrodébil. Además está el campo de Higgs, y, rápidamente, los W y Z chupan la esencia de Higgs y se hacen pesados; el fotón permanece intacto. La fuerza electrodébil se fragmenta en la débil (débil porque los mensajeros son muy gordos) y la electromagnética, cuyas propiedades determina el fotón, carente de masa. La simetría se rompe espontáneamente, dicen los teóricos. Prefiero la descripción según la cual el Higgs oculta la simetría con su poder dador de masa.

Las masas de los W y el Z se predijeron con éxito a partir de los parámetros de la teoría electrodébil. Y las relajadas sonrisas de los físicos teóricos nos recuerdan que Gerard ^t Hooft y Veltman dejaron sentado que la teoría entera esta libre de infinitos.

Lo cierto es que, la Gravedad, se ha negado a ser incluída en el Modelo estándard de la física de partículas.

La asignatura pendiente de la física teórica del siglo XX ha sido la unificación de la relatividad general y la mecánica cuántica. Las aproximaciones que se han hecho van desde la cuantificación canónica del campo gravitatorio hasta la ampliación de las simetrías en la teoría de supercuerdas. Existen también teorías que buscan una nueva interpretación de las teorías del espacio-tiempo, como se vio en el congreso sobre la ontología del espacio-tiempo que tuvo lugar en junio de 2006 en Montreal.

Penrose es actualmente Profesor emérito de Matemáticas de la Universidad de Oxford, y ya en los años 60 presentó su teoría de los “spin networks” que después fue tomada por Ashtekar y Rovelli, y otros, en la teoría de la gravitación cuántica.

A partir de los años 70, Penrose presentó su teoría de los “twistor”, que algunos físicos han aplicado a la teoría de las supercuerdas para resolver el enigma de las 11 dimensiones del espacio-tiempo. En su último libro “El camino a la Realidad” Penrose ha reivindicado la paternidad de las teorías de los “spin networks” y de los “twistors” que se empieza a utilizar por los físicos teóricos y que nosotros vamos a resumir brevemente.

Roger Penrose es uno de los nuevos humanistas del siglo que se ha interesado por los problemas de las matemáticas, de la física, de la biología, de la psicología y de la filosofía. Siguiendo el modelo de Popper de los tres mundos, ha trabajado sobre la flecha del mundo 1 de la física, al mundo 2 de la conciencia, y del mundo 3 de las matemáticas, al mundo 1.

En esta última dirección ha publicado numerosos libros y artículos, donde aborda la asignatura pendiente de la unificación de la mecánica cuántica y la teoría del campo gravitatorio. El camino que ha seguido Penrose es encontrar una base común a ambas.

Para ello ha introducido dos modelos: los “spin networks” y los “twistors”, el primero discreto, con una métrica intrínseca, no relativista, previo al concepto de espacio, el segundo continuo, con una métrica extrínseca, relativista e inmerso en un espacio-tiempo dado.

Con estos modelos intenta Penrose responder a la pregunta sobre el “por qué” de la realidad física, en vez del “cómo”. Nos encontramos así ante uno de los grandes misterios de la razón humana que nos acercan al misterio del Universo.

“Spin networks” y gravedad cuántica

El modelo de los “twistors” se ha aplicado con éxito a la clasificación de las partículas elementales y a la formulación de la relatividad general. Pero recientemente algunos modelos de la gravedad cuántica han retomado la idea de los “spin networks” de Penrose para desarrollar un modelo discreto llamado loop quantum gravity donde el espacio subyacente está discretizado.

Claro que son varias las corrientes que quieren abrirse camino hacia otras físicas nuevas.

La teoría de supercuerdas tiene tantas sorpresas fantásticas que cualquiera que investigue en el tema reconoce que está llena de magia. Es algo que funciona con tanta belleza… Cuando cosas que no encajan juntas e incluso se repelen, si se acerca la una a la otra alguien es capaz de formular un camino mediante el cual, no sólo no se rechazan, sino que encajan a la perfección dentro de ese sistema, como ocurre ahora con la teoría M que acoge con naturalidad la teoría de la relatividad general y la teoría mecánico-cuántica; ahí, cuando eso se produce, está presente la belleza.

Lo que hace que la teoría de supercuerdas sea tan interesante es que el marco estándar mediante el cual conocemos la mayor parte de la física es la teoría cuántica y resulta que ella hace imposible la gravedad. La relatividad general de Einstein, que es el modelo de la gravedad, no funciona con la teoría cuántica. Sin embargo, las supercuerdas modifican la teoría cuántica estándar de tal manera que la gravedad no sólo se convierte en posible, sino que forma parte natural del sistema; es inevitable para que éste sea completo.

¿Por qué es tan importante encajar la gravedad y la teoría cuántica? Porque no podemos admitir una teoría que explique las fuerzas de la naturaleza y deje fuera a una de esas fuerzas. Así ocurre con el Modelo Estándar que deja aparte y no incluye a la fuerza gravitatoria que está ahí, en la Naturaleza.

Lo que sí es una verdad irrefutable es que… ¡La búsqueda continua!

emilio silvera

Ene

2

Velocidades inimaginables

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (3)

Comments (3)

La sorpresa salta en cualquier parte

Hablar de Albert Einstein y Stephen Hawking es hablar de dos de las personas más brillantes de la historia. Dos científicos simplemente extraordinarios, que marcaron el siglo XX y que a menudo son señalados como ejemplos de inteligencia. Se cree que ambos tenían un cociente intelectual de 160, sólo dos puntos por debajo del máximo posible en el test de Mensa, sociedad fundada en 1946 que reúne a personas superdotadas de todo el mundo. Ese tope de 162 es la puntuación obtenida por Nicole Barr, una niña gitana de 12 años residente en el condado de Essex (Inglaterra).

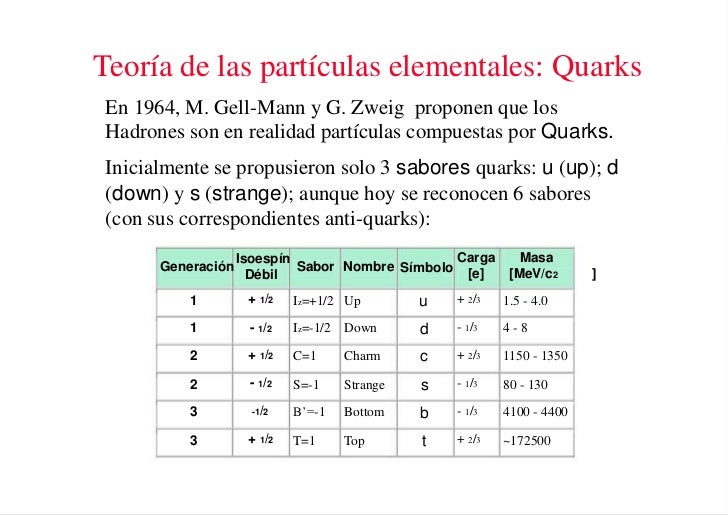

Una vez que se pusieron en orden entre las numerosas especies de partículas, se puede reconocer una pauta. Igual que Dimitri Ivanovich Mendeleev descubrió el sistema periódico de los elementos químicos en 1869, así también se hizo visible un sistema similar para las partículas. Esta pauta la encontraron independientemente el americano Murray Gell-Mann y el israelí Yuval Ne’eman. Ocho especies de mesones, todos con el mismo espín, u ocho especies de bariones, con el mismo espín, se podían reagrupar perfectamente en grupos que llamaremos multipletes. El esquema matemático correspondiente se llama SU(3). Grupletes de ocho elementos forman un octete “fundamental”. Por esta razón Gell-Mann llamó a esta teoría el “óctuplo camino”. Lo tomó prestado del budismo de acuerdo con el cual el camino hacia el nirvana es el camino óctuplo.

La enorme variedad de formas, colores, comportamientos, etc que acompaña a los objetos, incluidos los vivientes, sería una consecuencia de la riqueza en la información que soportan las moléculas (y sus agregados) que forman parte de dichos objetos. Ello explicaría que las moléculas de la vida sean en general de grandes dimensiones (macromoléculas). La inmensa mayoría de ellas contiene carbono. Debido a su tetravalencia y a la gran capacidad que posee dicho átomo para unirse consigo mismo, dichas moléculas pueden considerarse como un esqueleto formado por cadenas de esos átomos.

El carbono no es el único átomo con capacidad para formar los citados esqueletos. Próximos al carbono en la tabla periódica, el silicio, fósforo y boro comparten con dicho átomo esa característica, si bien en un grado mucho menor.

En el centro del átomo se encuentra un pequeño grano compacto aproximadamente 100.000 veces más pequeño que el propio átomo: el núcleo atómico. Su masa, e incluso más aún su carga eléctrica, determinan las propiedades del átomo del cual forma parte. Debido a la solidez del núcleo parece que los átomos, que dan forma a nuestro mundo cotidiano, son intercambiables entre sí, e incluso cuando interaccionan entre ellos para formar sustancias químicas (los elementos). Pero el núcleo, a pesar de ser tan sólido, puede partirse. Si dos átomos chocan uno contra el otro con gran velocidad podría suceder que los núcleos llegaran a chocar entre sí y entonces, o bien se rompen en trozos, o se funden liberando en el proceso partículas subnucleares. La nueva física de la primera mitad del siglo XX estuvo dominada por los nuevos acertijos que estas partículas planteaban.

Pero tenemos la mecánica cuántica; ¿es que no es aplicable siempre?, ¿cuál es la dificultad? Desde luego, la mecánica cuántica es válida para las partículas subatómicas, pero hay más que eso. Las fuerzas con que estas partículas interaccionan y que mantienen el núcleo atómico unido son tan fuertes que las velocidades a las que tienen que moverse dentro y fuera del núcleo están cerca de la velocidad de la luz, c, que es de 299.792’458 Km/s. Cuando tratamos con velocidades tan altas se necesita una segunda modificación a las leyes de la física del siglo XIX; tenemos que contar con la teoría de la relatividad especial de Einstein.

Esta teoría también fue el resultado de una publicación de Einstein de 1905. en esta teoría quedaron sentadas las bases de que el movimiento y el reposo son conceptos relativos, no son absolutos, como tampoco habrá un sistema de referencia absoluto con respecto al cual uno pueda medir la velocidad de la luz.

Pero había más cosas que tenían que ser relativas. En este teoría, la masa y la energía también dependen de la velocidad, como lo hacen la intensidad del campo eléctrico y del magnético. Einstein descubrió que la masa de una partícula es siempre proporcional a la energía que contienen, supuesto que se haya tenido en cuenta una gran cantidad de energía en reposo de una partícula cualquiera, como se denota a continuación:

E = mc2

Como la velocidad de la luz es muy grande, esta ecuación sugiere que cada partícula debe almacenar una cantidad enorme de energía, y en parte esta predicción fue la que hizo que la teoría de la relatividad tuviese tanta importancia para la física (¡y para todo el mundo!). Para que la teoría de la relatividad también sea autoconsistente tiene que ser holista, esto es, que todas las cosas y todo el mundo obedezcan a las leyes de la relatividad. No son sólo los relojes los que se atrasan a grandes velocidades, sino que todos los procesos animados se comportan de la forma tan inusual que describe esta teoría cuando nos acercamos a la velocidad de la luz. El corazón humano es simplemente un reloj biológico y latirá a una velocidad menor cuando viaje en un vehículo espacial a velocidades cercanas a la de la luz. Este extraño fenómeno conduce a lo que se conoce como la “paradoja de los gemelos”, sugerida por Einstein, en la que dos gemelos idénticos tienen diferente edad cuando se reencuentran después de que uno haya permanecido en la Tierra mientras que el otro ha viajado a velocidades relativistas.

Einstein comprendió rápidamente que las leyes de la gravedad también tendrían que ser modificadas para que cumplieran el principio relativista.

Para poder aplicar el principio de la relatividad a la fuerza gravitatoria, el principio tuvo que ser extendido de la siguiente manera: no sólo debe ser imposible determinar la velocidad absoluta del laboratorio, sino que también es imposible distinguir los cambios de velocidad de los efectos de una fuerza gravitatoria.

Einstein comprendió que la consecuencia de esto era que la gravedad hace al espacio-tiempo lo que la humedad a una hoja de papel: deformar la superficie con desigualdades que no se pueden eliminar. Hoy en día se conocen muy bien las matemáticas de los espacios curvos, pero en el época de Einstein el uso de estas nociones matemáticas tan abstractas para formular leyes físicas era algo completamente nuevo, y le llevó varios años encontrar la herramienta matemática adecuada para formular su teoría general de la relatividad que describe cómo se curva el espacio en presencia de grandes masas como planetas y estrellas.

Einstein tenía la idea en su mente desde 1907 (la relatividad especial la formuló en 1905), y se pasó 8 años buscando las matemáticas adecuadas para su formulación.

El tensor de Riemann contiene toda la información necesaria para poder describir un espacio curvo en N-dimensiones. Se necesita dieciséis números para …

Leyendo el material enviado por un amigo al que pidió ayuda, Einstein quedó paralizado. Ante él, en la primera página de una conferencia dada ante el Sindicato de Carpinteros, 60 años antes por un tal Riemann, tenía la solución a sus desvelos: el tensor métrico de Riemann, que le permitiría utilizar una geometría espacial de los espacios curvos que explicaba su relatividad general.

No está mal que en este punto recordemos la fuerza magnética y gravitatoria que nos puede ayudar a comprender mejor el comportamiento de las partículas subatómicas.

El electromagnetismo, decíamos al principio, es la fuerza con la cual dos partículas cargadas eléctricamente se repelen (si sus cargas son iguales) o se atraen (si tienen cargas de signo opuesto).

La interacción magnética es la fuerza que experimenta una partícula eléctricamente cargada que se mueve a través de un campo magnético. Las partículas cargadas en movimiento generan un campo magnético como, por ejemplo, los electrones que fluyen a través de las espiras de una bobina.

Esta teoría del electromagnetismo de Maxwell tenía la particularidad de que requería que la velocidad de la luz tuviera un valor fijo y definido, que normalmente se conoce como c, y que un unidades ordinarias es aproximadamente 3 × 108 metros por segundo.

Las fuerzas magnéticas y eléctricas están entrelazadas. En 1873, James Clerk Maxwell consiguió formular las ecuaciones completas que rigen las fuerzas eléctricas y magnéticas, descubiertas experimentalmente por Michael Faraday. Se consiguió la teoría unificada del electromagnetismo que nos vino a decir que la electricidad y el magnetismo eran dos aspectos de una misma cosa.

La interacción es universal, de muy largo alcance (se extiende entre las estrellas), es bastante débil. Su intensidad depende del cociente entre el cuadrado de la carga del electrón y 2hc (dos veces la constante de Planck por la velocidad de la luz). Esta fracción es aproximadamente igual a 1/137’036…, o lo que llamamos α y se conoce como constante de estructura fina.

En general, el alcance de una interacción electromagnética es inversamente proporcional a la masa de la partícula mediadora, en este caso, el fotón, sin masa.

También antes hemos comentado sobre la interacción gravitatoria de la que Einstein descubrió su compleja estructura y la expuso al mundo en 1915 con el nombre de teoría general de la relatividad, y la relacionó con la curvatura del espacio y el tiempo. Sin embargo, aún no sabemos cómo se podrían reconciliar las leyes de la gravedad y las leyes de la mecánica cuántica (excepto cuando la acción gravitatoria es suficientemente débil).

La teoría de Einstein nos habla de los planetas y las estrellas del cosmos. La teoría de Planck, Heisemberg, Schrödinger, Dirac, Feynman y tantos otros, nos habla del comportamiento del átomo, del núcleo, de las partículas elementales en relación a estas interacciones fundamentales. La primera se ocupa de los cuerpos muy grandes y de los efectos que causan en el espacio y en el tiempo; la segunda de los cuerpos muy pequeños y de su importancia en el universo atómico. Cuando hemos tratado de unir ambos mundos se produce una gran explosión de rechazo. Ambas teorías son (al menos de momento) irreconciliables.

La presencia de masas determina la geometría del espacio

- La interacción gravitatoria actúa exclusivamente sobre la masa de una partícula.

- La gravedad es de largo alcance y llega a los más lejanos confines del universo conocido.

- Es tan débil que, probablemente, nunca podremos detectar esta fuerza de atracción gravitatoria entre dos partículas elementales. La única razón por la que podemos medirla es debido a que es colectiva: todas las partículas (de la Tierra) atraen a todas las partículas (de nuestro cuerpo) en la misma dirección.

La partícula mediadora es el hipotético gravitón. Aunque aún no se ha descubierto experimentalmente, sabemos lo que predice la mecánica cuántica: que tiene masa nula y espín 2.

La ley general para las interacciones es que, si la partícula mediadora tiene el espín par, la fuerza entre cargas iguales es atractiva y entre cargas opuestas repulsiva. Si el espín es impar (como en el electromagnetismo) se cumple a la inversa.

Pero antes de seguir profundizando en estas cuestiones hablemos de las propias partículas subatómicas, para lo cual la teoría de la relatividad especial, que es la teoría de la relatividad sin fuerza gravitatoria, es suficiente.

Viajar al “mundo” de lo muy pequeño resulta fascinante

Si viajamos hacia lo muy pequeño tendremos que ir más allá de los átomos, que son objetos voluminosos y frágiles comparados con lo que nos ocupará a continuación: el núcleo atómico y lo que allí se encuentra. Los electrones, que ahora vemos “a gran distancia” dando vueltas alrededor del núcleo, son muy pequeños y extremadamente robustos. El núcleo está constituido por dos especies de bloques: protones y neutrones. El protón (del griego πρώτος, primero) debe su nombre al hecho de que el núcleo atómico más sencillo, que es el hidrógeno, está formado por un solo protón. Tiene una unidad de carga positiva. El neutrón recuerda al protón como si fuera su hermano gemelo: su masa es prácticamente la misma, su espín es el mismo, pero en el neutrón, como su propio nombre da a entender, no hay carga eléctrica; es neutro.

La masa de estas partículas se expresa en una unidad llamada mega-electrón-voltio o MeV, para abreviar. Un MeV, que equivale a 106 electrón-voltios, es la cantidad de energía de movimiento que adquiere una partícula con una unidad de carga (tal como un electrón o un protón) cuando atraviesa una diferencia de potencial de 106 (1.000.000) voltios. Como esta energía se transforma en masa, el MeV es una unidad útil de masa para las partículas elementales.

La mayoría de los núcleos atómicos contienen más neutrones que protones. Los protones se encuentran tan juntos en el interior de un núcleo tan pequeño que se deberían repeles entre sí fuertemente, debido a que tienen cargas eléctricas del mismo signo. Sin embargo, hay una fuerza que los mantiene unidos estrechamente y que es mucho más potente e intensa que la fuerza electromagnética: la fuerza o interacción nuclear fuerte, unas 102 veces mayor que la electromagnética, y aparece sólo entre hadrones para mantener a los nucleones confinados dentro del núcleo. Actúa a una distancia tan corta como 10-15 metros, o lo que es lo mismo, 0’000000000000001 metros.

La interacción fuerte está mediada por el intercambio de mesones virtuales, 8 gluones que, como su mismo nombre indica (glue en inglés es pegamento), mantiene a los protones y neutrones bien sujetos en el núcleo, y cuanto más se tratan de separar, más aumenta la fuerza que los retiene, que crece con la distancia, al contrario que ocurre con las otras fuerzas.

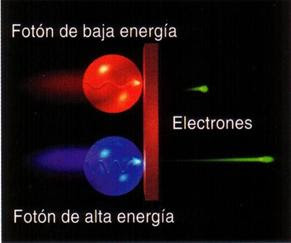

La luz es una manifestación del fenómeno electromagnético y está cuantizada en “fotones”, que se comportan generalmente como los mensajeros de todas las interacciones electromagnéticas. Así mismo, como hemos dejado reseñado en el párrafo anterior, la interacción fuerte también tiene sus cuantos (los gluones). El físico japonés Hideki Yukawa (1907 – 1981) predijo la propiedad de las partículas cuánticas asociadas a la interacción fuerte, que más tarde se llamarían piones. Hay una diferencia muy importante entre los piones y los fotones: un pión es un trozo de materia con una cierta cantidad de “masa”. Si esta partícula está en reposo, su masa es siempre la misma, aproximadamente 140 MeV, y si se mueve muy rápidamente, su masa parece aumentar en función E = mc2. Por el contrario, se dice que la masa del fotón en reposo es nula. Con esto no decimos que el fotón tenga masa nula, sino que el fotón no puede estar en reposo. Como todas las partículas de masa nula, el fotón se mueve exclusivamente con la velocidad de la luz, 299.792’458 Km/s, una velocidad que el pión nunca puede alcanzar porque requeriría una cantidad infinita de energía cinética. Para el fotón, toda su masa se debe a su energía cinética.

La cámara de niebla, también conocida como cámara de Wilson, es un dispositivo utilizado para detectar partículas de radiación ionizante. En su forma más sencilla, una cámara de niebla es un entorno cerrado que contiene vapor de agua superenfriado y supersaturado. Cuando una partícula cargada de suficiente energía interacciona con el vapor, lo ioniza. Los iones resultantes actúan como núcleos de condensación. alrededor de los cuales se forman gotas de líquido que dan lugar a una niebla. Al paso de las partículas se va produciendo una estela o traza, debido a los numerosos iones producidos a lo largo de su trayectoria.

Los físicos experimentales buscaban partículas elementales en las trazas de los rayos cósmicos que pasaban por aparatos llamados cámaras de niebla. Así encontraron una partícula coincidente con la masa que debería tener la partícula de Yukawa, el pión, y la llamaron mesón (del griego medio), porque su masa estaba comprendida entre la del electrón y la del protón. Pero detectaron una discrepancia que consistía en que esta partícula no era afectada por la interacción fuerte, y por tanto, no podía ser un pión. Actualmente nos referimos a esta partícula con la abreviatura μ y el nombre de muón, ya que en realidad era un leptón, hermano gemelo del electrón, pero con 200 veces su masa.

Antes de seguir veamos las partículas elementales de vida superior a 10-20 segundos que eran conocidas en el año 1970.

| Nombre | Símbolo | Masa (MeV) | Carga | Espín | Vida media (s) |

| Fotón | γ | 0 | 0 | 1 | ∞ |

| Leptones (L = 1, B = 0) | |||||

| Electrón | e– | 0’5109990 | – | ½ | ∞ |

| Muón | μ– | 105’6584 | – | ½ | 2’1970 × 10-6 |

| Tau | τ | ||||

| Neutrino electrónico | νe | ~ 0 | 0 | ½ | ~ ∞ |

| Neutrino muónico | νμ | ~ 0 | 0 | ½ | ~ ∞ |

| Neutrino tauónico | ντ | ~ 0 | 0 | ½ | ~ ∞ |

| Mesones (L = 0, B = 0) | |||||

| Pión + | π+ | 139’570 | 2’603 × 10-8 | ||

| Pión – | π– | 139’570 | 2’603 × 10-8 | ||

| Pión 0 | π0 | 134’976 | 0’84 × 10-16 | ||

| Kaón + | k+ | 493’68 | 1’237 × 10-8 | ||

| Kaón – | k– | 493’68 | 1’237 × 10-8 | ||

| Kaón largo | kL | 497’7 | 5’17 × 10-8 | ||

| Kaón corto | kS | 497’7 | 0’893 × 10-10 | ||

| Eta | η | 547’5 | 0 | 0 | 5’5 × 10-19 |

| Bariones (L = 0, B = 1) | |||||

| Protón | p | 938’2723 | + | ½ | ∞ |

| Neutrón | n | 939’5656 | 0 | ½ | 887 |

| Lambda | Λ | 1.115’68 | 0 | ½ | 2’63 × 10-10 |

| Sigma + | Σ+ | 1.189’4 | + | ½ | 0’80 × 10-10 |

| Sigma – | Σ– | 1.1974 | – | ½ | 7’4× 10-20 |

| Sigma 0 | Σ0 | 0 | ½ | 1’48 × 10-10 | |

| Ksi 0 | Ξ0 | 1.314’9 | 0 | ½ | 2’9 × 10-10 |

| Ksi – | Ξ– | 1.321’3 | – | ½ | 1’64 × 10-10 |

| Omega – | Ω– | 1.672’4 | – | 1½ | 0’82 × 10-10 |

Para cada leptón y cada barión existe la correspondiente antipartícula, con exactamente las mismas propiedades a excepción de la carga que es la contraria. Por ejemplo, el antiprotón se simboliza con y el electrón con e+. Los mesones neutros son su propia antipartícula, y el π+ es la antipartícula del π–, al igual que ocurre con k+ y k–. El símbolo de la partícula es el mismo que el de su antipartícula con una barra encima. Las masas y las vidas medias aquí reflejadas pueden estar corregidas en este momento, pero de todas formas son muy aproximadas.

Los símbolos que se pueden ver algunas veces, como s (extrañeza) e i (isoespín) están referidos a datos cuánticos que afectan a las partículas elementales en sus comportamientos.

Debo admitir que todo esto tiene que sonar algo misterioso. Es difícil explicar estos temas por medio de la simple palabra escrita sin emplear la claridad que transmiten las matemáticas, lo que, por otra parte, es un mundo secreto para el común de los mortales, y ese lenguaje es sólo conocido por algunos privilegiados que, mediante un sistema de ecuaciones pueden ver y entender de forma clara, sencilla y limpia, todas estas complejas cuestiones.

Si hablamos del espín (o, con más precisión, el momento angular, que es aproximadamente la masa por el radio por la velocidad de rotación) se puede medir como un múltiplo de la constante de Planck, h, dividido por 2π. Medido en esta unidad y de acuerdo con la mecánica cuántica, el espín de cualquier objeto tiene que ser o un entero o un entero más un medio. El espín total de cada tipo de partícula – aunque no la dirección del mismo – es fijo.

Espín del Electrón

Los espines “up” y “down”, permiten dos electrones para cada conjunto de números cuánticos espaciales  |

El espín del electrón s = 1/2 es una propiedad intrínseca de los electrones. Los electrones tienen un momento angular intrínseco caracterizado por el número cuántico 1/2. En el patrón de otros momentos angulares cuantizados, esto da un momento angular total

|

El electrón, por ejemplo, tiene espín ½. Esto lo descubrieron dos estudiantes holandeses, Samuel Gondsmit (1902 – 1978) y George Uhlenbeck (1900 – 1988), que escribieron sus tesis conjuntamente sobre este problema en 1972. Fue una idea audaz que partículas tan pequeñas como los electrones pudieran tener espín, y de hecho, bastante grande. Al principio, la idea fue recibida con escepticismo porque la “superficie del electrón” se tendría que mover con una velocidad 137 veces mayor que la de la luz, lo cual va en contra de la teoría de la relatividad general en la que está sentado que nada en el universo va más rápido que la luz, y por otra parte, contradice E=mc2, y el electrón pasada la velocidad de la luz tendría una masa infinita.

Hoy día, sencillamente, tal observación es ignorada, toda vez que el electrón carece de superficie.

Las partículas con espín entero se llaman bosones, y las que tienen espín entero más un medio se llaman fermiones. Consultado los valores del espín en la tabla anterior podemos ver que los leptones y los bariones son fermiones, y que los mesones y los fotones son bosones. En muchos aspectos, los fermiones se comportan de manera diferente de los bosones. Los fermiones tienen la propiedad de que cada uno de ellos requiere su propio espacio: dos fermiones del mismo tipo no pueden ocupar o estar en el mismo punto, y su movimiento está regido por ecuaciones tales que se evitan unos a otros. Curiosamente, no se necesita ninguna fuerza para conseguir esto. De hecho, las fuerzas entre los fermiones pueden ser atractivas o repulsivas, según las cargas. El fenómeno por el cual cada fermión tiene que estar en un estado diferente se conoce como el principio de exclusión de Pauli. Cada átomo está rodeado de una nube de electrones, que son fermiones (espín ½). Si dos átomos se aproximan entre sí, los electrones se mueven de tal manera que las dos nubes se evitan una a otra, dando como resultado una fuerza repulsiva. Cuando aplaudimos, nuestras manos no se atraviesan pasando la uno a través de la otra. Esto es debido al principio de exclusión de Pauli para los electrones de nuestras manos que, de hecho, los de la izquierda rechazan a los de la derecha.

Estadística Fermi-Dirac para las Fermiones. La estadística de Fermi-Dirac es la de contar estados de ocupación de forma estadística en un sistema de …

La estadística de Bose-Einstein es un tipo de mecánica estadñistica aplicable a la determinación de las propiedades estadísticas de conjuntos grandes de partículas indistinguibles capaces de coexistir en el mismo estado cuántico (bosones) en equilibrio térmico. A bajas temperaturas los bosones tienden a tener un comportamiento cuántico similar que puede llegar a ser idéntico a temperaturas cercanas al cero absoluto en un estado de la materia conocido como condensado de Bose-Einstein y producido por primera vez en laboratorio en el año 1995.

En contraste con el característico individualismo de los fermiones, los bosones se comportan colectivamente y les gusta colocarse todos en el mismo lugar. Un láser, por ejemplo, produce un haz de luz en el cual muchísimos fotones llevan la misma longitud de onda y dirección de movimiento. Esto es posible porque los fotones son bosones.

Cuando hemos hablado de las fuerzas fundamentales que, de una u otra forma, interaccionan con la materia, también hemos explicado que la interacción débil es la responsable de que muchas partículas y también muchos núcleos atómicos exóticos sean inestables. La interacción débil puede provocar que una partícula se transforme en otra relacionada, por emisión de un electrón y un neutrino. Enrico Fermi, en 1934, estableció una fórmula general de la interacción débil, que fue mejorada posteriormente por George Sudarshan, Robert Marschak, Murray Gell-Mann, Richard Feynman y otros. La fórmula mejorada funciona muy bien, pero se hizo evidente que no era adecuada en todas las circunstancias.

En 1970, de las siguientes características de la interacción débil sólo se conocían las tres primeras:

Decaimiento Beta

- La interacción actúa de forma universal sobre muchos tipos diferentes de partículas y su intensidad es aproximadamente igual para todas (aunque sus efectos pueden ser muy diferentes en cada caso). A los neutrinos les afecta exclusivamente la interacción débil.

- Comparada con las demás interacciones, ésta tiene un alcance muy corto.

- La interacción es muy débil. Consecuentemente, los choques de partículas en los cuales hay neutrinos involucrados son tan poco frecuentes que se necesitan chorros muy intensos de neutrinos para poder estudiar tales sucesos.

- Los mediadores de la interacción débil, llamados W+, W– y Z0, no se detectaron hasta la década de 1980. al igual que el fotón, tienen espín 1, pero están eléctricamente cargados y son muy pesados (esta es la causa por la que el alcance de la interacción es tan corto). El tercer mediador, Z0, que es responsable de un tercer tipo de interacción débil que no tiene nada que ver con la desintegración de las partículas llamada “corriente neutra”, permite que los neutrinos puedan colisionar con otras partículas sin cambiar su identidad.

A partir de 1970, quedó clara la relación de la interacción débil y la electromagnética (electrodébil de Weinberg-Salam).

La interacción fuerte (como hemos dicho antes) sólo actúa entre las partículas que clasificamos en la familia llamada de los hadrones, a los que proporciona una estructura interna complicada. Hasta 1972 sólo se conocían las reglas de simetría de la interacción fuerte y no fuimos capaces de formular las leyes de la interacción con precisión.

Como apuntamos, el alcance de esta interacción no va más allá del radio de un núcleo atómico ligero (10-13 cm aproximadamente).

La interacción es fuerte. En realidad, la más fuerte de todas.

Lo dejaré aquí, en verdad, eso que el Modelo Estándar de la Física, es feo, complejo e incompleto y, aunque hasta el momento es una buena herramienta con la que trabajar, la verdad es que, se necesita un nuevo modelo más avanzado y que incluya la Gravedad.

Veremos que nos trae la nueva etapa del LHC cuando comience sus actividades en abril/mayo de 2.016

emilio silvera

Dic

24

¡La Física! Siempre presente en nuestras vidas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

En 1.849, el físico francés Armand-Hippolyte-Louis Fizeau ideó un artificio mediante el cual se proyectaba la luz sobre un espejo situado a 8 km de distancia, que devolvía el reflejo al observador. El tiempo empleado por la luz en su viaje de ida y vuelta no rebasó apenas la 1/20.000 de segundo, pero Fizeau logró medirlo colocando una rueda dentada giratoria en la trayectoria del rayo luminoso. Cuando dicha rueda giraba a cierta velocidad, regulada, la luz pasaba entre los dientes y se proyectaba contra el siguiente, al ser devuelta por el espejo; así, Fizeau, colocado tras la rueda, no pudo verla. Entonces se dio más velocidad a la rueda, y el reflejo pasó por la siguiente muesca entre los dientes, sin intercepción alguna. De esa forma, regulando y midiendo la velocidad de la rueda giratoria, Fizeau pudo calcular el tiempo transcurrido y, por consiguiente, la velocidad a que se movía el rayo de luz.

Jean-Bernard-Léon Foucault suspendió una bola de 62 libras (unos 28 kilogramos) de hierro desde la cúpula del Panteón y lo puso en movimiento, balanceándolo. Para marcar su progreso el enganchó una aguja a la bola y colocó un anillo de tierra mojada en el suelo bajo él. La audiencia observó con pavor como el péndulo inexplicablemente parecía rotar, dejando un trazo ligeramente distinto en cada balanceo. En realidad era el suelo del Panteón el que estaba ligeramente en movimiento, y Foucault había demostrado, de una forma más convincente que nunca, que la tierra gira sobre su eje. En la latitud de París, el trazo del péndulo completaría una rotación completa en el sentido horario cada 30 horas; en el hemisferio sur rotaría en sentido antihorario, y en el ecuador no rotaría nada. En el Polo Sur, como han confirmado los científicos de la era moderna, el periodo de rotación es de 24 horas.

Un año más tarde, Jean Foucault (quien realizaría poco después su experimento -arriba- con los péndulos) precisó más estas medidas empleando un espejo giratorio en ve de una rueda dentada. Entonces se midió el tiempo transcurrido desviando ligeramente el ángulo de reflexión mediante el veloz espejo giratorio. Foucault obtuvo un valor de la velocidad de la luz de 300.883 km/s. También, el físico francés utilizó su método para determinar la velocidad de la luz a través de varios líquidos. Averiguó que era notablemente inferior a la alcanzada en el aire. Esto concordaba también con la teoría ondulatoria de Huyghens (abajo).

La naturaleza de la luz. Profesor escrupuloso, aunque poco entusiasta, Newton se dedicó a estudios de óptica que le llevaron, a través de una serie de experimentos, al famoso descubrimiento de la descomposición de la luz blanca, que fue explicada por él mediante una teoría corpuscular de la luz destinada a dar jaque a la teoría ondulatoria de C. Huygens y a dominar durante todo el siglo XVIII. Experimentos, descubrimientos e hipótesis sobre la luz fueron hechos públicos en una memoria a la Royal Society. Pero las tempestuosas disputas suscitadas por esta memoria le disgustaron hasta el punto de que se abstuvo de publicar sus Lecciones de óptica (desarrolladas en la cátedra lucasiana entre 1668 y 1671), las cuales sólo vieron la luz en 1729. No obstante, en 1675 presentó a la Royal Society una importante memoria, que constituirá después la base de su Óptica, en la que, partiendo de los experimentos sobre la coloración de laminillas metálicas, expone los principios de su teoría sobre la luz. En la imagen, El descubrimiento de la refracción de la luz de Newton (1827), óleo del pintor italiano Pelagio Palagi.

Michelson, Einstein y Millikan

Michelson fue más preciso aún en sus medidas. Este autor, durante cuarenta años largos, a partir de 1.879, fue aplicando el sistema Fizeau-Foucault cada vez con mayor refinamiento, para medir la velocidad de la luz. Cuando se creyó lo suficientemente informado, proyectó la luz a través de vacío, en vez de hacerlo a través del aire, pues este frena ligeramente su velocidad, y, empleó para ello tuberías de acero cuya longitud era superior a 1’5 km. Según sus medidas, la velocidad de la luz en el vacío era de 299.730 km/seg. (Sólo un 0’006% más bajo). Demostraría también que todas las longitudes de ondas luminosas viajan a la misma velocidad en el vacío.

En 1972, un equipo de investigadores bajo la dirección de Kenneth M. Eveson efectuó unas mediciones aún más exactas y vio que la velocidad de la luz era de 299.727’74 km/seg. Una vez se conoció la velocidad de la luz con semejante precisión, se hizo posible usar la luz, o por lo menos formas de ella, para medir distancias.

Desde Galileo con sus lámparas, cada vez se han utilizado aparatos más sofisticados para medir la velocidad de la luz, y, finalmente, se consiguió medirla de manera muy exacta en 299.792.458 metros por segundo que, es el límite que algo puede alcanzar corriendo por el espacio vacío y que sólo ha conseguido la luz.

Aunque para algunos resulte alto tedioso el tema anterior, no he podido resistirme a la tentación de exponerlo, así podrá saber algo más sobre la luz y, habrán conocido a personajes que hicieron posible el que ahora nosotros, la conozcamos mejor.

Podría continuar, hasta el final de este trabajo, hablando de la luz y sus distintas formas o aplicaciones: ondas de luz a través del espacio, de cómo se transmite la luz en el “vacío”, nos llega a través del espacio desde Galaxias situadas a miles de millones de años luz; las líneas de fuerzas electromagnéticas de Faraday y Maxwell de campos eléctricos y magnéticos cambiantes (todo ello explicado en un simple conjunto de cuatro ecuaciones, que describían casi todos los fenómenos referentes a esta materia electromagnética), o de los enigmas aún por descubrir (aunque predichos).

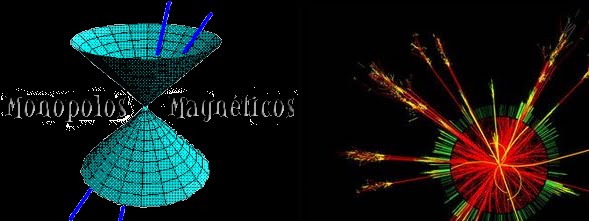

Muchos han ido a la caza de los monopolos magnéticos que, deben ser raros en el Universo, si finalmente existen. Parece que, algunos físicos han conseguido alguna cosa…no se bien qué sobre su existencia.

En 1.931, Dirac, acometiendo el asiento de una forma matemática, llegó a la conclusión de que sí los monopolos magnéticos existían, sería necesario que todas las cargas eléctricas fuesen múltiplos exactos de una carga más pequeña, como en efecto así es. Y dado que todas las cargas eléctricas son múltiplos exactos de alguna carga más pequeña, ¿no deberían en realidad existir los monopolos magnéticos?

En 1.974, un físico joven y prometedor (más tarde ganó el Nobel), Gerard’t Hooft, y un físico soviético, Alexander Poliakov, mostraron, independientemente, que podía razonarse, a partir de las grandes teorías unificadas, que los monopolos magnéticos debían así mismo existir, y que debían poseer una masa enorme. Aunque un monopolo magnético sería incluso más pequeño que un protón, debería tener una masa que sería de 10 trillones a 10 cuatrillones mayor que la del protón. Eso equivaldría a la masa de una bacteria comprimida en una diminuta partícula subatómica.

![[monopolos+m.gif]](http://4.bp.blogspot.com/_nbADpD65WD4/SqENDeBLtLI/AAAAAAAAJ0s/XB4iORp8-eQ/s1600/monopolos%2Bm.gif)

Sería la confirmación de una teoría de 1931. Si seres de otros mundos han podido verlos, habrían visto otro tipo de magnetismo los llamados “monopolos magnéticos”.

Semejantes partículas sólo podían haberse formado en el momento de la gran explosión (otra vez volvemos al origen). Desde entonces, no ha existido la suficientemente alta concentración de energía necesaria para formarla. Esas grandes partículas deberían avanzar a unos 225 km por seg., más o menos, y la combinación de una enorme masa y un pequeño tamaño le permitiría deslizarse a través de la materia sin dejar el menor rastro de presencia. Esta propiedad, de hecho, está relacionada directamente con el fracaso obtenido en su búsqueda.

Los físicos están tratando de idear un mecanismo capaz de poder detectar, con claridad, el paso de monopolos magnéticos.

Podríamos decir que, un monopolo magnético es una entidad magnética hipotética consistente en un polo Norte o Sur elemental aislado. Ha sido postulado como una fuente de campo magnético en analogía a la forma en que las partículas eléctricamente cargadas producen un campo eléctrico.

Se han diseñado numerosos experimentos ingeniosos para detectar monopolos, pero hasta ahora, ninguno ha producido un resultado definitivo. Los monopolos magnéticos son predichos en ciertas teorías gauge con bosones de Higgs. En particular, algunas teorías de gran unificación predicen monopolos muy pesados (con masas del orden de 1016 geV). Se habló de su aparición en los primeros experimentos del LHC, algunos denunciaron eso junto con la aparición de agujeros negros microscópicos pero, de momento…nada

Los monopolos magnéticos también son predichos en las teorías de Kaluza-Klein (5 dimensiones) y en teoría de supercuerdas (10 y 26 dimensione). Es decir, que se predice pero no se puede verificar, y, siendo así, quedamos anclados en el campo de la teoría.

Recuerdo que estaba hablando de los distintos aspectos de la luz, lo que no recuerdo es como he llegado a éste berenjenal de los monopolos magnéticos. Me ocurre siempre, estoy tratando un tema y termino hablando (escribiendo) de otro. No parece más que, el bolígrafo, tenga vida propia. Sin embargo, lo que ocurre en verdad es que, todo es uno, compuesto de distintas partes. Siempre estamos hablando de lo mismo, solo cambian las partes que, en cada momento, estemos estudiando.

La misteriosa materia que compondría el 23 % (se especula) de toda la materia del universo es tan esquiva que jamás ha sido observada por nadie. Así que sólo podíamos sospechar que quizá existía. La materia oscura emite, absorbe e interactúa con radiación electromagnética de manera tan débil que no puede ser observada por medios técnicos ordinarios, no refleja la luz para ser observada.

“Un equipo internacional de astrónomos de Japón, Gran Bretaña y Taiwan acaba de conseguir, por primera vez, imágenes que reflejan la distribución de materia oscura alrededor de 20 grandes cúmulos de galaxias. Los resultados se publicarán en la revista mensual de la Royal Astronomical Society. Las pruebas aún no son concluyentes, pero sí muy esperanzadoras”.

Ni en el infrarrojo, ni en los rayos X ni en el ultravioleta la materia oscura había revelado aún su auténtica naturaleza. Pero utilizando lentes gravitacionales los científicos han sido capaces de mostrar las primeras imágenes en las que se “aprecia” la misteriosa materia oscura. Bueno, eso es lo que dicen ellos.

Masa-Materia-Luz: Todo la misma cosa ¡Energía! que es el motor que hace andar al ¡El Universo!

emilio silvera

Dic

23

¡La Física! ¿Qué sería de nosotros sin ella?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

Incluso las frecuencias de onda cerebrales están estrechamente relacionadas con la actividad fisiológica de nuestro organismo. Esto es algo indudable, puesto que todo lo que conocemos en el mundo físico está compuesto por átomos que vibran a determinadas frecuencias. En las últimas décadas, la física cuántica nos ha revelado información muy importante acerca de nuestra realidad. Fue Richard Feynman el que dijo en cierta ocasión que si tuviera que elegir en una frase el descubrimiento más importante de la Ciencia moderna, elegiría:

El mundo está hecho de átomos”

Muchas son las veces que aquí nos hemos referido a que, 500 años antes de Cristo, ya algunos hablaban de ese hecho cierto de que “el mundo estaba hecho de átomos”. Los filósofos de la Naturaleza (como los llamaban entonces), Leucipo de Mileto y su Alumno, Demócrito de Abdera, fueron los encargados de divulgar ese increíble hecho que, según ellos decían: “Todas las cosas estaban hechas de unos objetos invisibles e indivisibles, la parte más pequeña de la materia que llamaban a-tomo o átomos. Aquella historia viene de mucho más lejos y, esos filósofos griegos tomaron prestadas las ideas de los pensadores hindúes que mucho antes que ellos hablaban de átomos y de vacío. Otro filósofo de la Naturaleza, Empédocles, nos decía:

“Pues yo he sido a veces un muchacho y una chica,

Un matorral y un pájaro y un pez en las olas saladas.”

Esto nos decía Empédocles, el padre de aquellos primitivos elementos formados por Agua, tierra, aire y fuego que, mezclados en la debida proporción, formaban todas las cosas que podemos ver a nuestro alrededor. Claro que, él no podía llegar a imaginar hasta donde pudimos llegar después en la comprensión de la materia a partir del descubrimiento de las partículas “elementales” que formaban el átomo. Pero sí, con sus palabras, nos quería decir que, la materia, una veces está conformando mundos y, en otras, estrellas y galaxias.

Sí, hay cosas malas y buenas pero todas deben ser conocidas para poder, en el primer caso aprovecharlas, y en el segundo, prevenirlas.

Pero demos un salto en el tiempo y viajémos hasta los albores del siglo XX cuando se hacía cada vez más evidente que alguna clase de energía atómica era responsable de la potencia del Sol y del resto de las estrellas que más lejos, brillaban en la noche oscura. Ya en 1898, sólo dos años despuès del descubrimiento de la radiactividad por Becquerel, el geólogo americano Thomas Chrowder Chamberlin especulaba que los átomos eran “complejas organizaciones y centros de eneromes energías”, y que “las extraordinarias condiciones que hay en el centro del Sol pueden…liberar una parte de su energía”. Claro que, por aquel entonces, nadie sabía cual era el mecanismo y cómo podía operar, hasta que no llegamos a saber mucho más sobre los átomos y las estrellas.

Conseguimos tener los átomos en nuestras manos y, aunque la imagen sea simbólica, nos muestra una realidad, toda vez que, en este mismo instante podemos construir “cosas” átomo a átomo. Hemos llegado a un nivel de manipulación de la materia que ni podíamos imaginar hasta hace tan sólo un siglo. Si aquellos Filósofos Naturales levantarán la cabeza…