Ago

7

Hoy un sueño ¿Realidad mañana?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

Seguramente, como hemos podido ver en una película de ciencia ficción, llegará un día en el que, podremos entrar en una inmensa habitación de hologramas, en la que, previa elección de la programación adecuada, todo se transformará en un “mundo ficticio” que, lo mismo podrá ser una playa luminosa con arena dorada, una Selva tropical o un desierto, dependiendo de los gustos del usuario.

Si repasamos la historia de la ciencia, seguramente encontraremos muchos motivos para el optimismo. Witten (el Físico de la Teoría M), está convencido de que la ciencia será algún día capaz de sondear hasta las energías de Planck. Como ya he contado en otras ocasiones, él dijo:

“No siempre es tan fácil decir cuáles son las preguntas fáciles y cuáles las difíciles. En el siglo XIX, la pregunta de por qué el agua hierve a 100 grados era desesperadamente inaccesible. Si usted hubiera dicho a un físico del siglo XIX que hacia el siglo XX sería capaz de calcularlo, le habría parecido un cuento de hadas… La teoría cuántica de campos es tan difícil que nadie la creyó completamente durante 25 años.”

En su opinión, las buenas ideas siempre se verifican. Los ejemplos son innumerables: la gravedad de Newton, el campo eléctrico de Faraday y el electromagnetismo de Maxwell, la teoría de la relatividad de Einstein en sus dos versiones y su demostración del efecto fotoeléctrico, la teoría del electrón de Paul Dirac, el principio de incertidumbre de Heisenberg, la función de ondas de Schrödinger, y tantos otros. Algunos de los físicos teóricos más famosos, sin embargo, protestaban de tanto empeño en la experimentación. El astrónomo arthur Eddington se cuestionaba incluso si los científicos no estaban forzando las cosas cuando insistían en que todo debería ser verificado.

Sin embargo, muchos son los ejemplos de un ingenio superior que nos llevaron a desvelar secretos de la Naturaleza que estaban profundamente escondidos, y, el trabajo de Dirac en relación al electrón, es una buena muestra de ese ingenio humano que, de vez en cuando vemos florecer.

Siendo m la masa en reposo del electrón, c la velocidad de la luz, p el operador de momento,  la constante reducida de Planck, x y t las coordenadas del espacio y el tiempo, respectivamente; y ψ (x, t) una función de onda de cuatro componentes. La función de onda ha de ser formulada como un espinor (objeto matemático similar a un vector que cambia de signo con una rotación de 2π descubierto por Pauli y Dirac) de cuatro componentes, y no como un simple escalar, debido a los requerimientos de la relatividad especial. Los α son operadores lineales que gobiernan la función de onda, escritos como una matriz y son matrices de 4×4 conocidas como matrices de Dirac.

la constante reducida de Planck, x y t las coordenadas del espacio y el tiempo, respectivamente; y ψ (x, t) una función de onda de cuatro componentes. La función de onda ha de ser formulada como un espinor (objeto matemático similar a un vector que cambia de signo con una rotación de 2π descubierto por Pauli y Dirac) de cuatro componentes, y no como un simple escalar, debido a los requerimientos de la relatividad especial. Los α son operadores lineales que gobiernan la función de onda, escritos como una matriz y son matrices de 4×4 conocidas como matrices de Dirac.

En la representación de Dirac, las cuatro matrices gamma contravariantes son:

-

\gamma es una matriz tipo tiempo y el resto son matrices tipo espacio.

El premio Nobel Paul Dirac incluso llegó a decir de forma más categórica: “Es más importante tener belleza en las ecuaciones que tener experimentos que se ajusten a ellas“, o en palabras del físico John Ellis del CERN, “Como decía en una envoltura de caramelos que abrí hace algunos años, «Es sólo el optimista el que consigue algo en este mundo».“

Yo, como todos ustedes, un hombre normal y corriente de la calle, escucho a unos y a otros, después pienso en lo que dicen y en los argumentos y motivaciones que les han llevado a sus respectivos convencimientos, y finalmente, también decido según mis propios criterios mi opinión, que no obligatoriamente coincidirá con alguna de esas opiniones, y que en algún caso, hasta me permito emitirla.

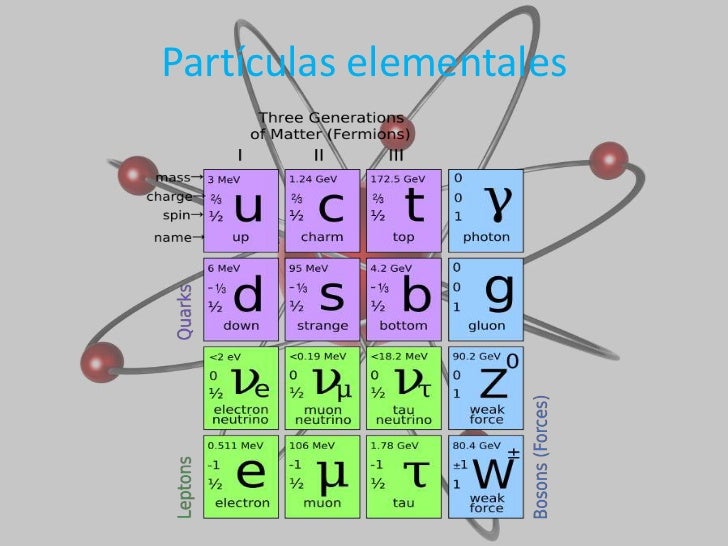

Niveles de aumento de la materia:

- Materia.

- Estructura molecular.

- Átomos.

- Electrones.

- Quarks.

- Cuerdas.

Suponiendo que algún físico brillante nos resuelva la teoría de campos de cuerdas y derive las propiedades conocidas de nuestro universo, con un poco de suerte, podría ocurrir en este mismo siglo, lo que no estaría nada mal considerando las dificultades de la empresa. El problema fundamental es que estamos obligando a la teoría de cuerdas a responder preguntas sobre energías cotidianas, cuando su “ámbito natural” está en la energía de Planck. Esta fabulosa energía fue liberada sólo en el propio instante de la creación, lo que quiere decir que la teoría de supercuerdas es naturalmente una teoría de la creación.

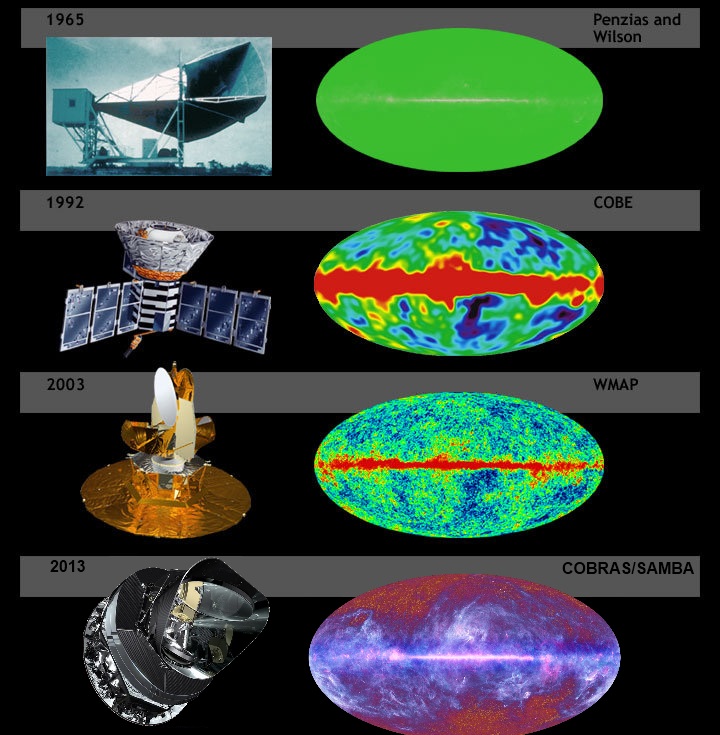

Las primeras observaciones realizadas por Planck | ESA y Axel Mellinger.

Fuimos capaces de predecir que el Big Bang produjo un “eco” cósmico reverberando en el universo y que podría ser mesurable por los instrumentos adecuados. De hecho, Arno Penzias y Robert Wilson de los Bell Telephone Laboratories ganaron el premio Nobel en 1.978 por detectar este eco del Big Bang, una radiación de microondas que impregna el universo conocido. El que el eco del Big Bang debería estar circulando por el universo miles de millones de años después del suceso fue predicho por primera vez por George Gamow y sus discípulos Ralpher y Robert Herman, pero nadie les tomó en serio.

La propia idea de medir el eco de la creación parecía extravagante cuando la propusieron por primera vez poco después de la segunda guerra mundial. Su lógica, sin embargo, era aplastante. Cualquier objeto, cuando se calienta, emite radiación de forma gradual. Ésta es la razón de que el hierro se ponga al rojo vivo cuando se calienta en un horno, y cuanto más se calienta, mayor es la frecuencia de radiación que emite. Una fórmula matemática exacta, la ley de Stefan-Boltzmann, relaciona la frecuencia de la luz (o el color en este caso) con la temperatura. De hecho, así es como los científicos determinan la temperatura de la superficie de una estrella lejana; examinando su color. Esta radiación se denomina radiación de cuerpo negro.

Esta radiación, cómo no, ha sido aprovechada por los ejércitos, que mediante visores nocturnos pueden operar en la oscuridad. De noche, los objetos relativamente calientes, tales como soldados enemigos o los carros de combate, pueden estar ocultos en la oscuridad, pero continúan emitiendo radiación de cuerpo negro invisible en forma de radiación infrarroja, que puede ser captada por gafas especiales de infrarrojo. Ésta es también la razón de que nuestros automóviles cerrados se calientes en verano, ya que la luz del Sol atraviesa los cristales del coche y calienta el interior. A medida que se calienta, empieza a emitir radiación de cuerpo negro en forma de radiación infrarroja. Sin embargo, esta clase de radiación no atraviesa muy bien el vidrio, y por lo tanto queda atrapada en el interior del automóvil, incrementando espectacularmente la temperatura.

Análogamente, la radiación de cuerpo negro produce el efecto invernadero. Al igual que el vidrio, los altos niveles de dióxido de carbono en la atmósfera, causados por la combustión sin control de combustibles fósiles, pueden atrapar la radiación de cuerpo negro infrarroja en la Tierra, y de este modo calentar gradualmente el planeta.

Hemos creado ingenios tecnológicos que nos midan el fondo cósmico de microondas del Big Bang

Gamow razonó que el Big Bang era inicialmente muy caliente, y que por lo tanto sería un cuerpo negro ideal emisor de radiación. Aunque la tecnología de los años cuarenta era demasiado primitiva para captar esta débil señal de la creación, Gamow pudo calcular la temperatura de dicha radiación y predecir con fiabilidad que un día nuestros instrumentos serían lo suficientemente sensibles como para detectar esta radiación “fósil”.

La lógica que había detrás de su razonamiento era la siguiente: alrededor de 300.000 años después del Big Bang, el universo se enfrió hasta el punto en el que los átomos pudieron empezar a componerse; los electrones pudieron empezar a rodear a los protones y neutrones formando átomos estables, que ya no serían destruidos por la intensa radiación que estaba impregnando todo el universo. Antes de este momento, el universo estaba tan caliente que los átomos eran inmediatamente descompuestos por esa radiación tan potente en el mismo acto de su formación. Esto significa que el universo era opaco, como una niebla espesa absorbente e impenetrable.

Pasados 300.000 años, la radiación no era tan potente; se había enfriado y por lo tanto la luz podía atravesar grades distancias sin ser dispersada. En otras palabras, el universo se hizo repentinamente negro y transparente.

Terminaré esta parte comentando que un auténtico cuerpo negro es un concepto imaginario; un pequeño agujero en la pared de un recinto a temperatura uniforme es la mejor aproximación que se puede tener de él en la práctica.

La radiación de cuerpo negro es la radiación electromagnética emitida por un cuerpo negro. Se extiende sobre todo el rango de longitudes de onda y la disminución de energías sobre este rango tiene una forma característica con un máximo en una cierta longitud de onda, desplazándose a longitudes de onda más cortas al aumentar las temperaturas*.

Hablar, sin más especificaciones, de radiación, es estar refiriéndonos a una energía que viaja en forma de ondas electromagnéticas o fotones por el universo. También nos podríamos estar refiriendo a un chorro de partículas, especialmente partículas alfa o beta de una fuente radiactiva o neutrones de un reactor nuclear.

La radiación actínida es la electromagnética que es capaz de iniciar una reacción química. El término es usado especialmente para la radiación ultravioleta y también para denotar radiación que podría afectar a las emulsiones fotográficas.

Radiación blanda, radiación cósmica, radiación de calor, radiación de fondo, de fondo de microondas, radiación dura, electromagnética, radiación gamma, infrarroja, ionizante, monocromática, policromática, de sincrotón, ultravioleta, de la teoría cuántica, de radiactividad… y, como se puede ver, la radiación en sus diversas formas es un universo en sí misma.

Siempre me llamó la atención y se ganó mi admiración el físico alemán Max Planck (1.858 – 1.947), responsable entre otros muchos logros de la ley de radiación de Planck, que da la distribución de energía radiada por un cuerpo negro. Introdujo en física el concepto novedoso de que la energía es una cantidad que es radiada por un cuerpo en pequeños paquetes discretos, en vez de una emisión continua. Estos pequeños paquetes se conocieron como cuantos y la ley formulada es la base de la teoría cuántica.

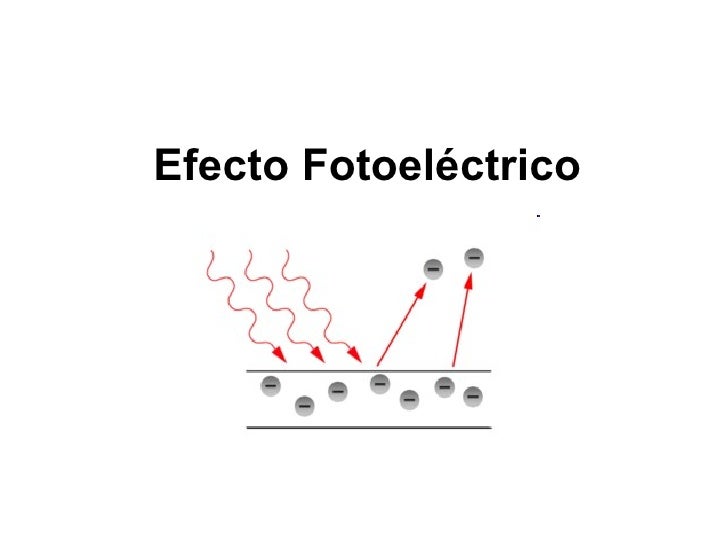

Einstein se inspiró en este trabajo para a su vez presentar el suyo propio sobre el efecto fotoeléctrico, donde la energía máxima cinética del fotoelectrón, Em, está dada por la ecuación que lleva su nombre: Em = hf – Φ.

Cada metal requiere, para que se produzca la extracción, una radiación con una frecuencia mínima (no). Cualquier otra radiación de menor frecuencia, no será capaz de arrancar electrones. Por debajo de la frecuencia mínima la intensidad de corriente -”i” (amperios)- será cero. No hay efecto fotoeléctrico.

Planck publicó en 1.900 un artículo sobre la radiación de cuerpo negro que sentó las bases para la teoría de la mecánica cuántica que más tarde desarrollaron otros, como el mismo Einstein, Heisenberg, Schrödinger, Dirac, Feymann, etc. Todos los físicos son conocedores de la enorme contribución que Max Planck hizo en física: la constante de Planck, radiación de Planck, longitud de Planck, unidades de Planck, etc. Es posible que sea el físico de la historia que más veces ha dado su nombre a conceptos de física. Pongamos un par te ejemplos de su ingenio:

1. vale 10-35 metros. Esta escala de longitud (veinte órdenes de magnitud menor que el tamaño del protón, de 10-15 m) es a la que la descripción clásica de gravedad cesa de ser válida y debe ser tenida en cuenta la mecánica cuántica. En la fórmula que la describe, G es la constante gravitacional, ħ es la constante de Planck racionalizada y c en la velocidad de la luz.

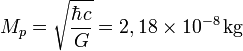

2. . Es la masa de una partícula cuya longitud de onda Compton es igual a la longitud de Planck. En la ecuación, ħ es la constante de Planck racionalizada, c es la velocidad de la luz y G es la constante gravitacional. Así, Se denomina masa de Planck a la cantidad de masa (21,7644 microgramos) que, incluida en una esfera cuyo radio fuera igual a la longitud de Planck, generaría una densidad del orden de 1093 g/cm³. Según la física actual, esta habría sido la densidad del Universo cuando tenía unos  segundos, el llamado Tiempo de Planck. Su ecuación, es decir la masa de Planc se denota:

segundos, el llamado Tiempo de Planck. Su ecuación, es decir la masa de Planc se denota:

El valor de la masa de Planck  se expresa por una fórmula que combina tres constantes fundamentales, la constante de Planck, (h), la velocidad de la luz (c), y la constante de gravitación universal (G). La masa de Planck es una estimación de la masa del agujero negro primordial menos masivo, y resulta de calcular el límite donde entran en conflicto la descripción clásica y la descripción cuántica de la gravedad.

se expresa por una fórmula que combina tres constantes fundamentales, la constante de Planck, (h), la velocidad de la luz (c), y la constante de gravitación universal (G). La masa de Planck es una estimación de la masa del agujero negro primordial menos masivo, y resulta de calcular el límite donde entran en conflicto la descripción clásica y la descripción cuántica de la gravedad.

“Aunque todas estas descripciones reflejan más una abundante imaginación que un hecho existencial apoyado teóricamente con alguna hipótesis que pueda ser comprobada en el laboratorio sobre hechos que están más allá de poder ser medidos jamás en algún laboratorio construido por humanos. La única forma de confrontar la factibilidad o la posibilidad del modelo de la espuma cuántica nos lleva necesariamente a confrontar la carencia de un modelo que logre unificar con éxito al macrocosmos con el microcosmos, a la Relatividad General con la Mecánica Cuántica, la Gravedad Cuántica. Si la energía y la materia (o mejor dicho la masa-energía) están formadas por discretas partículas, se supone que también deben de estarlo el espacio y el tiempo (o mejor dicho, el espacio-tiempo), y la “partícula fundamental” del espacio-tiempo debe de serlo el gravitón, aunque de momento todo esto son especulaciones que seguirán siéndolo mientras no tengamos a la mano algo que pueda confirmar la existencia de tan exótica partícula, quizá la más exótica de cuantas hayan sido concebidas por la imaginación del hombre.”

La descripción de una partícula elemental de esta masa, o partículas que interaccionan con energías por partículas equivalentes a ellas (a través de E = mc2), requiere de una teoría cuántica de la gravedad. Como la masa de Planck es del orden de 10-8 Kg (equivalente a una energía de 1019 GeV) y, por ejemplo, la masa del protón es del orden de 10-27 Kg y las mayores energías alcanzables en los aceleradores de partículas actuales son del orden de 103 GeV, los efectos de gravitación cuántica no aparecen en los laboratorios de física de partículas. Únicamente en un laboratorio aparecieron partículas que tenían energías del orden de la masa de Planck: en el universo primitivo, de acuerdo con la teoría del Big Bang, motivo éste por el que es necesaria una teoría cuántica de la gravedad para estudiar aquellas condiciones. Esta energía de la que estamos hablando, del orden de 1019 GeV (inalcanzable para nosotros), es la que necesitamos para verificar la teoría de supercuerdas.

Siempre, desde que puedo recordar, me llamó la atención los misterios y secretos encerrados en la naturaleza, y la innegable batalla mantenida a lo largo de la historia por los científicos para descubrirlos. Muchos han sido los velos que hemos podido descorrer para que, la luz cegadora del saber pudiera entrar en nuestras mentes para hacerlas comprender cómo actuaba la Naturaleza en ciertas ocasiones y el por qué de tales comportamientos, y, sin embargo, a pesar del largo camino recorrido, es mucho más el que nos queda por andar.

emilio silvera

Ago

6

¡La curiosidad humana! Siempre queriendo saber

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Fuerzas y Constantes…¡El Universo!

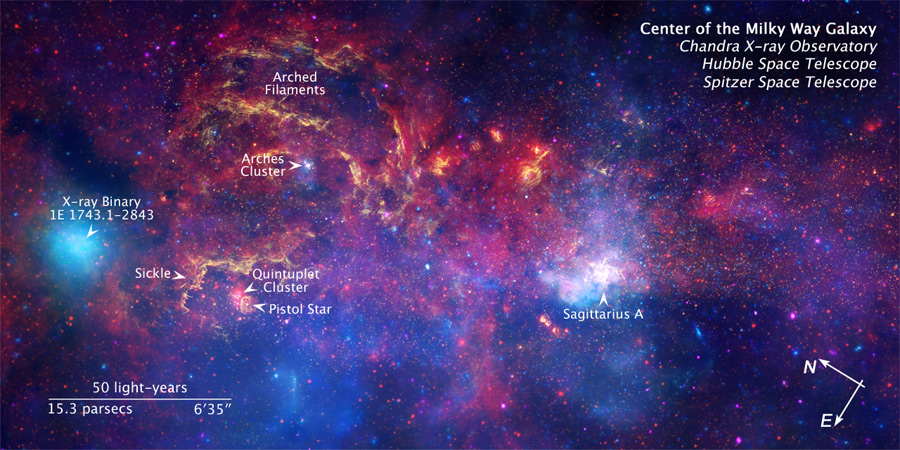

Sagitario A es una poderosa fuente de ondas de radio situada en el corazón mismo de la Vía Láctea, nuestra Galaxia, y ubicada en la Constelación de …

Hubo que descubrir la Historia y tratar de explorarla. Los mensajes del pasado se transmitían primero a través de las habilidades de la memoria, luego de la escritura y, finalmente, de modo explosivo, en los libros. El insospechado tesoro de reliquias que guardaba la tierra se remontaba a la prehistoria. El pasado se convirtió en algo más que un almacén de mitos y leyendas o un catálogo de lo familiar. Todavía, en algunos rincones antiguos de nuestras ciudades se pueden encontrar vestigios del pasado.

Calles y edificios del casco antiguo de Avilés (uno de los más importantes del norte de España) están declarados Conjunto Histórico Artístico por el Estado Español – La ciudad conserva importantes vestigios del pasado, algunos de ellos realmente notables. Lo mismo ocurre en otras muchas ciudades repartidas por todo el mundo y que nos recuerda lo que se fue.

Algunos mensajes que todavía podemos leer en algunos perdidos lugares de la geografía española, ¡son tan inocentes! que nos remontan a otros tiempos, a otro mundo que, aunque nos parezca mentira, es el mundo nuestro, el mismo que habitamos y la diferencia está marcada por el paso del tiempo y la evolución. Es fácil pasar de lo cotidiano y entrañable al átomo invisible que está, sin estar, presente en todo y en todos. En relación al átomo se podría decir, sin temor a equivocarnos que, es lo invisible siempre presente.

Nuevos mundos terrestres y marinos, riquezas de continentes remotos, relatos de viajeros aventureros que nos traían otras formas de vida de pueblos ignotos y lejanos, abrieron perspectivas de progreso y novedad. La sociedad, la vida diaria del hombre en comunidad, se convirtió en un y cambiante escenarios de descubrimientos. Muy atrás quedaron aquellos tiempos en que la vida que pululaba por el planeta era rudimentaria, sin consciencia. El nacimiento de la Humanidad, lleno el mundo de pensamientos.

Cuando en el Neolítico se descubrió la rueda y el arado, ¿qué salto hacia el futuro no daría la Humanidad?

Aquí, como sería imposible hacer un recorrido por el ámbito de todos los descubrimientos de la Humanidad, me circunscribo al ámbito de la física, y, hago un recorrido breve por el mundo del átomo que es el tema de hoy, sin embargo, sin dejar de mirar al hecho cierto de que, TODA LA HUMANIDAD ES UNA, y, luego, teniendo muy presente que, todo lo que conocemos es finito y lo que no conocemos infinito. Es bueno tener presente que intelectualmente nos encontramos en medio de un océano ilimitado de lo inexplicable. La tarea de cada generación es reclamar un poco más de terreno, añadir algo a la extensión y solidez de nuestras posesiones del saber (eso nos aconsejó el físico John Wheeler.)

Como decía Einstein: “El eterno misterio del mundo es su comprensibilidad.”

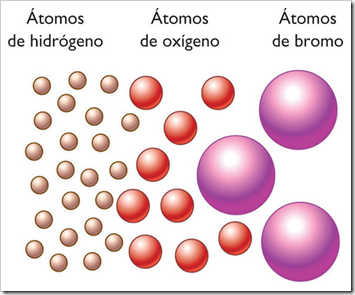

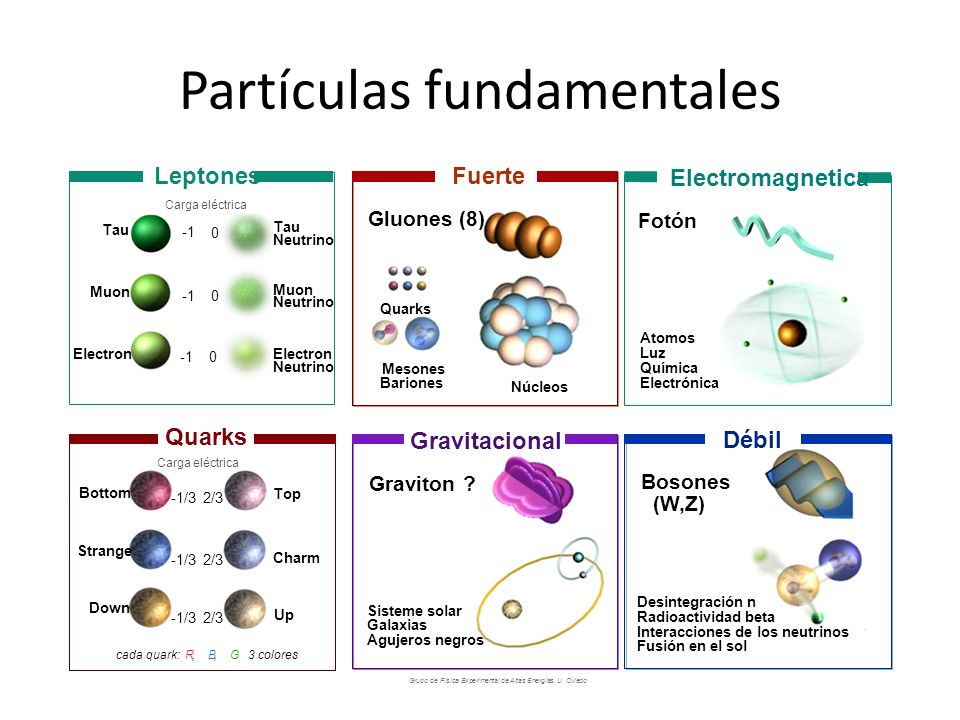

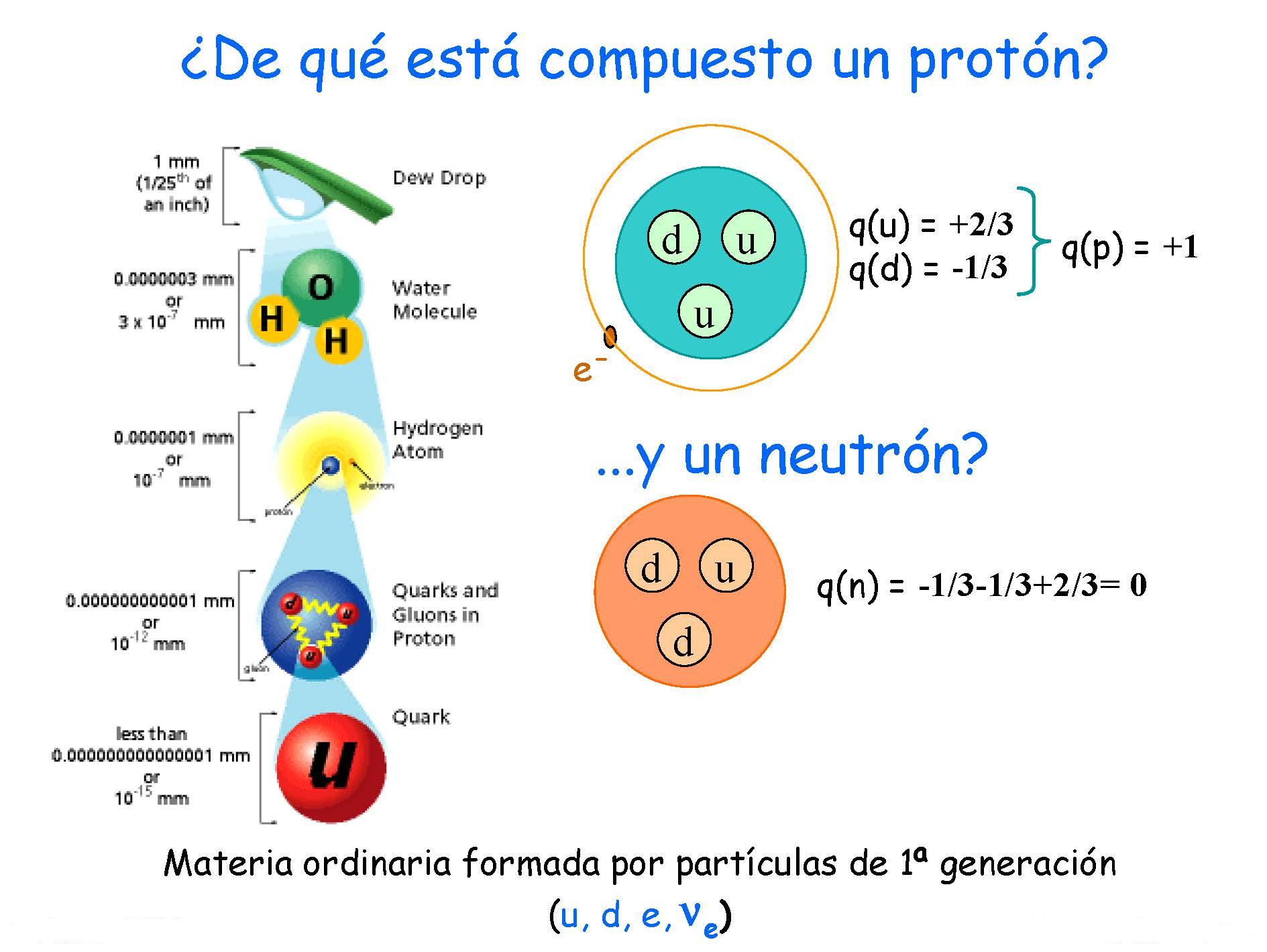

Es curioso, cuando hablamos del átomo de una manera general y cotidiana, la mayoría de las veces no pensamos en lo que en realidad es. Por ejemplo, el núcleo del átomo supone sólo el 1/100.000 de dicho átomo. Sin embargo, en ese diminuto núcleo, se encuentra todo lo importante del conjunto atómico, ya que, el resto (99%), simplemente son espacios vacíos estructurado por el electromagnetismo.

Así, en ese pequeñi núcleo, que etá formado por protones y neutrones, se encuentra la masa del átomo. Claro que, habría que explicar que los protones y neutrones no son partículas elementales, sino que están conformadas, de manera compleja, por otras partículas más pequeñas que se llaman Quarks. De hecho, un protón está hecho por un triplete de Quarks, 2 quarks up y 1 quark dowm, mientras que un neutrón, está hecho por 2 quarks dowm y 1 quark up.

Pero no termina ahí la complejidad del núcleo atómico, sino que, hay que explicar que estos Quarks que gforman protones y neutrones, están ahí dentro de ellos confinados por la fuarza nuclear guerte, de tal manera que, si están juntos (libertad asintótica), no tienen problema alguna para moverse. Sin embargo, si tratán de separarse, se ven literalmente sujetos por una especie de pegamento constituodo por 8 Gluones, las partículas intermediarias de la fuerza nuclerar fuerte, estás partículas, al contrario de los protones y neutrones que son Fermiones, pertenecen a la familia de los Bosones, como el Fotón que, transmite la fuerza electromagnética, las partículas W+, W- y Zº que son las intermediarias en la Fuerza electrodébil, y, finalmente, otro Bosón es el Gravitón (aún no encontrado) que, intermedia en la Fuerza de Gravedad.

Los protones y neutrones, al conformar el núcleo atómico, son conocidos también como nucleones. En realidad, ambas partículas, protones y neutrones, son de la familia de los Hadrones y, pertenecen a la rama de los Bariones, es decir, las partículas que conforman la materia luminosa, la que emite radiación y forman los mundos, las estrellas y galaxias y, también, a nosotros los seres vivos.

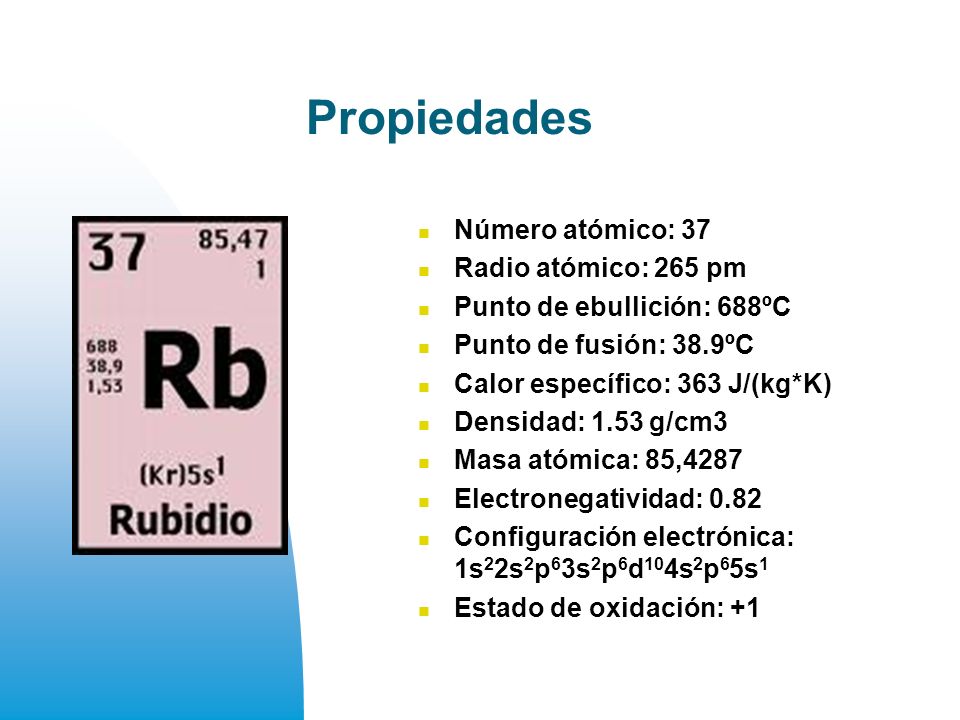

“Ha supuesto un gran avance en el campo de la Física. Científicos de la Universidad de Otago, en Nueva Zelanda, desarrollaron una técnica para aislar sistemáticamente y capturar un átomo en rápido movimiento neutral, y también han conseguido en primicia ver y fotografiar este átomo por primera vez, lo que han denominado la universidad como el “sueño de los científicos.

La captura del átomo de rubidio 85 es el resultado de un proyecto de investigación de tres años de duración financiado por la Fundación para la Investigación, Ciencia y Tecnología, y ha suscitado el interés en la comunidad científica internacional por las nuevas investigaciones que podrán surgir de este hito.”

¡Hay tantos mundos dentro de este nuestro! Sí, dentro de cada Mente existe un mundo… ¡Tan diferentes!

De lo Grande a lo Pequeño

El 6 de Agosto de 1945 el mundo recibió estupefacto desde Hiroshima la noticia de que el hombre había desembarcado en el oscuro continente del átomo. Sus misterios habrían de obsesionar al siglo XX. Sin embargo, el “átomo” había sido más de dos mil años una de las más antiguas preocupaciones de los filósofos naturales. La palabra griega átomo significa unidad mínima de materia, que se suponía era indestructible. el átomo era un término de uso corriente, una amenaza y una promesa sin precedentes.

Leucipo (c. 450-370 a.C.), filósofo griego. Es reconocido como creador de la teoría atómica de la materia, más tarde desarrollada por su discípulo, el filósofo griego Demócrito. Según teoría, toda materia está formada por partículas idénticas e indivisibles llamadas átomos.

Leucipo fue un griego legendario. Sin embargo, fue su discípulo Demócrito el que dio al atomismo su clásica como filosofía: “la parte invisible e indivisible de la materia”, se divertía tanto con la locura de los hombres que era conocido como “el filósofo risueño” o “el filósofo que ríe”. No obstante fue uno de los primeros en oponerse a la idea de la decadencia de la Humanidad a partir de una Edad de Oro mítica, y predicó sobre una base de progreso. Si todo el Universo estaba compuesto solamente por átomos y vacío, no sólo no era infinitamente complejo, sino que, de un modo u otro, era inteligible, y seguramente el poder del hombre no tenía límite.

Lo cierto es que, nuestro futuro es un libro en blanco y, lo que se pueda leer en él, aún no está escrito … ¿dependerá de nosotros?

Lucrecio (c. 95 a.C. -c. 55 a.C.) perpetuó en De rerum natura (De la naturaleza de lascosas) uno de los más importantes poemas latinos, al atomismo antiguo. Con la intención de liberar al pueblo del temor a los dioses, el poeta demostró que el mundo entero estaba constituido por vacío y átomos, los cuales se movían según sus leyes propias; que el alma moría con el cuerpo y que por consiguiente no había razón temer a la muerte o a los poderes sobrenaturales.

Lucrecio decía que comprender la Naturaleza era el único modo de hallar la paz de espíritu, y, como era de esperar, los padres de la Iglesia que pregonaban la vida eterna, atacaron sin piedad a Lucrecio y fue ignorado y olvidado durante toda la Edad Media que, como sabéis, fue la culpable de la paralización del saber de la Humanidad. Sin embargo, Lucrecio fue, una de las figuras más influyentes del Renacimiento.

Así pues, en un principio el atomismo vino al mundo sistema filosófico. Del mismo modo que la simetría pitagórica había proporcionado un marco a Copérnico, la geometría había seducido a Kepler y el círculo perfecto aristotélico hechizo a Harvey, así los “indestructibles” átomos de los filósofos atrajeron a los físicos y a los químicos. Francis Bacon observó que “la teoría de Demócrito referida a los átomos es, si no cierta, al menos aplicable con excelentes resultados al análisis de la Naturaleza”.

Descartes

Descartes (1596-1650) inventó su propia noción de partículas infinitamente pequeñas que se movían en un medio que llamó éter. Otro filósofo francés, Pierre Gassendi (1592-1655), pareció confirmar la teoría de Demócrito y presentó otra versión más del atomismo, que Robert Boyle (1627-1691) adaptó a la química demostrando que los “elementos clásicos -tierra, aire, fuego y agua- no eran en absoluto elementales.

Las proféticas intuiciones de un matemático jesuita, R.G. Boscovich (1711-1787) trazaron los caminos una nueva ciencia, la física atómica. Su atrevido concepto de “los puntos centrales” abandonaba la antigua idea de una variedad de átomos sólidos diferentes. Las partículas fundamentales de la materia, sugería Boscovich, eran todas idénticas, y las relaciones espaciales alrededor de esos puntos centrales constituían la materia… Boscovich que había llegado a estas conclusiones a partir de sus conocimientos de matemáticas y astronomía, anunció la íntima conexión entre la estructura del átomo y la del Universo, entre lo infinitesimal y lo infinito.

John Dalton

El camino experimental hacia el átomo fue trazado por John Dalton (1766-1844). Era este un científico aficionado cuáquero y autodidacta que recogió un sugestivo concepto de Lavoisier (1743-1794). Considerado una de los fundadores de la química moderna, Lavoisier, cuando definió un “elemento” como una sustancia que no ser descompuesta en otras sustancias por medio de ningún método conocido, hizo del átomo un útil concepto de laboratorio y trajo la teoría atómica a la realidad.

Dalton había nacido en el seno de una familia de tejedores de Cumberland, localidad inglesa situada en la región de los lagos, y estuvo marcada toda su vida por su origen humilde. A los doce ya se encontraba a cargo de la escuela cuáquera de su pueblo. Después, comenzó a ejercer la enseñanza en la vecina Kendal, y en la biblioteca del colegio encontró ejemplares de los Principia de Newton, de las Obras de la Historia Natural de Buffón, así un telescopio reflectante de unos setenta centímetros y un microscopio doble. Dalton recibió allí la influencia de John Gough, un notable filósofo natural ciego.

Dalton escribió a un amigo, “entiende muy bien todas las diferentes ramas de las matemáticas…Conoce por el tacto, el sabor y el olor de casi todas las plantas que crecen a casi treinta kilómetros a la redonda”. También Wordsworth elogia a Gough en su Excursión. Dalton recibió del filósofo ciego una educación básica en latín, griego y francés, y fue introducido en las matemáticas, la astronomía y todas las ciencias “de la observación”. Siguiendo el ejemplo de Gough, Dalton comenzó a llevar un meteorológico diario, que continuó hasta el día de su muerte.

Cuando los “disidentes” fundaron su colegio propio en Manchester, Dalton fue designado profesor de matemáticas y de filosofía natural. Halló una audiencia muy receptiva para sus experimentos en la Sociedad Literaria y Filosófica de Manchester, y presentó allí sus Hechos extraordinarios concernientes a la visión de los colores, que probablemente fue el primer sistemático sobre la imposibilidad de percibir los colores, o daltonismo, enfermedad que padecían tanto John Dalton como su hermano Jonathan. “He errado tantas veces el camino por aceptar los resultados de otros que he decidido escribir lo menos posible y solamente lo que pueda afirmar por mi propia experiencia”.

Al final del túnel oscuro de la ignorancia, siempre nos aguarda la luz del saber pero, hay que recorrer la distancia alcanzar el resplandor el saber.

Dalton observó la aurora boreal, sugirió el probable origen de los vientos alisios, las causas de la formación de nubes y de la lluvia y, sin habérselo propuesto, introdujo mejoras en los pluviómetros, los barómetros, los termómetros y los higrómetros. Su interés por la atmósfera le proporcionó una visión de la química que lo condujo al átomo.

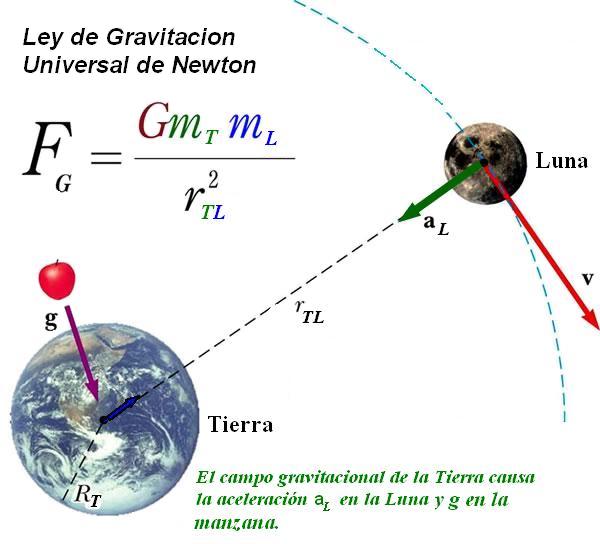

Newton había confiado en que los cuerpos visibles más pequeños siguieran las leyes cuantitativas que gobernaban los cuerpos celestes de mayor tamaño. La química sería una recapitulación de la Astronomía. , ¿Cómo podía el hombre observar y medir los movimientos y la atracción mutua de estas partículas invisibles? En los Principios Newton había conjeturado que los fenómenos de la Naturaleza no descritos en este libro podrían “depender todos de ciertas fuerzas por las cuales las partículas de los cuerpos, debido a causas hasta desconocidas, se impulsan mutuamente unas hacia otras y se unen formando figuras regulares, o bien se repelen y se apartan unas de otras.”

Dalton se lanzó a la búsqueda de “estas partículas primitivas” tratando de encontrar algún medio experimental que le permitiera incluirlas en un sistema cuantitativo. Puesto que los gases eran la de materia más fluida, más móvil, Dalton centró su estudio en la atmósfera, la mezcla de gases que componen el aire, el cual constituyó el punto de partida de toda su reflexión sobre los átomos.

“¿Por qué el agua no admite un volumen similar de gas?, preguntó Dalton a sus colegas de la Sociedad Literaria y Filosófica de Manchester en 1803. “Estoy casi seguro de que la circunstancia depende del peso y el número de las partículas últimas de los diversos gases; aquellos cuyas partículas son más ligeras y simples se absorben con más dificultad, y los demás con mayor facilidad, según vayan aumentando en peso y en complejidad.”

Teoría cinética de los Gases: La termodinámica se ocupa solo de variables microscópicas, como la presión, la temperatura y el volumen. Sus leyes básicas, expresadas en términos de dichas cantidades, no se ocupan para nada de que la materia formada por átomos. Sin embargo, la mecánica estadística, que estudia las mismas áreas de la ciencia que la termodinámica, presupone la existencia de los átomos. Sus leyes básicas son las leyes de la mecánica, las que se aplican en los átomos que forman el sistema.

Dalton había descubierto que, contrariamente a la idea dominante, el aire no era un vasto disolvente químico único sino una mezcla de gases, uno de los cuales conservaban su identidad y actuaba de manera independiente. El producto de sus experimentos fue recogido en la trascendental TABLE: Of the Relative Weights of Ultimate Particles of Gaseous and Other Bodies (“Tabla de los pesos relativos de las partículas últimas de los cuerpos gaseosos y de otros cuerpos”).

En las reacciones químicas, los átomos no se crean ni se destruyen, solamente cambian de distribución.

Mucho hemos avanzado desde aquellos primeros elementos que, según Empédocles, lo conformaban todo mezclados en la debida proporción. Él decía que la tierra, el agua, el aire y el fuego eran todos los elementos del mundo físico y que todo estaba hecho de a partir de ellos. No hay que quitarle mérito a la idea germinal que nos trajo muy lejos, hasta la Tabla periódica con sus 92 elementos naturales.

Finalmente trazará un programa de investigación que él mismo resume así: Es objetivo principal de este trabajo mostrar las ventajas que reporta la determinación precisa de los pesos relativos de las partículas últimas, tanto de los cuerpos simples como de los compuestos, determinar el de partículas simples elementales que constituyen una partícula compuesta y el número mínimo de partículas compuestas que entran en la formación de una nueva partícula compuesta.

Tomando al Hidrógeno como número uno, Dalton detalló en esta obra sustancias. Describió las invisibles “partículas últimas” como diminutas bolitas sólidas, similares a balas pero mucho más pequeñas, y propuso que se les aplicaran las leyes newtonianas de las fuerzas de atracción de la materia. Dalton se proponía lograr “una nueva perspectiva de los primeros principios de los elementos de los cuerpos y sus combinaciones”, que “sin duda…con el tiempo, producirá importantísimos cambios en el sistema de la química y la reducirá a una ciencia de gran simplicidad, inteligible hasta para los intelectos menos dotados”. Cuando Dalton mostró una “partícula de aire que descansa sobre cuatro partículas de agua como una ordenada pila de metralla” donde cada pequeño globo está en contacto con sus vecinos, proporcionó el modelo de esferas y radio de la química del siglo siguiente.

Dalton inventó unas “señales arbitrarias como signos elegidos para representar los diversos elementos químicos o partículas últimas”, organizadas en una tabla de pesos atómicos que utilizaba en sus populares conferencias. Naturalmente, Dalton no fue el primero en emplear una escritura abreviada para representar las sustancias químicas, pues los alquimistas también tenían su código. Pero él fue probablemente el primero que utilizó este tipo de simbolismo en un sistema cuantitativo de “partículas últimas”. Dalton tomó como unidad el átomo de Hidrógeno, y a partir de él calculó el peso de las moléculas como la suma de los pesos de los átomos que la componían, creando así una sintaxis moderna para la química. Las abreviaturas actuales que utilizan la primera letra del latino (por ejemplo H2O) fueron ideadas por el químico sueco Berzelius (1779-1848).

Habiendo cumplido más de 350 años, la Institución que presidiera Newton “Real Sociedad de Londres para el Avance de la Ciencia Natural” más conocida como “Royal Society”, sigue en plena y ostenta el respetado título de Sociedad más Antigua. ¡Si nos pudiera contar todo lo que allí se vivió”.

La teoría del átomo de Dalton no fue recibida en un principio con entusiasmo. El gran sir Humphry Davy desestimó inmediatamente sus ideas tachándolas de “más ingeniosas que importantes”. Pero las nociones de Dalton, desarrolladas en A New System of Chemical Philosophy (1808), eran tan convincentes que en 1826 le fue concedida la medalla real. Como Dalton no olvidó nunca su origen plebeyo, permaneció siempre apartado de la Royal Society de Londres, pero fue elegido miembro, sin su consentimiento, en 1822. Receloso del tono aristocrático y poco profesional de la Sociedad, él se encontraba más a gusto en Manchester, donde realizó la mayor parte de su obra, colaboró con Charles Babage y contribuyó a fundar la Asociación Británica el Progreso de la Ciencia, cuyo objetivo era llevar la ciencia hasta el pueblo. Los newtonianos partidarios de la ortodoxia religiosa no creían que Dios hubiera hecho necesariamente sus invisibles “partículas últimas” invariables e indestructibles. Compartían con Isaac Newton la sospecha de que Dios había utilizado su poder “ variar las leyes de la Naturaleza y crear mundos diversos en distintos lugares del Universo”.

Las verdaderas investigaciones sobre el átomo comenzaron en el siglo XVII, cuando los experimentos de Robert Boyle dieron impulso a la investigación de las intimidades de la materia. En 1803, el científico inglés John Dalton propuso por primera vez, la teoría de que cada elemento tiene un tipo particular de átomo y que cualquier cantidad de un mismo elemento está formada por átomos idénticos. Lo que distingue a un elemento de otro es la naturaleza de sus átomos.

El átomo indestructible de Dalton se convirtió en el fundamento de una naciente ciencia de la química, proporcionando los principios elementales, las leyes de composición constante y de proporciones múltiples y la combinación de elementos químicos en razón de su peso atómico. “El análisis y la síntesis química no van más allá de la separación de unas partículas de otras y su reunión”, insistió Dalton. “La creación o la destrucción de la materia no está al alcance de ningún agente químico. Sería lo mismo tratar de introducir un planeta en el Sistema Solar o aniquilar uno de los ya existentes que crear o destruir una partícula de Hidrógeno.” Dalton continuó usando las leyes de los cuerpos celestes visibles como indicios del Universo infinitesimal. El profético sir Humphry Davy, sin embargo, no se convencía, “no hay razón para suponer que ha sido descubierto un principio real indestructible”, afirmó escéptico.

Gay-Lussac

Dalton no era más que un Colón. Los Vespucios aún no habían llegado, y cuando lo hicieron trajeron consigo algunas sorpresas muy agradables y conmociones aterradoras. Entretanto, y durante medio siglo, el sólido e indestructible átomo de Dalton fue muy útil para los químicos, y dio lugar a prácticas elaboraciones. Un científico francés, Gay-Lussac, demostró que cuando los átomos se combinaban no lo hacían necesariamente de dos en dos, como había indicado Dalton, sino que podían agruparse en asociaciones distintas de unidades enteras. Un químico italiano, Avogadro (1776-1856), demostró que volúmenes iguales de gases a la misma temperatura y presión contenían el mismo de moléculas. Un químico ruso Dmitri Mendeléiev, nos trajo la Tabla Periódica de los elementos, propuso una sugestiva “Ley periódica” de los elementos. Si los elementos estaban dispuestos en orden según su creciente peso atómico entonces grupos de elementos de características similares se repetirían periódicamente.

Dmitri Mendeléiev

Más tarde se trasladó a Alemania, ampliar estudios en Heidelberg, donde conoció a los químicos más destacados de la época. A su regreso a Rusia fue nombrado profesor del Instituto Tecnológico de San Petersburgo (1864) y profesor de la universidad (1867), cargo que se vería forzado a abandonar en 1890 por motivos políticos, si bien se le concedió la dirección de la Oficina de Pesos y Medidas (1893).

Entre sus trabajos destacan los estudios acerca de la expansión térmica de los líquidos, el descubrimiento del punto crítico, el estudio de las desviaciones de los gases reales respecto de lo enunciado en la ley de Boyle-Mariotte y una formulación más exacta de la ecuación de . En el campo práctico destacan sus grandes contribuciones a las industrias de la sosa y el petróleo de Rusia.

Todos recordamos cuán difícil era memorizar la tabla periódica en el colegio. Más todavía que memorizar la tabla de multiplicar. Porque, además, la tabla periódica estaba compuesta por nombres y valores extraños, poco útiles la vida diaria. Sin embargo, algunos profesores de vocación, se valían de mil triquiñuelas para que, los niños la pudieran memorizar.

Con todo, su principal logro investigador fue el establecimiento del llamado sistema periódico de los elementos químicos, o tabla periódica, gracias al cual culminó una clasificación definitiva de los citados elementos (1869) y abrió el paso a los grandes avances experimentados por la química en el siglo XX.

Aunque su sistema de clasificación no era el primero que se basaba en propiedades de los elementos químicos, como su valencia, sí incorporaba notables mejoras, como la combinación de los pesos atómicos y las semejanzas entre elementos, o el hecho de reservar espacios en blanco correspondientes a elementos aún no descubiertos como el eka-aluminio o galio (descubierto por Boisbaudran, en 1875), el eka-boro o escandio (Nilson, 1879) y el eka-silicio o germanio (Winkler, 1886).

Mendeléiev demostró, en controversia con químicos de la talla de Chandcourtois, Newlands y L. Meyer, que las propiedades de los elementos químicos son funciones periódicas de sus pesos atómicos. Dio a conocer una primera versión de dicha clasificación en marzo de 1869 y publicó la que sería la definitiva a comienzos de 1871. Mediante la clasificación de los elementos químicos conocidos en su época en función de sus pesos atómicos crecientes, consiguió que aquellos elementos de comportamiento químico similar estuvieran situados en una misma columna vertical, formando un grupo. Además, en sistema periódico hay menos de diez elementos que ocupan una misma línea horizontal de la tabla. Tal como se evidenciaría más adelante, su tabla se basaba, en efecto, en las propiedades más profundas de la estructura atómica de la materia, ya que las propiedades químicas de los elementos vienen determinadas por los electrones de sus capas externas.

Tabla de elementos de Dalton, siglo XIX

Convencido de la validez de su clasificación, y a fin de lograr que algunos elementos encontrasen acomodo adecuado en la tabla, Mendeléiev «alteró» el valor de su peso atómico considerado correcto hasta entonces, modificaciones que la experimentación confirmó con posterioridad. A tenor de mismo patrón, predijo la existencia de una serie de elementos, desconocidos en su época, a los que asignó lugares concretos en la tabla.

Pocos después (1894), con el descubrimiento de ciertos gases nobles (neón, criptón, etc.) en la atmósfera, efectuado por el químico británico William Ramsay (1852-1816), la tabla de Mendeléiev experimentó la última ampliación en una columna, tras lo cual quedó definitivamente establecida.

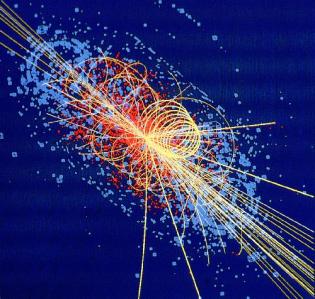

La sustancia más caliente de todas se creó al colisionar átomos de oro entre sí a velocidades cercanas a las de la luz. Es llamada “sopa de quarks y gluones” y alcanza unos humildes 4 trillones grados centígrados, lo que equivale a una temperatura de 250 mil veces más caliente que el interior del sol.

La disolución del indestructible átomo sólido provendría de dos fuentes, una conocida y la otra bastante nueva: el estudio de la luz y el descubrimiento de la electricidad. El propio Einstein describió este histórico movimiento como la decadencia de una perspectiva “mecánica” y el nacimiento de una perspectiva “de campo” del mundo físico, que le ayudó a encontrar su propio camino la relatividad, explicaciones y misterios nuevos.

Albert Einstein tenía en la pared de su estudio un retrato de Michael Faraday (1791-1867), y ningún otro hubiera podido ser más apropiado, pues Faraday fue el pionero y el profeta de la gran revisión que hizo posible la obra de Einstein. El mundo ya no sería un escenario newtoniano de “fuerzas a distancias”, objetos mutuamente atraídos por la fuerza de la Gravedad inversamente proporcional al cuadrado de la distancia que hay entre ellos. El mundo material se convertiría en una tentadora escena de sutiles y omnipresentes “campos de fuerzas”. idea era tan radical como la revolución newtoniana, e incluso más difícil de comprender para los legos en la materia

emilio silvera

Ago

5

Los Quarks invisibles

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

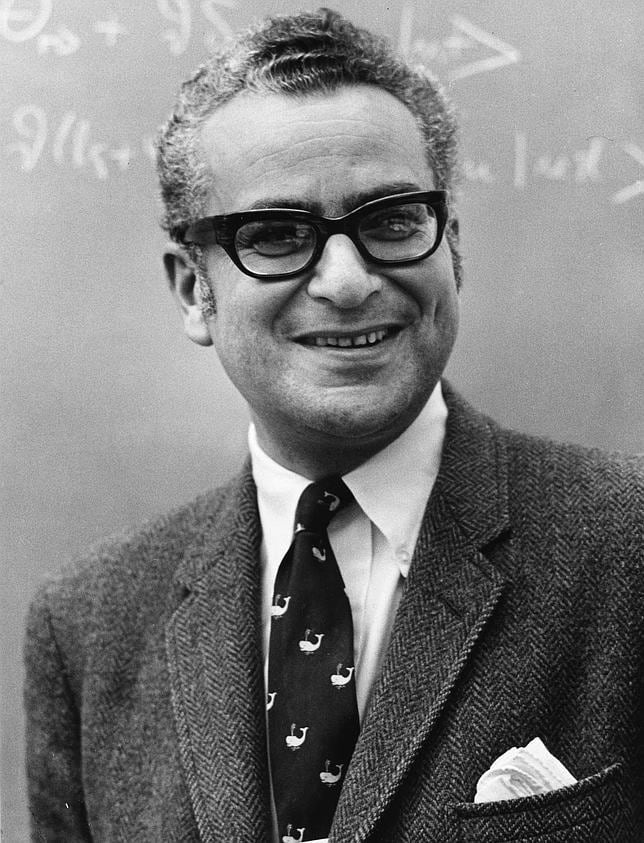

Una vez que se ha puesto orden entre las numerosas especies de partículas, se puede reconocer una pauta. Igual que Dimitri Ivanovich Mendeleev descubrió el sistema periódico de los elementos químicos en 1869, así también se hizo visible un sistema similar para las partículas. Esta pauta la encontraron independientemente el americano Murray Gell-Mann y el israelí Yuval Ne’eman. Ocho especies de mesones, todos con el mismo espín, u ocho especies de bariones, con el mismo espín, se podían reagrupar perfectamente en grupos que llamaremos multipletes. El esquema matemático correspondiente se llama SU(3). Grupletes de ocho elementos forman un octete “fundamental”. Por esta razón Gell-Mann llamó a esta teoría el “óctuplo camino”. Lo tomó prestado del budismo de acuerdo con el cual el camino hacia el nirvana es el camino óctuplo.

Pero las matemáticas SU(3) también admiten multipletes de diez miembros. Cuando se propuso este esquema se conocían nueve bariones con espín 3/2. Los esquemas SU(3) se obtienen al representar dos propiedades fundamentales de las partículas, la extrañeza S frente al isoespín I₃ , en una gráfica.

Imagen de trazas en la cámara de burbujas del primer evento observado incluyendo bariones Ω, en el Laboratorio Nacional Brookhaven.

De esta manera, Gell-Mann predijo un décimo barión, el omega-menos (Ω¯), y pudo estimar con bastante precisión su masa porque las masas de los otros nueve bariones variaban de una forma sistemática en el gráfico (también consiguió entender que las variaciones de la masa eran una consecuencia de una interacción simple). Sin embargo, estaba claro que la Ω¯, con una extrañeza S = -3, no tenía ninguna partícula en la que desintegrarse que no estuviera prohibida por las leyes de conservación de la interacción fuerte. De modo que, la Ω¯ sólo podía ser de tan sólo 10¯²³ segundos como los demás miembros del multiplete, sino que tenía que ser del orden de 10¯¹⁰ segundos. Consecuentemente, esta partícula debería viajar varios centímetros antes de desintegrarse y esto la haría fácilmente detectable. La Ω¯ fue encontrada en 1964 con exactamente las mismas propiedades que había predicho Gell-Mann.

Murray Gell-Mann, nacido en Nueva York en el año 1929, recibió el premio Nobel de Física en 1969 por su aporte en la teoría de las partículas atómicas.

Murray Gell-Mann, nacido en Nueva York en el año 1929, recibió el premio Nobel de Física en 1969 por su aporte en la teoría de las partículas atómicas.

Se identificaron estructuras multipletes para la mayoría de los demás bariones y mesones y Gell-Mann también consiguió explicarlas. Sugirió que los mesones, igual que los bariones, debían estar formados por elementos constitutivos “más fundamentales aún”. Gell-Mann trabajaba en el Instituto de Tecnología de California en Pasadena (CalTech), donde conversaba a menudo con Richard Feynman. Eran ambos físicos famosos pero con personalidades muy diferentes. Gell-Mann, por ejemplo, es conocido como un entusiasta observador de Pájaros, familiarizado con las artes y la literatura y orgulloso de su conocimiento de lenguas extranjeras. Feynman fue un hombre hecho a sí mismo, un analista riguroso que se reía de cualquier cosa que le recordara la autoridad establecida. Hay una anécdota que parece no ser cierta de hecho, pero que me parece tan buena que no puedo evitar el contarla; podía haber sucedido de esta forma. Gell-Mann le dijo a Feynman que tenía un problema, que estaba sugiriendo un nuevo tipo de ladrillos constitutivos de la materia y que no sabía qué nombre darles. Indudablemente debía haber de haber pensado en utilizar terminología latina o griega, como ha sido costumbre siempre en la nomenclatura científica. “Absurdo”, le dijo Feynman; “tú estás hablando de cosas en las que nunc ase había pensado antes. Todas esas preciosas pero anticuadas palabras están fuera de lugar. ¿Por qué no los llamas simplemente “shrumpfs”, “quacks” o algo así?”.

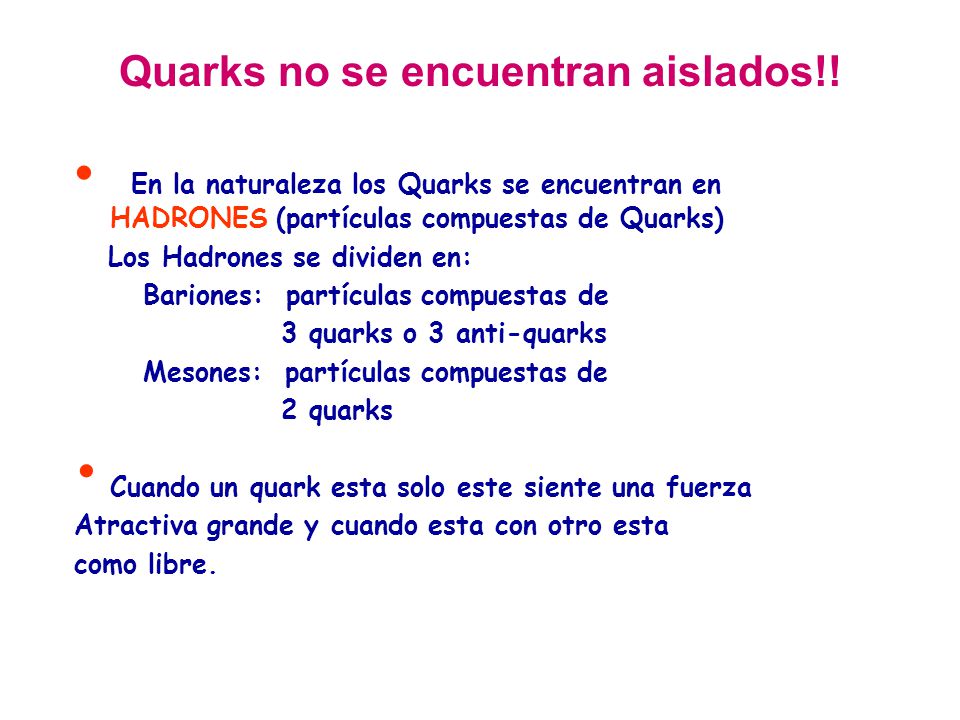

Cuando algún tiempo después le pregunté a Gell-Mann, éste negó que tal conversación hubiera tenido lugar. Pero la palabra elegida fue quark, y la explicación de Gell-Mann fue que la palabra venía de una frase de Fynnegan’s Wake de James Joyce; “¡Tres quarks para Muster Mark!”. Y, efectivamente así es. A esas partículas les gusta estar las tres juntas. Todos los bariones están formados por tres quarks, mientras que los mesones están formados por un quark y un antiquark.

Los propios quarks forman un grupo SU(3) aún más sencillo. Los llamaremos “arriba (u)”, “abajo” (d), y “extraño” (s). Las partículas “ordinarias” contienen solamente quarks u y d. Los hadrones “extraños” contienen uno o más quarks s (o antiquarks ŝ).

La composición de quarks de espín 3/2 se puede ver en la tabla 5. La razón por la que los bariones de espín ½ sólo forman un octete es más difícil de explicar. Está relacionada con el hecho de que en estos estados, al menos dos de los quarks tienen que ser diferentes unos de otros.

Realmente, la idea de que los hadrones estuvieran formados por ladrillos fundamentales sencillos había sido también sugerida por otros. George Zweig, también en el CalTech, en Pasadena, había tenido la misma idea. Él había llamado a los bloques constitutivos “ases!, pero es la palabra “quark” la que ha prevalecido. La razón por la que algunos nombres científicos tienen más éxito que otros es a veces difícil de comprender.

Pero en esta teoría había algunos aspectos raros. Aparentemente, los quarks (o ases) siempre existen en parejas o tríos y nunca se han visto solos. Los experimentadores habían intentado numerosas veces detectar un quark aislado en aparatos especialmente diseñados para ello, pero ninguno había tenido éxito.

Los quarks –si se pudieran aislar- tendrían propiedades incluso más extrañas. Por ejemplo, ¿cuáles serían sus cargas eléctricas? Es razonable suponer que tanto los quarks u como los quarks s y d deban tener siempre la misma carga. La comparación de la tabla 5 con la tabla 2 sugiere claramente que los quarks d y s tienen carga eléctrica -1/3 y el quark u tiene carga +2/3. Pero nunca se han observado partículas que no tengan carga múltiplo de la del electrón o de la del protón. Si tales partículas existieran, sería posible detectarlas experimentalmente. Que esto haya sido imposible debe significar que las fuerzas que las mantienen unidas dentro del hadrón son necesariamente increíblemente eficientes.

Aunque con la llegada de los quarks se ha clarificado algo más la flora y la fauna de las partículas subatómicas, todavía forman un conjunto muy raro, aún cuando solamente unas pocas aparezcan en grandes cantidades en el universo (protones, neutrones, electrones y fotones). Como dijo una vez Sybren S. de Groot cuando estudiaba neutrinos, uno realmente se enamora de ellos. Mis estudiantes y yo amábamos esas partículas cuyo comportamiento era un gran misterio. Los leptones, por ser casi puntuales, son los más sencillos, y por tener espín se ven afectados por la interacción que actúa sobre ellos de forma muy complicada, pero la interacción débil estaba bastante bien documentada por entonces.

Los hadrones son mucho más misteriosos. Los procesos de choque entre ellos eran demasiado complicados para una teoría respetable. Si uno se los imagina como pequeñas esferas hachas de alguna clase de material, aún quedaba el problema de entender los quarks y encontrar la razón por la que se siguen resistiendo a los intentos de los experimentadores para aislarlos.

Si queréis saber más sobre el tema, os recomiendo leer el libro “Partículas” de Gerard ´t Hooft

Ago

4

Materia de sombra, Axiones, ¿WIMPs en el Sol? ¿Y la vida?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

Es curioso como a veces, la realidad de los hechos observados, vienen a derribar esas barreras que muchos ponen en sus mentes negar lo evidente. Por ejemplo: Los extraordinarios resultados de la sonda Kepler, que en su primer año de misión ha encontrado ya 1.235 candidatos a planetas, 54 de ellos en la zona habitable de sus estrellas, ha permitido a los investigadores extrapolar el número total de mundos que podría haber sólo en la Vía Láctea, nuestra galaxia. Y ese número ronda los 50.000 millones. De los cuales, además, unos 500 millones estarían a la distancia adecuada de sus soles para permitir la existencia de agua en estado líquido, una condición necesaria para la vida.

Planetas parecidos a la Tierra, como arriba nos dicen, hay miles de millones y sólo cabe esperar que estén situados en los lugares adecuados que la vida tenga la oportunidad de surgir acogida por el ecosistema ideal del agua líquida, una atmósfera acogedora y húmeda, temperatura ideal media y otros parámetros que la vida reqiere para su existencia.

Un equipo de astrónomos internacionales pertenecientes al Observatorio Europeo Austral (ESO), el más importante del mundo, investiga la formación de un posible sistema planetario a partir de discos de material que rodea a una estrella joven. Según un comunicado difundido hoy por el centro astronómico que se levanta en la región norteña de Antofagasta, a través del “Very Large Telescope”(VLT), los científicos han estudiado la materia que rodea a una estrella joven.

Según los astrónomos, los planetas se forman a partir de discos de material que rodean a las estrellas, pero la transición discos de polvo hasta sistemas planetarios es rápida y muy pocos son identificados en esta fase. Uno de los objetos estudiados por los astrónomos de ESO, es la estrella T Chamaleontis (T-Cha), ubicada en la pequeña constelación de Chamaleón, la cual es comparable al sol pero en sus etapas iniciales.

Dicha estrella se encuentra a 330 años luz de la Tierra y tiene 7 millones de años de edad, lo que se considera joven para una estrella. “Estudios anteriores han demostrado que T Cha es un excelente objetivo para estudiar cómo se forman los sistemas planetarios”, señala el astrónomo Johan Olofsson, del Max Planck Institute of Astronomy de Alemania.

Algunas veces hablando de los extensos y complejos temas que subyacen en la Astronomía, lo mismo hablamos de “materia de sombre” que de “supercuerdas” y, se ha llegado a decir que existe otro universo de materia de sonbra que existe en paralelo al nuestro. Los dos universos se separaron la Gravedad se congeló sepapándose de las otras fuerzas. Las partículas de sombra interaccionan con nosotros sólo a través de la fuerza de la gravedad, lo cual las convierte en candidatas ideales para la tan traida y llevada “materia oscura”.

Llegamos a los Axiones.

El actual de la cuestión es que los cosmólogos creen saber que hay una gran cantidad de materia oscura en el Universo y, han conseguido eliminar la candidatura de cualquier tipo de partícula ordinaria que conocemos. En tales circunstancias no se llegar a otra conclusión que la materia oscura debe de existir en alguna forma que todavía no hemos visto y cuyas propiedades ignoramos totalmente. Sin embargo, se atreven a decir que, la Gravedad, es el efecto que se produce cuando la “materia oscura” pierde consistencia… , o algo así. ¡Cómo son!

A los teóricos nada les gusta más que aquella situación en la cual puedan dejar volar libremente la imaginación sin miedo a que nada tan brusco un experimento u observación acabe con su juego. En cualquier caso, han producido sugerencias extraordinarias acerca de lo que podría ser la “materia oscura” del universo.

Lo que hay en el Universo…no siempre lo podemos comprender.

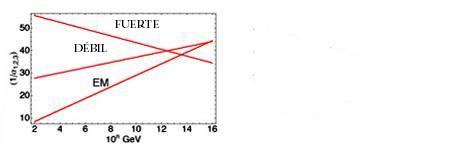

Otro de los WIMPs favoritos se llama axión. el fotino y sus compañeros, el axión fue sugerido por consideraciones de simetría. Sin embargo, a diferencia de las partículas, sale de las Grandes Teorías Unificadas, que describen el Universo en el segundo 10ˉ³5, más que de las teorías totalmente unificadas que operan en el tiempo de Planck.

mucho tiempo han sabido los físicos que toda reacción entre partículas elementales obedece a una simetría que llamamos CPT. Esto significa que si miramos la partícula de una reacción, y luego vemos la misma reacción cuando (1) la miramos en un espejo, (2) sustituimos todas las partículas por antipartículas y (3) hacemos pasar la película hacia atrás, los resultados serán idénticos. En este esquema la P significa paridad (el espejo), la C significa conjugación de carga (poner las antipartículas) y T la reversa del tiempo (pasar la película al revés).

Se pensaba que el mundo era simétrico respecto a CPT porque, al menos al nivel de las partículas elementales, era simétrico respecto a C, P y T independientemente. Ha resultado que no es éste el caso. El mundo visto en un espejo se desvía un tanto al mundo visto directamente, y lo mismo sucede al mundo visto cuando la película pasa al revés. Lo que sucede es que las desviaciones entre el mundo real y el inverso en cada uno de estos casos se cancelan una a la otra cuando miramos las tres combinadas.

Aunque esto es verdad, es verdad que el mundo es casi simétrico respecto a CP actuando solos y a T actuando solo; es decir, que el mundo es casi el mismo si lo miran en un espejo y sustituyen las partículas por antipartículas que si lo miran directamente. Este “casi” es lo que preocupa a los físicos. ¿Por qué son las cosas casi perfectas, pero les falta algo?

La respuesta a esta cuestión parece que estar en la posible existencia de esa otra partícula apellidada axión. Se supone que el Axión es muy ligero (menos de una millonésima parte de la masa del electrón) e interacciona sólo débilmente con otra materia. Es la pequeña masa y la interacción débil lo que explica el “casi” que preocupa a los teóricos.

nos asomamos a la Teoría de cuerdas, entramos en un “mundo” lleno de sombras en los que podemos ver brillar, a lo lejos, un resplandor cegador. Todos los físicos coinciden en el hecho de que es una teoría muy prometedora y de la que parece se podrán obtener buenos rendimientos en el futuro pero, de momento, es imposible verificarla.

El misterio de las funciones modulares podría ser explicado por quien ya no existe, Srinivasa Ramanujan, el hombre más extraño del mundo de los matemáticos. Igual que Riemann, murió antes de cumplir cuarenta años, y como Riemann antes que él, trabajó en total en su universo particular de números y fue capaz de reinventar por sí mismo lo más valioso de cien años de matemáticas occidentales que, al estar aislado del mundo en las corrientes principales de los matemáticos, le eran totalmente desconocidos, así que los buscó sin conocerlos. Perdió muchos años de su vida en redescubrir matemáticas conocidas.

Dispersas oscuras ecuaciones en sus cuadernos están estas funciones modulares, que figuran entre las más extrañas jamás encontradas en matemáticas. Ellas reaparecen en las ramas más distantes e inconexas de las matemáticas. Una función que aparece una y otra vez en la teoría de las funciones modulares se denomina ( ya he dicho otras veces) hoy día “función de Ramanujan” en su honor. Esta extraña función contiene un término elevado a la potencia veinticuatro.

¿Podeis imaginar la existencia de un Universo en permanente sombra?

La idea de un universo en sombra nos proporciona una manera sencilla de pensar en la materia oscura. El universo dividido en materia y materia se sombra en el Tiempo de Planck, y una evolucionó de acuerdo con sus propias leyes. Es de suponer que algún Hubble de sombra descubrió que ese universo de sombra se estaba expandiendo y es de suponer que algunos astrónomos de sombras piensan en nosotros candidatos para su materia oscura.

¡ que incluso haya unos ustedes de sombras leyendo la versión de sombra de este trabajo!

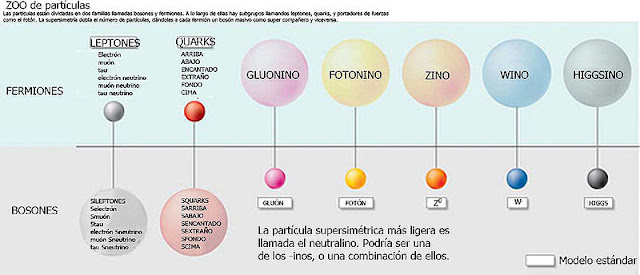

Partículas y partículas supersimétricas

Partículas son las que todos conocemos y que forman la materia, la supersimétricas, fotinos, squarks y otros, las estamos buscando sin poder hallarlas.

Estas partículas son predichas por las teorías que unifican todas las fuerzas de la naturaleza. Forman un conjunto de contrapartidas de las partículas a las que estamos habituados, son mucho más pesadas. Se nombran en analogía con sus compañeras: el squark es el compañero supersimétrico del quark, el fotino del fotón, etc. Las más ligeras de estas partículas podrían ser la materia oscura. Si es así, partícula probablemente pesaría al menos cuarenta veces más que el protón.

Lo cierto es que las partículas que conocemos son las que están presentes en el Modelo Estándard de la Física que incluye a tres de las cuatro fuerzas conocidas, la Gravedad se niega a compartir teoría y, según parece, sólo en una teoría más avanzada como la de cuerdas, se deja, incluir sin protestar dentro de ella, es decir, que si finalmente se verifica tal teoría, en ella subyace una teoría cuántica de la gravedad.

Y la materia de sombra, si existe, no hemos sabido dar con ella y, sin embargo, existen indicios de que está ahí. Así, los del LHC no de dejan de intentar su localización en en ese infinitesimal “mundo” de lo muy pequeño.

En algunas versiones de las llamadas teorías de supercuerdas hay todo un universo de materia de sombra que existe paralelo con el nuestro. Los dos universos se separaron la gravedad se congeló separándose de las otras fuerzas. Las partículas de sombra interaccionan con nosotros sólo a través de la fuerza de la gravedad, lo que las convierte en candidatas ideales para la materia oscura.

Axiones

El Axión es una partícula muy ligera (pero presumiblemente muy común) que, si existiera, resolvería un problema antiguo en la teoría de las partículas elementales. Se estima que una masa menor que una millonésima parte de la del electrón y se supone que impregna el universo de una manera semejante al fondo de microondas. La materia oscura consistiría en agregaciones de axiones por encima del nivel general de fondo.

Construímos inmensos aparatos de ingeniosas propiedades tecnológicas tratar de que nos busquen las WIMPs, esas hipotéticas partículas que podrían, llevarnos a un conocimiento mayor de la materia.

¿WIMPs en el Sol?

A lo largo de todo el se ha dado a entender que todas estas partículas candidatas a materia oscura de la que hemos estado hablando, son puramente hipotéticas. No hay pruebas de que ninguna de ellas se vaya a encontrar de hecho en la naturaleza. Sin embargo sería negligente si no mencionase un argumento –un diminuto rayo de esperanza- que tiende a apoyar la existencia de WIMPs de un u otro. Este argumento tiene que ver con algunos problemas que han surgido en nuestra comprensión del funcionamiento y la estructura del Sol.

Creemos que la energía del Sol viene de reacciones nucleares profundas dentro del núcleo. Si éste es el caso en realidad, la teoría nos dice que esas reacciones deberían estar produciendo neutrinos que en principio son detectables sobre la Tierra. Si conocemos la temperatura y composición del núcleo (creemos), entonces podemos predecir exactamente cuántos neutrinos detectaremos. Durante más de veinte años se llevó a cabo un experimento en una mina de oro de Dakota del Sur para detectar esos neutrinos y, desgraciadamente, los resultados fueron desconcertantes. El número detectado fue de sólo un tercio de lo que se esperaba. Esto se conoce como el problema del neutrino solar.

El problema de los neutrinos solares se debió a una gran discrepancia el número de neutrinos que llegaban a la Tierra y los modelos teóricos del interior del Sol. Este problema que duró mediados de la década de 1960 hasta el 2002, ha sido recientemente resuelto mediante un entendimiento de la física de neutrinos, necesitando una modificación en el modelo estándar de la física de partículas, concretamente en las neutrinos” href=”http://es.wikipedia.org/wiki/Oscilaci%C3%B3n_de_neutrinos”>oscilaciones de neutrinos. Básicamente, debido a que los neutrinos tienen masa, pueden cambiar del tipo de neutrino que se produce en el interior del Sol, el neutrino electrónico, en dos tipos de neutrinos, el muónico y el tauónico, que no fueron detectados.

La segunda característica del Sol que concierne a la existencia de WIMPs se refiere al hecho de las oscilaciones solares. los astrónomos contemplan cuidadosamente la superficie solar, la ven vibrar y sacudirse; todo el Sol puede pulsar en períodos de varias horas. Estas oscilaciones son análogas a las ondas de los terremotos, y los astrónomos llaman a sus estudios “sismología solar”. Como creemos conocer la composición del Sol, tenemos que ser capaces de predecir las propiedades de estas ondas de terremotos solares. Sin embargo hay algunas duraderas discrepancias entre la teoría y la observación en este campo.

No mucho que los astrónomos han señalado que si la Galaxia está en realidad llena de materia oscura en la de WIMPs, entonces, durante su vida, el Sol habría absorbido un gran número de ellos. Los WIMPs, por tanto, formarían parte de la composición del Sol, una parte que no se había tenido en cuenta hasta ahora. Cuando los WIMPs son incluidos en los cálculos, resultan dos consecuencias: primero, la temperatura en el núcleo del Sol resulta ser menor de lo que se creía, de forma que son emitidos menos neutrinos, y segundo, las propiedades del cuerpo del Sol cambian de tal modo que las predicciones de las oscilaciones solares son exactas.

Hasta nos atrevemos a exponer una imagen que nos muestra la distribución de los WIMPs

Este resultado es insignificante en lo que se refiere a la existencia de WIMPs, pero no debemos despreciar las coincidencias halladas, lo más prudente será esperar a nuevos y más avanzados experimentos (SOHO y otros). Tanto el problema del neutrino como las oscilaciones se pueden explicar igualmente por otros efectos que no tienen nada que ver con los WIMPs. Por ejemplo, el tipo de oscilaciones de neutrinos podría resolverse si el neutrino solar tuviera alguna masa, aunque fuese muy pequeña, y diversos cambios en los detalles de la estructura interna del Sol podrían explicar las oscilaciones. No obstante estos fenómenos solares constituyen la única indicación que tenemos de que uno de los candidatos a la materia oscura pueda existir realmente.

Toda charla sobre supersimetría y teoría últimas da a la discusión de la naturaleza de la materia oscura un tono solemne que no tiene ningún parecido con la forma en que se lleva en realidad el debate entre los cosmólogos. Una de las cosas que más me gusta de este campo es que todo el mundo parece ser capaz de conservar el sentido del humor y una distancia respecto a su propio trabajo, ya que, los buenos científicos saben que, todos los cálculos, conjeturas, hipótesis y finalmente teorías, no serán visadas en la aduana de la Ciencia, hasta que sean muy, pero que muy bien comprobadas mediante el experimento y la observación y, no una sino diez mil veces de que puedan ser aceptadas en el ámbito puramente científico.

El el Sol podemos hallar algunas respuestas

Posiblemente, el LHC nos pueda decir algo al respecto si, como no pocos esperan, de sus colisiones surgen algunas partículas supersimétricas que nos hablen de ese otro mundo oscuro que, estando en este, no hemos sabido encontrar este momento. Otra posibilidad sería que la tan manoseada materia oscura no existiera y, en su lugar, se descubriera otro fenómeno o mecanismo natural desconocido hasta ahora que, incidiendo en el comportamiento de expansión del Universo, nos hiciera pensar en la existencia de la “materia oscura” cubrir el hueco de nuestra ignorancia.

Hace algún tiempo, en esas reuniones periódicas que se llevan a cabo entre científicos de materias relacionadas: física, astronomía, astrofísica, comología…, alguien del grupo sacó a relucir la idea de la extinción de los dinosaurios y, el hombre se refirió a la teoría (de los muchas que circulan) de que el Sol, en su rotación alrededor de la Vía Láctea, se salía periódicamente fuera del plano de la Galaxia. Cuando hacía esto, el polvo existente en ese plano podía cesar de proteger la Tierra, que entonces quedaría bañada en rayos cósmicos letales que los autores de la teoría pensaban que podían permeabilizar el cosmos. Alguien, el fondo de la sala lanzó: ¿Quiere decir que los dinosaurios fueron exterminados por la radiación de fotinos?

La cosa se tomó a broma y risas marcaron el final de la reunión en la que no siempre se tratan los temas con esa seriedad que todos creen, toda vez que, los conocimientos que tenemos de las cosas son muy limitados y tomarse en serio lo que podría no ser… ¡No sería nada bueno!

Por ejemplo, si vemos la imagen de arriba y un letrero que diga: “Dopar un aislante topológico con impurezas magnéticas rompe la simetría de inversión temporal y abre una nueva vía a la espintrónica.” Para la mayoría de los presentes, el galimatias no le dirá nada y, sin embargo, para otros al tanto de las cuestiones de física, le parecerá que: “Los aislantes topológicos son materiales que conducen electrones en su superficie exterior, pero actúan como aislantes en su volumen interior. propiedad tiene su origen en la forma en que los electrones se mueven a través del material. Los electrones poseen un espín mecánico-cuántico que apunta hacia “arriba” o hacia “abajo”. El espín es normalmente independiente del movimiento de los electrones, pero dentro de los aislantes topológicos, el espín de los electrones está estrechamente relacionado con su movimiento.”

¡Qué cosas! Lo que digo siempre… ¡Nunca llegaremos a saberlo todo!

emilio silvera

Ago

2

¿La teoría cuántica y la Gravedad, dentro de las cuerdas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (13)

Comments (13)

Todo se degrada con el paso del Tiempo

Sí, a veces la Física, parece un Carnaval. Imaginamos universos que… ¿serán posibles?

Las teorías de cuerdas [TC’s] no son una invención nueva, ni mucho menos. La primera TC se inventó a finales de los años sesenta del siglo XX en un intento para encontrar una teoría para describir la interacción fuerte. La idea medular consistía en que partículas como el protón y el neutrón podían ser consideradas como ondas de «notas de una cuerda de violín». La interacción fuerte entre las partículas correspondería a fragmentos de cuerda que se extenderían entre pequeños pedacitos de cuerda, como las telas que forman algunos simpáticos insectos. Para que esta teoría proporcionase el valor observado para la interacción fuerte entre partículas, las cuerdas tendrían que ser semejantes a las de un violín, pero con una tensión de alrededor de unas diez toneladas.

La primera expresión de las TC’s fue desarrollada por Jöel Scherk, de París, y John Schwuarz, del Instituto de Tecnología de California, quienes en el año 1974 publicaron un artículo en el que demostraban que la TC podía describir la fuerza gravitatoria, pero sólo si la tensión en la cuerda se tensiometrara alrededor de un trillón de toneladas métricas. Las predicciones de la teoría de cuerdas serían las mismas que las de la relatividad general a escala de longitudes normales, pero diferirían a distancias muy pequeñas, menores que una trillonésima de un cm. Claro está, que en esos años, no recibieron mucha atención por su trabajo.

Ahora se buscan indicios de la teoría de cuerdas en los grandes aceleradores de partículas donde parece que algunos indicios nos dicen que se va por el buen camino, sin embargo, nuestros aceleradores más potentes necesitarían multiplicar por un número muy elevado su potencia para poder, comprobar la existencia de las cuerda situadas a una distancia de 10-35 m, lugar al que nos será imposible llegar en muchas generaciones. Sin embargo, en las pruebas que podemos llevar a cabo en la actualidad, aparecen indicios de una partlicula de espín 2 que todos asocian con el esquivo Gravitón, y, tal indicio, nos lleva a pensar que, en la teoría de supercuerdad, está implícita una Teoría Cuántica de la Gravedad.

Los motivos que tuvo la comunidad científica, entonces, para no brindarle la suficiente atención al trabajo de Scherk y Schwuarz, es que, en esos años, se consideraba más viable para describir a la interacción fuerte a la teoría basada en los quarks y los gluones, que parecía ajustarse mucho mejor a las observaciones. Desafortunadamente, Scherk murió en circunstancias trágicas (padecía diabetes y sufrió un coma mientras se encontraba solo en su estudio). Así, Schwuarz se quedó solo, en la defensa de la teoría de cuerdas, pero ahora con un valor tensiométrico de las cuerdas mucho más elevado.

Pero con los quarks, gluones y también los leptones, en la consecución que se buscaba, los físicos entraron en un cuello de botella. Los quarks resultaron muy numerosos y los leptones mantuvieron su número e independencia existencial, con lo cual seguimos con un número sustancialmente alto de partículas elementales (60), lo que hace que la pregunta ¿son estos los objetos más básicos?

Si esos sesenta objetos fuesen los más básicos, entonces también aflora otra pregunta ¿por qué son como son y por qué son tantos? Los físicos quisieran poder decir «salen de esto», o «salen de esto y aquello», mencionar dos principios bien fundamentales y ojalá sea tan simples que puedan ser explicados a un niño. La respuesta «porque Dios lo quiso así» posiblemente a muchos les cause «lipotimia», ya que esa respuesta nos lleva a reconocer nuestra ignorancia y, además, la respuesta que esperamos no pertenece al ámbito de la religión. Por ahora, ¿cuál es la última respuesta que puede dar la ciencia?

El cuello de botella incentivó a que se encendiera una luz de esperanza. En 1984 el interés por las cuerdas resucitó de repente. Se desempolvaron las ideas de Kaluza y Klein, como las que estaban inconclusas de Scherk y Schwuarz. Hasta entonces, no se habían hecho progresos sustanciales para explicar los tipos de partículas elementales que observamos, ni tampoco se había logrado establecer que la supergravedad era finita.

El ser humano –en función de su naturaleza– cuando se imagina algo muy pequeño, piensa en un puntito de forma esférica. Los físicos también son seres de este planeta y, para ellos, las partículas elementales son como puntitos en el espacio, puntos matemáticos, sin extensión. Son sesenta misteriosos puntos y la teoría que los describe es una teoría de puntos matemáticos. La idea que sugieren las TC’s es remplazar esos puntos por objetos extensos, pero no como esferitas sino más bien como cuerdas. Mientras los puntos no tienen forma ni estructura, las cuerdas tienen longitud y forma, extremos libres como una coma “,” (cuerda abierta), o cerradas sobre sí misma como un minúsculo círculo . Si el punto es como una minúscula esfera inerte de la punta de un elástico, la cuerda es el elástico estirado y con él se pueden hacer círculos y toda clase de figuras. Está lleno de posibilidades.

Muchas son las imágenes que se han elaborado para representar las cuerdas y, como nadie ha visto nunca ninguna, cualquiera de ellas vale para el objetivo de una simple explicación y, las cuerdas que se han imaginado han tomado las más pintorescas conformaciones para que, en cada caso, se adapten al modelo que se expone.

diferencia entre un punto y una coma. Según la teoría de cuerdas importa, y mucho. Por su extensión, a diferencia del punto, la cuerda puede vibrar. Y hacerlo de muchas maneras, cada modo de vibración representando una partícula diferente. Así, una misma cuerda puede dar origen al electrón, al fotón, al gravitón, al neutrino y a todas las demás partículas, según cómo vibre. Por ello, la hemos comparado con la cuerda de un violín, o de una guitarra, si se quiere.

Al dividir la cuerda en dos, tres, cuatro, cinco, o más partes iguales, se generan las notas de la escala musical que conocemos, o técnicamente, los armónicos de la cuerda. En general, el sonido de una cuerda de guitarra o de piano es una mezcla de armónicos. Según la mezcla, la calidad (timbre) del sonido. Si distinguimos el tono de estos instrumentos, es por la «receta» de la mezcla en cada caso, por las diferentes proporciones con que cada armónico entra en el sonido producido. Pero, también es posible hacer que una buena cuerda vibre en uno de esos armónicos en particular, para lo cual hay que tocarla con mucho cuidado. Los concertistas lo saben, y en algunas obras como los conciertos para violín y orquesta, usan este recurso de «armónicos». Así, la naturaleza, con su gran sabiduría y cuidado para hacer las cosas, produciría electrones, fotones, gravitones, haciendo vibrar su materia más elemental, esa única y versátil cuerda, en las diversas (infinitas) formas que la cuerda permite.

Una partícula ocupa un punto del espacio en todo momento. Así, su historia puede representarse mediante una línea en el espacio-tiempo que se le conoce como «línea del mundo». Por su parte, una cuerda ocupa una línea en el espacio, en cada instante de tiempo. Por tanto, su historia en el espaciotiempo es una superficie bidi-mensional llamada la «hoja del mundo». Cualquier punto en una hoja del mundo puede ser descrito mediante dos números: uno especificando el tiempo y el otro la posición del punto sobre la cuerda. Por otra parte, la hoja del mundo es una cuerda abierta como una cinta; sus bordes representan los caminos a través del espaciotiempo (flecha roja) de los extremos o comas de la cuerda (figura 12.05.03.02). La hoja del mundo de una cuerda cerrada es un cilindro o tubo (figura 12.05.03.03); una rebanada transversal del tubo es un círculo, que representa la posición de la cuerda en un momento del tiempo.

No cabe duda que, de ser ciertas las TC’s, el cuello de botella queda bastante simplificado. Pasar de sesenta objetos elementales a una sola coma o circulito es un progreso notable. Entonces, ¿por qué seguir hablando de electrones, fotones, quarks, y las demás?

Que aparentemente las cosas se simplifican con las TC’s, no hay duda, pero desafortunadamente en física las cosas no siempre son como parecen. Para que una teoría sea adoptada como la mejor, debe pasar varias pruebas. No basta con que simplifique los esquemas y sea bella. La teoría de las cuerdas está –se puede decir– en pañales y ha venido mostrado distintas facetas permeables. Surgen problemas, y se la deja de lado; se solucionan los problemas y una avalancha de trabajos resucitan la esperanza. En sus menos de treinta años de vida, este vaivén ha ocurrido más de una vez.

Uno de los problemas que más afecta a la cuerda está ligado con su diminuto tamaño. Mientras más pequeño algo, más difícil de ver. Es una situación que se agudiza en la medida que se han ido corrigiendo sus permeabilidades. En sus versiones más recientes, que se llaman supercuerdas, son tan superpequeñas que las esperanzas de ubicarlas a través de un experimento son muy remotas. Sin experimentos no podemos comprobar sus predicciones ni saber si son correctas o no. Exagerando, es como una teoría que afirmara que los angelitos del cielo tienen alitas. ¿Quién la consideraría seriamente?