May

25

La NASA cree que podría encontrar vida extraterrestre

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

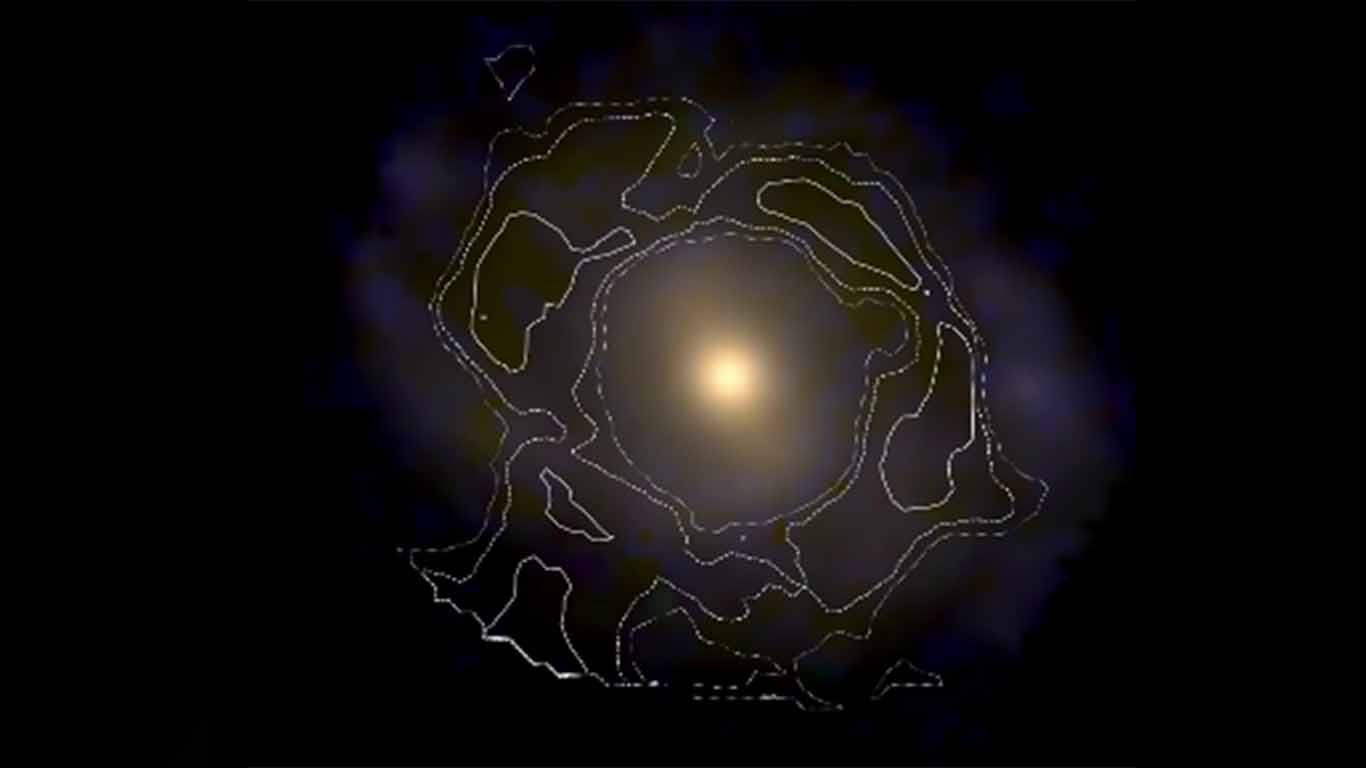

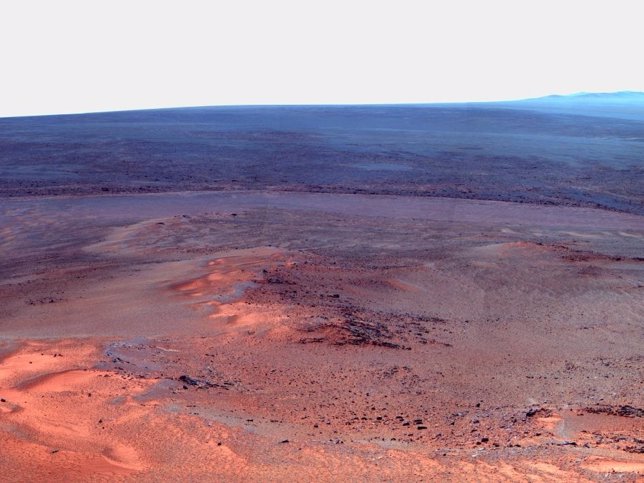

En su momento pudimos leer en los medios noticias como la que aquí mostramos en relación a la posibilidad de encontrar vida en otros mundos. Lo cierto es que la Vida, amigos míos, está presenté en más lugares de los que ni podemos imaginar, toda vez que es algo que está escrito en los “genes” del Universo. Recordemos la notica.

Univision.com | Jul 15, 2014 | 7:16 PM

Expertos de la NASA y las instituciones asociadas han expuesto en Washington su hoja de ruta para la búsqueda de vida en el Universo.

“Una de las inquietudes que ha tenido la humanidad es saber si hay vida en lugares fuera del planeta Tierra. En un reciente estudio realizado por investigadores del Instituto de Astronomía (IA) de la Universidad Nacional Autónoma de México (UNAM) y las instituciones McDonald Observatory junto con la Universidad de Austin en Texas, Estados Unidos, da indicios de que esto puede ser posible.”

Me hace gracia ver como representamos a los posibles habitantes de otros planetas. “Ellos” podrían ser de cualquier manera que nos podamos imaginar. Sin embargo, una cosa debemos tener en cuenta: El Universo se rige por leyes y constantes que son iguales en todas partes por muy lejos que esas regiones estén, y, en la Tierra, la base de la vida es el Carbono… ¿Por qué sería distintos en otros mundos?

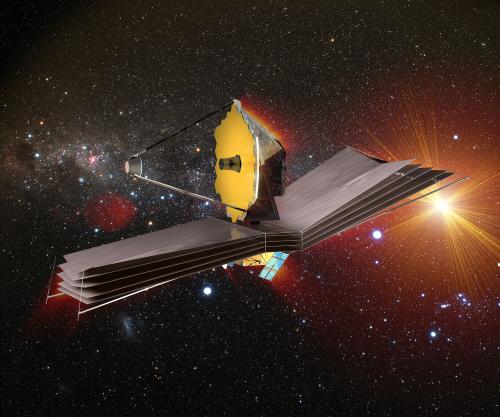

“Esta tecnología que estamos usando para estudiar los exoplanetas es real”

“El Telescopio Espacial James Webb y los próximos avances se están produciendo ahora, no son sueños. Esto es lo que hacemos en la NASA”. agregó.

“Lo que no sabíamos hace cinco años es que quizás el 10 a 20 por ciento de las estrellas que nos rodean tienen planetas del tamaño de la Tierra en la zona habitable”, dice Matt Mountain, director científico del telescopio Webb en el Instituto de Ciencia del Telescopio Espacial en Baltimore. “Está a nuestro alcance lograr un descubrimiento que cambiará el mundo para siempre”, aseguró.

May

24

¿Qué es la Luz?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (1)

Comments (1)

May

24

La luz. esa maravilla

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (5)

Comments (5)

El día que sepamos, lo que en realidad es la luz y el agua… ¡Habremos dado un gran paso en el saber del Universo! Esas dos misteriosas “verdades”, son la esencia del Universo y de la vida.

Una, la LUZ, es inmaterial (Fotón sin más en reposo), la otra es algo que podemos tocar, sabemos que está hecha de moléculas de agua (Hidrógeno y Oxígeno). Claro que, si nos fiamos de lo que dice la ecuación de Einstein E: mc2 (la energía y la masa son dos aspectos de la misma cosa), entonces, la energía luiínica se podría (en algún caso), convertir en masa.

May

24

A quien pueda interesar

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Fwd: XIII Conferencia Ciencia para Todos

|

||||

|

|

||||

Estimados miembros de la RSEF,

En nombre del Presidente de la RSEF, os enviamos la información recibida por la RAC por si fuera de vuestro interés.

Un saludo,

Itziar Serrano

RSEF

__________________________________________________________________________________________________

El próximo jueves 25 de mayo a las 18.30h en la RAC, tendrá lugar la XIII Conferencia del Ciclo Ciencia para Todos que pronunciará Dª Carmen Claver Cabrero bajo el título: ” Los catalizadores como aliados en el desarrollo sostenible”.

Será presentada por la Secretaria General, Dª Ana Crespo.

Con el ruego de su difusión entre aquellas personas a las que les pudiera interesar

Muchas gracias

Un cordial saludo

Mamen de las Heras Barruete

Presidencia

Calle Valverde, 22

28004 Madrid

Tel: 917 014 230

youtube.com/RealAcademiadeCienciasExactasFísicasNaturales

twitter.com/racienciasPara cancelar la suscripción a este grupo y dejar de recibir sus mensajes, envía un correo electrónico a SOCIOS-RSEF-L+unsubscribe@ggrupos.ucm.es.

May

24

Simetría en la Naturaleza

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Totales: 83.572.903

Totales: 83.572.903 Conectados: 55

Conectados: 55