Abr

27

Sí ¡Tenemos que saber!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Las leyes de la naturaleza son las mismas en cualquier lugar de nuestro universo; todo está formado por partículas elementales que se unen para formar núcleos, átomos, células y materia que, unas veces conforman estrellas brillantes, otras mundos habitados y también, grandes estructuras como galaxias y cúmulos de ellas.

“Por extraño que parezca, la velocidad de la luz (o de cualquier onda electromagnética) siempre tiene el mismo valor, c, sin importar la velocidad relativa de la fuente y el observador.”

Einstein se inspiró en la invariancia de la velocidad de la luz para regalarnos su teoría de la relatividad especial con su sencilla y asombrosa fórmula E = mc2, que nos dice la igualdad entre masa y energía. Nos dejó cómo se ralentizaba el tiempo al viajar más rápido y, con su teoría de la relatividad general, nos dejó una profunda lección de cómo se formula una teoría de la máxima eficacia mediante unas ecuaciones de bella factura y, sobre todo, de un extenso e inmenso mensaje.

Los grandes números de Eddington y Dirac, y trabajos de otros muchos personajes, han quedado aquí reflejados para facilitar al lector datos que no conocía y aspectos interesantes de las ciencias físicas.

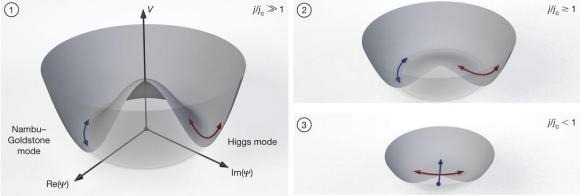

El espacio “vacio” del universo, las fuerzas que lo rigen, la simetría original en el Big Bang, las familias de las partículas con sus quarks, leptones y hadrones (bariones y mesones), y las partículas mediadoras de las fuerzas, gluones, fotones, partículas W y Z y el esquivo gravitón.

“Esto no es una mera conjetura; se ha probado en laboratorios y experimentos. Por todo el cosmos, a nivel subatómico, existe una incesante y burbujeante actividad en lo que creemos “vacío”.”

El espacio vacío no existe

La física cuántica establece que, en contra de las apariencias, el espacio vacío es un campo burbujeante de partículas subatómicas “virtuales” que se crean y se destruyen constantemente. Estas fugaces partículas dotan a cada centímetro cúbico de espacio de una cierta energía que, de acuerdo a la relatividad general, produce una fuerza anti-gravitatoria que hace que el espacio se expanda. No obstante, lo cierto es que nadie sabe en realidad qué está provocando la expansión acelerada del universo.

El Modelo Estándar con sus parámetros discrecionales y sus muchos beneficios con su eficacia como herramienta de trabajo.

Bueno, parece que quedan algunas “cuerdas” sueltas por ahí

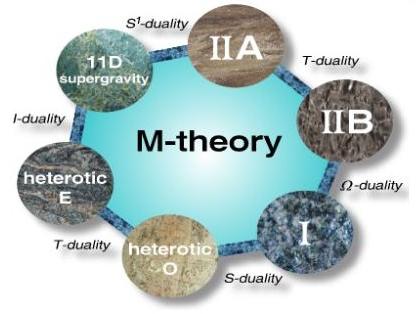

Las nuevas teorías de supercuerdas, la teoría M, sus autores y el final que pretenden unificar todas las fuerzas del Universo, la materia, la luz y la gravedad (la teoría cuántica de Max Planck con la Relatividad de Einstein), la explicación de todo…¡Un sueño! ¿Alcanzable?

Heisenberg y Schrödinger

También de pasada hemos comentado sobre el principio de incertidumbre de Heisenberg, la función de onda de Schrödinger, el cuanto de Planck, el positrón de Dirac, la nueva teoría de Witten, el radio de Schwarzschild que, a partir de las ecuaciones de Einstein dedujo la existencia de agujeros negros con su singularidad y el horizonte de sucesos, punto sin retorno de lo que pueda traspasar sus límites.

Se han incluido, en algunos casos, diagramas explicativos que tratan de hacer comprender mejor lo que digo. De pasada, he mencionado y explicado algo de lo que encierra el número 137, con sus secretos que nos recuerda lo poco que sabemos, número puro y adimensional.

He dedicado algunas líneas a explicar la teoría de los viajes en el tiempo, permitidos por las ecuaciones de Einstein a través de los agujeros de gusano que nos llevarían desde este universo hasta otros lugares muy lejanos y en otros tiempos distintos.

La materia exótica, lo que piensan Kip S. Thorne y el físico Stephen Hawking sobre estos viajes que, hoy al menos, son pura teoría; no tenemos los medios ni las energías necesarias para poder realizarlos (tampoco la tecnología ni el conocimiento).

Ahora van en busca del conocimiento de las M-Branas

Hemos llegado a teorías avanzadas como todas las modalidades de supercuerdas que han desembocado en la última teoría M de Ed Witten. Esta nueva aspirante a la teoría del todo, tiene su base en las ecuaciones de Einstein, fueron ampliadas por el matemático Theodor Kaluza y perfeccionadas por Oskar Klein; siguió el camino señalado por Veneziano, David Gross, Emil Martinec, Jeffrey Harvey y Ryan Rohm (el cuarteto de cuerda) y, finalmente, Witten.

Claro que llegar a estas teorías que exigen matemáticas topológicas de una profundidad y complejidad inusitadas, ha sido posible a que antes que todos ellos, estuvieron ahí Galileo y Newton, Faraday y Maxwell, Lorentz, Planck, Einstein y Riemann, y estoy seguro que también Ramanujan que, probablemente, tendrá aún algo que decir en todo esto con sus funciones modulares.

Muchos más también han hecho posible llegar al punto en que nos encontramos. Sería imposible mencionarlos a todos, sin embargo, aunque sin mencionar sus nombres, dejemos aquí un homenaje a todos ellos junto con nuestro agradecimiento; sin sus contribuciones todos nosotros estaríamos peor.

Independientemente de que sepamos lo que ocurre en el mundo macroscópico, también es preciso que no dejemos de mirar hacia ese otro mundo de lo infinitesimal. No lo olvides: ¡Todo lo grande está hecho de cosas pequeñas!

Es bueno para el ser humano que sepa el por qué de las cosas, que se interese por lo que ocurre a su alrededor, por su planeta que le acoge, por el lugar que ocupamos en el universo, por cómo empezó todo, cómo terminará y qué será del futuro de nuestra civilización y de la Humanidad en este universo que, como todo, algún día lejano del futuro terminará.

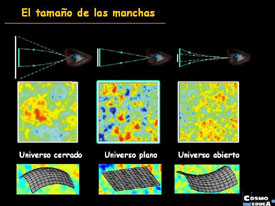

El fin del Universo es irreversible, de ello hemos dejado amplio testimonio a lo largo de este trabajo, su final estará determinado por la Densidad Crítica, la cantidad de materia que contenga nuestro universo que será la que lo clasifique como universo plano, universo abierto, o universo cerrado. En cada uno de estos modelos de universos, el final será distinto…, claro que para nosotros, la Humanidad, será indiferente el modelo que pueda resultar; en ninguno de ellos podríamos sobrevivir cuando llegara ese momento límite del fin. La congelación y el frío del cero absoluto o la calcinación del fuego final a miles de millones de grados del Big Crunch, acabarán con nosotros.

Para evitar eso se está trabajando desde hace décadas. Se buscan formas de superar dificultades que nos hacen presas fáciles de los elementos. La naturaleza indomable, sus leyes y sus fuerzas, hoy por hoy son barreras insuperables, para poder hacerlo, necesitamos saber.

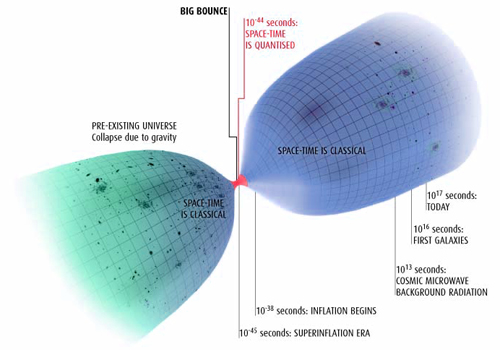

Algunas teorías proponen que nuestro universo surgió del rebote de uno previo que colapsaba por gravedad. ¡Es tanto lo que no sabemos!

El saber nos dará soluciones para conseguir más energías, viajar más rápido y con menos riesgos, vivir mejor y más tiempo, superar barreras hoy impensables como las del límite de Planck, la barrera de la luz (para poder viajar a las estrellas) y el saber también posibilitará, algún día, que nuestras generaciones futuras puedan colonizar otros mundos en sistemas solares de estrellas lejanas, viajar a otras galaxias, viajar a otro tiempo y, finalmente, viajar para escapar de nuestro destino, a otros universos.

Sí, lo sé, algunos de los que esto puedan leer pensarán que estoy fantaseando, pero la verdad es que no he hablado con más seriedad en mi vida, ya que, si no fuera como estoy diciendo, entonces, ¿para qué tantas calamidades, desvelos y sufrimientos?

Creo que la Humanidad tiene que cumplir su destino, primero en las estrellas lejanas, en otros mundos dentro y fuera de nuestra galaxia, y después…, ¿Quién sabe?

El paso del tiempo lo cambia todo; los sistemas se transforman, viven y mueren para dar paso a otros nuevos sistemas. Estrellas que brillan durante miles de millones de años y con el paso del tiempo consumen su material-combustible nuclear y mueren explotando en novas o supernovas para, con su material complejo, contribuir a la formación de nuevas estrellas y planetas e incluso formas de vida.

Todo envejece, se deteriora por la acción de la entropía, del paso del tiempo. Sin embargo, él no cambia, es invariante, continúa su camino mientras que, a su alrededor, las mutaciones son continuas y lo único que permanece inalterable es: el Tiempo.

Me encantaría tener sabiduría para poder exponer de manera más amplia y precisa lo que es el tiempo. Lo que aquí dejo escrito (después de documentarme), es corto y no me deja satisfecho. Cualquier persona mejor preparada lo habría hecho mejor pero, de todas formas, la voluntad que he puesto en este trabajo compensa sus posibles deficiencias y el lector sabrá disculpar las mismas.

De todas las maneras posibles en los que me he detenido a pensar sobre lo que es y supone el tiempo, la que más me impresiona es aquella que me hacer ver claramente que no podemos impedir su transcurrir, que su paso nos llevará hacia la eternidad convertidos en polvo, dejando atrás a los seres queridos que nos gustaría seguir protegiendo, sin llevarnos la certeza de lo que el destino les tiene reservado a sus vidas. Esa incertidumbre me causa una aguda impotencia, casi infinita que, en no pocas ocasiones, llego a sentir como un dolor físico y real causado por un pensamiento profundo del significado y las implicaciones irreversibles que el paso del tiempo nos trae a todos.

Lo explicamos de muchas maneras pero, ninguna nos dice lo que realmente es.

Individualmente hablando, el tiempo está bien mientras nos acompaña en nuestro recorrido a lo largo de nuestras vidas; después él continúa su camino mientras nosotros desaparecemos. Colectivamente, el tiempo es muy importante. Cada uno de nosotros hacemos un trabajo y desarrollamos una actividad que se va sumando a la de los demás. Con el tiempo, el trabajo, ese conocimiento adquirido, continúa aumentando y ese tiempo “infinito” es el que necesitamos nosotros y los que vendrán detrás para resolver problemas muy graves que se presentarán en el futuro y que, de poder o no poder resolverlos, dependerá que la humanidad perdure.

El tiempo será la mejor herramienta con la que podemos contar para resolver todos los problemas. Así lo dijo Hilbert:

David Hilbert

“Por muy inabordables que parezcan estos problemas, y por muy desamparados que nos encontremos frente a ellos hoy, tenemos la íntima convicción de que debe ser posible resolverlos mediante un número finito de deducciones lógicas. Y para ello, la mejor herramienta es el tiempo; él nos dará todas las respuestas a preguntas que hoy no podemos ni sabemos contestar”.

En la tumba de David Hilbert (1862-1943), en el cementerio de Gotinga (Alemania), dice:

“Debemos saber. Sabremos”.

Hilbert nos hacía su planteamiento que era obtener la respuesta a tres importantes preguntas:

- ¿Son las matemáticas completas, es decir cualquier proposición puede ser probada o rechazada?

- ¿Son las matemáticas consistentes, es decir no es posible demostrar algo falso?

- ¿Son las matemáticas determinantes, es decir cualquier proposición se puede demostrar como cierta o falsa tras una secuencia finita de pasos?”

Al plantearlo, la idea previa de Hilbert era que la respuesta sería afirmativa para estas tres cuestiones. No es para menos, teniendo en cuenta las palabras que ordenó grabar sobre su tumba en Gotinga:

“Wir müssen wissen. Wir werden wissen“, ”Debemos saber y sabremos’,’ que muestran su rechazo categórico al entonces vigente “Ignoramus et ignorabimus”

La curiosidad nos hace saber

Estoy totalmente de acuerdo con ello. El ser humano está dotado de un resorte interior, algo en su mente que llamamos curiosidad y que nos empuja (sin que en muchas ocasiones pensemos en el enorme esfuerzo y en el alto precio que pagamos) a buscar respuestas, a querer saber el por qué de las cosas, a saber por qué la naturaleza se comporta de una u otra manera y, sobre todo, siempre nos llamó la atención aquellos problemas que nos llevan a buscar nuestro origen en el origen mismo del universo y, como nuestra ambición de saber no tiene límites, antes de saber de dónde venimos, ya nos estamos preguntando hacia dónde vamos. Nuestra osadía no tiene barreras y, desde luego, nuestro pensamiento tampoco las tiene, gracias a lo cual, estamos en un estadio de conocimiento que a principios del siglo XXI, se podría calificar de bastante aceptable para dar el salto hacia objetivos más valiosos.

Es mucho lo que hemos avanzado en los últimos ciento cincuenta años. El adelanto en todos los campos del saber es enorme. Las matemáticas, la física, la astronomía, la química, la biología genética, y otras muchas disciplinas científicas que, en el último siglo, han dado un cambio radical a nuestras vidas.

Si no somos nosotros mismos los que, por una mezquina y desmedida ambición lo estropeamos, si sabemos ver donde está lo importante y damos de lado al brillo engañoso de lo que los hombres persiguen sin darse cuenta de su terrible error, si eso es así, podremos cumplir el destino que para nosotros está ahí, esperando que lleguemos a ese punto en el cual, podamos ver con claridad.

emilio silvera

Abr

23

¡La Física! Siempre presente

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (1)

Comments (1)

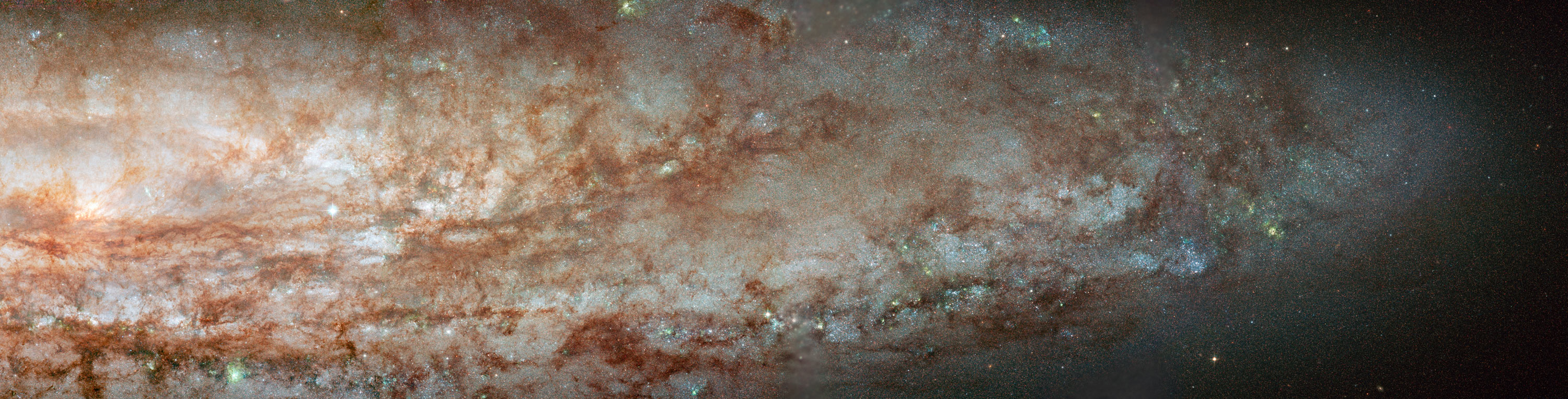

Todo comienza siendo una cosa y con el tiempo, se transforma en otra diferente: Evolución por la energía. En el Universo en que vivimos, nada desaparece; con el Tiempo se cumplen los ciclos de las cosas y se convierten en otra distinta, es un proceso irreversible. Estudiar en profundidad el simple proceso que siguen los Quarks -siempre con los Gluones pegados al culo- para poder formar el núcleo atómico, y, más tarde, que se forme el átomo, es una maravilla de la Naturaleza a la que no damos la importancia que verdaderamente tiene. Sin átomos… ¡No estaríamos! Todo lo que arriba nos muestran esas bellas imágenes son átomos que se juntaron para conformarlas.

El gas y el polvo se transforma en una brillante estrella que vive diez mil millones de años y termina en Nebulosa planeta con una enana blanca en el centro. Entonces la estrella que tenía un diámetro de 1.500 km, se reduce hasta unas pocas decenas, 20 0 30 Km y, su densidad, es inmensa, emitiendo radiación ultravioleta durante mucho tiempo hasta que se enfría y se convierte en un cadáver estelar.

La estrella enana blanca en solitario y en la segunda imagen es el puntito blanco del centro de la Nebulosa Planetaria cuyos componentes están ionizados por la radiación de la estrella.

En lo concerniente a cambios y transformaciones, el que más me ha llamado siempre la atención es el de las estrellas que se forman a partir de gas y polvo cósmico. Nubes enormes de gas y polvo se van juntando. Sus moléculas cada vez más apretadas se rozan, se ionizan y se calientan hasta que en el núcleo central de esa bola de gas caliente, la temperatura alcanza millones de grados. La enorme temperatura posible la fusión de los protones y, en ese instante, nace la estrella que brillará miles de millones de años y dará luz y calor. Su ciclo de vida estará supeditado a su masa. Si la estrella es supermasiva, varias masas solares, su vida será más corta, ya que consumirá el combustible nuclear de fusión (hidrógeno, helio, litio, oxígeno, etc) con más voracidad que una estrella mediana como nuestro Sol, de vida más duradera.

Una estrella, como todo en el Universo, está sostenida por el equilibrio de dos fuerzas contrapuestas; en caso, la fuerza que tiende a expandir la estrella (la energía termonuclear de la fusión) y la fuerza que tiende a contraerla (la fuerza gravitatoria de su propia masa). Cuando finalmente el proceso de fusión se detiene por agotamiento del combustible de fusión, la estrella pierde la fuerza de expansión y queda a merced de la fuerza de gravedad; se hunde bajo el peso de su propia masa, se contrae más y más, y en el caso de estrellas súper masivas, se convierten en una singularidad, una masa que se ha comprimido a tal extremo que acaba poseyendo una fuerza de gravedad de una magnitud difícil de imaginar el común de los mortales.

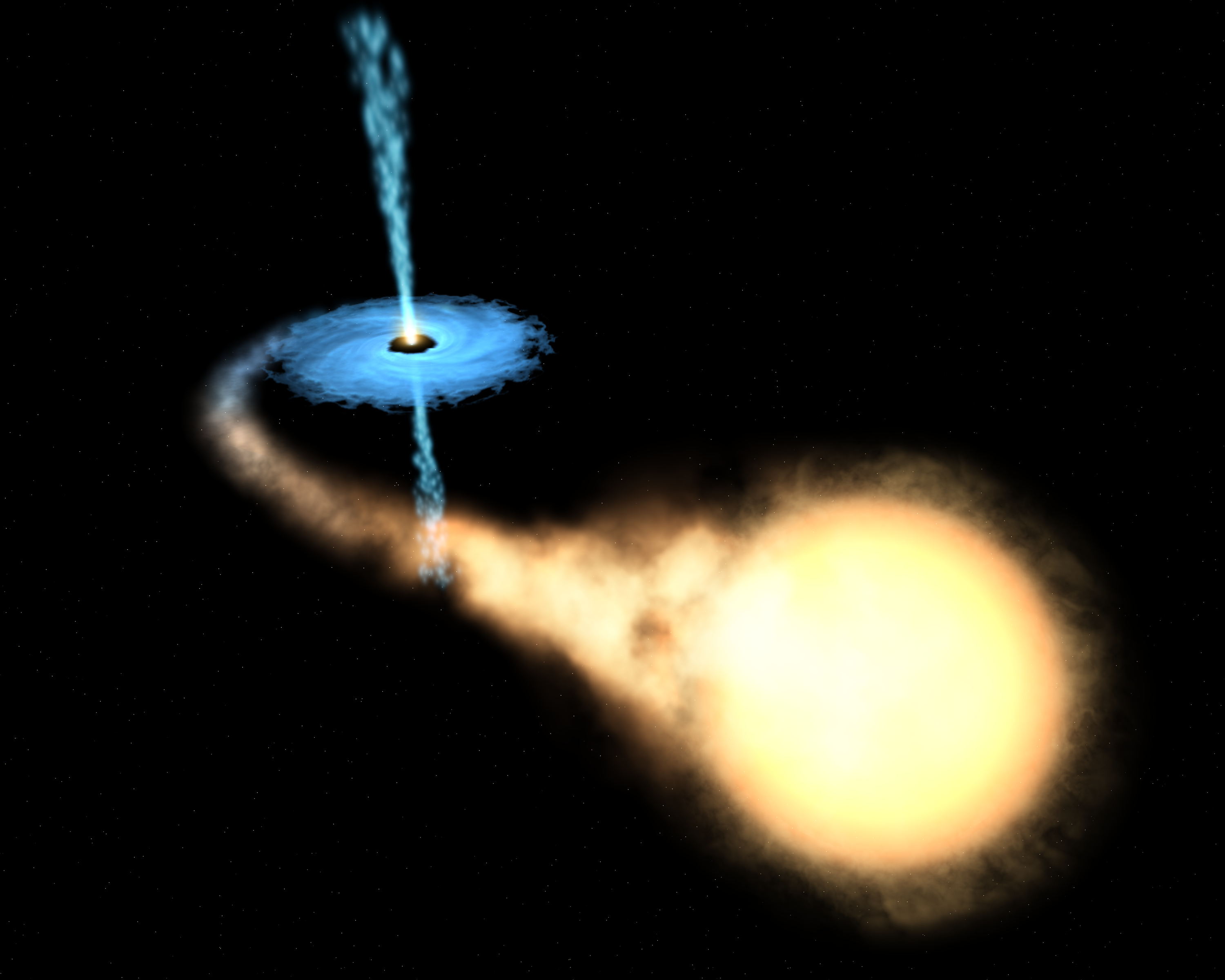

La singularidad con su inmensa fuerza gravitatoria atrae a la estrella vecina

La Tierra, un objeto minúsculo en comparación con esos objetos súper masivos estelares, genera una fuerza de gravedad que, para escapar de ella, una nave o cohete espacial tiene que salir disparado la superficie terrestre a una velocidad de 11’18 km/s; el sol exige 617’3 km/s. Es lo que se conoce como velocidad de escape, que es la velocidad mínima requerida escapar de un campo gravitacional que, lógicamente, aumenta en función de la masa del objeto que la produce. El objeto que escapa puede ser una cosa cualquiera, desde una molécula de gas a una nave espacial.

La velocidad de escape de un cuerpo está dada por , donde G es la constante gravitacional, M es la masa del cuerpo y R es la distancia del objeto que escapa del centro del cuerpo. Un objeto que se mueva con una velocidad menor que la de escape entra en una órbita elíptica; si se mueve a una velocidad exactamente igual a la de escape, sigue una órbita , y si el objeto supera la velocidad de escape, se mueve en una trayectoria hiperbólica y rompe la atadura en que la mantenía sujeto al planeta, la estrella o el objeto que emite la fuerza gravitatoria.

La mayor velocidad que es posible alcanzar en nuestro universo es la de la luz, c, velocidad que la luz alcanza en el vacío y que es de 299.793’458 km/s.

Sí, se pudo confirmar que los neutrinos respetan la supremacía del fotón, y la luz, sigue siendo la más rápida del Universo. Y sin embargo, no escapar de la atracción de un A.N. Los neutrinos, según todos los indicios, tiene una ínfima masa que les hace diferentes de los fotones que, en reposo, no tienen masa.

La luz es engullida por el agujero negro y, la estrella que lo orbita, parece que tiene una buena curda

Pues bien, es tal la fuerza de gravedad de un agujero negro que ni la luz puede escapar de allí; la singularidad la absorbe, la luz desaparece en su interior, de ahí su , agujero negro, la estrella supermasiva se contrae, llega a un punto que desaparece de nuestra vista. De acuerdo con la relatividad general, cabe la posibilidad de que una masa se comprima y reduzca sin límites su tamaño y se auto confine en un espacio infinitamente pequeño que encierre una densidad y una energía infinitos. Allí, el espacio y el tiempo dejan de existir.

Las singularidades ocurren en el Big Bang, en los agujeros negros y en el Big Crunch (que se podría considerar una reunión de todos los agujeros negros generados por el paso del tiempo en el universo y que nos llevará a un fin que será el comienzo).

Las singularidades de los agujeros negros están rodeados por una circunferencia invisible a su alrededor que marca el límite de su influencia. El objeto que traspasa ese límite es atraído, irremisiblemente, la singularidad que lo engulle, sea una estrella, una nube de gas o cualquier otro objeto cósmico que ose traspasar la línea que se conoce como horizonte de sucesos del agujero negro.

La existencia de los agujeros negros fue deducida por Schwarzschild, en el año 1.916, a partir de las ecuaciones de Einstein de la relatividad general. Este astrónomo alemán predijo su existencia, pero el de agujero negro se debe a Wehleer.

Señalamos la singularidad del Big Bang pero… ¿Fue así?

Así, el conocimiento de la singularidad está dado por las matemáticas de Einstein y más tarde por la observación de las señales que la presencia del agujero generan. Es una fuente emisora de rayos X que se producen al engullir materia que traspasa el horizonte de sucesos y es atrapada la singularidad, donde desaparece siempre sumándose a la masa del agujero cada vez mayor.

En el centro de nuestra galaxia, la Vía Láctea, ha sido detectado un enorme agujero negro, ya muy famoso, llamado Cygnus X-1. Después de todo, la velocidad de la luz, la máxima del universo, no vencer la fuerza de gravedad del agujero negro que la tiene confinada para siempre. En nuestra galaxia, con cien mil años luz de diámetro y unos doscientos mil millones de estrellas, ¿Cuántos agujeros negros habrá?

Para mí, la cosa está clara: el tiempo es imparable, el reloj cósmico sigue y sigue andando sin que nada lo pare, miles o cientos de miles, millones y millones de estrellas súper masivas explotarán en brillantes supernovas para convertirse en temibles agujeros negros. Llegará un momento que el de agujeros negros en las galaxias será de tal magnitud que comenzarán a fusionarse unos con otros que todo el universo se convierta en un inmenso agujero negro, una enorme singularidad, lo único que allí estará presente: la gravedad.

Esa fuerza de la naturaleza que está sola, no se puede juntar con las otras fuerzas que, como se ha dicho, tienen sus dominios en la mecánica cuántica, mientras que la gravitación residen en la inmensidad del cosmos; las unas ejercen su dominio en los confines microscópicos del átomo, mientras que la otra sólo aparece de manera significativa en presencia de grandes masas estelares. Allí, a su alrededor, se aposenta curvando el espacio y distorsionando el tiempo.

Esa reunión final de agujeros negros será la causa de que la Densidad Crítica sea superior a la ideal. La gravedad generada por el inmenso agujero negro que se irá formando en cada galaxia tendrá la consecuencia de parar la expansión actual del universo. Todas las galaxias que ahora están separándose las unas de las otras se irán frenando parar y, despacio al principio pero más rápido después, comenzarán a recorrer el camino hacia atrás. Finalmente, toda la materia será encontrada en un punto común donde chocará violentamente formando una enorme bola de fuego, el Big Crunch (es sólo una conjetua). Sin embargo, antes de que eso llegue, tendremos que resolver el primer problema: la muerte del Sol.

El Sol como gigante roja evaporará los océanos, y, la vida, tal como la conocemos desaparecerá

Los científicos se han preguntado a veces qué sucederá eventualmente a los átomos de nuestros cuerpos mucho tiempo después de que hayamos muerto. La posibilidad más probable es que nuestras moléculas vuelvan al Sol. En páginas anteriores he explicado el destino del Sol: se agotará su combustible de hidrógeno y fusionará helio; se hinchará en gigante roja y su órbita es probable que sobrepase la Tierra y la calcine; las moléculas que hoy constituyen nuestros cuerpos serán consumidas por la atmósfera solar.

Carl Sagan pinta el cuadro siguiente:

La Tierra quedará calcinada

“Dentro de miles de millones de años a partir de , habrá un último día perfecto en la Tierra… Las capas de hielo Ártica y Antártica se fundirán, inundando las costas del mundo. Las altas temperaturas oceánicas liberarán más vapor de agua al aire, incrementando la nubosidad y escondiendo a la Tierra de la luz solar retrasando el final. Pero la evolución solar es inexorable. Finalmente los océanos hervirán, la atmósfera se evaporará en el espacio y nuestro planeta será destruido por una catástrofe de proporciones que ni podemos imaginar.”

En una escala de tiempo de varios miles de millones de años, debemos enfrentarnos al hecho de que la Vía Láctea, en la que vivimos, morirá. Más exactamente, vivimos en el brazo espiral Orión de la Vía Láctea. miramos al cielo nocturno y nos sentimos reducidos, empequeñecidos por la inmensidad de las luces celestes que puntúan en el cielo, estamos mirando realmente una minúscula porción de las estrellas localizadas en el brazo de Orión. El resto de los 200 mil millones de estrellas de la Vía Láctea están tan lejanas que apenas pueden ser vistas como una cinta lechosa que cruza el cielo nocturno.

Aproximadamente a dos millones de años luz de la Vía Láctea está nuestra galaxia vecina más cercana, la gran galaxia Andrómeda, dos o tres veces mayor que nuestra galaxia. Las dos galaxias se están aproximando a unos 500 km/s, y chocarán en un periodo de entre 3 y 4 mil millones de años. Como ha dicho el astrónomo Lars Hernquist de la California en Santa Cruz, esta colisión será “parecida a un asalto. Nuestra galaxia será literalmente consumida y destruida“. Aunque, lo cierto es que aunque en el choque algo se detruya, lo cierto es que todo quedará en forma de una galaxia mucho mayor.

Ambas galaxias bailarán el Vals del “casamiento” antes de que la fusión las convierte en una sola galaxia

Así las cosas, no parece que la Humanidad del futuro lo tenga nada fácil. Primero tendrá que escapar, dentro de unos 4.000 millones de años del gigante rojo en que se convertirá el Sol que calcinará al planeta Tierra. Segundo, en unos 10.000 millones de años, la escapada tendrá que ser aún más lejana; la destrucción será de la propia galaxia que se fusionará con otra mayor sembrando el caos cósmico del que difícilmente se podría escapar quedándonos aquí. Por último, el final anunciado, aunque más largo tiempo, es el del propio universo que, por congelación o fuego, tiene los eones contados.

Por todas estas catástrofes anunciadas por la ciencia, científicos como Kip S. Thorne y Stephen Hawking sugieren a otros universos paralelos a través de agujeros de gusano en el hiperespacio. Sería la única puerta de salida para que la Humanidad no se destruyera.

La solución será “burlando a la velocidad de la luz , c, nunca podríamos vencerla

Si lo alcanzaremos o no, es imposible de contestar, no tenemos los necesarios para ello. Incluso se podría decir que aparte de estas catástrofes futuras que sabemos a ciencia cierta que ocurrirán, seguramente existan otras que están ahí latentes en la incertidumbre de si finalmente ocurren o no, sólo pendiente de decidir lo uno o lo otro por parámetros ocultos que no sabemos ni que puedan existir.

En esta situación de impotencia, de incapacidad física e intelectual, nos tenemos que dar y admitir que, verdaderamente, comparados con el universo y las fuerzas que lo rigen, somos insignificantes, menos que una mota de polvo flotando en el haz de luz que entra, imparable, por la ventana entre-abierta de la habitación.

Sin embargo, tampoco es así. Que se sepa, no existe ningún otro grupo inteligente que esté capacitado tratar de todas estas cuestiones. Que la especie humana sea consciente de dónde vino y hacia dónde va, en verdad tiene bastante mérito, y más, si consideramos que nuestro origen está a partir de materia inerte evolucionada y compleja que, un día, hace probablemente miles de millones de años, se fraguó en estrellas muy lejanas.

A finales de los 60, un joven físico italiano, Gabriele Veneziano, buscaba un grupo de ecuaciones que explicara la fuerza nuclear fuerte. Este pegamento tan fuerte que mantenía unidos los protones y neutrones del núcleo de cada átomo. Parece ser que por casualidad se encontró con un libro antiguo de matemáticas y en su interior encontró una ecuación de más de 200 años de antigüedad creada por un matemático suizo llamado Leonhard Euler. Veneziano descubrió con asombro que las ecuaciones de Euler, consideradas desde siempre una simple curiosidad matemática, parecían describir la fuerza nuclear fuerte. Después de un año de , se podría decir, que elaboraron la Teoría de Cuerdas de manera fortuita. Tras circular entre compañeros, la ecuación de Euler acabó escrita frente a Leonard Susskind, quien se retiro a su ático para investigar. Creía que aquella antigua fórmula describía matemáticamente la fuerza nuclear fuerte, pero descubrió algo nuevo. Lo primero que descubrió fue que describía una especie de partícula con una estructura interna que vibraba y que mostraba un comportamiento que no se limitaba al de una partícula puntual. Dedujo que se trataba de una cuerda, un hilo elástico, como una goma cortada por la mitad. Esta cuerda se estiraba y contraía además de ondear y coincidía exactamente con la fórmula. Susskind redactó un artículo donde explicaba el descubrimiento de las cuerdas, pero nunca llegó a publicarse.

Muchos buscaron la 5ª dimensión… ¡sin fortuna! Aquí sólo hay tres y el espacio.

Claro que, ya he comentado otras veces que la teoría de cuerdas tiene un origen real en las ecuaciones de Einstein en las que se inspiro Kaluza para añadir la quinta dimensión y perfeccionó Klein (teoría Kaluza-Klein). La teoría de cuerdas surgió a partir de su descubrimiento accidental por Veneziano y , y a partir de ahí, la versión de más éxito es la creada por los físicos de Princeton David Gross, Emil Martinec, Jeffrey Harvey y Ryan Rohm; ellos son conocidos en ese mundillo de la física teórica como “el cuarteto de cuerdas”. Ellos han propuesto la cuerda heterótica (híbrida) y están seguros de que la teoría de cuerdas resuelve el problema de “construir la propia materia a partir de la pura geometría: eso es lo que en cierto sentido hace la teoría de cuerdas, especialmente en su versión de cuerda heterótica, que es inherentemente una teoría de la gravedad en la que las partículas de materia, tanto las otras fuerzas de la naturaleza, emergen del mismo modo que la gravedad emerge de la geometría“.

La Gravedad cuántica está en algunas mentes , ¿Estará en la Naturaleza?

La característica más notable de la teoría de cuerdas ( ya he señalado), es que la teoría de la gravedad de Einstein está contenida automáticamente en ella. De hecho, el gravitón (el cuanto de gravedad) emerge como la vibración más pequeña de la cuerda cerrada, es más, si simplemente abandonamos la teoría de la gravedad de Einstein como una vibración de la cuerda, entonces la teoría se vuelve inconsistente e inútil. , de hecho, es la razón por la que Witten se sintió inicialmente atraído hacia la teoría de cuerdas.

Witten está plenamente convencido de que “todas las ideas realmente grandes en la física, están incluidas en la teoría de cuerdas“.

No entro aquí a describir el modelo de la teoría de cuerdas que está referido a la “cuerda heterótica”, ya que su complejidad y profundidad de detalles podría confundir al lector no iniciado. Sin embargo, parece justo que deje constancia de que consiste en una cuerda cerrada que tiene dos tipos de vibraciones, en el sentido de las agujas del reloj y en el sentido contrario, que son tratadas de diferente.

Las vibraciones en el sentido de las agujas de reloj viven en un espacio de diez dimensiones. Las vibraciones de sentido contrario viven en un espacio de veintiséis dimensiones, de las que dieciséis han sido compactificadas (recordemos que en la teoría penta-dimensional Kaluza-Klein, la quinta dimensión se compactificaba curvándose en un circulo). La cuerda heterótica debe su al hecho de que las vibraciones en el sentido de las agujas de reloj y en el sentido contrario viven en dos dimensiones diferentes pero se combinan para producir una sola teoría de supercuerdas. Esta es la razón de que se denomine según la palabra griega heterosis, que significa “vigor híbrido”.

En conclusión, las simetrías que vemos a nuestro alrededor, el arcoíris a las flores y a los cristales, pueden considerarse en última instancia como manifestaciones de fragmentos de la teoría deca-dimensional original. Riemann y Einstein habían confiado en llegar a una comprensión geométrica de por qué las fuerzas pueden determinar el movimiento y la naturaleza de la materia.

La teoría de cuerdas, a partir del descubrimiento Veneziano-Suzuki, estaba evolucionando atrás buscando las huellas de Faraday, Riemann, Maxwell y Einstein poder construir una teoría de campos de cuerdas. De hecho, toda la física de partículas estaba basada en teoría de campos. La única teoría no basada en teoría de campos era la teoría de cuerdas.

De la teoría de cuerdas combinada con la supersimetría dio lugar a la teoría de supercuerdas. La cuerda es un objeto unidimensional que en nueva teoría se utiliza remplazando la idea de la partícula puntual de la teoría cuántica de campos. La cuerda se utiliza en la teoría de partículas elementales y en cosmología y se representa por una línea o lazo (una cuerda cerrada). Los estados de una partícula pueden ser producidos por ondas estacionarias a lo largo de esta cuerda.

En teoría se trata de unificar a todas las fuerzas fundamentales incorporando simetría y en la que los objetos básicos son objetos unidimensionales que tienen una escala de 10-35 metros y, como distancias muy cortas están asociadas a energías muy altas, este caso la escala de energía requerida es del orden de 1019 GeV, que está muy por encima de la que hoy en día pueda alcanzar cualquier acelerador de partículas.

Antes expliqué, las cuerdas asociadas con los bosones sólo son consistentes como teorías cuánticas en un espacio-tiempo de 26 dimensiones; aquella asociadas con los fermiones sólo lo son en un espacio tiempo de 10 dimensiones. Ya se ha explicado que las dimensiones extras, además de las normales que podemos constatar, tres de espacio y una de tiempo, como la teoría de Kaluza-Klein, están enrolladas en una distancia de Planck. De , inalcanzables.

Una de las características más atractivas de la teoría de supercuerdas es que dan lugar a partículas de espín 2, que son identificadas con los gravitones (las partículas que transportan la gravedad y que aún no se han podido localizar). Por tanto, una teoría de supercuerdas automáticamente contiene una teoría cuántica de la interacción gravitacional. Se piensa que las supercuerdas, al contrario que ocurre con otras teorías ( ellas el Modelo Estándar), están libres de infinitos que no pueden ser eliminados por renormalización, que plagan todos los intentos de construir una teoría cuántica de campos que incorpore la gravedad. Hay algunas evidencias de que la teoría de supercuerdas está libre de infinitos, pero se está a la búsqueda de la prueba definitiva.

Aunque no hay evidencia directa de las supercuerdas, algunas características de las supercuerdas son compatibles con los hechos experimentales observados en las partículas elementales, como la posibilidad de que las partículas no respeten paridad, lo que en efecto ocurre en las interacciones débiles.

Extrañas configuraciones a las que, algunos físicos, le quieren sacar lo que seguramente no se encuentra en ellas, ¿Cómo representar dimensiones inexistentes? Al menos para nuestro conocimiento actual.

Estoy convencido de que la teoría de supercuerdas será finalmente corroborada por los hechos y, ello, se necesitará algún tiempo; no se puede aún comprobar ciertos parámetros teóricos que esas complejas matemáticas a las que llaman topología nos dicen que son así.

Habrá que tener siempre a mano las ecuaciones de Einstein, las funciones modulares de Ramanujan y el Super-tensor métrico de ese genio matemático que, al igual que Ramanujan, fue un visionario llamado Riemann.

Las historias de estos dos personajes, en cierto modo, son muy parecidas. Tanto Riemann como Ramanujan murieron antes de cumplir los 40 años y, también en ambos casos, en difíciles. Estos personajes desarrollaron una actividad matemática sólo comparable al trabajo de toda la vida de muchos buenos matemáticos.

¿Cómo es posible que, para proteger la simetría conforme original por su destrucción por la teoría cuántica, deben ser milagrosamente satisfechas cierto número de identidades matemáticas, que precisamente son las identidades de la función modular de Ramanujan?

En este trabajo he expresado que las leyes de la naturaleza se simplifican cuando se expresan en dimensiones más altas. Sin embargo, a la luz de la teoría cuántica, debo corregir algo esta afirmación, y para decirlo correctamente debería decir: las leyes de la naturaleza se simplifican cuando se expresan coherentemente en dimensiones más altas. Al añadir la palabra coherentemente hemos señalado un punto crucial, la ligadura nos obliga a utilizar las funciones modulares de Ramanujan, que fijan en diez de dimensiones del espacio-tiempo. Esto a su vez, puede facilitarnos la clave decisiva para explicar el origen del universo.

emilio silvera

Abr

22

Conociendo la materia

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

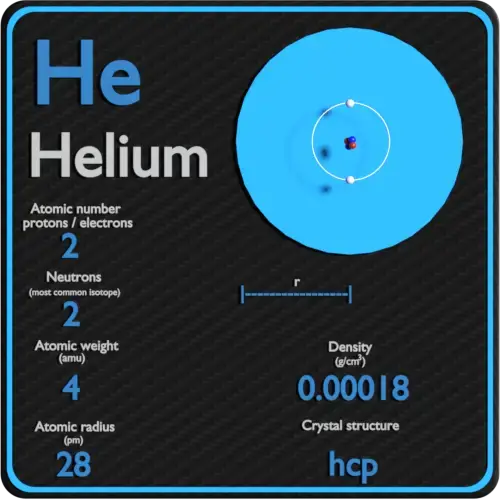

El núcleo atómico está formado por los nucleones formados por tripletes de Quarks allí confinados por la fuerza nuclear fuerte y sujeto por los Bosones llamados Gluones. El núcleo atómico contiene más del 99% de la masa del átomo.

Entre 1.906 y 1.908 (hace ahora un siglo) Rutherford realizó constantes experimentos disparando partículas alfa contra una lámina sutil de metal (como oro o platino), para analizar sus átomos. La mayor parte de los proyectiles atravesaron la barrera sin desviarse (como balas a través de las hojas de un árbol). Pero no todos. En la placa fotográfica que le sirvió de blanco tras el metal, Rutherford descubrió varios impactos dispersos e insospechados alrededor del punto central. Comprobó que algunas partículas habían rebotado. Era como si en vez de atravesar las hojas, algunos proyectiles hubiesen chocado contra algo más sólido.

Rutherford supuso que aquellas “balas” habían chocado contra una especie de núcleo denso, que ocupaba sólo una parte mínima del volumen atómico y ese núcleo de intensa densidad, desviaban los proyectiles que acertaban a chocar contra él. Ello ocurría en muy raras ocasiones, lo cual demostraba que los núcleos atómicos debían ser realmente ínfimos, porque un proyectil había de encontrar por fuerza muchos millones de átomos al atravesar la lámina metálica.

Era lógico suponer, pues, que los protones constituían ese núcleo duro. Rutherford representó los protones atómicos como elementos apiñados alrededor de un minúsculo “núcleo atómico” que servía de centro (después de todo eso, hemos podido saber que el diámetro de ese núcleo equivale a algo más de una cienmilésima del volumen total del átomo.)

En 1.908 se concedió a Rutherfor el premio Nóbel de Química, por su extraordinaria labor de investigación sobre la naturaleza de la materia. El fue el responsable de importantes descubrimientos que permitieron conocer la estructura de los átomos en esa primera avanzadilla.

Desde entonces se pueden descubrir con términos más concretos los átomos específicos y sus diversos comportamientos. Por ejemplo, el átomo de hidrógeno posee un solo electrón. Si se elimina, el protón restante se asocia inmediatamente a alguna molécula vecina; y cuando el núcleo desnudo de hidrógeno no encuentra por este medio un electrón que participe, actúa como un protón -es decir, una partícula subatómica-, lo cual le permite penetrar en la materia y reaccionar con otros núcleos si conserva la suficiente energía.

El helio, que posee dos electrones, no cede uno con tanta facilidad. Sus dos electrones forman un caparazón hermético, por lo cual el átomo es inerte. No obstante, si se despoja al helio de ambos electrones, se convierte en una partícula alfa, es decir, una partícula subatómica portadora de dos unidades de carga positiva.

Hay un tercer elemento, el litio, cuyo átomo tiene tres electrones. Si se despoja de uno o dos, se transforma en ion. Y si pierde los tres, queda reducida a un núcleo desnudo, con una carga positiva de tres unidades.

Las unidades de una carga positiva en el núcleo atómico deben ser numéricamente idéntica a los electrones que contiene como norma, pues el átomo suele ser un cuerpo neutro y esta igualdad de lo positivo con lo negativo, es el equilibrio. Y, de hecho, los números atómicos de sus elementos se basan en sus unidades de carga positiva, no en las de carga negativa, porque resulta fácil hacer variar el número de electrones atómicos dentro de la formación iónica, pero, en cambio, se encuentran grandes dificultades si se desea alterar el número de sus protones.

Apenas esbozado este esquema de la construcción atómica, surgieron nuevos enigmas. El número de unidades con carga positiva en un núcleo no equilibró, en ningún caso, el peso nuclear ni la masa, exceptuando el caso del átomo de hidrógeno. Para citar un ejemplo, se averiguó que el núcleo de helio tenía una carga positiva dos veces mayor que la del núcleo de hidrógeno; pero, como ya se sabía, su masa era cuatro veces mayor que la de este último. Y la situación empeoró progresivamente a medida que se descendía por la tabla de elementos, e incluso cuando se alcanzó el uranio, se encontró un núcleo con una masa igual a 238 protones, pero una carga que equivalía sólo a 92.

¿Cómo era posible que un núcleo que contenía cuatro protones (según se suponía del núcleo de helio) tuviera sólo dos unidades de carga positiva? Según la más simple y primera conjetura emitida, la presencia en el núcleo de partículas cargadas negativamente y con peso despreciable, neutralizaba dos unidades de su carga. Como es natural, se pensó también –en el electrón-. Se podría componer el rompecabezas si se suponía que el núcleo de helio estaba integrado por cuatro protones y dos electrones neutralizadores, lo cual deja libre una carga positiva neta de dos, y así sucesivamente, hasta llegar al uranio, cuyo núcleo tendría, pues, 238 protones y 146 electrones, con 92 unidades libres de carga positiva.

El hecho de que los núcleos radiactivos emitieran electrones (según se había comprobado ya, por ejemplo, en el caso de las partículas beta) reforzó esta idea general.

Dicha teoría prevaleció durante más de una década, hasta que, por caminos indirectos, llegó una respuesta mejor, como resultado de otras investigaciones.

Pero entretanto se había presentado algunas objeciones rigurosas contra dicha hipótesis. Por lo pronto, si el núcleo estaba constituido esencialmente de protones, mientras que los ligeros electrones no aportaban prácticamente ninguna contribución a la masa, ¿Cómo se explicaba que las masas relativas de varios núcleos no estuvieran representadas por números enteros? Según los pesos atómicos conocidos, el núcleo del átomo cloro, por ejemplo, tenía una masa 35’5 veces mayor que la del núcleo del hidrógeno. ¿Acaso significaba esto que contenía 35’5 protones? Ningún científico (ni entonces ni ahora) podía aceptar la existencia de medio protón.

Este singular interrogante encontró una respuesta incluso antes de solventar el problema principal. Y ello dio lugar a una interesante historia.

ÍSOTOPOS

Construcción de bloques uniformes

Allá por 1.816, el físico inglés William Prout había insinuado ya que el átomo de hidrógeno debía de entrar en la constitución de todos los átomos. Con el tiempo se fueron desvelando los pesos atómicos, y la teoría de Prout quedó arrinconada, pues se comprobó que muchos elementos tenían pesos fraccionarios (para lo cual se tomó el oxígeno, tipificado a 16). El cloro (según dije antes) tiene un peso atómico aproximado de 35’5, o para ser exactos, de 35’457. Otros ejemplos son el antimonio, con un peso atómico de 121’75; el bario, con 127’34; el boro, con 10’811, y el cadmio, con 112’40.

Hacia principios de siglo se hizo una serie de observaciones desconcertantes, que condujeron al esclarecimiento. El inglés William Crookes (el del “tubo Crookes) logró disociar del uranio una sustancia cuya ínfima cantidad resultó ser mucho más radiactiva que el propio uranio. Apoyándose en su experimento, afirmó que el uranio no tenía radiactividad, y que esta procedía exclusivamente de dicha impureza, que él denomino “uranio X”. Por otra parte, Henri Becquerel descubrió que el uranio purificado y ligeramente radiactivo adquiría mayor radiactividad con el tiempo, por causas desconocidas. Si se dejan reposar durante algún tiempo, se podía extraer de él repetidas veces uranio activo X. Para decirlo de otra manera: por su propia radiactividad, el uranio se convertía en el uranio X, más activo aún.

Por entonces, ivo, y cRutherfor, a su vez, separó del torio un “torio X” muy radiante comprobó también que el torio seguía produciendo más torio X. Hacia aquellas fechas se sabía ya que el más famoso de los elementos radiactivos, el radio, emitía un gas radiactivo, denominado radón. Por tanto, Rutherford y su ayudante, el químico Frederick Soddy, dedujeron que, durante la emisión de sus partículas, los átomos radiactivos de transformaban en otras variedades de átomos radiactivos.

Actinio C

Varios químicos, que investigaron tales transformaciones, lograron obtener un surtido muy variado de nuevas sustancias, a los que dieron nombres tales como radio A, radio B, mesotorio I, mesotorio II y Actinio C. Luego los agruparon todos en tres series, de acuerdo con sus historiales atómicos. Una serie de originó del uranio disociado; otra, del torio, y la tercera, del actinio (si bien más tarde se encontró un predecesor del actinio, llamado “protactinio”).

En total se identificaron unos cuarenta miembros de esas series, y cada uno se distinguió por su peculiar esquema de radiación. Pero los productos finales de las tres series fueron idénticos: en último término, todas las cadenas de sustancias conducían al mismo elemento, estable: PLOMO.

El isótopo más común del uranio es el 238, en que los 92 protones van acompañados por el germanio (32), el estaño (50) y el plomo (82).

Ahora bien, esas cuarenta sustancias no podían ser, sin excepción, elementos disociados, entre el uranio (92) y el plomo (82) había sólo diez lugares en la tabla periódica, y todos ellos, salvo dos, pertenecían a elementos conocidos.

En realidad, los químicos descubrieron que aunque las sustancias diferían entre sí por su radiactividad, algunas tenían propiedades químicas idénticas. Por ejemplo, ya en 1.907, los químicos americanos Herbert Newby Mc Coy y W.H. Ross descubrieron que el “radio-torio” (uno entre los varios productos de la desintegración del torio) mostraba el mismo comportamiento químico que el torio, y el “radio D”, el mismo que el del plomo; tanto, que era llamado a veces “radio plomo”. De todo lo cual se infirió que tales sustancias eran en realidad variedades del mismo elemento: el radio-torio, una forma de torio; el radio-plomo, un miembro de una familia de plomos, y así sucesivamente.

En 1.913, Soddy esclareció esa idea y le dio más amplitud. Demostró que cuándo un átomo emitía una partícula alfa, se transformaba en un elemento que ocupaba dos lugares más abajo en la lista de elementos, y que cuando emitía una partícula beta, ocupaba, después de su transformación, el lugar inmediatamente superior. Con arreglo a tal norma, el “radio-torio” descendería en la tabla hasta el lugar del torio, y lo mismo ocurría con las sustancias denominadas “uranio X” y “uranio Y”, es decir, que los tres serían variedades del elemento 90. Así mismo, el “radio D”, el “radio B” el “torio B” y el “actinio B” compartirían el lugar del plomo como variedades del elemento 82.

Soddy dio el nombre de “isótopos” (del griego iso y topos, “el mismo lugar”) a todos los miembros de una familia de sustancias que ocupaban el mismo lugar en la tabla periódica. En 1.921 se le concedió el premio Nóbel de Química.

El modelo protón-electrón del núcleo concordó perfectamente con la teoría de Soddy sobre los isótopos. Al retirar una partícula de dicho núcleo, exactamente lo que necesitaba para bajar dos lugares en la tabla periódica. Por otra parte, cuando el núcleo expulsaba un electrón (partícula beta), quedaba sin neutralizar un protón adicional, y ello incrementaba en una unidad la carga positiva del núcleo, lo cual era como agregar una unidad al número atómico, y, por tanto, el elemento pasaba a ocupar la posición inmediatamente superior en la tabla periódica de elementos.

¿Cómo se explica que cuando el torio se descompone en “radio-torio” después de sufrir no una, sino tres desintegraciones, el producto siga siendo torio? Pues bien, en este proceso el átomo de torio pierde una partícula alfa, luego una partícula beta y, más tarde, una segunda partícula beta. Si aceptamos la teoría sobre el bloque constitutivo de los protones, ello significa que el átomo ha perdido cuatro electrones (dos de ellos, contenidos presuntamente en la partícula alfa) y cuatro protones. (La situación actual difiere bastante de este cuadro, aunque, en cierto modo, esto no afecta al resultado.)

El núcleo de torio constaba inicialmente (según se suponía) de 232 protones y 142 electrones. Al haber perdido cuatro protones y otros cuatro electrones, quedaba reducido a 228 protones y 138 electrones. No obstante, conservaba todavía y el número atómico 90, es decir, el mismo antes.

Así, pues, el “radio-torio”, a semejanza del torio, posee 90 electrones planetarios, que giran alrededor del núcleo. Puesto que las propiedades químicas de átomo están sujetas al número de sus electrones planetarios, el torio y el “radio-torio” tienen el mismo comportamiento químico, sea cual fuere su diferencia en peso atómico (232 y 228, respectivamente).

Los isótopos de un elemento se identifican por su peso atómico, o “número másico”. Así, el torio corriente se denomina torio 232, y el “radio-torio”, torio 228. Los isótopos radiactivos del plomo se distinguen también por estas denominaciones:

Plomo 210 – Plomo 214-Plomo 212 y Plomo 211

“radio D” – “radio B” – “Torio B” y “Actinio B”

Se descubrió que la noción de isótopos podía aplicarse indistintamente tanto a los elementos estables como a los radiactivos. Por ejemplo, se comprobó que las tres series radiactivas anteriormente mencionadas terminaban en tres formas distintas de plomo. La serie del uranio acababa en plomo 206; la del torio, en el plomo 208, y la del actinio, en el plomo 207. Cada uno de estos era un isótopo estable y “corriente” del plomo, pero los tres plomos diferían por su peso atómico.

La materia tiene muchos secretos que están por desvelar, y, no dejamos de investigar para poder llegar a las respuestas planteadas que, de momento, no han tenido contestación.

emilio silvera

Abr

22

Conociendo la materia II

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Un isótopo estable es un nucleido que no es radiactivo (a diferencia de los radionucleidos), por lo que no experimenta de forma espontánea decaimiento radiactivo. Un elemento químico tiene uno o varios isótopos, de los cuales todos, algunos o ninguno, pueden ser estables. Los isótopos que no son estables (radioisótopos), a diferencia de los estables, se desintegran para dar lugar a otros nucleidos emitiendo partículas o radiación electromagnética.

Se conocen 2.500 nucleidos, de los cuales son estables menos de 300. La representación del número de neutrones (N) frente al número de protones (número atómico, Z) indicándose los isótopos estables se denomina carta de Sagre‘. Un ejemplo que podemos pomer es que el Tecnecio no tiene ningún isótopo estable, mientras que el estaño tiene diez isótopos estables.

Francis William Aston y el esquema de su invento

Mediante un dispositivo inventado por cierto ayudante de J.J. Thomson, llamado Francis William Aston, se demostró la existencia de los isótopos estables. En 1.919, Thomson, empleando la versión primitiva de aquel artilugio, demostró que el neón estaba constituido por dos variedades de átomos: una cuyo número de masa era 20, y otra, 22. El neón 20 era el isótopo común; el neón 22 lo acompañaba en la proporción de un átomo por cada diez. (Mas tarde se descubrió un tercer isótopo, el neón 21, cuyo porcentaje en el neón atmosférico era de un átomo por cada 400.)

Entonces fue posible, al fin, razonar el peso atómico fraccionario de los elementos. El peso atómico del neón (20, 183) representaba el peso conjunto de los tres isótopos, de pesos diferentes, que integraban, el elemento en su estado natural. Cada átomo individual tenía un número másico entero, pero el promedio de sus masas –el peso atómico- era un número fraccionario.

Aston procedió a mostrar que varios elementos estables comunes eran, en realidad, mezclas de isótopos. Descubrió que el cloro, con un peso atómico fraccionario de 35’453, estaba constituido por el cloro 35 y el cloro 37, en la “proporción” de cuatro a uno. En 1.922 se le otorgó el premio Nóbel de Química.

El Uranio 235 es combustible nuclear, el uranio 238 no lo es. Sin embargo, si ponemos uranio 238 en la base de un reactor generador y lo bombardeamos con neutrones lentos del uranio 235, el resultado será que se convierte en Plutonio 239 que sí es válido como combustible nuclear. El Uranio 235 solo supone el 7 por mil del Uranio de la Tierra, el resto es uranio 238.

En el discurso pronunciado al recibir el premio, Aston predijo la posibilidad de aprovechar la energía almacenada en el núcleo atómico, vislumbrando ya las futuras y nefastas bombas y centrales nucleares. Allá por 1.935, el físico canadiense Arthur Jeffrey Dempster empleó el instrumento de Aston para avanzar sensiblemente en esa dirección. Demostró que, si bien 993 de cada 1.000 átomos de uranio grande uranio 238 (no válido para combustible nuclear), los siete restantes eran uranio 235 (buen combustible nuclear). Y, muy pronto se haría evidente el profundo significado de tal descubrimiento.

Así, después de esta siguiendo huellas falsas durante un siglo, se reivindicó definitivamente la teoría de Prout. Los elementes estaban constituidos por bloques estructurales uniformes; si no átomos de hidrógeno, sí, por lo menos, unidades con masa de hidrógeno.

¿Qué no será capaz de inventar el hombre para descubrir los misterios de la naturaleza?

Ha pasado mucho tiempo desde que Rutherford identificara la primera partícula nuclear (la partícula alfa). El camino ha sido largo y muy duro, con muchos intentos fallidos antes de ir consiguiendo los triunfos (los únicos que suenan), y muchos han sido los nombres que contribuyeron para conseguir llegar al conocimiento del átomo y del núcleo actual: Los electrones circulando alrededor del núcleo, en sus distintos niveles, con un núcleo compuesto de protones y neutrones que, a su vez, son constituidos por los quarks allí confinados por los gluones, las partículas mediadoras de la fuerza nuclear fuente.

Pero ¿Qué habrá más allá de los quarks?

¿Las supercuerdas vibrantes?

¡Algún día se sabrá!

Partículas

El Universo de las partículas es fascinante. Cuando las partículas primarias chocan con átomos y moléculas en el aire, aplastan sus núcleos y producen toda clase de partículas secundaria. En esta radiación secundaria (aún muy energética) la que detectamos cerca de la Tierra, por los globos enviados a la atmósfera superior han registrado la radiación primaria.

El físico estadounidense Robert Andrews Millikan, que recogió una gran cantidad de información acerca de esta radiación (y que le dio el nombre de rayos cósmicos), decidió que debería haber una clase de radiación electromagnética. Su poder de penetración era tal que, parte del mismo, atravesaba muchos centímetros de plomo. Para Millikan, esto sugería que la radiación se parecía a la de los penetrantes rayos gamma, pero con la longitud de onda más corta.

Los rayos cósmicos que consiguen llegar a la superficie del planeta tienen consecuencia para nosotros

Otros, sobre todo el físico norteamericano Holly Compton, no estaban de acuerdo en que los rayos cósmicos fuesen partículas. Había un medio para investigar este asunto. Si se trataba de partículas cargadas, deberían ser rechazadas por el campo magnético de la Tierra al aproximarse a nuestro planeta desde el espacio exterior. Compton estudió las mediciones de la radiación cósmica en varias latitudes y descubrió que en realidad se curvaban con el campo magnético: era más débil cerca del ecuador magnético y más fuerte cerca de los polos, donde las líneas de fuerza magnética se hundían más en la Tierra.

Las partículas cósmicas primarias, cuando entran en nuestra atmósfera llevan consigo unas energías fantásticas, muy elevadas. En general, cuanto más pesado es el núcleo, más raro resulta entre las partículas cósmicas. Núcleos tan complejos como los que forman los átomos de hierro se detectaron con rapidez, en 1.968, otros núcleos tan complejos como los del uranio. Los núcleos de uranio constituyen sólo una partícula entre 10 millones. También se incluirán aquí electrones de muy elevada energía.

Ahora bien, la siguiente partícula inédita –después del neutrón- se descubrió en los rayos cósmicos. A decir verdad, cierto físico teórico había predicho ya este descubrimiento.

Paul Adrien Maurice Dirac había aducido, fundándose en un análisis matemático de las propiedades inherentes a las partículas subatómicas, que cada partícula debería tener su “antipartícula”. (Los científicos desean no sólo que la Naturaleza sea simple, sino también simétrica.) Así pues, debería haber un “antielectron”, salvo por su carga, que sería positiva, y no negativa, idéntico al electrón, y un “antiprotón” con carga negativa en vez de positiva.

En 1.930, cuando Dirac expuso su teoría, no llamó demasiado la atención en el mundo de la ciencia. Pero, fiel a la cita, dos años después apareció el “anti-electron”. Por entonces, el físico americano Carl David Anderson trabajaba con Millikan, en un intento por averiguar si los rayos cósmicos eran radiación electromagnética o partículas. Por aquellas fechas, casi todo el mundo estaba dispuesto a aceptar las pruebas presentadas por Compton, según las cuales, se trataría de partículas cargadas; pero Millikan no acababa de darse por satisfecho con tal solución.

Anderson se propuso averiguar si los rayos cósmicos que penetraban en una cámara de ionización se curvaban bajo la acción de un potente campo magnético. Al objeto de frenar dichos rayos lo suficiente como para detectar la curvatura, si la había, puso en la cámara una barrera de plomo de 6’35 mm de espesor. Descubrió que, cuando causaba el plomo, la radiación cósmica trazaba una estela curva a través de la cámara. Y descubrió algo más. A su paso por el plomo, los rayos cósmicos energéticos arrancaban partículas de los átomos de plomo. Una de esas partículas dejó una estela similar a la del electrón. ¡Allí estaba, pues, el “antielectron” de Dirac! Anderson le dio el nombre de “positrón”. Tenemos aquí un ejemplo de radiación secundaria producida por rayos cósmicos. Pero aún había más, pues en 1.963 se descubrió que los positrones figuraban también entre las radiaciones primarias.

Abandonado a sus propios medios, el positrón es tan estable como el electrón (¿y por qué no habría de serlo, si es idéntico al electrón, excepto en su carga eléctrica?). Además, su existencia puede ser indefinida. Ahora bien, en realidad no queda abandonado nunca a sus propios medios, ya que se mueve en un universo repleto de electrones. Apenas inicia su veloz carrera (cuya duración ronda la millonésima de segundo), se encuentra ya con uno.

Así, durante un momento relampagueante quedaran asociados el electrón y el positrón; ambas partículas girarán en torno a un centro de fuerza común. En 1.945, el físico americano Arthur Edwed Ruaark sugirió que se diera el nombre de “positronio” a este sistema de dos partículas, y en 1.951, el físico americano de origen austriaco Martín Deutch consiguió detectarlo guiándose por los rayos gamma característicos del conjunto.

Pero no nos confundamos, aunque se forme un sistema positronio, su existencia durará, como máximo, una diezmillonésima de segundo. El encuentro de electrón-positrón=aniquilamiento mutuo, solo queda energía en forma de radiación gamma. Ocurre pues, tal como había sugerido Einstein: la materia puede convertirse en energía y viceversa. Por cierto que Anderson consiguió detectar muy pronto el fenómeno inverso: desaparición súbita de los rayos gamma, para dar origen a una pareja electrón-positrón. Este fenómeno se llama “producción en pareja.” Anderson compartió con Hess el premio Nóbel de Física de 1.936.

Poco después, los Joliot-Curie detectaron el positrón por otros medios, y, al hacerlo así, realizaron, de paso, un importante descubrimiento. Al bombardear los átomos de aluminio con partículas alfa, descubrieron que con tal sistema no solo se obtenían protones, sino también positrones. Cuando suspendieron el bombardeo, el aluminio siguió emitiendo positrones, emisión que sólo con el tiempo se debilitó.

Aparentemente habían creado, sin proponérselo, una nueva sustancia radiactiva.

He aquí la interpretación de lo ocurrido, según los Joliot-Curie: Cuando un núcleo de aluminio absorbe una partícula alfa, la adición de los dos protones transforma el aluminio (nº atómico 13 en fósforo (nº atómico 15). Puesto que las partículas alfa contienen cuatro nucleones en total, el número masivo se eleva 4 unidades, es decir, del aluminio 27, al fósforo 31. Ahora bien, si al reaccionar se expulsa un protón de ese núcleo, la reducción en una unidad de sus números atómicos y masivos hará surgir otro elemento, o sea, el silicio 30.

Puesto que la partícula alfa es el núcleo del helio, y un protón es el núcleo del hidrógeno, podemos escribir la siguiente ecuación de esta “reacción nuclear”:

aluminio 27+helio4®silicio30+hidrogeno1

Nótese que los números másicos de equilibran:

27+4= a 30+1

Adentrarse en el Universo de las partículas que componen los elementos de la Tabla periódica, y, en definitiva, la materia conocida, es verdaderamente fantástico.

emilio silvera

Abr

20

Las moléculas portadoras de información

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Representación esquemática de la molécula de ADN y ARN, la molécula portadora de la información genética. Las moléculas se forman por la Asociación de dos o más átomos, que se mantienen juntas por medio de enlaces químicos. Podríamos decir que algunas moléculas de vida serían:

Los microARNs son moléculas de ARN que regulan la expresión génica uniéndose a un ARN mensajero (ARNm) determinado, impidiendo que se traduzca a proteína2.

La molécula de ADN consiste en dos cadenas que se enrollan entre ellas para formar una estructura de doble hélice. Cada cadena tiene una parte central formada por azúcares (desoxirribosa) y grupos fosfato. Enganchado a cada azúcar hay una de de las siguientes 4 bases: adenina (A), citosina (C), guanina (G), y timina (T). Las dos cadenas se mantienen unidas por enlaces entre las bases; la adenina se enlaza con la timina, y la citosina con la guanina. La secuencia de estas bases a lo largo de la cadena es lo que codifica las instrucciones para formar proteínas y moléculas de ARN.

– Agua.

– Hidratos de carbono.

– Lípidos.

– Proteínas.

– Acidos Nucleicos.

Principios inmediatos o biomoléculas: cada una de las sustancias que componen la materia viva.

– Simples: O2

– inorgánicos: agua…

– Compuestos:

– orgánicos: glúcidos, lípidos,

proteínas, ac. nucleicos

La enorme variedad de formas, colores, comportamientos, etc que acompaña a los objetos, incluidos los vivientes, sería una consecuencia de la riqueza en la información que soportan las moléculas (y sus agregados) que forman parte de dichos objetos. Ello explicaría que las moléculas de la vida sean en general de grandes dimensiones (macromoléculas). La inmensa mayoría de ellas contiene carbono. Debido a su tetravalencia y a la gran capacidad que posee dicho átomo para unirse consigo mismo, dichas moléculas pueden considerarse como un esqueleto formado por cadenas de esos átomos.

El carbono no es el único átomo con capacidad para formar los citados esqueletos. Próximos al carbono en la tabla periódica, el silicio, fósforo y boro comparten con dicho átomo esa característica, si bien en un grado mucho menor. Refiriéndonos al silicio, señalaremos que las “moléculas” que dicho átomo forma con el oxígeno y otros átomos, generalmente metálicos poseyendo gran nivel de información, difieren en varios aspectos de las moléculas orgánicas, es decir, de las que poseen un esqueleto de átomos de carbono.

El mundo de los silicatos es de una gran diversidad, existiendo centenares de especies minerológicas. Esas diferencias se refieren fundamentalmente a que el enlace químico en el caso de las moléculas orgánicas es covalente, y cuando se forma la sustancia correspondiente (cuatrillones de moléculas) o es un líquido, como es el caso de los aceites, o bien un sólido que funde fácilmente. Entre las moléculas que lo forman se ejercen unas fuerzas, llamadas de Van der Waals, que pueden considerarse como residuales de las fuerzas electromagnéticas, algo más débiles que éstas. En cambio, en los silicatos sólidos (como en el caso del topacio) el enlace covalente o iónico no se limita a una molécula, sino que se extiende en el espacio ocupado por el sólido, resultando un entramado particularmente fuerte.

Al igual que para los cristales de hielo, en la mayoría de los silicatos la información que soportan es pequeña, aunque conviene matizar este punto. Para un cristal ideal así sería en efecto, pero ocurre que en la realidad el cristal ideal es una abstracción, ya que en el cristal real existen aquí y allá los llamados defectos puntuales que trastocan la periodicidad espacial propia de las redes ideales. Precisamente esos defectos puntuales podían proporcionar una mayor información.

El cristal ideal no existe, en su estado natural, todos tienen imperfecciones y, sólo el elaborado, se podría decir que son cristales perfectos y, sin embargo, la mano del hombre lo que ha producido con tal intervención es perder una valiosa información inserta en ese cuerpo natural.

Si prescindimos de las orgánicas, el resto de las moléculas que resultan de la combinación entre los diferentes átomos no llega a 100.000, frente a los varios millones de las primeras. Resulta ranozable suponer que toda la enorme variedad de moléculas existentes, principalmente en los planetas rocosos, se haya formado por evolución de los átomos, como corresponde a un proceso evolutivo. La molécula poseería mayor orden que los átomos de donde procede, esto es, menor entropía. En su formación, el ambiente se habría desordenado al ganar entropía en una cierta cantidad tal, que arrojarse un balance total positivo.

No puedo dejar pasar la oportunidad, aunque sea de pasada, de mencionar las sustancias.

Las así llamadas, son cuerpos formados por moléculas idénticas, entre las cuales pueden o no existir enlaces químicos. Veremos varios ejemplos. Las sustancias como el oxígeno, cloro, metano, amoníaco, etc, se presentan en estado gaseoso en condiciones ordinarias de presión y temperatura. Para su confinamiento se embotellan, aunque existen casos en que se encuentran mezcladas en el aire (os podéis dar una vueltecita por el polo químico de Huelva en España).

En cualquier caso, un gas como los citados consiste en un enjambre de las moléculas correspondientes. Entre ellas no se ejercen fuerzas, salvo cuando colisionan, lo que hacen con una frecuencia que depende de la concentración, es decir, del número de ellas que están concentradas en la unidad de volumen; número que podemos calcular conociendo la presión y temperatura de la masa de gas confinada en un volumen conocido.

Nubes moleculares en Orión

Decía que no existen fuerzas entre las moléculas de un gas. En realidad es más exacto que el valor de esas fuerzas es insignificante porque las fuerzas residuales de las electromagnéticas, a las que antes me referí, disminuyen más rápidamente con la distancia que las fuerzas de Coulomb; y esta distancia es ordinariamente de varios diámetros moleculares.

Podemos conseguir que la intensidad de esas fuerzas aumente tratando de disminuir la distancia media entre las moléculas. Esto se puede lograr haciendo descender la temperatura, aumentando la presión o ambas cosas. Alcanzada una determinada temperatura, las moléculas comienzan a sentir las fuerzas de Van der Waals y aparece el estado líquido; si se sigue enfriando aparece el sólido. El orden crece desde el gas al líquido, siendo el sólido el más ordenado. Se trata de una red tridimensional en la que los nudos o vértices del entramado están ocupados por moléculas.

Todas las sustancias conocidas pueden presentarse en cualquiera de los tres estados de la materia (estados ordinarios y cotidianos en nuestras vidas del día a día).

El Plasma de las estrellas y otros cuerpos estelares forman el estado más común de la materia en nuestro Universo -al menos la que vemos-

Si las temperaturas reinantes, son de miles de millones de grados, el estado de la materia es el plasma, el material más común del universo, el de las estrellas (aparte de la materia oscura, que no sabemos ni lo que es, ni donde está, ni que “estado” es el suyo).

En condiciones ordinarias de presión, la temperatura por debajo de la cual existe el líquido y/o sólido depende del tipo de sustancia. Se denomina temperatura de ebullición o fusión la que corresponde a los sucesivos equilibrios (a presión dada) de fases: vapor ↔ líquido ↔ sólido. Estas temperaturas son muy variadas, por ejemplo, para los gases nobles son muy bajas; también para el oxígeno (O2) e hidrógeno (H2). En cambio, la mayoría de las sustancias son sólidos en condiciones ordinarias (grasas, ceras, etc).

Compuestas:

Las sustancias pueden ser simples y compuestas, según que la molécula correspondiente tenga átomos iguales o diferentes. El número de las primeras es enormemente inferior al de las segundas.

El concepto de molécula, como individuo físico y químico, pierde su significado en ciertas sustancias que no hemos considerado aún. Entre ellas figuran las llamadas sales, el paradigma de las cuales es la sal de cocina.

Es requerida por el organismo para mantener la volemia y procurar el adecuado equilibrio electrolítico. Además, conserva iso-tonicidad entre plasma e intersticio, así como también mantiene equilibrio con la célula. Implicada directa en el mantenimiento de la presión arterial media y en el equilibrio osmolar. Su disociación en sangre es parcial (sólo un 93 porciento).

Se trata de cloruro de sodio, por lo que cualquier estudiante de E.G.B. escribiría sin titubear su fórmula: Cl Na. Sin embargo, le podríamos poner en un aprieto si le preguntásemos dónde se puede encontrar aisladamente individuos moleculares que respondan a esa composición. Le podemos orientar diciéndole que en el gas Cl H o en el vapor de agua existen moléculas como individualidades. En realidad y salvo casos especiales, por ejemplo, a temperaturas elevadas, no existen moléculas aisladas de sal, sino una especie de molécula gigante que se extiende por todo el cristal. Este edificio de cristal de sal consiste en una red o entramado, como un tablero de ajedrez de tres dimensiones, en cuyos nudos o vértices se encuentran, alternativamente, las constituyentes, que no son los átomos de Cl y Na sino los iones Cl– y Na+. El primero es un átomo de Cl que ha ganado un electrón, completándose todos los orbitales de valencia; el segundo, un átomo de Na que ha perdido el electrón del orbital s.

Por esta zona de Huelva, conocida como Marismas del Odiel, llevaba con frecuencia a mis hijos pequeños que, jugando por aquellos parajes, se lo pasaban estupendamente, y, de camino, tenía la oportunidad de despertarles la curiosidad de cómo se producía la Sal.

Cuando los átomos de Cl y Na interaccionan por aproximarse suficientemente sus nubes electrónicas, existe un reajuste de cargas, porque el núcleo de Cl atrae con más fuerza los electrones que el de Na, así uno pierde un electrón que gana el otro. El resultado es que la colectividad de átomos se transforma en colectividad de iones, positivos los de Na y negativos los de Cl. Las fuerzas electromagnéticas entre esos iones determinan su ordenación en un cristal, el Cl Na. Por consiguiente, en los nudos de la red existen, de manera alternativa, iones de Na e iones de Cl, resultando una red mucho más fuerte que en el caso de que las fuerzas actuantes fueran de Van der Waals. Por ello, las sales poseen puntos de fusión elevados en relación con los de las redes moleculares.

emilio silvera

Totales: 84.966.084

Totales: 84.966.084 Conectados: 47

Conectados: 47