Nov

11

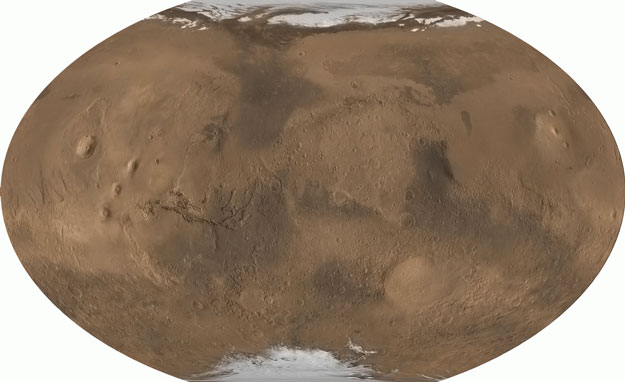

Nuestro lugar en el Universo…¿Cuál será?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Robert Dicke era su nombre y tenía los intereses científicos más amplios y diversos que imaginarse pueda, el decía que al final del camino todos los conocimientos convergen en un solo punto, el saber. No nos damos cuenta de ello pero, al final del camino, todos los conocimientos convergen y están relacionados de alguna extraña manera.

Como pregona la filosofía, nada es como se ve a primera vista, todo depende del punto de vista desde el que miremos las cosas, o, de la perspectiva que podamos tener de ellas conforme a las herramientas que tengamos a nuestra disposición, incluida la intelectual. Nosotros, que estudiamos el Universo y no lo sabemos todo de él, ya pensamos en la posible existencia de otros universos.

Si es que existen, ¿Cómo serían esos otros universos? ¿dejarían un margen para alguna forma de vida? y, de ser así, ¿Cómo serían?

“Lo primero que hay que comprender sobre los universos paralelos… es que no son paralelos. Es importante comprender que ni siquiera son, estrictamente hablando, universos, pero es más fácil si uno lo intenta y lo comprende un poco más tarde, después de haber comprendido que todo lo que ha comprendido hasta ese momento no es verdadero.”

Douglas Adams

Antes en la entrada que más arriba tenéis (“Observar la Naturaleza… da resultados”), comentaba sobre los grandes números de Dirac y lo que el personaje llamado Dicke pensaba de todo ello y, cómo dedujo que para que pudiera aparecer la biología de la vida en el Universo, había sido necesario que el tiempo de vida de las estrellas fuese el que hemos podido comprobar que es y que, el Universo, también tiene que tener, no ya las condiciones que posee, sino también, la edad que le hemos estimado.

Para terminar de repasar la forma de tratar las coincidencias de los Grandes Números por parte de Dicke, sería interesante ojear retrospectivamente un tipo de argumento muy similar propuesto por otro personaje, Alfred Wallace en 1903. Wallace era un gran científico que, como les ha pasado a muchos, hoy recibe menos reconocimiento del que se merece.

Fue él, antes que Charles Darwin, quien primero tuvo la idea de que los organismos vivos evolucionan por un proceso de selección natural. Afortunadamente para Darwin, quien, independientemente de Wallace, había estado reflexionando profundamente y reuniendo pruebas en apoyo de esta idea durante mucho tiempo, Wallace le escribió para contarle sus ideas en lugar de publicarlas directamente en la literatura científica. Pese a todo, hoy “la biología evolucionista” se centra casi porm completo en las contribuciones de Darwin.

Wallace tenía intereses muchos más amplios que Darwin y estaba interesado en muchas áreas de la física, la astronomía y las ciencias de la Tierra. En 1903 publicó un amplio estudio de los factores que hace de la Tierra un lugar habitable y pasó a explorar las conclusiones filosóficas que podrían extraerse del estado del Universo. Su libro llevaba el altisonante título de El lugar del hombre en el Universo.

Wallace, Alfred Russell (1823-1913), naturalista británico conocido por el desarrollo de una teoría de la evolución basada en la selección natural. Nació en la ciudad de Monmouth (hoy Gwent) y fue contemporáneo del naturalista Charles Darwin. En 1848 realizó una expedición al río Amazonas con el también naturalista de origen británico Henry Walter Bates y, desde 1854 hasta 1862, dirigió la investigación en las islas de Malasia. Durante esta última expedición observó las diferencias zoológicas fundamentales entre las especies de animales de Asia y las de Australia y estableció la línea divisoria zoológica -conocida como línea de Wallace- entre las islas malayas de Borneo y Célebes. Durante la investigación Wallace formuló su teoría de la selección natural. Cuando en 1858 comunicó sus ideas a Darwin, se dio la sorprendente coincidencia de que este último tenía manuscrita su propia teoría de la evolución, similar a la del primero. En julio de ese mismo año se divulgaron unos extractos de los manuscritos de ambos científicos en una publicación conjunta, en la que la contribución de Wallace se titulaba: “Sobre la tendencia de las diversidades a alejarse indefinidamente del tipo original”. Su obra incluye El archipiélago Malayo (1869), Contribuciones a la teoría de la selección natural (1870), La distribución geográfica de los animales (1876) y El lugar del hombre en el Universo (1903).

Pero sigamos con nuestro trabajo de hoy. Todo esto era antes del descubrimiento de las teorías de la relatividad, la energía nuclear y el Universo en expansión. La mayoría de los astrónomos del siglo XIX concebían el Universo como una única isla de materia, que ahora llamaríamos nuestra Vía Láctea. No se había establecido que existieran otras galaxias o cuál era la escala global del Universo. Sólo estaba claro que era grande.

Wallace estaba impresionado por el sencillo modelo cosmológico que lord Kelvin había desarrollado utilizando la ley de gravitación de Newton. Mostraba que si tomábamos una bola muy grande de materia, la acción de la gravedad haría que todo se precipitara hacia su centro. La única manera de evitar ser atraído hacia el centro era describir una órbita alrededor. El universo de Kelvin contenía unos mil millones de estrellas como el Sol para que sus fuerzas gravitatorias contrapesaran los movimientos a las velocidades observadas.

En el año 1901, Lord Kelvin solucionó cualitativa y cuantitativamente de manera correcta el enigma de la oscuridad de la noche en el caso de un universo transparente, uniforme y estático. Postulando un universo lleno uniformemente de estrellas similares al Sol y suponiendo su extensión finita (Universo estoico), mostró que, aun si las estrellas no se ocultan mutuamente, su contribución a la luminosidad total era finita y muy débil frente a la luminosidad del Sol. El demostró también que la edad finita de las estrellas prohibió la visibilidad de las estrellas lejanas en el caso de un espacio epicúreo infinito o estoico de gran extensión, lo que contestó correctamente al enigma de la oscuridad.

Lo intrigante de la discusión de Wallace sobre este modelo del Universo es que adopta una actitud no copernicana porque ve cómo algunos lugares del Universo son más propicios a la presencia de vida que otros. Como resultado, sólo cabe esperar que nosotros estemos cerca, pero no en el centro de las cosas.

Wallace da un argumento parecido al de Dicke para explicar la gran edad de cualquier universo observado por seres humanos. Por supuesto, en la época de Wallace, mucho antes del descubrimiento de las fuentes de energía nuclear, nadie sabía como se alimentaba el Sol, Kelvin había argumentando a favor de la energía gravitatoria, pero ésta no podía cumplir la tarea.

En la cosmología de Kelvin la Gravedad atraía material hacia las regiones centrales donde estaba situada la Vía Láctea y este material caería en las estrellas que ya estaban allí, generando calor y manteniendo su potencia luminosa durante enormes períodos de tiempo. Aquí Wallace ve una sencilla razón para explicar el vasto tamaño del Universo.

“Entonces, pienso yo que aquí hemos encontrado una explicación adecuada de la capacidad de emisión continuada de calor y luz por parte de nuestro Sol, y probablemente por muchos otros aproximadamente en la misma posición dentro del cúmulo solar. Esto haría que al principio se agregasen poco a poco masas considerables a partir de la materia difusa en lentos movimientos en las porciones centrales del universo original; pero en un período posterior serían reforzadas por una caída de materia constante y continua desde sus regiones exteriores a velocidades tan altas como para producir y mantener la temperatura requerida de un sol como el nuestro, durante los largos períodos exigidos para el continuo desarrollo de la vida.”

Vallace ve claramente la conexión entre estas inusuales características globales del Universo y las condiciones necesarias para que la vida evolucione y prospere en un planeta como el nuestro alumbrado por una estrella como nuestro Sol. Wallace completaba su visión y análisis de las condiciones cósmicas necesarias para la evolución de la vida dirigiendo su atención a la geología y la historia de la Tierra. Aquó ve una situación mucho más complicada que la que existe en astronomía. Aprecia el cúmulo de accidentes históricos marcados por la vía evolutiva que ha llegado hasta nosotros, y cree “improbable en grado máximo” que el conjunto completo de características propicias para la evolución de la vida se encuentre en otros lugares. Esto le lleva a especular que el enorme tamaño del Universo podría ser necesario para dar a la vida una oportunidad razonable de desarrollarse en sólo un planeta, como el nuestro, independientemente de cuan propicio pudiera ser su entorno local:

Vallace ve claramente la conexión entre estas inusuales características globales del Universo y las condiciones necesarias para que la vida evolucione y prospere en un planeta como el nuestro alumbrado por una estrella como nuestro Sol. Wallace completaba su visión y análisis de las condiciones cósmicas necesarias para la evolución de la vida dirigiendo su atención a la geología y la historia de la Tierra. Aquó ve una situación mucho más complicada que la que existe en astronomía. Aprecia el cúmulo de accidentes históricos marcados por la vía evolutiva que ha llegado hasta nosotros, y cree “improbable en grado máximo” que el conjunto completo de características propicias para la evolución de la vida se encuentre en otros lugares. Esto le lleva a especular que el enorme tamaño del Universo podría ser necesario para dar a la vida una oportunidad razonable de desarrollarse en sólo un planeta, como el nuestro, independientemente de cuan propicio pudiera ser su entorno local:

“Un Universo tan vasto y complejo como el que sabemos que existe a nuestro alrededor, quizá haya sido absolutamente necesario … para producir un mundo que se adaptase de forma precisa en todo detalle al desarrollo ordenado de la vida que culmina en el hombre.”

Hoy podríamos hacernos eco de ese sentimiento de Wallace. El gran tamaño del Universo observable, con sus 1080 átomos, permite un enorme número de lugares donde puedan tener lugar las variaciones estadísticas de combinaciones químicas que posibilitan la presencia de vida. Wallace dejaba volar su imaginación que unía a la lógica y, en su tiempo, no se conocían las leyes fundamentales del Universo, que exceptuando la Gravedad de Newton, eran totalmente desconocidas. Así, hoy jugamos con la ventaja de saber que, otros muchos mundos, al igual que la Tierra, pueden albergar la vida gracias a una dinámica igual que es la que, el ritmo del Universo, hace regir en todas sus regiones. No existen lugares privilegiados.

emilio silvera

Nov

11

La Naturaleza, nunca podremos doblegarla

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Nos empeñamos una y otra vez en querer sobrepasar nuestras posibilidades y, tenemos que pensar que, es la Naturaleza la que marca el ritmo de nuestras vidas y de nuestro tiempo, no al revés. El Universo tiene una mecánica que está regida por las fuerzas fundamentales de la Naturaleza y sus constantes y, nosotros, sólo podemos adaptarnos al mendio si queremos sobrevivir. Existen fuerzas y energías que nunca podremos controlar. Aquí mismo en la Tierra, considerada como Sistema cerrado, existen leyes y reglas inalterables, como lo son la rotación y traslación del planeta, la temperatura del núcleo, el magnetismo, las estaciones que rigen en la superficie, los océanos y los desiertos… Todo influye en el devenir de nuestras vidas sin que nosotros, pobres mortales, lo podamos evitar.

Sí, la Naturaleza nos muestra constantemente su poder. Fenómenos que no podemos evitar y que nos hablan de unos mecanismos que no siempre comprendemos. Nuestro planeta por ejemplo, se comporta como si de un ser vivo se tratara, la llaman Gaia y realiza procesos de reciclaje y renovación por medio de terremotos y erupciones volcánicas, Tsunamis y tornados devastadores que cambian el paisaje y nosotros, lo único podemos hacer es acatar el destino que ignoramos de lo que está por venir.

El mundo nos parece un lugar complicado. Sin embargo, existen algunas verdades sencillas que nos parecen eternas, no varían con el paso del tiempo (los objetos caen hacia el suelo y no hacia el cielo, el Sol se levanta por el Este, nunca por el Oeste, nuestras vidas, a pesar de las modernas tecnologías, están todavía con demasiada frecuencia a merced de complicados procesos que producen cambios drásticos y repentinos. La predicción del tiempo atmosférico es más un arte que una ciencia, los terremotos y las erupciones volcánicas se producen de manera impredecible y aparentemente aleatoria, los cambios en las Sociedades fluctúan a merced de sucesos que sus componentes no pueden soportar y exigen el cambio.

La inmensa complejidad que está presente en el cerebro humano y de cómo se genera lo que llalamos “la mente”, a partir de una maraña de conexiones entre más de cien mil millones de neuronas, más que estrellas existen en nuestra Galaxia, la Vía Láctea. Es algo grande que, en realidad, no hemos alcanzado a comprender. Nos empeñamos en querer dominar fuerzas que no conocemos y, nuestro empeño nos podría llevar a la propia destrucción.

La mente humana es de tal complejidad que no hemos podido llegar a comprender su funcionamiento. ¿Por qué unas personas tienen una gran facilidad para tocar el piano, otros para comprender las matemáticas complejas y algunos para ver lo que nadie ha sido capaz de detectar en el ámbito de la Naturaleza, pongamos por ejemplo un paisaje, o, llegar a comprender fenómenos físicos que configuran el mundo, el Universo y la vida?

Es precisamente a escala humana, donde se dan las características (posiblemente) más complejas del Universo, las que se resisten más a rendirse ante métodos y reglamentos fijos que las pretenda mantener estáticas e inamovibles por el interés de unos pocos. Las Sociedades son dinámicas en el tiempo y en el espacio y, su natural destino es el de evolucionar siempre, el de buscar las respuestas a cuestiones para ellas desconocidas y que al estar inmersas en el corazón de la Naturaleza, se sirven de la Ciencia para poder llegar al lugar más secreto y arrancar esas respuestas que tanto, parecen necesitar para continuar hacia el futuro.

Claro que, ese futuro, no depende de esas Sociedades Humanas que de alguna manera, están a merced de sucesos como aquel de Yucatán, cuando al parecer, hace ahora 65 millones de años, perecieron los Dinosaurios que reinaron en el Planeta durante 150 millones de años hasta que llegó aquél fatídico (para ellos) pedrusco que, en realidad, posibilitó nuestra llegada.

Aquellos terribles animales que poblaban la Tierra hubiera hecho imposible nuestra presencia en el planeta. Formas de vida incompatibles con nuestra especie que desaparecieron -según parece- por causas naturales venidas del espacio exterior para que más tarde, pudiéramos nosotros hacer acto de presencia en el planeta que nos acoge.

Aquello se considera una extinción masiva ocurrida en la Tierra, algo tan claramente reflejado en el registro fósil que se utiliza para marcar el final de un período de tiempo geológico, el Cretáseo, y el comienzo de otro, el Terciario. Puesto que la “C” ya se ha utilizado como inicial en un contexto similar en relación con el período Cámbrico, este marcador se suele denominar frontera K-T, con una “K” de Kreide, que es el nombre del Cretáceo en alemán. No fueron solos los dinosaurios los que resultaron afectados, aunque son los que aparecen con mayor protagonismo en los relatos populares cuando se habla de este desastre.

Esqueletos de dinosaurios expuestos en el Museo Real de Ontario, Canadá.

Alrededor del 70 por ciento de todas las especies que vivían en la Tierra al finales del cretáceo habían desaparecidos a principios del Terciario, lo cual indica que se trató realmente de una “extinción en masa” y explica por qué los geólogos y los paleontólogos utilizan la frontera K-T como un marcador importante en el registro fósil. Dadas las dificultades que plantean unas pruebas de tiempos tan remotos, y la lentitud con la que se acumulan los estratos geológicos, todo lo que podemos decir realmente sobre la velocidad a la que se produjo aquella extinción es que sucedió en menos de unas pocas decenas de miles de años, pero en ningún caso durante muchos millones de años; sin embargo, esto se considera un cambio brusco en relación con la escala de tiempo utilizada en geología.

Las preguntas obvias que esto plantea son las mismas que surgen tras un gran terremoto -por qué sucedió, y si podría suceder de nuevo y, en su caso, cuándo- En el caso del suceso K-T hay un candidato muy adecuado para ser el desencadenante que hizo que la extinción se produjera, por ejemplo, hace 60 0 55 millones de años. Los restos del enorme cráter que data justo de entonces ha sido descubierto bajo lo que es ahora la península de Yucatán, en Méjico, y por todo el mundo se han hallado estratos de hace 65 millones de años que contienen restos de iridio, un metal pesado que es raro en la corteza terrestre, pero del que sabemos que es un componente de algunos tipos de meteoritos. La capa de iridio es tan delgada que tuvo que depositarse en menos de 10.000 años (quizá mucho menos), lo cual es coherente con la teoría de que el suceso K-T fue desencadenado en su totalidad, de manera más o menos instantánea, por un gran golpe que llegó del espacio interestelar.

La catástrofe está servida

No sería difícil explicar por que pudo suceder todo esto. La energía cinética contenida en un impacto de este calibre sería equivalente a la explosión de unos mil millones de megatoneladas de TNT y arrojaría al espacio unos detritos en forma de grandes bloques que se desplazarían siguiendo trayectorias balísticas (como las de los misiles balísticos intercontinentales) y volverían a entrar en la atmósfera por todo el globo terráqueo, difundiendo calor y aumentando la temperatura en todas las regiones. Se produciría un efecto de calentamiento de 10 kilowatios por cada metro cuadrado de la superficie terrestre durante varias horas, un fenómeno que ha sido descrito gráficamente por Jay Melosh. A continuación, unas diminutas partículas de polvo lanzadas al interior de la parte superior de la atmósfera se extendería alrededor del todo el planeta y, combinada con el humo de todos los incendios desencadenados por el “asado a la parrilla”, bloquearían el paso de la luz del Sol, causando la muerte de todas las plantas que dependían de la fotosíntesis y congelando temporalmente el planeta.

Si el planeta se congela, ¿Dónde nos meteremos? ¿Cuantas criaturas tendrán la oportunidad de sobrevivir?

Hay pruebas de que, en épocas pasadas, la Tierra sufrió visitas inesperadas desde el espacio que trajo muerte y desolación. Hace unos 35 millones de años, la Tierra soportó unos impactos parecidos sin que se produjera una extinción del calibre del suceso K-T. Aunque los factores desencadenantes tengan la misma magnitud. Por otra parte, existen pruebas de que los Dinosaurios y otras especies estaban ya en decadencia en los dos últimos millones de años del Cretáceo. Parece que los grandes lagartos habían experimentado altibajos durante los 150 millones de años que se pasaron vagando por la Tierra. Hay opiniones para todos y algunos dicen que su desaparición se debió, en realidad, al aumento del Oxígeno en nuestra atmósfera.

Extinción masiva del Cretácico-Paleógeno – Wikipedia, la enciclopedia libre

El suceso K-T es en realidad sólo una entre cinco catástrofes similares (en la medida en que afectó en aquella época a la vida en la Tierra) a las que los geólogos denominan en conjunto las “cinco grandes” -y no es en absoluto la mayor-. Cada una de ellas se utiliza como marcador entre períodos geológicos y todas han sucedido durante los últimos 600 millones de años.

La razón por la que nos centramos en este pasado geológico relativamente reciente es que fue en esa época cuando los seres vivos desarrollaron por primera vez algunas características, tales como las conchas, que podían fosilizarse fácilmente, dejando rastros que pueden reconocerse en los estratos que se estudian en la actualidad.

Nuevas especies de fósiles de invertebrados marinos, que vivieron hace 465 millones de años, se han hallado en diversos yacimientos de la provincia de Ciudad Real en España, y, por todas partes del mundo, si se profundiza en la Tierra, se encuentran fósiles y conchas de tiempos pasados. En la imagen recreada arriba se recoge el descubrimiento especies nuevas, de animales marinos con concha que han posibilitado su hallazgo después de tantos millones de años.

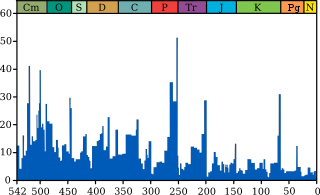

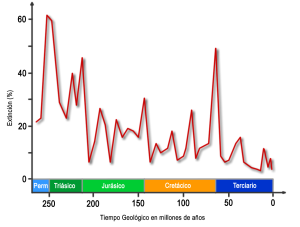

Pero centrémonos en las “cinco grandes extinciones” que, tomándolas cronológicamente se produjeron hace unos 440 millones de años (que marcaron la frontera entre los períodos Ordovícico y Silúrico), hace 360 millones de años (entre el Devónico y el Carbonífero), 250 millones de años (entre el Pérmico y el Triásico), 215 millones de años (en la frontera entre el Triásico y el Jurásico) y 65 millones de años (en la frontera K-T).

Millones de años

Intensidad de la extinción marina a través del tiempo. El gráfico azul muestra el porcentaje aparente (no el número absoluto) de los géneros de animales marinos extintos durante un determinado intervalo de tiempo. Se muestran las ultimas cinco grandes extinciones masivas.

Hay otras muchas extinciones en el registro fósil pero, las más importantes son las mencionadas. La más espectacular de todas ellas es el suceso que tuvo lugar hace unos 250 millones de años, al final del Pérmico. Se extinguieron al menos el 80 por ciento, y posiblemente hasta el 95 por ciento, de todas las especies que vivían en nuestro planeta en aquellos tiempos, tanto en la tierra como en los océanos, y lo hizo durante un intervalo de menos de 100.000 años. Sin embargo, dado que también se calcula que el 99 por ciento de todas las especies que han vivido en la Tierra se han extinguido, esto significa que son el doble las que han desaparecido en sucesos de -aparente- menor importancia.

La cuestión que nos intriga es si las extinciones en masa son realmente acontecimientos especiales, de carácter diferente al de las extinciones de menor importancia, o si son el mismo tipo de suceso, pero a gran escala -¿son las extinciones de vida en la Tierra unos hechos cuya naturaleza es independiente de su magnitud, como los terremotos y todos los demás fenómenos que la Naturaleza nos envía periódicamente que dan lugar a catástrofes y pérdidas de muchas vidas? La respuesta sincera es “no lo sabemos”, pero hay bastantes evidencias como para intuir que ésta es una posibilidad muy real.

El logotipo del Movimiento por la Extinción Humana Voluntaria es un globo terráqueo sobre el que aparece la letra V y sobre ella otra pequeña tierra y el acrónimo VHEMT de Voluntary Human Extinction Movement.

Gracias a un meticuloso trabajo de investigación de Jack Sepkoski, de la Universidad de Chicago que, pudo trazar un gráfico en el que mostraba como ha fluctuado durante los últimos 600 millones de años el nivel de extinciones que se produjo en cada intervalo de cuatro millones de años.

Extinciones segun Sepkoski

El gráfico nos muestra que la muerte de los dinosaurios fue también la muerte de los invertebrados marinos. La pregunta que se puede plantear es que clase de aleatoriedad es ésta, si realmente son sucesos aleatorios. Resulta que es una ley potencial -nuestro viejo amigo, el ruido 1/f-. El origen de esta señal aleatoria, de enorme interés por su ubicuidad y propiedades matemáticas, sigue siendo un misterio, a pesar de la atención que se le ha dedicado.

Ahora bien, no parece probable que todas las extinciones de vida que han sucedido en la Tierra hayan tenido como causa impactos procedentes del espacio. Lo que parece estar diciéndonos el registro fósil es que las extinciones se producen en todas las escalas, todos los tiempos, y que (como en el caso de los terremotos) puede producirse una extinción de cualquier magnitud en cualquier época. Algunas extinciones podrían ser desencadenadas por impactos de meteoritos; otras, por períodos glaciares. Una cosa sí que nos queda clara: es necesario un gran desencadenante para que ocurra un gran suceso, y, no podemos olvidar que estamos inmersos en un Sistema Complejo -la vida en la Tierra- que es autoorganizador, se alimenta a partir de un flujo de energía, y existe al borde del Caos. Si comprendemos eso, estaremos preparados para entender lo que todo esto significa para la vida en sí misma, siempre expuesta a las fuerzas del Universo.

La Tierra es una nave espacial que recorre el universo y, en sus viajes… ¿Por qué sitios tendrá que pasar? ¿Qué peligros la acechan?

A lo largo de nuestra Historia hemos conocido situaciones de muertes masivas como por ejemplo: La Peste de la Guerra del Peloponeso (430 a.C.), La Plaga Antonina (165 y 180), La Plaga de Justiniano (541 y 542), La Peste Negra (1348 y 1350), o, La Gripe Española (1918) y, todas ellas son en realidad de origen desconocido. Esto me lleva a pensar que la Tierra, nuestro planeta, viaja por el espacio como una gran nave espacial y recorre regiones interestelares en las que no sabemos qué puede haber, y, ¿quién puede negar que al atravesar esas regiones, no estén presenten en esas esporas fuertemente acorazadasa contra la radiación que, atravesando la atmósfera terrestre se instalen tan ricamente en nuestro mundo para florecer y sembrar la muerte entre nosotros? Lo cierto es que son muchas las cosas que no sabemos.

Al contacto con la atmósfera y el agua de la Tierra, con el calor del Sol, se abren y traen desolación y muerte

De todas las maneras, no podemos negar que grandes cambios nos acechan y, como la medida del “tiempo” es distinta para la escala humana que para la del Universo, en cualquier momento podrá tener lugar un acontecimiento de índole diversa (la caída de un meteorito, una pandemia debastadora, cataclismos tectónicos de gran magnitud, explosiones supernovas de inmensa intensidad que barra nuestra atmósfera y siembre de radiación el planeta…) que vendrá a transformar todo lo que nosotros consideramos importante y que, para la Naturaleza, no es nada.

De todas las maneras, en una cosa sí tenemos que estar de acuerdo: ¡La vida! Esa cosa tan frágil pero…, tan fuerte, se ha resistido a desaparecer a lo largo de los millones de años que lleva en el planeta y, eso nos lleva a sospechar que, lo mismo habrá sucedido en otros lugares y la Vida, debe estar por todas partes… ¡A pesar de todo! Algunas veces no puedo evitar el pensamiento de esa pregunta: ¿Cuántas Civilizaciones estarán ahora mismo germinando en otros mundos?

emilio silvera

Nov

10

¡El Universo y la vida!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

La reproducción es un proceso biológico que permite la creación de nuevos organismos en todas las formas de vida. Además de posibilitar la formación de nuevos individuos semejantes a sus progenitores, es decir, a sus padres, asegura la continuidad de las especies a través de la reproducción.

La vida (a partir de su primer paso, del primer individuo de cada especie) viene de la misma vida por reproducción. Ha surgido en el Universo de manera espontánea y, el Azar, bajo ciertas circunstancias muy especiales que estaban presentes en lugares privilegiados del Universo, dio lugar al surgir de la vida tal como la conocemos y, posiblemente, de muchas más formas desconocidas para nosotros. Y, todo eso amigos, es Entropía Negativa. Ahora, Las características de un ser vivo son siempre una recombinación de la información genética heredada.

CONSECUENCIA LOGICA: Las variaciones dentro de una misma especie son el resultado de una gran cantidad de información genética presente ya en sus antepasados y, como consecuencia de la lógica evolución, de la aparición espontánea de nueva información genética…

Aquí, en todo su esplendor, tenemos trozos de Universo que, nos está hablando de la creación. Esas estrellas brillantes, azuladas y super-masivas que radian en el ultravioleta ionizando toda la región circundante, es un signo, inequívoco de que la vida está cerca. Elementos sencillos se transformaran en otros más complejos y, aparecerán aminoácidos y la química-biológica que hacer, mucho más tarde, que sea posible la aparición de la vida en algún mundo perdido en las profundidades de una Galaxia que, como la nuestra, tendrá otras “Tierras” y otros “Seres”.

Cuántas veces se preguntó la Humanidad: ¿Hay vida en el Universo, además de la que existe en la Tierra? Las leyes de la Física, aplicables a toda la materia y la energía, tienen sin duda un papel fundamental en la comprensión del Universo y por ello la Astrofísica ha tenido un desarrollo espectacular en los últimos tiempos a pesar de la escasez de materia como la que conocemos.

Por otro lado, como el Universo es muy grande, las densidades medias son muy bajas y la materia se encuentra normalmente en estructuras muy simples, en forma de átomos y partículas individuales. La composición química del Universo y sus procesos son por ello también importantes para comprender su evolución, dando pie al uso más o menos extendido de astro-química. Sin embargo, las moléculas complejas son relativamente raras y los organismos vivos muchísimo más. La parte Biológica del Universo que conocemos se reduce a nuestro propio planeta por lo que parece excesivo poder hablar de Astrobiología. Por qué tenemos que preocuparnos por una parte tan ínfima del Universo. Ciertamente porque los seres humanos pertenecemos a esta extraña componente y, ya que no podemos reproducir en el laboratorio el paso de la química a la biología, es en el contexto del Universo (el gran Laboratorio) y su evolución en el que podemos analizar los límites y las condiciones necesarias para que emerja la vida en cualquier sitio.

En las Nebulosas nacen las estrellas, en sus hornos nucleares se producen las transiciones de fases necesarias para crear los elementos complejos necesarios para la vida. Si alrededor de las nuevas estrellas surgen nuevos mundos, ¿por qué tras miles de millones de años de evolución no puede surgir la vida en ellos, si como existe la posibilidad, están situados en la zona habitable? Las leyes del Universo son las mismas en todas partes y, todas las regiones del Cosmos, por muy alejadas que estén, están sometidas a ellas. Si en el planeta Tierra está presente el agua corriente, una atmósfera y la vida, ¿Por qué sería diferente en otros planetas similares que a millones pululan por nuestro Universo?

La Astrobiología es una ciencia que ha surgido en la frontera entre varias disciplinas clásicas: la Astronomía, la Biología, la Física, la Química o la Geología. Su objetivo final es comprender cómo surgió la vida en nuestro Universo, cómo se distribuye y cuál es su evolución primitiva, es decir, cómo pudo establecerse en su entorno.

En otras palabras, trata de comprender el papel de la componente biológica del Universo, conectando la astrofísica y la astro-química con la biología. Intenta para ello comprende el origen de la vida. : El paso de los procesos químicos prebióticos a los mecanismos bioquímicos y a la biología propiamente dicha.

Naturalmente, en Astrobiología nos planteamos preguntas fundamentales, como la propia definición de lo que entendemos como Vida, cómo y cuándo pudo surgir en la Tierra, su existencia actual o en el pasado en otros lugares o si es un hecho fortuito o una consecuencia de las leyes de la Física. Algunas de estas cuestiones se las viene formulando la humanidad desde el principio de los tiempos, pero ahora por primera vez en la historia, los avances de las ciencias biológicas y de la exploración mediante tecnología espacial, es posible atacarlas desde un punto de vista puramente científico. Para ello, la Astrobiología centra su atención en estudiar cuáles son los procesos físicos, químicos y biológicos involucrados en la aparición de la vida y su adaptabilidad, todo ello en el contexto de la evolución y estructuración, o auto-organización, del Universo.

Muchos son los que postulan que, las galaxias espirales son auto-generadoras a través de las explosiones supernovas y, siembran el espacio interestelar de la semilla creadora de la vida, además, este proceso regenerativo crea entropía negativa tratando de luchar contra el deterioro de la galaxia como sistema cerrado que de esta forma se mantiene y perdura. Nuevas y energéticas estrellas azuladas pueblan las regiones galácticas que se llenan de promesas futuras de nuevos mundos y nuevas formas de vida.

Como cualquier otra ciencia, la Astrobiología está sujeta a la utilización del método científico y por tanto a la observación y experimentación junto con la discusión y confrontación abierta de las ideas, el intercambio de datos y el sometimiento de los resultados al arbitraje científico. La clave de la metodología de esta nueva ciencia está en la explotación de las sinergias que se encuentran en las fronteras entre las disciplinas básicas mencionadas anteriormente, una región poco definida, cuyos límites se fijan más por la terminología que por criterios epistemológicos.

Un aspecto importante de la investigación en el campo de la Astrobiología es la herramienta fundamental que representa el concepto de complejidad. La vida es un proceso de emergencia del orden a partir del caos que puede entenderse en medios no aislados y, por tanto libres de la restricción de la segunda ley de la termodinámica, como un proceso complejo. En este sentido, la emergencia de patrones y regularidades en el Universo, ligados a procesos no lineales, y el papel de la auto-organización representan aspectos esenciales para comprender el fenómeno de la vida. Transiciones de estado, intercambios de información, comportamientos fuera de equilibrio, cambios de fase, eventos puntuales, estructuras auto-replicantes, o el propio crecimiento de la complejidad, cobran así pleno sentido en Astrobiología.

Muchos han sido, a lo largo de la historia de la Humanidad, los que visionaron el futuro que nos espera: “Yo puedo imaginar un infinito número de mundos parecidos a la Tierra, con un jardín del Edén en cada uno”. Lo afirmaba Giordano Bruno a finales del siglo XVI, antes de ser quemado por orden de la Inquisición Romana. Y, sí, muchas veces nos hicimos esa pregunta…

¿Habrá vida en otros mundos?

Planetas inimaginables ¿Que formas de vida acogerán? La pregunta que se plantea encima de la imagen de arriba tiene una fácil contestación: SÍ, hay otras formas de vida en el Universo, en planetas parecidos o iguales que la Tierra. Si no fuese así, la lógica y la estadística dejarían de tener sentido.

Un problema básico de esta ciencia, ya mencionado al principio, es la cantidad de datos disponibles, de sujetos de estudio. No conocemos más vida que la existente en la Tierra y ésta nos sirve de referencia para cualquier paso en la búsqueda de otras posibilidades. La astrobiología trata por ello de analizar la vida más primitiva que conocemos en nuestro planeta así como su comportamiento en los ambientes más extremos que encontremos para estudiar los límites de su supervivencia y adaptabilidad. Por otro lado, busca y analiza las condiciones necesarias para la aparición de entornos favorables a la vida, o habitables, en el Universo mediante la aplicación de métodos astrofísicos y de astronomía planetaria. Naturalmente, si identificáramos sitios en nuestro sistema solar con condiciones de habitabilidad sería crucial la búsqueda de marcadores biológicos que nos indiquen la posible existencia de vida presente o pasada más allá de la distribución de la vida en el Universo o, en caso negativo, acotaríamos aún más los límites de la vida en él.

Lagos de metano y una atmósfera como la de la Tierra hace 3.000 M de años

Titán, más allá de los anillos. Ahí podríamos encontrar lo que con tanto afán buscamos: otras formas de vida que, de una vez por todas, nos ofrezca la certeza de que no estamos solos en tan vasto Universo y, dada la conformación y características de ese pequeño mundo, no podríamos extrañarnos de que, la vida, incluso pudiera estar basada en otro elemento distinto del Carbono.

Diferentes condiciones ambientales pueden haber dado lugar a la vida e incluso permitido la supervivencia de algunos organismos vivos generados de forma casual, como experimento de la naturaleza. La Astrobiología trata de elucidar el papel de la evolución del Universo, y especialmente de cuerpos planetarios, en la aparición de la vida. En esta búsqueda de ambientes favorables para la vida, y su caracterización, en el sistema solar, la exploración espacial se muestra como una componente esencial de la Astrobiología. La experimentación en el laboratorio y la simulación mediante ordenadores o en cámaras para reproducir ambientes distintos son una herramienta que ha de ser complementada por la exploración directa a través de la observación astronómica, ligada al estudio de planetas extrasolares, o mediante la investigación in situ de mundos similares en cierta forma al nuestro, como el planeta Marte o algunos satélites de los planetas gigantes Júpiter y Saturno, como Europa, Encelado o el de arriba, Titán.

Titán es mucho más que un simple satélite de Saturno

Hoy, después de un viaje de siete años a través del sistema solar abordo de la nave Cassini, la sonda Huygens de la ESA ha pudo con éxito a través de la atmósfera de Titán (la mayor luna de Saturno) tomar tierra a salvo en su superficie para poder enviarnos datos e imagines que nos han dejado con la boca abierta por el asombro de lo que allí hay y, de lo que pueda estar presente…¿Vida microbiana?

La componente instrumental y espacial convierte a la Astrobiología en un ejemplo excelente de la conexión entre ciencia y tecnología. Los objetivos científicos de la Astrobiología, hemos visto, que requieren un tratamiento trans-disciplinar, conectando áreas como la física y la astronomía con la química y la biología. Esta metodología permite explotar sinergias y transferir conocimiento de unos campos a otros para beneficio del avance científico. Pero además, la Astrobiología está íntimamente ligada a la exploración espacial que requiere el desarrollo de instrumentación avanzada. Se necesitan tecnologías específicas como la robótica o los biosensores habilitadas para su empleo en condiciones espaciales y entornos hostiles muy diferentes al del laboratorio. Naturalmente la Astrobiología emplea estos desarrollos también para transferir conocimiento y tecnologías a otros campos de investigación científica y en particular, cuando es posible, incluso al sector productivo.

- astronomía y astrofísica.

- biología.

- química.

- geología.

- antropología.

Pero repasemos, para avanzar, cuáles son las áreas científicas propias de la Astrobiología. Como se ha dicho, es una ciencia interdisciplinar para el estudio del origen, evolución y distribución de la vida en el Universo. Para ello requiere una comprensión completa e integrada de fenómenos cósmicos, planetarios y biológicos. La astrobiología incluye la búsqueda y la caracterización de ambientes habitables en nuestro sistema solar y otros planetas alrededor de estrellas más alejadas, la búsqueda y análisis de evidencias de química prebiótica o trazas de vida larvada o extinguida en cuerpos del sistema solar como Marte o en lunas de planetas gigantes como Júpiter y Saturno. Asimismo se ocupa de investigaciones sobre los orígenes y evolución de la vida primitiva en la Tierra analizando el comportamiento de micro organismos en ambientes extremos.

Anhidrobiosis “vida sin agua”

Hidratación durante 3 h. ¿Qué no habrá por ahí fuera? Otros como los Acidófilos: Se desarrollan en ambientes de alta acidez, como el Picrophilus, los organismos de la cuenca del Río Tinto, en Huelva o la arquea que habita en una mina californiana llamada Irón Mountain, que crece en PH negativo. Los Organismos radiófilo o radio-resistente es aquél capaz de sobrevivir y prosperar en ecosistemas con niveles muy altos de radiaciones ionizantes. Los Halófilos que se Se desarrollan en ambientes hipersalinos, como las del género Halobacterium, que viven en entornos como el Mar Muerto. Los Termófilos:

Se desarrollan en ambientes a temperaturas superiores a 45 °C, algunos de ellos, los Hiper-termófilos tienen su temperatura optima de crecimiento por encima de los 80 °C., como el Pyrococcos furiosus, donde las chimeneas termales submarinas son testigos de ese asombroso hecho. Otros, como los Psicrófilos, que se desarrollan en ambientes de temperatura muy fría, como la Polaromanas vacuaolata. También tenemos los tardígrados, que se deshidratan para quedar como muertos durante cientos de años en condiciones de criptobiosis y pueden resistir en el espacio. Otros viven sin oxígeno, los hay que habitan a muchos metros bajo la superficie, o, algunos que existen con un bajo índice de humedad. En fin, la gama es amplia y nos muestra una enorme lista de protagonistas que, em medios imposible pueden vivir sin el menor problema. Y, si eso es así (que lo es), ?qué problema puede existir para que exista vida en otros planetas?

Los seres vivos surgen por todo el Universo y en las más extremas condiciones. Simplemente con observar lo que aquí tenemos nos podemos hacer una idea de lo que encontraremos por ahí fuera. Creo (aunque pudiera haber otras) que la vida en el Universo estará basada, como la nuestra, en el Carbono. El Carbono es el material más idóneo para ello por sus características especiales.

Desde el punto de vista más astronómico, la Astrobiología estudia la evolución química del Universo, su contenido molecular en regiones de formación estelar, la formación y evolución de discos proto-planetarios y estrellas, incluyendo la formación de sistemas planetarios y la caracterización de planetas extrasolares. En este campo en particular se han producido avances recientes muy importantes con la obtención de imágenes directas de planetas extrasolares y la identificación de algunos de ellos como puntos aislados de su estrella central gracias a técnicas de interferometría.

Los vacíos espaciales siguen siendo un gran misterio

Inmensas Nubes moleculares habitan en las galaxias y, dentro de ellas, al calor de las estrellas se producen transiciones de fase que nos traen la química-biológica para que la vida sea posible.

La caracterización de atmósferas de planetas extrasolares con tránsitos han permitido detectar CO₂ en la atmósfera de otros mundos y se ha descubierto el planeta más parecido a la Tierra por su tamaño y suelo rocoso aunque con un período demasiado corto para ser habitable. El lanzamiento de la misión Kepler de la NASA nos permite abrigar esperanzas de encontrar finalmente un planeta “hermano” del nuestro en la zona de habitabilidad de otra estrella.

El campo de la Astronomía planetaria, la Astrobiología estudia la evolución y caracterización de ambientes habitables en el sistema solar con el fin de elucidar los procesos planetarios fundamentales para producir cuerpos habitables.

Esto incluye el análisis de ambientes extremos y análogos al de Marte en nuestro planeta, como resulta ser la cuenca del Río Tinto en Huelva, así como la exploración de otros cuerpos del sistema solar, Marte en particular. Y, a propósito de Marte, recuerdo la emoción que sentí cuando la NASA detectó un foco de CH4 en el planeta. Al igual que los eucariotas, muchas bacterias respiran oxígeno. Pero otras bacterias utilizan para la respiración nitrato disuelto (NO3) en lugar de Oxígeno, y aún otras usan iones sulfato (SO42-) u óxidos metálicos de hierro o manganeso. Unos pocos procariotas pueden incluso utilizar CO2, que hacen reaccionar con ácido acético en un proceso que genera gas natural, que es el gas metano CH4 detectado en Marte. Dado que el planeta no muestra actividad volcánica, la fuente de dicho metano, ¿por qué no? podría ser bacteriana.

Estructura celular de una bacteria, típica célula procariota. El metabolismo de los procariotas es enormemente variado y resisten condiciones ambientales sorprendentes por lo extremas en parámetros como la temperatura y la acidez, entre otros,

El descubrimiento en Marte de agua en forma de hielo así como las claras evidencias de la existencia de agua líquida en su superficie en el pasado, proporcionadas por la observación de modificaciones de la componente mineralógica atribuidas al agua líquida en el subsuelo. Hoy por hoy, se considera que la presencia de agua líquida es una condición necesaria, aunque no suficiente, para la aparición de la vida ya que proporciona el caldo de cultivo para que las moléculas prebióticas se transformen en microorganismos biológicos.

En estas investigaciones el estudio del satélite Titán de Saturno mediante la sonda europea Huygens ha marcado un hito importante al acercarnos a un entorno prebiótico donde el metano ejerce un papel dominante.

En este sentido la posibilidad de explorar el satélite Europa, alrededor de Júpiter, es un claro objetivo de la Astrobiología dado que la espesa corteza de hielo que lo cubre puede esconder una gran masa de agua líquida.

Finalmente, la Astrobiología también contempla una serie de actividades más próximas al laboratorio en el que se analiza la evolución molecular, desde la química prebiótica, pasando por la adaptación molecular, hasta los mecanismos bioquímicos de interacción y adaptación al entorno. En este campo son muy importantes los estudios centrados en los límites de la biología, como la virología, y herramientas para la comprensión de los mecanismos de transmisión de información, de supervivencia y adaptabilidad, como las cuasi-especies. Entre los últimos avances de la química prebiótica de interés para la Astrobiología se encuentra el análisis de la quiralidad, una preferencia de la química de los organismos vivos por una simetría específica que nos puede acercar al proceso de su formación durante el crecimiento de la complejidad y la jerarquización de los procesos. Naturalmente, los mecanismos de transferencia de información genética resultan críticos para comprender la adaptabilidad molecular y son otro objetivo prioritario de la Astrobiología.

Está claro que la historia científica de la creación de la vida puede resultar una narración apasionante que, correctamente explicada en unión de los conocimientos que hoy poseemos del Universo, puede conseguir que comprendamos la inevitabilidad de la vida, no sólo ya en el planeta Tierra (único lugar -de momento-) en el que sabemos que está presente, sino por todos los confines del inmenso Universo. La diversidad biológica que podríamos contemplar de poder observar lo que por ahí fuera existe, nos llevaría más allá de un simple asombro.

Muchas hipótesis y ninguna certeza

Pero, ¿es realmente cierto que la ignorancia supera al conocimiento como camino más directo hacia el asombro? Bueno, lo que sí sabemos que es cierto es el hecho de que, cuanto más sabemos de las cosas, menos propensos somos al asombro. Y, siendo mucho lo que desconocemos de la historia de la vida y también de la del Universo, podemos decir que sabemos lo suficiente para “saber” que no estamos solos.

Algún día (espero que no demasiado lejano en el tiempo), encontraremos la prueba irrefutable de la existencia de la vida fuera de la Tierra. Espero que lo que hallemos no difiera exageradamente de lo que aquí existe y de lo que existió, seguramente, en esos otros lugares, el recorrido de la vida habrá sido muy similar al nuestro, y, la mayor diversidad de la vida será microbiana, esas formas primarias de vida que reconocemos como los verdaderos diminutos arquitectos de los ecosistemas terrestres. Aquí en la Tierra, la historia completa de la vida abarca unos 4.000 millones de años, desde los extraños mundos de los océanos sulfurosos que se extendían bajo una atmósfera asfixiante, pasando por bacterias que respiraban hierro, hasta llegar por fin a nuestro familiar mundo de oxígeno y ozono, de valles boscosos, de animales que nadan, corren o vuelan. Ni Sherezade podría haber imaginado un cuento más fascinante.

Hace poco NASA publicó esta foto de una de las lunas de Júpiter. Es volcánica, y genera océanos de lava y azufre. ¿Quién sabe lo que ahí pueda estar presente? Desde luego yo no puedo afirmar ni negar nada. Sin embargo, según lo descubierto aquí en la Tierra, mejor dejar la respuesta para más adelante.

Hemos alcanzado un nivel de desarrollo intelectual muy aceptable y, puesto que somos grandes animales, se nos puede perdonar que tengamos una visión del mundo que tiende a celebrar lo nuestro, pero la realidad es que nuestra perspectiva es errónea. Tenemos un concepto de nosotros mismos que, habiendo sido elaborado en nuestro cerebro tiende a ser tan irreal que, incluso llegamos a creernos especiales, y, la verdad es que, lo que tenemos de especial queda reducido al ámbito familiar, social y poco más. En el contexto del Universo, ¿Qué somos?

Creer que en un Universo “infinito” sólo existen unos seres que habitan un minúsculo objeto redondo, un grano de tierra de una simple Galaxia de entre cien millones…Parece, al menos, pretencioso. Dejemos que la Astrobiología nos indique el camino a seguir, que nuestros ingenios espaciales nos abran el camino y, cuando llegue el momento, partamos a conocer a nuestros hermanos.

La Fuente:

Obtenida en el Volumen 23, número 3 de 2009 de la Revista Española de Física, donde se publicó un magnifico trabajo de D. Álvaro Giménez, del Centro de Astrobiología INTA-CSIC. También tiene su parte aquí Andrew H. Knoll, reconocido paleontólogo que, en su libro La vida en un planeta joven, nos ofrece una apasionante narración sobre la vida, y, finalmente, lo poco que por mi parte he podido aportar.

emilio silvera

Nov

10

El secreto está en las estrellas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

El Tiempo es inexorable y su transcurrir va dejando atrás las cosas que del presente, van situándose en el pasado. Lejos queda ya aquellas efemérides y celebraciones del año 2009, cuando se conmemoró el Año Internacional de la Astronomía y me cupo el honor de (humildemente), colaborar con aquellas celebraciones.

Astrolabio de al-Sahli, del siglo XI (M.A.N., Madrid). El astrolabio es un antiguo instrumento que permite determinar la posición y altura de las estrellas sobre la bóveda celeste. El astrolabio era usado por los navegantes, astrónomos y científicos en general para localizar los astros y observar su movimiento, para determinar la hora a partir de la latitud o, viceversa, para averiguar la latitud conociendo la hora. También sirve para medir distancias por triangulación.

Con orgullo luzco en el ojal de mi chaqueta el astrolabio que nos dieron en Madrid, a todos los invitados, a la fiesta de inauguración en la que estaban presentes muchos astrónomos y astrofísicos del mundo entero.

Lo cierto es que, en su momento, ya desde el inicio del año 2.009 en el que se celebró el Año Internacional de la Astronomía, en muchos de mis artículos publicados en la colaboración que con la Organización Internacional tuve el honor de prestar, se hablaba de todos esos interesantes temas que, el universo nos presenta y que, inciden en el saber de la Naturaleza y del Mundo que nos acoge que, como nosotros… ¡También es Universo!

LA QUÍMICA DE LAS ESTRELLAS

Los cambios se estaban produciendo a una velocidad cada vez mayor. Al siglo de Newton también pertenecieron, entre otros, el matemático Fermat; Römer, quien midió la velocidad de la luz; Grimaldi, que estudió la difracción; Torricelli, que demostró la existencia del vacío; Pascal y Boyle, que definieron la física de los fluidos…La precisión de los telescopios y los relojes aumentó notablemente, y con ella el número de astrónomos deseosos de establecer con exactitud la posición de las estrellas y compilar catálogos estelares cada vez más completos para comprender la Vía Láctea.

La naturaleza de los cuerpos celestes quedaba fuera de su interés: aunque se pudiera determinar la forma, la distancia, las dimensiones y los movimientos de los objetos celestes, comprender su composición no estaba a su alcance. A principios del siglo XIX, William Herschel (1738-1822), dedujo la forma de la Galaxia, construyó el mayor telescopio del mundo y descubrió Urano. Creía firmemente que el Sol estaba habitado.

Hasta llegar a conocer nuestra situación astronómica…

Al cabo de pocos años, nacía la Astrofísica, que a diferencia de la Astronomía (ya llamada -”clásica o de posición”-), se basaba en pruebas de laboratorio. Comparando la luz emitida por sustancias incandescentes con la recogida de las estrellas se sentaban las bases de lo imposible: descubrir la composición química y la estructura y el funcionamiento de los cuerpos celestes. Estaba mal vista por los astrónomos “serios” y se desarrolló gracias a físicos y químicos que inventaron nuevos instrumentos de análisis a partir de las demostraciones de Newton sobre la estructura de la luz.

En 1814, Joseph Fraunhofer (1787-1826) realizó observaciones básicas sobre las líneas que Wollaston había visto en el espectro solar: sumaban más de 600 y eran iguales a las de los espectros de la Luna y de los planetas; también los espectros de Pólux, Capella y Porción son muy similares, mientras que los de Sirio y Cástor no lo son. Al perfeccionar el espectroscopio con la invención de la retícula de difracción (más potente y versátil que el prisma de cristal), Fraunhofer observó en el espectro solar las dos líneas del sodio: así se inició el análisis espectral de las fuentes celestes.

Mientras, en el laboratorio, John Herschel observó por primera vez la equivalencia entre los cuerpos y las sustancias que los producen, Anders J. Anhström (1814-1868) describía el espectro de los gases incandescentes y los espectros de absorción y Jean Foucault (1819-1874) comparó los espectros de laboratorio y los de fuentes celestes. Gustav Kirchhoff (1824-1887) formalizó las observaciones en una sencilla ley que cambió la forma de estudiar el cielo; “La relación entre el poder de emisión y de absorción para una longitud de onda igual es constante en todos los cuerpos que se hallan a la misma temperatura”. En 1859, esta ley empírica, que relacionaba la exploración del cielo con la física atómica, permitía penetrar en la química y la estructura de los cuerpos celestes y las estrellas. De hecho, basta el espectro de una estrella para conocer su composición. Y, con la espectroscopia, Kirchhoff y Robert Bunsen (1811-1899) demostraron que en el Sol había muchos metales.

La observación del Sol obsesionó a la mayoría de los Astrofísicos. A veces, resultaba difícil identificar algunas líneas y ello condujo a descubrir un nuevo elemento químico; se empezó a sospechar que el Sol poseía una temperatura mucho más elevada de lo imaginado. La línea de emisión de los espectros de estrellas y nebulosas demostraron que casi un tercio de los objetos estudiados eran gaseosos. Además, gracias al trabajo de Johan Doppler (1803-1853) y de Armand H. Fizeau (1819-1896), que demostró que el alejamiento o el acercamiento respecto al observador de una fuente de señal sonora o luminosa provoca el aumento o disminución de la longitud de onda de dicha señal, empezó a precisarse la forma de objetos lejanos. El cielo volvía a cambiar y hasta las “estrellas fijas” se movían.

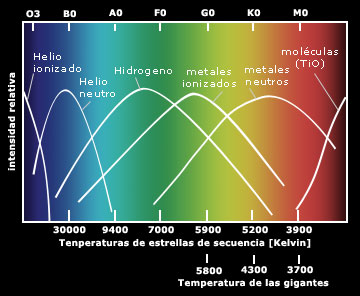

EL DIAGRAMA HR: EL CAMINO HACIA EL FUTURO

El padre Ángelo Secchi (1818-1878) fue el primero en afirmar que muchos espectros estelares poseen características comunes, una afirmación refrendada hoy día con abundantes datos. Secchi clasificó las estrellas en cinco tipos, en función del aspecto general de los espectros. La teoría elegida era correcta: el paso del color blanco azulado al rojo oscuro indica una progresiva disminución de la temperatura, y la temperatura es el parámetro principal que determina la apariencia de un espectro estelar.

Más tarde, otros descubrimientos permitieron avanzar en Astrofísica: Johan Balmer (1825-1898) demostró que la regularidad en las longitudes de onda de las líneas del espectro del hidrógeno podía resumirse en una sencilla expresión matemática; Pieter Zeeman (1865-1943) descubrió que un campo magnético de intensidad relativa influye en las líneas espectrales de una fuente subdividiéndolas en un número de líneas proporcional a su intensidad, parámetro que nos permite medir los campos magnéticos de las estrellas.

En otros descubrimientos empíricos la teoría surgió tras comprender la estructura del átomo, del núcleo atómico y de las partículas elementales. Los datos recogidos se acumularon hasta que la física y la química dispusieron de instrumentos suficientes para elaborar hipótesis y teorías exhaustivas.

Gracias a dichos progresos pudimos asistir a asociaciones como Faraday y su concepto de “campo” como “estado” del espacio en torno a una “fuente”; Mendeleiev y su tabla de elementos químicos; Maxwell y su teoría electromagnética; Becquerel y su descubrimiento de la radiactividad; las investigaciones de Pierre y Marie Curie; Rutherford y Soddy y sus experimentos con los rayos Alfa, Beta y Gamma; y los estudios sobre el cuerpo negro que condujeron a Planck a determinar su constante universal; Einstein y su trabajo sobre la cuantización de la energía para explicar el efecto fotoeléctrico, Bohr y su modelo cuántico del átomo; la teoría de la relatividad especial de Einstein que relaciona la masa con la energía en una ecuación simple…Todos fueron descubrimientos que permitieron explicar la energía estelar y la vida de las estrellas, elaborar una escala de tiempos mucho más amplia de lo que jamás se había imaginado y elaborar hipótesis sobre la evolución del Universo.

En 1911, Ejnar Hertzsprung (1873-1967) realizó un gráfico en el que comparaba el “color” con las “magnitudes absolutas” de las estrellas y dedujo la relación entre ambos parámetros. En 1913, Henry Russell (1877-1957) realizó otro gráfico usando la clase espectral en lugar del color y llegó a idénticas conclusiones.

El Diagrama de Hertzsprung-Russell (diagrama HR) indica que el color, es decir, la temperatura, y el espectro están relacionados, así como el tipo espectral está ligado a la luminosidad. Y debido a que esta también depende de las dimensiones de la estrella, a partir de los espectros puede extraerse información precisa sobre las dimensiones reales de las estrellas observadas. Ya solo faltaba una explicación de causa-efecto que relacionara las observaciones entre si en un cuadro general de las leyes.

El progreso de la física y de la química resolvió esta situación, pues, entre otros avances, los cálculos del modelo atómico de Bohr reprodujeron las frecuencias de las líneas del hidrógeno de Balmer. Por fin, la Astrofísica había dado con la clave interpretativa de los espectros, y las energías de unión atómica podían explicar el origen de la radiación estelar, así como la razón de la enorme energía producida por el Sol.

Las líneas espectrales dependen del número de átomos que las generan, de la temperatura del gas, su presión, la composición química y el estado de ionización. De esta forma pueden determinarse la presencia relativa de los elementos en las atmósferas estelares, método que hoy también permite hallar diferencias químicas muy pequeñas, relacionadas con las edades de las estrellas. Así, se descubrió que la composición química de las estrellas era casi uniforme: 90 por ciento de hidrógeno y 9 por ciento de helio (en masa, 71% y 27%, respectivamente). El resto se compone de todos los elementos conocidos en la Tierra.

Así mismo, el desarrollo de la Física ha permitido perfeccionar los modelos teóricos y explicare de forma coherente que es y como funciona una estrella. Dichos modelos sugirieron nuevas observaciones con las que se descubrieron tipos de estrellas desconocidas: las novas, las supernovas, los púlsares con periodos o tiempos que separan los pulsos, muy breves…También se descubrió que las estrellas evolucionan, que se forman grupos que luego se disgregan por las fuerzas de marea galácticas.

La Radioastronomía, una nueva rama de la Astronomía, aportó más datos sobre nuestra Galaxia, permitió reconstruir la estructura de la Vía Láctea y superar los límites de la Astronomía óptica.

Se estaban abriendo nuevos campos de estudio: los cuerpos galácticos, los cúmulos globulares, las nebulosas, los movimientos de la galaxia y sus características se estudiaron con ayuda de instrumentos cada vez más sofisticados. Y cuanto más se observaba más numerosos eran los objetos desconocidos descubiertos y más profusas las preguntas. Se descubrieron nuevos y distintos tipos de galaxias fuera de la nuestra; examinando el efecto Doppler, se supo que todas se alejaban de nosotros y, lo que es más, que cuanto más lejanas están más rápidamente se alejan.

El Telescopio Hubble nos muestra esta imagen del Universo Profundo

Acabábamos de descubrir que el Universo no terminaba en los límites de la Vía Láctea, sino que se había ampliado hasta el “infinito”, con galaxias y objetos cada vez más extraños. Sólo en el horizonte del Hubble se contabilizan 500 millones de galaxias. Y los descubrimientos continúan: desde el centro galáctico se observa un chorro de materia que se eleva más de 3.000 a.l. perpendicular al plano galáctico; se observan objetos como Alfa Cygni, que emite una energía radial equivalente a diez millones de veces la emitida por una galaxia como Andrómeda; se estudian los cuásares, que a veces parecen mas cercanos de lo que sugieren las mediciones del efecto Doppler; se habla de efectos de perspectiva que podrían falsear las conclusiones… Y nos asalta una batería de hipótesis, observaciones, nuevas hipótesis, nuevas observaciones, dudas…

Todavía no se ha hallado una respuesta cierta y global. Un número cada vez mayor de investigadores está buscándola en miles de direcciones. De esta forma se elaboran nuevos modelos de estrellas, galaxias y objetos celestes que quizá sólo la fantasía matemática de los investigadores consiga concretar: nacen los agujeros negros, los universos de espuma, las cadenas…

Encontrar Grafeno en el espacio ya no es una sorpresa, toparnos de bruces con océanos de metano… ¡tampoco!, hallar colonias de bacterias vivienda a muchos kilómetros de altura no es una novedad, saber que en las estrellas se fabrican los materiales aptos para hacer posible la química de la vida… nos maravilla pero ya, no es causa de asombro. Cada día damos un paso más hacia el saber del “mundo”, de la Naturaleza, del Universo en fin.

En la actualidad, el número de investigadores centrados en problemas relacionados con la evolución estelar, la Astrofísica y las teorías cosmogenéticas es tan elevado que ya no tiene sentido hablar de uno en particular, ni de un único hilo de investigación. Al igual que ocurre con otras ramas científicas las Astronomía se ha convertido en un trabajo de equipo a escala internacional que avanza sin cesar en una concatenación de innovaciones, inventos, nuevos instrumentos, interpretaciones cada vez más elaboradas y, a menudo más difíciles de entender incluso para los investigadores que avanzan con infinidad de caminos paralelos. Es una situación que ya vaticinaba Bacon en tiempos de Galileo.

Las estrellas, como casi cualquier entidad física, siguen un proceso de nacimiento, evolución y muerte. A diferencia de nosotros, la vida de una estrella se eleva a millones o miles de millones de años dependiendo de sus masas iniciales, a mayor masa menor tiempo de vida.

Hasta la Astronomía se ha especializado y, por ejemplo, quienes estudian problemas particulares de la física de las estrellas pueden desconocerlo todo sobre planetas y galaxias. También el lenguaje es cada vez más técnico, y los términos, capaces de resumir itinerarios de investigación, son complejos de traducir al lenguaje común. Así, mientras la divulgación avanza a duras penas entre una jungla de similitudes y silogismos, las informaciones que proceden de otras disciplinas son aceptadas por los científicos y los resultados de cada cual se convierten en instrumentos para todos.

La observación del Sol obsesionó a la mayoría de los Astrofísicos. A veces, resultaba difícil identificar algunas líneas y ello condujo a descubrir un nuevo elemento químico; se empezó a sospechar que el Sol poseía una temperatura mucho más elevada de lo imaginado.

El espectro, la temperatura, diagrama, elementos que las forman

La línea de emisión de los espectros de estrellas y nebulosas demostraron que casi un tercio de los objetos estudiados eran gaseosos. Además, gracias al trabajo de Johan Doppler (1803-1853) y de Armand H. Fizeau (1819-1896), que demostró que el alejamiento o el acercamiento respecto al observador de una fuente de señal sonora o luminosa provoca el aumento o disminución de la longitud de onda de dicha señal, empezó a precisarse la forma de objetos lejanos. El cielo volvía a cambiar y hasta las “estrellas fijas” se movían.

Las investigaciones sobre planetas, estrellas, materia interestelar, galaxias y Universo van paralelas, como si fueran disciplinas independientes, pero en continua osmosis. Y mientras la información sobre el Sol y los cuerpos del Sistema solar es más completa, detallada y fiable, y las hipótesis sobre nuestra Galaxia hallan confirmación, el Universo que empezamos a distinguir más allá de nuestros limites no se pareced a lo que hace un siglo se daba por sentado. Y mientras los modelos matemáticos dibujan uno o mil universos cada más abstractos y complejos, que tienen más que ver con la filosofía que con la observación, vale la pena recordar como empezó nuestro conocimiento hace miles de años.

Otros nos indicaron la dirección a seguir pero, la dureza del camino…, esa, la tuvimos que hacer nosotros. Es decir, en cada época y lugar, los que estuvieron, miraron hacia atrás para ver lo que hicieron sus ancestros y, con aquellas enseñanzas, tener la guía del camino a seguir, o, por el contrario, si los resultados no fueron buenos, rechazarlos. Lo cierto es que, al igual que nosotros, los que vengan detrás partirán con alguna ventaja aunque tengan que hacer su propio recorrido que, ni mucho menos tienen el camino despejado y, la niebla de la ignorancia sigue siendo espesa, aunque algo más suave que la que nosotros nos encontramos.

Ahora, amigos, después de este breve repaso por una pequeña parte de la Historia de la Astronomía, al menos tendréis una idea más cercana del recorrido que, la Humanidad, ha tenido que realizar para conocer mejor el Universo.

Los datos aquí reseñados tienen su origen en diversas fuentes que, de aquí y de allá, han sido tomadas para recomponer un mensaje que les lleve a todos algunos mensajes de como ocurrieron los acontecimientos en el pasado para que fuera posible nuestro presente.

emilio silvera

Nov

10

¡La Filosofía! Ese tesoro del pensamiento Humano

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Inducción probabilística estudiada en “El Círculo de Viena”

- Todo estudio científico se compone de fases de observación, procesamiento y conclusiones finales (o leyes generalistas). Una observación puntual puede arrojar resultados que no sean los esperados por lo que en muchos casos se hace uso de la probabilidad.

“El nacimiento y desarrollo de la ciencia experimental a partir del siglo XVII ha estado frecuentemente acompañado de polémicas filosóficas, y no pocas posturas filosóficas de la época moderna han representado, en parte, intentos diversos de solucionar esas polémicas”.

Resolver las diferentes polémicas filosóficas han hecho que en la época reciente se constituyese “la filosofía de la ciencia como disciplina autónoma, que ha dado lugar a la aparición de un nuevo tipo de dedicación profesional”.

Karl Popper

La aparición de este nuevo tipo de filósofo suele estar ligada a las actividades del círculo de Viena “que contribuyeron decisivamente a la consolidación de la filosofía de la ciencia como disciplina autónoma”. Desde esas actividades surgieron nuevas figuras que, ancladas en las consideraciones iniciales de la filosofía neopositivista del Círculo intenta responder a la cuestión de qué es la actividad científica y cual es su racionalidad propia. Heredan de la visión positivista que la ciencia es el paradigma de la objetividad y de la racionalidad.

Junto a la postura neopositivista crecen las figuras de otros pensadores. Entre esos nuevos filósofos se encuentra Karl Popper, cuya filosofía es también un intento de explicar el método científico y la racionalidad propia de la ciencia. Se convierte, tras alguno de los miembros del Círculo, en uno de los principales artífices de la consolidación de esta disciplina. A su sombra crecieron los principales filósofos de la ciencia del siglo XX y sus ideas constituyen siempre un paradigma, ya sea para seguirlas, ya sea para criticarlas.

Aquí yace en Paz el cuerpo de Karl Popper, ya que sus pensamientos vagan por todo el Universo… ¡libres! Los logros filosóficos de Karl Popper le valieron numerosos reconocimientos, tales como ser nombrado caballero por la reina Isabel II del Reino Unido en 1969. Recibió la insignia de Compañero de Honor (Companion of Honour) en 1982, el premio Lippincott de la Asociación Norteamericana de Ciencias Políticas y el premio Sonning. Fue miembro de la Sociedad Mont Pelerin, una comunidad de estudios fundada por Hayek para promover una agenda política liberal, así como de la Royal Society de Londres, con el rango de miembro, y de la Academia Internacional de la Ciencia. Entre otras, cultivó la amistad del canciller alemán Helmut Schmidt. Algunos conocidos discípulos de Popper fueron Hans Albert, Imre Lakatos y Paul Feyerabend.

“Creo, sin embargo, que al menos existe un problema filosófico por el que se interesan todos los hombres que reflexionan: es el de la cosmología, el problema de entender el mundo… incluidos nosotros y nuestro conocimiento como parte de él. Creo que toda ciencia es cosmología, y, en mi caso, el único interés de la filosofía, no menos que el de la ciencia, reside en los aportes que ha hecho a aquella; en todo caso, tanto la filosofía como la ciencia perderían todo su atractivo para mí si abandonasen tal empresa.”

Karl Popper. La lógica de la investigación científica.

Popper expuso su visión sobre la filosofía de la ciencia en su obra, ahora clásica, La lógica de la investigación científica, cuya primera edición se publicó en alemán (Logik der Forschung) en 1934. En ella el filósofo austríaco aborda el problema de los límites entre la ciencia y la metafísica, y se propone la búsqueda de un llamado criterio de demarcación entre las mismas que permita, de forma tan objetiva como sea posible, distinguir las proposiciones científicas de aquellas que no lo son. Es importante señalar que el criterio de demarcaciçon no decide sobre la veracidad o falsedad de una afirmación, sino sólo sobre si tal afirmación ha de ser estudiada y discutida dentro de la ciencia o, por el contrario, se sitúa en el campo más especulativo de la metafísica. Para Popper una proposición es científica si puede ser refutable, es decir, susceptible de que en algún momento se puedan plantear ensayos o pruebas para refutarla independientemente de que salgan airosas o no de dichos ensayos.

Karl Popper en una caricatura de Tullio Pericoli

En este punto Popper discrepa intencionadamente del programa positivista, que establecía una distinción entre proposiciones contrastables (positivas), tales como: “Hoy llueve”, y aquellas que, según los positivistas, no son más que abusos del lenguaje y carecen de sentido, por ejemplo: Dios existe. Para Popper, este último tipo de proposiciones sí tiene sentido y resulta legítimo discutir sobre ellas, pero han de ser distinguidas y separadas de la ciencia. Su criterio de demarcación le trajo sin querer un conflicto con Ludwing Wittgenstein, el cual también sostenía que era preciso distinguir entre proposiciones con sentido y las que no lo tienen. El criterio de distinción, para Wittgenstein, era el del “significado”: solamente las proposiciones científicas tenían significado, mientras que las que no lo tenían eran pura metafísica.

Era tarea de la filosofía desenmascarar los sinsentidos de muchas proposiciones autodenominadas científicas a través de la aclaración del significado de las proposiciones. A Popper se le encuadró en dicha escuela cuando formuló su idea de la demarcación, pero él mismo se encargó de aclarar que no estaba de acuerdo con dicho planteamiento, y que su tesis no era ningún criterio de significación (Popper siempre huyó de cualquier intento por aclarar significados antes de plantear teorías). Es más, Popper planteó que muchas proposiciones que para Wittgestein tenían significado no podían calificarse como ciencia como, por ejemplo, el psicoanálisis o el marxismo, ya que ante cualquier crítica se defendían con hipótesis ad hoc que impedían cualquier refutación.

No son pocos los filósofos que, con sus ideas, con su manera de ver el mundo, nos ayudaron a comprender, y, Karl Popper, fue uno de ellos-

- El problema principal: LOS LÍMITES Entre la ciencia y la metafísica Usando un criterio de ¿Cómo distinguir de los demarcación para que es ciencia de lo separar la ciencia de la que no lo es? especulación y la metafísica Para Popper una proposición es científica si puede ser refutable-

- Popper planteó que muchas proposiciones que para los pensadores de su época tenían significado, no podían calificarse como ciencia como, por ejemplo, el psicoanálisis o el marxismo y,obviamente, la religión, ya que ante cualquier crítica se defendían con hipótesis ad hoc que impedían cualquier refutación.

- En el sistema de Popper se combina la racionalidad con la extrema importancia que la crítica tiene en el desarrollo de nuestro conocimiento. Por eso, tal sistema fue bautizado como racionalismo crítico.

- FALSABILIDAD O FALSACIÓN.

Popper estaba de acuerdo con Hume respecto de que justificar nuestro conocimiento en forma inductiva conduce al irracionalismo. Pero, negaba que los científicos normalmente utilicen inferencias inductivas. A su vez, estaba de acuerdo con Kant acerca de que la experiencia y la observación presuponen ideas a priori. Pero, negaba que esas ideas a priori sean necesariamente verdaderas. Finalmente, estaba de acuerdo con Wittgenstein y los positivistas en que no podemos recurrir a principios válidos a priori para justificar la ciencia empírica. Pero, consideraba que la metafísica no tenía porqué carecer de sentido y que la verificabilidad es incapaz de distinguir a la ciencia de la metafísica puesto que no puede dar cuentas de la cientificidad de las leyes científicas, las cuales no pueden ser verificadas a través de argumentos inductivos derivados de la experiencia.

Aquí, Popper cortó el nudo gordiano al sugerir que las teorías científicas, en última instancia, no pueden ser justificadas. También al afirmar que el conocimiento científico es racional, no porque lo hayamos justificado, sino porque podemos criticarlo.

Para Popper, cualquier intento por justificar nuestro conocimiento debe aceptar algún enunciado como verdadero sin justificación alguna, a fin de evitar el regreso infinito.

Wittgenstein y los positivistas habían apelado a la experiencia para justificar nuestro conocimiento. Al contrario, Popper afirmó que ‘el principal problema de la filosofía es el análisis crítico del recurso a la autoridad de la ‘experiencia’ –precisamente la ‘experiencia’ que todo partidario del positivismo ingenuamente da por sentada’.

Popper creía que los enunciados observacionales jamás pueden suponer la veracidad de una ley universal. Además, Popper afirmó que sólo basta un contra-ejemplo para mostrar que una ley universal es falsa. Así, concluyó que es la falsabilidad lo que distingue a la ciencia de la metafísica. También postuló que la asimetría lógica entre los enunciados universales y singulares –las teorías científicas pueden ser falsadas, mas no verificadas; los enunciados observacionales pueden ser verificados, aunque no falsados– significa que la distinción entre ciencias naturales y metafísica no puede coincidir con la distinción entre enunciados con sentido y carentes de él.

Nuestro filósofo también negó que las teorías científicas sean descubiertas a través de un proceso inductivo. Popper pensaba que los científicos no desarrollan sus teorías generalizando observaciones, sino que inventan dichas teorías a modo de soluciones hipotéticas para los problemas con los que se enfrentan; y que deben recurrir a la experiencia y a las observaciones –no para justificar– sino para testear sus hipótesis. Por tanto, el crecimiento de la ciencia es tanto empírico como racional. Es empírico porque podemos testear nuestras hipótesis frente a observaciones y a la experiencia. Es racional puesto que utilizamos las formas válidas de argumentos de la lógica deductiva para criticar las hipótesis que contradicen enunciados observacionales que pensamos son verdaderos, y porque nunca arribamos a la conclusión de haber demostrado que una teoría es verdadera cuando la misma ha sobrevivido a nuestros tests.

Lo cierto es que no podemos plasmar aquí, en un corto espacio y limitado tiempo, los pensamientos de toda una vida y, nos limitamos a tomar datos de aquí y de allá para dejar un bosquejoque nos hable de quién fue el personaje y sus pensamientos.

El no creía en los nacionalismos, decía que era como regresar a la tribu.¡Cuánta razón tienen esas palabras! Un buen ejemplo lo tenemos cerca en Cataluña, donde el pueblo sufre sus consecuencias.

Por todo el mundo, en muchas de sus regiones, podemos ver los efectos negativos que dicho nacionalismo, por una u otra razón, la excusa no importa, los “inteligentes humanos” se matan. Y, de vez en cuando, sería bueno que algunos se pararan a pensar en los hechos y actuar después, emplear la lógica es bueno y debemos demostrar que somos seres racionales. La Filosofía es un buen camino.

emilio silvera

Totales: 85.983.698

Totales: 85.983.698 Conectados: 42

Conectados: 42