Ene

11

No siempre hablamos de lo que comprendemos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

“El espacio y el tiempo son conceptos tan fundamentales que se resisten a ser definidos (como en la conocida cita de San Agustín: “¿Qué es el tiempo? Si nadie me lo pregunta, lo sé. Si me lo preguntan, no lo sé”. Su naturaleza última está fuera del alcance de la ciencia y, sin embargo, toda la física se basa en ellos. Han evolucionado con la ciencia: el espacio y tiempo absolutos fueron esenciales para el desarrollo de la mecánica Newtoniana; un espacio-tiempo que depende del observador y que se ve deformado por la materia es el núcleo de la revolución traída por la Relatividad General.

Precisamente la Relatividad General, junto con la Teoría Cuántica de Campos (QFT) plantea un espinoso enigma a la ciencia actual, al no haberse encontrado ninguna teoría que las unifique. Pese a décadas de esfuerzo en varias líneas de investigación prometedoras (como las Supercuerdas), el proceso de unificación iniciado con las leyes de Maxwell no ha podido aún incluir con éxito a la Gravedad junto con las otras fuerzas. Es posible que la próxima revolución científica llegue con un cambio de paradigma que reconcilie las dos teorías enfrentadas con una nueva manera de comprender el espacio y el tiempo.”

¡La Física! Lo que busca la física fundamental es reducir las leyes de la Naturaleza a una teoría final sencilla que lo explique todo. El físico y premio Nobel Steven Weinberg señala que las reglas fundamentales son lo más satisfactorio (al menos para él). Las leyes básicas de Isaac Newton, que predicen el comportamiento de los planetas, son más satisfactorias, por ejemplo, que un almanaque en el que se indique la posición de todos los planetas en cada momento. Weinberg nos dice que la Física no puede explicarlo todo, matizando que sólo puede explicar los sucesos relacionándolos con otros sucesos y con las reglas existentes.

Por ejemplo, las órbitas de los planetas son el resultado de unas reglas, pero las distancias de los planetas al Sol son accidentales, y no son consecuencia de ley fundamental alguna. Claro que, también las leyes podrían ser fruto de casualidades. Lo que sí es cierto es que los físicos están más interesados por descubrir las reglas que por los sucesos que dichas reglas determinan, y más por los hechos que son independientes del tiempo; por ejemplo, les interesa más la masa del electrón que un tornado que se pueda producir en un lugar determinado.

De esa Teoría final que tosdos persiguen, seguramente, ni se han inventado sus matemáticas

La ciencia, como nos dice Weinberg, no puede explicarlo todo y, sin embargo, algunos físicos tienen la sensación de que nos estamos acercando a “una explicación del mundo” y, algún día, aunando todos los esfuerzos de muchos, las ideas de las mejores mentes que han sido, y las nuevas que llegarán, podremos, al fín, construir esa Teoría final tan largamente soñada que, para que sea convincente, deberá también, incluirnos a nosotros. Pero, paradógicamente y a pesar de estos pensamientos, existen hechos que los contradicen, por ejemplo, conocemos toda la física fundamental de la molécula de agua desde hace 7 decenas de años, pero todavía no hay nadie que pueda explicar por qué el agua hierve a los 100 ºC. ¿Qué ocurre? ¿Somos acaso demasiado tontos? Bueno, me atrevería a pronosticar que seguiremos siendo “demasiado tontos” incluso cuando los físicos consigan (por fin) esa teoría final que nos pueda dar una “explicación del mundo”. Siempre seguiremos siendo aprendices de la naturaleza que, sabia ella, nos esconde sus secretos para que persista el misterio.

¿Qué sería de nosotros si lo supiéramos todo?

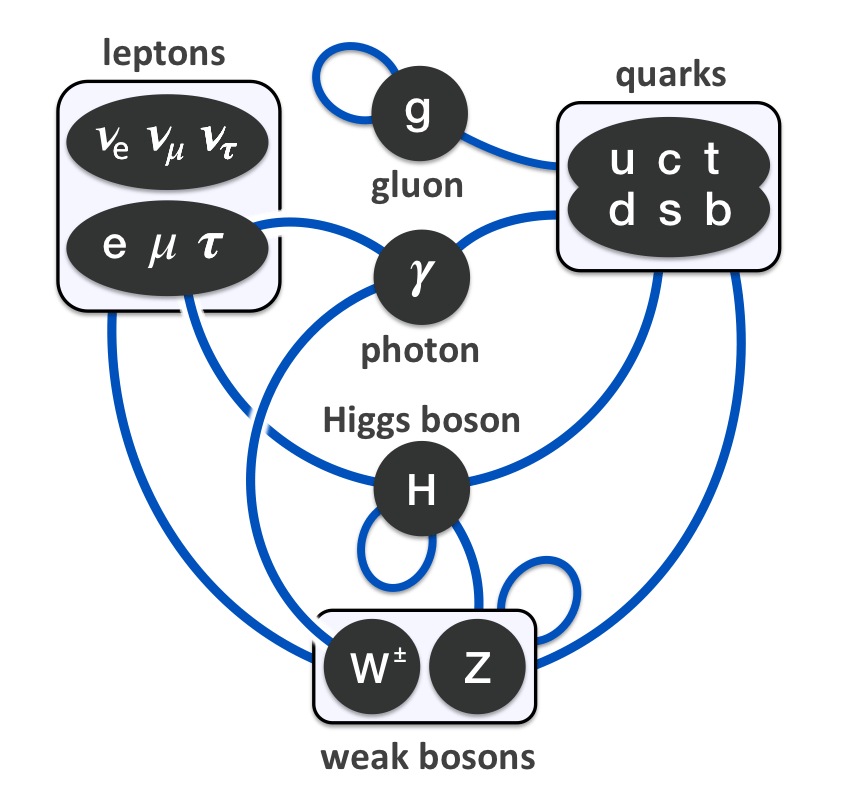

La explicación que dan los físicos actualmente sobre la subestructura de la materia se llama “el modelo estándar”. En este modelo están incluídas las doce partículas elementales y las tres fuerzas que, cuando se mezclan y se encajan, sirven para construir todo lo que hay en el universo, desde un redondo pan de pueblo hecho en un horno de leña, hasta las más complejas galaxias, y puede explicar todos los mecanismos de acción, es decir, la mecánica del mundo.

Entre las partículas figuran los seis Quarks famosos: arriba, abajo, extraño, encanto, fondo y cima. Las otras seis partículas son Leptones: el electrón y sus dos parientes más pesados, el muón y el tau y los tres neutrinos a ellos asociados. Las tres fuerzas son la electromagnética, la fuerza nuclear fuerte (que mantiene unidos a los quarks) y la fuerza nuclear débil (responsable de la radioactividasd). Hay una cuarta fuerza: la Gravedad que, aunque tan importante como las demás, nadie ha sabido como encajarla en el modelo estándar. Todas las partículas y fuerzas de este modelo son cuánticas; es decir, siguen las reglas de la mecánica cuántica. Aún no existe una teoría de la gravedad cuántica.

“Lo que Maldacena encontró es que, cuando se describe el comportamiento de cuerdas en un espacio tiempo curvadode una forma muy particular (concretamente un Anti DeSittertensoriado a otro espacio), el sistema es completamente equivalente al que describe una teoría de campos sobre la frontera conforme del espacio-tiempo, frontera que resulta ser… ¡¡un espacio de Minkowsky!! En palabras cotidianas, cada cosa que ocurre en el interior de una esfera de cristal se corresponde con algo que ocurre en su superficie.”

“Las consecuencias de esta conjetura son muy importantes, pues existe la posibilidad de que el resto de interacciones (electromagnéticas y nucleares) sean tan sólo una ilusión, el reflejo sobre el cristal de un escaparate del contenido de la tienda. Así, podría ser que el electromagnetismo tan sólo sea la imagen proyectada de la interacción de algunas cuerdas en un supuesto interior del espacio-tiempo. De la misma manera, la necesidad de compactificar las dimensiones adicionales desaparece en cierto modo si consideramos que, quizás, nuestro mundo sea solamente la frontera; siendo el interior del espacio-tiempo inaccesible.”

Quizás resulte que, al final, la única interacción sea la gravedad…

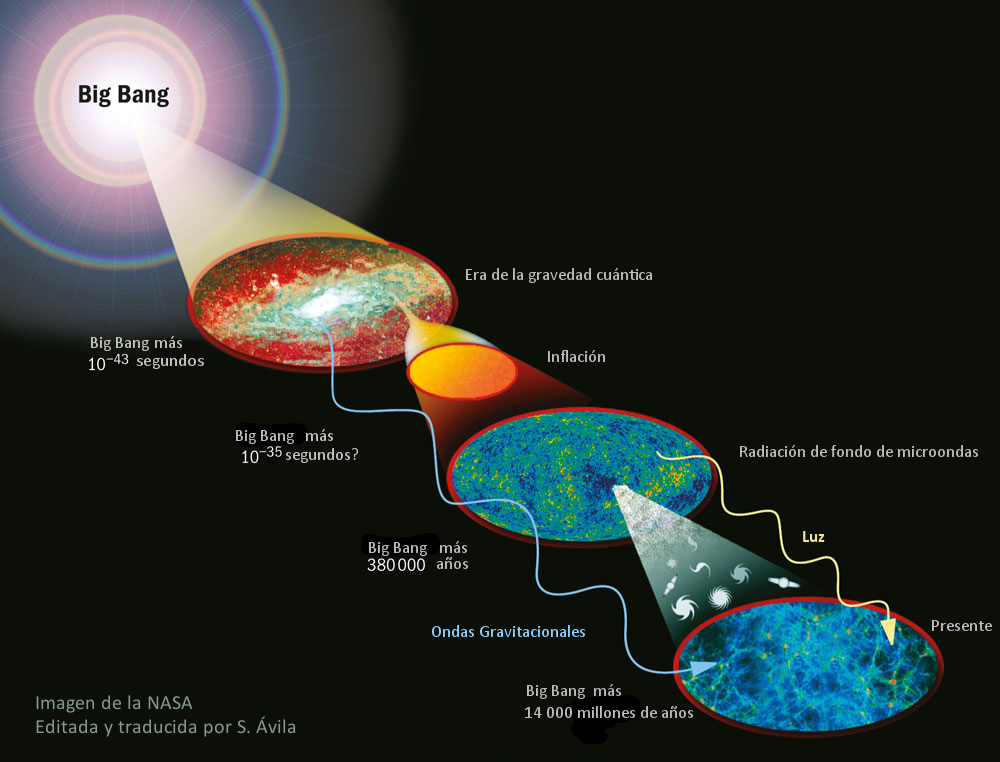

En realidad, la región que denominamos Gravedad cuántica nos lleva y comprende preguntas sobre el origen del universo observable que nadie ha sabido contestar. Nos lleva a complejos procesos cuánticos situados en las épocas más cercanas imaginables en un espacio-tiempo clásico, es decir, en lo que se conoce como Tiempo de Planck a 10-43 segundos del supuesto big bang, cuando reinaba una temperatura del orden de 10 x 1031 K. Pero, como hemos dicho, al no existir una teoría autoconsistente de la Gravedad cuántica, lo único que podemos hacer (como en tantas otras áreas de la Ciencia) es especular.

El Modelo Estándar no es, ni mucho menos, satisfactorio. Los científicos piensan que no sólo es incompleto, sino que es demasiado complicado y, desde hace mucho tiempo, buscan, incansables, otro modelo más sencillo y completo que explique mejor las cosas y que, además, no tenga (como tiene el modelo actual) una veintena de parámetros aleatorios y necesarios para que cuadren las cuentas…, un ejemplo: el bosón de Higgs necesario para dar masa a las partículas.

¡La masa! ese gran problema. Todas las partículas tienen masa diferentes pero nadie sabe de donde salen sus valores. No existe fórmula alguna que diga, por ejemplo, que el quark extraño debería pesar el doble (o lo que sea) del quark arriba, o que el electrón deba tener 1/200 (u otra proporción) de la masa del muón. Las masas son de todo tipo y es preciso “ponerlas a mano”, como se suele decir: cada una ha de ser medida experimental e individualmente. En realidad, ¿por qué han de tener masa las partículas? ¿de dónde viene la masa?

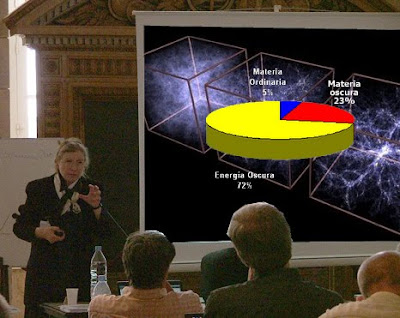

No puedo evitarlo ni tampoco me puedo quedar callado, cuando he asistido a alguna conferencia sobre la materia y, el ponente de turno se agarra a la “materia oscura” para justificar lo que no sabe, si al final hay debate, entro en escena para discutir sobre la existencia de esa “materia fantasma” que quiere tapar nuestra enorme ignorancia. Está claro que algo “hay” y lo llaman “matería oscura” pero nadie sabe lo que pueda ser.

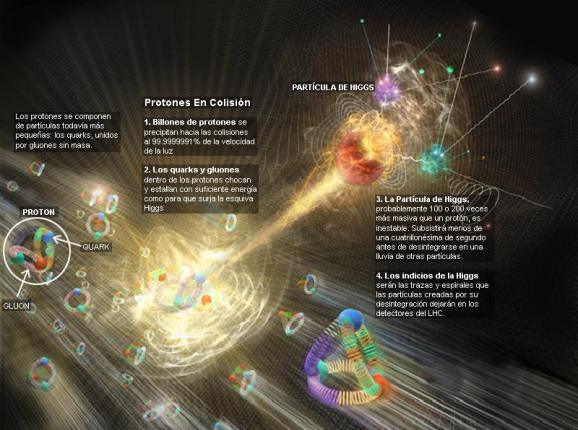

Pero, sigamos con el problema de la masa. Para resolverlo, muchos expertos en física de partículas creen actualmente en algo que llaman “campo de Higgs”. Se trata de un campo misterioso, invisible y etéreo que está permeando todo el espacio (¿habrán vuelto al antiguo éter pero cambiándole el nombre?). Hace que la materia parezca pesada, como cuando tratamos de correr por el fondo de la piscina llena de agua pero que el agua no se pudiera ver. Hace tiempo decíamos: “Si pudiéramos encontrar ese campo, o más bien la partícula la partícula que se cree es la manifestación de ese campo (llamada el bosón de Higgs), avanzaríamos un largo trecho hacia el conocimiento del universo.”

Parece (según nos dicen) que la hemos encontrado pero… ¡Quedan pendientes muchas explicaciones!

El Gran Colisionador de Hadrones

Aquí, en este imponente artilugio está la inventiva de nuestras mentes, se quiere dar respuesta a una serie de interrogantes que se espera solucionar con este experimento:

• Qué es la masa.

• El origen de la masa de las partículas

• El origen de la masa para los bariones.

• El número exacto de partículas del átomo.

Claro que, si no fuera tan largo de contar, os diría que, en realidad, el Campo de Higgs se descubrió hace ya muchos siglos en la antigua India, con el nombre de maya, que sugiere la idea de un velo de ilusión para dar peso a los objetos del mundo material. Pocos conocen que, los hindúes fueron los que más se acercaron a las ideas modernas sobre el átomo, la física cuántica y otras teorías actuales. Ellos desarrollaron muy temprano sólidas teorías atomistas sobre la materia. Posiblemente, el pensamiento atomista griega recibió las influencias del pensamiento de los hindúes a través de las civilizaciones persas. El Rig-Veda, que data de alguna fecha situada entre el 2000 y el 1500 a. C., es el primer texto hindú en el que se exponen unas ideas que pueden considerarse leyes naturales universales. La ley cósmica está relacionada con la luz cósmica.

Anteriores a los primeros Upanishads tenemos en la India la creación de los Vedas, visiones poéticas y espirituales en las que la imaginación humana ve la Naturaleza y la expresa en creación poética, y después va avanzando hacia unidades más intensamente reales que espirituales hasta llegar al Brahmán único de los Upanishads.

Hacia la época de Buda (500 a, C.), los Upanishad, escritos durante un período de varios siglos, mencionaban el concepto de svabhava, definido como “la naturaleza inherente de los distintos materiales”; es decir, su eficacia causal única, , tal como la combustión en el caso del fuego, o el hecho de fluir hacia abajo en el caso dela agua. El pensador Jainí Bunaratna nos dijo: “Todo lo que existe ha llegado a existir por acción de la svabhava. Así… la tierra se transforma en una vasija y no en paño… A partir de los hilos se produce el paño y no la vasija”.

También aquellos pensadores, manejaron el concepto de yadrccha, o azar desde tiempos muy remotos. Implicaba la falta de orden y la aleatoriedad de la causalidad. Ambos conceptos se sumaron a la afirmación del griego Demócrito medio siglo más tarde: “Todo lo que hay en el universo es fruto del azar y la necesidad”. El ejemplo que que dio Demócrito -similar al de los hilos del paño- fue que, toda la materia que existe, está formada por a-tomos o átomos.

Bueno, no lo puedo evitar, mi imaginación se desboca y corre rápida por los diversos pensamientos que por la mente pasan, de uno se traslada a otros y, al final, todo resulta un conglomerado de ideas que, en realidad, quieren explicar, dentro de esa diversidad, la misma cosa.

emilio silvera

Ene

10

El Tiempo de Planck y otros conceptos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (16)

Comments (16)

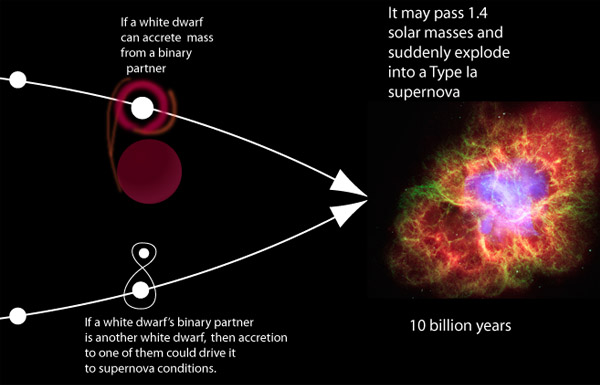

Por ejemplo, en el Sol, la radiación que produce la fusión tiende a que el Sol se expanda, y, por otra parte, la fuerza de Gravedad que genera su ingente masa, tiende a contraerlo, con lo cual, una fuerza se enfrenta a la otra y se frenan mutuamente durante miles de millones de años. Desaparecida la radiación de fusión… ¡Queda a merced de la Gravedad que hará su trabajo de manera irremediable!

Todos los objetos del Universo son el resulta de fuerzas antagónicas que, al ser iguales, se equilibran y consiguen la estabilidad. Las estrellas son el mejor ejemplo: La Gravedad trata de comprimir a la estrella que, mediante la fusión tiende a expandirse y, la lucha de esas dos fuerzas crea la estabilidad.

Estas estructuras, podemos decir que son entidades estables que existen en el Universo. Existen porque son malabarismos estables entre fuerzas competidoras de atracción y repulsión. Por ejemplo, en el caso de un planeta, como la Tierra, hay un equilibrio entre la fuerza atractiva de la Gravedad y la repulsión atómica que aparece cuando los átomos se comprimen demasiado juntos. Todos estos equilibrios pueden expresarse aproximadamente en términos de dos números puros creados a partir de las constantes e (electrón), h (constante de Planck), G (constante de gravitación) y mp (masa del protón), c (la velocidad de la luz en el vacío). Pero, ¿que es el Tiempo de Planck.

Tiempo de Planck

Es el tiempo que necesita el fotón (viajando a la velocidad de la luz, c, para moverse a través de una distancia igual a la longitud de Planck. Está dado por segundos, donde G es la constante gravitacional (6’672 59 (85) ×10-11 N m2 kg-2), ħ es la constante de Planck racionalizada (ħ = h/2π = 1’054589 × 10-34 Julios segundo) y c es la velocidad de la luz (299.792.458 m/s).

El valor del tiempo del Planck es del orden de 10-43 segundos. En la cosmología del Big Bang, hasta un tiempo (Tp) después del instante inicial, es necesaria usar una teoría cuántica de la gravedad para describir la evolución del universo. Expresado en números corrientes que todos podamos entender, su valor es 0’000.000.000.000.000.000.000.000.000.000.000.000.000.000.1 de 1 segundo, que es el tiempo que necesita el fotón para recorrer la longitud de Planck, de 10-35 metrtos (veinte órdenes de magnitud menor que el tamaño de del protón de 10-15 metros). el límite de Planc es Lp = √(Għ/c3 ≈ 1’61624 x 10-35 m.

Todo, desde Einstein, es relativo. Depende de la pregunta que se formule y de quién nos de la respuesta.

El tiempo es la escalera con peldaños “infinitos” que nos llevan hasta la “eternidad”…

Si preguntamos ¿qué es el tiempo?, tendríamos que ser precisos y especificar si estamos preguntando por esa dimensión temporal que no deja de fluir desde el Big Bang y que nos acompaña a lo largo de nuestras vidas, o nos referimos al tiempo atómico, ese adoptado por el SI, cuya unidad es el segundo y se basa en las frecuencias atómicas, definida a partir de una línea espectral particular de átomo de cesio-133, o nos referimos a lo que se conoce como tiempo civil, tiempo coordinado, tiempo de crecimiento, tiempo de cruce, tiempo de integración, tiempo de relajación, tiempo dinámico o dinámico de Baricéntrico, dinámico terrestre, tiempo terrestre, tiempo de Efemérides, de huso horario, tiempo estándar, tiempo local, tiempo luz, tiempo medio, etc, etc. Cada una de estas versiones del tiempo tiene una respuesta diferente, ya que no es lo mismo el tiempo propio que el tiempo sidéreo o el tiempo solar, o solar aparente, o solar medio, o tiempo terrestre, o tiempo universal. Como se puede ver, la respuesta dependerá de cómo hagamos la pregunta.

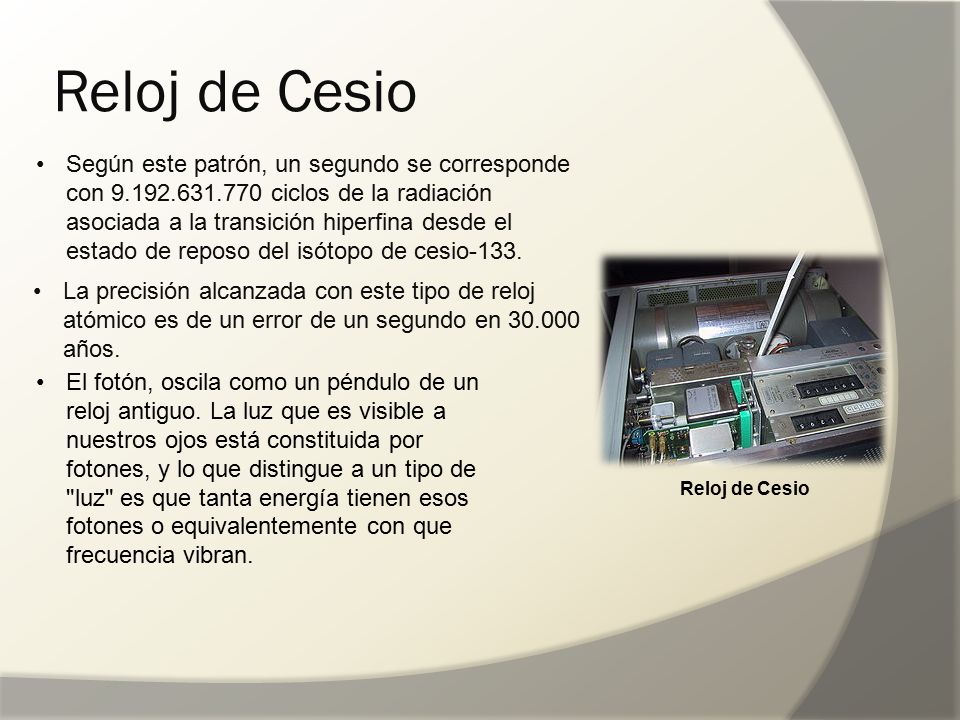

“En el año 1967 los relojes atómicos basados en cesio habían conseguido fiabilidad suficiente como para que la Oficina Internacional de Pesas y Medidas eligiera la frecuencia de vibración atómica de los dispositivos creados y perfeccionados por Essen como nuevo patrón base para la definición de la unidad de tiempo físico. Según este patrón, un segundo se corresponde con 9 192 631 770 ciclos de la radiación asociada a la transición hiperfina desde el estado de reposo del isótopo de cesio 133: (133Cs).”

La precisión alcanzada con este tipo de reloj atómico es tan elevada que admite únicamente un error de un segundo en 30 000 años. El reloj más preciso del mundo se diseña en el Observatorio de París, donde los actuales relojes atómicos tardarían 52 millones de años para desfasarse un segundo. El nuevo objetivo de la investigación francesa es aumentar ese plazo a 32 mil millones de años. El estándar actual de los relojes atómicos en activo permite el atraso de un segundo cada 3700 millones de años (NIST)

Reloj de Cesio cuyo funcionamiento se basa en la diferencia de energía entre dos estados del núcleo de Cesio-133 cuando se sitúa en un campo magnético. En un tipo, los átomos de cesio-133 son irradiados con radiación de radiofrecuencia, cuya frecuencia es elegida para corresponder a la diferencia de energía entre los dos estados. Es decir, nos valemos de un sistema complejo para determinar lo que el tiempo es basado en lo que de él nos indica la Naturaleza.

Es lógico pensar que el Tiempo, “nació con el Universo”, ambos, Tiempo y Universo, siempre han ido de la mano y, se podría decir que el Tiempo, es el único testigo de todo lo acontecido desde el “Big Bang”. ¡Si el Tiempo pudiera hablarnos!

En realidad, para todos nosotros el único tiempo que rige es el que tenemos a lo largo de nuestras vidas; los otros tiempos, son inventos del hombre para facilitar sus tareas de medida, de convivencia o de otras cuestiones técnicas o astronómicas pero, sin embargo, el tiempo es sólo uno; ese que comenzó cuando nació el universo y que finalizará cuando éste llegue a su final.

Lo cierto es que para las estrellas supermasivas, cuando llegan al final de su ciclo y dejan de brillar por agotamiento de su combustible nuclear, en ese preciso instante, el tiempo se agota para ella. Cuando una estrella pierde el equilibrio existente entre la energía termonuclear (que tiende a expandir la estrella) y la fuerza de gravedad (que tiende a comprimirla), al quedar sin oposición esta última, la estrella supermasiva se contrae aplastada bajo su propia masa. Queda comprimida hasta tal nivel que llega un momento que desaparece, para convertirse en un agujero negro, una singularidad, donde dejan de existir el “tiempo” y el espacio. A su alrededor nace un horizonte de sucesos, que si se traspasa se es engullido por la enorme gravedad del agujero negro.

Según todos los indicios, la Física nosm dice que, al llegar a la singularidad de un agujero negro, no podremos encontrar ni tiempo ni espacio. Es una región que, estando en este mundo, es como si estuviera en otro al que sólo se podrá llegar a través de la teoría tan esperada de la gravedad cuántica. Aquí, en la Singularidad, la Relatividad de Einstein llega y hace mutis por el foro.

El tiempo, de esta manera, deja de existir en estas regiones del universo que conocemos como singularidad. El mismo Big Bang surgió de una singularidad de energía y densidad infinitas que, al explotar, se expandió y creó el tiempo, el espacio y la materia.

Como contraposición a estas enormes densidades de las enanas blancas, estrellas de neutrones y agujeros negros, existen regiones del espacio que contienen menos galaxias que el promedio o incluso ninguna galaxia; a estas regiones las conocemos como vacío cósmico. Han sido detectados vacíos con menos de una décima de la densidad promedio del universo en escalas de hasta 200 millones de años luz en exploraciones a gran escala. Estas regiones son a menudo esféricas. El primer gran vacío en ser detectado fue el de Boötes en 1.981; tiene un radio de unos 180 millones de años luz y su centro se encuentra aproximadamente a 500 millones de años luz de la Vía Láctea. La existencia de grandes vacíos no es sorprendente, dada la existencia de cúmulos de galaxias y supercúmulos a escalas muy grandes.

Muchos son los misterios que nos quedan por resolver y muchos también los objetos que, estando ahí, aún no han sido localizados. La vastedad del inmenso Universo, hace difícil saber la realidad de todo su contenido y, necesitaremos siglos de estudio y observación para poder acernos, aunque sea mínimamente, a sus secretos.

Mientras que en estas regiones la materia es muy escasa, en una sola estrella de neutrones, si pudiéramos retirar 1 cm3 de su masa, obtendríamos una cantidad de materia increíble. Su densidad es de 1017 Kg/m3; los electrones y los protones están tan juntos que se combinan y forman neutrones que se degeneran haciendo estable la estrella de ese nombre que, después del agujero negro, es el objeto estelar más denso del universo.

Es interesante ver cómo a través de las matemáticas y la geometría, han sabido los humanos encontrar la forma de medir el mundo y encontrar las formas del universo. Pasando por Arquímedes, Pitágoras, Newton, Gauss o Riemann (entre otros), siempre hemos tratado de buscar las respuestas de las cosas por medio de las matemáticas.

Arthur C. Clarke nos decía: “Magia es cualquier tecnología suficientemente avanzada”

Pero también es magia el hecho de que en cualquier tiempo y lugar, de manera inesperada, aparezca una persona dotada de condiciones especiales que le permiten ver estructuras complejas matemáticas que hacen posible que la humanidad avance considerablemente a través de esos nuevos conceptos que nos permiten entrar en espacios antes cerrados, ampliando el horizonte de nuestro saber.

Recuerdo aquí uno de esos extraños casos que surgió el día 10 de Junio de 1.854 con el nacimiento de una nueva geometría: la teoría de dimensiones más altas que fue introducida cuando Georg Friedrich Bernhard Riemann dio su célebre conferencia en la facultad de la Universidad de Göttingen en Alemania. Aquello fue como abrir de golpe todas las ventanas cerradas durante 2.000 años de una lóbrega habitación que, de pronto, se ve inundada por la luz cegadora de un Sol radiante. Riemann regaló al mundo las sorprendentes propiedades del espacio multidimensional.

La nueva geometría de Riemann nos dijo como era la realidad del espacio curco, la Geometría del Universo

Su ensayo, de profunda importancia y elegancia excepcional, “sobre las hipótesis que subyacen en los fundamentos de la geometría” derribó pilares de la geometría clásica griega, que habían resistido con éxito todos los asaltos de los escépticos durante dos milenios. La vieja geometría de Euclides, en la cual todas las figuras geométricas son de dos o tres dimensiones, se venía abajo, mientras una nueva geometría riemanniana surgía de sus ruinas. La revolución riemanniana iba a tener grandes consecuencias para el futuro de las artes y las ciencias. En menos de tres decenios, la “misteriosa cuarta dimensión” influiría en la evolución del arte, la filosofía y la literatura en toda Europa. Antes de que hubieran pasado seis decenios a partir de la conferencia de Riemann, Einstein utilizaría la geometría riemanniana tetradimensional para explicar la creación del universo y su evolución mediante su asombrosa teoría de la relatividad general. Ciento treinta años después de su conferencia, los físicos utilizarían la geometría decadimensional para intentar unir todas las leyes del universo. El núcleo de la obra de Riemann era la comprensión de las leyes físicas mediante su simplificación al contemplarlas en espacios de más dimensiones.

Contradictoriamente, Riemann era la persona menos indicada para anunciar tan profunda y completa evolución en el pensamiento matemático y físico. Era huraño, solitario y sufría crisis nerviosas. De salud muy precaria que arruinó su vida en la miseria abyecta y la tuberculosis. Al igual que aquel otro genio, Ramanujan, murio muy joven.

emilio silvera

Ene

9

Fluctuaciones de vacío! ¿Que son?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (2)

Comments (2)

Un fuerte campo gravitatorio puede inducir un efecto desbocado en las fluctuaciones cuánticas que se producen en el espacio, aparentemente vacío, …

En física cuántica, la fluctuación cuántica es un cambio temporal en la cantidad de energía en un punto en el espacio como resultado del Principio de Incertidumbre que imaginó Werner Heisenberg. De acuerdo a una formulación de este principio energía y tiempo se relacionan de la siguiente forma:

Esto significa que la conservación de la energía puede parecer violada, pero sólo por breves lapsos. Esto permite la creación de pares partícula-antipartícula de partículas virtuales. El efecto de esas partículas es medible, por ejemplo, en la carga efectiva del electrón, diferente de su carga “desnuda”. En una formulación actual, la energía siempre se conserva, pero los estados propios del Hamiltoniano no son los mismos que los del operador del número de partículas, esto es, si está bien definida la energía del sistema no está bien definido el número de partículas del mismo, y viceversa, ya que estos dos operadores no conmutan.

Las fluctuaciones del vacío entre una esfera y una superficie plana

En un estudio realizado por un equipo de físicos con avanzados aparatos, han hallado un resultado del que nos dicen:

La materia se construye sobre fundamentos frágiles. Los físicos acaban de confirmar que la materia, aparentemente sustancial, es en realidad nada más que fluctuaciones en el vació cuántico. Los investigadores simularon la frenética actividad que sucede en el interior de los protones y neutrones, que como sabéis son las partículas que aportan casi la totalidad de la masa a la materia común.

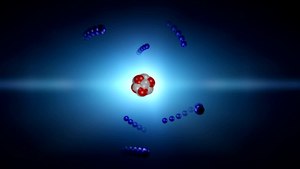

Cada protón (o neutrón) se compone de tres quarks – véase ilustración – pero las masas individuales de estos quarks apenas comprenden el 1% del total de la masa del protón¿Entonces de dónde sale el resto? La teoría sostiene que esta masa es creada por la fuerza que mantiene pegados a los quarks, y que se conoce como fuerza nuclear fuerte. En términos cuánticos, la fuerza fuerte es contenida por un campo de partículas virtuales llamadas gluones, las cuales irrumpen aleatoriamente en la existencia para desaparecer de nuevo. La energía de estas fluctuaciones del vacío debe sumarse a la masa total del neutróny del protón.

En nuestras mentes se acumulan signos y fórmulas que quieren ser los exponentes de la verdadera razón y origen de la materia pero… ¡Estaremos acertando!

Tiene y encierra tantos misterios la materia que estamos aún y años-luz de y conocer sobre su verdadera naturaleza. Es algo que vemos en sus distintas formas materiales que configuran y conforman todo lo material desde las partículas elementales hasta las montañas y los océanos. Unas veces está en estado “inerte” y otras, se eleva hasta la vida que incluso, en ocasiones, alcanza la consciencia de SER. Sin embargo, no acabamos de dilucidar de dónde viene su verdadero origen, su esencia, lo que era antes de “ser” materia. ¿Existe acaso una especie de sustancia cósmica anterior a la materia? Y, si realmente existe esa sustancia… ¿Dónde está?

Claro que hemos llegado a saber que las llamadas fluctuaciones del vacío son oscilaciones aleatorias, impredecibles e ineliminables de un campo de fuerza (electromagnético o gravitatorio) que son debidas a un “tira y afloja” en el que pequeñas regiones del espacio toman prestada, momentáneamente, energía de regiones adyacentes y luego las devuelven. Pero…

– ¿Qué regiones adyacentes?

Acaso universos paralelos, acaso deformaciones del espacio-tiempo a escalas microscópicas, micros agujeros negros que pasan a ser agujeros blancos salidos de estas regiones o campos de fuerza que no podemos ver pero sí sentir, y, en última instancia, ¿por qué se forman esas partículas virtuales que de inmediato se aniquilan y desaparecen antes de que puedan ser capturadas? ¿Qué sentido tiene todo eso?

Las consecuencias de la existencia del cuanto mínimo de acción fueron revolucionarios para la comprensión del vacío. Mientras la continuidad de la acción clásica suponía un vacío plano, estable y “realmente” vacío, la discontinuidad que supone el cuanto nos dibuja un vacío inestable, en continuo cambio y muy lejos de poder ser considerado plano en las distancias atómicas y menores. El vacío cuántico es de todo menos vacío, en él la energía nunca puede quedar estabilizada en valor cero, está fluctuando sobre ese valor, continuamente se están creando y aniquilando todo tipo de partículas, llamadas por eso virtuales, en las que el producto de su energía por el tiempo de su existencia efímera es menor que el cuanto de acción. Se llaman fluctuaciones cuánticas del vacío y son las responsables de que exista un que lo inunda todo llamado campo de punto cero.

Pero volvamos de nuevo a las fluctuaciones de vacío, que al igual que las ondas “reales” de energía positiva, están sujetas a las leyes de la dualidad onda/partícula; es decir, tienen tanto aspectos de onda como aspectos de partícula.

Las ondas fluctúan de forma aleatoria e impredecible, con energía positiva momentáneamente aquí, energía negativa momentáneamente allí, y energía cero en promedio. El aspecto de partícula está incorporado en el concepto de partículas virtuales, es decir, partículas que pueden nacer en pares (dos partículas a un tiempo), viviendo temporalmente de la energía fluctuacional tomada prestada de regiones “vecinas” del , y que luego se aniquilan y desaparecen, devolviendo la energía a esas regiones “vecinas”. Si hablamos de fluctuaciones electromagnéticas del vacío, las partículas virtuales son fotones virtuales; en el caso de fluctuaciones de la gravedad en el vacío, son gravitones virtuales.

De las llamadas fluctuaciones de vacío pueden surgir, partículas virtuales y quién sabe que cosas más… Hasta un nuevo Universo.

Son muchas las preguntas que no tienen respuestas

Parece que las fluctuaciones ocurren en cualquier lugar, pero que, son tan minúsculas que ningún observador o experimentador las ha detectado de una manera franca hasta la fecha y, se sabe que están ahí por experimentos que lo han confirmado. Estas fluctuaciones son más poderosas cuanto menos escala se considera en el espacio y, por debajo de la longitud de Planck-Wheeler las fluctuaciones de vacío son tan enormes que el espacio tal como lo conocemos “pareciera estar hirviendo” para convertirse en una especie de espuma cuántica que parece que en realidad, cubre todo el espacio “vacío cuántico” que sabemos que está ahí y es el campo del que surgen esas partículas virtuales que antes mencionaba.

¿Espuma cuántica? Si profundizamos mucho en la materia… Podríamos ver otro universo distinto al nuestro. Las cosas miles de millones de veces más pequeñas que en nuestro mundo cotidiano, no parecen las mismas cosas.

Hay magnitudes asociadas con las leyes de la gravedad cuántica. La longitud de Planck-Wheeler, ![]() es la escala de longitud por debajo de la cual el tal como lo conocemos deja de existir y se convierte en espuma cuántica. El tiempo de Planck-Wheeler (1/c veces la longitud de Planck-Wheeler o aproximadamente 10-43 segundos), es el intervalo de tiempo más corto que puede existir; si dos sucesos están separados por menos que esto, no se puede decir cuál sucede antes y cuál después. El área de Planck-Wheeler (el cuadrado de la longitud de Planck-Wheeler, es decir, 2,61×10-66cm2) juega un papel clave en la entropía de un agujero negro. ¡Qué locura!

es la escala de longitud por debajo de la cual el tal como lo conocemos deja de existir y se convierte en espuma cuántica. El tiempo de Planck-Wheeler (1/c veces la longitud de Planck-Wheeler o aproximadamente 10-43 segundos), es el intervalo de tiempo más corto que puede existir; si dos sucesos están separados por menos que esto, no se puede decir cuál sucede antes y cuál después. El área de Planck-Wheeler (el cuadrado de la longitud de Planck-Wheeler, es decir, 2,61×10-66cm2) juega un papel clave en la entropía de un agujero negro. ¡Qué locura!

En el complejo general, por ahí, en alguna parte, permanece oculta esa teoría cuántica de la gravedad que incansables (pero sin ningún éxito hasta el momento) buscamos. Cuando sepamos unir las dos teorías de lo pequeño y lo grande, lo tendremos todo.

Como tantas veces hemos comentado, los trabajos que se han realizado sobre poder construir una teoría cuántica de la gravedad nos llevan a un sorprendente de implicaciones. Por un lado, sólo se ha podido conceptuar a la gravedad cuántica, siempre y cuando, el universo tenga más de cuatro dimensiones. Además, se llega a considerar que en la era de Planck, tanto el universo como la gravedad pudieron ser una sola cosa compacta estructurada por objetos cuánticos infinitamente diminutos, como los que suponemos que conforman las supercuerdas. A esta escala, el mismísimo espaciotiempo estaría sometido a imprescindibles fluctuaciones muy semejantes a las que causan las partículas al nacer y desaparecer de la existencia en el espaciotiempo ordinario. Esta noción ha conducido a los teóricos a describir el universo de la era cuántica como una especie de extremadamente densa y agitada espuma que pudo haber contenido las vibrantes cuerdecillas que propugnan los cosmólogos cuerdistas.

Los físicos especulan que el cosmos ha crecido a desde una «nada» primigenia que al nacer comenzó el principio del tiempo y que, en ese parto, contenía toda la materia y toda la energía.

Hemos imaginado que nuestro universo surgió de una fluctuación de vacío a partír de otro universo

En física como en todas las demás disciplinas científicas, los conocimientos avanzan y las teorías que sostuvieron los cimientos de nuestros conocimientos se van haciendo viejas y van teniendo que ser reforzadas con las nuevas y más poderosas “vigas” de las nuevas ideas y los nuevos hallazgos científicos que hacen posible ir perfeccionando lo que ya teníamos.

Recientemente se han alzado algunas voces contra el Principio de Incertidumbre de Heisenberg. He podido leer en un artíoculo de la prestigiosa Revista Nature, un artículo del premio Nobel de Física Gerald ´t Hoofft, en el que propone que la naturaleza probabilistica de la mecánica cuántica, desaparecería a la escala de Planck, en la que el comportamiento de la materia sería determinista; a longitudes mayores, energías más pequeñas.

El mundo de lo muy pequeño (el micro espacio), a nivel atómico y subatómico, es el dominio de la física cuántica, así nunca podríamos saber, de acuerdo m con el principio de incertidumbre, y, en un momento determinado, la posición y el estado de una partícula. Este estado podría ser una función de la escala espacio-temporal. A esta escala tamaños todo sucede demasiado deprisa para nosotros.

El “universo cuántico” nada es lo que parece a primera vista, allí entramos en otro mundo que en nada, se parece al nuestro

Cuando hablamos de la mecánica cuántica, tenemos mirar un poco hacia atrás en el tiempo y podremos darnos del gran impacto que tuvo en el devenir del mundo desde que, en nuestras vidas, apareció el átomo y, más tarde, sus contenidos. Los nombres de Planck, Einstein, Bohr, Heisenberg, Schrödinger, Pauli, Bardeen, Roentgen, Dirac y muchos otros, se pudieron a la cabeza de la lista de las personas más famosas. Aquel primer premio Nobel de Física otorgado en 1900 a Roentgen por descubrir los rayos X, en el mismo año llegaría el ¡cuanto! De Planck que inspiró a Einstein para su trabajo sobre el Efecto fotoeléctrico que también, le valdría el Nobel, y, a partir de ese momento, se desencadenó una especie de alucinante por saber sobre el átomo, sus contenidos, y, de qué estaba hecha la materia.

La conocida como Paradoja EPR y los conceptos de Tiempo y , presente, pasado y futuro.

“Nadie ha resuelto la paradoja del gato de Schroedinger, ni la paradoja de Einstein-Podolsky-Rosen. El principio de incertidumbre no se ha explicado y se asume como un dogma, lo mismo pasa con el spin. El spin no es un giro pero es un giro. Aquí hay un desafío al pensamiento humano. ¡Aquí hay una aventura del pensamiento!”

Fueron muchas las polémicas desatadas a cuenta de las aparentes incongruencias de la moderna Mecánica Cuántica. La paradoja de Einstein-Podolsky-Rosen, denominada “Paradoja EPR”, trata de un experimento mental propuesto por Albert Einstein, Boris Podolsky y Nathan Rosen en 1935. Es relevante, pues pone de manifiesto un problema aparente de la mecánica cuántica, y en las décadas siguientes se dedicaron múltiples esfuerzos a desarrollarla y resolverla.

A Einstein (y a muchos otros científicos), la idea del entrelazamiento cuántico le resultaba extremadamente perturbadora. Esta particular característica de la mecánica cuántica permite preparar estados de dos o más partículas en los cuales es imposible obtener útil sobre el estado total del sistema haciendo sólo mediciones sobre una de las partículas.

Por otro lado, en un entrelazado, manipulando una de las partículas, se puede modificar el estado total. Es decir, operando sobre una de las partículas se puede modificar el estado de la otra a distancia de manera instantánea. Esto habla de una correlación entre las dos partículas que no tiene paralaje en el mundo de nuestras experiencias cotidianas. Cabe enfatizar pues que cuando se mide el estado de una partícula, enseguida sabemos el estado de la otra, lo cual aparentemente es instantáneo, es decir, sin importar las distancias a las que se encuentren las partículas, una de la otra, ambas saben instantáneamente el estado de la otra.

El experimento planteado por EPR consiste en dos partículas que interactuaron en el pasado y que quedan en un estado entrelazado. Dos observadores reciben cada una de las partículas. Si un observador mide el momento de una de ellas, sabe cuál es el momento de la otra. Si mide la posición, gracias al entrelazamiento cuántico y al principio de incertidumbre, puede la posición de la otra partícula de forma instantánea, lo que contradice el sentido común.

Animación que muestra dos átomos de oxígeno fusionándose para formar una molécula de O2 en su estado cuántico fundamental. Las nubes de color representan los orbitales atómicos. Los orbitales 2s y 2p de cada átomo se combinan para formar los orbitales σ y π de la molécula, que la mantienen unida. Los orbitales 1s, más interiores, no se combinan y permiten distinguir a cada núcleo. Lo que ocurre a escalas tan pequeñas es fascienante.

Si nos pudiéramos convertir en electrones, por ejemplo, sabríamos dónde y cómo estamos en cada momento y podríamos ver asombrados, todo lo que estaba ocurriendo a nuestro alrededor que, entonces sí, veríamos transcurrir a un ritmo más lento del que podemos detectar en los electrones desde nuestro macroestado espacio temporal. El electrón, bajo nuestro punto de vista se mueve alrededor del núcleo atómico a una velocidad de 7 millones de km/h.

A medida que se asciende en la escala de tamaños, hasta el tiempo se va ajustando a esta escala, los objetos, a medida que se hacen mayores se mueven más despacio y, además, tienen más duración que los pequeños objetos infinitesimales del micro mundo cuántico. La vida media de un neutron es de unos 15 minutos, por ejemplo, mientras que la vida media de una estrellas se puede contar en miles de millones de años.

En nuestra macroescala, los acontecimientos y ,los objetos se mueven a velocidades que a nosotros nos parecen normales. Si se mueven con demasiada lentitud nos parece que no se mueven. Así hablamos de escala de tiempo geológico, para referirnos al tiempo y velocidad de la mayor parte de los acontecimientos geológicos que afectan a la Tierra, el tiempo transcurre aquí en millones de años y nosotros ni lo apreciamos; nos parece que todo está inmóvil. Nosotros, los humanos, funcionamos en la escala de años (tiempo biológico).

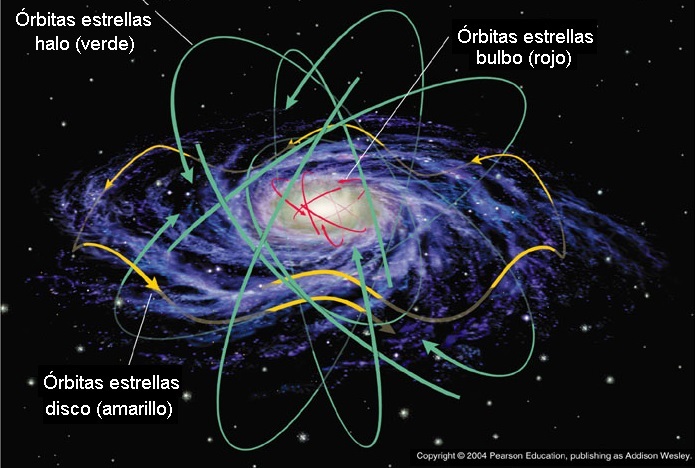

El Tiempo Cosmológico es aún mucho más dilatado y los objetos cósmicos (mundos, estrellas y galaxias), tienen una mayor duración aunque su movimiento puede ser muy rápido debido a la inmensidad del espacio universal en el que se mueven. La Tierra, por ejemplo, orbita alrededor del Sol a una velocidad media de 30 Km/s., y, el Sol, se desplaza por la Galaxia a una velocidad de 270 km/s. Y, además, se puede incrementar el tiempo y el espacio en su andadura al estar inmersos y ligados en una misma maya elñástica.

Así, el espacio dentro de un átomo, es muy pequeño; dentro de una célula, es algo mayor; dentro de un animal, mayor aún y así sucesivamente… hasta llegar a los enormes espaciosa que separan las estrellas y las galaxias en el Universo.

Distancias astronómicas separan a las estrellas entre sí, a las galaxias dentro del cúmulo, y a los cúmulos en los supercúmulos.

Las distancias que separan a los objetos del Cosmos se tienen que medir con unidades espaciales, tal es su inmensa magnitud que, nuestras mentes, aunque podamos hablar de ellas de manera cotidiana, en realidad, no han llegado a asimilarlas.Y, a todo ésto, los físicos han intentado con denuedo elaborar una teoría completa de la gravedad que incluya la mecánica cuántica. Los cálculos de la mayoría de las teorías propuesta de la «gravedad cuántica» arrojan numerosos infinitos. Los físicos no están seguros si el problema es técnico o conceptual. No obstante, incluso prescindiendo de una teoría completa de gravedad cuántica, se puede deducir que los efectos de la teoría cuántica, habrían cruciales durante los primeros 10-43 segundos del inicio del universo, cuando éste tenía una densidad de 1093 gramos por centímetro cúbico y mayor. (El plomo sólido tiene una densidad de aproximadamente diez gramos por centímetro cúbico.) Este período, que es el que corresponde a la era de Planck, y a su estudio se le llama cosmología cuántica. Como el universo en su totalidad habría estado sujeto a grandes incertidumbres y fluctuaciones durante la era de Planck o era cuántica, con la materia y la energía apareciendo y desapareciendo de un vacío en grandes cantidades, el concepto de un principio del universo podría no tener un significado bien definido. En todo caso, la densidad del universo durante este período es de tal magnitud que escapa a nuestra comprensión. Para propósitos prácticos, la era cuántica podría considerarse el estado inicial, o principio, del universo. En consecuencia, los procesos cuánticos ocurridos durante este período, cualquiera sea su naturaleza, determinaron las iniciales del universo.

Una cosa nos ha podido quedar clara: Los científicos para lograr conocer la estructura del universo a su escala más grande, deben retroceder en el tiempo, centrando sus teorías en el momento en que todo comenzó. Para ello, como todos sabéis, se han formulado distintas teorías unificadoras de las cuatro fuerzas de la naturaleza, con las cuales se han modelado acontecimiento y en el universo primitivo casi a todo lo largo del camino hasta el principio. Pero cómo se supone que debió haber habido un «antes», aparece una barrera que impide ir más allá de una frontera que se halla fijada a los 10-43 [s] después del Big Bang, un instante conocido como «momento de Planck», en homenaje al físico alemán Max Planck.

Esta barrera existe debido a que antes del momento de Planck, durante el período llamado la «era de Planck o cuántica», se supone que las cuatro fuerza fundamentales conocidas de la naturaleza eran indistinguibles o se hallaban unificadas , que era una sola fuerza. Aunque los físicos han diseñado teorías cuánticas que unen tres de las fuerzas, una por una, a través de eras que se remontan al momento de Planck, hasta ahora les ha prácticamente imposible armonizar las leyes de la teoría cuántica con la gravedad de la relatividad de Einstein, en un sólo modelo teórico ampliamente convincente y con posibilidades claras de ser contrastado en experimentos de laboratorio y, mucho menos, con observaciones.

Y después de todo ésto, sólo una caso me queda clara: ¡Lo poco que sabemos! A pesar de la mucha imaginación que ponemos en las cosas que creemos conocer.

emilio silvera

Ene

9

Convivimos con ellas sin prestarles atención I

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y la Vida ~

Clasificado en El Universo y la Vida ~

Comments (0)

Comments (0)

Existen inesperadas conexiones entre los cuerpos celestes y los patrones que rigen la Vida en el Planeta Tierra, No pocas de las secuencias que podemos observar, son la consecuencia directa de dichas conexiones, a las que, la mayoría de las veces, no le prestamos la menor atención.

Merece la pena examinar esos vínculos que, situados a niveles diferentes, pueden comenzar en puntos temporales subyacentes en el entorno terrestre y terminar con las respuestas que los seres vivos, donde sólo los Humanos, aprendieron a dar al reino astronómico el valor y la conexión que en todo ello tenían.

Estas respuestas (aunque a veces nos parezcan ancestrales), aún se manifiestan en nuestra organización social, y también subyacen a muchas de nuestras respuestas metafísicas y emocionales del Universo.

Hemos estado tentados a ver las estrellas como dioses, como demonios, como la mejor guía para la navez viajeras, como la profesía de la mala suerte, o, lo que es peor, como gobernantes de cada una de nuestras acciones.

Descubrimos también que hemos sido tremendamente afortunados por el simple hecho de que, la forma de vida que representamos, vino a caer, por razones del Azar, dentro de un entorno celeste que influye significativamente en el alcance y dirección de cualquier investigación científica del Universo que, en nuestra pacífica Región, se hace totalmente posible al estar alejados de lugares turbulentos y emisiones de inmensas energías que impedidirían cualquier clase de observación y estudio fiable.

Si en nuestro entorno explotaran Supernovas y estuvieran presentes Agujeros Negros masivos… ¡Las cosas serían muy diferentes para nosotros, o, incluso, no serían!

Nuestros primeros pasos preconscientes, es decir, los de nuestros ancestros primitivos a lo largo del Sendero Evolutivo, se produjeron en un mundo de alternancia diaria de la noche y el día, una crecida y bajada mensual de las mareas y una variación anuela en las horas diurnas y en el clima. Todos estos cambios de escenarios dejaron su impronta sobre nosotros, los actores en el serial de la Vida.

Algunos seres vivos pudieron sobrevivir mejor porque variaciones fortuitas les dieron ritmos corporales que reflejaban con precisión el pulso de cambios ventajosos en el entorno que pudieron ser aprovechados por ellos, tanto en las plantas como en los animales de todo tipo. Unos pudieron adaptarse y otros no.

Esos otros, sintieron directa y vivamente en su propios metabolismos aquellos cambios que los ritmos celestes imponían y a los que ellos, no se pudieron adaptar, y, de esa manera, sus especies perecieron y dejaron de existir.

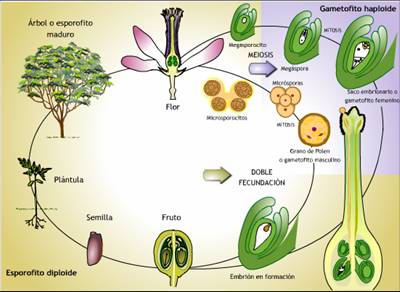

El mundo está lleno de Plantas y Animales que han crecido sensibles al ciclo de la noche y el día, el cielo estacional del calor del Sol y la variación mensual de las mareas. Las mareas oceánicas provocadas por las feses de la Luna influyeron en la evolución de los crustáceos y los anfibios.

La formación de regiones con grandes diferencias entre mareas vivas y muertas, con alternancia de períodos de inmersión y períodos secos, puede haber animado la disfunción de la vida del mar a la tierra. Las condiciones cambiantes estimulan la evolución de un tipo de complejidad que lleva a la vida porque crea condiciones en las que la variación supone una diferencia en las perspectivas de supervivencia (adaptarse o morir).

Existen huellas claras de un período anual en los ciclos vitales de las plantas y de los demás seres vivos de que, han favorecido su adaptación evolutiva y han hecho posible la supervivencia y crecimientos de las especies y sus “relojes” innatos que hace coincidir, en no pocos casos, el nacimiento de sus crías con momentos en los que la posibilidad de supervivencia es mayor, especialmente, en las regiones templadas, donde las estaciones cambian de manera más abruptas.

En la manera que hemos podido llegar a descubrir, de cómo desovan algunos y como tienen en cuenta el momento de la Luna nueva o Luna llena , y los peces desoven después de enterrar la mitad de sus cuerpos en la arena. De esta manera les da tiempo a que las mareas no puedan arrastrarlos para evitar su puesta.

Los animales sienten el cambio de las Estaciones por una respuesta a la duración de la Luz diurna. Hay ejemplos notables de la precisión de esta sensibilidad, que optimiza la fertilidad de las hembras para que coincida con el equinoccio de primavera.

Parece que la actividad de apareo se desencadena cuando la duración de la Luz diurna alcanza un valor crítico. Los experimentos muestran que pueden haber dos fases:

– Amor a la Luz

– Amor en la Oscuridad

En la primera fase, cuando la luz cae en el cuerpo estimula el crecimiento y la actividad; en la segunda fase, estas cosas se inhiben. En días largos, más luz estimula las respuestas bioquímicas más fuertes.

Pero la situación no es siempre tan sencilla. Las criaturas pueden poner a cero sus relojes internos exponiéndolos a entornos artificiales.

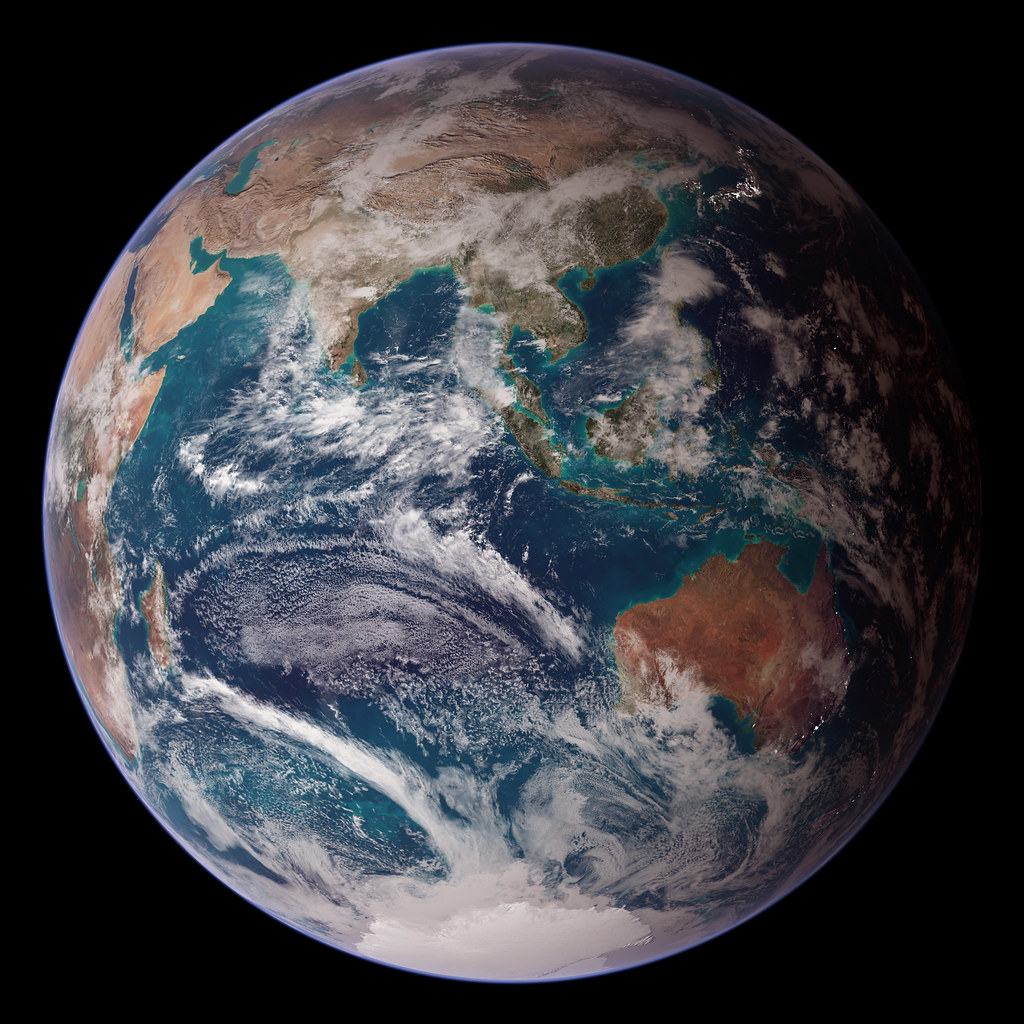

El día y el Año son las más simples de nuestras de nuestras divisiones temporales. La longitud del día está determinada por el Tiempo que tarda la Tierra en dar una vuelta alrededor de su eje. El día sería mucho más largo si la Tierra rotara más lentamente, y las variaciones diurnas no existirían en absoluto si la Tierra no tuviera rotación. En este caso, los seres vivos estarían, divididos entre tres poblaciones diferentes:

– Los que vivirían en el lado oscuro

– Los que vivirían en el lado luminoso

– Los que vivirían en la Zona Corpuscular intermedia

Está claro que hay un límite en lo que se refiere a que el día sea más corto o más largo, todo dependerá de los factores que en ello puedan intervenir. El día no podría ser mucho más corto porque hay un límite en la rápido que puede girar un cuerpo antes de que empiece a despedir a todos los objetos que estén sibre su superficie y, más tarde, a desintegrarse. De hecho, la longitud del día está alargándose muy lentamente, aproximadamente dos milésimas de segundo cada siglo, debido a la atracción de la Luna.

Seguramente, algunos de ustedes, al leer “…dos milésimas de segunda cada siglo…”, hayan podido pensar: Qué tontería, y, qué puedo eso influir en nada.

Lo cierto es que, durante los enormes períodos necesarios para un cambio Geológico o Biológico destacable, ese infinitesimal aumento adquiere una importancia vital.

Desde entonces la Tierra aumento su velocidad haciendo el día más largo

El día habría sido 11 horas más corto hace ahora 2.000 millones de años, cuando vivían las antiguas bacterias fósiles conocidas y halladas en las rocas más antiguas de la Tierra en Warradona (Australia). Se han hallado pruebas directas de este cambio impresos en los seres vivos en algunas arrecifes de las Bahamas.

En el coral se depositan bandas de crecimiento anual (similares a los anillos de los árboles), y contando cuantas bandas diarias hay en cada banda anual se puede determinar cuantos ciclos diarios había en un año. El crecimiento coral contemporáneo muestra unas trescientas sesenta y cinco bandas por cada año, aproximadamente lo que se esperaba, mientras que los corales de hace 350 millones de años, muestran unos cuatrocientos anillos diarios en cada banda anual, lo que nos indica que el día era entonces de sólo 21,9 horas.

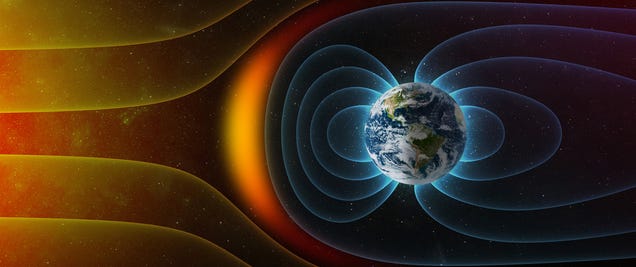

Si hacemos un viaje al pasado, para tratar de contemplar la evolución terrestre desde su formación, podríamos contemplar cómo, la Tierra jóven podría haber tenido días de tan sólo 6 horas. Así pués, si la Luna no existiera nuestro día sería (probablemente) dee sólo un cuarto de su longitud actual. Esto también hubiera tenido consecuencias para el campo magnético de la Tierra. Con un día de sólo 6 horas, la rotación más rápida de partículas cargadas dentro del planeta produciría un campo terrestre tres veces más intenso que el actual.

La sensibilidad magnética sería una adaptación más económica para los seres vivos de un mundo semejante.Sin embargo, los efectos ambientales de más largo alcance de un día más corto serían seguidos de vientos más fuertes, mucho más fuertes que azotarían que azotarían la superficie en rotación del planeta.

El grado de erosión por el viento y las olas sería muy grande. Habría presión selectiva hacia árboles más pequeños y para que las plantas desarrollaran hojas más pequeñas y más fuertes que fueran menos susceptibles de ser arrancadas. Esto podría alterar el curso de la evolución de la atmósfera terrestres al retrasar la conversión de su primitiva atmósfera de dióxido de Carbono en Oxígeno por acción de la Fotosíntesis.

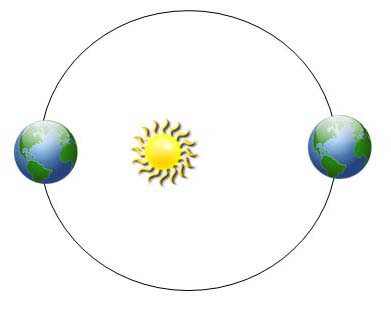

El año está determinado por el Tiempo que tarda la Tierra en completar una órbita alrededor del Sol. Este período de Tiempo no es en modo alguno aleatorio. Las temperaturas y emisiones de energía de las estrellasd estables están fijadas por las intensidades invariantes de las fuerzas de la naturaleza.

En un planeta sólo puede haber una actividad Biológica si su temperatura superficial no es extrema. Demasiado calor y las moléculas se frien; demasiado frío, y se congelan; pero en medio, hay un rango de temperaturas en el que pueden multiplicarse y crecer en complejidad los seres vivos.

Existe un estrecho rango dentro del cual el agua puede mantenerse líquida y ese estado es el óptimo para la evolución expontánea de la vida. El agua ofrece un ambiente maravilloso para la evolución de la Química compleja porque aumenta tanto la movilidad como la acumulación de grandes concentraciones de moléculas que se pueden transformar en estructuras complejas.

Estas limitaciones a las temperaturas garantizan a los seres vivos que su biología les exige estar situados en planetas que no estén demasiado cerca de su estrella madre, ni tampoco, demasiado lejos de su luz y su calor. Es lo que llamamos estar situados en la Zona habitable de una estrella para que, en los planetas allí situados, la vida pueda florecer.

Otra cuestión importe es que, esos planetas, tengan órbitas casi circulares, si queremos que dichos planetas permanezcan en esa Zona habitable, ya que, si la órbita es elíptica se saldría de ella y, la vida, tendría muchos problemas para poder mantenerse estable.

Aquí semuestra algunas órbitas elípticas con diferentes excentricidades. Así mismo, muestra cómo está el Sol durante el foco de una elipse, y algo de la matemática que hay tras las órbitas elípticas. Animación de Randy Russell (miembro del equipo de Ventanas al Universo).

Las órbitas elípticas llevarían al planeta a puntos con diferentes distancias y temperaturas con lo cual, la vida tendría muchos problemas para poder resistir cambios tan drásticos que, por lo general, serían mortales para los seres vivos de aquel planeta.

La Tierra en su deambular alrededor del Sol, describe una órbita elíptica pero, poco pronunciada. Su máxima distancia del Sol es de 1,017 veces la distancia media, y su mínima distancia es sólo de 0,983 veces la distancia media que sería la de 1 UA.

Como veréis, la ligera variación hace de la órbita “casi” un círculo perfecto y la variación anuela es aproximadamente de un 7% en el flujo de energía que la superficie de la Tierra recibe del Sol. La cercanía de la órbita de la Tierra a un círculo, tiene una importancia evidente.

La regularidad de la Tierra que viene dada por la intensidad de energía que nos envía el Sol, desde 150 millones de kilómetros, y, la intensidad está amortiguada por la rica y densa atmósfera terrestre, y, los seres vivos, tienen un escudo contra las radiaciones nosivas.

Dejemos aquí la primera parte.

En la segunda parte seguiremos hablando de la importancia que tiene la Luna para nosotros y explicaremos el por qué de las Estaciones en nuestro planeta.

La Fuente: “El Universo como Obra de Arte” JOHN D. BARROW.

Ene

8

Una de miedo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo dinámico ~

Clasificado en El Universo dinámico ~

Comments (0)

Comments (0)

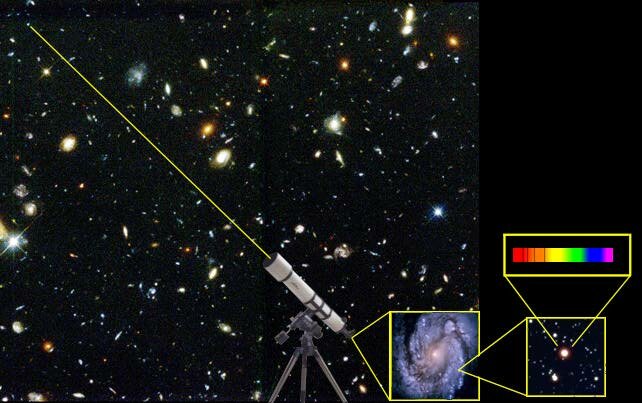

Los científicos pronostican una colisión de nuestra galaxia con la Gran Nube de Magallanes – Vídeo: ABC Multimedia/ The Auriga Project Una catastrófica colisión nexpulsará al Sistema Solar de nuestras Galaxia

En contra de lo que se creía, la Gran Nube de Magallanes chocará «en breve» con la Vía Láctea

Un equipo de investigadores de la universidad británica de Durham acaba de descubrir que la Gran Nube de Magallanes, una galaxia satélite de la nuestra, se precipitará contra la Vía Láctea en algún momento de los próximos 2.000 millones de años. Es decir, mucho antes de la titánica colisión con Andrómeda, la enorme vecina galáctica que los científicos creen que chocará con nosotros dentro de 8.000 millones de años.

Según la investigación, que acaba de publicarse en Montly Notices of the Royal Astronomical Society, la catastrófica fusión con la Gran Nube de Magallanes podría “despertar” a Sagitario A*, el agujero negro supermasivo que duerme en el centro de nuestra galaxia, que empezaría a devorar cuanto le rodea y que podría aumentar hasta diez veces su tamaño. En la actualidad, Sagitario A* tiene una masa equivalente a la de cuatro millones de soles.

A medida que el “monstruo” se fuera alimentando de los gases y materiales de su alrededor, el ahora inactivo agujero negro empezaría a expulsar radiación de alta energía, y aunque estos auténticos “fuegos artificiales cósmicos” no afectarían directamente a la Tierra, los investigadores creen que existe la posibilidad de que la colisión inicial pueda enviar a todo nuestro Sistema Solar al profundo vacío del espacio intergaláctico.

Galaxias satélite

La Gran Nube de Magallanes es la mayor galaxia satélite de la Vía Láctea

Las galaxias muy masivas, como lo es la nuestra, suelen estar rodeadas por un grupo de “pequeñas” galaxias satélite, que se mueven a su alrededor de forma parecida a como lo hacen las abejas alrededor de sus colmenas. Por lo general, estas pequeñas galaxias disfrutan de una vida tranquila, y orbitan sin novedad a sus galaxias anfitrionas durante miles de millones de años. Sin embargo, de vez en cuando, puede suceder que choquen con ellas, se hundan en su interior y sean irremediablemente “devoradas”.

Descubren dos nubes de gas en la Gran Nube de Magallanes

Detalle de una región de formación de estrellas en la Gran Nube de Magallanes, una de las galaxias satélite de la Vía Láctea.

EFE

En el caso de la Vía Láctea, la mayor y más brillante de sus galaxias satélite es precisamente la Gran Nube de Magallanes, que “llegó a nuestro barrio” hace apenas unos 1.500 millones de años y se encuentra a 163.000 años luz de distancia. Hasta hace poco, los astrónomos pensaban que esta pequeña galaxia orbitaría la Vía Láctea sin mayor problema durante muchos miles de millones de años, y que quizá la gran velocidad a la que se mueve la llevaría después a escapar de su atracción gravitatoria y proseguir en solitario su viaje por el espacio.

Pero el trabajo de los investigadores, que utilizaron una simulación hecha con el supercomputador EAGLE de la Universidad de Helsinki, especialmente diseñado para estudiar la formación de galaxias, les llevó a unas conclusiones completamente distintas: La Gran Nube de Magallanes no escapará nunca de la influencia gravitatoria de la Vía Láctea. Y no solo eso, sino que terminará por colisionar con ella en un “breve” periodo de tiempo.

Bueno, aunque estamos a 26.000 años luz del centro galáctico donde habita Sagitario A. unn acontecimiento de esta envergadura… ¡Traería consecuencias!

En palabras de Marius Cautun, que ha dirigido el trabajo, “Aunque 2.000 millones de años pueda parecer una eternidad si se compara con una vida humana, en escalas de tiempo cósmicas es, en realidad, un periodo muy corto. Y la destrucción de la Gran Nube de Magallanes cuando sea devorada por la Vía Láctea causará también estragos en nuestra propia galaxia, despertando al agujero negro que vive en su centro y convirtiendo la galaxia en un núcleo galáctico activo, o quasar”.

“El fenómeno -prosigue el investigador- generará poderosos chorros de radiación de alta energía emanando de los polos del agujero negro. Y si bien esto no afectará directamente a nuestro Sistema Solar, existe una pequeña posibilidad de que no podamos escapar ilesos de la colisión, cuyos efectos podrían empujarnos fuera de la Vía Láctea, hacia el profundo vacío del espacio intergaláctico”.

Un gran espectáculo

Según los investigadores, la colisión entre la Gran Nube de Magallanes y la Vía Láctea será espectacular. En palabras de Carlos Frenk, director del Instituto de Cosmología Computacional de la Universidad de Durham y coautor del estudio, “Por muy hermoso que sea, nuestro Universo evoluciona constantemente a través de eventos muy violentos, como será la próxima colisión con la Gran Nube de Magallanes“.

“A menos que se produzcan grandes desastres -prosigue Frenk- como una perturbación importante para el Sistema Solar, nuestros descendientes, si para entonces hay alguno, se encontrarán con un espectacular despliegue de fuegos artificiales cósmicos a medida que el recién despertado agujero negro supermasivo del centro de nuestra galaxia empiece a emitir enormes y brillantes chorros de radiación extremadamente energética”.

Totales: 85.989.657

Totales: 85.989.657 Conectados: 59

Conectados: 59