Mar

23

De lo pequeño a lo grande y, conocer la Naturaleza…¡No será...

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

“Una formulación muy hermosa que, creo, procede de América es la siguiente: alguien que ha golpeado a otro afirma que sólo ha movido sus puños libremente; el juez, sin embargo, replica: «La libertad de movimiento de tus puños está limitada por la nariz de tu vecino».

Debido al principio de exclusión de Pauli, es imposible que dos fermiones ocupen el mismo cuántico (al contrario de lo que ocurre con los bosones). La condensación Bose-Einstein es de importancia fundamental explicar el fenómeno de la superfluidez. A temperaturas muy bajas (del orden de 2×10-7º K) se formar un condensado de Bose-Einstein, en el que varios miles de átomos forman una única entidad (un superátomo). efecto ha sido observado con átomos de rubidio y litio. Como ha habréis podido suponer, la condensación Bose-Einstein es llamada así en honor al físico Satyendra Nath Bose (1.894 – 1.974) y a Albert Einstein. Así que, el principio de exclusión de Pauli tiene aplicación no sólo a los electrones, sino también a los fermiones; pero no a los bosones.

Las reglas de la mecánica cuántica tienen que ser aplicadas si queremos describir estadísticamente un sistema de partículas que obedece a reglas de ésta teoría en vez de las de la mecánica clásica. En estadística cuantica, los estados de energía se considera que están cuantizados. La estadística de Bose-Einstein se aplica si cualquier de partículas puede ocupar un estado cuántico dado. Dichas partículas (como dije antes) son los bosones que, tienden a juntarse.

Los bosones tienen un angular n h / 2p, donde n es cero o un entero y h es la constante de Planck. bosones idénticos, la función de ondas es siempre simétrica. Si solo una partícula puede ocupar un cuántico, tenemos que aplicar la estadística Fermi-Dirac y las partículas (como también antes dije) son los fermiones que tienen momento angular (n+½) h/2p y cualquier función de ondas de fermiones idénticos es siempre antisimétrica.

La mejor teoría explicar el mundo subatómico nació en 1928 cuando el teórico Paul Dirac combinó la mecánica cuántica con la relatividad especial para explicar el comportamiento del electrón. El resultado fue la mecánica cuántica relativista, que se transformó en un ingrediente primario en la teoría cuántica de campos. Con unas pocas suposiciones y ajustes ad-hoc, la teoría cuántica de campos ha probado ser suficientemente poderosa para formar la base del modelo estándar de las partículas y las fuerzas.

La relación el espín y la estadística de las partículas está demostrada por el teorema espín-estadística. En un espacio de dos dimensiones es posible que existan partículas (o cuasipartículas) con estadística intermedia entre bosones y fermiones. Estas partículas se conocen con el de aiones; para aniones idénticos la función de ondas no es simétrica (un cambio de fase de+1) o antisimétrica (un cambio de fase de -1), sino que interpola continuamente entre +1 y -1. Los aniones pueden ser importantes en el análisis del efecto Hall cuántico fraccional y han sido sugeridos como un mecanismo para la superconductividad de alta temperatura.

Resulta fácil comprender cómo un campo magnético la partícula cargada que gira, pero ya no resulta tan fácil saber por qué ha de hacer lo mismo un neutrón descargado. Lo cierto es que cuando un rayo de neutrones incide sobre un hierro magnetizado, no se comporta de la misma forma que lo haría si el hierro no estuviese magnetizado. El magnetismo del neutrón sigue siendo un misterio; los físicos sospechan que contiene cargas positivas y negativas equivalente a cero, aunque por alguna razón desconocida, logran crear un campo magnético cuando gira la partícula.

Particularmente creo que, si el neutrón masa, si la masa es energía (E = mc2), y si la energía es electricidad y magnetismo (según Maxwell), el magnetismo del neutrón no es tan extraño, sino que es un aspecto de lo que en realidad es materia. La materia es la luz, la energía, el magnetismo, en definitiva, la fuerza que reina en el universo y que está presente de una u otra forma en todas partes (aunque no podamos verla).

Sea fuere, la rotación del neutrón nos da la respuesta a esas preguntas:

La primera demostración efectiva de antimateria se tuvo en Brookhaven en 1.965

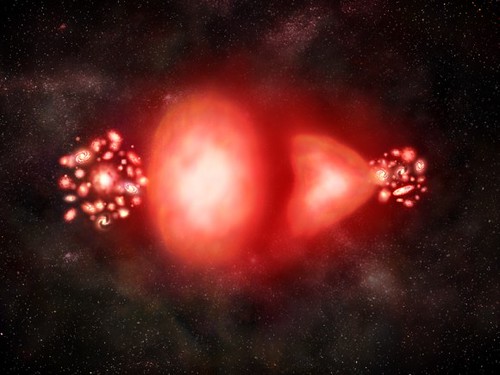

¿Qué es el antineutrón? Pues, simplemente, un neutrón cuyo movimiento rotatorio se ha invertido; su polo sur magnético, por decirlo así, está arriba y no abajo. En realidad, el protón y el antiprotón, el electrón y el positrón, muestran exactamente el mismo fenómeno de los polos invertidos. Es indudable que las antipartículas pueden combinarse para formar la antimateria, de la misma que las partículas corrientes forman la materia ordinaria.

La primera demostración efectiva de antimateria se tuvo en Brookhaven en 1.965, donde fue bombardeado un blanco de berilio con 7 protones BeV y se produjeron combinaciones de antiprotones y antineutrones, o sea, un antideuterón. entonces se ha producido el antihelio 3, y no cabe duda de que se podría crear otros antinúcleos más complicados aún si se abordara el problema con más interés.

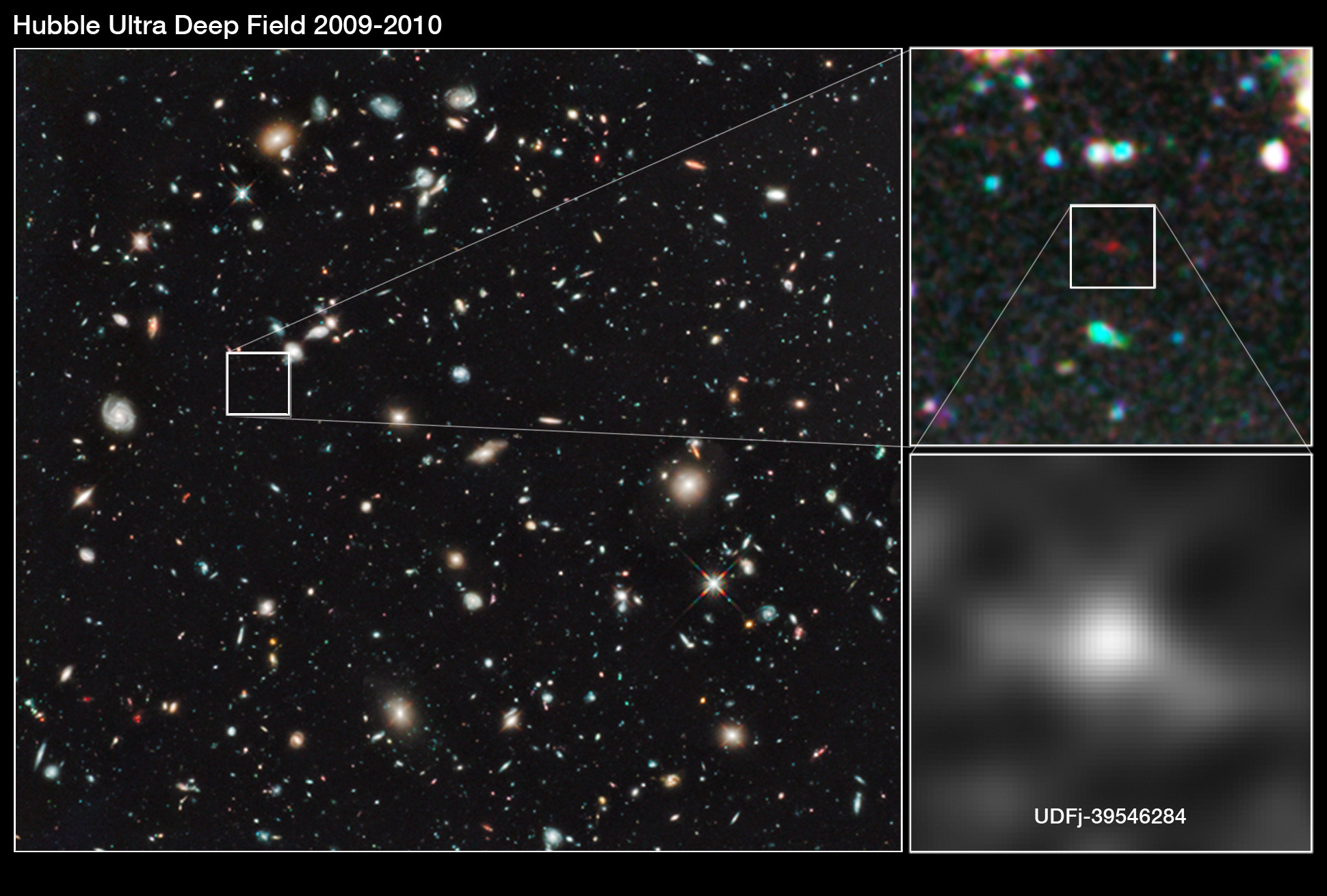

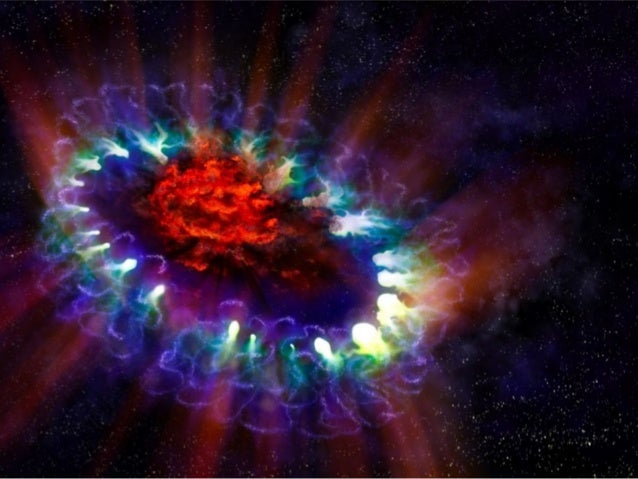

Pero, ¿existe en realidad la antimateria? ¿Hay masas de antimateria en el universo? Si las hubiera, no revelarían su presencia a cierta distancia. Sus efectos gravitatorios y la luz que produjeran serían idénticos a los de la materia corriente. Sin embargo, cuando se encontrasen las masas de las distintas materias, deberían ser claramente perceptibles las reacciones masivas del aniquilamiento mutuo resultante del encuentro. Así pues, los astrónomos observan especulativamente las galaxias, tratar de encontrar alguna actividad inusual que delate interacciones materia-antimateria.

…, ¿Hay masas de antimateria en el Universo? ¿Galaxias de antimateria?

Bueno, sabemos que no son las galaxias las que se alejan, sino que es el espacio el que se expande. Lo que no sabemos es encontrar antimateria en el espacio interestelar y, si la hay y está presente… ¡Aún no la hemos podido localizar! Algunos dicen que hay galaxias de antimateria y, yo digo que tengo un pariente en la galaxia Astrinia del cúmulo Ultramón a diez mil millones de años-luz de nuestra región.

No parece que dichas observaciones, al menos hasta el , hayan sido un éxito.

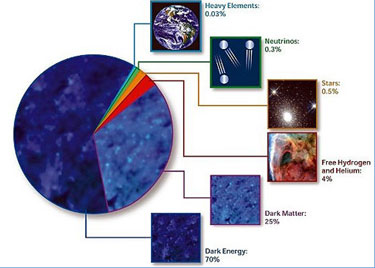

Según estimaciones recientes, resumidas en gráfico de la NASA, alrededor del 70% del contenido energético del Universo consiste en energía oscura, cuya presencia se infiere en su efecto sobre la expansión del Universo pero sobre cuya naturaleza última no se sabe casi nada.

¿Es posible que el Universo este formado casi enteramente por materia, con muy poca o ninguna antimateria? Y si es así, ¿por qué? dado que la materia y la antimateria son equivalentes en todos los aspectos, excepto en su oposición electromagnética, cualquier fuerza que crease una originaria la otra, y el Universo debería estar compuesta de iguales cantidades de la una y de la otra.

Este es el dilema. La teoría nos dice que debería haber allí antimateria, pero las observaciones lo niegan, no lo respaldan. ¿Es la observación la que falla? ¿Y qué ocurre con los núcleos de las galaxias activas, e incluso más aún, con los causares? ¿Deberían ser estos fenómenos energéticos el resultado de una aniquilación materia-antimateria? ¡No creo! Ni siquiera ese aniquilamiento parece ser suficiente, y los astrónomos prefieren aceptar la noción de colapso gravitatorio y fenómenos de agujeros negros como el único mecanismo conocido para producir la energía requerida.

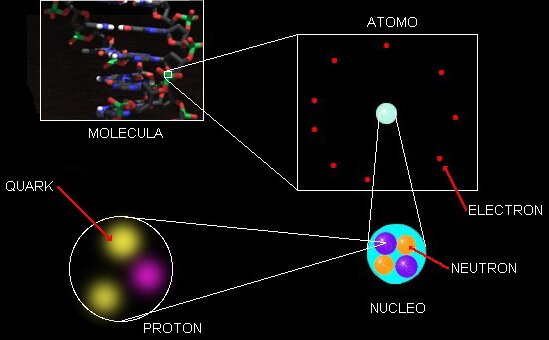

Estábamos hablando de mecánica cuántica y me pasé, sin que me diera , al ámbirto de la antimateria y el espacio del macro universo de las galaxias. Sin embargo, y aunque parezcan temas dispares, lo cierto es que, a medida que profundizamos en estas cuestiones, todas nos llevan, de una u otra manera, a relacionar el “mundo de lo muy pequeño” con el “mundo” de lo muy grande que, al fín y al cabo, está hecho de lo que existe en el primero, es decir, partículas infinitesimales de materia y… ¡de antimateria! para que todo quede compensado.

Sus dimensiones y masa le permiten ¡lo imposible! para nosotros. La tensión superficial es una consecuencia de que todas las moléculas y los átomos se atraen unos a otros con una fuerza que nosotros llamamos fuerza de Van der Vaalls. esta fuerza tiene un alcance muy corto. para ser más precisos, diremos que la intensidad de esta fuerza a una distancia r es aproximadamente proporcional a 1/r7. Esto significa que si se reduce la distancia entre dos átomos a la mitad, la fuerza de Van der Vaalls con la que se atraen uno a otro se hace 2 x 2 x 2 x 2 x 2 x 2 x 2 = 128 veces más intensa. Cuando los átomos y las moléculas se acercan mucho unos a otros quedan unidos muy fuertemente a través de esta fuerza.

La mecánica cuántica domina en el micromundo de los átomos y de las partículas “elementales”. Nos enseña que en la naturaleza cualquier masa, por sólida o puntual que pueda parecer, tiene un aspecto ondulatorio. Esta onda no es como una onda de agua. Se parece más a una ola de histeria que se expande: es una onda de información. Nos indica la probabilidad de detectar una partícula. La longitud de onda de una partícula, la longitud cuántica, se hace menor cuanto mayor es la masa de esa partícula.

Por el contrario, la relatividad general era siempre necesaria cuando se trataba con situaciones donde algo viaja a la velocidad de la luz, o está muy cerca o donde la gravedad es muy intensa. Se utiliza para describir la expansión del universo o el comportamiento en situaciones extremas, como la formación de agujeros negros.

La fuerza nuclear fuerte es la más potente del Universo

Sin embargo, la gravedad es muy débil comparada con las fuerzas que unen átomos y moléculas y demasiado débil para tener cualquier efecto sobre la estructura del átomo o de partículas subatómicas, se trata con masas tan insignificantes que la incidencia gravitatoria es despreciable. Todo lo contrario que ocurre en presencia de masas considerables como planetas, estrellas y galaxias, donde la presencia de la gravitación curva el espacio y distorsiona el tiempo.

Como resultado de estas propiedades antagónicas, la teoría cuántica y la teoría relativista gobiernan reinos diferentes, muy dispares, en el universo de lo muy pequeño o en el universo de lo muy grande. Nadie ha encontrado la manera de unir, sin fisuras, estas dos teorías en una sola y nueva de Gravedad-Cuántica.

¿Cuáles son los límites de la teoría cuántica y de la teoría de la relatividad general de Einstein? Afortunadamente, hay una respuesta simple y las unidades de Planck nos dicen cuales son. En realidad, es la propia Naturaleza la que marca esos límites que Stoney-Planck, supieron plasmar en ecuaciones que los marcan.

Supongamos que tomamos toda la masa del universo visible y determinamos su longitud de onda cuántica. Podemos preguntarnos en qué momento esta longitud de onda cuántica del universo visible superará su tamaño. La respuesta es: cuando el universo sea más pequeño en tamaño que la longitud de Planck, es decir, 10-33 de centímetros, más joven que el tiempo de Planck, 10-43 segundos y supere la temperatura de Planck de 1032 grados. Las unidades de Planck marcan la frontera de aplicación de nuestras teorías actuales. Para comprender en que se parece el mundo a una escala menor que la longitud de Planck tenemos que comprender plenamente cómo se entrelaza la incertidumbre cuántica con la gravedad. Para entender lo que podría haber sucedido cerca del suceso que estamos tentados a llamar el principio del universo, o el comienzo del tiempo, tenemos que penetrar la barrera de Planck. Las constantes de la naturaleza marcan las fronteras de nuestro conocimiento existente y nos dejan al descubierto los límites de nuestras teorías.

En los intentos más recientes de crear una teoría nueva para describir la naturaleza cuántica de la gravedad ha emergido un nuevo significado para las unidades naturales de Planck. Parece que el concepto al que llamamos “información” tiene un profundo significado en el universo. Estamos habituados a vivir en lo que llamamos “la edad de la información”. La información puede ser empaquetada en formas electrónicas, enviadas rápidamente y recibidas con más facilidad que nunca antes. Nuestra evolución en el proceso rápido y barato de la información se suele mostrar en una forma que nos permite comprobar la predicción de Gordon Moore, el fundador de Intel, llamada ley de Moore, en la que, en 1.965, advirtió que el área de un transistor se dividía por dos aproximadamente cada 12 meses. En 1.975 revisó su tiempo de reducción a la mitad hasta situarlo en 24 meses. Esta es “la ley de Moore” cada 24 meses se obtiene una circuiteria de ordenador aproximadamente el doble, que corre a velocidad doble, por el mismo precio, ya que, el coste integrado del circuito viene a ser el mismo, constante.

Globulos estelares con millones de estrellas

Siempre hemos tratado de buscar información del Universo para saber de nuestro entorno, de nuestro Sistema solar, de nuestra Galaxias, de las galaxias lejanas, y, de las mismas estrellas que alumbran los mundos y permite la vida con su luz y su calor. Hemos llegado a saber que somos “polvo de estrellas”, que los materiales que nos conforman están “fabricados” en sus “hornos nucleares”, la fusión creaelementos que, más tarde, forman parte de los mundos y de los seres vivos.

La velocidad de la luz en el vacío es por definición una constante universal de valor 299.792.458 m/s (suele aproximarse a 3·108 m/s), o lo que es lo mismo 9,46·1015 m/año; la segunda cifra es la usada para definir al intervalo llamado año luz. La información se transmitirá a esa velocidad como máximo, nuestro Universo, no permite mayor rapidéz, al menos, por los métodos convencionales.

Los límites últimos que podemos esperar para el almacenamiento y los ritmos de procesamiento de la información están impuestos por las constantes de la naturaleza. En 1.981, el físico israelí, Jacob Bekenstein, hizo una predicción inusual que estaba inspirada en su estudio de los agujeros negros. Calculó que hay una cantidad máxima de información que puede almacenarse dentro de cualquier volumen. Esto no debería sorprendernos.

(Longitud de Planck que al cuadrado sería de 10-66 cm2)

(Longitud de Planck que al cuadrado sería de 10-66 cm2)

Lo que debería hacerlo es que el valor máximo está precisamente determinado por el área de la superficie que rodea al volumen, y no por el propio volumen. El número máximo de bits de información que puede almacenarse en un volumen viene dado precisamente por el cómputo de su área superficial en unidades de Planck. Supongamos que la región es esférica. Entonces su área superficial es precisamente proporcional al cuadrado de su radio, mientras que el área de Planck es proporcional a la longitud de Planck al cuadrado, 10-66 cm2. Esto es muchísimo mayor que cualquier capacidad de almacenamiento de información producida hasta ahora. Asimismo, hay un límite último sobre el ritmo de procesamiento de información que viene impuesto por las constantes de la naturaleza.

Stoney Planck

No debemos descartar la posibilidad de que seamos capaces de utilizar las unidades de Planck-Stoney para clasificar todo el abanico de estructuras que vemos en el universo, desde el mundo de las partículas elementales hasta las más grandes estructuras astronómicas. Este fenómeno se puede representar en un gráfico que recree la escala logarítmica de tamaño desde el átomo a las galaxias.

Todas las estructuras del universo existen porque son el equilibrio de fuerzas dispares y competidoras que se detienen o compensan las unas a las otras; la atracción y la repulsión. Ese es el equilibrio de las estrellas donde la repulsión termonuclear tiende a expandirla y la atracción (contracción) de su propia masa tiende a comprimirla; así, el resultado es la estabilidad de la estrella. En el caso del planeta Tierra, hay un equilibrio entre la fuerza atractiva de la gravedad y la repulsión atómica que aparece cuando los átomos se comprimen demasiado juntos. Todos estos equilibrios pueden expresarse aproximadamente en términos de dos números puros creados a partir de las constantes e, h, c, G y mprotón

“Tras medir alfa en unas 300 galaxias lejanas, vimos un patrón constante: este número, que nos dice la fuerza del electromagnetismo, no es igual en otras partes que en la Tierra, y parecer variar de forma continua a lo largo de un eje”. Algunos se empeñan en variar la constante de estructura fina y, si eso llegara a producirse… las consecuencias serían funestas para nosotros. Otros estudios nos dicen que esa constante, no ha variado a lo largo de los miles de millones de años del Universo y, así debe ser, o, si varió, lo hizo en una escala ínfima.

|

α = 2πe2 / hc ≈ 1/137 |

|

αG = (Gmp2)2 / hc ≈ 10-38 |

Si varian algunas de las dos en sólo una diezmillonésima, muchas de las cosas que conforman el Universo serían imposible y, la consecuencia sería, la ausencia de vida. La identificación de constantes adimensionales de la naturaleza como a (alfa) y aG, junto con los números que desempeñan el mismo papel definitorio para las fuerzas débil y fuerte de la naturaleza, nos anima a pensar por un momento en mundos diferentes del nuestro. Estos otros mundos pueden estar definidos por leyes de la naturaleza iguales a las que gobiernan el universo tal como lo conocemos, pero estarán caracterizados por diferentes valores de constantes adimensionales. Estos cambios numéricos alterarán toda la fábrica de los mundos imaginarios. Los átomos pueden tener propiedades diferentes. La gravedad puede tener un papel en el mundo a pequeña escala. La naturaleza cuántica de la realidad puede intervenir en lugares insospechados.

Lo único que cuenta en la definición del mundo son los valores de las constantes adimensionales de la naturaleza (así lo creían Einstein y Planck). Si se duplica el valor de todas las masas no se puede llegar a saber, porque todos los números puros definidos por las razones de cualquier par de masas son invariables.

“Todos los físicos del mundo, deberían tener un letrero en el lugar más visible de sus casas, para que al mirarlo, les recordara lo que no saben. En el cartel sólo pondría esto: 137. Ciento treinta y siete es el inverso de algo que lleva el nombre de constante de estructura fina”

Lederman

Este número guarda relación con la posibilidad de que un electrón emita un fotón o lo absorba. La constante de estructura fina responde también al nombre de “alfa” y sale de dividir el cuadrado de la carga del electrón, por el producto de la velocidad de la luz y la constante de Planck. Tanta palabrería y numerología no significan otra cosa sino que ese solo numero, 137, encierra los misterios del electromagnetismo (el electrón, e–), la relatividad (la velocidad de la luz, c), y la teoría cuántica (la constante de Planck, h).

Todo eso está relacionado: leyes fundamentales, constantes, materia y espacio tiempo… ¡nosotros! Es posible (digo posible), que finalmente no seámos ni tanto ni tan poco como a veces creemos. Dejémos en un término medio nuestra valia en el contexto del Universo, aunque, poder crear ideas y pensamientos… ¡No es cosa valadí!

emilio silvera

Mar

23

¿La Física? Mucho más de lo que nos pueda parecer

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Para ser llamado científico, un método de investigación debe basarse en lo empírico y en la medición, sujeto a los principios específicos de las pruebas y el razonamiento, hay que demostrar con certeza la teoría.

Empecé a estudiar física hace ahora unos 50 años. Y poco a poco he ido viendo que una parte de la física iba dejando de ser ciencia, olvidando el método de Galileo, y avanzando hacia un sistema dogmático, místico e iniciático. Recordemos que el método dogmático es aquel en el cual se exige aceptar una afirmación que no esta apoyada en ningún hecho comprobable: La afirmación de que las tablas de la ley las había entregado una deidad, por ejemplo. Hoy es imposible, en el campo de la física, no aceptar la afirmación incomprobable, de que el mundo empezó en un Big-Bang, con una cierta energía que no se sabe que era, y moviéndose de una forma que exige un razonamiento circular que pasa de energía a frecuencias de algo que se desconoce, a energías de caracter desconocido a frecuencias de ….., y así indefinidamente.

Pero como con las tablas de la ley, nadie puede subir a la montaña a verificar las afirmaciones expresadas, que sin embargo hay que creer bajo pena de excomunión. Nadie puede volar en el tiempo hacia atrás hasta hace unos miles de millones de años, para verificar la hipótesis.

El sistema avanza hacia el misticismo: ¿Que otra cosa es la idea de las supercuerdas, una idea que para Steven Weinberg, padre de la Gran Unificacion, era ilusionante, pero se ha revelado incapaz de tener algo que ver con la realidad? O la SUSY, la supersimetría que postula que, por ejemplo, los electrones, con spin fraccionario, tengan simétricos con spin entero, selectrones que nadie ha medido ni de lejos.

Claro que, todas estas hipótesis, son ilusionantes y nos gustaría (en algunos casos) que fueran ciertas. Una cosa está clara: No tenemos en la actualidad ningún medio de verificarlas, como nos pasa con la Teoría de Cuerdas que, según han calculado, para llevar a cabo un experimento que nos posibilitará encontrarlas, necesitaríamos disponer de la Energía de Planck, es decir, 1019 GeV, una energía que ni uniendo todos los sistemas de nuestro mundo podríamos alcanzar hoy.

Y se está convirtiendo en iniciático. Para ”descubrir” el Higgs, el CERN cerró las puertas y aisló a sus dos equipos durante años, en un sistema indigno de la idea de la ciencia, que había sido pública y abierta para todos hasta ese momento. El CERN ha publicado los resultados de sus dos equipos pero, o estoy muy equivocado, no ha distribuido los datos originales, las fotografías de las trazas de los productos de desintegración de los productos de desintegración. Cuando se dio a conocer el hallazgo del Bosón de Higgs, se hizo a bombo y platillo, con una parafernaliz impropia de un proyecto científico y más parecido a una Feria. Claro que, todo ese montaje obedecía a obtener máyores presupuestos.

En las sociedades místicas, tras un periodo de iniciación para los elegidos, las verdades se revelaban siempre en ceremonias secretas bajo la terrible promesa de no revelar los ritos nunca fuera de la institución.

Otro de los padres de la Gran Unificación, el físico Abdus Salam, daba como razón poderosa para la búsqueda de la misma su fé en un único dios. Según él, la naturaleza debería tener una única fuerza, correspondiente a esa única deidad.

El padre de la mecánica cuántica, Niels Bohr, apremiado por Einstein, entre otros, llegó a decir que de esa forma de analizar el mundo atómico y sub-atómico, de esa mecánica cuántica había que tomar las reglas de cálculo, pero que había que renunciar a entender lo que pasaba en él. Esto dicho por un supuesto científico que había renunciado a entender la naturaleza, pero que controló, hasta su muerte, la concesión de los premios Nobel de física.

Es tremendamente importante considerar esto que he escrito aquí, en todos los caminos de la ciencia. Hoy la presión es publicar, aunque lo que se publique sea mera copia no entendida de otros trabajos publicados anterior o simultáneamente. Esos trabajos se acumulan en las revistas científicas, de donde no salen a las empresas ni hacia la técnica. Los resultados de un enorme tanto por ciento de la investigación no son aprovechados por aquellos que la han financiado, que dejan que esos resultados caigan en el olvido.

Mientras que un científico como Avelino Coma desarrolla hasta sus úlñtimos extremos la Ciencia, en su trabajo de laboratorio, y sus resultados se aprovechan para la sociedad, y lo mismo hacen otros cientos de miles de ellos, inmensas cantidades de dinero (esfuerzo) se tiran en desarrollos místicos sin utilidad alguna (por ejemplo, las investigaciones sobre la fusión del hidrógeno) o abiertamente carentes de relación con la naturaleza (las supercuerdas).

Edward Witten revisita la teoría de supercuerdas perturbativa en Strings 2012

Aún hay ciencia. Pero hay disciplinas que se están, tristemente, alejando de ella aunque se consideran públicamente, y así lo afirman, como los que marcan el camino del futuro de la misma. Terminarán olvidadas, como ha ocurrido con toda la mística iniciática. Pero de momento aún nos dicen, como los sufíes, que son los únicos que están cerca de la verdad.

La Ciencia es una cosa de la que todos sabemos como anda sus caminos y cuando se puede considerar digna de su nombre, otra cosa muy distinta será el especular y aventurar “teorías” que no llegan a ninguna parte, toda vez que tienen la imposibilidad de ser demostradas y, eso, amigos míos, es como hablar de la existencia de Dios.

Claro que, si realmente existiera el “todo poderoso”, nuestro mundo sería de otra manera, no tendríamos las humillantes desigualdeades que podemos comtemplar en algunas regiones del mundo, y, la vida, sería mucho más placentera. Algunos quieren soslayar sus propias responsabilidades dejando en manos de “Dios”, la solución que sólo está en nuestras manos.

emilio silvera

Mar

23

A vueltas con las Teorías… ¡El Universo y sus contenidos!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y... ¿nosotros? ~

Clasificado en El Universo y... ¿nosotros? ~

Comments (0)

Comments (0)

En el ranking de los científicos más importantes del mundo, elaborado en función del impacto de los artículos publicados por cada cual en las revistas científicas, los trabajos realizados y los libros, etc, que es un buen indicador de la carrera de cada uno, no parece haber ninguna duda en que Ed Witten, el físico-matemático estadounidense, tiene el número uno de esa lista, y muy destacado sobre el segundo. Aunque es Físico Teórico, en 1.990, la Unión Internacional de Matemáticos le concedió la Medalla Field, algo así como el primeo Nobel en matemáticas que no concede la Academia Sueca. Es la figura más destacada en el campo de las supercuerdas, un complicado entramado teórico que supera el gran contrasentido de que las dos vertientes más avanzadas de la física, la teoría relativista de la gravitación y la mecánica cuántica, sean incompatibles pese a que cada una por separado estén más que demostradas.

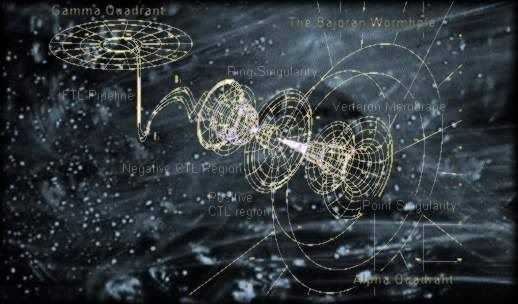

Ningún físico se siente cómodo con este divorcio recalcitrante, aunque no todos tienen la misma confianza en esta concepción de las supercuerdas, en que las partículas elementales (electrones, quarks, etc) son modos de vibración de cuerdas de tamaño inimaginablemente pequeño (10-33 cm) que existen en universos con 11 dimensiones en lugar de las cuatro cotidianas, tres de espacio y una de tiempo de la teoría de A. Einstein. Las supercuerdas están en ebullición desde que hace unos veinte años Witten dio un fuerte tirón a toda la cuestión al sintetizar brillantemente ideas que estabas en el ambiente y que nadie había sido capaz de formular a plena satisfacción de todos, ya que, esta especialidad de supercuerdas y de las 11 dimensiones exige un nivel y una profundidad matemática que sólo está al alcance de unos pocos. Este trabajo de Witten desembocó en lo que hasta ahora todos denominan teoría M (Witten, como ya he comentado antes, se refería en su exposición de la nueva teoría – o mejor, nuevo planteamiento – a magia, misterio y matriz).

La teoría de supercuerdas tiene tantas sorpresas fantásticas que cualquiera que investigue en el tema reconoce que está llena de magia. Es algo que funciona con tanta belleza… Cuando cosas que no encajan juntas e incluso se repelen, si se acerca la una a la otra alguien es capaz de formular un camino mediante el cual, no sólo no se rechazan, sino que encajan a la perfección dentro de ese sistema, como ocurre ahora con la teoría M que acoge con naturalidad la teoría de la relatividad general y la teoría mecánico-cuántica; ahí, cuando eso se produce, está presente la belleza.

Lo que hace que la teoría de supercuerdas sea tan interesante es que el marco estándar mediante el cual conocemos la mayor parte de la física es la teoría cuántica y resulta que ella hace imposible la gravedad. La relatividad general de Einstein, que es el modelo de la gravedad, no funciona con la teoría cuántica. Sin embargo, las supercuerdas modifican la teoría cuántica estándar de tal manera que la gravedad no sólo se convierte en posible, sino que forma parte natural del sistema; es inevitable para que éste sea completo.

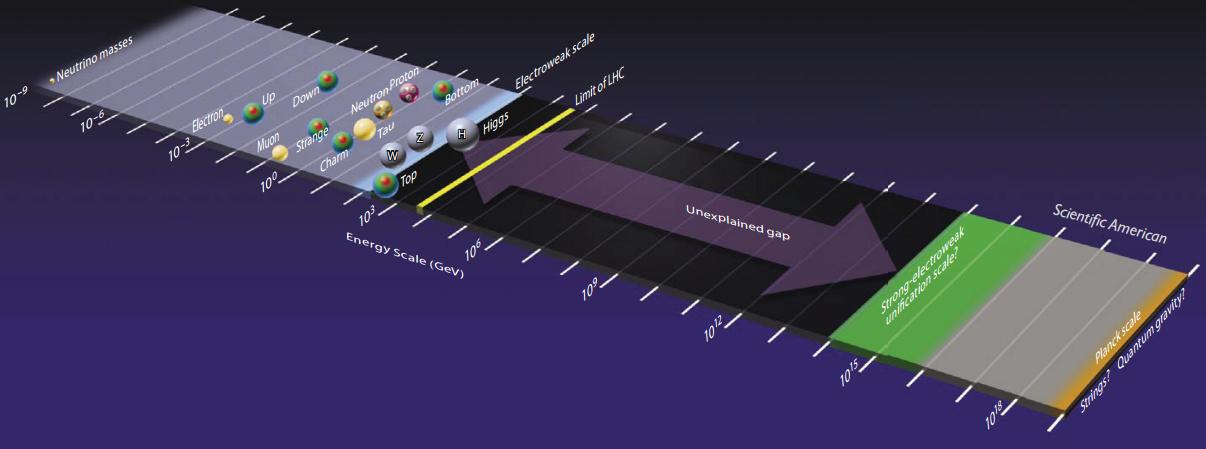

El modelo que tenenos de la física de partículas se llama Modelo Estándard y, nos habla de las interacciones entre partículas y las fuerzas o interraciones que están presentes, las leyes que rigen el Universo físico y que, no hemos podido completar al no poder incluir una de las fuerzas: La Gravedad. Claro que, no es esa la única carencia del Modelo, tiene algunas más y, a estas alturas, se va necesitando un nuevo Modelo, más completo y audaz, que incluya a todas las fuerzas y que no tengá parámetros aleatorios allí donde nuestros conocimientos no llegan.

Un sistema como el Modelo Estándar, que acoge todas las fuerzas de la naturaleza, dejando aparte la fuerza gravitatoria, no refleja la realidad de la naturaleza, está incompleto. Hace muchos años que la física persigue ese modelo, la llaman Teoría de Todo y debe explicar todas las fuerzas que interaccionan con las partículas subatómicas que conforman la materia y, en definitiva, el universo, su comienzo y su final, el hiperespacio y los universos paralelos. Esa es la teoría de supercuerdas.

Hace tiempo que los físicos tratan de mejorar el Modelo Estándar con otras teorías más avanzadas y modernas que puedan explicar la materia y el espacio-tiempo con mayor amplitud y, sobre todo, incluyendo la gravedad.Así que retomando la teoría de Kaluza de la quinta dimensión, se propuso la teoría de supergravedad en 1.976 por los físicos Daniel Freedman, Sergio Ferrara y Peter van Nieuwenhuizen, de la Universidad del Estado de Nueva York en Stoney Brook que desarrollaron esta nueva teoría en un espacio de once dimensiones.

¿Por qué es tan importante encajar la gravedad y la teoría cuántica? Porque no podemos admitir una teoría que explique las fuerzas de la naturaleza y deje fuera a una de esas fuerzas. Así ocurre con el Modelo Estándar que deja aparte y no incluye a la fuerza gravitatoria que está ahí, en la Naturaleza.

La teoría de supercuerdas se perfila como la teoría que tiene implicaciones si tratamos con las cosas muy pequeñas, en el microcosmos; toda la teoría de partículas elementales cambia con las supercuerdas que penetra mucho más; llega mucho más allá de lo que ahora es posible.

Hasta hoy, no se ha logrado, ni mucho menos, inventar una teoría de campo consistente totalmente unificadora que incluya la gravedad. Se han dado grandes pasos, pero las brechas «científicounificantes» siguen siendo amplias. El punto de partida ha sido siempre la teoría de la relatividad general y conceptos con ella relacionados, por la excelencia que manifiesta esa teoría para explicar la física gravitatoria macrocósmica. El problema que se presenta surge de la necesidad de modificar esta teoría sin perder por ello las predicciones ya probadas de la gravedad a gran escala y resolver al mismo tiempo los problemas de la gravedad cuántica en distancias cortas y de la unificación de la gravedad con las otras fuerzas de la naturaleza.

Sí, hay que mantener una mente abierta… a lo que pueda llegar pero…

Más allá de lo que nos permiten captar nuestros sentidos físicos, hay que tener nuestra mente abierta a la posibilidad de que puedan existir otras realidades diferentes a lo que nos dicta nuestra experiencia, realidades capaces de ser descubiertas por la fuerza del intelecto cuando nos atrevemos a cuestionar aquello que creíamos como absoluto.

En cuanto a nuestra comprensión del universo a gran escala (galaxias, el Big Bang…), creo que afectará a nuestra idea presente, al esquema que hoy rige y, como la nueva teoría, el horizonte se ampliará enormemente; el cosmos se presentará ante nosotros como un todo, con un comienzo muy bien definido y un final muy bien determinado.

Para cuando eso llegue, sabremos lo que es, como se genera y dónde están situadas la esquiva materia oscura y energía invisible que sabemos que están ahí, pero no sabemos explicar ni el qué ni el por qué.

La Humanidad, aún en proceso de humanización, para su evolución necesita otro salto cuantitativo y cualitativo del conocimiento que les permita avanzar notablemente hacia el futuro. Ese avance está supeditado a que la teoría M, la versión más avanzada de supercuerdas, se haga realidad.

Todos los avances de la Humanidad han estado siempre cogidos de la mano de las matemáticas y de la física. Gracias a estas dos disciplinas del saber podemos vivir cómodamente en ciudades iluminadas en confortables viviendas. Sin Einstein, pongamos por ejemplo, no tendríamos láseres o máseres, pantallas de ordenadores y de TV, y estaríamos en la ignorancia sobre la curvatura del espaciotiempo o sobre la posibilidad de ralentizar el tiempo si viajamos a gran velocidad; también estaríamos en la más completa ignorancia sobre el hecho cierto y demostrado de que masa y energía (E = mc2), son la misma cosa.

En realidad, en el CERN, se trabaja en algo más que en las partículas subatómicas y se buscan nuevas respuestas y remedios para paliar el dolor en el mundo. También, se ha contribuido de manera notable a las comunicaciones y, el mundo es tal como lo conocemos hoy gracias a Ingenios como el LHC que, por desconocimiento de muchos, en su momento, fue tan denostado, cuando gracías a ingenios de esa clase conocemos como funciona la Naturaleza y cómo es el mundo que nos rodea.

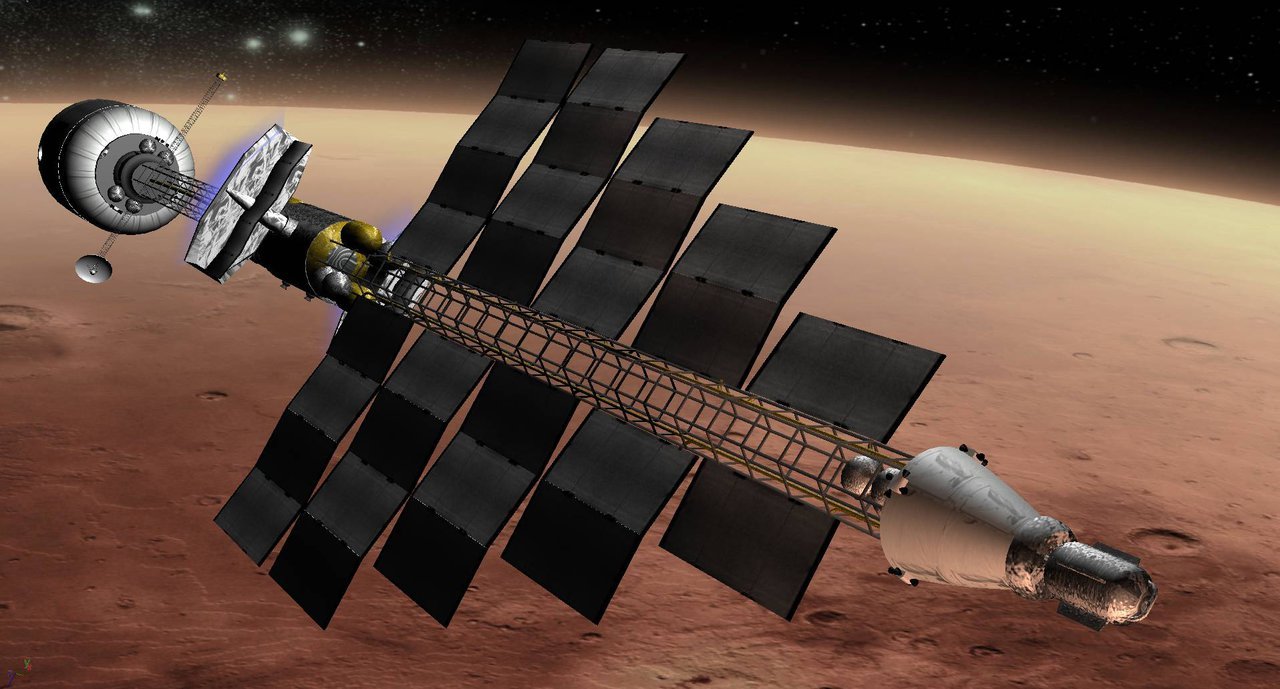

Es necesario continuar avanzando en el conocimiento de las cosas para hacer posible que, algún día, dominemos las energías de las estrellas, de los agujeros negros y de las galaxias. Ese dominio será el único camino para que la Humanidad que habita el planeta Tierra, pueda algún día, lejano en el futuro, escapar hacia las estrellas para instalarse en otros mundos lejanos. Ese es nuestro inevitable destino. Llegará ese irremediable suceso que convertirá nuestro Sol en una gigante roja, cuya órbita sobrepasará Mercurio, Venus y posiblemente el planeta Tierra. Pero antes, en el proceso, las temperaturas se incrementarán y los mares y océanos del planeta se reconvertirán en vapor. Toda la vida sobre el planeta será eliminada y para entonces, si queremos sobrevivir y preservar la especie, estaremos ya muy lejos, buscando nuevos mundos habitables en algunos casos, o instalados como colonizadores de otros planetas. Mientras tanto, el Sol habrá explotado en nova y se convertirá en una estrella enana blanca. Sus capas exteriores serán lanzadas al espacio estelar y el resto de la masa del Sol se contraerá sobre sí misma. La fuerza de gravedad reducirá más y más su diámetro, hasta dejarlo en unos pocos kilómetros, como una gran pelota de enorme densidad que poco a poco se enfriará. Un cadáver estelar.

Un día lejano dentro de unos milñes de millones de años, el Sol será una solitaria estrella enana blanca perdida entre las brumas de gases de una Nebulosa Planetaria que brillará surante cien millones de años.

Ese es el destino del Sol que ahora hace posible la vida en nuestro planeta, enviándonos su luz y su calor, sin los cuales, no podríamos sobrevivir. Para cuando eso llegue (faltan 4.000 millones de años), la Humanidad tendrá que contar con medios tan avanzados que ahora sólo podríamos imaginar. Las dificultades que habrá que vencer son muchas y, sobre todo, increíblemente difíciles de superar.

Ya hemos dado los primeros pasos y, nuestros ingenios espaciales tecnológicos y robotizados, han realizado para nosotros las tareas que, de momento, nos están vedadas pero, demosle tiempo al tiempo y, sin duda alguna, en ese futuro soñado, estaremos en las estrellas y en esos otros mundos que presentimos hermanos de la Tierra y que podrán acoger a la Humanidad que, dentro de otros cincuenta años, llegará a la cifra de 10.000 millones de seres y, nuestro planeta, no puede con todos. Mientras tanto, estamos creando ciudades del futuro con tecnologías que hasta hace muy poco tiempo nadie podía imaginar.

Algunas Empresas Privadas están preparándose para no quedar atrás en la conquista del Espacio

Algunas Empresas multinacionales están trabajando en programas que van más allá de los avances actuales para revelar las tecnologías e inventos que nos permitirán ver a través de las paredes, viajar en el tiempo y en el espacio y colonizar planetas distantes. La tecnología inteligente que llevará ayudantes robóticos a los hogares, ciudades enteras inmersas en Internet, y sistemas de entretenimiento que harán los sueños realidad en virtual. Sí, virtual hoy pero… ¿Y mañana?

Los actuales ingenios quedarán antiguos y nuevos ingenios surcarán el Espacio Exterior en el futuro

Naves interestelares que, tan grandes como ciudades surcaran las espacios

¿Cómo podremos evitar las radiaciones gamma y ultravioletas?

¿En qué clase de naves podremos escapar a esos mundos lejanos?

¿Seremos capaces de Burlar la barrera de la velocidad de la luz?

Nuestros ingenios espaciales, nuestra naves hoy (estamos en la edad primitiva de los viajes espaciales), pueden alcanzar una velocidad máxima de 40 ó 50 mil kilómetros por hora y, además, la mayor parte de su carga es el combustible necesario para moverla.

La estrella más cercana al Sol es Alfa Centauro; un sistema triple, consistente en una binaria brillante y una enana roja débil a 2º, llamada Próxima Centauro. La binaria consiste en una enana G2 de amplitud -0’01 y una enana K1 de magnitud 1’3. Vistas a simple vista, aparecen como una única estrella y se encuentran a 4’3 años luz del Sol.

Sabemos que 1 año luz es la distancia recorrida por la luz en un año trópico a través del espacio vacio, y equivale a 9’4607×1012 km, ó 63.240 Unidades Astronómicas, ó 0’3066 parsecs.

La Unidad Astronómica es la distancia que separa al planeta Tierra del Sol, y equivale a 150 millones de kilómetros; poco más de 8 minutos luz.

Ahora pensemos en la enormidad de la distancia que debemos recorrer para llegar a Alfa Centauri, nuestra estrella vecina más cercana.

63.240 Unidades Astronómicas a razón de 150 millones de km. Cada una nos dará 9.486.000.000.000 de kilómetros recorridos en un año y, hasta llegar a Alfa Centauro, lo multiplicamos por 4’3 y nos resultarían 40.789.800.000.000 de kilómetros hasta Alfa. La cantidad resultante son millones de kilómetros.

Ahora pensemos que con nuestras actuales naves que alcanzan velocidades de 50.000 km/h, tratáramos de llegar a Alfa Centauro. ¿Cuándo llegaríamos, en el supuesto caso de que no surgieran problemas durante el viaje?

Bueno, en estas condiciones, los viajeros que salieran de la Tierra junto con sus familias, tendrían que pasar el testigo a las siguientes generaciones que, con el paso del tiempo (muchos, muchos siglos), olvidarían su origen y, posiblemente, las condiciones de ingravidez del espacio mutarían el físico de estos seres en forma tal que, al llegar a su destino podrían ser cualquier cosa menos humanos. Precisamente para evitar este triste final, estamos investigando, haciendo pruebas en viajes espaciales, trabajando en nuevas tecnologías y probando con nuevos materiales, y buscando en nuevas teorías avanzadas, como la teoría M, las respuesta a preguntas que hacemos y de las que hoy no tenemos respuesta, y sin estas respuestas, no podemos continuar avanzando para que, cuando llegue ese lejano día, podamos con garantía salir hacia las estrellas, hacia esos otros mundos que acogerá a la Humanidad, cuyo destino, irremediablemente, está en las estrellas. De material de estrellas estamos hechos y en las estrellas está nuestro destino.

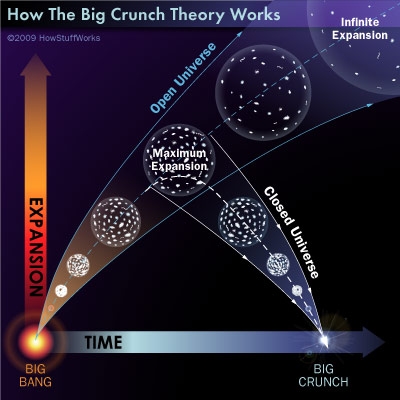

Si finalmente el destino del universo (supeditado a su densidad crítica), es el Big Crunch, entonces la Humanidad tendrá otro problema, este aún más gordo que el anterior, para resolver. Aunque parece que no habrá Big Crunch, según los últimos estudios nos dicen que el universo es plano y que estamos en el límite de la Densidad Crítica, con lo cual, el Universo tendrá una muerte térmica, es decir, el frío absoluto de los -273 ºC. Con esa temperatura, ni los átomos se mueven.

Muchos son los peligros que en el futuro nos acechan: La galaxia Andrómeda se nos viene encima y en unos miles de millones de años se fusionará con la Vía Láctea. Nuestro Sol tiene un tiempo de vida limitado, en cuanto agote el combustible buclear de fusíón, se convertirá en gigante roja, más tarde, creará una Nebulosa planetaria para quedarse como enana blanca. Por otra parte, hay estudios muy serios que dicen que la Tierra saldrá de la zona habitable que actualmente ocupa y, si eso pasa… ¡Acordémosnos de Marte! ¿Qué fue lo que pasó allí, un planeta con atmósfera y océanos en el pasado.

Habrá que buscar soluciones para escapar de nuestro sistema solar, lo que en un futuro lejano, y teniendo encuentra que el avance tecnológico, es exponencial, parece que dicho problema puede tener una solución dentro de los límites que la lógica nos puede imponer. El segundo parece más serio, ¡escapar de nuestro universo! Pero… ¿a dónde podríamos escapar? Stephen Hawking y otros científicos nos hablan de la posibilidad de universos paralelos o múltiples; en unos puede haber condiciones para albergar la vida y en otros no. ¿Pero cómo sabremos que esos universos existen y cuál es el adecuado para nosotros? ¿Cómo podremos escapar de este universo para ir a ese otro?

No podemos ni escapar de nuestro propio sistema solar y ya pensamos en viajar a otro universo. ¡Como somos los Humanos!

Pensar en el futuro nos pone en un serio problema y hacemos preguntas que nadie puede contestar hoy. La Humanidad, para saber con certeza su futuro, tendrá que seguir trabajando y buscando nuevos conocimientos y, para dentro de unos milenios (si antes no se destruye a sí misma), seguramente, habrá obtenido algunas respuestas que contestarán esta difícil pregunta que, a comienzos del siglo XXI, nadie está capacitado para contestar.

Se puede sentir la fascinación causada por la observación de la belleza que encierra el universo, las muchas maravillas que contiene y que causa asombro cada día, aunque no se tenga preparación científica, pero el nivel de apreciación de la Naturaleza, la verdadera maravilla, vendrá de comprender mejor lo que estamos viendo, que es mucho más que grandes figuras luminosas y múltiples objetos brillantes, es… la evolución… la vida elevada al máximo nivel que se dará, cuando la mente se fusione con el universo mismo como un todo etéreo, cuando no necesitemos hacer preguntas y las respuestas esté en nosotros que, somos el universo.

emilio silvera

Mar

22

Biosfera, hidrosfera…¡La Tierra!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en La magia de la Tierra ~

Clasificado en La magia de la Tierra ~

Comments (0)

Comments (0)

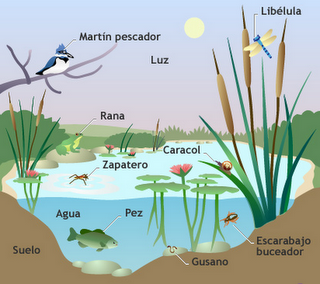

La BIOSFERA en realidad no es una capa de la Tierra; es el conjunto de todos los ecosistemas existentes en la Tierra, es decir, de todos los seres vivos junto con el medio en el que viven. Por eso, la biosfera es parte de la corteza terrestre, pero también es parte de la hidrosfera y de la atmósfera.

En este dibujo puedes observar lo que supone el agua respecto al conjunto de nuestro Planeta. Recuerda que el 97% del agua de la Tierra es salada y solo un 3% es agua dulce.

La biosfera y la hidrosfera están estrechamente relacionadas: el agua es el elemento esencial de todas las formas de vida, y la distribución del agua en el planeta (es decir, los límites de la hidrosfera) condiciona directamente la distribución de los organismos (los límites de la biosfera). El término biosfera, de reciente creación, indica el conjunto de zonas de la Tierra donde hay vida, y se circunscribe a una estrecha región de unos 20 Km de altura comprendida entre las cimas montañosas más elevadas y los fondos oceánicos más profundos. Sólo pueden hallarse formas de vida en la biosfera, donde las condiciones de temperatura, presión y humedad son adecuadas para las más diversas formas orgánicas de la Tierra.

Ciclo del agua

Obviamente, las fronteras de dicha “esfera” son elásticas y su extensión coincide con la de la hidrosfera; se superpone a las capas más bajas de la atmósfera y a las superficiales de la litosfera, donde se sumerge, como máximo, unos 2 Km. Sin embargo, si por biosfera se entiende la zona en la que hay vida así como la parte inorgánica indispensable para la vida, deberíamos incluir en este concepto toda la atmósfera, sin cuyo “escudo” contra las radiaciones más fuertes no existiría ningún tipo de vida; o la corteza terrestre entera y las zonas superiores del manto, sin las cuales no existiría la actividad volcánica, que resulta necesaria para enriquecer el suelo con nuevas sustancias minerales.

Por tanto, la biosfera es un ecosistema tan grande como el planeta Tierra y en continua modificación por causas naturales y (desgraciadamente) artificiales.

Es importante cuidar los ecosistemas de la Tierra, es mucho lo que nos jugamos en ello

Las modificaciones naturales se producen a escalas temporales muy variables: en tiempos larguísimos determinados por la evolución astronómica y geológica, que influyen decididamente en las características climáticas de los distintos ambientes (por ejemplo, durante las glaciaciones), o en tiempos más breves, relacionados con cambios climáticos desencadenados por sucesos geológicos-atmosféricos imprevistos (por ejemplo, la erupción de un volcán, que expulsa a la atmósfera grandes cantidades de cenizas capaces de modificar el clima de extensas áreas durante periodos considerables).

En cambio, las modificaciones artificiales debidas a la actividad humana tienen efectos rápidos: la deforestación producida en África por las campañas de conquista romanas contribuyó a acelerar la desertificación del Sahara, como tampoco hay duda de que la actividad industrial de los últimos siglos determina modificaciones dramáticas y repentinas en los equilibrios biológicos.

La biosfera es el punto de encuentro entre las diversas “esferas” en las que se subdivide la Tierra: está surcada por un flujo continuo de energía procedente tanto del interior del planeta como del exterior, y se caracteriza por el intercambio continuo de materia, en un ciclo incesante que une todos los entornos.

La biosfera es el ecosistema global. Comprende todos los ecosistemas y organismos vivos en la atmósfera, en la tierra (biosfera terrestre), o en los océanos (biosfera marina), incluida materia orgánica muerta derivada (por ejemplo, basura, materia orgánica en suelos y desechos oceánicos).

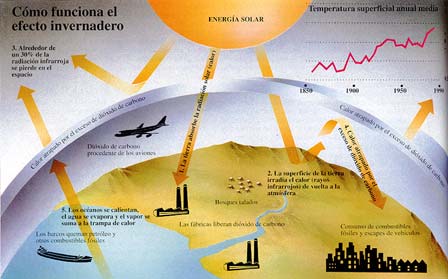

Pero no por esta razón hay vida por todas partes, pues la vida requiere condiciones particulares e imprescindibles. Existen determinados elementos físicos y químicos que “limitan” el desarrollo de la vida. La presencia y disponibilidad de agua es el primero y el más importante. El agua es el disolvente universal para la química de la vida; es el componente primario de todos los organismos y sin agua la vida es inconcebible (Tales de Mileto fue el primero en darse cuenta de ello). Pero no sólo es eso: al pasar del estado sólido al líquido y al gaseoso y viceversa, el agua mantiene el “efecto invernadero natural”, capaz de conservar la temperatura del planeta dentro de los niveles compatibles con la vida (es decir, poco por debajo de los 0º C y poco por encima de los 40º C).

La presión, que no deberá superar mucho el kilogramo por centímetro cuadrado (como sucede alrededor de los 10 m de profundidad en el mar), así como una amplia disponibilidad de sales minerales y de luz solar (indispensable – como expliqué antes – para la vida de las plantas) son también factores que marcan las posibilidades de vida.

Muchos son los misterios que se esconden en las profundidades marinas

Está claro que se nos ha dado un lugar privilegiado, que reúne todas y cada una de las condiciones excepcionales para la vida, y somos tan ignorantes que aún siendo un bien escaso (en nuestro enorme Sistema Solar, parece que el único), nos lo queremos cargar. Pero sin querer, me marcho por las ramas y me desvío del tema principal, la evolución por la energía, y como está directamente implicada, hablemos un poco de nuestra casa.

El planeta Tierra

Cinturones de Van Allen: Fuerzas invisibles actúan para preservarnos de energías nosivas provenientes del espacio interestelar.

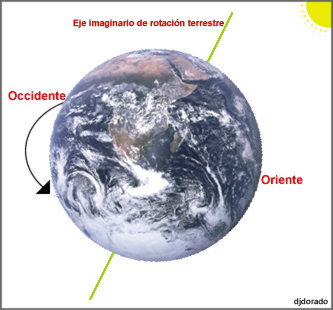

Las fuerzas que actúan sobre la Tierra, como planeta en el espacio, tiene profundas implicaciones energéticas. La gravitación ordena y orienta, y obstaculiza y facilita los flujos de energía cinética. La rotación genera la fuerza centrífuga y la de Coriolis: la primera achata el planeta por los polos ensanchándolo por el ecuador, y la segunda desvía los vientos y las corrientes de los océanos (a la derecha del hemisferio norte y a la izquierda en el hemisferio sur). La rotación es también la causa de los ritmos diarios de las plantas y animales, y de la desaceleración de la Tierra, que alarga el día un promedio de 1’5 ms cada siglo, lo que representa una pérdida de tres teravatios por fricción de mareas.

La tierra presenta varios movimientos en su viaje anual alrededor del Sol. Los más conocidos son el movimiento de Rotación y el movimiento de Traslación.

En el movimiento de Rotación, la Tierra da una vuelta sobre si misma en 24 horas alrededor de un eje imaginario. Es decir en lo que denominamos un día. El de traslación se computa por un año.

Pero ni la gravitación ni la rotación (fricción) hacen de la Tierra un planeta único entre los cuerpos celestes de nuestro entorno. Su exclusividad procede de sus propiedades térmicas internas, que causan los ciclos geotectónicos que modifican la superficie, y de su atmósfera, océanos y plantas que transforman la radiación solar que reciben. Los orígenes de estos procesos no están claros.

Podemos fijar la edad de la Tierra en algo más de los 4.000 millones de años por la desintegración de los isótopos radiactivos, pero poco podemos asegurar sobre la formación del planeta o sobre la energética de la Tierra primitiva. Sobre el tema circulan varias teorías, y es muy plausible que el origen del Sistema Solar planetario fuera una nube interestelar densa en la que el Sol se formó por una inestabilidad gravitatoria y que la posterior aglomeración del resto de esta materia dispersa, que giraba a distintas distancias, a su alrededor, diera lugar a los planetas. No está claro si al principio la Tierra estaba extremadamente caliente o relativamente fría. Me inclino por lo primero y estimo que el enfriamiento fue gradual con los cambios de atmósferas y la creación de los océanos.

Los océanos de la Tierra vistos desde el espacio

Las incertidumbres geológicas básicas se extienden hasta el presente. Diferentes respuestas a cuestiones como la cantidad de 40K en el núcleo terrestre o sobre la convección del magma en el manto (hay una o dos celdas) dan lugar a diferentes explicaciones para el flujo de calor y la geotectónica de la Tierra. Lo que sí está claro es que el flujo interno de calor, menos de 100 mW/m2, tiene un efecto pequeño comparado con la reflexión, absorción y emisión de la radiación solar.

El balance de la radiación terrestre (Rp) en la capa alta de la atmósfera es la suma de la radiancia extraterrestre (la constante sola Q0) reducida por el albedo planetario y el flujo saliente de larga longitud de onda (Qi): Rp = Q0(1-ap) + Qi = 0. El flujo emitido es igual a la suma de la radiación atmosférica y la terrestre: Qi = Qea + Qes. Los balances de la radiación en la atmósfera (Ra) y en la superficie de la Tierra (Rs) son iguales, respectivamente, a la diferencia entre la correspondiente absorción y emisión: Ra = Qaa + Qea y Rs = Qas + Qes, de manera que Rp = Ra + Rs = 0. Hay que continuar explicando la radiación saliente con los flujos irradiados y emitidos por la superficie terrestre, el flujo de radiación medio absorbida, etc., etc., etc., con una ingente reseña de símbolos y tedioso esquemas que, a mi parecer, no son legibles para el lector normal y no versado en estos conocimientos. Así que, aunque sea mutilar el trabajo, desisto de continuar por ese camino y prosigo por senderos más amenos y sugestivos para el lector.

La fuente más importante del calentamiento atmosférico proviene de la radiación terrestre de longitud de onda larga, porque el flujo de calor latente es una contribución secundaria y el flujo de calor sensible sólo es importante en las regiones áridas donde no hay suficiente agua para la evaporación. Los océanos y los continentes también reciben indirectamente, irradiadas por la atmósfera, la mayor parte de su calor en forma de emisiones de longitudes de onda larga (4 – 50 μm). En este flujo de radiación reenviado hacia la superficie terrestre por los gases invernadero, domina a la radiación del vapor de agua, que con una concentración variable, emite entre 150 y 300 W/m2, y al que también contribuye el CO2 con unos 75 W/m2.

El intercambio de radiación de longitud de onda larga entre la superficie y la atmósfera sólo retrasa temporalmente las emisiones de calor terrestre, pero controla la temperatura de la biosfera. Su máximo es casi 400 W/m2 en los trópicos nubosos, pero es importante en todas las estaciones y presenta significativas variaciones diarias. El simple paso de una nube puede aumentar el flujo en 25 W/m2. Las mayores emisiones antropogénicas de gases invernadero han aumentado este flujo en cerca de un 2’5 W/m2 desde finales del siglo XIX.

Como era de esperar, las observaciones de los satélites confirman que el balance de energía de la Tierra está en fase con la radiación solar incidente (Q0), pero la radiación media saliente (Qi) está desfasada con la irradiancia, alcanzando el máximo durante el verano en el hemisferio norte. La distribución asimétrica de los continentes y el mar explica este fenómeno. En el hemisferio norte, debido a la mayor proporción de masa terrestre, se experimentan mayores cambios estacionales que dominan el flujo global de la radiación saliente.

Quizás el resultado más sorprendente que se deriva de las observaciones por satélite sea que, estacionalmente, se observan cierto déficit y superávit de radiación y el balance de la radiación en el planeta no es igual a cero, pero sin embargo, en cada hemisferio la radiación anual está en equilibrio con el espacio exterior. Además, la contribución atmosférica por transporte de energía hacia los polos es asimétrica respecto al ecuador con valores extremos de unos 3 PW cerca de los 45º N, y -3 PW cerca de 40º S.

Podría continuar hablando sobre los vientos, los terremotos, las lluvias y otros fenómenos atmosféricos, sin embargo, no creo que, por ser estos fenómenos naturales muy conocidos de todos, pudieran tener gran interés. Pasemos pues a comentar sobre los océanos.

Las lluvias tan necesarias para todos y para todo

Agua, mejor que Tierra, habría sido el nombre adecuado para el tercer planeta, puesto que los océanos cubren más del 70 por ciento de la superficie terrestre, con una profundidad media de 3’8 Km. Debido a las especiales propiedades térmicas del agua, éstas constituyen un extraordinario regulador del balance energético del planeta.

Este líquido tiene cinco ventajas termodinámicas importantes: un punto de ebullición inusualmente alto, debido a su capacidad para formar enlaces de hidrógeno intermoleculares; un calor específico de 2’5 a 3’3 veces más elevado que el del suelo; una capacidad calorífica (calor específico por unidad de volumen) aproximadamente seis veces mayor que la tierra seca; un altísimo calor de vaporización que le permite transportar una gran cantidad de calor latente; y su relativamente baja viscosidad, que le convierte en un eficiente transportador de calor en los océanos mediante miríadas de remolinos y caudalosas corrientes.

No es sorprendente, pues, que los océanos, que tienen cerca del 94 por ciento de toda el agua, sean determinantes en el balance energético del planeta. Cuatro quintas partes de la radiación solar que llega a la Tierra entra en la atmósfera que cubre los océanos, los cuales con un albedo superior al 6% absorben la energía con una tasa cercana a 65 PW, casi el doble de la absorción atmosférica total y cuatro veces mayor que la continental. Inevitablemente, los océanos también absorben la mayor parte, casi dos tercios, del calor rerradioirradiado hacia abajo por la atmósfera elevando su ritmo de calentamiento a los 175 PW.

Arrecife poco profundos y ecosistemas

Salvo en los océanos menos profundos, la interacción aire-mar no afecta directamente a las aguas profundas. Las oscuras y frías aguas de las profundidades marinas están aisladas de la atmósfera por la capa mixta, una capa de poca profundidad que va de pocos metros a pocos cientos de metros y que está afectada por los vientos y el oleaje.

A pesar de que el alto calor específico del agua limita el rango de variación, las temperaturas de esta capa sufren importantes fluctuaciones diarias y estacionales. Sin embargo, variaciones relativamente pequeñas de la temperatura de la superficie de los océanos tienen importantes consecuencias climáticas: quizás el mejor ejemplo de esta teleconexión climática sea el fenómeno del Niño, que consiste en una extensión en forma de lengua de las aguas superficiales calientes hacia el este, cuyos efectos se extienden desde Canadá hasta África del sur.

Debido a que la conductividad térmica del agua es muy baja, la transferencia de energía de la capa mixta hacia las profundidades se realiza fundamentalmente mediante corrientes convectivas. Estas corrientes compensan la extremadamente baja fuerza ascensional de las aguas profundas, más calientes, que son desplazadas por el movimiento hacia el ecuador de las corrientes frías provenientes de los polos. En contraste con el gradual ascenso general de las aguas oceánicas, la convección hacia abajo se produce en corrientes bien delimitadas que forman gigantescas cataratas oceánicas. Seguramente la mayor es la que fluye hacia el sur bajo el estrecho de Dinamarca, entre Islandia y Groenlandia, y se sumerge unos 3’5 Km transportando 5 millones de m3/s, un caudal veinte veces mayor que el del Amazonas.

El agua de la vida

Miríadas de corrientes oceánicas, que a menudo viajan cientos de kilómetros a diferentes profundidades, transportan considerables cantidades de energía y sal. Quizás el ejemplo más importante de estas combinaciones de transportes sea la corriente de agua caliente y salada que sale del Mediterráneo a través del estrecho de Gibraltar. Este flujo caliente pero denso desciende sobre la pendiente de la plataforma continental hasta alcanzar el equilibrio entre el peso y el empuje ascensional a unos mil metros de profundidad. Aquí se separa en dos celdas lenticulares que se mueven durante siete años hacia el este y hacia el sur, respectivamente, hasta que decaen o chocan contra alguna elevación marina.

Un mapa global de los flujos de calor desde la superficie oceánica hasta las capas profundas muestra claramente máximos longitudinales a lo largo del ecuador y a lo largo de aproximadamente 45º S en los océanos Atlántico e Índico. Esta transferencia es también importante en algunas áreas costeras donde se producen intensos flujos convectivos ascendentes que intercambian calor entre las aguas superficiales y las profundas, como ocurre en la costa de California y al oeste de África. Un flujo en dirección contraria, que calienta la atmósfera, se produce en las dos mayores corrientes oceánicas calientes, la corriente del Golfo en el Atlántico y la de Kuroshio en el Pacífico oriental.

Aguas termales y sulfurosas

Todas la regiones donde se produce este ascenso de aguas calientes (a lo largo de las costas del continente americano, África, India y la zona ecuatorial del Pacífico occidental) se distinguen fácilmente por los elevados niveles de producción de fitoplancton, causados por un importante enriquecimiento de nutrientes, comparados con los que, de otra manera, corresponderían normalmente a las aguas superficiales oligotrópicas.

La radiación transporta la mayor parte (casi 4/5) de la energía que fluye desde la capa mixta hasta la atmósfera, y el resto del flujo calorífico se produce por calor latente en forma de vapor de agua y lluvias.

Aún no se ha realizado una valoración cuantitativa del transporte total para cada latitud, pero en el océano Atlántico hay transferencia de calor hacia el norte a lo largo de toda su extensión, alcanzando en el trópico un valor aproximado de 1 PW, flujo equivalente al que se produce en el Pacífico norte. En el Pacífico sur, el flujo de calor hacia el polo a través del trópico es de 0’2 PW. La parte occidental del Pacífico sur puede constituir la mayor reserva de calor del Atlántico sur, de igual modo que es probable que el océano Índico sur constituya una reserva del Pacífico.

Ahora tocaría comentar algo sobre los ríos del planeta, sin embargo, lo obvio y me dirijo directamente a comentar sobre el calor de la Tierra.

Aunque la Tierra se formara inicialmente a partir de materia fría (material cósmico) que se contrajo por acción de la gravedad, durante la formación posterior del núcleo líquido y en los periodos de intensa actividad volcánica se ha liberado una enorme cantidad de calor. Los frecuentes impactos de objetos pesados también han contribuido al calentamiento de la superficie. Hay mucha incertidumbre sobre la historia térmica de la Tierra de los últimos 3.000 millones de años, durante los cuales el planeta se ha ido enfriando y una gran parte de este flujo de calor ha alimentado los movimientos geotectónicos globales, creando nueva corteza en las dorsales oceánicas; un proceso que ha ido acompañado de terremotos recurrentes y erupciones volcánicas de lava, cenizas y agua caliente.

Solamente hay dos posibles fuentes de calor terrestre, pero la importancia relativa de las respectivas contribuciones no está aún muy clara. El calor basal, liberado por un lento enfriamiento del núcleo terrestre debe representar una gran parte del flujo total, si bien cálculos basados en la desintegración radiactiva del U235, U238, Th232 y K40 sugieren que éste representa al menos la mitad y quizás hasta nueve décimos del flujo total de calor del planeta. Esta disparidad obedece a la incertidumbre en la concentración de K40 en la corteza terrestre. Pero sea cual sea la proporción, el flujo total, basado en miles de medidas realizadas desde los años cincuenta, está próximo a los 40 TW.

Aunque inicialmente se pensó que los flujos continentales y oceánicos eran aproximadamente iguales, en realidad difieren de forma sustancial. Las regiones del fondo oceánico más recientes contribuyen con más de 250 mW/m2, cantidad que supera hasta tres veces las zonas continentales más recientes. El flujo medio para todo el fondo marino es aproximadamente igual a 95 mW/m2, lo que representa un 70% más que el correspondiente a la corteza continental. El flujo medio global es de 80 mW/m2, unos tres órdenes de magnitud inferior al valor medio del flujo de calor de la radiación solar global.

Llegados a este punto, tengo que respirar. ¡Qué maravilla! ¡La Tierra!

emilio silvera

Mar

22

¿Por qué es difícil Viajar a Marte? I (Apuntes de la NASA)

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Marte ~

Clasificado en Marte ~

Comments (3)

Comments (3)

¿Por qué es difícil ir a Marte?

Fotograma de la película ‘The martian’. AIDAN MONAGHAN

El estreno de la película ‘Marte’ (The Martian) ha despertado cierta curiosidad acerca de posibles futuros viajes humanos al planeta rojo. Después de haber ido a la Luna en varias ocasiones hace ya casi cinco décadas, y estando acostumbrados a ver astronautas viajar al espacio casi de forma rutinaria, es tentador pensar que enviar seres humanos a Marte pueda ser algo perfectamente plausible a día de hoy, o tal vez un tanto más complicado que lo hecho hasta ahora. Sin embargo, la realidad es que enviar seres humanos a Marte constituye un desafío de una dificultad y complejidad absolutamente descomunales que se aleja mucho de todo lo que se ha hecho hasta ahora en la historia de la exploración humana del espacio.

En esta y en la siguiente entrada hablaré de las razones por las que esta empresa constituye un desafío inmenso y sobre cómo se plantea en la actualidad una misión tripulada a Marte. Con objeto de ofrecer una perspectiva inicial para entender la dimensión del problema de una forma intuitiva, en esta entrada trataré de la razón principal que hace extremadamente difícil una misión a Marte, la razón de la que prácticamente se derivan casi todas las demás: la distancia.

Matt Damon in “The Martian.” Credit Aidan Monaghan/Twentieth Century Fox

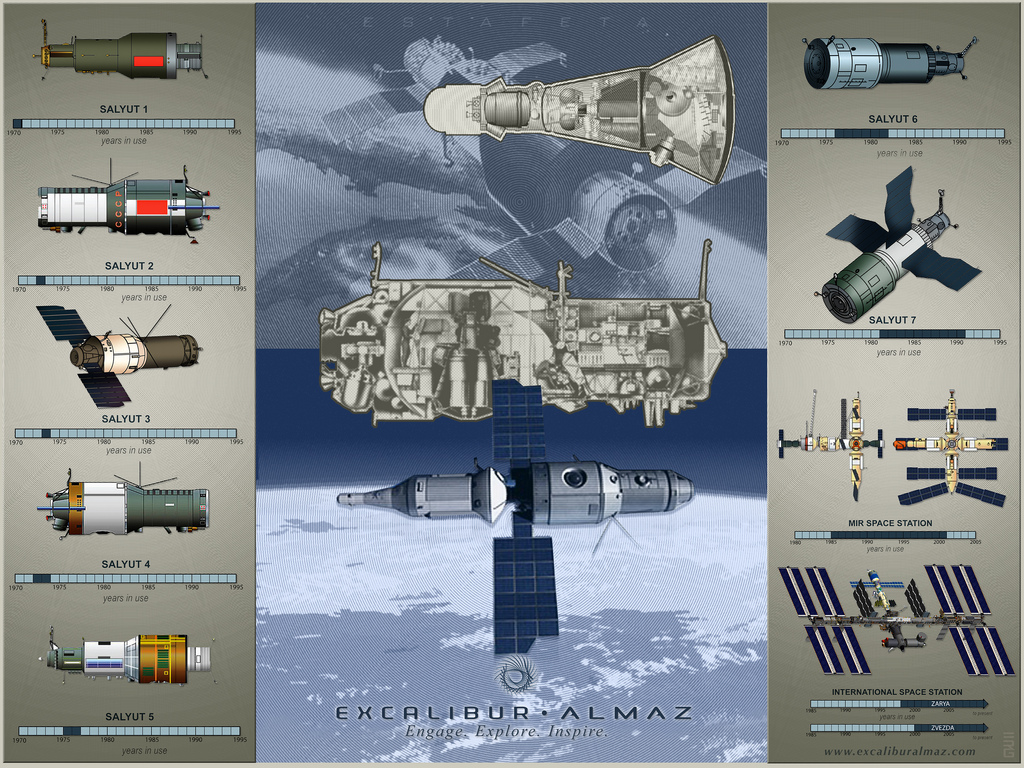

Vemos astronautas viajar con frecuencia al espacio, a la Estación Espacial Internacional (ISS), antes a la estación Mir, a bordo de naves Soyuz, o antes a bordo del Transbordador Espacial, etc., y se suele tener la impresión de que el lugar al que se viaja en estas misiones es muy lejano; sin embargo, las altitudes típicas a las que estas estaciones y vehículos espaciales orbitan alrededor de la Tierra son de unos pocos cientos de kilómetros. La ISS, por ejemplo, orbita alrededor de la Tierra a una altitud que es equivalente a la distancia que hay en línea recta entre Madrid y Almería: unos 400 km. Esta región espacial a la que viajan los humanos de forma rutinaria está dentro de la conocida como ‘región de las órbitas bajas de la Tierra’, y técnicamente la llamamos LEO (del inglés Low Earth Orbit).

Comparativa entre orbitas bajas de la Tierra (arriba) y la distancia a escala entre la Tierra y la Luna (abajo).

Los viajes tripulados lunares implicaron viajar más allá de las órbitas LEO ya que la Luna orbita nuestro planeta a una distancia media de unos 380.000 km, lo que viene a ser unas 1.000 veces más lejos que las altitudes de estas órbitas bajas. Una tripulación y su nave se ponen en órbita alrededor de la Tierra poco después de su lanzamiento, mientras que la distancia a la Luna se cubría en las misiones Apolo en prácticamente 3 días.

En el caso de Marte la situación es muy diferente. Ir a Marte implica pasar de una misión geocéntrica a una centrada en el Sol, o heliocéntrica, lo que supone un salto enorme en las distancias involucradas. Aunque las distancias máxima y mínima entre la Tierra y Marte varían dentro de un cierto rango, la mínima distancia posible es de unos 55 millones de km y la máxima posible es de unos 400 millones de km.

Estas son distancias enormes en comparación a todo lo que se ha volado en misiones tripuladas al espacio hasta ahora. La distancia máxima a Marte viene a ser 1.000 veces mayor que la que hay entre la Tierra y la Luna, lo que viene a ser 1.000.000 de veces mayor que la distancia que separa la superficie terrestre de las órbitas LEO a las que se viaja normalmente.

Distancias aproximadas mínima y máxima posibles entre la Tierra y Marte. Como referencia, la distancia media de la Tierra a la Luna es de 380.000 km.

Sin necesidad de conocer nada más, los datos acerca de la distancia a Marte ya constituyen una buena pista para empezarnos a asomar a la magnitud del problema. Para apreciarlo mejor, y sin entrar en detalles relativos a métodos de propulsión o dinámica orbital, vamos a comparar en números redondos dos misiones tripuladas, una orbital alrededor de la Tierra para un solo tripulante y otra lunar de tres tripulantes, para hacernos una idea de la progresión en la masa necesaria de los cohetes involucrados para llevar a cabo estas misiones y entender el contexto de lo que supondrá una misión a Marte.

Empezamos con la primera misión orbital del Programa Mercury de principios de los ’60: la Mercury 6 de John Glenn. Aquí se precisó de un cohete Atlas de 120 toneladas y 29 metros de altura para poner en una órbita de 200 km de altitud media alrededor de la Tierra una masa útil de 1,2 toneladas formada por una cápsula Mercury con su único tripulante, el cual permaneció en el espacio 5 horas.

Veamos ahora lo que cambia la situación al tener a la Luna como destino unas 1.000 veces más lejos. En el caso del Apolo 17 -la última misión de exploración lunar-, su módulo de mando y servicio más su módulo lunar, sumando todo cerca de 50 toneladas, hubieron de ser lanzados a la Luna por el poderoso cohete Saturno V de unas 3.000 toneladas y de 110 metros de altura para una misión de una duración total de unos 12 días y medio en la que 2 de sus tripulantes permanecieron sobre la superficie lunar algo más de 3 días.

Cohete lunar Saturno V junto al cohete Atlas del Programa Mercury para un tripulante (Transbordador Espacial incluido como referencia). Fuente: http://historicspacecraft.com/.

Vemos así el salto cuantitativo necesario cuando queremos ir a otro mundo que está 1.000 veces más allá de las órbitas bajas de la Tierra tanto en la masa útil a lanzar (de 1,2 a 50 toneladas) como en el tamaño del cohete lanzador requerido (de 120 a 3.000 toneladas). Comparemos todo esto con una misión a Marte. Aquí la tripulación constará de 6 astronautas y su duración, tomando como ejemplo la oportunidad en 2037, sería de 174 días para la ida y 201 días para la vuelta, con una estancia de 539 días en Marte. Una estancia tan larga en Marte sería necesaria a la espera de que la posición relativa entre este planeta y la Tierra fuera óptima para el regreso con un mínimo gasto de combustible, lo que ahorra el envío de centenares de toneladas de combustible. Todo esto supone un total de 914 días, o 2 años y medio.

Como vemos, el salto entre la Luna y Marte es descomunal, ya que doblar la tripulación y extender la duración a cerca de 73 veces la de la misión lunar más larga, supone la necesidad de proveer y transportar cerca de 150 veces más suministros. Por otra parte, una mayor duración de viaje interplanetario supone la necesidad de proveer a la tripulación de mayor protección contra las radiaciones, lo que se consigue en parte añadiendo aún más masa, aunque este problema no está aún resuelto.

Otro problema de la larga duración es que las cosas se rompen a lo largo de tanto tiempo. O bien se tendrá que mejorar sustancialmente la durabilidad de los equipos o estos habrán de poder ser repuestos por recambios que también habrá que transportar, lo que implica una mayor masa. Las naves de carga que visitan la ISS pueden abastecerla de repuestos cuando algo se estropea a bordo pero esta opción no será posible en una misión a Marte.

Una vez dicho todo esto, al igual que cuesta más acelerar y frenar un camión que un turismo por tener el primero más masa, tengamos en cuenta que enviar más masa a Marte implica transportar también más combustible para acelerar toda esa carga hacia Marte, para frenarla a la llegada a ese planeta, y para volver a la Tierra desde allí; y pensemos que todo ese combustible (centenares de toneladas) también hay que lanzarlo al espacio inicialmente.

En total, para una misión a Marte se requerirá lanzar al espacio entre 850 y 1.250 toneladas. Esta es una cantidad enorme si tenemos en cuenta que la Ia ISS tiene una masa de unas 420 toneladas y que una nave con la que estamos familiarizados como el Transbordador Espacial solo podía enviar al espacio entre 15 y 25 toneladas aproximadamente, dependiendo de la altitud de la órbita final. El Ariane 5 es capaz de poner unas 20 toneladas en órbita baja alrededor de la Tierra, al igual que el cohete ruso Protón, por ejemplo.

Así pues, a partir de todo esto, y sin saber mucho más, ya podemos anticipar de forma intuitiva que no se podrá utilizar un único cohete para ir a Marte, sino que se precisarán varios lanzamientos de cohetes -tanto o más poderosos que el Saturno V de los años ’60- para ensamblar en el espacio distintos elementos de propulsión, módulos de combustible, hábitats y naves, que habrán de enviarse a Marte por separado y por anticipado, además de la nave con la tripulación, que sería enviada en último lugar. Entraremos en estos detalles en la siguiente entrada.

Aunque depende de diversos factores, se requerirán, de hecho, del orden de 10 lanzamientos de cohetes con la capacidad del Saturno V o similar; pero recordemos que el número total de cohetes Saturno V que se enviaron a la Luna en todo el Programa Apolo fue de 9. El Saturno V fue retirado de servicio después del Porgrama Apolo pero ostenta el récord, aún a día de hoy, como el cohete operativo más poderoso que haya habido nunca, capaz de poner algo más de 120 toneladas en órbita baja alrededor de la Tierra y de enviar 50 toneladas a la Luna. Tuvo que ser específicamente diseñado y construido en su día para poder alcanzar la Luna, y no existe un lanzador de tanta capacidad en la actualidad. El cohete que se encargaría de la mayor parte de los lanzamientos en una futura misión a Marte se está desarrollando en la actualidad y se llama SLS (Space Launch System), el cual tendrá prestaciones parecidas o acaso un tanto mayores que el Saturno V.

Por otra parte, un tiempo de 174 días de ida en condición de ingravidez afecta profundamente a la fisiología humana, algo especialmente preocupante al llegar a un planeta donde no hay nadie para asistirte. Las naves que se pueden ver en las películas (incluida la película ‘Marte’), con un amplio y confortable habitáculo en forma de donut girando para simular la aceleración de la gravedad, no son realistas en la actualidad.

Dos años y medio es un tiempo muy largo también por razones psicológicas. La Tierra será vista por la tripulación como un punto de luz semejante a una estrella durante la mayor parte del viaje y será apenas imperceptible en la noche marciana cuando fuera visible. La tripulación tendrá que convivir en una condición de confinamiento permanente en un espacio reducido en una situación de gran estrés, y con la imposibilidad de mantener conversaciones fluidas con los seres queridos en la Tierra debido al tiempo de viaje de la señal.

Después de todo esto, y aunque no se han mencionado todas las dificultades técnicas, tecnológicas y operativas, creo que ahora puede apreciarse un poco mejor a lo que nos enfrentamos en una misión a Marte. A partir de aquí, y una vez expuesta esta perspectiva para contextualizar el problema y entrar en materia, en la siguiente entrada explicaré cómo se plantea en la actualidad una misión humana a Marte y cómo se relaciona con lo que se ve en la película ‘Marte’ (The Martian).

sigue en la II parte

Fuente: NASA

Totales: 67.371.310

Totales: 67.371.310 Conectados: 28

Conectados: 28