Nov

14

¿Las estrellas? Sí, son mucho más… ¡que simples puntitos...

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Estrellas ~

Clasificado en Estrellas ~

Comments (0)

Comments (0)

Es cierto que cuando vemos las cosas con cierta asiduidad y de forma permanente, esa cotidianidad nos hace perder la perspectiva y no pensamos en lo que realmente esas cosas pueden ser y, con las estrellas nos ocurre algo similar, ya que son algo más, mucho más, que simples puntitos luminosos que brillan en la oscuridad de la noche. Una estrella es una gran bola de gas luminoso que, en alguna etapa de su vida, produce energía por la fusión nuclear del hidrógeno para formar helio. El término estrella por tanto, no sólo incluye estrellas como nuestro Sol, que están en la actualidad quemando hidrógeno, sino también protoestrellas, aún no lo suficientemente calientes como para que dicha combustión haya comenzado, y varios tipos de objetos evolucionados como estrellas gigantes y supergigantes, que están quemando otros combustibles nucleares, o las enanas blancas y las estrellas nucleares, que están formadas por combustible nuclear gastado.

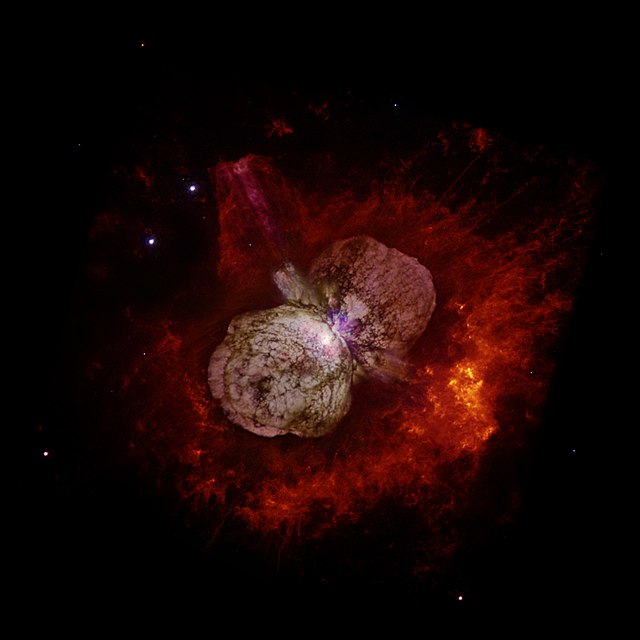

En esta imagen del Telescopio Espacial Hubble se pueden apreciar a la estrella Eta Carinæ y los restos de erupciones antiguas que forman la La Nebulosa del Homúnculo alrededor de la estrella. La nebulosa fue creada por una erupción de Eta Carinae cuya luz alcanzó la Tierra en 1.843. Eta Carinae aparece como un parche blanco en el centro de la imagen, donde los dos lóbulos de la nebulosa Homúnculo convergen. Como su masa está calculada entre las 100/150 masas solares, su propia radiación la podría destruir y, la única defensa que tiene es, la de eyectar marterial al Espacio Interestelar para descongestionarse y seguir viviendo.

Estrellas masivas que expulsan gases, ya que, cuando la masa es muy grande, su propia radiación las puede destruir y, de esta manera, descongestionan la tensión y evitan un final anticipado. Arriba teneis una estrella supermasiva que ha expulsado gases formando una nebulosa para evitar su muerte, Eta Carinae es un buen ejemplo de cómo actúan este tipo de estrellas masivas para evitar la muerte. Estas son estrellas que estám congestionadas y, sólo la expulsión de material la puede aliviar y conseguir que siga brillando como estrella evitando explotar como supernova.

Se calcula que la masa máxima de una estrella es de unas 120 masas solares, por encima de la cual sería destruida por su propia radiación. La masa mínima es de 0,08 masas solares; por debajo de ella, los objetos no serían lo suficientemente calientes en sus núcleos como para que comience la combustión del hidrógeno, y se convertirían en enanas marrones.

De la misma forma que al calentar una pieza de metal cambia de color, al principio rojo, luego amarillo hasta llegar al blanco, el color de una estrella varia según su temperatura superficial. Las estrellas más frías son las rojas, y las mas calientes las azules. Estos colores suelen percibirse a simple vista, como por ejemplo Antares (la estrella principal de Scorpius) que es de color rojo, o Rigel (en Orion) de color azul. En astronomía se utiliza la escala Kelvin para indicar temperaturas, donde el cero absoluto es -273 grados Celsius.

El Diagrama de Hertzsprung-Russell (arriba) proporcionó a los astrónomos un registro congelado de la evolución de las estrerllas, el equivalente astrofísico del registro fósil que los geólogos estudian en los estratos rocosos. Presumiblemente, las estrellas evolucinan de algún modo, pasan la mayor parte de su tiempo en la serie principal (la mayoría de las estrellas en la actualidad, en el brevísimo tiempo que tenemos para observar, se encuentran allí), pero empiezan y terminan su vida en alguna otra parte, entre las ramas o en el mantillo. Por supuesto, no podemos esperar para ver que esto sucede, pues el tiempo de vida, aún de estrellas de vida corta, se mide en millones de años. Hallar la respuesta exigirá conocer la física del funcionamiento estelar.

El progreso en física, mientras tanto, estaba bloqueado por una barrera aparentemente insuperable. Esto era literal: el agente responsable era conocido como la Barrera de Coulomb, y por un tiempo frustró los esfuerzos de los físicos teóricos para comprender cómo la fusión nuclear podía producir energía en las estrellas.

La barrera de Coulomb, denominado a partir de la ley de Coulomb, nombrada así del físico Charles-Augustin de Coulomb (1736–1806), es la barrera de energía debida a la interacción electrostática que el núcleo atómico debe superar para experimentar una reacción nuclear. Esta barrera de energía es proporcionada por la energía potencial electrostática:

donde:

- k es la constante de Coulomb = 8.9876×109 N m² C−2;

- ε0 es la permeabilidad en el vacío;

- q1, q2 son las cargas de las partículas que interactúan;

- r es el radio de interacción.

Un valor positivo de U es debido a una fuerza de repulsión, así que las partículas que interactúan están a mayores niveles de energía cuando se acercan. Un valor negativo de la energía potencial U indica un estado de ligadura, debido a una fuerza atractiva. La linea de razonamiento que conducía a esta barrera era impecable. Las estrellas están formadas en su mayor parte por hidrógeno. Esto se hace evidente en el estudio de sus espectros.) El núcleo del átomo de hidrógeno consiste en un sólo protón, y el protón contiene casi toda la masa del átomo. (Sabemos esto por los experimentos de Rutherford explicados aquí en otra ocasión). Por tanto, el protón también debe contener casi toda la energía latente del átomo de hidrógeno.

(Recordemos que la masa es igual a la Energía: E = mc2. (En el calor de una estrella los protones son esparcidos a altas velocidades -el calor significa que las partículas involucradas se mueven rápidamente- y, como hay muchos protones que se apiñam en el núcleo denso de una estrella, deben de tener muchísimos choques. En resumen, la energía del Sol y las estrellas, puede suponerse razonablemente, implica las interacciones de los protones. esta era la base de conjetura de Eddintong de que la fuente de la energía estelar “difícilmente puede ser otra cosa que energía subatómica, la cual, como se sabe, existe en abundancia en toda la materia”.

A ese punto, todo iba bien, la ciencia estaba cerca de identificar la fusión termonuclear como el secreto de la energía solar. Pero aquí era donde intervenía la Barrera de Coulomb. Los protones están cargados positivamente; las partículas de igual carga se repelen entre sí; y este obstáculo parecía demasiado grande para ser superado, aun a la elevada velocidad a la que los protones se agitaban en el intenso calor del centro de las estrellas. De acuerdo con la física clásica, muy raras veces podían dos protones de una estrella ir con la rapidez suficiente para romper las murallas de sus campos de fuerza electromágnéticos y fundirse en un sólo núcleo. Los cálculos decían que la tasa de colisión de protones no podía bastar para mantener las reacciones de fusión. Sin embargo, allí estaba el Sol, con su rostro radiante y sonriente al ver el esfuerzo y las ecuaciones que decían que no podía brillar.

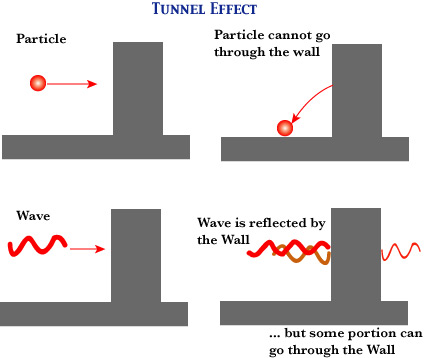

Dejemos aquí este proceso y digamos que, realmente, la mayoría de las veces el protón rebotará en la Barrera de Coulomb, pero de cuando en cuando la atravesará. Este es el “Efecto Túnel Cuántico”; que permite brillar a las estrellas. George Gamow, ansioso de explotar las conexiones entre la astronomía y la nueva física exótica a la que era adepto, aplicó las probabilidades cuánticas a la cuestión de la fusión nuclear en las estrellas y descubrió que los protones pueden superar la Barrera de Coulomb, o casi.

El efecto túnel cuántico se hizo cargo de los cálculos de la desalentadora predicción clásica, que establecia la fusión de los protones a sólo una milésima de la tasa necesaria para explicar la energía liberada por el Sol, y la elevó a una décima de la tasa necesaria. Luego se tardó menos de un año para dar cuenta del deficit restante: la solución fue completada en 1929, cuando Robert Atkinson y Fritz Houterman combinaron los hallazgos de Gamow con lo que se ha llamado teoría maxwelliana de la distribución de velocidades. En la distribución maxwelliana hay siempre unas pocas partículas que se mueven mucho más rápidamente que la media y, Robert Atkinson y Fritz Houterman hallaron que estas pocas partículas veloces bastqaban para compensar la diferencia. Finalmente se hizo claro como podía romperse la Barrera de Coulomb suficientemente a menudo para que la fusión nuclear se produjese en las estrellas.

Pero la figura clave en todos estos desarrollos fue Hans Bhete, un refugiado de la Alemania nazi que había estudiado con Fermi en Roma y fue a enseñar en Cornell en EE. UU. Como su amigo Gamow, el joven Bhete era un pensador efervescente y vivaz, con tanto talento que parecía hacer su trabajo como si de un juego se tratara. Aunque no preparado en Astronomía, Bhete era un estudioso de legendaria rapidez. En 1938 ayudó al discipulo de Gamow y Edward Teller, C.L. Critchfield, a calcular una reacción que empezase con la colisión de dos protones podía generar aproximadamente la energía irradiada por el Sol, 3,86 x 1033 ergios por segundo. Así, en un lapso de menos de cuarenta años, la humanidad había progresado de la ignorancia de la existencia misma de los átomos a la comprensión del proceso de fusión termonuclear primaria que suministra energía al Sol.

Pero la reacción protón. protón no era bastante energética para explicar la luminosidad muy superior de estrellas mucho más grandes que el Sol, estrellas como las supergigantes azules de las Pléyades, que ocupan las regiones más altas del diagrama de Herptzsprung-Russell. Bhete puso remedio a esto antes de que terminase aquel el año 1938.

En abril de 1938, Bhete asistió a una conferencia organizada por Gamow y Teller que tenía el objeto de que físicos y astrónomos trabajaran juntos en la cuestión de la generación de energía en las estrellas. “Allí, los astrofísicos nos dijeron a los físicos todo que sabían sobre la constitución interna de las estrellas -recordoba Bhete-. esto era mucho (aunque) habían obtenido todos los resultados sin conocimiento de la fuente específica de energía.” De vuelta a Cornell, Bhete abordó el problema con celeridad y, en cuestión de semanas logró identificar el ciclo del Carbono, la reacción de fusión crítica que da energía a las estrellas que tiene más de una vez y media la masa del Sol.

Bhete que estaba falto de dinero, retiró el artículo que escribió sobre sus hallazgos y que ya tenía entragado en la Revista Physical Review, para entregarlo en un Concurso postulado por la Academía de Ciencias de Nueva York sobre la producción de energía en las estrellas. Por supuesto, Bhete ganó el primer Premio uy se llevó los 500 dolares que le sirvieron para que su madre pudiera emigrar a EE UU. Después lo volvió a llevar a la Revista que lo publicó y, finalmente, se lo publicaron y tal publicación le hizo ganar el Nobel. Por un tiempo, Bhete había sido el único humano que sabía por qué brillan las estrellas.

Cuando miramos al cielo y podemos contemplar extasiados esas maravillas que ahí arriba, en el espacio interestelar están brillando, y, nos da la sensación de que están hacièndonos guiños, como si quisieran mandarnos un mensaje, decirnos algo y nosotros, no pensamos en todo lo que ahí, en esos “puntitos brillantes” se está fraguando. De lo que allí ocurre, depende que los mundos tengan los materiales que en ellos están presentes y, de entre esos materiales, se destacan aquellos que por su química biológica, permiten que se pueda formar la vida a partir de unos elementos que se hiceron en los hornos nucleares de las estrellas.

Con la excepción del Sol, las estrellas están tan lejos de nosotros que, aún mirando a través de un telescopio, aparecen como un pequeño punto de luz en el espacio. Cuando observamos las estrellas, la turbulencia en la atmósfera refracta la luz que emana de ésta en direcciones diferentes. Esto hace que las estrellas parezcan estar cambiando de iluminación y de posición, lo que le da ese efecto titilante.

Y sí, es curioso que, mirando en la oscura noche como brillan las estrellas del cielo, nos atrae su titilar engañoso (es la atmósfera terrestre la que hace que lo parezca) y su brillo, Sin embargo, pocos llegan a pensar en lo que verdaderamente está allí ocurriendo. Las transformaciones de fase por fusión no cesan. Esta transformación de materia en energía es consecuencia de la equivalencia materia-energía, enunciada por Albert Einstein en su famosa fórmula E=mc2; donde E es la energía resultante, m es la masa transformada en energía, y c es la velocidad de la luz (300 000 kilómetros por segundo). La cantidad de energía que se libera en los procesos de fusión termonuclear es fabulosa.

Un gramo de materia transformado íntegramente en energía bastaría para satisfacer los requerimientos energéticos de una familia mediana durante miles de años. Sería impensable hoy, que pudiéramos vivir en una casa sin iluminación artificial para que nos suministre toda la energía que necesitamos para las diferentes actividades que, durante la jornada desarrollamos.

Es un gran triunfo del ingenio humano el saber de qué, están confomadas las estrellas y qué materiales se están forjando allí, al inmenso calor de sus núcleos. Recuerdo aquí a aquel Presidente de la Real Society de Londres que, en una reunión multitudinaria, llegó a decir: “Una cosa está clara, nunca podremos saber de qué están hechas las estrellas”. El hombre se vistió de gloria con la, desde entonces, famosa frase. Creo que nada, con tiempo por delante, será imposible para nosotros.

El Sol se comporta prácticamente como un cuerpo negro, el cual emite energía siguiendo la ley de Planck a la temperatura media de 6.000 K. La radiación solar se distribuye desde el infrarrojo hasta el ultravioleta. No toda la radiación alcanza la superficie de laTierra, porque las ondas ultravioletas más cortas son absorbidas por los gases de la atmósfera. La magnitud que mide la radiación solar que llega a la Tierra es la irradiancia, que mide la potencia que por unidad de superficie alcanza a la Tierra. Su unidad es el W/m2 (vatio por metro cuadrado).

A nuestro planeta sólo llega una ínfima fracción del calor que se genera en el Sol y, sin embargo, es más que suficiente para mantener aquí la vida. El Sol tiene materia que supone la misma que tendrían 300.000 Tierras. Nuestra estrella madre está situada a una UA (150 millones de kilómetros de nosotros) y, todas esas circunstancias y otras muchas, hacen que todo sea tal como lo vemos a nuestro alrededor. Si cualquiera de esos parámetros fuera diferente o variara tan sólo unas fracciones, seguramente la Tierra sería un planeta muerto y, nosotros, no estaríamos aquí. Sin embargo… ¡Estamos! y, gracias a ello, se pueden producir descubrimientos como los que más arriba hemos relatado y han podido y pueden existir personajes de cuyas mentes surgen ideas creadoras que nos llevan a saber cómo son las cosas.

Lo cierto es que, cada día sabemos mejor como funciona ma Naturaleza que, al fin y al cabo, es la que tiene todas las respuestas que necesitamos conocer.

emilio silvera

Nov

13

¿El núcleo del átomo? ¡Una maravilla de la Naturaleza!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El núclo atómico ~

Clasificado en El núclo atómico ~

Comments (3)

Comments (3)

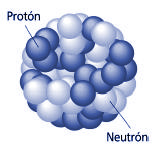

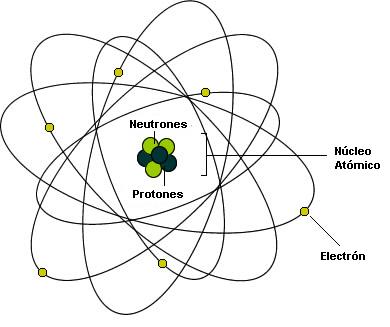

Las partículas del núcleo atómico. Protón y neutrón.

En 1920 (Rutherford) descdubrió las partículas positivas que forman los átomos, los protones.

Por lo tanto en los núcleos de los átomos hay unas partículas positivas que se llaman protones. En el hidrógeno solo hay una partícula ya que recordemos su masa era casi la misma.

Se comprobó que el número de protones es una característica especial de cada elemento químico, ya que todos los átomos del mismo elemento tienen el mismo número de protones. Se llama número atómico (Z) al número de protones que tienen los átomos de un elemento químico. A cada elemento químico le corresponde un número atómico desde 1 hasta 106.

Todavía tenemos que buscar otras partículas en el núcleo atómico. La masa de los protones de un núcleo es mucho menor que la masa del núcleo.

Cada elemento químico se caracteriza por el número de protones de su núcleo, que se denomina número atómico (Z). Así, el hidrógeno ( 1H) tiene un protón, el carbono ( 6C) tiene 6 protones y el oxígeno ( 8O) tiene 8 protones en el núcleo.

El número de neutrones del núcleo puede variar. Casi siempre hay tantos o más neutrones que protones. La masa atómica (A) se obtiene sumando el número de protones y de neutrones de un núcleo determinado.

Un mismo elemento químico puede estar constituído por átomos diferentes, es decir, sus números atómicos son iguales, pero el número de neutrones es distinto. Estos átomos se denominan isótopos del elemento en cuestión. Isótopos significa “mismo lugar“, es decir, que como todos los isótopos de un elemento tienen el mismo número atómico, ocupan el mismo lugar en la Tabla Periódica.

isótopos del Hidrógeno

isótopos del Carbono

Desde 1918 estaba probado que existían los isótopos. Estos, eran átomos que tenían propiedades químicas iguales (parecían elementos iguales, por tanto), tenían el mismo número atómico, pero sus masas atómicas eran diferentes. En el núcleo debían existir partículas neutras que contribuyeran a la masa pero no tuvieran carga eléctrica.

La curiosidad acerca del tamaño y masa del átomo atrajo a cientos de científicos durante un largo período en el que la falta de instrumentos y técnicas apropiadas impidió lograr respuestas satisfactorias. Con posterioridad se diseñaron numerosos experimentos ingeniosos para determinar el tamaño y peso de los diferentes átomos.

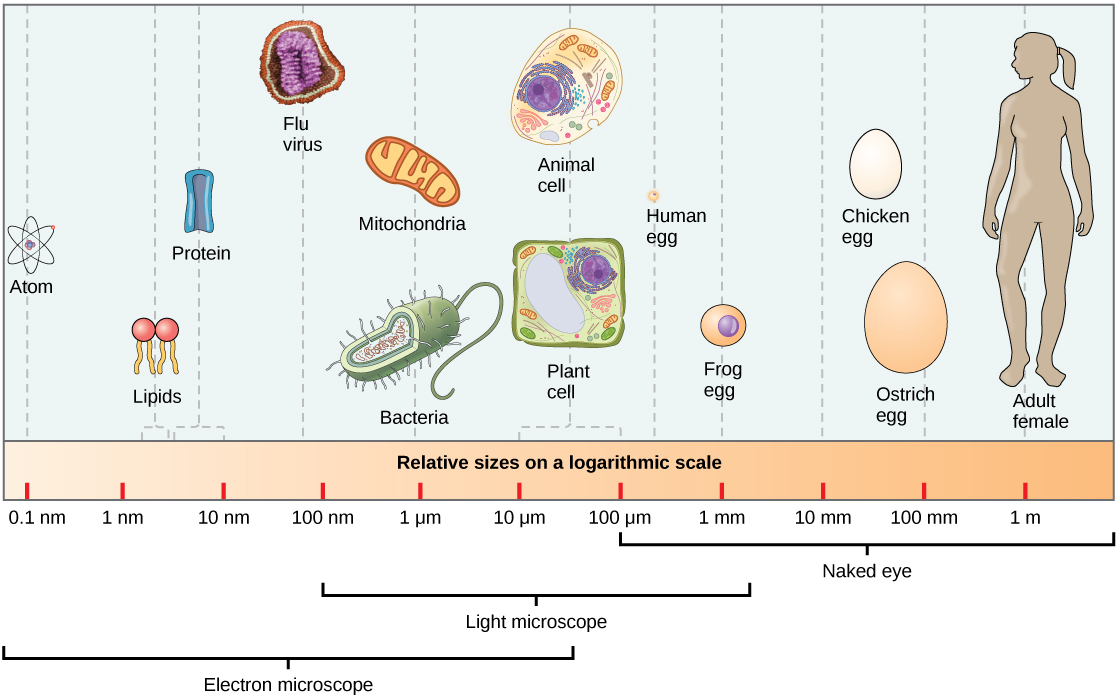

El átomo más ligero, el de hidrógeno, tiene un diámetro de aproximadamente 10-10 m (0,0000000001 m) y una masa alrededor de 1,7 x 10-27 kg (la fracción de un kilogramo representada por 17 precedido de 26 ceros y una coma decimal).

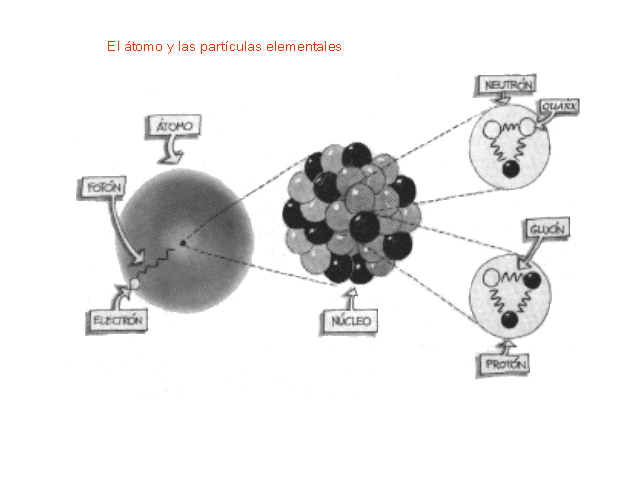

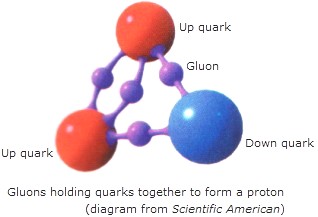

Como no es el objeto del trabao, no hablaremos hoy de los Quarks, y, simplemente diremos que en la naturaleza no se encuentran quarks aislados. Estos siempre se encuentran en grupos, llamados Hadrones. de dos o tres quarks, conocidos como mesones y bariones respectivamente. Esto es una consecuencia directa del confinamiento de color. En el año 2003 se encontró evidencia experimental de una nueva asociación de cinco quarks, los Pentaquarks, cuya evidencia, en principio controvertida , fue demostrada gracias al Colisionador de Partículas LHC en el pasado Julio de 2.015.

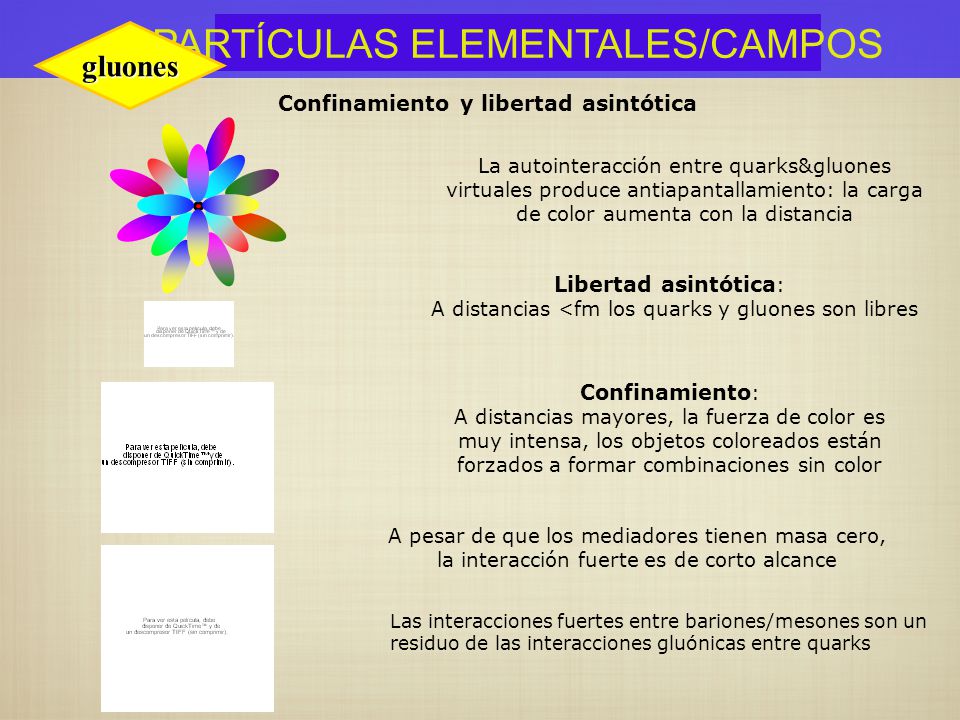

Pero sigamos con lo que nos ocupa y veámos que los Quarks están confinados dentro de los nucleones (protones y neutrones) donde la fuerza fuerte les retiene y nos los deja que se vayan alejando más de lo debido como se explica en el cuadro de arriba.

Dentro del nucleo se desatan las fuerzas de la Naturaleza, la que conocemos como fuerza nuclear fuerte, la más potente de las cuatro fuerzas fundamentales que, intermediada por otras partículas de la familia de los Bosones, los Gluones, no dejan que los Quarks se alejen y son retenidos allí, dentro de los nucleones donde tienen su función de conformar los hadrones másicos del núcleo que le aporta la materia al átomo.

Los Gluones, son las partículas intermediarias de la fuerza fuerte, y, de la misma manera, existen otros Bosones encargados de mediar en las otras fuerzas conocidas de la Naturaleza: El Fotón para los fenómenos electromagnéticos, el Gravitón (no encontrado aún) para la fuerza de Gravedad, y, los W+, W– y Zº para la fuerza nuclear débil.

Lo cierto es que, el núcleo atómico está cargado positivamente y, tal carga, hace la llamada para que, un enjambre de electrones, con cargas negativas, vengan a rodear el núcleo atómico y, de esa manera, queda estabilidado el átomo, ese pequeño objeto que conforma todas las cosas hechas de materia.

Así, los electrones que rodea el núcleo, con su carga eléctrica negativa que complementa la positiva de los protones y hace estable al átomo; una masa de solamente 1/1.836 de la del núcleo más ligero (el del hidrógeno). Y, sin embargo, la importancia del electrón es vital en el universo.

Repasando todo esto, no puedo dejar de recordar aquellas palabras que el físico Freeman Dyson escribió:

“Cuando miramos en el universo e identificamos los muchos accidentes de la física y la astronomía que han colaborado en nuestro beneficio, casi parece que el universo debe haber sabido, en cierto sentido, que nosotros íbamos a venir“.

Fijaros en el hecho cierto de que, si la carga del electrón, o, la masa del protón, variaran aunque sólo fuese una diezmillonésima parte… ¡La vida no podría existir en el Universo! Estamos hechos de átomos y, con tal cambio, éstos nunca se habrían podido conformar.

emilio silvera.

Nov

12

La partícula que es materia y antimateria a la vez

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (4)

Comments (4)

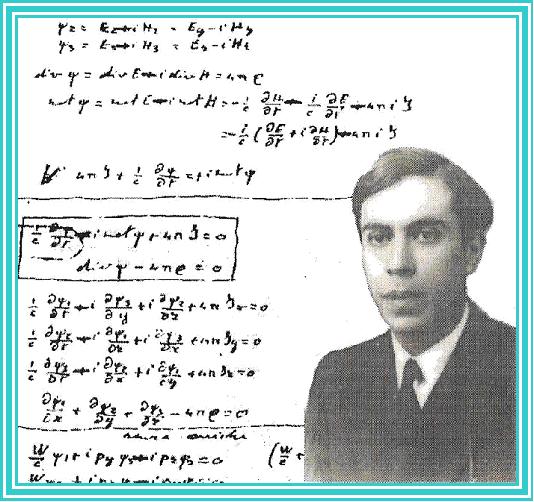

Un equipo de EEUU crea una exótica partícula cuya existencia se predijo hace más de 70 años

En 1937, un joven y brillante físico italiano llamado Ettore Majorana predijo la existencia de una partícula aparentemente imposible. No tenía carga y, por tanto, podía comportarse a la vez como si estuviese hecha de materia y antimateria. Hacía solo unos años que Paul Dirac, otro joven y brillante físico británico, había explicado la teoría moderna de la antimateria. Esta venía a decir que por cada elemento de materia conocida podía haber un reverso con carga opuesta hecha de antimateria. Así, un electrón tendría su positrón y un protón, su antiprotón. Cuando ambos entraban en contacto se desintegraban de forma violenta dejando escapar un estallido de radiación. La excepción era esa exótica partícula predicha por Majorana. Desde entonces, nadie ha conseguido observarla en la naturaleza. Su falta de carga haría que estas partículas, llamadas fermiones de Majorana, no interactuaran con la materia convencional con lo que serían muy difíciles de detectar. Hoy se piensa que partículas similares podrían ser las que componen la esquiva materia oscura, esa sustancia que compone el 23% del universo sin que nadie aún haya conseguido observarla de forma directa. Un año después de hacer su propuesta, como si fuese uno de sus fermiones indetectables, Ettore Majorana desapareció sin dejar rastro mientras viajaba en un barco hacia Nápoles.

Hoy, un equipo de investigadores de EEUU publica un estudio en el que demuestran haber observado fermiones de Majorana. Tal y como predijo el físico, se trata de partículas que se comportan como si estuviesen hechas de materia y antimateria al mismo tiempo y que serían a la vez una partícula y su propia antipartícula.

“Hemos tomado una imagen directa del fermión de Majorana”

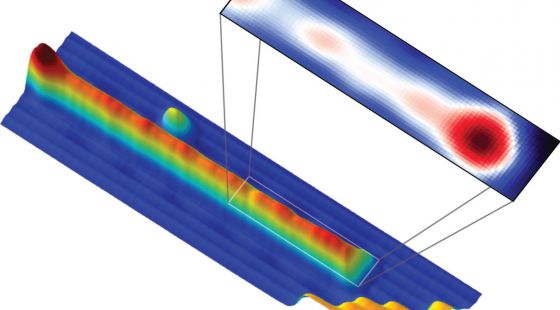

El hallazgo no se ha hecho en un gran acelerador de partículas, como en el caso del bosón de Higgs, sino en un experimento controlado con materiales superconductores y observado con un microscopio de efecto túnel, que permite ver un material a nivel atómico. Los investigadores tomaron una finísima tira de hierro de un átomo de ancho y la enfriaron hasta rozar el cero absoluto (-273 grados). Fue entonces cuando, a cada extremo de la cadena, aparecieron los esquivos fermiones de Majorana.

“Hemos tomado una imagen directa del fermión de Majorana usando el microscopio de efecto túnel en lugar de detectar su existencia de forma indirecta”, explica a Materia Ali Yazdani, uno de los investigadores de Princeton autores del hallazgo. Sus resultados se publican hoy en la revista Science. En 2012, otro equipo europeo clamó haber observado los mismos fermiones. Pero su detección no era del todo directa y las señales observadas podían deberse a otras causas. Las nuevas pruebas “dan más más credibilidad” a la creación de partículas de Majorana, señala Llorenç Serra, del Instituto nstituto de Física Interdisciplinar y Sistemas Complejos (CSIC-UIB).

Ettore Majorana, el gran físico que desapareció misteriosamente

Pero, ¿son estas partículas realmente fermiones como los predichos por el desaparecido Majorana? Es una cuestión que enciende a los físicos que trabajan con detectores como el LHC o en grandes sensores para cazar neutrinos. Estos experimentos pueden observar partículas fundamentales naturales, producidas de forma espontánea en el universo o de forma provocada haciendo chocar protones a velocidades cercanas a la de la luz. Por el contrario, las partículas generadas en experimentos como el de Princeton deben su comportamiento a los átomos que las rodean, en este caso de hierro y plomo. No son partículas elementales sino una variante inferior que los físicos denominan “cuasipartículas”. La gran pregunta ahora es si las propiedades que se observan en estas cuasipartículas se dan también en el mundo de las partículas elementales.

Por ejemplo se piensa que el neutrino, que apenas interactúa con la materia, podría ser a la vez partícula y antipartícula. Esto explicaría cómo pudo surgir un universo como el que conocemos, pero nadie, por ahora, lo ha conseguido demostrar. Otras posibles partículas de Majorana aún no confirmadas y también esenciales para entender el universo serían los neutralinos, que compondrían la materia oscura, otro de los grandes interrogantes de la física actual.

“El hecho de que la naturaleza produzca cuasipartículas de Majorana resulta cuando menos sugestivo de que las partículas elementales que pueden serlo, como el neutrino, también lo serán”, opina Juan José Gómez-Cadenas. Este físico del CSIC dirige un experimento en Canfranc con el que pretende ser el primero en detectar a ese esquivo neutrino que es partícula y su contrario. “Da la impresión de que, también aquí se cumple la regla que dice que la naturaleza siempre opta por que si una cosa es posible, entonces va y la implementa”, resalta.

Yazdani añade que “quizás la clave del estudio sea que demostrar un concepto de forma experimental y con precisión en un sistema te puede dar confianza de que quizás esa misma idea juegue un papel en otro sistema”. Y añade “Esta política de preguntarse ‘¿por qué no? es probablemente la que inspiró a Majorana y ha sido clave en muchos hallazgos científicos”.

Después de 76 años, el destino del propio Majorana sigue siendo un misterio.”

Hasta aquí el arículo de El Pais.

Ettore Majorana (1906-¿1938?) solo publicó 10 artículos científicos, el último de ellos póstumo. Sin embargo, muchos lo comparan con Newton, con Galileo y con los grandes genios del siglo XX. Durante su vida muy pocos se dieron cuenta de su genio, salvo quizás Enrico Fermi (1901-1954), Premio Nobel de Física en 1938 por su teoría de la interacción débil, quien le dirigió la tesis de grado en 1929, y Emilio G. Segré (1905-1989), Premio Nobel de Física en 1959 por el descubrimiento del antiprotón, que fue su profesor en 1928. ¿Por qué Majorana es un mito y está considerado uno de los físicos más importantes e influyentes del siglo XX? Hay un tipo de fermiones que recibe su nombre, los fermiones de Majorana, en pie de igualdad con los fermiones de Dirac. Obviamente, solo un gran genio puede poner su nombre al lado de los de Fermi y Dirac. ¿Realmente Majorana fue uno de los padres de la física del siglo XX?

Las Matemáticas

La historia se articula fundamentalmente entorno a la relación de Ettore Majorana (1906-1938), un joven genio de las matemáticas puras, con el físico Enrico Fermi (1901 – 1954). En su primer encuentro, Fermi entra en un aula donde este joven se encuentra solo, escribiendo en una pizarra (la escena puede verse aquí). “¿Has probado tú esa solución?”, le pregunta. Ettore se vuelve ligeramente para ver a su interlocutor, y al momento sigue escribiendo, respondiendo “Fue difícil al principio, pero sólo fueron cuentas”. Fermi se sonríe con sorna (¿sólo cuentas?), y le pregunta sobre el tiempo que le llevó resolverlo. “Es verdad que me ha llevado bastante. Estuve toda una noche”, responde el joven. Fermi, con un tono un poco más severo, responde: “A nosotros nos llevó una semana. Y éramos tres”. A continuación le pregunta por sus intereses como estudiante. Hace ingeniería, aunque afirma no apasionarle demasiado, y explica cómo ve las cosas:

En realidad me gustan las matemáticas, pero me fastidia que todo el mundo se aproveche de ellas. Físicos, ingenieros, generales de artillería… El esfuerzo de resolver un problema debería bastar por sí mismo – un cálculo perfecto debería ser inmediatamente destruido.

En ese instante, después de volver a echar un vistazo a la pizarra, Fermi comienza a borrarla. “¿Qué hace?”, le pregunta Ettore. “Destruyo un cálculo perfecto”, responde. Entonces Fermi le ofrece un libro, y le pide que elija lo que quiera. Ettore abre por una página al azar, y se lo devuelve. “No es fácil”, responde, pero claro, para eso es el gran Enrico Fermi, no le queda más remedio que resolver el ejercicio en cuestión, que resulta ser una integral definida. La escribe. Es la siguiente:

![]()

Mientras Fermi escribe y llena la pizarra de cuentas, Ettore se sienta de espaldas a él sobre la tarima, y escribe en una pequeña libreta (del tamaño de los post-it, aproximadamente). Cuando la cámara muestra lo que ha escrito, mientras Fermi sigue llenando el encerado, vemos la integral, a continuación x = 2cosht, y directamente la expresión de una primitiva (ver la imagen):

![]()

y mentalmente, como en otros momentos de la película, pensativo, acaba escribiendo el resultado: 1,21. Ha terminado mucho antes que Fermi, que sigue llenando la pizarra. Sonríe.

Al poco, Fermi termina y exclama “¡Ya está hecho!” Y recuadra la solución, 1,21. Vemos la pizarra en la imagen, tal y como la haría cualquiera (cualquiera que sepa, por supuesto, que un cambio de variable posible para eliminar la raíz cuadrada es trigonométrico; recuérdense para deducir si necesitamos una razón circular o hiperbólica las identidades sen2x + cos2x = 1, o cosh2x – senh2x = 1). Fermi utiliza el teorema del cambio de variable, etc., etc. Entonces Ettore le lanza el cuadernillo para que compruebe cómo llegó a la misma solución en menor tiempo y necesitando menos espacio.

Si uno se toma la molestia de hacer el cálculo (es pesado, pero “non è difficile”, es un ejercicio de primero de ingeniería; perdón, de grado en ingeniería, aunque tal y como se han pensado estos nuevos estudios (que toman su nombre de una ciudad italiana, precisamente), probablemente ya no la haga nadie, y en el mejor de los casos, se la encomienden al ordenador), comprobará que el resultado de la primitiva (al menos el que me sale a mí) es:

![]() ,

,

que en realidad vale 1.205234942 (y esto último sí lo he hecho con el ordenador). Hay un error en el argumento de la arcotangente, y no sabemos quien es esa misteriosa γ, que por más vueltas que le he dado, no se me ha ocurrido. Pero desde luego, pensando en cómo el cine representa las matemáticas, nada que ver con la integral trivialona de la película española comentada el mes pasado.

Adelanto hacia la computación cuántica

Más allá de los misterios del cosmos, la investigación en este campo tiene otra posible aplicación en el terreno de la computación cuántica. Esta disciplina pretende generar ordenadores millones de veces más potentes que los actuales aprovechando las propiedades cuánticas de ciertas partículas. El hecho de que los fermiones generados sean duales, a la vez materia y antimateria, les da una sorprendente estabilidad respecto a su entorno, lo que podría ayudar a usarlos para componer bits cuánticos más manejables que los que actualmente se diseñan basados en electrones, según una nota de prensa difundida por Princeton. “Son unos experimentos muy sólidos, que dan más credibilidad a que la física de partículas Majorana aparece en los sistemas de materia condensada”, opina Llorenç Serra, que investiga los efectos cuánticos de ciertos materiales en el Instituto nstituto de Física Interdisciplinar y Sistemas Complejos (CSIC-UIB). Serra coincide en que el tipo de materiales usados en este estudio, cadenas de hierro superconductoras, tienen potencial para mejorar la computación cuántica. “La gran ventaja que tienen”, dice, es que los fermiones de Majorana “están deslocalizados en los dos extremos del cable”. Esto, dice, “les hace robustos y un estado cuantico robusto frente a pérdidas de coherencia es imprescindible para un ordenador cuantico”.

Publica: emilio silvera

Nov

11

¿La teoría cuántica y la Gravedad, dentro de las cuerdas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

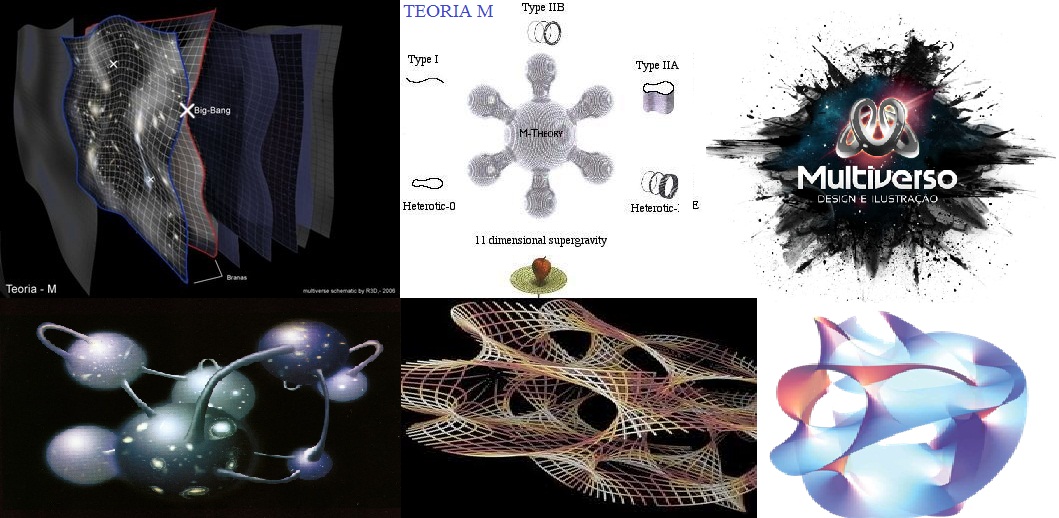

Sí, a veces la Física, parece un Carnaval. Imaginamos universos que… ¿serán posibles?

Las teorías de cuerdas [TC’s] no son una invención nueva, ni mucho menos. La primera TC se inventó a finales de los años sesenta del siglo XX en un intento para encontrar una teoría para describir la interacción fuerte. La idea medular consistía en que partículas como el protón y el neutrón podían ser consideradas como ondas de «notas de una cuerda de violín». La interacción fuerte entre las partículas correspondería a fragmentos de cuerda que se extenderían entre pequeños pedacitos de cuerda, como las telas que forman algunos simpáticos insectos. Para que esta teoría proporcionase el valor observado para la interacción fuerte entre partículas, las cuerdas tendrían que ser semejantes a las de un violín, pero con una tensión de alrededor de unas diez toneladas.

La primera expresión de las TC’s fue desarrollada por Jöel Scherk, de París, y John Schwuarz, del Instituto de Tecnología de California, quienes en el año 1974 publicaron un artículo en el que demostraban que la TC podía describir la fuerza gravitatoria, pero sólo si la tensión en la cuerda se tensiometrara alrededor de un trillón de toneladas métricas. Las predicciones de la teoría de cuerdas serían las mismas que las de la relatividad general a escala de longitudes normales, pero diferirían a distancias muy pequeñas, menores que una trillonésima de un cm. Claro está, que en esos años, no recibieron mucha atención por su trabajo.

Ahora se buscan indicios de la teoría de cuerdas en los grandes aceleradores de partículas donde parece que algunos indicios nos dicen que se va por el buen camino, sin embargo, nuestros aceleradores más potentes necesitarían multiplicar por un número muy elevado su potencia para poder, comprobar la existencia de las cuerda situadas a una distancia de 10-35 m, lugar al que nos será imposible llegar en muchas generaciones. Sin embargo, en las pruebas que podemos llevar a cabo en la actualidad, aparecen indicios de una partlicula de espín 2 que todos asocian con el esquivo Gravitón, y, tal indicio, nos lleva a pensar que, en la teoría de supercuerdad, está implícita una Teoría Cuántica de la Gravedad.

Los motivos que tuvo la comunidad científica, entonces, para no brindarle la suficiente atención al trabajo de Scherk y Schwuarz, es que, en esos años, se consideraba más viable para describir a la interacción fuerte a la teoría basada en los quarks y los gluones, que parecía ajustarse mucho mejor a las observaciones. Desafortunadamente, Scherk murió en circunstancias trágicas (padecía diabetes y sufrió un coma mientras se encontraba solo en su estudio). Así, Schwuarz se quedó solo, en la defensa de la teoría de cuerdas, pero ahora con un valor tensiométrico de las cuerdas mucho más elevado.

Pero con los quarks, gluones y también los leptones, en la consecución que se buscaba, los físicos entraron en un cuello de botella. Los quarks resultaron muy numerosos y los leptones mantuvieron su número e independencia existencial, con lo cual seguimos con un número sustancialmente alto de partículas elementales (60), lo que hace que la pregunta ¿son estos los objetos más básicos?

Si esos sesenta objetos fuesen los más básicos, entonces también aflora otra pregunta ¿por qué son como son y por qué son tantos? Los físicos quisieran poder decir «salen de esto», o «salen de esto y aquello», mencionar dos principios bien fundamentales y ojalá sea tan simples que puedan ser explicados a un niño. La respuesta «porque Dios lo quiso así» posiblemente a muchos les cause «lipotimia», ya que esa respuesta nos lleva a reconocer nuestra ignorancia y, además, la respuesta que esperamos no pertenece al ámbito de la religión. Por ahora, ¿cuál es la última respuesta que puede dar la ciencia?

El cuello de botella incentivó a que se encendiera una luz de esperanza. En 1984 el interés por las cuerdas resucitó de repente. Se desempolvaron las ideas de Kaluza y Klein, como las que estaban inconclusas de Scherk y Schwuarz. Hasta entonces, no se habían hecho progresos sustanciales para explicar los tipos de partículas elementales que observamos, ni tampoco se había logrado establecer que la supergravedad era finita.

El ser humano –en función de su naturaleza– cuando se imagina algo muy pequeño, piensa en un puntito de forma esférica. Los físicos también son seres de este planeta y, para ellos, las partículas elementales son como puntitos en el espacio, puntos matemáticos, sin extensión. Son sesenta misteriosos puntos y la teoría que los describe es una teoría de puntos matemáticos. La idea que sugieren las TC’s es remplazar esos puntos por objetos extensos, pero no como esferitas sino más bien como cuerdas. Mientras los puntos no tienen forma ni estructura, las cuerdas tienen longitud y forma, extremos libres como una coma “,” (cuerda abierta), o cerradas sobre sí misma como un circulito. Si el punto es como una esferita inerte de la punta de un elastiquito, la cuerda es el elástico estirado y con él se pueden hacer círculos y toda clase de figuras. Está lleno de posibilidades.

Muchas son las imágenes que se han elaborado para representar las cuerdas y, como nadie ha visto nunca ninguna, cualquiera de ellas vale para el objetivo de una simple explicación y, las cuerdas que se han imaginado han tomado las más pintorescas conformaciones para que, en cada caso, se adapten al modelo que se expone.

diferencia entre un punto y una coma. Según la teoría de cuerdas importa, y mucho. Por su extensión, a diferencia del punto, la cuerda puede vibrar. Y hacerlo de muchas maneras, cada modo de vibración representando una partícula diferente. Así, una misma cuerda puede dar origen al electrón, al fotón, al gravitón, al neutrino y a todas las demás partículas, según cómo vibre. Por ello, la hemos comparado con la cuerda de un violín, o de una guitarra, si se quiere.

Al dividir la cuerda en dos, tres, cuatro, cinco, o más partes iguales, se generan las notas de la escala musical que conocemos, o técnicamente, los armónicos de la cuerda. En general, el sonido de una cuerda de guitarra o de piano es una mezcla de armónicos. Según la mezcla, la calidad (timbre) del sonido. Si distinguimos el tono de estos instrumentos, es por la «receta» de la mezcla en cada caso, por las diferentes proporciones con que cada armónico entra en el sonido producido. Pero, también es posible hacer que una buena cuerda vibre en uno de esos armónicos en particular, para lo cual hay que tocarla con mucho cuidado. Los concertistas lo saben, y en algunas obras como los conciertos para violín y orquesta, usan este recurso de «armónicos». Así, la naturaleza, con su gran sabiduría y cuidado para hacer las cosas, produciría electrones, fotones, gravitones, haciendo vibrar su materia más elemental, esa única y versátil cuerda, en las diversas (infinitas) formas que la cuerda permite.

Una partícula ocupa un punto del espacio en todo momento. Así, su historia puede representarse mediante una línea en el espaciotiempo que se le conoce como «línea del mundo». Por su parte, una cuerda ocupa una línea en el espacio, en cada instante de tiempo. Por tanto, su historia en el espaciotiempo es una superficie bidimensional llamada la «hoja del mundo». Cualquier punto en una hoja del mundo puede ser descrito mediante dos números: uno especificando el tiempo y el otro la posición del punto sobre la cuerda. Por otra parte, la hoja del mundo es una cuerda abierta como una cinta; sus bordes representan los caminos a través del espaciotiempo (flecha roja) de los extremos o comas de la cuerda (figura 12.05.03.02). La hoja del mundo de una cuerda cerrada es un cilindro o tubo (figura 12.05.03.03); una rebanada transversal del tubo es un círculo, que representa la posición de la cuerda en un momento del tiempo.

No cabe duda que, de ser ciertas las TC’s, el cuello de botella queda bastante simplificado. Pasar de sesenta objetos elementales a una sola coma o circulito es un progreso notable. Entonces, ¿por qué seguir hablando de electrones, fotones, quarks, y las demás?

Que aparentemente las cosas se simplifican con las TC’s, no hay duda, pero desafortunadamente en física las cosas no siempre son como parecen. Para que una teoría sea adoptada como la mejor, debe pasar varias pruebas. No basta con que simplifique los esquemas y sea bella. La teoría de las cuerdas está –se puede decir– en pañales y ha venido mostrado distintas facetas permeables. Surgen problemas, y se la deja de lado; se solucionan los problemas y una avalancha de trabajos resucitan la esperanza. En sus menos de treinta años de vida, este vaivén ha ocurrido más de una vez.

Uno de los problemas que más afecta a la cuerda está ligado con su diminuto tamaño. Mientras más pequeño algo, más difícil de ver. Es una situación que se agudiza en la medida que se han ido corrigiendo sus permeabilidades. En sus versiones más recientes, que se llaman supercuerdas, son tan superpequeñas que las esperanzas de ubicarlas a través de un experimento son muy remotas. Sin experimentos no podemos comprobar sus predicciones ni saber si son correctas o no. Exagerando, es como una teoría que afirmara que los angelitos del cielo tienen alitas. ¿Quién la consideraría seriamente?

La propia base conceptual de la teoría comporta problemas. Uno de ellos, es el gran número de dimensiones que se usan para formularla. En algunos casos se habla de 26 o, en el mejor, de 10 dimensiones para una cuerdita: espacio (son 3), tiempo (1) y otras seis (o 22) más, que parecen estar enroscadas e invisibles para nosotros. Por qué aparecieron estas dimensiones adicionales a las cuatro que nos son familiares y por qué se atrofiaron en algún momento, no lo sabemos. También, la teoría tiene decenas de miles de alternativas aparentemente posibles que no sabemos si son reales, si corresponden a miles de posibles universos distintos, o si sólo hay una realmente posible. Algunas de estas versiones predicen la existencia de 496 fuerzones, partículas como el fotón, que transmiten la fuerza entre 16 diferentes tipos de carga como la carga eléctrica. Afirmaciones como éstas, no comprobables por la imposibilidad de hacer experimentos, plagan la teoría de cuerdas. Quienes alguna vez intentaron trabajar matemáticamente en las cuerdas, muchas veces deben haber pensado de que lo que estaban calculando más se asemejaba a juegos de ejercicios que la consecución de una base matemática teórica tras objetivo de dar un paso trascendental en el conocimiento de la naturaleza. Ahora, los que tienen puesta su fe en ella suelen afirmar que se trata de una teoría que se desfasó de la natural evolución de la física, que su hallazgo fue un accidente, y no existe aún el desarrollo matemático para formularla adecuadamente.

En las teorías de cuerdas, lo que anteriormente se consideraba partículas, se describe ahora como ondas viajando por las cuerdas, como las notas musicales que emiten las cuerdas vibrantes de un violín. La emisión o absorción de una partícula por otra corresponde a la división o reunión de cuerdas.

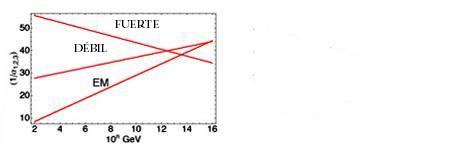

“Al principio se vio como un gran éxito, pero pronto esta “reunificación”, no tan exacta, empezó a dar fallos entre los físicos que trabajaban en las “grandes teorías unificadas”. Como puede verse en la gráfica que representa las intensidades de las fuerzas básicas respecto a la energía expresada en GeV (en la figura se representa en el eje horizontal los exponentes de las potencias de diez), las gráficas no llegan a coincidir en un punto como era de esperar aunque la “tendencia” si se apreciaba unificadora.”

La Teoría de cuerdas trata de incorparar la Gravedad a las otras tres fuerzas y completar asíel panorama actual de la Física de Partículas en el Modelo Estándar en el que sólo están incluídas estas tres interacciones de arriba, la Gravedad queda fuera por surgir infinitos no renormalizables que, desaparecen en la Teoría de supercuerdas de 26 dimensdiones de espacio tiempo para los Bosones y de 10 y 11 dimensiones de espacio tiempo para los Ferniones.

El trabajo que aquí hemos leido lo he obtenido de fuentes diversas y, como tantos otros, nos dice más o menos lo que todos. La realidad de la Teoría de supercuerdas está en que no podemos llegar a ese límite necesario de los 10-35 m, donde supuestamente, está instalada la cuerda, y, como llegar a esa distancia nos exige una energía de 1019 GeV con la que no podemos ni soñar. Seguirán, por mucho tiempo, las especulaciones y cada cual, tendrá su idea, su propia teoría, toda vez que, ninguna de ellas podrá ser verificadas y mientras eso sea así (que lo es), todas las teorías tendrán la posibilidad de ser refrendadas…algún día.

- ¿Dónde estarán las respuestas?

Sin embargo, una cosa es cierta, es la única teoría, la de supercuerdas, que nos da cierta garantía de que vamos por el buen camino, en su desarrollo aparecen indicios confirmados por los experimentos, como por ejemplo, la aparici´çon de una partícula de espín 2, el Gravitón que nos lleva a pensar que, en la teoría de supercuerdas está integrada una teoría Cuántica de la Gravedad que nos, podrá llevar, hasta esos primeros momentos del Big Bang que ahora quedan tan oscuros a la vista de los observadores y, de la misma manera, nos dejará entrar en la Singularidad de un Agujero Negro para poder ver (al fin) lo que allí pueda haber, qué clase de partículas o de materia se ha podido formar en un material tan extremadamente denso como el de la singularidad.

Habrá que tener paciencia con la Teoría de cuerdas y con el hallazgo tan esperado del Gravitón que nos confirmará, al fín, que la Gravedad como las demás interacciones, también está cuantizada y tiene su Bosón transmisor. De lo que no acabo de estar seguro es…del hecho en sí, de que podamos univer la Gravedad con la cuántica…¡son tan dispares! y habitan en reinos tan diferentes.

emilio silvera

Nov

9

El Universo, la Vida consciente y, …, ¿el Destino?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y la Química de la Vida ~

Clasificado en El Universo y la Química de la Vida ~

Comments (0)

Comments (0)

A medida que se expandía a partir de su estado primordial uniforme, el universo se enfriaba. Y con las temperaturas más bajas vinieron nuevas posibilidades. La materia fue capaz de agregarse en enormes estructuras amorfas: las semillas de las galaxias actuales. Empezaron a formarse los átomos allanando el camino para la química y la formación de objetos físicos sólidos.

primordial uniforme, el universo se enfriaba. Y con las temperaturas más bajas vinieron nuevas posibilidades. La materia fue capaz de agregarse en enormes estructuras amorfas: las semillas de las galaxias actuales. Empezaron a formarse los átomos allanando el camino para la química y la formación de objetos físicos sólidos.

Comparado con los patrones actuales, el universo en dicha época era sorprendentemente homogeneo. El material cósmico estaba presente por todo el espacio con una uniformidad casi perfecta. La Temperatura era la misma en todas partes. La materia, descompuestas en sus constityentes básicos por el tremendo calor, estaba en un estado de extraordinaria simplicidad. Ningún hipotético observador hubiera podido conjeturar a partir de este estado poco prometedor que el universo estaba dotado de enormes potencialidades. Ninguna clave podía desvelar que, algunos miles de millones de años más tarde, billones de estrellas refulgentes se organizarían en miles de millones de galaxias espirales; que aparecerían planetas y cristales, nubes y océanos, montañas y glaciares; que uno de esos planetas (al menos que sepamos) sería habitado por árboles y bacterias, por elefantes y peces. Ninguna de estas cosas podía predecirse.

La Tierra se formó hace aproximadamente 4550 millones de años y la vida surgió unos mil millones de años después. Es el hogar de millones de especies, incluyendo los seres humanos y actualmente el único cuerpo astronómico donde se conoce la existencia de vida.18 La atmósfera y otras condiciones abióticas han sido alteradas significativamente por la biosfera del planeta, favoreciendo la proliferación de organismos aerobios, así como la formación de una capa de ozono que junto con el campo magnético terrestre bloquean la radiación solar dañina, permitiendo así la vida en la Tierra.

a historia de la vida en la Tierra pretende narrar los procesos por los cuales los organismos vivos han evolucionado, desde el origen de la vida en la Tierra, hace entre 3800 millones de años y 3500 millones de años, hasta la gran diversidad y comp`lejidad biológica presente en las diferentes formas de los organismos, su fisiología y comportamiento que conocemos en la actualidad; así como la naturaleza que, en forma de catástrofes globales, cambios climáticos o uniones y separaciones de continentes y océanos, han condicionado su desarrollo. Las similitudes entre todos los organismos actuales indican la existencia de un ancestro común universal del cual todas las especies conocidas se han diferenciado a través de los procesos de la evolución

Muchos fenómenos maravillosos han emergido en el universo desde aquella época primera: agujeros negros monstruosos tan masivos como

aquella época primera: agujeros negros monstruosos tan masivos como miles de millones de soles, que engullen estrellas y escupen chorros de gas; estrellas de neutrones y púlsares que giran miles de veces por segundo y cuyo material está comprimido hasta

miles de millones de soles, que engullen estrellas y escupen chorros de gas; estrellas de neutrones y púlsares que giran miles de veces por segundo y cuyo material está comprimido hasta una densidad de mil millones de toneladas por centímetro cúbico; partículas subatómicas tan esquivas que podrían atravesar una capa de plomo sólido de años-luz de espesor y que, sin embargo, no dejan ninguna traza discernible; ondas gravitatorias fantasmales producidas por la colisión de dos agujeros negros que finalizan su danza de gravedad fusionando sus terribles fuerzas de densidades “infinitas”. Pese a todo, y por sorprendentes que estas cosas nos puedan parecer, el fenómeno de la vida es más notable que todas ellas en conjunto.

una densidad de mil millones de toneladas por centímetro cúbico; partículas subatómicas tan esquivas que podrían atravesar una capa de plomo sólido de años-luz de espesor y que, sin embargo, no dejan ninguna traza discernible; ondas gravitatorias fantasmales producidas por la colisión de dos agujeros negros que finalizan su danza de gravedad fusionando sus terribles fuerzas de densidades “infinitas”. Pese a todo, y por sorprendentes que estas cosas nos puedan parecer, el fenómeno de la vida es más notable que todas ellas en conjunto.

¿De dónde surgieron con su gracia y colorido, su agilidad de movimiento y su sentido de orientación?

En realidad, la Vida, no produjo ninguna alteración súbita o espectacular en la esfera cósmica. De hecho, y a juzgar por la vida en la Tierra, los cambios que han provocado han sido extraordinariamente graduales. De todas formas, una vez que la vida se inició, el universo nunca sería el mismo. De manera lenta pero segura, ha transformado el planeta Tierra. Y al ofrecer un camino a la consciencia, la inteligencia y la tecnología, ella tiene la capacidad de cambiar el universo.

segura, ha transformado el planeta Tierra. Y al ofrecer un camino a la consciencia, la inteligencia y la tecnología, ella tiene la capacidad de cambiar el universo.

Si mramos esa Nebulosa que abre este trabajo , podemos pensar en qué materiales están ahí presentes sometidos a fuerzas de marea de estrellas jóvenes y de inusitadas energías de radiación ultravioleta que, junto con la fuerza de gravedad, conformar el lugar y hacen que se distorsionen los materiales en los que inciden parámetros que los hacen cambiar de fase y transmutarse en otros distintos de los que, en principio eran. Ahí, en esa nubes inmensas productos de explosiones supernovas, están los materiales de los que se forman nuevas estrellas y mundos que, si se sitúan en el lugar adecuado…pueden traer consigo la vida.

, podemos pensar en qué materiales están ahí presentes sometidos a fuerzas de marea de estrellas jóvenes y de inusitadas energías de radiación ultravioleta que, junto con la fuerza de gravedad, conformar el lugar y hacen que se distorsionen los materiales en los que inciden parámetros que los hacen cambiar de fase y transmutarse en otros distintos de los que, en principio eran. Ahí, en esa nubes inmensas productos de explosiones supernovas, están los materiales de los que se forman nuevas estrellas y mundos que, si se sitúan en el lugar adecuado…pueden traer consigo la vida.

¡Han sido y son tantas formas de vida las que han pasado y están en la Tierra! Dicen los expertos que sólo el uno por ciento de las especies que han existido viven actualmente en nuestro planeta y, teniendo en cuenta que son millones, ¿cuántas especies han pasado por aquí?

que son millones, ¿cuántas especies han pasado por aquí?

Claro que no podemos hacer caso de todo lo que los científicos puedan decir alguna que otra vez que, en realidad, va encaminado a producir el asombro de la gente corriente, alimentar el consumo público y, sobre todo, conseguir subvenciones para nuevos proyectos. Es curioso que, la ignorancia, proporcione mejor situación para seguir investigando que la certeza, toda vez que, con la incertidumbre del qué será, se despierta la curiosidad y nos proporciona una motiviación, en cambio, la certeza nos relaja.

nuevos proyectos. Es curioso que, la ignorancia, proporcione mejor situación para seguir investigando que la certeza, toda vez que, con la incertidumbre del qué será, se despierta la curiosidad y nos proporciona una motiviación, en cambio, la certeza nos relaja.

Está claro que debemos apoyar con fuerza el programa de Astrobiología de la NASA y de las otras naciones. Si queremos que, finalmente, se lleve a cabo un Proyecto de cierta entidad, tendremos que aunar las fuerzas y, las distintas Agencvias Espaciales del Mundo Occidental tendrán que poner sobre la mesa lo que tienen para que, de una vez por todas podamos, por ejemplo, hacer realidad una colonia terrestre en el Planeta Marte.

realidad una colonia terrestre en el Planeta Marte.

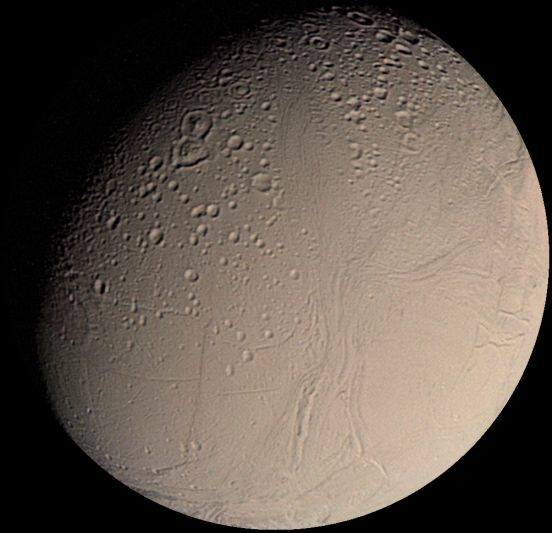

Todos sabemos que resolver el problema de biogenesis está en la mente de muchos. Los astrónomos consioderan que planetas como Júpiter y Saturno y, también sus lunas, son inmensos laboratorios prebióticos, en donde los pasos que trajeron la vida a la Tierra podrían estar ahora misma allí presentes y, de ahí, la enorme importancia que tendría poder investigarlos en la forma adecuada.

misma allí presentes y, de ahí, la enorme importancia que tendría poder investigarlos en la forma adecuada.

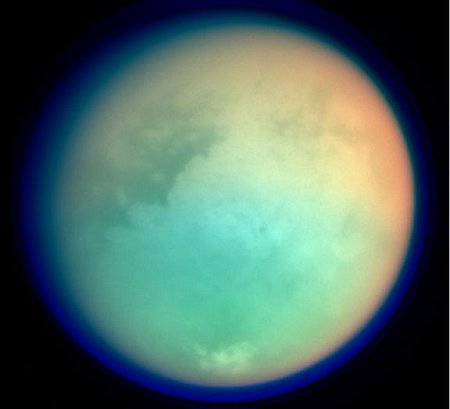

¿Qué sorpresas nos aguarda en Titán con su atmósfera y acéanos de metano?

Resolver el misterio de la biogénesis no es sólo un problema más de una larga lista de proyectos científicos indispensables. Como el origen del Universo y el origen de la Consciencia, representa algo en conjunto mucho más profundo, puesto que pone a prueba las bases mismas de nuestra ciencia y de nuestra visión del mundo. Un descubrimiento que promete cambiar los principios mismos en los que se basa nuestra comprensión del mundo físico merece que se le de una prioridad urgente.

el origen del Universo y el origen de la Consciencia, representa algo en conjunto mucho más profundo, puesto que pone a prueba las bases mismas de nuestra ciencia y de nuestra visión del mundo. Un descubrimiento que promete cambiar los principios mismos en los que se basa nuestra comprensión del mundo físico merece que se le de una prioridad urgente.

El mistrio del origen de la vida ha intrifado a filósofos, teólogos y científicos durante dos mil quinientos años. Durante los próximos siglos tendremos la oportunidad de ahondar más en ese misterio grandioso que es la Vida, una oportunidad dorada que no debemos, de ninguna manera desechar, ahí tendremos la oportunidad, con los nuevos medios tecnológicos y de todo tipo que vendran, los avances en el saber del mundo, la nueva manera de mirtar las cosas, la nueva física…Todo ello, nos dará la llave para abrir esa puerta durante tanto tiempo cerrada. Ahora parece un poco entrwabierta pero, no podemos conseguir que se abra de par en par para poder mirar dentro del misterio central.

parece un poco entrwabierta pero, no podemos conseguir que se abra de par en par para poder mirar dentro del misterio central.

Árbol filogenético mostrando la divergencia de las especies modernas de su ancestro común en el centro. Los tres dominios están coloreados de la siguiente forma; las Bacterias en azul, las Archeas en verde, y las Eucariotas en color rojo. Puede parecer mentira que a partir de estos minúsculos seres puediera comenzar la fascinante aventura de la Vida en la Tierra.

Aquellos primeros tiempos fueron duros y de una larga transición para nuestro planeta, las visitas de meteoritos, el inmenso calor de sus entrañas, la química de los materiales fabricados en las estrellas que allí estaban presentes…Todo ello, contribuyó, junto a otros muchos y complejos sucesos, fuerzas e interacciones, a que, hacde ahora unos cuatro mil millones de años, surgiera aquella primera célula replicante que, con el tiempo, nos trajo a nosotros aquí.

nuestro planeta, las visitas de meteoritos, el inmenso calor de sus entrañas, la química de los materiales fabricados en las estrellas que allí estaban presentes…Todo ello, contribuyó, junto a otros muchos y complejos sucesos, fuerzas e interacciones, a que, hacde ahora unos cuatro mil millones de años, surgiera aquella primera célula replicante que, con el tiempo, nos trajo a nosotros aquí.

Los protobiontes fueron los precursores evolutivos de las primeras células procariotas. Los protobiontes se originaron por la convergencia y conjugación de microesferas de proteínas, carbohidratos, lípidos y otras substancias orgánicas encerradas por membranas lipídicas. El agua fue el factor más significativo para la configuración del endo plama de los protobiontes.

Como físico teórico hecho así mismo, algo ingenuo y con un enorme grado de fantasía en mis pensamientos, cuando pienso acerca de la vida a nivel molecular, la pregunta que se me viene a la mente es: ¿Cómo saben lo que tienen que hacer todos estos átomos estúpidos? La complejidad de la célula viva es inmensa, similar a la de una ciudad en cuanto al grado de su elaborada actividad. Cada molécula tiene una función específica y un lugar asignado en el esquema global, y así se manufacturan los objetos correctos. Hay mucho ir y venir en marcha. Las moléculas tienen que viajar a través de la célula para encontrarse con otras en el lugar correcto para llevar a cabo sus tareas de forma adecuada.

adecuada.

Todo esto sucede sin un jefe que dé órdenes a las moléculas y las dirija a sus posiciones adecuadas. Ningún supervisor controla sus actividades. Las moléculas hacen simplemente lo que las moléculas tienen que hacer : moverse ciegamente, chocar con las demás, rebotar, unirse. En el nivel de los átomos individuales, la vida es una anarquía: un caos confuso y sin propósito. Pero, de algún modo, colectivamente, estos átomos inconscientes se unen y ejecutan, a la perfección, el cometido que la Naturaleza les tiene encomendados en la danza de la vida y con una exquisita precisión.

: moverse ciegamente, chocar con las demás, rebotar, unirse. En el nivel de los átomos individuales, la vida es una anarquía: un caos confuso y sin propósito. Pero, de algún modo, colectivamente, estos átomos inconscientes se unen y ejecutan, a la perfección, el cometido que la Naturaleza les tiene encomendados en la danza de la vida y con una exquisita precisión.

Ya más recientemente, evolucionistas tales como el inglés Richard Dawkins, han destacado el paradigma del “gen egoista”, una imagen poderosa que pretende ilustrar la idea de que los genes son el objetivo último de la selección natural. Los teóricos como Stuart Kauffman, asociado desde hace tiempo al famoso Instituto de Santa Fe, donde los ordenadores crean la llamada vida artificial, insisten en la “autoorganización” como una propiedad fundamental de la vida.

hace tiempo al famoso Instituto de Santa Fe, donde los ordenadores crean la llamada vida artificial, insisten en la “autoorganización” como una propiedad fundamental de la vida.

¿Puede la ciencia llegar a explicar un proceso tan magníficamente autoorquestado? Muchos son los científicos que lo niegan al estimar que, la Naturaleza, nunca podrá ser suplantada ni tampoco descubierta en todos sus secretos que, celosamente nos esconde. Sin embargo…Tengo mis dudas. Ellos piensan que la célula viva es demasiado elaborada, demasiado complicada, para ser el producto de fuerzas ciegas solamente y, que debajo de esa aleatoriedad y de un falso azar, deben estar escondidas otras razones que no llegamos a alcanzar. La Ciencia podrá llegar a dar una buena explicación de esta o aquella característica individual, siguen diciendo ellos, pero nunca explicará la organización global, o cómo fue ensamblada la célula original por primera vez.

ser el producto de fuerzas ciegas solamente y, que debajo de esa aleatoriedad y de un falso azar, deben estar escondidas otras razones que no llegamos a alcanzar. La Ciencia podrá llegar a dar una buena explicación de esta o aquella característica individual, siguen diciendo ellos, pero nunca explicará la organización global, o cómo fue ensamblada la célula original por primera vez.

= Sección captor de agua de moléculas lípidas

= Colas repelentes de agua

Las «alfombras» microbianas son múltiples capas, multi-especies de colonias de bacterias y otros organismos que generalmente sólo tienen unos pocos milímetros de grosor, pero todavía contienen una amplia gama de entornos químicos, cada uno de ellos a favor de un conjunto diferente de microorganismos. Hasta cierto punto, cada alfombra forma su propia cadena alimenticia, pues los subproductos de cada grupo de microorganismos generalmente sirven de “alimento” para los grupos adyacentes.

Los estromatolitos (arriba) son pilares rechonchos construidos como alfombras microbianas que migran lentamente hacia arriba para evitar ser sofocados por los sedimentos depositados en ellos por el agua. Ha habido un intenso debate acerca de la validez de fósiles que supuestamente tienen más de 3000 millones de años, con los críticos argumentando que los llamados estromatolitos podrían haberse formado por procesos no biológicos.En 2006, otro descubrimiento de estromatolitos fue reportado en el mismo lugar de Australia, como los anteriores, en las rocas de hace 3500 millones de años.

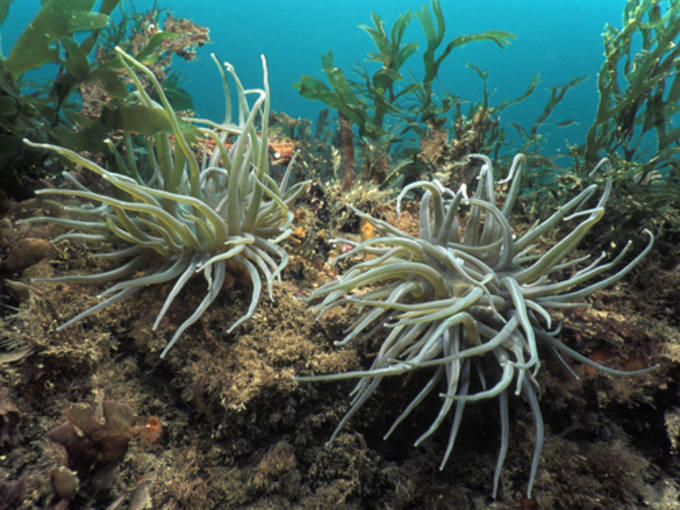

En las modernas alfombras bajo el agua, la capa superior consiste a menudo de cianobacterias fotosintéticas que crean un ambiente rico en oxígeno, mientras que la capa inferior es libre de oxígeno y, a menudo dominado por el sulfuro de hidrógeno emitido por los organismos que viven allí. Se estima que la aparición de la fotosíntesis oxigénica por las bacterias en las alfombras, aumentó la productividad biológica por un factor de entre 100 y 1.000. El agente reductor utilizada por la fotosíntesis oxigénica es el agua, pues es mucho más abundante que los agentes geológicos producidos por la reducción requerida de la anterior fotosíntesis no oxigénica. A partir de este punto en adelante, la «vida» misma produce mucho más los recursos que necesita que los procesos geoquímicos.67 El oxígeno, en ciertos organismos, puede ser tóxico, pues éstos no están adaptados a él, así mismo, en otros organismos que sí lo están, aumenta considerablemente su eficiencia metabólica. El oxígeno se convirtió en un componente importante de la atmósfera de la Tierra alrededor de hace 2400 millones de años

Al igual que muchas esponjas, hay cianobacterias fotosintéticas que viven dentro de sus células.

¿Cuál es el secreto de esta sorprendente organización? ¿Cómo puede ser obra de átomos estúpidos? Tomados de uno en uno, los átomos solo pueden dar empujones a sus vecinos y unirse a ellos si las circunstancias son apropiadas. Pero colectivamente consiguen ingeniosas maravillas de construcción y control, con un ajuste fino y una complejidad todavía no igualada por ninguna ingeniería humana. De algún modo la Naturaleza descubrió cómo construir intrincadas máquinas que llamamos célula viva, utilizando sólo todas las materias primas disponibles, todas en un revoltijo. Repite esta hazaña cada día en nuestros propios cuerpos, cada vez que se forma una nueva célula. Esto ya es un logro fantástico. Más notable incluso es que la Naturaleza construyó la primera célula a partir de cero. ¿Cómo lo hizo?

una nueva célula. Esto ya es un logro fantástico. Más notable incluso es que la Naturaleza construyó la primera célula a partir de cero. ¿Cómo lo hizo?

Una célula es la unidad morfológica y funcional de todo ser vivo. De hecho, la célula es el elemento de menor tamaño que puede considerarse vivo. De este modo, puede clasificarse a los organismos vivos según el número de células que posean: si sólo tienen una, se les denomina unicelulares (como pueden ser los protozoos o las bacterias, organismos microscópicos); si poseen más, se les llama pluricelulares En estos últimos el número de células es variable: de unos pocos cientos, como en algunos nematodos, a cientos de billones (1014), como

de células que posean: si sólo tienen una, se les denomina unicelulares (como pueden ser los protozoos o las bacterias, organismos microscópicos); si poseen más, se les llama pluricelulares En estos últimos el número de células es variable: de unos pocos cientos, como en algunos nematodos, a cientos de billones (1014), como en el caso del ser humano.. Las células suelen poseer un tamaño de 10 μm y una masa de 1 ng, si bien existen células mucho mayores.

en el caso del ser humano.. Las células suelen poseer un tamaño de 10 μm y una masa de 1 ng, si bien existen células mucho mayores.

Algunas veces he pensado que el secreto de la vida puede proceder de sus propiedades de información; un organismo es un completo sistema de procesos de información. La complejidad y la información pueden ser iluminadas por la disciplina de la termodinámica. La vida es tan siroprendente que, de algún modo, debe haber piodido sortear las leyes de la termodinámica. En particular, la segunda ley que puede considerar como la más fundamental de todas las leyes de la naturaleza, describe una tendencia hacia la desintegración y la degeneración que la vida, ¡claramente evita!

proceder de sus propiedades de información; un organismo es un completo sistema de procesos de información. La complejidad y la información pueden ser iluminadas por la disciplina de la termodinámica. La vida es tan siroprendente que, de algún modo, debe haber piodido sortear las leyes de la termodinámica. En particular, la segunda ley que puede considerar como la más fundamental de todas las leyes de la naturaleza, describe una tendencia hacia la desintegración y la degeneración que la vida, ¡claramente evita!

¿Cómo es posible tal cosa?

Si alguno de ustedes sabe contestar esa pregunta…que nos lo exponga, así sabremos un poco más.

emilio silvera

Totales: 83.305.187

Totales: 83.305.187 Conectados: 48

Conectados: 48