Oct

20

¡Fisica! Siempre la Física

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

¡El Universo! ¿Sería eso lo que pasó?

Como nunca dejaremos a aprender cosas nuevas, de desvelar secretos de la Naturaleza, de seguir investigando en busca de “otras verdades”, de elaborar nuevos modelos y nuevas Teorías que nos acerquen, cada vez más a la realidad del mundo (ese es, de momento, nuestro cometido), estamos abocados a tratar de saber lo que no sabemos y que, no pocas veces, creemos que sabemos. Ya lo dijo Popper:

“Cuanto más profundizo en el saber de las cosas, más consciente soy de lo poco que sé. Mis conocimientos son finitos , mi ignorancia, es infinita“.

Lo que nos lleva a la versión antigua del dicho: “Sólo se que no se nada” de Sócrates.

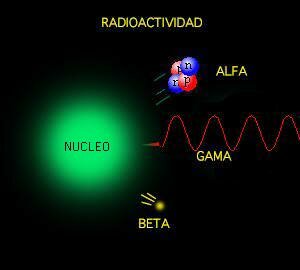

Las sustancias formadas por una sola clase de átomos se llaman elementos químicos. La palabra “átomo” procede del griego ατομος, que significa “indivisible” y el uso de la palabra “elemento” sugiere que se ha llegado a los ladrillos básicos con los que está formada la materia. De hecho, esta es la imagen que se tenía a mediados del siglo XIX cuando se acuñaron estos términos. Sin embargo, hoy sabemos que todo esto es falso, que los átomos se pueden dividir y que, de esta manera, los elementos han dejado de ser verdaderamente elementales. Los físicos continúan con esta nomenclatura aunque sea formalmente incorrecta, ya que, la costumbre, como dicen los juristas, no pocas veces rigen la jerga de las leyes.

“La revolución de la mecánica cuántica empieza a materializarse, y el qubit es el principal protagonista. Siendo la unidad mínima de información de extraño mundo, permitirá procesar toda la información existente en segundos.” El futuro que nos aguarda es inimaginable y cada día que pasa aparecen nuevos logros tecnológicos que nos sitúan en otro mundo, otra sociedad, otras nuevas formas de vivir y de comprender.

Sí, son los electrones los que dan al átomo su forma esférica

A todo esto y hablando de los átomos, por fuerza, nos tenemos que acordar del electrón que da al átomo su esférica. Son partículas cargadas eléctricamente que se mueven alegremente alrededor del núcleo. El electrón es muy ligero: su masa es solamente 1/1.836 de la del núcleo más ligero (el hidrógeno). La carga eléctrica del electrón es de signo opuesto a la del núcleo, de manera que los electrones están fuertemente atraídos el núcleo y se repelen mutuamente. Si la carga eléctrica total de los electrones en un átomo iguala a la del núcleo, lo que generalmente se necesitan varios electrones, se dice que el átomo está en equilibrio o que es eléctricamente neutro.

Un experimento realizado por científicos del Centro de Viena para la Ciencia y Tecnología Cuánticas ha demostrado que, en el mundo cuántico, la transición hacia el equilibrio térmico es más interesante y más complicada de lo que se pensaba.

Según destaca el , publicado en ‘Science’, entre un ordenado inicial y un estado final estadísticamente mixto, puede emerger un “cuasi-estacionario estado intermedio”. Este estado intermedio ya exhibe algunas propiedades como el equilibrio, pero parte de las características del estado inicial permanecen visibles durante un período de tiempo muy largo.

El fenómeno se denomina “pre-termalización” y desempeña un papel importante en diversos procesos de no equilibrio en la física cuántica. Podría, por ejemplo, ayudarnos a comprender el estado del universo temprano.

La fuerza a la que obedecen los electrones, la denominada fuerza electrostática o de Coulomb, es matemáticamente bastante sencilla y, sin embargo, los electrones son los responsables de las importantes propiedades de los “enlaces químicos”. Esto se debe a que las leyes de movimiento de los electrones están regidas completamente por la “mecánica cuántica”, teoría que se completó a principios del siglo XX. Es una teoría paradójica y difícil de entender y explicar, pero al mismo tiempo es muy interesante, fantástica y revolucionaria. uno se introduce en las maravillas de la mecánica cuántica es como si hiciera un viaje a un universo que está situado fuera de este mundo nuestro, ya que, las cosas que allí se ven, desdicen todo lo que dicta nuestro sentido común de cómo tiene que ser el mundo que nos rodea.

Sincronización perfecta, ¡es una sinfonía!

No solamente los electrones, sino también los núcleos atómicos y los átomos en su conjunto obedecen y se rigen por la mecánica cuántica. La Física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck, escribió un artículo de ocho páginas y allí propuso una posible solución a un problema que había intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menos intensidad, por los objetos más fríos.

Estaban bien aceptados entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía. Pero si usamos las leyes de la termodinámica para calcular la intensidad de la radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano, y, luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico a una cierta longitud de onda característica, y que la intensidad disminuye tanto para las longitudes mayores como para las longitudes menores. Esta longitud característica es inversamente proporcional a la temperatura absoluta del objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273 ºC bajo cero). Cuando a 1.000 ºC un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de luz visible.

El espectro electromagnético se extiende la radiación de menor longitud de onda, como los rayos gamma y los rayos X, pasando por la luz ultravioleta, la luz visible y los rayos infrarrojos, hasta las ondas electromagnéticas de mayor longitud de onda, como son las ondas de radio. Se cree que el límite la longitud de onda más pequeña posible es la longitud de Planck mientras que el límite máximo sería el tamaño del Universo.

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de la onda y, por lo tanto, proporcional a la frecuencia de la radiación emitida. La sencilla fórmula es:

donde h es la constante de Planck (cuyo valor es 6,626 × 10−34 J·s). Sólo los fotones con una frecuencia alta (por encima de un valor umbral específico) podían provocar la corriente de electrones. Por ejemplo, la luz azul emitía unos fotones con una energía suficiente para arrancar los electrones del metal, mientras que la luz roja no. Una luz más intensa por encima del umbral mínimo puede arrancar más electrones, pero ninguna cantidad de luz por debajo del mismo podrá arrancar uno solo, por muy intenso que sea su brillo.

El esquema del Efecto fotoeléctrico nos muestra como la luz arranca electrones de la placa.

Poco tiempo después, en 1905, Einstein formuló esta teoría de una forma mucho más tajante: el sugirió que los objetos calientes no son los únicos que emiten radiación en de energía, sino que toda la radiación consiste en múltiplos de los paquetes de energía de Planck. El príncipe francés Louis-Victor de Broglie, dándole otra vuelta a la teoría, propuso que no sólo cualquier cosa que oscila tiene una energía, sino que cualquier cosa con energía se debe comportar como una “onda” que se extiende en una cierta región del espacio, y que la frecuencia, v, de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse como una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilatorias de campos de fuerza.

El curioso comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de De Broglie. Poco después, en 1926, Erwin Schrödinger descubrió escribir la teoría ondulatoria de Debroglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños estaban exactamente determinados por la recién descubiertas “ecuaciones de onda cuánticas”.

Pocas dudas nos pueden caber a estas alturas de que la mecánica cuántica (de Planck) y, la Relatividad –tanto especial general- (de Einstein), además de ser las dos teorías más importantes de la Física de nuestro tiempo, funcionan de tal forma que uno, cuando profundiza en sus predicciones y las compara con lo que ocurre en el Universo, no por menos que, asombrarse, al comprobar como unas mentes humanas han sido capaces de llegar a estos profundos pensamientos que nos acerca a la realidad de la Naturaleza, al mismo tiempo que nos aleja de nuestra propia realidad.

Sí, están ahí pero, en realidad, no sabemos, a ciencia cierta, ni cómo se formaron las galaxias

¿Qué encontraremos cuando sea posible verificar la Teoría de cuerdas? ¿Qué hay más allá de los Quarks? ¿Sabremos alguna vez lo que es una singularidad? ¿Será verdad la existencia de esa materia oscura de la que tanto se habla? ¿Podremos al fín, encontrar esa fuente de energía que tanto necesita la Humanidad para dar ese segundo paso el futuro? ¿Tendremos, acaso, algún destino que no sea el de la irremisible extinción?

¡Preguntas! Preguntas y más preguntas que no podemos contestar. Es desesperante estar inmersos en inmenso océano de ignorancia. ¿Cuándo sabremos? El el epitafio que Hilbert ordenó esculpir en su Tumba, nos lo prometía: “Tenemos que saber, sabremos”. Si, ¿pero cuándo?

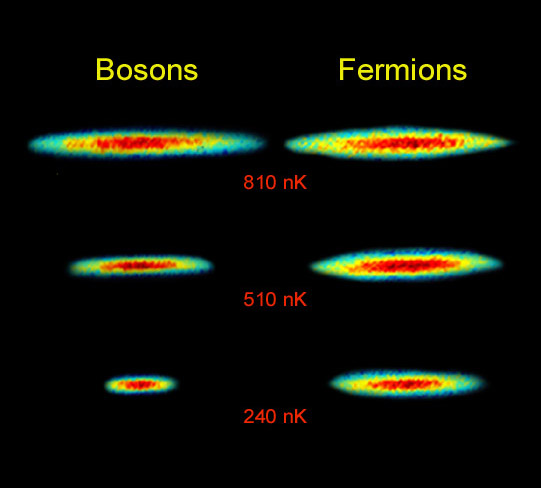

Lo cierto es que, las reglas de la mecánica cuántica tienen que ser aplicadas si queremos describir estadísticamente un sistema de partículas que obedece a reglas de ésta teoría en vez de las de la mecánica clásica. En estadística cuantica, los estados de energía se considera que están cuantizados. La estadística de Bose-Einstein se aplica si cualquier de partículas puede ocupar un estado cuántico dado. Dichas partículas (como dije antes) son los bosones que, tienden a juntarse.

Los bosones tienen un angular n h / 2p, donde n es cero o un entero y h es la constante de Planck. bosones idénticos, la función de ondas es siempre simétrica. Si solo una partícula puede ocupar un cuántico, tenemos que aplicar la estadística Fermi-Dirac y las partículas (como también antes dije) son los fermiones que tienen momento angular (n+½) h/2p y cualquier función de ondas de fermiones idénticos es siempre antisimétrica.

La mejor teoría explicar el mundo subatómico nació en 1928 cuando el teórico Paul Dirac combinó la mecánica cuántica con la relatividad especial para explicar el comportamiento del electrón. El resultado fue la mecánica cuántica relativista, que se transformó en un ingrediente primario en la teoría cuántica de campos. Con unas pocas suposiciones y ajustes, la teoría cuántica de campos ha probado ser suficientemente poderosa para formar la base del modelo estándar de las partículas y las fuerzas que rigen el universo.

La relación el espín y la estadística de las partículas está demostrada por el teorema espín-estadística. En un espacio de dos dimensiones es posible que existan partículas (o cuasipartículas) con estadística intermedia entre bosones y fermiones. Estas partículas se conocen con el de aiones; para aniones idénticos la función de ondas no es simétrica (un cambio de fase de+1) o antisimétrica (un cambio de fase de -1), sino que interpola continuamente entre +1 y -1. Los aniones pueden ser importantes en el análisis del efecto Hall cuántico fraccional y han sido sugeridos como un mecanismo para la superconductividad de alta temperatura.

Debido al principio de exclusión de Pauli no es imposible que dos fermiones ocupen el mismo espacio cuántico (al contrario de lo que ocurre con los bosones). Y, precisamente por eso, se degeneran electrones y neutrones dando lugar a la formación de estrellas enanas blancas y de neutrones que, encuentran la estabilidad frenando la fuerza de gravedad.

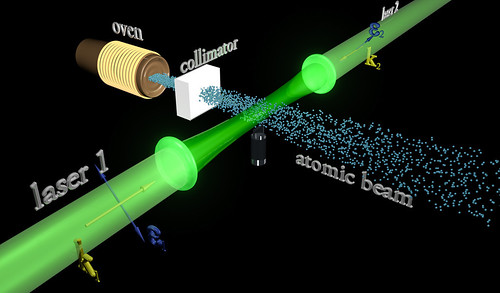

La condensación de Bose-Einstein es de importancia fundamental explicar el fenómeno de la superfluidez. A temperaturas muy bajas (del orden de 2×10-7k) se formar un condensado de Bose-Einstein, en el que varios miles de átomos forman una única entidad (un superátomo). efecto ha sido observado con átomos de rubidio y litio. Este efecto (condensación Bose-Einstein), ya habréis podido suponer, es llamado así en honor al físico Satyendra Naht Bose (1.894-1.974) y de Albert Einstein.

Más reciente es la obtención del Condensado de Bose-Einstein (BEC); en este caso las bases teóricas se postularon en la década de los 20 en manos de Satyendra Nath Bose y Albert Einstein. El primero describe ciertas reglas para determinar si dos fotones deberían considerarse idénticos o diferentes (Estadísticas de Bose) y Einstein aplica dichas reglas a los átomos intentando averiguar como se comportarían. Así, halla los efectos de que a muy bajas temperaturas los átomos están al mismo nivel cuántico produciendo fenómenos como la superfluidez o la superconductividad.

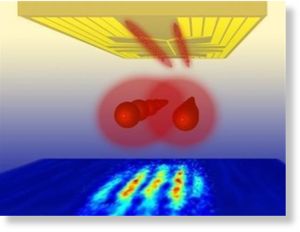

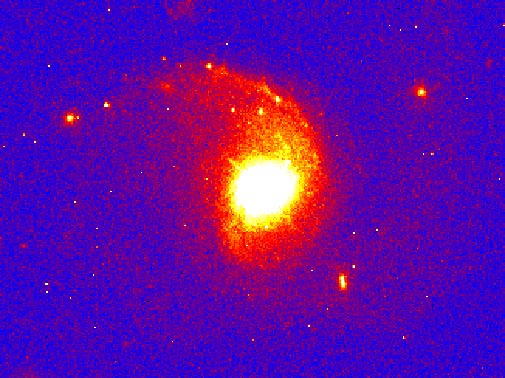

Distribución de momentos que confirma la existencia de un estado de agregación de la materia, el condensado de Bose-Einstein. obtenidos en un gas de átomos de rubidio, la coloración indica la cantidad de átomos a cada velocidad, con el rojo indicando la menor y el blanco indicando la mayor. Las áreas blancas y celestes indican las menores velocidades. A la izquierda se observa el diagrama inmediato anterior al condensado de Bose-Einstein y al centro el inmediato posterior. A la derecha se observa el diagrama luego de cierta evaporación, con la sustancia cercana a un condensado de Bose-Einstein puro. El pico no es infinitamente angosto debido al Principio de indeterminación de Heisenberg: dado que los átomos están confinados en una región del espacio, su distribución de velocidades posee necesariamente un cierto ancho mínimo. La distribución de la izquierda es para T > Tc (sobre 400 nanokelvins (nK)), la central para T < Tc (sobre 200 nK) y la de la derecha para T << Tc (sobre 50 nK).

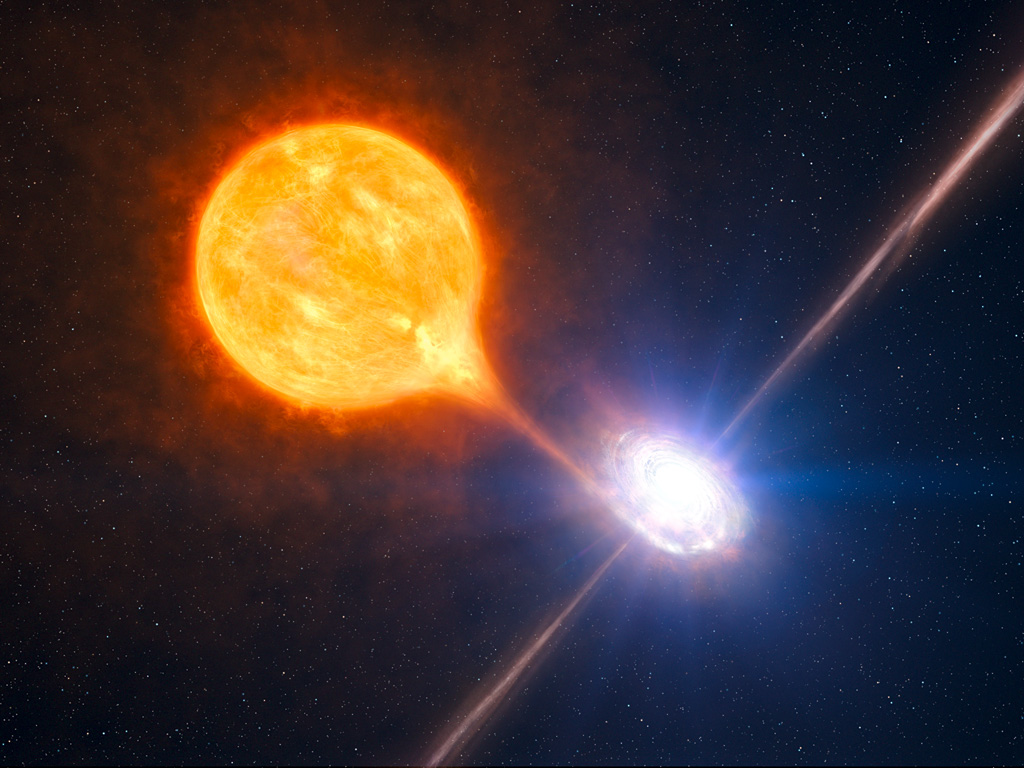

… del sistema binario descubierto a 7,000 años luz de la Tierra, que está formado por una estrella de neutrones (el círculo más grande) y enana blanca (el …

Las estrellas enanas blancas, de neutrones y los púlsares existen, precisamente, por el principio de exclusión de Pauli que, degenera electrones y neutrones cuando las estrellas masivas, al final de su existencia, explotan como Supernovas y´su masa se contraen sobre sí misma más y más. Si la estrella es demasiado masiva, entonces ni ese principio de exclusión puede frenar a la Gravedad y se convierte en un Agujero negro.

Así que, el principio de exclusión de Pauli tiene aplicación no sólo a los electrones, sino también a los fermiones; pero no a los bosones. Si nos fijamos en todo lo que estamos hablando aquí, nos daremos de que la mecánica cu´çantica es extraña y siendo fácil comprender como forma un campo magnético la partícula cargada que gira, no resulta tan fácil saber por qué ha de hacer lo mismo un neutrón descargado.

Lo cierto es que ocurre así. La prueba directa más evidente de ello es que cuando un rayo de neutrones incide sobre un hierro magnetizado, no se comporta de la misma que lo haría si el hierro no estuviese magnetizado. El magnetismo del neutrón sigue siendo un misterio; los físicos sospechan que contiene cargas positivas y negativas equivalentes a cero, aunque por alguna razón desconocida, lograr crear un campo magnético cuando gira la partícula.

emilio silvera

Oct

20

Coreografía de un par de electrones

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

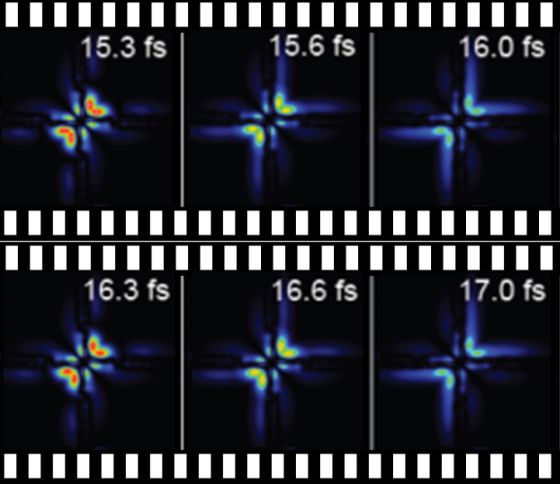

Físicos y químicos nos sorprenden cada día con el control que pueden ejercer sobre la materia. Por primera vez, investigadores españoles y alemanes hemos conseguido obtener la película del movimiento de los dos electrones que constituyen el átomo de helio e incluso controlar los pasos de esta singular pareja de baile. Para ello, hemos empleado una combinación de pulsos de luz visible y ultravioleta con una duración de tan solo unos pocos cientos de attosegundos (un attosegundo es una mil millonésima de una milmillonésima parte de un segundo). El control sobre el movimiento de pares de electrones podría revolucionar nuestra visión de la química, ya que los enlaces entre los distintos átomos que constituyen las moléculas, desde el agua al ADN, son el resultado del apareamiento de dos electrones. Por tanto, la perspectiva de utilizar láseres de attosegundos para controlar el destino de los electrones apareados en un enlace abre el camino a la producción de sustancias que no pueden ser sintetizadas utilizando procedimientos químicos convencionales.

Representación animada de un átomo de deuterio, uno de los isótopos del hidrógeno.

Para explicar algunas características extrañas en el espectro del átomo de hidrógeno, en 1913, el físico Niels Bohr introdujo un modelo planetario en el que el electrón cargado negativamente, unido al núcleo cargado positivamente por la fuerza electrostática de Coulomb, está restringido a moverse solamente a lo largo de órbitas muy concretas. Esta cuantificación del movimiento electrónico abrió un nuevo capítulo de la física y química modernas, sin el cual no se podría haber alcanzado el conocimiento de la materia del que se dispone hoy en día. En el modelo de Bohr, las cosas suceden rápidamente: el año sideral, es decir, el tiempo que el electrón necesita para completar la órbita más corta alrededor del núcleo, tiene la increíblemente corta duración de 0.000 000 000 000 000 152 segundos, o 152 attosegundos (as), un valor que se hace aún más pequeño cuando se consideran elementos más pesados en la tabla periódica de los elementos químicos.

… investigadores de la UAM consigue por primera vez utilizar pulsos láser con una duración de attosegundos para observar el movimiento de los electrones …

El attosegundo es, de hecho, la escala de tiempo natural en el que los electrones se mueven en la materia ordinaria. El movimiento ultrarrápido predicho por el modelo de Bohr no pudo ser confirmado directamente hasta que, a comienzos de este siglo, una serie de avances revolucionarios generó la tecnología láser capaz de producir destellos de luz suficientemente cortos (el récord mundial es de 67 as) para hacer fotografías del movimiento de un electrón y así generar la película de ese movimiento. En contraste con el mundo macroscópico, una película del movimiento del electrón no revela un desplazamiento a lo largo de una trayectoria bien definida. Como consecuencia del comportamiento ondulatorio de la materia a nivel atómico, el electrón aparece como una nube difusa (o paquete de ondas) en movimiento. La densidad de la nube indica la probabilidad de encontrar al electrón en distintas regiones del espacio.

Observar el comportamiento de los electornes es todo un espectáculo

En los sistemas más grandes que el hidrógeno, con varios electrones, la misma fuerza de Coulomb que une a un electrón con el núcleo también actúa repulsivamente entre los electrones. El efecto de tal repulsión es apantallar la carga nuclear, debilitando así el efecto atractivo del núcleo sobre cada uno de los electrones. Sin embargo, en gran medida, los electrones siguen actuando como partículas independientes y, por tanto, el movimiento del paquete de ondas que representa a todos los electrones no es mucho más complicado que el observado para un solo electrón en el átomo de hidrógeno. Hasta ahora, los experimentos llevados a cabo para seguir el movimiento de los paquetes de onda en átomos complejos fueron capaces de poner en marcha un solo electrón a la vez, confirmando esta imagen de que los electrones se mueven de forma casi independiente los unos de los otros.

La repulsión electrostática entre los electrones, sin embargo, tiene un efecto secundario, más sutil. De la misma manera que un pasajero de autobús evita sentarse al lado de otros pasajeros y toparse con ellos a medida que camina por el pasillo, los electrones tratan de evitarse el uno al otro cuando se mueven en el interior de un átomo o una molécula; el movimiento de los electrones se dice que está correlacionado. De este modo, los electrones minimizan su repulsión mutua y, como consecuencia, estabilizan el átomo o molécula a la que pertenecen. Dicha estabilización es responsable del balance energético de todos los procesos naturales, y es clave para nuestra comprensión y control del comportamiento de la materia, como la transferencia de energía en sistemas fotosintéticos, la protección de datos en los futuros ordenadores cuánticos, etcétera. A pesar de ello, el movimiento de dos electrones correlacionados ha eludido la observación experimental directa hasta el momento presente. Además, es muy difícil de reproducir teóricamente, ya que, incluso para el átomo de helio, que es el sistema más simple con dos electrones, las ecuaciones físico-cuánticas que describen este movimiento no pueden resolverse exactamente y, en su lugar, deben realizarse costosos cálculos numéricos en superordenadores.

Para poder tomar en cuenta la indistinguibilidad de los dos electrones del helio siguiendo las reglas de la Mecánica Cuántica, lo cual requiere que en una …

Esta semana, en la revista Nature, los investigadores teóricos de la Universidad Autónoma de Madrid, Luca Argenti y Fernando Martín, en colaboración con el grupo experimental de Thomas Pfeifer, del Instituto Max Planck de Heidelberg, explicamos cómo hemos reconstruido por primera vez el movimiento simultáneo de dos electrones excitados en el helio, a partir de datos experimentales y cálculos de física cuántica inéditos. Hemos utilizado una versión de alta resolución de una técnica conocida como espectroscopia de absorción transitoria de attosegundos, mediante la cual se midió la transparencia de una muestra de helio a destellos cortos de luz ultravioleta en función del tiempo transcurrido entre este destello y otro de luz roja generado por un láser de titanio-zafiro.

Al igual que un adulto empuja a un niño en un columpio, el pulso ultravioleta lleva el átomo a un estado excitado, donde ambos electrones oscilan. Actuando de manera adecuada, las piernas de los niños pueden amplificar o amortiguar las oscilaciones del columpio. Y midiendo la amplitud de dichas oscilaciones se puede deducir el punto en el que el niño movió las piernas, es decir, reconstruir el movimiento original del columpio. De una manera similar, en el experimento, el pulso de luz roja fortalece o debilita la absorción de la luz ultravioleta en función del tiempo transcurrido entre los dos pulsos. A partir de la modulación de la absorción ultravioleta, hemos logrado reconstruir la oscilación de los dos electrones, y de ahí deducir la evolución del correspondiente paquete de ondas. Más allá del seguimiento de este movimiento, también pudimos modificarlo y controlarlo aumentando la intensidad del pulso rojo. Volviendo a la analogía del columpio, es como si el niño estuviera, además, sujetando una cometa: un fuerte golpe de viento alteraría por completo la oscilación del columpio.

Con este trabajo, consideramos que hemos abierto el camino para la observación directa del movimiento electrónico correlacionado en átomos y moléculas, y quizá para controlar el movimiento de los electrones apareados en enlace químicos, lo que permitiría la producción de sustancias que no pueden ser obtenidas con procedimientos químicos convencionales.

Luca Argenti y Fernando Martín son investigadores teóricos del Departamento de Química de la Universidad Autónoma de Madrid

Oct

19

Nuevos materiales, nuevos procesos, nuevos dispositivos I

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física... ¡Y mucho más! ~

Clasificado en Física... ¡Y mucho más! ~

Comments (1)

Comments (1)

En los últimos años se han desarrollado materiales que, debido a su estructura nanométrica, presentan nuevas propiedades, y por tanto tienen aplicaciones en campos tan diversos como son la transmisión de información mediante luz, el almacenamiento de datos, la generación y el transporte de energía eléctrica, la síntesis de catalizadores, la elaboración de textiles más resistentes, o la implantación de nuevos implantes óseos.

El gran número de nuevos materiales y dispositivos demostradores que se han desarrollado en estos años ha sido fruto, por un lado del desarrollo de sofisticadas técnicas de síntesis, caracterización y manipulación que se han puesto a punto y, por otro, del gran avance en los métodos de computación en la nanoescala (técnicas ab-initio, dinámica molecular, etc.) que se han probado en las grandes instalaciones dedicadas al cálculo científico de altas prestaciones. Es precisamente la combinación de experimentos punteros con métodos teóricos precisos un elemento esencial para comprender un gran número de procesos y mecanismos que operan en la nanoescala. En concreto, una de las aportaciones teóricas más importantes al desarrollo de la Nanotecnología ha llegado de la mano de la Teoría de Funcionales de la Densidad (DFT, en sus siglas en inglés) por la que en 1998 Walter Kohn recibió el Premio Nobel en Química, compartido con John A. Pople, “padre” de la Química Cuántica. Con respecto al desarrollo experimental, cabe resaltar el alto grado de desarrollo de las técnicas SPM para ver y manipular la materia a escala nanométrica en multitud de ambientes diferentes (ultra alto vacío, humedad controlada, celdas catalíticas, temperaturas variables,…). Esta capacidad nos ha permitido diseñar nuevos experimentos con los que comprender el comportamiento de nuevos materiales y dispositivos. Dado la gran variedad de materiales y sus aplicaciones, es imposible en un artículo presentar una visión completa de la situación de la Nanotecnología, por lo que nos vamos a limitar a presentar algunos ejemplos que ilustran el estado actual de este campo.

Hacia la electrónica molecular: Electrónica molécular de espín. Representación del dispositivo compuesto por una isla base de cobalto sobre la que se deposita una sola molécula de …

Debido a su tamaño nanométrico, las estructuras moleculares pueden poner de manifiesto nuevas propiedades electrónicas. Sin embargo, la necesidad de poder producir estructuras nanométricas de forma masiva, tal y como requieren las aplicaciones industriales hace que la manipulación individual de nano-objetos como las moléculas pase a un segundo plano, requiriéndose alternativas más útiles para incorporar la Nanotecnología a los procesos de fabricación. Por esta razón, en los últimos años se están estudiando profusamente las condiciones de formación y las propiedades de capas autoensambladas de diferentes moléculas orgánicas sobre superficies.

ampliación del anterior, con el agregado de la molécula de piridina,a modo de explicación en el dibujo, toda la molécula (las 6 moléculas de piridina mas el átomo de cobalto)es una supramolecula.

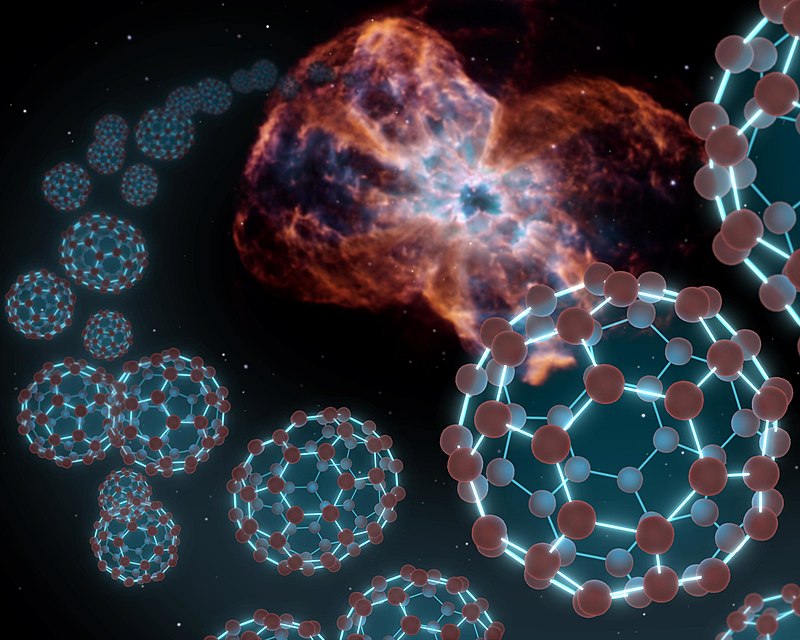

En estos casos la superficie no sólo proporciona un soporte, sino que posee un papel activo en la formación de diferentes patrones moleculares en dos dimensiones. Así, la posibilidad de generar sistemas autoensamblados de moléculas con propiedades bien definidas y dirigidas hacia la realización de funciones concretas abre un camino para cambiar desde el imperante paradigma del silicio en la electrónica hacia otro basado en la electrónica molecular. Este nuevo paradigma será mucho más rico por la gran diversidad de componentes moleculares que pueden entrar en juego. Entre los componentes prometedores para la Nanotecnología, que están relacionados con las moléculas orgánicas, y que habrá que tener en cuenta en el futuro de la microelectrónica, estarán los fullerenos, los nanotubos de carbono y el grafeno, de los que hablamos a continuación.

Los fullerenos o “bucky-balls”

Con este nombre se denomina al conjunto de distintas moléculas cerradas sobre sí mismas con formulación. El más conocido, por lo estable y abundante en naturaleza es el llamado Cn. El más conocido, por lo estable y abundante en la Naturaleza es el llamado C60, que está formado por 12 pentágonos y 20 exágonos, dispuestos como en un balón de futbol. Las aplicaciones Nanotecnológicas que se pueden derivar del uso de esta molécula están todavía en fase de estudio y son muy variadas. Sin embargo, aunque actualmente no existen aplicaciones concretas ya se han sintetizado más de mil nuevas moléculas basadas en fullereno y hay más de cien patentes internacionales registradas. El carácter rectificador de los fullerenos les hace atractivos para su uso en electrónica molecular.

La formación de este tipo de estructuras se produce más fácilmente de lo que podemos imaginar, pues son uno de los principales integrantes de la carbonilla y se generan abundantemente en cualquier combustión. Sin embargo, a día de hoy uno de los principales problemas para su utilización es el de conseguir una síntesis controlada de fullereno. Esto requiere complicadas técnicas, tales como la vaporización del grafito o la pirolisis láser, que normalmente producen exclusivamente los fullerenos más estables. Recientemente se ha propuesto un nuevo método para conseguirlo basado en principios “nano”.

La paridad es la simetría de Alicia en el país de las maravillas a través del espejo. La simetría P de una ley física indica que dicha ley es invariante si …

Se trata de partir de una molécula precursora sintetizada de forma tal que sea como un fullereno abierto, con los enlaces rotos saturados por hidrógeno. Esta molécula se puede plegar sobre sí misma mediante una transformación topológica de manera que de lugar a un fullereno. Se trata de partir de una estructura plana (un recortable) para posteriormente ensamblar un objeto en tres dimensiones. Este plegado se consigue mediante un proceso des-hidrogenación catalizada por una superficie. Una vez que la molécula plana ha perdido estos hidrógenos se cierran sobre sí misma de forma expontánea formando un fullereno.

Este proceso se ha podido seguir, entre otras técnicas, mediante imágenes de microscopía túnel in-situ. Los mecanismos existentes en el proceso se pueden entender gracias a los cálculos ab-initio que apoyan la investigación experimental. Esta combinación pone de manifiesto como una molécula plana de carbono sin hidrógeno se pliega expontáneamente. La belleza de este nuevo método de síntesis reside en que si se sintetizan moléculas precursoras planas con diferentes topologías se pueden conseguir moléculas cerradas de diferentes formas, tamaños e incluso que contengan átomos diferentes al Carbono. Así se ha sintetizado por primera vez la molécula C57 N3 sobre una superficie.

¡La Naturaleza! La NASA encontró fulerenos esféricos o buxkybolas en la nebulosa Tc1 a 6.000 años-luz. Posiblemente sean una de las moléculas más bellas que podamos encontrar, es una de las formas más estables del carbono, y sus 60 átomos se distribuyen formando 20 hexágonos y 12 pentágonos que ofrecen una forma idéntica al clásico balón de fútbol.

Nanotubos de Carbono

Si el descubrimiento del C60 fue un hito importante para la Nanotecnología, el de los llamados Nanotubos de Carbono lo ha superado con creces. Los Nanotubos de Carbono, unas diez mil veces más finos que un cabello, presentan excelentes propiedades físicas y su fabricación resulta relativamente económica. Un cable fabricado de Nanotubos de Carbono resultaría diez veces más ligero que uno de acero con el mismo diámetro pero sería ¡cien veces más resistente! A estas impresionantes propiedades mecánicas se le añaden unas interesantes propiedades eléctricas, puesto que pueden ser tanto conductores como aislantes, según la topología que presenten.

Un Nanotubo de Carbono se obtiene mediante el plegado sobre sí mismo de un plano atómico de grafito (enrollándolo). Según como se pliegue el plano grafítico se obtiene un Nanotubo que puede conducir la corriente eléctrica, ser semiconductor o ser aislante. En el primer caso, los Nanotubos de Carbono son muy buenos conductores a temperatura ambiente, pudiendo transportar elevadas densidades de corriente. En el segundo presentan propiedades rectificadoras. Por otra parte, si inducimos defectos en la estructura podemos generar moléculas semiconductoras y así formar diodos o transistores. Es decir, tenemos todos los elementos en nuestras manos para construir nanocircuitos basados en Carbono.

Grafeno

A un solo plano atómico de grafito se le llama grafeno, y éste, a diferencia del grafito, es difícil de obtener. Recientemente, mediante cálculos teóricos, se han realizado predicciones acerca de las importantes propiedades electrónicas que podría tener este material. Entre ellas una altísima movilidad electrónica y una baja resistividad, de manera que estos planos atómicos podrían ser los futuros sustitutos del silicio en los dispositivos electrónicos. Ahora bien, al día de hoy, estas propuestas provienen esencialmente de cálculos teóricos y, por tanto, antes de que el grafeno pase a sustituir al silicio en la electrónica del futuro, es necesario verificar las predicciones teóricas en el laboratorio. Actualmente, éste es un campo muy activo de investigación, y muchos grupos están trabajando en la obtención de capas de grafeno soportadas sobre diferentes materiales, como polímeros o aislantes, para poder determinar sus propiedades eléctricas y comprobar las predicciones teóricas.

El estudio de grafeno sobre metales de transición es un campo muy activo de investigación ya que las capas de grafeno crecen de manera fácil, muy controladas y con un bajo número de defectos sobre estas superficies. Además el grafeno sobre un substrato forma patrones conocidos como redes de Moiré, en las que la periodicidad atómica de las dos redes cristalinas (substrato y grafeno), coincide cada dos-tres nm, dando lugar a deformaciones de la capa de grafeno, que se reflejan como prominencias en la imagen STM.

Nanohilos

No sólo las moléculas, los Nanotubos o el grafeno son las apuestas para sustituir al silicio. Otros elementos como los Nanohilos fabricados a partir de materiales semiconductores o los Nanohilos metálicos tendrán también cierto protagonismo. En concreto, los Nanohilos semiconductores presentan un gran potencial como transistores pero también presentan aplicaciones en campos como octoelectrónica o en la fabricación de censores biológicos. Por otro lado los Nanohilos metálicos, cuya síntesis controlada es más difícil, poseen gran interés como interconectores. En el caso de los Nanohilos formados de materiales Ni, Co o Fe se puede aprovechar también su potencial comportamiento magnetorresisitivo para ser usados en dispositivos de almacenamiento magnético. Los Nanohilos metálicos son interesantes a su vez porque los efectos de tamaño inducen en ellos la aparición de transiciones de fase martensíticas y la aparición de configuraciones no cristalinas.

En el siguiente hablaremos de las Nanopartículas y la fuente de estos conocimientos aparece publicada en…

Editadas por la RSEF.

Publica: emilio silvera

Oct

17

Imaginación sin límite pero… ¿Sabremos comprender?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Relativista ~

Clasificado en Física Relativista ~

Comments (0)

Comments (0)

Está claro que pensar siquiera en que en nuestro Universo, dependiendo de la región en la que nos encontremos, habrá distintas leyes físicas, sería pensar en un universo chapuza. Lo sensato es pensar y creer que en cualquier parte del universo rigen las mismas leyes físicas, hasta que no se encuentre pruebas reales a favor de lo contrario, los científicos suponen con prudencia que, sean cuales fueran las causas responsables de las pautas que llamamos “Leyes de la Naturaleza”, es mucho más inteligente adoptar la creencia de la igualdad física en cualquier parte del Cosmos por muy remota que se encuentre aquella región; los elementos primordiales que lo formaron fueron siempre los mismos y las fuerzas que intervinieron para formarlo también.

La materia y las fuerzas que conforman nuestro Universo

Las fuerzas fundamentale son

|

Tipo de Fuerza |

Alcance en m |

Fuerza relativa |

Función |

| Nuclear fuerte |

<3×10-15 |

1041 |

Une Protones y Neutrones en el núcleo atómico por medio de Gluones. |

| Nuclear débil |

< 10-15 |

1028 |

Es responsable de la energía radiactiva producida de manera natural. Portadoras W y Z– |

| Electromagnetismo |

Infinito |

1039 |

Une los átomos para formar moléculas; propaga la luz y las ondas de radio y otras formas de energías eléctricas y magnéticas por medio de los fotones. |

| Gravitación |

Infinito |

1 |

Mantiene unidos los planetas del Sistema Solar, las estrellas en las galaxias y, nuestros pies pegados a la superficie de la Tierra. La transporta el gravitón. |

Fue Einstein el que anunció lo que se llamó principio de covariancia: que las leyes de la naturaleza deberían expresarse en una forma que pareciera la misma para todos los observadores, independientemente de dónde estuvieran situados y de cómo se estuvieran moviendo. En caso contrario… ¿En qué clase de Universo estaríamos?

Lo cierto es que Einstein fue muy afortunado y pudo lanzar al mundo su teoría de la relatividad especial, gracias a muchos apoyos que encontró en Mach, en Lorentz, en Maxwell… En lo que se refiere a la relatividad general, estuvo dando vueltas y vueltas buscando la manera de expresar las ecuaciones de esa teoría pero, no daba con la manera de expresar sus pensamientos.

Sin embargo, fue un hombre con suerte, ya que, durante la última parte del siglo XIX en Alemania e Italia, matemáticos puros habían estado inmersos en el estudio profundo y detallado de todas las geometrías posibles sobre superficies curvas. Habían desarrollado un lenguaje matemático que automáticamente tenía la propiedad de que toda ecuación poseía una forma que se conservaba cuando las coordenadas que la describían se cambiaban de cualquier manera. Este lenguaje se denominaba cálculo tensorial. Tales cambios de coordenadas equivalen a preguntar qué tipo de ecuación vería alguien que se moviera de una manera diferente.

Einstein se quedó literalmente paralizado al leer la Conferencia de Riemann. Allí, delante de sus propios ojos tenía lo que Riemann denominaba Tensor métrico. Einstein se dio cuenta de que era exactamente lo que necesitaba para expresar de manera precisa y exacta sus ideas. Así llegó a ser posible la teoría de la relatividad general.

Gracias al Tensor de Rieman, Einstein pudo formular: ![]()

Recordando aquellos años de búsqueda e incertidumbre, Einstein escribió:

“Los años de búsqueda en la oscuridad de una verdad que uno siente pero no puede expresar el deseo intenso y la alternancia de confianza y desazón hasta que uno encuentra el camino a la claridad y comprensión sólo son familiares a aquél que los ha experimentado. “

Einstein, con esa aparentemente sencilla ecuación que arriba podemos ver, le dijo al mundo mucho más, de lo que él mismo, en un principio pensaba. En ese momento, se podría decir, sin temor a equivocarnos que comenzó la historia de la cosmología moderna. Comprendidmos mejor el universo, supimos ver y comprender la implosión de las estrellas obligadas por la gravedad al salir de la secuencia principal, aprecieron los agujeros negros… y, en fin, pudimos acceder a “otro universo”.

Es curioso como la teoría de la relatividad general nos ha llevado a comprender mejor el universo y, sobre todo, a esa fuerza solitaria, la Gravedad. Esa fuerza de la naturaleza que ahora está sola, no se puede juntar con las otras fuerzas que -como tantas veces hemos comentado aquí-, tienen sus dominios en la mecánica cuántica, mientras que la gravitación residen en la inmensidad del cosmos; las unas ejercen su dominio en los confines microscópicos del átomo, mientras que la otra sólo aparece de manera significativa en presencia de grandes masas galácticas, estelas y de objetos que, como los agujerods negros y los mundos, emiten la fuerza curvando el espacio a su alrededor y distorsionando el tiempo si su densidad llega a ser extrema.

Cuando miramos al cielo nocturno -en la imagen de arriba lo hacemos desde Tenerife- y nos sentimos reducidos, empequeñecidos por la inmensidad de las luces celestes que puntúan en el cielo, estamos mirando realmente una minúscula porción de las estrellas localizadas en el brazo de Orión. El resto de los 200 mil millones de estrellas de la Vía Láctea están tan lejanas que apenas pueden ser vistas como una cinta lechosa que cruza el cielo nocturno.

Cuando recordamos que la galaxia Andrómeda se está acercando a la Vía Láctea a unos 300 km/s, y sabiendo lo que ahora sabemos, no podemos dejar de preguntarnos ¿dónde estará la Humanidad dentro de cinco mil millones de años? Si tenemos la suerte de haber podido llegar tan lejos -que es dudoso-, seguramente, nuestra inmensa imaginación habrá desarrollado conocimientos y tecnologías suficientes para poder escapar de tan dramático suceso. Estaremos tan ricamente instalados en otras galaxias, en otros mundos. De alguna manera… ¿No es el Universo nuestra casa?

emilio silvera

Oct

17

¡¡Quásares!! Extraños objetos de inusitado brillo y energía

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo asombroso ~

Clasificado en El Universo asombroso ~

Comments (0)

Comments (0)

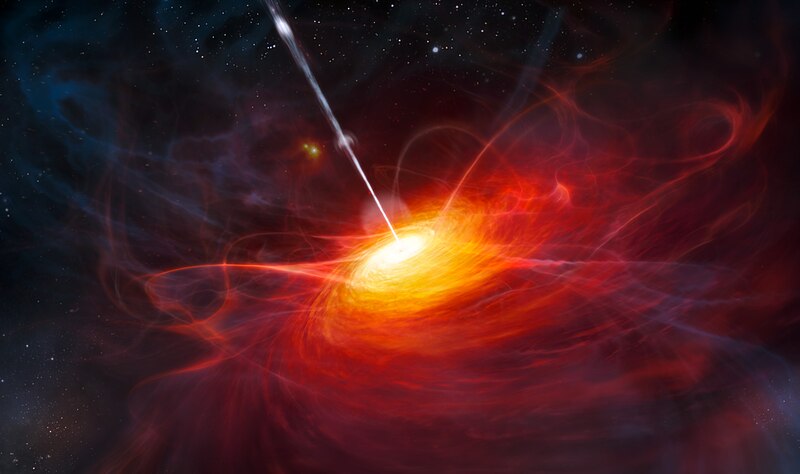

Una composición artísdtica del quásar más brillante descubierto hasta el momento: ULAS J1120+064.

Los quásares son galaxias distantes muy luminosas, alimentadas por un agujero negro supermasivo en su centro. Su brillo los convierte en poderosos faros que pueden ayudar a investigar la época en que se formaron las primeras estrellas y galaxias.Son útilespara ir comprendiendo cómo se formó el universo al revelar el estado de ionización del medio intergaláctico que tuvo lugar unos mil millones de años después del Big Bang. Parece que ULAS J1120+064 es es quásar más distante descubierto hasta el momento. Situado a más de doce mil millones de años-luz de nuestra Galaxia, está cerca de los limites del universo visible. La masa del agujero negro situado en el centro de ULAS J1120+0641 equivale a dos mil millones de veces la masa del Sol.

Estas fotos del Telescopio Espacial Hubble muestra diversos quasáres. Los quasáres son objetos distantes de gran energía. El quasar de arriba a la izquierda está a 1.4 mil millones de años luz de la Tierra. La imagen a la derecha muestra un quasar que puede ser el resultado del choque de dos galaxias viajando a 1 millón de millas por hora. Esta galaxia está a 3 mil millones de años luz de distancia. En la foto del centro un quasar se une con una galaxia.

STScI.

Los quásares han sido identificados históricamente en estudios ópticos, insensibles a fuentes de desplazamiento al rojo más allá de 6,5. Con el estudio de ULAS J1120+0641 se ha podido compronbar que tiene un acercamiento de 7,085, lo que significa 770 millones de años después del origen del universo. El quásar más cercano a este punto observado hasta el momento tenía un desplazamiento de 6,44 (100 millones de años más joven que este). Estudiar la distancia entre los dos “faros” servirá para arrojar algo de luz a una época de la que los científicos no tienen mucha información. Para la ciencia no es fácil poder explicar cómo, en una fase tan temprana del universo, se pudo crear un objeto con una masa tan inmensa que derriba las actuales teorías sobre el crecimiento de los agujeros negros supermasivos que predicen un crecimiento lento a medida que “el monstruo” atrae materia hacia sí desde la región circundante.

La imagen de arriba es otra representación artística de un Quásar, las auténticas los las seis fotografías que más arriba podéis ver y que representan -al menos eso es lo que parece- una apariencia estelar, muy similar a una estrella común tomada en la lejanía. Sin embargo el análisis detallado y profundo nos delatan algunas peculiaridades que rodean a esta clase de objetos y que los define en su singularidad propia que los hace muy diferents a las estrellas comunes al tener estructuras muy complejas. El descubrimiento de los quásares se debió a que son intensos emisores de radio ondas y también fuentes de rayos X, radiación ultravioleta, luz visible e infrarroja, es decir, la emisión de los cuásares recorre todo el espectro electromagnético.

Imagen de 3C273 recogida por el telescopio espacial Chandra

Fue en 1963 cuando M. Schmidt identificó por primera vez al quasar 3C 273 como el objeto más alejado entre todas las galaxias conocidas en ese entonces: los cálculos lo ubicaron a unos 2.000 millones de años-luz. Posteriormente, se comprobó que elcorrimiento al rojo de todos los quásares es mayor que el de las galaxias conocidas; por lo tanto, se encuentran más distantes que cualquiera de ellas. Esta evidencia confirmaría que se trata de los objetos más lejanos del universo conocido.

Así, las luces brillantes de los cielos que parecían estrellas, pero que eran demasiado luminosas para serlo, comenzaron a ser conocidas como objetos casi-estrellas o, resumiento, quasares. La extraordinaria luminosidad de los quasares era sólo una de entre sus poco frecuentes propiedades. Todavía era más extraño el hecho de que esa enorme efusión de energía parecía proceder de una región del espacio notablemente pequeña, más pequeña, de hecho, que nuestro Sistema solar.

Comparando las dos imágenes, aunque sean tan distitnas y representan realidades tan opuestas, lo cierto es que uno se hace una idea de lo inmensamente rica que es la diversidad del Universo con todas las formas y objetos que contiene. Un simple paisaje de nuestro planeta y un quásar lejano y, sin embargo, todo lo que está presente en ambos lugares está hecho de la misma cosa, Quarks y Leptones que se conforman de manera distinta para dar resultados diferentes y diferentes propiedades que han partido de una fuente común.

Lo asombroso de los quásares está en una pregunta que se hacen todos los astrónomos: ¿Cómo puede un objeto tan “pequeño” como un sistema solar producir la energía de cientos de miles de millones de estrellas? Y, sin embargo, el espacio que ocupan no tiene lugar para contener tántas estrellas como serían necesarias para emitir esa enorme energía. Lo cierto es que no se sabe si existe alguna fuerza desconocida para la ciencia que pueda generar la energía de los quásares. Una fuerza incluso más poderosa que la nuclear que es la que genera la energía que irradian las estrellas.

El misterio fue desvelado a base de observaciones y cálculos y más comprobaciones: Los quásares eran, en realidad, enormes agujeros negros situados en el centro de las galaxias más lejanas del Universo que, habían tenido el tiempo suficiente para hacerse tan inmensamente grandes que, dominaban la galaxia que los contenían y eran una gran parte de ella. Otros postulan que son galaxias jovenes que tienen un agujero negro central. Lo cierto es que, saber, lo que se dice saber lo que son los quásares, nadie lo sabe con exactitud milimétrica y todos son aproximaciones y conjeturas más o menos acertadas como otros muchos misterios que rodean las cosas del Universo que no hemos llegado a comprender.

Arriba podemos contemplar la simulación por ordenador de Joshua Barnes de la Universidad de Hawai. Abajo la escenificación artística del corazón de un quásar, un agujero negro masivo que absorbe en un vórtice de gas. Los astrónomos e Hawai creen que el Quásar brilla debido a que una galaxia gigante con un agujero negro colisiona con otra galaxia rica en gas que alimenta al agujero negro. Crédito: A. Simonet, Universidad Estatal de Sonoma, NASA.

Según todos los síntomas y datos que podemos poner sobre la mesa de estudio, la conclusión que podría ser la más acertada nos lleva a pensar que, los quásares, son inmensos agujeros negros alojados en los núcleos de grandes galaxias ricas en gas y numerosas estrellas que rodean al masivo objeto que, de manera gradual va describiendo una espiral de materia que atrae hasta él. A medida que cada estrella se acerca lo suficiente al agujero negro, su cuerpo gaseoso se desprende…

… debido a la fuerza de gravedad que genera el agujero negro y que es totalmente irresistible para la estrella que, inevitablemente, se espaguetiza y cae en las fauces del monstruo para engrosar su increíble y densa masa que lo hace más y más poderoso a medida que engulle materia de todo tipo que por las cercanias pueda pasar.

Los átomos de materia gaseosa situados en el interior de la estrella que, literalmente se desintegra, tomando gran velocidad por la fuerza de atracción que sobre ella ejerce el agujero negro, se mueve cada vez más rápidamente, como deseosa de llegar a su fatal destino. Cuando los átomos se aproximan a los límites del agujero negro, chocan unos con otros. Estas colisiones elevan la temperatura del gas, y este gas caliente irradia energía al espacio. Esta energía es la que detectan nuestros ingenios cuando estamos observando a un quásar lejano.

Nuestro Universo nos puede mostrar maravillas y cosas tan extrañas que durante muchos años no llegamos a comprender. El intenso estudio y las repetidas observaciones que en los distintos lugares del mundo se llevan a cabo sobre estos exóticos objetos, poco a poco, van generando datos que, unidos, nos llevan hacia la comprensión de lo que allí sucede, de cómo se pudieron generar algunos de estos extraños cuerpos masivos, o, pongamos por caso, cuál es el origen de las beiznas luminosas de gas plasmático que podemos contemplar en el remanente de una explosión supernova. La materia, amigos míos, puede adoptar tan extrañas y exóticas formas que, algunas, nos resultan desconcoidas y misteriosas.

La teoría prevé que el diámetro de un agfujero negro es proporcional a la cantidad de materia que hay en su interior. De esta manera, cada vez que un agujero negro se encuentra con otro y lo absorbe, el agujero negro resultante es mucho mayor. Al ser mucho más grande, ese mismo agujero negro tiene ahora más posibilidad de chocar con otros objetos al atraerlos gravitacionalmente y, los engulle para hacerce más y más grande. A partir de cierto momento, la capacidad de ese agujero negro de seguir absorbiendo más y más masa, se hace imparable y entra en un proceso sin fin en el que, cuanto mayor sea el agujero negro, más probabilidades tendrá de seguir consumiendo la materia que -pobre de ella- pase por sus dominios gravitatorios. De estos agujeros negros gigantes, han sido detectados -al menos así lo parecen los efectos de radiación y otros muy específicos que han sido comprobados- una buena cantidad en diversas galaxias más o menos lejanas.

Cuando un agujero negro engulle a una estrella, al ginal del proceso, se emite una inmensa explosión de energía. Estas explosiones de energía que se siguen unas a otras a medida que las estrellas más cercanas al agujero negro son consumidas por él, alimentan la extraordinaria cantidad de energía del quásar. Así que, resulta que el quásar es una galaxia que tiene un agujero negro gigante en el centro.

La deslumbrante radiación del quásar se crea a partir de las estrellas que, una por una, van alimentando al agujero negro gigante. Cada vez que el agujero negro gigante captura una estrella, vemos como el quásar tiene un fulgor como cuando arrojamos otro leño al fuego -guardando las distancias-. Al principio, el fuego resplandece con gran fulgor porque el agujero negro gigante tiene a su alcance un amplio suministro de estrellas disponibles para alimentar su insaciable voracidad.

Hemos podido llegar tan lejos gracias a que la Ciencia de la Astronomía y la Astrofísica no ha dejado de avanzar desde aquellos rudimentarios datos observacionales de los sumerios, y babilonios, o, los chinos los griegos y los árabes hasta llegar a Galileo y Kepler, Tycho Brahe y tantos otros que, enamorados de las maravillas del Universo, entregaron sus vidas al estudio de la Naturaleza del espacio infinito.

Así, hemos podido llegar a saber que, pasando el tiempo, muchas estrellas de la zona interior de las galaxias han ido desapareciendo al ser engullidas por esos monstruosos gigantes que llaamamos agujeros negros. Después de un intervalo de tiempo relativamente corto, quizá de unos cientos de millones de años, quedan ya muy pocas estrellas. Al quedar sin fuente de energía, el quásar se va oscureciendo y allí, donde antes resplandecía un fulgurante quásar, sólo queda ahora una galaxia de apariencia normal que, eso sí, en su interior aloja a un monstruo que está al acecho de lo que por allí pueda pasar para devorarlo.

Se conocen más de 200.000 cuasares. Todos los espectros observados tienen un corrimiento al rojo considerable, que va desde 0,06 hasta el máximo de 6,4. Por tanto, todos los quasares se sitúan a grandes distancias de la Tierra, el más cercano a 240 Mpc (780 millones de años luz) y el más lejano a 6 Gpc (13.000 millones de años luz). La mayoría de los quasares se sitúan a más de 1 Gpc de distancia; como la luz debe tardar un tiempo muy largo en recorrer toda la distancia, los cuasares son observados cuando existieron hace mucho tiempo, y el universo como era en su pasado distante.

Cuando profundizamos en las maravillas que el Universo contiene, cuando llegamos a comprender el por qué de los sucesos que podemos observar en el espacio profundo, cuando el estudio y la obervación ilumina nuestras mentes y el inmenso resplandor del saber nos inunda, entonces, y sólo entonces, llegamos a comprender la materia, la energía, los objetos estelares y cosmológicos que pueblan el Cosmos, todo ello, se rige por una serie de normas que son inalterables: Las cuatro fuerzas fundamentales y las constantes universales que, no sólo hacen posible la existencia de Quásares lejanos alentados por la presencia de agujeros negros gigantes, sino que también, esas mismas leyes y normas, hacen posible la existencia de las estrellas y los mundos y, en ellos, de la vida y de la inteligencia que todo lo vigila y de todo quiere saber.

Claro que, esa inteligencia a la que me refiero podría estar plasmada de muchas formas e incluso, algunas, aíun teniéndolas junto a nosotros ni la podríamos ver. La vida en el Universo, aunque la única que conocemos es la que está presente en el planeta Tierra, de cuya diversidad nos asombramos cada día -sólo tenemos que recordar que de las formas de vida que han estado presente en nuestro planeta, simplemente el uno por ciento pervive y está presente en estos momentos, el resto se entinguió por uno u otro motivo-, y, si la diversidad es tan grande en un redudico espacio como la Tierra… ¿Qué no habrá por ahí fuera?

emilio silvera

Totales: 77.278.500

Totales: 77.278.500 Conectados: 66

Conectados: 66