Sep

26

¡El Universo! ¿Cuando lo podremos conocer?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (2)

Comments (2)

La teoría del Big Bang es capaz de explicar la expansión del universo, la existencia de una radiación de fondo cósmica y la abundancia de núcleos ligeros el helio, el helio-3, el deuterio y el litio-7, cuya formación se predice que ocurrió alrededor de un segundo después del Big Bang, cuando la temperatura reinante era de 1010 K.

Si la teoría del Bing Bang es correcta (como parece que lo es -al menos de momento-), debe de existir alguna fuerza desconocida, i, quizá la misma gravedad que no hemos llegado a entender totalmente y tenga alguna que se nos escapa, o, una gran proporción de “materia oscura” en no bariónica, quizás axiones, fotinos o neutrinos masivos, supervivientes de las etapas tempranas del Big Bang y, ¿por qué no?, también podríamos suponer que la materia oscura que tanto nos preocupa pudiera estar encerrada dentro de las singularidades de tantos y tantos agujeros negros que se han debido formar a lo largo de los 13.700 millones de años que es la edad del universo.

Los agujeros negros, cuya existencia se dedujo por Schwarzschild en 1.916 a partir de las ecuaciones de campo de Einstein de la relatividad general, son objetos supermasivos, invisibles a nuestra vista (de ahí su ) del que no escapa ni la luz; tal es la fuerza gravitatoria que generan que incluso engullen la materia de sus vecinas, objetos estelares como estrellas que osan traspasar el cinturón de seguridad que llamamos horizonte de sucesos.

Pues , si en el universo existen innumerables agujeros negros, por qué no creer que sean uno de los candidatos más firmes que sea la buscada “materia oscura”. Bueno, también podrían ser las “cuerdas cósmicas”, o, ¿por qué no? la sustancia que los griegos clásicos llamaban Ylem, o… ¡vaya usted a saber que es, lo que produce el efecto de expansión de nuestro universo!

Para mí particularmente, sin descartar absolutamente nada de lo anterior (cualquier teoría podría ser la cierta), la denominada materia oscura (si finalmente existe), está situada en la quinta dimensión, y nos llegan sus efectos a través de fluctuaciones del “vacío” donde residen inmensas energías que rasgan el espacio-tiempo y que, de alguna manera, deja pasar a los gravitones que transportan la fuerza gravitacional que emite dicha materia y sus efectos se dejan sentir en nuestro universo, haciendo que las galaxias se alejen las unas de las otras a mayor velocidad de la que tendrían si el universo estuviera poblado sólo de la materia bariónica que nos rodea.

Claro que mi pensamiento es eso, una conjetura más de las muchas que circulan. A veces me sorprendo al escuchar como algunos astrofísicos de reconocido , sin pudor alguno, dogmatizan hablando de estas cuestiones sobre las que no tienen la menor certeza. Podemos hablar de la energía y materia oscura pero, siempre, dejando claro que son teorías de lo que podría ser y que, más o menos probables, aún no han sido confirmadas.

De todas las maneras, incluso la denominación dada: “materia oscura”, delata nuestra ignorancia. ¿Cómo poemos poner a algo que ni sabemos si existe en realidad. Se buscó esta solución para poder cuadrar las cuentas. Las observaciones astronómicas dejaron claro que, las galaxias, se alejaban las unas de las otras a velocidades cada vez mayores y que, de seguir así, llegaría un día en el futuro en el que, las únicas galaxias cercanas serían las del Grupo Local. Que cada vez el espacio “vacío” entre galaxias será mayor. ¿Qué fuerza desconocida empujaba a las galaxias a expandirse hacia el exterior? La materia bariónica no era la causante. Así que, se inventí la materia oscura y, de esa manera, el problema quedó zanjado. Claro que, no solucionado.

Mecánica cuántica, relatividad, átomos, el genóma, agujeros negros, la constante cosmológica, la constante de Planck racionalizada… Sabemos representar muchas otras cosas pero, la materia oscura, al sernos desconocida, no sabemos como ser y no podemos tener una imagen de lo que la materia oscura es (si es que es), así que hablamos y hablamos de ella sin cesar pero también sin, saber.

Mientras tanto, dejamos que el “tiempo” transcurra y como en todo lo demás, finalmente, alguien nos dará la respuesta, o, nos sacará del error, al demostrar que la dichosa materia oscura, nunca existió y que es, otra fuerza, la que produce los efectos observados en la expansión acelerada del Universo.

Claro que nos falta mucho…

que tengamos todas las respuestas que necesitamos para viajar a las estrellas, tener energía infinita obtenida de agujeros negros, lograr el traslado instantáneo de materia viva a lugares distantes, dominar toda una galaxia, etc, tendrán que transcurrir algunos eones de tiempo que, algunos de estos sueños se haga realidad y, si ocurren algunas de esas cosas en el futuro…¿La haremos nosotros? ¿O, quizá para entonces sean otros los que habrán cogido la antorcha de nuestros sueños?

No creo que tarden mucho en trabajar codo con codo con nosotros

vez se avanza más en menos tiempo. Y, llegará el momento, cuando dentro de algunos milenios, estemos preparados para viajar a las estrellas que, estarán aquí presentes con nosotros los inevitables Robots. Según una serie de cálculos y profundos pensamientos, no podremos seguir adelante llegados a un punto de no retorno, y, nos veremos obligados a fabricar robots muy sofisticados que harán trabajos espaciales y de colonización de Planetas para preparar la posterior llegada de los Humanos. Es inevitable pero, ¿será una buena idea?

Acordaos de que hace menos de un siglo no existían televisores, teléfonos móviles, faxes, ni aceleradores de partículas. En los últimos cien años hemos avanzado de una manera que sería el asombro de nuestros antepasados. De la misma manera pero mucho más acelerada, serán las décadas venideras y, dentro de los próximos cien años (a finales del presente siglo), si lo pudiéramos ver, quedaríamos tan asombrados como lo estarían nuestros bisabuelos si pudieran abrir los ojos y ver el mundo actual.

¿Qué maravillas tendremos dentro de 200 años? ¿Qué adelantos científicos se habrán alcanzado? ¿Sabremos más sobre el origen de la vida? ¿Qué estadio de saber habrá alcanzado la Fisica, y, si entonces hemos verificado la Teoría de cuerdas, qué nuevas teorías estarán en boga? ¿Habremos convertido Marte en una segunda Tierra (terraformarla) al proporcionarle una atmósfera y un escudo magnético?

La verdad es que, científicamente hablando, no habría problema alguno

Dejando a un lado, a los primeros descubridores, Ptolomeo, Copérnico, Galileo, Kepler y otros muchos de tiempos pasados, tenemos que atender a lo siguiente:

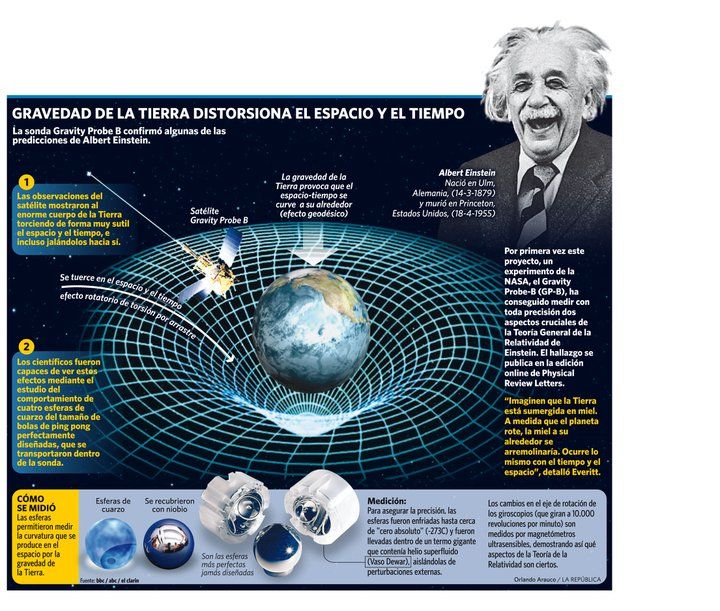

La primera revolución de la física se produjo en 1.905, cuando Albert Einstein con su relatividad especial nos ayudo en nuestra comprensión de las leyes que gobiernan el universo. Esa primera revolución nos fue dada en dos pasos: 1905 la teoría de la relatividad especial y en 1.915, diez años después, la teoría de la relatividad general. Al final de su relativista, Einstein concluyó que el espacio y el tiempo están distorsionados por la materia y la energía, y que distorsión es la responsable de la gravedad que nos mantiene en la superficie de la Tierra, la misma que mantiene unidos los planetas del Sistema Solar girando alrededor del Sol y también la que hace posible la existencia de las galaxias. La Relatividad General de Einstein, nos dice cómo la materia determina la geometría del Universo.

Un universo que se curva sobre sí mismo en presencia de la materia

Einstein nos dio un conjunto de ecuaciones a partir de los cuales se deducir la distorsión del tiempo y del espacio alrededor de objetos cósmicos que pueblan el universo y que crean esta distorsión en función de su masa. Se han cumplido 100 años entonces y miles de físicos han tratado de extraer las predicciones encerradas en las ecuaciones de Einstein (sin olvidar a Riemann) sobre la distorsión del espaciotiempo. Es decir, Einstein nos dijo que la materia, es la que determina la geometría del Universo.

Un agujero negro es lo definitivo en distorsión espaciotemporal, según las ecuaciones de Einstein: está hecho única y exclusivamente a partir de dicha distorsión. Su enorme distorsión está causada por una inmensa cantidad de energía compactada: energía que reside no en la materia, sino en la propia distorsión. La distorsión genera más distorsión sin la ayuda de la materia. es la esencia del agujero negro.

Si tuviéramos un agujero negro del tamaño de la calabaza más grande del mundo, de unos 10 metros de circunferencia, entonces conociendo las leyes de la geometría de Euclides se podría esperar que su diámetro fuera de 10 m / π = 3’14159…, o aproximadamente 3 metros. Pero el diámetro del agujero es mucho mayor que 3 metros, quizá algo más próximo a 300 metros. ¿Cómo puede ser esto? Muy simple: las leyes de Euclides fallan en espacios muy distorsionados.

Como podemos imaginar un objeto pesado o masivo colocado en el centro de una superficie elástica, se ha hundido a consecuencia del peso y ha provocado una distorsión que cambia completamente la medida original del diámetro de esa circunferencia que, al ser hundida por el peso, se agranda en función de éste.

Al espacio le ocurre igual.

De la misma manera se considerar que el espacio tridimensional dentro y alrededor de un agujero negro está distorsionado dentro de un espacio plano de dimensión más alta (a menudo llamado hiperespacio), igual que la lámina bidimensional está distorsionada como describo en la imagen anterior.

Lo más intrigante de los agujeros negros es que, si caemos en uno, no tendremos manera alguna de salir o enviar señales a los que están fuera esperándonos. Pensemos que la masa de la Tierra que es de 5’974X1024 Kg (densidad de 5’52 gramos por cm3), requiere una velocidad de escape de 11’18 Km/s, ¿cuál no será la masa y densidad de un agujero negro si pensamos que ni la luz que viaja a 299.792’458 Km/s escapar de su fuerza de gravedad?

La Gravedad, presente en el Universo…, ¡de tantas maneras!

Es tanta la densidad que no sólo distorsiona el espacio, sino que también distorsiona el tiempo según las ecuaciones de Einstein: el flujo del tiempo se frena cerca del agujero, y en un punto de no retorno (llamado el “horizonte” del agujero, o límite), el tiempo está tan fuertemente distorsionado que empieza a fluir en una dirección que normalmente sería espacial; el flujo de tiempo futuro está dirigido hacia el centro del agujero. Nada moverse hacia atrás en el tiempo1, insisten las ecuaciones de Einstein; de modo que una vez dentro del agujero, nos veremos arrastrados irremisiblemente hacia abajo con el flujo del tiempo, hacia una “singularidad” escondida en el corazón del agujero; en ese lugar de energía y densidad infinitas, el tiempo y el espacio dejan de existir.

Como he apuntado antes en alguna parte de este mismo , la descripción relativista del agujero negro procede de la obra de Kart Schwarzschil. En 1.916, apenas unos meses después de que Einstein formulara sus famosas ecuaciones, Schwarzschild fue capaz de resolver exactamente las ecuaciones de Einstein y calcular el campo gravitatorio de una estrella masiva estacionaria.

Así, Históricamente la primera solución importante fue obtenida por Schwarzschild en 1916, solución conocida posteriormente como métrica de Schwarzschild, representa el campo creado por un astro estático y con simetría esférica. Dicha solución constituye una muy buena aproximación al campo gravitatorio dentro del sistema solar, lo cual permitió someter a confirmación experimental la teoría general de la relatividad explicándose hechos previamente no explicados como el avance del perihelio de Mercurio y prediciendo nuevos hechos más tarde observados como la deflexión de los rayos de luz de un campo gravitatorio. Además las peculiaridades de esta solución condujeron al descubrimiento teórico de la posibilidad de los agujeros negros, y se abrió todo una nueva área de la cosmología relacionada con ellos. Lamentablemente el estudio del colapso gravitatorio y los agujeros negros condujo a la predicción de las singularidades espacio-temporales, deficiencia que revela que la teoría de la relatividad general es incompleta. Quizá la teoría de cuerdas, en la que subyace ésta, nos complete el cuadro.

Geometría aparente del plano de la eclíptica en un sistema cuyo astro central es un agujero negro de Schwarzschild. La solución de Schwarzschild tiene varias características interesantes:

La solución de Schwarzschild permitió aplicar los postulados de la relatividad general a disciplinas como la mecánica celeste y la astrofísica, lo cual supuso una verdadera revolución en el estudio de la cosmología: Apenas seis años después de la publicación de los trabajos de Einstein, el físico ruso Aleksander Fridman introdujo el concepto de singularidad espacio-temporal, definido como un punto del espacio-tiempo en el que confluyen todas las geodésicas de las partículas que habían atravesado el horizonte de sucesos de un agujero negro. En normales, la curvatura producida por la masa de los cuerpos y las partículas es compensada por la temperatura o la presión del fluido y por fuerzas de tipo electromagnético, cuyo estudio es objeto de la física de fluidos y del estado sólido. Sin embargo, cuando la materia alcanza cierta densidad, la presión de las moléculas no es capaz de compensar la intensa atracción gravitatoria. La curvatura del espacio-tiempo y la contracción del fluido aumentan cada vez a mayor velocidad: el final lógico de este proceso es el surgimiento de una singularidad, un punto del espacio-tiempo donde la curvatura y la densidad de tetramomentum son infinitas.

- En primer lugar, una línea de no retorno rodea al agujero negro: cualquier objeto que se acerque a una distancia menor que radio será absorbido inevitablemente en el agujero.

- En segundo lugar, cualquiera que cayera dentro del radio de Schwarzschild será consciente de un “universo especular” al “otro lado” del espacio-tiempo.

Incluso surgieron agujeros de gusano que nos podían trasladar a puntos distantes tanto en el tiempo como en el espacio.

Einstein no se preocupaba por la existencia de extraño universo especular porque la comunicación con él era imposible. Cualquier aparato o sonda enviada al centro de un agujero negro encontraría una curvatura infinita; es decir, el campo gravitatorio sería infinito y, como ya dije antes, ni la luz podría escapar a dicha fuerza, e igualmente, las ondas de radio electromagnéticas también estarían prisioneras en el interior de un agujero negro, con lo cual, el mensaje nunca llegará al exterior. Allí dentro, cualquier objeto material sería literalmente pulverizado, los electrones serían separados de los átomos, e incluso los protones y los neutrones dentro de los propios núcleos serían desgajados. Además, penetrar en el universo alternativo, la sonda debería ir más rápida que la velocidad de la luz, lo que no es posible; c es la velocidad límite del universo.

Así pues, aunque este universo especular es matemáticamente necesario para dar sentido a la solución de Schwarzschild, nunca podría ser observado físicamente (al menos por el ). En consecuencia, el famoso puente de Einstein-Rosen que conecta estos dos universos fue considerado un artificio matemático.

Posteriormente, los puentes de Einstein-Rosen se encontraron pronto en otras soluciones de las ecuaciones gravitatorias, tales como la solución de Reisner-Nordstrom que describe un agujero eléctricamente cargado. Sin embargo, el puente de Einstein-Rosen siguió siendo una nota a pie de página curiosa pero olvidada en el saber de la relatividad.

Las cosas comenzaron a cambiar con la solución que el matemático presentado por el neozelandés Roy Kerr, presentado en 1.963, encontró otra solución exacta de las ecuaciones de Einstein. Kerr supuso que cualquier estrella colapsante estaría en rotación. Así pues, la solución estacionaria de Schwarzschild para un agujero negro no era la solución físicamente más relevante de las ecuaciones de Einstein.

La solución de Kerr de un agfujero negro en rotación causó sensación en el campo de la relatividad cuando fue propuesta. El astrofísico Subrahmanyan Chandrasekhar llegó a decir:

“La experiencia que ha dejado más huella en mi vida científica, de más de cuarenta años, fue cuando comprendí que una solución exacta de las ecuaciones de Einstein de la relatividad general, descubierta por el matemático Roy Kerr, proporciona la representación absolutamente exacta de innumerables agujeros negros masivos que pueblan el universo. Este estremecimiento ante lo bello, este hecho increíble de que un descubrimiento motivado por una búsqueda de la belleza en matemáticas encontrará su réplica exacta en la naturaleza, es lo que me lleva a decir que la belleza es aquello a lo que lleva la mente humana en su nivel más profundo“.

Un agujero negro de Kerr o agujero negro en rotación es una región de agujero negro presente en el espacio-tiempo de Kerr, cuando el objeto másico tiene un radio inferior a cierta magnitud, por encima de este radio el universo de Kerr no presenta región de agujero negro. Un agujero negro de Kerr es una región no isótropa que queda delimitada por un horizonte de sucesos y una ergoesfera presentando notables diferencias con respecto al agujero negro de Schwarzschild. Esta nueva frontera describe una región donde la luz aun escapar pero cuyo giro induce altas energías en los fotones que la cruzan. Debido a la conservación del momento angular, este espacio un elipsoide, en cuyo interior se encuentra un solo horizonte de sucesos con su respectiva singularidad, que debido a la rotación tiene de anillo.

La solución de Kerr de un agujero negro giratorio permite que una nave espacial pase a través del centro del agujero por el eje de rotación y sobrevivir al viaje a pesar de los enormes pero finitos campos gravitorios en el centro, y seguir derecha hacia el otro universo especular sin ser destruida por la curvatura infinita.

Para nosotros, teniendo el concepto que tenemos de lo que un agujero negro es, es tan difícil imaginar que una nave pueda entrar en él y poder salir más tarde, como imaginar que, en mundos extraños como el de arriba, puedan existir criaturas inteligentes como en la Tierra.

El universo, como todos sabemos, abarca a todo lo que existe, incluyendo el espacio y el tiempo y, por supuesto, toda la materia está en la que esté constituida. El estudio del universo se conoce como cosmología. Si cuando escribimos Universo nos referimos al conjunto de todo, al cosmos en su conjunto, lo escribimos con mayúscula, el universo referido a un modelo matemático de alguna teoría física, ese se escribe con minúscula.

El universo real está constituido en su mayoría por espacios aparentemente vacíos, existiendo materia concentrada en galaxias formadas por estrellas y gas (también planetas, quásares, púlsares, cometas, estrellas enanas blancas y marrones, estrella de neutrones, agujeros negros y otros muchos objetos espaciales). El universo se esta expandiendo, las galaxias se alejan continuamente los unas de las otras. Existe una evidencia creciente de que existe una materia oscura invisible, no bariónica, que constituir muchas veces la masa total de las galaxias visibles. El concepto más creíble del origen del universo es la teoría del Big Bang de acuerdo con la cual el universo se creó a partir de una singularidad infinita de energía y densidad a inmensas temperaturas de millones de grados K, hace unos 15.000 millones de años.

emilio silvera

Sep

26

La Cosmología y la Humanidad

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Cosmología ~

Clasificado en Cosmología ~

Comments (18)

Comments (18)

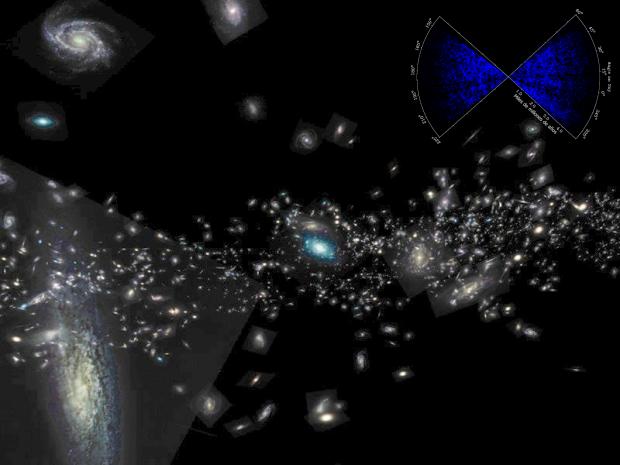

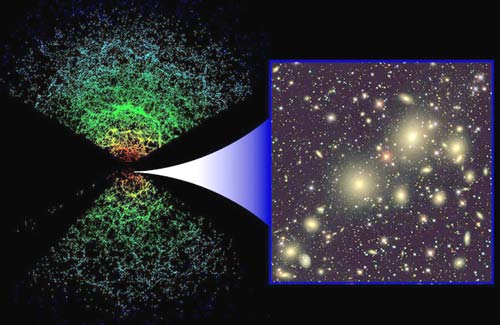

Queremos configurar el universo y hacemos mapas de las galaxias…

La cosmología, a pesar del paso del tiempo, continúa siendo una disciplina interesante, basada en la astronomía y la física. Tenemos la necesidad de saber cómo es nuestro mundo (el universo), incluso si esa visión es inexacta o incompleta. Los antiguos indúes, babilonios y mayas combinaron la ciencia con la religión y las estructuras sociales para completar la imagen. Pensar que nosotros, hacemos algo diferente es, engañarnos a nosotros mismos. Si la cosmología moderna parece ajena a la religión, esto es porque las hemos convertido en una auténtica religión secular. Ahora, el sitio de los dioses, es ocupado por el Universo mismo, la Naturaleza sabia que tratamos de comprender.

A diferencia de los físicos o los químicos que aceptan gustosos los desafíos de sus paradigmas, los comólogos modernos son lagashianos, es decir, defienden el modelo que ellos han elegido frente a cualquier prueba que vaya contra él. Como dijo el físico ruso Lev Landau: “Los cosmólogos caen a menudo en errores, pero nunca dudan”.

El mundo de la cosmología ortodoxa del big bang no soporta a los disidentes y, luego, hay muchos y la historia nos habla de ellos. Por poner un ejemplo, me referiré al conocido protegido de Hubble, Halton Arp, educado en Harvard y Caltech que nunca renunció al rigor intelectual de su mentor y, en consecuencia, sostenía que los corrimientos el rojo no demostraban necesariamente la existencia de un universo en expansión. Todos conocemos la calidad que como astrónomo tenía Arp y de sus renombrados descubrimientos que, en su día, llenaron las primeras portadas de toda la prensa.

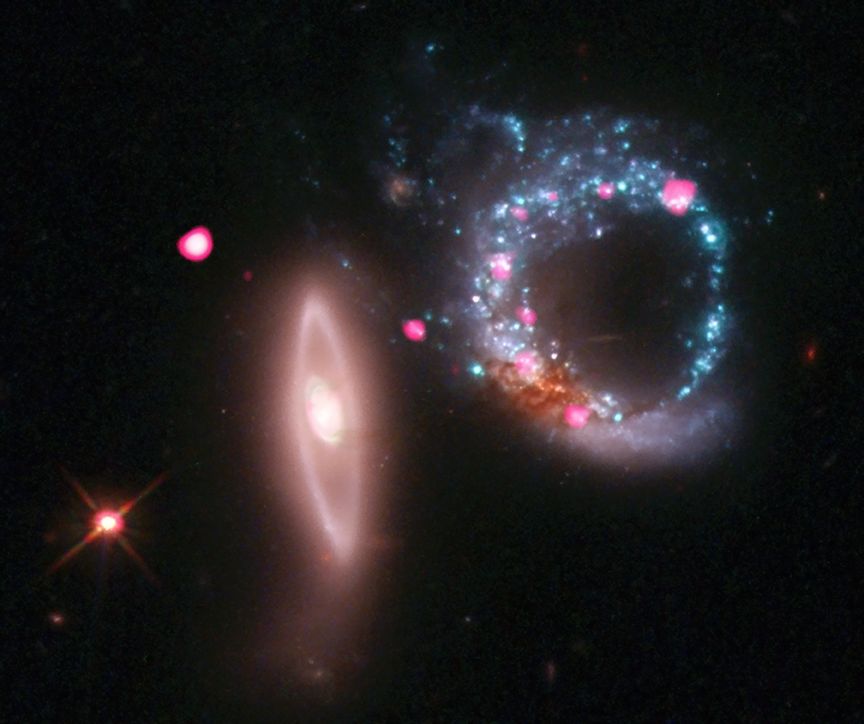

Arp 147 es una pareja de galaxias en fuerte interacción localizada a unos 430 millones de años luz de la Tierra sobre la constelación de Cetus. La colisión entre ambos objetos, que una vez fueron una típica galaxia elíptica y una típica galaxia espiral, ha generado una onda expansiva de formación estelar intensa en lo que era la galaxia espiral, deformando este objeto de tal forma que tiene una estructura claramente anular.

A veces, los objetos en el cielo que aparecen extraños o diferentes de lo normal, tienen una historia que contar que puede ser científicamente valioso. Esta fue la idea del catálogo de Halton Arp de Galaxias Peculiares que apareció en los años 1960. Uno de los raros objetos listados es Arp 261, que ha sido fotografiado con mayor detalle que nunca usando el instrumento FORS2 en el Telescopio Muy Grande de ESO. La imagen contiene varias sorpresas.

Arp 261 yace a 70 millones de luz de distancia en la constelación de Libra. Su caótica y muy inusual estructura es creada por la interacción de dos galaxias. Aunque las estrellas individuales es muy raro que colisionen en este evento, ya que están muy alejadas unas de otras, las enormes nubes de gas y polvo ciertamente chocan a gran velocidad, lo que provoca nuevos cúmulos de calientes estrellas. Las órbitas de las estrellas existentes son dramáticamente alteradas, creando los remolinos que se extienden en la superior izquierda e inferior derecha de la imagen. Ambas galaxias eran probablemente enanas, no muy distintas que las Nubes de Magallanes que orbitan nuestra galaxia.

Viendo esas imágenes de increíble misterio, toda vez que esconden historias que tenemos que deducir de sus configuraciones, nos hacen caer en la de que, en realidad, todas nuestras cosmologías, desde las cosmologías sumerias y maya hasta la de los “expertos” actuales, están limitadas por una falta de visión que conlleva una enorme carencia de conocimientos. El que sabe, tiene una panorámica visual de la mente mucho más amplia que el que no tiene los conocimientos y, digamosló fuerte y claro: ¡Aún no sabemos! Innegable es que vamos avanzando y mucho pero, de ahí a decir que conocemos lo que el Universo es… hay un enorme abismo que necesita del puente del conocimiento para poder pasar al otro lado.

En los lejanos confines del Universo, a casi 13 mil millones años luz de la Tierra, unas extrañas galaxias yacen escondidas. Envueltas en polvo y atenuadas por la enorme distancia, ni siquiera el Telescopio Espacial Hubble es capaz de reconocerlas. Tendremos que esperar a su sustituto el James Webb.

James Webb Space Telescope (JWST) artist’s conception (NASA). Sabiendo todo lo que nos ha traído el Hubble, esas imágenes que nos ejaron literalmente con la boca abierta por el asombro, ¿qué no podrá traernos este nuevo ingenio que supera en mucho al anterior? Su es en honor al segundo administrador de la NASA y, sus objetivos:

- Buscar la luz de las primeras estrellas y galaxias formadas tras el supuesto big bang

- Estudiar la formación y evolución de las galaxias

- Comprender mejor la formación de estrellas y planetas

- Estudiar los sistemas planetarios y los orígenes de la vida

En su obra Cosmos, Carl Sagan describe varios mitos antiguos de la creación, que son, según escribe este autor, “un tributo a la audacia humana”. Al tiempo que llama al big bang “nuestro mito científico moderno”, señala una diferencia crucial en el sentido de que “la ciencia se plantera así misma preguntas y podemos realizar experimentos y observaciones tratar de comprobar nuestras teorías”.

Sin embargo, lo que está claro es que Sagan, se sentía muy atraído por lacosmología cíclica hindú, en la cual Brahma, el gran dios creador, consigue que un universo llegue a existir el lo sueña

¿Qué univeros soñaría Brahma? ¿Sería como nuestro? ¿Tendrían vida?

Según el experto en religiones Mircea Eliade, durante cada día brahmánico, 4.320 millones de años para ser exactos, el universo sigue su curso. Pero, al comienzo del anochecer brahmánico, el dios se cansa de todo esto, bosteza y cae en un profundo sueño. El universo se desvanece, disolviendo los tres dominios materiales que son la Tierra, el Sol y los cielos, que contiene la Luna, los planetas y la estrella Polar. (Hay cuatro dominios superiores a éstos que no se destruyen en este ciclo). La noche va pasando; entonces Brahma empieza a soñar de y otro universo empieza a existir.

Este ciclo de creación y destrucción continúa eternamente, lo cual se pone de manifiesto en el dios hinfú Siva, señor de la danza que , que sostiene en su mano derecha el tambor que anuncia la creación del universo y en la mano izquierda la llama que. mil millones de años después, destruirá este universo. Hay que decir tambien que Brahma no es sino uno de los muchos dioses que también sueñan sus propios universos, es decir, ya por aquel entonces, se hablaba y creía en los multiversos.

Alrededor de todas aquellas configuraciones del Cosmos, como era de esperar, tenían muchos rituales y celebraciones. Cinco días después de terminar Sat Chandi Mahayajna, culto a la Energía Cósmica, empezará Yoga Poornima que es el culto a su contraparte, la Consciencia Cósmica, Shiva. Así, ambos eventos, cada uno único en su , rinden tributo a la figura materna y paterna del universo y crean un círculo completo de experiencia total. Al término de ambos eventos uno se siente saciado, completo y pleno.

Los 8.640 millones de años que constituyen el ciclo completo de un día y una noche en la vida de Brahma vienen a ser aproximadamente la mitad de la edad del Universo según los cálculos actuales. Los antiguos hindúes creían que cada día brahmánico duraba un kalpa, 4.320 millones de años, siendo 72.000 kalpas un siglo brahmánico, en total 311.040.000 millones de años. El hecho de que los hindúes fueran capaces de concebir el universo en miles de millones de años (en ves de hablar de los miles de millones que se solían barajar en las culturas y doctrinas religiosas primitivas occidentales) fue, según Sagan, “sin duda una casualidad”. luego es posible que fuera sólo cuestión de suerte. No obstante, la similitud entre la cosmolo´gia hindú y la cosmología actual no me parece a mí una casualidad, ahñi subyace un elevado conocimiento.

Es posible que, aquellas teorías que si las trasladamos a este tiempo, en alguinos casos no podríamos discernir si se trata de las ideas de entonces o, por el contrario son nuestras modernas ideas, con esos ciclos alternos de destrcucción y creación, pudieran estar conectados y fuertemente ligados a nuestra psique humana que, al fin y al cano, de alguna manera que no hemos podido llegar a entender, está, ciertamente, conectada con el universo del que forma parte. Claro que, debemos entender y saber extrapolar los mensajes de entonces y transplantarlos al aquí y , y, aquellos redobles del tambor de Siva que sugieren el inmenso impulso energético repentino, podría ser muy bien lo que provocó nuestrobig bang.

Recientemente, un prestigioso físico afirma haber hallado evidencias de un Universo anterior al nuestro, mediante la observación del fondo cósmico de microondas. Esto significaría que nuestro Universo no es único, sino que han existido otros universos con anterioridad, quizás un infinito. Es un ciclo que hasta ahora solo se creía teórico, sin ningún tipo de prueba que lo respalde. Ahora parece haberse encontrado la primera.

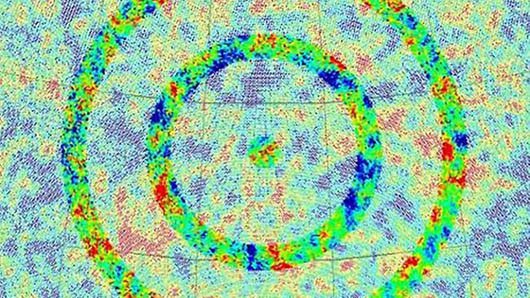

El descubrimiento son unos extraños patrones circulares que pueden encontrarse en la radiación de fondo de microondas del WMAP (Imagen arriba), según un artículo recientemente publicado en ArXiv.org, donde Penrose explica el fenómeno, tras analizar los extraídos de estas anomalías. Concluye que es una clara prueba de que el espacio y el tiempo existen mucho antes de nuestro Big Bang hace 13.700 millones de años, que provienen de anteriores universos que podríamos llamar “eones”, de un ciclo que se lleva repitiendo el infinito.

Nos podemos imaginar, en un largo viaje en el tiempo hacia tiempos pasados, todo lo que allí, en aquellas civilizaciones de pensaba acerca del Cosmos, las leyendas que se contaban para explicar los sucesos y con detalles, narrar lo que era el “mundo-universo” que ellos, en su ya inmensa imaginación, sibujaban de una forma muy similar a la nuestra (salvando las distancias), toda vez que, en lo esencial, muchas son las coincidencias de ayar y hoy. ¿Quiere eso decir que hemos adelantado muy poco? Todo lo contrario, hemos adelantado muchísimo para poder comprobar que, muchos de aquellos postulados de hace miles de años, eran ciertas y apuntaban en la correcta dirección.

emilio silvera

Sep

21

¿La Humanidad en el Espacio? ¿Para cuándo?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Otros mundos ~

Clasificado en Otros mundos ~

Comments (0)

Comments (0)

Mirando la escena que la imagen de arriba nos presenta, nos resulta algo antigua y pasada de moda si la comparamos con los vuelos que en el presente se programan y los ingenios espaciales que las modernas tecnologías nos permiten enviar al espacio exterior a la búsqueda de otros mundos que, aunque en nuestro propio Sistema solar, debemos conocer para saber, qué nos puede esperar en regiones más lejanas que, algún día en el futuro, tendremos que visitar buscando cobijo a una Humanidad que no tendrá bastante con el pequeño mundo que ahora ocupa.

Aquello fue todo un acontecimiento, una nueva era de los viajes espaciales que comenzó en aquel mes de Julio de 1950 ¡El primer cohete lanzado desde Cabo Cañaveral, Florida: el BumperII. Como una prueba o investigación para probar los sistemas y, al mismo tiempo, investigar la artmósfera superior de la Tierra con sensores especiales que medían las distintas caracterísiticas de la alta atmósfera así como los impactos de los rayos cósmicos. Hasta pasados siete años, la Unión Soviética no lanzó el Sputnik I y II, los primeros satélites que orbitaron la Tierra.

El primer vuelo del Columbia – Imagen cortesía Wikipedia

El 12 de abril de 1981, despegaba la lanzadera espacial Columbia, la primera nave espacial reutilizable. La lanzadera espacial Columbia se entregó a la NASA el 25 de marzo de 1979. Tras su primer vuelo operativo, se mantuvo en servicio hasta el 1 de febrero de 2003; ese día, durante la reentrada en la atmósfera, la nave se desintegró causando la muerte de sus siete tripulantes.

Aquel Proyecto sobrepasó a la NASA que se vio sometida a enormes presiones para mantener el proyecto de lanzamientos de las lanzaderas que, como todos conocemos ahora, fue apresurado a pesar de las muchas dificultades técnicas. Estas circunstancias estarían en la base del accidente del Challenger que nos sobrecogió a todos.

Está claro que la imagren de arriba nos producía otra impresión, nos transmite poderío y seguridad. Sin embargo, tampoco el sistema fue el idóneo para lo que buscamos, lo que queremos, lo que necesitamos pero, pensar en viajes espaciales tripulados… ¡No es ninguna bagatela!

El accidente del transbordador espacial Challenger se produjo el 28 de enero de 1986. La Imagen de la desintegración del Challenger, tras 73 segundos de haber iniciado su viaje permanece en la mente de todos los que, en directo pudimos contemplar tan fatídico suceso. Las juntas fallaron debido principalmente a la sobrecompresión repetida durante el montaje y que las bajas temperaturas agravaron aún más. Esta anomalía fue advertida por los ingenieros de Morton Thiokol, los fabricantes de las partes del impulsor, se advirtió a la NASA, pero por presión de la misma NASA los ingenieros de Morton Thiokol cedieron y autorizaron el despegue.

El Discovery asciende por el cielo al inicio de la STS-31, mientras, por primera vez desde 1986, el segundo transbordador, el Columbia, espera su turno para ser lanzado. Cuando se lanzó el Hubble al espacio la Humanidad emprendió el camino hacia el verdadero conocimiento del Universo lejano.

Ya situado en orbita, el Hubble durante su despliegue.

Ya situado en su preciso lugar, pudo realizar el trabajo para el que fue construido y, su rentabilidad -a pesar de las protestas de muchos- no tiene dudas.

El lanzamiento del Telescopio más rentable hasta el momento que nos ha podido llevar en un viaje hasta el espacio profundo y enseñarnos galaxias que vivieron hace doce mil millones de años, es decir, muy cercanas en el tiempo, al nacimiento del Universo mismo. Con el Hubble, hemos captado imágenes de impable precio al poder localizar y ver objetos antes misteriores como púlsares, estrellas de neutrones y enanas blancas, Agujeros negros y Quasares situados en el centro de galaxias activas. No digamos de rica diversidad de la familia de Nebulosas y de algunas explosiones supernocas.

Todo eso formará parte de nuestro vagaje intelectual cuando un día lejano en el futuro, tengamos esas naves idóneas para poder hacer (ahora sí) esos viajes a otros mundos que ahora tanto añoramos y que, de ninguna manera estamos capacitados a realizar por falta de medios tecnologícos y humanos que no deben ser sacrificados, a cualquier precio: No a los viajes de Ida sin vuelta.

El astrónomo suizo Michel Mayor. / Uly Martín (EL PAÍS)

La existencia de mundos fuera del sistema solar era una fantasía de muchos y una posibilidad (con algún indicio astronómico) para los científicos. Desde 1995, esa idea, los planetas extrasolares, es una realidad. Fueron el astrónomo suizo Michel Mayor y su entonces joven colaborador Didier Queloz los descubridores del primer cuerpo de este tipo, 51 Pegasi, en órbita de otra estrella, y se abrió así un nuevo campo de investigación muy fecundo: más de 750 planetas ya identificados y el conocimiento sobre cómo se forman y evolucionan los sistemas planetarios en el universo. Mayor y Queloz han recibido este año el Premio Fronteras del Conocimiento en Ciencias Básicas de la Fundación BBVA.

Mayor, a sus 70 años, profesor —ahora emérito— de la Universidad de Berna, sigue investigando en primera fila sobre los planetas extrasolares, a los que llegó desde su formación como astrofísico teórico y sus investigaciones sobre los brazos de las galaxias espirales. Lo definitivo, dice, fue la puesta a punto de un método de detección indirecta de esos planetas mediante la observación sutil de los movimientos que inducen gravitatoriamente en los astros que orbitan.

Cuando es preguntado sobre vida y otros mundos, el profesor nos dice:

“El hombre fue a la Luna y tardó unos tres días. Siendo muy optimistas, el planeta extrasolar habitable más próximo estaría a unos 30 años luz, es decir, 1.000 millones de veces más lejos que la Luna, así que se tardaría muchísimo. Cabe pensar en nuevas tecnologías para viajar más rápido, pero el coste energético sería descomunal, algo completamente loco, y viajar a una velocidad cercana a la de la luz… En realidad es un problema de leyes físicas, no de tecnología. Así que visitar esos mundos es impensable porque están muy lejos. Para aprender algo de ellos nos queda observarlos con telescopios.”

Acabábamos de descubrir (como aquel que dice) que el Universo no terminaba en los límites de la Vía Láctea, sino que se había ampliado hasta el “infinito”, con galaxias y objetos cada vez más extraños. Sólo en el horizonte del Hubble se contabilizan 500 millones de galaxias. Y los descubrimientos continúan: desde el centro galáctico se observa un chorro de materia que se eleva más de 3.000 a.l. perpendicular al plano galáctico; se observan objetos como Alfa Cygni, que emite una energía radial equivalente a diez millones de veces la emitida por una galaxia como Andrómeda; se estudian los cuásares, que a veces parecen mas cercanos de lo que sugieren las mediciones del efecto Doppler; se habla de efectos de perspectiva que podrían falsear las conclusiones… Y nos asalta una batería de hipótesis, observaciones, nuevas hipótesis, nuevas observaciones y, nuevas dudas…

Todavía no se ha hallado una respuesta cierta y global. Un número cada vez mayor de investigadores está buscándola en miles de direcciones. De esta forma se elaboran nuevos modelos de estrellas, galaxias y objetos celestes que quizá sólo la fantasía matemática de los investigadores podían concretar: nacen los agujeros negros, estrellas de Quarks, los universos de espuma, las cadenas…

Todos esos conocimientos que poco a poco vamos atesorando, serán la base del conocimiento que nos posibilitará en el futuro, llegar más lejos y m,ás rápido a lugares que ahora nos resultan sólo un sueño, toda vez que, poco más de medio siglo de experiencias en viajes espaciales, viene a ser como nada, simplemente son los conocimientos básicos para mayore sempresasque aún quedan muy lejos de nuestro alcance.

Viajar hoy al mismo planeta Marte, queda fuera de nuestro alcance y enviamos sondas y naves que nos cuentan lo que allí pasa preparando el viaje. Un viaje largamente solado por mchos que, cuando han solicitado voluntarios se presentaron a miles. Sin embargo, por el momento, el viaje sería de irás y no volverás, lo cual, al no ser de recibo, impide que se realice ni ahora ni dentro de 5 o 10 años. Son muchas las medidas de segiridad y de tecnologías nuevas que habrá que tener para poder, al fín, visitar y estacionarnos en Marte.

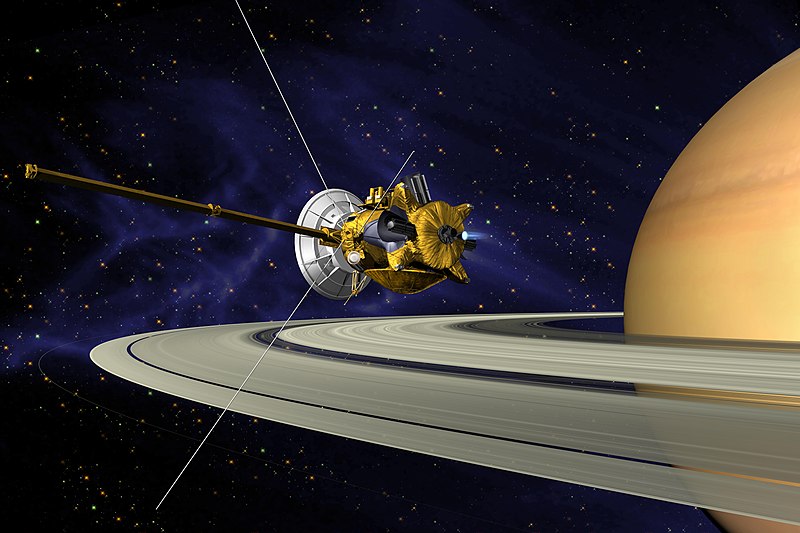

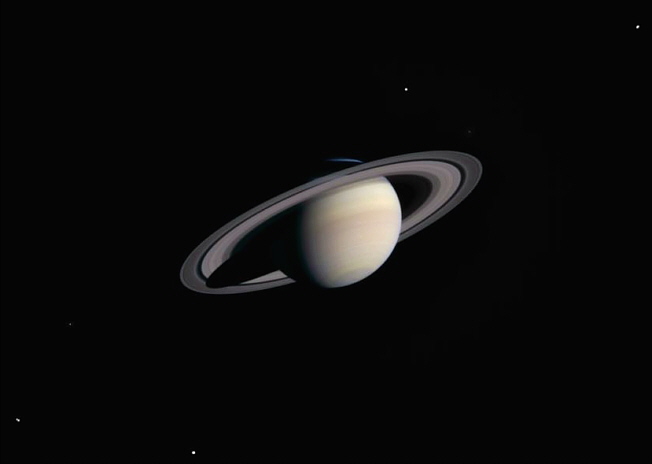

Un Proyecto que ha pasado todas las pruebas y, comparándo el coste con su rentabilidad… ¡Los beneficios son infinitamente superiores al esfuerzo realizado! Y, con la gran cantidad de conocimiento que nos ha podido sumistrar de Saturno, Titan y otras lunas y de la región en general, nos ha facilitado el saber de lo que en estos lugares se gesta y como se comportan los planetas gaseosos y los pequeños planetas que, como Titán, podrían ser una fuente de sopresas en un futuro no muy lejano.

Posiblemente, así veríamos Saturno desde Titán

Repetir aquí escenas y lugares de lo ya conseguido, por lo muy visto y manoseado en lugares como este, prefiero dejarlo de lado y, pasar de manera directa a ese futuro que presentimos y que, desde luego, será la consecuencia de todos estos “pilares” que posibilitan la construcción de ese primer “edificio del viaje espacial” que literalmente se pueda ganar ese nombre al ser un vuelo tripulado por seres de nuestra especie.

Lanzamiento de la histórica misión Mercury 6 en la que John Glenn se convirtió en el primer estadounidense en orbitar la Tierra. Dentro de unas décadas, estas imágenes nos parecerán tan viejas que nos recordaran aquella legendaria conquista del Oeste con sus carretas. Las futuras modernas naves espaciales no tendrán nada que ver con estos antiguos cohetes de los primeros pasos por el espacio cercano.

Ahora, tratemos de imaginar que a princpios del próximo siglo, podemos construir una nave espacial-ciudad que pudiera estar preparada para alojar a familiar enteras, con sus escuelas y fábricas, sus centros de energías, sus hospitales y todo lo necesario para que, como aquí en la Tierra, tengan, durante el viaje todas las necesidades cubiertas. Además, para esas fechas, ya no son problema ni la gravedad artificial ni tampoco el repeler, mediante campos magnéticos alreddor de la Nave, a todas esas partículas nosivas provenientes del Sol y de otras estrellas.

Habremos entrado en otra era y se podrán leer cosas como…

“Ahora sí, parece que todo está bien controlado para poder realizar el sueño largamente retenido de viajar a otros mundos de fuera de nuestro propio Sistema Solar y, hecha una selección lógica, se ha elegido a epsilón Eridani es una estrella de la constelación de Eridanus. Está situada a unos 10,5 años-luz de la Tierra, siendo una de las más próximas al Sistema solar y, la tercera más próxima visible a simple vista. Es una estrella de la secuencia principal, de Tipo Espectral K2, muy parecida al Sol, con una masa de 0,83 masas solares, un radio de 0,895 radios solares y una luminosidad estelar de 0,28 veces la solar. Su espectro óptico es muy variable, con muchas líneas espectrales de emisión. Tiene un campo magnético muy fuerte que gira aproximadamente cada 11 días. Su período de rotación es de 12 días. La razón para todo ello es su juventud: tiene sólo 600 millones de años cuando nuestro Sol tiene 4600 millones. Un lugar interesante para el estudio y, por los alrededores, pueden haber planetas habitables.”

Lo cierto es que la expedición con todos los honores y en presencia de Autoridades y Público en General, partío para aquella aventura -algo incierta- el 4 de Julio de 2.050 cargado de toda la ilusión de un proyecto magno puede transmitir a cada uno de los enamorados respondsables del proyecvto al que entregaron su vida misma y la vida de sus familia. Que estimaban garantizadas dado que, también habían buscado el remedio para soportar esas velocidades relativistas sin que el cuerpo humano, padeciría rémoras dejadas por esos cambios de inusitadas velocidades.

Así que la Nave salió y, desde luego, nuestras disciplinas científicas no se quedaron paradas; La Física, la Biofísica y Astrofícia, la misma Astronomía, la Biología molecular y las Matemáticas, así como todas las teorías en marcha que van más alla de las cuerdas una vez conquistada la energía de Planck que pudo facilitar ese viaje a Epsilon Eridani, ahora las fluctuaciones de vacío no tienen secreto y se descubrió por fin, que “materia oscura” como el “eter” no existía y que un apéndice de la gravedad, era el causante de todo lo que podíamos observar y que no entraba en la normalidad de lo que sabíamos. Una constante cosmológica algo dirente a la de Einstein estaba allí y hacía que el espacio se expandiera.

Nos creíamos los dueños del átomo y también de las galaxias y, como si de dioses se tratara, “jugábamos con lo grande y con lo pequeño para tratar de entrar en sus entrañas, conocer sus contenidos y saber, de una vez por toda, esos secretos de la materia que nos resistieron durante años. Ahora, era posible el viaje, a más de 10 años- luz de la Tierra.

Una cosa que, aunque podía ser previsible, no había sido prevista: Veámos, la Nave ciudad construida tal efecto, viajaria a 300.000 kilómetros por hora, máxima velocidad conseguida hasta esa fecha, y, recorrer más de 10 años-luz a esa distancia implicaría un tiempo considerable de unos 9 460 730 472 580,8 km por año viajando a 299.792,458 Km/s. Lo que nos distanciaria de la velocidad de la luz a una distancia abismal, es decir, sólo podríamos viajar a la décima parte de la velocidad de la luz.

A pesar de todo eso y creyendonos en posesión del dominio de los átomos y las galaxias, el viaje partió hacia su futuro en Epsilon Eridani y todos, sin ecxcepción, estaban tan contentos como ilusionados al partir sin tener en cuenta que, en tan largo viaje muchas cosas podrían pasar. A pesar de que la tripulación sería crionizada por turnos, seguramente no llegarían todos los que salieran de la Tierra hacia aquella otra “Tierra” prometida.

Sólo habían pasado 25 años desde la partida de la Nave y, en la Tierra, sucedieron cosas que, aunque podían haber sido previstas, estas cosas surgen cuando tienen que surgir , de manera inesperada, cuando algún físico descubre la manera de poder obtener de la Naturaleza, aquello que ésta le ofrece y que antes, nadie había podido observar ni comprender que allí estaba a disposición de todos, aquella maravilla que, sin tene que doblegar la velocidad de la luz -cosa que es imposible-, sí, podía, sin embargo, burlarla para poder llegar a lugares que, de la otra manera, necesitarían años, milenios y millones de años para poder conseguirlo viajando a la relativimente lenta, velocidad de la luz si la ponemos en el contexto del Universo de cuyas distancias ya sabemos algo.

Así que, una vez perfeccionado, en unos pocos años el viaje a través del Hiperespacio, resultó que se enviaron naves y demás elementos para poder instalarse en el planeta objeto del destino de los Viajeros que, cuando llegaron muchos, muchos, muchísimos años más tarde, se pudieron encontrar con el trabajo terminado y aterrizaron en las afueras de la más hermosa ciudad futurista que podían haber imaginado.

Cada logro tiene su tiempo y, si queremos hacer las cosas antes de tiempo… ¡Las consecuencias no son buenas! Los del LHC, deberían tener esa premisa muy encuenta, no sería bueno tontear con un “juguete” tan peligroso, sobre todo, sin sabar de antemano qué resultados podríamos obtener de nuestros jueguecitos.

Con todo esto quiero significar que, a veces, no conviene correr tanto, hay que dar tiempo al tiepo al tiempo. Las cosas no llegan por que sí, sino que vienen a nuestras mentes, a nuestra comprendión, cuando estas están preparadas para utilizar dicho conocimiento. El precipitarnos nos puede llevar a situaciuones que como la que aquí constamos, podían haber sido evitadas en vidas, en trabajo y esfuerzo y en mucho tiempo perdido. Mejor esperar los momentos idóneos para cada codsa que, por otra parte, no nos resultará fácil.

emilio silvera

Sep

20

Lo que se cree sobre el Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo, El Universo misterioso ~

Clasificado en El Universo, El Universo misterioso ~

Comments (3)

Comments (3)

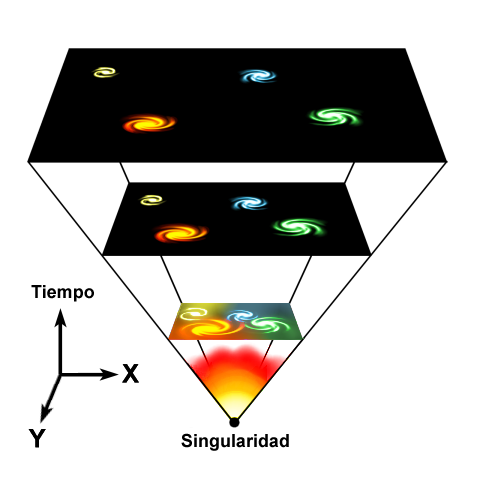

Según la teoría del Big Bang, el Universo se originó en una singularidad espaciotemporal de densidad infinita matemáticamente paradójica. El universo se ha expandido desde entonces, por lo que los objetos astrofísicos se han alejado unos respecto de los otros. Es decir, lo que se ha expandido ha sido el espacio, con lo cual, no se viola el principio de la relatividad de la velocidad de la luz, toda vez que, los objetos, nunca pudieron sobrepasar dicha velocidad.

El Universo

“El universo es la totalidad del espacio y del tiempo, de todas las formas de la materia, la energía y el impulso, las leyes y constantes físicas que las gobiernan. Sin embargo, el término también se utiliza en sentidos contextuales ligeramente diferentes y alude a conceptos como cosmos, mundo o naturaleza.

Observaciones astronómicas indican que el universo tiene una edad de 13,73 ± 0,12 millardos de años (entre 13 730 y 13 810 millones de años) y por lo menos 93 000 millones de años luz de extensión.2 El evento que dio inicio al universo se denomina Big Bang. Se denomina Big-Bang a la singularidad que creó el universo. Después del Big Bang, el universo comenzó a expandirse para llegar a su condición actual, y continúa haciéndolo.

Debido a que, según la teoría de la relatividad especial, la materia no puede moverse a una velocidad superior a la velocidad de la luz, puede parecer paradójico que dos objetos del universo puedan haberse separado 93 mil millones de años luz en un tiempo de únicamente 13 mil millones de años; sin embargo, esta separación no entra en conflicto con la teoría de la relatividad general, ya que ésta sólo afecta al movimiento en el espacio, pero no al espacio mismo, que puede extenderse a un ritmo superior, no limitado por la velocidad de la luz. Por lo tanto, dos galaxias pueden separarse una de la otra más rápidamente que la velocidad de la luz si es el espacio entre ellas el que se dilata.

La radiación de fondo de microondas

Mediciones sobre la distribución espacial y el desplazamiento hacia el rojo (redshift) de galaxias distantes, la radiación cósmica de fondo de microondas, y los porcentajes relativos de los elementos químicos más ligeros, apoyan la teoría de la expansión del espacio, y más en general, la teoría del Big Bang, que propone que el universo en sí se creó en un momento específico en el pasado.

Observaciones recientes han demostrado que esta expansión se está acelerando, y que la mayor parte de la materia y la energía en el universo son las denominadas materia oscura y energía oscura, la materia ordinaria (barionica), solo representaría algo más del 5 % del total3 (véanse materia oscura y energía oscura).

Los experimentos sugieren que el universo se ha regido por las mismas leyes físicas, constantes a lo largo de su extensión e historia. Es homogéneo e isotrópico. La fuerza dominante en distancias cósmicas es la gravedad, y la relatividad general es actualmente la teoría más exacta para describirla. Las otras tres fuerzas fundamentales, y las partículas en las que actúan, son descritas por el Modelo Estándar. El universo tiene por lo menos tres dimensiones de espacio y una de tiempo, aunque experimentalmente no se pueden descartar dimensiones adicionales muy pequeñas. El espacio-tiempo parece estar conectado de forma sencilla, y el espacio tiene una curvatura media muy pequeña o incluso nula, de manera que la geometría euclidiana es, como norma general, exacta en todo el universo.

La ciencia modeliza el universo como un sistema cerrado que contiene energía y materia adscritas al espacio-tiempo y que se rige fundamentalmente por principios causales.

Basándose en observaciones del universo observable, los físicos intentan describir el continuo espacio-tiempo en que nos encontramos, junto con toda la materia y energía existentes en él. Su estudio, en las mayores escalas, es el objeto de la cosmología, disciplina basada en la astronomía y la física, en la cual se describen todos los aspectos de este universo con sus fenómenos.

La teoría actualmente más aceptada sobre la formación del universo, fue teorizada por el canónigo belga Lemaître, a partir de las ecuaciones de Albert Einstein. Lemaitre concluyó (en oposición a lo que pensaba Einstein), que el universo no era estacionario, que el universo tenía un origen. Es el modelo del Big Bang, que describe la expansión del espacio-tiempo a partir de una singularidad espaciotemporal. El universo experimentó un rápido periodo de inflación cósmica que arrasó todas las irregularidades iniciales. A partir de entonces el universo se expandió y se convirtió en estable, más frío y menos denso. Las variaciones menores en la distribución de la masa dieron como resultado la segregación fractal en porciones, que se encuentran en el universo actual como cúmulos de galaxias.

En cuanto a su destino final, las pruebas actuales parecen apoyar las teorías de la expansión permanente del universo (Big Freeze ó Big Rip, Gran Desgarro), que nos indica que la expansión misma del espacio, provocará que llegará un punto en que los átomos mismos se separarán en partículas subatómicas. Otros futuros posibles que se barajaron, especulaban que la materia oscura podría ejercer la fuerza de gravedad suficiente para detener la expansión y hacer que toda la materia se comprima nuevamente; algo a lo que los científicos denominan el Big Crunch o la Gran Implosión, pero las últimas observaciones van en la dirección del gran desgarro.”

Ahora, Roger Penrose, de la Universidad de Oxford y uno de los físicos más brillantes de la actualidad, cree haber detectado “atisbos” de la existencia de otro universo. Uno que existía antes que el Big Bang. Lo cual pone, literalmente, patas arriba las teorías cosmológicas actuales. En un artículo recién publicado en ArXiv.org, Penrose explica que ha llegado a esa extraordinaria conclusión tras analizar, en los datos del satélite WMAP, ciertos patrones circulares que aparecen en el fondo de microondas cósmico y que sugieren, ni más ni menos, que el espacio y el tiempo no empezaron a existir en el Big Bang, sino que nuestro universo existe en un ciclo continuo de “rebotes” que él llama “eones”.

Según Penrose, lo que actualmente percibimos como nuestro universo, no es más que uno de esos eones. Hubo otros antes del Big Bang y habrá otros después. Unas ideas que se oponen frontalmente al modelo cosmológico más extendido en la actualidad: el de universo inflacionario. Según dicho modelo, el universo empezó en un punto de densidad infinita (el Big Bang) hace aproximadamente 13.700 millones de años, se expandió de forma extremadamente rápida durante una fracción de segundo, y ha continuado expandiéndose mucho más lentamente desde entonces, un tiempo durante el cual han ido surgiendo galaxias, estrellas, planetas y, finalmente, los seres humanos.

El tiempo antes del Big Bang Penrose, sin embargo, está convencido de que el modelo inflacionario no cuadra con el bajísimo estado de entropía que hizo posible el nacimiento del universo tal y como lo conocemos. Y tampoco cree que el espacio y el tiempo empezaran a existir en el momento del Big Bang, sino que el Big Bang fue, de hecho, sólo uno entre una serie de muchos acontecimientos similares, con cada uno marcando el inicio de un nuevo “eón” en la historia del universo. Las teorías de Penrose implican que, en un futuro lejano, el universo volverá, de alguna manera, a tener las condiciones que hicieron posible el Big Bang. Según el físico, en esos momentos la geometría del universo será suave y lineal, muy diferente a como es ahora, con abundantes picos y discontinuidades.

«La materia oscura puede ser ‘otra dimensión’, tal vez incluso un importante sistema de transporte galáctico. […]

En Interstellar, la película de ciencia ficción de Christopher Nolan, los protagonistas cruzan un agujero de gusano hallado fortuitamente en las cercanías de Saturno que permite viajar a varios mundos potencialmente habitables fuera del Sistema Solar. A veces pienso que, hablar de esto es casi lo mismo que hablar de cómo se creó en el Universo, en ambos casos, existen espacios oscuros que nos alejan de la posible verdad de lo que pudo ocurrir o de lo que podrá ser posible.

Esta futura continuidad de forma, afirma, permitirá una transición desde el final del actual eón, con un universo muy expandido e infinitamente grande, al inicio del siguiente, cuando de nuevo se hará infinitamente pequeño para estallar formando el siguiente Big Bang. Pruebas en el fondo cósmico El físico asegura que ha encontrado pruebas que sostienen lo que dice. Y que esas pruebas están en el fondo cósmico de microondas, los ecos lejanos del propio Big Bang, una especie de rescoldo de aquella gran explosión que es detectable, hoy, en cualquier punto del universo. Analizando, junto a su colega armenio Vahe Gurzadyan, siete años de datos del satélite WMAP, que está diseñado precisamente para medir el fondo de microondas, Penrose ha detectado con claridad una serie de “círculos concéntricos”, regiones en el cielo de microondas en los que el rango de temperatura de la radiación es notablemente menor que en otros sitios. Son precisamente esos círculos los que nos permiten “ver” a través del Big Bang, vislumbrando el eón que que existió anteriormente. Los círculos, dicen Penrose y Gurzadyan, son marcas dejadas en nuestro eón por las ondulaciones esféricas de las ondas gravitatorias que se generaron cuando los agujeros negros colisionaron en el eón anterior. Y estos círculos, sostienen, suponen un serio problema para la teoría inflacionaria, según la cual la distribución de las variaciones de temperatura en el cielo deberían ser Gaussianas, o aleatorias, en lugar de tener estructuras discernibles en su interior. Si Penrose tiene razón, cambiará por completo la forma que tenemos de percibir el universo en que vivimos, su nacimiento y su destino final.

Amigos míos, lo cierto es que, seguros lo que se dice seguros… ¡No lo podemos estar! Ya que, los modelos actuales del Universo, aunque algunos, como el Big Bang, parece que se puede acercar a esa realidad que buscamos, lo cierto es que, nos deja muchas zonas oscuras y, afirmar nada podemos.

emilio silvera

Sep

20

La simetría CP y otros aspectos de la Física

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

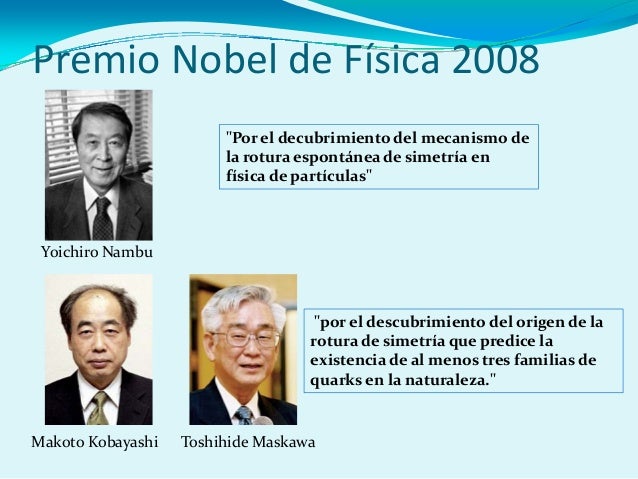

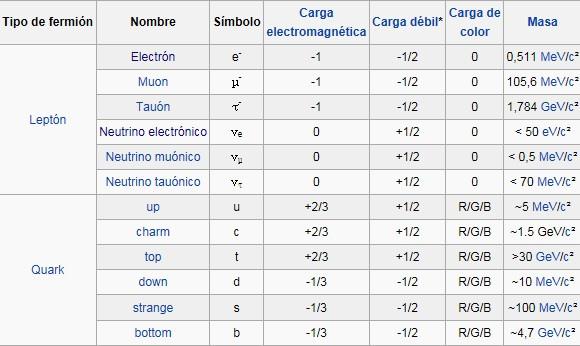

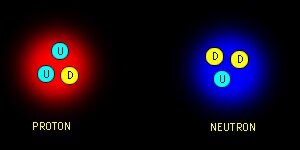

Los quarks al otro lado del espejo. Científicos del Laboratorio Nacional Jefferson Lab (EEUU) han verificado la rotura de la simetría de paridad (también llamada simetría del espejo) en los quarks mediante el bombardeo de núcleos de deuterio con electrones de alta energía. Los núcleos de deuterio están formados por un protón y un neutrón, es decir, por tres quarks arriba y tres quarks abajo. La dispersión inelástica entre un electrón y un quark, es decir, su colisión, está mediada por la interacción electrodébil, tanto por la fuerza electromagnética como por la fuerza débil. Esta última es la única interacción fundamental que viola la simetría de paridad.

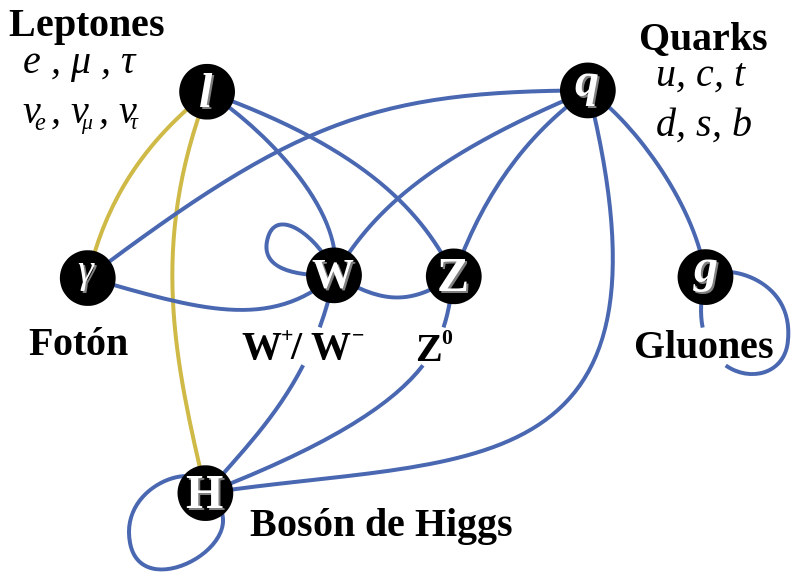

Tenemos que saber cómo la violación de la simetría CP (el proceso que originó la materia) aparece, y, lo que es más importante, hemos de introducir un nuevo fenómeno, al que llamamos campo de Higgs, para preservar la coherencia matemática del modelo estándar. La idea de Higgs, y su partícula asociada, el bosón de Higgs, cuenta en todos los problemas que he mencionado antes. Parece, con tantos parámetros imprecisos (19) que, el modelo estándar se mueve bajo nuestros pies.

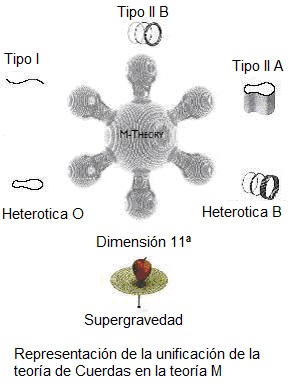

Entre los teóricos, el casamiento de la relatividad general y la teoría cuántica es el problema central de la física moderna. A los esfuerzos teóricos que se realizan con ese propósito se les llama “supergravedad”, “súpersimetría”, “supercuerdas” “teoría M” o, en último caso, “teoría de todo o gran teoría unificada”.

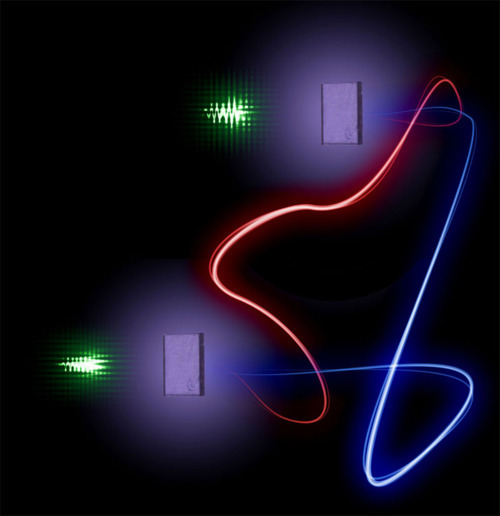

La Física nos lleva de vez en cuando a realizar viajes alucinantes. Se ha conseguido relacionar y vibrar a dos diamantes en el proceso conocido como entrelazamiento cuántico. El misterioso proceso, al que el propio Eisntein no supo darle comprensión completa, supone el mayor avance la fecha y abre las puertas de la computación cuántica. que nos hagamos una idea del hallazgo, en 1935 Einstein lo llegó a denominar la “acción fantasmal a distancia”. Un efecto extraño en donde se conecta un objeto con otro de manera que incluso si están separados por grandes distancias, una acción realizada en uno de los objetos afecta al otro.

Ahí tenemos unas matemáticas exóticas que ponen de punta hasta los pelos de las cejas de algunos de los mejores matemáticos del mundo (¿y Perelman? ¿Por qué nos se ha implicado?). Hablan de 10, 11 y 26 dimensiones, siempre, todas ellas espaciales menos una que es la temporal. Vivimos en cuatro: tres de espacio (este-oeste, norte-sur y arriba-abajo) y una temporal. No podemos, ni sabemos o no es posible instruir, en nuestro cerebro (también tridimensional), ver más dimensiones. Pero llegaron Kaluza y Klein y compactaron, en la longitud de Planck las dimensiones que no podíamos ver. ¡Problema solucionado! Pero se sigue hablando de partículas supersimétricas.

¿Quién puede ir a la longitud de Planck para verlas?

La puerta de las dimensiones más altas quedó abierta y, a los teóricos, se les regaló una herramienta maravillosa. En el Hiperespacio, todo es posible. Hasta el matrimonio de la relatividad general y la mecánica cuántica, allí si es posible encontrar esa soñada teoría de la Gravedad cuántica.

Así que, los teóricos, se han embarcado a la búsqueda de un objetivo audaz: buscan una teoría que describa la simplicidad primigenia que reinaba en el intento calor del universo en sus primeros tiempos, una teoría carente de parámetros, donde estén presentes todas las respuestas. Todo debe ser contestado a partir de una ecuación básica.

¿Dónde radica el problema?

El problema está en que la única teoría candidata no tiene conexión directa con el mundo de la observación, o no lo tiene todavía si queremos expresarnos con propiedad. La energía necesaria para ello, no la tiene ni la nueva capacidad energético del acelerador de partículas LHC . Ni sumando todos los aceleradores de partículas de nuestro mundo, podríamos lograr una energía de Planck (1019 GeV), que sería necesaria para poder llegar hasta las cuerdas vibrantes de la Teoría. Ni en las próximas generaciones seremos capaces de poder utilizar tal energía.

La verdad es que, la teoría que ahora tenemos, el Modelo Estándar, concuerda de manera exacta con todos los datos a bajas energías y contesta cosas sin sentido a altas energías. Sabemos sobre las partíoculas elementales que conforman la materia bariónica, es decir, los átomos que se juntan para formar moléculas, sustancias y cuerpos… ¡La materia! Pero, no sabemos si, pudiera haber algo más elemental aún más allá de los Quarks y, ese algo, pudieran ser esas cuerdas vibrantes que no tenemos capacidad de alcanzar.

¡Necesitamos algo más avanzado!

Se ha dicho que la función de la partícula de Higgs es la de dar masa a las Cuando su autor lanzó la idea al mundo, resultó además de nueva muy extraña. El secreto de todo radica en conseguir la simplicidad: el átomo resulto ser complejo lleno de esas infinitesimales partículas electromagnéticas que bautizamos con el nombre de electrones, resultó que tenía un núcleo que contenía, a pesar de ser tan pequeño, casi toda la masa del átomo. El núcleo, tan pequeño, estaba compuesto de otros objetos más pequeños aún, los quarks que estaban instalados en nubes de otras partículas llamadas gluones y, ahora, queremos continuar profundizando, sospechamos, que después de los quarks puede haber algo más.

Con 7 TeV ha sido suficiente para encontrar la famosa partícula de Higgs pero…

Bueno, la idea nueva que surgió es que el espacio entero contiene un campo, el campo de Higgs, que impregna el vacío y es el mismo en todas partes. Es decir, que si miramos a las estrellas en una noche clara estamos mirando el campo de Higgs. Las partículas influidas por este campo, toman masa. Esto no es por sí mismo destacable, pues las partículas pueden tomar energía de los campos (gauge) de los que hemos comentado, del campo gravitatorio o del electromagnético. Si llevamos un bloque de plomo a lo alto de la Torre Eiffel, el bloque adquiriría energía potencial a causa de la alteración de su posición en el campo gravitatorio de la Tierra.

Como E=mc2, ese aumento de la energía potencial equivale a un aumento de la masa, en este caso la masa del Sistema Tierra-bloque de plomo. Aquí hemos de añadirle amablemente un poco de complejidad a la venerable ecuación de Einstein. La masa, m, tiene en realidad dos partes. Una es la masa en reposo, m0, la que se mide en el laboratorio cuando la partícula está en reposo. La partícula adquiere la otra parte de la masa en virtud de su movimiento (como los protones en el acelerador de partículas, o los muones, que aumentan varias veces su masa cuando son lanzados a velocidades cercanas a c) o en virtud de su energía potencial de campo. Vemos una dinámica similar en los núcleos atómicos. Por ejemplo, si separamos el protón y el neutrón que componen un núcleo de deuterio, la suma de las masas aumenta.

Peor la energía potencial tomada del campo de Higgs difiere en varios aspectos de la acción de los campos familiares. La masa tomada de Higgs es en realidad masa en reposo. De hecho, en la que quizá sea la versión más apasionante de la teoría del campo de Higgs, éste genera toda la masa en reposo. Otra diferencia es que la cantidad de masa que se traga del campo es distinta para las distintas partículas.

Los teóricos dicen que las masas de las partículas de nuestro modelo estándar miden con qué intensidad se acoplan éstas al campo de Higgs.

La influencia de Higgs en las masas de los quarks y de los leptones, nos recuerda el descubrimiento por Pietez Zeeman, en 1.896, de la división de los niveles de energía de un electrón cuando se aplica un campo magnético al átomo. El campo (que representa metafóricamente el papel de Higgs) rompe la simetría del espacio de la que el electrón disfrutaba.

Hasta ahora no tenemos ni idea de que reglas controlan los incrementos de masa generados por el Higgs (de ahí la expectación creada por el nuevo acelerador de partículas LHC). Pero el problema es irritante: ¿por qué sólo esas masas -Las masas de los W+, W–, y Zº, y el up, el down, el encanto, el extraño, el top y el bottom, así como los leptones – que no forman ningún patrón obvio?

Las masas van de la del electrón 0’0005 GeV, a la del top, que tiene que ser mayor que 91 GeV. Deberíamos recordar que esta extraña idea (el Higgs) se empleó con mucho éxito para formular la teoría electrodébil (Weinberg-salam). Allí se propuso el campo de Higgs como una forma de ocultar la unidad de las fuerzas electromagnéticas y débiles. En la unidad hay cuatro partículas mensajeras sin masa -los W+, W–, Zº y fotón que llevan la fuerza electrodébil. Además está el campo de Higgs, y, rápidamente, los W y Z chupan la esencia de Higgs y se hacen pesados; el fotón permanece intacto. La fuerza electrodébil se fragmenta en la débil (débil porque los mensajeros son muy gordos) y la electromagnética, cuyas propiedades determina el fotón, carente de masa. La simetría se rompe espontáneamente, dicen los teóricos. Prefiero la descripción según la cual el Higgs oculta la simetría con su poder dador de masa.

Las masas de los W y el Z se predijeron con éxito a partir de los parámetros de la teoría electrodébil. Y las relajadas sonrisas de los físicos teóricos nos recuerdan que ^t Hooft y Veltman dejaron sentado que la teoría entera esta libre de infinitos.

Todos los intentos y los esfuerzos por hallar una pista del cuál era el origen de la masa fallaron. Feynman escribió su famosa pregunta: “¿Por qué pesa el muón?”. Ahora, por lo menos, tenemos una respuesta parcial, en absoluto completa. Una vez potente y segura nos dice: “!Higgs¡” Durante más de 60 años los físicos experimentadores se rompieron la cabeza con el origen de la masa, y ahora el campo Higgs presenta el problema en un contexto nuevo; no se trata sólo del muón. Proporciona, por lo menos, una fuente común para todas las masas. La nueva pregunta feynmariana podría ser: ¿Cómo determina el campo de Higgs la secuencia de masas, aparentemente sin patrón, que da a las partículas de la matería?

La variación de la masa con el estado de movimiento, el cambio de masa con la configuración del sistema y el que algunas partículas (el fotón seguramente y los neutrinos posiblemente) tengan masa en reposo nula son tres hechos que ponen entre dicho que el concepto de masa sea una tributo fundamental de la materia. Habrá que recordar aquel cálculo de la masa que daba infinito y nunca pudimos resolver; los físicos sólo se deshicieron del “renormalizándolo”, ese truco matemático que emplean cuando no saben hacerlo bien.

Ese es el problema de trasfondo con el que tenemos que encarar el problema de los quarks, los leptones y los vehículos de las fuerzas, que se diferencian por sus masas. Hace que la historia de Higgs se tenga en pie: la masa no es una propiedad intrinseca de las partículas, sino una propiedad adquirida por la interacción de las partículas y su entorno.

La idea de que la masa no es intrinseca como la carga o el espín resulta aún más plausible por la idílica idea de que todos los quarks y fotones tendrían masa cero. En ese caso, obedecerían a una simetría satisfactoria, la quiral, en laque los espines estarían asociados para siempre con su dirección de movimiento. Pero ese idilio queda oculto por el fenómeno de Higgs.

¡Ah, una cosa más! Hemos hablado de los bosones gauge y de su espín de una unidad; hemos comentado también las partículas fermiónicas de la materia (espin de media unidad). ¿Cuál es el pelaje de Higgs? Es un bosón de espin cero. El espín supone una direccionalidad en el espacio, pero el campo de Higgs de masa a los objetos dondequiera que estén y sin direccionalidad. Al Higgs se le llama a veces “bosón escalar” [sin dirección] por esa razón.

Basta con cambiar un quark tipo U a uno tipo D.

Pues justamente esto es lo que ocurre en la naturaleza cuando entra en acció la fuerzxa nuclear débil. Un quark tipo U cambia a uno tipo D por medio de la interacción débil así

Las otras dos partículas que salen son un anti-electrón y un neutrino. Este mismo proceso es el responsable del decaimiento radiactivo de algunos núcleos atómicos. Cuando un neutrón se convierte en un protón en el decaimiento radiactivo de un núcleo, aparece un electrón y un neutrino. Este es el origen de la radiación beta (electrónes).

La interacción débil, recordareis, fue inventada por E.Fermin para describir la desintegración radiactiva de los núcleos, que era básicamente un fenómeno de poca energía, y a medida que la teoría de Fermi se desarrolló, llegó a ser muy precisa a la hora de predecir un enorme número de procesos en el dominio de energía de los 100 MeV. Así que ahora, con las nuevas tecnologías y energías del LHC, las esperanzas son enormes para, por fin, encontrar el bosón Higgs origen de la masa… y algunas cosas más.

Hay que responder montones de preguntas. ¿Cuáles son las propiedades de las partículas de Higgs y, lo que es más importante, cuál es su masa? ¿Cómo reconoceremos una si nos la encontramos en una colisión de LHC? ¿Cuántos tipos hay? ¿Genera el Higgs todas las masas, o solo las hace incrementarse? ¿Y, cómo podemos saber más al respecto? Como s su partícula, nos cabe esperar que la veamos ahora después de gastar más de 50.000 millones de euros en los elementos necesarios para ello.

También a los cosmólogos les fascina la idea de Higgs, pues casi se dieron de bruces con la necesidad de tener campos escalares que participasen en el complejo proceso de la expansión del Universo, añadiendo, pues, un peso más a la carga que ha de soportar el Higgs.

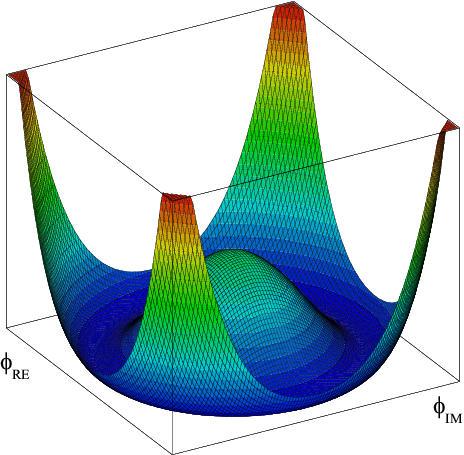

El campo de Higgs, tal y como se lo concibe ahora, se puede destruir con una energía grande, o temperaturas altas. Estas generan fluctuaciones cuánticas que neutralizan el campo de Higgs. Por lo tanto, el cuadro que las partículas y la cosmología pintan juntas de lo que un universo primitivo puso y de resplandeciente simetría es demasiado caliente para Higgs. Pero cuando la temperatura cae bajo los 10′5 grados kelvin o 100 GeV, el Higgs empieza a actuar y hace su generación de masas. Así por ejemplo, antes de Higgs teníamos unos W, Z y fotones sin masa y la fuerza electrodébil unificada.

El Universo se expande y se enfría, y entonces viene el Higgs (que engorda los W y Z, y por alguna razón ignora el fotón) y de ello resulta que la simetría electrodébil se rompe.

Tenemos entonces una interacción débil, transportada por los vehículos de la fuerza W+, W–, Z0, y por otra parte una interacción electromagnética, llevada por los fotones. Es como si para algunas partículas del campo de Higgs fuera una especie de aceite pesado a través del que se moviera con dificultad y que las hiciera parecer que tienen mucha masa. Para otras partículas, el Higgs es como el agua, y para otras, los fotones y quizá los neutrinos, es invisible.

De todas las maneras, es tanta la ignorancia que tenemos sobre el origen de la masa que, nos agarramos como a un clavo ardiendo el que se ahoga, en este caso, a la partícula de Higgs que, algunos, han llegado a llamar, de manera un poco exagerada:

¡La partícula Divina!

¡Ya veremos en que termina todo esto! Y que explicación se nos ofrece desde el CERN en cuanto al auténtico escenario que según ellos, existe en el Universo para que sea posible que las partículas tomen su masa de ese oceáno de Higgs, en el que, según nuestro amigo Ramón Márquez, las partículas se frenan al interaccionar con el mismo y toman su masa, el lo llama el “efecto frenado”.

Peter Higgs, de la Universidad de Edimburgo, introdujo la idea en la física de partículas. La utilizaron los teóricos steven Weinberg y Abdus Salam, que trabajaban por separado, para comprender como se convertía la unificada y simétrica fuerza electrodébil, transmitida por una feliz familia de cuatro partículas mensajeras de masa nula, en dos fuerzas muy diferentes: la QED con un fotón carente de masa y la interacción débil con sus W+, W– y Z0 de masa grande. Weinberg y Salam se apoyaron en los trabajos previos de Sheldon Glasgow, quien tras los pasos de Julian Schwinger, sabía sólo que había una teoría electrodébil unificada, coherente, pero no unió todos los detalles. Y estaban Jeffrey Goldstone y Martines Veltman y Gerard’t Hooft. También hay otras a los que había que mencionar, pero lo que siempre pasa, quedan en el olvido de manera muy injusta. Además, ¿Cuántos teóricos hacen falta para encender una bombilla?

La verdad es que, casi siempre, han hecho falta muchos. Recordemos el largo recorrido de los múltiples detalle sueltos y físicos que prepararon el terreno para que, llegara Einstein y pudiera, uniéndolo todos, exponer su teoría relativista. (Mach, Maxwell, Lorentz… y otros).

Sobre la idea de Peter Higgs, Veltman, uno de sus arquitectos, dice que es una alfombra bajo la que barremos nuestra ignorancia. Glasgow es menos amable y lo llamó retrete donde echamos las incoherencias de nuestras teorías actuales. La objeción principal: que no tenemos la menor prueba experimental.

Ahora, por fin la tenemos con el LHC, y ésta pega, se la traspasamos directamente a la teoría de supercuerdas y a la materia oscura que, de momento, están en la sombra y no brillan con luz propia, toda vez que ninguna de ellas ha podido ser verificada, es decir, no sabemos si el Universo atiende a lo que en ellas se predice.

El modelo estándar es lo bastante fuerte para decirnos que la partícula de Higgs de menor masa (podría haber muchas) debe “pesar” menos de 1 TeV. ¿Por qué? Si tiene más de 1 TeV, el modelo estándar se vuelve incoherente y tenemos la crisis de la unitariedad.

Después de todo esto, llego a la conclusión de que, el campo de Higgs, el modelo estándar y nuestra idea de cómo pudo surgir el Universo no dependen de que se encuentre el bosón de Higgso se averigue si realmente existe la materia oscura, Aunque sepamos llegar al fondo de la Teoría de Cuerdas y confirmarla, Poder crear esa Teoría cuántica de la Gravedad…Y, en fín, seguir descubriendo los muchos misterios que no nos dejan saber lo que el Universo es. Ahora, por fin, tenemos grandes aceleradores y Telescopisos con la energía necesaria y las condiciones tecnológicas suficientes para que nos muestre todo eso que queremos saber y nos digan dónde reside esa verdad que incansables perseguimos. Sin embargo, siempre seguiremos haciendo preguntas y siempre, también, serán insuficientes, los aparatos que podamos construir para que nos digan como es el Universo y cómo funciona la Naturaleza. Saberlo todo, nunca sabremos.

¡La confianza en nosotros mismos, no tiene límites! Pero, no siempre ha estado justificada.

emilio silvera

Totales: 77.907.756

Totales: 77.907.756 Conectados: 17

Conectados: 17