May

31

Nuestro Planeta: ¡Es tan complejo!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en La Tierra y su energía ~

Clasificado en La Tierra y su energía ~

Comments (0)

Comments (0)

Nuestro planeta, como nosotros mismos, es agua y luz

La biosfera y la hidrosfera están estrechamente relacionadas: el agua es el elemento esencial de todas las formas de vida, y la distribución del agua en el planeta (es decir, los límites de la hidrosfera) condiciona directamente la distribución de los organismos (los límites de la biosfera). El término biosfera, de reciente creación, indica el conjunto de zonas de la Tierra donde hay vida, y se circunscribe a una estrecha región de unos 20 Km de altura comprendida entre las cimas montañosas más elevadas y los fondos oceánicos más profundos. Sólo pueden hallarse formas de vida en la biosfera, donde las condiciones de temperatura, presión y humedad son adecuadas para las más diversas formas orgánicas de la Tierra.

En lo más hondo. Entorno de la sima Krubera en la que se halló el artrópodo.-DENIS PROVALOV

Un equipo de espeleólogos y científicos españoles ha sacado de las entrañas de la tierra al animal que vive a mayor profundidad del mundo. Se trata de una nueva especie de artrópodo de seis patas y color blanquecino hallado a casi dos kilómetros bajo tierra. organismo milimétrico supone una sorpresa monumental, ya que casi ningún científico esperaba encontrar nada vivo en un lugar tan inaccesible.

Obviamente, las fronteras de dicha “esfera” son elásticas y su extensión coincide con la de la hidrosfera; se superpone a las capas más bajas de la atmósfera y a las superficiales de la litosfera, donde se sumerge, como máximo, unos 2 Km. Sin embargo, si por biosfera se entiende la zona en la que hay vida así como la parte inorgánica indispensable para la vida, deberíamos incluir en este concepto toda la atmósfera, sin cuyo “escudo” contra las radiaciones más fuertes no existiría ningún tipo de vida; o la corteza terrestre entera y las zonas superiores del manto, sin las cuales no existiría la actividad volcánica, que resulta necesaria para enriquecer el suelo con nuevas sustancias minerales.

Por tanto, la biosfera es un ecosistema tan grande como el planeta Tierra y en continua modificación por causas naturales y (desgraciadamente) artificiales.

Las modificaciones naturales se producen a escalas temporales muy variables: en tiempos larguísimos determinados por la evolución astronómica y geológica, que influyen decididamente en las características climáticas de los distintos ambientes (por ejemplo, durante las glaciaciones), o en tiempos más breves, relacionados con cambios climáticos desencadenados por sucesos geológicos-atmosféricos imprevistos (por ejemplo, la erupción de un volcán, que expulsa a la atmósfera grandes cantidades de cenizas capaces de modificar el clima de extensas áreas durante periodos considerables).

Estos sucesos naturales van transformando el pasisaje y nos trae cambios y nueva vida

En cambio, las modificaciones artificiales debidas a la actividad humana tienen efectos rápidos: la deforestación producida en África por las campañas de conquista romanas contribuyó a acelerar la desertificación del Sahara, como tampoco hay duda de que la actividad industrial de los últimos siglos determina modificaciones dramáticas y repentinas en los equilibrios biológicos.

La biosfera es el punto de encuentro entre las diversas “esferas” en las que se subdivide la Tierra: está surcada por un flujo continuo de energía procedente tanto del interior del planeta como del exterior, y se caracteriza por el intercambio continuo de materia, en un ciclo incesante que une todos los entornos.

Muchas son las criaturas de especies ditintas que enriquecen la diversidad de la vida en la Tierra

Pero no por esta razón hay vida por todas partes, pues la vida requiere condiciones particulares e imprescindibles. Existen determinados elementos físicos y químicos que “limitan” el desarrollo de la vida. La presencia y disponibilidad de agua es el primero y el más importante. El agua es el disolvente universal para la química de la vida; es el componente primario de todos los organismos y sin agua la vida es inconcebible (Tales de Mileto fue el primero en darse cuenta de ello). Pero no sólo es eso: al pasar del estado sólido al líquido y al gaseoso y viceversa, el agua mantiene el “efecto invernadero natural”, capaz de conservar la temperatura del planeta dentro de los niveles compatibles con la vida (es decir, poco por debajo de los 0º C y poco por encima de los 40º C).

La presión, que no deberá superar mucho el kilogramo por centímetro cuadrado (como sucede alrededor de los 10 m de profundidad en el mar), así como una amplia disponibilidad de sales minerales y de luz solar (indispensable – como expliqué antes – para la vida de las plantas) son también factores que marcan las posibilidades de vida.

Está claro que se nos ha dado un lugar privilegiado, que reúne todas y cada una de las condiciones excepcionales para la vida, y somos tan ignorantes que aún siendo un bien escaso (en nuestro enorme Sistema Solar, parece que el único), nos lo queremos cargar. Pero sin querer, me marcho por las ramas y me desvío del tema principal, la evolución por la energía, y como está directamente implicada, hablemos un poco de nuestra casa.

El planeta Tierra

Las fuerzas que actúan sobre la Tierra, como planeta en el espacio, tiene profundas implicaciones energéticas. La gravitación ordena y orienta, y obstaculiza y facilita los flujos de energía cinética. La rotación genera la fuerza centrífuga y la de Coriolis: la primera achata el planeta por los polos ensanchándolo por el ecuador, y la segunda desvía los vientos y las corrientes de los océanos (a la derecha del hemisferio norte y a la izquierda en el hemisferio sur). La rotación es también la causa de los ritmos diarios de las plantas y animales, y de la desaceleración de la Tierra, que alarga el día un promedio de 1’5 ms cada siglo, lo que representa una pérdida de tres teravatios por fricción de mareas.

Pero ni la gravitación ni la rotación (fricción) hacen de la Tierra un planeta único entre los cuerpos celestes de nuestro entorno. Su exclusividad procede de sus propiedades térmicas internas, que causan los ciclos geotectónicos que modifican la superficie, y de su atmósfera, océanos y plantas que transforman la radiación solar que reciben. Los orígenes de estos procesos no están claros. Sin embargo, sabemos que todos esos complejos fenómenos y circuntancias han dado vía libre a la aparición de la vida.

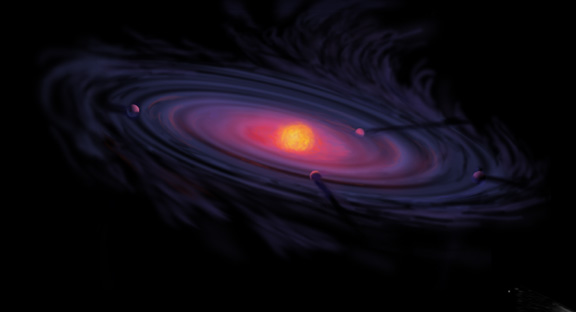

Un disco proto planetario como este pudo formar nuestro sistema solar a partir de la Nebulosa

Podemos fijar la edad de la Tierra en algo más de los 4.000 millones de años por la desintegración de los isótopos radiactivos, pero poco podemos asegurar sobre la formación del planeta o sobre la energética de la Tierra primitiva. Sobre el tema circulan varias teorías, y es muy plausible que el origen del Sistema Solar planetario fuera una nube interestelar densa en la que el Sol se formó por una inestabilidad gravitatoria y que la posterior aglomeración del resto de esta materia dispersa, que giraba a distintas distancias, a su alrededor, diera lugar a los planetas. No está claro si al principio la Tierra estaba extremadamente caliente o relativamente fría. Me inclino por lo primero y estimo que el enfriamiento fue gradual con los cambios de atmósferas y la creación de los océanos.

Las incertidumbres geológicas básicas se extienden hasta el presente. Diferentes respuestas a cuestiones como la cantidad de 40K en el núcleo terrestre o sobre la convección del magma en el manto (hay una o dos celdas) dan lugar a diferentes explicaciones para el flujo de calor y la geotectónica de la Tierra. Lo que sí está claro es que el flujo interno de calor, menos de 100 mW/m2, tiene un efecto pequeño comparado con la reflexión, absorción y emisión de la radiación solar.

El balance de la radiación terrestre (Rp) en la capa alta de la atmósfera es la suma de la radiancia extraterrestre (la constante sola Q0) reducida por el albedo planetario y el flujo saliente de larga longitud de onda (Qi): Rp = Q0(1-ap) + Qi = 0. El flujo emitido es igual a la suma de la radiación atmosférica y la terrestre: Qi = Qea + Qes. Los balances de la radiación en la atmósfera (Ra) y en la superficie de la Tierra (Rs) son iguales, respectivamente, a la diferencia entre la correspondiente absorción y emisión: Ra = Qaa + Qea y Rs = Qas + Qes, de manera que Rp = Ra + Rs = 0. Hay que continuar explicando la radiación saliente con los flujos irradiados y emitidos por la superficie terrestre, el flujo de radiación medio absorbida, etc., etc., etc., con una ingente reseña de símbolos y tedioso esquemas que, a mi parecer, no son legibles para el lector normal y no versado en estos conocimientos. Así que, aunque sea mutilar el trabajo, desisto de continuar por ese camino y prosigo por senderos más amenos y sugestivos para el lector.

La fuente más importante del calentamiento atmosférico proviene de la radiación terrestre de longitud de onda larga, porque el flujo de calor latente es una contribución secundaria y el flujo de calor sensible sólo es importante en las regiones áridas donde no hay suficiente agua para la evaporación. Los océanos y los continentes también reciben indirectamente, irradiadas por la atmósfera, la mayor parte de su calor en forma de emisiones de longitudes de onda larga (4 – 50 μm). En este flujo de radiación reenviado hacia la superficie terrestre por los gases invernadero, domina a la radiación del vapor de agua, que con una concentración variable, emite entre 150 y 300 W/m2, y al que también contribuye el CO2 con unos 75 W/m2.

El intercambio de radiación de longitud de onda larga entre la superficie y la atmósfera sólo retrasa temporalmente las emisiones de calor terrestre, pero controla la temperatura de la biosfera. Su máximo es casi 400 W/m2 en los trópicos nubosos, pero es importante en todas las estaciones y presenta significativas variaciones diarias. El simple paso de una nube puede aumentar el flujo en 25 W/m2. Las mayores emisiones antropogénicas de gases invernadero han aumentado este flujo en cerca de un 2’5 W/m2 desde finales del siglo XIX.

Como era de esperar, las observaciones de los satélites confirman que el balance de energía de la Tierra está en fase con la radiación solar incidente (Q0), pero la radiación media saliente (Qi) está desfasada con la irradiancia, alcanzando el máximo durante el verano en el hemisferio norte. La distribución asimétrica de los continentes y el mar explica este fenómeno. En el hemisferio norte, debido a la mayor proporción de masa terrestre, se experimentan mayores cambios estacionales que dominan el flujo global de la radiación saliente.

Quizás el resultado más sorprendente que se deriva de las observaciones por satélite sea que, estacionalmente, se observan cierto déficit y superávit de radiación y el balance de la radiación en el planeta no es igual a cero, pero sin embargo, en cada hemisferio la radiación anual está en equilibrio con el espacio exterior. Además, la contribución atmosférica por transporte de energía hacia los polos es asimétrica respecto al ecuador con valores extremos de unos 3 PW cerca de los 45º N, y -3 PW cerca de 40º S.

Si la Naturaleza se enfada… ¡Nosotros a temblar!

Podría continuar hablando sobre los vientos, los terremotos, las lluvias y otros fenómenos atmosféricos, sin embargo, no creo que, por ser estos fenómenos naturales muy conocidos de todos, pudieran tener gran interés. Pasemos pues a comentar sobre los océanos.

Agua, mejor que Tierra, habría sido el nombre adecuado para el tercer planeta, puesto que los océanos cubren más del 70 por ciento de la superficie terrestre, con una profundidad media de 3’8 Km. Debido a las especiales propiedades térmicas del agua, éstas constituyen un extraordinario regulador del balance energético del planeta.

Este líquido tiene cinco ventajas termodinámicas importantes: un punto de ebullición inusualmente alto, debido a su capacidad para formar enlaces de hidrógeno intermoleculares; un calor específico de 2’5 a 3’3 veces más elevado que el del suelo; una capacidad calorífica (calor específico por unidad de volumen) aproximadamente seis veces mayor que la tierra seca; un altísimo calor de vaporización que le permite transportar una gran cantidad de calor latente; y su relativamente baja viscosidad, que le convierte en un eficiente transportador de calor en los océanos mediante miríadas de remolinos y caudalosas corrientes.

No es sorprendente, pues, que los océanos, que tienen cerca del 94 por ciento de toda el agua, sean determinantes en el balance energético del planeta. Cuatro quintas partes de la radiación solar que llega a la Tierra entra en la atmósfera que cubre los océanos, los cuales con un albedo superior al 6% absorben la energía con una tasa cercana a 65 PW, casi el doble de la absorción atmosférica total y cuatro veces mayor que la continental. Inevitablemente, los océanos también absorben la mayor parte, casi dos tercios, del calor rerradioirradiado hacia abajo por la atmósfera elevando su ritmo de calentamiento a los 175 PW.

Salvo en los océanos menos profundos, la interacción aire-mar no afecta directamente a las aguas profundas. Las oscuras y frías aguas de las profundidades marinas están aisladas de la atmósfera por la capa mixta, una capa de poca profundidad que va de pocos metros a pocos cientos de metros y que está afectada por los vientos y el oleaje.

A pesar de que el alto calor específico del agua limita el rango de variación, las temperaturas de esta capa sufren importantes fluctuaciones diarias y estacionales. Sin embargo, variaciones relativamente pequeñas de la temperatura de la superficie de los océanos tienen importantes consecuencias climáticas: quizás el mejor ejemplo de esta teleconexión climática sea el fenómeno del Niño, que consiste en una extensión en forma de lengua de las aguas superficiales calientes hacia el este, cuyos efectos se extienden desde Canadá hasta África del sur.

Debido a que la conductividad térmica del agua es muy baja, la transferencia de energía de la capa mixta hacia las profundidades se realiza fundamentalmente mediante corrientes convectivas. Estas corrientes compensan la extremadamente baja fuerza ascensional de las aguas profundas, más calientes, que son desplazadas por el movimiento hacia el ecuador de las corrientes frías provenientes de los polos. En contraste con el gradual ascenso general de las aguas oceánicas, la convección hacia abajo se produce en corrientes bien delimitadas que forman gigantescas cataratas oceánicas. Seguramente la mayor es la que fluye hacia el sur bajo el estrecho de Dinamarca, entre Islandia y Groenlandia, y se sumerge unos 3’5 Km transportando 5 millones de m3/s, un caudal veinte veces mayor que el del Amazonas.

Miríadas de corrientes oceánicas, que a menudo viajan cientos de kilómetros a diferentes profundidades, transportan considerables cantidades de energía y sal. Quizás el ejemplo más importante de estas combinaciones de transportes sea la corriente de agua caliente y salada que sale del Mediterráneo a través del estrecho de Gibraltar. Este flujo caliente pero denso desciende sobre la pendiente de la plataforma continental hasta alcanzar el equilibrio entre el peso y el empuje ascensional a unos mil metros de profundidad. Aquí se separa en dos celdas lenticulares que se mueven durante siete años hacia el este y hacia el sur, respectivamente, hasta que decaen o chocan contra alguna elevación marina.

Un mapa global de los flujos de calor desde la superficie oceánica hasta las capas profundas muestra claramente máximos longitudinales a lo largo del ecuador y a lo largo de aproximadamente 45º S en los océanos Atlántico e Índico. Esta transferencia es también importante en algunas áreas costeras donde se producen intensos flujos convectivos ascendentes que intercambian calor entre las aguas superficiales y las profundas, como ocurre en la costa de California y al oeste de África. Un flujo en dirección contraria, que calienta la atmósfera, se produce en las dos mayores corrientes oceánicas calientes, la corriente del Golfo en el Atlántico y la de Kuroshio en el Pacífico oriental.

El giro de la Tierra hacia el Este influye también en las corrientes marinas, porque tiende a acumular el agua contra las costas situadas al oeste de los océanos, como cuando movemos un recipiente con agua en una dirección y el agua sufre un cierto retraso en el movimiento y se levanta contra la pared de atrás del recipiente. Así se explica, según algunas teorías, que las corrientes más intensas como las del Golfo en el Atlántico y la de Kuroshio en el Pacífico se localicen en esas zonas.

Este mismo efecto del giro de la Tierra explicaría las zonas de afloramiento que hay en las costas este del Pacífico y del Atlántico en las que sale agua fría del fondo hacia la superficie. Este fenómeno es muy importante desde el punto de vista económico, porque el agua ascendente arrastra nutrientes a la superficie y en estas zonas prolifera la pesca. Las pesquerías de Perú, Gran Sol (sur de Irlanda) o las del África atlántica se forman de esta manera.

![]()

Imagen esquemática y conceptual de distintos fenómenos eléctricos y luminosos generados por ciertas tormentas intensas. Imagen tomada de Internet, en su versión inglesa, y adaptada al español. La imagen originaria es de Lyons et al. (2000) de la American Geophysical Union.

Todas la regiones donde se produce este ascenso de aguas calientes (a lo largo de las costas del continente americano, África, India y la zona ecuatorial del Pacífico occidental) se distinguen fácilmente por los elevados niveles de producción de fitoplancton, causados por un importante enriquecimiento de nutrientes, comparados con los que, de otra manera, corresponderían normalmente a las aguas superficiales oligotrópicas.

La radiación transporta la mayor parte (casi 4/5) de la energía que fluye desde la capa mixta hasta la atmósfera, y el resto del flujo calorífico se produce por calor latente en forma de vapor de agua y lluvias.

Aún no se ha realizado una valoración cuantitativa del transporte total para cada latitud, pero en el océano Atlántico hay transferencia de calor hacia el norte a lo largo de toda su extensión, alcanzando en el trópico un valor aproximado de 1 PW, flujo equivalente al que se produce en el Pacífico norte. En el Pacífico sur, el flujo de calor hacia el polo a través del trópico es de 0’2 PW. La parte occidental del Pacífico sur puede constituir la mayor reserva de calor del Atlántico sur, de igual modo que es probable que el océano Índico sur constituya una reserva del Pacífico.

Los rios refrescan amplias zonas de la Tierra y hacen posible la vida

Ahora tocaría comentar algo sobre los ríos del planeta, sin embargo, me parece que merece un capítulo aparte y especial por su significado para muchos pueblos y culturas y también, por su contribución para hacer posible muchos ecosistemas y formas de vida. Así que, me dirijo directamente a comentar sobre el calor de la Tierra.

Aunque la Tierra se formara inicialmente a partir de materia fría (material cósmico) que se contrajo por acción de la gravedad, durante la formación posterior del núcleo líquido y en los periodos de intensa actividad volcánica se ha liberado una enorme cantidad de calor. Los frecuentes impactos de objetos pesados también han contribuido al calentamiento de la superficie. Hay mucha incertidumbre sobre la historia térmica de la Tierra de los últimos 3.000 millones de años, durante los cuales el planeta se ha ido enfriando y una gran parte de este flujo de calor ha alimentado los movimientos geotectónicos globales, creando nueva corteza en las dorsales oceánicas; un proceso que ha ido acompañado de terremotos recurrentes y erupciones volcánicas de lava, cenizas y agua caliente.

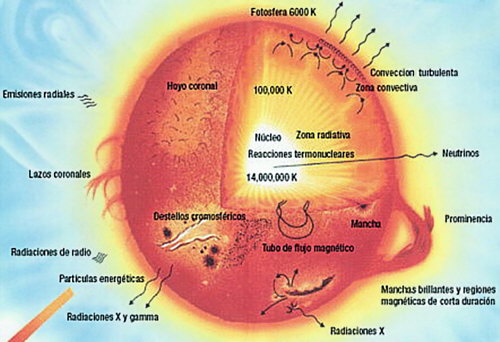

Solamente hay dos posibles fuentes de calor terrestre, pero la importancia relativa de las respectivas contribuciones no está aún muy clara. El calor basal, liberado por un lento enfriamiento del núcleo terrestre debe representar una gran parte del flujo total, si bien cálculos basados en la desintegración radiactiva del U235, U238, Th232 y K40 sugieren que éste representa al menos la mitad y quizás hasta nueve décimos del flujo total de calor del planeta. Esta disparidad obedece a la incertidumbre en la concentración de K40 en la corteza terrestre. Pero sea cual sea la proporción, el flujo total, basado en miles de medidas realizadas desde los años cincuenta, está próximo a los 40 TW.

Aunque inicialmente se pensó que los flujos continentales y oceánicos eran aproximadamente iguales, en realidad difieren de forma sustancial. Las regiones del fondo oceánico más recientes contribuyen con más de 250 mW/m2, cantidad que supera hasta tres veces las zonas continentales más recientes. El flujo medio para todo el fondo marino es aproximadamente igual a 95 mW/m2, lo que representa un 70% más que el correspondiente a la corteza continental. El flujo medio global es de 80 mW/m2, unos tres órdenes de magnitud inferior al valor medio del flujo de calor de la radiación solar global.

emilio silvera

May

30

La necesidad agudiza el ingenio

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Materiales increibles ~

Clasificado en Materiales increibles ~

Comments (0)

Comments (0)

Así se produce el decaimiento Beta

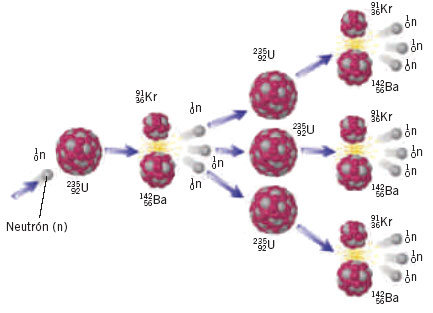

La fuerza nuclear débil nos habla de materiales que, de manera natural, emiten radiación y se desintegran. Al pensar en la desintegración me ha traído a la memoria aquellos libros de Asimov que nos explicaba cuestiones de ciencia y nos decía existen materiales que se desintegran de manera natural y que son materiales fértiles, o que sin serlo, se pueden transformar en otros que sí lo son.

Al hablar de material fértil me estoy refiriendo a núclidos que pueden absorber neutrones formar material fisible. El uranio-238, por ejemplo, absorbe un neutrón para formar uranio-239, que se desintegra en plutonio-239. es el tipo de conversión que la imaginación del hombre hace que ocurra en un reactor reproductor.

Lo explicaré con más detalles: El Reactor Reproductor rápido es un reactor de neutrones rápidos diseñado producir combustible generando más material fisible del que consume. El FBR es uno de los tipos posibles de reactores reproductores.

Veámos: El uranio-235 es un combustible práctico, es decir, los neutrones lentos son capaces de que el uranio-235 se fisione, o lo que es lo mismo, se rompan sus átomos en dos, produciendo neutrones lentos, que a su vez inducen otras fisiones atómicas. El uranio-233 y el plutonio-239 son combustibles nucleares prácticos por las mismas razones.

Desgraciadamente, el uranio-233 y el plutonio-239 no existen en estado natural sino en trazas mínimas, y el uranio-235, aunque existe en cantidades apreciables, no deja de ser raro. En cualquier muestra de uranio natural, sólo siete de mil átomos son de uranio-235, el resto es uranio-238.

Uranio

El uranio natural extraído de las minas contiene un 99´3 % de U-238 y apenas el 0´7 % de U-235.

El uranio-238, la variedad común de uranio, no es un combustible nuclear práctico. Así que, el uranio que más abunda en la naturaleza no sirve como combustible nuclear. Podemos conseguir que se fisione, sólo con neutrones rápidos. Los átomos de uranio-238 que se rompen en dos, producen neutrones lentos, que no bastan para producir o inducir nuevas fisiones. El uranio-238 cabría compararlo a la madera húmeda: es posible que arda, pero acabará por apagarse.

El uranio es un elemento químico metálico de color plateado-grisáceo de la serie de los actínidos, su símbolo químico es U y su número atómico es 92. Por ello posee 92 protones y 92 electrones, con una valencia de 6. Su núcleo contener entre 142 y 146 neutrones, sus isótopos más abundantes son el 238U que posee 146 neutrones y el 235U con 143 neutrones. El uranio tiene el mayor peso atómico de todos los elementos que se encuentran en la naturaleza. El uranio es aproximadamente un 70% más denso que el plomo, aunque menos denso que el oro o el wolframio. Es levemente radioactivo. Fue descubierto como óxido en 1789 por M. H. Klaproth que lo llamó así en el honor del planeta Urano que acababa de ser descubierto en 1781.

Supongamos, sin embargo, que se separa el uranio-235 del uranio-238 ( más bien difícil) y que se utiliza aquel para hacer funcionar un reactor nuclear. Los átomos de uranio-235 que forman el combustible del reactor se fisionan y esparcen miríadas de neutrones lentos en todas direcciones. Si el reactor está rodeado por una capa de uranio ordinario (que en su mayor es uranio-238), los neutrones que van a parar allí son absorbidos por el uranio-238 y, aunque no pueden que el uranio-238 se fisione, sí pueden provocar otros cambios que finalmente, producirán plutonio-239. Separando este plutonio-239 del uranio (tarea muy fácil), puede ser utilizado como combustible nuclear practico para la fisión.

De esta manera, el reactor nuclear genera combustible a partir de un material (uranio-238) que no lo es. Este es el motivo de que al reactor nuclear que hace posible la transformación se le llame “reactor generador”.

Un reactor generador bien diseñado puede producir más plutonio-239 que el uranio-234 consumido para ello. De este modo, las reservas totales de uranio de la Tierra (y no sólo las de uranio-235) se convierten en potenciales de combustible nuclear.

Torio

Carlo Rubbia, exdirector del CERN (los mismos que hicieron el Colisionador de Hadrones) y ganador del premio Nobel de física en 1984, ha trabajado buena de su carrera en el desarrollo de tecnologías para la producción de energía a partir de torio y calcula que con un reactor adecuado, este proceso de fisión podría generar a partir de 1 tonelada del elemento la misma cantidad de energía que 200 toneladas de uranio y 3.500.000 toneladas de carbón.

El torio, tal se da en la naturaleza, consiste todo él en torio-232, que al igual que el uranio-238, no es un combustible nuclear práctico, porque requiere neutrones rápidos fisionarse. Pero si se coloca torio-232 alrededor de un reactor nuclear, sus átomos absorberán los neutrones y, sin experimentar fisión alguna, se convertirán en átomos de uranio-233. Como el uranio-233 es un combustible práctico que se separar fácilmente del torio, el resultado es otra variedad del reactor generador, que convierte las reservas de torio en un combustible nuclear en potencia.

que no se descubra otra manera de producir energía, el Uranio seguirá

La cantidad total de uranio y de torio que hay en la Tierra es unas 800 veces mayor que las reservas de uranio-235, lo que significa que el buen uso de los reactores generadores podría multiplicar por 800 la oferta potencial de energía extraída de plantas de fisión nuclear.

En punto, sin dejar de elogiar la inteligencia del hombre que ha sabido encontrar la manera de transformar una materia inservible en otra practica, hay que decir que la energía de fisión nuclear genera también muchos problemas.

Como estará comprobando al lector de este , el autor ha querido esta vez diversificar los temas y plasmar una variedad múltiple que facilite el conocimiento de distintas cosas que ocurren en la naturaleza, o que la mano del hombre hace que ocurran, y todas estas cuestiones tratadas aquí van encaminadas a resolver preguntas que en alguna ocasión nos hemos podido , tales como:

¿Por qué al calentar un metal se pone primero rojo, luego naranja, después amarillo, a continuación blanco en lugar de seguir el espectro y ponerse verde?

¿Y el color en las estrellas?

un herrero está trabajando, el metal adquiere diferentes colores según recibe el calor de la fragua. Primero se mostrará de un rojo intenso, para ir progresivamente adoptando tonos más claros, pasando del anaranjado al amarillo, y por fin al blanco.

Si se pudiera seguir calentando el hierro, éste adquiriría tonos azulados. Estos cambios en la coloración son una consecuencia directa del aumento de la temperatura, que permitirá mayor maleabilidad. El Cúmulo del Joyero (en la constelación de la Cruz del Sur), fotografiado arriba, muestra cómo ocurre lo mismo con las estrellas, de manera que encontraremos estrellas azules, las más calientes, blancas, amarillas, anaranjadas y rojas, las más “frías”. A veces, estos colores pueden percibirse a simple vista, Antares (Alpha Scorpii) que es de color rojo, o Rigel (Beta Orionis) blanco-azulada.

En la Naturaleza rigen las mismas leyes para todos y, en todas partes se producen los mismos fenómenos debidos a las mismas causas, en caso: ¡La Temperatura!

Cualquier objeto, a cualquier energía superior al cero absoluto, radia ondas electromagnéticas. Si su temperatura es muy baja, emite sólo ondas de radio largas, muy pobres en energías. Al aumentar la temperatura, radia una cantidad mayor de ondas, también empieza a radiar ondas de radio más cortas (y más energéticas). Si la temperatura sigue subiendo, empiezan a radiarse microondas aún más energéticas y después radiaciones infrarrojas.

Esto no quiere decir que a una temperatura dada sólo se emitan ondas de radio largas, un poco más arriba sólo ondas de radio cortas, luego sólo microondas y después sólo infrarrojos. En realidad, se emite toda la gama de radiaciones, pero siempre hay una radiación máxima, es decir, una gama de longitudes de onda que son las más radiadas, flanqueadas por cantidades menores en el lado de las energías bajas y por cantidades todavía más pequeñas en el de las altas.

un objeto alcanza la temperatura del cuerpo humano (37°C), el máximo de radiación se encuentra en los infrarrojos largos. El cuerpo humano también radia ondas de radio, pero las longitudes de ondas más cortas y más energéticas son siempre las más fáciles de detectar por ser los más potentes.

Cuando la temperatura alcanza aproximadamente los 600°C, el máximo de radiación se halla en el infrarrojo corto. Pero a estas alturas la pequeña cantidad de radiación que se halla en el lado de las energías altas adquiere una importancia especial, porque entra ya en la región de la luz visible roja. El objeto reluce entonces con un rojo intenso.

rojo constituye sólo un pequeño porcentaje de la radiación total, pero como da la casualidad de que nuestro ojo lo percibe, le otorgamos toda nuestra atención y decimos que el objeto está al “rojo vivo”.

Si la temperatura sigue subiendo, el máximo de radiación continúa desplazándose las longitudes de ondas cortas y cada vez se emite más luz visible de longitudes cada vez menores. Aunque el objeto radia más luz roja, se van agregando poco a poco luz anaranjada y luz amarilla en cantidades menores pero significativas. Al llegar a los 1.000°C la mezcla de colores la percibimos como naranja, y a los 2.000°C como amarilla. Lo cual no significa que a los 1.000°C sólo se radie luz naranja y a los 2.000°C sólo se radie luz amarilla, porque si fuese así, habría efectivamente que esperar que lo siguiente fuese “color verde”. Lo que en realidad vemos son mezclas de colores.

Al llegar a los 6.000°C (la temperatura superficial del Sol), el máximo de radiación está en el amarillo visible y lo que llega a nuestros ojos son grandes cantidades de luz visible, el violeta hasta el rojo. La incidencia simultánea de toda la gama de luz visible sobre nuestra retina nos da la sensación de blanco, y de ahí el color del Sol.

Los objetos más calientes aún que el Sol radian todas las longitudes de ondas de luz visible y en cantidades todavía mayores, el máximo de radiación se desplaza al azul, de modo que la mezcla se desequilibra y el blanco adquiere un tinte azulado.

Toda esta travesía se produce para objetos calientes que emiten “espectros continuos”, es decir, que radian luz en la forma de una ancha banda de longitudes de ondas. Ciertas sustancias en adecuadas, radian sólo luz de determinadas longitudes de onda. El nitrato de bario radia luz verde cuando se calienta, y con ese fin se lo utiliza en los fuegos de artificio, “calor verde”, podríamos decir.

Nitrato de Bario que produce el color verde en los bonitos fuegos artificiales

¡Qué bonito es saber!

En alguna ocasión todos hemos oído mencionar la palabra “gases nobles”, y sin embargo no siempre sabemos lo que son y el por qué le llaman así. Los elementos que reaccionan difícilmente o que no reaccionan en absoluto con otros elementos se denominan “inertes”. El nitrógeno y el platino son ejemplos de elementos inertes.

En la última década del siglo pasado se descubrieron en la atmósfera una serie de gases que no parecían intervenir en ninguna reacción química. Estos nuevos gases (helio, neón, argón, kripton, xenón y radón) son más inertes que cualquier otro elemento y se agrupan bajo el de gases inertes.

Los elementos inertes reciben a veces el calificativo de “nobles” porque esa resistencia a reaccionar con otros elementos recordaba un poco a la altanería de la aristocracia. El oro y el platino son ejemplos de “metales nobles”, y por la misma razón se llaman a veces “gases nobles” a los gases inertes. 1.962, el nombre más común era el de gases inertes, quizá porque lo de nobles parecía poco apropiados en sociedades democráticas.

Es apropiado incluir una descripción de este grupo de elementos conocido en un capítulo dedicado a los halógenos, porque el flúor es el único elemento conocido que entra en combinación química directa con los dos gases nobles más pesados, el xenón y el criptón, resultando en compuestos estables.

Los gases nobles surgen en la naturaleza como constituyentes menos abundantes de la atmósfera. La primera indicación de la existencia de los gases nobles fue divulgada por el químico ingles Cavendish, en 1784.

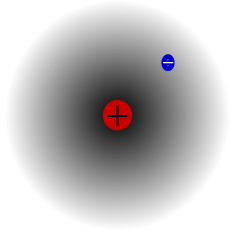

La razón de que los gases inertes sean inertes es que el conjunto de electrones de uno de sus átomos está distribuido en capas especialmente estables. La más exterior, en concreto, tiene 8 electrones. Así la distribución electrónica del neón es (2,8) y la del argón (2,8,8). Como la adición o sustracción de electrones rompe distribución estable, no pueden producirse cambios electrónicos. Lo cual significa que no pueden producirse reacciones químicas y que estos elementos son inertes.

bien, el grado de inercia depende de la fuerza con que el núcleo, cargado positivamente y situado en el centro del átomo sujeta a los 8 electrones de la capa exterior. Cuantas más capas electrónicas haya la exterior y el centro, más débil será la atracción del núcleo central sobre los electrones de esa última capa de electrones.

El Radón es un gas radiactivo de origen natural procedente de la desintegración radiactiva de pequeñas cantidades de uranio presentes en rocas y suelo, es el responsable de miles de muertes por cáncer de pulmón en Europa año. El gas se filtra en los edificios a través del suelo y de los sótanos, puede acumularse llegando a niveles elevados, especialmente en espacios cerrados y poco ventilados.

Quiere esto decir que el gas inerte más complejo es también el inerte. El gas inerte de estructura atómica más complicada es el radón. Sus átomos tienen una distribución electrónica de (2,8,18,32,18,8). El radón, sin embargo está sólo constituido por isótopos radiactivos y es un elemento con el que difícilmente se pueden hacer experimentos químicos. El siguiente en orden de complejidad es el xenón, que es estable. Sus átomos tienen una distribución electrónica de (2,8,18,18,8).

Se sabe desde hace décadas que la abundancia en la Tierra del xenón es menor de lo que debería ser según las proporciones observadas del resto de gases nobles. Las abundancias de estos gases se usan por los geoquímicos para evaluar y datar los principales procesos terrestres, incluyendo la formación de la atmósfera. Para poder hacerlo parten de una hipótesis básica: que los gases nobles son inertes en toda circunstancia. Un realizado por Gary Schrobilgen y David Brock, de la Universidad McMaster (Canadá), cuyos resultados se publican en el Journal of the American Chemical Society explica la baja abundancia del xenón y pone en evidencia que el xenón no es tan noble se suponía.

Los electrones más exteriores de los átomos de xenón y radón están bastante alejados del núcleo y, por consiguiente, muy sueltos. En presencia de átomos que tienen una gran apetencia de electrones, son cedidos rápidamente. El átomo con mayor apetencia de electrones es el flúor, y así fue como en 1.962 el químico canadiense Neil Bartlett consiguió formar compuestos de xenón y flúor.

Desde entonces se han conseguido formar también compuestos de radón y kriptón. Por eso los químicos rehúyen el de gases inertes, porque a fin de cuentas, esos gases no son completamente inertes. Hoy día se ha impuesto la denominación de “gases nobles”, y existe toda una rama de la química que se ocupa de los “compuestos de gases nobles”.

Naturalmente, cuanto más pequeño es el átomo de un gas noble, más inerte es, y no se ha encontrado nada que sea capaz de arrancarles algún electrón. El argón, cuya distribución electrónica es de 2,8,8 y el neón, con 2,8 electrones respectivamente, sigue siendo completamente inerte. Y el más inerte de todos es el helio, cuyos átomos contienen una sola capa electrónica con dos electrones (que es lo máximo que alojar esta primera capa) que al estar en la primera linea cerca del núcleo positivo, están fuertemente atraídos al tener su carga eléctrica el signo negativo.

finalizar diré que los gases nobles (gases inertes, gases raros) están clasificados en el grupo 18 (antiguamente 0) de la tabla periódica de dos elementos y se definen por símbolos que responden a: helio (He), neón (Ne), argón (Ar), kriptón (Kr), xenón (Xe) y radón (Rn).

Ya se dijo antes la configuración electrónica de uno de ellos y todas las capas internas están completamente ocupadas, lo que hace que estos elementos, por tanto, constituyan la terminación de un periodo y posean configuración de capa completa, por lo que sus energías de ionización son muy elevadas y su reactividad química escasa.

son monoatómicos, las moléculas de los gases nobles poseen simetría esférica, y las fuerzas intermoleculares son muy débiles, por lo que sus entalpías de vaporización son muy bajas.

Con todo lo anteriormente expuesto sobre los gases nobles, espero que el lector del aquí reflejado pueda tener una idea más amplia y un conocimiento más certero sobre lo que en realidad son los denominados como “gases nobles”.

En comparación con la inmensidad del universo, nos queda aún muchísimo que aprender. Si nos limitamos a nuestro entorno más cercano, la Tierra, ¿cómo hemos podido llegar tan lejos?

¡La curiosidad! y ¡La necesidad! ¡El Instinto! y ¡La Evolución! Todo ello, amigos míos, nos lleva a querer saber y, para ello, debemos desvelar los secretos de la Naturaleza, como que, por cierto, no resulta nada fácil, llevamos miles de años intentando comprender y, de , sólo sabemos… ¡Algunas cosas!

emilio silvera

May

29

Física y algunos personajes

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

¡¡Qué Bonito es saber!!

Hubo que la historia de explorarla. Los mensajes del pasado se transmitían primero a través de las habilidades de la memoria, luego de la escritura y, finalmente, de modo explosivo, en los libros. El insospechado tesoro de reliquias que guardaba la tierra se remontaba a la prehistoria. El pasado se convirtió en algo más que un almacén de mitos y leyendas o un catálogo de lo familiar.

INAH restaura piezas mayas de Palenque que nos hablan del pasado

Nuevos mundos terrestres y marinos, riquezas de continentes remotos, relatos de viajeros aventureros que nos traían otras formas de vida de pueblos ignotos y lejanos, abrieron perspectivas de progreso y novedad. La sociedad, la vida diaria del hombre en comunidad, se convirtió en un “nuevo mundo” cambiante de nuevos escenarios y asombrosos descubrimientos.

“George Herbert Leigh Mallory (18 de junio de 1886 – 8 o 9 de junio de 1924) fue un escalador y montañero británico que tomó parte en las tres primeras expediciones que se proponían escalar el Everest (1921, 1922 y 1924). Desapareció junto con su compañero de cordada, Andrew Irvine, a más de 8000 msnm en la cara noreste de la montaña. Aún hoy persiste la duda sobre si consiguieron hacer cumbre, en cuyo caso, se habrían adelantado en 29 años al primer ascenso oficial, que llevaron a cabo Edmund Hillary y Tenzing Norgay en 1953. El cuerpo de Mallory no fue encontrado hasta 1999, 75 años después de su desaparición.”

Quizás una de las historias más maravillosas que nos han dejado los aventureros del pasado siglo XX, es la de la tercera expedición de Irvine y Mallory. Estos dos jóvenes aventuresros ingleses tenían el ardiente deseo de escalar por primera vez el pico más alto del planeta.Siempre nos ha movido una fuerza misteriosa por llegar hasta lo desconocido para contemplar lo que desde allí nos muestra la Naturaleza.

Aquí, sería imposible un recorrido por el ámbito de todos los descubrimientos de la Humanidad, me circunscribo al ámbito de la física, y, hago un recorrido breve por el mundo del átomo que es el tema de hoy, sin embargo, sin dejar de mirar al hecho cierto de que, TODA LA HUMANIDAD ES UNA, y, luego, teniendo muy presente que, todo lo que conocemos es finito y lo que no conocemos infinito. Es bueno tener presente que intelectualmente nos encontramos en medio de un océano ilimitado de lo inexplicable.

La complejidad de nuestras mentes que tienen un gran reto por delante

La tarea de generación es reclamar un poco más de terreno, añadir algo a la extensión y solidez de nuestras posesiones del saber.

decía Einstein: “El eterno misterio del mundo es su comprensibilidad.”

Amigos, hablemos del átomo. De lo Grande a lo Pequeño.

Explosión nuclear de Hiroshima

El 6 de Agosto de 1945 el mundo recibió estupefacto Hiroshima la noticia de que el hombre había desembarcado en el oscuro continente del átomo. Sus misterios habrían de obsesionar al siglo XX. Sin embargo, el “átomo” había sido más de dos mil una de las más antiguas preocupaciones de los filósofos naturales. La palabra griega átomo significa unidad mínima de materia, que se suponía era indestructible. el átomo era un término de uso corriente, una amenaza y una promesa sin precedentes.

![[leucipo.jpg]](http://1.bp.blogspot.com/_ns8_0N54PWc/Skge4dCBVhI/AAAAAAAAAEs/KmhKlua_IWU/s1600/leucipo.jpg)

Leucipo (c. 450-370 a.C.), filósofo griego. Es reconocido creador de la teoría atómica de la materia, más tarde desarrollada por su discípulo, el filósofo griego Demócrito. Según teoría, toda materia está formada por partículas idénticas e indivisibles llamadas átomos.

Así que, el primer filósofo atómico fue un griego legendario, Leucipo, que se cree vivió en el siglo V a.C., y, a Demócrito, su discípulo, que dio al atomismo su clásica filosofía: “la invisible e indivisible de la materia”, se divertía tanto con la locura de los hombres que era conocido “el filósofo risueño” o “el filósofo que ríe”. No obstante fue uno de los primeros en oponerse a la idea de la decadencia de la Humanidad a partir de una Edad de Oro mítica, y predicó sobre una base de progreso. Si todo el Universo estaba compuesto solamente por átomos y vacío, no sólo no era infinitamente complejo, sino que, de un modo u otro, era inteligible, y seguramente el poder del hombre no tenía límite.

Lucreci0 (c. 95 a. C. -c. 55 a.C.) perpetuó en De rerum natura uno de los más importantes poemas latinos, al atomismo antiguo. Con la intención de liberar al pueblo del temor a los dioses, el poeta demostró que el mundo entero estaba constituido por vacío y átomos, los cuales se movían según sus leyes propias; que el alma moría con el cuerpo y que por consiguiente no había razón en temer a la muerte o a los poderes sobrenaturales.

Lucrecio decía que comprender la Naturaleza era el único modo de hallar la paz de espíritu, y, era de esperar, los padres de la Iglesia que pregonaban la vida eterna, atacaron sin piedad a Lucrecio y fue ignorado y olvidado toda la Edad Media que, como sabéis, fue la culpable de la paralización del saber de la Humanidad. Sin embargo, Lucrecio fue, una de las figuras más influyentes del Renacimiento.

Así pues, en un principio el atomismo vino al mundo de la mano del sistema filosófico. Del mismo modo que la simetría pitagórica había proporcionado un marco a Copérnico, la geometría había seducido a Kepler y el círculo perfecto aristotélico a Harvey, así los “indestructibles” átomos de los filósofos atrajeron a los físicos y a los químicos. Francis Bacon observó que “la teoría de Demócrito referida a los átomos es, si no cierta, al aplicable con excelentes resultados al análisis de la Naturaleza”.

Descartes

Descartes (1596-1650) inventó su propia noción de partículas infinitamente pequeñas que se movían en un medio que llamó éter. Otro filósofo francés, Pierre Gassendi (1592-1655), pareció confirmar la teoría de Demócrito y presentó otra versión más del atomismo, que Robert Boyle (1627-1691) adaptó a la química demostrando que los “elementos clásicos -tierra, aire, fuego y agua- no eran en absoluto elementales.

Las proféticas intuiciones de un matemático jesuita, R.G. Boscovich (1711-1787) trazaron los caminos una nueva ciencia, la física atómica. Su atrevido concepto de “los puntos centrales” abandonaba la antigua idea de una variedad de átomos sólidos diferentes. Las partículas fundamentales de la materia, sugería Boscovich, eran todas idénticas, y las relaciones espaciales alrededor de esos puntos centrales constituían la materia… Boscovich que había llegado a estas conclusiones a partir de sus conocimientos de matemáticas y astronomía, anunció la íntima conexión la estructura del átomo y la del Universo, lo infinitesimal y lo infinito.

John Dalton

El camino experimental el átomo fue trazado por John Dalton (1766-1844). Era este un científico aficionado cuáquero y autodidacta que recogió un sugestivo concepto de Lavoisier (1743-1794). Considerado una de los fundadores de la química moderna, Lavoisier, definió un “elemento” una sustancia que no ser descompuesta en otras sustancias por medio de ningún método conocido, hizo del átomo un útil concepto de laboratorio y trajo la teoría atómica a la realidad.

Dalton había nacido en el seno de una familia de tejedores de Cumberland, localidad inglesa situada en la región de los lagos, y estuvo marcada toda su vida por su origen humilde. A los doce ya se encontraba a cargo de la escuela cuáquera de su pueblo. Después, comenzó a ejercer la enseñanza en la vecina Kendal, y en la biblioteca del colegio encontró ejemplares de los Principia de Newton, de las Obras de la Historia Natural de Buffón, así un telescopio reflectante de unos setenta centímetros y un microscopio doble. Dalton recibió allí la influencia de John Gough, un notable filósofo natural ciego que, de acuerdo a lo que Dalton escribió a un amigo, “entiende muy todas las diferentes ramas de las matemáticas…Conoce por el tacto, el sabor y el olor de casi todas las plantas que crecen a casi treinta kilómetros a la redonda”. También Wordsworth elogia a Gough en su Excursión. Dalton recibió del filósofo ciego una educación básica en latín, griego y francés, y fue introducido en las matemáticas, la astronomía y todas las ciencias “de la observación”. Siguiendo el ejemplo de Gough, Dalton comenzó a llevar un meteorológico diario, que continuó el día de su muerte.

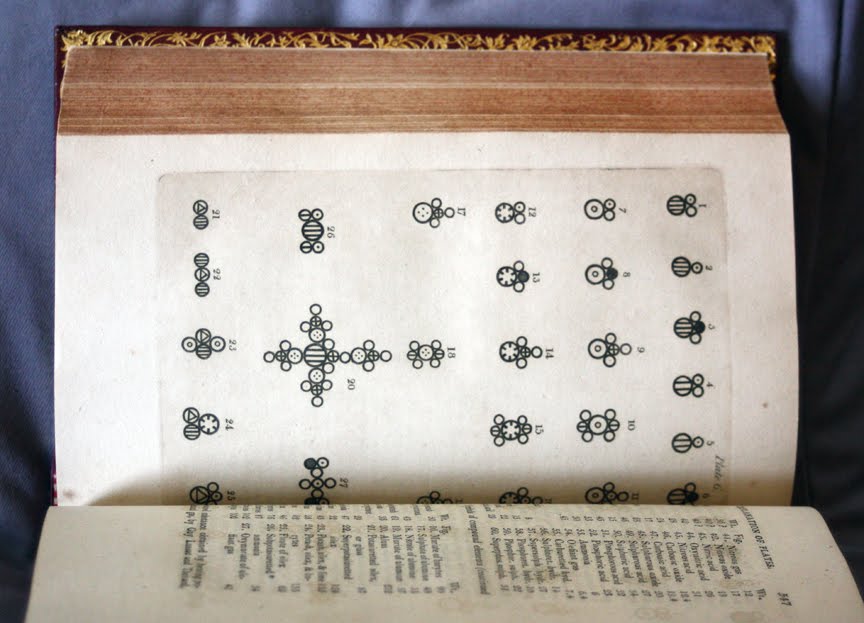

Una ilustración de moléculas, según la teoría atómica de John Dalton. En el siglo XIX, Dalton sentó las bases de la actual teoría atómica, que luego se revelaría substancialmente correcta.

los “disidentes” fundaron su colegio propio en Manchester, Dalton fue designado profesor de matemáticas y de filosofía natural. Halló una audiencia muy receptiva para sus experimentos en la Sociedad Literaria y Filosófica de Manchester, y presentó allí sus Hechos extraordinarios concernientes a la visión de los colores, que probablemente fue el primer sistemático sobre la imposibilidad de percibir los colores, o daltonismo, enfermedad que padecían tanto John Dalton como su hermano Jonathan. “He errado tantas veces el camino por aceptar los resultados de otros que he decidido escribir lo posible y solamente lo que pueda afirmar por mi propia experiencia”.

Dalton observó la boreal, sugirió el probable origen de los vientos alisios, las causas de la formación de nubes y de la lluvia y, sin habérselo propuesto, introdujo mejoras en los pluviómetros, los barómetros, los termómetros y los higrómetros. Su interés por la atmósfera le proporcionó una visión de la química que lo condujo al átomo.

Newton había confiado en que los cuerpos visibles más pequeños siguieran las leyes cuantitativas que gobernaban los cuerpos celestes de mayor tamaño. La química sería una recapitulación de la Astronomía. , ¿Cómo podía el hombre observar y medir los movimientos y la atracción mutua de estas partículas invisibles? En los Principios Newton había conjeturado que los fenómenos de la Naturaleza no descritos en libro podrían “depender todos de ciertas fuerzas por las cuales las partículas de los cuerpos, debido a causas desconocidas, se impulsan mutuamente unas otras y se unen formando figuras regulares, o se repelen y se apartan unas de otras.”

¿Podremos ver algún día, el átomo así?

Dalton se lanzó a la búsqueda de “estas partículas primitivas” tratando de encontrar algún medio experimental que le permitiera incluirlas en un sistema cuantitativo. Puesto que los gases eran la de materia más fluida, más móvil, Dalton centró su estudio en la atmósfera, la mezcla de gases que componen el aire, el cual constituyó el punto de partida de toda su reflexión sobre los átomos.

“¿Por qué el agua no admite un volumen similar de gas?, preguntó Dalton a sus colegas de la Sociedad Literaria y Filosófica de Manchester en 1803. “Estoy casi seguro de que la circunstancia depende del peso y el de las partículas últimas de los diversos gases; aquellos cuyas partículas son más ligeras y simples se absorben con más dificultad, y los demás con mayor facilidad, según vayan aumentando en peso y en complejidad.”

Dalton había descubierto que, contrariamente a la idea dominante, el aire no era un vasto disolvente químico único sino una mezcla de gases, uno de los cuales conservaban su identidad y actuaba de manera independiente. El producto de sus experimentos fue recogido en la trascendental TABLE: Of the Relative Weights of Ultimate Particles of Gaseous and Other Bodies (“Tabla de los pesos relativos de las partículas últimas de los cuerpos gaseosos y de otros cuerpos”).

El átomo de Hidrógeno sólo 1 protón y 1 electrón

Tomando al Hidrógeno uno, Dalton detalló en esta obra sustancias. Describió las invisibles “partículas últimas” como diminutas bolitas sólidas, similares a balas pero mucho más pequeñas, y propuso que se les aplicaran las leyes newtonianas de las fuerzas de atracción de la materia. Dalton se proponía lograr “una nueva perspectiva de los primeros principios de los elementos de los cuerpos y sus combinaciones”, que “sin duda…con el tiempo, producirá importantísimos cambios en el sistema de la química y la reducirá a una ciencia de gran simplicidad, inteligible hasta los intelectos menos dotados”. Cuando Dalton mostró una “partícula de aire que descansa sobre cuatro partículas de agua como una ordenada pila de metralla” donde cada pequeño globo está en con sus vecinos, proporcionó el modelo de esferas y radio de la química del siglo siguiente.

Dalton inventó unas “señales arbitrarias como signos elegidos representar los diversos elementos químicos o partículas últimas”, organizadas en una tabla de pesos atómicos que utilizaba en sus populares conferencias. Naturalmente, Dalton no fue el primero en emplear una escritura abreviada para representar las sustancias químicas, pues los alquimistas también tenían su código. Pero él fue probablemente el primero que utilizó este de simbolismo en un sistema cuantitativo de “partículas últimas”. Dalton tomó como unidad el átomo de Hidrógeno, y a partir de él calculó el peso de las moléculas como la suma de los pesos de los átomos que la componían, creando así una sintaxis moderna para la química. Las abreviaturas actuales que utilizan la primera letra del latino (por ejemplo H2O) fueron ideadas por el químico sueco Berzelius (1779-1848).

Berzelius

La teoría del átomo de Dalton no fue recibida en un principio con entusiasmo. El gran sir Humphry Davy desestimó inmediatamente sus ideas tachándolas de “más ingeniosas que importantes”. Pero las nociones de Dalton, desarrolladas en A New System of Chemical Philosophy (1808), eran tan convincentes que en 1826 le fue concedida la medalla real. Dalton no olvidó nunca su origen plebeyo, permaneció siempre apartado de la Royal Society de Londres, pero fue elegido miembro, sin su consentimiento, en 1822. Receloso del tono aristocrático y poco profesional de la Sociedad, él se encontraba más a gusto en Manchester, donde realizó la mayor de su obra, colaboró con Charles Babage y contribuyó a fundar la Asociación Británica el Progreso de la Ciencia, cuyo objetivo era llevar la ciencia el pueblo. Los newtonianos partidarios de la ortodoxia religiosa no creían que Dios hubiera hecho necesariamente sus invisibles “partículas últimas” invariables e indestructibles. Compartían con Isaac Newton la sospecha de que Dios había utilizado su poder “ variar las leyes de la Naturaleza y crear mundos diversos en distintos lugares del Universo”.

El átomo indestructible de Dalton se convirtió en el fundamento de una naciente ciencia de la química, proporcionando los principios elementales, las leyes de composición constante y de proporciones múltiples y la combinación de elementos químicos en razón de su peso atómico. “El análisis y la síntesis química no van más allá de la separación de unas partículas de otras y su reunión”, insistió Dalton. “La creación o la destrucción de la materia no está al alcance de ningún agente químico. Sería lo mismo tratar de introducir un planeta en el Sistema Solar o aniquilar uno de los ya existentes que crear o destruir una partícula de Hidrógeno.” Dalton continuó usando las leyes de los cuerpos celestes visibles como indicios del Universo infinitesimal. El profético sir Humphry Davy, sin embargo, no se convencía, “no hay razón suponer que ha sido descubierto un principio real indestructible”, afirmó escéptico.

Humphry Davy.

Dalton no era más que un Colón. Los Vespucios aún no habían llegado, y lo hicieron trajeron consigo algunas sorpresas muy agradables y conmociones aterradoras. Entretanto, y durante medio siglo, el sólido e indestructible átomo de Dalton fue muy útil los químicos, y dio lugar a prácticas elaboraciones. Un científico francés, Gay-Lussac, demostró que cuando los átomos se combinaban no lo hacían necesariamente de dos en dos, como había indicado Dalton, sino que podían agruparse en asociaciones distintas de unidades enteras. Un químico italiano, Avogadro (1776-1856), demostró que volúmenes iguales de gases a la misma temperatura y presión contenían el mismo de moléculas. Un químico ruso, Mendeleiev, propuso una sugestiva “Ley periódica” de los elementos. Si los elementos estaban dispuestos en orden según su creciente peso atómico entonces grupos de elementos de características similares se repetirían periódicamente.

La disolución del indestructible átomo sólido provendría de dos fuentes, una conocida y la otra bastante nueva: el estudio de la luz y el descubrimiento de la electricidad. El propio Einstein describió histórico movimiento como la decadencia de una perspectiva “mecánica” y el nacimiento de una perspectiva “de campo” del mundo físico, que le ayudó a encontrar su propio camino la relatividad, explicaciones y misterios nuevos.

Albert Einstein tenía en la pared de su estudio un retrato de Michael Faraday (1791-1867), y ningún otro hubiera podido ser más apropiado, pues Faraday fue el pionero y el profeta de la gran revisión que hizo posible la obra de Einstein. El mundo ya no sería un escenario newtoniano de “fuerzas a distancias”, objetos mutuamente atraídos por la fuerza de la Gravedad inversamente proporcional al cuadrado de la distancia que hay ellos. El mundo material se convertiría en una tentadora escena de sutiles y omnipresentes “campos de fuerzas”. idea era tan radical como la revolución newtoniana, e incluso más difícil de comprender los legos en la materia.

Toda esta historia es mucho más amplia de lo que aquí podemos contar pero, en algún hay que parar y aquí lo dejamos.

emilio silvera

May

29

Recordemos a un personaje, unos hechos.

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Personajes de la Historia ~

Clasificado en Personajes de la Historia ~

Comments (0)

Comments (0)

trabajo fue presentado en el Carnaval de la Física en homenaje a Riemann.

Recordemos aquí un extraño caso que surgió el día 10 de Junio de 1.854 con el nacimiento de una nueva geometría: la teoría de dimensiones más altas que fue introducida cuando Georg Friedrich Bernhard Riemann que dio su célebre conferencia en la facultad de la Universidad de Göttingen en Alemania. Aquello fue como abrir de golpe todas las ventanas cerradas 2.000 años de una lóbrega habitación que, de pronto, se ve inundada por la luz cegadora de un Sol radiante. Riemann regaló al mundo las sorprendentes propiedades del espacio multidimensional.

Su ensayo, de profunda importancia y elegancia excepcional, “sobre las hipótesis que subyacen en los fundamentos de la geometría” derribó pilares de la geometría clásica griega, que habían resistido con éxito todos los asaltos de los escépticos durante dos milenios. La vieja geometría de Euclides, en la cual todas las figuras geométricas son de dos o tres dimensiones, se venía abajo, mientras una nueva geometría riemanniana surgía de sus ruinas. La revolución riemanniana iba a tener grandes consecuencias el futuro de las artes y las ciencias. En menos de tres decenios, la “misteriosa cuarta dimensión” influiría en la evolución del arte, la filosofía y la literatura en toda Europa. Antes de que hubieran pasado seis decenios a partir de la conferencia de Riemann, Einstein utilizaría la geometría riemanniana tetradimensional para explicar la creación del universo y su evolución mediante su asombrosa teoría de la relatividad general. Ciento treinta años después de su conferencia, los físicos utilizarían la geometría decadimensional para intentar unir todas las leyes del universo. El núcleo de la obra de Riemann era la comprensión de las leyes físicas mediante su simplificación al contemplarlas en espacios de más dimensiones.

Contradictoriamente, Riemann era la persona indicada para anunciar tan profunda y completa evolución en el pensamiento matemático y físico. Era huraño, solitario y sufría crisis nerviosas. De salud muy precaria que arruinó su vida en la miseria abyecta y la tuberculosis.

Riemann nació en 1.826 en Hannover, Alemania, segundo de los seis hijos de un pobre pastor luterano que trabajó y se esforzó como humilde predicador para alimentar a su numerosa familia que, mal alimentada, tendrían una delicada salud que les llevaría a una temprana muerte. La madre de Riemann también murió de que sus hijos hubieran crecido.

A edad muy temprana, Riemann mostraba ya los rasgos que le hicieron famoso: increíble capacidad de cálculo que era el contrapunto a su gran timidez y temor a expresarse en público. Terriblemente apocado era objeto de bromas de otros niños, lo que le hizo recogerse aún más en un mundo matemático intensamente privado que le salvaba del mundo hostil exterior.

Para complacer a su padre, Riemann se propuso hacerse estudiante de teología, obtener un puesto remunerado pastor y ayudar a su familia. En la escuela secundaria estudió la Biblia con intensidad, pero sus pensamientos volvían siempre a las matemáticas. Aprendía tan rápidamente que siempre estaba por delante de los conocimientos de sus instructores, que encontraron imposible mantenerse a su altura. Finalmente, el director de la escuela dio a Riemann un pesado libro para mantenerle ocupado. El libro era la Teoría de números de Adrien-Marie Legendre, una voluminosa obra maestra de 859 páginas, el tratado más avanzado del mundo sobre el difícil tema de la teoría de números. Riemann devoró el libro en seis días.

Cuando el director le preguntó: “¿ dónde has leído?”, el joven Riemann respondió: “ es un libro maravilloso. Ya me lo sé todo”.

Sin creerse realmente la afirmación de su pupilo, el director le planteó varios meses después cuestiones complejas sobre el contenido del libro, que Riemann respondió correctamente.

Con mil sacrificios, el padre de Riemann consiguió reunir los fondos necesarios que a los 19 años pudiera acudir a la Universidad de Göttingen, donde encontró a Carl Friedrich Gauss, el aclamado por todos “Príncipe de las Matemáticas”, uno de los mayores matemáticos de todos los tiempos. Incluso hoy, si hacemos una selección por expertos para distinguir a los matemáticos más grandes de la Historia, aparecerá indudablemente Euclides, Arquímedes, Newton y Gauss.

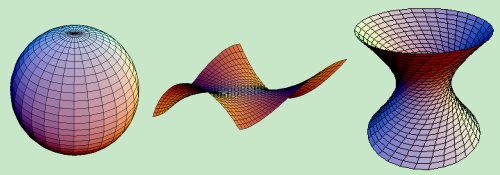

Gráfico: Un corte de Riemann, con dos hojas conectadas a lo largo de una línea. Si caminamos alrededor del corte, permanecemos dentro del mismo espacio. Pero si atravesamos el corte, pasamos de una hoja a la continua. es una superficie múltiplemente conexa

Los estudios de Riemann no fueron un camino de rosas precisamente. Alemania sacudida por disturbios, manifestaciones y levantamientos, fue reclutado en el cuerpo de estudiantes para proteger al rey en el palacio real de Berlín y sus estudios quedaron interrumpidos.

En aquel ambiente, el problema que captó el interés de Riemann fue el colapso que, según el pensaba, suponía la geometría euclidiana, que mantiene que el espacio es tridimensional y “plano” (en el espacio plano, la distancia más corta dos puntos es la línea recta; lo que descarta la posibilidad de que el espacio pueda estar curvado, como en una esfera).

Para Riemann, la geometría de Euclides era particularmente estéril cuando se la comparaba con la rica diversidad del mundo. En ninguna veía Riemann las figuras geométricas planas idealizadas por Euclides. Las montañas, las olas del mar, las nubes y los torbellinos no son círculos, triángulos o cuadrados perfectos, sino objetos curvos que se doblan y retuercen en una diversidad infinita. Riemann, ante aquella realidad, se rebeló contra la aparente precisión matemática de la geometría griega, cuyos fundamentos, descubrió él, estaban basados en definitiva sobre las arenas movedizas del sentido común y la intuición, no sobre el terreno firme de la lógica y la realidad del mundo.

Euclides nos habló de la obviedad de que un punto no tiene dimensión. Una línea tiene una dimensión: longitud. Un plano tiene dos dimensiones: longitud y anchura. Un sólido tiene tres dimensiones: longitud, anchura y altura. Y allí se detiene. Nada tiene cuatro dimensiones, incluso Aristóteles afirmó que la cuarta dimensión era imposible. En Sobre el cielo, escribió: “La línea tiene magnitud en una dirección, el plano en dos direcciones, y el sólido en tres direcciones, y más allá de éstas no hay otra magnitud porque los tres son todas”. Además, en el año 150 d. C. el astrónomo Ptolomeo de Alejandría fue más allá de Aristóteles y ofreció, en su libro sobre la distancia, la primera “demostración” ingeniosa de que la cuarta dimensión es imposible.

En realidad, lo único que Ptolomeo demostraba era que era imposible visualizar la cuarta dimensión con nuestros cerebros tridimensionales (de hecho, hoy sabemos que muchos objetos matemáticos no pueden ser visualizados, aunque demostrarse que en realidad, existen). Ptolomeo puede pasar a la Historia como el hombre que se opuso a dos grandes ideas en la ciencia: el sistema solar heliocéntrico y la cuarta dimensión.

La ruptura decisiva con la geometría euclidiana llegó Gauss pidió a su discípulo Riemann que preparara una presentación oral sobre los “fundamentos de la geometría”. Gauss estaba muy interesado en ver si su discípulo podía desarrollar una alternativa a la geometría de Euclides.

Riemann desarrolló su teoría de dimensiones más altas.

Finalmente, cuando hizo su presentación oral en 1.854, la recepción fue entusiasta. Visto en retrospectiva, fue, sin discusión, una de las conferencias públicas más importantes en la historia de las matemáticas. Rápidamente se entendió por toda Europa la noticia de que Riemann había roto definitivamente los límites de la geometría de Euclides que había regido las matemáticas durante dos milenios.

El tensor de Riemann contiene toda la información necesaria poder describir un espacio curvo en N-dimensiones. Se necesita dieciséis números para describir el tensor métrico en un espacio tetradimensional. Estos números pueden disponerse en una matriz cuadrada (seis de dichos números son realmente redundantes; de modo que el tensor métrico diez números independientes).

Riemann creó su tensor métrico que, a partir de ese momento, otros dispusieran de una poderosa herramienta que les hacía posible expresarse, a partir del famoso teorema de Pitágoras (uno de los grandes descubrimientos de los griegos en matemáticas que establece la relación entre las longitudes de los tres lados de un triángulo rectángulo: afirma que la suma de los cuadrados de los lados menores es igual al cuadrado del lado mayor, la hipotenusa; es decir, si a y b son los longitudes de los dos catetos, y c es la longitud de la hipotenusa, entonces a2 + b2 = c2. El teorema de Pitágoras, por supuesto, es la base de toda la arquitectura; toda estructura construida en este planeta está basada en él. Claro que, es una herramienta para utilizar en un mundo tridimensional).

El tensor métrico de Riemann, o N dimensiones, fue mucho más allá y podemos decir que es el teorema para dimensiones más altas con el que podemos describir fenómenos espaciales que no son planos, tales como un remolino causado en el agua o en la atmósfera, como por ejemplo también la curvatura del espacio en presencia de grandes masas. Precisamente, el tensor de Riemann permitió a Einstein formular su teoría de la gravedad y posteriormente lo utilizo Kaluza y Klein para su teoría en la quinta dimensión de la que años más tarde se derivaron las teorías de supergravedad, supersimetría y, finalmente, las supercuerdas.

Para asombro de Einstein, cuando tuvo ante sus ojos la conferencia de Riemann de 1.854 que le había enviado su amigo Marcel Grossman, rápidamente se dio de que allí estaba la clave para resolver su problema. Descubrió que podía incorporar todo el cuerpo del trabajo de Riemann en la reformulación de su principio. Casi línea por línea, el gran trabajo de Riemann encontraba su verdadero lugar en el principio de Einstein de la relatividad general. fue la obra más soberbia de Einstein, incluso más que su celebrada ecuación E = mc2. La reinterpretación física de la famosa conferencia de Riemann se denomina relatividad general, y las ecuaciones de campo de Einstein se sitúan entre las ideas más profundas de la historia de la ciencia.

No sería justo reconocer aquí que Riemann, tiene mucho que ver en ese gran logro de Einstein (Relatividad General), y de toda la física en lo que a la geometría de espacios curvos se refiere..

emilio silvera

May

27

El Cúmulo Globular Omega Centauri

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (0)

Comments (0)

En la galeria de imágenes que diariamente nos pone el amigo Shalafi (Administrador del lugar), hoy nos ha tocado un cúmulo de estrellas que es una maravilla. Si miramos referencias del mismo, en cualquier sitio que miremos podrán decirnos cosas como esta:

“Omega Centauri, ω Cen o NGC 5139 es un cúmulo globular situado en la constelación de Centaurus. Fue descubierto por Edmond Halley en 1677. Este cúmulo orbita alrededor de nuestra galaxia, la Vía Láctea, siendo el más grande y brillante de los cúmulos globulares que la orbitan. Es uno de los pocos que puede ser observado a simple vista. Omega Centauri esta a unos 18.300 años luz (5.6 kpc) de la Tierra y contiene varios millones de estrellas de Población II. Las estrellas de su centro están tan juntas entre si que se cree que se encuentran a tan solo 0,1 años luz las unas de las otras. Su edad estimada es de cerca de 12 mil millones de años. Contiene alrededor de 10 millones de estrellas.

A pesar de no ser una estrella de la constelación recibió una denominación de Bayer, la ω. Una característica que lo distingue de los demás cúmulos globulares de nuestra galaxia es que contiene estrellas de distintas generaciones. Por este motivo se especula que Omega Centauri puede ser el remanente del núcleo de una galaxia enana que fue satélite de nuestra Vía Láctea. Esta galaxia tendría un tamaño cientos de veces superior al actual de Omega Centauri y fue disgregada y absorbida por nuestra galaxia. La química y la dinámica de Omega Centauri son consistentes con esta hipótesis.

Al igual que Mayall II, un cúmulo globular que orbita la galaxia de Andrómeda, Omega Centauri presenta un rango de metalicidades y de edades estelares que llevan a pensar que no se formó de una sola vez (al contrario de lo que es normal en los cúmulos globulares). Muchas de las estrellas que forman Omega Centauri se piensa que son el remanente del núcleo de la galaxia enana ancestral que fue capturada por la Vía Láctea.”

Cúmulo estelar abierto M11. Puede observarse su estructura poco densa, formada por estrellas jóvenes y brillantes que difiere del cúmulo que arriba ponemos como actor principal de ésta reseña.

Cuando observamos el universo mediante un telescopio se nos hace evidente que multitud de estrellas no se encuentran solas, si no que forman parte de sistemas de dos, tres o más soles. De hecho una gran parte de estrellas son consideradas sistemas binarios o múltiples, vinculados gravitatoriamente. Sin embargo es posible encontrar las estrellas formando comunidades aún mucho mayores y que implican una evolución conjunta desde su nacimiento en alguna gran nebulosa, nos referimos a los cúmulos estelares, verdaderas ciudades de estrellas.

Observando estos conglomerados de decenas, centenares o miles de componentes, enseguida nos percataremos que responden a dos tipos de agrupamientos muy diferentes atendiendo a su morfología

Los cúmulos de estrellas se clasifican en dos grupos: cúmulos abiertos, que no poseen forma definida, y cúmulos globulares, que son esféricos o casi esféricos. Los abiertos están formados por unos cientos estrellas jóvenes, mientras que los cúmulos globulares contienen más de mil veces esa cantidad, y generalmente son estrellas muy viejas.

Los cúmulos globulares forman un halo alrededor de nuestra galaxia, la Vía Láctea, mientras que los abiertos se sitúan en los brazos de la espiral.

Los cúmulos abiertos son mucho más numerosos que los globulares: se conocen unos 1.000 en nuestra galaxia mientras que sólo hay 140 globulares.

El pequeño cúmulo abierto de Las Pléyades

“Las Pléyades (que significa «palomas» en griego), también conocidas como Objeto Messier 45, M45, Las Siete Hermanas o Cabrillas, o Los Siete Cabritos, es un cúmulo abierto visible a simple vista en el cielo nocturno, con un prominente lugar en la mitología antigua, situado a un costado de la constelación de Tauro. Las Pléyades son un grupo de estrellas muy jóvenes situadas a una distancia aproximada de 450 años luz de la Tierra y están contenidas en un espacio de treinta años luz. Se formaron hace apenas unos 100 millones de años aproximadamente, durante la era Mesozoica en la Tierra, a partir del colapso de una nube de gas interestelar. Las estrellas más grandes y brillantes del cúmulo son de color blanco-azulado y cerca de cinco veces más grandes que el Sol.”

La nebulosa de Orión es un ejemplo de una región en la que todavía se están formando estrellas. En el centro de la nebulosa se encuentra un grupo de estrellas viejas, el “Trapecio de Orión”. La nebulosa contiene suficiente gas como para formar otros cientos de estrellas del mismo tipo.

Se conoce como “asociación estelar” a una agrupación de estrellas parecida a un cúmulo, pero distribuidas sobre un área mayor. A menudo se encuentran cúmulos abiertos en el interior de una asociación, en zonas donde la densidad del gas a partir del cual se formó la asociación es mayor.

Los miembros de un cúmulo nacen juntos y continúan moviéndose juntos por el espacio. Esto sirve para hallar sus distancias. Midiendo el movimiento de las estrellas a lo largo de la línea de visión y a través de la línea de visión, se pueden calcular las distancias que las separan del Sistema Solar. Esta técnica se conoce como el método del cúmulo móvil.

“Los cúmulos estelares ayudan a comprender la evolución estelar al ser estrellas formadas en la misma época a partir del material de una nube molecular. También representan un importante paso en la determinación de la escala del Universo. Algunos de los cúmulos abiertos más cercanos pueden utilizarse para medir sus distancias absolutas por medio de la técnica del paralaje. El diagrama de Hertzsprung-Russell de estos cúmulos puede entonces representarse con los valores de luminosidad absoluta. Los diagramas similares de cúmulos cuya distancia no es conocida pueden ser comparados con los de distancia calibrada estimando la distancia que los separa de nosotros.”

El Universo nunca dejará de sorprendernos, es demasiado grande para que nuestras mentes tridimensionales lo puedan asimilar y, en él se encuentran muchas cosas que nos sobrepasan, están presentes distancias que no podemos asimilar aunque inventamos unidades para tratar de midirlas. Y, sobre todo, en el Universo que tiene su ritmo particular que viene dado por las cuatro fuerzas fundamentales que, en interacción con la materia presente, producen fenómenos que tratamos de desvelar y, tanto los objetos como los sucesos, tienen su mensaje que no siempre comprendemos.

emilio silvera

Totales: 77.895.707

Totales: 77.895.707 Conectados: 38

Conectados: 38