Dic

21

¡Tenemos que saber! y, sabremos.

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (3)

Comments (3)

En 1.949, el físico francés Louis de Broglie, que ganó el premio Nobel, propuso construir un laboratorio europeo de física de partículas. Su idea caló hondo en la comunidad internacional, y tres años más tarde, 11 países europeos dieron el visto bueno y el dinero para construir el CERN, inaugurado en Ginebra en 1.954, y al que tanto le debe la física y las Sociedades modernas del mundo.

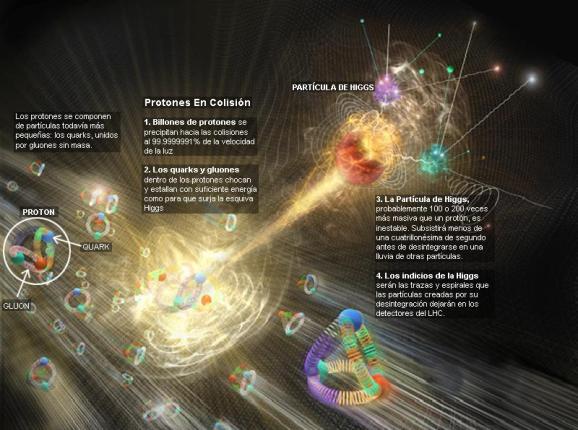

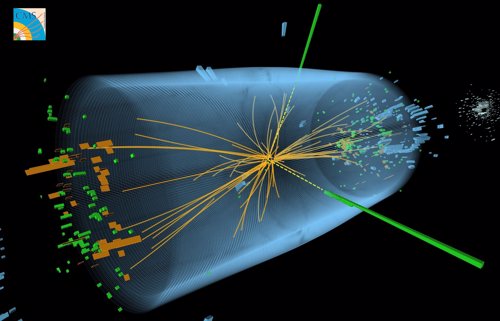

Los aceleradores de partículas son un gran invento que ha permitido comprobar (hasta donde se ha podido, al menos) la estructura del átomo. En el acelerador del Fermilab, por ejemplo, un detector de tres pisos de altura que en su momento costó unos ochenta millones de dólares para poder captar electrónicamente los “restos” de la colisión entre un protón y un antiprotón. Aquí la prueba consiste en que decenas de miles de sensores generen un impulso eléctrico cuando pasa una partícula. Todos esos impulsos son llevados a procesadores electrónicos de datos a través de cientos de miles de cables. Por último, se hace una grabación en carrete de cinta magnética codificada con ceros y unos. La cinta graba las violentas colisiones de los protones y antiprotones, en las que generan unas setenta partículas que salen disparadas en diferentes direcciones dentro de las varias secciones del detector.

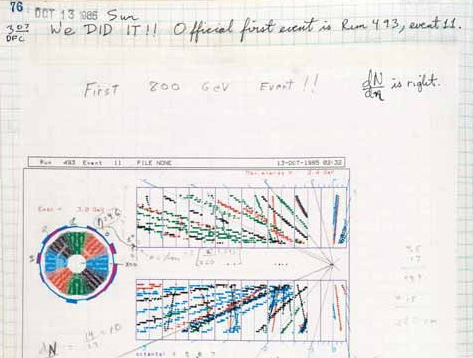

El 13 de octubre de 1985 se produjo la primera colisión protón-antiprotón en el Tevatrón del Fermilab

La ciencia, en especial la física de partículas, gana confianza en sus conclusiones por duplicación, es decir, un experimento en California se confirma mediante un acelerador de un estilo diferente que funciona en Ginebra con otro equipo distinto, que incluye en cada experimento los controles necesarios y todas las comprobaciones para que puedan confirmar con muchas garantías el resultado finalmente obtenido. Es un proceso largo y muy complejo; la consecuencia de muchos años de investigación de muchos equipos diferentes.

No es suficiente con un único resultado. Si muchos, en distintos lugares dan lo mismo…se pueden considerar ciertos

Yo puedo visualizar la estructura interna de un átomo. Puedo hacer que me vengan imágenes mentales de nebulosas de “presencia” de electrón alrededor de la minúscula mota del núcleo que atrae esa bruma de la nube electrónica hacia sí. Puedo ver los átomos, los protones y los neutrones, y en su interior, los diminutos quarks enfangados en un mar de neutrones. Claro que todo eso es posible por el hecho de que dicha imagen me es muy familiar. Creo que cada uno construirá sus propias imágenes conforme él las vea a partir de las ecuaciones o bien de cómo las formó en su mente a partir de sus lecturas o explicaciones oídas en charlas científicas.

Cuando entraron en escena David Politrer, de Harvard, y David Gross y Frank Wilczek, de Pinceton, el panorama de lo que ocurría en el interior del núcleo se aclaró bastante. Ellos, descubrieron algo que llamaron libertad asintótica. Asintótico significa, burdamente, “que se acerca cada vez más, pero no toca nunca”. La interacción fuerte se debilita más y más a medida que un quark se aproxima a otro. Esto significa, paradójicamente, que cuando los quarks están muy juntos se portan casi como si fuesen libres; pero cuando se apartan, las fuerzas se hacen efectivamente mayores. Las distancias cortas suponen energías altas, así que la interacción fuerte se debilita a altas energías. Esto es justo lo contrario de lo que pasa con la fuerza eléctrica. Aún más importante era que la interacción fuerte necesitase una partícula mensajera, como las otras fuerzas, y en alguna parte le dieron al mensajero el nombre de gluón (del inglés glue, pegamento).

A todo esto, llegó Murray Gell-Mann con sus quarks para completar el panorama. Adjudicó a estas diminutas partículas color y sabor (nada que ver con el gusto y los colores reales) y llegó la teoría denominada cromodinámica cuántica. Todo aquello dio mucho que hablar y mucho trabajo a los teóricos y experimentadores, y al entrar en los años ochenta, se había dado ya con todas las partículas de la materia (los quarks y los leptones), y teníamos las partículas mensajeras, o bosones gauge, de las tres fuerzas, a excepción de la gravedad.

|

MATERIA |

|||

|

Primera generación |

Segunda generación |

Tercera generación |

|

|

u |

c |

t |

|

|

d |

s |

b |

|

|

Son los quarks up, down, charmed, strange, top y bottom. |

|||

|

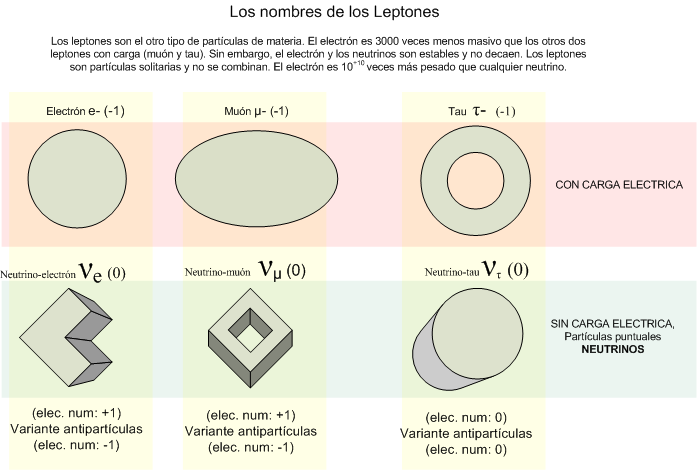

Los leptons son: |

|||

|

υe |

υμ |

υτ |

|

|

e |

μ |

τ |

|

|

FUERZAS |

|||

|

Fotón |

Electromagnetismo |

||

|

W+, W–, Z0 |

Interacción débil |

||

|

Ocho gluones |

Interacción fuerte |

||

La familia de los leptones está compuesta por el electrón, muón y tau con sus correspondientes neutrinos. Así quedó prácticamente completo el llamado modelo estándar que describe las partículas que forman la materia conocida y las fuerzas que intervienen e interaccionan con ellas. La gravedad quedó plasmada en la relatividad general de Einstein.

¿Por qué es incompleto el modelo estándar? Una carencia es que no se haya visto todavía el quark top; otra, la ausencia de una de las cuatro fuerzas fundamentales, la gravedad. Otro defecto estético es que no es lo bastante simple; debería parecerse más a la tierra, aire, fuego y agua de Empédocles. Hay demasiados parámetros y demasiados controles que ajustar. Necesitamos una nueva teoría que sea menos complicada, más sencilla y bella, sin vericuetos intrincados que salvar, con la limpieza y serena majestad de la teoría de la gravedad que, con enorme simpleza y aplicando los principios naturales, trata los temas más profundos del universo. Esperemos que continúe desarrollándose la teoría de cuerdas y que, como parece, incluya todas las fuerzas, todas las partículas y, en fin, todos los parámetros que dan sentido al universo.

Sí, al Modelo Estándar la faltan algunas cosas y le sobran otras, o, al menos, sería necesario explicarlas mejor. La Gravedad no está presente y, hay una veintena de parámetros aleatorios que, como el Bosón de Higgs, no se pueden explicar…aún. La Historia viene de lejos:

|

El modelo estándar: Historia resumida |

|||||

|

Autores |

Fechas |

Partículas |

Fuerza |

Nota |

Comentario |

|

Tales (milesio) |

600 a.C. |

Agua |

No se menciona |

8 |

Fue el primero en explicar el mundo mediante causas naturales. Lógica en lugar de mito. |

|

Empédocles (agrigento) |

460 a.C. |

Tierra, agua, aire y fuego |

Amor y discordia |

9 |

Aportó la idea de que hay múltiples partículas que se combinan para formar toda la materia. |

|

Demócrito (Abdera) |

430 a.C. |

El átomo indivisible e invisible, o a-tomo |

Movimiento violento constante |

10 |

Su modelo requería demasiadas partículas, cada una con una forma diferente, pero su idea básica de que hay un átomo que no puede ser partido sigue siendo la definición básica de partícula elemental. |

|

Isaac Newton (inglés) |

1.687 |

Átomos duros con masa, impenetrables |

Gravedad (cosmos); fuerzas desconocidas (átomos) |

7 |

Le gustaban los átomos pero no hizo que su causa avanzase. Su gravedad fue un dolor de cabeza para los peces gordos en la década de 1.990 |

|

Roger J. Boscovich (dálmata) |

1.760 |

“Puntos de fuerza” indivisibles y sin forma o dimensión |

Fuerzas atractivas y repulsivas que actúan entre puntos |

9 |

Su teoría era incompleta, limitada, pero la idea de que hay partículas de “radio nulo”, puntuales, que crean “campos de fuerza”, es esencial en la física moderna. |

|

Michael Faraday (inglés) |

1.820 |

Cargas eléctricas |

Electromagnetismo |

8’5 |

Aplicó el atomismo a la electricidad al conjeturar que las corrientes estaban formadas por “corpúsculos de electricidad”, los electrones. |

|

Dimitri Mendeleev (siberiano) |

1.870 |

Más de 50 átomos dispuestos en la tabla periódica de los elementos |

No hace cábalas sobre las fuerzas |

8’5 |

Tomó la idea de Dalton y organizó todos los elementos químicos conocidos. En su tabla periódica apuntaba con claridad una estructura más profunda y significativa. |

|

Ernest Rutherford (neozelandés) |

1.911 |

Dos partículas; núcleo y electrón |

La fuerza nuclear fuerte más el electromagnetismo. La gravedad |

9’5 |

Al descubrir el núcleo, reveló una nueva simplicidad dentro de todos los átomos de Dalton. El experimentador por excelencia. |

|

Bjorken, Fermi, Friedman, Gell-Mann, Glasgow, Kennedy, Lederman, Peri, Richter, Schwartz, Steinberger, Taylor, Ting, más un reparto de miles. |

1.992 |

Seis quarks y seis leptones, más sus antipartículas. Hay tres colores de quarks |

El electromagnetismo, la interacción fuerte y débil: doce partículas que llevan las fuerzas más la gravedad. |

? |

Demócrito de Abdera ríe. |

A todo esto y como he dicho, el quark top está perdido (ya se encontró) y el neutrino tau no se ha detectado directamente (pero experimentos nos han dicho que un neutrino muónico se puede transformar en uno tau), y muchos de los números que nos hacen falta conocer los tenemos de forma imprecisa. Por ejemplo, no sabemos si los neutrinos tienen alguna masa en reposo.

Tenemos que saber cómo la violación de la simetría CP (el proceso que originó la materia) aparece, y lo que es más importante, hemos de introducir un nuevo fenómeno, al que llamamos campo de Higgs, para preservar las coherencia matemática del modelo estándar. La idea de Higgs y su partícula asociada, el bosón de Higgs, cuenta en todos los problemas que he mencionado antes. Parece, con tantos parámetros imprecisos (19), que el modelo estándar está asentado sobre arenas movedizas.

En realidad, no sabemos si la relatividad general y la teoría cuántica, son dos mundos antagónicos que nos empeñamos en unir

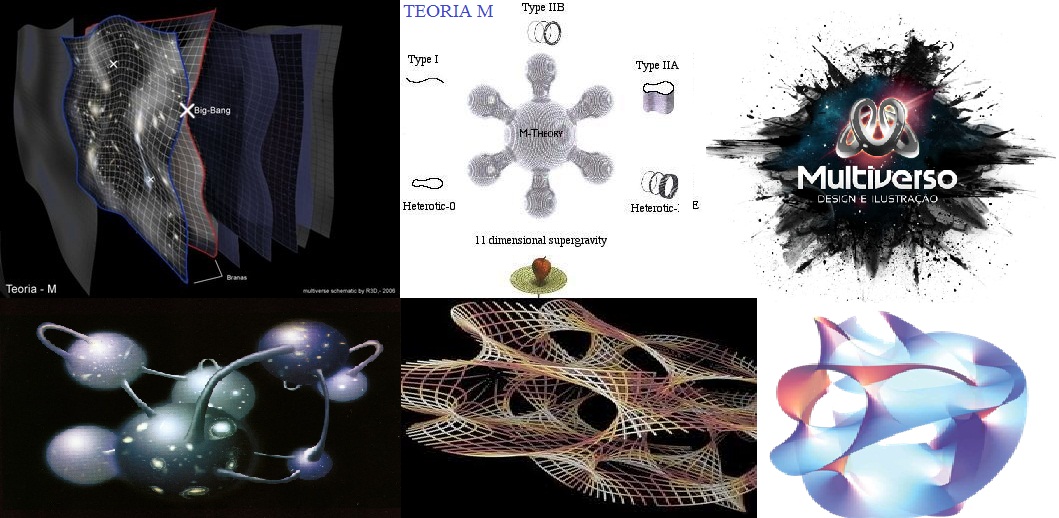

Entre los teóricos, el casamiento de la relatividad general y la teoría cuántica es el problema central de la física moderna. A los esfuerzos teóricos que se realizan con ese propósito se les llama “supergravedad”, “supersimetría”, “supercuerdas”, “teoría M” o, en último caso, “teoría de todo” o “gran teoría unificada”.

Ahí tenemos unas matemáticas exóticas que ponen de punta hasta los pelos de las cejas de algunos de los mejores matemáticos del mundo (¿y Perelman?; ¿por qué no se ha implicado?). Hablan de 10, 11 y 26 dimensiones, siempre todas ellas espaciales menos una que es la temporal. Vivimos en cuatro: tres de espacio (este-oeste, norte-sur y arriba-abajo) y una temporal. No podemos ni sabemos, o no nos es posible intuir en nuestro cerebro (también tridimensional), ver más dimensiones. Pero llegaron Kaluza y Klein y compactaron en la longitud de Planck las dimensiones que no podíamos ver; ¡problema solucionado! ¿Quién puede ir a la longitud de Planck para verlas?

La puerta de las dimensiones más altas quedó abierta y a los teóricos se les regaló una herramienta maravillosa: el hiperespacio; todo es posible. Hasta el matrimonio de la relatividad general y la mecánica cuántica, allí sí es posible encontrar esa soñada teoría de la gravedad cuántica.

¡Tiene tántos secretos el Universo!

Así que las teorías se han embarcado a la búsqueda de un objeto audaz: buscan una teoría que describa la simplicidad primigenia que reinaba en el intenso calor del universo en sus primeros tiempos; una teoría carente de parámetros, donde estén presentes todas las respuestas. Todo debe ser contestado a partir de una ecuación básica.

¿Dónde radica el problema?

El problema está en que la única teoría candidata no tiene conexión directa con el mundo de la observación, o no lo tiene todavía si queremos expresarnos con propiedad. La energía necesaria para ello, no la tiene ni el nuevo acelerador de partículas LHC que mencioné en páginas anteriores.

La verdad es que la teoría que ahora tenemos, el modelo estándar, concuerda de manera exacta con todos los datos a bajar energías y contesta cosas sin sentido a altas energías. ¡Necesitamos algo más avanzado!

Se ha dicho que la función de la partícula de Higgs es la de dar masa a las partículas que carecen de ella, disfrazando así la verdadera simetría del mundo. Cuando su autor lanzó la idea al mundo, resultó además de nueva, muy extraña. El secreto de todo radica en conseguir la simplicidad: el átomo resultó ser complejo, lleno de esas infinitesimales partículas electromagnéticas que bautizamos con el nombre de electrones. Resultó que tenía un núcleo que contenía, a pesar de ser tan pequeño, casi toda la masa del átomo. El núcleo, tan pequeño, estaba compuesto de otros objetos más pequeños aún; los quarks que estaban instalados en nubes de otras partículas llamadas gluones, y ahora queremos continuar profundizando, sospechando que después de los quarks puede haber algo más.

Con los últimos experimentos en el LHC, podemos leer declaraciones como éstas:

“…confirmaron que durante este año, tal y como se ha anunciado hace semanas, se ha obtenido una auténtica marea de datos que dejan poco o ningún lugar a dudas sobre la existencia de la partícula que la teoría considera responsable de la masa de todas las demás partículas y sin la que el Universo, sencillamente no existiría tal y como lo conocemos.”

En 1964 se predijo la existencia de esa partícula

Bueno, la idea nueva que surgió es que el espacio entero contiene un campo, el campo de Higgs, que impregna el vacío y es el mismo en todas partes, es decir, que si miramos a las estrellas en una noche clara, estamos mirando el campo de Higgs. Las partículas influidas por este campo toman masa. Esto no es por sí mismo destacable, pues las partículas pueden tomar energía de los campos (gauge) de los que hemos comentado: del campo gravitatorio o del electromagnético. Si llevamos un bloque de plomo a lo alto de la Torre Eiffel, el bloque adquirirá energía potencial a causa de la alteración de su posición en el campo gravitatorio de la Tierra. Como E = mc2, ese aumento de la energía potencial equivale a un aumento de la masa, en este caso la masa del sistema Tierra-bloque de plomo. Aquí hemos de añadirle amablemente un poco de complejidad a la venerable ecuación de Einstein: la masa, m, tiene en realidad dos partes; una es la masa en reposo, m0, la que se mide en el laboratorio cuando la partícula está en reposo. La partícula adquiere la otra parte de la masa en virtud de su movimiento (como los protones en el acelerador de partículas, o los muones, que aumentan varias veces su masa cuando son lanzados a velocidades cercanas a c), o en virtud de su energía potencial de campo. Vemos una dinámica similar en los núcleos atómicos. Por ejemplo, si separamos el protón y el neutrón que componen un núcleo de deuterio, la suma de las masas aumenta.

Pero la energía potencial tomada del campo de Higgs difiere en varios aspectos de la acción de los campos familiares. La masa tomada de Higgs es en realidad masa en reposo. De hecho, en la que quizá sea la versión más apasionante de la teoría del campo de Higgs, éste genera toda la masa en reposo. Otra diferencia es que la cantidad de masa que se traga del campo es distinta para las distintas partículas. Los teóricos dicen que las masas de las partículas de nuestro modelo estándar miden con qué intensidad se acoplan éstas al campo de Higgs.

La influencia de Higgs en las masas de los quarks y de los leptones nos recuerda el descubrimiento por Pieter Zeeman, en 1.896, de la división de los niveles de energía de un electrón cuando se aplica un campo magnético al átomo. El campo (que representa metafóricamente el papel de Higgs) rompe la simetría del espacio de la que el electrón disfrutaba.

Hasta ahora no tenemos ni idea de qué reglas controlan los incrementos de masa generados por Higgs (de ahí la expectación creada por el nuevo acelerador de partículas LHC), pero el problema es irritante: ¿por qué sólo esas masas - las masas de los W+, W–, Z0, y el up, down, encanto, estraño, top y bottom, así como los leptones – que no forman ningún patrón obvio?

Las masas van desde la del electrón (0’0005 GeV) a la del top, que tiene que ser mayor que 91 GeV. Deberíamos recordar que esta extraña idea (el Higgs) se empleó con mucho éxito para formular la teoría electrodébil (Weinberg-Salam). Allí se propuso el campo de Higgs como una forma de ocultar la unidad de las fuerzas electromagnética y débil. En la unidad hay cuatro partículas mensajeras sin masa – los W+, W–, Z0 y el fotón – que llevan la fuerza electrodébil. Además está el campo de Higgs, y rápidamente, los W y Z absorben la esencia de Higgs y se hacen pesados; el fotón permanece intacto. La fuerza electrodébil se fragmenta en la débil (débil porque los mensajeros son muy gordos), y la electromagnética, cuyas propiedades determina el fotón, carente de masa. La simetría se rompe espontáneamente, dicen las teorías. Prefiero la descripción según la cual el Higgs oculta la simetría con su poder dador de masa.

Las masas de los W y Z se predijeron con éxito a partir de los parámetros de la teoría electrodébil, y las relajadas sonrisas de los físicos teóricos nos recuerdan que Hooft y Veltman dejaron sentado que la teoría entera está libre de infinitos.

Todos los intentos y los esfuerzos por hallar una pista de cuál era el origen de la masa fallaron. Feynman escribió su famosa pregunta: “¿por qué pesa el muón?”. Ahora, por lo menos, tenemos una respuesta parcial, en absoluto completa. Una voz potente y segura nos dice “¡Higgs!”. Durante más de sesenta años los físicos experimentadores se rompieron la cabeza con el origen de la masa, y ahora el campo de Higgs presenta el problema en un contexto nuevo; no se trata sólo del muón. Proporciona, por lo menos, una fuente común para todas las masas. La nueva pregunta feynmaniana podría ser: ¿cómo determina el campo de Higgs la secuencia de masas, aparentemente sin patrón, que da a las partículas de la materia?

La variación de la masa con el estado de movimiento, el cambio de masa con la configuración del sistema y el que algunas partículas (el fotón seguramente, y los neutrinos posiblemente) tengan masa en reposo nula son tres hechos que ponen en entredicho que el concepto de masa sea un atributo fundamental de la materia. Habrá que recordar aquel cálculo de la masa que daba infinito y nunca pudimos resolver; los físicos sólo se deshicieron de él “renormalizándolo”, ese truco matemático que empleam cuando no saben hacerlo bien.

¿Sabremos alguna vez cómo adquieren masa las partículas?

Ese es el problema de trasfondo con el que tenemos que encarar el problema de los quarks, los leptones y los vehículos de las fuerzas, que se diferencian por sus masas. Hace que la historia de Higgs se tenga en pie: la masa no es una propiedad intrínseca de las partículas, sino una propiedad adquirida por la interacción de las partículas y su entorno.

La idea de que la masa no es intrínseca como la carga o el espín resulta aún más plausible por la idílica idea de que todos los quarks y fotones tendrían masa cero. En ese caso, obedecerían a una simetría satisfactoria, la quiral, en la que los espines estarían asociados para siempre con su dirección de movimiento. Pero ese idilio queda oculto por el fenómeno de Higgs.

Una cosa más; hemos hablado de los bosones gauge y de su espín de una unidad. Hemos comentado también las partículas fermiónicas de la materia (espín de media unidad). ¿Cuál es el pelaje de Higgs? Es un bosón de espín cero. El espín supone una direccionalidad en el espacio, pero el campo de Higgs da masa a los objetos donde quiera que estén y sin direccionalidad. Al Higgs se le llama a veces “bosón escalar” (sin dirección) por esa razón.

La interacción débil, recordaréis, fue inventada por E. Fermi para describir la desintegración radiactiva de los núcleos, que era básicamente un fenómeno de poca energía, y a medida que la teoría de Fermi se desarrolló, llegó a ser muy precisa a la hora de predecir un enorme número de procesos en el dominio de energía de los 100 MeV. Así que ahora, con las nuevas tecnologías y energías del LHC, las esperanzas son enormes para, por fin, encontrar el bosón de Higgs “origen de la masa”… y algunas cosas más.

Hay que responder montones de preguntas: ¿cuáles son las propiedades de las partículas de Higgs? y, lo que es más importante, ¿cuál es su masa? ¿Cómo reconoceremos una si nos la encontramos en una colisión del LHC? ¿Cuántos tipos hay? ¿Genera el Higgs todas las masas o sólo las hace incrementarse? ¿Cómo podemos saber más al respecto? Cómo es su partícula, nos cabe esperar que la veremos ahora después de gastar más de 50.000 millones de euros en los elementos necesarios para ello.

También a los cosmólogos les fascina la idea de Higgs, pues casi se dieron de bruces con la necesidad de tener campos escalares que participasen en el complejo proceso de la expansión del universo, añadiendo pues, un peso más a la carga que ha de soportar el Higgs.

Existirán los campos de Higgs, o…

… sólo será una creación de la mente.

El campo de Higgs, tal como se lo concibe ahora, se puede destruir con una energía grande, o temperaturas altas. Éstas generan fluctuaciones cuánticas que neutralizan el campo de Higgs. Por lo tanto, el cuado que las partículas y la cosmología pintan juntas de un universo primitivo puro y de resplandeciente simetría es demasiado caliente para Higgs. Pero cuando la temperatura cae bajo los 10-5 grados Kelvin o 100 GeV, el Higgs empieza a actuar y hace su generación de masas. Así, por ejemplo, antes del Higgs teníamos unos W, Z y fotones sin masa y la fuerza electrodébil unificada.

El universo se expande y se enfría, y entonces viene el Higgs (que “engorda” los W y Z, y por alguna razón ignora el fotón) y de ello resulta que la simetría electrodébil se rompe.

Tenemos entonces una interacción débil, transportada por los vehículos de la fuerza W+, W–, Z0, y por otra parte una interacción electromagnética, llevada por los fotones. Es como si para algunas partículas del campo de Higgs fuera una especie de aceite pesado a través del que se moviera con dificultad y que les hiciera parecer que tienen mucha masa. Para otras partículas, el Higgs es como el agua, y para otras, los fotones y quizá los neutrinos, es invisible.

De todas formas, es tanta la ignorancia que tenemos sobre el origen de la masa que nos agarramos como a un clavo ardiendo, en este caso, a la partícula de Higgs, que algunos han llegado a llamar “la partícula divina”.

¡Ya veremos en qué termina todo esto!

Sí, dudas hemos tenido todos

Hay otras muchas cuestiones de las que podríamos hablar y, la Física y la Astronomía, siendo mi gran Pasión, ocupa mucho de mi tiempo. La Física, amigos míos, nos dirá como es el “mundo” y digo mundo querinedo significar Naturaleza y Universo. La Física encierra una belleza…, que está presente en:

- Una simetría unificadora.

- La capacidad de explicar grandes cantidades de datos experimentales con las expresiones matemáticas más económicas.

El Modelo Estándar falla en ambos aspectos, mientras que la relatividad general los exhibe, ambos, de manera bien patente. Nunca una teoría dijo tanto con tan poco; su sencillez es asombrosa y su profundidad increíble.De hecho, desde que se publicó en 1.915, no ha dejado de dar frutos, y aún no se han obtenido de ella todos los mensajes que contiene.

emilio silvera

Dic

20

La vida y la muerte de las partículas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (5)

Comments (5)

Cuando hablamos del tiempo de vida de una partícula nos estamos refiriendo al tiempo de vida medio, una partícula que no sea absolutamente estable tiene, en cada momento de su vida, la misma probabilidad de desintegrarse. Algunas partículas viven más que otras, pero la vida media es una característica de cada familia de partículas.

También podríamos utilizar el concepto de “semivida”. Si tenemos un gran número de partículas idénticas, la semivida es el tiempo que tardan en desintegrarse la mitad de ese grupo de partículas. La semivida es 0,693 veces la vida media.

Si miramos una tabla de las partículas más conocidas y familiares (fotón, electrón muón tau, la serie de neutrinos, los mesones con sus piones, kaones, etc., y, los Hadrones bariones como el protón, neutrón, lambda, sigma, ksi y omega, en la que nos expliquen sus propiedades de masa, carga, espín, vida media (en segundos) y sus principales manera de desintegración, veríamos como difieren las unas de las otras.

Algunas partículas tienen una vida media mucho más larga que otras. De hecho, la vida media difiere enormemente. Un neutrón por ejemplo, vive 10¹³ veces más que una partícula Sigma⁺, y ésta tiene una vida 10⁹ veces más larga que la partícula sigma cero. Pero si uno se da cuenta de que la escala de tiempo “natural” para una partícula elemental (que es el tiempo que tarda su estado mecánico-cuántico, o función de ondas, en evolucionar u oscilar) es aproximadamente 10ˉ²⁴ segundos, se puede decir con seguridad que todas las partículas son bastantes estables. En la jerga profesional de los físicos dicen que son “partículas estables”.

¿Cómo se determina la vida media de una partícula? Las partículas de vida larga, tales como el neutrón y el muón, tienen que ser capturadas, preferiblemente en grandes cantidades, y después se mide electrónicamente su desintegración. Las partículas comprendidas entre 10ˉ¹⁰ y 10ˉ⁸ segundos solían registrarse con una cámara de burbujas, pero actualmente se utiliza con más frecuencia la cámara de chispas. Una partícula que se mueve a través de una cámara de burbujas deja un rastro de pequeñas burbujas que puede ser fotografiado. La Cámara de chispas contiene varios grupos de de un gran número de alambres finos entrecruzados entre los que se aplica un alto voltaje. Una partícula cargada que pasa cerca de los cables produce una serie de descargas (chispas) que son registradas electrónicamente. La ventaja de esta técnica respecto a la cámara de burbujas es que la señal se puede enviar directamente a una computadora que la registra de manera muy exacta.

Una partícula eléctricamente neutra nunca deja una traza directamente, pero si sufre algún tipo de interacción que involucre partículas cargadas (bien porque colisionen con un átomo en el detector o porque se desintegren en otras partículas), entonces desde luego que pueden ser registradas. Además, realmente se coloca el aparato entre los polos de un fuerte imán. Esto hace que la trayectoria de las partículas se curve y de aquí se puede medir la velocidad de las partículas. Sin embargo, como la curva también depende de la masa de la partícula, es conveniente a veces medir también la velocidad de una forma diferente.

En un experimento de altas energías, la mayoría de las partículas no se mueven mucho más despacio que la velocidad de la luz. Durante su carta vida pueden llegar a viajar algunos centímetros y a partir de la longitud media de sus trazas se puede calcular su vida. Aunque las vidas comprendidas entre 10ˉ¹³ y 10ˉ²⁰ segundos son muy difíciles de medir directamente, se pueden determinar indirectamente midiendo las fuerzas por las que las partículas se pueden transformar en otras. Estas fuerzas son las responsables de la desintegración y, por lo tanto, conociéndolas se puede calcular la vida de las partículas, Así, con una pericia ilimitada los experimentadores han desarrollado todo un arsenal de técnicas para deducir hasta donde sea posible todas las propiedades de las partículas. En algunos de estos procedimientos ha sido extremadamente difícil alcanzar una precisión alta. Y, los datos y números que actualmente tenemos de cada una de las partículas conocidas, son los resultados acumulados durante muchísimos años de medidas experimentales y de esa manera, se puede presentar una información que, si se valorara en horas de trabajo y coste de los proyectos, alcanzaría un precio descomunal pero, esa era, la única manera de ir conociendo las propiedades de los pequeños componentes de la materia.

Que la mayoría de las partículas tenga una vida media de 10ˉ⁸ segundos significa que son ¡extremadamente estables! La función de onda interna oscila más de 10²² veces/segundo. Este es el “latido natural de su corazón” con el cual se compara su vida. Estas ondas cuánticas pueden oscilar 10ˉ⁸ x 10²², que es 1¹⁴ o 100.000.000.000.000 veces antes de desintegrarse de una u otra manera. Podemos decir con toda la seguridad que la interacción responsable de tal desintegración es extremadamente débil.

Aunque la vida de un neutrón sea mucho más larga (en promedio un cuarto de hora), su desintegración también se puede atribuir a la interacción débil. A propósito, algunos núcleos atómicos radiactivos también se desintegran por interacción débil, pero pueden necesitar millones e incluso miles de millones de años para ello. Esta amplia variación de vidas medias se puede explicar considerando la cantidad de energía que se libera en la desintegración. La energía se almacena en las masas de las partículas según la bien conocida fórmula de Einstein E = Mc². Una desintegración sólo puede tener lugar si la masa total de todos los productos resultantes es menor que la masa de la partícula original. La diferencia entre ambas masas se invierte en energía de movimiento. Si la diferencia es grande, el proceso puede producirse muy rápidamente, pero a menudo la diferencia es tan pequeña que la desintegración puede durar minutos o incluso millones de años. Así, lo que determina la velocidad con la que las partículas se desintegran no es sólo la intensidad de la fuerza, sino también la cantidad de energía disponible.

Si no existiera la interacción débil, la mayoría de las partículas serían perfectamente estables. Sin embargo, la interacción por la que se desintegran las partículas π°, η y Σ° es la electromagnética. Se observará que estas partículas tienen una vida media mucho más corta, aparentemente, la interacción electromagnética es mucho más fuerte que la interacción débil.

Durante la década de 1950 y 1960 aparecieron tal enjambre de partículas que dio lugar a esa famosa anécdota de Fermi cuando dijo: “Si llego a adivinar esto me hubiera dedicado a la botánica.”

Si la vida de una partícula es tan corta como 10ˉ²³ segundos, el proceso de desintegración tiene un efecto en la energía necesaria para producir las partículas ante de que se desintegre. Para explicar esto, comparemos la partícula con un diapasón que vibra en un determinado modo. Si la “fuerza de fricción” que tiende a eliminar este modo de vibración es fuerte, ésta puede afectar a la forma en la que el diapasón oscila, porque la altura, o la frecuencia de oscilación, está peor definida. Para una partícula elemental, esta frecuencia corresponde a su energía. El diapasón resonará con menor precisión; se ensancha su curva de resonancia. Dado que para esas partículas extremadamente inestable se miden curvas parecidas, a medida se las denomina resonancias. Sus vidas medias se pueden deducir directamente de la forma de sus curvas de resonancia.

Un ejemplo típico de una resonancia es la delta (∆), de la cual hay cuatro especies ∆ˉ, ∆⁰, ∆⁺ y ∆⁺⁺(esta última tiene doble carga eléctrica). Las masas de las deltas son casi iguales 1.230 MeV. Se desintegran por la interacción fuerte en un protón o un neutrón y un pión.

Existen tanto resonancias mesónicas como bariónicas . Las resonancias deltas son bariónicas. Las resonancias deltas son bariónicas. (También están las resonancias mesónicas rho, P).

Las resonancias parecen ser solamente una especie de versión excitada de los Hadrones estable. Son réplicas que rotan más rápidamente de lo normal o que vibran de diferente manera. Análogamente a lo que sucede cuando golpeamos un gong, que emite sonido mientras pierde energía hasta que finalmente cesa de vibrar, una resonancia termina su existencia emitiendo piones, según se transforma en una forma más estable de materia.

Por ejemplo, la desintegración de una resonancia ∆ (delta) que se desintegra por una interacción fuerte en un protón o neutrón y un pión, por ejemplo:

∆⁺⁺→р + π⁺; ∆⁰→р + πˉ; o п+π⁰

En la desintegración de un neutrón, el exceso de energía-masa es sólo 0,7 MeV, que se puede invertir en poner en movimiento un protón, un electrón y un neutrino. Un Núcleo radiactivo generalmente tiene mucha menos energía a su disposición.

El estudio de los componentes de la materia tiene una larga historia en su haber, y, muchos son los logros conseguidos y muchos más los que nos quedan por conseguir, ya que, nuestros conocimientos de la masa y de la energía (materia), es aún limitado.

emilio silvera

Dic

17

¿La Física? ¡Son tantas cosas!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (5)

Comments (5)

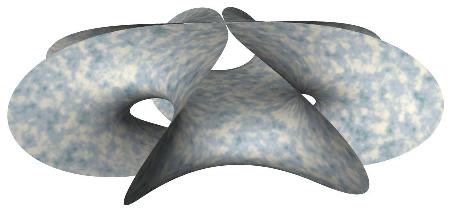

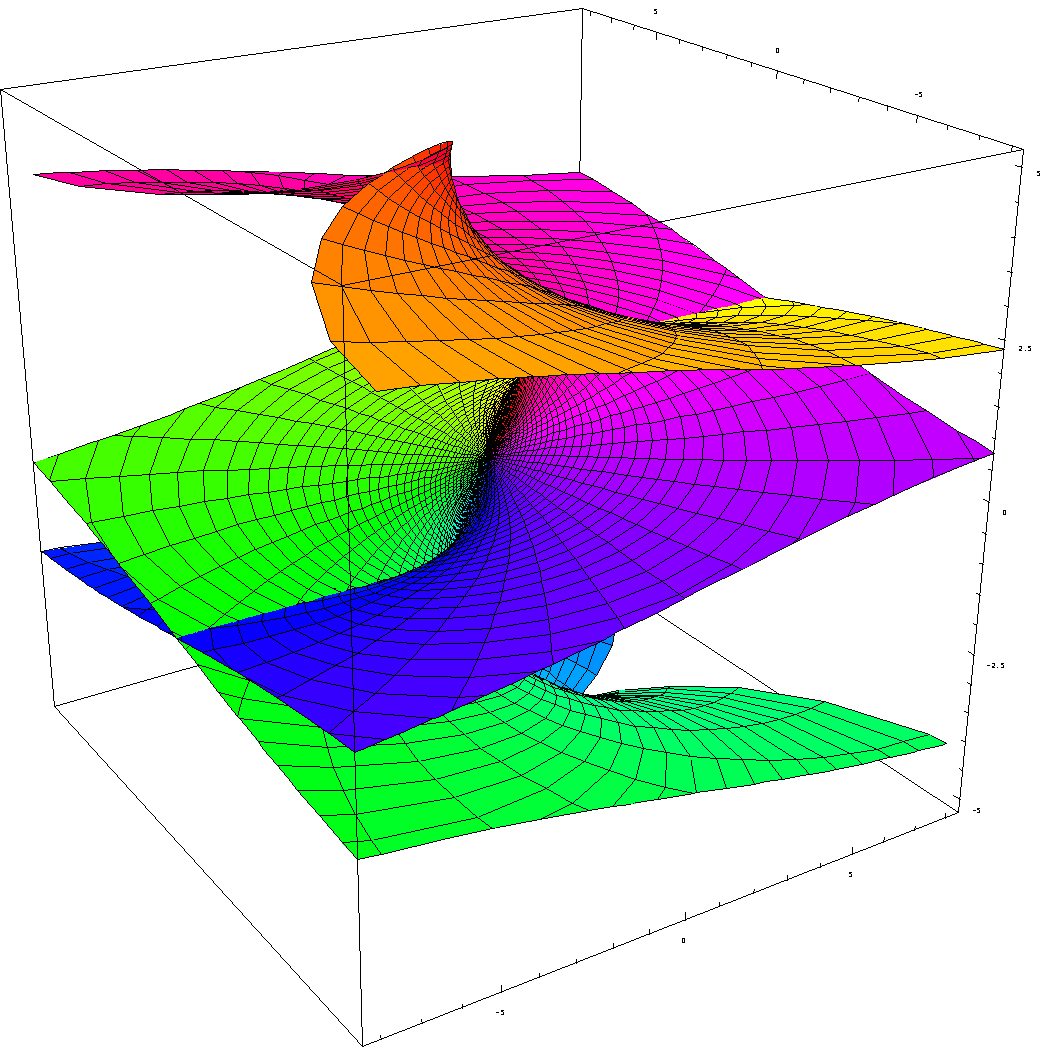

Es cierto lo que decía el profesor venezolano Alberto R. Mejías: “A pesar de carecer actualmente de formulación dinámica, es posible obtener gran cantidad de información sobre Teoría M, teoría que se postula como unificadora de todas las interacciones, a partir de sus sectores perturbacionales y de baja energía. En las regiones perturbacionales adecuadas, la Teoría M adopta la apariencia de la Teoría de Cuerdas. Al considerar su límite de baja energía, surge la supergravedad en once dimensiones. Aquí se indica cómo Teoría M puede ser considerada como una deformación biparamétrica de Geometría Clásica, dónde un parámetro controla la generalización de puntos a lazos y el otro parámetro controla la suma sobre topologías de superficies RIEMANN. La formulación matemática final de Teoría M tendrá que considerar Teoría de Fibrados Vectoriales, Teoría K y Geometría No Conmutativa.

Y es cierto que, actualmente, la Teoría M nos conduce de manera directa hasta el objeto matemático más complejo y más rico que jamás se ha tocado en Física. Finalmente, nos lleva a la unificación de todas las grandes teorías anteriores y consigue, de manera natural, unificar la relatividad general de Einstein con la cuántica de Planck. Es decir, allí, en la Toería M, se describen juntas las cuatro fuerzas de la Naturaleza. Lo curioso del caso es que, cuando se desarrollan las ecuaciones de esta compleja teoría, aparezcan las ecuaciones de Einstein de la Relatividad General que, subyacen dentro de ella.

Lo cierto es que, si miramos hacia atrás en el tiempo, nos encontramos con el hecho cierto de que, Einstein pudo formular su bella teoría de la relatividad general gracias a una conferencia que dio Riemann y que, habiendo pedido ayuda a su amigo Marcel Grosmman, éste le mandara una copia en la que, aparecía el Tensor Métrico de Riemann que le dio a Einstein las herramientas de las que carecía.

Aquel trabajo de Riemann, su ensayo, de profunda importancia y elegancia excepcional, “sobre las hipótesis que subyacen en los fundamentos de la geometría” derribó pilares de la geometría clásica griega, que habían resistido con éxito todos los asaltos de los escépticos durante dos milenios. La vieja geometría de Euclides, en la cual todas las figuras geométricas son de dos o tres dimensiones, se venía abajo, mientras una nueva geometría riemanniana surgía de sus ruinas. La revolución riemanniana iba a tener grandes consecuencias para el futuro de las artes y las ciencias. En menos de tres decenios, la “misteriosa cuarta dimensión” influiría en la evolución del arte, la filosofía y la literatura en toda Europa. Antes de que hubieran pasado seis decenios a partir de la conferencia de Riemann, Einstein utilizaría la geometría riemanniana tetradimensional para explicar la creación del universo y su evolución mediante su asombrosa teoría de la relatividad general. Ciento treinta años después de su conferencia, los físicos utilizarían la geometría decadimensional para intentar unir todas las leyes del universo. El núcleo de la obra de Riemann era la comprensión de las leyes físicas mediante su simplificación al contemplarlas en espacios de más dimensiones.

De todo aquello y buscando nuevos caminos para poder responder a preguntas planteadas que nadie había sabido contestar, surgieron teorías que, como la de Kaluza-Klein, nos trajeron hasta la supersimetría, supergravedad y a todas lasversiones de la teoría de cuerdas que Witten ha unificado en la Teoría M. Pensar en las complejas matemáticas topológicas requeridas por la teoría de supercuerdas puede producir incomodidad en muchas personas que, aún siendo físicos, no están tan capacitados para entender tan profundas ideas.

Bernhard Riemann introdujo muchas nuevas ideas y fue uno de los más grandes matemáticos. En su corta vida (1.826 – 1.866) propuso innumerables propuestas matemáticas que cambiaron profundamente el curso del pensamiento de los números en el planeta Tierra, como el que subyace en la teoría relativista en su versión general de la gravedad, entre otras muchas (superficie de Riemann, etc.). Riemann les enseñó a todos a considerar las cosas de un modo diferente.

- Numerosos ejemplos de superficies de Riemann no compactas se obtienen por el procedimiento de extensión analítica.

La superficie de Riemann asociada a la función holomorfa “tiene su propia opinión” y decide por sí misma cuál debería ser el, o mejor, su dominio, con independencia de la región del plano complejo que nosotros podamos haberle asignado inicialmente.

Podríamos encontrar otros muchos tipos de superficies de Riemann.

Este bello concepto desempeña un papel importante en algunos de los intentos modernos de encontrar una nueva base para la física matemática (muy especialmente en la teoría de cuerdas), y al final, seguramente descubrirá el mensaje que encierra.

El caso de las superficies de Riemann es fascinante, aunque desgraciadamente sólo es para iniciados. Proporcionaron los primeros ejemplos de la noción general de variedad, que es un espacio que puede pensarse “curvado” de diversas maneras, pero que localmente (por ejemplo, en un entorno pequeño de cualquiera de sus puntos), parece un fragmento de espacio euclídeo ordinario.

La esfera de Riemann juega un papel fundamental en cualquier sistema cuántico de dos estados, describiendo el conjunto de estados cuánticos posibles. Para una partícula de espín 1/2, su papel geométrico es particularmente evidente puesto que los puntos de la esfera corresponden a las posibles direcciones espaciales para el eje de giro. En otras situaciones el papel de la esfera de posibilidades de Riemann está bastante más oculto, con una relación mucho menos clara con la geometría espacial.

Si estudiamos de manera profunda lo que Riemann nos legó, tendremos que convenir en el hecho irrefutable de que fue, junto con otros grandes matemáticos, uno de los que posibilitaron que la humanidad siguiera avanzando en el conmocimiento de la Naturaleza. La esfera de Riemann, superficie de Riemann compacta, el teorema de la aplicación de Riemann, las superficies de Riemann y aplicaciones complejas… Todo de una enorme importancia para las matemáticas en general y la geometría en particular… y, para la física también.

Ernst Mach

Einstein supo captar algunas buenas ideas sueltas que aunó en un sólo conjunto para convertirlas en teoría unificada de todas ellas que sueltas no decían tanto como juntas y bien colocadas. Así, hizo suyos los conceptos de Mach, Lorentz, Maxwell e incluso Galileo y finalmente Riemann -entre otros- para dejar sentadas las bases de cómo era la Naturaleza mediante las dos versiones de la teoría relativista, la especial y la general.

“La inercia de cualquier sistema es el resultado de su interacción con el resto del Universo. En otras palabras, cada partícula del universo ejerce una influencia sobre todas las demás partículas.”

Este concepto le hizo pensar profundamente y le llevó a todas sus ideas de la relatividad general que pudo exponer gracias a Riemann. Sin la geometría de Riemann de los espacios curvos, sin su tensor métrico…

En escritos anteriores consideramos dos aspectos de la relatividad general de Einstein, a saber, el principio de la relatividad, que nos dice que las leyes de la física son ciegas a la distinción entre reposo y movimiento uniforme; y el principio de equivalencia, que nos dice de qué forma sutil deben modificarse estas ideas para englobar el campo gravitatorio.

Ahora hay que hablar del tercer ingrediente fundamental de la teoría de Einstein, que está relacionada con la finitud de la velocidad de la luz. Es un hecho notable que estos tres ingredientes básicos puedan remontarse a Galileo; en efecto, parece que fue también Galileo el primero que tuvo una expectativa clara de que la luz debería viajar con velocidad finita, hasta el punto de que intentó medir dicha velocidad. El método que propuso (1.638), que implica la sincronización de destellos de linternas entre colinas distantes, era, como sabemos hoy, demasiado tosco. Él no tenía forma alguna de anticipar la extraordinaria velocidad de la luz.

Parece que tanto Galileo como Newton tenían poderosas sospechas respecto a un profundo papel que conecta la naturaleza de la luz con las fuerzas que mantienen la materia unida.

Pero la comprensión adecuada de estas ideas tuvo que esperar hasta el siglo XX, cuando se reveló la verdadera naturaleza de las fuerzas químicas y de las fuerzas que mantienen unidos los átomos individuales. Ahora sabemos que tales fuerzas tienen un origen fundamentalmente electromagnético (que vincula y concierne a la implicación del campo electromagnético con partículas cargadas) y que la teoría del electromagnetismo es también la teoría de la luz.

Para entender los átomos y la química se necesitan otros ingredientes procedentes de la teoría cuántica, pero las ecuaciones básicas que describen el electromagnetismo y la luz fueron propuestas en 1.865 por el físico escocés James Clark Maxwell, que había sido inspirado por los magníficos descubrimientos experimentales de Michael Faraday unos treinta años antes y que él plasmó en una maravillosa teoría que Einstein también aprovechó para la suya.

Esta teoría del electromagnetismo de Maxwell tenía la particularidad de que requería que la velocidad de la luz tuviera un valor fijo y definido, que normalmente se conoce como c, y que un unidades ordinarias es aproximadamente 3 × 108 metros por segundo.

Sin embargo, esto nos presenta un enigma si queremos conservar el principio de relatividad. El sentido común nos diría que si se mide que la velocidad de la luz toma el valor concreto c en el sistema de referencia del observador, entonces un segundo observador que se mueva a una velocidad muy alta con respecto al primero medirá que la luz viaja a una velocidad diferente, aumentada o disminuida, según sea el movimiento del segundo observador.

Pero el principio de relatividad exigiría que las leyes físicas del segundo observador (que definen en particular la velocidad de la luz que percibe el segundo observador) deberían ser idénticas a las del primer observador. Esta aparente contradicción entre la constancia de la velocidad de la luz y el principio de relatividad condujo a Einstein (como de hecho, había llevado previamente al físico holandés Hendrick Antón Lorentz y muy en especial al matemático francés Henri Poincaré) a un punto de vista notable por el que el principio de relatividad del movimiento puede hacerse compatible con la constancia de una velocidad finita de la luz.

La velocidad de la luz en el vacío es la misma para todos los observadores inerciales, independientemente del estado de movimiento de la fuente de luz, c siempre irá a la velocidad de 299.792.458 metros por segundo.

En el caso de un espacio tiempo bidimensional (x,t) representamos el cono de luz como dos líneas cruzadas, una de pendiente 1 y otra de pendiente -1.(Estamos normalizando la velocidad de la luz al valor c=1).

¿Cómo funciona esto? Sería normal que cualquier persona creyera en la existencia de un conflicto irresoluble entre los requisitos de una teoría como la de Maxwell, en la que existe una velocidad absoluta de la luz, y un principio de relatividad según el cual las leyes físicas parecen las mismas con independencia de la velocidad del sistema de referencia utilizado para su descripción.

¿No podría hacerse que el sistema de referencia se moviera con una velocidad que se acercara o incluso superara a la de la luz? Y según este sistema, ¿no es cierto que la velocidad aparente de la luz no podría seguir siendo la misma que era antes? Esta indudable paradoja no aparece en una teoría, tal como la originalmente preferida por Newton (y parece que también por Galileo), en la que la luz se comporta como partículas cuya velocidad depende de la velocidad de la fuente. En consecuencia, Galileo y Newton podían seguir viviendo cómodamente con un principio de relatividad.

Pero semejante imagen de la naturaleza de la luz había entrado en conflicto con la observación a lo largo de los años, como era el caso de observaciones de estrellas dobles lejanas que mostraban que la velocidad de la luz era independiente de la de su fuente. Por el contrario, la teoría de Maxwell había ganado fuerza, no sólo por el poderoso apoyo que obtuvo de la observación (muy especialmente en los experimentos de Heinrich Hertz en 1.888), sino también por la naturaleza convincente y unificadora de la propia teoría, por la que las leyes que gobiernan los campos eléctricos, los campos magnéticos y la luz están todos subsumidos en un esquema matemático de notable elegancia y simplicidad.

En la teoría de Maxwell, la luz toma forma de ondas, no de partículas, y debemos enfrentarnos al hecho de que en esta teoría hay realmente una velocidad fija a la que deben viajar las ondas luminosas.

El punto de vista geométrico-espaciotemporal nos proporciona una ruta particularmente clara hacia la solución de la paradoja que presenta el conflicto entre la teoría de Maxwell y el principio de relatividad.

Este punto de vista espaciotemporal no fue el que Einstein adoptó originalmente (ni fue el punto de vista de Lorentz, ni siquiera, al parecer, de Poincaré), pero, mirando en retrospectiva, podemos ver la potencia de este enfoque. Por el momento, ignoremos la gravedad y las sutilezas y complicaciones asociadas que proporciona el principio de equivalencia y otras complejas cuestiones, que estimo aburrirían al lector no especialista, hablando de que en el espacio-tiempo se pueden concebir familias de todos los diferentes rayos de luz que pasan a ser familias de líneas de universo, etc.

Baste saber que, como quedó demostrado por Einstein, la luz, independientemente de su fuente y de la velocidad con que ésta se pueda mover, tendrá siempre la misma velocidad en el vacío, c, o 299.792.458 metros por segundo. Cuando la luz atraviesa un medio material, su velocidad se reduce. Precisamente, es la velocidad c el límite alcanzable de la velocidad más alta del universo. Es una constante universal y, como hemos dicho, es independiente de la velocidad del observador y de la fuente emisora.

En alguna ocasión (como contrapunto) he puesto el ejemplo del principio de relatividad contrario a lo que acabo de explicar: el niño que viaja con su padre en un tren que marcha a la velocidad de 80 Km/h. Ambos están asomados por la ventanilla del tren. El niño, en el momento de pasar junto a la estación (en la que el jefe de estación parado en el andén, observa el paso del tren), arroja una pelota por la ventanilla que sale disparada de su mano, en la misma dirección de la marcha del tren, a 20 Km/h. Ahora, tanto el padre del niño como el jefe de estación, tienen un aparato que mide la velocidad de la pelota. El resultado es dispar: el jefe de estación ve que su aparato estima la velocidad de la pelota en 100 Km/h, mientras que el padre del niño la sitúa en 20 km/h. La explicación es sencilla. El aparato del jefe de estación, parado e inmóvil al medir la velocidad de la pelota obtiene el resultado de la suma de la velocidad del tren (80 Km/h) y de la velocidad de impulso del lanzamiento (20 Km/h), pero el padre del niño, montado en el tren que marcha a 80 Km/h, está en movimiento, y su aparato también, con lo cual sólo puede medir la velocidad de lanzamiento (20 Km/h). Así que las dos mediciones del mismo fenómeno nos ha dado un resultado muy diferente, todo vez que depende del observador y de que esté en reposo o en movimiento.

¡Dichoso niño! Nos ha demostrado que, en ciertas situaciones…sí importa el movimiento

Sin embargo, la velocidad de la luz es invariante, y si pudiéramos suponer que el niño lanzaba un rayo de luz en lugar de una pelota, tanto el jefe de estación como el padre del niño habrían medido la misma velocidad. La luz corre siempre lo mismo, independientemente de que su fuente esté parada o en movimiento, o de que el observador que la mida esté en reposo o en movimiento. Sin embargo, el fenómeno de ralentización del tiempo, cuando se viaja a velocidades relativistas, es otra historia.

La imagen espaciotemporal fue introducida por primera vez por Hermann Minkowski (1.864 – 1.909), que era un matemático extraordinariamente bueno y original. Casualmente él fue también uno de los profesores de Einstein en el ETH, Instituto Federal de Tecnología de Zurich, a finales de la última década del siglo XIX.

De hecho, la idea misma del espacio-tiempo es de Minkowski, que habiendo leído la teoría de la relatividad especial de su antiguo alumno, en 1.908 escribía:

“En lo sucesivo, el espacio por sí solo y el tiempo por sí solo están condenados a desvanecerse en meras sombras, y sólo un tipo de unión entre ambos conservará una realidad independiente“.

Se deduce de estas palabras que Minkowski, cuando conoció la teoría de la relatividad de Einstein sacó sus propias consecuencias, y a pesar de las maravillosas intuiciones físicas de su alumno y de las excelentes contribuciones de Lorentz y Poincaré, fue él, Minkowski, el que aportó un punto de vista fundamental y revolucionario, el espacio-tiempo, la geometría subyacente en la teoría de la relatividad especial.

Hermann Minkowski

Sumergirse en este tema, sin que nos demos cuenta, nos puede llevar a plantearnos complejos tales como que la geometría de Minkowski tiene grupos de simetría tan grandes como el que tiene el espacio-tiempo G de la física galileana, y no sólo están todos los puntos M (Minkowski) en pie de igualdad, sino que todas las velocidades posibles (direcciones de género tiempo que apuntan al futuro) están también en pie de igualdad entre sí.

Para evitar meterme en un callejón sin salida (para mí), dejaré aquí el giro que está tomando el trabajo que, sin que pueda impedirlo, y como si tuviera vida propia, profundiza y se hace más complejo hasta sobrepasar mis limitados conocimientos. De todas las maneras, tendremos que convenir en el hecho cierto de que, en Física, han pasado cosas que te cortan la respiración, como por ejempo:

La ecuación de Dirac de ondas relativista de la mecánica cuántica fue formulada por Paul Dirac en 1928. Da una descripción de las partículas elementales de espín ½, como el electrón, y es completamente consistente con los principios de la mecánica cuántica y de la teoría de la relatividad especial. Además de dar cuenta del espín, la ecuación predice la existencia de antipartículas

La ecuación de Dirac para el electrón supuso un momento crucial para la física en muchos aspectos. En 1.928, cuando Dirac propuso su ecuación, las únicas partículas conocidas para la ciencia eran los electrones, los protones y los fotones. Las ecuaciones de Maxwell libres describen el fotón (como fue previsto por Einstein en 1.905) en un primer trabajo cuyas ideas fueron desarrolladas por Einstein, Bose y otros, hasta que en 1.927 Jordan y Pauli proporcionaron un esquema matemático global para describir los fotones libres de acuerdo con la teoría de Maxwell para el campo libre cuantizado.

Además, tanto el protón como el electrón, parecían estar muy bien descritos por las ecuaciones de Dirac. La interacción electromagnética, que describe la influencia de los fotones sobre los electrones y los protones, estaba excepcionalmente tratada mediante la receta de Dirac, a saber, mediante la idea gauge (tal como fue introducida básicamente por Weyl en 1.918), y el propio Dirac ya había empezado a construir el 1.927 una formulación de una teoría completa de los electrones (o protones) en interacción con protones.

Así pues, todas las herramientas básicas parecían estar más o menos a punto para la descripción de todas las partículas conocidas de la naturaleza, junto con sus más destacadas interacciones.

Los físicos de la época no eran tan ilusos como para pensar que todo aquello les pudiera llevar pronto a una “teoría del todo”. Eran conscientes de que, ni las fuerzas necesarias para mantener unidos los núcleos (las que ahora llamamos nuclear fuerte) ni los mecanismos responsables de la desintegración radiactiva (ahora fuerza nuclear débil) podrían acomodarse sin importantes avances adicionales.

Allí algo no estaba bien, ya que si los electrones y los protones estilo Dirac, que sólo interaccionaban electromagnéticamente, fueran los únicos ingredientes de los átomos, incluyendo sus núcleos, entonces todos los núcleos ordinarios (excepto el simple protón que constituye el núcleo de hidrógeno) se desintegrarían al instante debido a la repulsión electrostática de las cargas positivas predominantes.

¡Tenía que estar actuando alguna otra cosa desconocida, algo que explicara una fuerte influencia atractiva dentro del núcleo! En 1.932, Chadwick descubrió el neutrón, y se comprendió por fin que el modelo protón/electrón para el núcleo, que había sido popular hasta entonces, debía ser reemplazado por otro en el que los protones y los neutrones estarían presentes, y donde una fuerte interacción protón-neutrón mantendría el núcleo unido.

Pero esta fuerza fuerte no era lo único que faltaba en el conocimiento de la época.

La radiactividad del uranio se conocía desde las observaciones de Henri Becquerel en 1.896, y se presentaba como el resultado de otra interacción (la fuerza débil) diferente de la fuerte y de la electromagnética. Incluso un neutrón, si se deja libre, sufriría una desintegración radiactiva en un periodo de unos quince minutos.

Uno de los misteriosos productos de la radiactividad era el evasivo neutrino, propuesto como hipótesis provisional por Pauli en 1.929, aunque no fue obserado directamente hasta 1.956.

Ahora, las cosas se conocen mejor y se dispone de una imagen más completa conocida como modelo estándar de la física de partículas. Este modelo parece acoger casi todo el comportamiento observado concerniente al vasto conjunto de partículas que hoy conocemos. Al fotón, el electrón, el protón, el positrón y el neutrón, se han añadido el muón y los diversos neutrinos, los piones (predichos por Yukawa en 1.934), los kaones, los lambdas, los sigmas y la celebradamente predicha por Gell-Mann, la omega menos.

El antiprotón fue directamente observado en 1.955, y el antineutrón en 1.956. hay nuevos tipos de entidades conocidas como los quarks, gluones, bosones W+, W– y Z0; hay vastas hordas de partículas cuya existencia es tan fugaz que no han sido nunca directamente observadas, por lo que suelen llamar “resonancias”.

El formalismo de la teoría moderna exige así mismo entidades transitorias llamadas partículas “virtuales”, y también cantidades conocidas como “fantasmas” que están aún más lejos de poder ser observadas en directo. Existe un número desmesurado de partículas propuestas (aún no observadas) que son predichas por ciertos modelos teóricos, aunque no son en absoluto consecuencias del andamiaje general de la física de partículas aceptada: a saber, bosones X, axiones, fotinos, gluinos, monopolos magnéticos, dilatones, etc.

Está también la misteriosa partícula de Higgs (aún no observada) cuya existencia, de una u otra forma, es esencial para la física de partículas actual, donde la partícula de Higgs se considera responsable de la masa de todas las partículas.

Bueno, no creo que el gravitón sea tan feo, y, además, algo sí sabemos de él, es un bosón de espín par, ya que está asociado a un campo clásico tensorial de segundo orden. En cuanto a la masa del gravitón las mediciones experimentales dan una cota superior del orden de mg = 1,6 × 10−69 kg, aunque podría ser exactamente cero. Lo cierto es que está siendo muy esquiva ésta partícula a la hora de dejarse pillar. Se cree que es la partícula mediadora de la fuerza gravitatoria y, aunque no está inmersa en el Modelo estándar, sí está descrita por la teoría de Einstein de la Gravedad.

Es bien sabido que la mecánica cuántica (el universo de las partículas subatómicas) y la relatividad general (el universo de los grandes objetos cosmológicos), de momento no han sido unidas; se rechazan mutuamente con una ferocidad asombrosa.

Parece que la teoría de cuerdas no sólo no rechaza estas dos teorías antagónicas, sino que en sus más altas dimensiones las acoge de manera natural, y ambas se complementan para formar un todo en el que tienen cabida el universo de las partículas, de la gravedad, de las fuerzas fundamentales y de la materia.

Es bonito pensar que un día, pasado el tiempo, se contará con ese modelo completo que, sin estridencias, dé cabida a todo y nos lo pueda explicar todo. Un sueño que cada día está más cerca y, si nadie lo remedia y nuestra imaginación sigue funcionando como hasta el momento lo ha venido haciendo… ¡Grandes cosas se verán!

Si hemos sido capaces de vaticinar la existencia del positrón (la antimateria), el neutrino que explica la masa “perdida”, la existencia de agujeros negros, o, llegar hasta el mismo corazón de la materia ¡los átomos! ¿De qué no seremos capaces?

Pero, a todo ésto debenmos aprender con la Ciencia a…dudar de los “expoertos” (como nos recomensaba Feynman).

emilio silvera

Dic

14

¡¡Supercuerdas!! ¿Qué es eso?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (1)

Comments (1)

Algunas veces, cuando nos adentramos en teorías muy avanzadas de la Física que pretende “desnudar” al Universo para conocerlo en su más absoluta desnudez, uno no puede dejar de generar la idea de que, estamos volviendo de nuevo a escenarios mitológicos en los que, la imaginaciónn del hombre dibujaba escenarios que ahora nos pueden parecer demenciales, y, sin embargo, acercarse a ésta nueva Teoria que llaman de supercuerdas… No estámucho más alejado de todo aquello guardando las distancias entre ambas imaginaciones.

Esta “nueva teoría” la de Supercuerdas, nos dice que el Universo consta de diez dimensiones de espacio y una de tiempo que están creadas por delgadas cuerdas que, al mismo modo que si se trataran de las cuerdas de una lira, pueden vibrar, y, al vibrar, van creando partículas con las resonancias o notas que se generan de sus vibraciones.

En la Mitología muchos dioses tocan instrumentos musicales formados por cuerdas que al ser rasgadas suavemente van generando melódicos sonidos y, las diosas tejedoras van hilando el destino del mundo. La lira de Apolo o el Arpa de Orfeo se me vienen a la mente recordando escenas que la mitología nos dejó.

Claro que, llegó Tales de Mileto el antiguos filósofo griego que nació en Mileto en la Jonia griega. Él fue, la fuente principal para la filosofía y la ciencia. Identificado como la primera persona que investigó los principios básicos, la cuestión de las sustancias procedentes de la materia y, por tanto, como el fundador de la escuela de filosofía natural. Thales estaba interesado en casi todo, la investigación de casi todas las áreas del conocimiento, la filosofía, la historia, la ciencia, las matemáticas, la ingeniería, la geografía y la política.

Propuso teorías para explicar muchos de los eventos de la naturaleza, la sustancia primordial, la importancia que tenía el agua para la vida, el apoyo de la tierra, y las causas de los cambios. Thales estaba muy involucrado en los problemas de la astronomía y formuló una serie de explicaciones de los acontecimientos cosmológicos en los que, (se decía) que tradicionalmente participan entidades sobrenaturales.

Su enfoque cuestionador a la comprensión de los fenómenos celestes fue el comienzo de la astronomía griega. Las hipótesis de Thales eran nuevas y audaces, el fue el que liberó a los fenómenos naturales de la intervención divina, el que allanó el camino hacia la empresa científica. Fundó la escuela de Mileto de la filosofía natural, desarrolló el método científico que más tarde y pasado el tiempo iniciaó la iluminación occidental en el campo científico. Una serie de anécdotas está estrechamente relacionada con las investigaciones de Thales sobre el Cosmos. Tales fue muy apreciado en la antigüedad, y una carta citada por Diógenes Laercio, y que pretendía ser de Anaxímenes a Pitágoras, informó “…que todo nuestro discurso debe comenzar con una referencia a Thales.” Fue el primero que dejó la mitología para emplear la lógica.

Claro que el relato sobre Mileto, aunque irremediablemente relacionado con el presente, es cosa del pasado. Ahora, como entonces, nos seguimos haciendo las mismas preguntas de ¿dónde estamos?, ¿qué hacemos aquí? ¿qué es la materia? y ¿de qué manera se rige el Universo en realidad? Estas y mil preguntas más son las que nuestra curiosidad nos hace formular con la esperanza de que alguien… nos pueda ofrecer alguna respuesta.

La Física del último siglo ha sido asombrosa y los avances a la vista están. Hemos llegado con la Mecánica Cuántica y la Relatividad hasta un Universo dosdoblado en dos partes: Uno que nos cuenta como es el microcosmos, ese “mundo de lo muy pequeño” y, el otro, nos habla de lo macroscópico, lo muy grande. Partículas infinitesimales y supercúmulos de galaxias conforman nuestro saber del Cosmos y, queriendo desentrañar los secretos que nos esconde, imaginamos teorías que pretenden ir encaminadas a desvelarlos.

Aquí, en la figura, dicen que hay 7 dimensiones

Y, mientras tanto buscamos y procuramos indagar en lo más profundo de la Naturaleza, por el camino, podemos encontrarnos con gente que dicen cosas: “Detectan huellas de otras siete dimensiones en nuestro Universo Un mapa alternativo de la energía cósmica en el big bang corroboraría la teoría de las supercuerdas.” Es entonces cuando uno, no sabe si reir o llorar, al ver la osadía que algunos tienen que, por buscar un poco de notoriedad y algunos minutos de “gloria”, no se recatan en decir sandeces que no tienen ninguna base científica. Pero, los medios de comunicación ¡lo soportan todo!

Quiero recordar que lfue la Revista Time la que vino a poner la guinda en el léxico de la Física de partículas al proclamar la teoría de las Supercuerdas a bombo y platillo, lanzando a los cuatro vientos la noticia de una Teoria de Tdo. Una teoría que proponía una descripción unificada de todas las fuerzas de la Naturaleza, hasta la Gravedad, tan díscola ella negándose a entrar en el Modelo Estándar de la Física de Partículas, estaría allí incluída y cómodamente instalada en una Teoría libre de parámetros aleatorios e infinitos. ¡Qué maravilla!

La premisa básica de la nueva teoría era que reemplazaba a las familiares partículas puntuales por otras que eran segmentos cortos “de cuerda”. La teoría de cuerdas se caracteriza por una estructura que empuja las fronteras de las matemáticas (como la física ya ha hecho en alguna otra ocasión en el pasado) y las limitaciones conceptuales de la imaginación humana hasta extremos antes nunca experimentados.

Como todo en este mundo, la creación de esta teoría tiene su propia historia y sus propios héroes: Gabrielle Veneziano, Johon Schwartz, André Neveu, Pierre Ramond, Jeff Harvey, Joel Sherk, Michael Green, David Gross y un dotado flutista de Hamelin que responde al nombre de Edward Witten y cuya flauta, etá hecha de increibles ecuaciones de tal complijidad topológica que, hasta a los más afamados físicos, se les ponen de punta los pelos de las cejas al enfrentarse a ellas.

Hablamos y hablamos de un universo hecho con dimensiones extra que, pueden ser 10, 11 o 26 y, lo curioso del caso es que, aparte de una temporal que está presente en todas esas variantes, con el resto siempre hacemos el mismo reparto: tres de espacio (que es en el que nos movemos y no podemos renegar de su existencia) y, el resto -no importa el número- son dimensiones compactadas en el límite de Planck, al que, naturalemte, no tenemos manera de llegar.

Los tiempos cambian, y, con los cambios llegan las nuevas doctrinas o creencias, y, ¿por qué no? nuevas teorías. Desde hace algún tiempo venimos dando vueltas y vueltas, en el campo de la Física, a estas avanzadas teorías que no podemos demostrar, toda vez que, al contrario del Modelo Estándar, no son -por ahora- verificables sus predicciones. Me estoy refiriendo, como habeis podido suponer a la Teoría de supercuerdas, La cuerdad Heterótica, la Supergravedad y Supersimetría, y, finalmente, la última versión que viene a ser un compendio de todas las demás, la Teoría M.

Como nos dice Brian Greene en uno de los capítulos del libro El tejido del cosmos, que él titula: “Especulaciones sobre el espacio y el tiempo en la teoría M”, hoy, tres décadas después de la articulación de la teoría de cuerdas,la mayoría de los que trabajan en ella, creen que aún no tenemos una respuesta general para la pregunta fundamental: ¿qué es la teoría de cuerdas? A pesar de que sabemos bastante de la teoría, sus características más elementales son familiares y, a estas alturas, casi cercanas. Tampoco debemos despreciar los éxitos que ha cosechado y, desde luego, es bien sabido todo lo que nos promete y también ¿cómo no? los desafíos que suponen lograr todas esas promesas que en ella están encerradas.

La relatividad especial tiene la constancia de la Velocidad de la luz, la relatividad general tiene el principio de Equivalencia, la mecánica cuántica tiene, el principio de Incertidumbre y, sin embargo, los teóricos de cuerdas aún siguen buscando algo de lo que carece la teoría de cuerdas que, precisamente es: el tipo de principio nuclear que se encontraron en aquellas otras teorías y le dan razón de ser y la sólida base que toda teoría necesita para ser…¡una auténtica teoría!

Esa nueva teorías quiere explicarlo todo. Nada puede estar fuera de ella: ¡El Universo que es, todo lo que existe, ahí estará!

La Teoría de Cuerdas nos habla de un lugar muy distante, casi tan distante como Hoz o la Atlántida (no, no sonrías Kike, que hablo en serio). Esta Teoría nos quiere llevar hasta los dominios de Planck, un lugar que nadie ha visitado nunca. Ni con un LHC que tuviera un millón de veces la potencia de energía del que ahora busca el Bosón de Higgs, podríamos ir allí. Tan lejano está ese lugar que, cuando los científicos tratan de llegar a él, situado en los primeros instantes después del comienzo del Tiempo, no saben, las matemáticas no responden a sus planteamientos y, de esa manera, nunca hemos podido llegar a saber que sucedió en aquellas primeras fracciones de segundo en el nacimiento del Big Bang, donde, supuestamente, se encuentra el límite de Planck.

¿Será tan difícil encontrar las “cuerdas” como localizar el mundo perdido de la Atlántida? Bueno, por aquí cerca de mi casa, en las costas de Doñana, en el mismo epicentro del Golfo de Cádiz, un equipo de científicos están buscando, afanosamente esa Ciudad perdida que nadie sabe si es leyenda o fue realidad alguna vez. Queda un atisbo de esperanza de poder encontrarla. Algunos textos antiguos la mencionan. Sin embargo, de las cuerdas ¿qué tenemos? ¡La Imaginación de algunos! ¡Las esperanzas de muchos!

Ni observando con una lupa podremos descubrir más de tres dimensiones de espacio en nuestro mundo cotidiano, la otra que completa el cuadro en el que estamos inmersos, según Einstein, es el Tiempo que siempre nos acompaña. Hasta ahí todo está -más o menos- conforme. Sin emnbargo, cuando se nos habla de 11 dimensiones de las que quitamos las cuatro antes mencionada y nos quedan siete compactadas o enrolladas…pero, enrollada ¿dónde y cómo? Bueno, la teoría arranca de la Gravedad, que se basa en la geometría, así que cabe visualizar que algunas de esas dimensiones estén enrolladas en una bola minúscula. El tamaño de la bola es el característico del régimen de Planck, 10-33 centímetrtos que viene a ser el tamaño de la cuerda que reemplaza a la partícula puntual.

Así, las partículas que conocemos, surgen en la forma de vibraciones de esas cuerdas, es decir, sus resonancias producen las partículas y, esas cuerdas tensadas, tendrían un número infinito de modos vibración (ese es, el fundamento del violín o del laud -si os acordáis de lo que os conté aquí de aquel viejo músico Italiano llamado Galileo (sí, el padre del astrónomo)-. Las vibraciones de las cuerdas reales se clasifican a partir de la nota fundamental y de sus armónicos o modos de frecuencia, Las matemáticas de las microcuerdas son similares. Nuestras partículas salen de los modos de frecuencia menor.

No, no será fácil llegar a las respuestas de éstas difíciles preguntas que la física tiene planteadas. Y, sin embargo, ¿cómo podríamos describir lo que en esta teoría ha llegado a causar tanta pasión en esos físicos que llevan años luchando con ella? Recuerdo haber leído aquella conferencia apasionante que dio E. Witten en el Fermilab. Su pasión y forma de encausar los problemas, sus explicaciones, llevaron a todos los presentes a hacerse fervientes y apasionados fans de aquella maravillosa teoría. Todos hablaban subyugados mucho después de que el evento hubiera terminado. Según contó León Lederman, que asistió a aquella conferencia: “Yo nunca había visto nada igual, cuando Witten concluyó su charla, hubo muchos segundos de silencio -¿es mucho?- antes de los aplausos.

Claro que, a medida que la teoría fue topándose con unas matemáticas cada vez más difíciles y una proliferación de direcciones posibles, el progreso y la intensidad que rodeaban a las supercuerdas disminuyeron hasta un nivel más sensato, y ahora, sólo podemos seguir insistiendo y esperar para observar que nos puede traer el futuro de esta teoría que, es posible (y digo sólo posible) que se pueda beneficiar, de alguna manera, de las actividades del LHC que, en algunas de sus incursiones a ese mundo fantasmagórico de lo infinitesimal, podría -y digo podría- atisvar la sombra que puedan producir las supercuerdas.

No son pocos los físicos capaces que están empeñados en demostrar esa teoría. Por ejemplo, Físicos de SLAC desarrollan una prueba de marco de trabajo dependiente para la Teoría de Cuerdas Crítica. La Teoría de Cuerdas resuelve muchas de las cuestiones que arruinan la mente de los físicos, pero tiene un problema importante — no hay actualmente ningún método conocido para comprobarla y, si las energías requeridas para ello, es la de Planck (1019 GeV), la cosa se pone fea.

¿Cómo llegsar hasta la energía de Planck?

Lo cierto es que, de momento, sólo es un sueño y, la energía de Planck está muy lejos de nuestro alcance. Poder contar con la energía de Planck, por el momento y durante mucho, mucho, muchísimo tiempo, será sólo un sueño que algunos físicos tienen en la mente. Una regla universal en la física de partículas es que para partículas con energías cada vez mayores, los efectos de las colisiones están determinados por estructuras cada vez más pequeñas en el espacio y en el tiempo. El modelo estándar es una construcción matemática que predice sin ambigüedad cómo debe ser el mundo de las estructuras aún más pequeñas. Pero existen varias razones para sospechar que sus predicciones pueden, finalmente (cuando podamos emplear más energía en un nivel más alto), resultar equivocadas.

¡Un universo de Supercuerdas! El sueño de Einstein comienza a tomar realidad, a través de un nuevo paradigma de la ciencia que viene a romper con la toda la visión del mundo y del universo que teníamos hasta ahora, más allá de lo imaginable. Si la Teoría de cuerdas, finalmente resultase ser cierta, ese descubrimiento llevaría al mundo y a la humanidad hasta una nueva dimensión de su propia conciencia.

Habrá que tener paciencia con la Teoría de cuerdas y con el hallazgo tan esperado del Gravitón que nos confirmará, al fín, que la Gravedad como las demás interacciones, también está cuantizada y tiene su Bosón transmisor. De lo que no acabo de estar seguro es…del hecho en sí, de que podamos unir la Gravedad con la Cuántica…¡son tan dispares! y ¡habitan en reinos tan diferentes!

Aunque, ¿qué puedo saber yo?

emilio silvera

Dic

8

¡Los Límites de la infdormación! Y de nuestras teorías

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

La emisión de electrones por metales iluminados con luz de determinada frecuencia fue observada a finales del siglo XIX por Hertz y Hallwachs. El proceso por el cual se liberan electrones de un material por la acción de la radiación se denomina efecto fotoeléctrico o emisión fotoeléctrica. Sus características esenciales son:

- Para cada sustancia hay una frecuencia mínima o umbral de la radiación electromagnética por debajo de la cual no se producen fotoelectrones por más intensa que sea la radiación.

- La emisión electrónica aumenta cuando se incrementa la intensidad de la radiación que incide sobre la superficie del metal, ya que hay más energía disponible para liberar electrones.

En los metales hay electrones que se mueven más o menos libremente, estos electrones no escapan del metal a temperaturas normales por que no tienen energía suficiente. Calentando el metal aumenta su energía y alguno puede escapar. Los electrones “evaporados” se denominan termoelectrones. Estudiando el efecto fotoeléctrico podemos ver que también se pueden liberar electrones (fotoelectrones) mediante la absorción por el metal de la energía de radiación electromagnética.

Einstein explicó las características del efecto fotoeléctrico, suponiendo que cada electrón absorbía un cuanto de radiación o fotón. La energía de un fotón se obtiene multiplicando la constante h de Planck por la frecuencia fde la radiación electromagnética.

E=hf

Si la energía del fotón E, es menor que la energía de arranque W , no hay emisión fotoeléctrica. En caso contrario, si hay emisión y el electrón sale del metal con una energía cinética Ec igual a E-W.

Mucha fue la constribución de Einstein por crear la imagen moderna de las leyes de la Naturaleza. Desempeñó un papel principal en la creación de la perspectiva correcta sobre el carácter atómico y cuántico del mundo material a pequeña escala, demostró que la velocidad de la luz introducía una relatividad en la visión del espacio de cada observador, y encontró por sí solo la teoría de la gravedad que sustituyó la imagen clásica creada por Isaac Newton más de dos siglos antes que él. Su famosa fórmula de E = mc2 es una fórmula milagrosa, es lo que los físicos definen como la auténtica belleza. Decir mucho con pocos signos y, desde luego, nunca ningún físico dijo tanto con tan poco. En esa reducida expresión de E = mc2, está contenido uno de los mensajes de mayor calado del universo: masa y energía, son la misma cosa.

Einstein siempre estuvo fascinado por el hecho de que algunas cosas deben parecer siempre iguales, independientemente de cómo se mueva el que las ve, como la luz en el vacío, c. Él nos dijo el límite con que podríamos recibir información en el universo, la velocidad de c.

La velocidad de la luz en el vacío es por definición una constante universal de valor 299.792.458 m/s2 3 (suele aproximarse a 3·108 m/s), o lo que es lo mismo 9,46·1015 m/año; la segunda cifra es la usada para definir al intervalo llamado año luz.

Él reveló todo el alcance de lo que Stoney y Planck simplemente habían supuesto: que la velocidad de la luz era una constante sobrehumana fundamental de la naturaleza. También sabía el maestro que, en el proceso de nuevas teorías, la búsqueda de la teoría final que incluyera a otras fuerzas de la naturaleza distintas de la gravedad, daría lugar a teorías nuevas y cada vez mejores que irían sustituyendo a las antiguas teorías. De hecho, él mismo la buscó durante los 30 últimos años de su vida pero, desgraciadamente, sin éxito. Ahora se ha llegado a la teoría de supercuerdas que sólo funciona en 10 y 26 dimensiones y es la teoría más prometedora para ser la candidata a esa teoría final de la que hablan los físicos.

El físico espera que las constantes de la naturaleza respondan en términos de números puros que pueda ser calculado con tanta precisión como uno quiera. En ese sentido se lo expresó Einstein a su amiga Ilse Rosenthal-Schneider, interesada en la ciencia y muy amiga de Planck y Einstein en la juventud.

Lo que Einstein explicó a su amiga por cartas es que existen algunas constantes aparentes que son debidas a nuestro hábito de medir las cosas en unidades particulares. La constante de Boltzmann es de este tipo. Es sólo un factor de conversión entre unidades de energía y temperatura, parecido a los factores de conversión entre las escalas de temperatura Fahrenheit y centígrada. Las verdaderas constantes tienen que ser números puros y no cantidades con “dimensiones”, como una velocidad, una masa o una longitud. Las cantidades con dimensiones siempre cambian sus valores numéricos si cambiamos las unidades en las que se expresan.

Stoney Planck

La interpretación de las unidades naturales de Stoney y Planck no era en absoluto obvia para los físicos. Aparte de ocasionarles algunos quebraderos de cabeza al tener que pensar en tan reducidas unidades, y sólo a finales de la década de 1.960 el estudio renovado de la cosmología llevó a una plena comprensión de estos patrones extraños. Uno de los curiosos problemas de la Física es que tiene dos teorías hermosamente efectivas (la mecánica cuántica y la relatividad general) pero gobiernan diferentes dominios de la naturaleza.