Jul

8

Sí, nuevas Teorías nos hablarán de cómo es la Naturaleza

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Hacia el futuro ~

Clasificado en Hacia el futuro ~

Comments (1)

Comments (1)

En nuestro Universo existen cosas extrañas que, seguramente, cuando sepamos más, sabremos su explicación: ¿Por qué no hay anti-bariones primordiales en el Universo mientras que hay un barión por cada mil millones de fotones?, dicho de otra manera, el origen de la materia. Claro que, para explicar este hecho necesitamos comprender como se comportaba nuestro Universo a temperaturas tan altas como un billón de grados.

Las interacciones entre partículas elementales (interacciones electromagnéticas, débiles y fuertes) están clasificadas por su entidad (constantes de acoplamiento) y por las partículas “transportadoras” de las mismas (partículas de spín=1 0 bosones de gauge) . Todas ellas están bellamente descritas por lo que se conoce habitualmente como Modelo Estándar de las interacciones electrodébiles y fuerte. Estamos deliberadamente dejando al margen las interacciones gravitatorias que, al menos a nivel clásico, están perfectamente descritas por la Teoría de la Gravitación o Relatividad General formulada por A. Einstein en 1915 y 1916.

El Modelo Estándar nos dice que las partículas elementales, cuya interacción se detecta en particular en los grandes aceleradores como el Large Hadrón Collider (LHC) que está funcionando el el CERN (Ginebra-Suiza), no son los átomos, ni los núcleos atómicos, ni siquiera los protones y neutrones de los que están constituidos, sino los Quarks, de los que están compuestos neutrones y protones, los leptones cargados eléctricamente (partículas ligeras como los electrones que están en la corteza de los átomos o muones que aparecen en ciertas desintegraciones), los leptones neutros o neutrinos (partículas enigmáticas con una masa pequeñísima comparada con el resto del espectro) y partículas transportadoras de las interacciones como fotones (cuanto de luz) transportadores de las interacciones electromagnéticas, los bosones W+, W- y Z0 que transportan las interacciones electrodébiles y los Gluones que transportan la interacción fuerte.

Partiendo de los Quarks, se conforma el núcleo hecho de protones y neutrones. Los Quarks, confinados dentro de estos nucleones, quedan sujetos por la fuerza fuerte a través de las partícuals mediadoras, los Gluones. Para formar el átomo, se necesitan electrones que, rodean el núcleo en número igual al de protones que contiene, y, como el protón está cargado eléctricamente con fuerza positiva, ésta se equilibra mediante la negativa de la misma potencia que aportan los electrones. De esta manera, el átomo queda debidamente estabilizado para poder unirse a otros para formar células que, a su vez se unen para formar moléculas que, a su vez, se juntan para formar materia.

Todas estas partículas de las que podemos hablar ya han sido descubiertas, mientras que la única incógnita del Modelo Estándar reside en el mecanismo por el que los fermiones elementales y ciertas partículas transportadoras de las interacciones como la W y Z adquieren masa. La Teoría de la “ruptura expontánea de simetría electrodébil” implica que tiene que existir una partícula aún no descubierta, el Bosón de Higgs, que es responsable de que las anteriores partículas, incluida ella misma, sean masivas.

¿Cómo será ese Bosón de Higgs y, de qué mecanismo se vale para dar masa a las demás partículas?

Todos hemos oido hablar hasta la saciedad de que el Bosón de Higgs debe ser descubierto por el Colisionador LHC y tal descubrimiento añadiría una buena ráfaga de luz sobre algunos enigmas, propiedades no bien conocidas de las interacciones débiles. Ahora que dicen haberlo encontrado, al menos de momento, no parece que se tengan noticias de ninguna nueva revolusión de la física. ¡Habrá que esperar!

El Modelo Estándar es pues la estructura matemática que describe las interacciones entre las partículas elementales conocidas. El Modelo Estándar, como cualquier otra teoría física, tiene que ser capaz de describir de froma correcta los datos experimentales que son los que realmente establece el veredicto último de una teoría.

En particular el Modelo Estándar ya ha sido (y está siendo) ampliamente contrastado con los datos experimentales de las colisiones de altas energías, como el Large Electrón Positrón (LEP) que estuvo funcionando en el CERN hasta el año 2000 y el Tevatrón que está en funcionamiento en el Laboratorio Fermilab (En Chicago, Illinois, USA), así como en aceleradores de baja energía.

El Tevatron, que ha sido el acelerador de partículas más potente del mundo hasta que entró en funcionamiento el LHCeuropeo, cerró el pasado 30 de de septiembre de 2011, de forma definitiva, tras 26 años de operación.

El resultado obtenido es que el acuerdo entre la teoría y los resultados experimentales es concluyente, llevándose el acuerdo hasta niveles de 0,1%. Sin embargo, a pesar de que los resultados experimentales no indiquen apenas fisuras en el Modelo Estándar existen motivaciones acuciantes para ir más allá de éste. Está claro que, el principal objetivo del Modelo está en descubrir los orígenes de la Materia, entendiendo por tal los protones y neutrones de los que estamos hechos nosotros mismos, es decir, la materia bariónica.

En este lugar, el Fermilab, se llevan a cabo proyectos de enorme importancia para conocer lo que la materia es. Y, de la misma manera que en el CERN, se realizan colisiones de haces de partículas que reproducen aquellos momentos de la creación, el big bang en miniatura para, a partir del estudio de lo que ahí pasa, poder llegar a comprender aquellos primeros momentos que aún, mantiene, algunas regiones oscuras que no dejan ver lo que allí pasó.

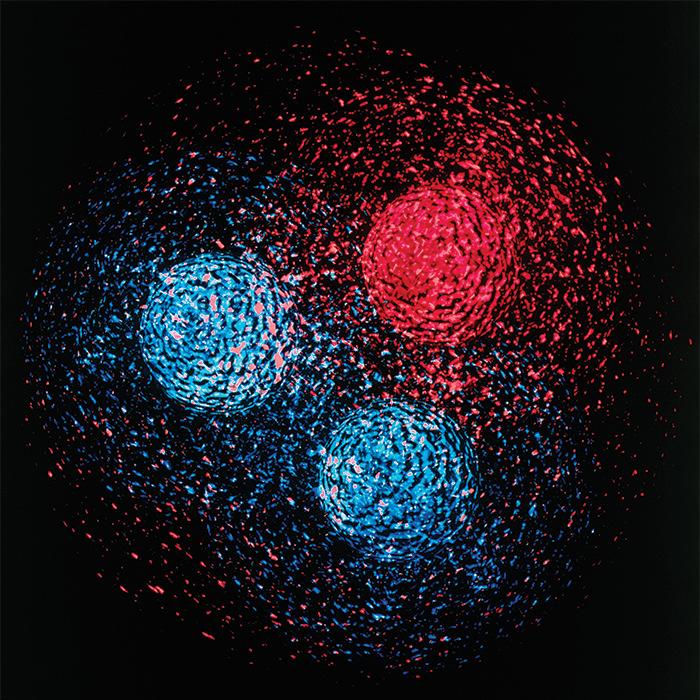

Los dos problemas “experimentales” más acuciantes que presenta en estos momentos el Modelo Estándar está relacionado con los dos tipos de Materia que constituyen el Universo observable. El 17% de la Materia de nuestro Universo es materia “luminosa”, es decir, materia constituida, como nosotros mismos por protones y neutrones. Por otro lado, el 83% de nuestro universo Universo está constituido por Materia Oscura (yo prefiero decir: parece que está constituido por materia invisible que llamamos oscura), es decir, materia que ha sido detectada por el momento sólo indirectamente a través de sus interacciones gravitacionales.

De nuevo el Modelo Estándar requiere de una extensión para poder incluir candidatos a Materia Oscura.

Muchas son las noticias que saltan a los medios y que son emitidas por equipos que quieren llevarse el galardón del hallazgo de la M. O. Veamos por ejemplo uno de ellos:

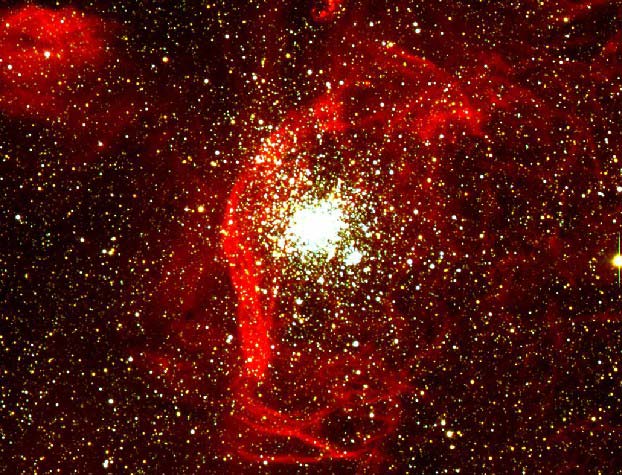

24 OCTUBRE 2010. Un teórico del Fermilab y sus colegas de la Universidad de Nueva York podrían haber encontrado pistas sobre algunos de los más jugosos secretos del universo en el centro de la Vía Láctea. La materia oscura. En su análisis de los datos públicos de los rayos gamma del Telescopio Espacial Fermi, Dan Hooper, científico del Fermilab, y Lisa Goodenough, un estudiante graduado en la Universidad de Nueva York, informan que los rayos gamma de muy alta energía procedentes del centro de la Vía Láctea vienen de las colisiones de materia oscura.

“Salimos de nuestra manera de considerar todas las causas de los fondos que imitan la señal, y no se encontraron otras fuentes plausibles en astrofísica o la mecánica que se puede producir una señal como ésta”, dijo Hooper.

Un reciente trabajo, publicado en el servidor repositorio científico arXiv-pre, describe sus hallazgos. Los astrofísicos desde hace mucho tiempo postulan una amplia gama de partículas de materia oscura, incluyendo los axiones, las partículas súper pesadas y partículas que se encuentran entre: débilmente partículas masivas de interacción, o WIMPs.

Ahora nos dicen que el LHC se prepara para poder buscar la materia oscura y, que yo sepa, el Bosón de Higgs (aunque digan lo contrario) no se ha encontrado. Al parecer han localizado una partícula que tiene todos los atributos para poder ser el Higgs pero… ¿Será él?

Claro que, la realidad es tozuda, y, nadie puede decirnos qué es la dichosa y teórica “materia oscura” de qué está hecha, cómo se formó, de qué mecanismos se vale para pasar inadvertida sin emitir radiaciones que podamos detectar, y, un sin fin de cuestiones que la hace extraña y muy exótica, hasta el punto de que podamos pensar que está y no está en este mundo. ¿No estará escondida en eso que llamamos vacío y, las partículas portadoras de la Fuerza Gravitatoria, el Gravitón, nos trae a nuestra parte del “mundo” la Gravedad que genera y que es, la que detectan los cosmólogos cuando ven que las galaxias se alejan las unas de las otras a más velocidad de la que tendrían que hacerlo si sólo existiera la materia bariónica que podemos observar?

Hablámos de los posibles candidatos a materia oscura, aquí la situación es incluso más complicada puesto que candidatos a materia oscura no han sido detectados por experimentos de física de partículas con lo que (como antes decía) su misma naturaleza nos es desconocida. Para competar el relato cabe decir que experimentos astrofísicos, en particular detección de supernovas, indican que el total de la materia anteriormente descrita (o sea luminosa y oscura) constituyen tan sólo el 28% de la densidad de energía del universo observable mientras que el resto es una energía no detectable mediante experimentos de Física de Partículas y que se conoce con el nombre de energía Oscura, que puede ser simplemente una Constante Cosmológica.

Einstein se burla de nosotros como si supiera (el muy ladino) que él llevaba razón, y, la Constante Cosmológica está ahí, presente en el Universo. La verdad es que, nos trae de cabeza, el no saber detectar dónde está la verdad para saber el camino a tomar en el futuro.

Así que, finalmente podemos concluir que el 4,6% es la materia bariónica (Supercúmulos de Galaxias, Nebulosas, Mundos, y demás cuerpos observables .-también nosotros-) y, el 17% de la densidad de materia del universo podría ser la llamada “materia oscura” . Aún cuando la proporción sea minoritaria para la Bariónica, para nosotros es prioritaria, de ella estamos hecho nosotros mismos y que, por supuesto, es la única materia que podemos detectar de forma directa, conocemos (las partículas que la conforman) sus secretos, sus parámetrtos físicos, sus masas y cargas, sus funciones dentro del contexto general y, en definitiva es la materia que está tan cerca de nosotros que, nosotros mismos somos ella.

También los pilares básicos de nuestro propio ser, son Quark y Leptones, es decir, materia bariónica. Así que, si los observadores del Universo (nosotros) somos de materia radiante y luminosa, no creo que esa “materia oscura” tenga más importancia que aquella de la que nosotros estamos formados. Más bien creo que, existe alguna fuerza (llámese constante cosmológica o de cualquier otra forma) desconocida que, se confunde con esa clase de materia. Materia, lo que se dice materia, por mí, sólo existe la que podemos ver y detectar.

Dos son los problemas esenciales que deben ser entendidos en relación con el número bariónico del Universo:

– El primero es que no hay prácticamente evidencia de antimateria en el Universo. De hecho no hay antimateria en nuestro Sistema solar y solamente aparecen antiprotones en los rayos cósmicos. Sin embargo, los antiprotones se pueden producir como producto secundarios en colisiones del tipo pp → 3p + p (en esta última p debería aparecer una rayita horizontal encima (antiprotón) pero, en mi cuadro de caracteres especiales no lo tengo) que proporcionan una abundancia de antiprotones semejante a la observada.

Así por ejemplo, resulta que se detecta un antiprotón aproximadamente por cada 3000 protones mientras que se encuentra un átomo de antihelio por cada 10000 átomos de Helio. Todos estos datos experimentales están de acuerdo con la existencia de antimateria primordial en el Universo. De hecho, la no existencia de antimateria resulta esencial para la estabilidad del mismo puesto que la materia y la materia se aniquilan entre sí produciendo radiación.

Satélite WMAP

– Una vez explicado el hecho de que practicamente no hay antimateria en el Universo, el segundo problema sería entender el origen de la densidad de materia luminosa. De hecho, utilizando los datos de la abundancia primordial de elementos ligeros, de acuerdo con la teoría de la nucleosíntesis, junto con los datos del Satélite WMAP, se deduce que hay en torno a 1 protón por cada mil millones de fotones en el Universo. Siendo nB y n γ las densidades de bariones y fotones respectivamente, se tiene que η=nB/nγ ≈ 0.61 x 10-9.

Para ser un poco más preciso podríamos decir que en 5 metros cúbicos hay un sólo barión y mil millones de fotones en promedio.

Para entender mejor cuál puede ser el mecanismo que explique la generación de materia en nuestro Universo, es decir, el parámetro η que acabamos de describir, debemos retrotraernos a la época en que el universo estaba muy caliente, poco después del Big Bang. Es decir, la llamada era denominada de la Radiación. Las partículas cuya masa es (muy) inferior a la temperatura del universo se aniquilan con sus antipartículas por las reacciones inversas a las anteriores. En este momento las partículas se comportan practicamente como si fueran de masa cero y se dice que la partícula en cuestión está en equilibrio térmico con la radiación. El Modelo Estándar Cosmológico predice una relación entre la edad del Universo (en segundos) y la temperatura del mismo (en K) que viene dada por:

en donde kB es la constante de Boltzmann. La ecuación anterior nos dice que para una temperatura próxima al GeV (equivalente a la masa del protón, que es de unos diez billones de grados, ¡el tiempo transcurrido en el universo después del Big Bang era de unas dos diez millonésimas de segundo!

Para temperasturas inferiores a la masa de la partícula, las partículas y antipartículas siguen aniquilándose en fotones, aunque el proceso inverso no puede tener ya lugar y la densidad de equilibrio térmico de partículas y antipartículas decrece exponencialmente como exp (-m/T) en donde m es la masa de la partícula en cuestión. Este proceso se termina cuando el ritmo de aniquilación de partículas y antipartículas no puede competir con el ritmo de expansión del universo (constante de Hubble H) , momento en el que las partículas y antipartículas se salen del equilibrio térmico y su densidad queda “congelada” a los valores de equilibrio correspondientes a la temperatura de”congelación” (temperatura de freezeout). Si aplicamos este proceso a los nucleones protones y neutrones) y antinucleones de masa ~ 1 GeV se puede ver como la densidad de los mismos empieza a disminuir exponencialmente para temperaturas inferiores al GeV, mientras que se salen de equilibrio térmico para temperaturas del orden de 20 MeV, para la cual la densidad de equilibrio resulta ser: nB/nγ=nB/nγ ≈ 10-18.

Esto nos demuestra que partiendo de un Universo simétrico, como hemos supuesto hasta el momento, hoy en día el Universo seguiría siendo simétrico respecto al número bariónico y, además, ¡el número de bariones sería mil millones más bajo que el que observamos! La solución de este problema sólo puede tener una respuesta: debemos abandonar la hipótesis de que el Universo era inicialmente simétrico respecto al número bariónico. La explicación podría seguir y es larga y algo compleja pero, por mi cuenta, resumo diciendo que, esa simetría no es posible, si tenemos en cuenta que, las partículas creadas después del Big Bang, al ser diferentes, también tenían diferentes masas y, tal hecho cierto, hace imposible que la expansión del Universo fuera isotrópica, así que, al expandirse anisotrópicamente, la asimetría queda servida.

Sí, podríamos decir que, la asimetría del Universo es la responsable de su diversidad. No todo es igual en el Universo. Lo son todos los protones y electrones que existen, y, también, todos los neutrones, es decir, son idénticos y simétricos los objetos de la misma familia a niveles microscópicos pero, cuando nos vamos al mundo macroscópico de las galaxias, las estrellas, los mundos o, nosotros mismos, no encontramos dos iguales.

El Universo, amigos, es una maravilla.

Agradeceré aquí la mayor aportación de D. Mariano Quirós de cuyo artículo en el Volumen 25, número 4 de la Revista de Física, encontré el Origen de la materia: bariogenesis, del que pude obtener la mayor parte del texto que aquí han podido leer.

Este trabajo fue publicado en este lugar el pasado 24 de marzo

emilio silvera

Jul

7

Estructuras fundamentales del Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo asombroso ~

Clasificado en El Universo asombroso ~

Comments (1)

Comments (1)

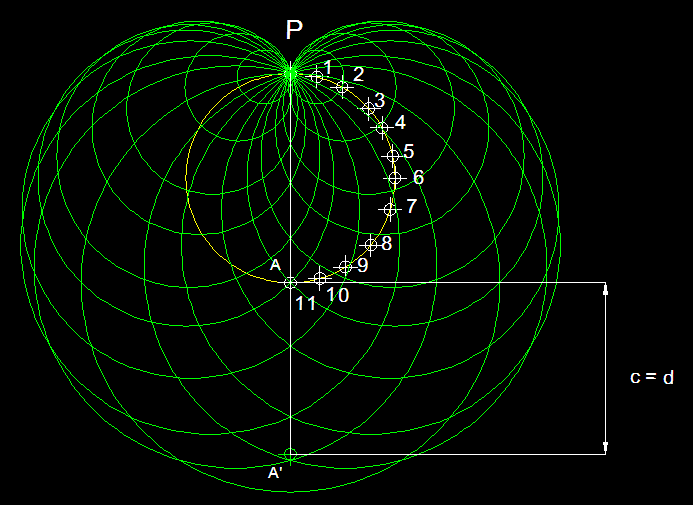

Estructuras Fundamentales de la Naturaleza

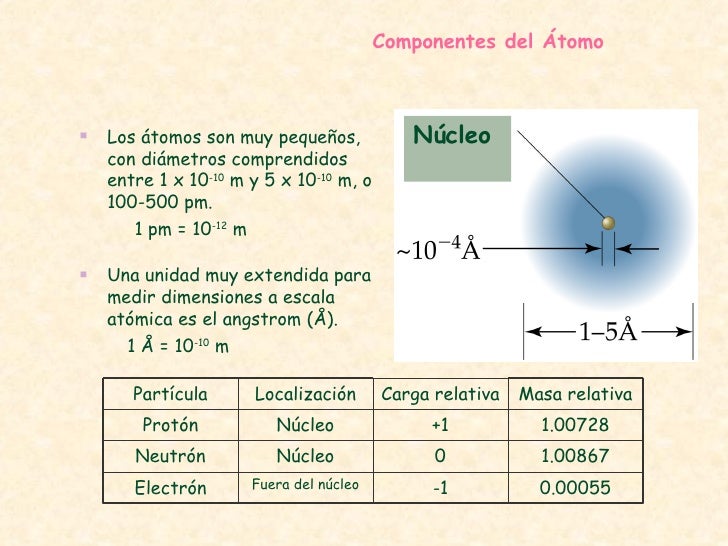

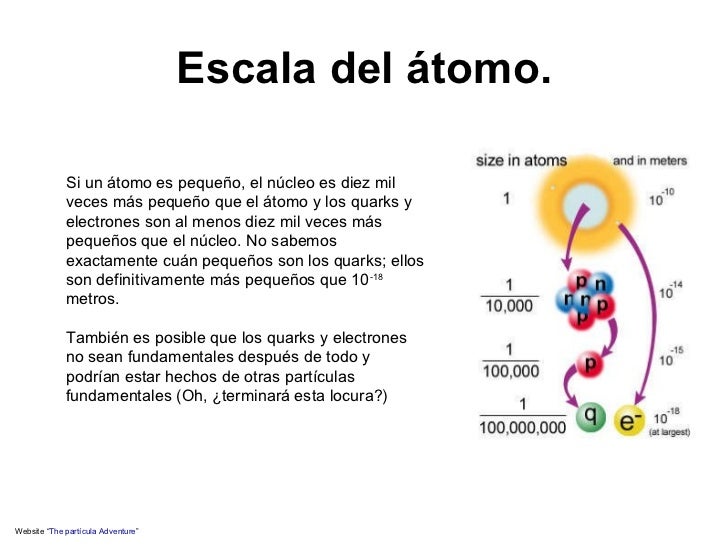

Hemos llegado a poder discernir la relación directa que vincula el tamaño, la energía de unión y la edad de las estructuras fundamentales de la Naturaleza. Una molécula es mayor y más fácil de desmembrar que un átomo; lo mismo podemos decir de un átomo respecto al núcleo atómico, y de un núcleo con respecto a los quarks que contiene.

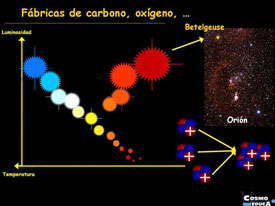

La cosmología sugiere que esta relación resulta del curso de la historia cósmica, que los quarks se unieron primero, en la energía extrema del big bang original, y que a medida que el Universo se expandió, los protones y neutrones compuestos de quarks se unieron para formar núcleos de átomos, los cuales, cargados positivamente, atrajeron a los electrones cargados con electricidad negativa estableciéndose así como átomos completos, que al unirse formaron moléculas y estas, a su vez, juntas en una inmensa proporción, forman los cuerpos que podemos ver a lo largo y lo ancho de todo el universo. Grandes estructuras y cúmulos y supercúmulos de galaxias que están hechos de la materia conocida como bariónica, es decir, de Quarks y Leptones.

Si es así, cuanto más íntimamente examinemos la Naturaleza, tanto más lejos hacia atrás vamos en el tiempo. Alguna vez he puesto el ejemplo de mirar algo que nos es familiar, el dorso de la mano, por ejemplo, e imaginemos que podemos observarlo con cualquier aumento deseado.

Con un aumento relativamente pequeño, podemos ver las células de la piel, cada una con un aspecto tan grande y complejo como una ciudad, y con sus límites delineados por la pared celular. Si elevamos el aumento, veremos dentro de la célula una maraña de ribosomas serpenteando y mitocondrias ondulantes, lisosomas esféricos y centríolos, cuyos alrededores están llenos de complejos órganos dedicados a las funciones respiratorias, sanitarias y de producción de energía que mantienen a la célula.

Ya ahí tenemos pruebas de historia. Aunque esta célula particular solo tiene unos pocos años de antigüedad, su arquitectura se remonta a más de mil millones de años, a la época en que aparecieron en la Tierra las células eucariota o eucarióticas como la que hemos examinado.

Para determinar dónde obtuvo la célula el esquema que le indicó como formarse, pasemos al núcleo y contemplemos los delgados contornos de las macromoléculas de ADN segregadas dentro de sus genes. Cada una contiene una rica información genética acumulada en el curso de unos cuatro mil millones de años de evolución.

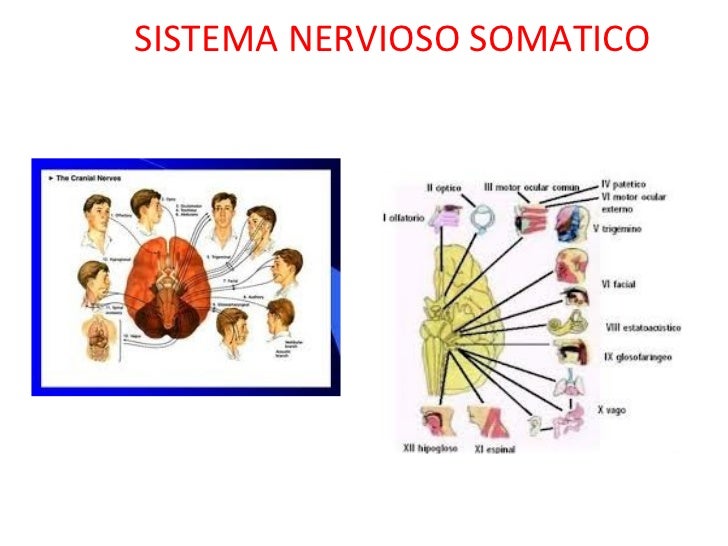

Sistema nervioso somático

Incluye grupos de neuronas que llevan información desde los órganos sensoriales (incluyendo toda la piel) hasta el sistema nervioso central (principalmente hasta el cordón espinal). A estos grupos de neuronas se les llama neuronas sensoriales o aferentes.

a. Las neuronas que recogen información directamente de los órganos sensoriales son neuronas especializadas con formas y sensibilidad particular. Por lo regular, estas neuronas tienen abundantes dendritas y axones cortos.

b. Por su parte, las neuronas que llevan información desde los órganos sensoriales hasta el sistema nervioso central suelen tener menos dendritas y axones largos. Grupos de estos axones forman lo que generalmente conocemos como nervios. Estos muestran un color blanco debido a la abundancia de capas de mielina, característico de los axones. A estos grupos de axones se les conoce como nervios sensoriales o aferentes.

Almacenado en un alfabeto de nucleótidos de cuatro “letras”- hecho de moléculas de azúcar y fosfatos, y llenos de signos de puntuación, reiteraciones para precaver contra el error, y cosas superfluas acumuladas en los callejones sin salida de la historia evolutiva-, su mensaje dice exactamente cómo hacer un ser humano, desde la piel y los huesos hasta las células cerebrales.

Si elevamos más el aumento veremos que la molécula de ADN está compuesta de muchos átomos, con sus capas electrónicas externas entrelazadas y festoneadas en una milagrosa variedad de formas, desde relojes de arena hasta espirales ascendentes como largos muelles y elipses grandes como escudos y fibras delgadas como puros. Algunos de esos electrones son recién llegados, recientemente arrancados átomos vecinos; otros se incorporaron junto a sus núcleos atómicos hace más de cinco mil millones de años, en la nebulosa de la cual se formó la Tierra.

El enlace: Adenina con Timina o Guanina con Citosina, constituyendo dicha secuencia el código genético en el que se organiza el funcionamiento celular.

Si elevamos el aumento cien mil veces, el núcleo de un átomo de carbono se hinchará hasta llenar el campo de visión. Tales núcleos átomos se formaron dentro de una estrella que estalló mucho antes de que naciera el Sol. Si podemos aumentar aún más, veremos los tríos de quarks que constituyen protones y neutrones.

El microscopio electrónico nos enseña cosas alucinantes

Los quarks han estado unidos desde que el Universo sólo tenía unos pocos segundos de edad. Ellos se unieron en tripletes para construir protones, neutrones y demás partículas que conforman la masa, la materia.

Al llegar a escalas cada vez menores, también hemos entrado en ámbitos de energías de unión cada vez mayores. Un átomo puede ser desposeído de su electrón aplicando sólo unos miles de electrón-voltios de energía. Sin embargo, para dispersar los nucleones que forman el núcleo atómico se requieren varios millones de electrón-voltios, y para liberar los quarks que constituyen cada nucleón se necesitaría cientos de veces más energía aún.

Introduciendo el eje de la historia, esta relación da testimonio del pasado de las partículas: las estructuras más pequeñas, más fundamentales están ligadas por niveles de energía mayores porque las estructuras mismas fueron forjadas en el calor del big bang.

Hemos llegado hasta la consciencia del Ser, y, sabemos en qué lugar del Universo estamos

Nos cuesta asimilar que la evoluciòn de la materia se pudiera elevar (bajo un sin fin de parámetros y transmutaciones muy complejos), hasta alcanzar la consciencia y llegar a generar pensamientos. Parece como si el Universo hubiera sabido que nosotros (también otros seres similares e inteligentes en otros mundos del inmenso Cosmos), teníamos que venir y, para ello, creó sistemas idóneos para la vida como el planeta Tierra y muchos otros de su clase que ofrecen tal cobijo a criaturas vivas.

Los aceleradores de partículas, como los telescopios, funcionen como máquinas del tiempo. Un telescopio penetra en el pasado en virtud del tiempo que tarda la luz en desplazarse entre las estrellas; un acelerador recrea, aunque sea fugazmente, las condiciones que prevalecían en el Universo primitivo. En la imagen de arriba podemos ver como el Telescopio Espacial Hubble, poco a poco, ha podido ir avanzando hacia atrás en el tiempo para enseñarnos las imágenes captadas cuando el Universo era muy joven. ¿Podremos algún día fabricar telescopios tan potentes que puedan captar imágenes del universo vecino?

Hemos llegado a dominar técnicas asombrosas que nos facilitan ver aquello que, prohibido para nuestro físico, sólo lo podemos alcanzar mediante sofisticados aparatos que bien nos introduce en el universo microscópico de los átomos, o, por el contrario nos llevan al Universo profundo y nos enseña galaxias situadas a cientos y miles de millones de años-luz de la Tierra.

Cuando vemos esos objetos cosmológicos lejanos, cuando estudiamos una galaxia situada a 100.000 mil años-luz de nosotros, sabemos que nuestros telescopios la pueden captar gracias a que, la luz de esa galaxia, viajando a 300.000 Km/s llegó a nosotros después de ese tiempo, y, muchas veces, no es extraño que el objeto que estamos viendo ya no exista o si existe, que su conformación sea diferente habiéndose transformado en diferentes transiciones de fase que la evolución en el tiempo ha producido.

Las entrañas de un protón

Siempre hemos querido saber lo que hay más allá de lo que el ojo ve

En el ámbito de lo muy pequeño, vemos lo que está ahí en ese momento pero, como se explica más arriba, en realidad, también nos lleva al pasado, a los inicios de cómo todo aquello se formó y con qué componentes que, en definitiva, son los mismos de los que están formadas las galaxias, las estrellas y los planetas, una montaña y un árbol y, cualquiera de nosotros que, algo más evolucionado que todo lo demás, podemos contarlo aquí.

Estas y otras muchas maravillas son las que nos permitirán, en un futuro relativamente cercano, que podamos hacer realidad muchos sueños largamente dormidos en nuestras mentes.

emilio silvera

Jul

7

Una pregunta tonta: ¿Qué es la vida?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Noticias ~

Clasificado en Noticias ~

Comments (1)

Comments (1)

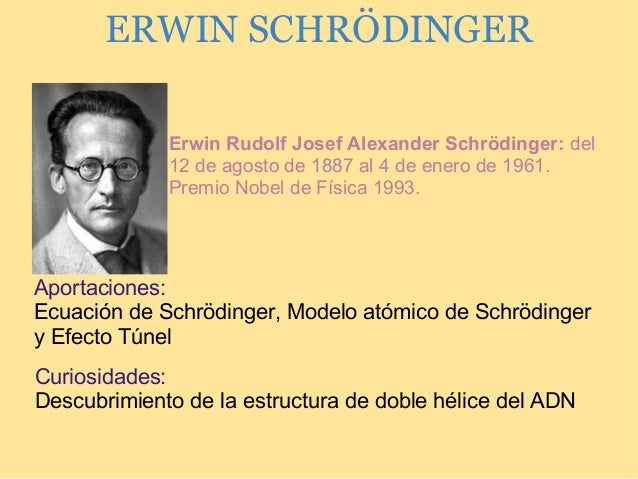

El físico Erwin Schrodinger pronunció una serie de conferencias con un tema común: ¿Qué es la vida?

Todos tenemos una idea intuitiva de qué es la vida. Sabemos de su existencia por nuestra propia experiencia pero la cosa se complica cuando tratamos de ponerlo negro sobre blanco. Una cantidad enorme de células deciden ponerse de acuerdo para construir un cuerpo. Actúan unidas, con la misión compartida de mantener la autonomía y la identidad de su existencia.

Erwin Schrodinger fue uno de los científicos más importantes del siglo XX. Recibió el Premio Nobel de Física en 1993 gracias al desarrollo de la Teoría Cuántica. Sin embargo, como todo pensador ilustre, trató de desentrañar conceptos que se extienden más allá de su ámbito de estudio. En sus propias palabras: “…se volvió casi imposible, para una única mente, dominar por completo más que una pequeña porción especializada de ese conocimiento. No veo otra salida para este dilema (bajo riesgo de perder nuestro objetivo para siempre) que aventurarnos a embarcar, algunos de nosotros, en una síntesis de hechos y teorías, aunque dotados de un conocimiento incompleto y de segunda mano sobre algunos de ellos, y, peor aun, pudiendo parecer tontos”.

¿Por qué son los átomos tan pequeños?

O dicho de otra forma: ¿por qué los seres vivos son enormes comparados con el tamaño de los átomos? La escala a la que trabaja “la vida” es necesariamente grande, y entiéndaseme; cuando digo “grande” quiero decir comparado con un átomo. Es necesario que sea así porque, si no, las perturbaciones que añaden los procesos atómicos, como por ejemplo el calor, harían que los desarrollos biológicos fueran imposibles. Imaginemos que unos pocos átomos formaran un organismo vivo. Sabemos que el calor produce vibraciones que aumentan la separación entre átomos. Pues si sólo unos pocos formaran un cuerpo, éste se pasaría la vida creciendo y menguando desaforadamente como si se estuvieran bebiendo frascos y frascos del elixir de Alicia en el País de las Maravillas. Aprendemos entonces que la vida tiene una escala necesaria: la del planeta Tierra.

Orden a partir del desorden y orden a partir del orden

Ya hemos hablado en alguna ocasión de la relación entre orden, entropía y vida. Cualquier proceso vital lo es gracias al aumento de desorden en el Universo. La naturaleza realiza procesos en los que trata de organizar, de reglar, de acumular. Sin embargo este “orden a partir del desorden” requiere un paso más. Sería imposible que una especie perdurara en el tiempo, más allá de su corta vida como individuo sin la existencia de la información genética. Las especies son capaces de comunicar su esencia a sus descendientes. Un mecanismo de transmisión del “orden a partir del orden” que perdura durante siglos. La información es parte fundamental de la existencia de la vida.

¿Se basa la vida en leyes físicas?

Investigadores del Centro de Investigación Ecológica y Aplicaciones Forestales han llevado a cabo un estudio que tarta de explicar cómo la complejidad y diversidad de la vida se relacionan con procesos y leyes físicas. Según los autores, la vida se organiza a caballo de gradientes de energía, acumulando información por combinación e innovación de forma gradual y destruyéndose de vez en cuando de forma repentina.

Bueno, algunos dicen que lo único que no cambia es el Cambio. Por eso hay vida

Se puede entrever que la Biología será útil a la Física, provocando el descubrimiento de nuevas leyes y, también, la Física a la Biología, porque ofrecerá una explicación unificada de la vida. Sin embargo, e inevitablemente, aunque aún no conozcamos todos los procesos que hacen que la vida exista, sólo podrán ser físicos, puesto que cuanto se encuentra en la materia de un ser vivo son los elementos con los que están hechos el resto del universo. Nuestros cabellos, las hojas de los arboles, el agua o el polvo estelar están hechos de los mismos componentes. Elementos únicos regidos por las leyes universales de la física. Sólo eso puede explicarlo todo. ¿O no?

– Seguir leyendo: http://www.libertaddigital.com/ciencia-tecnologia/ciencia/2016-06-08/una-pregunta-tonta-que-es-la-vida-1276575691/

Jul

7

Moléculas vivas sorprendentes

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Ciencia y Vida ~

Clasificado en Ciencia y Vida ~

Comments (0)

Comments (0)

En matemáticas se pueden trazar líneas precisas y concretas que dividan en dos clases entes de naturaleza matemática. Una estructura geométrica se puede suporponer o no a su imagen especular. Una estructura asimétrica puede tener una lateralidad a la derecha o bien a la izquierda.

Cualquier número entero positivo es par o impar, y no hay ninguno de tales números para el cual su situación a este respecto ofrezca la menor duda. Pero en el mundo, si exceptuamos el nivel subatómico de la teoría cuántica, las lineas divisorias son casi siempre difusas. El alquitrán, ¿es sólido o líquido?. Lo cierto es que, la mayoría de las propiedades físicas se “mueven” en un espectro continuo que hace que vayan cambiando de manera imperceptible de un extremo a otro del mismo.

El paso del tiempo convierte en líquido, gas o sólido algunos materiales y, a otros, los deforma hasta perder su estructura original para convertirlos en lo que antes no eran. Nada permanece, todo cambia. Sea cual fuere la línea de división, habrá algunos casos en los que no podamos definirla y, en otros, habrá objetos tan próximos a ella que el lenguaje ordinario no será lo suficientemente preciso como para poder afirmar a qué lado pertenece. Y, la propiedad de la vida, está, precisamente, en uno de esos continuos.

Para porbar esto basta que consideremos los virus: son las estructuras biológicas más pequeñas que se conocen con la propiedad de poder “comer” (absorber sustancias situadas en sus proximidades), crecer y fabricar copias exactas de sí mismas.

Son mucho más pequeños que una bacteria (en realidad, algunos virus infectan las bacterias) y pasan sin dificultad a través de un filtro de porcelana fina que, aunque a nosotros nos parezca que está completamente sellada y su superficie es totalmente hermética y lisa, para ellos, tan “infinitamente” pequeños, ofrece miles de huecos por los que poder colarse.

Nuevas grabaciones en vídeo de un virus que infecta a las células sugiere que los virus se expanden mucho más rápido de lo que pensábamos. El descubrimiento de este mecanismo permitirá crear nuevos fármacos para hacer frente a algunos virus. En la punta de un alfiler caben millones de ellos. De hecho, los virus tienen el tamaño de una décima de micrómetro (diezmillonésima parte del metro).

El mundo de lo muy pequeño es fascinante y, por ejemplo, si hablamos de átomos, se necesitarían aproximadamente una cantidad para nosotros inconmensurable de átomos (602.300.000.000.000.000.000.000) para lograr un solo gramo de materia. Fijáos que hablamos de lo pequeño que pueden llegar a ser los virus y, sin embargo, el Hidrógeno con un sólo protón es el átomo más ligero y su masa es 400.000 veces menor que la masa de un virus, como antes dije, el organismo vivo más pequeño que se conoce. El virus más diminuto conocido mide unos o,00000002 m; su tamaño es 2.000 veces mayor que el del átomo. Y, en la punta del alfiler que antes mencionamos cabrían 60.000.000.000 (sesenta mil millones) de átomos.

Bombardeando rayos X podemos verlos

Como los virus son menores que la longitud de onda de la luz, no pueden observarse con un microscopio luminoso ordinario, pero los bioquímicos disponen de métodos ingeniosos que les permiten deducir su estructura, ya que pueden verlos mediante bombardeos con rayos X u otras partículas elementales.

En ralidad, se puede decir que un cristal “crece”, pero lo hace de un modo ciertamente trivial. Cuando se encuentra en una solución que contiene un compuesto semejante a él, dicho compuesto se irá depositando sobre su superficie; a medida que esto ocurre, el cristal se va haciendo mayor, pero el virus, igual que todos los seres vivos, crece de una manera más asombrosa: toma elementos de su entorno, los sintetiza en compuestos que no están presentes en el mismo y hace que se combinen unos con otros de tal manera que lleguen a dar una estructura compleja, réplica del propio virus.

Los virus sólo se multiplican en células vivientes. La célula huésped debe proporcionar la energía y la maquinaria de síntesis, también los precursores de bajo peso molecular para la síntesis de las proteínas virales y de los ácidos nucleicos. El ácido nucleico viral transporta la especificidad genética para cifrar todas las macromoléculas específicas virales en una forma altamente organizada.

El poder que tienen los virus de infectar, e incluso matar, un organismo, se debe precisamente a esto. Invade las células del organismo anfitrión, detiene su funcionamiento y lo sustituye, por decirlo de alguna manera, por otros nuevos. Ordena a la célula que deje de hacer lo que normalmente hace para que comience a fabricar las sustancias necesarias para crear copias de sí mismo, es decir, del virus invasor.

El primer virus que se descubrió, y uno de los más estudiados, es el virus sencillo que produce la “enfermedad del mosaico” en la planta del tabaco. Cristaliza en forma de barras finas que pueden observarse a través del microsopio electrónico. Recientemente se ha descubierto que cada barra es, en realidad, una estructura helicoidal orientada a la derecha, formada por unas 2.000 moléculas idénticas de proteína, cada una de las cuales contiene más de 150 subunidades de aminoácidos.

Animación de parte de una estructura de ADN de doble hélice

Jul

7

La Física y el Tiempo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (3)

Comments (3)

Para el topólogo, un nudo es una curva continua, cerrada y sin puntos dobles. Esta curva está situada en un espacio de tres dimensiones y se admite que pueda ser deformada, estirada, comprimida, aunque está “prohibido” hacerle cortes. Cuando se puede, a través de diversas manipulaciones, se pasa de un nudo a otro y se dice que son equivalentes. Claro que, algunos se abstraen en cuestiones con otras, al parecer, no relacionadas.

Un viejo amigo bromeaba diciendo que el Andante en do menor de la Sinfonía Concertante de Mozart conseguía devolverle a su intimidad anímica de partida, y que por eso, en su opinión, plasmaba de forma inefable el tiempo cíclico, o mejor aún, una CTC (“curva de género de tiempo cerrada”). Y transcurridos los doce minutos que dura ese movimiento, volvíamos a escucharlo una vez más. Mientras, discutíamos sin cesar sobre el tiempo, esa abstracción de la Mente que nadie ha sabido explicar.

No es bueno perder la perspectiva

Hay un tiempo para cada cosa. Un tiempo para soñar, inconmensurable, un tiempo para vivir, siempre corto, un tiempo para filosofar, misterioso,…, y un tiempo para la ciencia, sujeto a número.

Me gustaría empezar definiendo el tiempo, pero no sé. Sesudos pensadores, como Platón y Aristóteles, lo ensayaron con brillantez. El tiempo es una imagen móvil de la eternidad. Esta imagen es eterna, pero se mueve según número, dirá Platón en el TIMEO. El tiempo es el número de movimiento según el antes y el después…El tiempo no es movimiento, sino movimiento en tanto en cuanto admite enumeración. El tiempo es una especie de número. El tiempo es obviamente aquello que se cuenta, no aquello con lo cual contamos, escribirá Aristóteles en su FÍSICA.

Alguna vez, en simbiosis con la Naturaleza, podemos sentir como se ha parado el tiempo

Son definiciones muy sugestivas, aunque teñidas de circularidad: movimiento en el tiempo, tiempo a través del movimiento. Agustín de Hipona vio esto claramente. Célebre es asimismo su declaración: Si nemo a me quaerat, scio; si quaerenti explicari velim, nescio (CONFESIONES). En uno de los análisis más penetrantes del tema, sugirió Agustín la Mente como fuente de tiempo: En ti es, mente mía, donde mido los tiempos.

Time is what happens when nothing else happens, afirma Feynman; para a continuación advertir que toda definición del tiempo es necesariamente circular, y que lo importante no es decir qué es el tiempo, sino decir cómo se mide lo que llamamos tiempo. En su enciclopédico tratado sobre la gravitación, Misner, Thorne y Wheeler nos recuerdan de forma sencilla y profunda lo que toda medida del tiempo físico debe cumplir: Time is defined so that motion looks simple.

El tiempo es un concepto inventado por el hombre para ordenar, primero, sus sensaciones y actos, y luego, los fenómenos. Decían los escolásticos: Tempus est ens rationis cum fundamento in re. La primera unidad natural debió ser el día, por la ciclidad conspicua de las salidas del Sol. Los grandes avances científicos y tecnológicos a lo largo de los siglos han estado vinculados a los adelantos en la precisión con que se ha ido midiendo el tiempo. Hoy disponemos de relojes que aseguran un segundo en 20 millones de años, y el paso de la femtoquímica a la attofísica empieza a ser una realidad.

No pocas veces nos podemos ver perdidos en la vorágina de lo que llamamos tiempo, algo tan enorme que, en realidad, no sabemos lo que es. No lo hemos llegado a comprender, y, por si fuera poco, tampoco sabemos, si en realidad existe.

El tiempo antes de Einstein.

La física nació en torno al tiempo. Las regularidades en los ciclos astrales permitieron al acierto en las predicciones apoyadas en esta periodicidad, y con ello despertó sin duda la confianza del hombre en la racionalidad, inclinándole a escoger el cosmos frente al cáos.

Breve historia de la medida del tiempo

La longitud de las sombras fue uno de los primeros métodos usados para fijar las horas. En el Museo Egipcio de Berlín hay un fragmento de piedra que posiblemente sea de un reloj de sol de alrededor de 1500 a.C. Los babilonios desarrollaron los relojes de sol, y se dice que el astrónomo Anaximandro de Mileto los introdujo en Grecia en el siglo VI a.C.

En el siglo II a C, Eratóstenes, de la biblioteca de Alejandría, concibió y llevó a cabo la primera medida de las dimensiones de la Tierra de la que se tiene noticia. En el Año Internacional de la Astronomía, una de las actividades que se llevaron a cabo fue, precisamente averiguar el radio terrestre por el mismo método.

Aparte de relojes de sol, en la antigüedad se usaron también relojes de arena, de agua, cirios y lámparas de aceite graduadas.

En la segunda mitad del siglo XIII aparecen los primeros relojes mecánicos. Su precisión era muy baja (10-20%). En el XIV se mejoran, con el invento del escape de rueda catalina, y ya se alcanzan precisiones de 20 a 30 minutos por día (1-2%). Por allá al año 1345 se empieza a dividir las horas en minutos y segundos.

El tiempo físico asoma en el siglo XIV, en el Merton College Oxford y luego en la Universidad de París, con Oresme. Se representa en una línea horizontal, mientras en vertical se disponen las cualidades variables. Son los primeros gráficos de función (en este caso, función del tiempo). La cinemática celeste brinda un buen reloj a través de la segunda ley de Kepler, midiendo tiempos mediante áreas. La ley armónica de Kepler permitirá medirlos a través de longitudes. Galileo desarrolló la cinemática terrestre, y sugirió el reloj de péndulo. A Huygens debemos la técnica de medida del tiempo que ha llegado a nuestros días, y que suministró relojes más precisos y transportables mediante volantes oscilatorios acoplados a resortes de calidad.

Diseño del reloj de péndulo de Huygens, 1656 (imagen de dominio público).

La importancia, no sólo científica sino económica, de disponer de relojes precisos y estables, queda reflejada en el premio ofrecido por el gobierno inglés de la reina Ana en 1714, que dispuso that a reward be settled by Parliament upon such person o persons as shall discover a more certain and practicable method of ascertainig longitude that any yet in practice. La recompensa era de 20, 000 libras para el que presentara un cronómetro capaz de determinar la longitud con error menor de 30´ de arco al término de un viaje a las Indias occidentales, equivalente a mantener el tiempo con error menor de 2 minutos tras seis semanas de viaje. Se la llevó casi medio siglo después el relojero británico John Harrison (1693-1776), con un reloj, conocido como H4, que incorporaba correcciones por variación en la temperatura, y que en un primer viaje de 81 días desde Porstmouth a Puerto Real (Jamaica) en 1761-62 se retrasó 5 s, esto es, de precisión 10⁻⁶ (10; 44).

Después se pasó a los de diapasón, de aquí a los de cuarzo, y hoy los atómicos ofrecen precisiones desde 10⁻¹² – 10⁻¹⁵ (Cs) hasta 10⁻¹⁶ (máser de H).

Una red de relojes atómicos de cesio, sincronizados mediante ondas de radio, velan actualmente por la exactitud de la hora sobre el planeta. Como señala Davies (10), ya no nos sirve como cronómetro el giro de la Tierra alrededor de su eje. Aunque durante siglos ha sido este viejo trompo un magnífico reloj de referencia, la falta de uniformidad de su giro (las mareas, por ejemplo, lo frenan incesantemente y alargan con ello el día en un par de milésimas de segundo por siglo, perceptible para los finos cronómetros actuales), y otras desviaciones estacionales, cuantitativamente similares a estos retrasos seculares, pero irregulares y de signo variable, son circunstancias que en conjunto obligan a añadir al tiempo civil un segundo intercalar cada uno o dos años (el último lo fue el 1 de enero de 1999, a las 0 horas) con el fin de remediar la asincronía entre los tiempos atómicos y los días astronómicos. El día no tiene 86 400 s justos (donde el segundo se define como la duración de 9 192 631 770 períodos de una determinada vibración de los átomos de Cs. Hoy la tecnología alcanza precisiones fabulosas: relojes que en treinta millones de años se desviarían a lo sumo en un diminuto segundo, como el NIST-F1 (Boulder, Colorado).

Por norma general y para mayor exactitud del sistema, dentro del campo visual de cualquier receptor GPS siempre hay por lo menos 8 satélites presentes. Cada uno de esos satélites mide 5 m de largo y pesa 860 kg . La energía eléctrica que requieren para su funcionamiento la adquieren a partir de dos paneles compuestos de celdas solares adosadas a sus costados. Están equipados con un transmisor de señales codificadas de alta frecuencia, un sistema de computación y un reloj atómico de cesio, tan exacto que solamente se atrasa un segundo cada 30 mil años.

La posición que ocupan los satélites en sus respectivas órbitas facilita que el receptor GPS reciba, de forma constante y simultánea, las señales de por lo menos 6 u 8 de ellos, independientemente del sitio donde nos encontremos situado. Mientras más señales capte el receptor GPS, más precisión tendrá para determinar las coordenadas donde se encuentra situado.

Incluso hay relojes de pulsera comerciales (receptores de señales de radio) con precisión de un segundo por millón de años garantizada por un reloj atómico en una lejana estación. La naturaleza de altísima precisión: la estabilidad del púlsar binario b1855+09 puede ser de unas partes en 10¹⁵ o incluso mejor.

El tiempo en Newton:

En los PRINCIPIA, Newton empieza con una renuncia a definir el tiempo: El tiempo, el espacio, el lugar y el movimiento son de todos bien conocidos. Y no los defino. Pero digo que el vulgo no concibe esas cantidades más que por su relación a cosas sensibles. Para evitar ciertos prejuicios que de aquí se originan, es conveniente distinguirlas en absolutas y relativas, verdaderas y aparentes, matemáticas y vulgares.

A continuación, sin embargo, Newton se arrepiente de su primer impulso y aclara: El tiempo absoluto, verdadero y matemático, de suyo y por su propia naturaleza fluye uniformemente sin relación a nada externo y se llama también duración: el tiempo relativo, aparente y vulgar es cualquier medida sensible y externa (exacta o no uniforme) de la duración por medio del movimiento y se usa vulgarmente en lugar del tiempo verdadero: tal como la hora, el día, el mes, el año.

Sabemos del fluir del tiempo por el cambio que se produce en nuestro Universo, en el Mundo, en Nuestras Vidas. Con el paso del Tiempo las cosas cambian y nada permanece. Por eso sabemos que está ahí

¿Qué significa que el tiempo fluye? ¿Qué el tiempo “se mueve en el tiempo”? De nuevo la pescadilla mordiéndose la cola. El absolutismo del tiempo newtoniano recibió encendidas críticas. Leibniz opuso su idea de espacio y tiempos puramente relativos, el primero como un orden de coexistencia, el segundo como un orden de sucesiones de las cosas; ambos, espacio y tiempo, son phœnomena bene fundata. Los argumentos dinámicos con que Newton arropa su tesis de la naturaleza absoluta de la rotación y con ello la de un espacio absoluto, apoyo posterior para el tiempo absoluto, también hallan fuertes objeciones. Para Berkeley esas razones de Newton lo único que muestran es la importancia del giro respecto de las masas lejanas del Universo y no respecto de un espacio absoluto, que él no acepta. Ernst Mach, en la segunda mitad del XIX, insistirá decididamente en este punto de vista, y desde su positivismo acosará los absolutos newtonianos. De “medieval”, “no científico”, “metafísico”, tilda Mach a Newton: No tenemos derecho a hablar de un tiempo “absoluto”: de un tiempo independiente de todo cambio. Tal tiempo absoluto no puede medirse por comparación con ningún movimiento; por tanto no tiene valor práctico ni científico, y nadie tiene derecho a decir que sabe algo de él. Es una concepción metafísica vana.

El tiempo en Einstein:

El tiempo newtoniano, absoluto, el nos es familiar, tuvo que dejar paso al tiempo einsteniano, mutable y relativo, con tantos “ahora” por suceso cuantos estados de movimiento mutuo imaginemos.

El tercero de los trabajo enviados por Albert Einstein (AE) en su Annus Mirabilis de 1905 a Annalen der Physik lleva por título “Zur Elektrodynamik Bewegter Körper” (“Sobre la electrodinámica de los cuerpos en movimiento”). Junto con el quinto, titulado “Ist der Trägheit eines Körpers von seinem Energieinhalt abhängig?” (“¿Depende la inercia de un cuerpo de su contenido de energía?”), constituyen lo que hoy se llama TEORÍA ESPECIAL DE LA RELATIVIDAD.

Velocidad de la luz desde la Tierra a la Luna, situada a más de 380.000 km.

Da Albert Einstein un par de razones para justificar su tercer trabajo:

- La insatisfacción que le produce la asimetría en la descripción maxwelliana de los fenómenos electromagnéticos: la acción entre un conductor y un imán depende solo del movimiento relativo entre ambos, pero la teoría de Maxwell distingue entre el caso de conductor en reposo y el caso de imán en reposo: a) En el primer caso el campo magnético móvil engendra un campo eléctrico, con una energía determinada, que a su vez produce corrientes en el conductor en reposo. b) En el segundo caso, no se produce ningún campo electrónico, sino una fuerza electromotriz en el conductor, sin energía asociada, que engendra una corriente como en el caso anterior.

- La incapacidad de la óptica y del electromagnetismo (EM) para detectar el movimiento respecto del lichtmedium, es decir, de un inercial privilegiado. Esto le sugiere que la óptica y el EM tienen las mismas ecuaciones en todos los inerciales (sistemas en los que las leyes de la mecánica de Newton son las mismas). Y AE eleva esto a un principio, que llama “Prinzip der Relativität”, y le añade un compañero, aparentemente incompatible con él: “La velocidad de la luz en vacío es siempre la misma, con independencia del estado de movimiento del cuerpo emisor”

¿Será ese de arriba el rayo de luz de Einstein, o, por el contrario, será un asteroide que se nos viene encima?

Siendo todavía muy joven, en 1895-1896, ya le preocupaba el EM y la luz, como recordaba en 1955: “Si persiguiéramos a la velocidad de la luz un rayo de luz, veríamos una onda independiente del tiempo. ¡Tal cosa, sin embargo, no existe! Este fue el primer experimento mental, infantil, en relación con la teoría especial de la relatividad”.

Este tercer trabajo de Einstein en 1905 no contiene ninguna referencia a otros trabajos, ni suyos ni de otros (como Lorentz o Poincaré).

Consciente de que su postulado de la constancia de la velocidad de la luz choca frontalmente con la ley galileana de adición de velocidades, Albert Einstein revisa los cimientos de la Física, empezando por definir físicamente y con sumo cuidado el concepto de Gleichzeitigkeit o simultaneidad entre sucesos. Considera un sistema inercial, para el que supone válida la geometría euclidiana para calcular distancias entre objetos estacionarios a través de sus coordenadas respecto de sus ejes cartesianos. Si A, B son dos observadores estacionarios, provistos de relojes iguales, y A (B) manda una señal luminosa a B (A), quien la devuelve sin tardanza a A (B), diremos que el reloj de A está sincronizado con el reloj de B si

t(B) – t(A) = t’(A) – t(B),

donde t(A) es el tiempo marcado por el reloj de A cuando envía la señal a B, t(B) lo que marca el reloj de B al llegarle la señal de A y reemitirla, y t’(A) la lectura del reloj de A al recibir la devolución de B.

No parece el mejor método para medir la velocidad de la luz, el empleado por Galileo. Claro que, en aquellos tiempos…¿Qué se podía hacer?

Supone Albert Einstein que esta definición no lleva a contradicciones, que es en principio posible entre cualquier par de observadores estacionarios en el inercial, y que la relación de sincronización anterior es de equivalencia: Si A está sincronizada con B, también B lo está con A, y si además B lo está con C, también A y C lo están. A esto le siguen ecuaciones que quiero obviar para no dar complejidad al trabajo.

No existe “el” presente

Pasa Albert Einstein a enunciar con precisión el principio de relatividad y el postulado de la constancia de la velocidad de la luz en el vacío:

- Las leyes que rigen los cambios de los sistemas físicos son las mismas en todos los inerciales.

- Todo rayo de luz se mueve en cualquier inercial con una misma velocidad, c, independientemente del movimiento de su fuente.

Como consecuencia, demuestra que el concepto de sincronía, y por ende de simultaneidad, es relativo, no absoluto. La noción de “presente”, “ahora” o cualquier instante determinado depende del referencial inercial.

Algunos incluso hablaron de energía taquiónica

¿Más rápido que la luz?

¿Existen partículas que se muevan con velocidad superior a la de la luz? Sí; por ejemplo, cualquier partícula que lleve en agua, a temperatura entre 0 y 50 ºC, una velocidad ν > c / n, n = 1.3, irá más deprisa en ese medio que los fotones del espectro visible. Lo mismo ocurre con la mayoría de los rayos cósmicos que llegan a la atmósfera; son superlumínicos en relación con la velocidad de la luz en el aire. Precisamente en esta posibilidad de rebasar la velocidad de la luz en un medio reside el efecto Cherenkov.

Lo que no se conocen son taquiones, o partículas que se muevan más deprisa que la luz en el vacío. Si existieran, podrían utilizarse para mandar información al pasado. Violando el orden causa-efecto. Por ello se “decreta” su inexistencia.

En fin, que la velocidad de la luz en el vacío, al menos que sepamos, es infranqueable. Es un límite impuesto por la Naturaleza al que habrá que vencer, no superándolo (que no se puede), sino mediante una artimaña física inteligente que logre burlar dicho límite.

Aparte de algún que otro añadido, el artículo (parcialmente expuesto aquí -se obviaron partes complejas), es del Físico de la Universidad Complutense D. Alberto Galindo Tixaire. Fue publicado en el Volumen 19, número 1 de la Revista Española de Física en 2005 Año Mundial de la Física

En realidad, un Homenaje a Einstein por haber pasado más de un siglo desde aquel acontecimiento memorable de la Relatividad Especial en el año 1.905 y estar a punto de cumplirse otro siglo desde su relatividad general de 1915. Dos acontecimientos que marcaron el camino de la Física y la Cosmología. Hace ahora un par de años que se cumplieron los 100 años desde que Einstein diera al mundo la segunda parte de su Teoría.

emilio silvera

Totales: 75.822.721

Totales: 75.822.721 Conectados: 38

Conectados: 38