Ene

13

¡Fisica! Siempre la Física

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Las sustancias formadas por una sola clase de átomos se llaman elementos químicos. La palabra “átomo” procede del griego ατομος, que significa “indivisible” y el uso de la palabra “elemento” sugiere que se ha llegado a los ladrillos básicos con los que está formada la materia. De hecho, esta es la imagen que se tenía a mediados del siglo XIX se acuñaron estos términos. Sin embargo, hoy sabemos que todo esto es falso, que los átomos se pueden dividir y que, de esta manera, los elementos han dejado de ser verdaderamente elementales. Los físicos continúan con esta nomenclatura aunque sea formalmente incorrecta, ya que, la costumbre, como dicen los juristas, no pocas veces rigen la jerga de las leyes.

“La revolución de la mecánica cuántica empieza a materializarse, y el qubit es el principal protagonista. Siendo la unidad mínima de información de extraño mundo, permitirá procesar toda la información existente en segundos.” El futuro que nos aguarda es inimaginable y cada día que pasa aparecen nuevos logros tecnológicos que nos sitúan en otro mundo, otra sociedad, otras nuevas formas de vivir y de comprender.

Sí, son los electrones los que dan al átomo su forma esférica

A todo esto y hablando de los átomos, por fuerza, nos tenemos que acordar del electrón que da al átomo su esférica. Son partículas cargadas eléctricamente que se mueven alegremente alrededor del núcleo. El electrón es muy ligero: su masa es solamente 1/1.8836 de la del núcleo más ligero (el hidrógeno). La carga eléctrica del electrón es de signo opuesto a la del núcleo, de manera que los electrones están fuertemente atraídos el núcleo y se repelen mutuamente. Si la carga eléctrica total de los electrones en un átomo iguala a la del núcleo, lo que generalmente se necesitan varios electrones, se dice que el átomo está en equilibrio o que es eléctricamente neutro.

Un experimento realizado por científicos del Centro de Viena para la Ciencia y Tecnología Cuánticas ha demostrado que, en el mundo cuántico, la transición hacia el equilibrio térmico es más interesante y más complicada de lo que se pensaba.

Según destaca el , publicado en ‘Science’, entre un ordenado inicial y un estado final estadísticamente mixto, puede emerger un “cuasi-estacionario estado intermedio”. Este estado intermedio ya exhibe algunas propiedades como el equilibrio, pero parte de las características del estado inicial permanecen visibles durante un período de tiempo muy largo.

fenómeno se denomina “pre-termalización” y desempeña un papel importante en diversos procesos de no equilibrio en la física cuántica. Podría, por ejemplo, ayudarnos a comprender el estado del universo temprano.

La fuerza a la que obedecen los electrones, la denominada fuerza electrostática o de Coulomb, es matemáticamente bastante sencilla y, sin embargo, los electrones son los responsables de las importantes propiedades de los “enlaces químicos”. Esto se debe a que las leyes de movimiento de los electrones están regidas completamente por la “mecánica cuántica”, teoría que se completó a principios del siglo XX. Es una teoría paradójica y difícil de entender y explicar, pero al mismo tiempo es muy interesante, fantástica y revolucionaria. uno se introduce en las maravillas de la mecánica cuántica es como si hiciera un viaje a un universo que está situado fuera de este mundo nuestro, ya que, las cosas que allí se ven, desdicen todo lo que dicta nuestro sentido común de cómo tiene que ser el mundo que nos rodea.

Sincronización perfecta, ¡es una sinfonía!

No solamente los electrones, sino también los núcleos atómicos y los átomos en su conjunto obedecen y se rigen por la mecánica cuántica. La Física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck, escribió un artículo de ocho páginas y allí propuso una posible solución a un problema que había intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menos intensidad, por los objetos más fríos.

Estaban bien aceptados entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía. Pero si usamos las leyes de la termodinámica para calcular la intensidad de la radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano, y, luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico a una cierta longitud de onda característica, y que la intensidad disminuye tanto para las longitudes mayores como para las longitudes menores. Esta longitud característica es inversamente proporcional a la temperatura absoluta del objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273 ºC bajo cero). Cuando a 1.000 ºC un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de luz visible.

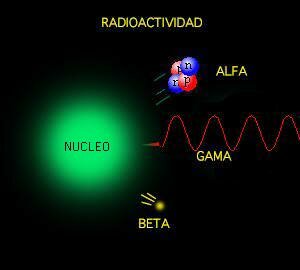

El espectro electromagnético se extiende la radiación de menor longitud de onda, como los rayos gamma y los rayos X, pasando por la luz ultravioleta, la luz visible y los rayos infrarrojos, hasta las ondas electromagnéticas de mayor longitud de onda, como son las ondas de radio. Se cree que el límite la longitud de onda más pequeña posible es la longitud de Planck mientras que el límite máximo sería el tamaño del Universo.

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de la onda y, por lo tanto, proporcional a la frecuencia de la radiación emitida. La sencilla fórmula es:

donde h es la constante de Planck (cuyo valor es 6,626 × 10−34 J·s). Sólo los fotones con una frecuencia alta (por encima de un valor umbral específico) podían provocar la corriente de electrones. Por ejemplo, la luz azul emitía unos fotones con una energía suficiente para arrancar los electrones del metal, mientras que la luz roja no. Una luz más intensa por encima del umbral mínimo puede arrancar más electrones, pero ninguna cantidad de luz por debajo del mismo podrá arrancar uno solo, por muy intenso que sea su brillo.

El esquema del Efecto fotoeléctrico nos muestra como la luz arranca electrones de la placa.

Poco tiempo después, en 1905, Einstein formuló esta teoría de una forma mucho más tajante: el sugirió que los objetos calientes no son los únicos que emiten radiación en de energía, sino que toda la radiación consiste en múltiplos de los paquetes de energía de Planck. El príncipe francés Louis-Victor de Broglie, dándole otra vuelta a la teoría, propuso que no sólo cualquier cosa que oscila tiene una energía, sino que cualquier cosa con energía se debe comportar como una “onda” que se extiende en una cierta región del espacio, y que la frecuencia, v, de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse como una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilatorias de campos de fuerza.

El curioso comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de De Broglie. Poco después, en 1926, Erwin Schrödinger descubrió escribir la teoría ondulatoria de Debroglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños estaban exactamente determinados por la recién descubiertas “ecuaciones de onda cuánticas”.

Pocas dudas nos pueden caber a estas alturas de que la mecánica cuántica (de Planck) y, la Relatividad –tanto especial general- (de Einstein), además de ser las dos teorías más importantes de la Física de nuestro tiempo, funcionan de tal forma que uno, cuando profundiza en sus predicciones y las compara con lo que ocurre en el Universo, no por menos que, asombrarse, al comprobar como unas mentes humanas han sido capaces de llegar a estos profundos pensamientos que nos acerca a la realidad de la Naturaleza, al mismo tiempo que nos aleja de nuestra propia realidad.

Sí, están ahí pero, en realidad, no sabemos, a ciencia cierta, ni cómo se formaron las galaxias

¿Qué encontraremos cuando sea posible verificar la Teoría de cuerdas? ¿Qué hay más allá de los Quarks? ¿Sabremos alguna vez lo que es una singularidad? ¿Será verdad la existencia de esa materia oscura de la que tanto se habla? ¿Podremos al fín, encontrar esa fuente de energía que tanto necesita la Humanidad para dar ese segundo paso el futuro? ¿Tendremos, acaso, algún destino que no sea el de la irremisible extinción?

¡Preguntas! Preguntas y más preguntas que no podemos contestar. Es desesperante estar inmersos en inmenso océano de ignorancia. ¿Cuándo sabremos? El el epitafio que Hilbert ordenó esculpir en su Tumba, nos lo prometía: “Tenemos que saber, sabremos”. Si, ¿pero cuándo?

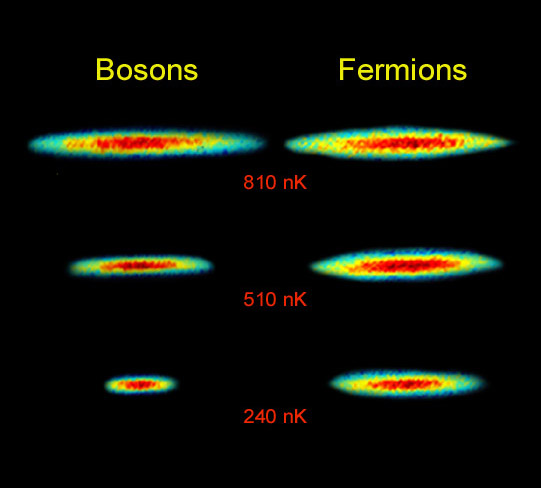

Lo cierto es que, las reglas de la mecánica cuántica tienen que ser aplicadas si queremos describir estadísticamente un sistema de partículas que obedece a reglas de ésta teoría en vez de las de la mecánica clásica. En estadística cuantica, los estados de energía se considera que están cuantizados. La estadística de Bose-Einstein se aplica si cualquier de partículas puede ocupar un estado cuántico dado. Dichas partículas (como dije antes) son los bosones que, tienden a juntarse.

Los bosones tienen un angular n h / 2p, donde n es cero o un entero y h es la constante de Planck. bosones idénticos, la función de ondas es siempre simétrica. Si solo una partícula puede ocupar un cuántico, tenemos que aplicar la estadística Fermi-Dirac y las partículas (como también antes dije) son los fermiones que tienen momento angular (n+½) h/2p y cualquier función de ondas de fermiones idénticos es siempre antisimétrica.

La mejor teoría explicar el mundo subatómico nació en 1928 cuando el teórico Paul Dirac combinó la mecánica cuántica con la relatividad especial para explicar el comportamiento del electrón. El resultado fue la mecánica cuántica relativista, que se transformó en un ingrediente primario en la teoría cuántica de campos. Con unas pocas suposiciones y ajustes, la teoría cuántica de campos ha probado ser suficientemente poderosa para formar la base del modelo estándar de las partículas y las fuerzas que rigen el universo.

La relación el espín y la estadística de las partículas está demostrada por el teorema espín-estadística. En un espacio de dos dimensiones es posible que existan partículas (o cuasipartículas) con estadística intermedia entre bosones y fermiones. Estas partículas se conocen con el de aiones; para aniones idénticos la función de ondas no es simétrica (un cambio de fase de+1) o antisimétrica (un cambio de fase de -1), sino que interpola continuamente entre +1 y -1. Los aniones pueden ser importantes en el análisis del efecto Hall cuántico fraccional y han sido sugeridos como un mecanismo para la superconductividad de alta temperatura.

Debido al principio de exclusión de Pauli es imposible que dos fermiones ocupen el mismo cuántico (al contrario de lo que ocurre con los bosones). Y, precisamente por eso, se degeneran electrones y neutrones dando lugar a la formación de estrellas enanas blancas y de neutrones que, encuentran la estabilidad frenando la fuerza de gravedad.

La condensación de Bose-Einstein es de importancia fundamental explicar el fenómeno de la superfluidez. A temperaturas muy bajas (del orden de 2×10-7k) se formar un condensado de Bose-Einstein, en el que varios miles de átomos forman una única entidad (un superátomo). efecto ha sido observado con átomos de rubidio y litio. Este efecto (condensación Bose-Einstein), ya habréis podido suponer, es llamado así en honor al físico Satyendra Naht Bose (1.894-1.974) y de Albert Einstein.

Más reciente es la obtención del Condensado de Bose-Einstein (BEC); en este caso las bases teóricas se postularon en la década de los 20 en manos de Satyendra Nath Bose y Albert Einstein. El primero describe ciertas reglas para determinar si dos fotones deberían considerarse idénticos o diferentes (Estadísticas de Bose) y Einstein aplica dichas reglas a los átomos intentando averiguar como se comportarían. Así, halla los efectos de que a muy bajas temperaturas los átomos están al mismo nivel cuántico produciendo fenómenos como la superfluidez o la superconductividad.

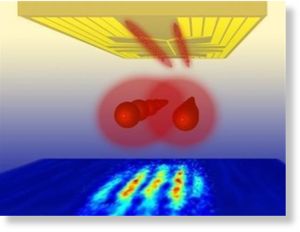

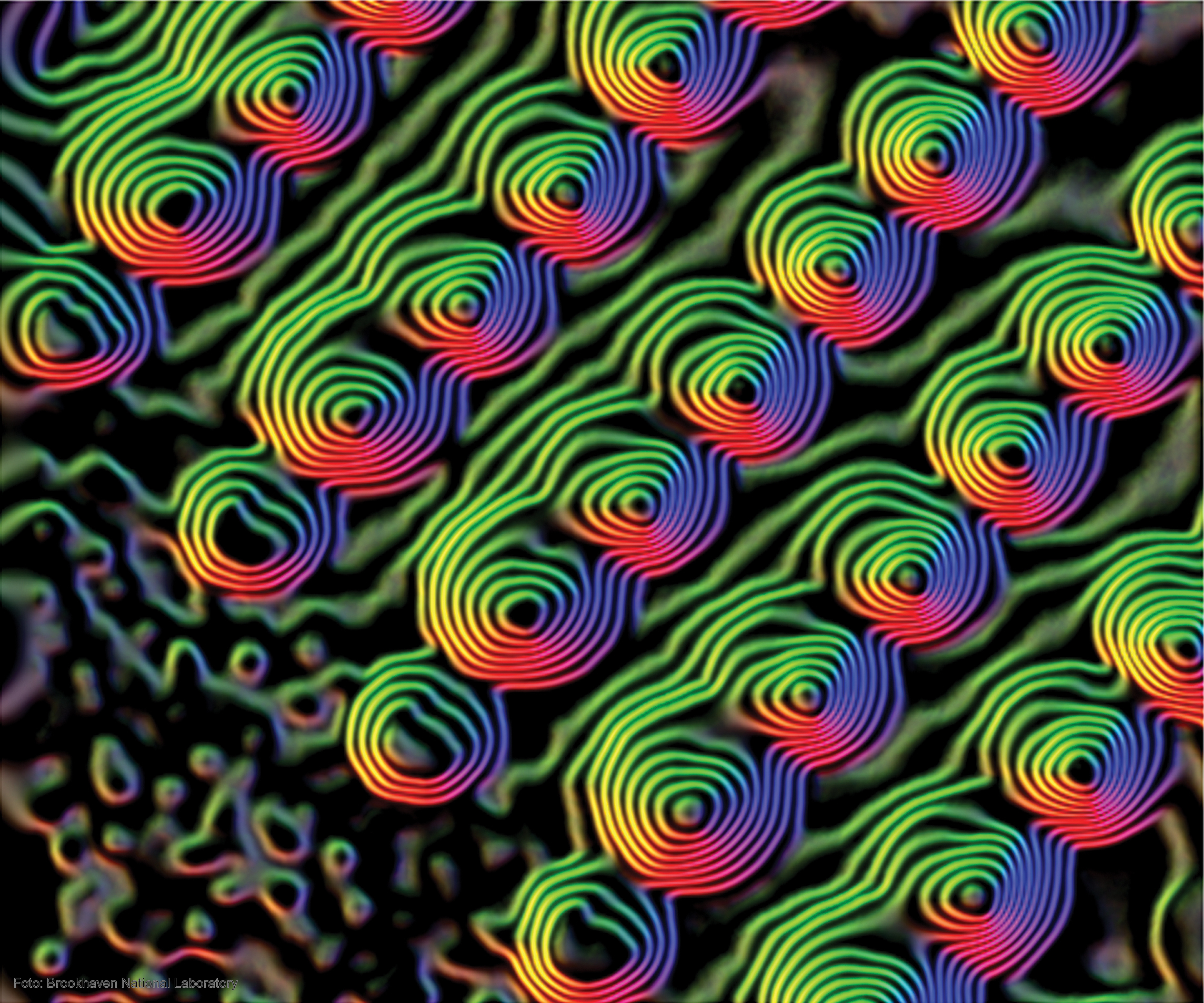

Distribución de momentos que confirma la existencia de un estado de agregación de la materia, el condensado de Bose-Einstein. obtenidos en un gas de átomos de rubidio, la coloración indica la cantidad de átomos a cada velocidad, con el rojo indicando la menor y el blanco indicando la mayor. Las áreas blancas y celestes indican las menores velocidades. A la izquierda se observa el diagrama inmediato anterior al condensado de Bose-Einstein y al centro el inmediato posterior. A la derecha se observa el diagrama luego de cierta evaporación, con la sustancia cercana a un condensado de Bose-Einstein puro. El pico no es infinitamente angosto debido al Principio de indeterminación de Heisenberg: dado que los átomos están confinados en una región del espacio, su distribución de velocidades posee necesariamente un cierto ancho mínimo. La distribución de la izquierda es para T > Tc (sobre 400 nanokelvins (nK)), la central para T < Tc (sobre 200 nK) y la de la derecha para T << Tc (sobre 50 nK).

Las estrellas enanas blancas, de neutrones y los púlsares existen, precisamente, por el principio de exclusión de Pauli que, degenera electrones y neutrones cuando las estrellas masivas, al final de su existencia, explotan como Supernovas y´su masa se contraen sobre sí misma más y más. Si la estrella es demasiado masiva, entonces ni ese principio de exclusión puede frenar a la Gravedad y se convierte en un Agujero negro.

Así que, el principio de exclusión de Pauli tiene aplicación no sólo a los electrones, sino también a los fermiones; pero no a los bosones. Si nos fijamos en todo lo que estamos hablando aquí, nos daremos de que la mecánica cu´çantica es extraña y siendo fácil comprender como forma un campo magnético la partícula cargada que gira, no resulta tan fácil saber por qué ha de hacer lo mismo un neutrón descargado.

Lo cierto es que ocurre así. La prueba directa más evidente de ello es que cuando un rayo de neutrones incide sobre un hierro magnetizado, no se comporta de la misma que lo haría si el hierro no estuviese magnetizado. El magnetismo del neutrón sigue siendo un misterio; los físicos sospechan que contiene cargas positivas y negativas equivalentes a cero, aunque por alguna razón desconocida, lograr crear un campo magnético cuando gira la partícula.

emilio silvera

Ene

13

¿La Física? ¡Una maravilla!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

Cuando llegamos a los seres unicelulares, se ve que ellos no hay distinción entre arriba y abajo. Para ellos, la tensión superficial del agua es mucho más importante que la fuerza de la gravedad a esa escala.

La tensión superficial es una consecuencia de que todas las moléculas y los átomos se atraen unos a otros con una fuerza que nosotros llamamos de Van der Waals. fuerza tiene un alcance muy corto; para ser precisos, diremos que la intensidad de esta fuerza a una distancia r es aproximadamente 1/r7. Esto significa que si se reduce la distancia dos átomos a la mitad de la fuerza de Van der Waals con la que se atraen uno a otro se hace 2 × 2 × 2 × 2 × 2 × 2 × 2 = 128 veces más intensa. Cuando los átomos y las moléculas se acercan mucho unos a otros quedan unidos muy fuertemente a través de esta fuerza. El conocimiento de esta fuerza se debe a Johannes Diderik Van der Waals (1837 – 1923) con su tesis sobre la continuidad del líquido y gaseoso que le haría famoso, ya que en esa época (1873), la existencia de las moléculas y los átomos no estaba completamente aceptado.

La tensión superficial del agua, es el efecto físico (energía de atracción entre las moléculas) que “endurece” la capa superficial del agua en reposo y permite a algunos insectos, como el mosquito y otros desplazarse por la superficie del agua sin hundirse.

El famoso físico inglés James Clerk Maxwell, que formuló la teoría del electromagnetismo de Faraday, quedó muy impresionado por este de Van der Waals.

Los tamaños de los seres uniceculares, animales y vegetales, se miden en micrómetros o “micras”, donde 1 micra es 1/1.000 de milímetro, aproximadamente el tamaño de los detalles más pequeños que se pueden observar con un microscopio ordinario. El mundo de los microbios es fascinante, pero no es el objeto de este trabajo, y continuaremos el viaje emprendido las partículas elementales que forman núcleos, átomos, células y materia, así como las fuerzas que intervienen en las interacciones fundamentales del universo y que afecta a todo lo que existe.

Hemos hablado del electrón que rodea el núcleo, de su carga eléctrica negativa que complementa la positiva de los protones y hace estable al átomo; una masa de solamente 1/1.836 de la del núcleo más ligero (el del hidrógeno). La importancia del electrón es vital en el universo.

Pero busquemos los “cuantos”. La física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck propuso una posible solución a un problema que había intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menor intensidad, por los objetos más fríos (radiación de cuerpo negro).

Estaba bien aceptado entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía. Pero si utilizamos las leyes de la termodinámica para calcular la intensidad de una radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano y, luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico a una cierta longitud de onda característica, y que la intensidad disminuye tanto para longitudes mayores como para menores. Esta longitud de onda característica es inversamente proporcional a la temperatura absoluta de objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273º bajo cero). Cuando a 1.000º C un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de luz visible.

Radiación de Cuerpo Negro

Un cuerpo negro es un objeto teórico o ideal que absorbe toda la luz y toda la energía radiante que incide sobre él. Nada de la radiación incidente se refleja o pasa a través del cuerpo negro. A pesar de su , el cuerpo negro emite luz y constituye un modelo ideal físico para el estudio de la emisión de radiación electromagnética. El nombre Cuerpo negro fue introducido por Gustav Kirchhoff en 1862.

La luz emitida por un cuerpo negro se denomina radiación de cuerpo negro. Todo cuerpo emite energía en de ondas electromagnéticas, siendo esta radiación, que se emite incluso en el vacío, tanto más intensa cuando más elevada es la temperatura del emisor. La energía radiante emitida por un cuerpo a temperatura ambiente es escasa y corresponde a longitudes de onda superiores a las de la luz visible (es decir, de menor frecuencia). Al elevar la temperatura no sólo aumenta la energía emitida sino que lo hace a longitudes de onda más cortas; a esto se debe el cambio de color de un cuerpo cuando se calienta. Los cuerpos no emiten con igual intensidad a todas las frecuencias o longitudes de onda, sino que siguen la ley de Planck.

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en paquetes de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de onda, y por tanto, proporcional a la frecuencia de radiación emitida. La fórmula es E = hν, donde E es la energía del paquete, ν es la frecuencia y h es una nueva constante fundamental de la naturaleza, la constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo nueva condición, el resultado coincidió perfectamente con las observaciones.

Poco tiempo después, en 1905, Einstein formuló esta teoría de una manera mucho más tajante: él sugirió que los objetos calientes no son los únicos que emiten radiación en paquetes de energía, sino que toda la radiación consiste en múltiplos del paquete de energía de Planck. El príncipe francés Louis-Victor de Broglie, dándole otra vuelta a la teoría, propuso que no sólo cualquier cosa que oscila tiene energía, sino que cualquier cosa con energía se debe comportar una “onda” que se extiende en una cierta región del espacio, y que la frecuencia ν de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilantes de campos de fuerza, esto lo veremos más adelante.

El curioso comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de de Broglie. Poco después, en 1926, Edwin Schrödinger descubrió cómo escribir la teoría ondulatoria de de Broglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños quedaba exactamente determinado por las recién descubiertas “ecuaciones de ondas cuánticas”.

Está bien comprobado que la mecánica cuántica funciona de maravilla…, pero, sin embargo, surge una pregunta muy formal: ¿qué significan realmente estas ecuaciones?, ¿qué es lo que están describiendo? Isaac Newton, allá en 1867 formuló cómo debían moverse los planetas alrededor del Sol, estaba claro todo el mundo qué significaban sus ecuaciones: que los planetas estaban siempre en una posición bien definida des espacio y que sus posiciones y sus velocidades en un momento concreto determinan inequívocamente cómo evolucionarán las posiciones y las velocidades en el tiempo.

Pero los electrones todo es diferente. Su comportamiento parece estar envuelto en misterio. Es como si pudieran “existir” en diferentes lugares simultáneamente, como si fueran una nube o una onda, y esto no es un efecto pequeño. Si se realizan experimentos con suficiente precisión, se puede determinar que el electrón parece capaz de moverse simultáneamente a lo largo de trayectorias muy separadas unas de otras. ¿Qué puede significar todo esto?

Niels Bohr consiguió responder a esta pregunta de tal que con su explicación se pudo seguir trabajando, y muchos físicos siguen considerando su respuesta satisfactoria. Se conoce como la interpretación de Copenhague de la mecánica cuántica.

Si la mecánica cuántica tiene cosas extrañas y el espín es una de ellas. Y si uno piensa que la intuición le ayudará a comprender todo esto, pues no lo hará, o es poco probable que lo haga. Las partículas tienen un espín fundamental. Al igual que la carga eléctrica o la masa, el espín ayuda a definir que de partícula es cada una.

Las leyes de la mecánica cuántica han sido establecidas con mucha precisión; permite cómo calcular cualquier cosa que queramos saber. Pero si queremos “interpretar” el resultado, nos encontramos con una curiosa incertidumbre fundamental: que varias propiedades de las partículas pequeñas no pueden estar bien definidas de manera simultánea. Por ejemplo, podemos determinar la velocidad de una partícula con mucha precisión, pero entonces no sabremos exactamente dónde se encuentra; o a la inversa, podemos determinar la posición con precisión, pero entonces su velocidad queda mal definida. Si una partícula tiene espín (rotación alrededor de su eje), la dirección alrededor de la cual está rotando (la orientación del eje) no puede ser definida con gran precisión.

La posición y el momento de una partícula nunca lo podremos saber con precisión ilimitada.

No es fácil explicar de forma sencilla de dónde viene esta incertidumbre, pero existen ejemplos en la vida cotidiana que tienen algo parecido. La altura de un tono y la duración en el tiempo durante el cual oímos el tono tienen una incertidumbre mutua similar. Para afinar un instrumento se debe escuchar una nota durante un cierto intervalo de tiempo y compararla, por ejemplo, con un diapasón que debe vibrar también durante un tiempo. Notas muy breves no tienen bien definido el tono.

El principio de incertidumbre de Heisenberg representa uno de los pilares fundamentales de la mecánica cuántica, también lo es el prinicpio de exclusión de Pauli que explica como los fermiones se comportan y hacen posible que existan estrellas enanas blancas y de neutrones, otros principios de Física nos hablan del por qué, la materia se comporta como lo hace allá, en lo más profundo de su “ser”. Los físicos ven mucho más profundamente de lo que a primera vista podemos ver la gente normal, ellos son privilegiados que saben, del mundo, de la Naturaleza y del Universo, ellos comprender la dinámica oculta en ese “universo” de lo infinitesimal.

Para que las reglas de la mecánica cuántica funcionen, es necesario que todos los fenómenos naturales en el mundo de las cosas pequeñas estén regidos por las mismas reglas. Esto incluye a los virus, bacterias e incluso a las personas. Sin embargo, cuando más grande y más pesado es un objeto, más difícil es observar las desviaciones de las leyes del movimiento “clásicas” debidas a la mecánica cuántica. Me gustaría referirme a exigencia tan importante y tan peculiar de la teoría con la palabra “holismo”. Esto no es exactamente lo mismo que entienden algunos filósofos por holismo, y que podría definir como “el todo es más que la suma de sus partes”. Si la física nos ha enseñado algo es justo lo contrario. Un objeto compuesto de un gran de partículas puede ser entendido exactamente si se conocen las propiedades de sus partes (partículas); basta que sepamos sumar correctamente (¡y esto no es nada fácil en mecánica cuántica!). Lo que entiendo por holismo es que, efectivamente, el todo es la suma de las partes, pero sólo se puede hacer la suma si todas las partes obedecen a las mismas leyes. Por ejemplo, la constante de Planck, h, que es igual a 6’626075… × 10-34 Julios segundo, debe ser exactamente la misma para cualquier objeto en cualquier sitio, es decir, debe ser una constante universal.

La mecánica cuántica es muy extraña a nuestro “sentido común”, sabemos que se desenvuelve en ese “universo” de lo muy pequeño, alejado de nuestra vida cotidiana en el macrocosmos tetradimensional que, no siempre coincide con lo que, en aquel otro ininitesimal acontece.

Las reglas de la mecánica cuántica funcionan tan bien que refutarlas resulta realmente difícil. Los trucos ingeniosos descubiertos por Werner Heisemberg, Paul Dirac y muchos otros mejoraron y completaron las reglas generales. Pero Einstein y otros pioneros como Erwin Schrödinger siempre presentaron serias objeciones a interpretación. Quizá funcione bien, pero ¿dónde está exactamente el electrón?, ¿en el punto x o en el punto y? En pocas palabras, ¿dónde está en realidad?, y ¿cuál es la realidad que hay detrás de nuestras fórmulas? Si tenemos que creer a Bohr, no tiene sentido buscar tal realidad. Las reglas de la mecánica cuántica, por sí mismas, y las observaciones realizadas con detectores son las únicas realidades de las que podemos hablar.

Es cierto que, existe otro universo dentro de nuestro del que, aún, nos queda mucho por aprender.

La mecánica cuántica puede ser definida o resumida así: en principio, con las leyes de la naturaleza que conocemos se puede predecir el resultado de cualquier experimento, en el sentido que la predicción consiste en dos factores: el primer factor es un cálculo definido con exactitud del efecto de las fuerzas y estructuras, tan riguroso como las leyes de Isaac Newton para el movimiento de los planetas en el Sistema Solar; el segundo factor es una arbitrariedad estadística e incontrolable definida matemáticamente de estricta. Las partículas seguirán una distribución de probabilidades dadas, primero de una forma y luego de otra. Las probabilidades se pueden calcular utilizando la ecuación de Schrödinger de función de onda (Ψ) que, con muchas probabilidades nos indicará el lugar probable donde se encuentra una partícula en un dado.

Muchos estiman que esta teoría de las probabilidades desaparecerá cuando se consiga la teoría que explique, de forma completa, todas las fuerzas; la buscada teoría del todo, lo que implica que nuestra descripción actual incluye variables y fuerzas que (aún) no conocemos o no entendemos. Esta interpretación se conoce como hipótesis de las variables ocultas.”

Publica: emilio silvera

Ene

12

¿Cómo pueden publicar cosas como éstas?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en ¡La Materia Oscura! ~

Clasificado en ¡La Materia Oscura! ~

Comments (0)

Comments (0)

“DESCUBREN EVIDENCIA SOBRE LA EXISTENCIA DE MATERIA OSCURA

Publicado por Equipo de Crónica Digital – 22 de septiembre, 2014

“Científicos estadounidenses encontraron pruebas de la existencia de la materia oscura tras analizar rayos espaciales, publicó hoy el Instituto Tecnológico de Massachussets (MIT).

Se estima que casi el 85 por ciento del universo esta compuesto por materia oscura, pero esta no refleja ni emite luz, por tanto resulta invisible para los telescopios.

Por esa razón, durante décadas los expertos solo pudieron observar los efectos de la materia oscura, en concreto las fuerzas gravitacionales que parecen mantener juntos los cúmulos de galaxias.

Ahora, los nuevos datos publicados por el MIT podrían arrojar luz sobre el origen y las propiedades de la materia oscura.

En 2011 se instaló en la Estación Espacial Internacional el dispositivo Espectrómetro Magnético Alfa (AMS), con el objetivo de identificar el origen de la materia oscura.

Según el análisis de los datos recogidos por AMS durante dos años y medio, entre los 41 mil millones de casos de rayos espaciales, se registraron 10 millones de electrones con sus positrones.

El positrón es una partícula elemental que posee la misma masa y carga eléctrica que el electrón, pero en este caso es positiva; este antielectrón (como también se le conoce) no forma parte de la materia ordinaria, sino de la antimateria.

Dado que los positrones pueden existir solo en un número muy reducido dentro del flujo del rayo espacial, su exceso sugiere que pueden provenir de una fuente distinta y, en concreto, que su origen podría estar vinculado a la materia oscura.

Según Paolo Zuccon, catedrático adjunto de física en el MIT, los resultados de AMS muestran inequívocamente que en la galaxia existe una nueva fuente de positrones.

Todavía no sabemos si estos positrones provienen de los choques de la materia oscura o de fuentes astrofísicas como los pulsares, pero las mediciones que se llevan a cabo por AMS podrían discriminar entre estas dos hipótesis, afirmó Zuccon.”

Washington, 22 septiembre 2014

Crónica Digital / PL

Con esta imagen también podría decirse que, el personaje, sale al espacio exterior en busca de la materia oscura. Total, ¿será por decir?

Según yo lo veo, la noticia publicada nos habla de las ganas de protagonismo de los autores y, desde luego, no dicen absolutamente nada que, en el plano científico demuestre que la “materia oscura” pueda existir. A lo largo del reportaje se dicen cosas como éstas:

“Según Paolo Zuccon, catedrático adjunto de física en el MIT, los resultados de AMS muestran inequívocamente que en la galaxia existe una nueva fuente de positrones.”

Tal incongruencia científica no es propia de un catedrático de física, y, nos podría explicar de manera más clara, de dónde surgió de pronto esa nueva fuente de positrones y, sobre todo, ¿cómo es que antes no estaba ahí? ¿De dónde llegó? ¿Qué la produjo? ¿Por qué positrones, la antipartícula del electrón, la antimateria?

Son tantas las afirmaciones sin sentido que están presentes en esta noticia que mejor, dejarla pasar y no prestarle una atención que no se merece.

emilio silvera

Ene

12

Nuevos Materiales, nuevos procesos, nuevos dispositivos. II

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Nuevos materiales ~

Clasificado en Nuevos materiales ~

Comments (0)

Comments (0)

Los fullerenos o “bucky-balls

Una investigación ha desarrollado una nueva estructura cuántica capaz de emitir fotones individuales de color rojo. El avance, que se publica en la revista Nature Materials, se basa en el confinamiento cuántico que se genera en cada uno de los puntos y que les permite modular la energía de la luz que emiten.

En este trabajo han participado investigadores de la Universidad de Zaragoza, el Institut de Recerca en Energia de Catalunya (IREC), la Universidad de Barcelona y del Instituto de Ciencia de Materiales de Barcelona del CSIC. El investigador Jordi Arbiol de este último explica:

“El resultado final son hilos unidimensionales, de tamaño nanométrico, compatibles con la tecnología electrónica actual, que permitirían crear dispositivos a mayor escala con un control total de la emisión de luz, fotón a fotón”.

Pero centrémonos en el trabajo que aquí se prenta hoy y que comienza hablando de los…

Nanohilos

No sólo las moléculas, los Nanotubos o el grafeno son las apuestas para sustituir al silicio. Otros elementos como los Nanohilos fabricados a partir de materiales semiconductores o los Nanohilos metálicos tendrán también cierto protagonismo. En concreto, los Nanohilos semiconductores presentan un gran potencial como transistores pero también presentan aplicaciones en campos como octoelectrónica o en la fabricación de censores biológicos. Por otro lado los Nanohilos metálicos, cuya síntesis controlada es más difícil, poseen gran interés como interconectores. En el caso de los Nanohilos formados de materiales Ni, Co o Fe se puede aprovechar también su potencial comportamiento magnetorresisitivo para ser usados en dispositivos de almacenamiento magnético. Los Nanohilos metálicos son interesantes a su vez porque los efectos de tamaño inducen en ellos la aparición de transiciones de fase martensíticas y la aparición de configuraciones no cristalinas.” Veamos que pasa con las Nanopartículas.

Nanopartículas

Quizás, junto a los nanotubos de carbono, las nanopartículas representan los materiales que tienen una repercución tecnológica más inmediata. Además de sus propiedades intrínsecas, las nanopartículas representan los materiales que tienen una repercusión tecnológica más inmediata. Además de sus propiedades intrínsecas, las nanopartículas, debido a su pequeño tamaño, pueden convertirse en diminutos dispositivos capaces de realizar otras funciones, como transportar un medicamento específico por el torrente sanguíneo sin obstruirlo. Para lograr esto, las nanopartículas deben ser el soporte de capas de moléculas autoensambladas que confieren una funcionalidad adicional a las mismas.

Como su propio nombre indica, el término “nanopartícula” designa una agrupación de átomos o moléculas que dan lugar a una partícula con dimensiones nanométricas. Es decir, que su tamaño está comprendido entre 1 y 100 nm. Dependiendo de cuáles sean los átomos o moléculas que se agrupan se originarán diferentes tipos de nanopartículas. Así, por ejemplo, tendremos nanopartículas de oro, de plata o nanopartículas magnéticas si están formadas por átomos de Fe o Co. Su pequeño tamaño hace que la relación superficie/volumen crezca y por tanto que estas estructuras tengan unas propiedades características y esencialmente distintas a las que presenta el material en volumen.

Una estrategia para la formación de nanopartículas es recubrirlas con distintas capas de manera tal que cada una aporte funcionalidades diferentes al sistema. Así, por ejemplo, recientemente se han descrito nanopartículas cuyo interior está formado por un material magnético, como el Co, seguido de una capa intermedia de SiO2 que aporta estabilidad al sistema y finalmente una superficie de oro.

El tamaño final de la nanopartícula es de 3 nm, y esta estructura laminar hace que tengan un núcleo magnético que posibilite su guiado, y una superficie de oro que facilite el autoensamblado de moléculas orgánicas o biológicas para diferentes aplicaciones. Entre éstas destaca su uso como biosensores. Para ello se inmoviliza material biológico, como ácido desoxirribonucleico (ADN) o el llamado ácido nucléico péptidico (PNA, del inglés peptide nucleic acid), que siendo un ácido nucléico artificial, presenta un “esqueleto” molecular formado por enlaces peptidicos y una estructura de bases nucleicas exactamente igual a la del ADN. El PNA puede reconocer cadenas complementarias de ADN, incluso con mayor eficiencia para la hibridación que la que representa el ADN para reconocer su hebra complementaria. Por este motivo, el PNA se ha propuesto como sonda para la fabricación de biosensores altamente eficientes. Estas macromoléculas unidas a superficies o nanopartículas son capaces de detectar diferentes analítos de interés, particularmente otars moléculas biológicas.

Sin embargo, el concepto de nanopartícula debe concebirse en un sentido más amplio ya que no sólo puede estar basada en un núcleo inorgánico, pudiéndose sintetizar nanopartículas poliméricas. Yendo un poco más allá una cápsida vírica puede entenderse como una nanopartícula formada por una carcasa proteica. Esta cápsida vírica tiene dimensiones nanométricas y, en muchos casos, burla con facilidad las membranas celulares. Por esta razón este tipo de “nanopartículas” se proponen para su uso en nanomedicina, y son el objeto de estudios básicos en los que las herramientas como los microscopios de fuerzas atómicas juegan un papel esencial. En particular, estas herramientas nos permiten caracterizar las propiedades mecánicas y las condiciones de ruptura de cápsidas víricas así como la forma en la que dichas cápsidas se comportan ante, por ejemplo, cambios controlados de humedad.

En un discurso recientemente impartido en la Universidad Europea de Madrid, William F. Clinton, ex-Presidente de los EE.UU, afirmó que ” el cometido del siglo XXI será salvar al mundo del cambio climático, regenerar la economía y crear empleo. El futuro más allá será la Nanotecnología y la biotecnología”. El propio W.F. Clinton fue el impulsor de la Iniciativa Nacional de Nanotecnología durante su mandato, convirtiendo durante los últimos 10 años a EE.UU en el líder mundial en la generación de conocimientos básicos y aplicados en el ámbito de la Nanotecnología.

Nadie pone en duda las afirmaciones de W.F. Clinton sobre el papel de la Nanotecnología en nuestro futuro a medio y largo plazo, por lo uqe es imperativo estar suficientemente preparados para construir este nuevo paradigma científico. En el caso concreto de España, las dos últimas ediciones del Plan Nacional de I+D+I han encumbrado las investigaciones en Nanociencia y Nanotecnología a la categoría de Acción Estratégica. En la actualidad se están poniendo en marcha varios centros dedicados a Nanotecnología. Dichas iniciativas son producto, por lo general, de costosos impulsos puntuales, locales, dirigidos por científicos con iniciativa, pero no son fruto de una actuación de conjunto, planificada siguiendo una estrategia quiada por unos objetivos ambiciosos, en los que impere la coordinación y el uso eficiente de los recursos. La actual coyuntura económica no invita al optimismo a este respecto, por lo que sería necesario poner en marcha iniciativas que promuevan la adquisición de infraestructuras, la formación de técnicos, la coordinación entre centros emergentes, etc.

Otro punto sobre el que no hay que descuidarse tiene que ver con la formación, en todos los niveles educativos, en Nanotecnología. En este sentido son numerosas las universidades españolas que ofrecen cursos de master y/o doctorado con contenidos relacionados con la Nanotecnología. Sin embargo, muchos de estos cursos tienen pocos estudiantes inscritos, al igual que ocurre con muchos estudios de grado relacionados con las ciencias básicas. La tarea de fascinar y atraer a nuestros jóvenes hacia la ciencia debe comenzar mucho antes. En este sentido, los conceptos inherentes a la Nanotecnología deben formar parte del conocimiento que debe llegar a los estudiantes de educación secundaria, como ocurre en países como Alemania, Finlandia, Taiwán, Japón, EE.UU., etc. Además, la Nanotecnología es una materia que causa cierta fascinación a los adolescentes por lo que puede ser un buen punto de partida para incentivar las vocaciones científicas. Esta ha sido una de las principales razones por las que los autores de este artículo junto con otros investigadores (Carlos Briones del Centro de Astrobiología y Elena Casero de la Universidad Autónoma de Madrid) accedieron a la petición de la Fundación Española de Ciencia y Tecnología (FECyT) para escribir una Unidad Didáctica de Ciencia y Tecnología. Dicho libro ya se encuentra en todos los institutos españoles de educación secundaria y bachillerato, y se puede descargar desde la web de la FECyT. Esperemos que esta pequeña contribución, junto con otras de mayor calado que deben promoverse desde las diversas administraciones públicas, permita tomar la senda que nos lleve a medio plazo hacia la tan ansiada sociedad basada en el conocimiento.

Fuente: Revista Española de Física. Volumen 23 Nº 4 de 2009

Los Autores:

D. José Ángel Martín Gago, del Instituto de Ciencia de Materiales de Madrid, Concejo Superior de Investigaciones científicas, Centro de Astrobiología /CSIC/INTA), Instituto Nacional de Técnica Aerpespacial, y, D. Pedro A. Serena Domingo, del Instituo de Ciencia y Materiales de Madrid y del Consejo Superior de Investigaciones Científicas.

Ene

12

Titán, luna de Saturno de grandes secretos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Titán ~

Clasificado en Titán ~

Comments (0)

Comments (0)

Publicado por Tendencias 21 (Tendencias Científicas), en su momento pude leer los nuevos datos descubiertos en aquella luna de Saturno que, con la misión Cassini-Huygens vino a ser la portada de muchos medios científicos. La noticia nos dice:

“La misión internacional a Saturno, Cassini, ha descubierto un océano bajo la superficie de Titán, aportando una importante pista sobre los mecanismos internos de esta luna, y descubriendo otro lugar de nuestro Sistema Solar en el que también abunda el agua líquida. El océano de Titán podría tener hasta 250 km de profundidad, fluyendo bajo una capa de hielo de unos 50 km de espesor.”

Mareas en Titán producidas por Saturno

Titán se encuentra en una órbita elíptica en torno a Saturno, completando una revolución cada 16 días. La superficie de la luna se deforma bajo la acción de la gravedad del planeta – cuando pasa por el punto más cercano a Saturno, se estira hasta tomar la forma de un balón de rugby.

La atracción gravitatoria de Titán altera la trayectoria de Cassini, y estos cambios en la superficie de la luna hacen que las perturbaciones hayan sido ligeramente diferentes en cada una de las visitas de la sonda. Estos efectos se pueden caracterizar al estudiar cómo varía la frecuencia de las señales de radio que envía el satélite a la Tierra.

“Gracias a los instrumentos de Cassini, sabemos que la superficie de Titán está compuesta de agua helada, cubierta en su mayor parte por una capa de moléculas orgánicas – el océano que oculta también podría contener otros compuestos, como amoníaco o sulfato de amonio”, destaca Iess.

“Si bien no podemos deducir la profundidad del océano a partir de nuestras medidas, los modelos matemáticos sugieren que podría tener hasta 250 km de profundidad, fluyendo bajo una capa de hielo de unos 50 km de espesor”.

Esta teoría podría explicar por qué la atmósfera de Titán contiene tanto metano. Dada la corta vida de esta molécula, tiene que existir algún mecanismo que lo reponga.

“Sabemos que las reservas de metano en los lagos de hidrocarburos de la superficie de Titán no son suficientes como para explicar la gran cantidad de esta molécula que se encuentra disuelta en su atmósfera, pero un océano podría constituir una gran reserva adicional”, explica Iess.

“Esta es la primera vez que Cassini demuestra que existe un océano bajo la superficie de Titán, aportando una importante pista sobre los mecanismos internos de esta luna, y descubriendo otro lugar de nuestro Sistema Solar en el que también abunda el agua líquida”, concluye Nicolas Altobelli, científico del proyecto Cassini para la ESA.”

Totales: 77.346.419

Totales: 77.346.419 Conectados: 61

Conectados: 61