Nov

1

¡La Naturaleza!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Extinciones de origen desconocido ~

Clasificado en Extinciones de origen desconocido ~

Comments (0)

Comments (0)

Nos empeñamos una y otra vez en querer sobrepasar nuestras posibilidades y, tenemos que pensar que, es la Naturaleza la que marca el ritmo de nuestras vidas y de nuestro tiempo, no al revés. El Universo tiene una mecánica que está regida por las fuerzas fundamentales de la Naturaleza y sus constantes y, nosotros, sólo podemos adaptarnos al mendio si queremos sobrevivir. Existen fuerzas y energías que nunca podremos controlar.

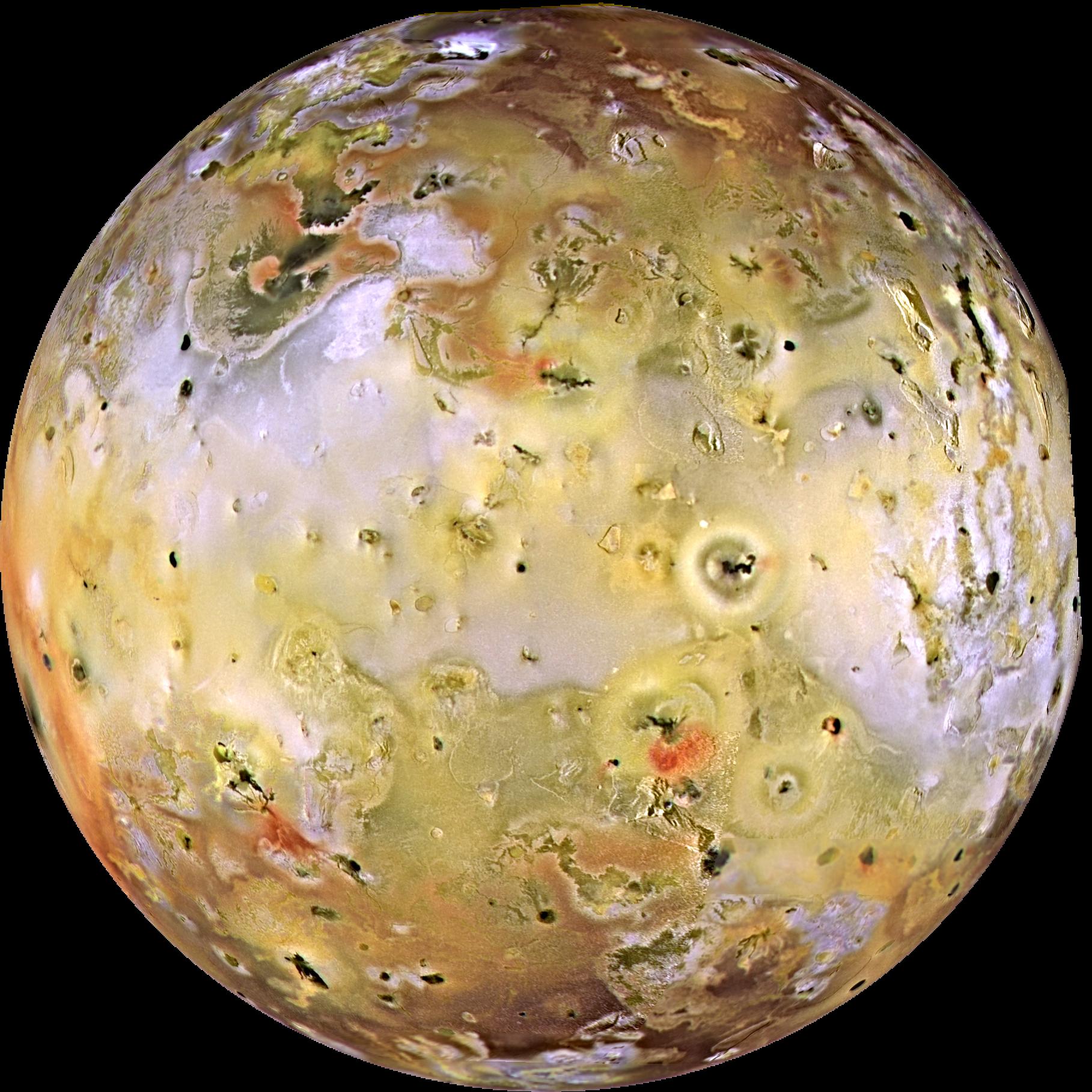

Sí, la Naturaleza nos muestra constantemente su poder. Fenómenos que no podemos evitar y que nos hablan de unos mecanismos que no siempre comprendemos. Nuestro planeta por ejemplo, se comporta como si de un ser vivo se tratara, la llaman Gaia y realiza procesos de reciclaje y renovación por medio de terremotos y erupciones volcánicas, Tsunamis y tornados debastadores que cambian el paisaje y nosotros, lo único podemos hacer es acatar el destino que ignoramos de lo que está por venir.

El mundo nos parece un lugar complicado. Sin embargo, existen algunas verdades sencillas que nos parecen eternas, no varían con el paso del tiempo (los objetos caen hacia el suelo y no hacia el cielo, el Sol se levanta por el Este, nunca por el Oeste, nuestras vidas, a pesar de las modernas tecnologías, están todavía con demasiada frecuencia a merced de complicados procesos que producen cambios drásticos y repentinos. La predicción del tiempo atmosférico es más un arte que una ciencia, los terremotos y las erupciones volcánicas se producen de manera impredecible y aparentemente aleatoria, los cambios en las Sociedades fluctuan a merced de sucesos que sus componentes no pueden soportar y exigen el cambio.

La inmensa complejidad que está presente en el cerebro humano y de cómo se genera lo que llalamos “la mente”, a partir de una maraña de conexiones entre más de cien mil millones de neuronas, más que estrellas existen en nuestra Galaxia, la Vía Láctea. Es algo grande que, en realidad, no hemos alcanzado a comprender. Nos empeñamos en querer dominar fuerzas que no conocemos y, nuestro empeño nos podría llevar a la propia destrucción.

La mente humana es de tal complejidad que no hemos podido llegar a comprender su funcionamiento. ¿Por qué unas personas tienen una gran facilidad para tocar el piano, otros para comprender las matemáticas complejas y algunos para ver lo que nadie ha sido capaz de detectar en el ámbito de la Naturaleza, pongamos por ejemplo un paisaje, o, llegar a comprender fenómenos físicos que configuran el mundo, el Universo y la vida?

Es precisamente a escala humana, donde se dan las características (posiblemente) más complejas del Universo, las que se resisten más a rendirse ante métodos y reglamentos fijos que las pretenda mantener estáticas e inamovibles por el interés de unos pocos. Las Sociedades son dinámicas en el tiempo y en el espacio y, su natural destino es el de evolucionar siempre, el de buscar las respuestas a cuestiones patra ellas desconocidas y que al estar inmersas en el corazón de la Naturaleza, se sirven de la Ciencia para poder llegar al lugar más secreto y arrancar esas respuestas que tánto, parecen necesitar para continuar hacia el futuro.

Claro que, ese futuro, no depende de esas Sociedades Humanas que de alguna manera, están a merced de sucesos como aquel de Yucatán, cuando al parecer, hace ahora 65 millones de años, perecieron los Dinosaurios que reinaron en el Planeta durante 150 millones de años hasta que llegó aquél fatídico (para ellos) pedrusco que, en realidad, posibilitó nuestra llegada.

Aquellos terribles animales que poblaban la Tierra hubiera hecho imposible nuestra presencia en el planeta. Formas de vida incompatibles con nuestra especie que desaparecieron -según parece- por causas naturales venidas del espacio exterior para que más tarde, pudiéramos nosotros hacer acto de presencia en el planeta que nos acoge.

Aquello se considera una extinción masiva ocurrida en la Tierra, algo tan claramente reflejado en el registro fósil que se utiliza para marcar el final de un período de tiempo geológico, el Cretáseo, y el comienzo de otro, el Terciario. Puesto que la “C” ya se ha utilizado como inicial en un contexto similar en relación con el período Cámbrico, este marcador se suele denominar frontera K-T, con una “K” de Kreide, que es el nombre del Cretáceo en alemán. No fueron solos los dinosaurios los que resultaron afectados, aunque son los que aparecen con mayor protagonismo en los relatos populares cuando se habla de este desastre.

Esqueletos de dinosaurios expuestos en el Museo Real de Ontario, Canadá.

Alrededor del 70 por ciento de todas las especies que vivían en la Tierra al finales del cretáceo habian desaparecidos a principios del Terciario, lo cual indica que se trató realmente de una “extinción en masa” y explica por qué los geólogos y los paleontólogos utilizan la frontera K-T como un marcador importante en el registro fósil. Dadas las dificultades que plantean unas pruebas de tiempos tan remotos, y la lentitud con la que se acumulan los estratos geológicos, todo lo que podemos decir realmente sobre la velocidad a la que se produjo aquella extinción es que sucedió en menos de unas pocas decenas de miles de años, pero en ningún caso durante muchos millones de años; sin embargo, esto se considera un cambio brusco en relación con la escala de tiempo utilizada en geología.

Las preguntas obvias que esto plantea son las mismas que surgen tras un gran terremoto -por qué sucedió, y si podría suceder de nuevo y, en su caso, cuándo- En el caso del suceso K-T hay un candidato muy adecuado para ser el desencadenante que hizo que la extinción se produjera, por ejemplo, hace 60 0 55 millones de años. Los restos del enorme cráter que data justo de entonces ha sido descubierto bajo lo que es ahora la península de Yucatán, en Méjico, y por todo el mundo se han hallado estratos de hace 65 millones de años que contienen restos de iridio, un metal pesado que es raro en la corteza terrestre, pero del que sabemos que es un componente de algunos tipos de meteoritos. La capa de iridio es tan delgada que tuvo que depositarse en menos de 10.000 años (quizá mucho menos), lo cual es coherente con la teoría de que el suceso K-T fue desencadenado en su totalidad, de manera más o menos instantánea, por un gran golpe que llegó del espacio interestelar.

La catástrofe está servida

No sería difícil explicar por que pudo suceder todo esto. La energía cinética contenida en un impacto de este calibre sería equivalente a la explosión de unos mil millones de megatoneladas de TNT y arrojaría al espacio unos detritos en forma de grandes bloques que se desplazarían siguiendo trayectorias balísticas (como las de los misiles balísticos intercontinentales) y volverían a entrar en la atmósfera por todo el globo terráqueo, difundiendo calor y aumentando la temperatura en todas las regiones. Se produciría un efecto de calentamiento de 10 kilowatios por cada metro cuadrado de la superficie terrestre durante varias horas, un fenómeno que ha sido descrito gráficamente por Jay Melosh. A continuación, unas diminutas partículas de polvo lanzadas al interior de la parte superior de la atmósfera se extendería alrededor del todo el planeta y, combinada con el humo de todos los incendios desencadenados por el “asado a la parrilla”, bloquearían el paso de la luz del Sol, causando la muerte de todas las plantas que dependían de la fotosíntesis y congelando temporalmente el planeta.

Si el planeta se congela, ¿dónde nos meteremos? ¿cuántas criaturas tendrán la oportunidad de sobrevivir?

Hay pruebas de que, en épocas pasadas, la Tierra sufrió visitas inesperadas desde el espacio que trajo muerte y desolación. Hace unos 35 millones de años, la Tierra soportó unos impactos parecidos sin que se produjera una extinción del calibre del suceso K-T. Aunque los factores desencadenantes tengan la misma magnitud. Por otra parte, existen pruebas de que los Dinosaurios y otras especies estaban ya en decadencia en los dos últimos millones de años del Cretáceo. Parece que los grandes lagartos habían experimentado altibajos durante los 150 millones de años que se pasaron vagando por la Tierra. Hay opiniones para todos y algunos dicen que su desparición se debió, en realidad, al aumento del Oxígeno en nuestra atmósfera.

El suceso K-T es en realidad sólo una entre cinco catástrofes similares (en la medida en que afectó en aquella época a la vida en la Tierra) a las que los geólogos denominan en conjunto las “cinco grandes” -y no es en absoluto la mayor-. Cada una de ellas se utiliza como marcador entre períodos geológicos y todas han sucedido durante los últimos 600 millones de años.

La razón por la que nos centramos en este pasado geológico relativamente reciente es que fue en esa época cuando los seres vivos desarrollaron por primera vez algunas características, tales como las conchas, que podían fosilizarse fácilmente, dejando rastros que pueden reconocerse en los estratos que se estudian en la actualidad.

Nuevas especies de fósiles de invertebrados marinos, que vivieron hace 465 millones de años, se han hallado en diversos yacimientos de la provincia de Ciudad Real en España, y, por todas partes del mundo, si se profundiza en la Tierra, se encuentran fósiles y conchas de tiempos pasados. En la imagen recreada arriba se recoge el descubrimiento especies nuevas, de animales marinos con concha que han posibilitado su hallazgo después de tantos millones de años.

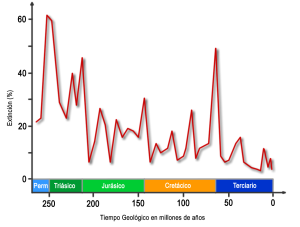

Pero centrémonos en las “cinco grandes extinciones” que, tomándolas cronológicamente se produjeron hace unos 440 millones de años (que marcaron la frontera entre los períodos Ordovícico y Silúrico), hace 360 millones de años (entre el Devónico y el Carbonífero), 250 millones de años (entre el Pérmico y el Triásico), 215 millones de años (en la frontera entre el Triásico y el Jurásico) y 65 millones de años (en la frontera K-T).

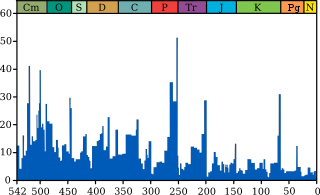

Millones de años

Intensidad de la extinción marina a través del tiempo. El gráfico azul muestra el porcentaje aparente (no el número absoluto) de los géneros de animales marinos extintos durante un determinado intervalo de tiempo. Se muestran las ultimas cinco grandes extinciones masivas.

Hay otras muchas extinciones en el registro fósil pero, las más importantes son las mencionadas. La más espectacular de todas ellas es el suceso que tuvo lugar hace unos 250 millones de años, al final del Pérmico. Se extinguieron al menos el 80 por ciento, y posiblemente hasta el 95 por ciento, de todas las especies que vivían en nuestro planeta en aquellos tiempos, tanto en la tierra como en los océanos, y lo hizo durante un intervalo de menos de 100.000 años. Sin embargo, dado que también se calcula que el 99 por ciento de todas las especies que han vivido en la Tierra se han extinguido, esto significa que son el doble las que han desaparecido en sucesos de -aparente- menor importancia.

La cuestión que nos intriga es si las extinciones en masa son realmente acontecimientos especiales, de carácter diferente al de las extinciones de menor importancia, o si son el mismo tipo de suceso, pero a gran escala -¿son las extinciones de vida en la Tierra unos hechos cuya naturaleza es independiente de su magnitud, como los terremotos y todos los demás fenómenos que la Naturaleza nos envía periódicamente que dan lugar a catástrofes y pérdidas de muchas vidas? La respuesta sincera es “no lo sabemos”, pero hay bastantes evidencias como para intuir que ésta es una posibilidad muy real.

El logotipo del Movimiento por la Extinción Humana Voluntaria es un globo terráqueo sobre el que aparece la letra V y sobre ella otra pequeña tierra y el acrónimo VHEMT de Voluntary Human Extinction Movement.

Gracias a un meticuloso trabajo de investigación de Jack Sepkoski, de la Universidad de Chicago que, pudo trazar un gráfico en el que mostraba como ha fluctuado durante los últimos 600 millones de años el nivel de extinciones que se produjo en cada intervalo de cuatro millones de años.

Extinciones segun Sepkoski

El gráfico nos muestra que la muerte de los dinosaurios fue también la muerte de los invertebrados marinos. La pregunta que se puede plantear es que clase de aleatoriedad es ésta, si realmente son sucesos aleatorios. Resulta que es una ley potencial -nuestro viejo amigo, el ruido 1/f-. El origen de esta señal aleatoria, de enorme interés por su ubicuidad y propiedades matemáticas, sigue siendo un misterio, a pesar de la atención que se le ha dedicado.

Ahora bien, no parece probable que todas las extinciones de vida que han sucedido en la Tierra hayan tenido como causa impactos procedentes del espacio. Lo que parece estar diciéndonos el registro fósil es que las extinciones se producen en todas las escalas, todos los tiempos, y que (como en el caso de los terremotos) puede producirse una extinción de cualquier magnitud en cualquier época. Algunas extinciones podrían ser desencadenadas por impactos de meteoritos; otras, por períodos glaciares. Una cosa sí que nos queda clara: es necesario un gran desencadenante para que ocurra un gran suceso, y, no podemos olvidar que estamos inmersos en un Sistema Complejo -la vida en la Tierra- que es autoorganizador, se alimenta a partir de un flujo de energía, y existe al borde del Caos. Si comprendemos eso, estaremos preparados para entender lo que todo esto significa para la vida en sí misma, siempre expuesta a las fuerzas del Universo.

La Tierra es una nave espacial que recorre el universo y, en sus viajes… ¿Por qué sitios tendrá que pasar? ¿Qué peligros la acechan?

A lo largo de nuestra Historia hemos conocido situaciones de muertes masivas como por ejemplo: La Peste de la Guerra del Peloponeso (430 a.C.), La Plaga Antonina (165 y 180), La Plaga de Justiniano (541 y 542), La Peste Negra (1348 y 1350), o, La Gripe Española (1918) y, todas ellas son en realidad de origen desconocido. Esto me lleva a pensar que la Tierra, nuestro planeta, viaja por el espacio como una gran nave espacial y recorre regiones interestelares en las que no sabemos qué puede haber, y, ¿quién puede negar que al atravesar esas regiones, no estén presenten en esas esporas fuertemente acorazadasa contra la radiación que, atravesando la atmósfera terrestre se instalen tan ricamente en nuestro mundo para florecer y sembrar la muerte entre nosotros? Lo cierto es que son muchas las cosas que no sabemos.

Al contacto con la atmósfera y el agua de la Tierra, con el calor del Sol, se abren y traen desolación y muerte

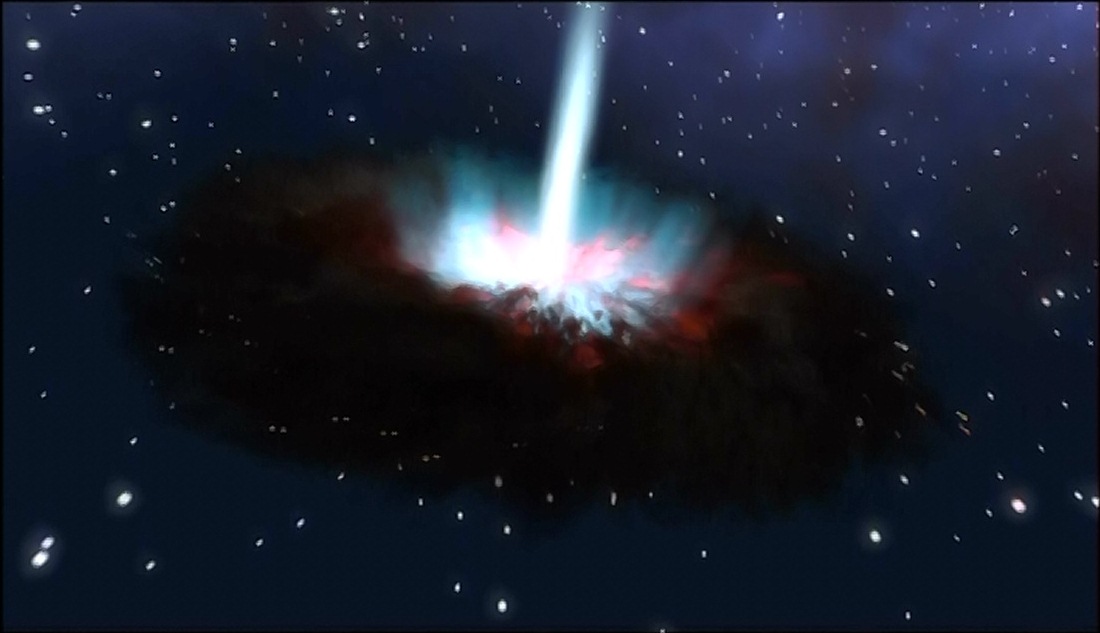

De todas las maneras, no podemos negar que grandes cambios nos acechan y, como la medida del “tiempo” es distinta para la escala humana que para la del Universo, en cualquier momento podrá tener lugar un acontecimiento de índole diversa (la caída de un meteorito, una pandemia debastadora, cataclismos tectónicos de gran magnitud, explosiones supernovas de inmensa intensidad que barra nuestra atmósfera y siembre de radiación el planeta…) que vendrá a transformar todo lo que nosotros consideramos importante y que, para la Naturaleza, no es nada.

De todas las maneras, en una cosa sí tenemos que estar de acuerdo: ¡La vida! Esa cosa tan frágil pero tan fuerte, se ha resistido a desaparecer a lo largo de los millones de años que lleva en el planeta y, eso nos lleva a sospechar que, lo mismo habrá sucedido en otros lugares y la Vida, debe estar por todas partes… ¡A pesar de todo!

emilio silvera

Nov

1

Hay que recorrer un largo camino para saber

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Descubrir y aprender ~

Clasificado en Descubrir y aprender ~

Comments (0)

Comments (0)

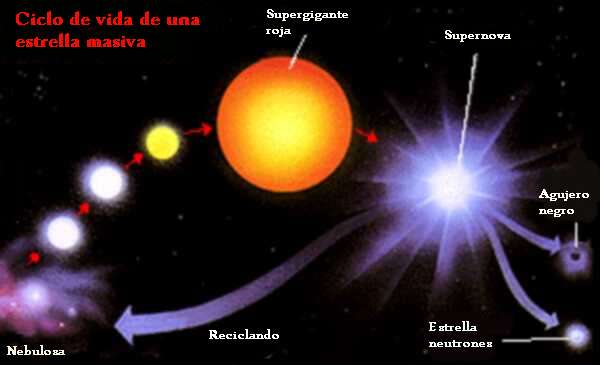

“La masa con la que nace una estrella determina su historia y, sobre todo, la duración de su vida. Llamamos estrellas masivas a todas aquellas estrellas aisladas que explotan como supernovas al final de su existencia debido al colapso gravitatorio. Para que exploten como supernovas deben tener un mínimo de alrededor de ocho masas solares. Estrellas con menos masa pueden explotar, pero no por sí mismas (deben darse otras condiciones). Y hay parámetros secundarios que pueden introducir cambios, pero la masa es determinante.”

“En cuanto al máximo, el límite está en lo que la naturaleza sea capaz de producir. Hasta hace poco se creía que este límite estaba en torno a monstruos de 150 masas solares, aunque recientes trabajos lo elevan hasta 300. No obstante, no es un dato seguro ya que, cuanto más masiva es una estrella, menos vive, con lo cual estrellas más grandes serían difíciles de observar.”

Verdaderamente si pudiéramos contemplar de cerca, el comportamiento de una estrella cuando llega el final de su vida, veríamos como es, especialmente intrigante las transiciones de fase de una estrella en implosión observada desde un sistema de referencia externo estático, es decir, vista por observadores exteriores a la estrella que permanecen siempre en la misma circunferencia fija en lugar de moverse hacia adentro con la materia de la estrella en implosión. La estrella, vista desde un sistema externo estático, empieza su implosión en la forma en que uno esperaría. Al igual que una pesada piedra arrojada desde las alturas, la superficie de la estrella cae hacia abajo (se contrae hacia adentro), lentamente al principio y luego cada vez más rápidamente. Si las leyes de gravedad de Newton hubieran sido correctas, esta aceleración de la implosión continuaría inexorablemente hasta que la estrella, libre de cualquier presión interna, fuera aplastada en un punto de alta velocidad. Pero no era así según las fórmulas relativistas que aplicaron Oppenheimer y Snyder. En lugar de ello, a medida que la estrella se acerca a su circunferencia crítica su contracción se frena hasta hacerse a paso lento. Cuanto más pequeña se hace la estrella, más lentamente implosiona, hasta que se congela exactamente en la circunferencia crítica y, dependiendo de su masa, explosiona como supernova para formar una inmensa nebulosa o, se tranforma en nebulosa planetaria, más pequeña.

Ahí podemos observar a una estrella muy joven, de dos o tres millones de años que, en un futuro lejano será una gran Supernova. Los procesos que podríamos observar al final de la vida de una estrella gigante… ¡Son fascinantes! Ese punto azulado que vemos envuelto en una masa de gas y polvo, no es otra cosa que la estrella Eta Carinae, una variable luminosa azul hipermasiva. Su masa puede osciular entre las 100 y 150 masas solares y, como el límite para la masa de una estrella está estipulado en 120 masas solares, ésta de arriba, para no ser destruída por su propia radiación, eyecta material al espacio interestelar para descongestionarse.

En la escena que antes explicabámos, por mucho tiempo que nos quedemos esperando y comtemplando el suceso, si uno está en reposo fuera de la estrella (es decir, en reposo en el sistema de referencia externo estático), uno nunca podrá ver que la estrella implosiona a través de la circunferencia crítica. Ese fue el mensaje inequívoco que Oppenheimer y Snyder nos enviaron. Para poder ver eso, habría que estar dentro de la estrella, instalado en la materia que está sufriendo la contracción y, no sabemos porque eso es así.

¿Se debe esta congelación de la implosión a alguna fuerza inesperada de la relatividad general en el interior de la estrella? No, en absoluto, advirtieron Oppenheimer y Snyder. Más bien se debe a la dilatación gravitatoria del tiempo (el frenado del flujo del tiempo) cerca de la circunferencia crítica. Tal como lo ven los observadores estáticos, el tiempo en la superficie de la estrella en implosión debe fluir cada vez más lentamente cuando la estrella se aproxima a la circunferencia crítica; y, consiguientemente, cualquier cosa que ocurre sobre o en el interior de la estrella, incluyendo su implosión, debe aparecer como si el movimiento se frenara poco a poco hasta congelarse.

Por extraño que esto pueda parecer, aún había otra predicción más extrañas de las fórmulas de Oppenheimer y Snyder: si bien es cierto que vista por observadores externos estáticos la implosión se congela en la circunferencia crítica, no se congela en absoluto vista por los observadores que se mueven hacia adentro con la superficie de la estrella. Si la estrella tiene una masa de algunas masas solares y empieza con un tamaño aproximado al del Sol, entonces vista desde su propia superficie implosiona hacia la circunferencia crítica en aproximadamente una hora, y luego sigue implosionando más allá de la criticalidad hacia circunferencias más pequeñas.

Allá por el año 1939, cuando Oppenheimer y Snyder descubrieron estas cosas, los físicos ya se habían acostumbrados al hecho de que el tiempo es relativo; el flujo del tiempo es diferente medido en diferentes sistemas de referencia que se mueven de diferentes formas a través del Universo. Claro que, nunca antes había encontrado nadie una diferencia tan extrema entre sistemas de referencia. Que la implosión se congele para siempre medida en el sistema externo estático, pero continúe avanzando rápidamente superando al punto de congelación medida en el sistema desde la superficie de la estrella era extraordinariamente difícil de comprender. Nadie que estudiara las matemáticas de Oppenheimer y Snyder se sentía cómodo con semejante distorsión extrema del tiempo. Pero ahí estaba, en sus fórmulas. Algunos podían agitar sus brazos con explicaciones heurísticas, pero ninguna explicación parecía muy satisfactoria. No sería completamente entendido hasta finales de los cincuenta.

Fue Wheeler el que discrepó del trabajo de Oppenheimer y Snyder, alegando, con toda la razón que, cuando ellos habían realizado su trabajo, habría sido imposible calcular los detalles de la implosión con una presión realista (presión térmica, presión de degeneración y presión producida por la fuerza nuclear), y con reacciones nucleares, ondas de choque, calor, radiación y expulsión de masa. Sin embargo, los trabajos desde las armas nucleares de los veinte años posteriores proporcionaron justamente las herramientas necesarias.

Presión, reacciones nucleares, ondas de choque, calor radiación y expulsión de masa eran todas ellas características fundamentales de una bomba de hidrógeno; sin ellas, una bomba no explosionaría. A finales de los años cincuenta, Stirling Colgate quedó fascinado por el problema de la implosión estelar. Con el apoyo de Edward Teller, y en colaboración con Richard White y posteriormente Michael May, Colgate se propuso simular semejante implosión en un ordenador. Sin embargo, cometieron un error, mantuvieron algunas de las simplificaciones de Oppenheimer al insistir desde el principio en que la estrella fuera esférica y sin rotación, y, aunque tuvieron en cuenta todos los argumentos que preocupaban a Wheeler, aquello no quedó perfeccionado hasta después de varios años de esfuerzo y, a comienzo de los años sesenta ya estaban funcionando correctamente.

Un día a principio de los años sesenta, John Wheeler entró corriendo en la clase de relatividad de la Universidad de Princeton. Llegaba un poco tarde, pero sonreía con placer. Acababa de regresar de una visita a Livermore donde había visto los resultados de las simulaciones recientes de Colgate y su equipo. Con excitación en su voz dibujó en la pizarra un diagrama tras otro explicando lo que sus amigos de Livermore habían aprendido.

Cuando la estrella en implosión tenía una masa pequeña, desencadenaba una implosión de supernova y formaba una estrella de neutrones precisamente en la forma que Fritz Wicky había especulado treinta años antes. Sin embargo, si la estrella original era más masiva lo que allí se producía (aparte de la explosión supernova) era un agujero negro notablemente similar al altamente simplificado modelo que veinticinco años calcularon Oppenheimer y Snyder. Vista desde fuera, la implosión se frenaba y se quedaba congelada en la circunferencia crítica, pero vista por alguien en la superficie de la estrella, la implosión no se congelaba en absoluto. La superficie de la estrella se contraía a través de la circunferencia crítica y seguía hacia adentro sin vacilación.

Lo cierto fue que allí, por primera vez, se consiguió simular por ordenador la implosión que debía producir agujeros negros. Está claro que la historia de todo esto es mucho más larga y contiene muchos más detalles que me he saltado para no hacer largo el trabajo que, en realidad, sólo persigue explicar a ustedes de la manera más simple posible, el trabajo que cuesta obtener los conocimientos que no llegan (casi nunca) a través de ideas luminosas, sino que, son el resultado del trabajo de muchos.

Hoy, sabemos mucho más de cómo finaliza sus días una estrella y, dependiendo de su masa, podemos decir de manera precisa que clase de Nebulosa formará, que clase de explosión (si la hay) se producirá, y, finalmente, si el resultado de todo ello será una estrella enana blanca que encuentra su estabilidad final por medio del Principio de exclusión de Pauli (en mecánica cuántica)que se aplica a los fermiones pero no a los Bosones (son fermiones los quarks, electrones, protones y neutrones), en virtud del cual dos partículas idénticas en un sistema, como los electrones en un átomo o quarks en un hadrón (protón o neutrón, por ejemplo), no pueden poseer un conjunto idéntico de números cuánticos.

La estrella azul cerca del centro de esta imagen es Zeta Ophiuchi. Cuando se ve en luz visible aparece como una estrella roja relativamente débil rodeada de otras estrellas tenues y sin polvo. Sin embargo, en esta imagen infrarroja tomada con campo amplio por el Explorador Infrared Survey de la NASA, o WISE, un punto de vista completamente diferente emerge. Zeta Ophiuchi es en realidad una muy masiva y caliente estrella azul, brillante que traza su camino a través de una gran nube de polvo y gas interestelar.

Una estrella masiva alejándose de su antiguo compañero se manifiesta haciendo un imponente surco a través de polvo espacial, como si se tratase de la proa de un barco. La estrella, llamada Zeta Ophiuchi, es enorme, con una masa de cerca de 20 veces la de nuestro Sol. En esta imagen, en los que se ha traducido la luz infrarroja a colores visibles que vemos con nuestros ojos, la estrella aparece como el punto azul en el interior del arco de choque. Zeta Ophiuchi orbitó una vez alrededor de una estrella aún más grande. Pero cuando la estrella explotó en una supernova, Zeta Ophiuchi se disparó como una bala. Viaja a la friolera velocidad de 24 kilómetros por segundo arrastrando con ella un conglomerado de polvo que distorsiona la región por la que pasa.

Mientras la estrella se mueve través del espacio, sus poderosos vientos empujan el gas y el polvo a lo largo de su camino en lo que se llama un arco de choque. El material en el arco de choque está tan comprimido que brilla con luz infrarroja que WISE puede captar. El efecto es similar a lo que ocurre cuando un barco cobra velocidad a través del agua, impulsando una ola delante de él. Esta onda de choque queda completamente oculta a la luz visible. Las imágenes infrarrojas como esta son importantes para arrojar nueva luz sobre lo que ocurre en situaciones similares.

Pero, siguiendo con el tema de las implosiones de las estrellas, ¿cuál es la razón por la que la materia no se colapsa, totalmente, sobre sí misma? El mismo principio que impide que las estrellas de neutrones y las estrellas enanas blancas implosionen totalmente y que, llegado un momento, en las primeras se degeneran los neutrones y en las segundas los electrones, y, de esa manera, se frena la compresión que producía la gravedad y quedan estabilizadas gracias a un principio natural que hace que la materia normal sea en su mayor parte espacio vacio también permite la existencia de los seres vivos. El nombre técnico es: El Principio de Exclusión de Pauli y dice que dos fermiones (un tipo de partículas fundamentales) idénticos y con la misma orientación no pueden ocupar simultáneamente el mismo lugar en el espacio. Por el contrario, los bosones (otro tipo de partículas, el fotón, por ejemplo) no se comportan así, tal y como se ha demostrado recientemente por medio de la creación en el laboratorio de los condensados de Bose-Einstein.

¿Cuál es la diferencia?

Los bosones son sociables; les gusta estar juntos. Como regla general, cualquier átomo con un número par de electrones+protones+neutrones es un bosón. Así, por ejemplo, los átomos del sodio ordinario son bosones, y pueden unirse para formar condensados Bose-Einstein.

Los bosones son sociables; les gusta estar juntos. Como regla general, cualquier átomo con un número par de electrones+protones+neutrones es un bosón. Así, por ejemplo, los átomos del sodio ordinario son bosones, y pueden unirse para formar condensados Bose-Einstein.

Izquierda: Los bosones son sociables; los fermiones son antisociales.

Los fermiones, por otro lado, son antisociales. No pueden juntarse en el mismo estado cuántico (por el Principio de Exclusión de Pauli de la mecánica cuántica). Cualquier átomo con un número impar de electrones+protones+neutrones, como el potasio-40, es un fermión.

Pero, estábamos diciendo: “…no pueden poseer un conjunto idéntico de números cuánticos.” A partir de ese principio, sabemos que, cuando una estrella como nuestro Sol deja de fusionar Hidrógeno en Helio que hace que la estrella deje de expandirse y quede a merced de la Gravedad, ésta implosionará bajo el peso de su propia masa, es decir, se contraerá sobre sí misma por la fuerza gravitatoria pero, llegará un momento en el cual, los electrones, debido a ese principio de exclusión de Pauli que les impide estar juntos, se degeneran y se moverán de manera aleatoria con velocidades relativista hasta el punto de ser capaces de frenar la fuerza provocada por la gravedad, y, de esa manera, quedará estabilizada finalmente una estrella enana blanca.

Si hablamos de una estrella supermasiva, su produce la implosión arrojando las capas externas al espacio interestelar mientras que el grueso de la estrella se comprime más y más sin que nada la pueda frenar, aquí no sirve el Principipo de exclusión de Pauli para los fermiones y, es tal la fuerza gravitatoria que se desencadena como consecuencia de que la estrella supergigante no puede seguir fusionando y queda a merce4d de una sola fiuerza: La Gravedad, que ésta, la comprime hasta lo inimaginable para convertir toda aquella ingente masa en una singularidad, es decir, un punto de densidad y energía “infinitas” que ni la luz puede escapar de allí, y, el tiempo se ralentiza y el espacio se curva a su alrededor.

Si la estrella original es más masiva, la degeneración de los electrones no será suficiente para frenar la fuerza gravitatoria y, los electrones se fusionaran con los protones para convertirse en neutrones que, bajo el mismo principio de exclusión sufrirán la degeneración que frenará la fuerza de gravedad quedando entonces una estrella de neutrones. Por último, si la estrella es, aún más masiva, ni la degeneración de los neutrones será suficiente para frenar la inmensa fuerza gravitatoria generada por la masa de la estrella que, continuará la implosión contrayéndose cada vez más hasta desaparecer de nuestra vista convertida en un agujero negro.

¿Qué forma adoptará, qué transición de fase se produce en la materia dentro de una Singularidad?

¡Resulta todo tan complejo!

emilio silvera

Nov

1

¡El futuro incierto!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Futuro incierto ~

Clasificado en El Futuro incierto ~

Comments (0)

Comments (0)

A mí, particularmente, me da mucho miedo un futuro en el que las máquinas sean imprescindibles. En este mismo momento ya casi lo son. ¿Qué haríamos sin ordenadores que mediante sus programas dirigen fábricas, llevan todo el movimiento de las Bolsas del mundo y de los bancos, dirigen los satélites del espacio, llevan a cabo complicadas operaciones quirúrgicas y montan y ensamblan elaborados mecanismos industriales? El mundo quedaría paralizado. Incluso las Centrales nucleares, algo tan peligroso, está dirigido por los ordenadores que marcan las pautas a seguir mediante programas elaborados a tal efecto. ¿Y si fallan?

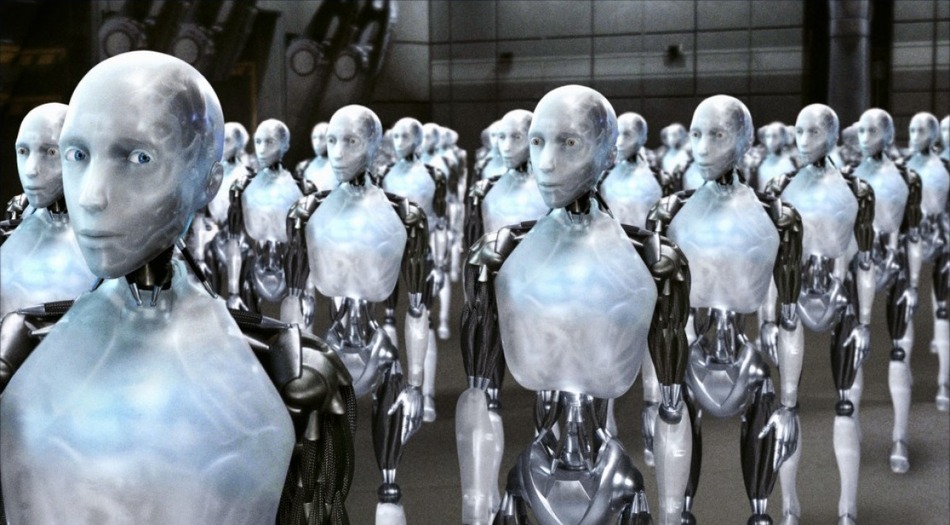

Pienso en un mundo mucho más avanzado, dentro de 500 – 1.000 años. ¿Qué habrá pasado con los robots?, máquinas cada vez más perfectas que llegaron a autofabricarse y repararse. ¿Cómo evolucionarán a partir de esos procesadores inteligentes de la nanotecnología? ¿Llegarán algún día a pensar por sí mismos? Ahí puede estar uno de los grandes peligros de la Humanidad.

La invención del robot (del checo, robota, trabajo) se debe al esfuerzo de las sociedades humanas por liberarse de las labores más ingratas y penosas a que se ven obligados algunos de sus individuos. En un principio, la apariencia de los robots sólo atendía a las razones prácticas de las funciones que cada modelo tenía que desempeñar, o sea, su morfología estaba aconsejada por criterios funcionales y prácticos.

Una vez superada la primera fase, el hombre trata de fabricar robots que cada vez sean más semejantes a su creador, y aunque las primeras figuras han sido algo groseras y poco hábiles en sus movimientos, poco a poco se va perfeccionando la imitación de los humanos.

Un robot se diferencia fundamentalmente de una máquina por su capacidad para funcionar de modo automático sin la acción permanente del hombre. Los primeros robots se mostraron especialmente válidos para llevar a cabo aquellos trabajos sencillos y repetitivos que resultaban tediosos y pesados al hombre (al Ser Humano mejor). También son ideales para el trabajo en el que se está expuesto a cierto peligro o se trabaja con materiales peligrosos en lugares nocivos para los seres vivos

Nuevas generaciones de robots que…, ¿comienzan a ser peligrosos?

Las máquinas del futuro nos pueden superar. Hemos comenzado a inventar robots que, cada vez son más sofisticados y tienen más prestaciones y, de seguir por ese camino, de no poner unas reglas claras, precisas u rígidas sobre el límite…las cosas podrían salir mal.

Una de las condiciones esenciales que debe tener una máquina-robot para ser considerada como tal es la posibilidad de ser programada para hacer tareas diversas según las necesidades y la acción que de ellos se requieran en cada situación. Y, si llegan a poseer la potestad de pensar por sí mismas, de repentizar soluciones no programadas, de sentir y ser conscientes…¡malo!

Dentro de algunas decenas de años, por ejemplo, no será necesario que ningún astronauta salga al espacio exterior para reparar estaciones espaciales o telescopios como hacen ahora, con riesgo de sus vidas, con el Hubble.

El miedo a los robots del futuro que antes citaba está relacionado con el hecho de que la robótica es el estudio de los problemas relacionados con el diseño, aplicación, control y sistemas sensoriales de los robots.

Ya van quedando muy viejos aquellos robots de primera generación (en realidad brazos mecánicos), muy utilizados en labores de menos precisión de la industria automovilística. Hoy día, los robots que se fabrican, están provistos de sofisticados sistemas “inteligentes” que son capaces de detectar elementos e incluso formas de vida rudimentarias. El proyecto de la NASA en el río Tinto es un ejemplo de ello; allí han utilizado pequeños robots capaces de comunicar datos científicos de los hallazgos en el fondo de un río. Actúan mediante programas informáticos complejos o no, que hacen el trabajo requerido.

Supermáquinas que pueden desarrollar trabajos imposibles

Las necesidades de la industria aeronáutica, poco a poco, han ido exigiendo sistemas de mayor precisión, capaces de tomar decisiones adecuadas en un entorno predefinido en función de las condiciones particulares de un momento dado. Estos ingenios, llamados de segunda generación, poseen instrumentos propios y programación informática dotada de medios de autocorrección frente a estímulos externos variables.

Los sensores utilizados por los sistemas robóticas de segunda generación son, con frecuencia, equipos de cámaras electrónicas digitales que convierten la imagen luminosa recibida desde el exterior en impulsos eléctricos que se comparan con patrones almacenados en un pequeño núcleo de memoria informática. Así mismo, disponen de instrumentos táctiles de alta sensibilidad y de detección de pesos y tensiones.

Incluso en otros planetas a millones de distancia de la Tierra, realizan los trabajos programados

Los robots de tercera generación emplean avanzados métodos informáticos, los llamados sistemas de inteligencia artificial, y procedimientos de percepción multisensorial (estoy leyendo una maravillosa tesis doctoral de un ingeniero de materiales – hijo de un buen amigo – que es fascinante, y me está abriendo la mente a nuevos campos y nuevos conceptos en el ámbito de la inteligencia artificial. Su nombre es A. Mora Fernández, y tiene la suerte de ser, además, un físico teórico matemático, con lo cual, según lo que puedo deducir de su trabajo, le espera grandes empresas y mi deseo personal es que triunfe en ese complejo mundo de fascinantes perspectivas al que pertenece).

Estos ingenios de tercera generación adoptan algunas características del comportamiento humano al contar con la capacidad para percibir la realidad del entorno desde varias perspectivas y utilizar programas que rigen su propia actuación de modo inteligente. Conscientes de su situación espacial, los robots de tercera generación comprenden directamente el lenguaje humano y lo utilizan para comunicarse con las personas.

Los Androides del futuro. ¿Tendrán autonomía de pensamiento? ¿Les daremos cerebros espintrónicos para pensar?

La ciencia robótica, basándose en avanzados principios de la electrónica y la mecánica, busca en la constitución y modo de funcionamiento del cuerpo y del cerebro humano los fundamentos con los que diseñar androides de posibilidades físicas e intelectivas semejantes a los del ser humano.

Nada de esto es ciencia ficción; es lo que hoy mismo ocurre en el campo de la robótica. Aún no podemos hablar de robots con cerebros positrónicos capaces de pensar por sí mismos y tomar decisiones que no le han sido implantados expresamente para responder a ciertas situaciones, pero todo llegará. Ya tienen velocidad, flexibilidad, precisión y número de grados de libertad. ¿Qué hasta donde llegarán? ¡Me da miedo pensar en ello!

Pronto nos costará distinguirlos. Acodáos de aquella película de los replicantes… ¡Eran como nosotros!

Mecánicamente, el robot ya supera al ser humano; hace la misma tarea, con la misma velocidad y precisión o más que aquél, y tiene la ventaja de que no se cansa, puede continuar indefinidamente desempeñando la tarea en lugares que para nosotros serían imposibles por sus condiciones extremas.

Menos mal que, de momento al menos, el cerebro del ser humano no puede ser superado por un robot, ¿pero será para siempre así? Creo que el hombre es un ser que, llevado por sus ambiciones, es capaz de cometer actos que van encaminados a lograr la propia destrucción y, en el campo de la robótica, si no se tiene un exquisito cuidado, podemos tener un buen ejemplo.

El peligro puede ser muy real

Antes de dotar a estas máquinas de autonomía de obrar y de pensar, debemos sopesar las consecuencias y evitar, por todos los medios, que un robot pueda disponer como un ser humano del libre albedrío, como artificial que es, siempre debe estar limitado y tener barreras infranqueables que le impidan acciones contrarias al bienestar de sus creadores o del entorno.

Es muy importante que los sistemas sensoriales de los robots estén supeditados a los límites y reglas requeridas por los sistemas de control diseñados, precisamente, para evitar problemas como los que antes mencionaba de robots tan avanzados y libre pensadores e inteligentes que, en un momento dado, puedan decidir suplantar a la Humanidad a la que, de seguir así, podrían llegar a superar.

Esta simpática imagen ya ha sido superada

Pensemos en las ventajas que tendrían sobre los humanos una especie de robots tan inteligentes que ni sufrirían el paso del tiempo ni les afectaría estar en el vacío o espacio exterior, o podrían tranquilamente, al margen de las condiciones físicas y geológicas de un planeta, colonizarlo fácilmente, aunque no dispusiera de atmósfera, ya que ellos no la necesitarían y, sin embargo, podrían instalarse y explotar los recursos de cualquier mundo sin excepción. ¡Menuda ventaja nos llevarían! Además, lo mismo que nosotros nos reproducimos, los robots se fabricarán unos a otros. Ni las famosas tres leyes de Asimos me tranquilizan… ¿Las recuerdan?

- Ningún robot no debe dañar a un ser humano o, por su inacción, dejar que sufra daño.

- Debe obedecer las órdenes que les son dadas por un ser humano, excepto si entran en conflicto con la primera Ley.

- Debe proteger su propia existencia hasta donde esa protección no entre en conflicto con la Primera y la Segunda Ley.

Pero… ¿Quién podría asegurar que todo eso se cumplirá? ¡Nadie puede!

Con los complejos y sofisticados sensores y elementos tecnológicos avanzados con los que serán dotados los robots del futuro, ¿éstos no pensarán y decidirán por su cuenta? ¡Creo que nadie está en situación de asegurar nada! La amenaza está ahí, en el futuro, y el evitarla sólo depende de nosotros, los creadores. ¡Es tanta nuestra ignorancia!

Ciertamente hemos imaginado mundos futuros en los que, no parece que las tres leyes de la robótica puedan preservar la integridad física de los humanos. Si los robots alcanzan ese nivel autónomo de pensamiento… Sería, ¡la rebelión de las máquinas! tantas veces vista en la ficción del cine.

¿Que puede impedir que en el futuro los robots tengan conciencia de ser, o, incluso, sentimientos?

Parece mentira que, alguna vez, lleguen a sentir…llorar o reir

Mirando a mi alrededor, de manera clara y precisa, puedo comprobar que el mundo biológico está compuesto por una variedad de seres que, siendo iguales en su origen, son totalmente distintos en sus formas y en sus mentes, y, de la misma manera, al igual que en nuestro planeta Tierra, pasará en otros situados en regiones remotas del espacio. Y, pensando en nuestras vidas, podemos llegar a preguntarnos si todo ésto tiene algún sentido. ¿Para qué tanto esfuerzo y trabajo? ¿No será que estamos preparando el terreno para “seres” artificiales que, mejor dotados que nosotros para salir al espacio exterior, serán los que suplanten a la Humanidad y cumplan finalmente los sueños de ésta, que harán suyos?.

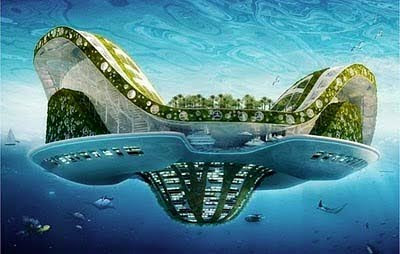

¡Qué lastima! Si ese fuera nuestro destino. ¡Fabricar a una especie artificial para que cumpliera nuestros deseos! Lo cierto es que, nosotros los humanos, no estamos físicamente preparados para viajar a las estrellas, y, de hacerlo, necesitaríamos dotarnos de tanta seguridad que, los costes, serían impensables. Naves como ciudades que nos transportaran muy lejos, y, pensando en que estamos supeditamos a la velocidad de la luz, estas naves-ciudades estarían preparadas para mantener a generaciones.

Ciudades que surcan el hiperespacio o que pueden estacionarse en los fondos oceánicos

Nuestro futuro es muy incierto, y, como podemos ver cada día, estamos supeditados a los caprichos de la Naturaleza. Conceptualmente, la biología generalmente va a la saga de la física. Si bien es cierto que las ideas de Darwin sobre la evolución han desplazado la concesión trasnochada y, ¿por qué no?, anti-ilustrada de la creación espacial, pero es cierto que bien entrado el siglo XX, muchos biólogos todavía pensaban instintivamente que los seres humanos representaban la culminación de la evolución, y que nuestra especie no era simplemente el centro del desarrollo evolutivo sino, en realidad, su razón de ser. Y, tales pensamientos, nos pueden dar una idea muy clara del nivel de sabiduría del que podemos presumir.

Ahora sabemos que nuestra contribución al árbol genealógico de la vida es tan periférica y minúscula como la de la Tierra en el Universo. El árbol, tal como lo podemos ver hoy, es realmente frondoso. Desde que surgió la vida en la Tierra, probablemente haya producido cientos de miles de millones, quizás billones, de ramitas, donde cada ramita representa una especie, y Homo sapiens es sólo una más entre ellas. En pocas palabras, nuestra especie ha sido tan cabalmente “periferalizada” por la biología como lo ha sido por la cosmología. Sólo somos una de las formas de vida que habita el Universo y, no es seguro que seámos la más inteligente.

¿Quién sabe lo que pueda existir ahí fuera, en otros mundos, en otros universos?

Una vez que hemos comprendido que no somos “los elegidos” y que, estamos en este Mundo, una infinitesimal fracción de una Galaxia de entre cientos de miles de millones de ellas, podemos ser conscientes de que, la humildad será nuestra mejor elección para no equivocarnos y llevarnos decepciones que, en otro caso, serían de consecuencias muy graves. Muchas pueden ser las criaturas que, habitantes de otros mundos, nos pueden superar en inteligencia y conocimientos y, seguramente por eso, porque en nuestro fuero interno algo nos dice que es así, nos estamos preparando para ese futuro que irremediablemente llegará, y, lo único que podemos hacer es crear réplicas de nosotros mismos que, aunque artificiales, puedan representarnos de alguna manera en ese futuro incierto.

No podemos saber lo que vendrá. ¿Es todo tan imprevisible!

Ese encuentro maravilloso que tantas veces hemos imaginado, es posible que no lo sea tanto. No podemos saber las criaturas que pueden estar presentes en otros mundos y con qué medios puedan contar. Siempre se me hizo cuesta arriba el hecho de que, algún día del futuro, los robots fabricados por nosotros, podrían adquirir la supremacía del planeta. Sin embargo, alguna vez he pensado también que, quizás, sea la única manera de poder hacer frente a lo que vendrá.

Hemos oído en no pocas ocasiones que la realidad supera a la imaginación, y, desde luego, simplemente con ver todo lo que existe en el Universo, podemos dar fe de tal afirmación. ¿Quién iba a pensar hace 150 años en la existencia de Agujeros Negros o Estrellas de Neutrones? Y, de la misma manera que aquí en la Tierra surgieron cientos de miles de especies y formas de vida a lo largo de su historia, ¿qué prohíbe que en otros mundos surgieran también especies de vida que ni podemos imaginar? ¿Y, la Naturaleza? En Japón hemos visto estos días de lo que es capaz y, desde luego nada puede ser descartado.

Cualquier cosa puede ser posible, ¡es tan frágil la línea que nos separa del Caos!

Es cierto, nuestras limitaciones son enormes, enorme es también nuestra ignorancia y, si somos conscientes de ello, habremos dado un gran paso para hacer frente a lo que pueda venir. Al menos no nos cogerá desprevenido y, el suceso es menos doloroso cuando se espera.

Sí, es verdad, que a veces, confundimos la ilusión y la euforia del momento con la realidad. Sin embargo, nada más lejos de ser cierto. Vivimos en una falsa seguridad cotidiana que nos hace no pensar en lo que puede llegar: Un accidente, una enfermedad, un meteorito caído del cielo, un terremoto, o, incluso una estrella enana marrón que choque con la Luna y dé al traste con nuestra tranquila vida en este planeta. Y, a todo esto, no hemos hablado del peligro biológico de los birus que, nosotros mismos, manejamos en Laboratorios tratando de conseguir… “cosas” que, no siempre están en nuestras manos. No sabemos ni cambatir el ébola y estamos a merced de… ¡La Naturaleza y sus caprichos!

El destino, ¡tiene tántas bifurcaciones! Parece un laberinto de espejos que lo hace incierto. No siempre hemos sabido ver la realidad de las cosas

Así que, ilusos y tranquilos -de otra manera sería horrible la vida-, en estos últimos años hemos sido capaces de determinar los genes responsables de las más variadas manifestaciones de nuestra existencia: susceptibilidad a la obesidad, diferentes tipos de tumores, esquizofrenia, depresión o la mayor o menor capacidad para danza y ritmo. Y, con sorpresa para algunos, se ha podido saber que nuestra secuencia genética sólo difiere un 0’5% de nuestros parientes cercanos neandertales o que tampoco estamos muy lejos, genéticamente hablando, de algunos equinodermos que divergieron de nuestra rama evolutiva hace ahora 500 millones de años.

También, al mismo tiempo, hemos construido ingenios que enviados a otros mundos, situados a millones de kilómetros del nuestro, nos mandan imágenes que podemos contemplar tranquilamente sentados en el salón de nuestras casas. Y, paralelamente, se trabaja en cerebros artificiales espintrónicos y, más adelante, positrónicos que ocuparan cuerpos perfectos de robots que, aunque artificiales, algún día llegarán a pensar y sentir. ¿Serán nuestros sucesores? ¿Serán los que finalmente realizarán nuestros sueños de viajar a las estrellas?

Sin embargo, y a pesar de tantas proezas, si en algo sigue la ciencia gateando en la oscuridad, es precisamente en el total desconocimiento de la parte más compleja y delicada de nuestro cuerpo: ¡el Cerebro! ¡Si tuviéramos tiempo!

emilio silvera

Totales: 67.132.743

Totales: 67.132.743 Conectados: 20

Conectados: 20