Feb

2

Nuevas ideas, ideas viejas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

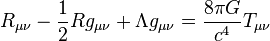

Cuando Einstein irrumpió en la Física, nadie le conocía y sólo era un oscuro empleado de la Oficina de Patentes de Berna en Suiza. Él, sin embargo, no había dejado de estar al día y seguí todo aquello que se pudiera mover en relñación a su pasión: La Física. Los escritos de Mach, de Lorentz, de Maxwell, de Planck… Todo ello le llevó a elaborar su famosa teoría relativista que convulsionó el mundo de la ciencia y, si me apuras mucho, hasta el ámbito filosófico cambió a partir de la relatividad. Una teoría que venía a decir cosas increibles como que la masa era energía congelada, que la luz marcaba el límite de la velocidad del universo, o, que el tiempo se ralentizaba si se marcha a velocidades cercanas a c. Esos estraños postulados no fueron, en un principio, bien entendidos por la física del momento.

Manuscrito de Einstein con la fórmula de la Teoría de la Relatividad. Cuando esto se dio a conocer al mundo, muchos miraron excépcicos la fórmula y las implicaciones que de ella se podrían derivar, aquello podría cambiar lo firmemente establecido: ¡sacrilegio! ¿qué será de la Física si hacemos caso a lo que diga cualquiera?

Siempre ha sido así, el Status Institucional establecido, bien acomodado en los sillones de las academias y corporaciones, hacen la señal de la cruz, como para espantar al diablo, cada vez que aparecen nuevas ideas que, en realidad, les aterra, toda vez que les puede remover de sus asientos y prebendas, ya que, generalmente, dejan al descubierto que todo lo que predomina, está asentado en una falsa base de criterios y teorías que no siempre, son las correctas ni pueden ser demostradas y, mientras tanto eso ocurre, ellos, ¡a vivir que son dos días!

En el trabajo “No siempre la Física se puede explicar con palabras”, el amigo Tom Vood nos deja el siguiente comentario que, al parecerme de interés aquí os lo inserrto para que todos, podais pensar en lo que aquí expone: Creo que sí, deben ser divulgadas.

!”Te dejo una entre muchas “revelaciones” reciente, calentitas solo para ti; que no quisiera que se divulgaran. Pero le dejo a su responsabilidad, si borrarlas, si usted cree que debo seguir como guerrillero de la ciencia o debe ser conocidas estas ideas por toda la comunidad científica. Disculpa, pero no logro discernir eso. Pero como admiras tanto a Einstein y yo soy tan tonto, te la insinúo por arribita: (Según el modelo de la interacción Luz-Luz).

http://www.emiliosilveravazquez.com/blog/2012/05/31/acercarse-a-la-velocidad-de-la-luz-trae-consecuencias/

¿Sabes por que las energíasmasas (partículas, o electromagnéticos confinados) no pueden superar la velocidad de la luz?

Bueno Einstein se moriría por explicárselo; a pesar de que para los modernos físicos esas preguntas ilegales no se le hacen a la física; recuerda el famoso: ¡no preguntes y calcula! Como diciendo, no eres físico, sino físico-matemático. O lo que no se, o no me puedo explicar, no lo puedes preguntar, es de mal gusto hacerlo, o de ignorantes. ¡Que daño Dios!

Bueno, pues una partícula según mi modelo es energíacampo confinada o electromagnético confinado en forma de energíamasa y por lo tanto cuando alcanza la velocidad de la luz, ocurre la ruptura de simetría que lo regresa a ser de nuevo energíacampo.

Más riguroso: Si una energíamasa alcanza la velocidad de la luz, se convierte en energíacampo.

De aquí se extraen miles de corolarios:

-Las energíasmasas (partículas) si alcanzan la velocidad de la luz, solo que una vez que la alcanzan, se rompe su topología de confinación, de energíasmasas y se liberan de nuevo como energíascampos. Algo que nunca dejaron de ser. Es que eso nunca las cinco física anteriores lo prohibían; por algo era. Mi modelo no mutila, incorpora,… Son los físicos, los que al no tener un buen modelo, medio que lo veían implícito así en la teoría; que eso no podía suceder. Pero si sucede, solo que nunca pueden sostenerse así.

Tom parece tener en sus manos las respuesto pero… se les escapa entre los dedos

-Nunca una energíamasa (partícula con masa) podrá superar la velocidad de la luz. La conclusión Eisteniana que nadie se ha podido explicar. Vez que fácil es todo, una vez que se va ha la física.

-La velocidad de la luz no es una barrera, la barrera es la ley que confina la energíacampo, en forma de energíamasa. Esa topología, geometría; o relaciona geometrías/energía.

-Toda aniquilación, desintegración y explosión tipo Big Bang (odio, o no creo lo del Big Bang) de los cuerpos del macrocosmo, es por la misma causa.

-De esto se extrae (del modelo también) la ley universal permitibilidad máxima de energía por unidad de espaciotiempo… El VICEVERSA; porque si no todo fuera energíascampos y la naturaleza no ocurre así: Toda energíacampo (luz,…) se confina como energíamasa, cuando su velocidad se hace cero.

-O lo que es lo mismo, ninguna partícula sin masa puede llegar a alcanzar el estado de reposo. Otra cosa que ningún modelo ha explicado, aunque es evidente que es un principio natural. Como todo lo que les explico. ¡Total, si eso es ilegal para el establishment!

De aquí se infieren muchas preguntas, conclusiones, paradojas, o explicaciones más racionales, a muchas cosas que decimos explicadas o que no hemos explicado todavía.

también nosotros estamos inmersos en un campo de energía-masa

La energíascampos (ustedes siempre piensen en la luz como yo al principio, para que no se pierdan) nunca puede estar en reposo (que la energía no puede estar en reposo es conocido, por eso es energía), pero como si existen circunstancias físicas muy especiales, donde esta puede ir disminuyendo su velocidad hasta que sea cero; la naturaleza resuelve esta paradoja, confinando las energíascampos, en diferentes topologías que donde se conserva como energíascampos (mas fácil verlo si piensan en luz); pero exteriormente se manifiesta como un ente, que puede estar en reposo o moverse como un todo; como lo que llamamos partículas con masa ( para mi energíasmasas).

Otra idea que puede ayudarlos a digerir esto: la energíacampo oscila, están acotadas entre la velocidad cero y la velocidad “c”. Esa oscilación, tipo superficie de agua hirviente, es lo que ocurre en la superficie de un agujero negro. Otra revelación de la riqueza física que despliega el modelo.

Te explico mejor: Cuando una energíacampo (luz) cae en un campo tan intenso como el de un agujero negro, su velocidad comienza a disminuir, llegado al “horizonte” (concepto que hay que ampliar) donde su velocidad seria cero; según mi modelo se confina como una energíamasa y trataría de moverse como un todo. Y aquí pueden ocurrir varias cosas que no te he explicado. Según la geometría que adopte la confinación, podrá ser un fermión izquierdo o derecho (una partícula o una antipartícula); así que puede ocurrir aniquilación…

También podría ocurrir que esa partícula (o energíamasa) alcance la velocidad de la luz; es decir regrese ha ser energíacampo, ya te explique por que. Ahora, la gravitación es energíacampo también, y aquí ocurre que ella penetra a la partícula (el mismo proceso de la aniquilación, todo es lo mismo, hay una regularidad natural entre el micromundo y el macromundo, que nadie ve), satura la estabilidad de su topología, y esta se desintegra (aquí tienes la explicación de todos los procesos de desintegración y con el, los tiempos de vida). Pero desintegración en mi razonamientos, en el modelo; es decaer en otra topología de menor energía y cuando esas topologías estables, quedan agotadas por las leyes naturales, que los físicos llamamos de conservación (carga, spin, Isoespin, CP, CPT,…); no le queda otro remedio a la energíamasa; que volver ha ser una energíacampo.

Estaría bien que Tom pudiera, por fín, atrapar con los dedos de la Mente, su teoría Luz-Luz (débil-fuerte) para asombrar al mundo.

Bueno espero haberte complacido en algo, “tuvisteis la exclusividad”, lo dejo ahí porque para que lo digieran y porque tengo muchos problemas que resolver. Tampoco tengo tiempo de leer lo que escribí (como ya es costumbre); pero ustedes son inteligentes como para no crucificarme, así que corrígeme ha tus Dones. Pueden divulgar a su antojo, como siempre les digo, “mi física de café con leche”. Tómense su tiempo para digerirlo, para acostumbrarse a estas nuevas concepciones físicas, esto párese merecerlo, parece novedoso.

Gracias amigo, te agradecemos las revelaciones que, si al fin se abren camino, nos podrían llevar a terrenos más cercanos a la realidad física del mundo. Daríamos un paso adelante en la comprensión del Universo y, como pasa siempre que obtenemos alguna nueva respuesta…¡Podríamos seguir planteando neuvas preguntas! que por cierto, ahora no podemos hacer por no tener ese conocimiento que tú tratas de entregar al mundo.

Sigamos con la Gravedad Cuántica

La física será incompleta y conceptualmente insatisfactoria en tanto no se disponga de una teoría adecuada de la gravedad cuántica. Todos hemos oido hablar de la incompatibilidad de las dos teorías que sustentan hoy por hoy toda la Física y que, todosm también sabemos que, son teorías incompletas que necesitan de una reunificación en un todo poderoso que todo lo puesda explicar.

Durante el siglo XX, la física se fundamentó, en general, sobre dos grandes pilares: la mecánica cuántica y la teoría de relatividad. Sin embargo, a pesar de los enormes éxitos logrados por cada una de ellas, las dos aparecen ser incompatibles. Esta embarazosa contradicción, en el corazón mismo de física teórica, se ha transformado en uno de los grandes desafíos permanentes en la ciencia.

La teoría de la relatividad general da cuenta a la perfección de la gravitación. Por su parte, la aplicación a la gravedad de la mecánica cuántica requiere de un modelo específico de gravedad cuántica. A primera vista, parecería que la construcción de una teoría de gravedad cuántica no sería más problemático que lo que resultó la teoría de la electrodinámica cuántica (EDC), que ya lleva más de medio siglo con aplicaciones más que satisfactorias.

En lo medular, la EDC describe la fuerza electromagnética en términos de los cambios que experimentan las llamadas partículas virtuales, que son emitidas y rápidamente absorbidas de nuevo; el principio de incertidumbre de Heisenberg nos dice que ellas no tienen que conservar la energía y el movimiento. Así la repulsión electrostática entre dos electrones puede ser considerada como la emisión, por parte de un electrón, de fotones virtuales y que luego son absorbidos por el otro.

La misma mecánica, pero a través de los cambios de la partícula virtual de la gravedad el «gravitón» (el quantum del campo gravitacional), podría considerarse para estimar la atracción gravitacional entre dos cuerpos. Pero gravitones nunca se han visto. La gravedad es tan débil que puede obviarse a escala molecular, donde los efectos cuánticos son importantes. Ahora, si los cambios que podrían realizarse en los gravitones sólo se producen en la interacción entre dos puntos de masa, es posible, entonces, que en los cuerpos masivos se ignore los efectos cuánticos. El principio de incertidumbre de Heisenberg nos señala que no podemos medir simultáneamente la posición y la velocidad de una partícula subatómica, pero esta indeterminación es imperceptible para los planetas, las estrellas o las galaxias.

Sí, pero, ¿qué me dices del gravitón?

Pero el principal obstáculo, sin embargo, es la cantidad de complicados procesos que implica examinar un gran número de gravitones. La gravedad se diferencia crucialmente del electromagnetismo al no ser lineal. Esta inlinealidad surge porque la gravedad posee la energía, y ésta tiene la masa, que gravita. En el lenguaje cuántico, esto implica que gravitones interactúan recíprocamente con otro gravitones, a diferencia de los fotones, que interactúan sólo con cargas y corrientes eléctricas y no con otros fotones. Ahora, como los gravitones interactúan el uno con el otro, las partículas de materia son rodeadas por complejas redes de gravitones virtuales que forman «lazos cerrados», muy semejante a «árboles bifurcados».

En la teoría de campo cuántica, los lazos cerrados son un signo de problema; ellos normalmente producen respuestas infinitas en los cálculos de procesos físicos. En EDC, tales lazos ocurren cuando un electrón emite y absorbe de nuevo su propio fotón. En ese caso, los infinitos son soslayados a través de un procedimiento matemático conocido como renormalización. Si éste es hecho correctamente, se obtienen razonables respuestas. La QED es lo que se llama una teoría renormalizable porque todos los infinitos pueden ser soslayados sistemáticamente; en efecto, solo un conjunto de operaciones matemáticas es suficiente para eliminar los infinitos.

Parece que aquí puede estar la solución

Lamentablemente, tal procedimiento sistemático no es operativo cuando la mecánica cuántica es aplicada a la relatividad general; la teoría es, por lo tanto, «no-renormalizable». Cada proceso que implique progresivamente más lazos cerrados de gravitones introduce nuevas variantes de términos infinitos. Lo anterior, coarta la investigación para muchísimos fenómenos de interés, y sugiere que puede que haya básicamente algo que esté errado en la relatividad general, en la mecánica cuántica, o en ambas.

Pero miremos más allá del problema de renormalización, ¿qué pasaría si nos remontáramos a un momento en que todo lo que podemos ver, y hasta lo que hay más allá de nuestro «horizonte» de 13.000 millones de años luz, estaba comprimido hasta un volumen menor que el de un núcleo atómico? A estas densidades descomunales, que se dieron durante los primeros 10-43 segundos del universo (lo que se conoce como «tiempo de Planck»), tanto los efectos cuánticos como la gravedad habrían sido importantes. ¿Qué pasa cuando los efectos cuánticos convulsionan todo un universo?

Por ello, la física será incompleta y conceptualmente insatisfactoria en tanto no se disponga de una teoría adecuada de la gravedad cuántica. Algunos teóricos creen que ya es tiempo de explorar las leyes físicas que prevalecían en el tiempo de Planck, y han propuesto algunas hipótesis interesantes. Sin embargo, no hay consenso sobre qué ideas hay que descartar. Lo que es seguro es que debemos rechazar nuestras queridas concepciones del espacio y el tiempo basadas en el sentido común: el espaciotiempo a muy pequeña escala podría tener una estructura caótica, espumosa, sin ninguna flecha temporal bien definida; puede que haya una generación y fusión continua de agujeros negros primores y minúsculos. La actividad podría ser lo bastante violenta para generar nuevos dominios espaciotemporales que evolucionarían como universos independientes. Eventos más tardíos (en particular la fase inflacionaria que se describe en el capítulo XVI) podrían haber borrado cualquier rastro de la era cuántica inicial. El único lugar donde podrían observarse efectos cuántico-gravitatorios sería cerca de las singularidades centrales de los agujeros negros (de donde ninguna señal puede escapar). Una teoría sin consecuencias evidentes fuera de estos dominios tan exóticos e inaccesibles no es verificable. Para que se la tome en serio debe estar íntimamente insertada o, en su efecto, articulada en alguna teoría con fundamento empírico, o bien debe percibirse como una conclusión inevitable y convincente.

Durante las últimas décadas, varias tentativas han sido hechas para buscarle una solución al problema de la no-renormalización de la gravedad cuántica y caminar hacia la unificación de todas las fuerzas. La aproximación más esperanzadora para alcanzar ese viejo anhelo de los físicos es la teoría de las «supercuerdas», que ya anteriormente vimos.

Sin embargo, recordemos aquí que en la teoría de las supercuerdas se presume una escala natural energética determinada por la energía de Planck, alrededor de unos 1019 GeV. Esto es 1017 veces más alto que los tipos de energías que pueden ser producidos en los aceleradores de partículas más grandes, lo que imposibilita contrastar con la teoría la existencia misma de las supercuerdas. No obstante, los teóricos esperan que a escala de energía accesible tanto la física, la relatividad general, el electromagnetismo, las fuerzas nucleares débiles y fuertes, las partículas subatómicas surjan de la teoría de las supercuerdas como una aproximación. Así, se espera conseguir con ese modelo de cuerdas no sólo una ajustada descripción de la gravedad cuántica, sino que también intentar con ella la anhelada unificación de las fuerzas.

Lamentablemente, no hay un único límite de baja energía para la teoría de las supercuerdas como tampoco un sólo modelo de la teoría. Por un tiempo, lo anterior pareció como una barrera infranqueable, pero en años recientes, y a través de una mayor abstractación matemática, se ha construido un nuevo modelo de supercuerdas conocido como «la teoría M» que amalgama dentro de ella otras teorías de supercuerdas.

Por ahora, es demasiado pronto para pronunciarse si la teoría M es finalmente el medio que reconciliará la gravitación y la mecánica cuántica, pero sí debería poder cumplir con algunas expectativas, como ser las de explicar algunos hechos básicos sobre el mundo físico. Por ejemplo, el espaciotiempo de cuatro dimensional tendría que surgir de la teoría, más bien que ser insertado en ella. Las fuerzas y las partículas de naturaleza también deberían ser descritas, preferentemente incluyendo sus propiedades claves, como fuerzas de interacción y masas. Sin embargo, a no ser que la teoría M, o una variante futura, pueda ser proyectada a la baja energía de los laboratorio de física para poder ser contrastada, corre el riesgo de empezar a ser olvidada y finalmente archivada como uno más de los muchos y elegantes ejercicios matemáticos que se han elaborado para la física en los últimos tiempos.

Cuerdas o filamentos vibrantes en el corazón de la materia

Si la teoría de supercuerda es una pérdida de tiempo o no, ello está por verse. Por ahora, el desafío más duro a superar por la teoría es entender por qué el espacio de 9 dimensiones más el tiempo se «comprime» bajo el aspecto de nuestro espacio habitual tetradimensional (el tiempo más las tres dimensiones espaciales), en vez de hacerlo en tres o cinco dimensiones, y ver cómo sucede esto. Aún hay un espacio infranqueable entre la teoría de supercuerdas y los fenómenos observables. La teoría de supercuerdas plantea problemas demasiado difíciles ahora mismo para los matemáticos. En este aspecto, es muy diferente de la mayor parte de teorías físicas: normalmente, el aparato matemático de las teorías se desarrolla antes que éstas. Por ejemplo, Einstein utilizó conceptos geométricos desarrollados en el siglo XIX, no tuvo que partir de cero para construir las matemáticas que necesitaba.

Por su parte, los físicos cuerdistas se acorralan en lo que es fácil de comprobar, es difícil de calcular y lo que es fácil de calcular, es difícil comprobar. En consecuencia, pareciera que el camino que se está siguiendo es pretender desarrollar la teoría más y más, y hacer cálculos cada vez más difíciles de manera de poder predecir cosas que sean fáciles de observar. ¿El camino tendrá tiempo y final? Nadie tiene por ahora la respuesta.

El físico Eugene Wigner escribió un célebre artículo sobre este particular que llevaba por título «La irrazonable efectividad de la matemática en las ciencias físicas». También es un hecho notable que el mundo exterior muestre tantas estructuras susceptibles de descripción en «lenguaje» matemático (sobre todo cuando tales estructuras se alejan mucho de las experiencias cotidianas que moldearon la evolución de nuestros cerebros). Edward Witten, el principal experto en supercuerdas, describe dicha teoría como «una física del siglo XXI que cayó en el siglo XX». Sin embargo, sería más extraordinario que seres humanos de cualquier siglo llegaran a desarrollar una teoría tan «final» y general como pretenden ser las supercuerdas.

Salvo mejor parecer

Feb

1

La Física de Partículas al Servicio de la Salud

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física... ¡Y mucho más! ~

Clasificado en Física... ¡Y mucho más! ~

Comments (0)

Comments (0)

Transferencias tecnológicas del CERN a la Biomedicina

Partículas y mucho más

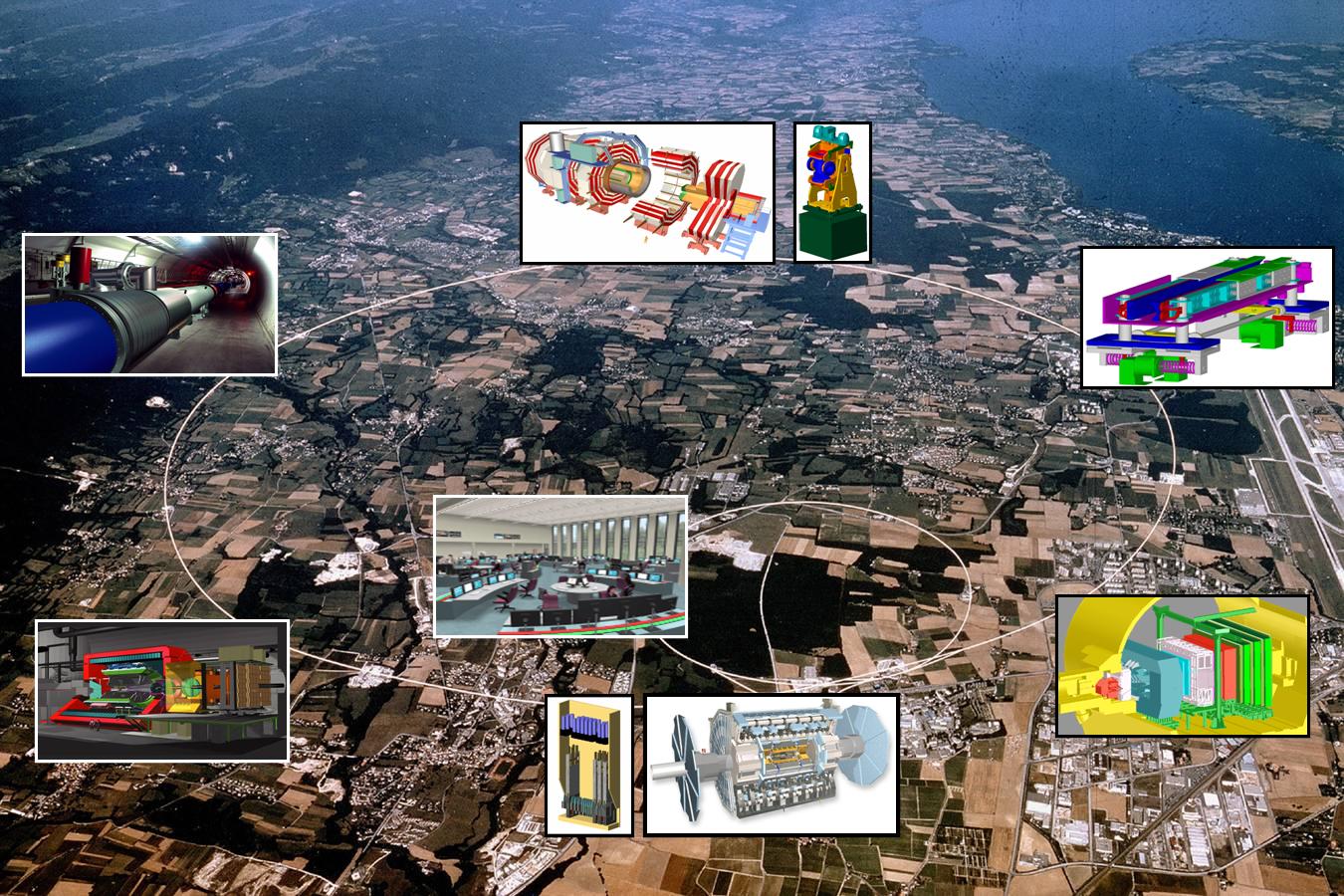

Seguramente la mayoría de los lectores de la Revista Española de Física han oído más de una vez hablar del CERN. Fundado en 1954, constituye el mayor laboratorio de física de partículas del mundo, con veinte países miembros y un personal de unas 3.000 personas entre físicos, ingenieros y personal técnico y administrativo de todo tipo. Seguramente están también al tanto de los grandes experimentos que se están preparando en este centro como el Large Hadron Collider (LHC), situado en un túnel circular de 27 km de longitud, destinado a elucidar el origen de la llamada ruptura de la simetría electrodébil y en última instancia el origen de las masas de las partículas elementales (no de la masa del protón o del neutrón como erróneamente se dice a veces en los medios de comunicación), o del proyecto CERN Neutrino Gran Sasso (CNGS), que consiste en enviar un haz de neutrinos de alta energía desde el CERN al laboratorio subterráneo italiano del Gran Sasso que se encuentra a 730 km, para estudiar las oscilaciones de estas huidizas partículas.

También es muy probable que muchos lectores asocien de manera natural la palabra acelerador de partículas a los instrumentos que utilizan los físicos modernos para estudiar y comprender mejor la estructura y el comportamiento de la materia a pequeñas escalas. Sin embargo, de los 17.000 aceleradores de partículas que se estima existen en la actualidad en todo el mundo, aproximadamente la mitad de ellos se usan en medicina y sólo una parte muy pequeña se usan para investigación fundamental. Por este y otros motivos que se discutirán más adelante, en este número especial de la Revista Española de Física dedicado a la física y las ciencias de la vida, ha parecido conveniente incluir un artículo en el que, al menos brevemente, se describieran algunas de las transferencias tecnológicas (spinoffs) importantes que la actividad del CERN aporta a dichas ciencias.

Mucho de lo que aquí se descubre, se aplica a nuestra Salud

Es bastante razonable que, como ocurre con las ciencias del espacio, mucha gente se pregunte cuál es la utilidad social de la física de partículas más allá de la adquisición de conocimientos fundamentales de la naturaleza. Sin embargo, es preciso señalar que los aceleradores y detectores de partículas del CERN y otros laboratorios similares requieren el uso, y muchas veces el desarrollo, de tecnologías de punta que obligan a una estrecha colaboración con la industria que redunda en beneficio de ambas partes. Las transferencias tecnológicas que se producen en este proceso se incorporan inmediatamente a nuestra vida diaria en áreas tales como la electrónica, procesamiento industrial y médico de imágenes, manejo y usos de la radiación , metrología, nuevos materiales, tecnologías de la computación y la información, tratamiento del cáncer, etc. En este artículo se pondrá el énfasis en aquellas actividades del CERN que han redundado de una forma más clara en beneficio de las ciencias biomédicas.

PET/TC o más allá de los rayos X

En el ámbito de la medicina los aceleradores de partículas se utilizan con dos finalidades; una para la formación de imágenes con propósitos diagnósticos y otra, para terapia, principalmente oncológica. Desde el descubrimiento de los rayos X por Röntgen en 1895, este tipo de radiación electromagnética ha proporcionado una información de valor incalculable y aún sigue proporcionándola. Sin embargo, mucho más recientemente, se han desarrollado otras técnicas complementarias de diagnóstico basadas en los llamados radiofármacos. Estas sustancias radiactivas presentan idealmente la propiedad de poder ser inyectadas en el organismo humano de forma segura y de fijarse exclusivamente a determinados tejidos. Posteriormente, a medida que van desintegrándose, emiten ciertas partículas que pueden ser detectadas y analizadas produciendo de esta forma imágenes estáticas o incluso dinámicas de los órganos en los que se depositaron los radiofármacos y, en definitiva, proporcionando información no solamente sobre la morfología de aquellos, sino también, en muchos casos, sobre su función y metabolismo.Los radiofármacos se producen utilizando haces de protones de alta intensidad y, como tienen una vida media muy baja, deben utilizarse cerca de donde se han creado. Se calcula que unos 20 millones de personas son diagnosticadas cada año mediante el uso de este tipo de sustancias.

Son técnicas no invasivas que dejan al descubierto lo que interesa ver y eliminar.

Una de las técnicas de este tipo más utilizada en la actualidad es la Positron Emission Tomography (PET). En su aplicación se utiliza normalmente un ciclotrón para irradiar alguna sustancia que se convierte en radiactiva por desintegración beta positiva (emisora de positrones). Esta sustancia se une por ejemplo a la glucosa y se inyecta al paciente. Los positrones producidos se aniquilan con los electrones circundantes dando lugar a dos fotones de energía muy bien definida, emitidos en direcciones opuestas. Estos fotones interaccionan con un material escintilador dando lugar a la emisión de otros fotones que pueden ser detectados por fotomultiplicadores o fotodiodos para formar la imagen de los tejidos que se pretenden estudiar en función de la distribución de la glucosa radiactiva. Por ejemplo, en el caso del diagnóstico del cáncer las células cancerosas suelen consumir más glucosa que las células sanas debido a su mayor vascularización y a su mayor actividad metabólica y reproductiva, produciendo por tanto una mayor emisión de fotones. Por el contrario, las zonas donde el tejido presente mayor número de células muertas brillarán menos debido a la menor concentración de glucosa radioactiva, lo cual puede ser muy útil para el diagnóstico de infartos y otras lesiones.

Tecnológias que llegan más allá

De acuerdo con David Townsend, uno de los pioneros en el desarrollo de la tecnología PET, aunque ésta no fue inventada en el CERN, una cantidad esencial e inicial de trabajo desarrollado en el CERN a partir de 1977 contribuyó de forma significativa al desarrollo del PET 3D. La tecnología PET alcanza su grado más alto de utilidad diagnóstica cuando se combina con la Computed Tomography (CT). La CT es un método de formación de imágenes tridimensionales a partir del procesamiento digital de un gran número de imágenes bidimensionales de rayos X. Inicialmente, las diferentes imágenes se obtenían alrededor de un solo eje de rotación y de ahí su nombre original de Computed Axial Tomography (CAT).

La técnica combinada PET/CT es uno de los desarrollos más excitantes de la medicina nuclear y la radiología modernas. Las reconstrucciones de imágenes CT permiten el diagnóstico precoz de tumores basándose en sus características morfológicas, mientras que la tecnología PET es capaz de diferenciar con grane eficiencia los tejidos malignos de los benignos. La fusión PET/CT permite ahora integrar las imágenes morfológica y fisiológica en una única imagen. El prototipo del scanner ART, el Partial Ring Tomograph (PRT), fue desarrollado en el CERN en 1980 y 1990 por David Townsend, Martín Wensveen y Henri Tochon-Danguy, y evaluado clínicamente en el departamento de medicina nuclear del Hospital Cantonal de Ginebra. ART puede considerarse como el precursor de la parte PET del moderno scanner PET/CT, que ha producido un impacto extraordinario en la tecnología de imágenes con fines médicos. Además, el CERN continua hoy en día contribuyendo a este campo fundamental de la medicina moderna mediante proyectos como Clear PET, Clear PEM, HPD PET etc.

Sin embargo, la importancia del CERN en el desarrollo de las tecnologías PET o CT, y en general de todo tipo de scanner, va mucho más allá. En efecto, todo este tipo de dispositivos se basa, de una forma u otra, en los detectores desarrollados a finales de los sesenta en el CERN por George Charpak. Su trabajo fue reconocido en 1992 con la concesión del Premio Nobel de Física por su invención y desarrollo de detectores de partículas, en particular de la cámara proporcional multihilos, que produjo una revolución en la técnica de exploración de las partes más íntimas de la materia. Los detectores desarrollados por Charpak se usan aún para todo tipo de investigaciones médicas y biológicas y podrían eventualmente sustituir completamente a las placas fotográficas en la radio-biología aplicada. La velocidad creciente con la que permiten registrar las imágenes en radio medicina conducen a una menor tiempo de exposición y a menores dosis de radiación indeseada recibida por los pacientes.

Hadronterapia, o las partículas contra el cáncer

Como es bien sabido, una de las herramientas terapéuticas esenciales en el campo de la oncología es la radioterapia. Dicho tratamiento se aplica hoy en día aproximadamente a la mitad de los pacientes de cáncer. En cierto modo se puede considerar como una forma sutil de cirugía donde el bisturí es reemplazado por un haz colimado de partículas capaz de esterilizar las células malignas mediante la inactivación de su ADN, impidiendo así su reproducción. Tradicionalmente, la radioterapia se ha basado en el uso de rayos X (fotones), electrones y, más recientemente, hadrones, es decir, partículas capaces de interaccionar fuerte o nuclearmente, si bien no es ésta la propiedad más interesante de estas partículas para las aplicaciones radioterapeúticas. Los haces de rayos X y los electrones se obtienen normalmente a partir de aceleradores lineales como los del CERN, aunque mucho más pequeños, y se apuntan hacia los tumores con la energía, dirección y colimación apropiadas para optimizar su efecto destructivo sobre los mismos. Por su parte, los neutrones pierden energía en el interior del organismo de una forma diferente, lo cual les hace más indicados para el tratamiento de ciertos tipos especiales de tumores. Se obtienen a partir de las colisiones de protones, previamente acelerados en un ciclotrón, con núcleos de berilio. Este hecho hace que esta terapia sea bastante más cara que las anteriores, pero a cambio el ciclotrón puede ser usado también para la producción de radiofármacos.

Cintíficos del CERN aplivcan antimateria contra el Cáncer

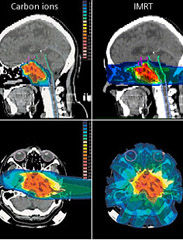

El estudio de las posibilidades de utilización de haces de hadrones en la terapia del cáncer tuvo su origen en el trabajo seminal de R.R Wilson titulado Radiological Use of Fast Protons (Radiology 47, 1946). En dicho artículo se ponía de manifiesto que los protones, así como otras partículas cargadas pesadas, presentan la propiedad única de que al penetrar en el cuerpo humano depositan la mayor parte de su energía a una preofundidad que depende de su energía inicial. Este hecho permite seleccionar cuidadosamente el área que se quiere irradiar, preservando de dicha radiación al tejido sano que pudiera encontrarse a menor profundidad. Además, como las partículas se detienen a una distancia de la superficie bien definida por la energía del haz, tampoco resultarían dañadas las células situadas detrás del blanco seleccionado.

En contraste, la energía depositada por los rayos X alcanza su máximo cerca de la superficie de entrada y decae exponencialmente hasta que abandona el cuerpo humano en el lado opuesto, haciendo por tanto muy difícil seleccionar la zona que quiere irradiarse sin dañar otras áreas de células sanas. El trabajo de Wilson de 1946 condujo a toda una nueva línea de investigación experimental, principalmente en el Lawrence Berkeley Laboratory, que ha dado lugar al desarrollo de una nueva clase de terapias antitumorales basadas en la irradiación con protones y más recientemente con iones de carbono. Estas técnicas han sido aplicadas en más de 40 centros de todo el mundo, y de ellas se han beneficiado hasta la fecha más de 50.000 pacientes. No obstante, continúan investigándose nuevas formas de intentar mejorar el ratio entre la energía depositada en las células tumorales y en el tejido sano.

En la actualidad, el CERN se encuentra involucrado en diversos proyectos relacionados con la hadronterapia. Por ejemplo, en el diseño de un acelerador de protones e iones de carbono dedicado exclusivamente a usos médicos conocido como Proton Ion Medical Machine Study (PIMMS). Otro proyecto interesante es la realización de las pruebas del Linear Booster ( LIBO), capaz de acelerar una haz de protones hasta 200 Mev (los hospitales habiualmente utilizan energías en torno a los 65 MeV) y que estaría especializado en el tartamiento de tumores profundos.

Finalmente, y situándonos en un plano de investigación a un nivel más básico, es interesante señalar que en octubre de 2006 se presentaron los primeros resultados de un experimento llevado a cabo en el CERN con potencial para futuras aplicaciones en la terapia del cáncer. Se trataba del Antiproton Cell Experiment (ACE), que constituye la primera investigación realizada hasta la fecha sobre efectos biológicos de los antiprotones. Los antiprotones se comportan como los protones cuando entran en el organismo, pero generan mucha más energía en el blanco seleccionado debido a du aniquilación con los protones existentes en los núcleos de los átomos de las células, y además depositan esta energía de una forma biológicamente más efectiva.

Se busca antimateria contra el Cáncer. Los resultados muestran que los antiprotones son cuatro veces más efectivos que los protones para destruir células vivas. (Foto: Especial CERN )

Evaluando la fracción de células supervivientes después de la irradiación con el haz de antiprotones, el experimento ACE ha encontrado que a eficiencia de éstos es unas cuatro veces mayor que la de los protones, mientras que el daño producido a las células situadas antes del blanco era básicamente el mismo. De acuerdo con Michael Holzscheiter, portavoz del experimento ACE, este hecho podría ser extremadamente importante para el tratamiento de casos de cáncer recurrente, donde este tipo de propiedad es vital. La tecnología desarrollada previamente en el CERN para la obtención de haces de antiprotones de buena calidad a la energía apropiada es esencial para este prometedor experimento, que difícilmente podría haberse realizado en ningún otro laboratorio. Éste es por tanto un magnífico ejemplo de cómo la investigación en física de partículas desarrollada en el CERN puede generar soluciones innovadores con excelentes beneficios médicos potenciales.

Los investigadores de ACE, en colaboración con otras instituciones de todo el mundo, están realizando en la actualidad nuevos tests para comprobar la eficacia de este método en el caso de tumores situados a mayor profundidad, y comparando sus resultados con los de otros métodos más convencionales como la irradiación mediante iones de carbono. Si todo sale como se espera, los beneficios clínicos de esta nueva técnica podrían empezar a producirse dentro de la próxima década.

Otro ejemplo importante de tecnología creada en el CERN con aplicaciones a la terapia del cáncer es el Neutron Driven Element Trasmuter. Se trata de un sistema de producción de radioisótopos específicos específicos a partir de un acelerador de protones cuyo desarrollo fue liderado por Carlo Rubbia, Premio Nobel de Física en 1984 por el descubrimiento de los bosones W y Z y ex director general del CERN. La idea es utilizar el haz de protones para producir neutrones los cuales provocan reacciones en un ambiente apropiado donde ciertos elementos son convertidos en los isótopos deseados.

La diferencia principal entre este método, seguro y barato, y el método más tradicional de utilizar los neutrones provenientes de un reactor nuclear, es que no requiere el uso de material fisionable ni funciona críticamente, es decir las reacciones se detienen en el momento en el que el acelerador es apagado. Más aún, el método tiene la ventaja de que sólo se producen los isótopos requeridos, lo que redunda en una importante reducción de impacto ambiental. Normalmente, el blanco utilizado es plomo, elemento idóneo por presentar el menor ritmo de captura de neutrones. Los neutrones se producen por espalación a partir del haz de protones y permanecen en el interior del blanco de plomo, que está rodeado de un deflector de grafito, hasta que su espectro se suaviza suficientemente para cubrir un gran rango de energías que permiten su utilización para la transmutación de los elementos necesarios para la obtención de los isótopos deseados.

El Neutron Driven Element Trasmuter ha permitido, entre otras cosas, la producción de radioisótopos beta emisores como el 166Ho, 186 Re o el 188Re que son de gran importancia en braquiterapia. Dicha técnica, muy utilizada en el tratamiento de cánceres ginecológicos y en el de cáncer de próstata, es un tipo de radioterapia de proximidad donde la fuente radiactiva se sitúa dentro o muy cerca de los tejidos que requieren irradiación. Típicamente, la fuente radiactiva, de alta actividad y corta vida media, se encapsula en una semilla, filamento o tubo y se implanta en quirófano en la zona deseada. Las diferentes dosis requeridas en cada caso hacen que sea fundamental disponer del mayor muestrario posible de radioisótopos con la actividad y vida media apropiadas, lo cual convierte al Neutron Driven Element Trasmuter en una herramienta valiosísima para el futuro de este tipo de técnica terapéutica.

Información y computación sin fronteras

CERN, … where the web was born; éste es uno de los reclamos publicitarios que suelen utilizarse para hacer ver al público la importancia de los retornos tecnológicos que en este laboratorio tienen lugar. Y en efecto, fue a finales de los ochenta cuando Tim Berners-Lee desarrolló estándar de Hyper Text Transfer Protocol (HTTP) e implementó los primeros servidores web en el CERN. Su esfuerzo permitió la comunicación fácil y segura y el intercambio de todo tipo de información entre todos los ordenadores del mundo conectados a internet, dando lugar de esta forma a una de las revoluciones tecnológicas más importantes de las últimas décadas. Las repercusiones científicas, tecnológicas, culturales, comerciales y de ocio de la web son ya tan conocidas que apenas merecen comentario alguno.

El término Grid fue acuñado por Ian Foster and Carl Kesselman en su libro The Grid, Blueprint for new Computing Infraestructure (Morgan Kaufman, 1998), aunque las ideas básicas habían sido consideradas con anterioridad. No existe un acuerdo general sobre cual debería ser la definición precisa de las tecnologías Grid, pero hay un amplio concenso en que esta debería contener elementos tales como recursos compartidos, virtualización, abstracción del acceso a los recursos y estandarización. La filosofía Grid consistería, no sólo en compartir información entre diferentes usuarios, sino también recursos, como por ejemplo, procesadores, tiempo de CPU, unidades de almacenamiento, así como otros aparatos e instrumentos, de tal forma que eventualmente cada usuario tendría acceso virtual, por ejemplo, a la capacidad de cálculo de todos los demás usuarios de esa Grid. En los primeros tiempos de esta tecnología de la información se llegó a hablar de la Grid, refiriéndose a la posibilidad de existencia de una única World Wide Grid.

Todo surgió del CERN

Hasta el momento,, sin embargo, este concepto no es una realidad y más bien lo que se encuentra es que diferentes grupos de proyectos crean su propia Grid usando sus propias implementaciones, estándares y protocolos y dando acceso restringido solamente a una cierta comunidad de usuarios autorizados. Así, aunque se siguen realizando importantes esfuerzos en cuanto a la estandarización de los protocolos, no está claro cual será el camino que este tipo de tecnología seguirá en el futuro en lo que se refiere a la futura existencia de un única Grid.

En cualquier caso es importante resaltar que una vez más el CERN ha sido pionero en este tipo de tecnología. Los detectores que se están instalando (a estas alturas, todos instalados y en marcha) en el LHC (ATLAS, CMS, ALICE, LHCb, SUSY, etc.), son tan complejos, que han requerido cada uno de ellos el concurso de muchas instituciones de todo el mundo para su construcción, y lo seguirán requiriendo para su mantenimiento cuando el acelerador empiece a funcionar (ya está en marcha), y, como no, para el análisis de los datos que se obtengan. Para hacerse una idea de la dimensión y complejidad de estos análisis baste mencionar que el compact Muon Selenoid (CMS), una vez pasado su primer filtro, deberá almacenar información sobre el resultado de las colisiones producidas en su interior a un ritmo del orden de 100 a 200 MB por segundo durante un tiempo esperado de unos cien días por año. Resulta obvio que sólo una tecnología tipo Grid puede afrontar con posibilidades de éxito un reto semejante y de hecho el CERN ha inspirado varios proyectos Grid multinacionales por este motivo. Posiblemente, el más grande de ellos hasta la fecha sea el EGEE (Enablinbg Grids for E-Science), que conecta más de 150 paises y ofrece 20 000 CPUs y más de 10 Petabytes de memoria.

De manera análoga a como ocurrió con las tecnologías de la detección y aceleración, las tecnologías Grid tendrán, y de hecho ya empiezan a tener, un fuerte impacto en las ciencias de la vida y de la salud. En este sentido, uno de los campos obvios de aplicación es la bioinformática. Gracias a los espectaculares avances llevados a cabo en los últimos años en el campo de la biología molecular, se dispone hoy en día de cantidades crecientes de información genética de diferentes especies e individuos. Dicha información codificada en el ADN en forma de secuencia de tripletes o codones de ácidos nucleicos, que constituyen los genes que contienen la estructura primaria de las diferentes proteínas, ha sido y está siendo obtenida por centenares de grupos diferentes distribuidos por todo el mundo y debe almacenarse en gigantescas bases de datos de forma eficiente para su compartición, contrastación y análisis.

Ejemplos típicos serían la búsqueda de determinadas secuencias, comparaciones, búsqueda de determinadas mutaciones o alelos, etc. Resulta evidente que esta ingente labor puede verse enormemente beneficiada por el uso de tecnologías Grid. De hecho, la Bioinformática, y en particular sus aplicaciones biomédicas, han sido una parte importante del proyecto EGEE desde el comienzo del mismo.

Finalmente, y como última muestra de cómo puede revertir en la sociedad las tecnologías de la información y la computación provenientes de la física de partículas, es interesante mencionar el Proyecto Mammogrid y su continuación Mammogrid Plus. Liderado por el CERN, dicho proyecto de la UE utiliza la tecnología Grid para crear una base de datos de mamografías que pueda ser usada para investigar un gran conjunto de datos e imágenes que, aparte de otras aplicaciones sanitarias, sea útil para estudiar el potencial de esta tecnología para servir de soporte a la colaboración entre los profesionales de la salud de la UE.

Ciencia, Tecnología y Sociedad

A estas alturas debería haber quedado claro que los centros científicos de élite internacionales como el CERN, no sólo nos proporcionan un conocimiento más profundo de la naturaleza, sino que las tecnologías de punta que en ellos se desarrollan acaban permeando a la Sociedad y se incorporan a nuestras vidas cotidianas. El autor del artículo, Antonio Dobado, del Departamento de Física Teórica I de la Universidad Complutense de Madrid, ha pretendido ilustrar el hecho innegable de la conexión existente entre temas tan aparentemente dispares como el de la Física de Partículas y la Biomedicina, pero ejemplos semejantes podrían haberse encontrado en prácticamente cualquier área de la actividad humana.

La Sociedad no puede permanecer por más tiempo ajena a la Ciencia y a todo lo que trae consigo. Precisamente por eso la RSEF dedica un gran esfuerzo a la difícil tarea de convencer al público de la importancia de la Física como valor científico, cultural y social, como una forma rigurosa y profunda del acercamiento al conocimiento de la naturaleza, y a la vez como generadora de nuevas tecnologías. En este sentido, es una espléndida noticia la inminente creación de un nuevo Grupo especializado en el seno de la RSEF denominado Física Médica. Y, desde aquí, aprovechamos la oportunidad para darles la bienvenida y desearles el mayor éxito en sus futuras andaduras en la búsqueda de la verdad científica.

Fuente: Revista Española de FÍSICA.

Publicada por la RSEF con el Nº 3 Volumen 21 de 2007

La presente transcripción es de: Emilio Silvera

Miembro numerario de la RSEF y adscrito a los Grupos Especializados de Física Teórica y Astrofísica.

Feb

1

Espacio-tiempo curvo y los secretos del Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Sin categoría ~

Clasificado en Sin categoría ~

Comments (0)

Comments (0)

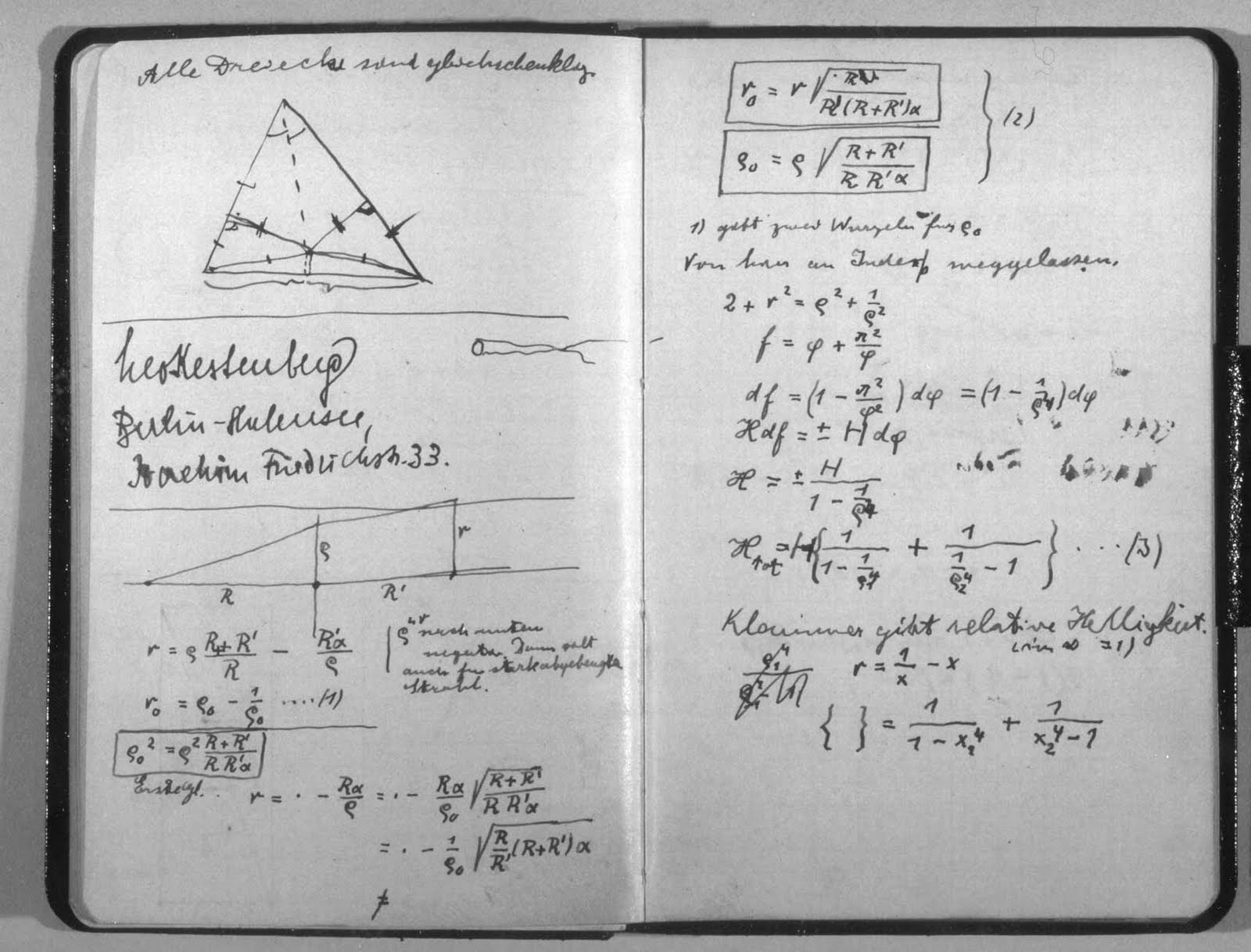

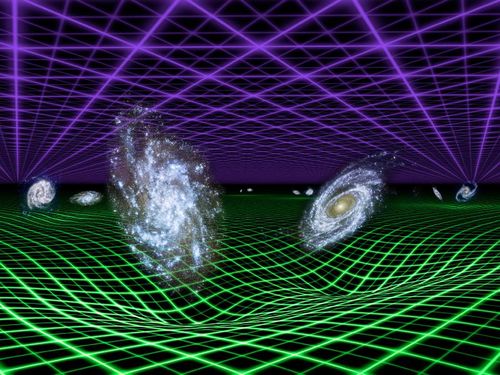

La densidad de energía-momentum en la teoría de la relatividad se representa por cuadritensor energía-impulso. La relación entre la presencia de materia y la curvatura debida a dicha materia viene dada por la ecuación de campo de Einstein. Esta sencilla ecuación es la demostración irrebatible de la grandeza de la mente humana que, con unos pocos signos nos puede decir tánto. De las ecuaciones de campo de Einstein, se pudieron deducir muchas cosas, tales como que el espacio se curva en presencia de grandes masas, como mundos, estrellas y galaxias para configurar la geometría del espacio.

Los vientos estelares emitidos por las estrellas jóvenes, distorsionan el material presente en las Nebulosas, y, de la misma manera, en presencia de masa se distosiona el esapcio-tiempo. En estos lugares que, como océanos de gas y polvo iniozado por la radiación de las estrellas masivas más jóvenes, existen moléculas complejas que, en algún caso, son esenciales para la existencia de la vida.

La teoría cuántica de campos en espacio-tiempo curvo es una extensión de la teoría cuántica de campos estándar en la que se contempla la posibilidad de que el espacio-tiempo por el cual se propaga el campo no sea necesariamente plano (descrito por la métrica de Minkouski). Una predicción genérica de esta teoría es que pueden generarse partículas debido a campos gravitacionales dependientes del tiempo, o a la presencia de horizontes.

La teoría cuántica de campos en espacio-tiempo curvo puede considerarse como una primera aproximación de gravedad cuántica. El paso siguiente consiste en una gravedad semiclásica, en la que se tendrían en cuenta las correcciones cuánticas, debidas a la presencia de materia, sobre el espacio-tiempo.

En un espacio euclideo convencional un objeto físico finito está contenido dentro de un ortoedro mínimo, cuyas dimensiones se llaman ancho, largo y profundida o altura. El espacio físico a nuestro alrededor es tridimensional a simple vista. Sin embargo, cuando se consideran fenómenos físicos la gravedad, la teoría de la relatividad nos lleva a que el universo es un ente tetra-dimensional que incluye tanto dimensiones espaciales como el tiempo como otra dimensión. Diferentes observadores percibirán diferentes “secciones espaciales” de este espacio-tiempo por lo que el espacio físico es algo más complejo que un espacio euclídeo tridimiensional.

En las teorías actuales no existe una razón clara para que el de dimensiones espaciales sean tres. Aunque existen ciertas instuiciónes sobre ello: Ehrenfest (aquel gran físico nunca reconocido) señaló que en cuatro o más dimensiones las órbitas planetarias cerradas, por ejemplo, no serían estables (y por ende, parece difícil que en un universo así existiera vida inteligente preguntándose por la tridimensionalidad espacial del universo).

Es cierto que en nuestro mundo tridimensional y mental existen cosas misteriosas. A veces me pregunto que importancia puede tener un . (“¿Qué hay en un nombre? Lo que llamamos rosa, / con cualquier otro nombre tendría el mismo dulce aroma”? (-Shakespeare, Romeo y Julieta-) – La rosa da sustento a muchos otros tópicos literarios: se marchita como símbolo de la fugacidad del tiempo y lo efímero de la vida humana; y provoca la prisa de la doncella recogerla mientras pueda. Por otro lado, le advierte de que hay que tener cuidado: no hay rosa sin espinas.

También el mundo de la poesía es un tanto misterioso y dicen, que… “Los poetas hablan consigo mismo y el mundo les oye por casualidad.” Tópicos ascéticos, metafísicos o existenciales: Quiénes somos, de dónde venimos, a dónde vamos, las llamadas preguntas trascendentales, propias de la cosmología, la antropología y la metafísica. Los poetas siempre han buscado un mundo irreal y han idealizado el enaltecido mucho más allá de este mundo.

Como siempre me pasa, me desvío del tema que en este trabajo nos ocupa: El espacio-tiempo.

Estamos inmersos en el espacio-tiempo curvo y tetradimensional de nuestro Universo. Hay que entender que el espacio–tiempo es la descripción en cuatro dimensiones del universo en la que la posición de un objeto se especifica por tres coordenadas en el espacio y una en el tiempo. De acuerdo con la relatividad especial, no existe un tiempo absoluto que pueda ser medido con independencia del observador, de manera que eventos simultáneos para un observador ocurren en instantes diferentes vistos desde otro lugar. El tiempo puede ser medido, por tanto, de manera relativa, como lo son las posiciones en el espacio (Euclides) tridimensional, y esto puede conseguirse mediante el concepto de espacio–tiempo. La trayectoria de un objeto en el espacio–tiempo se denomina por el de línea de universo. La relatividad general nos explica lo que es un espacio–tiempo curvo con las posiciones y movimientos de las partículas de materia.

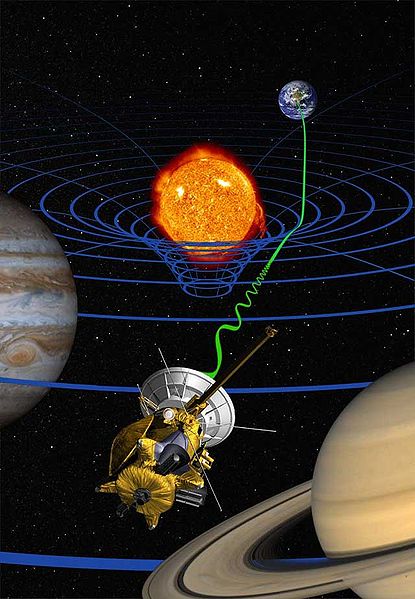

La introducción por parte de Minkouski de la idea espaciotemporal resultó tan importante es porque permitió a Einstein utilizar la idea de geometría espaciotemporal para formular su teoría de la relatividad general que describe la Gravedad que se genera en presencia de grandes masas y cómo ésta curva el espacio y distorsiona el tiempo. En presencia de grandes masas de materia, tales como planetas, estrellas y galaxias, está presente el fenómeno descrito por Einstein en su teoría de la relatividad general, la curvatura del espacio–tiempo, eso que conocemos como gravedad, una fuerza de atracción que actúa todos los cuerpos y cuya intensidad depende de las masas y de las distancias que los separan; la fuerza gravitacional disminuye con el cuadrado. Hemos llegado a comprender que es la materia, la que determina la geometría del espacio-tiempo.

En la imagen, dos partículas en reposo relativo, en un espacio-tiempo llano y Se representan en este esquema dos partículas que se acercan entre sí siguiendo un movimiento acelerado. La interpretación newtoniana supone que el espacio-tiempo es llano y que lo que provoca la curvatura de las líneas de universo es la fuerza de interacción gravitatoria entre ambas partículas. Por el contrario, la interpretación einsteiniana supone que las líneas de universo de estas partículas son geodésicas (“rectas”), y que es la propia curvatura del espacio tiempo lo que provoca su aproximación progresiva.

El máximo exponente conocido del espacio-tiempo curvo, se podría decir que se da en la formación de los agujeros negros, donde la masa queda comprimida a tal densidad que se conforma en una singularidad, ese objeto de energía y densidad “infinitsas” en el que, el espacio y el tiempo desaparecen de nuestra vista y parece que entran en “otro mund” para nosotros desconocidos.

Los agujeros negros, cuya existencia se dedujo por Schwarzschild en 1.916 a partir de las ecuaciones de campo de Einstein de la relatividad general, son objetos supermasivos, invisibles a nuestra vista (de ahí su nombre) del que no escapa ni la luz; tal es la fuerza gravitatoria que generan que incluso engullen la materia de sus vecinas, objetos estelares como estrellas que osan traspasar el cinturón de seguridad que llamamos horizonte de sucesos.

Desde siempre hemos tenido la tendencia de querer representar las cosas y a medida que pudimos descubrir conocimientos nuevos, también le dimos a esos nuevos saberes sus símbolos y ecuaciones matemáticas que representaban lo que creíamos saber. Mecánica cuántica, relatividad, átomos, el genóma, agujeros negros, la constante cosmológica, la constante de Planck racionalizada…

Wheeler decía allá por el año 1957, que el punto final de la compresión de la materia -la propia singularidad– debía estar gobernada por la unión, o matrimonio, de las leyes de la mecánica cuántica y las de la distorsión espaciotemporal. Esto debe ser así, puesto que la distorsión espaguetiza el espacio a escalas tan extraordinariamente microscópicas que están profundamente influenciadas por el principio de incertidumbre.

Las leyes unificadas de la distorsión espaciotemporal y la mecánica cuántica se denominan “leyes de la gravedad cuántica”, y han sido un “santo grial” para todos los físicos desde los años cincuenta. A principios de los sesenta los que estudiaban física con Wheeler, pensaban que esas leyes de la gravedad cuántica eran tan difíciles de comprender que nunca las podrían descubrir durante sus vidas. Sin embargo, el tiempo inexorable no deja de transcurrir, mientras que, el Universo y nuestras mentes también, se expanden. De tal manera evolucionan nuestros conocimientos que, poco a poco, vamos pudiendo conquistar saberes que eran profundos secretos escondidos de la Naturaleza y, con la Teoría de cuerdas (aún en desarrollo), parece que por fín, podremos tener una teoría cuántica de la gravedad.

Una cosa sí sabemos: Las singularidades dentro de los agujeros negros no son de mucha utilidad puesto que no podemos contemplarla desde fuera, alejados del horizonte de sucesos que marca la línea infranqueable del irás y no volverás. Si alguna vez alguien pudiera llegar a ver la singularidad, no podría regresar para contarlo. Parece que la única singularidad que podríamos “contemplar” sin llegar a morir sería aquella del Big Bang, es decir, el lugar a partir del cual pudo surgir el universo y, cuando nuestros ingenios tecnológicos lo permitan, serán las ondas gravitacionales las que nos “enseñarán” esa singularidad.

Esta pretende ser la imagen de un extraño objeto masivo, un quásar que sería una evidencia vital del Universo primordial. Es un objeto muy raro que nos ayudará a entender cómo crecieron los agujeros negros súpermasivos unos pocos cientos de millones de años después del Big Bang (ESO).

Representación artística del aspecto que debió tener 770 millones después del Big bang el quásar más distante descubierto hasta la fecha (Imagen ESO). Estas observaciones del quásar brindan una imagen de nuestro universo tal como era durante su infancia, solo 750 millones de años después de producirse la explosión inicial que creó al universo. El análisis del espectro de la luz del quásar no ha aportado evidencias de elementos pesados en la nube gaseosa circundante, un hallazgo que sugiere que el quásar data de una era cercana al nacimiento de las primeras estrellas del universo.

Basándose en numerosos modelos teóricos, la mayoría de los científicos está de acuerdo sobre la secuencia de sucesos que debió acontecer durante el desarrollo inicial del universo: Hace cerca de 14.000 millones de años, una explosión colosal, ahora conocida como el Big Bang, produjo cantidades inmensas de materia y energía, creando un universo que se expandía con suma rapidez. En los primeros minutos después de la explosión, protones y neutrones colisionaron en reacciones de fusión nuclear, formando así hidrógeno y helio.

Finalmente, el universo se enfrió hasta un punto en que la fusión dejó de generar estos elementos básicos, dejando al hidrógeno como el elemento predominante en el universo. En líneas generales, los elementos más pesados que el hidrógeno y el helio, como por ejemplo el carbono y el oxígeno, no se formaron hasta que aparecieron las primeras estrellas. Los astrónomos han intentado identificar el momento en el que nacieron las primeras estrellas, analizando a tal fin la luz de cuerpos muy distantes. (Cuanto más lejos está un objeto en el espacio, más antigua es la imagen que de él recibimos, en luz visible y otras longitudes de onda del espectro electromagnético.) Hasta ahora, los científicos sólo habían podido observar objetos que tienen menos de unos 11.000 millones de años. Todos estos objetos presentan elementos pesados, lo cual sugiere que las estrellas ya eran abundantes, o por lo menos estaban bien establecidas, en ese momento de la historia del universo.

Supernova 1987 A

El Big Bang produjo tres tipos de radiación: electromagnética (fotones), radiación de neutrinos y ondas gravitatorias. Se estima que durante sus primeros 100.000 años de vida, el universo estaba tan caliente y denso que los fotones no podían propagarse; eran creados, dispersados y absorbidos antes de que apenas pudieran recorrer ínfimas distancias. Finalmente, a los cien mil años de edad, el universo se había expandido y enfriado lo suficiente para que los fotones sobrevivieran, y ellos comenzaron su viaje hacia la Tierra que aún no existía. Hoy los podemos ver como un “fondo cósmico de microondas”, que llega de todas las direcciones y llevan gravada en ellos una imagen del universo cuando sólo tenía esa edad de cien mil años.

Se dice que al principio sólo había una sola fuerza, la Gravedad que contenía a las otras tres que más tarde se desgajaron de ella y “caminaron” por sí mismas para hacer de nuestro universo el que ahora conocemos. En Cosmología, la fuerza de gravedad es muy importante, es ella la que mantiene unidos los sistemas planetarios, las estrellas en las galaxias y a las galaxias en los cúmulos. La Gravedad existe a partir de la materia que la genera para curvar el espaciotiempo y dibujar la geometría del universo.

Un agujero negro es lo definitivo en distorsión espaciotemporal, según las ecuaciones de Einstein: está hecho única y exclusivamente a partir de dicha distorsión. Su enorme distorsión está causada por una inmensa cantidad de energía compactada: energía que reside no en la materia, sino en la propia distorsión. La distorsión genera más distorsión sin la ayuda de la materia. es la esencia del agujero negro.

Lo cierto es que los físicos relativistas se han sentido muy frustrados desde que Einstein publicó su Teoría de la relatividad general y se desprendieron de ellas mensajes asombroso como el de la existencia de agujeros negros que predecían sus ecuaciones de campo. Así que, se dirigieron a los astrónomos para que ellos confirmaran o refutaran su existencia mediante la observación del universo profundo. Sin embargo y, a pesar de su enorme esfuerzo, los astrónomos npo han podido obtener medidas cuantitativas de ninguna distorsión espaciotemporal de agujeros negros. Sus grandes triunfos han consistido en varios descubrimientos casi incontrovertibles de la existencia de agujeros negros en el universo, pero han sido incapaces de cartografiar, ni siquiera de forma ruda, esa distorsión espaciotemporal alrededor de los agujeros negros descubiertos. No tenemos la técnica para ello y somos conscientes de lo mucho que nos queda por aprender y descubrir.

Las matemáticas siempre van por delante de esa realidad que incansables buscamos. Ellas nos dicen que en un agujero negro, además de la curvatura y el frenado y ralentización del tiempo, hay un tercewr aspecto en la distorsi´pon espaciotemporal de un agujero negro: un torbellino similar a un enorme tornado de espacio y tiempo que da vueltas y vueltas alrtededor del horizonte del agujero. Así como el torbellino es muy lento lejos del corazón del tornado, también el torbellino. Más cerca del núcleo o del horizonte el torbellino es más rápido y, cuando nos acercamos hacia el centro ese torbellino espaciotemporal es tan rápido e intenso que arrastra a todos los objetos (materia) que ahí se aventuren a estar presentes y, por muy potentes que pudieran ser los motores de una nave espacial… ¡nunca podrían hacerla salir de esa inmensa fuerza que la atraería hacia sí! Su destino sería la singularidad del agujero negro donde la materia comprimida hasta límites inimaginables, no sabemos en qué se habrá podido convertir.

Todos conocemos la teoría de Einstein y lo que nos dice que ocurre cuando grandes masas, como planetas, están presentes: Curvan el espacio que lo circundan en función de la masa. El exponente máximo de dicha curvatura y distorsión temporal es el agujero negro que, comprime la masa hasta hacerla “desaparecer” y el tiempo, en la singularidad formada, deja de existir. En ese punto, la relatividad general deja de ser válida y tenemos que acudir a la mecánica cuántica para seguir comprendiendo lo que allí está pasando.

Einstein no se preocupaba por la existencia de este extraño universo dentro del agujero negro porque la comunicación con él era imposible. Cualquier aparato o sonda enviada al centro de un agujero negro encontraría una curvatura infinita; es decir, el campo gravitatorio sería infinito y, como ya se explica anteriormente, nada puede salir de un agujero negro, con lo cual, el mensaje nunca llegará al exterior. Allí dentro, cualquier objeto material sería literalmente pulverizado, los electrones serían separados de los átomos, e incluso los protones y los neutrones dentro de los propios núcleos serían desgajados. De todas las maneras tenemos que reconocer que este universo especular es matemáticamente necesario para poder ir comprendiendo cómo es, en realidad, nuestro universo.

Con todo esto, nunca hemos dejado de fantasear. Ahí tenemos el famoso puente de Einstein-Rosen que conecta dos universos y que fue considerado un artificio matemático. De todo esto se ha escrito hasta la extenuación:

“Pero la factibilidad de poder trasladarse de un punto a otro del Universo recurriendo a la ayuda de un agujero de gusano es tan sólo el principio de las posibilidades. Otra posibilidad sería la de poder viajar al pasado o de poder viajar al futuro. Con un túnel conectando dos regiones diferentes del espacio-tiempo, conectando el “pasado” con el “futuro”, un habitante del “futuro” podría trasladarse sin problema alguno hacia el “pasado” Einstein—Rosen—Podolsky), para poder estar físicamente presente en dicho pasado con la capacidad de alterar lo que está ocurriendo en el “ahora”. Y un habitante del “pasado” podría trasladarse hacia el “futuro” para conocer a su descendencia mil generaciones después, si la hubo.“

El puente de Einstein-Rosen conecta universos diferentes. Einstein creía que cualquier cohete que entrara en el puente sería aplastado, haciendo así imposible la comunicación Posteriormente, los puentes de Einstein-Rosen se encontraron pronto en otras soluciones de las ecuaciones gravitatorias, tales como la solución de Reisner-Nordstrom que describe un agujero eléctricamente cargado. Sin embargo, el puente de Einstein-Rosen siguió siendo una nota a pie de página curiosa pero olvidada en el saber de la relatividad.

Lo cierto es que algunas veces, tengo la sensación de que aún no hemos llegado a comprender esa fuerza misteriosa que es la Gravedad, la que no se quiere juntar con las otras tres fuerzas de la Naturaleza. Ella campa solitaria y aunque es la más débil de las cuatro, esa debidad resulta engañosa poreque llega a todas partes y, además, como algunos de los antiguos filósofos naturales, algunos piensan que es la única fuerza del universo y, de ella, se desgajaron las otras tres cuando el Universo comenzó a enfriarse.

¡El Universo! Es todo lo que existe y es mucho para que nosotros, unos recien llegados, podamos llegar a comprenderlo en toda su inmensidad. Muchos son los secretos que esconde y, como siempre digo, son muchas más las preguntas que las respuestas. Sin embargo, estamos en el camino y… Como dijo el sabio: ¡Todos los grandes viajes comenzaron con un primer paso!

En el Universo todo es fruto de dos fuerzas contrapuestas:

Por ejemplo, las estrellas son estables por el hecho de que, la energía de fusión tiende a expandir la estrella y, la fuerza de Gravedad generada por su ingente masa, la hace contraerse. De esa manera, las dos fuerzas se contrarrestan y consiguen estabilizar a la estrella que vive miles de años. Cuando se agota el combustible nuclear de fusión, la estrella queda a merced de la Gravedad y se contrae (implosiona) bajo el peso de su propia masa, la gravedad la aplasta más y más hasta convertirla en una estrella de neutrones y un agujero negro si es una estrlla masiva.

En el átomo, el equilibrio se alcanza como consecuencia de que, los protones (los nucleones que forman el núcleo), están cargados positivamente, y, los electrones que orbitan a su alrededor, están cargadas eléctricamente con cargas negativas equivalentes, con lo cual, el equilibrio queda servido y se alcanza la establidad.

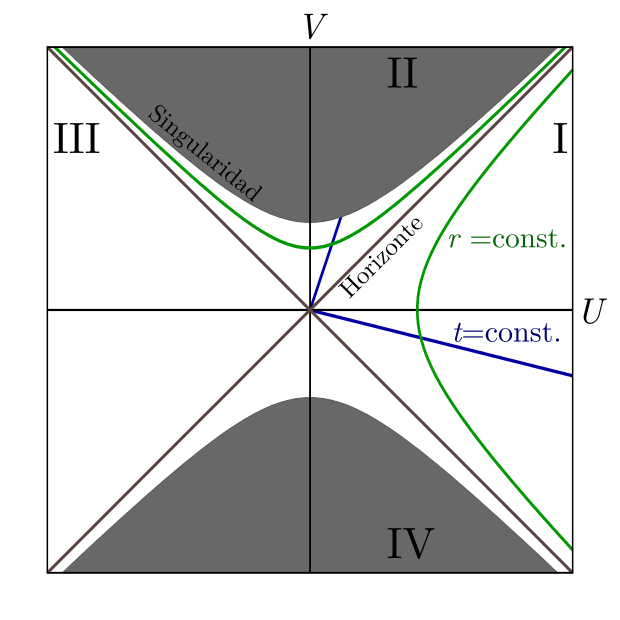

Diagrama de Kruskal-Szekeres para un agujero negro. Las rectas azules son superficies de tiempo constante. Las curvas verdes son superficies de radio constante. -Las regiones I y II (sólo la parte blanca) son el exterior y el interior de un agujero negro. -La región III es una región exterior al agujero negro “paralela”. -La región IV (sólo la parte blanca) es un agujero blanco. Las zonas grises adyacentes a las regiones II y IV son las singularidades.

El agujero Blñanco, al contrario del Agujero negro, en lugar de engullir materia la expulsaria

El agujero negro de Schwarzschild es descrito como una singularidad en la cual una geodésica puede sólo ingresar, tal tipo de agujero negro incluye dos tipos de horizonte: un horizonte “futuro” (es decir, una región de la cual no se puede salir una vez que se ha ingresado en ella, y en la cual el tiempo -con el espacio- son curvados hacia el futuro), y un horizonte “pasado”, el horizonte pasado tiene por definición la de una región donde es imposible la estancia y de la cual sólo se puede salir; el horizonte futuro entonces ya correspondería a un agujero blanco.

Así, nos encontramos con el hecho cierto de que, en el Universo, todo es equilibrio y estabilidad: el resultado de dos fuerzas contrapuestas.

Veamos otro ejemplo:

Curvas de potencial en un sistema de dos cuerpos (aquí el Sol y la Tierra), mostrando los cinco puntos de Lagrange. Las flechas indican pendientes alrededor de los puntos L –acercándose o alejándose de ellos. Contra la intuición, los puntos L4 y L5son máximos.

Los puntos de Lagrange, también denominados puntos L o puntos de libración, son las cinco posiciones en un sistema orbital donde un objeto pequeño, sólo afectado por la gravedad, puede estar teóricamente estacionario respecto a dos objetos más grandes, como es el caso de un satélite artificial con respecto a la Tierra y la Luna. Los puntos de Lagrange marcan las posiciones donde la atracción gravitatoria combinada de las dos masas grandes proporciona la fuerza centrípeta necesaria para rotar sincrónicamente con la menor de ellas. Son análogos a las órbitas geosincrónicas que permiten a un objeto estar en una posición «fija» en el espacio en lugar de en una órbita en que su posición relativa cambia continuamente. Una definición más precisa pero técnica es que los puntos de Lagrange son las soluciones estacionarias del problema de los tres cuerpos.

Diagrama del sistema Sol-Tierra, que muestra el punto L2, más alejado que la órbita lunar.

El telescopio que vendrá a suplir al viejo Hubble. Un dato curioso sobre este telescopio es que no estará situado en la órbita terrestre, se situará en el punto de Lagranje L2. Los puntos de Lagrange son las posiciones donde la gravedad del Sol y la Tierra se equilibran, de manera que un objeto puede permanecer estable, sin salir despedido hacia el espacio profundo. El James Webb se ha situado en esta posición es para aislarlo de la contaminación que existe en la órbita terrestre.

El James Webb Space Telescope o JWST durante mucho tiempo ha sido promocionado como el reemplazo para el telescopio espacial Hubble. El telescopio está considerado como uno de los proyectos más ambiciosos de la ciencia espacial emprendido. A pesar del enorme desafío, el telescopio se está acercando a la terminación. El telescopio ha servido como un aula técnico sobre las complejidades involucrada con un proyecto tan complejo. También ha servido para desarrollar nuevas tecnologías que son utilizadas por los ciudadanos promedio en sus vidas cotidianas.

En nuestro Universo todo resulta ser el equilibrio de dos fuerzas contrapuestas que se igualan y se equilibran para alcanzar la estabilidad que es requerida para que todo exista en ese nivel de normalidad que hace de nuestro universo el que podemos observar y, los fenómenos que se producen, los cambios, siempre van encaminados a eso, a conseguir ese equilibrio que observamos.

Fuerzas positivas y negaticas hacen que el núcleo de los átomos sea estable y las galaxias están sujetas por la Gravedad que mantiene las estrellas juntas y que no dejan que la expansión las pueda deshacer. El el níucleo de los átomos están los protones cargados con fuerzas positivas que atraen el mismo número de electrones que orbitan a su alrededor, y, al estar cargados con fuerzas negativas que se equilibran con las de los protones, el átomo es muy estable.

Cuando hablamos de equilibrio lo estamos haciendo del estado en el que un sistema tiene su energía distribuida de la manera estadísticamente más probable, un estado del sistema en el que las fuerzas, influencia, reacciones, etc., se compensan las unas a las otras de manera que no se permiten cambios y prevalece la estabilidad.

Equilibrio estático en tres dimensiones

Un cuerpo se encuentra en equilibrio estático si las resultantes de todas las fuerzas y todos los pares que actúan en él son ambas cero; se si halla en reposo, estará ciertamente no acelerado. Un cuerpo de ese tipo en el reposo se encuentra en equilibrio estable si después de un ligero desplazamiento vuelve a su posición original. Existen diversas variantes que no merece la pena mencionar aquí para no hacer aburrido el trabajo.

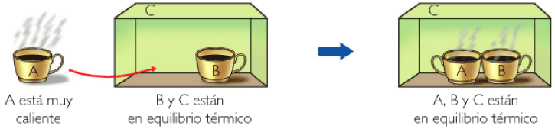

También existe el equilibrio térmico y se dice que un cuerpo está en equilibrio térmico si no hay ningún intercambio de calor dentro de él o entre e´y sus alrededores. Un sistema se encuentra en equilibrio térmico cuando cuando una reacción y su inversa está teniendo lugar a la misma velocidad. Estos son ejemplos de equilibrios dinámicos, en los que la actividad en un sentido está compensada por la actividad en el sentido inverso. De nuevo el equilibrio o estabilidad creado por fuerzas contrapuestas.

La energía se equipara segín una teoría de propuesta por Ludwig Boltzmann y fundamentada teóricamente por James Clerk Maxwell, en virtud de la cual la energía de las moléculas de un gas en una muestra grande en equilibrio tçermico está dividida por igual entre todos los grados de libertad disponibles, siendo la energía media de cada grado de libertad kT/2, donde k es la constante de Boltzmann y T es la temperatura termodinámica. La proposición no es en general cierta si los efectos cuánticos son importantes, pero frecuentemente es una buena aproximación.

El cuadro nos muestra una Ilustración de los distintos tipos de simetría en las formas orgánicas (Field Museum, Chicago).

Claro que si hablamos de simetrías, nos podríamos perder un un laberinto de clases y formas: esférica, cilíndrica, reflectiva, traslacional, helicoidal, de rotación, de ampliación, bilateral, radial… (muchas otras). Pero si nos referimos de manera simple a lo que es o entendemos por una simetria, nos estaremos refiriendo al conjunto de invariancias de un sistema.

Al aplicar una transformación de simetría sobre un sistema, el sistema queda inalterado. La simetría es estudiada matemáticamente usando teoría de grupos. Algunas de las simetrías son directamente físicas. Algunos ejemplos son las reflexiones y rotaciones de las moléculas y las transformaciones de las redes cristalinas.

Las dos fuerzas contrapuestas en los seres vivos inteligentes de nuestro mundo, está precisamente en nosotros mismos: El hombre y la Mujer, juntos, forman un sólo ente de equilibrio perfecto que nos lleva al más alto nivel de simetría y belleza, y, tal equilibrio y conjunción, hace posible el milagro de la replicación.

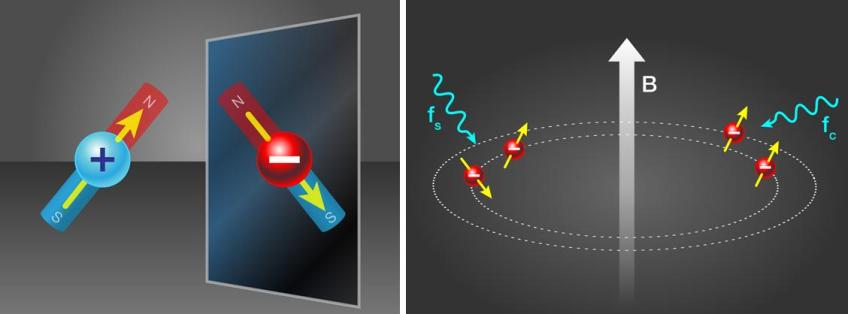

“La Trampa de Antihidrógeno (ATRAP) es un pequeño experimento en el CERN cuyo objetivo es comparar la antimateria con la materia, en concreto, átomos de antihidrógeno (formados por un antiprotón y un positrón, o antielectrón) con átomos de hidrógeno (formados por un protón y un electrón). Acaban de publicar la medida más precisa del momento magnético del antiprotón, 2,792847356(23) veces el magnetón nuclear, que coincide con el del protón en al mentos cinco partes por millón (0,0005%), una nueva medida (directa) de la invarianza CPT” (Francis (th)E mule Science’s News).

Existen simetrías más generales y abstractas como la invariancia CPT y las simetrías asociadas a las teorías gauge (tendríamos que mirar en simetrías rotas y supersimetría para ampliar el concepto en su más amplio espectro y concepción de lo que la simetría es. En el Universo, las simetrías están por todas partes: Estrellas, mundos, galaxias…

emilio silvera

Totales: 67.198.245

Totales: 67.198.245 Conectados: 61

Conectados: 61